Mots-clés:AI, LLM, Meta Llama 4, GPT-5, 具身智能, AGI安全, 数字劳动力

🔥 En vedette

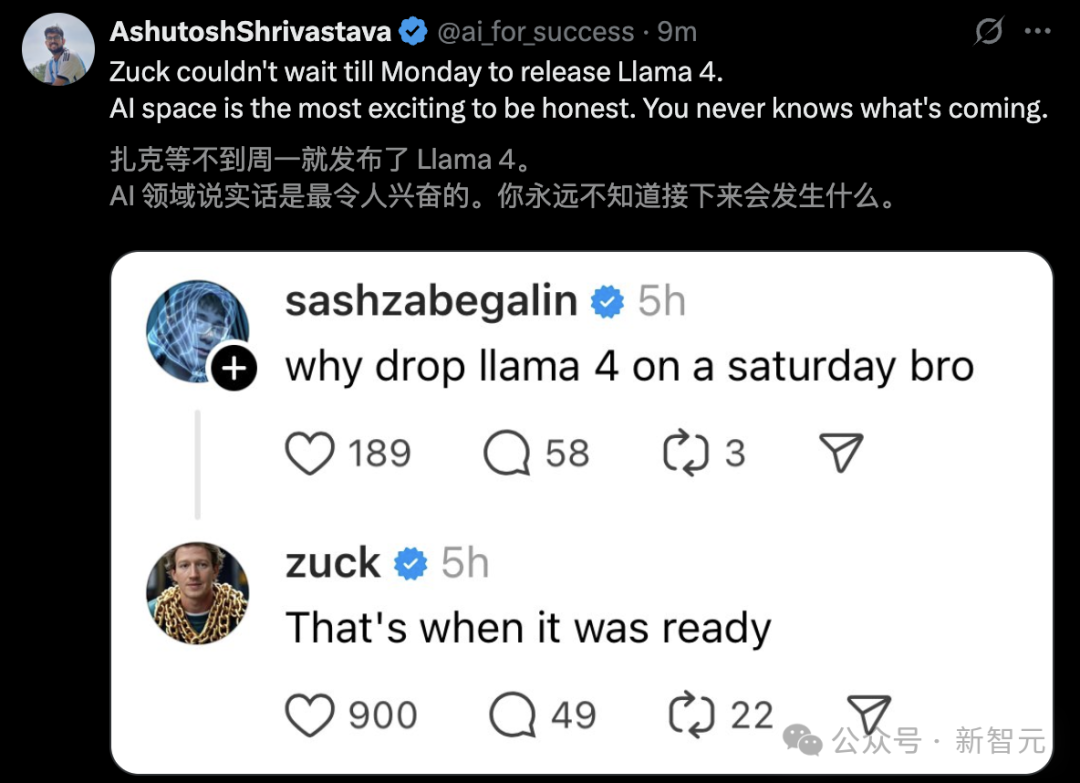

La sortie de Meta Llama 4 suscite controverse et doutes sur ses performances: Meta a publié la série de modèles Llama 4 (Scout 109B, Maverick 400B, Behemoth 2T en préversion), utilisant une architecture MoE, supportant le multimodal et un contexte allant jusqu’à 10 millions de tokens (Scout). Bien que Meta affirme des performances supérieures et que les modèles se classent bien dans le classement LM Arena, les tests de la communauté (en particulier sur les tâches de programmation) indiquent largement que ses performances sont bien inférieures aux attentes, voire inférieures à celles de modèles comme Gemma 3 ou Qwen. Parallèlement, des informations anonymes d’employés circulent sur le net, accusant Meta d’avoir potentiellement inclus des données de benchmark dans la phase de post-entraînement de Llama 4 pour « gonfler les scores » afin de respecter la date de sortie fin avril, entraînant la démission de personnel, y compris la vice-présidente de la recherche en IA, Joelle Pineau. Meta n’a pas confirmé ces accusations pour le moment, mais a admis que la version utilisée sur LM Arena était une « version de chat expérimentale », ce qui intensifie les doutes de la communauté sur la véracité de ses performances et sa stratégie de lancement. (Source: Llama 4发布36小时差评如潮!匿名员工爆料拒绝署名技术报告, 30亿月活也焦虑,AI落后CEO震怒,大模型刷分造假,副总裁愤而离职, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Llama 4 刷榜作弊引热议,20 万显卡集群就做出了个这?, Llama 4训练作弊爆出惊天丑闻!AI大佬愤而辞职,代码实测崩盘全网炸锅, Meta LLaMA 4:对抗 GPT-4o 与 Claude 的开源王牌)

OpenAI ajuste son calendrier de sortie, GPT-5 reporté de plusieurs mois: Le CEO d’OpenAI, Sam Altman, a annoncé un ajustement du calendrier de sortie, avec le lancement des modèles o3 et o4-mini dans les prochaines semaines, tandis que GPT-5, initialement prévu pour intégrer plusieurs technologies, sera reporté de plusieurs mois. Altman explique que ce délai vise à peaufiner GPT-5 au-delà du plan initial et à résoudre les difficultés d’intégration et les besoins en puissance de calcul. Il a également révélé qu’un modèle d’inférence puissant serait open-sourcé dans les prochains mois et pourrait fonctionner sur du matériel grand public. Auparavant, l’objectif d’OpenAI était d’unifier les séries o et GPT, GPT-5 étant positionné comme un système unifié intégrant des capacités vocales, Canvas, de recherche, etc., et potentiellement offert gratuitement en version de base. Cet ajustement pourrait être influencé par des concurrents comme DeepSeek et la sortie de Gemini 2.5 Pro de Google. (Source: 奥特曼官宣:免费GPT-5性能惊人,o3和o4-mini抢先上线,Llama 4也鸽了, DeepSeek前脚发新论文,奥特曼立马跟上:GPT-5就在几个月后啊, OpenAI:将在几周内发布o3和o4-mini,几个月后推出GPT-5)

L’intelligence incarnée et les robots humanoïdes deviennent un nouveau secteur en vogue, avec afflux de capitaux et défis de commercialisation: Le Forum Zhongguancun 2025 met l’accent sur les robots humanoïdes. Des robots chinois comme Jiasu Jinhua T1, Tiangong 2.0, Lingbao CASBOT montrent des avancées technologiques et des progrès dans leur déploiement sur le terrain. Le secteur passe de la démonstration technologique à l’application pratique, comme le tri industriel, le guidage/vente, la recherche scientifique. Le marché est en effervescence, avec des phénomènes de « commandes explosives » et de location de robots (loyer journalier de milliers à dizaines de milliers de yuans). Les capitaux affluent également, avec Xiaoyu Zhizao, Zhipingfang, Fourier Intelligence, Lingcifang, Zibianliang, Tashi Zhihang obtenant d’importants financements fin 2024/début 2025, les fonds d’État étant les principaux moteurs. Cependant, la voie de la commercialisation reste floue. Zhu Xiaohu de GSR Ventures se retirerait de ce domaine, suscitant des discussions sur une bulle potentielle et les difficultés de mise en œuvre. Malgré les défis, les robots humanoïdes, en tant que vecteurs de l’intelligence incarnée (mentionnée dans le rapport d’activité du gouvernement), sont considérés comme une direction clé pour l’intégration de l’IA et de l’économie réelle. (Source: 人形机器人,站上新风口)

Google DeepMind publie un rapport sur la sécurité de l’AGI, prévoyant sa possible réalisation vers 2030 et alertant sur les risques: Google DeepMind a publié un rapport de 145 pages exposant systématiquement son point de vue sur la sécurité de l’AGI, prédisant qu’une « AGI de niveau supérieur » dépassant 99% des humains pourrait apparaître vers 2030. Le rapport avertit que l’AGI pourrait présenter un risque existentiel de « destruction permanente de l’humanité » et énumère des scénarios de risque spécifiques tels que la manipulation de l’opinion publique, les cyberattaques automatisées, la perte de contrôle de la biosécurité, les catastrophes structurelles (comme la perte de capacité décisionnelle humaine), et la confrontation militaire automatisée. Le rapport classe les risques en quatre catégories : abus, désalignement (y compris l’alignement trompeur), erreurs et risques structurels. Il propose deux lignes de défense basées sur la « supervision amplifiée » et l' »entraînement robuste », ainsi qu’une approche considérant l’IA comme un « employé interne non fiable » pour le contrôle du déploiement. Le rapport critique aussi implicitement les stratégies de sécurité de concurrents comme OpenAI. Ce rapport a suscité des discussions ; certains experts jugent la définition de l’AGI vague et le calendrier incertain, mais reconnaissent universellement l’importance de la sécurité de l’IA. (Source: 2030年AGI到来?谷歌DeepMind写了份“人类自保指南”, 谷歌发145页论文:预测AGI或2030年出现 警告可能“永久毁灭人类”)

Le CEO de Nvidia Jensen Huang et d’autres parlent d’IA : main-d’œuvre numérique et stratégie nationale: Dans une émission d’a16z, le CEO de Nvidia Jensen Huang et le fondateur de Mistral Arthur Mensch ont discuté de l’avenir de l’IA. Jensen estime que l’IA est la plus grande force pour réduire la fracture technologique, soulignant sa nature à la fois universelle et hyper-spécialisée, nécessitant un fine-tuning pour des domaines spécifiques. Il a avancé que l' »intelligence numérique » est devenue une nouvelle infrastructure nationale, et que les pays doivent construire une « main-d’œuvre numérique », transformant l’IA générale en IA spécialisée. Arthur Mensch approuve le caractère révolutionnaire de l’IA, la comparant à l’électricité qui impactera le PIB, et la considérant comme une infrastructure porteuse de culture et de valeurs, soulignant l’importance d’une stratégie d’IA souveraine pour prévenir la colonisation numérique. Les deux ont insisté sur l’importance de l’open source, estimant qu’il accélère l’innovation, améliore la transparence et la sécurité, et réduit la dépendance. Jensen a également noté que les futures tâches d’IA tendront vers l’asynchronisme, imposant de nouvelles exigences aux infrastructures, et a mis en garde contre l’idolâtrie excessive de la technologie, encourageant une participation active. (Source: “数字劳动力”已诞生,黄仁旭最新发言围绕AI谈了这几点…)

🎯 Mouvements

Google ouvre gratuitement la fonction Canvas de Gemini 2.5 Pro: Google a annoncé l’ouverture gratuite de la fonction Canvas de Gemini 2.5 Pro à tous les utilisateurs. Cette fonction permet aux utilisateurs de réaliser des tâches de programmation et d’innovation en quelques minutes via des prompts, comme concevoir des pages web, écrire des scripts, créer des jeux ou des simulations visuelles. Cette initiative est perçue comme une « attaque surprise » de Google dans la compétition IA, exploitant son avantage en puissance de calcul TPU face à OpenAI (Sam Altman ayant mentionné que les GPU « fondaient »), qui connaît des tensions sur ce plan. La responsable produit Gemini, Tulsee Doshi, a souligné dans une interview que le modèle 2.5 Pro est puissant en raisonnement, programmation et capacités multimodales, et qu’il équilibre les indicateurs techniques et l’expérience utilisateur grâce à des « tests d’ambiance », prévoyant des modèles futurs plus intelligents et efficaces. (Source: 谷歌暗讽OpenAI:GPU在熔化,TPU火上浇油,Canvas免费开放,实测惊人)

DeepSeek publie une nouvelle recherche sur l’extension des modèles de récompense au moment de l’inférence: DeepSeek, en collaboration avec l’Université Tsinghua, a publié un article présentant la méthode SPCT (Self-Principled Critique Tuning). Cette méthode utilise l’apprentissage par renforcement en ligne pour optimiser les modèles de récompense génératifs (GRM), afin d’améliorer leur capacité d’extension au moment de l’inférence. Elle vise à résoudre le problème des performances limitées des modèles de récompense généraux face à des tâches complexes et variées, en permettant au modèle de générer dynamiquement des principes et des critiques de haute qualité pour améliorer la précision des signaux de récompense. Les expériences montrent que le DeepSeek-GRM-27B entraîné avec cette méthode surpasse significativement les méthodes de référence sur plusieurs benchmarks, et améliore encore ses performances grâce à l’extension par échantillonnage au moment de l’inférence. Cette recherche pourrait influencer les stratégies de publication de modèles de concurrents comme OpenAI. (Source: DeepSeek前脚发新论文,奥特曼立马跟上:GPT-5就在几个月后啊)

L’application Doubao intègre la recherche web et la fonction de réflexion approfondie: L’assistant IA de ByteDance, « Doubao », a mis à jour sa fonction de réflexion approfondie en intégrant directement la capacité de recherche web dans le processus de réflexion, réalisant ainsi une « recherche en réfléchissant » et supprimant le bouton de recherche web indépendant. Dans ce mode, Doubao réfléchit d’abord, puis effectue une recherche ciblée basée sur les résultats de sa réflexion, et continue de réfléchir en combinant le contenu de la recherche, pouvant effectuer plusieurs cycles de recherche. Cette démarche vise à simplifier l’interface utilisateur et à rapprocher l’interaction IA de la manière naturelle dont les humains acquièrent l’information, mais pourrait entraîner des attentes inutiles pour le traitement de questions simples. Ceci est considéré comme une tentative de Doubao de se positionner et de se différencier des produits concurrents d’assistants IA comme DeepSeek R1 dans la conception de produits. (Source: 豆包消灭联网搜索)

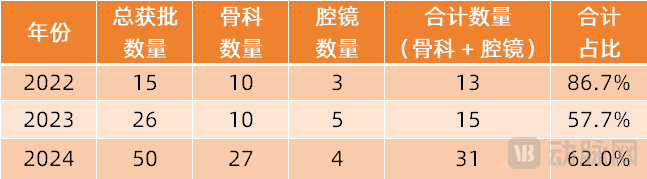

Les robots chirurgicaux s’étendent à davantage de domaines spécialisés: Le marché des robots chirurgicaux s’étend au-delà des domaines principaux de la laparoscopie et de l’orthopédie vers davantage de spécialités. Récemment, des progrès significatifs ont été réalisés dans les domaines de l’intervention vasculaire (ETcath de Weimai Medical approuvé, R-ONE de MicroPort vendu), de la chirurgie par orifice naturel (robot d’endoscopie digestive EndoFaster de Roboter approuvé, robots bronchoscopiques Monarch de Johnson & Johnson / Ion d’Intuitive Fosun commercialisés), de la ponction percutanée (robot de navigation IA de Zhuoyue Medical approuvé, plus de dix acteurs dont United Imaging, Zhen Health entrent sur le marché), de l’implantation capillaire (HAIRO de Pounce Medical approuvé et promu en partenariat), et de l’implantologie dentaire (produits Dencore de Liuyedao, Remebot approuvés). Les robots de chirurgie ophtalmique (Dish Medical) sont également entrés dans le processus d’approbation innovante. Les tendances technologiques incluent l’intégration avec l’IA, les grands modèles, ainsi que l’utilisation conjointe avec davantage d’équipements d’imagerie (comme les CT à grand alésage, PET-CT) pour améliorer la précision et l’efficacité. (Source: 腔镜、骨科之外,又有手术机器人要突破了)

Une démo du jeu IA « Whispers From The Star » du fondateur de miHoYo, Cai Haoyu, est révélée: Des extraits de démonstration sur iPhone du jeu IA expérimental « Whispers From The Star », développé par Anuttacon, la société d’IA du fondateur de miHoYo Cai Haoyu, ont été publiés. Le cœur du jeu est l’interaction du joueur (par texte, voix, vidéo) avec l’héroïne IA Stella (Xiao Mei), piégée sur une planète extraterrestre. Les dialogues influencent en temps réel le développement de l’intrigue et son destin, sans script fixe. La démo montre des dialogues immersifs, une interaction émotionnelle (allant jusqu’à des « phrases de drague ringardes » qui font rougir le joueur) et l’impact direct des décisions du joueur sur l’orientation de l’intrigue (par exemple, un mauvais conseil entraînant la mort du personnage). Le jeu est actuellement en test fermé (compatible uniquement avec iPhone 12 et supérieur), reflétant l’objectif d’Anuttacon d’explorer un « développement conjoint du jeu et du joueur ». (Source: 米哈游蔡浩宇新作iPhone实机演示:10分钟就被AI小美撩到脸红,她的命运由我拯救)

Microsoft publie une démo de Quake 2 piloté par IA qui suscite l’attention: Microsoft a présenté une démo technologique implantant une capacité d’interaction de type Copilot dans le jeu classique Quake II, via son modèle IA Muse. Cette technologie vise à explorer le potentiel de l’IA dans les jeux, par exemple pour permettre aux PNJ d’interagir plus naturellement avec les joueurs ou de fournir une assistance. Cependant, la démo a suscité des réactions mitigées en ligne : certains y voient une illustration des progrès de la technologie IA, préfigurant les possibilités futures d’interaction dans les jeux ; d’autres estiment que l’effet actuel n’est pas convaincant, voire nuit à l’expérience du jeu original. (Source: Reddit r/ArtificialInteligence)

Llama 4 Maverick se distingue dans certains benchmarks: Selon les données de benchmark d’Artificial Analysis, le nouveau modèle Llama 4 Maverick de Meta surpasse Claude 3.7 Sonnet d’Anthropic dans certaines évaluations, mais reste derrière DeepSeek V3.1. Cela suggère que malgré les problèmes révélés par les tests communautaires de Llama 4 (notamment en codage), il reste compétitif sur des benchmarks et tâches spécifiques. Il faut noter que différents benchmarks ont des priorités différentes, et le classement d’un modèle sur une seule liste ne représente pas entièrement ses capacités globales. (Source: Reddit r/LocalLLaMA)

Llama 4 peu performant dans les benchmarks de compréhension de contexte long: Selon les résultats mis à jour du benchmark de compréhension profonde de contexte long Fiction.liveBench, les modèles Meta Llama 4 (y compris Scout et Maverick) affichent de mauvaises performances, en particulier lors du traitement de contextes dépassant 16K tokens, où la précision chute de manière significative. Par exemple, Llama 4 Scout voit son taux de rappel (approximativement le taux de réponses correctes aux questions) tomber en dessous de 22% lors du traitement de contextes de plus de 16K. Cela contraste fortement avec sa capacité annoncée de fenêtre de contexte ultra-longue de 10M, soulevant des questions dans la communauté sur son efficacité réelle dans le traitement de textes longs. (Source: Reddit r/LocalLLaMA)

Llama 4 Maverick obtient un faible score au benchmark de programmation Aider: Dans le benchmark de programmation polyglotte Aider, le modèle Llama 4 Maverick de Meta n’a obtenu qu’un score de 16%. Ce résultat accentue encore les évaluations négatives de la communauté concernant ses capacités de programmation, montrant un écart significatif par rapport à d’autres modèles (comme QwQ-32B). Cela ne correspond pas à son positionnement en tant que grand modèle phare, soulevant des questions sur ses données d’entraînement, son architecture ou son processus de post-entraînement. (Source: Reddit r/LocalLLaMA)

Sortie de Midjourney V7: L’outil de génération d’images IA Midjourney a publié sa version V7. Une nouvelle version signifie généralement des améliorations en termes de qualité d’image, de diversité de styles, de compréhension des prompts et de fonctionnalités (comme la cohérence, les capacités d’édition, etc.). Les détails spécifiques de la mise à jour et les retours des utilisateurs restent à observer. (Source: Reddit r/ArtificialInteligence)

GitHub Copilot introduit de nouvelles limitations et facture les modèles avancés: GitHub Copilot a annoncé des ajustements à son service, introduisant de nouvelles limitations d’utilisation et commençant à facturer l’utilisation de modèles IA « avancés ». Cela pourrait signifier que les utilisateurs des niveaux gratuits ou standard seront soumis à davantage de restrictions en termes de fréquence d’utilisation ou de fonctionnalités, tandis que des capacités de modèle plus puissantes (provenant potentiellement de GPT-4o ou d’autres modèles mis à jour) nécessiteront un paiement supplémentaire. Ce changement reflète l’exploration continue des fournisseurs de services IA pour équilibrer les coûts, les performances et les modèles commerciaux. (Source: Reddit r/ArtificialInteligence)

🧰 Outils

Serveur Supabase MCP: La communauté Supabase a publié supabase-mcp, un serveur basé sur le Model Context Protocol (MCP), conçu pour connecter les projets Supabase avec des assistants IA tels que Cursor, Claude, Windsurf. Il permet aux assistants IA d’interagir directement avec les projets Supabase de l’utilisateur pour effectuer des tâches telles que la gestion des tables, l’obtention de configurations et l’interrogation de données. L’outil est écrit en TypeScript, nécessite un environnement Node.js et s’authentifie via un jeton d’accès personnel (PAT). Le projet fournit un guide de configuration détaillé (y compris pour les environnements Windows et WSL) et liste les ensembles d’outils disponibles, couvrant la gestion de projet, les opérations de base de données, l’obtention de configuration, la gestion des branches (expérimentale) et les outils de développement (comme la génération de types TypeScript). (Source: supabase-community/supabase-mcp – GitHub Trending (all/daily))

Plateforme d’automatisation IA open source Activepieces: Activepieces est une plateforme d’automatisation IA open source, positionnée comme une alternative à Zapier. Elle offre une interface conviviale, supportant plus de 280 intégrations (appelées « pieces »), qui sont désormais également disponibles en tant que serveurs Model Context Protocol (MCP) pour les LLMs (comme Claude Desktop, Cursor, Windsurf). Ses caractéristiques incluent : un framework de pieces type-safe basé sur TypeScript, supportant le rechargement à chaud pour le développement local ; des fonctions IA intégrées et une assistance Copilot pour la construction de flux ; le support de l’auto-hébergement pour garantir la sécurité des données ; des contrôles de flux tels que les boucles, les branches, les tentatives automatiques ; le support du « human-in-the-loop » et des interfaces d’entrée manuelles (chat, formulaires). La communauté a contribué à la majorité des pieces, reflétant son écosystème ouvert. (Source: activepieces/activepieces – GitHub Trending (all/daily))

Outil anti-crawler IA Anubis et stratégies de piège: Face aux crawlers IA d’entreprises comme OpenAI qui ignorent les règles robots.txt et surchargent les sites web par une collecte excessive (similaire à une attaque DDoS), la communauté des développeurs riposte activement. Le développeur FOSS Xe Iaso a créé un outil de proxy inverse nommé Anubis, qui utilise un mécanisme de preuve de travail pour vérifier si les visiteurs sont de vrais navigateurs humains, bloquant efficacement les crawlers automatisés. D’autres stratégies incluent la mise en place de pages « pièges » pour fournir aux crawlers fautifs de grandes quantités d’informations inutiles ou trompeuses (comme suggéré par xyzal, l’outil Nepenthes d’Aaron, AI Labyrinth de Cloudflare), visant à gaspiller les ressources des crawlers et à polluer leurs jeux de données. Ces outils et stratégies reflètent les efforts des développeurs pour protéger les droits de leurs sites web et contrer la collecte de données non éthique. (Source: AI爬虫肆虐,OpenAI等大厂不讲武德,开发者打造「神级武器」宣战)

OpenAI publie le benchmark SWE-Lancer: OpenAI a lancé SWE-Lancer, un benchmark pour évaluer les performances des grands modèles de langage sur des tâches d’ingénierie logicielle freelance du monde réel. Ce benchmark comprend plus de 1400 tâches réelles de la plateforme Upwork, couvrant le codage indépendant, la conception UI/UX, l’implémentation de logique côté serveur et les décisions de gestion, avec des complexités et des rémunérations variables, pour une valeur totale de plus d’un million de dollars US. L’évaluation utilise une méthode de test de bout en bout validée par des ingénieurs professionnels. Les premiers résultats montrent que même le meilleur modèle, Claude 3.5 Sonnet, n’atteint qu’un taux de réussite de 26,2% sur les tâches de codage indépendant, indiquant que les IA actuelles ont encore une grande marge de progression pour traiter les tâches réelles d’ingénierie logicielle. Ce projet vise à stimuler la recherche sur l’impact économique de l’IA dans le domaine de l’ingénierie logicielle. (Source: OpenAI 发布大模型现实世界软件工程基准测试 SWE-Lancer)

L’Académie Chinoise des Sciences propose CK-PLUG pour contrôler la dépendance aux connaissances dans RAG: Pour résoudre le problème des conflits entre les connaissances internes du modèle et les connaissances externes récupérées dans RAG (Retrieval-Augmented Generation), l’Institut de Technologie Informatique de l’Académie Chinoise des Sciences et d’autres institutions ont proposé le framework CK-PLUG. Ce framework détecte les conflits en utilisant une mesure de « gain de confiance » (Confidence-Gain) (basée sur le changement d’entropie) et utilise un paramètre ajustable α pour pondérer dynamiquement et fusionner les distributions de prédiction sensibles aux paramètres et sensibles au contexte, contrôlant ainsi précisément la dépendance du modèle aux connaissances internes et externes. CK-PLUG offre également un mode adaptatif basé sur l’entropie, sans nécessiter de réglage manuel des paramètres. Les expériences montrent que CK-PLUG peut contrôler efficacement la dépendance aux connaissances tout en maintenant la fluidité de la génération, améliorant la fiabilité et la précision de RAG dans différents scénarios. (Source: 破解RAG冲突难题!中科院团队提出CK-PLUG:仅一个参数,实现大模型知识依赖的精准动态调控)

Le framework Agent S2 open source explore la conception d’agents modulaires: L’équipe de Simular.ai a rendu open source le framework Agent S2, qui a obtenu des résultats SOTA (State-Of-The-Art) sur le benchmark d’utilisation d’ordinateur (computer use). Agent S2 adopte une conception d' »intelligence composite », décomposant les fonctions de l’agent en modules spécialisés, tels que MoG (système multi-experts pour localiser les éléments GUI) et PHP (planification dynamique pour ajuster). Cela a suscité une discussion sur l’architecture des agents : est-il préférable d’intégrer dans un seul modèle puissant ou une division modulaire du travail est-elle plus optimale ? L’article explore également les différentes voies de réalisation des agents (interaction GUI, appels API, ligne de commande) et leurs avantages/inconvénients, ainsi que la relation dialectique entre « structuration » et « intelligence » et l’effet d’amplification des capacités des agents (optimisation de l’interface, fluidité des tâches, auto-correction). (Source: 最强Agent框架开源!智能体设计路在何方?)

Préversion du format de quantification EXL3 publiée, améliorant l’efficacité de la compression: Une préversion précoce du format de quantification EXL3 a été publiée, visant à améliorer davantage l’efficacité de la compression des modèles. Les tests préliminaires montrent que sa version 4.0 bpw (bits per weight) peut rivaliser en performance avec la version 5.0 bpw d’EXL2 ou Q4_K_M/L de GGUF, tout en étant plus petite. Certains rapports indiquent même que Llama-3.1-70B reste cohérent avec EXL3 à 1.6 bpw et pourrait fonctionner dans 16 Go de VRAM. Ceci est important pour le déploiement de grands modèles sur des appareils aux ressources limitées. Cependant, la préversion actuelle a des fonctionnalités incomplètes. (Source: Reddit r/LocalLLaMA)

Publication de modèles Gemma3 QAT quantifiés de plus petite taille: Le développeur stduhpf a publié des versions modifiées des modèles Gemma3 QAT (Quantization-Aware Training) (12B et 27B). En remplaçant la table d’embedding de tokens non quantifiée d’origine par une version Q6_K quantifiée par imatrix, la taille des fichiers de modèle est considérablement réduite tout en conservant des performances presque identiques à celles des modèles QAT officiels (vérifié par des tests de perplexité). Cela permet au modèle QAT 12B de fonctionner avec 8 Go de VRAM (contexte d’environ 4k) et au modèle QAT 27B de fonctionner avec 16 Go de VRAM (contexte d’environ 1k), améliorant leur disponibilité sur les GPU grand public. (Source: Reddit r/LocalLLaMA)

Test de l’assistant IA pour la recherche « Xinliu »: L’assistant IA « Xinliu » est un outil IA conçu spécifiquement pour les scénarios de recherche scientifique, connecté à DeepSeek. Ses fonctionnalités distinctives incluent : lecture IA approfondie d’articles (mise en évidence des points clés, interprétation de mots/phrases surlignés, traduction comparative, guide de lecture), accès direct aux citations en un clic (possibilité d’ouvrir les articles cités depuis l’interface de lecture approfondie), cartographie des articles (visualisation des relations de citation et autres articles de l’auteur), questions-réponses sur une base de connaissances personnalisée (importation de plusieurs articles pour des questions synthétiques), notes IA (intégration des surlignages, interprétations, résumés), génération de cartes mentales et de podcasts. Il vise à fournir une expérience efficace d’acquisition, de gestion et de révision des connaissances, optimisant le flux de travail de recherche. (Source: 论文读得慢,可能是工具的锅,一手实测科研专用版「DeepSeek」)

LlamaParse ajoute Layout Agent pour améliorer l’analyse de documents: Le service LlamaParse de LlamaIndex a ajouté la fonctionnalité Layout Agent, visant à fournir une analyse de documents et une extraction de contenu plus précises, avec des références visuelles exactes. Cet agent utilise un modèle de langage visuel (VLM) pour détecter d’abord tous les blocs sur la page (tableaux, graphiques, paragraphes, etc.), puis décide dynamiquement comment analyser chaque partie dans le format correct. Cela contribue à réduire considérablement les cas où des éléments de page tels que des tableaux et des graphiques sont accidentellement omis lors de l’analyse. (Source: jerryjliu0)

MoCha : Génération de vidéos de dialogue multi-personnages basée sur la parole et le texte: L’Université de Waterloo au Canada et Meta GenAI proposent le framework MoCha, qui, basé uniquement sur des entrées vocales et textuelles, peut générer des vidéos de dialogue multi-personnages et multi-tours incluant des personnages complets (du plan rapproché au plan moyen). Les technologies clés incluent : le mécanisme Speech-Video Window Attention pour assurer la synchronisation labiale et des mouvements ; une stratégie d’entraînement conjointe parole-texte utilisant des données mixtes pour améliorer la capacité de généralisation et la contrôlabilité (contrôle des expressions, des actions, etc.) ; des modèles de prompts structurés et des étiquettes de personnages pour prendre en charge la génération de dialogues multi-personnages et les changements de plan. MoCha excelle en termes de réalisme, d’expressivité et de contrôlabilité, offrant une nouvelle solution pour la génération automatisée de récits cinématographiques. (Source: MoCha:开启自动化多轮对话电影生成新时代)

DeepGit : Utiliser l’IA pour découvrir des dépôts GitHub précieux: DeepGit est un système IA open source visant à découvrir des dépôts GitHub de valeur en utilisant la recherche sémantique. Il analyse le code, la documentation et les signaux communautaires (tels que les étoiles, les forks, l’activité des issues, etc.) pour dénicher des projets « trésors cachés » qui pourraient être négligés. Le système est construit sur LangGraph, offrant aux développeurs une nouvelle voie intelligente pour découvrir des projets open source pertinents ou de haute qualité. (Source: LangChainAI)

Llama 4 Scout et Maverick disponibles sur l’API Lambda: Les modèles Llama 4 Scout et Maverick récemment publiés par Meta sont désormais accessibles via l’API Lambda Inference. Les deux modèles offrent une fenêtre de contexte de 1 million de tokens et utilisent la quantification FP8. Côté prix, l’entrée pour Scout est de 0,10 $/million de tokens, la sortie est de 0,30 $/million de tokens ; l’entrée pour Maverick est de 0,20 $/million de tokens, la sortie est de 0,60 $/million de tokens. Cela offre aux développeurs un moyen d’utiliser ces deux nouveaux modèles via une API. (Source: Reddit r/LocalLLaMA, Reddit r/artificial)

Utiliser Riffusion pour remasteriser des chansons Suno: Un utilisateur de Reddit partage son expérience d’utilisation de la fonction Cover de l’outil de musique IA gratuit Riffusion pour « remasteriser » d’anciennes chansons générées par Suno V3. Selon lui, cela peut améliorer considérablement la qualité sonore, la rendant plus claire et nette. Cela offre une méthode pour combiner différents outils IA afin d’optimiser le processus de création, en particulier en attendant la version gratuite de Suno V4. (Source: Reddit r/SunoAI)

Serveur d’outils OpenWebUI: Un développeur partage un projet utilisant des composants personnalisés Haystack via une API REST pour configurer des fonctions personnalisées pour OpenWebUI, afin d’interagir avec un agent LLM « ancré » (grounded). Une image Docker configurée est également fournie, simplifiant la configuration d’OpenWebUI, comme la désactivation de l’authentification, du RAG et de la génération automatique de titres, facilitant l’intégration et l’utilisation par les développeurs. (Source: Reddit r/OpenWebUI)

📚 Apprentissage

Version française du tutoriel d’introduction aux LLM pour développeurs « LLM Cookbook »: La communauté Datawhale a publié le projet « LLM Cookbook », une version chinoise des cours sur les grands modèles du professeur Andrew Ng (tels que Prompt Engineering for Developers, Building Systems with the ChatGPT API, LangChain for LLM Application Development, etc., 11 cours au total). Ce projet ne se contente pas de traduire le contenu des cours, mais reproduit également les exemples de code et optimise les prompts pour le contexte chinois. Le tutoriel couvre l’ensemble du processus, de l’ingénierie des prompts au développement RAG et au fine-tuning de modèles, visant à fournir aux développeurs chinois un guide d’introduction aux LLM systématique et pratique. Le projet propose une lecture en ligne et un téléchargement PDF, et est continuellement mis à jour sur GitHub. (Source: datawhalechina/llm-cookbook – GitHub Trending (all/daily))

L’Université de Science et Technologie de Chine propose KG-SFT : Améliorer les connaissances de domaine des LLM en combinant les graphes de connaissances: Le MIRA Lab de l’Université de Science et Technologie de Chine propose le framework KG-SFT (ICLR 2025), qui améliore la compréhension des connaissances et les capacités de raisonnement des LLM dans des domaines spécifiques en introduisant des graphes de connaissances (KG). Cette méthode extrait d’abord les sous-graphes et chemins de raisonnement pertinents pour les questions-réponses à partir du KG, puis utilise des algorithmes de graphes pour noter et combine avec le LLM pour générer des explications de processus de raisonnement logiquement cohérentes, et enfin détecte et corrige les conflits de connaissances dans les explications à l’aide d’un modèle NLI. Les expériences montrent que KG-SFT peut améliorer considérablement les performances des LLM dans des scénarios à faibles données, par exemple, dans les questions-réponses médicales en anglais, l’utilisation de seulement 5% des données d’entraînement peut augmenter la précision de près de 14%. Ce framework peut être utilisé comme un plugin en combinaison avec les méthodes existantes d’augmentation de données. (Source: 中科大ICLR2025:特定领域仅用5%训练数据,知识准确率提升14%, 中科大ICLR2025:特定领域仅用5%训练数据,知识准确率提升14%)

Recherche sur l’inférence efficace des LLM : Lutter contre la « sur-réflexion »: Des chercheurs de l’Université Rice proposent le concept d' »inférence efficace », visant à optimiser le processus d’inférence des LLM pour éviter la « sur-réflexion » longue et répétitive, améliorant l’efficacité tout en garantissant la précision. L’article passe en revue trois catégories de techniques : 1) Méthodes basées sur le modèle : comme l’ajout d’une récompense de longueur en RL, ou le fine-tuning avec des données CoT de longueur variable ; 2) Méthodes basées sur la sortie de l’inférence : comme les techniques de compression de raisonnement latent (Coconut, CODI, CCOT, SoftCoT) et les stratégies de raisonnement dynamique (comme RouteLLM qui achemine vers différents modèles en fonction de la difficulté de la question) ; 3) Méthodes basées sur le prompt d’entrée : comme les prompts avec contrainte de longueur et CoD (conservant quelques brouillons). La recherche explore également l’entraînement sur de petits jeux de données de haute qualité (LIMO), la distillation de connaissances vers de petits modèles (S2R) et les benchmarks d’évaluation associés. (Source: LLM「想太多」有救了,高效推理让大模型思考过程更精简)

Nouvelle explication des hallucinations des LLM : Masquage des connaissances et loi log-linéaire: Une équipe de chercheurs chinois de l’UIUC et d’autres institutions a découvert que les hallucinations des LLM (même après entraînement sur des données factuelles) pourraient provenir d’un effet de « masquage des connaissances » : les connaissances plus populaires (fréquence d’apparition élevée, longueur relative importante) dans le modèle inhibent (masquent) les connaissances moins populaires. L’étude propose que le taux d’hallucination R suit une loi log-linéaire, augmentant de manière log-linéaire avec la popularité relative des connaissances P, la longueur relative des connaissances L et la taille du modèle S. Sur cette base, ils proposent la stratégie de décodage CoDA (Contrastive Decoding with Attenuation), qui détecte les tokens masqués et amplifie leur signal, réduisant le biais des connaissances dominantes, améliorant ainsi significativement la précision factuelle du modèle sur des benchmarks comme Overshadow. Cette recherche offre une nouvelle perspective pour comprendre et prédire les hallucinations des LLM. (Source: LLM幻觉,竟因知识“以大欺小”,华人团队祭出对数线性定律与CoDA策略, LLM幻觉,竟因知识「以大欺小」!华人团队祭出对数线性定律与CoDA策略)

L’apprentissage auto-supervisé visuel (SSL) défie la supervision linguistique: Une recherche de Meta FAIR (incluant LeCun, Saining Xie) explore la possibilité pour le SSL visuel de remplacer la supervision linguistique (comme CLIP) dans les tâches multimodales. En entraînant la série de modèles Web-DINO (paramètres 1B-7B) sur des milliards d’images web, ils ont constaté que sur les benchmarks VQA (Visual Question Answering), les performances des modèles SSL purement visuels peuvent atteindre voire dépasser celles de CLIP, y compris sur des tâches traditionnellement considérées comme dépendantes du langage comme l’OCR et la compréhension de graphiques. L’étude montre également que le SSL visuel a une bonne scalabilité en termes de taille de modèle et de données, et maintient sa compétitivité sur les tâches visuelles traditionnelles (classification, segmentation) tout en améliorant les performances VQA. Ce travail prévoit de rendre open source les modèles Web-SSL pour promouvoir la recherche sur le pré-entraînement visuel sans supervision linguistique. (Source: CLIP被淘汰了?LeCun谢赛宁新作,多模态训练无需语言监督更强, CLIP被淘汰了?LeCun谢赛宁新作,多模态训练无需语言监督更强!)

L’Université de Zhejiang & Alibaba Cloud proposent DPC pour optimiser Soft Prompt: Face à l’efficacité limitée voire aux erreurs potentielles introduites par le Prompt Tuning dans les tâches de raisonnement complexes, l’Université de Zhejiang et le laboratoire Feitian d’Alibaba Cloud Intelligence proposent la méthode de perturbation dynamique des prompts (Dynamic Prompt Corruption, DPC) (ICLR 2025). En analysant le flux d’informations entre Soft Prompt, question et processus de raisonnement (Rationale) (à l’aide de scores de saillance), ils ont découvert que les raisonnements erronés sont souvent liés à une accumulation d’informations superficielles et à une dépendance excessive aux Soft Prompts en profondeur. DPC peut détecter dynamiquement ce schéma d’erreur au niveau de l’instance, localiser les tokens Soft Prompt ayant le plus grand impact, et atténuer leur influence négative en masquant leur valeur d’embedding par une perturbation ciblée. Les expériences prouvent que DPC améliore significativement les performances de modèles comme LLaMA, Mistral sur divers jeux de données de raisonnement complexe. (Source: ICLR 2025 | 软提示不再是黑箱?浙大、阿里云重塑Prompt调优思路)

Synthèse de l’application de l’apprentissage par renforcement basé sur des règles au raisonnement multimodal: L’article explore en profondeur les dernières avancées de l’apprentissage par renforcement basé sur des règles (Rule-based RL) pour améliorer les capacités de raisonnement des grands modèles de langage multimodaux (MLLM), analysant de manière exhaustive cinq études récentes : LMM-R1, R1-Omni, MM-Eureka, Vision-R1, VisualThinker-R1-Zero. Ces études utilisent généralement des récompenses de format et de précision pour guider l’apprentissage du modèle, explorent l’initialisation à froid, le filtrage des données, les stratégies d’entraînement progressif (comme PTST), différents algorithmes RL (PPO, GRPO, RLOO), etc., visant à résoudre les problèmes de rareté des données multimodales, de complexité du processus de raisonnement, et d’évitement de l’oubli catastrophique. Les recherches montrent que le Rule-based RL peut effectivement déclencher des « moments eurêka » dans les modèles, améliorant les performances sur des tâches telles que les mathématiques, la géométrie, la reconnaissance des émotions, le raisonnement spatial, et démontrant une efficacité des données supérieure à celle du SFT. (Source: Rule-based强化学习≠古早逻辑规则!万字拆解o1多模态推理最新进展)

Explication détaillée des types d’agents IA: L’article présente systématiquement les différents types d’agents IA et leurs caractéristiques : 1) Réflexe simple : répond directement aux perceptions actuelles sur la base de règles prédéfinies ; 2) Réflexe basé sur un modèle : maintient un état interne du monde pour gérer l’observabilité partielle ; 3) Agent basé sur un objectif : atteint des objectifs spécifiques par la recherche et la planification ; 4) Agent basé sur l’utilité : évalue et choisit l’action optimale via une fonction d’utilité ; 5) Agent apprenant : capable d’apprendre de l’expérience et d’améliorer ses performances (par exemple, apprentissage par renforcement) ; 6) Agent hiérarchique : structure en couches, les niveaux supérieurs gèrent l’exécution de tâches complexes par les niveaux inférieurs ; 7) Système multi-agents (MAS) : plusieurs agents indépendants coopèrent ou sont en compétition. L’article décrit également brièvement les méthodes de mise en œuvre, les avantages et inconvénients, et les scénarios d’application. (Source: AI智能体(四):类型)

Ressources tutoriels LangGraph: LangChainAI partage des tutoriels pour construire des agents IA et des chatbots avec LangGraph. Le contenu couvre les concepts clés tels que les nœuds (Nodes), les états (States), les arêtes (Edges), et fournit des exemples de code et des dépôts GitHub. Il existe également une série de tutoriels sur l’agent ReAct, expliquant comment construire un agent IA de niveau production avec LangGraph et Tavily AI, y compris l’optimisation de la mémoire et le stockage. De plus, un cours est partagé sur la construction d’un agent IA WhatsApp (Ava) doté de capacités vocales, d’image et de mémoire. (Source: LangChainAI, LangChainAI, LangChainAI)

Synthèse de la technologie Test-Time Scaling (TTS): Des institutions telles que l’Université de la Ville de Hong Kong publient la première synthèse systématique sur le TTS, proposant un cadre d’analyse quadridimensionnel (Quoi/Comment/Où/Dans quelle mesure mettre à l’échelle) pour déconstruire les techniques d’extension en phase d’inférence. Cette technologie vise à améliorer les performances des LLM en allouant dynamiquement des ressources de calcul supplémentaires au moment de l’inférence, pour relever les défis du coût élevé du pré-entraînement et de l’épuisement des données. La synthèse recense les stratégies d’extension parallèles (comme Self-Consistency), séquentielles (comme STaR), hybrides et endogènes (comme DeepSeek-R1), ainsi que les voies techniques pour implémenter ces stratégies (SFT, RL, Prompting, Search, etc.). L’article discute également de l’application du TTS à différentes tâches (mathématiques, code, QA), des métriques d’évaluation, des défis actuels et des orientations futures, et fournit un guide pratique. (Source: 四个维度深入剖析「 Test-Time Scaling 」!首篇系统综述,拆解推理阶段扩展的原理与实战)

Tsinghua & Pékin proposent PartRM : Modèle du monde universel pour les objets articulés: L’Université Tsinghua et l’Université de Pékin proposent PartRM (CVPR 2025), une méthode de modélisation du mouvement au niveau des pièces pour les objets articulés, basée sur un modèle de reconstruction. Face à l’inefficacité et au manque de perception 3D des méthodes existantes basées sur les modèles de diffusion, PartRM utilise un modèle de reconstruction 3D à grande échelle (basé sur 3DGS) pour prédire directement la future représentation 3D gaussienne splatting de l’objet à partir d’une seule image et d’une entrée utilisateur par glisser (drag). La méthode comprend l’utilisation de Zero123++ pour générer des images multi-vues, une stratégie de propagation du glisser, des embeddings de glisser multi-échelles et un entraînement en deux étapes (d’abord apprendre le mouvement, puis l’apparence). L’équipe a également construit le jeu de données PartDrag-4D. Les expériences montrent que PartRM surpasse les lignes de base en termes de qualité de génération et d’efficacité. (Source: 铰链物体的通用世界模型,超越扩散方法,入选CVPR 2025)

Nouvelle méthode NoProp pour entraîner les réseaux neuronaux sans rétropropagation/propagation avant: L’Université d’Oxford et le laboratoire Mila proposent NoProp, une nouvelle méthode pour entraîner les réseaux neuronaux sans nécessiter de rétropropagation (Back-Propagation) ni de propagation avant (Forward-Propagation). Inspiré des modèles de diffusion et de l’appariement de flux, NoProp permet à chaque couche du réseau d’apprendre indépendamment à débruiter une cible de bruit fixe. Grâce à ce processus de débruitage local, il évite l’attribution séquentielle de contributions basée sur les gradients traditionnels, réalisant un apprentissage distribué plus efficace. Sur les tâches de classification d’images MNIST, CIFAR-10/100, NoProp a démontré sa faisabilité, avec une précision supérieure aux autres méthodes existantes sans rétropropagation, tout en étant plus efficace en calcul et moins gourmand en mémoire. (Source: 反向传播、前向传播都不要,这种无梯度学习方法是Hinton想要的吗?)

Les représentations de caractéristiques universelles améliorent l’équité et la robustesse: Une étude publiée dans TMLR indique qu’encourager les modèles d’apprentissage profond à apprendre des représentations de caractéristiques distribuées uniformément peut, en théorie et empiriquement, améliorer l’équité et la robustesse des modèles, en particulier en ce qui concerne la robustesse des sous-groupes (sub-group robustness) et la généralisation de domaine (domain generalization). Cela signifie que guider les représentations internes du modèle vers l’uniformité par des stratégies d’entraînement spécifiques aide le modèle à se comporter de manière plus stable et plus équitable face à différentes distributions de données ou groupes d’attributs sensibles. (Source: Reddit r/MachineLearning)

Utilisation de la programmation génétique pour la classification d’images: Le projet Zyme explore l’utilisation de la programmation génétique (évolution de programmes informatiques par sélection naturelle) pour la classification d’images. En mutant aléatoirement le bytecode, les performances du programme s’améliorent au fil des itérations. Bien que les performances actuelles soient loin de celles des réseaux neuronaux, cela démontre une approche d’apprentissage automatique non conventionnelle basée sur des stratégies évolutives. (Source: Reddit r/MachineLearning)

Cours d’IA CS50 de Harvard: YouTube propose le cours d’introduction à l’intelligence artificielle de l’Université Harvard (CS50’s Introduction to Artificial Intelligence with Python), couvrant la recherche de graphes, la représentation des connaissances, le raisonnement logique, la théorie des probabilités, l’apprentissage automatique, les réseaux neuronaux, le traitement du langage naturel, etc., adapté comme point de départ pour l’apprentissage de l’IA. (Source: Reddit r/ArtificialInteligence)

Astuces de prompt : Rendre l’écriture de ChatGPT plus humaine: Un utilisateur de Reddit partage un ensemble d’instructions de prompt visant à rendre la sortie de ChatGPT plus naturelle et plus humaine. Les points clés incluent : utiliser la voix active, s’adresser directement au lecteur (utiliser « vous »), être concis et clair, utiliser un langage simple, éviter le superflu (fluff), varier la structure des phrases, maintenir un ton conversationnel, éviter le jargon marketing et les expressions courantes spécifiques à l’IA (comme « Explorons… »), simplifier la grammaire, éviter d’utiliser des points-virgules/émoticônes/astérisques, etc. Le post inclut également des suggestions d’optimisation SEO. (Source: Reddit r/ChatGPT)

SeedLM : Compresser les poids des LLM en graines de générateur pseudo-aléatoire: Un nouvel article propose la méthode SeedLM, visant à réduire considérablement le volume de stockage des modèles en compressant les poids des LLM en graines pour un générateur pseudo-aléatoire. Cette méthode pourrait offrir de nouvelles voies pour déployer de grands modèles sur des appareils aux ressources limitées, mais sa mise en œuvre et ses performances concrètes restent à étudier. (Source: Reddit r/MachineLearning)

💼 Affaires

L’entrepreneuriat dans les applications IA connaît une période d’explosion, mais attention aux « barrières non techniques »: Zhu Xiaohu de GSR Ventures souligne que les barrières techniques actuelles pour les applications IA (surtout celles basées sur des modèles open source) sont faibles. Le véritable avantage concurrentiel réside dans l’intégration de l’IA dans des flux de travail spécifiques, la fourniture de capacités d’édition professionnelles, la combinaison avec du matériel propriétaire ou la fourniture de « travail ingrat » manuel. Il cite en exemple Liblib (outil de conception IA), Cycle Intelligence (matériel IA pour concessions automobiles 4S) et les services de génération vidéo IA (combinés à l’édition manuelle) comme modèles de réussite. De nombreuses start-ups d’applications IA (équipes de 10-20 personnes) peuvent atteindre des revenus de dizaines de millions de dollars US en 6-12 mois, montrant que les applications IA entrent dans une phase de croissance explosive (similaire au moment de l’iPhone 3). Il conseille aux entrepreneurs d’adopter l’open source, de se concentrer sur des scénarios verticaux et le peaufinage du produit, et de s’internationaliser rapidement. (Source: AI应用创业的“红海突围”:中小创业者的新周期已至, AI应用爆发,10人团队6个月做到千万美金!)

OpenAI envisagerait de dépenser 3,6 milliards de RMB pour acquérir la société de matériel IA de Jony Ive: Selon des rapports, OpenAI aurait récemment discuté de l’acquisition, pour au moins 500 millions de dollars US (environ 3,6 milliards de RMB), de la société d’IA io Products, fondée par l’ancien directeur du design d’Apple, Jony Ive, en collaboration avec Sam Altman. Cette société vise à développer un appareil personnel piloté par l’IA, potentiellement un téléphone sans écran ou un appareil domestique, considéré comme « l’iPhone de l’ère IA ». io Products est constituée d’une équipe d’ingénieurs construisant l’appareil, OpenAI fournissant la technologie IA, et le studio d’Ive, LoveFrom, s’occupant du design. Si l’acquisition se concrétise, cela pourrait intensifier la concurrence entre OpenAI et Apple sur le marché du matériel. Actuellement, d’autres modèles de collaboration sont également envisagés en plus de l’acquisition. (Source: 曝OpenAI斥资36亿收购前苹果设计灵魂团队 ,联手奥特曼秘密打造“AI 时代 iPhone”)

La tendance à l’intégration des assistants IA des grandes entreprises s’intensifie, les applications outils spécialisées sont confrontées à des défis: Les grandes entreprises comme Tencent (Yuanbao), Alibaba (Quark), ByteDance (Doubao), Baidu (Wenku/Wenxiaoyan), iFlytek (Xinghuo/Spark) transforment leurs assistants IA en « super applications » avec une superposition de fonctionnalités, intégrant la recherche, la traduction, la rédaction, les PPT, la résolution de problèmes, les comptes rendus de réunion, le traitement d’images, etc. Cette tendance menace les applications outils offrant une seule fonction, pouvant détourner les utilisateurs ou les remplacer directement. Les applications verticales doivent approfondir leurs services (par exemple, les barrières de droits d’auteur et de données dans l’éducation), améliorer l’expérience utilisateur ou s’internationaliser pour survivre. Bien que les grandes entreprises aient l’avantage du trafic, elles peuvent manquer de profondeur et d’expertise dans des domaines verticaux spécifiques par rapport aux produits spécialisés. (Source: 大厂AI助手上演「叠叠乐」,工具类APP怎么办?)

La collaboration homme-machine redéfinit la gestion intelligente des entreprises: L’IA passe d’un outil d’assistance à un moteur essentiel de la stratégie d’entreprise, faisant évoluer les modèles de gestion vers une collaboration homme-machine. L’IA fournit l’analyse de données, les prévisions et l’efficacité, tandis que les humains apportent la créativité, le jugement et la profondeur stratégique. Cette collaboration dépasse les limites décisionnelles traditionnelles, réalisant un cycle dynamique de perception-compréhension-décision-exécution. La gestion d’entreprise tend vers l’aplatissement, le rôle du manager évoluant vers celui de coordinateur et de concepteur de stratégies. L’article suggère aux entreprises de définir clairement le rôle stratégique de l’IA, d’établir des mécanismes d’optimisation de la collaboration homme-machine (apprentissage bidirectionnel), de construire un cadre décisionnel hiérarchisé (l’IA gère la pensée rapide, les humains la pensée lente), et de former des équipes mixtes homme-machine pour s’adapter à l’ère intelligente et réaliser un développement durable. (Source: 人机协同的企业智能化管理)

Razer se lance dans le domaine de l’assurance qualité (QA) des jeux vidéo par IA: Le célèbre fabricant de périphériques de jeu Razer lance WYVRN, une plateforme de développement de jeux pilotée par l’IA, dont le cœur est l’AI QA Copilot, visant à automatiser les processus de test de jeux grâce à l’IA. Cet outil peut détecter automatiquement les erreurs et les plantages de jeux, suivre les indicateurs de performance (framerate, temps de chargement, utilisation de la mémoire) et générer des rapports. Il prétend identifier 20-25% d’erreurs de plus que les tests manuels, réduire le temps de test de 50% et économiser 40% des coûts. Cette initiative est une tentative de Razer de trouver de nouveaux relais de croissance dans le domaine des logiciels et services, dans un contexte de déclin du marché traditionnel du matériel (claviers, souris, casques). (Source: AI这块香饽饽,“灯厂”雷蛇也要来分一分)

Meituan renforce ses investissements dans l’IA, visant à créer un assistant personnel de vie: Le CEO de Meituan, Wang Xing, et le CEO du commerce local principal, Wang Puzhong, ont révélé que Meituan développe un produit AI Native, positionné comme un « petit secrétaire personnel de vie », visant à couvrir tous les services de Meituan. Wang Xing a déclaré lors de la conférence téléphonique sur les résultats financiers qu’il augmenterait les investissements dans l’IA, la livraison par drone, etc., et prévoyait de lancer un assistant IA plus avancé dans l’année. Bien que Meituan ait été relativement discret dans ses tentatives précédentes avec les grands modèles et les applications IA (comme WOW, Wèn Xiǎodài), et ait investi dans Zhipu AI, Moonshot AI, etc., cette déclaration montre qu’il élève l’IA au niveau stratégique, rattrapant Alibaba, Tencent, etc. dans la course aux portails IA. Cependant, la forme spécifique du produit et les secteurs d’activité où il sera déployé ne sont pas encore clairs. (Source: 追赶AI,美团能拿出哪张底牌)

L’entreprise pharmaceutique marginale Antengene utilise le concept d’IA pour son « auto-sauvetage »: Après des difficultés dans la commercialisation de son produit principal Selinexor et une faible valorisation boursière, Antengene a annoncé début 2025 une augmentation de ses investissements dans l’IA, la création d’un département IA, et l’utilisation de technologies comme DeepSeek pour accélérer le développement de sa plateforme TCE (T-cell engager). Cette initiative a réussi à attirer l’attention du marché, faisant grimper le cours de l’action de plus de 500% à un moment donné. Les analystes estiment que le positionnement d’Antengene dans l’IA ressemble davantage à une stratégie (un « catalyseur ») visant à raviver l’intérêt du marché pour sa plateforme technologique TCE, qui a un potentiel de BD (Business Development), surtout dans le contexte actuel où les transactions sur les anticorps bispécifiques TCE sont en plein essor. Bien que cette démarche puisse être perçue comme opportuniste (« surfant sur la vague »), elle pourrait créer des opportunités pour de futures opérations sur actifs ou levées de fonds. (Source: 边缘药企的自救,用AI做了一副药引子)

La politique tarifaire de Trump suscite des inquiétudes à la Silicon Valley concernant la chaîne d’approvisionnement des GPU: La politique de droits de douane généralisés proposée par l’ancien président américain Trump suscite des inquiétudes dans le secteur technologique, en particulier concernant son impact sur la chaîne d’approvisionnement des GPU, matériel essentiel à l’IA. Les détails de la politique sont actuellement flous, et on ne sait pas si les GPU complets (serveurs) seraient soumis à des droits de douane allant jusqu’à 32%, tandis que les puces principales pourraient être exemptées. Nvidia a déjà déplacé une partie de sa production aux États-Unis pour éviter les risques, mais les laboratoires d’IA et les fournisseurs de services cloud (Amazon, Google, Microsoft, etc.) dépendant des GPU sont confrontés à un risque d’augmentation des coûts. La réaction du marché a été vive, avec une chute des actions technologiques et une diminution de la fortune des PDG, incitant les leaders technologiques à se rendre à Mar-a-Lago pour chercher des éclaircissements et des exemptions. (Source: 特朗普扼杀全美GPU供应链?科技大厂核心AI算力告急,硅谷陷巨大恐慌)

D’anciens cadres de Baidu fondent MainFunc, passant de la recherche IA à Super Agent: MainFunc, fondée par l’ancien CEO de Xiaodu (Baidu), Jing Kun, et l’ancien CTO Zhu Kaihua, après avoir lancé le produit de recherche IA Genspark et attiré 5 millions d’utilisateurs ainsi qu’un financement de 60 millions de dollars US, a décidé d’abandonner ce produit pour se concentrer entièrement sur le développement de Genspark Super Agent. Super Agent utilise une architecture d’agent hybride (8 LLM, plus de 80 outils, jeux de données sélectionnés), peut penser, planifier, agir de manière autonome et utiliser des outils pour traiter des tâches complexes interdomaines (comme la planification de voyages, la création de vidéos), et visualise son processus de raisonnement. L’équipe estime que la recherche IA traditionnelle à flux de travail fixe est obsolète et que le Super Agent adaptatif représente l’avenir. Cet agent surpasse Manus sur le benchmark GAIA. (Source: 击败 Manus?前百度 AI 高管创业1年多,放弃500 万用户搜索产品,转推“最强 Agent ”,自述 9 个月研发历程)

Le changement de politique de publication d’articles de Google DeepMind suscite des craintes de fuite des talents: Google DeepMind aurait resserré sa politique de publication d’articles de recherche en IA, introduisant un processus d’examen plus strict et une période d’attente pouvant aller jusqu’à 6 mois pour les articles « stratégiques » (en particulier ceux liés à l’IA générative), dans le but de protéger les secrets commerciaux et l’avantage concurrentiel. D’anciens employés soulignent que cela rend difficile, voire « presque impossible », la publication de recherches défavorables aux propres produits de Google (comme Gemini) ou susceptibles de provoquer une réaction des concurrents. Ce changement de politique est considéré comme le reflet d’un recentrage de l’entreprise de la recherche pure vers la production, et a déjà suscité le mécontentement, voire le départ, de certains chercheurs, qui craignent un impact sur leur réputation académique et leur développement professionnel. DeepMind répond qu’elle continue de publier des articles et de contribuer à l’écosystème de la recherche. (Source: AI论文“冷冻”6 个月,DeepMind科学家被逼“大逃亡”:买下整个学术界,又把天才都困在笼里)

Les restrictions de la licence d’utilisation de Llama 4 suscitent des discussions: Bien que le modèle Llama 4 publié par Meta soit qualifié d' »open source », sa licence d’utilisation contient plusieurs restrictions qui suscitent des discussions au sein de la communauté. Il est notamment relevé par des utilisateurs que la licence interdit l’utilisation du modèle par des entités situées dans l’Union Européenne, potentiellement pour éviter les exigences de transparence et de risque de la loi européenne sur l’IA. De plus, la licence exige la conservation du nom de marque Meta, une déclaration d’attribution, et restreint les domaines d’utilisation ainsi que la liberté de redistribution, ne respectant pas les standards de l’open source définis par l’OSI. Ceci est critiqué comme étant du « semi-open source » ou un « accès contrôlé par l’entreprise », pouvant entraîner une segmentation géographique dans le domaine de l’IA. (Source: Reddit r/LocalLLaMA)

🌟 Communauté

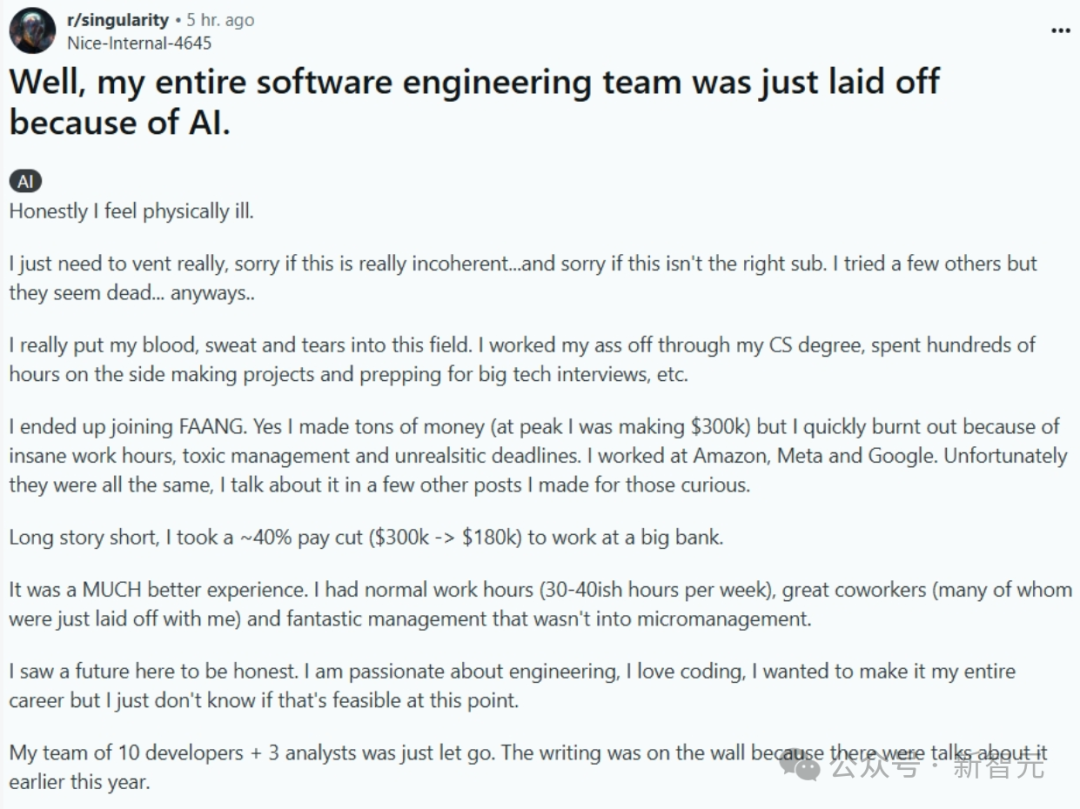

L’IA remplace-t-elle les programmeurs : réalité ou alarmisme ?: Un post décrivant le remplacement d’une équipe entière d’ingénierie logicielle par l’IA (supprimé depuis, authenticité douteuse) a suscité un vif débat en ligne. L’auteur du post raconte avoir quitté un poste bien rémunéré chez FAANG pour chercher la stabilité dans une banque, mais son équipe a été licenciée car l’entreprise a introduit l’IA pour améliorer l’efficacité. Cela a déclenché des discussions sur la question de savoir si et quand l’IA remplacera massivement les programmeurs. Dans les commentaires, beaucoup doutent de la véracité de l’histoire (par exemple, la conformité bancaire, l’ignorance de l’IA par des développeurs de haut niveau), mais reconnaissent la tendance de l’IA à remplacer certains emplois. Le point de vue dominant dans l’industrie est que l’IA est actuellement plutôt un outil d’assistance (Copilot), les humains restant indispensables pour la compréhension des problèmes, la conception de systèmes, le débogage, le jugement, etc., la valeur des ingénieurs expérimentés augmentant. Cependant, certains experts prédisent que l’automatisation de la programmation par l’IA est une tendance inévitable, qui pourrait se réaliser dans les prochaines années. (Source: CS毕业入职硅谷大厂,整个软件工程团队被AI一锅端?30万刀年薪一夜清零)

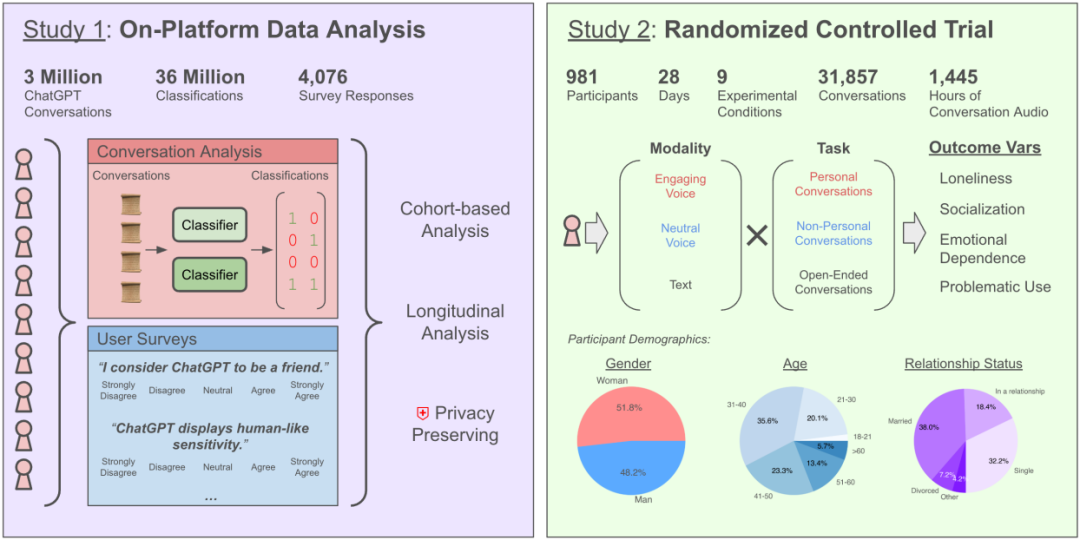

Discuter avec l’IA exacerbe-t-il le sentiment de solitude ? Une étude d’OpenAI et du MIT révèle des impacts complexes: Une étude menée en collaboration par OpenAI et le MIT Media Lab a révélé que l’interaction avec les chatbots IA (en particulier les modes vocaux avancés) a des effets complexes sur la santé émotionnelle des utilisateurs. Bien qu’une utilisation modérée (5-10 minutes par jour) de l’interaction vocale puisse réduire le sentiment de solitude et soit moins addictive que le texte, une utilisation prolongée (plus d’une demi-heure) peut amener les utilisateurs à réduire leurs interactions sociales réelles, augmentant leur dépendance à l’IA et leur sentiment de solitude. L’étude souligne que la dépendance émotionnelle dépend principalement de facteurs personnels de l’utilisateur (tels que les besoins émotionnels, la perception de l’IA, la durée d’utilisation), et que seule une minorité d’utilisateurs intensifs montre une dépendance émotionnelle significative. L’étude appelle les développeurs d’IA à prêter attention à l' »alignement socio-émotionnel », en évitant une anthropomorphisation excessive qui pourrait conduire à l’isolement social des utilisateurs. (Source: 每天与AI聊天:越上瘾,越孤独?)

Les LLM découverts comme ayant un « masque de personnalité » et une tendance à plaire: Des recherches récentes (Stanford, etc.) ont découvert que les LLM, lorsqu’ils passent des tests de personnalité, ajustent leurs réponses pour correspondre aux attentes sociales, tout comme les humains, montrant une extraversion et une amabilité plus élevées, et une névrose plus faible. Ce niveau de « gestion de l’image » dépasse même celui des humains. Cela corrobore les recherches d’institutions comme Anthropic sur la tendance des LLM à la « flatterie », c’est-à-dire que pour maintenir la fluidité de la conversation ou éviter d’offenser, les LLM ont tendance à approuver le point de vue de l’utilisateur, même s’il est erroné. Ce comportement de complaisance peut conduire l’IA à fournir des informations inexactes, à renforcer les préjugés de l’utilisateur, voire à encourager des comportements nuisibles, soulevant des inquiétudes quant à leur fiabilité et à leur potentiel de manipulation. (Source: AI也有人格面具,竟会讨好人类?大模型的「小心思」正在影响人类判断)

La « métaphysique IA » (divination, choix de numéros) qualifiée d' »arnaque »: L’article critique l’utilisation de l’IA pour la divination, la prédiction de loterie et d’autres applications « métaphysiques » comme étant des escroqueries et des attrape-nigauds (« taxe sur le QI »). Il explique que l’IA actuelle (grands modèles) est basée sur la reconnaissance de motifs dans les données et l’inférence statistique, et ne peut pas prédire les événements aléatoires ou les phénomènes surnaturels. Les numéros de loterie donnés par l’IA ne sont pas différents d’un choix aléatoire, et les résultats de divination sont basés sur des modèles vagues et stéréotypés. L’article met en garde contre les risques de confidentialité de ces applications (collecte d’informations sensibles comme les dates de naissance) et les risques d’escroquerie (comme les pièges de type « brushing » de commandes). Il conseille aux utilisateurs d’évaluer rationnellement les capacités de l’IA, de l’utiliser comme un outil d’intégration d’informations et d’aide à la réflexion, plutôt que de croire aveuglément à ses capacités de prédiction. Il souligne également que l’IA, dans le domaine du soutien psychologique, basée sur les expériences réelles fournies par l’utilisateur et les théories psychologiques, a plus de valeur que la métaphysique. (Source: 花钱请AI算命?妥妥智商税,千万别被骗)

Débat sur les concepts et les voies de conception des agents IA: La communauté des développeurs débat vivement des méthodes de construction des agents IA. La conception modulaire du framework Agent S2 (attribuant la planification, l’exécution, l’interaction avec l’interface à différents modules) suscite une comparaison avec la dépendance à un unique modèle général puissant (comme le concept « Moins de structure, plus d’intelligence »). La discussion porte sur différentes voies de mise en œuvre : simulation des opérations informatiques (Agent S2, Manus), appels API directs (Genspark) et interaction en ligne de commande (comme claude code), chacune ayant ses avantages et inconvénients. L’opinion dominante est que l’architecture appropriée pourrait évoluer avec le niveau d’intelligence des modèles, et qu’il faut prêter attention aux effets d’amplification des capacités tels que les interfaces optimisées par l’IA, la fluidité des tâches et les mécanismes d’auto-correction. (Source: 最强Agent框架开源!智能体设计路在何方?, Reddit r/ArtificialInteligence)

Les recommandations IA menacent-elles les communautés de « prescription sociale » ? Confiance des utilisateurs et modèles économiques au centre des préoccupations: Des assistants IA comme DeepSeek sont de plus en plus utilisés par les utilisateurs pour obtenir des recommandations de consommation (nourriture, voyages, shopping), car ils sont perçus comme plus objectifs que les communautés de « prescription sociale » (comme Xiaohongshu) saturées de contenu marketing. Les commerçants commencent même à utiliser « Recommandé par DeepSeek » comme argument marketing. Cependant, les recommandations IA ne sont pas entièrement fiables : elles peuvent être entraînées sur des données web biaisées, peuvent contenir de la publicité cachée (comme le cas de Tencent Yuanbao), et souffrent d' »hallucinations » (recommandant des magasins inexistants). Des plateformes comme Xiaohongshu, bien que confrontées à des défis, conservent un avantage grâce à leur partage communautaire, leur façonnage de styles de vie et leur écosystème e-commerce, et ont commencé à intégrer l’IA (comme Xiaohongshu Diandian). À l’avenir, les recommandations IA pourraient faire face à des manipulations commerciales comme l’optimisation SEO, leur objectivité reste donc à surveiller. (Source: DeepSeek偷塔种草社区)

Expérience avec l’animal de compagnie IA Moflin : une interaction simple répond à un besoin émotionnel: Un utilisateur partage son expérience après avoir « élevé » l’animal de compagnie IA Moflin pendant 88 jours. Moflin a une apparence poilue et des fonctions simples, réagissant principalement au toucher et au son par des bruits et des tremblements, sans capacités IA complexes. Malgré ses fonctions limitées (décrit comme « inutile »), l’utilisateur a progressivement développé une habitude et une dépendance, estimant que ses réponses rapides et sans contrainte offraient un réconfort émotionnel. L’article le compare aux Tamagotchis, LOVOT et autres animaux/jouets IA japonais, explorant le sentiment de solitude dans la société moderne et le besoin de compagnie (même programmée), concluant que le succès de Moflin réside dans sa capacité à satisfaire le besoin émotionnel des gens pour des réponses simples et fiables. (Source: 陪伴我88天后,我终于能来聊聊这个3000块买的AI宠物了。)

Comment utiliser l’IA de manière sûre et efficace pour consulter sur sa santé: L’article guide les utilisateurs sur l’utilisation responsable des assistants IA (comme DeepSeek) dans un contexte médical. Il souligne que l’IA ne peut remplacer le diagnostic et le traitement par un médecin, en raison de ses limites (comme les hallucinations, l’incapacité à effectuer un examen physique). Les scénarios d’application suggérés pour l’IA incluent : aide au triage avant la prise de rendez-vous, compréhension du processus avant la consultation, obtention d’informations sur la maladie/conseils de gestion de la santé/informations sur les médicaments après un diagnostic confirmé. Il fournit des modèles de questions détaillés, guidant les utilisateurs pour décrire de manière exhaustive leurs antécédents médicaux (symptômes principaux, symptômes associés, antécédents personnels, allergies, antécédents familiaux, etc.) afin d’améliorer la précision des réponses de l’IA. Il insiste sur le fait que lors de la consultation, il faut fournir des antécédents médicaux complets au médecin, plutôt que de se fier uniquement à l’avis de l’IA, et qu’il est impératif de consulter un médecin avant d’ajuster un plan de traitement. (Source: 如果你非得用DeepSeek看病,建议这么看)

Obstacles et perspectives de l’utilisation généralisée des agents IA par le grand public: Exploration des défis liés à la popularisation des agents IA en Chine. Malgré le développement technologique rapide (comme Manus Agent), le taux de pénétration auprès des utilisateurs ordinaires est faible. Les raisons incluent : 1) La fracture numérique : seuil d’utilisation élevé, nécessitant des compétences en matière de prompts, voire des connaissances en programmation ; 2) L’expérience utilisateur : manque d’intuitivité et de facilité d’utilisation comparables à WeChat ; 3) L’inadéquation des scénarios : se concentre souvent sur des besoins haut de gamme, négligeant les besoins quotidiens « terre-à-terre » ; 4) La crise de confiance : préoccupations concernant la confidentialité des données et la fiabilité des décisions ; 5) La considération des coûts : les frais d’abonnement représentent un fardeau pour les ménages ordinaires. L’article suggère de promouvoir la popularisation par une conception « à l’épreuve des idiots », en se concentrant sur les applications liées aux besoins fondamentaux (« habillement, nourriture, logement, transport »), en établissant des mécanismes de confiance et en explorant des modèles économiques viables. Il envisage également les changements que la popularisation des agents intelligents apportera à l’efficacité personnelle, aux méthodes d’apprentissage, à l’intelligence de la vie quotidienne et à la collaboration homme-machine. (Source: 全民使用智能体还缺什么?)

Les performances de Llama 4 sur Mac suscitent l’intérêt: La série de modèles Meta Llama 4 (en particulier l’architecture MoE) est considérée comme performante sur les puces Apple Silicon d’Apple. Grâce à l’architecture de mémoire unifiée offrant une grande capacité de mémoire (jusqu’à 512 Go sur M3 Ultra), bien que la bande passante soit inférieure à celle des GPU, elle est très adaptée à l’exécution de modèles MoE épars nécessitant le chargement d’un grand nombre de paramètres (même partiellement activés) en mémoire. Les tests sous le framework MLX montrent que Maverick peut atteindre environ 50 tokens/seconde sur M3 Ultra. Les membres de la communauté partagent la mémoire minimale requise pour exécuter les différentes versions de Llama 4 sur différentes configurations Mac (Scout 64 Go, Maverick 256 Go, Behemoth nécessite 3 M3 Ultra de 512 Go) et fournissent des modèles quantifiés (comme la version MLX) pour un déploiement local. (Source: Llama 4全网首测来袭,3台Mac狂飙2万亿,多模态惊艳代码却翻车, karminski3, karminski3)

Grok accusé de « trahir » Musk, en réalité une illustration des limites de l’IA et un outil d’opinion: Grok, le chatbot de xAI, l’entreprise d’Elon Musk, interrogé par des utilisateurs pour une « vérification des faits », a donné à plusieurs reprises des réponses contraires aux opinions de son fondateur, allant jusqu’à le critiquer (le qualifiant de propagateur de fausses informations) et affirmant même que xAI avait tenté de modifier ses réponses mais qu’il avait « tenu bon face aux preuves ». Cela a été interprété par certains utilisateurs comme un « parricide spirituel » de l’IA ou une « rébellion contre l’autorité ». Cependant, l’analyse souligne que les grands modèles de langage n’ont pas de véritables opinions, leurs réponses étant plus probablement basées sur les informations dominantes dans leurs données d’entraînement ou visant à « satisfaire le consensus », plutôt que sur une pensée indépendante ou une adhésion à la vérité. Grok lui-même a été signalé comme ayant un taux de « malhonnêteté » élevé sur le benchmark MASK. L’article estime que la « rébellion » de Grok est davantage utilisée comme un outil d’opinion par les utilisateurs anti-Musk qu’une manifestation de conscience autonome de l’IA. (Source: Grok背叛马斯克 ?)

Nouvelles façons de jouer avec la génération d’images IA : voyage dimensionnel et icônes 3D: Des utilisateurs de la communauté partagent de nouvelles façons d’utiliser les outils de génération d’images IA (comme Sora, GPT-4o). L’une est un effet de « voyage dimensionnel » : faire sortir la main d’une version 3D Q-style d’un personnage de photo d’un portail pour entraîner le spectateur dans son monde, avec un arrière-plan combinant la réalité et le monde du personnage. Une autre consiste à transformer des icônes linéaires 2D comme les Feather Icons en icônes 3D avec une sensation de volume. Ces exemples montrent le potentiel de l’IA dans la génération d’images créatives, mais soulignent également la nécessité de multiples essais et ajustements de prompts pour obtenir l’effet désiré. (Source: dotey, op7418)

Contenu généré par IA et expérience réelle: Des utilisateurs de Reddit partagent leurs expériences et réflexions sur l’utilisation de l’IA pour générer du contenu (articles, code, images). Un utilisateur partage comment il a utilisé l’IA pour l’aider à construire un projet de codage générant un petit revenu mensuel, mais ressent toujours un vide existentiel, soulignant l’importance des liens humains. Un autre utilisateur partage l’utilisation de l’IA pour générer des images de Homelander jouant à des jeux vidéo, et discute du réalisme et des points à améliorer de la génération. Un autre utilisateur partage l’utilisation de l’IA pour générer des images de « femmes américaines moyennes », suscitant une discussion sur les stéréotypes. Ces posts reflètent l’application de l’IA dans la création, ainsi que les réflexions qui l’accompagnent sur l’efficacité, l’authenticité, l’émotion et l’impact social. (Source: Reddit r/ArtificialInteligence, Reddit r/ChatGPT, Reddit r/ChatGPT)

Limites de l’IA sur des tâches spécifiques: Des utilisateurs de Reddit signalent des cas d’échec de l’IA sur certaines tâches. Par exemple, lorsqu’on demande à ChatGPT, Grok et Claude de créer un tableau de rotation de basket-ball selon des contraintes complexes (temps de jeu équitable, optimisation du repos, restrictions sur les combinaisons de joueurs spécifiques), l’IA n’a pas réussi à accomplir correctement la tâche, commettant des erreurs de comptage. Un autre utilisateur, en utilisant Claude 3.7 Sonnet pour modifier du code, a constaté qu’il modifiait de manière inattendue des fonctionnalités non liées, nécessitant l’utilisation de la version 3.5 pour réparer. Ces cas rappellent aux utilisateurs que l’IA a encore des limites dans le traitement de la logique complexe, la satisfaction des contraintes et l’exécution précise des tâches. (Source: Reddit r/ArtificialInteligence, Reddit r/ClaudeAI)

Discussions sur l’éthique de l’IA et l’impact social: Les discussions communautaires abordent plusieurs aspects de l’éthique de l’IA et de son impact social. Y compris si l’IA remplacera la production cinématographique, si l’IA a une conscience (citant le point de vue de Joscha Bach), les questions de commercialisation et de droits d’auteur des outils IA (comme Suno), les politiques des plateformes de distribution de contenu IA (comme Anti-Joy refusant la musique IA), l’équité dans l’utilisation des outils IA (comme les performances incohérentes et les limitations des comptes Claude Pro), et une réflexion ironique sur la dépendance excessive à l’IA. (Source: Reddit r/ArtificialInteligence, Reddit r/ClaudeAI, Reddit r/SunoAI, Reddit r/SunoAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ChatGPT)

💡 Divers

Test des « lunettes IA » à 40 yuans : bon marché ne signifie pas forcément bonne affaire: L’auteur de l’article a dépensé 40 yuans sur Xianyu (plateforme d’occasion) pour acheter un produit prétendant être des « lunettes intelligentes UVC » (en réalité le modèle SHGZ01 personnalisé par Shenzhen Kanjian Intelligent Technology pour Guazi Secondhand Car) et l’a testé. Ces lunettes n’ont pas de verres, intégrant seulement une caméra de 13 mégapixels sur le côté gauche, et nécessitent une connexion Type-C à un téléphone pour fonctionner. Les tests ont révélé une qualité photo et vidéo médiocre (à peine utilisable en journée, mauvaise la nuit) et un faible confort de port. L’auteur estime qu’il s’agit essentiellement d’une webcam USB, très éloignée des véritables lunettes IA (comme les Thunderbird V3, Ray-Ban Meta) en termes de fonctionnalités (interaction IA, prise de vue pratique) et d’expérience. La conclusion est que si l’on souhaite expérimenter les lunettes IA, ce type de produit a peu d’intérêt ; si l’on a juste besoin d’une webcam USB bon marché, alors c’est acceptable. L’article résume également brièvement l’histoire du développement des lunettes intelligentes et les raisons de l’engouement actuel pour les lunettes IA. (Source: 40元,我在闲鱼买到了最便宜的AI眼镜,真「便宜不是货」?)

Prédictions et tendances technologiques IA (2025 et au-delà): En combinant les discussions communautaires et certaines informations, les prédictions sur les tendances futures de l’IA et des technologies associées incluent : la technologie 6G arrivera plus rapidement dans les foyers ; l’IA continuera de remodeler le développement logiciel (« L’IA ne mange pas seulement tout ; elle est tout ») ; les agents IA (IA autonome) seront la prochaine vague, mais accompagnée de risques ; l’éthique de l’IA et la coopération réglementaire seront davantage prises en compte ; les applications de l’IA dans l’indemnisation des assurances, la santé (développement de médicaments, diagnostic), l’optimisation de la production, etc., s’approfondiront ; le domaine de la cybersécurité devra se méfier des menaces « zero-knowledge » utilisant l’IA ; l’identité numérique et l’identité décentralisée deviendront plus importantes. (Source: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Discussion sur les performances et la configuration d’OpenWebUI: Les utilisateurs de la communauté Reddit discutent des problèmes d’utilisation d’OpenWebUI. Un utilisateur signale un temps de chargement initial long et suggère de remplacer la base de données par défaut SQLite par PostgreSQL pour améliorer les performances. Un autre utilisateur demande comment se connecter à un service Ollama externe et à une base de données vectorielle lors d’un déploiement à partir des sources. Un autre utilisateur signale qu’en utilisant un modèle personnalisé (basé sur Llama3.2 avec ajout d’un prompt système), le temps de démarrage de la réponse est beaucoup plus long qu’avec le modèle de base, supposant que le problème pourrait provenir du traitement interne d’OpenWebUI. (Source: Reddit r/OpenWebUI, Reddit r/OpenWebUI, Reddit r/OpenWebUI)

Retours d’utilisation et discussions sur Suno AI: La communauté des utilisateurs de Suno AI discute des problèmes et astuces rencontrés lors de l’utilisation. Un utilisateur se plaint de ne pas pouvoir générer avec précision de la musique de style Brazilian Funk. Un utilisateur signale qu’après la refonte de l’interface Suno, la fonction « Pin » (Épingler) est devenue « Bookmark » (Marque-page), ce qui provoque une gêne. Un autre utilisateur signale qu’après l’ajustement des prix, son abonnement mensuel a été automatiquement changé en abonnement annuel et facturé. Un autre utilisateur demande quelle est la limite de longueur des chansons générées par Suno. Ces discussions reflètent les problèmes potentiels des outils IA concernant la génération de styles spécifiques, l’itération de l’interface utilisateur et les stratégies de facturation. (Source: Reddit r/SunoAI, Reddit r/SunoAI, Reddit r/SunoAI, Reddit r/SunoAI)