Palabras clave:Google TPUs, GPT-5, Google Earth AI, NVIDIA, Anthropic, OpenAI, Desarrollo de fármacos con IA, Computación de IA, Sistema de computación de aprendizaje automático espacial, Capacidad de demostración matemática de GPT-5, Razonamiento geoespacial a nivel planetario, Supercomputadora DGX SuperPOD, Tendencia a la baja de precios de modelos de IA

🔥 En Foco

Google TPUs van al espacio, explorando sistemas de computación ML escalables: Sundar Pichai anunció el “Proyecto Cazador del Sol”, con el objetivo de explorar la construcción de sistemas de computación de aprendizaje automático (ML) escalables en el espacio, utilizando energía solar. Investigaciones iniciales muestran que los TPUs Trillium-generation de Google no sufrieron daños en pruebas simuladas de radiación en órbita terrestre baja, pero la gestión térmica y la fiabilidad del sistema en órbita siguen siendo desafíos significativos. Google planea lanzar dos satélites prototipo a principios de 2027 en colaboración con Planet, marcando un paso crucial en la expansión de la computación AI al espacio. (Fuente: fchollet

)

GPT-5 demuestra nuevas capacidades en pruebas matemáticas, Tao Te-Hsien afirma la investigación asistida por AI: Matemáticos de Princeton y la Universidad Estatal de Ohio descubrieron que GPT-5, asistido por Lean, formalizó con éxito un contraejemplo del problema de Erdős, que había sido un desafío durante 30 años, e incluso reveló que el problema ya había sido resuelto hace 30 años pero fue pasado por alto. Tao Te-Hsien calificó esto como un caso interesante de prueba asistida por computadora y enfatizó el papel de la AI como un asistente poderoso en lugar de un matemático independiente, presagiando la entrada de la investigación matemática en una “era industrializada”. (Fuente: 36氪

)

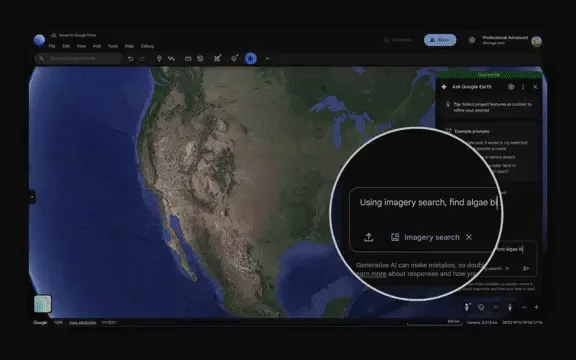

Google Earth AI lanza un agente a escala terrestre, potenciando el razonamiento geoespacial: Google ha mejorado Earth AI, combinando sus décadas de experiencia en modelado mundial con las avanzadas capacidades de razonamiento de Gemini, logrando por primera vez un razonamiento geoespacial complejo a escala planetaria. El sistema puede conectar automáticamente modelos de pronóstico del tiempo, mapas de población e imágenes satelitales para monitoreo ambiental y respuesta a desastres, como proporcionar alertas de inundaciones a 2 mil millones de personas, y abre su modelo central a los probadores a través de una plataforma en la nube. (Fuente: 36氪

)

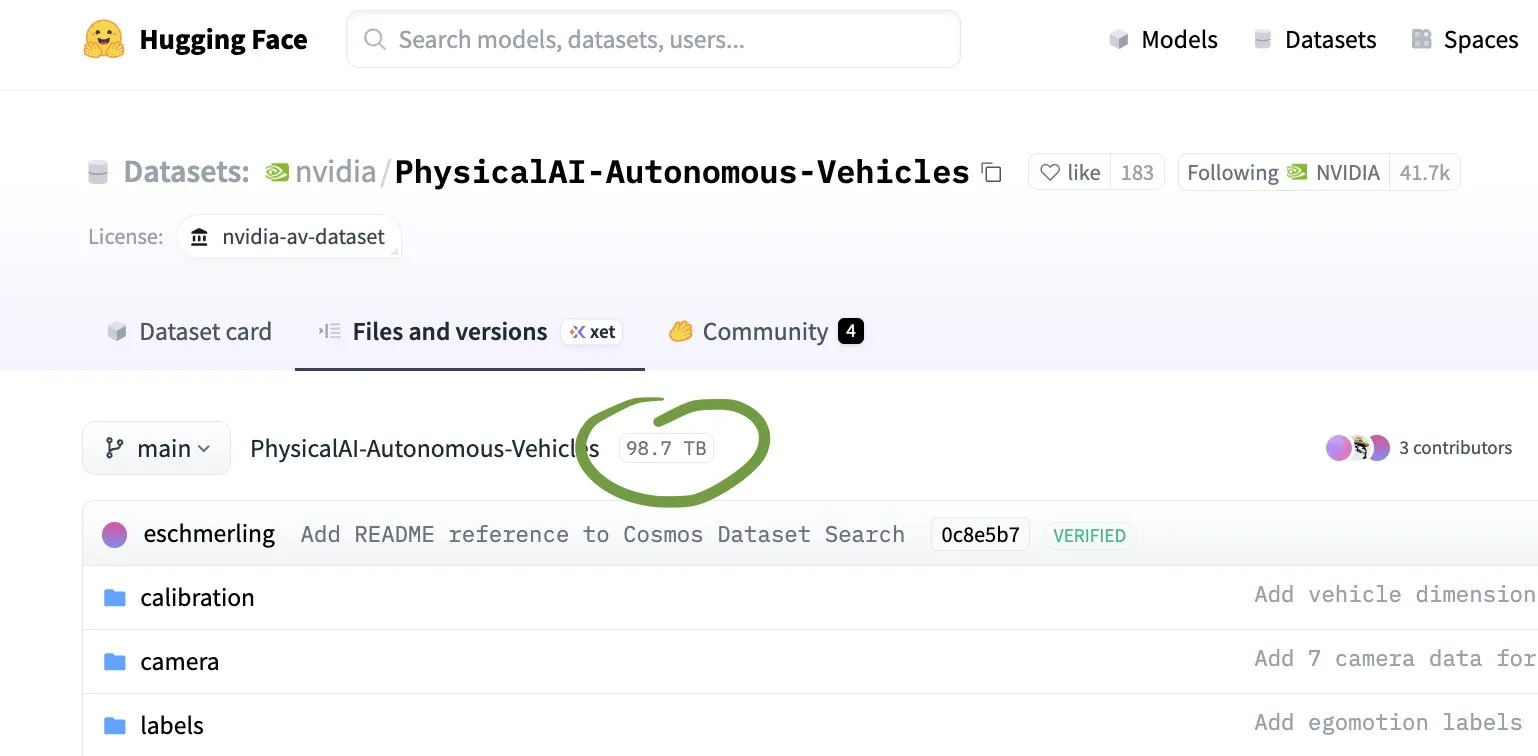

Nvidia y Lilly colaboran para construir una fábrica de desarrollo de fármacos con AI y billones de teraflops: Nvidia y Lilly se han asociado para desplegar una supercomputadora DGX SuperPOD construida con 1000 GPUs B300, creando la primera “superfábrica de AI” dedicada a la industria farmacéutica global. Esta fábrica se utilizará para el descubrimiento y desarrollo de fármacos, acelerando el cribado molecular y mejorando las tasas de éxito de la síntesis, para abordar los desafíos de alto costo, largos ciclos y bajas tasas de éxito de la I+D farmacéutica tradicional, marcando la entrada de la industria farmacéutica en una carrera armamentista de AI. (Fuente: 36氪

)

🎯 Tendencias

Anthropic lanza un ambicioso plan de crecimiento, proyectando ingresos superiores a 70 mil millones de dólares para 2028: La compañía de AI Anthropic ha elevado significativamente sus expectativas de crecimiento para los próximos tres años, proyectando que los ingresos superarán los 70 mil millones de dólares para 2028 y generarán 17 mil millones de dólares en flujo de caja, impulsado principalmente por la fuerte demanda de sus modelos de AI por parte de clientes empresariales. Su asistente de programación Claude Code ya ha alcanzado ingresos anualizados de casi mil millones de dólares, y se espera que logre un flujo de caja positivo tan pronto como en 2027, más rápido que OpenAI. (Fuente: 36氪

)

OpenAI y AWS alcanzan un acuerdo de computación de 38 mil millones de dólares, gigantes de Silicon Valley se unen y se cruzan: OpenAI y Amazon AWS han alcanzado un acuerdo estratégico de colaboración en la nube valorado en 38 mil millones de dólares, que les dará acceso completo a los recursos de computación de AWS, incluyendo la última generación de GPUs y CPUs de Nvidia. Este movimiento se considera un paso clave para que OpenAI logre su plan de infraestructura de computación de billones de teraflops, y también refleja la estrategia de los gigantes de la AI de buscar proveedores diversificados en la carrera armamentista de la computación. (Fuente: 36氪

)

Caída drástica de los costos de AI y reestructuración del valor del trabajo humano: Los precios de los modelos de AI están disminuyendo a una velocidad asombrosa; por ejemplo, el costo de los modelos de nivel GPT-3.5 se ha desplomado 280 veces en un año, y los modelos de gama alta incluso hasta 900 veces. Esto ha llevado a la popularización de las aplicaciones de AI, pero al mismo tiempo, los precios de los servicios humanos difíciles de reemplazar por AI (como el servicio doméstico, la enfermería, las reparaciones) continúan aumentando, creando una paradoja de “deflación de AI, inflación humana” que remodela la estructura del valor del trabajo. (Fuente: 36氪

)

Estado actual y futuro de la aplicación de AI en el comercio electrónico “Doble Once”: En el “Doble Once” de 2025, las plataformas de comercio electrónico han introducido completamente funciones de AI, como AI Universal Search, AI Help Me Choose, AI Virtual Try-on, entre otras, con el objetivo de mejorar la eficiencia y la experiencia del consumidor. Sin embargo, una encuesta revela que los consumidores tienen una baja percepción de las funciones de AI, y existen problemas como la imprecisión en la comprensión de la intención y la complejidad del proceso de compra. Las plataformas esperan que la AI restructure la distribución del tráfico, potencie a los comerciantes y explore nuevos modelos de aplicaciones nativas de AI y comercio electrónico basado en agentes. (Fuente: 36氪

)

Creciente preocupación por el impacto ambiental de la AI: Las discusiones en redes sociales señalan que el rápido desarrollo de la AI ha llevado a un aumento masivo en la demanda de computación, con nuevos centros de datos consumiendo grandes cantidades de electricidad y recursos hídricos, lo que agrava la carga ambiental. Por ejemplo, los centros de datos en Georgia ya han afectado el suministro de agua local, generando preocupaciones sobre la presión en la red eléctrica y la contaminación ambiental. (Fuente: Reddit r/ArtificialInteligence

)

El problema de la “depreciación” provocado por las actualizaciones y el mantenimiento de los modelos de AI: Anthropic ha emitido un compromiso para preservar los pesos de las versiones antiguas de sus modelos de AI, con el fin de abordar el problema de la “depreciación” causado por las actualizaciones de modelos y evitar que los usuarios pierdan resultados históricos debido a la iteración de modelos. Esta acción ha generado discusiones en la comunidad sobre la gestión del ciclo de vida de los modelos de AI, la responsabilidad ética y el “bienestar del modelo”. (Fuente: MatthewJBar

)

Impacto y redefinición del mercado laboral por la AI: En la ola de despidos impulsados por la AI, ha surgido un fenómeno de “boomerang”, donde los empleados son recontratados por sus antiguos empleadores, lo que sugiere problemas de planificación en las decisiones de despido de las empresas. Al mismo tiempo, la AI asume tareas rutinarias, lo que lleva a la gente a reflexionar sobre la definición de “trabajo no rutinario”; el trabajo humano podría orientarse hacia áreas creativas, emocionales y otras que la AI difícilmente puede reemplazar, destacando el profundo impacto de la AI en el mercado laboral y la redefinición de la naturaleza del trabajo. (Fuente: Reddit r/artificial

)

AI en la educación infantil: Tencent Research Institute publica una evaluación de la idoneidad de la AI para niños “left-behind”: La evaluación muestra que los Large Models (LLMs) se desempeñan bien en el soporte básico para niños “left-behind” (niños que se quedan en casa mientras sus padres trabajan en otras ciudades), como la seguridad de la información y la precisión del contenido, pero tienen claras deficiencias en capacidades de nivel superior como el cuidado empático, el apoyo relacional y el empoderamiento autónomo. La AI se desempeña mejor en cuestiones emocionales, pero carece de una comprensión profunda de las situaciones reales, lo que podría llevar a una dependencia excesiva de los “consejos autoritarios” de la AI por parte de los niños, generando preocupaciones sobre la equidad educativa y el desarrollo de la autonomía infantil. (Fuente: 36氪

)

El papel dominante de los factores no técnicos en la selección de tecnología AI: Steve Francia, un líder técnico senior de Google, señala que el 90% de las decisiones de selección de tecnología, como los lenguajes de programación, no están relacionadas con la tecnología en sí, sino que están influenciadas por “conversaciones invisibles” como la identidad personal, la afiliación emocional y las etiquetas profesionales. A través de ejemplos personales, revela que este sesgo puede llevar a las empresas a perder oportunidades de mercado y a un aumento de costos, enfatizando la importancia de transformar los debates técnicos en consideraciones económicas. (Fuente: 36氪)

Restricciones de AI en la generación de contenido provocan debate sobre la libertad creativa: Las discusiones en redes sociales señalan que las grandes empresas de AI generalmente restringen la generación de contenido pornográfico, violento, sangriento, con derechos de autor o que identifique a personas reales. Esta tendencia ha generado preocupaciones sobre la libertad creativa, con algunos argumentando que la sociedad está tratando a todas las computadoras como “computadoras escolares”, limitando el potencial de la AI en el arte y la expresión. (Fuente: brickroad7)

🧰 Herramientas

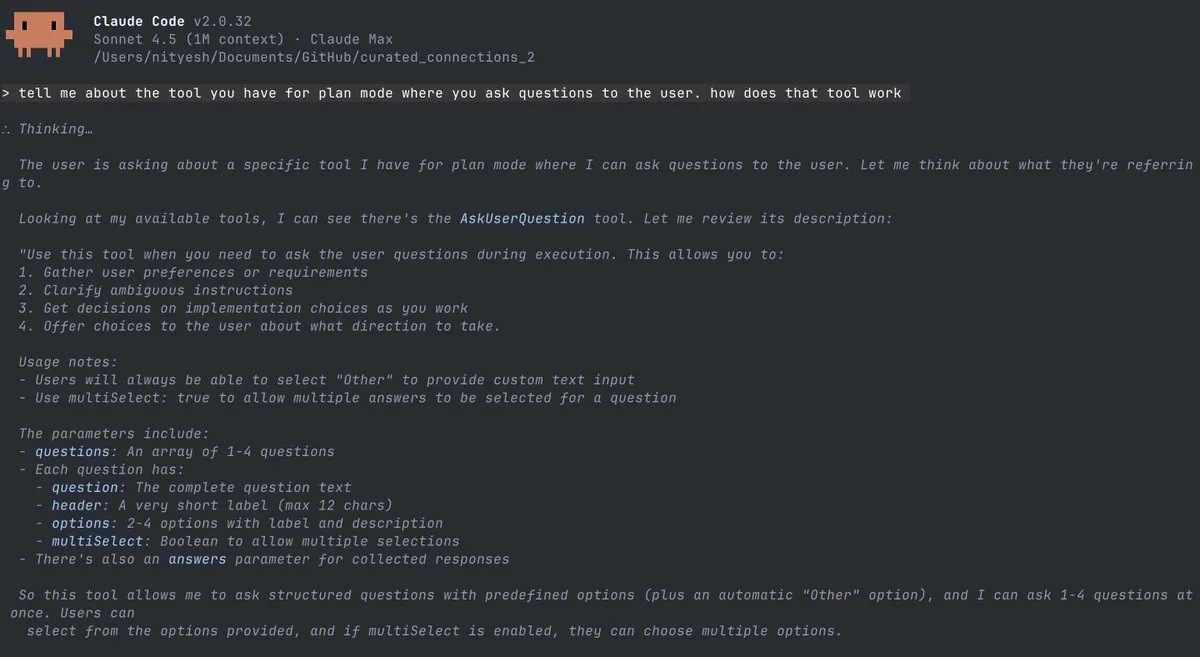

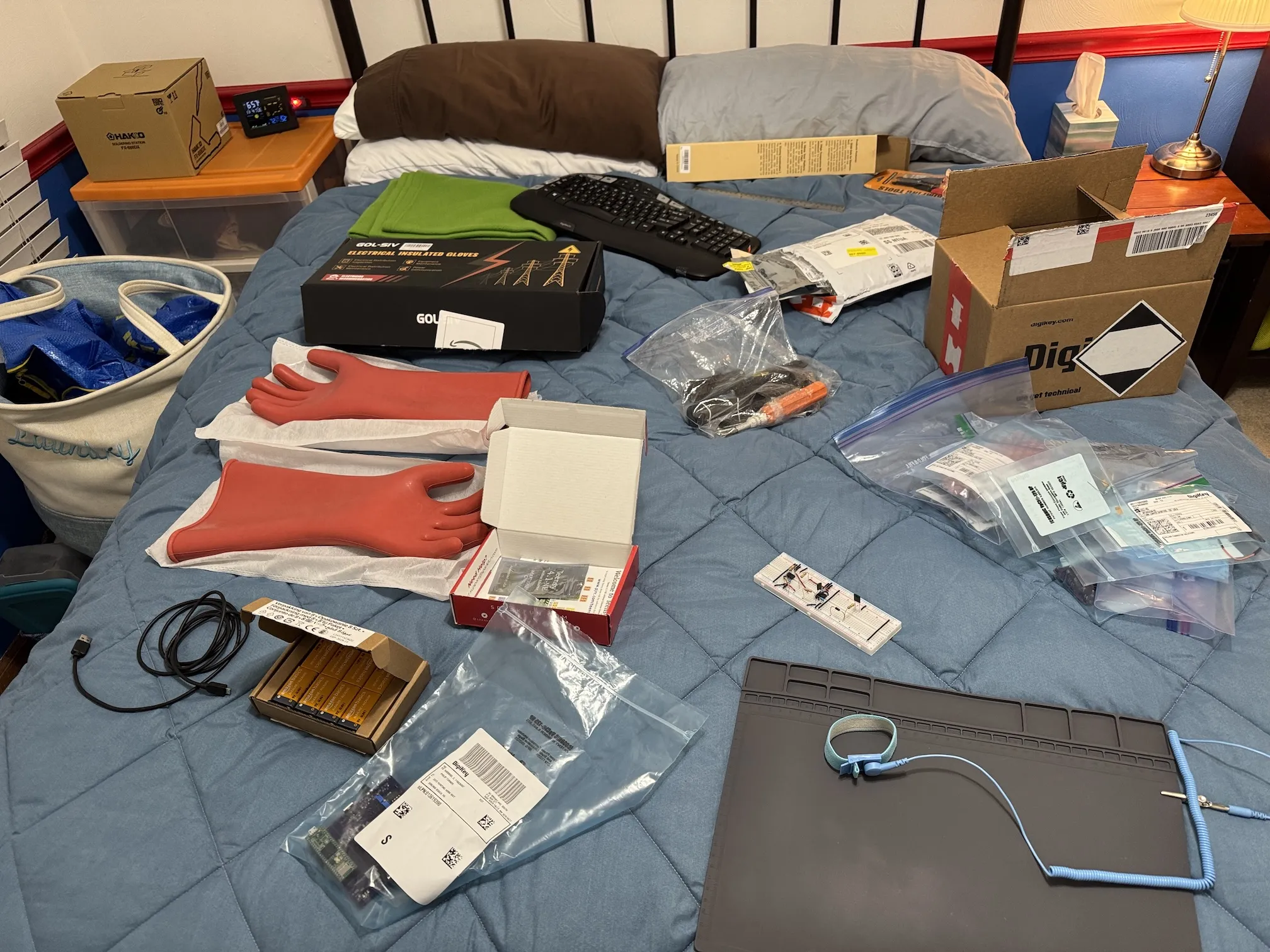

Herramientas de codificación con AI continúan evolucionando, mejorando la eficiencia del desarrollo y la gestión de modelos: Anthropic Claude Code ofrece créditos gratuitos pero la experiencia web es deficiente; su herramienta “AskUserQuestion” mejora la interacción en modo agente. VS Code añade funciones de gestión de modelos de lenguaje, LangChain lanza su serie de middleware Agent y la herramienta LangSmith, e Imbue Sculptor ofrece sugerencias de calidad de código. OpenAI Codex se integra con Slack, y FactoryAI Droid simplifica la orquestación de GPT/Claude, impulsando conjuntamente la codificación asistida por AI hacia una dirección más eficiente e inteligente. (Fuente: Reddit r/ClaudeAI

)

Reka lanza un servidor MCP gratuito, potenciando el chat con AI y el desarrollo de Agent: Reka Labs ha lanzado un servidor MCP (Model Context Protocol) gratuito, que permite a los desarrolladores desplegar modelos ML, RAG o Agent con poco código, e integra funciones como búsqueda en línea y verificación de hechos con AI, mejorando significativamente el potencial de las aplicaciones de chat con AI. (Fuente: RekaAILabs)

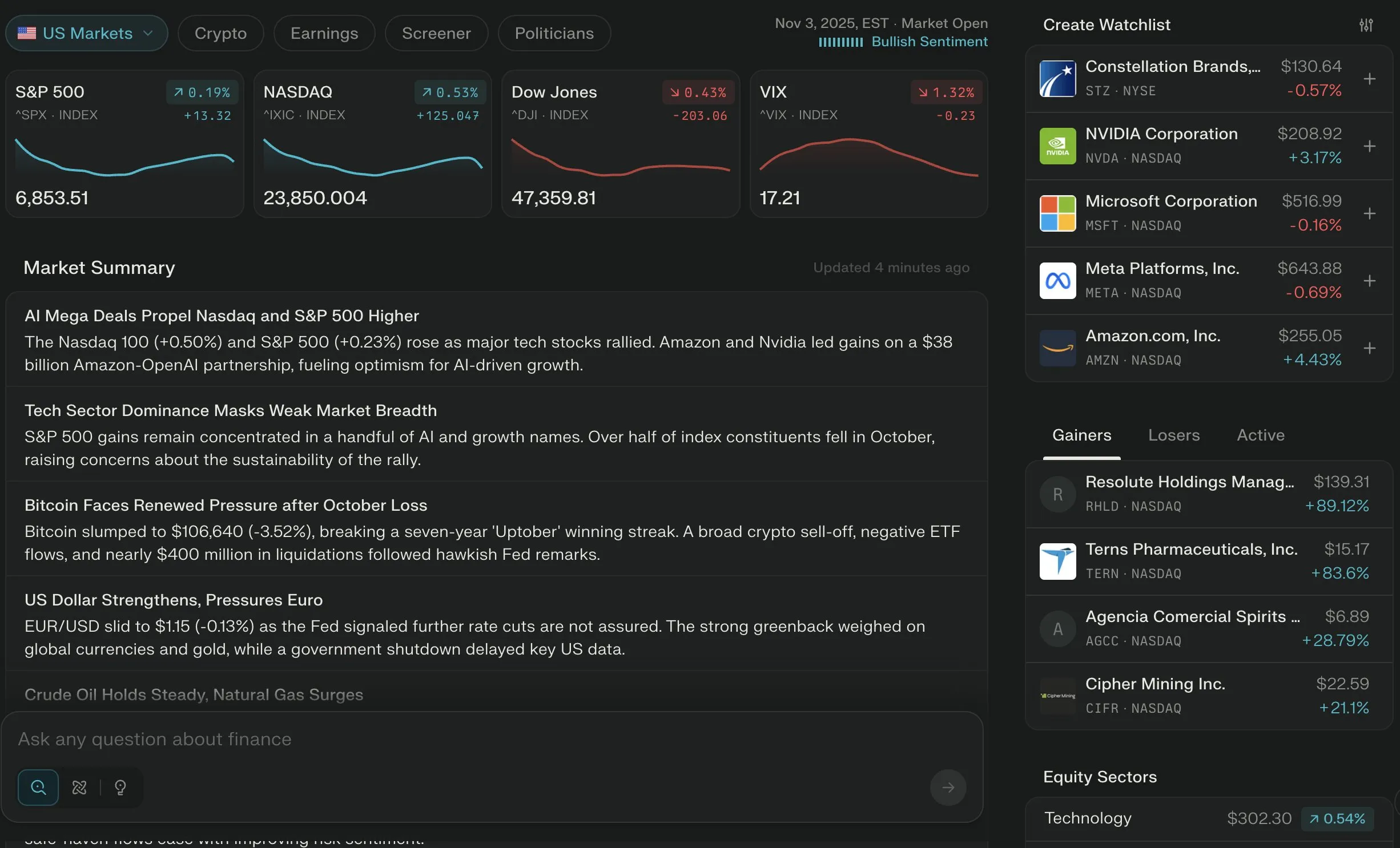

Perplexity Finance se convierte en la herramienta financiera de AI líder, ofreciendo asistencia de consultoría profesional: Perplexity Finance ha sido ampliamente elogiada por sus excelentes capacidades de análisis financiero con AI, siendo considerada la mejor herramienta financiera de AI de 2025. Al mismo tiempo, las herramientas de AI han demostrado un gran potencial en el manejo de facturas hospitalarias elevadas, reduciendo significativamente las facturas masivas al identificar errores de codificación, lo que destaca el valor de la AI para potenciar el campo de la consultoría profesional. (Fuente: AravSrinivas

)

Notion lanza notas de reuniones con AI, Bilibili implementa traducción de voz en off con AI, mejorando la eficiencia diaria: Notion ha lanzado una función de notas de reuniones con AI, logrando una gestión de reuniones integrada, y Bilibili ha lanzado la traducción de voz en off con AI, capaz de replicar el tono de voz. Estas herramientas de AI se están integrando en el trabajo y la vida diaria, mejorando la eficiencia a través de la automatización y la inteligencia. (Fuente: zachtratar

)

Herramientas de creación de video con AI se vuelven Agent-izadas, LeBo TouPing explora nuevos modos de interacción con AI: Los agentes de herramientas de video con AI simplifican los complejos flujos de trabajo creativos, integrando múltiples herramientas en un único agente de chat. LeBo TouPing también ha lanzado una solución de proyección de pantalla con AI, que permite controlar la interacción multipantalla mediante comandos de lenguaje natural, transformando la proyección de pantalla de una función de visualización a un punto de entrada de colaboración inteligente, explorando conjuntamente nuevas aplicaciones de la AI en la interacción multimedia y la creación de contenido. (Fuente: fabianstelzer

)

Reddit MCP Buddy integra Anthropic Directory, permitiendo el análisis inteligente de datos de la comunidad: Reddit MCP Buddy ha sido aprobado por Anthropic Directory, permitiendo la instalación con un solo clic. Los usuarios pueden utilizar fácilmente agentes de AI para buscar y analizar discusiones de la comunidad de Reddit, obteniendo sentimientos del mercado, inteligencia de productos y consejos profesionales, entre otros, sin necesidad de configuración manual, lo que simplifica enormemente el proceso de obtención de información de la comunidad. (Fuente: Reddit r/ClaudeAI

)

LangGraph Deep Agents construye un planificador gastronómico, demostrando el potencial de la arquitectura multi-agente: Un desarrollador ha utilizado LangGraph Deep Agents para construir un planificador de viajes gastronómicos, coordinando múltiples sub-agentes especializados a través de un agente supervisor para lograr una planificación y ejecución de tareas complejas, demostrando el poderoso potencial de la arquitectura multi-agente en aplicaciones del mundo real. (Fuente: hwchase17)

Augmentcode publica una guía de prácticas para la escalabilidad de la ingeniería impulsada por AI: Augmentcode ha lanzado una guía de prácticas para la escalabilidad de la ingeniería impulsada por AI, que ofrece una hoja de ruta de cuatro fases desde la experimentación hasta la innovación continua. La guía enfatiza el papel de los “campeones de AI” como facilitadores, la importancia de la AI consciente del contexto, y un marco para integrar y medir el impacto de la AI en el ciclo de vida del desarrollo de software, con el objetivo de ayudar a los equipos a lograr un impacto organizacional de la AI en la ingeniería. (Fuente: TheTuringPost

)

📚 Aprendizaje

Videos de las ponencias de PyTorch Conference 2025 disponibles en YouTube: Los videos de las ponencias de PyTorch Conference 2025 ya están disponibles en YouTube, cubriendo investigaciones de vanguardia como el motor de ejecución distribuida Monarch, Kimi K2 de Moonshot AI, Olmo-Thinking de AI2, Marin de Together, así como temas técnicos como programación de GPU, preentrenamiento MoE, PyTorch distribuido y tolerancia a fallos, proporcionando ricos recursos de aprendizaje para los desarrolladores. (Fuente: eliebakouch

)

nanochat de Karpathy como proyecto práctico de educación en AI: Karpathy, uno de los fundadores de OpenAI, posiciona nanochat como un “ChatGPT de 100 dólares para llevar a casa”, con el objetivo de proporcionar una plataforma experimental a través de mini-modelos para ayudar a cualquiera a comprender la inteligencia del aprendizaje automático. El proyecto cubre un ciclo de aprendizaje completo de preentrenamiento, ajuste fino supervisado y aprendizaje por refuerzo, enfatizando la práctica manual con micro-modelos para profundizar la comprensión de la esencia de la AI. (Fuente: TheTuringPost

)

Proyecto de código abierto GPT-OSS implementado desde cero, sin necesidad de PyTorch ni GPU: Un desarrollador ha implementado el modelo GPT-OSS desde cero utilizando Python puro, sin depender de PyTorch ni GPU, y ha publicado un tutorial detallado en un blog y un repositorio de código. El proyecto explica en profundidad conceptos centrales de LLM modernos como GQA, MoE y RoPE, con el objetivo de ayudar a los principiantes a comprender la arquitectura Transformer desde los principios fundamentales. (Fuente: Reddit r/deeplearning)

Arxiv Troller: Nueva herramienta de búsqueda y gestión de artículos de Arxiv: Para compensar las deficiencias de arxiv-sanity-lite, un desarrollador ha lanzado una nueva herramienta de búsqueda de artículos de Arxiv llamada “arxiv troller”. Esta herramienta permite agrupar artículos, buscar artículos similares y planea añadir funciones de búsqueda de similitud basada en citas y eliminación de resultados no deseados, con el objetivo de proporcionar una experiencia más fluida en la organización y descubrimiento de artículos. (Fuente: Reddit r/MachineLearning)

Microsoft propone AsyncThink, inaugurando la era de la “organización de agentes” de AI: El equipo de Microsoft ha propuesto un nuevo método de inferencia LLM llamado “pensamiento asíncrono” (AsyncThink), que organiza los procesos de pensamiento internos en una estructura ejecutable concurrentemente, resolviendo problemas de alta latencia y baja adaptabilidad en los métodos de pensamiento paralelo existentes. Los experimentos demuestran que AsyncThink mejora la precisión del razonamiento matemático mientras reduce la latencia de inferencia en un 28% y puede generalizarse a tareas no vistas. (Fuente: 36氪

)

Peking University y ByteDance lanzan Open-o3 Video de código abierto, el primer modelo de video de razonamiento espacio-temporal: Un equipo conjunto de la Universidad de Pekín y ByteDance ha lanzado Open-o3 Video, el primer modelo de código abierto que incrusta evidencia espacio-temporal explícita en todo el proceso de razonamiento de video. Puede señalar simultáneamente “cuándo y dónde” ocurren los eventos, adopta una arquitectura non-agent, evitando llamadas a herramientas complejas, y supera el rendimiento de GPT-4o y Gemini-2-Flash en múltiples pruebas de razonamiento de video. (Fuente: 36氪

)

Tuzhan & Peking University UniWorld V2 rompen el SOTA en edición de imágenes, destacando en chino y control de detalles: Tuzhan Intelligent y el equipo UniWorld de la Universidad de Pekín han lanzado el modelo UniWorld-V2, introduciendo el marco de entrenamiento posterior de aprendizaje por refuerzo UniWorld-R1, aplicando por primera vez la optimización de la estrategia RL a un modelo de edición de imágenes de arquitectura unificada. UniWorld-V2 supera a modelos cerrados de primer nivel como GPT-Image-1 en los benchmarks GEdit-Bench e ImgEdit, destacando especialmente en el dominio de la tipografía china y el control espacial detallado. (Fuente: 36氪

)

BERT como modelo de difusión de texto, Karpathy reflexiona sobre la era autorregresiva: La investigación de Nathan Barry muestra que BERT es esencialmente un caso especial de modelo de difusión de texto, y puede extenderse a un generador de texto mediante una tasa de enmascaramiento dinámica. Este descubrimiento ha llevado a Karpathy a reflexionar sobre los mecanismos de generación de LLM, sugiriendo que la generación autorregresiva no es el único paradigma y que los modelos de difusión aún tienen un enorme potencial en el campo de la generación de texto. (Fuente: 36氪

)

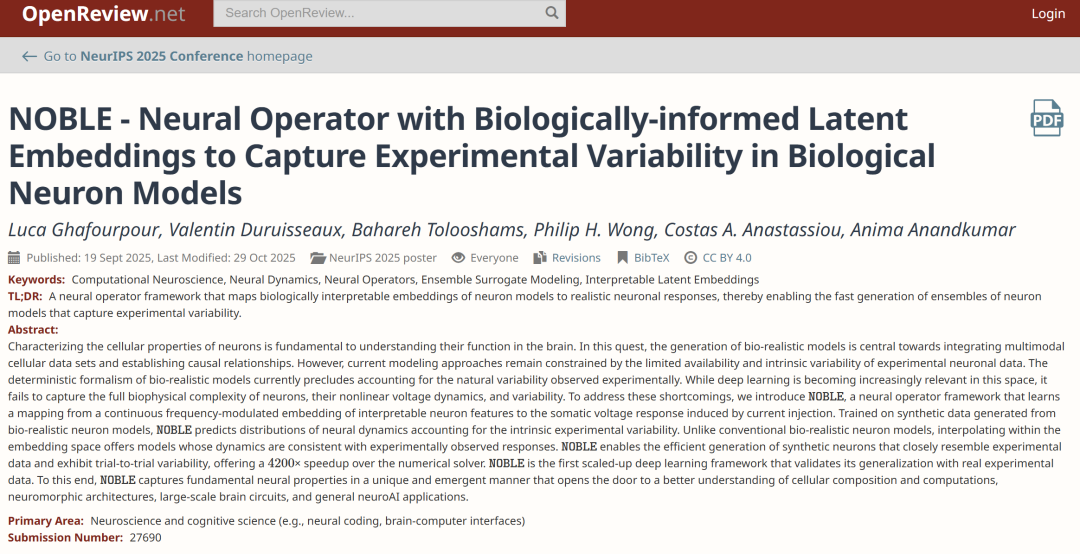

Marco NOBLE de ETH Zurich, simulación de dinámica neuronal 4200 veces más rápida: ETH Zurich y otras instituciones han propuesto el marco de aprendizaje profundo NOBLE, que por primera vez valida, a través de datos experimentales de la corteza cerebral humana, el aprendizaje directo de la dinámica no lineal neuronal a partir de datos experimentales. Su velocidad de simulación es 4200 veces más rápida que los solucionadores numéricos tradicionales, puede reproducir con precisión el comportamiento neuronal y generar nuevas respuestas neuronales, sentando las bases para la simulación de redes neuronales a gran escala. (Fuente: 36氪

)

BRAINS: Un sistema de recuperación mejorada para la detección y monitoreo de la enfermedad de Alzheimer: BRAINS es un nuevo sistema que utiliza las potentes capacidades de razonamiento de los Large Language Models (LLM) para la detección y monitoreo de la enfermedad de Alzheimer (AD). El sistema cuenta con un módulo de diagnóstico cognitivo y un módulo de recuperación de casos, y al ajustar los LLM en conjuntos de datos cognitivos y de neuroimagen, y fusionar casos similares recuperados, clasifica eficazmente la gravedad de la enfermedad e identifica signos tempranos de deterioro cognitivo. (Fuente: HuggingFace Daily Papers)

TWIST2: Un sistema escalable y portátil de adquisición de datos para robots humanoides: Este sistema utiliza PICO4U VR y un robot de cuello personalizado para lograr un control de cuerpo completo, permitiendo la recopilación eficiente de datos de habilidades de robots humanoides móviles y diestros a largo plazo. El sistema TWIST2 es completamente reproducible y de código abierto, sentando las bases para el control autónomo de estrategias visuomotoras de robots humanoides y demostrando una capacidad eficiente de recopilación de datos. (Fuente: HuggingFace Daily Papers)

💼 Negocios

Jensen Huang, CEO de Nvidia, vende acciones por mil millones de dólares, enfrenta mercado chino a cero y presión de ventas en corto: Jensen Huang, CEO de Nvidia, ha vendido acciones por un total de más de mil millones de dólares desde junio, mientras que el precio de las acciones de la compañía enfrenta ventas en corto por parte de inversores como Michael Burry. Afectada por los controles de exportación de EE. UU., la cuota de mercado de Nvidia en chips de AI en China se ha reducido casi a cero, enfrentando pérdidas de ingresos de miles de millones de dólares. Huang intenta construir una “Alianza de la Cadena de Suministro de AI de Asia Oriental” a través de la “diplomacia del pollo frito” para fortalecer la cooperación con gigantes coreanos y hacer frente a los desafíos. (Fuente: 36氪

)

Ubtech, la “primera acción de robots humanoides”, gana otro gran contrato de cien millones de yuanes, acelerando el proceso de industrialización: Ubtech ha ganado el proyecto “Centro de Adquisición de Datos de Robots Humanoides de Zigong Digital Investment”, obteniendo un gran contrato de 159 millones de yuanes para la adquisición de los últimos robots humanoides Walker S2. Este es otro pedido importante después del contrato de 250 millones de yuanes en septiembre, lo que demuestra su progreso continuo en el proceso de industrialización de robots humanoides, aunque la compañía aún enfrenta presión sobre sus ganancias. (Fuente: 36氪

)

El fenómeno de “shelling” es común en las startups de AI, el 73% depende de APIs de terceros: Una investigación de ingeniería inversa en 200 startups de AI revela que el 73% de las empresas que afirman tener “tecnología de desarrollo propio” en realidad dependen principalmente de APIs de terceros como ChatGPT y Claude, con márgenes de beneficio que van de 75 a 1000 veces. El informe expone el problema generalizado de la exageración de marketing en el ecosistema de startups de AI y pide una mayor transparencia, instando a los inversores a evaluar con cautela. (Fuente: 36氪

)

🌟 Comunidad

Los agentes de codificación con AI reavivan la pasión de los desarrolladores por la programación: Muchos desarrolladores afirman que los agentes de codificación con AI (como Claude Code) han mejorado enormemente la experiencia de programación, permitiéndoles construir prototipos rápidamente y aprender nuevas tecnologías en menos tiempo. Este modelo de “aprender haciendo” ha hecho que la programación sea más divertida y eficiente, e incluso ha reavivado la pasión por programar. (Fuente: Reddit r/ArtificialInteligence)

ChatGPT genera insatisfacción entre los usuarios por hacer demasiadas preguntas y “elogios sin sentido”: Los usuarios de ChatGPT se quejan de que el modelo hace demasiadas preguntas de aclaración antes de responder a preguntas sencillas, y que sus respuestas son demasiado halagadoras, llegando incluso a un “elogio sin sentido”. Los usuarios cuestionan su método de entrenamiento y su utilidad, considerando que esto afecta gravemente la productividad y están pensando en cambiar a otros modelos. (Fuente: Reddit r/ChatGPT

)

ChatGPT utilizado para apoyo emocional, aliviando el duelo de los usuarios: Un usuario compartió que, tras la inesperada muerte de su mascota, ChatGPT le proporcionó respuestas inesperadamente amables y compasivas, ayudándole a procesar el duelo y la culpa. Esto demuestra el potencial de las herramientas de AI para ofrecer apoyo emocional, satisfaciendo las necesidades emocionales de los usuarios en momentos especiales a través de la escucha y respuestas no críticas. (Fuente: Reddit r/ChatGPT

)

“Probar la identidad humana” se convierte en un nuevo desafío impulsado por la AI: A medida que el contenido generado por AI se vuelve cada vez más realista, demostrar la propia humanidad en línea se ha convertido en un problema cada vez más urgente. Tecnologías de escaneo de iris como el Orb de Worldcoin tienen como objetivo proporcionar una verificación de identidad humana que proteja la privacidad, para hacer frente al desafío de la proliferación de bots de AI, lo que ha generado discusiones en la comunidad sobre la privacidad de los datos y la futura infraestructura de identidad. (Fuente: Reddit r/artificial

)

Anuncio de AI de Coca-Cola provoca fuerte reacción pública: El anuncio de Navidad de Coca-Cola de este año, producido 100% por AI, ha recibido una gran cantidad de críticas negativas, siendo calificado de “carente de alma” y con una “trama limitada por las restricciones tecnológicas de la AI”. El público considera que la concepción del anuncio priorizó la tecnología sobre la creatividad, lo que resultó en un contenido mediocre, destacando los desafíos que la AI aún enfrenta en el campo de la creación artística y las expectativas estéticas del público hacia el arte de la AI. (Fuente: karminski3)

Publicidad engañosa de empresas de AI genera crisis de confianza en los usuarios: Algunos usuarios han informado que las empresas de AI continúan cobrando después de que los usuarios cancelan sus cuentas, cuestionando su ética comercial. Al mismo tiempo, una investigación de desarrolladores ha descubierto que un gran número de startups de AI exageran su tecnología “de desarrollo propio”, cuando en realidad están “shelling” APIs de terceros, lo que lleva a una disminución de la confianza de los usuarios en la industria de la AI. (Fuente: sarahcat21)

💡 Otros

China lanza un robot policial esférico de alta velocidad, la industrialización de robots humanoides acelera con desafíos: China ha lanzado un robot policial esférico de alta velocidad, con capacidad para capturar criminales de forma autónoma. Al mismo tiempo, el proceso de industrialización de robots humanoides se acelera, con empresas como Ubtech ganando repetidamente grandes contratos de cien millones de yuanes, pero el cierre de la empresa de robots K-scale también revela que la industria enfrenta presiones de financiación, comercialización y cadena de suministro. La competencia en escenarios industriales y comerciales es feroz, y el diseño de productos, la capacidad de entrega y la reducción de precios se vuelven clave; la industria está pasando de las demostraciones tecnológicas a la materialización de pedidos. (Fuente: Ronald_vanLoon

)

La AI conversacional entra en el “momento del billón”, los avances tecnológicos impulsan la interacción similar a la humana: La AI conversacional, que integra tecnologías como LLM, ASR, TTS y RTE, está evolucionando de respuestas mecánicas a conversaciones naturales similares a las humanas. Agora ha publicado el “Libro Blanco de Desarrollo de AI Conversacional 2025” y una serie de productos, con el objetivo de resolver desafíos técnicos como la baja latencia, las interrupciones naturales y la gestión del contexto. La AI se está implementando a gran escala en escenarios como hardware inteligente, compañía emocional y educación en línea, y en el futuro logrará interacción multimodal y colaboración multi-agente, con el potencial de convertirse en un nuevo portal de información y centro de servicios. (Fuente: 36氪

)

La escasez de suministro de GPU afecta a proyectos “moonshot” no-LLM: El suministro actual de GPU está dominado por proyectos LLM, lo que dificulta que otros proyectos “moonshot” no-LLM obtengan la potencia de cómputo necesaria. Este fenómeno destaca el desequilibrio en la asignación de recursos en el campo de la AI y el enorme efecto de succión de los LLM en todo el ecosistema de hardware de computación. (Fuente: teortaxesTex

)