Palabras clave:modelo de IA, tecnología OCR, infraestructura de IA, modelo de lenguaje grande, agente de IA, modelo multimodal de IA, optimización del consumo energético de IA, ecosistema de código abierto de IA, modelo DeepSeek OCR, razonamiento multimodal Gemini 3, modelo de mundo Emu3.5, arquitectura de atención mixta Kimi Linear, tecnología de plegado de memoria AgentFold

Selección del Editor de la Columna de IA

🔥 En Foco

DeepSeek OCR model: Nuevo avance en la memoria de IA y optimización del consumo energético : DeepSeek ha lanzado un modelo OCR cuya innovación central reside en la forma de procesar la información y almacenar la memoria. El modelo comprime la información textual en formato de imagen, reduciendo significativamente los recursos computacionales necesarios para su funcionamiento, lo que podría mitigar la creciente huella de carbono de la IA. Este método simula la memoria humana mediante compresión jerárquica, difuminando el contenido menos importante para ahorrar espacio, manteniendo al mismo tiempo una alta eficiencia. Esta investigación ha captado la atención de expertos como Andrej Karpathy, quienes consideran que las imágenes podrían ser más adecuadas que el texto como entrada para los LLM, abriendo nuevas direcciones para la memoria de IA y las aplicaciones de agentes. (Fuente: MIT Technology Review)

Gigantes tecnológicos continúan invirtiendo fuertemente en infraestructura de IA : Gigantes tecnológicos como Microsoft, Meta y Google anunciaron en sus últimos informes de ganancias que seguirán aumentando significativamente el gasto en infraestructura de IA. Meta proyecta que su gasto de capital este año alcanzará entre 70.000 y 72.000 millones de dólares, con planes de expandirse aún más el próximo año; los ingresos de Microsoft Intelligent Cloud superaron por primera vez los 30.000 millones de dólares, con un crecimiento del 40% en Azure y otros servicios en la nube, y se espera que la capacidad de IA aumente un 80%. Sundar Pichai, CEO de Google, enfatizó que el enfoque de pila completa de IA impulsa un fuerte dinamismo y adelantó el próximo lanzamiento de Gemini 3. Estas inversiones reflejan el optimismo de los gigantes sobre futuros avances en IA y su determinación de tomar la delantera en el mercado. (Fuente: Wired, Reddit r/artificial)

Anthropic descubre que los LLM poseen una “capacidad de introspección” limitada : Una investigación reciente de Anthropic revela que los Large Language Models (LLMs) como Claude poseen una “verdadera conciencia introspectiva”, aunque esta capacidad es aún limitada. El estudio explora si los LLM pueden reconocer sus propios pensamientos internos o si simplemente generan respuestas plausibles basadas en las preguntas. Este hallazgo sugiere que los LLM podrían tener un nivel de autoconocimiento más profundo de lo esperado, lo que es significativo para la comprensión y el desarrollo de sistemas de IA más inteligentes y conscientes. (Fuente: Anthropic, Reddit r/artificial)

Extropic lanza un nuevo hardware de computación termodinámica TSU, afirmando un avance en el consumo energético de IA : La compañía Extropic ha presentado un nuevo dispositivo de computación, el TSU (Thermodynamic Sampling Unit), cuyo núcleo es el “P-bit” (probabilistic bit), capaz de oscilar entre 0 y 1 con una probabilidad programable, con el objetivo de lograr una mejora de 10.000 veces en la eficiencia energética de la IA. La compañía ha lanzado el chip X0, el kit de prueba de escritorio XTR0 y el TSU de grado comercial Z1, y ha liberado la biblioteca de software Thermol para la simulación de TSU en GPU. Aunque la definición de su referencia de mejora de eficiencia ha sido cuestionada, esta dirección busca abordar la enorme brecha de potencia computacional y energía de la IA, lo que podría generar un cambio de paradigma en la computación de IA. (Fuente: TheRundownAI, pmddomingos, op7418)

🎯 Tendencias

Google adelanta el lanzamiento de Gemini 3, reforzando la tendencia de especialización en su familia de modelos de IA : Sundar Pichai, CEO de Google, anunció durante la conferencia de resultados que la nueva versión de su modelo insignia, Gemini 3, se lanzará a finales de este año. Destacó que la familia de modelos de IA de Google avanza hacia la especialización: Gemini se enfoca en el razonamiento multimodal, Veo en la generación de video, Genie en agentes interactivos y Nano en la inteligencia en dispositivos. Esta estrategia indica que Google está pasando de un modelo único y general a una arquitectura de sistema interconectada y optimizada para diferentes escenarios, con el fin de mejorar la fiabilidad, reducir la latencia y soportar el despliegue en el borde. (Fuente: Reddit r/ArtificialInteligence, shlomifruchter)

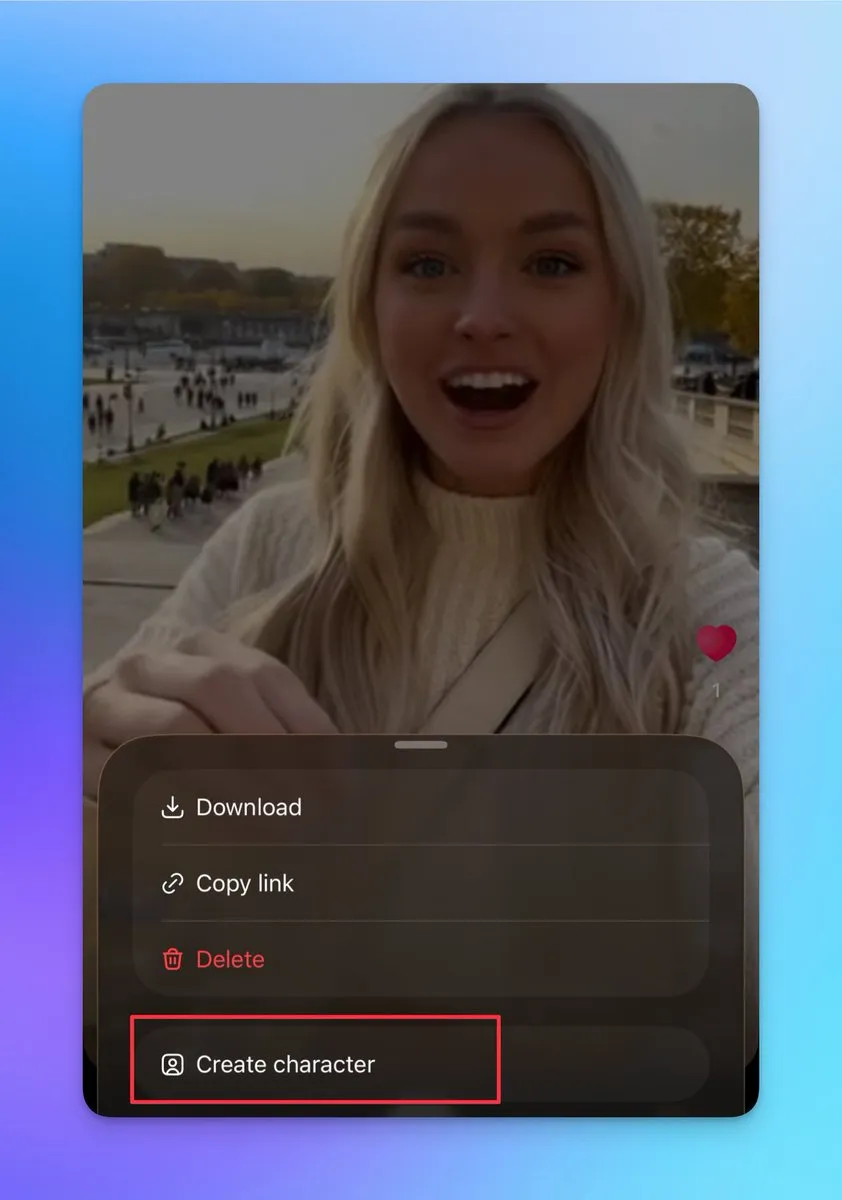

Sora 2 añade funciones de personajes personalizados y unión de videos, permitiendo la creación de videos largos y continuos : Sora 2 ha recibido recientemente varias actualizaciones importantes, incluyendo la compatibilidad con la creación de otros personajes (no se pueden subir fotos reales, pero se pueden crear a partir de personas en videos existentes). Los usuarios pueden utilizar esta función para garantizar la coherencia de los personajes, lo cual es crucial para construir videos largos y continuos. Además, la página de borradores permite unir múltiples videos antes de publicarlos, y la página de búsqueda ha añadido una clasificación que muestra los shows en vivo con personas reales y los creadores de contenido secundario. Estas actualizaciones mejoran significativamente la flexibilidad creativa y la interactividad del usuario de Sora 2, y se espera que aumenten considerablemente sus usuarios activos diarios. (Fuente: op7418, billpeeb, op7418)

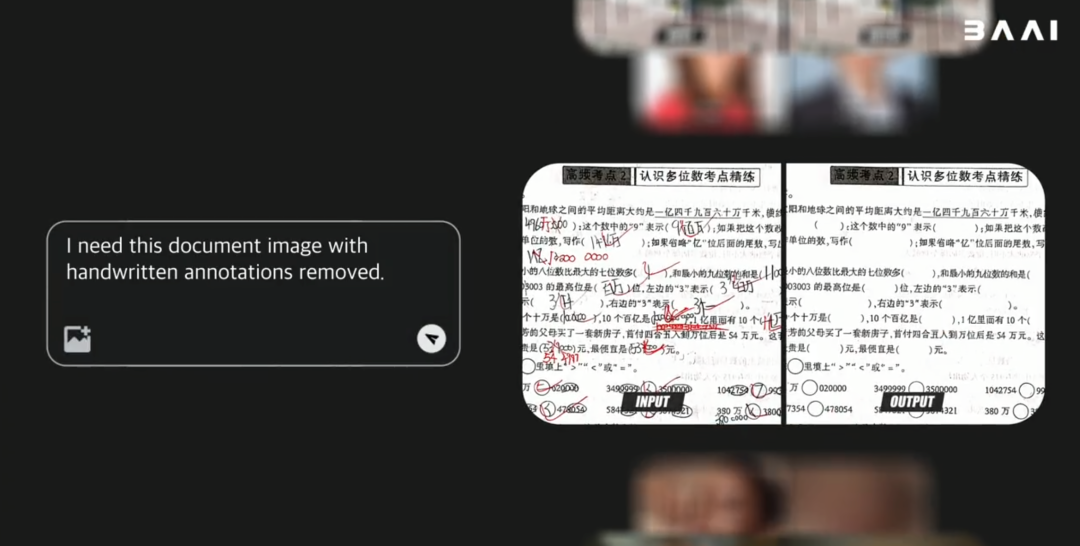

BAAI lanza el modelo mundial multimodal de código abierto Emu3.5, superando el rendimiento de Gemini-2.5-Flash-Image : La Academia de Inteligencia Artificial de Beijing (BAAI) ha lanzado Emu3.5, un modelo mundial multimodal de código abierto con 34B parámetros. Este modelo utiliza un marco Decoder-only Transformer, capaz de procesar simultáneamente tareas de imagen, texto y video, unificándolas en una tarea de predicción del siguiente State. Emu3.5 ha sido preentrenado con una vasta cantidad de datos de video de internet, lo que le confiere la capacidad de comprender la continuidad espacio-temporal y la causalidad. Destaca en narrativa visual, guía visual, edición de imágenes, exploración del mundo y operaciones encarnadas, con una mejora significativa en la fidelidad física, igualando o incluso superando el rendimiento de Gemini-2.5-Flash-Image (Nano Banana). (Fuente: 36氪)

Moonshot AI lanza el modelo Kimi Linear, que utiliza una arquitectura de atención lineal híbrida : Moonshot AI ha presentado el modelo Kimi Linear, un modelo de 48B parámetros basado en la arquitectura de atención lineal híbrida (KDA), con 3B parámetros activos y soporte para una longitud de contexto de 1M. Kimi Linear, mediante la optimización de Gated DeltaNet, ha mejorado significativamente el rendimiento y la eficiencia del hardware en tareas de contexto largo, reduciendo los requisitos de KV cache hasta en un 75% y aumentando el rendimiento de decodificación en 6 veces. Este modelo ha demostrado un rendimiento excepcional en varias pruebas de referencia, superando a los modelos de atención completa tradicionales, y se han lanzado dos versiones de código abierto en Hugging Face. (Fuente: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, bigeagle_xd)

El modelo MiniMax M2 mantiene la arquitectura Full Attention, destacando los desafíos en el despliegue de producción : Haohai Sun, jefe de preentrenamiento de MiniMax M2, explicó por qué el modelo M2 sigue utilizando la arquitectura Full Attention en lugar de la atención lineal o dispersa. Señaló que, aunque la atención eficiente puede ahorrar capacidad computacional en teoría, en sistemas industriales reales, su rendimiento, velocidad y precio aún son difíciles de superar por la Full Attention. Los principales cuellos de botella radican en las limitaciones de los sistemas de evaluación, los altos costos experimentales de las tareas de inferencia complejas y la inmadurez de la infraestructura. MiniMax considera que, al buscar capacidades de contexto largo, la calidad de los datos, el sistema de evaluación y la optimización de la infraestructura son más cruciales que simplemente cambiar la arquitectura de atención. (Fuente: Reddit r/LocalLLaMA, ClementDelangue)

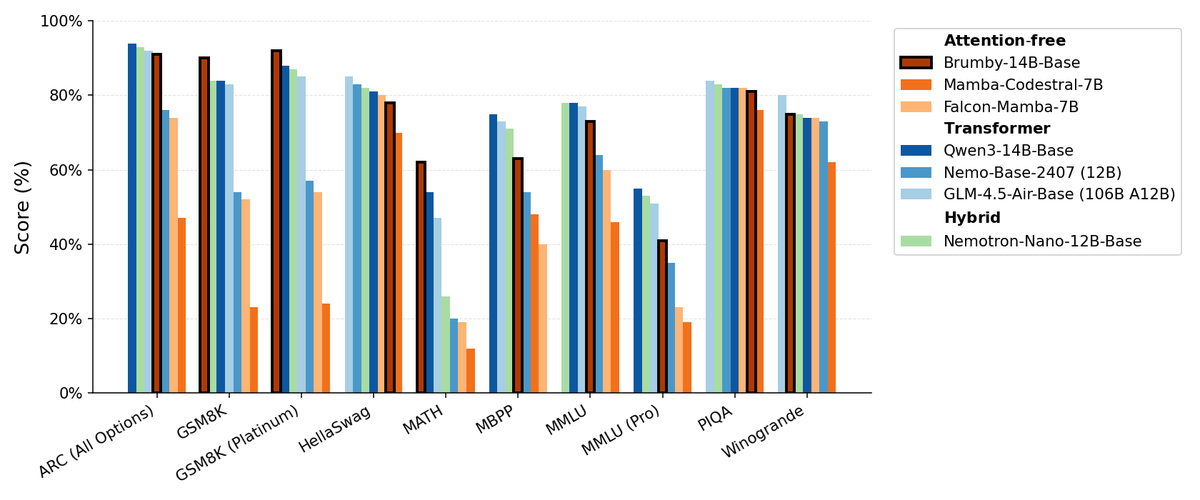

Manifest AI lanza Brumby-14B-Base, explorando modelos base sin atención : Manifest AI ha lanzado Brumby-14B-Base, afirmando que es el modelo base sin atención más potente hasta la fecha, entrenado con 14 mil millones de parámetros a un costo de solo 4000 dólares. Este modelo iguala el rendimiento de los modelos Transformer e híbridos de tamaño similar, lo que sugiere que la era de los Transformer podría estar llegando lentamente a su fin. Este avance abre nuevas posibilidades para la arquitectura de modelos de IA, mostrando un enorme potencial para reducir los costos de entrenamiento y desafiando el dominio de los mecanismos de atención tradicionales. (Fuente: ClementDelangue, teortaxesTex)

Nuevos modelos Nemotron basados en Qwen3 32B, optimizando la calidad de respuesta de los LLM : NVIDIA ha lanzado Qwen3-Nemotron-32B-RLBFF, un Large Language Model ajustado a partir de Qwen/Qwen3-32B, diseñado para mejorar la calidad de las respuestas generadas por los LLM en su modo de pensamiento predeterminado. Este modelo de investigación supera significativamente al Qwen3-32B original en pruebas de referencia como Arena Hard V2, WildBench y MT Bench, y ofrece un rendimiento similar al de DeepSeek R1 y O3-mini, pero con un costo de inferencia inferior al 5%, demostrando avances en rendimiento y eficiencia. (Fuente: Reddit r/LocalLLaMA)

La arquitectura Mamba sigue siendo ventajosa en el procesamiento de contexto largo, pero su entrenamiento paralelo es limitado : La arquitectura Mamba destaca en el manejo de contextos largos (millones de tokens), evitando el problema de explosión de memoria de los Transformer. Sin embargo, su principal limitación radica en la dificultad de paralelizar el entrenamiento, lo que obstaculiza su adopción en aplicaciones a mayor escala. A pesar de la existencia de varios mezcladores lineales y arquitecturas híbridas, el desafío del entrenamiento paralelo de Mamba sigue siendo un cuello de botella clave para su aplicación masiva. (Fuente: Reddit r/MachineLearning)

NVIDIA lanza ARC, Rubin, Omniverse DSX y más, reforzando su liderazgo en infraestructura de IA : NVIDIA realizó una serie de importantes anuncios en la conferencia GTC, incluyendo NVIDIA ARC (Aerial RAN Computer) en colaboración con Nokia para desarrollar 6G, Rubin, la supercomputadora de tercera generación a escala de rack, Omniverse DSX (un plano para el diseño colaborativo virtual y la operación de fábricas de IA a nivel de gigabit), y NVIDIA Drive Hyperion (una arquitectura estandarizada para taxis robot) en asociación con Uber. Estos lanzamientos demuestran que NVIDIA está redefiniendo su posición de fabricante de chips a arquitecto de infraestructura nacional, enfatizando el “Made in USA” y la carrera energética para enfrentar los desafíos de la era de la IA y el 6G. (Fuente: TheTuringPost, TheTuringPost)

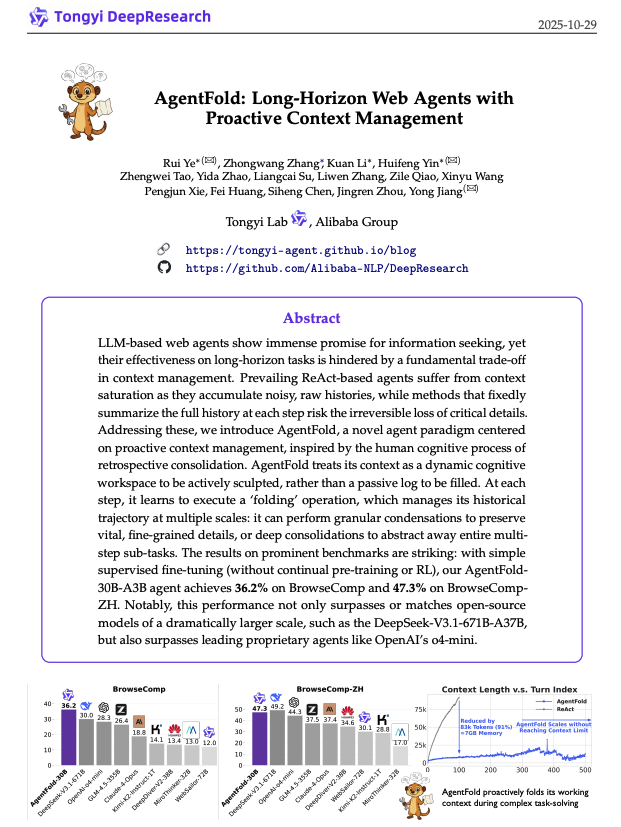

AgentFold: Gestión adaptativa del contexto para mejorar la eficiencia de los agentes web : AgentFold propone una novedosa técnica de ingeniería de contexto que, a través de “Memory Folding”, comprime los pensamientos pasados de un agente en una memoria estructurada, gestionando dinámicamente el espacio de trabajo cognitivo. Este método resuelve el problema de sobrecarga de contexto de los agentes ReAct tradicionales y ha demostrado un rendimiento excepcional en pruebas de referencia como BrowseComp, superando a modelos grandes como DeepSeek-V3.1-671B. AgentFold-30B logra un rendimiento competitivo con un menor número de parámetros, mejorando significativamente la eficiencia de desarrollo y despliegue de agentes web. (Fuente: omarsar0)

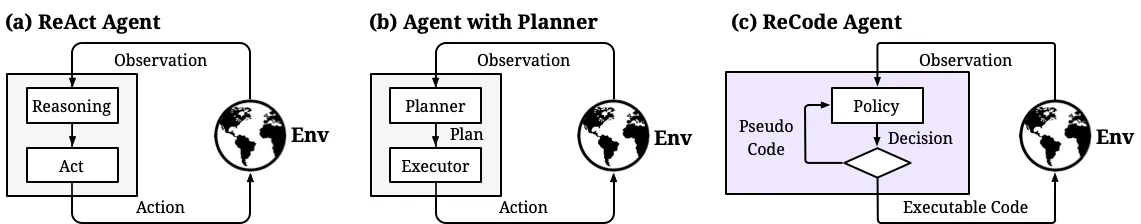

ReCode: Unificación de planificación y acción para el control dinámico de la granularidad de decisión en agentes de IA : ReCode (Recursive Code Generation) es un nuevo método de Parameter-Efficient Fine-Tuning (PEFT) que unifica la representación de planificación y acción de los agentes de IA al tratar la planificación de alto nivel como una función recursiva que se descompone en acciones de grano fino. Este método logra un rendimiento SOTA con solo el 0.02% de los parámetros de entrenamiento y reduce el consumo de memoria de GPU. ReCode permite a los agentes adaptarse dinámicamente a diferentes granularidades de decisión, aprender decisiones jerárquicas y supera significativamente a los métodos tradicionales en eficiencia y utilización de datos, siendo un paso importante hacia el razonamiento similar al humano. (Fuente: dotey, ZhihuFrontier)

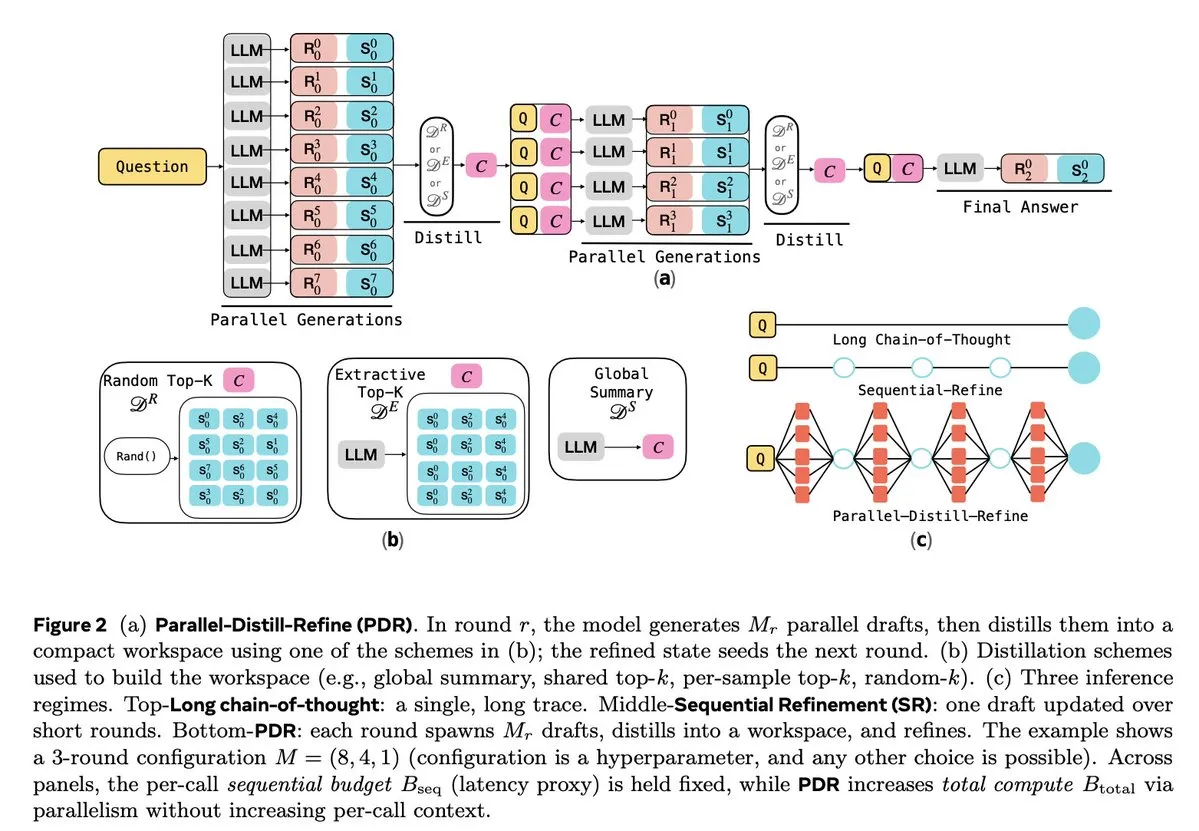

Optimización de la inferencia de LLM y el aprendizaje por refuerzo : Múltiples estudios se centran en mejorar la eficiencia y fiabilidad de la inferencia de LLM. Parallel-Distill-Refine (PDR) reduce el costo y la latencia de tareas de inferencia complejas mediante la generación y el refinamiento paralelo de borradores. Flawed-Aware Policy Optimization (FAPO) introduce un mecanismo de recompensa y penalización para corregir patrones defectuosos en el proceso de inferencia, aumentando la fiabilidad. El marco PairUni equilibra las tareas de comprensión y generación de LLM multimodales a través del entrenamiento por pares y el algoritmo de optimización Pair-GPRO. PM4GRPO utiliza técnicas de minería de procesos para mejorar la capacidad de inferencia de los modelos de políticas mediante el aprendizaje por refuerzo GRPO consciente de la inferencia. El protocolo Fortytwo, por su parte, logra un rendimiento excepcional en la inferencia de grupos de IA y una fuerte resistencia a las indicaciones adversarias mediante un consenso de clasificación distribuido entre pares. (Fuente: NandoDF, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

🧰 Herramientas

Tencent lanza WeKnora de código abierto: un marco de comprensión y recuperación de documentos impulsado por LLM : Tencent ha lanzado WeKnora de código abierto, un marco de comprensión de documentos y recuperación semántica basado en LLM, diseñado específicamente para manejar documentos complejos y heterogéneos. Adopta una arquitectura modular que combina preprocesamiento multimodal, indexación de vectores semánticos, recuperación inteligente e inferencia de LLM, siguiendo el paradigma RAG. Al combinar bloques de documentos relevantes e inferencia del modelo, logra respuestas de alta calidad y conscientes del contexto. WeKnora es compatible con múltiples formatos de documentos, modelos de incrustación y estrategias de recuperación, y ofrece una interfaz web y API fáciles de usar, compatible con el despliegue local y en la nube privada, garantizando la soberanía de los datos. (Fuente: GitHub Trending)

Jan: Alternativa de ChatGPT de código abierto y offline, compatible con la ejecución local de LLM : Jan es una alternativa de ChatGPT de código abierto que funciona 100% offline en el ordenador del usuario. Permite a los usuarios descargar y ejecutar LLM de HuggingFace (como Llama, Gemma, Qwen, GPT-oss, etc.) y es compatible con la integración de modelos en la nube como OpenAI y Anthropic. Jan ofrece asistentes personalizados, una API compatible con OpenAI e integración del Model Context Protocol (MCP), enfatizando la protección de la privacidad y proporcionando a los usuarios una experiencia de IA local con control total. (Fuente: GitHub Trending)

Claude Code: El kit de herramientas para desarrolladores y el ecosistema de habilidades de Anthropic : Claude Code de Anthropic mejora significativamente la eficiencia de los desarrolladores a través de una serie de “habilidades” y agentes. Esto incluye el conector Rube MCP (que conecta Claude a más de 500 aplicaciones), el kit de herramientas de desarrollo Superpowers (que ofrece comandos /brainstorm, /write-plan, /execute-plan), un paquete de documentos (para procesar Word/Excel/PDF), Theme Factory (automatización de guías de marca) y Systematic Debugging (que simula procesos de depuración de desarrolladores avanzados). Estas herramientas, con su diseño modular y capacidad de conciencia contextual, ayudan a los desarrolladores a automatizar flujos de trabajo, revisar código, refactorizar y corregir errores, e incluso permiten a equipos no técnicos crear sus propias herramientas. (Fuente: Reddit r/ClaudeAI, Reddit r/ClaudeAI)

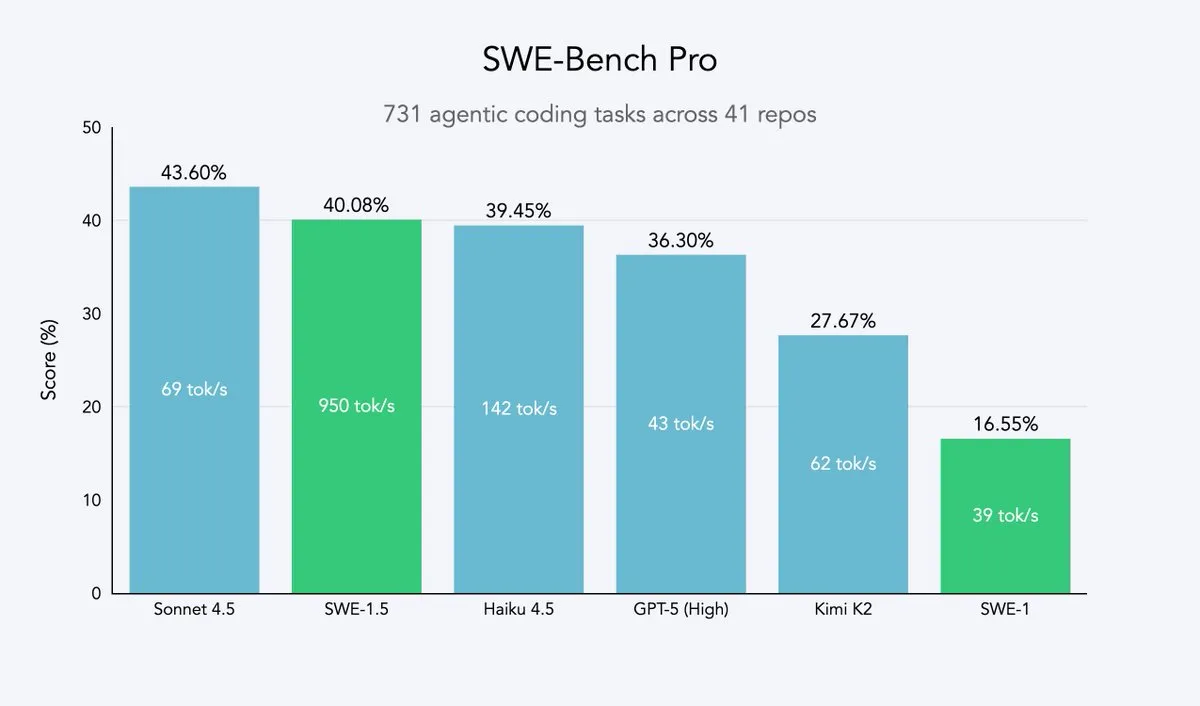

Cursor 2.0 y Windsurf: Agentes de código que buscan velocidad y eficiencia : Cursor y Windsurf han lanzado modelos de agentes de código optimizados para la velocidad y la plataforma 2.0. Su estrategia se basa en el ajuste fino mediante aprendizaje por refuerzo de grandes modelos de código abierto (como Qwen3) y su despliegue en hardware optimizado, para lograr un efecto de “inteligencia media pero velocidad ultrarrápida”. Esta ruta es una estrategia eficiente para las empresas de agentes de código, ya que les permite acercarse a la frontera de Pareto de velocidad e inteligencia con el mínimo costo de recursos. El modelo SWE-1.5 de Windsurf establece un nuevo estándar de velocidad al tiempo que logra un rendimiento de codificación casi SOTA. (Fuente: dotey, Smol_AI, VictorTaelin, omarsar0, TheRundownAI)

Perplexity Patents: El primer agente de investigación de patentes de IA, potenciando la inteligencia de IP : Perplexity ha lanzado Perplexity Patents, el primer agente de investigación de patentes de IA del mundo, diseñado para democratizar la inteligencia de IP. Esta herramienta permite la búsqueda y la investigación entre patentes, y en el futuro se lanzará Perplexity Scholar, centrado en la investigación académica. Esta innovación simplificará enormemente los procesos de búsqueda y análisis de patentes, ofreciendo a innovadores, abogados e investigadores un servicio de inteligencia de propiedad intelectual eficiente y fácil de usar. (Fuente: AravSrinivas)

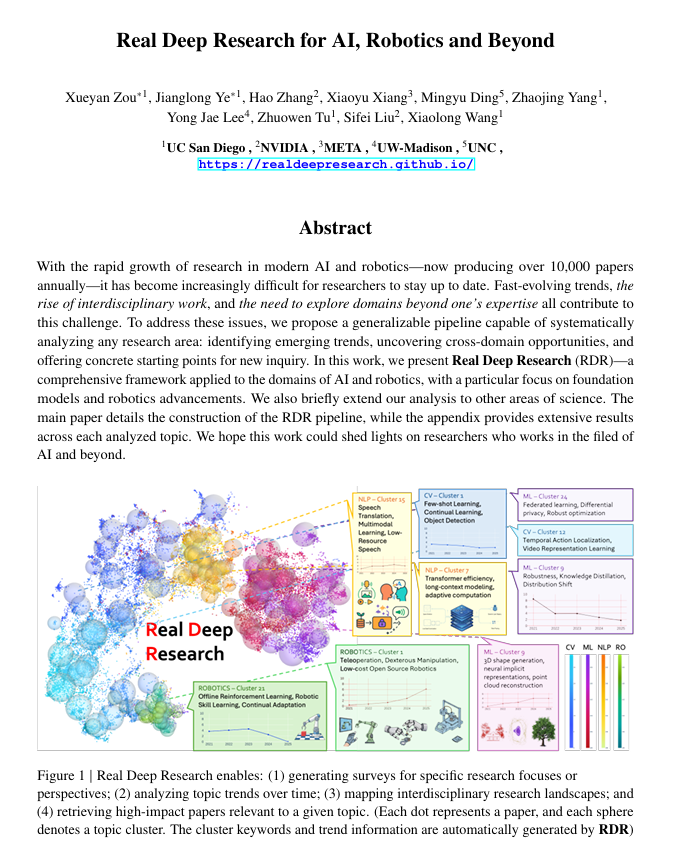

Real Deep Research (RDR): Un marco de investigación científica profunda impulsado por IA : Real Deep Research (RDR) es un marco impulsado por IA diseñado para ayudar a los investigadores a mantenerse al día con el rápido avance de la ciencia moderna. RDR cierra la brecha entre las encuestas escritas por expertos y la minería automatizada de literatura, ofreciendo procesos de análisis escalables, análisis de tendencias, conocimientos de conexión entre dominios y la generación de resúmenes estructurados y de alta calidad. Sirve como una herramienta de investigación integral, ayudando a los investigadores a comprender mejor el panorama general. (Fuente: TheTuringPost)

LangSmith lanza el Agent Builder sin código, empoderando a equipos no técnicos para construir agentes : LangSmith de LangChainAI ha lanzado el Agent Builder sin código, diseñado para reducir la barrera de entrada en la construcción de agentes de IA, permitiendo que equipos no técnicos creen agentes fácilmente. Esta herramienta, a través de una UX de construcción de agentes conversacional, una función de memoria incorporada que ayuda a los agentes a recordar y mejorar, y la capacidad de empoderar a equipos no técnicos y desarrolladores para construir agentes juntos, acelera la popularización y aplicación de los agentes de IA. (Fuente: LangChainAI)

Verdent integra MiniMax-M2, mejorando la capacidad y eficiencia de codificación : Verdent ahora es compatible con el modelo MiniMax-M2, ofreciendo a los usuarios capacidades de codificación avanzadas, agentes de alto rendimiento y activación eficiente de parámetros. Al probar MiniMax-M2 de forma gratuita en VS Code a través de Verdent, los desarrolladores pueden disfrutar de una experiencia de codificación más inteligente, rápida y rentable. Esta integración lleva la potente capacidad de MiniMax-M2 a una comunidad de desarrolladores más amplia. (Fuente: MiniMax__AI)

Base44 lanza un nuevo Builder, acelerando la conversión de conceptos a aplicaciones : Base44 ha lanzado un Builder completamente nuevo, marcando un cambio fundamental en su forma de trabajar. El nuevo Builder se asemeja más a un desarrollador experto, capaz de investigar antes de construir, obtener contexto de múltiples fuentes, depurar de forma inteligente y tomar decisiones arquitectónicas informadas. Esta actualización tiene como objetivo multiplicar por diez la velocidad de conversión de conceptos en aplicaciones funcionales, mejorando enormemente la eficiencia del desarrollo. (Fuente: MS_BASE44)

Qdrant y Confluent colaboran para potenciar agentes de IA conscientes del contexto en tiempo real : Qdrant se ha asociado con Confluent para proporcionar contexto fresco y en tiempo real a agentes de IA inteligentes y aplicaciones empresariales a través de Confluent Streaming Agents y Real-Time Context Engine. La capacidad de búsqueda vectorial de Qdrant, combinada con los datos de streaming en tiempo real de Confluent, permite a los desarrolladores construir y escalar agentes de IA impulsados por eventos y conscientes del contexto, desbloqueando así todo el potencial de la IA basada en agentes y reduciendo drásticamente el tiempo de resolución y los costos en escenarios como la respuesta a incidentes. (Fuente: qdrant_engine, qdrant_engine)

📚 Aprendizaje

ICLR26 Paper Finder: Herramienta de búsqueda de artículos de IA basada en LLM : Un desarrollador ha creado ICLR26 Paper Finder, una herramienta que utiliza modelos de lenguaje como columna vertebral para buscar artículos de conferencias de IA específicas. Los usuarios pueden realizar consultas por título, palabras clave e incluso resúmenes de artículos, siendo la búsqueda por resumen la más precisa. La herramienta está alojada en un servidor personal y en Hugging Face, proporcionando a los investigadores de IA un método eficiente para la recuperación de literatura. (Fuente: Reddit r/deeplearning, Reddit r/MachineLearning)

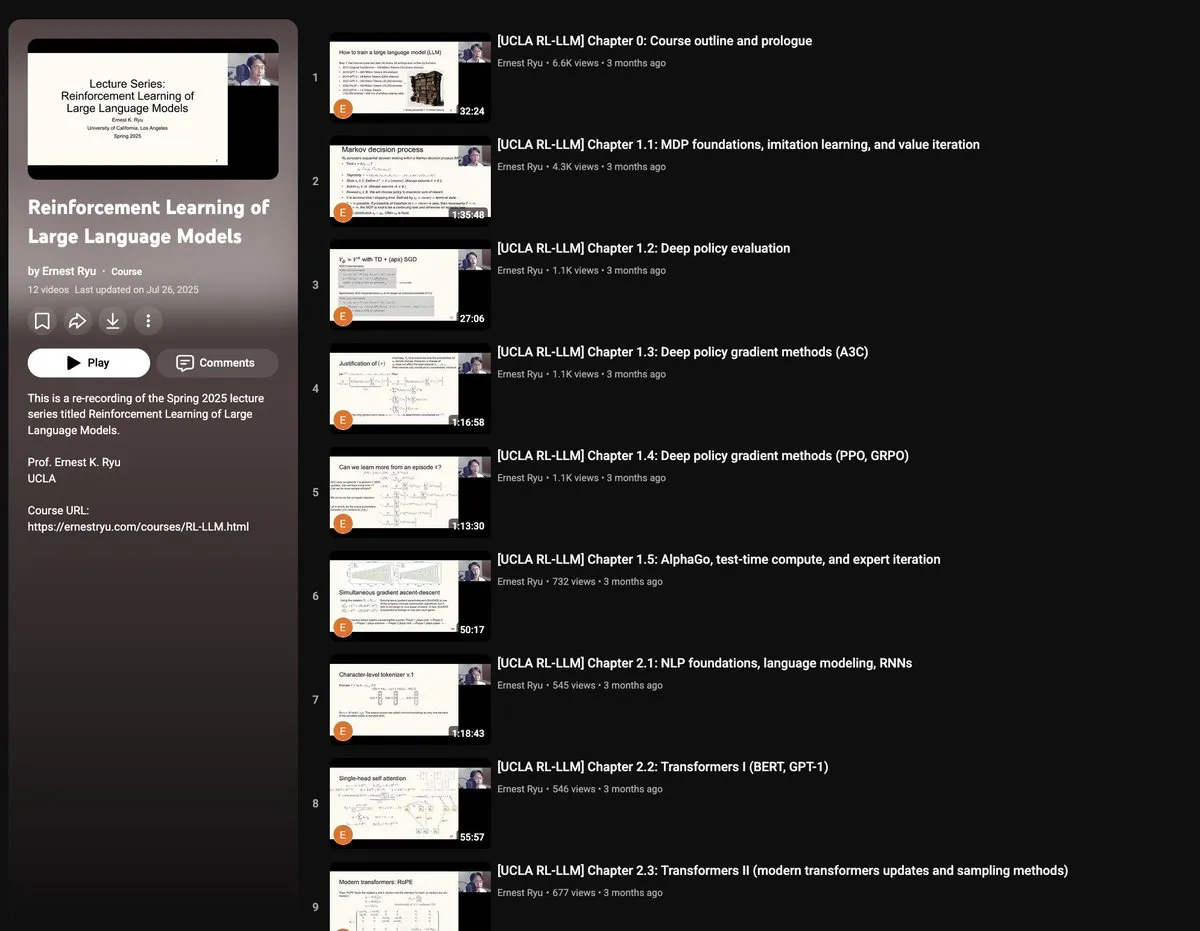

Curso de Primavera de UCLA 2025: Aprendizaje por Refuerzo para Large Language Models : UCLA ofrecerá en la primavera de 2025 un curso sobre “Aprendizaje por Refuerzo para Large Language Models”, que cubrirá una amplia gama de temas de RLxLLM, incluyendo fundamentos, computación en tiempo de prueba, RLHF (Reinforcement Learning from Human Feedback) y RLVR (Reinforcement Learning from Verifiable Rewards). Este nuevo conjunto de conferencias brinda a investigadores y estudiantes la oportunidad de profundizar en la teoría y práctica de vanguardia del aprendizaje por refuerzo para LLM. (Fuente: algo_diver)

Guía de Autoencoder dibujada a mano: Entendiendo los fundamentos de la IA generativa : ProfTomYeh ha publicado una guía detallada de 7 pasos sobre Autoencoder (autoencoder) dibujada a mano, con el objetivo de ayudar a los lectores a comprender esta red neuronal que desempeña un papel clave en la compresión, la eliminación de ruido y el aprendizaje de representaciones de datos ricas. El Autoencoder es la base de muchas arquitecturas generativas modernas, y esta guía explica de manera intuitiva cómo funciona para codificar y decodificar información, siendo un recurso valioso para aprender los conceptos centrales de la IA generativa. (Fuente: ProfTomYeh)

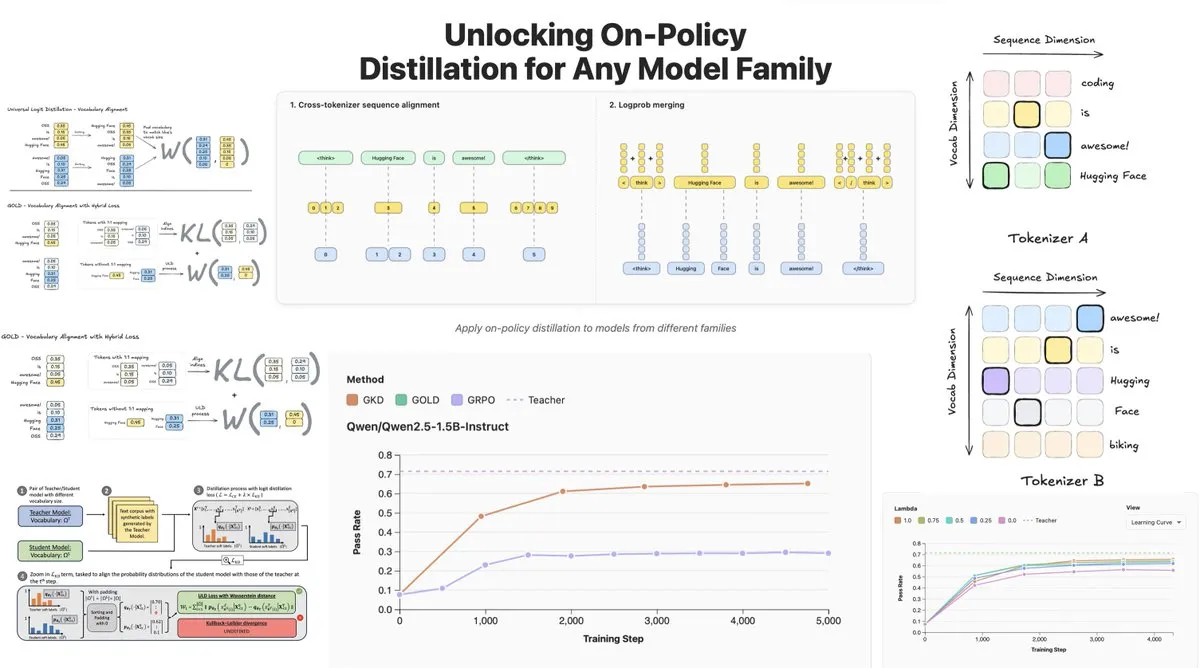

Hugging Face lanza On-Policy Logit Distillation, compatible con la destilación entre modelos : Hugging Face ha presentado General On-Policy Logit Distillation (GOLD), que amplía los métodos de destilación de políticas para permitir la destilación de cualquier modelo “maestro” a cualquier modelo “estudiante”, incluso si sus Tokenizer son diferentes. Esta tecnología se ha integrado en la biblioteca TRL, permitiendo a los desarrolladores seleccionar cualquier par de modelos del Hub para la destilación, lo que proporciona una enorme flexibilidad y capacidad de recuperación del rendimiento para el post-training de LLM, resolviendo especialmente el problema de la disminución del rendimiento general después del ajuste fino en dominios específicos. (Fuente: clefourrier, winglian, _lewtun)

Lumi: Google DeepMind utiliza Gemini 2.5 para asistir en la lectura de artículos de arXiv : El equipo PAIR de Google DeepMind ha lanzado Lumi, una herramienta que utiliza el gran modelo Gemini 2.5 para asistir en la lectura de artículos de arXiv. Lumi puede añadir resúmenes, referencias y preguntas y respuestas en línea a los artículos, ayudando a los investigadores a leer de forma más inteligente y eficiente, mejorando la comprensión de la literatura científica. (Fuente: GoogleDeepMind)

💼 Negocios

La IA impulsa ingresos récord para gigantes tecnológicos; Microsoft y Google presentan informes financieros brillantes : Alphabet, la empresa matriz de Google, y Microsoft han logrado resultados históricos en sus últimos informes financieros, con la IA como motor de crecimiento principal. Alphabet superó por primera vez los cien mil millones de dólares en ingresos trimestrales, alcanzando los 102.300 millones de dólares, con un crecimiento del 34% en Google Cloud y el 70% de los clientes existentes utilizando productos de IA. Los ingresos de Microsoft aumentaron un 18% hasta los 77.700 millones de dólares, con los ingresos de Intelligent Cloud superando por primera vez los 30.000 millones de dólares y un crecimiento del 40% en los servicios en la nube de Azure, impulsado significativamente por la IA. Ambas compañías planean aumentar drásticamente el gasto de capital en IA para consolidar su posición de liderazgo en el campo de la IA y obtener el reconocimiento del mercado de capitales. (Fuente: 36氪, Yuchenj_UW)

CTO de Block: El AI Agent Goose automatiza el 60% del trabajo complejo; la calidad del código no tiene relación directa con el éxito del producto : Dhanji R. Prasanna, CTO de Block (anteriormente Square), compartió cómo la empresa, a través del marco de AI Agent de código abierto “Goose”, ahorró a 12.000 empleados entre 8 y 10 horas de trabajo semanal en 8 semanas. Goose, basado en el Model Context Protocol (MCP), puede conectar herramientas empresariales para automatizar tareas como la escritura de código, la generación de informes y el procesamiento de datos. Prasanna enfatizó que las empresas nativas de IA deben redefinirse como empresas tecnológicas y ajustar sus estructuras organizativas. Propuso la visión contraintuitiva de que “la calidad del código no tiene relación directa con el éxito del producto”, argumentando que la clave es si el producto resuelve los problemas del usuario, y animó a los ingenieros a adoptar la IA, siendo los ingenieros experimentados y los novatos quienes muestran la mayor aceptación de las herramientas de IA. (Fuente: 36氪)

La industria de los humanos digitales entra en una fase de eliminación; la producción de humanos digitales 3D se orienta hacia plataformas : Con la explosión de los grandes modelos, la industria de los humanos digitales se enfrenta a una reestructuración, eliminando a las empresas que carecen de capacidades de IA. Los humanos digitales 2D representan el 70.1% del mercado, mientras que los humanos digitales 3D están limitados por la iteración tecnológica y los altos costos de GPU. Empresas líderes como MoFa Technology enfatizan que los humanos digitales 3D deben coincidir con las capacidades de los grandes modelos y señalan que la acumulación de datos de alta calidad, el talento escaso y una sólida capacidad artística son clave. La tendencia de la industria muestra que la producción de humanos digitales 3D está evolucionando hacia plataformas, y los avances en la tecnología de IA han reducido los costos, haciendo posible la aplicación a escala. Empresas como Yingmou Technology y Baidu también han lanzado plataformas de generación 3D, con el objetivo de convertir a los humanos digitales en infraestructura para potenciar más escenarios de aplicación. (Fuente: 36氪)

🌟 Comunidad

Percepción compleja de los usuarios sobre la emoción y la confianza en la IA: Comparación entre R2D2 y ChatGPT : Las redes sociales debaten acaloradamente las diferencias en la conexión emocional de los usuarios con R2D2 y ChatGPT. Los usuarios consideran a R2D2 adorable por su temperamento único, lealtad e imagen “similar a un caballo”, y porque no involucra problemas éticos sociales reales. Por otro lado, ChatGPT, como una “IA falsa real”, debido a su utilidad, las restricciones de censura de contenido y las preocupaciones sobre una posible vigilancia, dificulta el establecimiento de un vínculo emocional similar. Esta comparación revela que las expectativas de los usuarios hacia la IA no solo radican en la inteligencia, sino también en su experiencia de interacción “humanizada” y la percepción de su impacto social. (Fuente: Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT)

Limitaciones del asesoramiento psicológico con IA y la necesidad de intervención humana : Con el auge de los productos de asesoramiento psicológico con IA, la gente ha comenzado a usar la IA para abordar la soledad y los problemas psicológicos. Un estudio muestra que aproximadamente el 22% de los profesionales de la Generación Z han consultado a un psicólogo, y casi la mitad ha buscado asesoramiento de IA. La IA tiene ventajas en la provisión de información, la exclusión de factores y el acompañamiento, pero no puede reemplazar el papel de los psicólogos humanos en la empatía, la comprensión de las “señales no verbales” y la dirección del ritmo del tratamiento. Los casos demuestran que la IA requiere un mecanismo de interrupción manual al identificar riesgos extremos, y los humanos son indispensables en el juicio de los límites entre emociones y patologías, la acumulación de experiencia y la comunicación no verbal. La IA debe asumir principalmente tareas repetitivas y de apoyo, y reducir el umbral para buscar ayuda, con el objetivo final de guiar a las personas de vuelta a relaciones interpersonales reales. (Fuente: 36氪)

Interacción entre personas mayores y grandes modelos: Definiendo el “algoritmo” desde el “modo de vida” : La Universidad de Fudan y el Laboratorio Tencent SSV Time, entre otras instituciones, llevaron a cabo un estudio de un año de duración, enseñando a 100 personas mayores a usar grandes modelos. La investigación reveló que la actitud de los mayores hacia la IA no es de resistencia, sino de una “visión tecnológica pragmática” basada en sus experiencias de vida. Les preocupa más si la tecnología puede integrarse en su vida diaria y ofrecer compañía, en lugar de funciones extremas. En la calibración de la confianza, los mayores mostraron varios patrones como “corrección limitada”, “reciprocidad colaborativa” y “rigidez cognitiva”, además de “dudas al preguntar” y una “brecha de género”. Los grandes modelos que esperan son como “adivinos”, “médicos de confianza”, “amigos con quienes charlar” y “juguetes para relajarse”, es decir, una tecnología que “comprenda a las personas” de manera más suave y cercana a la vida cotidiana. Esto indica que el valor de la tecnología radica en cuánto tiempo puede esperar, no en qué tan rápido corre, y aboga por una tecnología “simbiótica” en lugar de “adaptada a la edad”, medida por los sentimientos, el ritmo y la dignidad humana. (Fuente: 36氪)

Impacto social de la IA: Desde la vigilancia de la privacidad hasta el consumo de energía y la transformación del empleo : Las redes sociales discuten ampliamente los múltiples impactos de la IA en la sociedad. Los usuarios temen que la IA ya esté realizando una “vigilancia invisible” a través de diversas aplicaciones, búsquedas y cámaras, prediciendo e influyendo en el comportamiento individual, en lugar de un control robótico de ciencia ficción. Al mismo tiempo, la enorme demanda de energía y recursos hídricos de los centros de datos de IA ha provocado protestas comunitarias, resultando en cortes de energía y escasez de agua. Además, la IA mejora la productividad en la generación de código y la automatización de tareas, pero suscita debates sobre los cambios en la estructura del empleo y los desafíos de la calidad del código de IA para la eficiencia de la producción. Estas discusiones reflejan las complejas emociones del público sobre las comodidades y los riesgos potenciales que trae la tecnología de IA. (Fuente: Reddit r/artificial, MIT Technology Review, MIT Technology Review, Ronald_vanLoon, Ronald_vanLoon)

Rápida evolución de la terminología y los conceptos en el campo de la IA : La comunidad discute que la terminología y los conceptos en el campo de la IA están evolucionando rápidamente. Por ejemplo, “entrenar/construir un modelo” a menudo se refiere a “ajuste fino”, y el “ajuste fino” se considera una nueva forma de “ingeniería de prompts/contexto”. Este cambio refleja la creciente complejidad de la pila tecnológica de IA y la necesidad de operaciones más refinadas. Además, en cuanto al equilibrio entre la velocidad y la inteligencia del modelo, los desarrolladores tienden a preferir modelos “lentos pero inteligentes”, ya que pueden proporcionar resultados más fiables, incluso si esto implica más tiempo de espera. (Fuente: dejavucoder, dejavucoder, dejavucoder)

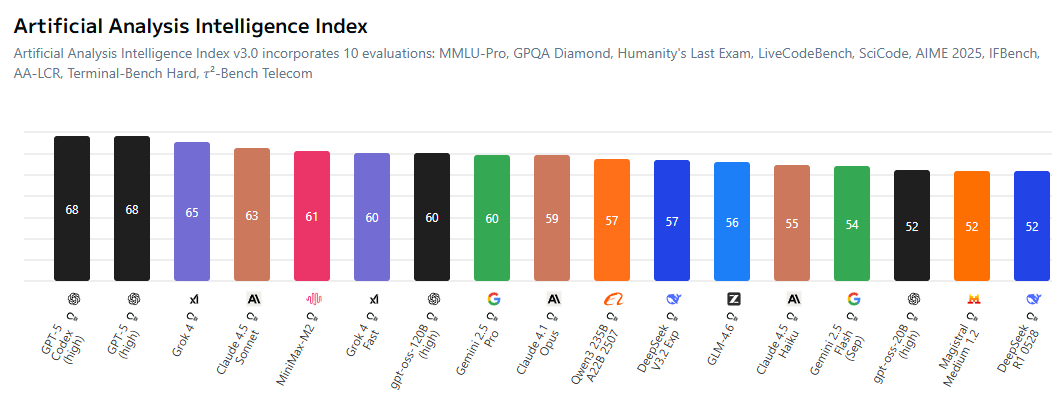

Aumenta la competencia entre el ecosistema de IA de código abierto y los modelos propietarios : La comunidad debate que la brecha entre los modelos de IA de código abierto y los propietarios se está reduciendo, lo que obliga a los laboratorios de código cerrado a ser más competitivos en sus precios. Modelos de código abierto como MiniMax-M2 han demostrado un rendimiento excepcional en el AI Index y tienen costos extremadamente bajos. Al mismo tiempo, las empresas chinas y las startups están abriendo activamente la tecnología de IA, mientras que las empresas estadounidenses están relativamente rezagadas en este aspecto. Esta tendencia presagia una era en la que “todos entrenarán modelos basados en código abierto” en el campo de la IA, impulsando la democratización y la innovación de la tecnología de IA. (Fuente: ClementDelangue, huggingface, clefourrier, huggingface)

Impacto y desafíos éticos del contenido generado por IA en las industrias tradicionales : El contenido generado por IA está penetrando cada vez más en las industrias tradicionales, como los “artistas” impulsados por IA que llegan a las listas de éxitos musicales, y la tecnología de deepfake utilizada para el fraude (como un falso discurso de Jensen Huang promocionando una estafa de criptomonedas). Estos fenómenos han provocado debates sobre derechos de autor, ética y regulación. Al mismo tiempo, la IA también ha traído nuevas herramientas de productividad en la generación de código y la gestión automatizada de cuentas de redes sociales, pero la calidad y fiabilidad de su contenido generado aún requieren la revisión humana. Esto subraya el desafío de cómo equilibrar la innovación tecnológica con la responsabilidad social y las normas éticas en el proceso de popularización de la IA. (Fuente: Reddit r/artificial, 36氪, jeremyphoward)

La comunidad de investigación de IA se centra en la calidad de los datos y la evaluación : La comunidad de investigación de IA presta cada vez más atención al papel crucial de la calidad de los datos en el entrenamiento de modelos, señalando que obtener datos de alta calidad es más desafiante que alquilar GPU o escribir código. Al mismo tiempo, existe un amplio debate sobre las limitaciones de los puntos de referencia de evaluación, argumentando que los existentes pueden no reflejar completamente las capacidades reales de los modelos y son susceptibles de una optimización excesiva. Los investigadores piden el desarrollo de sistemas de evaluación más informativos y realistas para promover el desarrollo saludable de la investigación de IA. (Fuente: code_star, code_star, clefourrier, tokenbender)

Aplicaciones y perspectivas de la IA en el sector de la salud : La IA muestra un enorme potencial en el sector de la salud. Por ejemplo, CloudPeng Technology ha lanzado nuevos productos de IA+salud, incluyendo un laboratorio de cocina inteligente y un refrigerador inteligente equipado con un gran modelo de salud de IA, que ofrecen gestión personalizada de la salud. Además, MONAI, como kit de herramientas de IA para imágenes médicas, proporciona un marco de código abierto PyTorch. Los exoesqueletos impulsados por IA ayudan a los usuarios de sillas de ruedas a ponerse de pie y caminar, y los agentes de diagnóstico LLM aprenden estrategias de diagnóstico en entornos clínicos virtuales. Estos avances presagian que la IA transformará profundamente los servicios de salud, desde la gestión diaria de la salud hasta el diagnóstico y tratamiento asistidos. (Fuente: 36氪, GitHub Trending, Ronald_vanLoon, Ronald_vanLoon, HuggingFace Daily Papers)

Transformación organizacional y demanda de talento en la era de la IA : Con la popularización de la IA, las empresas se enfrentan a una profunda transformación en sus estructuras organizativas y necesidades de talento. Dhanji R. Prasanna, CTO de Block, enfatiza que las empresas deben redefinirse como “compañías tecnológicas” y pasar de un “sistema de gerencia general” a un “sistema funcional” para concentrar el enfoque tecnológico. Herramientas de IA como Goose pueden mejorar significativamente la productividad, pero la arquitectura y el diseño de alto nivel aún requieren ingenieros experimentados. Al contratar, las empresas valoran más la mentalidad de aprendizaje y el pensamiento crítico que la mera habilidad en el uso de herramientas de IA. La IA también difumina los límites de los puestos de trabajo, con roles no técnicos comenzando a utilizar herramientas de IA, impulsando la formación de un modelo de colaboración “humano-máquina”. (Fuente: 36氪, MIT Technology Review, NandoDF, SakanaAILabs)

💡 Otros

Innovación continua en robótica multifuncional : El campo de la robótica muestra una innovación diversificada, incluyendo el robot SpiRobs inspirado en pulpos, drones capaces de nadar, el robot Helix para la clasificación de paquetes, y robots humanoides que asisten en la inspección de calidad en la fábrica de NIO. Estos avances abarcan el diseño biónico, la automatización, la colaboración humano-robot y la adaptabilidad a entornos especiales, presagiando el amplio potencial de la tecnología robótica en aplicaciones industriales, militares y cotidianas. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Profundización del concepto de AI Agent y perspectivas de mercado : Los AI Agent se definen como entidades inteligentes capaces de razonar y adaptarse como los humanos, permitiendo una conversación fluida entre humanos y máquinas. Se consideran una tendencia futura en el trabajo, y están surgiendo numerosas herramientas para construir AI Agent en el mercado. El valor central de los AI Agent radica en convertirse en “herramientas de producción” capaces de ejecutar tareas reales, y no solo herramientas auxiliares de “chat”, y su desarrollo impulsará la aplicación profunda de la IA en diversos campos. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, dotey)

IA y conducción autónoma: La flota de Uber adopta nuevos chips de Nvidia, impulsando el desarrollo de taxis robot : La próxima generación de la flota de vehículos autónomos de Uber adoptará los nuevos chips de Nvidia, lo que se espera que reduzca el costo de los taxis robot. La plataforma Drive Hyperion de Nvidia es una arquitectura estandarizada para vehículos “listos para taxis robot”, y la colaboración con Uber impulsará la popularización de la tecnología de conducción autónoma entre los consumidores. Esto indica que la aplicación de la IA en el sector del transporte se está acelerando, con el objetivo de lograr servicios de conducción autónoma más seguros y económicos. (Fuente: MIT Technology Review, TheTuringPost)