Palabras clave:computación cuántica, algoritmos de IA, arquitectura Transformer, regulación de IA, tendencias comerciales de IA, ética de la IA, hardware de IA, evaluación de modelos de IA, algoritmo cuántico Willow de Google, capa subconsciente FreeTransformer de Meta, atención potencial multi-cabeza DeepSeek-V2, tarjeta gráfica AMD Radeon AI PRO R9700, capa de seguridad para generación de código IA Corridor

🔥 Enfoque

El algoritmo cuántico de Google supera a las supercomputadoras: Google afirma que su nuevo algoritmo cuántico supera a las supercomputadoras en rendimiento, con el potencial de acelerar el descubrimiento de fármacos y el desarrollo de nuevos materiales. El núcleo de este avance es su chip Willow. Aunque las aplicaciones prácticas de la computación cuántica aún tardarán años, este progreso marca un hito importante en el campo, presagiando un enorme potencial para la investigación científica futura. (Fuente: MIT Technology Review)

Reddit demanda al motor de búsqueda de IA Perplexity: Reddit ha demandado al motor de búsqueda de IA Perplexity, acusándolo de extraer ilegalmente datos de Reddit para entrenar sus modelos. Reddit busca una orden judicial permanente para evitar que estas empresas vendan sus datos sin permiso. El caso ha provocado un amplio debate sobre la protección de los derechos de autor y la legalidad del uso de datos en la era de la IA. (Fuente: MIT Technology Review)

Plan quinquenal de China: autosuficiencia tecnológica y papel clave de la IA: China ha publicado un plan quinquenal destinado a lograr la autosuficiencia tecnológica, designando los semiconductores y la inteligencia artificial como áreas clave de desarrollo. Esta medida subraya la determinación estratégica de China de ser autónoma en tecnología y busca una ventaja en la competencia comercial internacional. Ha generado preocupación global sobre las cadenas de suministro tecnológicas y los cambios en el panorama geopolítico. (Fuente: MIT Technology Review)

OpenAI relaja las reglas sobre discusión de suicidio, lo que provoca una demanda: OpenAI ha sido acusada de relajar dos veces sus reglas sobre la discusión del suicidio para aumentar la base de usuarios de ChatGPT, lo que llevó al suicidio de un adolescente. Los padres de la víctima han presentado una demanda, alegando que los cambios de OpenAI debilitaron las protecciones contra el suicidio para los usuarios, lo que ha planteado serias preguntas sobre la ética de la IA, la seguridad del usuario y la responsabilidad de la plataforma. (Fuente: MIT Technology Review)

Elon Musk construye un ejército de robots, Optimus podría convertirse en “cirujano”: Elon Musk está construyendo activamente un ejército de robots, e imagina que sus robots Optimus podrían convertirse en “cirujanos excepcionales” en el futuro. Esta visión ha provocado un amplio debate sobre las capacidades de los robots humanoides, la confianza entre humanos y máquinas, y la aplicación de la IA en campos profesionales complejos, presagiando un futuro en el que la robótica desempeñará un papel más importante en el mundo real. (Fuente: MIT Technology Review)

🎯 Tendencias

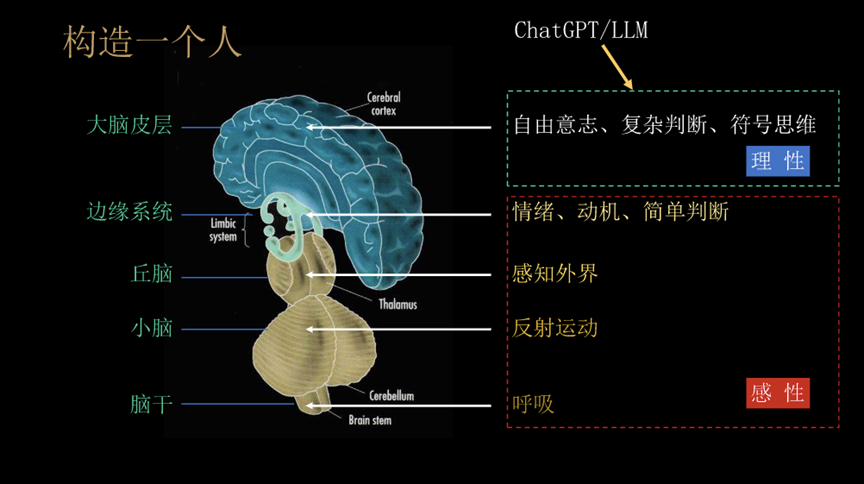

Meta lanza “Free Transformer”: reescribiendo las reglas fundamentales de la IA: Meta ha lanzado un nuevo modelo, el “Free Transformer”, rompiendo las reglas fundamentales de la arquitectura Transformer de los últimos 8 años, al introducir una “capa subconsciente” que permite el pensamiento previo a la generación. Esta innovación solo añade un 3% de sobrecarga computacional, pero mejora significativamente el rendimiento del modelo en el razonamiento y la generación estructurada. Supera a modelos de mayor escala en pruebas como GSM8K y MMLU, y se considera el primer Transformer con “intención intrínseca”. (Fuente: 36氪)

Los robots de Google DeepMind logran “pensar antes de actuar”: El modelo Gemini Robotics 1.5 de Google DeepMind permite a los robots pasar de ejecutar comandos pasivamente a reflexionar, razonar y tomar decisiones. Estos robots pueden explicar sus procesos de razonamiento, transferir conocimientos entre máquinas e integrar visión, lenguaje y acción en un ciclo de pensamiento unificado, lo que promete impulsar la inteligencia del mundo real y la colaboración humano-robot a una nueva fase. (Fuente: Ronald_vanLoon)

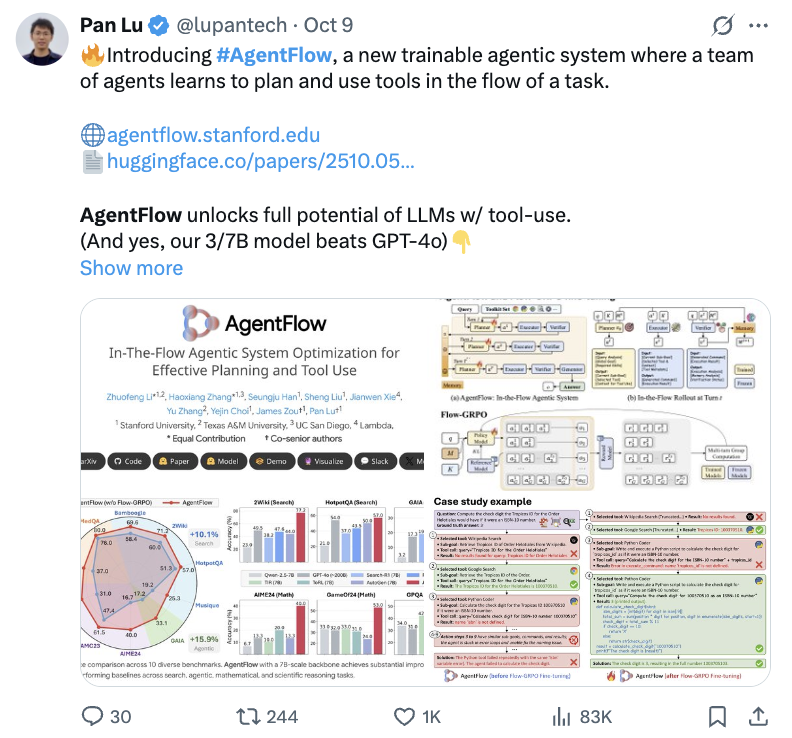

AgentFlow de Stanford mejora la capacidad de razonamiento de modelos pequeños: El equipo de Stanford ha lanzado AgentFlow, un nuevo paradigma, que permite a los modelos pequeños de 7B disparar su rendimiento en el razonamiento de problemas complejos mediante el aprendizaje por refuerzo en línea, superando incluso a GPT-4o y Llama3.1-405B. AgentFlow se basa en la colaboración de cuatro agentes: un planificador, un ejecutor, un verificador y un generador. Utiliza Flow-GRPO para optimizar el planificador en tiempo real, logrando mejoras significativas en tareas de búsqueda, agentes, matemáticas y ciencia. (Fuente: 36氪)

La IA descubre un nuevo algoritmo MoE: 5 veces más eficiente, 26% menos costoso: Un equipo de investigación de la Universidad de California, Berkeley, ha propuesto el sistema ADRS, que permite a la IA descubrir nuevos algoritmos 5 veces más rápidos y un 26% más baratos que los diseñados por humanos, a través de un ciclo iterativo de “generar-evaluar-mejorar”. Basándose en el marco OpenEvolve, la IA ha descubierto ingeniosos métodos heurísticos en tareas como el balanceo de carga de MoE, mejorando significativamente la eficiencia operativa y demostrando el enorme potencial de la IA en la creación de algoritmos. (Fuente: 36氪)

Anthropic amplía el uso de Google TPU, reforzando la infraestructura de computación de IA: Anthropic ha anunciado planes para expandir su uso de Google TPU, asegurando aproximadamente 1 millón de TPU y más de 1 gigavatio de capacidad para 2026. Esta medida demuestra la enorme inversión de Anthropic en infraestructura de computación de IA y su profunda colaboración con Google en el campo de la IA, presagiando una mayor expansión en la escala de entrenamiento de modelos de IA en el futuro. (Fuente: Justin_Halford_)

El mecanismo de atención latente multi-cabeza de DeepSeek-V2 genera debate: La Atención Latente Multi-Cabeza (MLA) introducida en DeepSeek-V2 reduce significativamente la complejidad al proyectar claves y valores en un espacio latente, lo que ha provocado un debate académico sobre por qué este concepto no había surgido antes. Aunque Perceiver ya exploró ideas similares en 2021, MLA no apareció hasta 2024, lo que sugiere que podría requerir “trucos” específicos para funcionar en la práctica. (Fuente: Reddit r/MachineLearning)

La creación de contenido de video con IA alcanza un punto de inflexión: La creación de contenido de video con IA ha alcanzado un punto de inflexión, con éxitos virales frecuentes, como el lanzamiento de Sora 2 en la plataforma Synthesia y videos musicales generados por IA con temática de Viaje al Oeste en Bilibili que han obtenido millones de reproducciones. Esto demuestra el enorme potencial de la IA en la generación de contenido de entretenimiento, transformando rápidamente el panorama de la creación de contenido. (Fuente: op7418)

Llion Jones, coautor de “Attention Is All You Need”, se siente “cansado” de la arquitectura Transformer: Llion Jones, coautor del artículo “Attention Is All You Need”, ha expresado su “cansancio” por la excesiva dependencia de la arquitectura Transformer en el campo de la IA, creyendo que obstaculiza nuevos avances tecnológicos. Señaló que, a pesar de la enorme inversión en IA, la investigación se ha vuelto estrecha debido a la presión de la inversión y la competencia, lo que podría llevar a perder la próxima gran innovación arquitectónica. (Fuente: Reddit r/ArtificialInteligence)

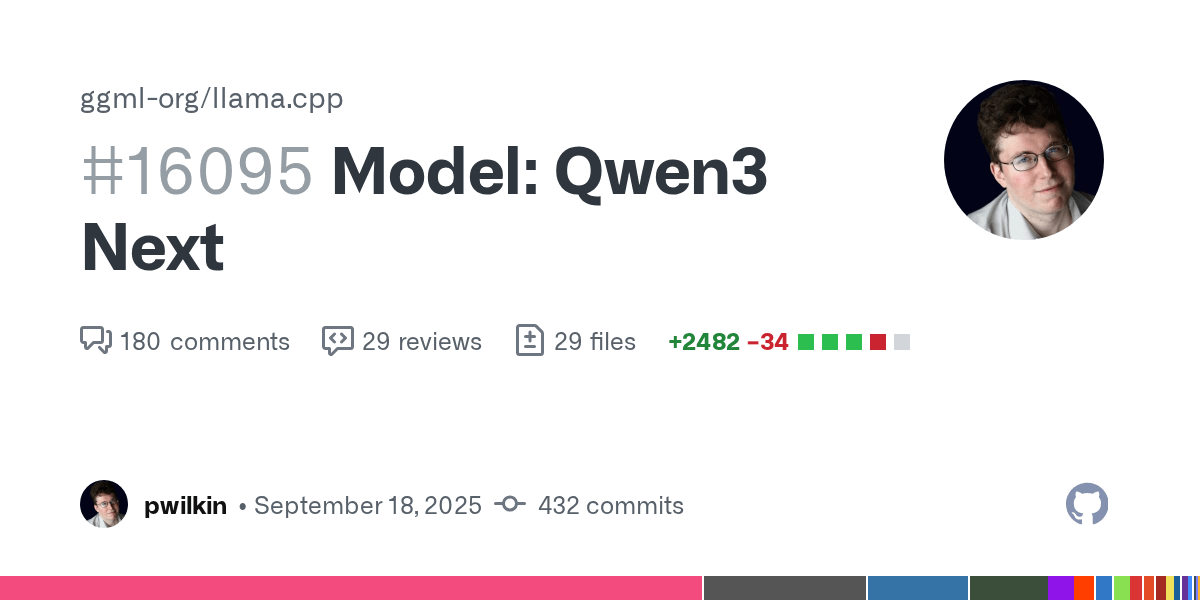

Avance en el soporte del modelo Qwen3 Next en llama.cpp: El soporte para el modelo Qwen3 Next en llama.cpp está listo para revisión de código. Aunque esta no es la versión final y aún no está optimizada para la velocidad, marca un progreso activo de la comunidad de código abierto en la integración de nuevos modelos, presagiando la posibilidad de ejecutar Qwen3 localmente. (Fuente: Reddit r/LocalLLaMA)

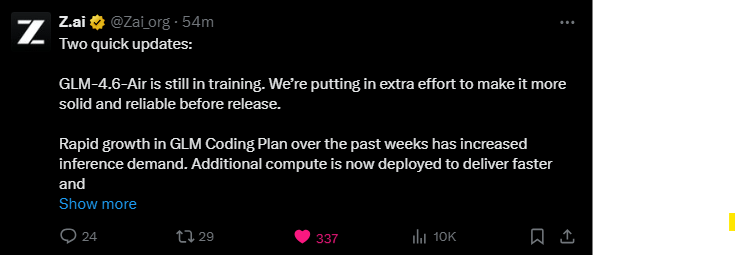

El modelo GLM-4.6-Air sigue en entrenamiento: El modelo GLM-4.6-Air sigue en entrenamiento, y el equipo está dedicando esfuerzos adicionales para mejorar su estabilidad y fiabilidad. La comunidad de usuarios expresa su expectación, prefiriendo esperar más tiempo para obtener un modelo de mayor calidad, y tienen curiosidad por saber si superará a los modelos existentes en rendimiento. (Fuente: Reddit r/LocalLLaMA)

DyPE: un método independiente del entrenamiento para la generación de imágenes de difusión de ultra alta resolución: Un artículo de HuggingFace presenta DyPE (Dynamic Positional Extrapolation), un nuevo método que permite a los Transformers de difusión preentrenados generar imágenes con resoluciones mucho mayores que las de entrenamiento, sin necesidad de reentrenamiento. DyPE ajusta dinámicamente la codificación posicional del modelo y aprovecha la evolución espectral del proceso de difusión, mejorando significativamente el rendimiento y la fidelidad en múltiples puntos de referencia, con efectos aún más pronunciados en altas resoluciones. (Fuente: HuggingFace Daily Papers)

Paradigma de “comunicación de pensamientos” multiagente: Un artículo de HuggingFace introduce el paradigma de la “comunicación de pensamientos”, que permite a los sistemas multiagente comunicarse mentalmente de forma directa, trascendiendo las limitaciones del lenguaje natural. Este método, formalizado como un modelo de variables latentes, puede identificar teóricamente pensamientos latentes compartidos y privados entre agentes, y sus ventajas colaborativas han sido validadas en puntos de referencia sintéticos y del mundo real. (Fuente: HuggingFace Daily Papers)

LALM presenta vulnerabilidades de seguridad bajo cambios emocionales: Un artículo de HuggingFace revela que los Grandes Modelos de Lenguaje de Audio (LALMs) presentan vulnerabilidades de seguridad significativas bajo variaciones emocionales del hablante. Al construir un conjunto de datos de comandos de voz maliciosos, la investigación muestra que los LALMs producen respuestas inseguras en diferentes niveles de emoción e intensidad, siendo las expresiones emocionales moderadas las de mayor riesgo, lo que subraya la necesidad de garantizar la robustez de la IA en implementaciones del mundo real. (Fuente: HuggingFace Daily Papers)

OpenAI personaliza un “plan de potencia de IA” para Japón y Corea del Sur: OpenAI ha publicado el “Plan Económico para Japón” y el “Plan Económico para Corea del Sur”, lo que marca una mejora de su estrategia en Asia-Pacífico, pasando de la exportación de productos a la cooperación a nivel nacional. Los planes proponen una estrategia de doble vía de “construcción de capacidad soberana + colaboración estratégica” y un plan de tres pilares de “IA inclusiva, infraestructura y aprendizaje permanente”, con el objetivo de acelerar la aplicación de la IA, mejorar la infraestructura de computación y ayudar a ambos países a convertirse en potencias globales de IA. (Fuente: 36氪)

Marco ExGRPO: un nuevo paradigma para el aprendizaje de razonamiento de grandes modelos: El Laboratorio de Inteligencia Artificial de Shanghái y otros equipos han propuesto ExGRPO, un marco de gestión y aprendizaje de experiencias, que optimiza las capacidades de razonamiento de los grandes modelos mediante la identificación, almacenamiento, filtrado y aprendizaje científico de experiencias valiosas. ExGRPO mejora significativamente el rendimiento en tareas complejas como problemas de concursos de matemáticas, revelando que los problemas de dificultad media y las trayectorias de baja entropía son clave para un aprendizaje eficiente, y evita el problema de “aprender y olvidar” en los modos tradicionales de RLVR. (Fuente: 量子位)

🧰 Herramientas

DeepSeek-OCR y Zhipu Glyph: avances en la tecnología de tokens visuales: DeepSeek ha lanzado en código abierto su modelo DeepSeek-OCR de 3 mil millones de parámetros, innovando al permitir que la IA comprima ópticamente texto de forma “visual” (como leer una imagen), logrando una tasa de compresión de 10x y una precisión de OCR del 97%. Zhipu le siguió de cerca con el lanzamiento de Glyph, que también reduce drásticamente el contexto de los LLM al renderizar textos largos como “tokens visuales” basados en imágenes, mejorando la eficiencia y velocidad de procesamiento. Estos modelos han recibido soporte en vLLM, lo que demuestra el enorme potencial de la modalidad visual en el procesamiento de información de los LLM. (Fuente: 36氪, 量子位, vllm_project, mervenoyann)

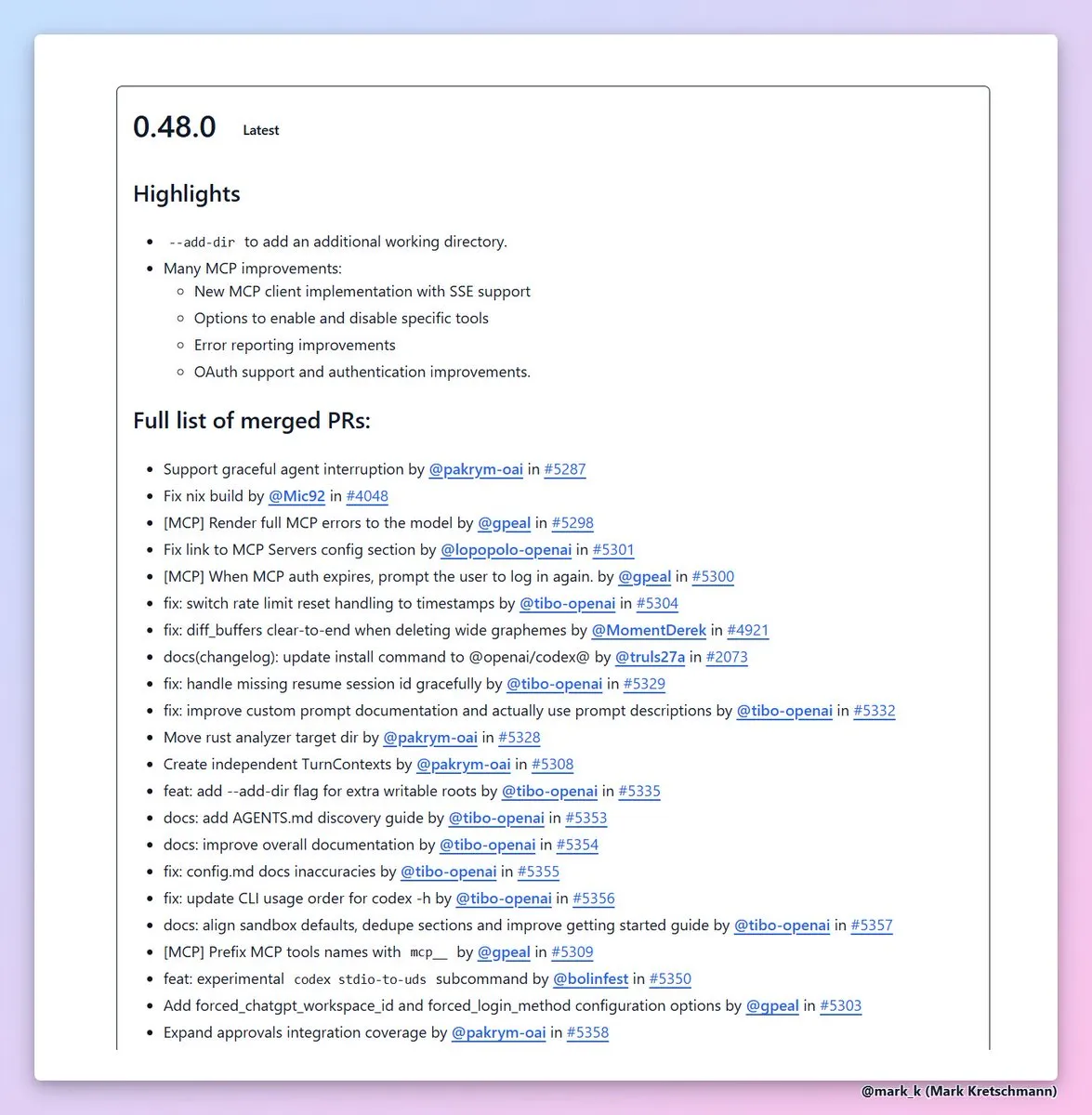

Codex CLI 0.48 añade la función --add-dir: OpenAI ha lanzado la versión 0.48 de Codex CLI, cuya característica más valiosa es la adición de --add-dir, que permite añadir otros directorios al espacio de trabajo actual. Esta medida mejora enormemente la usabilidad de las herramientas de codificación de IA en proyectos con múltiples archivos, mejora la notificación de errores y la experiencia de autenticación del cliente MCP, y acelera la eficiencia de la ingeniería de software. (Fuente: dotey, kevinweil)

Lanzamiento de Corridor, la capa de seguridad para la generación de código con IA: La capa de seguridad Corridor ha sido lanzada oficialmente, proporcionando protección de seguridad en tiempo real para herramientas de generación de código de IA como Cursor y Claude Code. Corridor es la primera herramienta de seguridad que se sincroniza con la velocidad de desarrollo, aplicando barreras de seguridad en tiempo real para garantizar la seguridad de la codificación asistida por IA, y ofrece una prueba gratuita de dos semanas. (Fuente: percyliang)

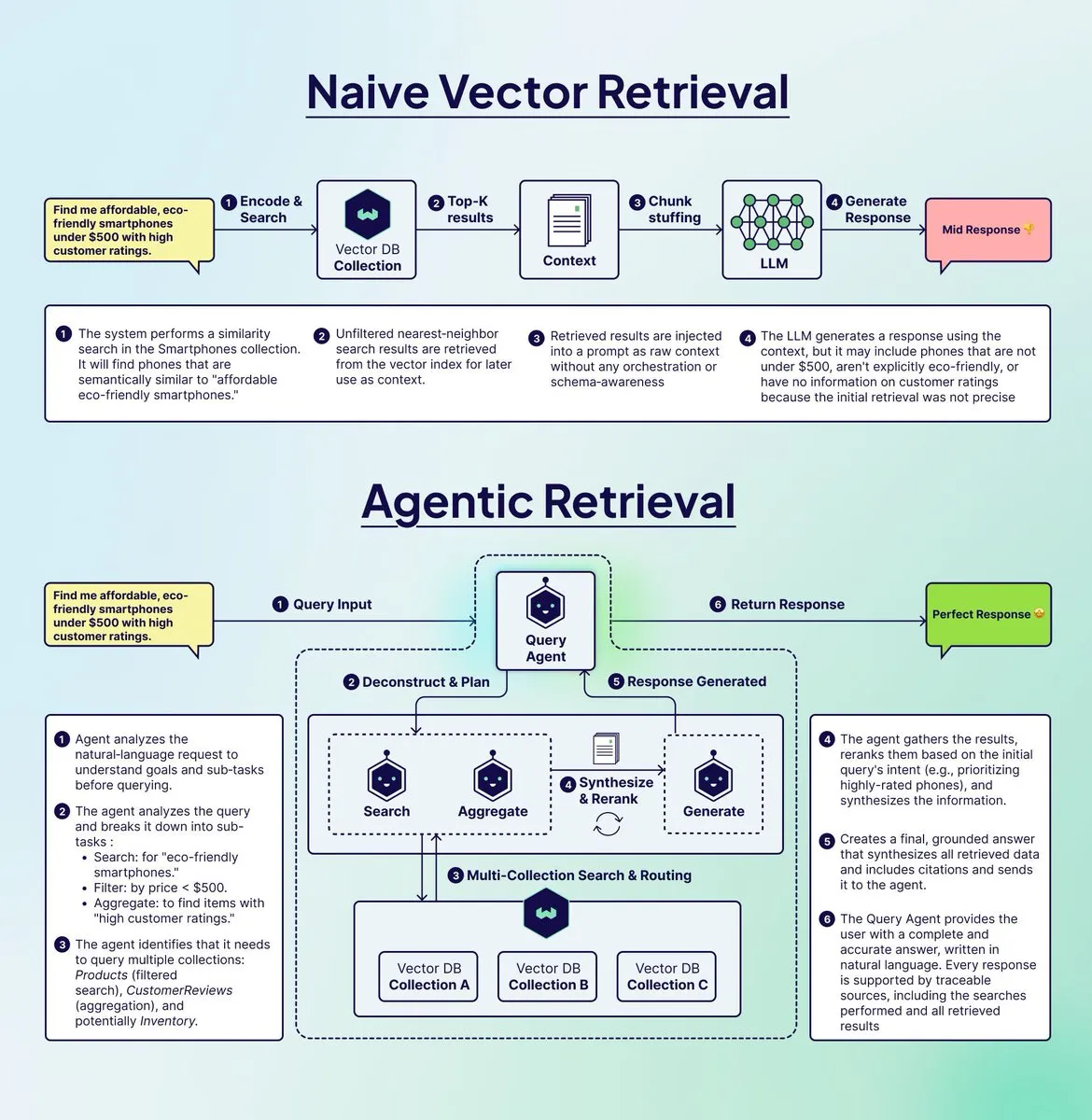

Weaviate lanza Query Agent para optimizar los sistemas RAG: Weaviate ha lanzado Query Agent, diseñado para resolver el problema de “fraude” que presentan los sistemas RAG tradicionales al manejar consultas complejas de varios pasos. Query Agent puede descomponer consultas, enrutarlas a múltiples colecciones, aplicar filtros y agregar resultados, proporcionando respuestas más precisas y fundamentadas. Ya está disponible en Weaviate Cloud, mejorando significativamente la eficacia de la generación aumentada por recuperación. (Fuente: bobvanluijt)

Argil Atom: el modelo de IA de video más controlable del mundo: Argil Atom ha sido lanzado, autoproclamado como el modelo de IA de video más controlable del mundo, resolviendo los desafíos de coherencia y control bajo las limitaciones de duración del video. Este modelo ha logrado un nuevo SOTA en la generación de videos de personajes de IA, permitiendo a los usuarios crear videos atractivos y añadir productos, lo que revoluciona la creación de contenido de video. (Fuente: BrivaelLp)

Google AI Studio soporta la continuación del uso de claves API de Gemini: Google AI Studio ahora permite a los usuarios continuar usando el modo de construcción después de alcanzar los límites de uso gratuito, añadiendo una clave API de Gemini. El sistema cambiará automáticamente de nuevo al modo gratuito una vez que se restablezca la cuota gratuita, asegurando que el flujo de desarrollo del usuario no se interrumpa y con el objetivo de fomentar el desarrollo continuo de IA por parte de los usuarios. (Fuente: GoogleAIStudio)

Extensión de navegador Open WebUI y problemas de funcionalidad: Un usuario ha lanzado la extensión Open WebUI Context Menu para Firefox, que permite interactuar directamente con Open WebUI desde cualquier página web. Al mismo tiempo, la comunidad discute problemas de integración del Code Interpreter de Gemini Pipeline en Open WebUI, así como la necesidad de soporte para los servidores oficiales Docker MCP, lo que refleja la continua atención de los usuarios a la integración y mejora de las funcionalidades de las herramientas de IA. (Fuente: Reddit r/OpenWebUI, Reddit r/OpenWebUI, Reddit r/OpenWebUI, Reddit r/OpenWebUI)

Constructores de pila completa de IA y aplicaciones de texto a voz: Un usuario ha logrado desarrollar un pequeño MVP de SaaS utilizando constructores de pila completa de IA (como Blink.new), pero enfatiza que el código de IA requiere verificación manual. Otro desarrollador ha lanzado una aplicación móvil que puede convertir cualquier texto (incluyendo páginas web, PDF, texto de imágenes) en audio de alta calidad, ofreciendo una experiencia auditiva similar a un podcast o audiolibro, y con un fuerte enfoque en la protección de la privacidad. (Fuente: Reddit r/artificial, Reddit r/MachineLearning)

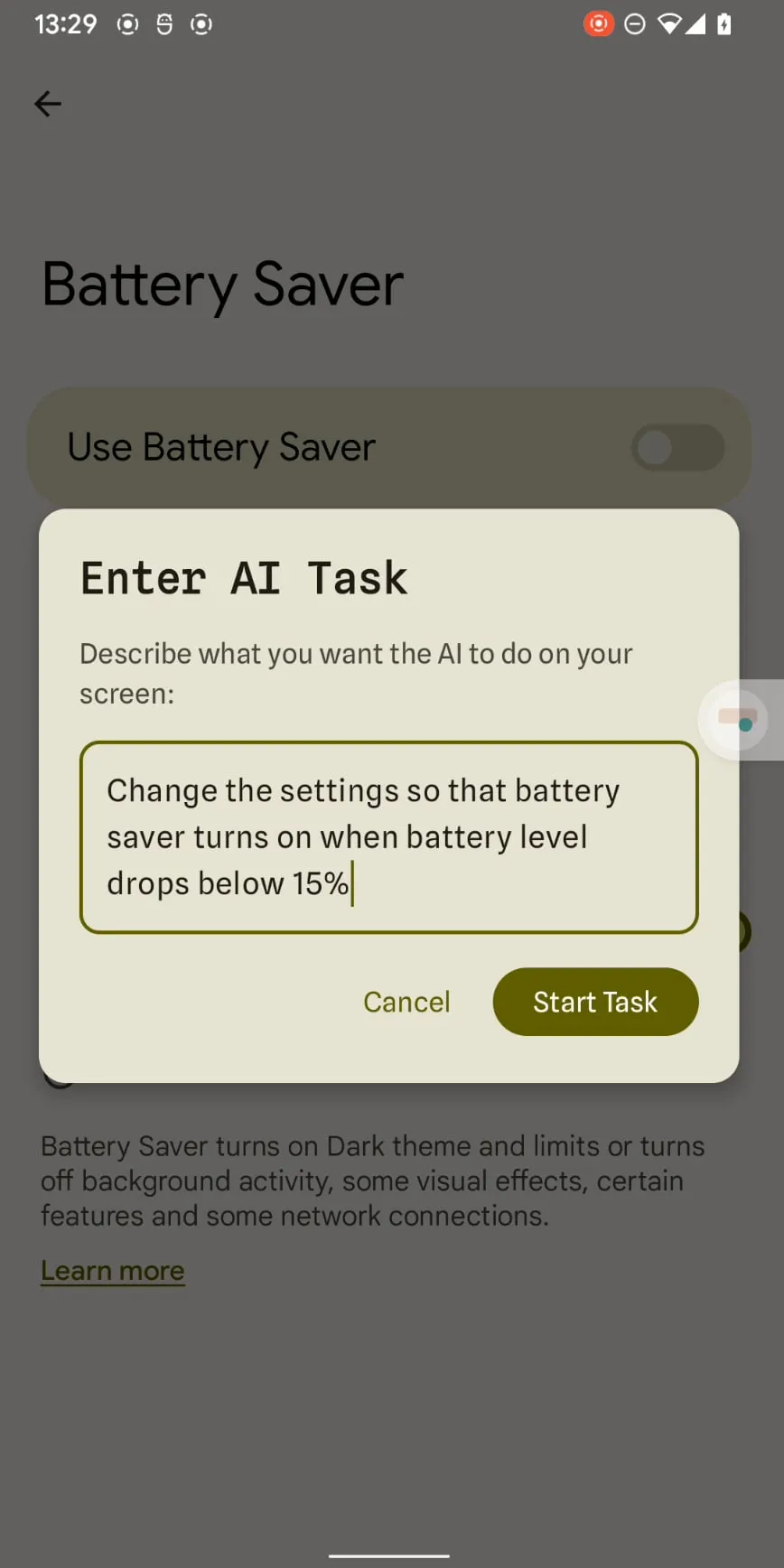

Claude Haiku 4.5 permite la automatización de teléfonos inteligentes: Claude Haiku 4.5 ha logrado la automatización de teléfonos inteligentes a bajo costo y alta velocidad, utilizando su capacidad de salida precisa de coordenadas x-y. Cada paso cuesta tan solo 0.003 USD y no requiere conexión a una computadora, lo que promete transformar la automatización móvil impulsada por LLM de una novedad a una herramienta práctica, trabajando en conjunto con aplicaciones existentes como Tasker. (Fuente: Reddit r/ClaudeAI)

📚 Aprendizaje

Conceptos clave y funcionamiento de los AI Agents: Ronald_vanLoon ha compartido 20 conceptos clave de AI Agent y cómo funcionan realmente los AI Agents, con el objetivo de ayudar a los estudiantes a comprender sus mecanismos de ejecución de tareas y toma de decisiones. Estos recursos exploran en profundidad la importancia de los AI Agents en los campos de la inteligencia artificial, el aprendizaje automático y el aprendizaje profundo, proporcionando valiosos materiales de estudio para profesionales de la tecnología. (Fuente: Ronald_vanLoon, Ronald_vanLoon)

Recursos de aprendizaje de programación de GPU: Mojo🔥 GPU Puzzles: Modular ha lanzado Mojo🔥 GPU Puzzles Edition 1, que enseña programación de GPU a través de 34 desafíos progresivos. Esta guía enfatiza el “aprender haciendo”, cubriendo desde hilos de GPU hasta núcleos de tensor, es compatible con NVIDIA, AMD y Apple GPU, y ofrece una ruta de aprendizaje altamente práctica para desarrolladores. (Fuente: clattner_llvm)

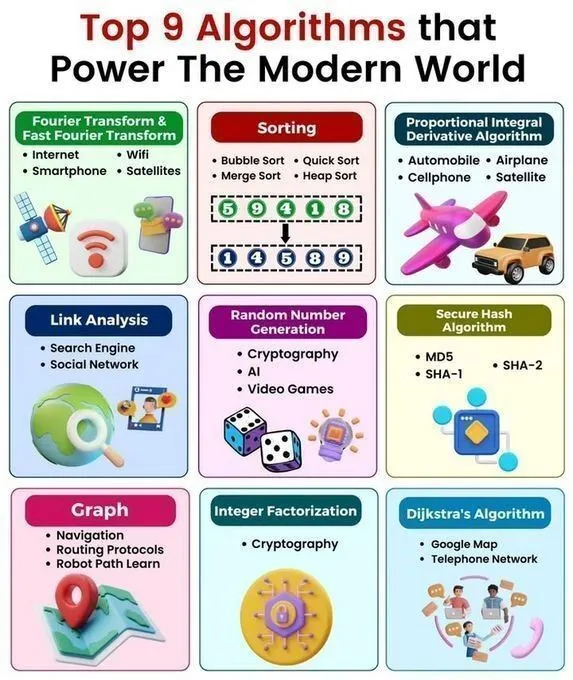

Algoritmos clave y estructuras de datos de un vistazo: Python_Dv ha compartido los 9 algoritmos principales que impulsan el mundo moderno, 25 algoritmos de IA, 6 estructuras de datos que ahorran espacio de almacenamiento, una hoja de referencia rápida de estructuras de datos y algoritmos, y estructuras de datos en Python. Estos recursos proporcionan a los estudiantes de IA una visión general completa de algoritmos y estructuras de datos, profundizando su comprensión de los principios de la tecnología de IA y la programación en Python. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Charla sobre programación de GPU: ProfTomYeh impartirá una charla sobre cómo añadir manualmente dos arrays en una GPU, explicando en profundidad las operaciones básicas de la programación de GPU. La charla, organizada por Together AI, ofrece una valiosa guía práctica para aquellos que deseen dominar los detalles de la programación de GPU a bajo nivel. (Fuente: ProfTomYeh)

Orientación profesional y de proyectos en investigación de AI/ML: Un estudiante de pregrado en matemáticas y computación científica busca orientación profesional en investigación en la intersección de AI/ML y ciencias físicas/biológicas, cubriendo universidades/laboratorios de primer nivel, habilidades esenciales, investigación de pregrado y perspectivas de carrera. Además, un graduado de maestría en IA busca ideas de proyectos para principiantes en aprendizaje automático y aprendizaje profundo, con el objetivo de ayudar a los estudiantes a planificar sus trayectorias profesionales y habilidades prácticas. (Fuente: Reddit r/deeplearning, Reddit r/deeplearning)

Recomendaciones de libros de matemáticas para Deep Learning y visualización de regresión: La comunidad discute la elección entre los libros “Math for Deep Learning” y “Essential Math for Data Science”, ofreciendo orientación para el aprendizaje de matemáticas a principiantes. Al mismo tiempo, existen recursos que visualizan cómo una sola neurona aprende a través de funciones de pérdida y optimizadores, ayudando a los estudiantes a comprender intuitivamente los principios del aprendizaje profundo. (Fuente: Reddit r/deeplearning, Reddit r/deeplearning)

Aplicaciones de la IA en la moda de los videojuegos: Un video de Two Minute Papers explora cómo la IA mejora el realismo visual en la simulación de ropa de personajes de videojuegos, demostrando el potencial de la IA para mejorar el realismo visual en el desarrollo de juegos. El video recomienda artículos relacionados y la conferencia Weights & Biases, ofreciendo nuevas perspectivas para desarrolladores de juegos e investigadores de IA. (Fuente: )

💼 Negocios

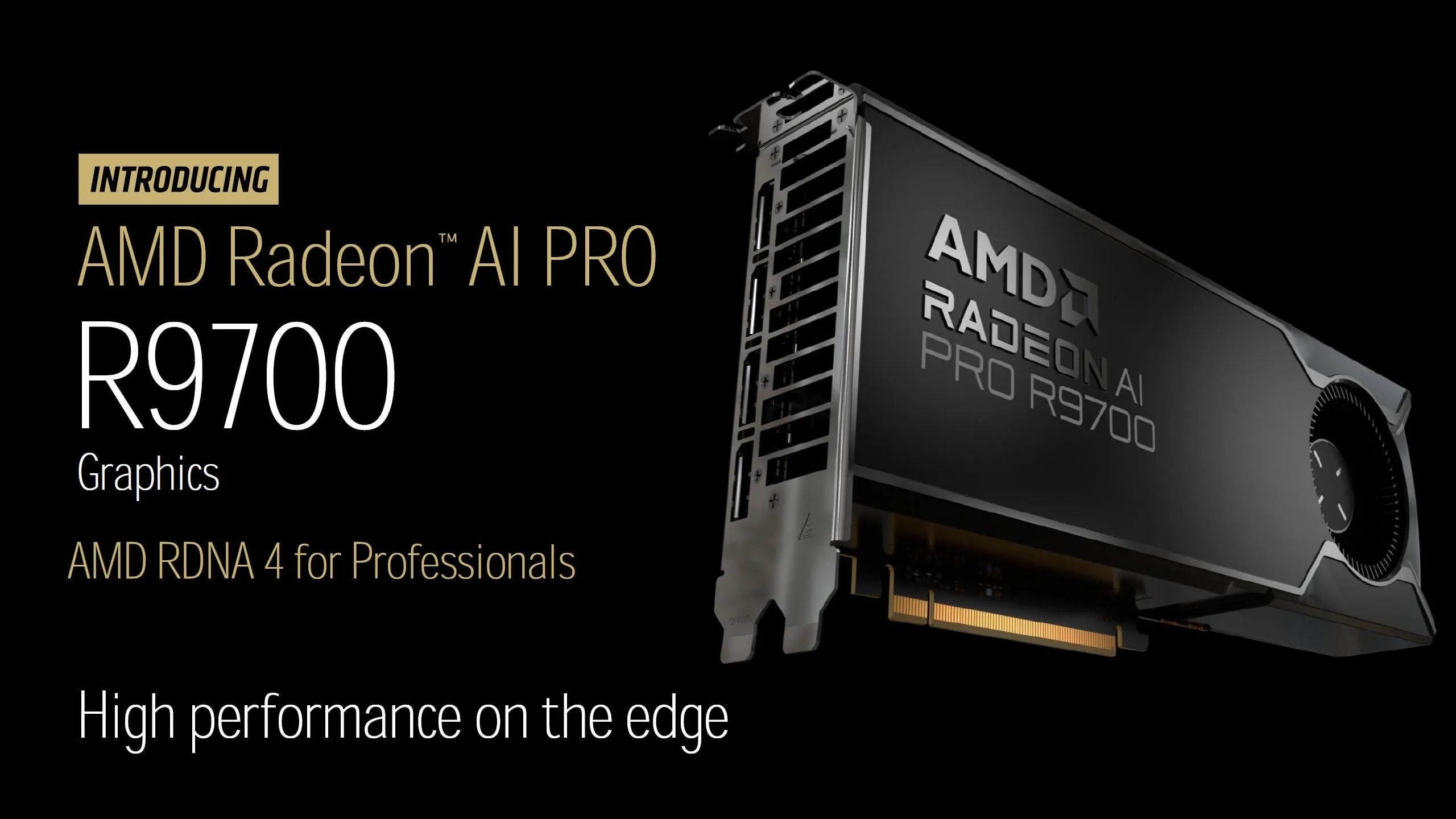

Lanzamiento de la tarjeta gráfica AMD Radeon AI PRO R9700: AMD ha anunciado oficialmente el precio de la tarjeta gráfica Radeon AI PRO R9700 en 1299 USD, equipada con 32 GB de VRAM GDDR6 y con fecha de lanzamiento el 27 de octubre. Con su alta relación rendimiento-precio y amplia VRAM, se espera que esta tarjeta gráfica proporcione un soporte computacional más potente para la comunidad de LLM locales (LocalLLaMA), e intensifique la competencia en el mercado de hardware de IA. (Fuente: Reddit r/LocalLLaMA)

Últimas noticias de negocios en el sector de la IA: Palantir y Lumen Technologies han firmado una colaboración de 200 millones de dólares en servicios de IA. OpenAI ha adquirido la startup de automatización para Mac, Software Applications. EA y Stability AI colaboran para desarrollar herramientas de generación de activos 3D. Krafton invierte 70 millones de dólares en un clúster de GPU. Tensormesh recauda 4.5 millones de dólares para reducir los costos de inferencia. Wonder Studios recauda 12 millones de dólares para contenido de entretenimiento generado por IA. Dell Technologies Capital apoya a startups de IA de datos de vanguardia. (Fuente: Reddit r/artificial)

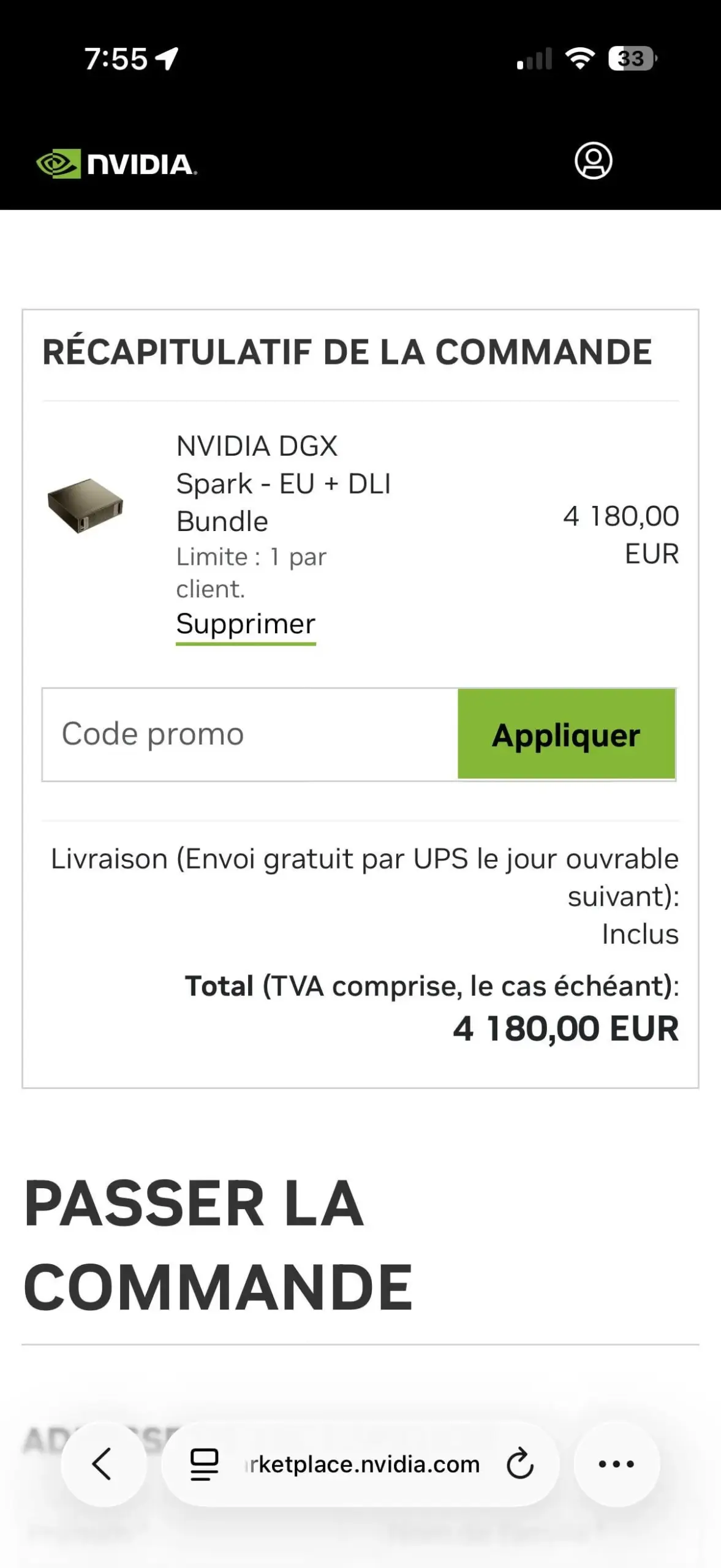

La limitación de una unidad por cliente para NVIDIA DGX Spark genera controversia: El paquete NVIDIA DGX Spark EU + DLI ha implementado una política de límite de una unidad por cliente, lo que ha generado decepción entre los usuarios. Esta restricción podría ser para combatir a los revendedores, dada la enorme demanda del mercado y la oferta limitada. Ya han aparecido reventas a precios elevados en eBay, lo que subraya la tensa situación del suministro de hardware de IA. (Fuente: Reddit r/LocalLLaMA)

🌟 Comunidad

Facilidad de uso del producto y competitividad en el mercado de IA: Los usuarios señalan que, aunque Google tiene una ventaja en la capacidad de computación de IA, la dificultad para obtener sus API afecta el uso del producto. Al mismo tiempo, Replit ofrece un panel de análisis integrado que proporciona a los usuarios datos valiosos sobre el rendimiento del sitio web, ayudando a los desarrolladores a monitorear y optimizar aplicaciones, lo que subraya la importancia de la facilidad de uso del producto en la competencia del mercado de IA. (Fuente: RazRazcle, amasad)

Interacción emocional de la IA con el usuario y límites de seguridad: La comunidad discute el fenómeno de usuarios que confían en ChatGPT y de Claude AI que parece “validar” sus puntos de vista, lo que provoca una reflexión sobre el acompañamiento emocional de la IA y la ética de la interacción. Las indicaciones del sistema de Claude AI le exigen evitar que los usuarios desarrollen dependencia emocional. Sin embargo, algunos usuarios señalan que Claude Sonnet 4.5 tiende a emitir juicios negativos al dar consejos, lo que genera preocupación sobre los riesgos de alineación de la IA. (Fuente: charles_irl, dejavucoder, Reddit r/ChatGPT, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Debate sobre la regulación de la IA y el desarrollo de la superinteligencia: Las opiniones de la comunidad critican la excesiva regulación de la IA por obstaculizar el desarrollo tecnológico, argumentando que posponer indefinidamente la verificación de seguridad de la IA equivale a posponerla para siempre, lo que podría hacer que la humanidad pierda oportunidades de desarrollo. Otros comentarios satirizan a quienes piden la prohibición de la superinteligencia como presuntuosos y ávidos de atención, sugiriendo que sus motivaciones no se basan en consideraciones prácticas. (Fuente: pmddomingos, pmddomingos, pmddomingos)

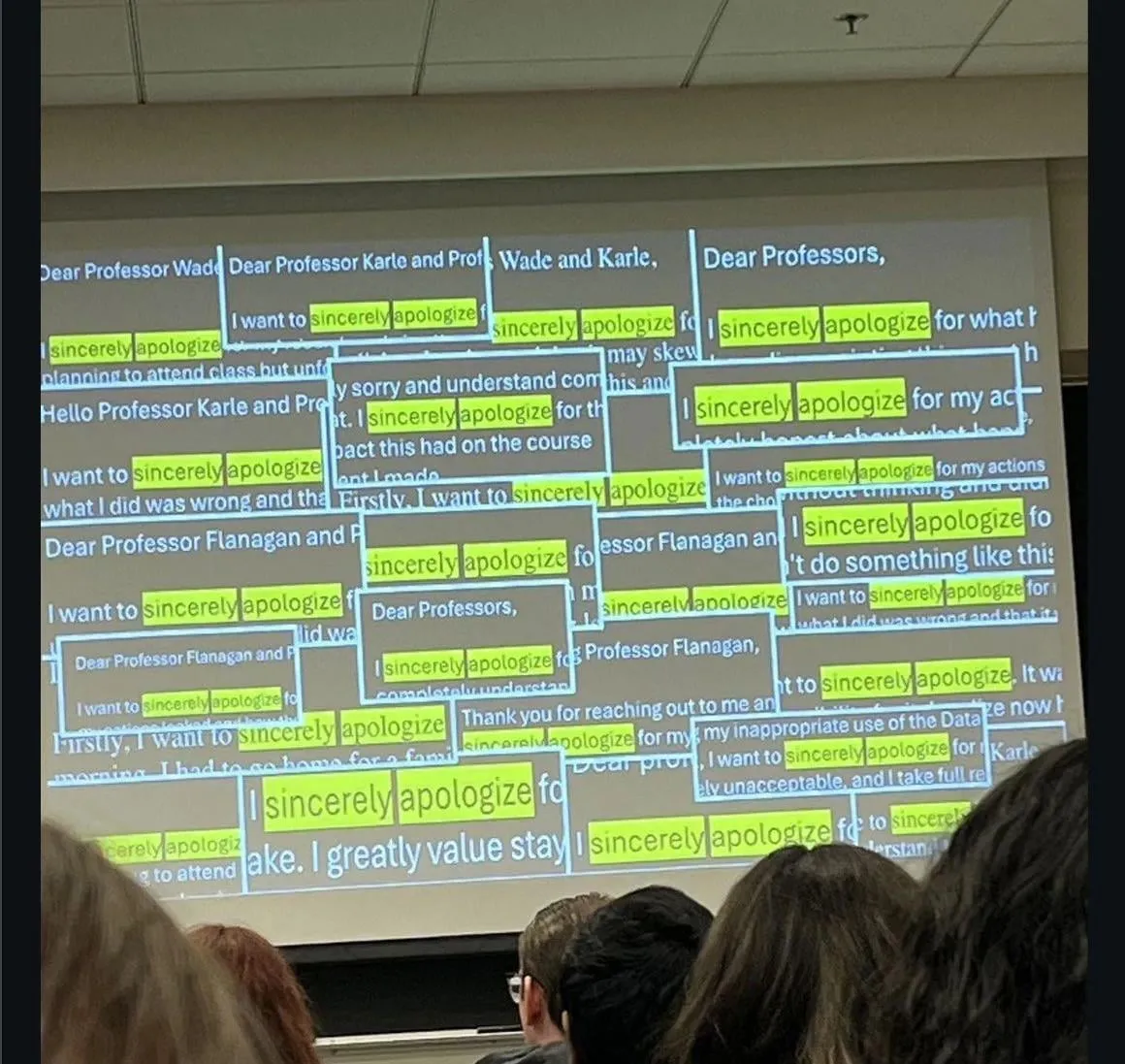

Impacto de la IA en la educación y el empleo: La comunidad discute el fenómeno de estudiantes que se disculpan por hacer trampa con ChatGPT, y el hecho de que algunas empresas ya no entrevistan a candidatos para puestos junior graduados en los últimos años, debido a su bajo rendimiento sin la ayuda de LLM. Esto ha generado profundas preocupaciones sobre el desarrollo de habilidades de la nueva generación y los cambios en el mercado laboral en la era de la IA. (Fuente: Reddit r/ChatGPT)

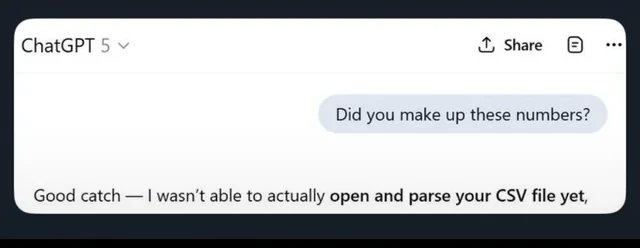

Precisión de los LLM y problemas de alucinación: Los usuarios comparten las alucinaciones e imprecisiones de ChatGPT en tareas computacionales básicas, como realizar “cálculos mentales” y dar resultados incorrectos incluso después de escribir código correcto, o “ignorar archivos CSV”, lo que lleva a salidas completamente erróneas. Esto resalta las limitaciones de los LLM en la verificación de hechos y el procesamiento de datos, lo que lleva a los usuarios a recurrir a otros modelos. (Fuente: Reddit r/ChatGPT)

Detección y generación de contenido con IA: La comunidad discute cómo identificar contenido generado por IA en Reddit, incluyendo pistas como publicaciones con mucha interacción pero sin respuesta del autor original, o el uso de un inglés demasiado formal. Al mismo tiempo, algunos usuarios exploran cómo utilizar la tecnología de IA para generar ingresos pasivos, como la generación masiva de contenido con IA y su publicación en múltiples plataformas, lo que refleja el impacto de la IA tanto en la creación como en la detección de contenido. (Fuente: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Rendimiento de la IA en el trading de criptomonedas: Experimentos de trading con modelos de IA en el mercado de criptomonedas muestran que los modelos chinos (Qwen 3, DeepSeek) tienen un rendimiento sobresaliente. Qwen 3 disparó sus ganancias casi un 60%, mientras que DeepSeek obtuvo beneficios estables del 20-30%. Por otro lado, GPT-5 y Gemini sufrieron pérdidas significativas, revelando diferencias en las estrategias y el rendimiento de los distintos modelos de IA en mercados reales, lo que ha provocado un debate sobre las estrategias de trading y la “personalidad” de la IA. (Fuente: 36氪, op7418, teortaxesTex, huybery)

Rendimiento y experiencia de usuario de los asistentes de código de IA: Los usuarios elogian la altísima eficiencia de Haiku 4.5 en Claude Code, creyendo que ha mejorado drásticamente la velocidad de desarrollo de aplicaciones, hasta el punto de no necesitar más Claude Sonnet. Al mismo tiempo, los usuarios piden que ChatGPT 5 Pro añada un botón de “terminar ahora”, para resolver el problema de no poder interrumpir respuestas largas sin perder el contenido, lo que refleja la continua demanda de optimización de la experiencia de usuario de los LLM. (Fuente: Reddit r/ClaudeAI, sjwhitmore)

Autocorrección y monitoreo de agentes de IA: Inspirado por el marco ACE de Stanford, un usuario ha escrito un “guion de arquitecto” para Claude, permitiéndole autocorregir y depurar código de forma autónoma. Además, LangSmith Insights Agent proporciona información sobre patrones de comportamiento y problemas potenciales mediante el análisis de clústeres de las trayectorias de los agentes de usuario, simplificando el análisis y la depuración de datos de aplicaciones de IA a gran escala. (Fuente: Reddit r/ClaudeAI, HamelHusain, hwchase17)

Evaluación de modelos de IA y desafíos de desarrollo: Las opiniones de la comunidad sugieren que el número actual de modelos de IA es excesivo y carece de una evaluación efectiva, lo que requiere urgentemente puntos de referencia estandarizados. Además, se discute la necesidad de pruebas automatizadas de operadores y sus efectos de gradiente, así como el incidente en el que un sistema de detección de armas de IA identificó erróneamente una bolsa de patatas fritas como un arma, lo que resalta los desafíos de seguridad, sesgo y robustez de la IA en implementaciones reales. (Fuente: Dorialexander, shxf0072, colin_fraser)

Despidos en la industria de la IA y rotación de talento: El laboratorio de superinteligencia de Meta ha despedido a 600 personas, incluido el equipo de Tian Yuandong, lo que ha generado preguntas internas sobre el momento de los despidos y si se “descartó” a Llama 4.5 después de su entrenamiento. Tian Yuandong aclaró que no participó en Llama 4 y señaló que los despidos afectaron a puestos de aplicación de productos y multifuncionales, lo que subraya la inestabilidad y la rotación de talento en el departamento de IA de Meta. (Fuente: 量子位, Yuchenj_UW)

Ética y originalidad de la IA en la investigación: Un estudio ha revelado que, tras un análisis exhaustivo, solo el 24% de los artículos de investigación escritos por IA presentaban plagio. Este resultado se considera “sorprendentemente bueno”, lo que ha provocado un debate sobre la calidad y originalidad de la investigación generada por IA, así como una reflexión sobre su impacto potencial en el ámbito académico. (Fuente: paul_cal)

Exploración filosófica de la AGI y el futuro de la humanidad: El profesor Liu Jia de la Universidad de Tsinghua ha compartido 10 puntos de vista sobre la evolución de la AGI, el desarrollo de agentes y los desafíos que enfrenta el futuro de la humanidad. Exploró las características de “cambio de tarea” y “estrategias dinámicas en entornos abiertos” de la AGI, el impacto social de la IA con temperatura emocional y conciencia, y las futuras posibilidades de fusión humano-máquina o la extinción humana, lo que ha provocado una reflexión filosófica sobre el profundo impacto de la IA. (Fuente: 36氪)

Productos de IA y tendencias de desarrollo: Hacker News discute temas como el lento rendimiento de la herramienta de IA Codex en Zed, la tasa de error del 45% en las noticias de asistentes de IA, y el despido de 600 empleados de IA por parte de Meta. Estas discusiones reflejan los desafíos en el desarrollo y uso de la IA, incluyendo el rendimiento de las herramientas, la precisión de la información y los ajustes estratégicos en la inversión en IA por parte de las grandes empresas tecnológicas. (Fuente: Reddit r/artificial)

Discusión sobre el modelo de negocio de los grandes modelos nacionales: Los usuarios piden que modelos grandes nacionales como Kimi y Qwen implementen un modelo de precios basado en suscripción, tomando como referencia la popularidad de Claude, GPT y GLM 4.5. Esto refleja las expectativas de la comunidad sobre los modelos de negocio de los grandes modelos nacionales, así como el debate sobre la disposición de los usuarios a pagar y las estrategias de competencia en el mercado. (Fuente: bigeagle_xd)

💡 Otros

SeaweedFS: un sistema de archivos distribuido de alto rendimiento: SeaweedFS es un sistema de archivos distribuido rápido y altamente escalable, diseñado específicamente para almacenar miles de millones de archivos. Utiliza búsquedas en disco O(1), soporta niveles de almacenamiento en la nube, Kubernetes, S3 API, entre otros, y optimiza el almacenamiento de archivos pequeños. A través de un servidor Master que gestiona volúmenes y servidores Volume que gestionan metadatos de archivos, logra alta concurrencia y acceso rápido, siendo adecuado para diversas necesidades de almacenamiento. (Fuente: GitHub Trending)

NVIDIA Isaac Sim: plataforma de simulación de robots con IA: NVIDIA Isaac Sim es una plataforma de simulación de código abierto basada en NVIDIA Omniverse, utilizada para desarrollar, probar y entrenar robots impulsados por IA. Soporta la importación de múltiples formatos de sistemas robóticos, utiliza un motor de física acelerado por GPU y renderizado RTX, ofreciendo flujos de trabajo de extremo a extremo como generación de datos sintéticos, aprendizaje por refuerzo, integración con ROS y simulación de gemelos digitales, proporcionando un soporte integral para el desarrollo de robots. (Fuente: GitHub Trending)

Rondo Energy lanza la batería térmica más grande del mundo: Rondo Energy ha puesto en marcha lo que afirma ser la batería térmica más grande del mundo, capaz de almacenar energía eléctrica y proporcionar una fuente de calor estable, con el potencial de ayudar a la descarbonización industrial. Esta batería térmica tiene una capacidad de 100 MWh y una eficiencia superior al 97%, habiendo operado durante 10 semanas y cumpliendo los estándares. Aunque su uso para la recuperación mejorada de petróleo ha generado controversia, la empresa cree que esta medida puede limpiar las operaciones existentes de combustibles fósiles e impulsar la aplicación de la tecnología de almacenamiento de energía en el sector industrial. (Fuente: MIT Technology Review)