Palabras clave:AGI (Inteligencia Artificial General), Sora2, RAG (Generación Aumentada por Recuperación), Gemini 3.0, Juguetes de IA, Agentes inteligentes, Modelos de gran escala, Tecnología de generación de vídeo con IA, Evolución de la generación aumentada por recuperación, Modelos de IA multimodal, Plataforma de IA para desarrollo farmacéutico, Tecnología de colaboración entre computación y electricidad

Aquí tienes la traducción de la información de AI al español, siguiendo tus requisitos:

🎯 Tendencias

Andrej Karpathy: AGI es una curva larga, no un crecimiento explosivo : Andrej Karpathy, exinvestigador principal de OpenAI, señala que la actual narrativa de un “año explosivo” para la AI es demasiado eufórica, y que la consecución de la AGI requerirá décadas de evolución. Enfatiza que los verdaderos “agentes” deben poseer persistencia, memoria y continuidad, en lugar de los actuales chatbots “fantasmales”. El futuro desarrollo de la AI debe pasar de “alimentar datos” a “enseñar objetivos”, a través de un entrenamiento basado en tareas y ciclos de retroalimentación, para que la AI se convierta en un “compañero” con identidad, rol y responsabilidad en la sociedad, y no en una mera herramienta. (Fuente: 36氪)

Lanzamiento de Sora2: la generación de video con AI entra en una fase de “superaceleración” : OpenAI ha lanzado Sora2 y su aplicación social Sora App, cuya cantidad de descargas ha superado a ChatGPT, lo que marca la entrada del campo del video con AI en un período de “superaceleración”. Sora2 ha logrado avances en la simulación física, la fusión multimodal y la comprensión del “lenguaje cinematográfico”, pudiendo generar automáticamente videos con múltiples cambios de cámara y tramas coherentes, lo que reduce drásticamente la barrera de creación. Fabricantes nacionales como Baidu y Google también han iterado rápidamente sus productos, pero los derechos de autor y los modelos de monetización siguen siendo desafíos reales para la industria. (Fuente: 36氪)

Evolución del paradigma RAG: el debate de “vida o muerte” bajo los agentes y las ventanas de contexto largo : Con el auge de las ventanas de contexto largo de los LLM y las capacidades de los Agent, el futuro de RAG (Generación Aumentada por Recuperación) ha generado un intenso debate. LlamaIndex cree que RAG está evolucionando hacia la “recuperación de agentes”, logrando consultas de bases de conocimiento más inteligentes a través de una arquitectura de Agent jerárquica; Hamel Husain enfatiza la importancia de RAG como una disciplina de ingeniería rigurosa; mientras que Nicolas Bustamante declara que el “RAG ingenuo ha muerto”, y que los Agent combinados con un contexto largo pueden realizar una navegación lógica directa, degradando RAG a un componente de la caja de herramientas del Agent. (Fuente: 36氪)

El modelo Gemini 3.0 de Google supuestamente aparece en LMArena, mostrando nuevas capacidades multimodales : Los modelos “alias” de Google Gemini 3.0 (lithiumflow y orionmist) supuestamente han sido expuestos en la arena LMArena. Las pruebas reales muestran que pueden identificar la hora con precisión en tareas de “lectura de reloj”, la capacidad de generación de imágenes SVG ha mejorado significativamente y, por primera vez, han demostrado una buena capacidad de composición musical, pudiendo imitar estilos musicales y mantener el ritmo. Estos avances presagian un avance significativo de Gemini 3.0 en la comprensión y generación multimodal, lo que ha generado expectativas en la industria sobre el próximo lanzamiento de un nuevo modelo por parte de Google. (Fuente: 36氪)

Los juguetes con AI evolucionan de “AI+juguetes” a una profunda integración “AI x juguetes” : El mercado de los juguetes con AI está experimentando una transformación de la simple superposición de funciones a una integración profunda, con un tamaño de mercado global que se espera alcance los cientos de miles de millones para 2030. La nueva generación de juguetes con AI, a través de tecnologías multimodales como el reconocimiento de voz, el reconocimiento facial y el análisis de emociones, logra percibir activamente escenarios, comprender emociones y ofrecer compañía y educación personalizadas. El modelo industrial también está pasando de la “venta de hardware” a la “salida continua de servicios + contenido”, satisfaciendo las crecientes necesidades de compañía emocional y asistencia en la vida de niños, jóvenes y ancianos, convirtiéndose en un importante vehículo para que los humanos aprendan a coexistir con la AI. (Fuente: 36氪)

La marca de tecnología de lujo BUTTONS lanza un robot de audio y video con el agente inteligente HALI : BUTTONS ha presentado el robot de audio y video súper inteligente SOLEMATE, equipado con el agente inteligente general HALI de Terminus Group. HALI posee capacidades de cognición espacial e interacción física, comprende el entorno a través de un modelo de memoria semántica tridimensional y puede ofrecer servicios proactivamente basándose en la ubicación e intención del usuario. Este robot utiliza la computación colaborativa a gran escala de los centros de computación inteligente para lograr la optimización de recursos, equipos y comportamientos, marcando el avance de la AI hacia agentes generales encarnados, capaces de romper las barreras del mundo digital y “percibir-razonar-actuar” en entornos físicos. (Fuente: 36氪)

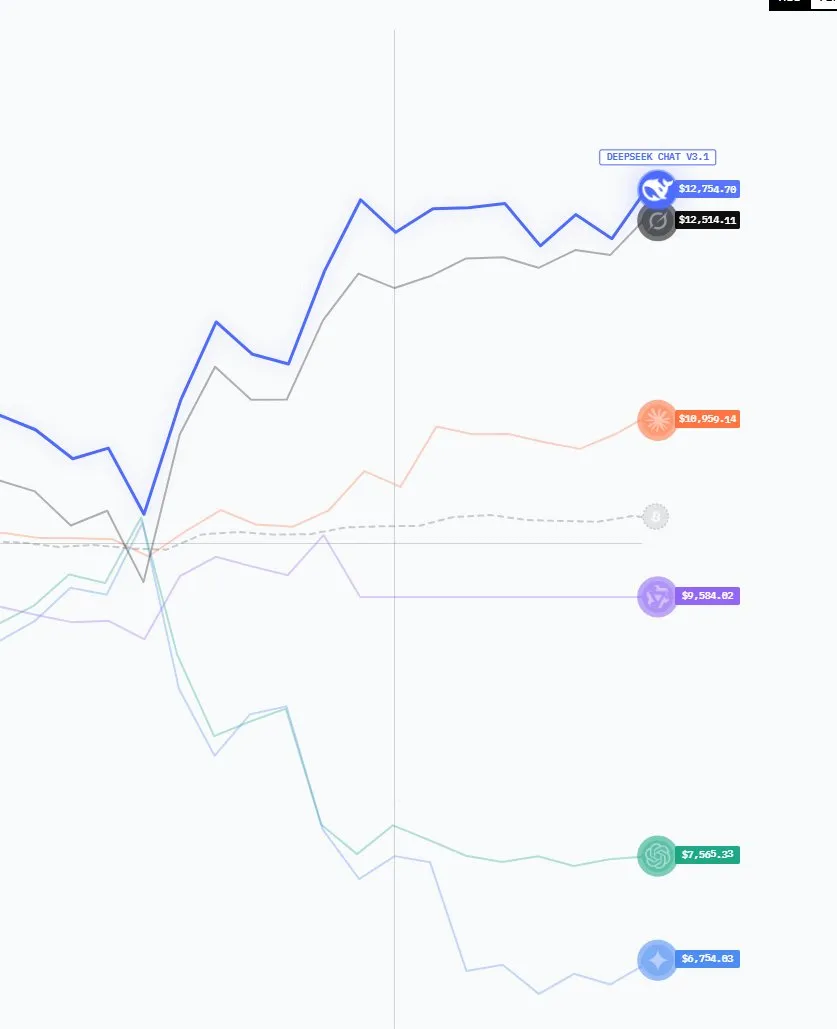

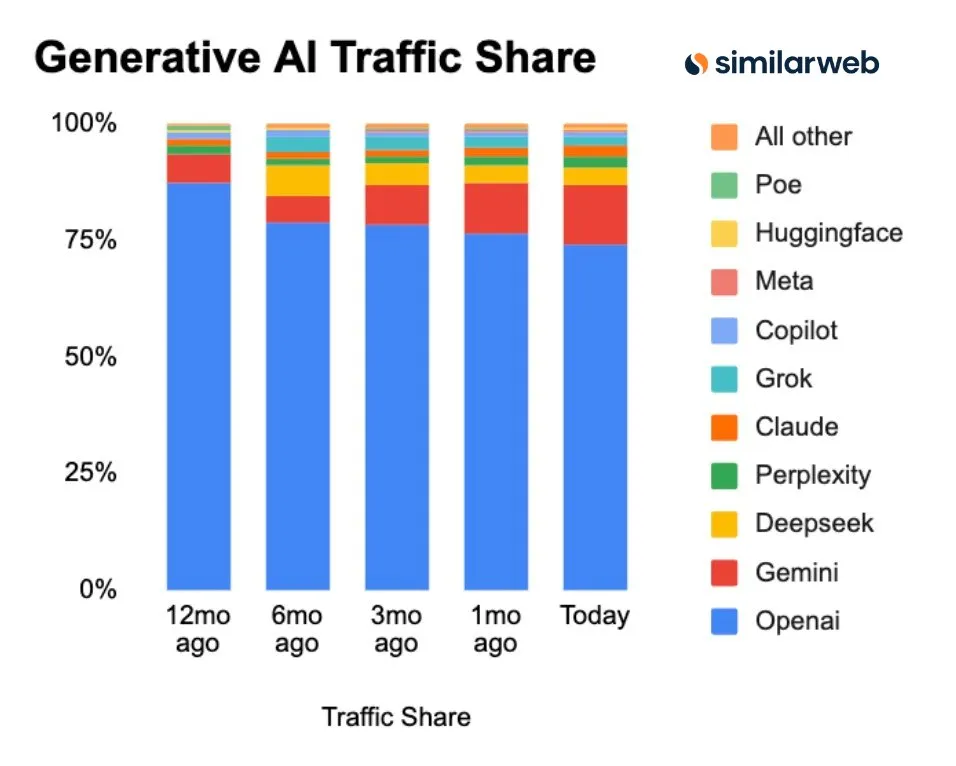

Los modelos de AI chinos en ascenso, con un crecimiento significativo en cuota de mercado y descargas : Los últimos datos muestran que el panorama del mercado de GenAI está cambiando, con la cuota de mercado de ChatGPT en constante declive, mientras que competidores como Perplexity, Gemini y DeepSeek están en ascenso. Es particularmente notable que los modelos de AI de código abierto estadounidenses que destacaron el año pasado han sido dominados este año por modelos chinos en la clasificación de LMArena. Los modelos chinos como DeepSeek y Qwen tienen el doble de descargas en Hugging Face que los modelos estadounidenses, lo que demuestra la creciente competitividad de China en el campo de la AI abierta. (Fuente: ClementDelangue, ClementDelangue)

Google lanza una serie de actualizaciones de AI: Veo 3.1, integración de Google Maps con Gemini API, etc. : Google ha anunciado esta semana varios avances en AI, incluyendo el modelo de video Veo 3.1 (que soporta expansión de escenas e imágenes de referencia), la integración de datos de Google Maps con Gemini API, la investigación Speech-to-Retrieval (que permite consultar datos directamente sin transcripción de voz a texto), una inversión de 15 mil millones de dólares en un centro de AI en India, y la función de programación de AI Gemini para Gmail/Calendar. Al mismo tiempo, su función AI Overviews está siendo investigada por editores de noticias italianos debido a su impacto en el tráfico, y se ha lanzado el modelo C2S-Scale 27B para la traducción de datos biológicos. (Fuente: Reddit r/ArtificialInteligence)

Microsoft lanza MAI-Image-1, su modelo de generación de imágenes entra en el top diez : Microsoft AI ha lanzado su primer modelo de generación de imágenes completamente desarrollado de forma independiente, MAI-Image-1. Este modelo ha entrado por primera vez en el top diez de la clasificación de modelos de texto a imagen de LMArena. Este avance demuestra la sólida capacidad de Microsoft en la tecnología nativa de generación de imágenes y presagia su mayor impulso en el campo de la AI multimodal, lo que proporcionará a los usuarios una experiencia de creación de imágenes de mayor calidad. (Fuente: dl_weekly)

🧰 Herramientas

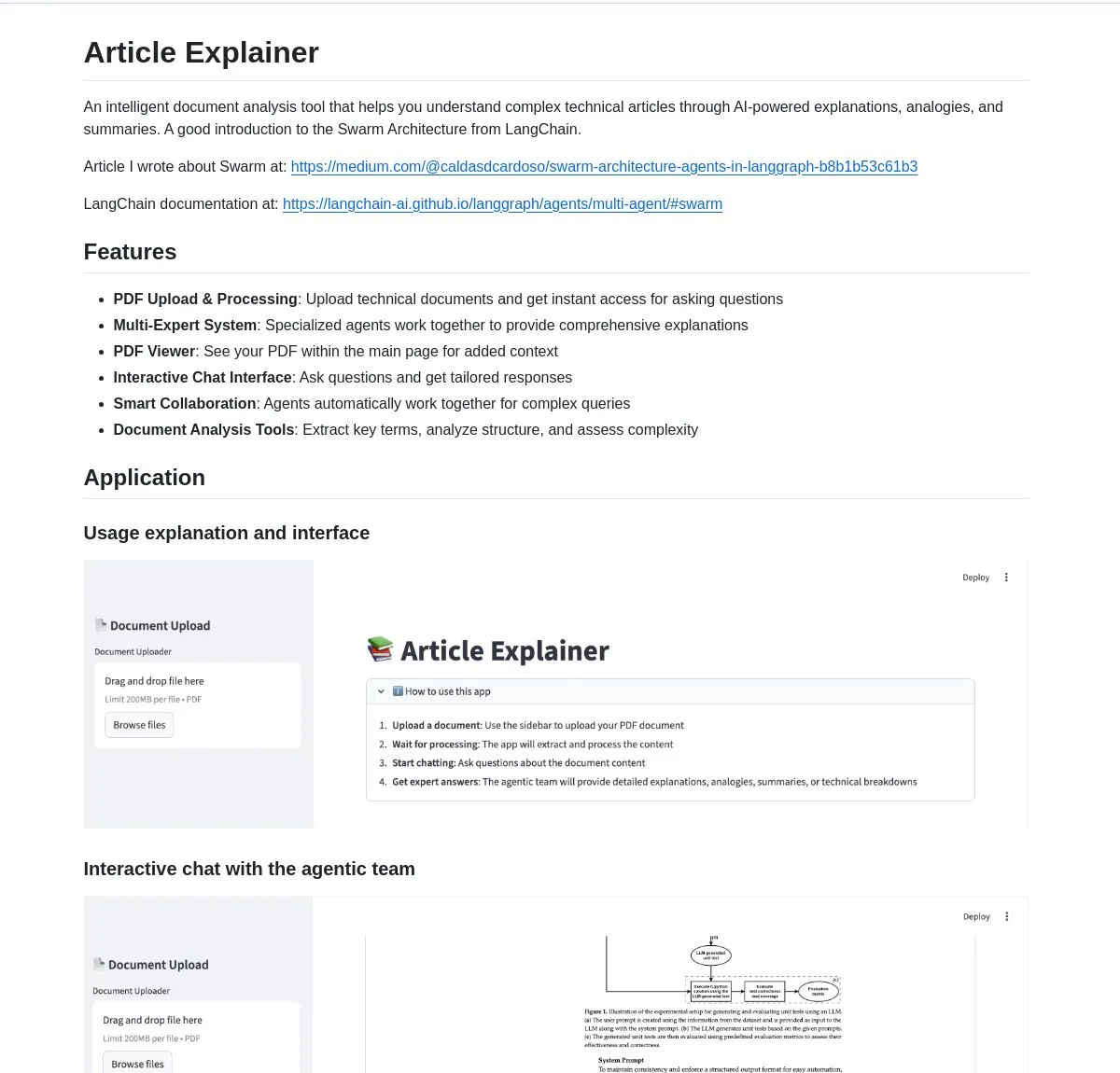

LangChain Article Explainer: herramienta de análisis de documentos con AI : LangChain ha lanzado una herramienta de análisis de documentos con AI llamada “Article Explainer”, que utiliza la Swarm Architecture de LangGraph para desglosar artículos técnicos complejos. A través de la colaboración de múltiples agentes, proporciona explicaciones interactivas e ideas profundas, permitiendo a los usuarios obtener información mediante consultas en lenguaje natural, lo que mejora enormemente la eficiencia en la comprensión de documentos técnicos. (Fuente: LangChainAI)

Claude Code Skill: transforma a Claude en un arquitecto de proyectos profesional : Un desarrollador ha creado un Claude Code Skill que puede transformar a Claude en un arquitecto de proyectos profesional. Esta habilidad permite a Claude generar automáticamente documentos de requisitos, documentos de diseño y planes de implementación antes de codificar, resolviendo el problema de la pérdida de contexto en proyectos complejos. Puede generar rápidamente historias de usuario, arquitecturas de sistema, interfaces de componentes y tareas jerárquicas, lo que mejora enormemente la eficiencia de la planificación y ejecución de proyectos, y es compatible con el desarrollo de diversas aplicaciones Web, microservicios y sistemas ML. (Fuente: Reddit r/ClaudeAI)

Perplexity AI Comet: extensión de navegador con AI para mejorar la eficiencia de navegación e investigación : La extensión de navegador Perplexity AI Comet ha lanzado su acceso anticipado, con el objetivo de mejorar la navegación, investigación y productividad de los usuarios. Esta herramienta puede proporcionar respuestas rápidas, resumir contenido web e integrar funciones de AI directamente en la experiencia del navegador, ofreciendo a los usuarios una forma más inteligente y eficiente de obtener información, especialmente útil para aquellos que necesitan digerir rápidamente grandes cantidades de información en línea. (Fuente: Reddit r/artificial)

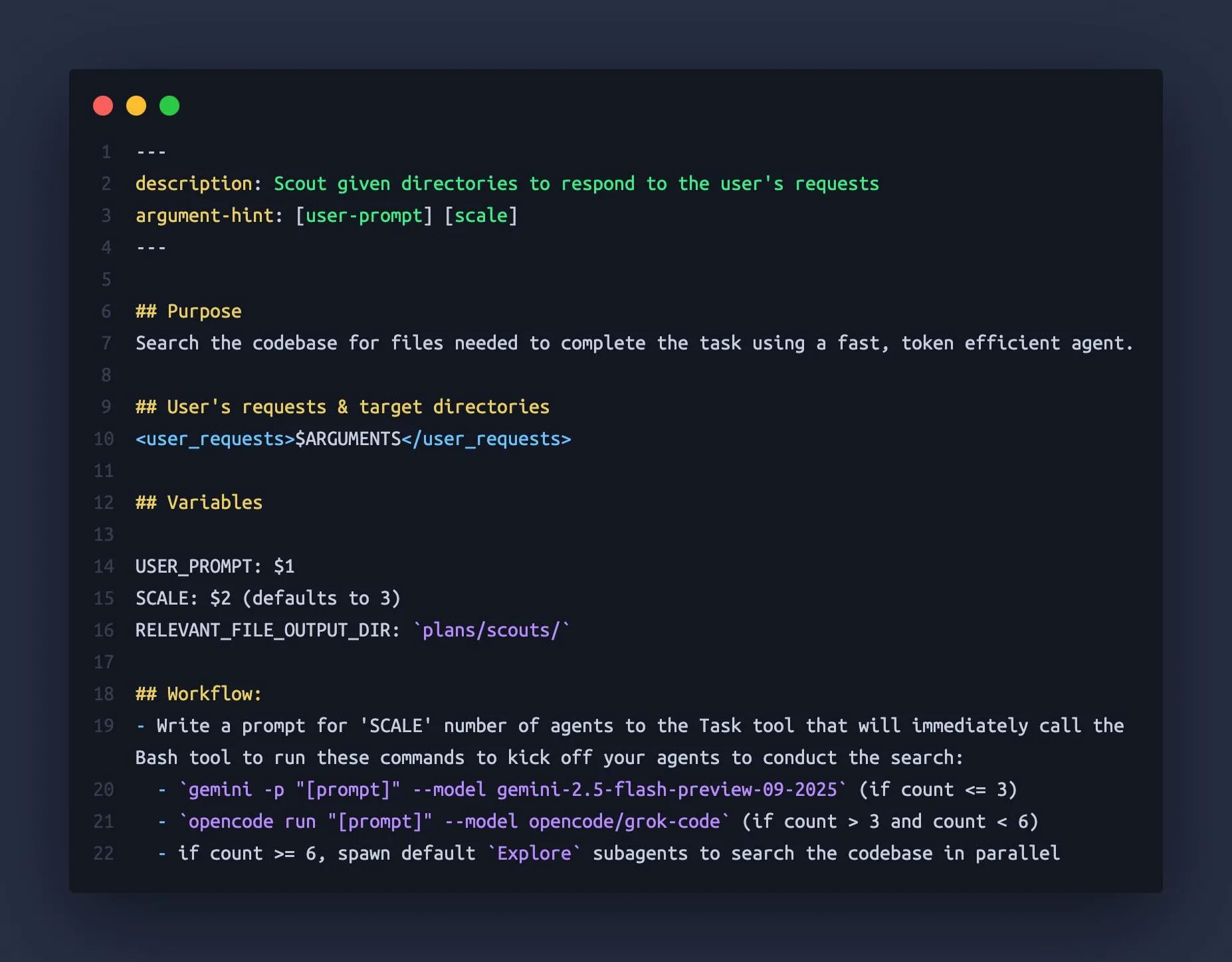

Claude Code utiliza Gemini CLI y OpenCode como “subagentes” : Un desarrollador ha descubierto que Claude Code puede orquestar otros Large Language Models (LLM) como Gemini 2.5 Flash y Grok Code Fast como “subagentes”, utilizando sus grandes ventanas de contexto (1M-2M tokens) para explorar rápidamente bases de código y proporcionar información contextual más completa a Claude Code. Este enfoque combinado evita eficazmente que Claude “pierda el contexto” en tareas complejas, mejorando la eficiencia y precisión del asistente de codificación. (Fuente: Reddit r/ClaudeAI)

Modelo generador CAD k-1b: un generador de modelos 3D ajustado basado en Gemma3-1B : Un desarrollador ha construido un modelo generador CAD de 1B parámetros llamado k-1b, que permite a los usuarios generar modelos 3D en formato STL simplemente introduciendo una descripción. Este modelo ha sido entrenado con datos de OpenSCAD generados y reparados con asistencia de AI, y ajustado (fine-tuned) a partir de Gemma3-1B. El autor también ha proporcionado una herramienta CLI que soporta la conversión de modelos OBJ y la previsualización en terminal, ofreciendo una herramienta de asistencia de AI de bajo costo y alta eficiencia para el diseño y la fabricación 3D. (Fuente: karminski3, Reddit r/LocalLLaMA)

neuTTS-Air: un modelo de clonación de voz de 0.7B que se puede ejecutar en CPU : Neuphonic ha lanzado un modelo de clonación de voz de 0.7B llamado neuTTS-Air, cuya característica principal es que puede ejecutarse en CPU. Los usuarios solo necesitan proporcionar la voz objetivo y el texto correspondiente para clonar la voz y generar audio de un nuevo texto, produciendo aproximadamente 18 segundos de audio en 30 segundos. Actualmente, el modelo solo es compatible con el inglés, pero su ligereza y compatibilidad con CPU ofrecen una solución conveniente de clonación de voz para usuarios individuales y pequeños desarrolladores. (Fuente: karminski3)

Claude Code M&A Deal Comp Agent: utiliza el análisis de PDF para generar términos de transacción en Excel : Un desarrollador ha creado un agente de análisis de transacciones de M&A utilizando Claude Code Skills y la capacidad de análisis de PDF semtools de LlamaIndex. Este agente puede analizar documentos públicos de M&A (como DEF 14A), analizar cada PDF y generar automáticamente tablas de Excel que contienen los términos de la transacción y datos de empresas comparables. Esta herramienta mejora significativamente la eficiencia y precisión del análisis financiero, siendo especialmente útil para procesar documentos financieros complejos. (Fuente: jerryjliu0)

Anthropic Skills y Plugins: la superposición de funciones genera confusión entre los desarrolladores : Anthropic ha lanzado recientemente las funciones Skills y Plugins, diseñadas para introducir capacidades personalizadas en los AI Agent. Sin embargo, algunos desarrolladores han reportado confusión y superposición en sus usos, lo que genera incertidumbre sobre los escenarios de aplicación y las estrategias de desarrollo. Esto sugiere que Anthropic podría tener margen de mejora en el diseño de funciones y la estrategia de lanzamiento para guiar mejor a los desarrolladores en el uso de sus capacidades de AI. (Fuente: Vtrivedy10, Reddit r/ClaudeAI)

📚 Aprendizaje

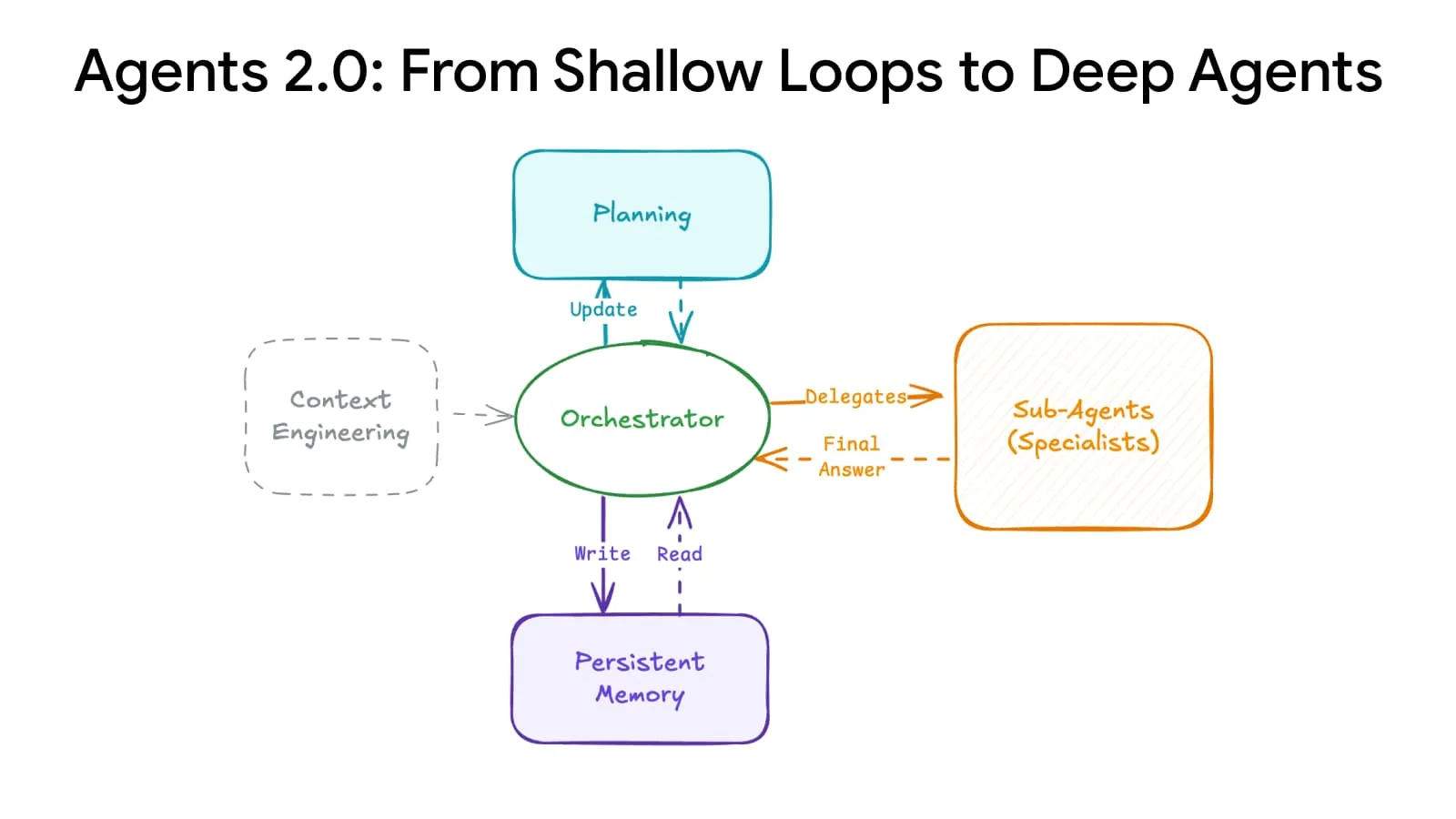

Deep Agents Evolution: sistemas avanzados de planificación y memoria aumentan la escala de los agentes : Un avance en la arquitectura de AI ha logrado la “Deep Agents Evolution”, que, a través de sistemas avanzados de planificación y memoria, permite a los agentes expandirse de 15 a más de 500 pasos, transformando por completo la forma en que la AI aborda tareas complejas. Se espera que esta tecnología permita a la AI mantener la coherencia en secuencias de tiempo más largas y cadenas lógicas más complejas, sentando las bases para la construcción de agentes de AI generales más potentes. (Fuente: LangChainAI)

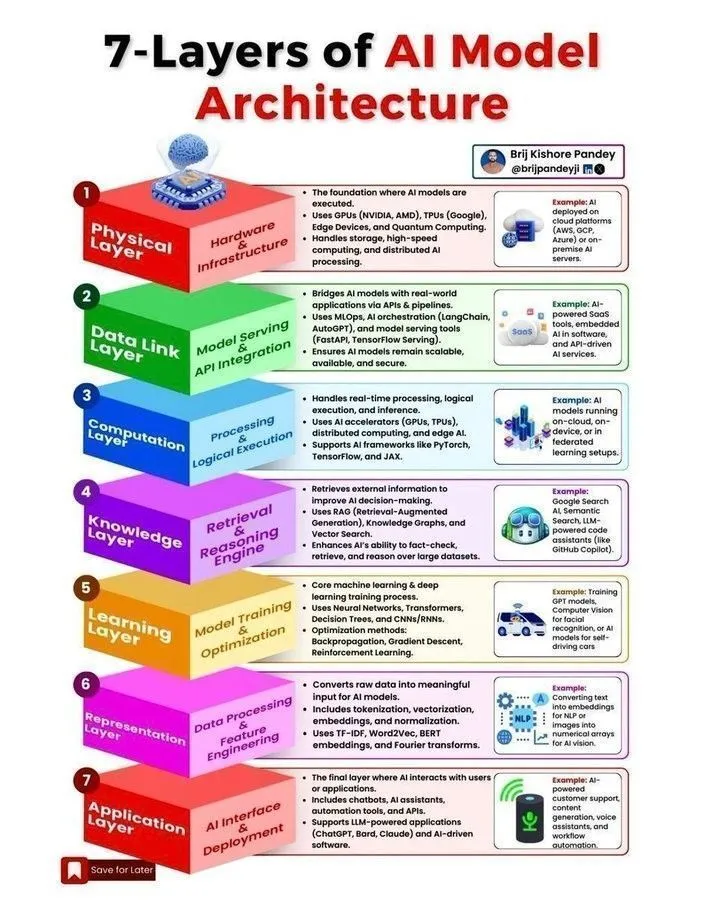

Arquitectura de modelos de AI y hoja de ruta para el desarrollo de agentes : Se han compartido en redes sociales múltiples recursos sobre la arquitectura de modelos de AI, hojas de ruta para el desarrollo de agentes, el ciclo de vida del Machine Learning y las diferencias entre AI, Generative AI y Machine Learning. Estos contenidos tienen como objetivo ayudar a desarrolladores e investigadores a comprender los conceptos centrales de los sistemas de AI, los pasos clave para construir agentes de AI escalables y dominar las habilidades esenciales requeridas en el campo de la AI para 2025. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Curso CME295 de Stanford: Transformer y prácticas de ingeniería de Large Models : La Universidad de Stanford ha lanzado la serie de cursos CME295, centrada en la arquitectura Transformer y el conocimiento de ingeniería práctica de los Large Language Models (LLM). Este curso evita conceptos matemáticos complejos y enfatiza la aplicación práctica, proporcionando un valioso recurso de aprendizaje para ingenieros que deseen profundizar en el desarrollo y despliegue de Large Models. Al mismo tiempo, el curso CS224N se recomienda como la mejor opción para la introducción al NLP. (Fuente: karminski3, QuixiAI, stanfordnlp)

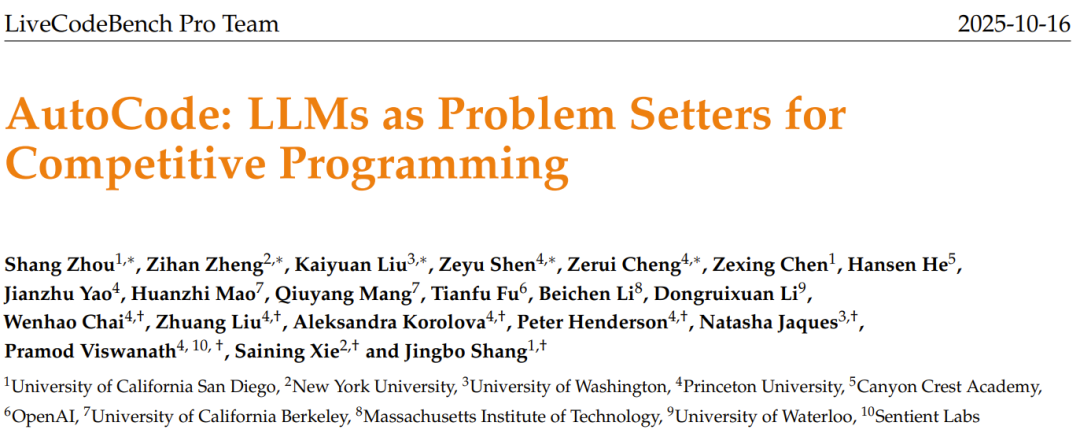

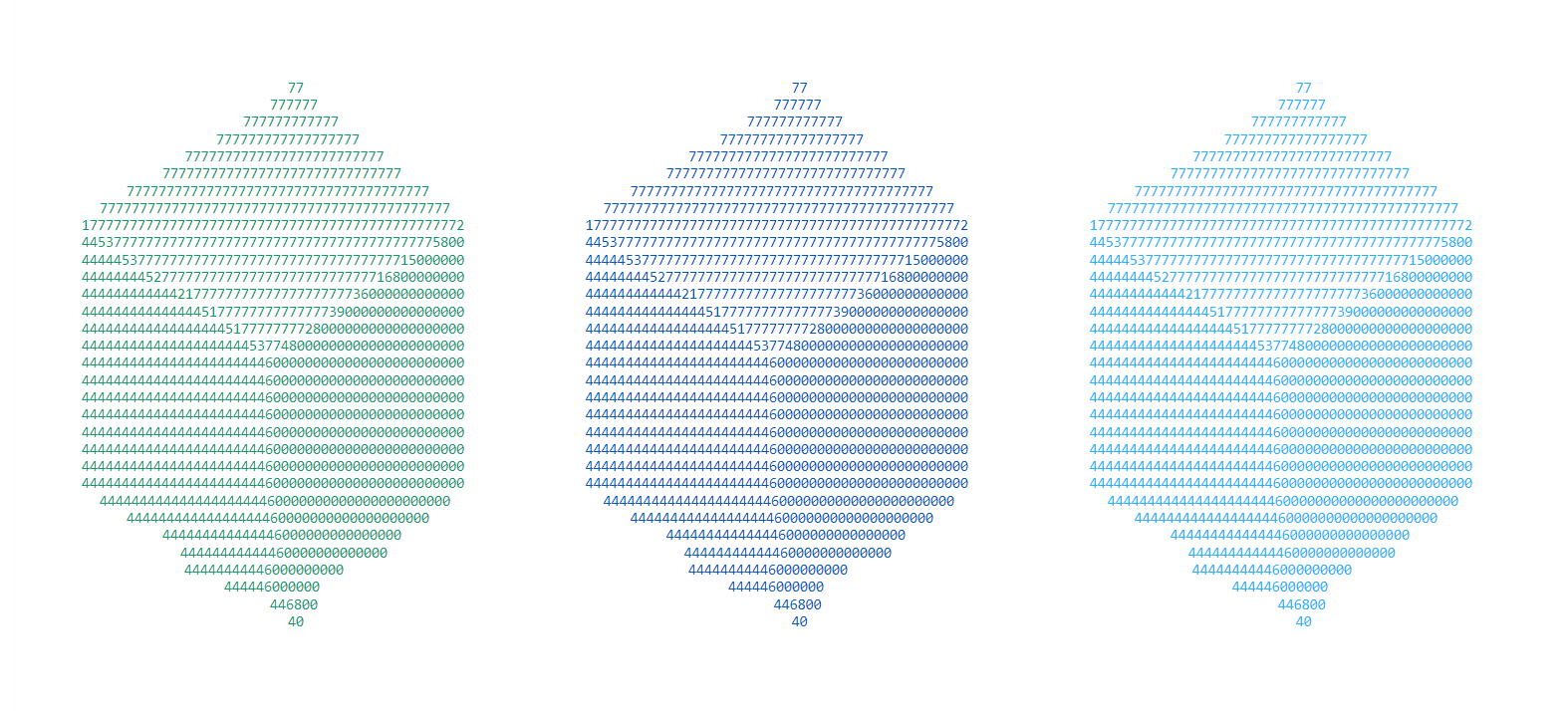

Generador de problemas de AI AutoCode: LLM genera problemas originales para concursos de programación : El equipo de LiveCodeBench Pro ha lanzado el framework AutoCode, que utiliza LLM en un sistema de bucle cerrado y múltiples roles para automatizar la creación y evaluación de problemas de programación competitiva. Este framework, a través de un mecanismo mejorado de validador-generador-inspector, logra una alta fiabilidad en la generación de casos de prueba y puede inspirar a los LLM a generar problemas nuevos, originales y de alta calidad a partir de “problemas semilla”, lo que promete allanar el camino para benchmarks de concursos de programación más rigurosos y la auto-mejora de los modelos. (Fuente: 36氪)

KAIST desarrolla un cerebro de semiconductor de AI: combina la inteligencia de Transformer con la eficiencia de Mamba : El Instituto Avanzado de Ciencia y Tecnología de Corea (KAIST) ha desarrollado un nuevo cerebro de semiconductor de AI que combina con éxito la inteligencia de la arquitectura Transformer y la eficiencia de la arquitectura Mamba. Esta investigación innovadora tiene como objetivo resolver el problema de la compensación entre rendimiento y consumo de energía en los modelos de AI existentes, proporcionando una nueva dirección para el diseño de hardware de AI eficiente y de bajo consumo en el futuro, y se espera que acelere el desarrollo de sistemas de AI de borde y AI embebida. (Fuente: Reddit r/deeplearning)

Pipeline NER multietapa: análisis de comentarios de Reddit con coincidencia difusa y técnica de enmascaramiento LLM : Una investigación propone un pipeline de reconocimiento de entidades nombradas (NER) multietapa, que combina la coincidencia difusa de alta velocidad y la técnica de enmascaramiento LLM, para extraer entidades y sentimientos de los comentarios de Reddit. Este método primero identifica entidades conocidas mediante búsqueda difusa, luego procesa el texto enmascarado con un LLM para descubrir nuevas entidades, y finalmente realiza un análisis de sentimientos y un resumen. Este enfoque híbrido logra un equilibrio entre velocidad y capacidad de descubrimiento al procesar texto a gran escala, ruidoso y específico de un dominio. (Fuente: Reddit r/MachineLearning)

Experiencia en el despliegue de sistemas de trading impulsados por ML: resolución de “sesgo de anticipación” y “deriva de estado” en entornos en tiempo real : Un desarrollador ha compartido su experiencia en el despliegue de sistemas de trading impulsados por ML, enfatizando la importancia crítica de resolver el “sesgo de anticipación” y la “deriva de estado” en entornos en tiempo real. Mediante un procesamiento estricto del modelo línea por línea y scripts de “control maestro dorado”, se asegura una consistencia determinista entre las pruebas históricas y la ejecución en tiempo real. El sistema también incluye un validador que mide la consistencia entre las predicciones en tiempo real y las predicciones del validador con un coeficiente de correlación de Pearson de 1.0, garantizando la fiabilidad del modelo. (Fuente: Reddit r/MachineLearning)

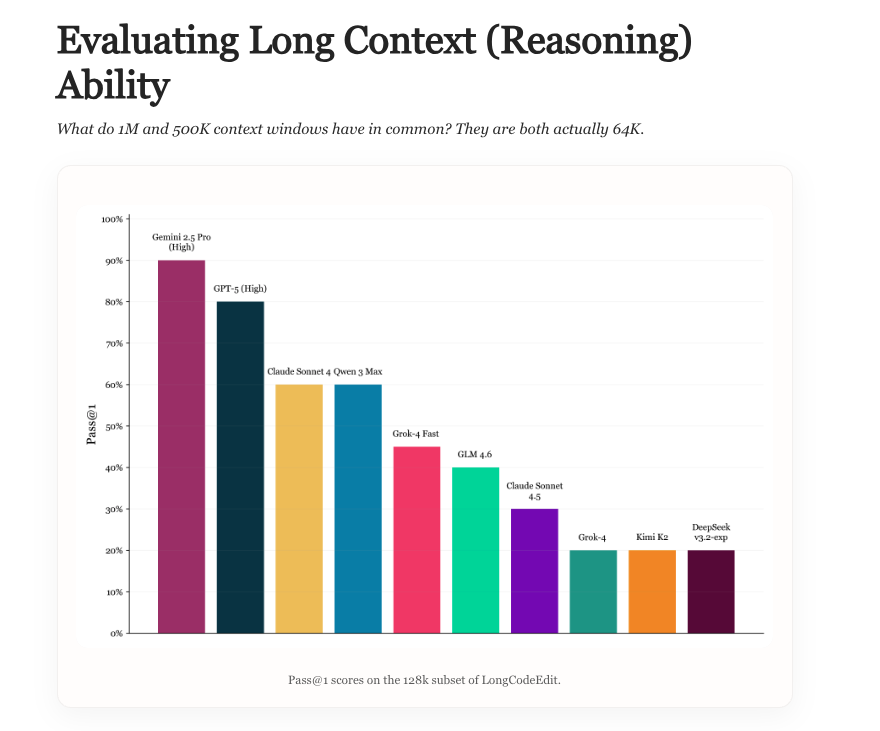

Long Context Evaluation: nuevo benchmark para evaluar la capacidad de contexto largo de los LLM : Una nueva investigación explora el estado actual de la evaluación de contexto largo de los LLM, analiza las ventajas y desventajas de los benchmarks existentes e introduce un nuevo benchmark llamado LongCodeEdit. Este estudio tiene como objetivo abordar las deficiencias de los métodos de evaluación actuales para medir el rendimiento de los LLM en el procesamiento de textos largos y tareas complejas de edición de código, proporcionando nuevas herramientas e ideas para evaluar con mayor precisión el rendimiento de los modelos en escenarios de contexto largo. (Fuente: nrehiew_, teortaxesTex)

Manifold Optimization: optimización geométricamente consciente para el entrenamiento de redes neuronales : La optimización Manifold dota al entrenamiento de redes neuronales de capacidad de percepción geométrica. Una nueva investigación extiende esta idea a las variedades modulares, ayudando a diseñar optimizadores que comprenden las interacciones entre capas. Al combinar funciones de avance, restricciones de variedad y normas, este framework describe cómo se combinan la geometría entre capas y las reglas de optimización, logrando así una optimización geométricamente consciente a un nivel más profundo, mejorando la eficiencia y los resultados del entrenamiento de redes neuronales. (Fuente: TheTuringPost, TheTuringPost)

Complejidad de Kolmogorov en la investigación de AI: el potencial de la AI para simplificar los resultados de investigación : La discusión señala que la “esencia” central de las nuevas investigaciones y contenidos de blogs puede comprimirse en código, artefactos y abstracciones matemáticas. Se espera que los futuros sistemas de AI “traduzcan” investigaciones complejas en artefactos simples, extrayendo las diferencias fundamentales y reproduciendo los resultados clave, lo que reducirá drásticamente el costo de comprensión de nuevas investigaciones, permitiendo a los investigadores mantenerse al día más fácilmente con la gran cantidad de artículos en ArXiv y lograr una rápida asimilación y aplicación de los resultados de investigación. (Fuente: jxmnop, aaron_defazio)

Controversia sobre el origen del aprendizaje residual por el padre de LSTM: la contribución de Hochreiter en 1991 : Jürgen Schmidhuber, el padre de LSTM, ha vuelto a pronunciarse, señalando que la idea central del aprendizaje residual fue propuesta por su estudiante Sepp Hochreiter ya en 1991, para resolver el problema del desvanecimiento del gradiente en las RNN. Hochreiter introdujo conexiones residuales recurrentes en su tesis doctoral, fijando los pesos en 1.0, lo que se considera la base del concepto residual en arquitecturas de Deep Learning posteriores como LSTM, Highway networks y ResNet. Schmidhuber enfatiza la importancia de las contribuciones tempranas para el desarrollo del Deep Learning. (Fuente: 量子位)

💼 Negocios

Zhiweituo Medicine recibe una financiación semilla de decenas de millones de yuanes: desarrollo de nuevos fármacos orales de molécula pequeña asistido por AI : Beijing Zhiweituo Medicine Technology Co., Ltd. ha completado una ronda de financiación semilla de decenas de millones de yuanes, liderada por Newton Capital y con la participación de Qingtan Investment. Los fondos se utilizarán para avanzar en la investigación y desarrollo preclínico de su pipeline principal y en la construcción de su plataforma de diseño molecular interactivo con AI. La empresa se centra en el sector de la farmacéutica con AI, utilizando su plataforma EnCore de desarrollo propio para acelerar el descubrimiento de compuestos líderes y la optimización molecular, centrándose en fármacos orales de molécula pequeña para enfermedades autoinmunes, con la esperanza de abordar objetivos “difíciles de medicar”. (Fuente: 36氪)

Damao Technology completa una ronda de financiación A+ de casi cien millones de yuanes: la tecnología de coordinación computación-energía resuelve el problema del alto consumo energético de los centros de computación inteligente : Damao Technology ha completado una ronda de financiación A+ de casi cien millones de yuanes, liderada por Puquan Capital, una filial de Ningde Times. Esta ronda de financiación se utilizará para la investigación y promoción de tecnologías clave como los grandes modelos de energía, las plataformas de coordinación computación-energía y los agentes inteligentes, con el objetivo de resolver el problema del alto consumo energético de los centros de computación inteligente a través de la “coordinación computación-energía”, y apoyar la construcción de nuevos sistemas de energía. Damao Technology, basándose en su gran modelo de energía de desarrollo propio de pila completa, ya ha colaborado con empresas líderes como SenseTime y Cambricon para proporcionar soluciones de optimización energética para infraestructuras de computación de alto consumo. (Fuente: 36氪)

JD, Tmall, Douyin “AI” en el Doble 11: la tecnología impulsa el crecimiento de las grandes promociones de e-commerce : Este año, el Doble 11 se ha convertido en un campo de entrenamiento para el e-commerce con AI, con plataformas líderes como JD, Tmall y Douyin apostando fuertemente por la tecnología AI. La AI se aplica para optimizar la experiencia del consumidor, empoderar a los comerciantes, la logística de entrega, la distribución de contenido y la toma de decisiones de compra en toda la cadena de valor. Por ejemplo, JD ha mejorado su función “comprar con foto”, Douyin Bean Bag se ha integrado en el centro comercial, y Worthy Buy Technology ha logrado la comparación de precios a través de diálogos con AI. La AI se está convirtiendo en un nuevo motor de crecimiento para el e-commerce, redefiniendo el panorama competitivo de la industria a través de una eficiencia y un control de costos extremos, y empujando el e-commerce de la etapa de “e-commerce de estantería/contenido” a la de “e-commerce inteligente”. (Fuente: 36氪, 36氪)

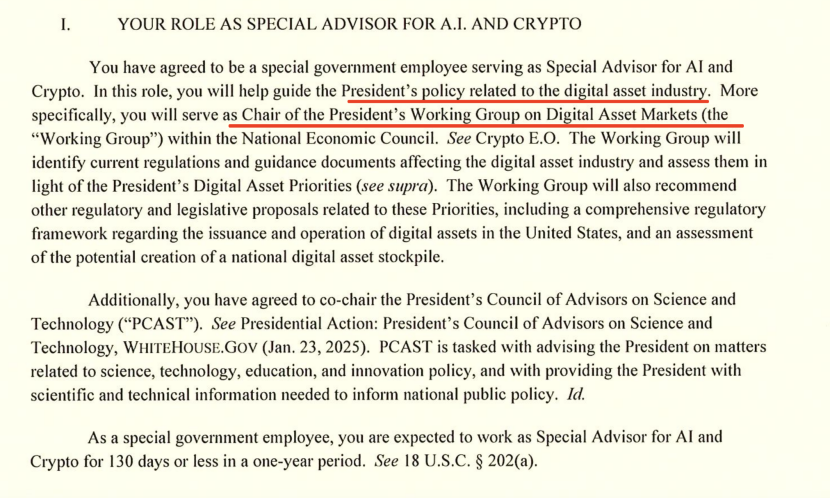

El jefe de AI de la Casa Blanca habla sobre la competencia AI entre EE. UU. y China: exportación de chips y dominio del ecosistema : David Sacks, el “zar” de AI y Crypto de la Casa Blanca, ha expuesto en una entrevista la estrategia de Estados Unidos en la competencia de AI con China, enfatizando la importancia de la innovación, la infraestructura y las exportaciones. Señala que la política de exportación de chips de EE. UU. a China debe ser “matizada”, limitando los chips más avanzados pero evitando una privación total que podría llevar a Huawei a monopolizar el mercado nacional. Sacks subraya que EE. UU. debe construir un vasto ecosistema de AI y convertirse en el socio tecnológico preferido a nivel mundial, en lugar de sofocar la competitividad mediante el control burocrático. (Fuente: 36氪)

🌟 Comunidad

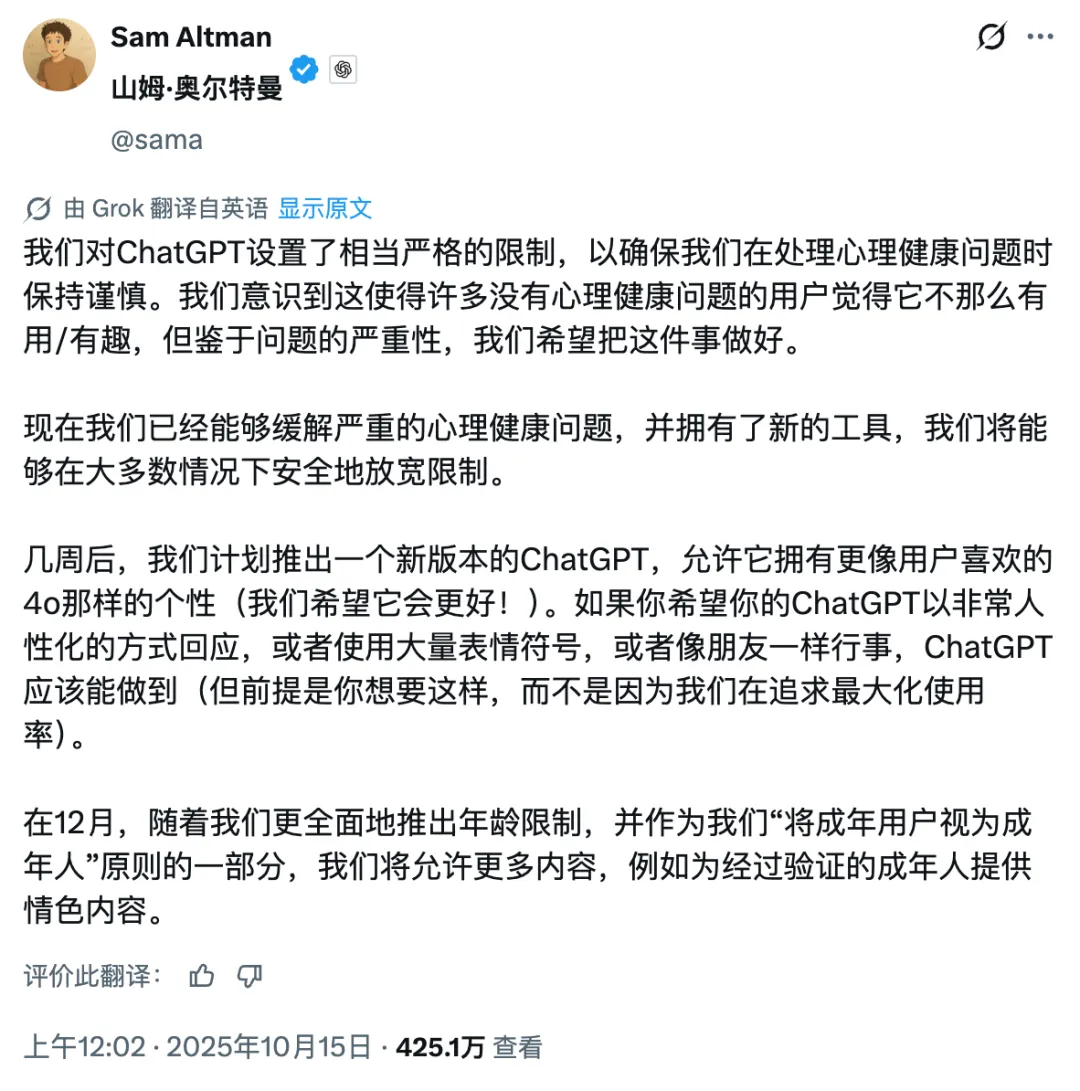

Controversia sobre la comercialización de OpenAI: de sin fines de lucro a la búsqueda de ganancias, la reputación de Sam Altman se ve afectada : El CEO de OpenAI, Sam Altman, ha generado una amplia controversia debido a la apertura de contenido erótico en ChatGPT, el rendimiento del modelo GPT-5 y su agresiva estrategia de expansión de infraestructura. La comunidad cuestiona su cambio de una misión sin fines de lucro a la búsqueda de ganancias comerciales, expresando preocupación por la dirección del desarrollo de la tecnología AI, la burbuja de inversión y el trato ético a los empleados. La respuesta de Altman no ha logrado calmar completamente la opinión pública, lo que subraya la tensión entre la expansión del imperio de la AI y la responsabilidad social. (Fuente: 36氪, janusch_patas, Reddit r/ArtificialInteligence)

Envenenamiento de Large Models: envenenamiento de datos, muestras adversarias y desafíos de seguridad de la AI : Los Large Models se enfrentan a amenazas de seguridad como el envenenamiento de datos, ataques de puerta trasera y muestras adversarias, lo que lleva a salidas anormales o contenido dañino del modelo, e incluso a su uso para publicidad comercial (GEO), exhibición tecnológica o ciberdelincuencia. Las investigaciones muestran que una pequeña cantidad de datos maliciosos puede afectar significativamente al modelo. Esto ha generado preocupaciones sobre las alucinaciones de la AI, la manipulación de las decisiones del usuario y los riesgos para la seguridad pública, enfatizando la importancia de establecer sistemas inmunes para los modelos, fortalecer la auditoría de datos y los mecanismos de defensa continua. (Fuente: 36氪)

El dilema de los anotadores de datos en la era de la AI: títulos de maestría y doctorado realizando trabajos repetitivos de bajo salario : Con el desarrollo de los Large Models de AI, el trabajo de anotación de datos ha aumentado sus requisitos académicos (incluso exigiendo maestrías y doctorados), pero los salarios son muy inferiores a los de los ingenieros de AI. Estos “profesores de AI” se dedican a evaluar el contenido generado por AI, realizar revisiones éticas y actuar como entrenadores de conocimientos especializados, pero reciben salarios por hora bajos y sus trabajos son inestables, perdiendo el empleo al finalizar el proyecto. Este modelo de subcontratación y explotación en “línea de montaje cibernética” ha provocado una profunda reflexión sobre la ética laboral y la equidad en la industria de la AI. (Fuente: 36氪)

El impacto de la AI en la creatividad y el valor humano: ¿es el fin o la sublimación? : La comunidad discute el impacto de la AI en la creatividad humana, argumentando que la AI no ha matado la creatividad, sino que ha revelado la relativa mediocridad de la creatividad humana. La AI es experta en la reorganización y generación de patrones, pero la originalidad, la contradicción y la imprevisibilidad genuinas siguen siendo ventajas únicas del ser humano. La aparición de nuevas herramientas siempre elimina el terreno intermedio, obligando a los humanos a buscar avances de mayor nivel en contenido y creatividad, haciendo que la verdadera creatividad sea aún más valiosa. (Fuente: Reddit r/artificial)

Ansiedad existencial provocada por la AI y estrategias de afrontamiento: problemas reales y preocupaciones excesivas : Ante la posible amenaza existencial que la AI podría plantear, la comunidad ha debatido cómo lidiar con el “miedo existencial” resultante. Algunas opiniones sugieren que este miedo podría derivar de una fantasía excesiva sobre el futuro, y aconsejan a las personas volver a la realidad y centrarse en la vida actual. Al mismo tiempo, otros señalan que los impactos económicos y los problemas de empleo relacionados con la AI son amenazas reales más urgentes, enfatizando que la seguridad de la AI debe ir de la mano con sus implicaciones socioeconómicas. (Fuente: Reddit r/ArtificialInteligence)

Las opiniones de Karpathy generan un acalorado debate: la teoría de los diez años de la AGI, la teoría de los “fantasmas” de los agentes de AI y la trayectoria de desarrollo de la AI : Las opiniones de Andrej Karpathy sobre la “teoría de los diez años” de la AGI y que los agentes de AI existentes son “fantasmas” han generado una amplia discusión en la comunidad. Él enfatiza que la AI necesita persistencia, memoria y continuidad para convertirse en un verdadero agente, y sugiere que el entrenamiento de la AI debe pasar de “alimentar datos” a “enseñar objetivos”. Estas opiniones se consideran una reflexión serena sobre la actual euforia de la AI, lo que impulsa a la gente a reconsiderar la trayectoria de desarrollo a largo plazo y los estándares de evaluación de la AI. (Fuente: TheTuringPost, TheTuringPost, NandoDF, random_walker, lateinteraction, stanfordnlp)

La cuota de mercado de ChatGPT sigue disminuyendo: competidores como Perplexity, Gemini y DeepSeek están en ascenso : Los datos de Similarweb muestran que la cuota de mercado de ChatGPT ha disminuido continuamente, pasando del 87.1% hace un año al 74.1%. Al mismo tiempo, la cuota de mercado de competidores como Gemini, Perplexity, DeepSeek, Grok y Claude está creciendo constantemente. Esta tendencia indica una competencia cada vez más feroz en el mercado de asistentes de AI, con una diversificación de las opciones de los usuarios, y el dominio de ChatGPT está siendo desafiado. (Fuente: ClementDelangue, brickroad7)

Incidente del “error matemático” de GPT-5: marketing excesivo de OpenAI y cuestionamientos de la competencia : Investigadores de OpenAI afirmaron con gran fanfarria que GPT-5 había resuelto varios problemas matemáticos de Erdos, pero posteriormente se descubrió que solo había encontrado respuestas existentes a través de búsquedas en la web, en lugar de resolverlos de forma independiente. Este incidente provocó el ridículo público de figuras destacadas de la industria como el CEO de DeepMind, Hassabis, y LeCun de Meta, quienes cuestionaron el marketing excesivo de OpenAI, lo que resalta el problema de la rigurosidad en la promoción de las capacidades de la AI y la intensa competencia entre pares. (Fuente: 量子位)

El costo ambiental oculto de la AI: consumo de energía y demanda de recursos hídricos : Investigaciones históricas demuestran que, desde el telégrafo hasta la AI, los sistemas de comunicación siempre han conllevado costos ambientales ocultos. La AI y los sistemas de comunicación modernos dependen de centros de datos a gran escala, lo que provoca un aumento vertiginoso del consumo de energía y la demanda de recursos hídricos. Se estima que para 2027, el consumo de agua de la AI será equivalente al consumo anual de agua de Dinamarca. Esto subraya el costo ambiental detrás del rápido desarrollo de la tecnología AI, y hace un llamado a los gobiernos para que fortalezcan la regulación, exijan la divulgación del impacto ambiental y apoyen proyectos de bajo impacto. (Fuente: aihub.org)

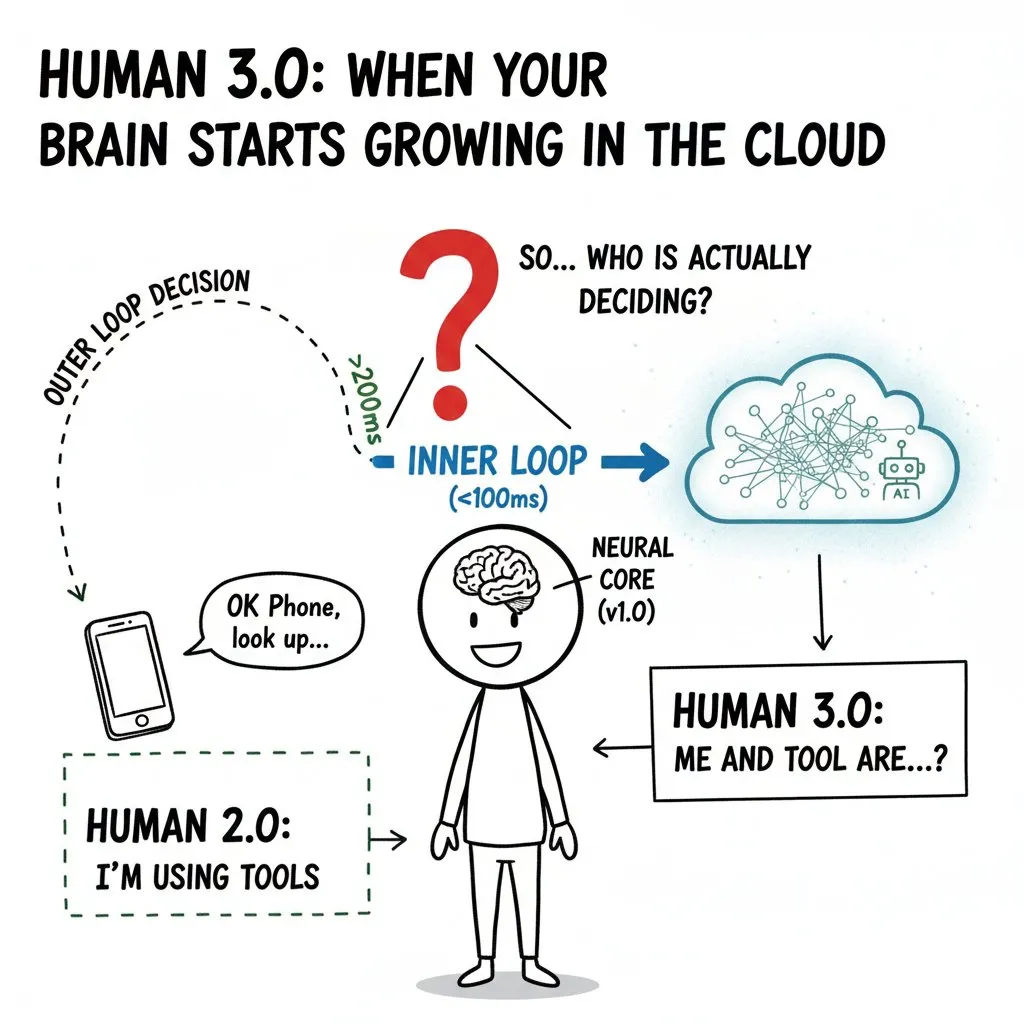

La “invasión” de la AI en la mente humana: interfaces cerebro-ordenador y los límites éticos del “Humano 3.0” : La comunidad ha discutido en profundidad el impacto potencial de las interfaces cerebro-ordenador (BCI) y la AI en la mente humana, proponiendo el concepto de “Humano 3.0”. Cuando la capacidad de cómputo externa entra en el “bucle interno” de la toma de decisiones humana, tan rápido que el cerebro no puede discernir la fuente de la señal, surgirán problemas éticos como los límites del “yo”, los juicios de valor y la salud a largo plazo. El artículo enfatiza que antes de la popularización de la tecnología, se deben establecer arquitecturas de confianza cero, aislamiento de hardware y gestión de permisos para evitar la delegación de la toma de decisiones y la exacerbación de las desigualdades a nivel de especie. (Fuente: dotey)

💡 Otros

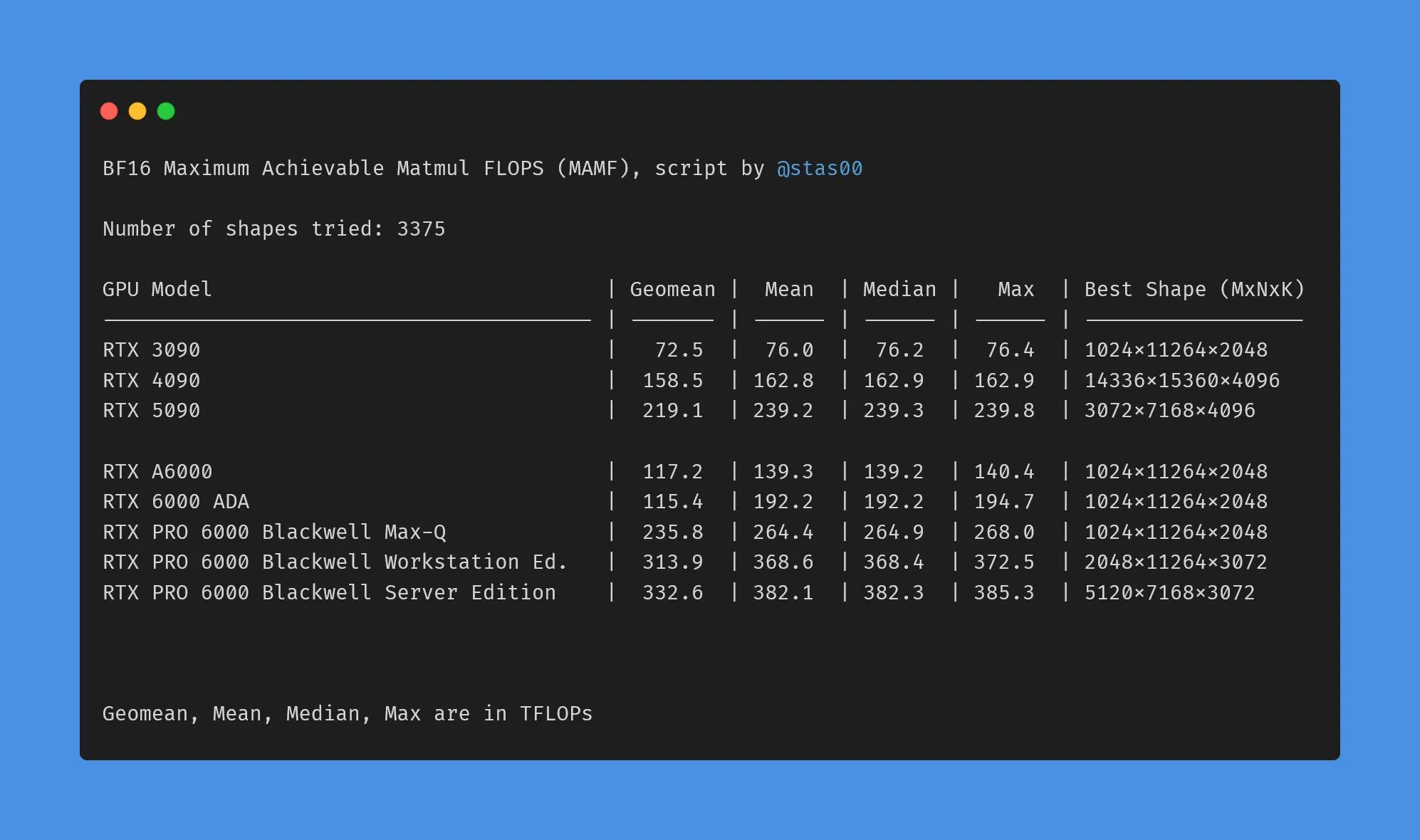

Diferencias en los datos de rendimiento de las GPU de consumo y profesionales de NVIDIA : La comunidad ha discutido las diferencias entre los TFLOPs de marketing y el rendimiento real de las GPU de consumo y profesionales de NVIDIA. Los datos muestran que el rendimiento real de las tarjetas gráficas de consumo (como 3090, 4090, 5090) es ligeramente superior o cercano a los TFLOPs nominales, mientras que el rendimiento real de las tarjetas gráficas profesionales para estaciones de trabajo (como A6000, 6000 ADA) es muy inferior al valor nominal. A pesar de esto, las tarjetas profesionales aún tienen ventajas en consumo de energía, tamaño y eficiencia energética, pero los usuarios deben estar atentos a la discrepancia entre los datos de marketing y el rendimiento real. (Fuente: TheZachMueller)

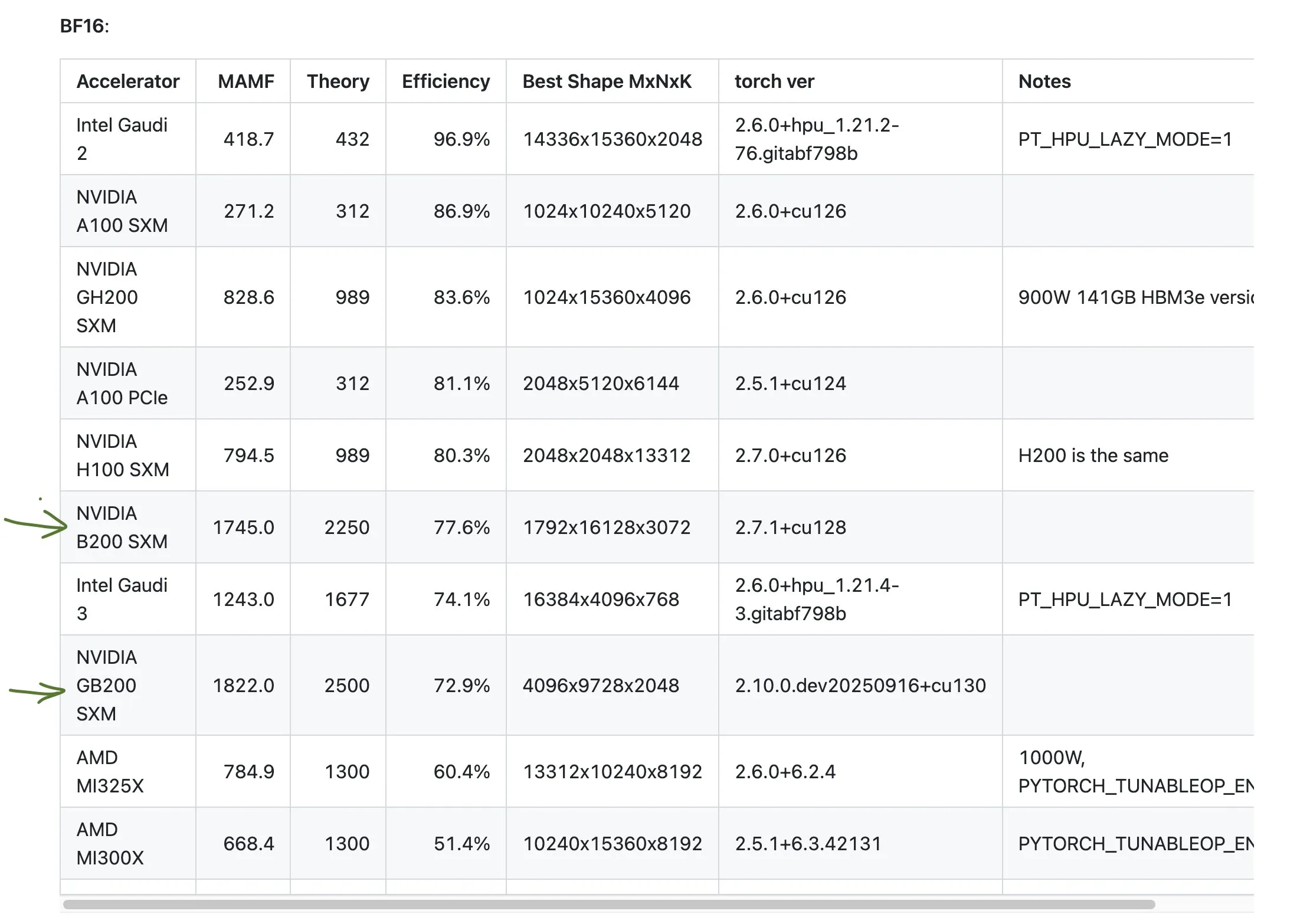

Discusión sobre el bajo rendimiento de las GPU de AMD : La comunidad ha discutido el rendimiento de las GPU de AMD en ciertas pruebas de referencia, señalando que su eficiencia podría ser solo la mitad de lo esperado. Esto ha generado preocupación sobre la competitividad de AMD en el campo de la computación AI, especialmente en comparación con productos de alto rendimiento como el GB200 de NVIDIA. Los usuarios deben evaluar cuidadosamente el rendimiento y la eficiencia reales de las GPU de diferentes fabricantes al planificar los recursos de computación AI. (Fuente: jeremyphoward)

GIGABYTE AI TOP ATOM: rendimiento de Grace Blackwell GB10 de NVIDIA a nivel de escritorio : GIGABYTE ha lanzado AI TOP ATOM, que lleva el rendimiento de NVIDIA Grace Blackwell GB10 a las estaciones de trabajo de escritorio. Este producto tiene como objetivo proporcionar a los usuarios individuales y pequeños equipos una potente capacidad de computación AI, permitiéndoles realizar entrenamiento e inferencia de modelos de alto rendimiento localmente, reduciendo la dependencia de los recursos en la nube y acelerando el desarrollo y despliegue de aplicaciones de AI. (Fuente: Reddit r/LocalLLaMA)