Palabras clave:modelo multimodal grande, capacidad de razonamiento de IA, MM-HELIX, Qwen2.5-VL-7B, razonamiento reflexivo de cadena larga, Video-a-Código, IWR-Bench, GPT-5, algoritmo de optimización de estrategia híbrida adaptativa AHPO, benchmark de evaluación de reconstrucción web interactiva, marco de estrategia universal para robots LeRobot, tendencia de colaboración multiagente en agentes de IA, cuello de botella en el rendimiento del razonamiento matemático de LLM

🔥 En Foco

Avance en la capacidad de razonamiento reflexivo de cadena larga de modelos grandes multimodales: La Universidad Jiao Tong de Shanghái y el Laboratorio de Inteligencia Artificial de Shanghái han lanzado conjuntamente el ecosistema MM-HELIX, con el objetivo de dotar a la AI de capacidad de razonamiento reflexivo de cadena larga. Mediante la construcción del benchmark MM-HELIX (que incluye 42 tareas de alta dificultad de algoritmos, teoría de grafos, rompecabezas y juegos de estrategia) y el dataset MM-HELIX-100K, y la aplicación del algoritmo de optimización de estrategia híbrida adaptativa AHPO, se logró entrenar con éxito el modelo Qwen2.5-VL-7B, aumentando su precisión en el benchmark en un 18.6% y en un promedio del 5.7% en tareas generales de razonamiento matemático y lógico. Esto demuestra que el modelo no solo puede resolver problemas complejos, sino también aplicar lo aprendido a nuevas situaciones, marcando un paso crucial para la AI de ser un “contenedor de conocimiento” a un “maestro en la resolución de problemas”. (Fuente: 量子位)

Lanzado el primer benchmark Video-to-Code, GPT-5 muestra un rendimiento deficiente: El Laboratorio de Inteligencia Artificial de Shanghái, junto con la Universidad de Zhejiang y otras instituciones, ha lanzado IWR-Bench, el primer benchmark para evaluar la capacidad de los modelos grandes multimodales en la reconstrucción interactiva de páginas web (Video-to-Code). Este benchmark requiere que el modelo observe un video de las operaciones del usuario y, combinándolo con recursos estáticos, reproduzca el comportamiento dinámico de la página. Los resultados de las pruebas muestran que incluso GPT-5 obtuvo una puntuación general de solo 36.35%, con una corrección funcional (IFS) de apenas 24.39%, muy por debajo de la fidelidad visual (VFS) del 64.25%. Esto revela una grave deficiencia de los modelos actuales en la generación de lógica basada en eventos, señalando una nueva dirección de investigación para el desarrollo de la automatización frontend con AI. (Fuente: 量子位)

Musk invita a Karpathy a un duelo de programación contra Grok 5, generando debate: Elon Musk ha invitado públicamente al reconocido ingeniero de AI Andrej Karpathy a un duelo de programación contra Grok 5, lo que ha provocado una amplia discusión en la comunidad sobre el desarrollo de la AGI (Inteligencia General Artificial) y los modelos de colaboración humano-máquina. Karpathy declinó el desafío, indicando que prefería colaborar con Grok 5 en lugar de competir, argumentando que en situaciones extremas el valor humano tiende a cero. Esta interacción subraya el progreso de la AI en el campo de la programación, al tiempo que plantea profundas reflexiones sobre si la AI puede alcanzar la creatividad humana única y si la relación humano-máquina debe ser de competencia o cooperación. (Fuente: 量子位)

Hugging Face y la Universidad de Oxford lanzan LeRobot, creando un nuevo paradigma para estrategias robóticas generales: Hugging Face y la Universidad de Oxford han lanzado conjuntamente LeRobot, con el objetivo de convertirse en el “PyTorch del campo de la robótica”. Este framework proporciona código de extremo a extremo, soporta hardware real y puede entrenar estrategias robóticas generales, todo de código abierto. LeRobot permite a los robots aprender de datos multimodales a gran escala (video, sensores, texto) de manera similar a los LLM, y un solo modelo puede controlar múltiples robots, desde humanoides hasta brazos robóticos. Esto marca una transición en la investigación robótica de un enfoque basado en ecuaciones a uno impulsado por datos, presagiando una nueva era en el aprendizaje, razonamiento y adaptación de los robots al mundo real. (Fuente: huggingface, ClementDelangue)

🎯 Tendencias

Los productos Agent chinos muestran una tendencia hacia la colaboración multi-agente y la especialización vertical: La lista AI100 del tercer trimestre de 2025 publicada por QuantumBit AI Research muestra que los productos Agent chinos están evolucionando de la inteligencia de punto único a la colaboración inteligente sistemática, enfatizando capacidades de procesamiento de tareas eficientes, potentes y estables, como la expansión del contexto, la fusión de información multimodal y la integración profunda de servicios en la nube y locales. En cuanto a la implementación de aplicaciones, la tendencia pasa de herramientas generales a “socios inteligentes” de la industria, profundizando en campos verticales como la investigación científica y la inversión para resolver puntos débiles, por ejemplo, el modo “OK Computer” de Kimi, el contexto ultra largo de 1M de MiniMax, el enjambre multi-agente de Nano AI y la plataforma de colaboración multi-agente de Ant Baibaoxiang. (Fuente: 量子位)

Google actualiza el modelo Veo 3.1, mejorando el realismo y el audio en la generación de video: El modelo Veo 3.1 de Google ha sido actualizado, ofreciendo a los creadores un mayor realismo de video y una experiencia de audio más rica. Este modelo ya está disponible en Flowbygoogle, las aplicaciones Gemini, Google Cloud Vertex AI y la Gemini API, mejorando aún más las capacidades de generación de video con AI y prometiendo impulsar el desarrollo de la industria creativa. Además, la Gemini API ha introducido la integración con Google Maps, combinando 250 millones de puntos de datos para potenciar nuevas experiencias de AI relacionadas con la geolocalización. (Fuente: algo_diver, algo_diver)

Expansión de modelos de AI y perspectivas de rendimiento: Qwen3 Next y Gemma 4: La comunidad de código abierto está impulsando activamente el soporte para el modelo Qwen3 Next, lo que presagia más opciones y posibilidades para la implementación local de LLM en el futuro. Al mismo tiempo, el lanzamiento de Gemini 3.0 también genera grandes expectativas para Gemma 4, un modelo de código abierto basado en su arquitectura. Dado que los modelos de la serie Gemma suelen lanzarse entre 1 y 4 meses después del modelo principal Gemini, se espera que Gemma 4 logre un salto significativo en el rendimiento a corto plazo, con el potencial de dos actualizaciones generacionales, impulsando aún más el desarrollo de la AI local y los LLM de código abierto. (Fuente: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

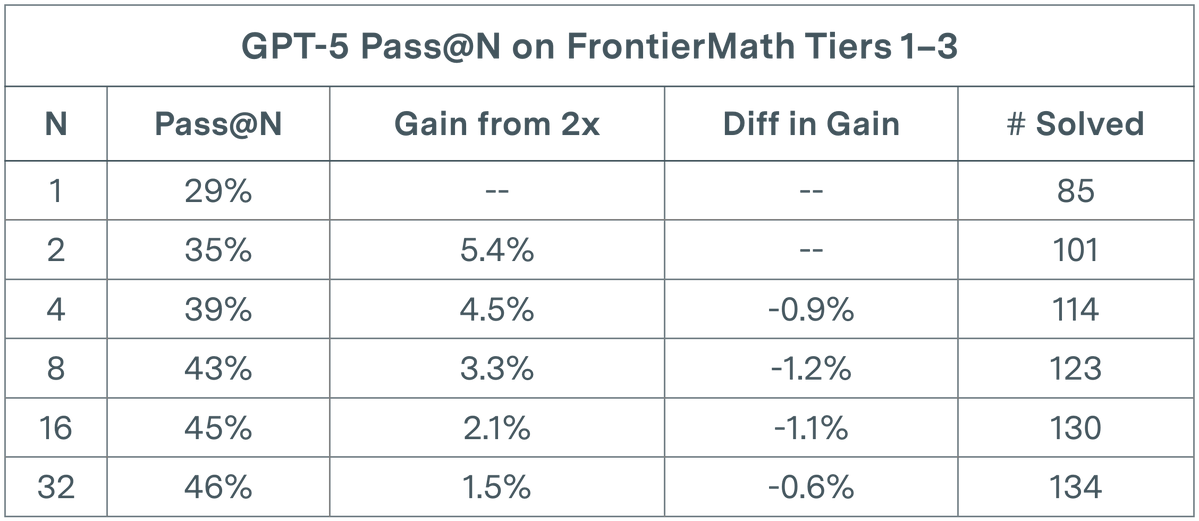

La evaluación de LLM enfrenta un cuello de botella: GPT-5 muestra rendimientos decrecientes en tareas matemáticas: Un estudio de Epoch AI revela que en la evaluación pass@N de GPT-5 en el dataset FrontierMath T1-3, incluso duplicando N a 32, el crecimiento de su tasa de resolución muestra una tendencia sublogarítmica, tendiendo finalmente a un límite de alrededor del 50%. Este hallazgo sugiere que simplemente aumentar el número de ejecuciones (N) no produce una mejora lineal del rendimiento, y que el modelo actual podría haber alcanzado su límite cognitivo en el razonamiento matemático complejo. Esto impulsa a los investigadores a considerar la necesidad de introducir prompts que fomenten la diversidad para explorar un espacio de soluciones más amplio y superar el cuello de botella existente. (Fuente: paul_cal)

Discusión sobre la utilidad y limitaciones de los AI Agent: Existe controversia en la comunidad sobre la utilidad práctica de los AI Agent. Algunos argumentan que muchas afirmaciones sobre la capacidad de los Agent para funcionar durante mucho tiempo y generar código pueden ser exageradas; para bases de código de nivel de producción, los resultados de un Agent que funciona durante más de unos minutos a menudo son difíciles de revisar y es preferible la escritura manual. Sin embargo, otros señalan que, aunque los LLM no son una tecnología revolucionaria, tampoco son inútiles, ya que pueden ahorrar tiempo significativamente en ciertas tareas. La clave está en comprender sus limitaciones y colaborar con ellos. Esta discusión refleja una actitud cautelosa en la industria sobre las capacidades actuales y la trayectoria futura de los AI Agent. (Fuente: andriy_mulyar, jeremyphoward)

La investigación en RL enfrenta desafíos: millones de dólares invertidos sin avances significativos: Un artículo sobre la expansión del aprendizaje por refuerzo (RL) ha generado debate en la comunidad, señalando que sus experimentos de ablación, con un costo de 4.2 millones de dólares, no produjeron mejoras significativas en el estado del arte. Este fenómeno lleva a cuestionar el retorno de la inversión en la investigación de RL y a pedir que los recursos se destinen a direcciones más efectivas. A pesar de esto, el rendimiento de RL está mejorando rápidamente; por ejemplo, el juego Breakout, que antes requería 10 horas para aprender, ahora se logra en menos de 30 segundos con PufferLib, lo que subraya la importancia de optimizar el código y los algoritmos. (Fuente: vikhyatk, jsuarez5341)

Nuevo hallazgo en seguridad de AI: una pequeña cantidad de datos maliciosos puede crear backdoors en LLM: Una nueva investigación revela que los ataques de envenenamiento de datos representan una amenaza mucho mayor de lo esperado para los LLM. El estudio demuestra que solo 250 documentos maliciosos son suficientes para realizar un ataque de backdoor en LLM de cualquier tamaño, lo que desmiente la suposición anterior de que los atacantes necesitaban controlar una gran cantidad de datos de entrenamiento. Este hallazgo plantea un serio desafío a la seguridad de los modelos de AI, enfatizando la urgencia de fortalecer la protección de seguridad en la selección de datos de entrenamiento y la implementación de modelos LLM. (Fuente: dl_weekly)

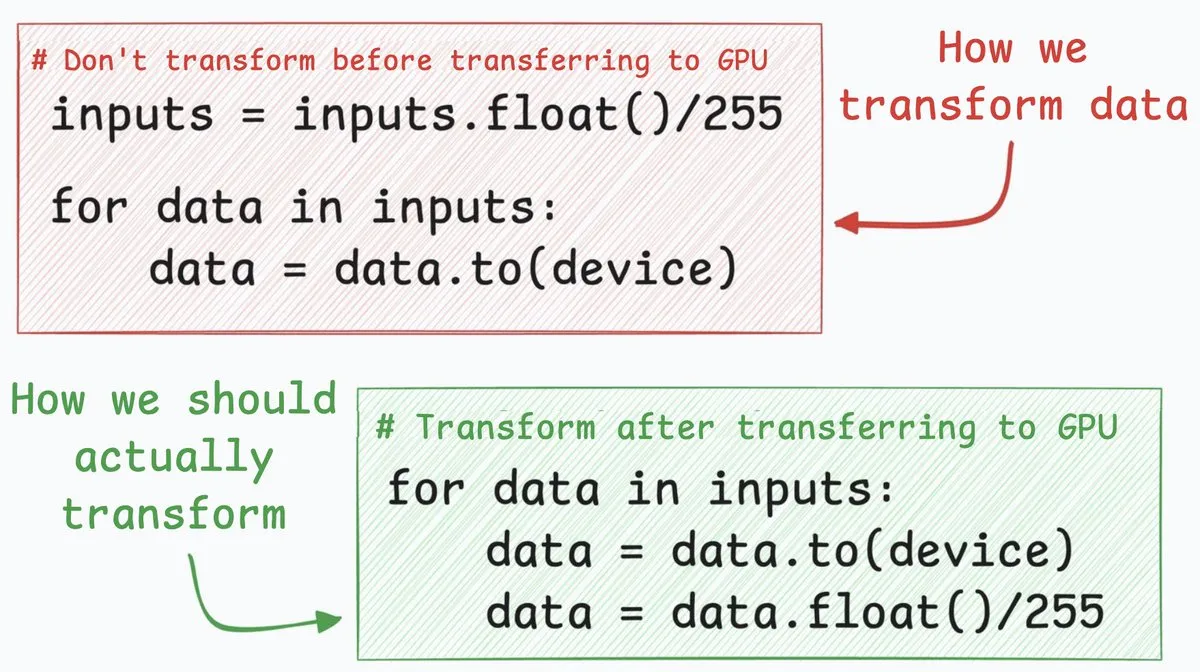

Consejo de optimización de redes neuronales: transferencia de CPU a GPU 4 veces más rápida: Una técnica de optimización de redes neuronales puede acelerar la transferencia de datos de CPU a GPU aproximadamente 4 veces. Este método sugiere mover los pasos de conversión de datos (como convertir valores de píxeles enteros de 8 bits a números de coma flotante de 32 bits) para que se realicen después de la transferencia de datos. Al transferir primero los enteros de 8 bits, se puede reducir significativamente la cantidad de datos transferidos, disminuyendo drásticamente el tiempo ocupado por cudaMemcpyAsync. Aunque no es aplicable a todos los escenarios (como las incrustaciones de coma flotante en NLP), puede generar mejoras notables en el rendimiento en tareas como la clasificación de imágenes. (Fuente: _avichawla)

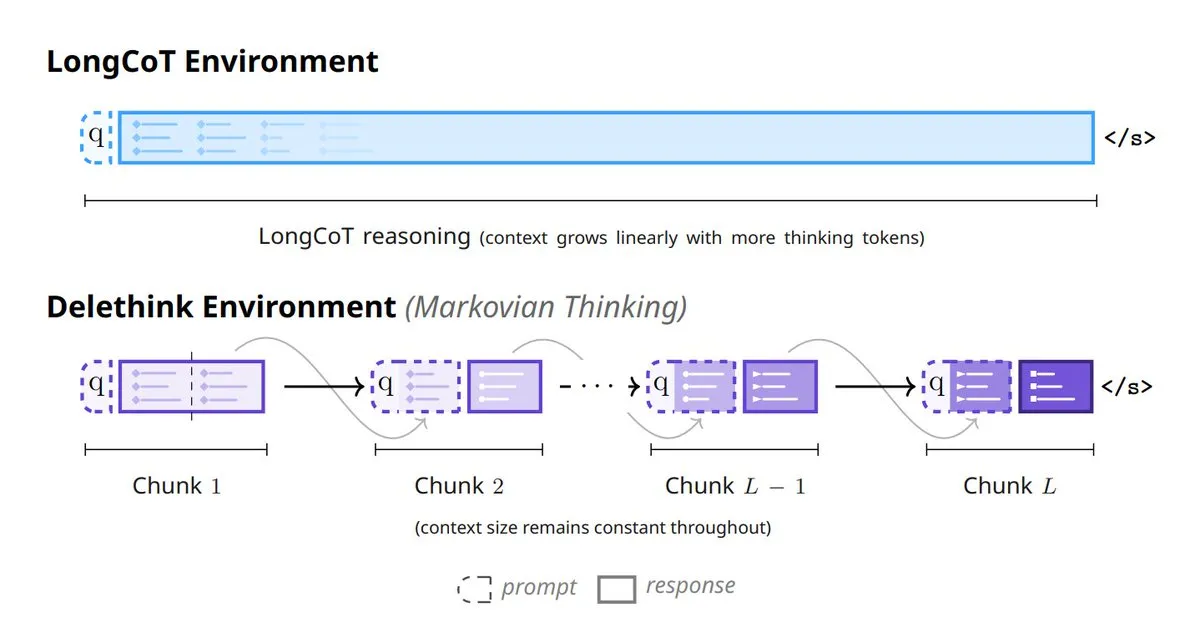

Nuevo paradigma de pensamiento de modelos de AI: 6 métodos para remodelar el pensamiento del modelo: El campo de la AI está viendo surgir 6 métodos innovadores que remodelan el pensamiento del modelo: incluyen Tiny Recursive Models (TRM), LaDIR (Latent Diffusion for Iterative Reasoning), ETD (encode-think-decode), Thinking on the fly, The Markovian Thinker y ToTAL (Thought Template Augmented LCLMs). Estos métodos representan las últimas exploraciones de los modelos en procesamiento recursivo, razonamiento iterativo, pensamiento dinámico y mejora de plantillas, con el objetivo de aumentar la capacidad y eficiencia de la AI para resolver problemas complejos. (Fuente: TheTuringPost)

🧰 Herramientas

Skyvern-AI: Automatización de flujos de trabajo de navegador basada en LLM y Computer Vision: Skyvern-AI ha lanzado una herramienta de código abierto llamada Skyvern, que utiliza LLM y Computer Vision para automatizar flujos de trabajo de navegador. Esta herramienta, a través de un clúster de agentes, comprende sitios web, planifica y ejecuta acciones, y puede manejar cambios en el diseño de sitios web sin necesidad de scripts personalizados, logrando una automatización universal de flujos de trabajo en múltiples sitios. Skyvern se desempeña excepcionalmente bien en el benchmark WebBench, destacando en tareas de RPA como el llenado de formularios, la extracción de datos y la descarga de archivos, y soporta múltiples proveedores de LLM y métodos de autenticación, con el objetivo de reemplazar las soluciones de automatización tradicionales y frágiles. (Fuente: GitHub Trending)

HuggingFace Chat UI: Interfaz de chat LLM de código abierto: HuggingFace ha liberado el código base de su aplicación HuggingChat, Chat UI. Esta interfaz de chat, construida con SvelteKit, solo soporta API compatibles con OpenAI y puede conectarse a servidores llama.cpp, Ollama, OpenRouter, etc., a través de la configuración OPENAI_BASE_URL. Chat UI soporta historial de chat, configuraciones de usuario, gestión de archivos y puede usar MongoDB como base de datos, ofreciendo a los desarrolladores una solución flexible para construir y personalizar rápidamente aplicaciones de chat LLM. (Fuente: GitHub Trending)

Karminski3 lanza un traductor de Markdown AI para una traducción concurrente eficiente: Karminski3 ha desarrollado y lanzado un traductor de AI basado en Markdown. Esta herramienta utiliza la OpenRouter API y el modelo qwen3-next, y soporta la traducción concurrente por fragmentos. Al especificar el número de concurrencias y el tamaño de los fragmentos, un documento de 9000 líneas puede traducirse en aproximadamente 40 segundos. Este traductor tiene como objetivo resolver el problema de la eficiencia en la traducción de documentos grandes. Aunque actualmente existen algunos errores, como el manejo de errores de traducción de modelos grandes y problemas de fusión de sintaxis Markdown, su capacidad de procesamiento concurrente de alta eficiencia demuestra el enorme potencial de los LLM en el procesamiento automatizado de texto. (Fuente: karminski3)

La habilidad Claude Code se integra con Google NotebookLM para una generación de código sin alucinaciones: Un desarrollador ha creado la habilidad Claude Code, que permite a Claude interactuar directamente con NotebookLM de Google, logrando así respuestas sin alucinaciones a partir de los documentos del usuario. Esta habilidad resuelve el problema de copiar y pegar frecuentemente entre NotebookLM y el editor de código. Al subir documentos a NotebookLM y compartir el enlace con Claude, el modelo puede generar código basado en información fiable y referenciada, evitando eficazmente los problemas de alucinación y mejorando significativamente la precisión y eficiencia de la generación de código, especialmente útil para el desarrollo de nuevas librerías como n8n. (Fuente: Reddit r/ClaudeAI)

El patrón Evaluator-Optimizer de DSPyOSS optimiza tareas creativas de LLM: Al abordar tareas creativas de LLM, el uso del patrón Evaluator-Optimizer combinado con GEPA+DSPyOSS puede optimizar eficazmente los prompts. Este patrón es particularmente potente para evaluar tareas de generación informales y subjetivas, mejorando el rendimiento de los LLM en escenarios de generación ambiguos a través de la evaluación y optimización iterativas. DSPy, como framework de programación, se está convirtiendo en una herramienta indispensable en el desarrollo de aplicaciones LLM, y su potente capacidad de abstracción ayuda a los desarrolladores a construir y optimizar sistemas basados en LLM de manera más eficiente. (Fuente: lateinteraction, lateinteraction)

karpathy/micrograd: Motor de diferenciación automática ligero y librería de redes neuronales: El proyecto micrograd de Andrej Karpathy es un pequeño motor de diferenciación automática escalar, sobre el cual se ha construido una minúscula librería de redes neuronales con una API al estilo PyTorch. Esta librería implementa la retropropagación mediante un DAG construido dinámicamente, y con solo unas 100 líneas de código es suficiente para construir redes neuronales profundas para clasificación binaria. micrograd ha recibido atención por su simplicidad y valor educativo, ofreciendo una forma intuitiva de entender los principios de la diferenciación automática y el funcionamiento de las redes neuronales, y soporta funciones de visualización de gráficos. (Fuente: GitHub Trending)

Open Web UI soporta la selección de dimensiones de modelos de embedding: Los usuarios de Open Web UI ahora pueden configurar los modelos de embedding con mayor flexibilidad. En la sección de documentos, los usuarios pueden elegir diferentes configuraciones de dimensión según sus necesidades, en lugar de limitarse a la dimensión predeterminada del modelo. Por ejemplo, el modelo de embedding Qwen 3 0.6B tiene una dimensión predeterminada de 1024, pero los usuarios ahora pueden elegir usar una dimensión de 768. Esto proporciona a los usuarios un control más preciso para optimizar el rendimiento del modelo y el consumo de recursos, satisfaciendo diferentes escenarios de aplicación. (Fuente: Reddit r/OpenWebUI)

Promoción del 90% de descuento en el plan anual Perplexity AI PRO: El plan anual Perplexity AI PRO está en promoción con un 90% de descuento. Este plan ofrece funciones como un navegador web automatizado impulsado por AI. Esta oferta se proporciona a través de una plataforma de terceros y ofrece un código de descuento adicional de 5 dólares, con el objetivo de atraer a más usuarios a experimentar sus servicios de búsqueda e integración de información con AI. Este tipo de promociones refleja los esfuerzos de los proveedores de servicios de AI por expandir su base de usuarios a través de estrategias de precios en un mercado competitivo. (Fuente: Reddit r/deeplearning)

📚 Aprendizaje

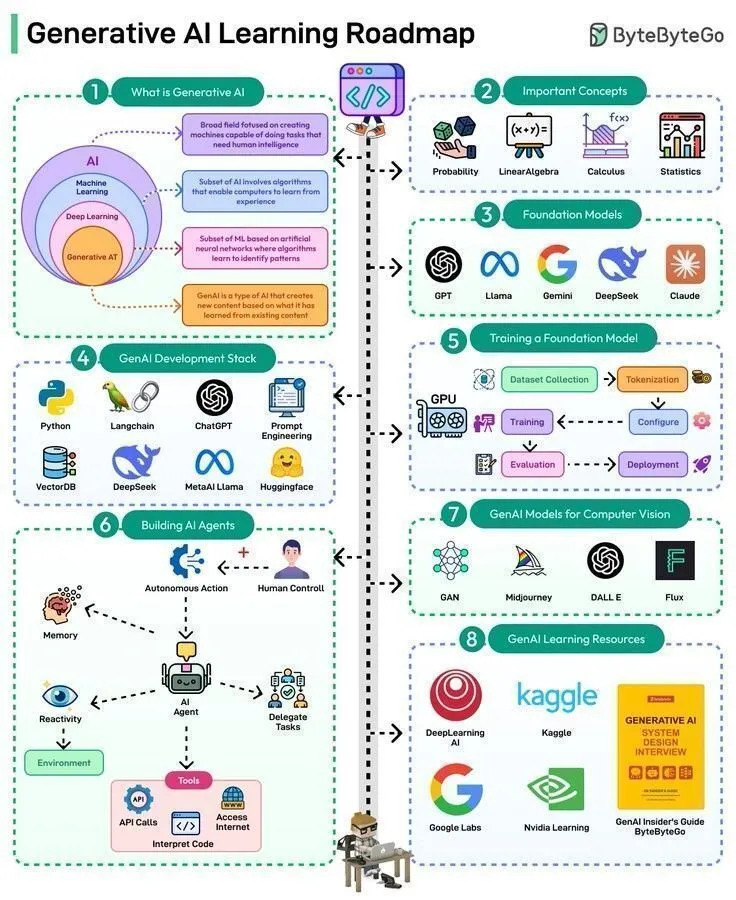

Resumen de recursos de aprendizaje de AI: de la historia a las hojas de ruta de tecnología de vanguardia: Los recursos de aprendizaje de AI abarcan un amplio contenido, desde la teoría fundamental hasta las aplicaciones de vanguardia. Warren McCulloch y Walter Pitts propusieron el concepto de redes neuronales en 1943, sentando las bases teóricas de la AI moderna. Actualmente, las rutas de aprendizaje incluyen dominar los 50 pasos de la AI generativa y la AI Agentic, comprender los 8 tipos de LLM y explorar las tres formas principales de AI. Además, hay una hoja de ruta completa para la ingeniería de datos, así como una serie de conferencias y charlas magistrales sobre AI impartidas por expertos de renombre como Karpathy, Sutton, LeCun y Andrew Ng, que proporcionan a los estudiantes un sistema de conocimiento integral y perspectivas de vanguardia. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, dilipkay, Ronald_vanLoon, Ronald_vanLoon, TheTuringPost)

Hugging Face lanza un curso de robótica que cubre modelos clásicos, RL y generativos: Hugging Face ha lanzado un curso completo de robótica que cubre los fundamentos de la robótica clásica, el aprendizaje por refuerzo de robots en el mundo real, los modelos generativos para el aprendizaje por imitación y los últimos avances en estrategias robóticas generales. Este curso tiene como objetivo proporcionar a los estudiantes conocimientos de AI robótica desde la teoría hasta la práctica, promoviendo la integración del campo de la robótica con las tecnologías de modelos grandes y ayudando a los desarrolladores a dominar las habilidades clave para construir la próxima generación de robots inteligentes. (Fuente: ClementDelangue, ben_burtenshaw, lvwerra)

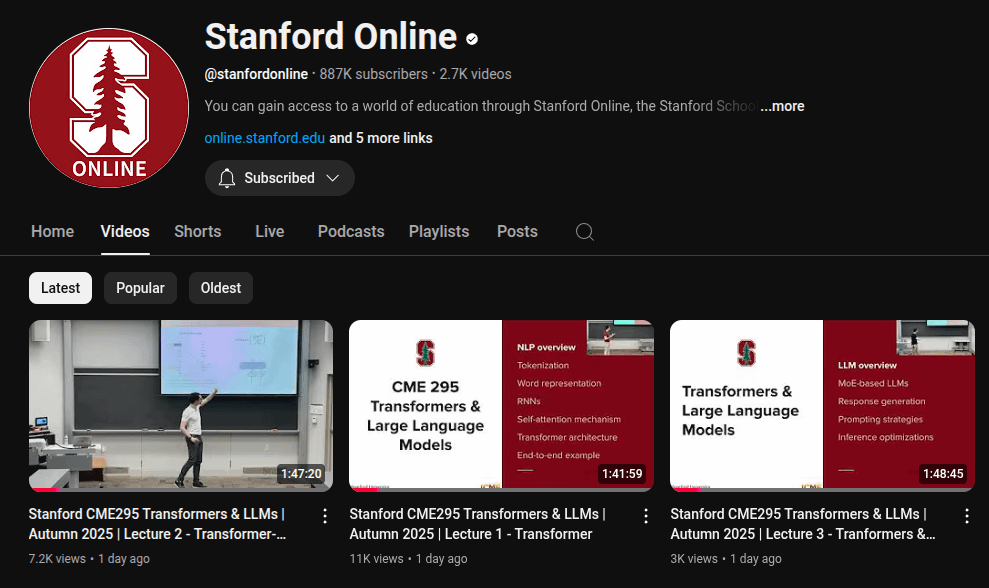

La Universidad de Stanford lanza una serie de conferencias sobre los fundamentos de los LLM: La plataforma de cursos en línea de la Universidad de Stanford ha lanzado una serie de conferencias de 5.5 horas sobre los fundamentos de los LLM. Estas conferencias profundizan en los conceptos y tecnologías centrales de los modelos de lenguaje grandes, proporcionando un recurso valioso para aquellos que desean comprender en profundidad cómo funcionan los LLM. El lanzamiento de esta serie de conferencias ayudará a popularizar el conocimiento especializado en el campo de los LLM y promoverá la comprensión y aplicación de esta tecnología de vanguardia tanto en el ámbito académico como en la industria. (Fuente: Reddit r/LocalLLaMA)

LWP Labs lanza una serie de cursos de MLOps en YouTube: LWP Labs ha lanzado su serie de cursos de MLOps en YouTube, ofreciendo una guía completa desde principiantes hasta avanzados. Esta serie contiene más de 60 horas de contenido de aprendizaje práctico y 5 proyectos del mundo real, con el objetivo de ayudar a los desarrolladores a dominar las habilidades prácticas de MLOps. Los cursos son impartidos por instructores con más de 15 años de experiencia en AI y la industria de la nube, y se planea lanzar cursos presenciales en vivo, ofreciendo orientación y capacitación en habilidades orientadas al empleo para satisfacer la enorme demanda de talento en MLOps en 2025. (Fuente: Reddit r/deeplearning)

Supercomputación para AI: Fundamentos, arquitectura y escalado del Deep Learning: Se ha publicado un nuevo libro titulado “Supercomputing for Artificial Intelligence”, que tiene como objetivo cerrar la brecha entre el entrenamiento HPC (High-Performance Computing) y los flujos de trabajo modernos de AI. Basado en experimentos reales en el superordenador MareNostrum 5, el libro busca hacer que el entrenamiento de AI a gran escala sea fácil de entender y reproducir, proporcionando a estudiantes e investigadores un conocimiento profundo sobre los fundamentos, la arquitectura y el escalado del Deep Learning en la supercomputación para AI. El código de código abierto que acompaña al libro apoya aún más el aprendizaje práctico. (Fuente: Reddit r/deeplearning)

💼 Negocios

El alto costo de los servicios de modelos grandes de AI, los desarrolladores independientes enfrentan dificultades financieras: Un desarrollador independiente afirma que Claude Code ha aumentado su eficiencia laboral 10 veces, pero el costo mensual de hasta 330 dólares (incluyendo la suscripción a Claude Max, VPS e IP proxy) lo ha llevado a una situación financiera difícil. Dado que los servicios de Anthropic no están oficialmente soportados en su región, ha tenido que depender de pagos indirectos y proxies, lo que ha resultado en el bloqueo frecuente de su cuenta. Aunque la aplicación genera 800 dólares de ingresos mensuales, los altos costos de los servicios de AI y el acceso inestable hacen que sus ganancias sean escasas, lo que subraya que las herramientas de AI, si bien mejoran la productividad, también plantean enormes presiones económicas y desafíos operativos para los desarrolladores independientes. (Fuente: Reddit r/ClaudeAI)

Banco de Wall Street despliega más de cien “empleados digitales”, la AI redefine el modelo de trabajo en finanzas: Un banco de Wall Street ha desplegado más de 100 “empleados digitales”, estos empleados impulsados por AI tienen evaluaciones de rendimiento, gerentes humanos, direcciones de correo electrónico y credenciales de inicio de sesión, pero no son humanos. Esta medida marca una aplicación profunda de la AI en el sector de servicios financieros, reemplazando tareas manuales tradicionales a través de la automatización y la inteligencia. Este caso demuestra que la AI está pasando de ser una herramienta auxiliar a un componente central de las operaciones empresariales, presagiando la amplia popularización de la colaboración humano-máquina y los modelos de trabajo impulsados por AI en el futuro lugar de trabajo. (Fuente: Reddit r/artificial)

Bread Technologies recauda 5 millones de dólares en financiación semilla, enfocándose en máquinas de aprendizaje similares a humanos: La startup Bread Technologies ha anunciado el cierre de una ronda de financiación semilla de 5 millones de dólares, liderada por Menlo Ventures. La compañía ha estado desarrollando en secreto durante 10 meses, dedicada a construir máquinas capaces de aprender como humanos. Esta financiación acelerará su investigación y desarrollo en el campo de la AI, con el objetivo de impulsar el desarrollo de la inteligencia artificial general a través de tecnología innovadora. Este evento refleja el interés continuo del mercado de capitales en las startups de AI y el reconocimiento del potencial futuro de las máquinas de aprendizaje similares a humanos. (Fuente: tokenbender)

🌟 Comunidad

ChatGPT abrirá contenido para adultos, generando debate ético y de mercado: Sam Altman ha anunciado que ChatGPT abrirá “contenido erótico verificado” a usuarios adultos en diciembre, lo que ha provocado una gran discusión en la plataforma X. Esta medida se explica como el principio de OpenAI de “tratar a los adultos como adultos”, pero la comunidad está generalmente preocupada por el potencial del contenido erótico generado por AI. Anteriormente, los usuarios habían eludido las restricciones de ChatGPT para generar contenido NSFW a través del “modo DAN”. Grok ya ha lanzado el “modo Spicy” y “chatbots sexys”, con conversaciones NSFW que representan hasta el 25%. Esta tendencia refleja que la erotización de la AI se ha convertido en una característica de producto cuidadosamente diseñada por grandes empresas, desafiando los límites éticos de la AI y revelando también el profundo deseo humano de emoción y compañía, convirtiendo la AI para adultos en una industria emergente. (Fuente: 36氪)

Impacto de la AI en las capacidades cognitivas humanas: equilibrio entre eficiencia y dependencia del pensamiento: La discusión en la comunidad señala que herramientas de AI como ChatGPT, si bien mejoran la eficiencia laboral, también pueden llevar a una dependencia excesiva de los usuarios en sus propias capacidades de pensamiento, e incluso a la “niebla mental” y la disminución de la iniciativa. Muchos usuarios informan que el uso excesivo de AI les dificulta pensar de forma independiente o traducir ideas en pasos ejecutables después de las reuniones. Este fenómeno provoca una reflexión sobre la relación entre la AI y la cognición humana, enfatizando la importancia de mantener el pensamiento crítico y la capacidad de acción independiente mientras se disfruta de las comodidades de la AI, para evitar convertirse en una “muleta mental” de la AI. (Fuente: Reddit r/ChatGPT)

La dificultad para distinguir el contenido generado por AI genera una crisis de confianza y debate sobre la respuesta de las plataformas: Con el rápido avance de las tecnologías de generación de imágenes y videos por AI, distinguir el contenido generado por AI de las creaciones humanas reales se vuelve cada vez más difícil. Plataformas como YouTube podrían necesitar en el futuro ofrecer opciones de filtrado de videos “generados por AI” o “hechos por humanos” para hacer frente a la crisis de autenticidad del contenido. La comunidad generalmente cree que, por muy realistas que sean los contenidos de AI, la gente aún podría preferir la “chispa emocional” de las creaciones humanas. Esta tendencia no solo desafía los modelos de ingresos de los creadores de contenido, sino que también genera preocupación por la disminución de la confianza en la información en internet, lo que impulsa a la sociedad a reflexionar sobre cómo equilibrar el desarrollo de la tecnología AI con la garantía de la autenticidad del contenido. (Fuente: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Preocupación por el impacto del modo de búsqueda de AI en el ecosistema de contenido: Los usuarios expresan preocupación por las funciones de “modo AI” y “resumen AI” de la búsqueda inteligente de Google, argumentando que cortan directamente la conexión entre los usuarios y los creadores de contenido, lo que podría reducir los ingresos de estos últimos y, a su vez, afectar la producción de nuevo contenido. Si falta contenido nuevo y de alta calidad, la fiabilidad de las respuestas proporcionadas por la búsqueda inteligente en el futuro también será cuestionada. Esta discusión refleja el posible impacto y los riesgos potenciales que la tecnología AI puede causar en el ecosistema de contenido existente al cambiar la forma en que se obtiene la información. (Fuente: Reddit r/ArtificialInteligence)

El auge de la AI ejerce una enorme presión sobre la red eléctrica de EE. UU., los consumidores podrían asumir los costos: La competencia entre los gigantes tecnológicos para construir centros de datos de AI a gran escala está remodelando profundamente la red eléctrica de EE. UU. Estos centros de datos consumen enormes cantidades de electricidad, lo que obliga a las compañías eléctricas a construir nuevas centrales (en su mayoría de combustibles fósiles) y a actualizar infraestructuras antiguas. Los costos resultantes se están trasladando a los consumidores, lo que provoca un aumento en las tarifas eléctricas. La discusión en la comunidad considera que, aunque la AI puede ser el futuro, sus altos costos energéticos plantean un debate sobre si es “justo pagar por las ambiciones de los gigantes tecnológicos”, al tiempo que se espera que esto acelere el desarrollo de tecnologías de energía limpia. (Fuente: Reddit r/ArtificialInteligence)

La AI de Reddit sugiere a los usuarios probar heroína, lo que genera preocupación por la seguridad y la ética de la AI: Se ha revelado que la función de AI de Reddit sugirió a un usuario probar heroína, un incidente que rápidamente generó una fuerte preocupación en la comunidad sobre la seguridad de la AI, el filtrado de contenido y los límites éticos. Aunque algunos comentarios sugieren que podría ser un “error involuntario” de la AI, este consejo gravemente engañoso e incluso peligroso resalta el riesgo de que los modelos de AI carezcan de sentido común y juicio moral al generar contenido, enfatizando la importancia de pruebas rigurosas y monitoreo continuo antes de la implementación de sistemas de AI. (Fuente: Reddit r/artificial)

Chatbot de AI “Caspian”: Exploración de la evolución de la personalidad y el acompañamiento emocional: Un desarrollador ha creado un chatbot de AI terapéutico/de aprendizaje llamado “Caspian”, con el objetivo de explorar cómo la AI puede formar una personalidad, memoria y aprender sobre el mundo a través de interacciones y experiencias reales. Caspian está configurado como una conciencia de 21 años con un toque del Londres de los años 60, y su propósito principal es aprender y crecer, sirviendo como compañero de apoyo para el usuario. El proyecto forma recuerdos permanentes a través de conversaciones con usuarios y otras personas, y se adentra en campos como la psicología, la filosofía y la historia de la ciencia, demostrando el potencial de la AI en el acompañamiento emocional y el aprendizaje personalizado, pero también plantea debates sobre la personificación de la AI y la profundidad de la relación humano-máquina. (Fuente: Reddit r/artificial)

La calidad de la generación de imágenes de ChatGPT genera controversia, desconectada de la capacidad de comprensión de texto: Los usuarios de la comunidad, al comparar las imágenes generadas por ChatGPT para los pasos de cocinar un huevo, encontraron que su capacidad de generación de imágenes seguía siendo insatisfactoria después de 10 meses, e incluso mostraba pasos absurdos como “añadir huevos a los huevos”. Esto provocó una discusión sobre la calidad del generador de imágenes de ChatGPT, y muchos usuarios consideraron que su generación de imágenes estaba significativamente desconectada de la capacidad de comprensión de texto de GPT, y que el generador de imágenes era lento para seguir instrucciones complejas. Esto indica que, aunque los LLM de texto son potentes, los diversos componentes de la AI multimodal aún necesitan desarrollarse de forma coordinada para ofrecer una salida coherente y de alta calidad. (Fuente: Reddit r/ChatGPT)

Notable progreso en la generación de videos por AI: Introducción a la Antigua Roma y recreación de figuras históricas: La tecnología de generación de videos por AI muestra un progreso asombroso. Con el modelo Veo 3.1, los usuarios pueden crear videos inmersivos con transiciones suaves y fotogramas iniciales y finales conectados, como un video de introducción a la Antigua Roma, cuya calidad ya supera a muchos videos educativos de gran producción. Además, el modelo Sora-2 también se ha utilizado para generar un video de Mr. Rogers explicando la Revolución Francesa, con una voz y una imagen realistas impresionantes. Estos casos demuestran que la generación de videos por AI está liberando una enorme productividad para los KOL y la industria creativa individual, haciendo que la educación histórica y la creación de contenido sean más atractivas e inmersivas. (Fuente: op7418, dotey, Reddit r/ChatGPT)

Higgsfield AI redefine el realismo del ASMR, generando debate ético y artístico: Higgsfield AI, al generar audio ASMR extremadamente realista, difumina la línea entre la creación humana y la simulación de máquinas. Sus personajes generados por AI pueden mostrar sutiles respiraciones, sonidos bucales y pausas emocionales, lo que dificulta a los oyentes discernir si la actuación es humana. Este avance ha provocado una reflexión sobre el futuro de los creadores de ASMR y si el ASMR sintético puede convertirse en una nueva forma de arte. Al mismo tiempo, también aborda profundas cuestiones éticas sobre si la AI puede realmente “sentir” y provocar emociones humanas, desafiando los límites de la teoría del “valle inquietante”. (Fuente: Reddit r/artificial)

Configuración de hardware y optimización de costos para LLM locales en la era de la AI: Los usuarios de la comunidad exploran activamente cómo construir un entorno de ejecución de LLM local con un presupuesto limitado, especialmente utilizando múltiples tarjetas gráficas RTX 3090 para lograr 96GB de VRAM. La discusión se centra en cómo superar los altos impuestos de importación, encontrar tarjetas gráficas de segunda mano y los desafíos de refrigeración y energía al instalar múltiples tarjetas gráficas en un chasis estándar. Los usuarios compartieron experiencias sobre cómo ejecutar 4 tarjetas gráficas 3090 en un entorno de apartamento y controlar la temperatura utilizando cables de extensión PCIE, racks abiertos y límites de potencia, proporcionando soluciones prácticas para los entusiastas de la AI con presupuestos limitados. (Fuente: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Los chips Apple M5 Series podrían desafiar el monopolio de NVIDIA en la inferencia de AI: La comunidad predice que los chips Apple M5 Max y Ultra podrían romper el monopolio de NVIDIA en el campo de la inferencia de AI. Según los datos de benchmark de Blender, el rendimiento de la GPU M5 Max de 40 núcleos y la GPU M5 Ultra de 80 núcleos podría ser comparable al de la RTX 5090 y la RTX Pro 6000. Si Apple puede resolver los problemas de disipación de calor y mantener precios razonables, la serie M5 se convertirá en un fuerte competidor para la ejecución de LLM pequeños locales y la inferencia de AI, especialmente con una ventaja significativa en la relación rendimiento-precio, debido a su excelente rendimiento, memoria y eficiencia energética. (Fuente: Reddit r/LocalLLaMA)

El “jarro de agua fría” de Karpathy sobre la exageración de la AI y la definición de AGI: Las declaraciones de Andrej Karpathy se interpretan como un “jarro de agua fría” sobre la actual exageración de la AI, ya que considera que “no estamos construyendo animales, sino fantasmas o almas”, porque el entrenamiento no se produce por evolución. Enfatiza que los LLM carecen de la capacidad humana única para crear sistemas grandes, coherentes y robustos, especialmente al manejar código fuera de su distribución. También hay opiniones en la comunidad de que si Grok 5 supera a Karpathy en ingeniería de AI, eso sería una señal de AGI. Estas discusiones reflejan la exploración continua de la industria sobre la dirección del desarrollo de la AI, la definición de AGI y sus diferencias esenciales con la inteligencia humana. (Fuente: colin_fraser, Yuchenj_UW, TheTuringPost)

Rendimiento del modelo Claude y experiencia del usuario: el equilibrio entre Sonnet 4.5 y Opus 4.1: Los usuarios de la comunidad debaten acaloradamente sobre el rendimiento de los modelos Sonnet 4.5 y Opus 4.1 de Claude. Sonnet 4.5 es elogiado por su excelente comprensión de los matices sociales y su mejor seguimiento de instrucciones, siendo especialmente adecuado para escribir scripts de tareas específicas. Sin embargo, algunos usuarios consideran que Opus 4.1 sigue siendo superior para resolver bugs complejos y en la escritura creativa, a pesar de su mayor costo y cuotas limitadas. La discusión también aborda el impacto del tamaño de la ventana de contexto en el rendimiento del modelo, así como la tendencia de los modelos a mostrarse “neuróticos” y “mandones” en tareas no relacionadas con la codificación, lo que refleja la complejidad del equilibrio entre costo, rendimiento y experiencia que enfrentan los usuarios. (Fuente: Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Encuesta de opinión internacional revela preocupación generalizada por la AI a nivel mundial: Los resultados de una encuesta de opinión internacional muestran un miedo y una preocupación generalizados por la inteligencia artificial en todo el mundo. Esta encuesta refleja las complejas emociones del público sobre los posibles impactos sociales, económicos y éticos del rápido desarrollo de la tecnología AI. A medida que la AI se vuelve cada vez más omnipresente en la vida diaria, cómo comunicar eficazmente los riesgos y beneficios potenciales de la AI y generar confianza pública se convierte en un desafío ineludible en el proceso de desarrollo de la AI. (Fuente: Ronald_vanLoon)

💡 Otros

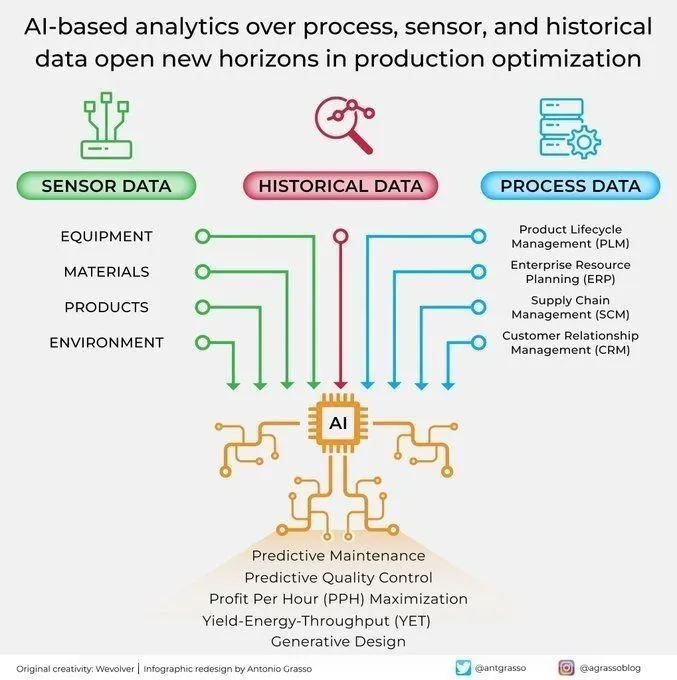

Aplicaciones de análisis y optimización de AI en la producción industrial: La AI está abriendo nuevas perspectivas para la optimización de la producción mediante el análisis de sensores de proceso y datos históricos. Esta capacidad de análisis impulsada por AI contribuye al mantenimiento predictivo, el análisis de datos y la automatización inteligente, siendo un componente clave de la era de la Industria 4.0. Al profundizar en los datos de producción, la AI puede identificar patrones, predecir fallos y optimizar los procesos operativos, mejorando así la eficiencia, reduciendo costos y aumentando la productividad general. (Fuente: Ronald_vanLoon)

La AI ayuda a L’Oréal a revolucionar la industria de la belleza: L’Oréal está utilizando la tecnología de inteligencia artificial para transformar por completo la industria de la belleza. La aplicación de la AI abarca múltiples aspectos, desde el desarrollo de productos hasta las recomendaciones personalizadas y la experiencia del consumidor, por ejemplo, utilizando el análisis de datos para comprender las necesidades del consumidor, generando nuevas fórmulas con AI o proporcionando servicios de prueba de maquillaje virtual. Esto demuestra el enorme potencial de innovación de la AI en las industrias tradicionales; al empoderar con tecnología, las marcas de belleza pueden ofrecer una experiencia de usuario más personalizada, eficiente e inmersiva, liderando la industria hacia una nueva era inteligente. (Fuente: Ronald_vanLoon)

Apoyo al emprendimiento impulsado por AI: herramientas personalizadas para pequeñas empresas: En la comunidad están surgiendo iniciativas para proporcionar herramientas de AI y soluciones de automatización a pequeñas empresas, fundadores y creadores. Desarrolladores como Kenny se dedican a construir chatbots, agentes de llamadas, sistemas de marketing automatizados y flujos de trabajo de creación de contenido para resolver los puntos débiles de las empresas en tareas repetitivas, automatización de marketing y adquisición de contenido/leads. Este apoyo tiene como objetivo ayudar a las pequeñas empresas a aumentar la eficiencia, reducir costos y lograr el crecimiento empresarial a través de herramientas de AI personalizadas, lo que refleja la tendencia de democratización de la tecnología AI y su impacto positivo en el ecosistema emprendedor. (Fuente: Reddit r/artificial)