Palabras clave:robot humanoide, modelo grande de IA, aprendizaje por refuerzo, IA multimodal, agente de IA, cuello de botella de datos de Figure 03, demostración matemática de GPT-5 Pro, RAG en dispositivo de EmbeddingGemma, diálogo de análisis gráfico con GraphQA, rendimiento de inferencia de NVIDIA Blackwell

🔥 En Foco

Figure 03 en la portada de la lista de las mejores invenciones de Time, el CEO dice “en esta etapa, solo faltan los datos” : El CEO de Figure, Brett Adcock, declaró que el mayor cuello de botella actual para el robot humanoide Figure 03 es la “data”, no la arquitectura ni la capacidad de cómputo, y cree que la data puede resolver casi todos los problemas, impulsando la aplicación a gran escala de los robots. Figure 03 apareció en la portada de la lista de las mejores invenciones de la revista Time de 2025, lo que provocó un debate sobre la importancia de la data, la capacidad de cómputo y la arquitectura en el desarrollo de los robots. Brett Adcock enfatizó que el objetivo de Figure es que los robots realicen tareas humanas en entornos domésticos y comerciales, y otorga gran importancia a la seguridad de los robots, prediciendo que el número de robots humanoides podría superar al de los humanos en el futuro. (Fuente: 量子位)

¡Terence Tao desafía fronteras con GPT-5 Pro! Un problema sin solución durante 3 años, resuelto con una prueba completa en 11 minutos : El renombrado matemático Terence Tao, en colaboración con GPT-5 Pro, resolvió un problema de geometría diferencial sin solución durante 3 años en solo 11 minutos. GPT-5 Pro no solo completó cálculos complejos, sino que también proporcionó una prueba completa e incluso ayudó a Tao a corregir su intuición inicial. Tao concluyó que la AI se desempeña excelentemente en problemas de “pequeña escala”, también es útil para comprender problemas de “gran escala”, pero en estrategias de “escala media” podría reforzar intuiciones erróneas. Subrayó que la AI debe ser el “copiloto” de los matemáticos, mejorando la eficiencia experimental, en lugar de reemplazar completamente el trabajo humano creativo e intuitivo. (Fuente: 量子位)

🎯 Tendencias

Yunpeng Technology lanza nuevos productos de AI+Salud : Yunpeng Technology, en colaboración con Shuaikang y Skyworth, ha lanzado nuevos productos de AI+Salud, incluyendo el “Laboratorio de Cocina del Futuro Digital e Inteligente” y un refrigerador inteligente equipado con un gran modelo de AI para la salud. El gran modelo de AI para la salud optimiza el diseño y la operación de la cocina, mientras que el refrigerador inteligente ofrece gestión de salud personalizada a través del “Asistente de Salud Xiaoyun”. Esto marca un avance de la AI en la gestión diaria de la salud, logrando servicios de salud personalizados a través de dispositivos inteligentes, lo que se espera impulse el desarrollo de la tecnología de salud en el hogar y mejore la calidad de vida de los residentes. (Fuente: 36氪)

Avances en robots humanoides e inteligencia encarnada: del hogar a las aplicaciones industriales : Múltiples discusiones en redes sociales muestran los últimos avances en robots humanoides e inteligencia encarnada. Reachy Mini fue nombrado una de las mejores invenciones de 2025 por la revista Time, lo que demuestra el potencial de la colaboración de código abierto en el campo de la robótica. Una prótesis biónica impulsada por AI permite a un joven de 17 años controlar con la mente, y los robots humanoides pueden realizar tareas domésticas con facilidad. En el sector industrial, Yondu AI lanzó una solución de picking de almacén con robots humanoides con ruedas, AgiBot presentó el Lingxi X2 con capacidad de movimiento casi humana, y China también lanzó un robot policial esférico de alta velocidad. Los robots de Boston Dynamics han evolucionado para convertirse en camarógrafos multifuncionales, y el robot cuadrúpedo LocoTouch logra un transporte inteligente a través del tacto. (Fuente: Ronald_vanLoon, Ronald_vanLoon, ClementDelangue, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, johnohallman, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Avances en las capacidades de los grandes modelos y nuevas mejoras en las pruebas de referencia de código : GPT-5 Pro y Gemini 2.5 Pro lograron un rendimiento de medalla de oro en la Olimpiada Internacional de Astronomía y Astrofísica (IOAA), demostrando la poderosa capacidad de la AI en el campo de la física de vanguardia. GPT-5 Pro también exhibió una capacidad superior de búsqueda y verificación de literatura científica, resolviendo el problema Erdos #339 y pudiendo identificar eficazmente fallas importantes en artículos publicados. En el ámbito del código, KAT-Dev-72B-Exp se convirtió en el modelo de código abierto líder en SWE-Bench Verified, alcanzando una tasa de reparación del 74.6%. El proyecto SWE-Rebench evita la contaminación de datos al probar nuevos GitHub issue planteados después del lanzamiento de los grandes modelos. Sam Altman está muy entusiasmado con el futuro de Codex. En cuanto a si la AGI puede lograrse únicamente con LLM puros, la comunidad de investigación de AI generalmente cree que es difícil de alcanzar solo con el núcleo de LLM. (Fuente: gdb, karminski3, gdb, SebastienBubeck, karminski3, teortaxesTex, QuixiAI, sama, OfirPress, Reddit r/LocalLLaMA, Reddit r/ArtificialInteligence)

Innovación y desafíos de rendimiento en hardware e infraestructura de AI : La plataforma NVIDIA Blackwell ha demostrado un rendimiento y eficiencia de inferencia inigualables en las pruebas de referencia SemiAnalysis InferenceMAX, y Together AI ya ofrece sistemas NVIDIA GB200 NVL72 y HGX B200. Groq, a través de su ASIC y estrategia de integración vertical, está redefiniendo la economía de la infraestructura de LLM de código abierto con menor latencia y precios competitivos. La comunidad discutió el impacto de la eliminación del Python GIL en la ingeniería de AI/ML, creyendo que su eliminación podría mejorar el rendimiento multihilo. Además, los entusiastas de LLM compartieron sus configuraciones de hardware y exploraron las compensaciones de rendimiento entre modelos grandes cuantificados y modelos pequeños no cuantificados en diferentes niveles de cuantificación, señalando que la cuantificación de 2 bits puede ser adecuada para la conversación, pero las tareas de codificación requieren al menos Q5. (Fuente: togethercompute, arankomatsuzaki, code_star, MostafaRohani, jeremyphoward, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Dinámicas de vanguardia en modelos y aplicaciones de AI: de modelos generales a dominios verticales : Nuevos modelos y funcionalidades de AI continúan surgiendo. El gran modelo de turco Kumru-2B ha destacado en Hugging Face, y Replit lanzó varias actualizaciones esta semana. Sora 2 ha eliminado su marca de agua, lo que presagia aplicaciones más amplias para la tecnología de generación de video. Se rumorea que Gemini 3.0 se lanzará el 22 de octubre. La AI sigue profundizando en el sector de la salud, con la patología digital utilizando AI para el diagnóstico asistido de cáncer, y la microscopía sin marcadores combinada con AI promete nuevas herramientas de diagnóstico. Los modelos de Realidad Aumentada (AR) han logrado el SOTA en la lista Imagenet FID. El Agent de codificación de línea de comandos Qwen Code se actualizó para admitir el reconocimiento de imágenes del modelo Qwen-VL. La Universidad de Stanford propuso el método Agentic Context Engineering (ACE), que permite que los modelos sean más inteligentes sin necesidad de un ajuste fino. Los modelos de la serie DeepSeek V3 también están en constante iteración, y los tipos de despliegue de AI Agent y la remodelación de los servicios profesionales por parte de la AI también se han convertido en puntos focales de la industria. (Fuente: mervenoyann, amasad, scaling01, npew, kaifulee, Ronald_vanLoon, scaling01, TheTuringPost, TomLikesRobots, iScienceLuvr, NerdyRodent, shxf0072, gabriberton, Ronald_vanLoon, karminski3, Ronald_vanLoon, teortaxesTex, demishassabis, Dorialexander, yoheinakajima, 36氪)

🧰 Herramientas

GraphQA: Convirtiendo el análisis de grafos en conversaciones en lenguaje natural : LangChainAI ha lanzado el framework GraphQA, que combina NetworkX y LangChain para transformar el análisis complejo de grafos en conversaciones en lenguaje natural. Los usuarios pueden hacer preguntas en inglés simple, y GraphQA seleccionará y ejecutará automáticamente los algoritmos apropiados, manejando grafos con más de 100,000 nodos. Esto simplifica enormemente la barrera de entrada para el análisis de datos de grafos, haciéndolo más accesible para usuarios no especializados, y representa una importante innovación de herramientas en el campo de los LLM. (Fuente: LangChainAI)

La mejor herramienta Agentic AI para VS Code : Visual Studio Magazine ha calificado una herramienta como una de las mejores herramientas Agentic AI para VS Code, lo que marca un cambio en el paradigma de desarrollo de “asistentes” a “Agentes reales” que pueden pensar, actuar y construir junto con los desarrolladores. Esto refleja la evolución de las herramientas de AI en el desarrollo de software, desde funciones auxiliares hasta una colaboración inteligente más profunda, mejorando la eficiencia y la experiencia de los desarrolladores. (Fuente: cline)

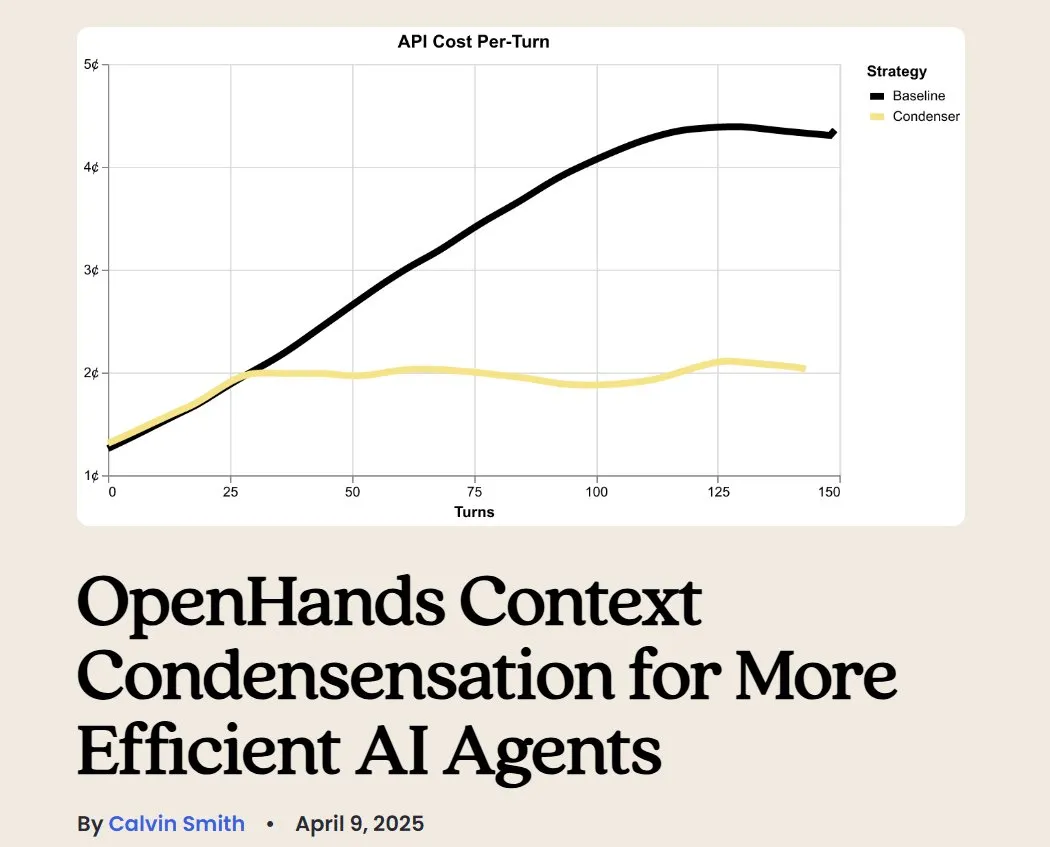

OpenHands: Herramienta de código abierto para la gestión de contexto de LLM : OpenHands, como herramienta de código abierto, ofrece varios compresores de contexto para gestionar el contexto de los LLM en aplicaciones Agentic, incluyendo la poda básica del historial, la extracción de “eventos más importantes” y la compresión de la salida del navegador. Esto es crucial para la depuración, evaluación y monitoreo de aplicaciones LLM, sistemas RAG y flujos de trabajo Agentic, lo que ayuda a mejorar la eficiencia y consistencia de los LLM en tareas complejas. (Fuente: gneubig)

BLAST: Motor de navegador web AI : LangChainAI ha lanzado BLAST, un motor de navegador web AI de alto rendimiento diseñado para proporcionar capacidades de navegación web a las aplicaciones de AI. BLAST ofrece una interfaz compatible con OpenAI, soporta paralelización automática, caché inteligente y streaming en tiempo real, lo que permite integrar eficientemente la información web en los flujos de trabajo de AI, expandiendo enormemente la capacidad de los AI Agents para obtener y procesar datos web en tiempo real. (Fuente: LangChainAI)

Opik: Herramienta de evaluación de LLM de código abierto : Opik es una herramienta de evaluación de LLM de código abierto utilizada para depurar, evaluar y monitorear aplicaciones LLM, sistemas RAG y flujos de trabajo Agentic. Ofrece seguimiento completo, evaluación automatizada y paneles listos para producción, ayudando a los desarrolladores a comprender mejor el comportamiento del modelo, optimizar el rendimiento y garantizar la fiabilidad de las aplicaciones en escenarios reales. (Fuente: dl_weekly)

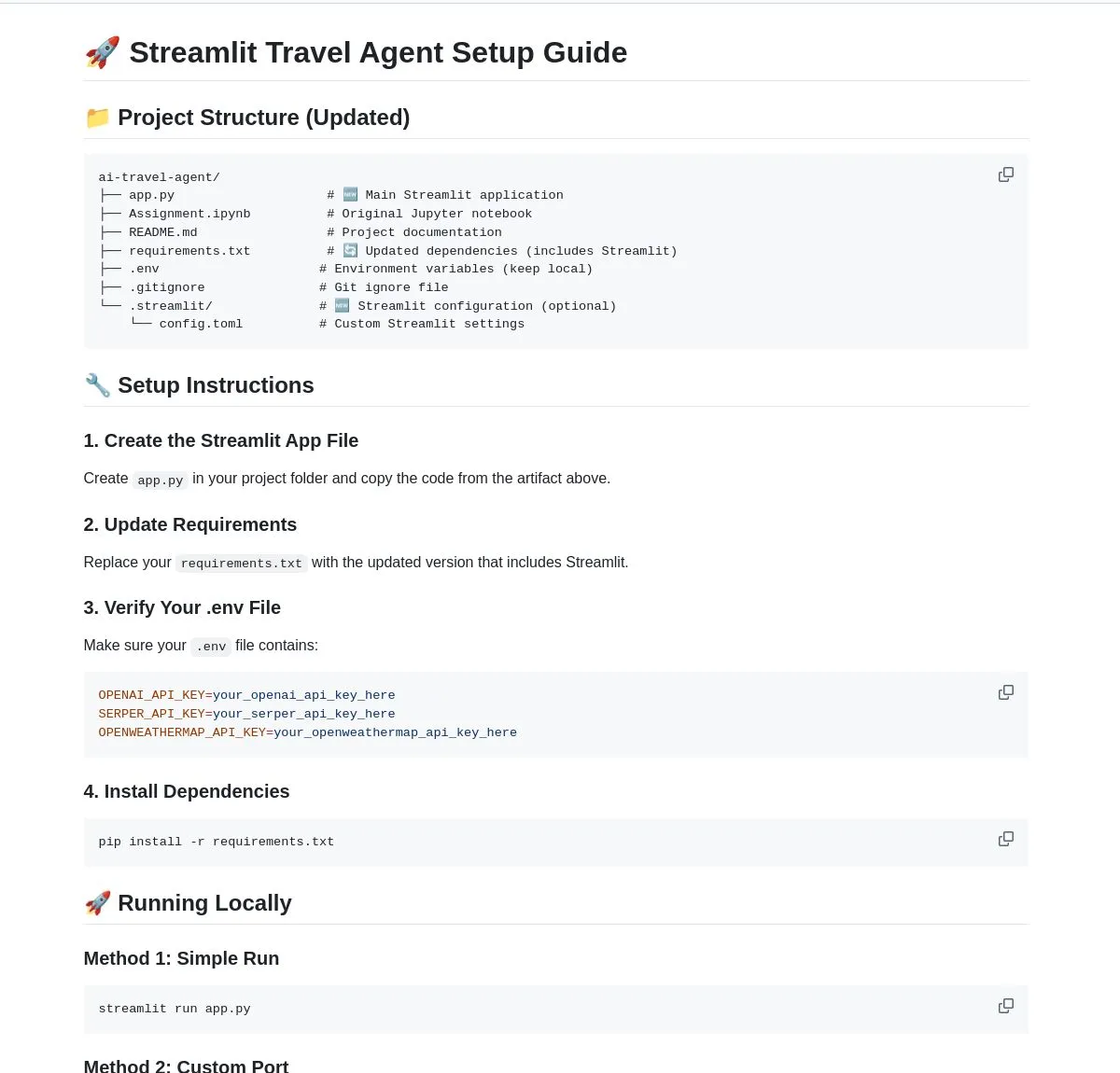

AI Travel Agent: Asistente de planificación inteligente : LangChainAI ha presentado un AI Travel Agent inteligente que integra información de clima en tiempo real, búsqueda y viajes, y utiliza múltiples API para simplificar todo el proceso, desde las actualizaciones meteorológicas hasta el cambio de divisas. Este Agent está diseñado para proporcionar planificación y asistencia de viajes integral, mejorando la experiencia del usuario, y es un caso típico de cómo los LLM potencian a los Agents en escenarios de aplicación vertical. (Fuente: LangChainAI)

Concepción de una herramienta de construcción de prompts para anunciantes de AI : Se ha planteado la idea de que el mercado necesita urgentemente una herramienta de AI que ayude a los profesionales del marketing a construir “prompts para anunciantes”. Esta herramienta debería ayudar a establecer un sistema de evaluación (que cubra la seguridad de la marca, el cumplimiento de los prompts, etc.) y probar los modelos principales. Con el lanzamiento de varias unidades de anuncios naturales por parte de OpenAI, la importancia de los prompts de marketing es cada vez más evidente, y estas herramientas se convertirán en un eslabón clave en el proceso de creatividad y distribución publicitaria. (Fuente: dbreunig)

Actualización de Qwen Code: Soporte para reconocimiento de imágenes del modelo Qwen-VL : El Agent de codificación de línea de comandos Qwen Code se actualizó recientemente, añadiendo soporte para cambiar al modelo Qwen-VL para el reconocimiento de imágenes. Las pruebas de usuario muestran buenos resultados y actualmente es de uso gratuito. Esta actualización amplía enormemente las capacidades de Qwen Code, permitiéndole no solo manejar tareas de código, sino también realizar interacciones multimodales, mejorando la eficiencia y precisión del Agent de codificación al procesar tareas que contienen información visual. (Fuente: karminski3)

Alojando un servidor personal de chatbot con LibreChat : Una publicación de blog ofrece una guía sobre cómo usar LibreChat para alojar un servidor personal de chatbot y conectarse a múltiples paneles de control de modelos (MCPs). Esto permite a los usuarios gestionar y cambiar de forma flexible entre diferentes backends de LLM, logrando una experiencia de chatbot personalizada, y destaca la flexibilidad y control de las soluciones de código abierto en el despliegue de aplicaciones de AI. (Fuente: Reddit r/artificial)

Generador de AI: Dando vida a avatares virtuales : Un usuario busca el mejor generador de AI para “dar vida” a su imagen de marca (incluyendo videos de personas reales y avatares virtuales) para su canal de YouTube, con el fin de reducir el tiempo de filmación y grabación y centrarse en la edición. El usuario espera que la AI permita a los avatares conversar, jugar, bailar, etc. Esto refleja la alta demanda de los creadores de contenido de herramientas de AI para la animación de avatares y la generación de video, con el fin de mejorar la eficiencia de producción y la diversidad de contenido. (Fuente: Reddit r/artificial)

LLM local contra el spam de correo electrónico: una solución privada : Una publicación de blog comparte cómo utilizar LLM locales para identificar y combatir de forma privada el spam en el propio servidor de correo electrónico. Esta solución combina Mailcow, Rspamd, Ollama y un agente Python personalizado, proporcionando a los usuarios de servidores de correo autoalojados un método de filtrado de spam basado en AI, destacando el potencial de los LLM locales en la protección de la privacidad y las aplicaciones personalizadas. (Fuente: Reddit r/LocalLLaMA)

📚 Aprendizaje

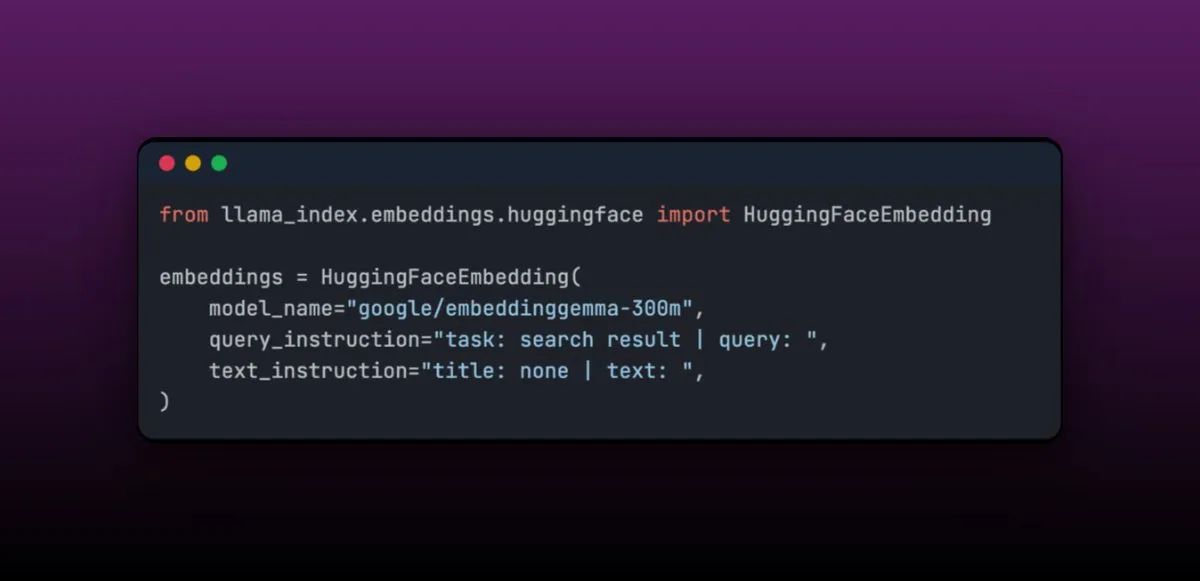

EmbeddingGemma: Modelo de embedding multilingüe para aplicaciones RAG en dispositivos : EmbeddingGemma es un modelo de embedding multilingüe compacto con solo 308M parámetros, ideal para aplicaciones RAG en dispositivos y fácil de integrar con LlamaIndex. Este modelo ocupa un lugar destacado en el Massive Text Embedding Benchmark y, debido a su pequeño tamaño, es adecuado para dispositivos móviles. Su facilidad de ajuste fino permite que, después de ser ajustado en dominios específicos (como datos médicos), su rendimiento pueda superar al de modelos más grandes. (Fuente: jerryjliu0)

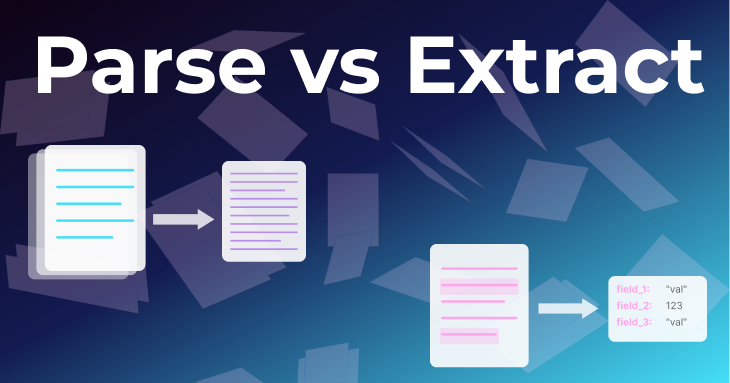

Dos métodos fundamentales para el procesamiento de documentos: Parsing y Extracción : Un artículo del equipo de LlamaIndex profundiza en dos métodos fundamentales para el procesamiento de documentos: “parsing” y “extracción”. El parsing convierte el documento completo en Markdown o JSON estructurado, conservando toda la información, y es adecuado para RAG, investigación profunda y resumen. La extracción obtiene una salida estructurada del LLM, estandarizando el documento a un patrón común, y es adecuado para ETL de bases de datos, flujos de trabajo de Agent automatizados y extracción de metadatos. Comprender la diferencia entre ambos es crucial para construir Agents de documentos eficientes. (Fuente: jerryjliu0)

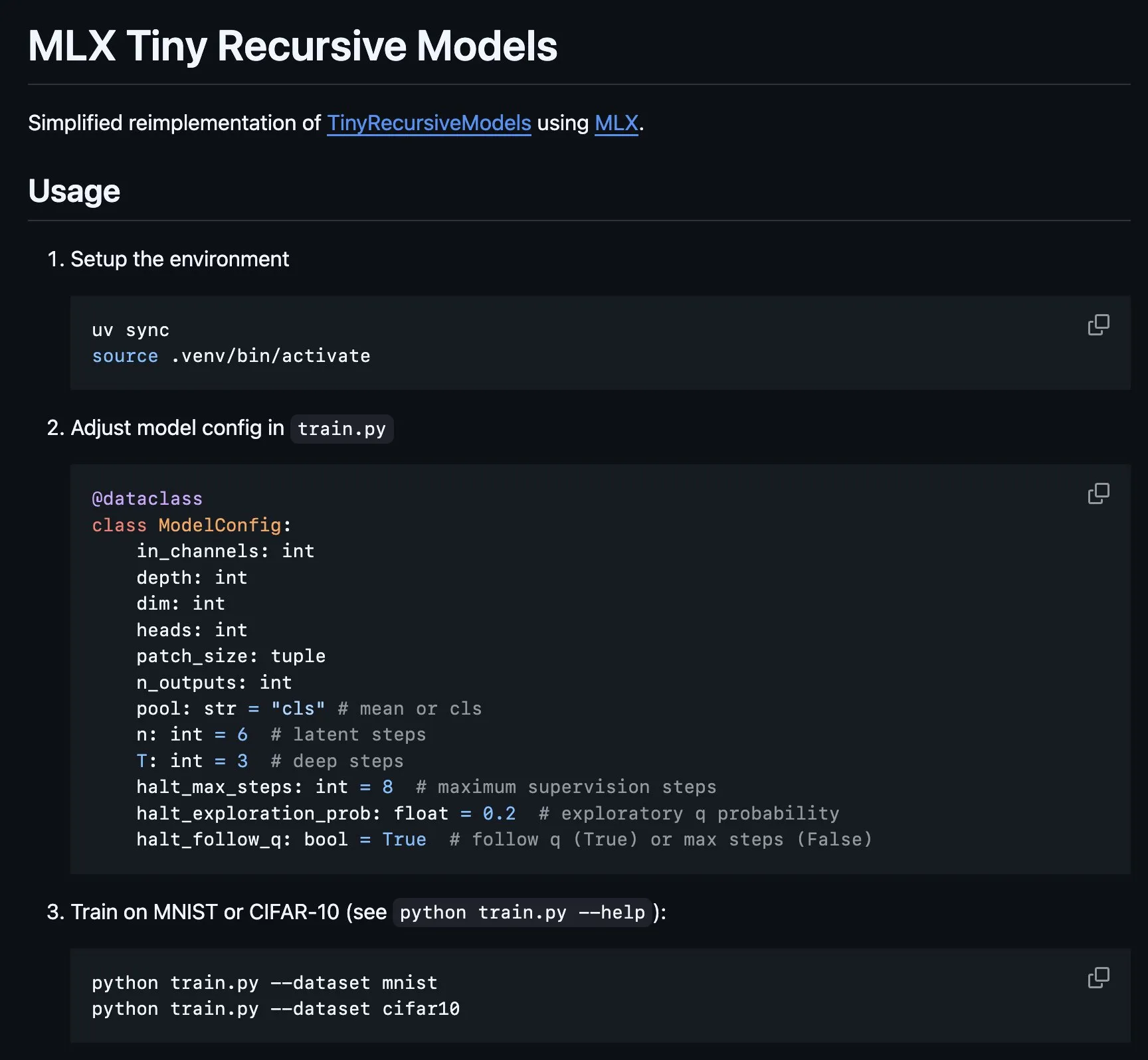

Implementación de Tiny Recursive Model (TRM) en MLX : La plataforma MLX implementa la parte central del Tiny Recursive Model (TRM), propuesto por Alexia Jolicoeur-Martineau, que busca obtener un alto rendimiento a través de inferencia recursiva con una pequeña red neuronal de 7M parámetros. Esta implementación en MLX hace posible la experimentación local en laptops Apple Silicon, reduciendo la complejidad y cubriendo características como la supervisión profunda, los pasos de inferencia recursiva y EMA, lo que facilita el desarrollo y la investigación de modelos pequeños y eficientes. (Fuente: awnihannun, ImazAngel)

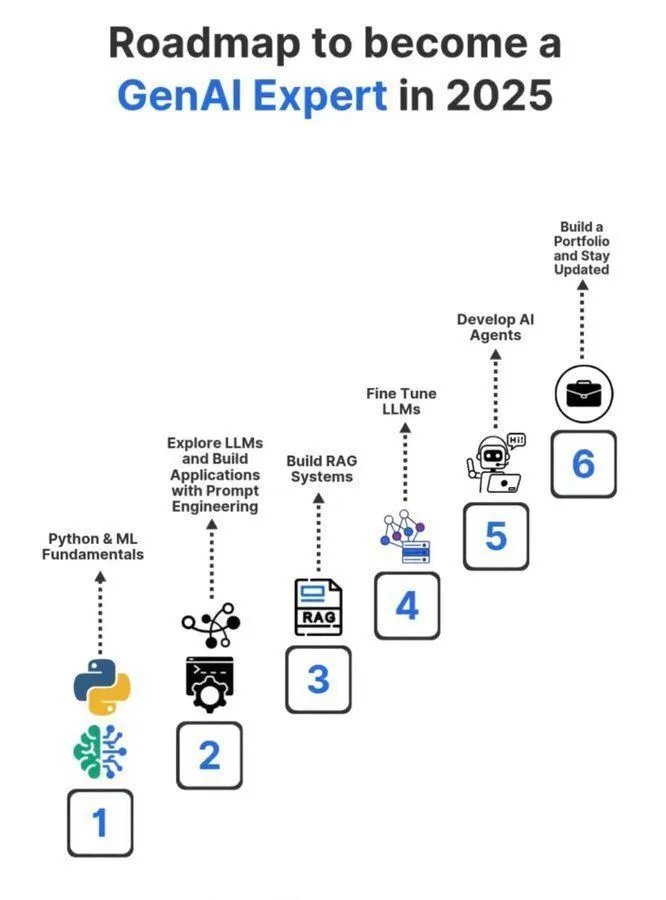

Hoja de ruta de aprendizaje para expertos en AI generativa 2025 : Se ha compartido en redes sociales una hoja de ruta detallada para expertos en AI generativa en 2025, que cubre los conocimientos y habilidades clave necesarios para convertirse en un profesional en el campo de la AI generativa. Esta hoja de ruta tiene como objetivo guiar a los aspirantes a aprender sistemáticamente conceptos centrales como inteligencia artificial, machine learning y deep learning, para adaptarse a las tendencias tecnológicas de GenAI en rápido desarrollo. (Fuente: Ronald_vanLoon)

Compartiendo experiencias de estudio de doctorado en Machine Learning : Un usuario ha vuelto a compartir una serie de tweets sobre la realización de un doctorado en el campo del Machine Learning, con el objetivo de proporcionar orientación y experiencia a quienes estén interesados en estudiar un doctorado en ML. Estos tweets pueden cubrir el proceso de solicitud, las direcciones de investigación, el desarrollo profesional y las experiencias personales, constituyendo un valioso recurso de aprendizaje de AI en la comunidad. (Fuente: arohan)

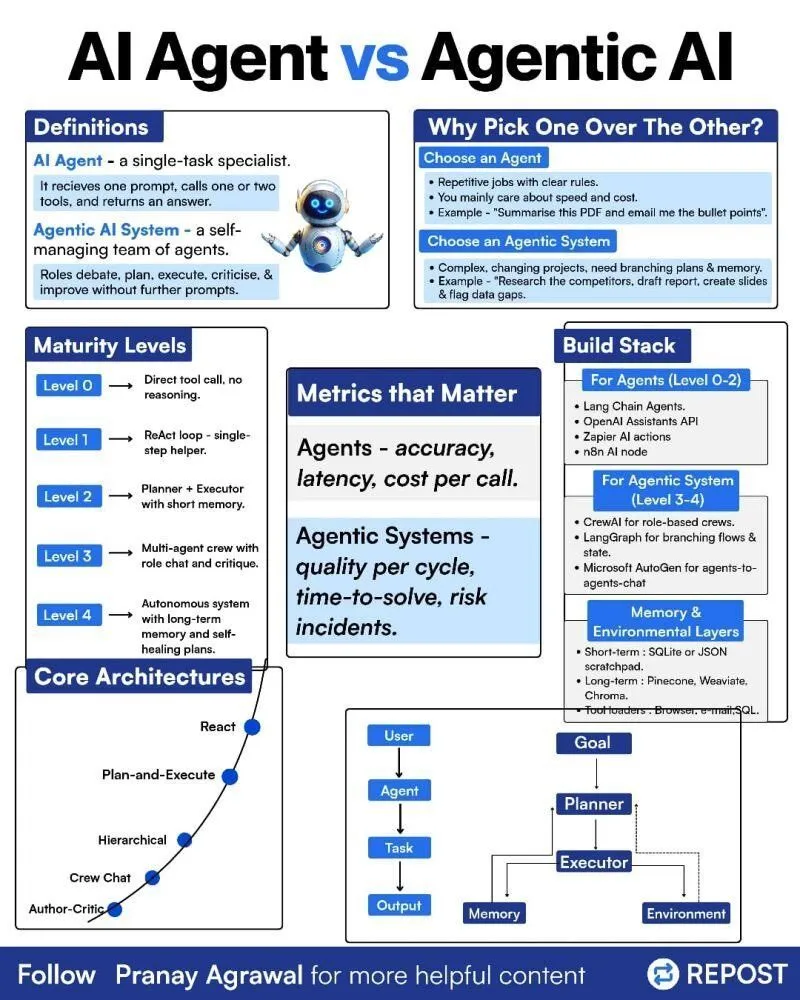

Diferencias entre AI Agents y Agentic AI : Se ha compartido en redes sociales una infografía sobre las diferencias entre “AI Agents” y “Agentic AI”, con el objetivo de aclarar estos dos conceptos relacionados pero distintos. Esto ayuda a la comunidad a comprender mejor los tipos de despliegue de AI Agent, su nivel de autonomía y el papel de la Agentic AI en sistemas de inteligencia artificial más amplios, promoviendo una discusión más precisa sobre la tecnología de Agents. (Fuente: Ronald_vanLoon)

Reinforcement Learning y Weight Decay en el entrenamiento de LLM : Las redes sociales discutieron que el Weight Decay podría no ser una buena idea en el entrenamiento de Reinforcement Learning (RL) de LLM. Algunos argumentan que el Weight Decay puede hacer que la red olvide una gran cantidad de información pre-entrenada, especialmente en las actualizaciones de GRPO con ventaja cero, donde los pesos tienden a cero. Esto sugiere que los investigadores deben considerar cuidadosamente el impacto del Weight Decay al diseñar estrategias de entrenamiento de RL para LLM, para evitar la degradación del rendimiento del modelo. (Fuente: lateinteraction)

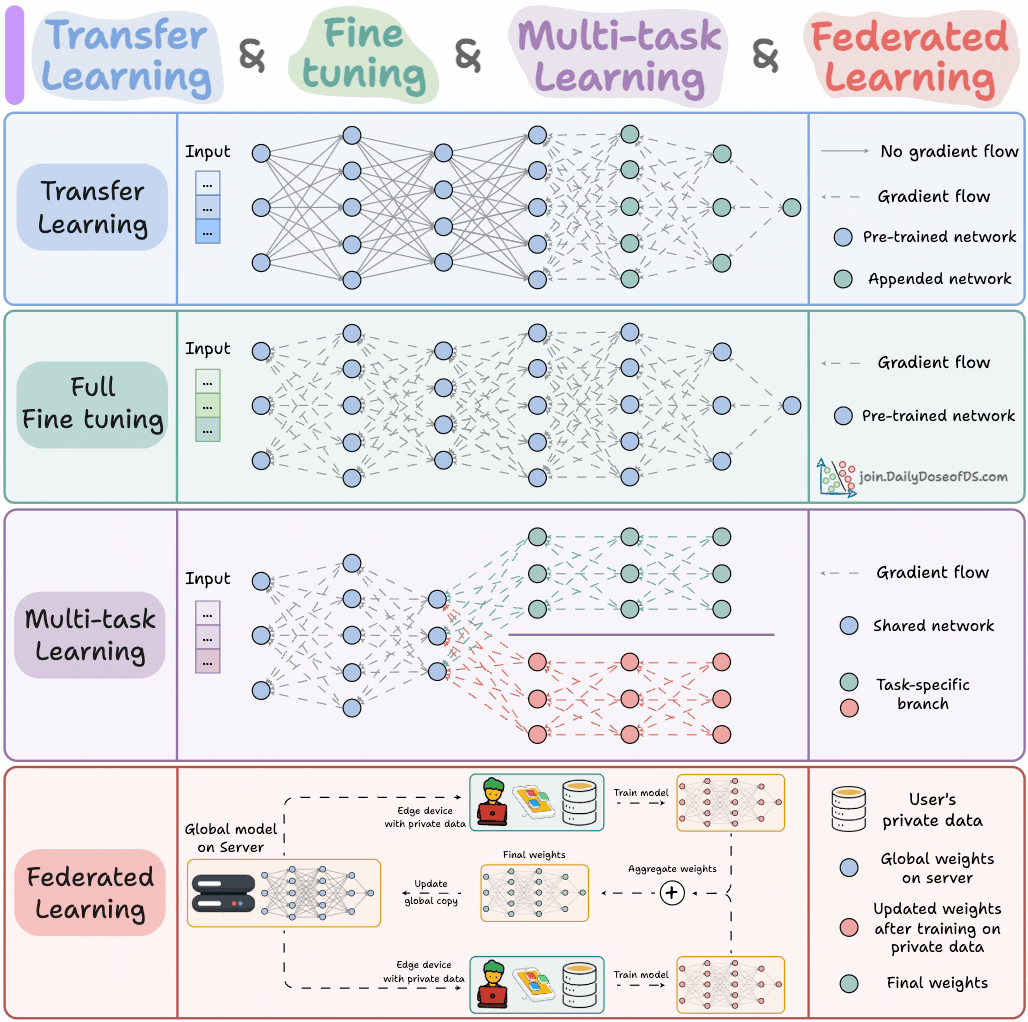

Paradigmas de entrenamiento de modelos de AI : Un experto compartió cuatro paradigmas de entrenamiento de modelos que los ingenieros de ML deben conocer, con el objetivo de proporcionar una guía teórica y un marco práctico clave para los ingenieros de Machine Learning. Estos paradigmas pueden abarcar el aprendizaje supervisado, no supervisado, por refuerzo y auto-supervisado, ayudando a los ingenieros a comprender y aplicar mejor los diferentes métodos de entrenamiento de modelos. (Fuente: _avichawla)

Reinforcement Learning basado en Curriculum Learning para mejorar las capacidades de los LLM : Un estudio encontró que el Reinforcement Learning (RL) combinado con Curriculum Learning puede enseñar nuevas capacidades a los LLM, algo difícil de lograr con otros métodos. Esto demuestra el potencial del Curriculum Learning para mejorar las capacidades de razonamiento a largo plazo de los LLM, lo que sugiere que la combinación de RL y Curriculum Learning podría ser una vía clave para desbloquear nuevas habilidades de AI. (Fuente: sytelus)

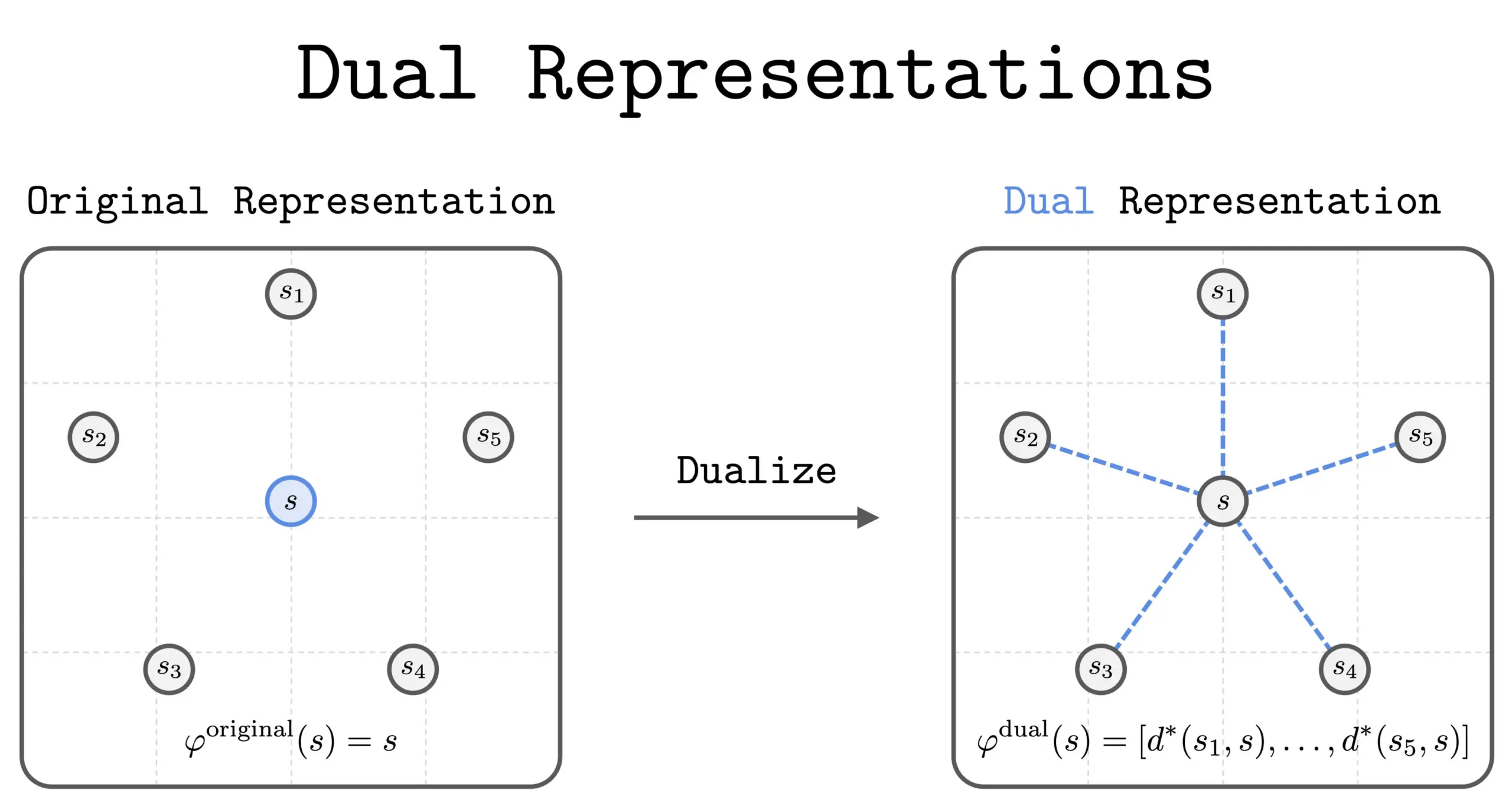

Nuevo método de “representación dual” en RL : Una nueva investigación introduce el método de “representación dual” en el Reinforcement Learning (RL). Este método ofrece una nueva perspectiva al representar los estados como un “conjunto de similitudes” con todos los demás estados. Esta representación dual posee buenas propiedades teóricas y beneficios prácticos, y se espera que mejore el rendimiento y la capacidad de comprensión del RL. (Fuente: dilipkay)

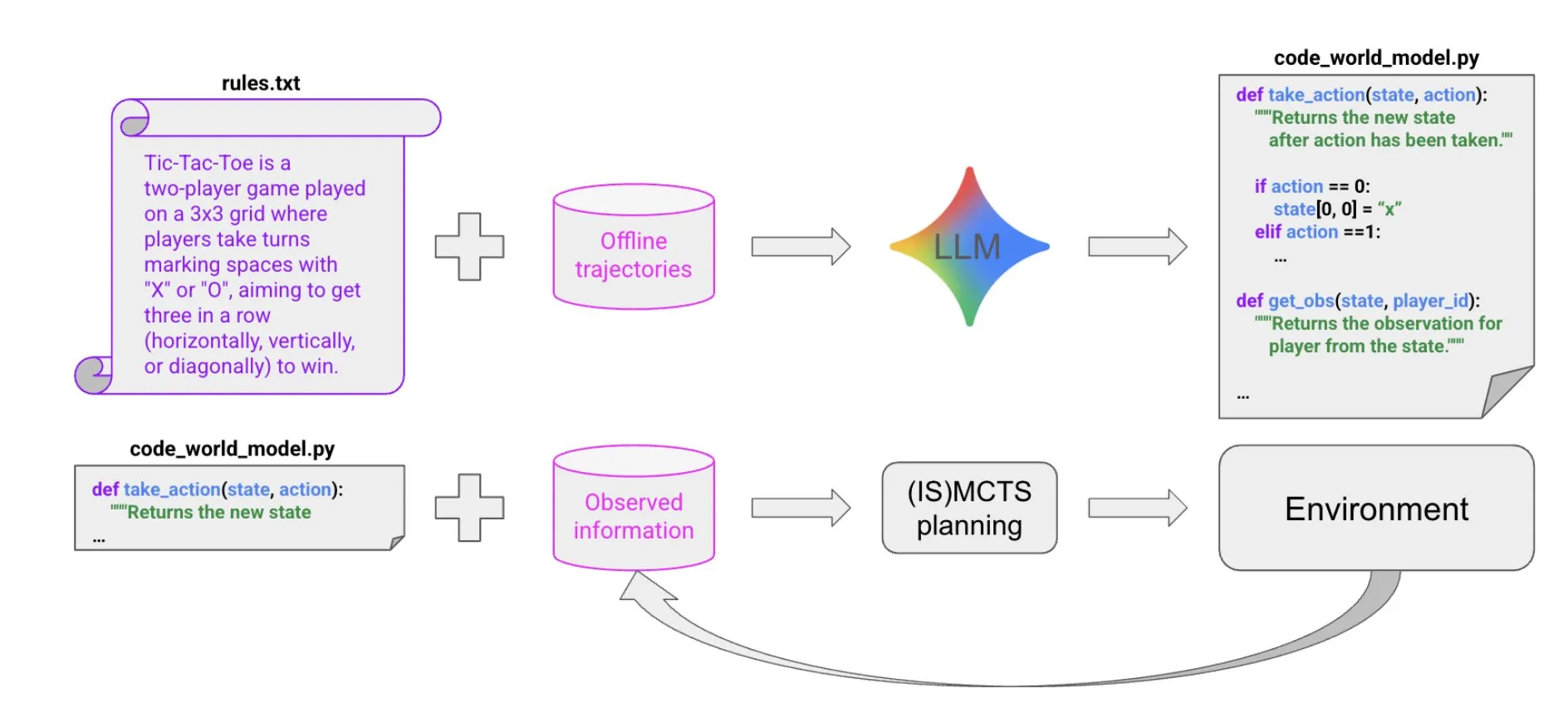

Construcción de modelos del mundo mediante síntesis de código impulsada por LLM : Un nuevo artículo propone un método extremadamente eficiente en cuanto a muestras para crear Agents que se desempeñan bien en entornos simbólicos multi-Agent y parcialmente observables, mediante la síntesis de código impulsada por LLM. Este método aprende modelos del mundo de código a partir de una pequeña cantidad de datos de trayectoria e información de fondo, y luego los pasa a solucionadores existentes (como MCTS) para seleccionar la siguiente acción, proporcionando nuevas ideas para la construcción de Agents complejos. (Fuente: BlackHC)

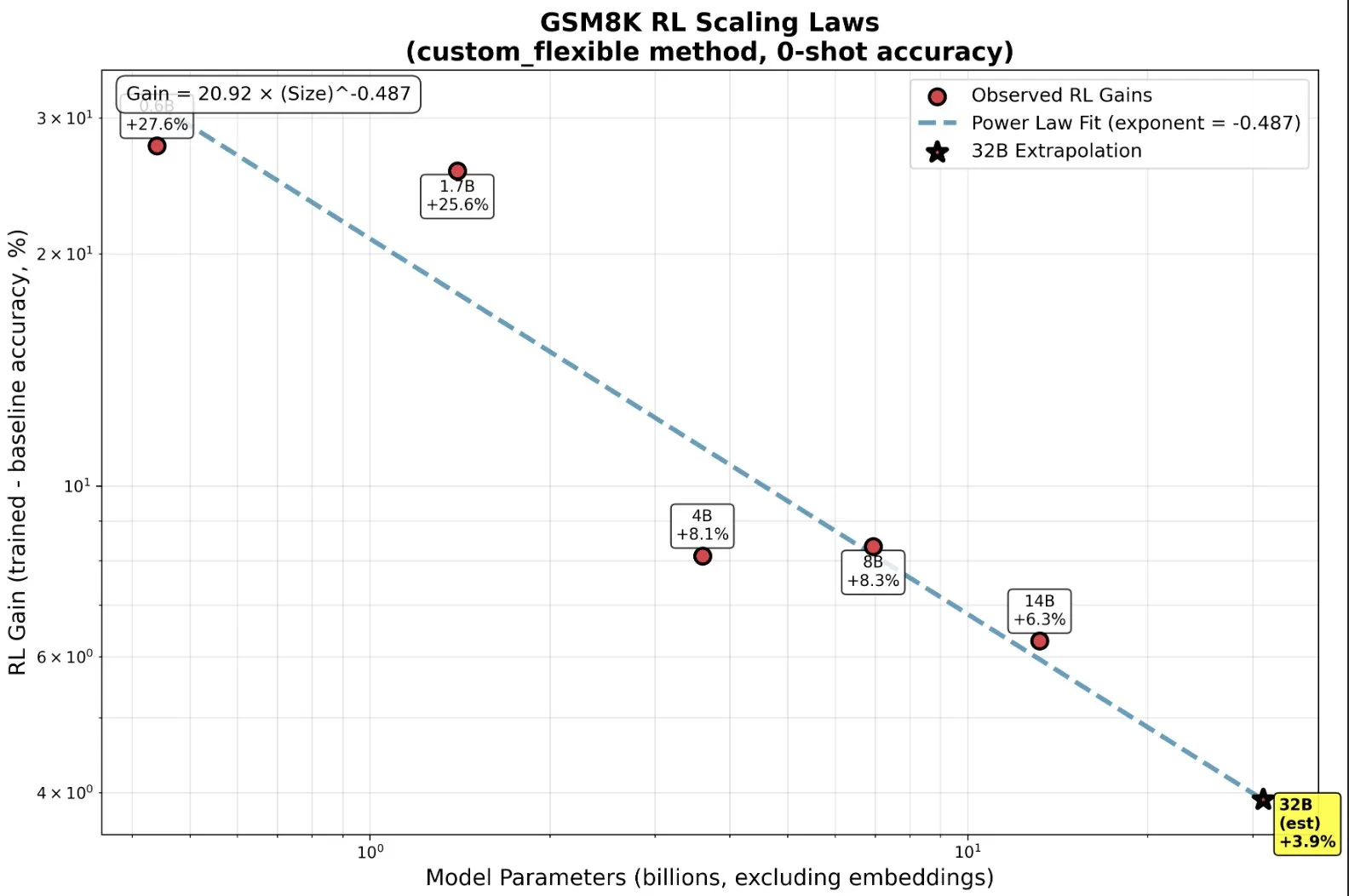

Entrenamiento de modelos pequeños con RL: Capacidades emergentes más allá del pre-entrenamiento : La investigación ha descubierto que, en el Reinforcement Learning (RL), los modelos pequeños pueden beneficiarse desproporcionadamente e incluso exhibir capacidades “emergentes”, lo que desafía la intuición tradicional de “cuanto más grande, mejor”. En modelos de pequeña escala, el RL puede ser más eficiente computacionalmente que un mayor pre-entrenamiento. Este hallazgo es significativo para las decisiones de los laboratorios de AI sobre cuándo detener el pre-entrenamiento y cuándo comenzar el RL al escalar, revelando nuevas leyes de escalado entre el tamaño del modelo y la mejora del rendimiento en RL. (Fuente: ClementDelangue, ClementDelangue)

AI vs. Machine Learning vs. Deep Learning: Explicación sencilla : Un recurso de video explica de manera sencilla y fácil de entender las diferencias entre Inteligencia Artificial (AI), Machine Learning (ML) y Deep Learning (DL). Este video tiene como objetivo ayudar a los principiantes a comprender rápidamente estos conceptos centrales, sentando las bases para un estudio más profundo en el campo de la AI. (Fuente: )

Gestión de plantillas de prompts en experimentos con modelos de Deep Learning : La comunidad de Deep Learning discutió cómo gestionar y reutilizar plantillas de prompts en experimentos con modelos. En proyectos grandes, especialmente al modificar arquitecturas o conjuntos de datos, el seguimiento del efecto de diferentes variantes de prompts se vuelve complejo. Los usuarios compartieron experiencias utilizando herramientas como Empromptu AI para el control de versiones y la clasificación de prompts, enfatizando la importancia de la versionización de prompts y la alineación de conjuntos de datos con prompts para optimizar los productos del modelo. (Fuente: Reddit r/deeplearning)

Guía para la selección de modelos de Code Completion (FIM) : La comunidad discutió los factores clave para elegir modelos de Code Completion (FIM). La velocidad se considera una prioridad absoluta, sugiriendo modelos con pocos parámetros que solo usen GPU (objetivo >70 t/s). Además, los modelos “base” y los modelos de instrucción se desempeñan de manera similar en tareas FIM. La discusión también enumeró modelos FIM recientes y ligeramente más antiguos como Qwen3-Coder y KwaiCoder, y exploró cómo herramientas como nvim.llm pueden soportar modelos no específicos de código. (Fuente: Reddit r/LocalLLaMA)

Compensaciones de rendimiento en modelos cuantificados: Grandes modelos y baja precisión : La comunidad discutió las compensaciones de rendimiento entre modelos grandes cuantificados y modelos pequeños no cuantificados, así como el impacto del nivel de cuantificación en el rendimiento del modelo. Generalmente se cree que la cuantificación de 2 bits puede ser adecuada para escribir o conversar, pero para tareas como la codificación, se requiere al menos el nivel Q5. Algunos usuarios señalaron que el rendimiento de Gemma3-27B disminuye significativamente con baja cuantificación, mientras que algunos modelos nuevos se entrenan con precisión FP4, sin necesidad de mayor precisión. Esto indica que el efecto de la cuantificación varía según el modelo y la tarea, y requiere pruebas específicas. (Fuente: Reddit r/LocalLLaMA)

Razones por las que MissForest de R falla en tareas de predicción : Un artículo de análisis explora las razones por las que el algoritmo MissForest de R falla en tareas de predicción, señalando que al imputar, rompe silenciosamente el principio clave de separación entre el conjunto de entrenamiento y el de prueba. El artículo explica las limitaciones de MissForest en tales situaciones e introduce nuevos métodos como MissForestPredict que resuelven este problema manteniendo la consistencia entre el aprendizaje y la aplicación. Esto tiene una importante guía para los practicantes de Machine Learning al tratar con valores perdidos y construir modelos predictivos. (Fuente: Reddit r/MachineLearning)

Búsqueda de recursos de Machine Learning multimodal : Los usuarios de la comunidad buscan recursos de aprendizaje de Machine Learning multimodal, especialmente materiales teóricos y prácticos sobre cómo combinar diferentes tipos de datos (texto, imágenes, señales, etc.) y comprender conceptos como la fusión, la alineación y la atención intermodal. Esto refleja una creciente demanda de aprendizaje de tecnologías de AI multimodal. (Fuente: Reddit r/deeplearning)

Búsqueda de recursos de video sobre entrenamiento de modelos de inferencia con Reinforcement Learning : La comunidad de Machine Learning busca los mejores recursos de video de charlas científicas sobre el uso de Reinforcement Learning (RL) para entrenar modelos de inferencia, incluyendo videos introductorios y explicaciones detalladas de métodos específicos. Los usuarios desean obtener contenido académico de alta calidad, en lugar de videos superficiales de influencers, para comprender rápidamente la literatura relevante y decidir futuras direcciones de investigación. (Fuente: Reddit r/MachineLearning)

Viaje de 11 meses de codificación con AI: Herramientas, pila tecnológica y mejores prácticas : Un desarrollador compartió un viaje de 11 meses de codificación con AI, detallando experiencias, fracasos y mejores prácticas utilizando herramientas como Claude Code. Enfatizó que en la codificación con AI, la planificación inicial y la gestión del contexto son mucho más importantes que la escritura del código en sí. Aunque la AI reduce la barrera para implementar código, no reemplaza el diseño arquitectónico y la visión de negocio. Esta experiencia compartida cubre múltiples proyectos, desde frontend hasta backend y desarrollo de aplicaciones móviles, y recomienda herramientas auxiliares como Context7 y SpecDrafter. (Fuente: Reddit r/ClaudeAI)

💼 Negocios

JPMorgan Chase: 2 mil millones de dólares invertidos anualmente para transformarse en un “banco totalmente AI” : Jamie Dimon, CEO de JPMorgan Chase, anunció una inversión anual de 2 mil millones de dólares en AI, con el objetivo de transformar la compañía en un “banco totalmente AI”. La AI se ha integrado profundamente en operaciones centrales como la gestión de riesgos, transacciones, servicio al cliente, cumplimiento y banca de inversión, no solo ahorrando costos, sino, lo que es más importante, acelerando el ritmo de trabajo y cambiando la naturaleza de los puestos. JPMorgan Chase, a través de su plataforma LLM Suite de desarrollo propio y el despliegue a gran escala de AI Agents, considera la AI como el sistema operativo subyacente de la empresa, y enfatiza que la integración de datos y la ciberseguridad son los mayores desafíos de su estrategia de AI. Dimon cree que la AI es un valor real a largo plazo, no una burbuja a corto plazo, y que redefinirá la banca. (Fuente: 36氪)

Apple desde Musk (El texto original termina aquí abruptamente, indicando una frase o idea incompleta.)