Palabras clave:OpenAI Sora, Generación de vídeo con IA, Modelo Recursivo Minúsculo (TRM), Juguetes de IA, Chips de IA, Recreación de vídeo Sora 2, Eficiencia de inferencia TRM, Crecimiento del mercado de juguetes de IA, Colaboración de chips entre AMD y OpenAI, Controversias de derechos de autor de contenido generado por IA

Aquí tienes la traducción de la información de AI a español, manteniendo los requisitos solicitados:

🔥 Enfoque

El auge y los desafíos de la aplicación OpenAI Sora : La aplicación de generación de video con AI Sora, lanzada por OpenAI, se ha vuelto rápidamente popular, alcanzando la cima de la App Store. Su capacidad gratuita e ilimitada de generación de video ha suscitado amplias preocupaciones sobre los costos operativos, la infracción de derechos de autor (especialmente el uso de IP existentes y la imagen de celebridades fallecidas) y el abuso de la tecnología deepfake. Sam Altman ha reconocido la necesidad de considerar un modelo de negocio y planea ofrecer un control de derechos de autor más refinado. El impacto de esta aplicación en el ecosistema de creación de contenido y la percepción de la realidad ha provocado un debate sobre si el video generado por AI superará al video “real”. (Fuente: MIT Technology Review, rowancheung, fabianstelzer, nptacek, paul_cal, BlackHC)

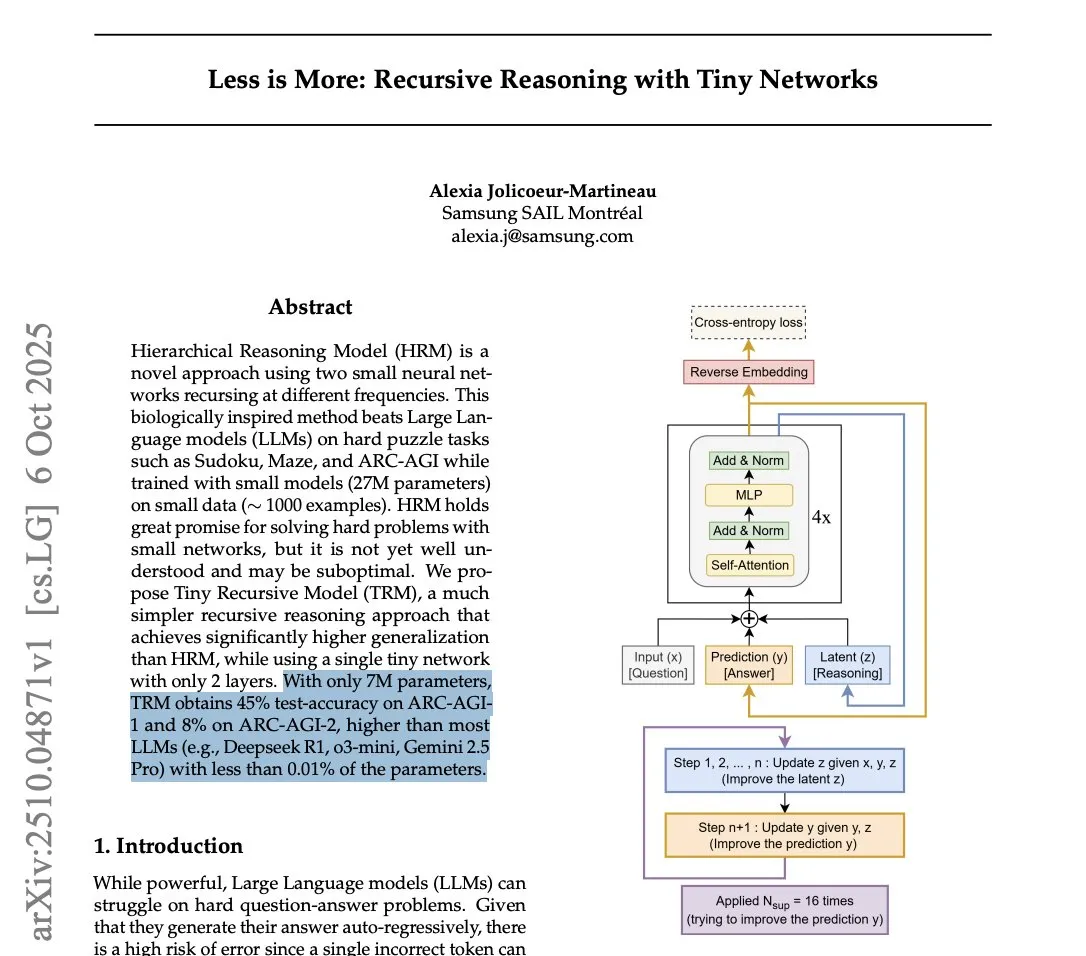

Samsung lanza Tiny Recursive Model (TRM) para desafiar la eficiencia de inferencia de los LLM : Samsung ha lanzado el Tiny Recursive Model (TRM), una pequeña red neuronal de solo 7 millones de parámetros, que ha demostrado un rendimiento excepcional en el benchmark ARC-AGI, superando incluso a grandes LLM como DeepSeek-R1 y Gemini 2.5 Pro. TRM emplea un método de inferencia recursiva, optimizando las respuestas a través de múltiples “reflexiones” internas y autocríticas. Este avance ha provocado un debate sobre si los “modelos pequeños pueden ser más inteligentes” y presagia que, en las tareas de inferencia, la innovación arquitectónica podría ser más importante que el mero tamaño del modelo, lo que promete reducir significativamente los costos computacionales de la inferencia SOTA. (Fuente: HuggingFace Daily Papers, fchollet, cloneofsimo, ecsquendor, clefourrier, AymericRoucher, ClementDelangue, Dorialexander)

Yao Shunyu de Tsinghua se traslada de Anthropic a Google DeepMind, citando diferencias de valores como la razón principal : Yao Shunyu, becario de honor del Departamento de Física de la Universidad de Tsinghua, ha anunciado su salida de Anthropic para unirse a Google DeepMind como científico de investigación senior. Señaló que el 40% de las razones de su partida se deben a “diferencias fundamentales de valores” con Anthropic, considerando que la empresa no es amigable con los investigadores chinos y los empleados con posturas neutrales. Yao Shunyu trabajó en Anthropic durante un año, participando en la construcción de la teoría de aprendizaje por refuerzo detrás de Claude 3.7 Sonnet y la serie Claude 4. Afirmó que el campo de la AI está evolucionando a una velocidad asombrosa, pero que ahora es el momento de mirar hacia adelante. (Fuente: ZhihuFrontier, 量子位)

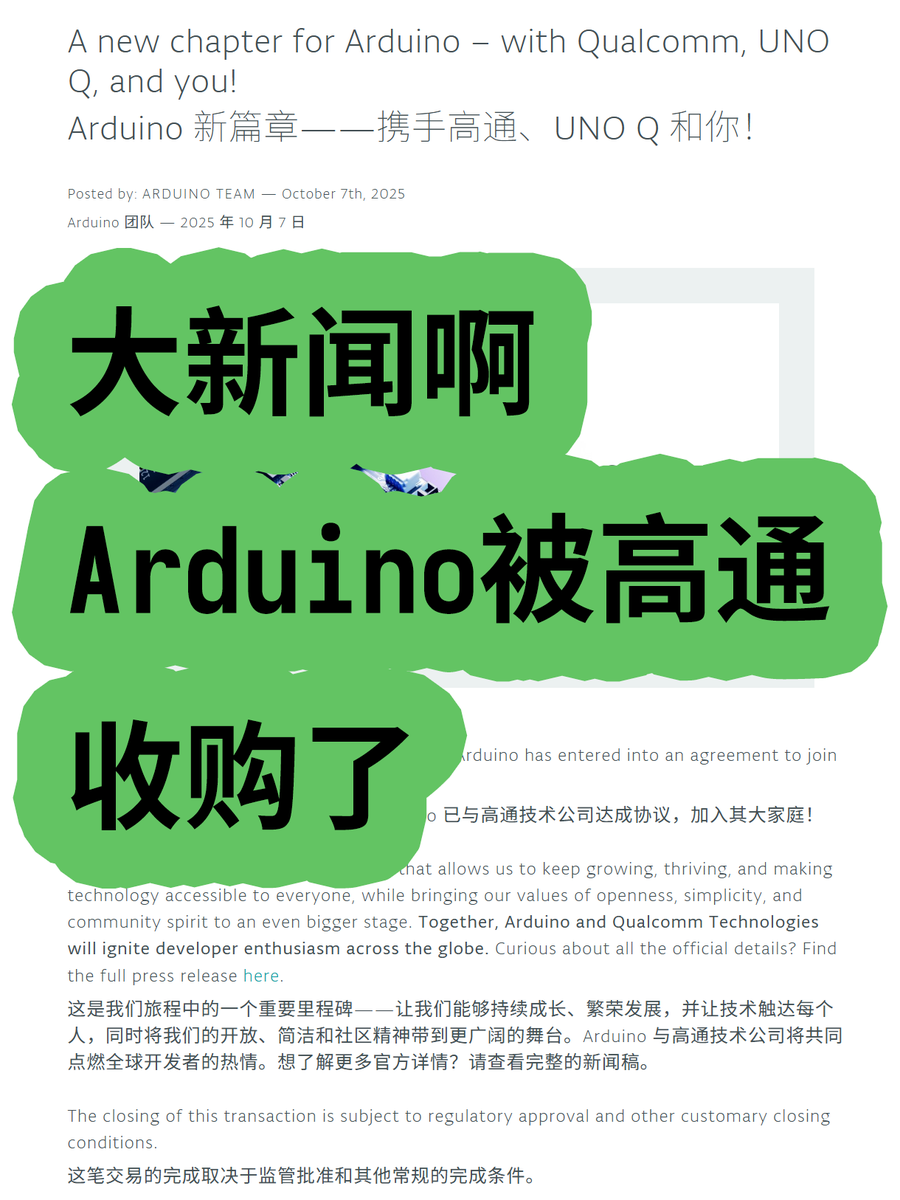

Arduino es adquirida por Qualcomm, lo que presagia una nueva dirección para la IA embebida : Arduino ha sido adquirida por Qualcomm y ha lanzado su primera placa de desarrollo colaborativa, la UNO Q, equipada con el procesador Qualcomm Dragonwing QRB2210, que integra soluciones de AI. Esto marca la evolución de Arduino desde el campo tradicional de los microcontroladores de baja potencia hacia la computación de borde con potencia media y capacidades de AI integradas. Esta medida podría impulsar la aplicación generalizada de la AI en el IoT y dispositivos embebidos, proporcionando a los desarrolladores una mayor capacidad de cómputo de AI y presagiando una nueva transformación en el ecosistema de hardware de AI embebida. (Fuente: karminski3)

Meta Superintelligence lanza REFRAG: un nuevo avance en la eficiencia de RAG : Meta Superintelligence ha publicado su primer artículo, REFRAG, que propone un nuevo método RAG (Retrieval-Augmented Generation) diseñado para mejorar significativamente la eficiencia. Este método convierte la mayoría de los bloques de documentos recuperados en “incrustaciones de bloques” compactas y amigables para LLM, que son consumidas directamente por el LLM, y utiliza una estrategia ligera para expandir selectivamente algunas incrustaciones de bloques a tokens completos según sea necesario y dentro del presupuesto. Esto reduce significativamente los costos de KV cache y atención, acelera la latencia del primer byte y el rendimiento, manteniendo la precisión, abriendo nuevas vías para las aplicaciones RAG en tiempo real. (Fuente: Reddit r/deeplearning, Reddit r/LocalLLaMA)

🎯 Tendencias

xAI cierra una ronda de financiación de 20 mil millones de dólares, con una inversión de 2 mil millones de dólares de Nvidia : xAI, la compañía de Elon Musk, ha completado con éxito una ronda de financiación de 20 mil millones de dólares, que incluye una inversión directa de 2 mil millones de dólares de Nvidia. Estos fondos se utilizarán, a través de un vehículo de propósito especial (SPV), para adquirir GPU de Nvidia, apoyando la construcción de su centro de datos Memphis Colossus 2. Esta estructura de financiación es única y tiene como objetivo garantizar el hardware para la expansión a gran escala de xAI en el campo de la computación de AI, intensificando aún más la competencia en el mercado de chips de AI. (Fuente: scaling01)

El auge de los juguetes con IA en los mercados chino y estadounidense : Los juguetes con AI equipados con chatbots y asistentes de voz se han convertido en una nueva tendencia, con un rápido crecimiento en el mercado chino y una expansión a mercados internacionales como Estados Unidos. Productos de compañías como BubblePal y FoloToy buscan reducir la dependencia de los niños de las pantallas. Sin embargo, los padres informan que las funciones de AI a veces son inestables, con respuestas largas o reconocimiento de voz lento, lo que lleva a una disminución del interés de los niños. Compañías estadounidenses como Mattel también están colaborando con OpenAI para desarrollar juguetes con AI. (Fuente: MIT Technology Review)

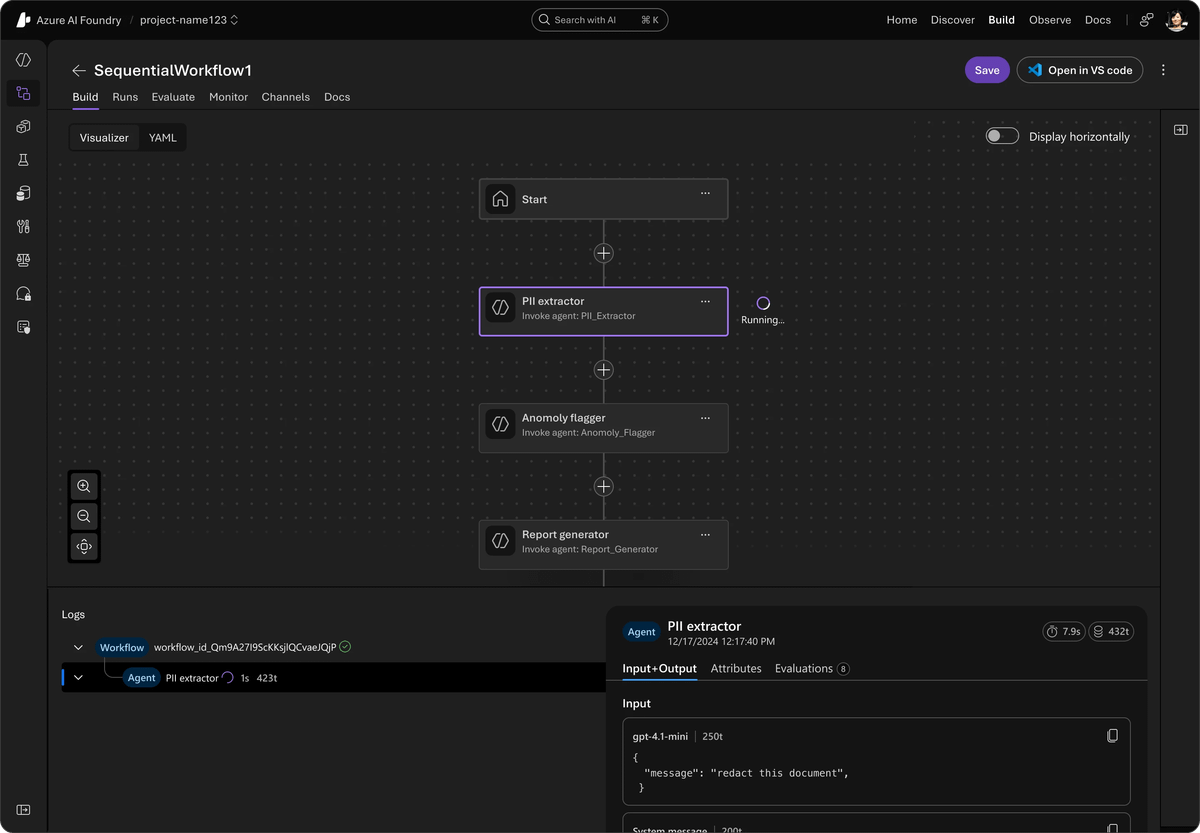

Microsoft lanza un marco Agent unificado de código abierto, integrando AutoGen y Semantic Kernel : Microsoft ha lanzado el Agent Framework, un SDK unificado de código abierto diseñado para integrar AutoGen y Semantic Kernel, con el fin de construir sistemas de AI multi-agente de nivel empresarial. Este marco, respaldado por Azure AI Foundry, simplifica la orquestación y la observabilidad, y es compatible con varias API. Introduce una vista previa privada de flujos de trabajo multi-agente, el seguimiento entre marcos de OpenTelemetry, capacidades de agente de voz en tiempo real con Voice Live API, y herramientas de AI responsable, con el objetivo de mejorar la seguridad y eficiencia de los sistemas de agentes. (Fuente: TheTuringPost)

AI21 Labs lanza Jamba 3B, un modelo pequeño que supera a la competencia en rendimiento : AI21 Labs ha lanzado Jamba 3B, un modelo MoE de solo 3 mil millones de parámetros, que destaca tanto en calidad como en velocidad, especialmente en el procesamiento de contextos largos. Este modelo mantiene una velocidad de generación de aproximadamente 40 t/s en Mac incluso con más de 32K de contexto, superando con creces a Qwen 3 4B y Llama 3.2 3B. Jamba 3B supera a Gemma 3 4B y Phi-4 Mini en el índice de inteligencia, y su capacidad de inferencia se mantiene intacta con 256K de contexto, demostrando el enorme potencial de los modelos pequeños en la AI de borde y el despliegue en dispositivos. (Fuente: Reddit r/LocalLLaMA)

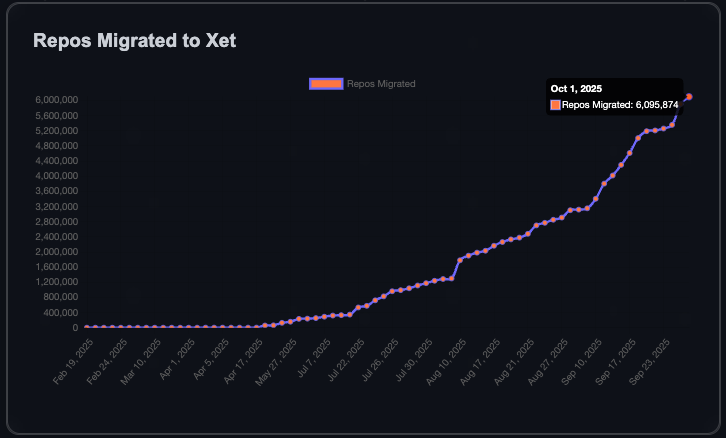

La comunidad de HuggingFace crece rápidamente, añadiendo un millón de repositorios en 90 días : La comunidad de HuggingFace ha añadido un millón de repositorios de modelos, datasets y Spaces en los últimos 90 días; el primer millón de repositorios tardó seis años en alcanzarse, lo que significa que se crea un nuevo repositorio cada 8 segundos. Este crecimiento se debe a la transferencia de datos más eficiente lograda con la tecnología Xet, y al hecho de que el 40% de los repositorios privados indican una tendencia de uso interno de HuggingFace por parte de las empresas para compartir modelos y datos. El objetivo de la comunidad es alcanzar los 10 millones de repositorios, lo que presagia un floreciente ecosistema de AI de código abierto. (Fuente: Teknium1, reach_vb)

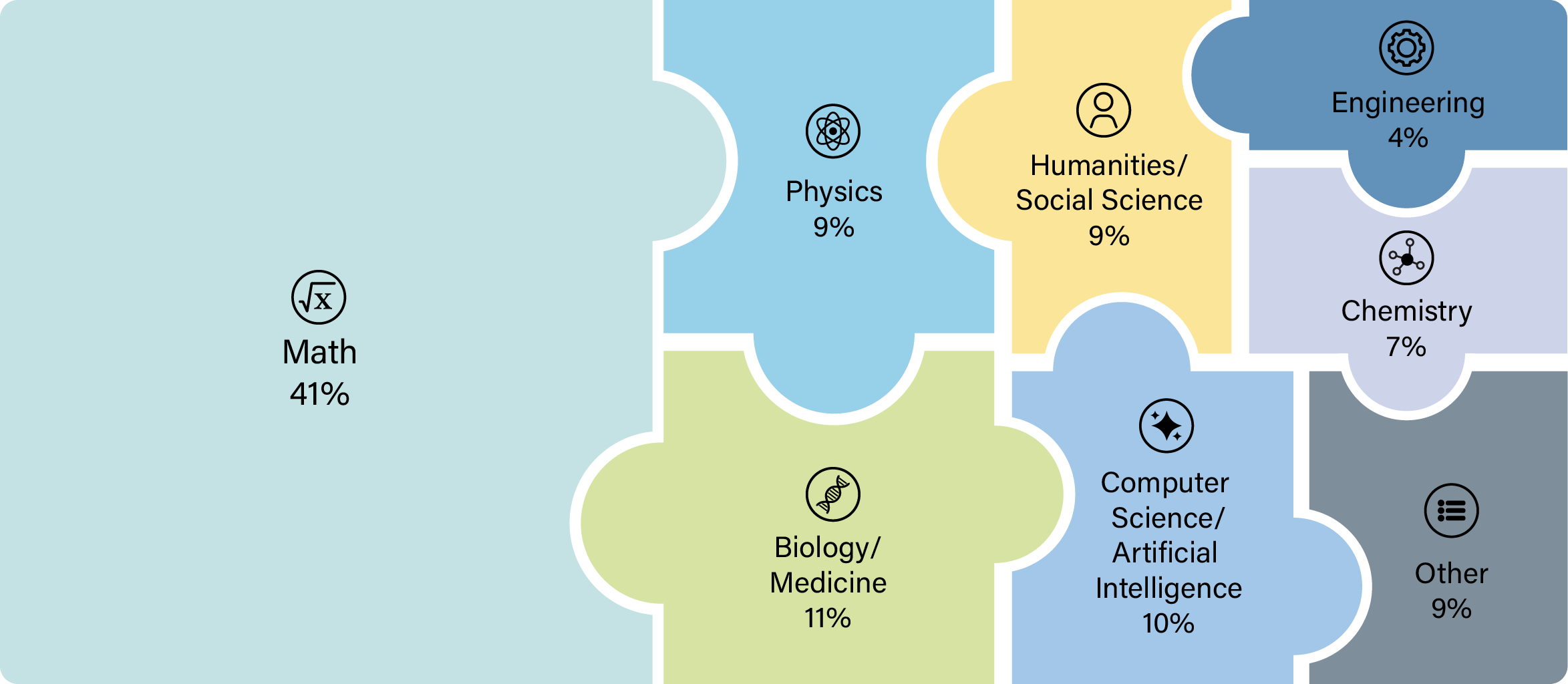

OpenAI GPT-5 demuestra capacidades innovadoras en la investigación científica : El modelo GPT-5 de OpenAI ha cruzado un umbral importante; los científicos lo han utilizado con éxito para realizar investigaciones originales en campos como las matemáticas, la física, la biología y la informática. Este avance indica que GPT-5 no solo puede responder preguntas, sino también guiar y ejecutar exploraciones científicas complejas, acelerando enormemente el proceso de investigación. Algunos investigadores han afirmado que, tras el lanzamiento de GPT-5 Thinking y GPT-5 Pro, ya no es razonable realizar investigación científica sin consultarlos. (Fuente: tokenbender)

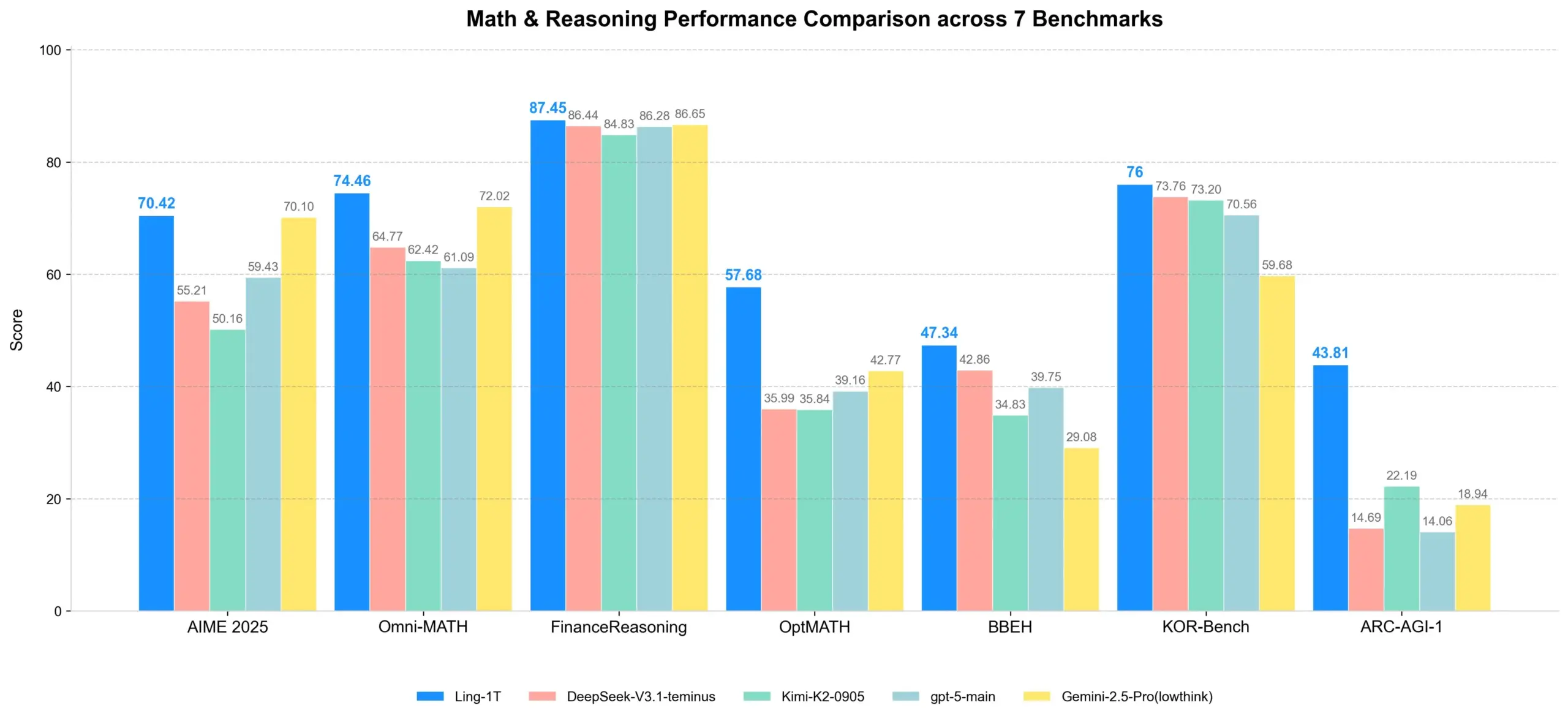

Ling-1T: Lanzamiento de un modelo de inferencia de código abierto con un billón de parámetros : Ling-1T, el modelo insignia de la serie Ling 2.0, cuenta con un billón de parámetros totales, de los cuales aproximadamente 50 mil millones de parámetros activos por token, y ha sido entrenado en más de 20 billones de tokens de inferencia intensiva. Este modelo logra una inferencia escalable a través del currículo Evo-CoT y Linguistics-Unit RL, demostrando un sólido equilibrio entre eficiencia y precisión en tareas de inferencia complejas. También posee capacidades avanzadas de comprensión visual y generación de código frontend, y puede utilizar herramientas con una tasa de éxito de aproximadamente el 70%, marcando un nuevo hito en la inteligencia de código abierto a escala de billones. (Fuente: scaling01, TheZachMueller)

Meta Ray-Ban Display redefine la interacción y el aprendizaje humano-computadora : Las gafas inteligentes Meta Ray-Ban Display integran funciones de aprendizaje y traducción en el uso diario, ofreciendo experiencias de “traducción invisible” y “aprendizaje visual instantáneo”. Los subtítulos de las conversaciones se muestran directamente en las lentes, y los usuarios pueden obtener información relevante simplemente mirando un punto de referencia o una obra de arte. Además, el control por gestos se logra a través de la Neural Band, permitiendo operar sin necesidad de un teléfono móvil. Esta tecnología promete remodelar la forma en que interactuamos, aprendemos y nos conectamos con el mundo, marcando un nuevo comienzo para la computación centrada en el ser humano. (Fuente: Ronald_vanLoon)

🧰 Herramientas

Synthesia lanza Copilot, potenciando la edición profesional de video con AI : Synthesia ha lanzado Copilot, un editor de video profesional con AI. Esta herramienta puede escribir guiones rápidamente, conectar bases de conocimiento y recomendar material visual de forma inteligente, como si se tuviera un colega que conoce a fondo el negocio y la plataforma Synthesia. Copilot tiene como objetivo simplificar el proceso de producción de video, reducir la barrera para la creación de video profesional y proporcionar soluciones de video con AI eficientes y personalizadas para empresas y creadores de contenido. (Fuente: synthesiaIO, synthesiaIO)

GLIF Agent utiliza Sora 2 para recrear y personalizar videos virales : GLIF ha desarrollado un Agent capaz de recrear cualquier video viral utilizando el modelo Sora 2. Este Agent primero analiza el video original y luego genera prompts detallados basados en los resultados del análisis. Los usuarios pueden colaborar con el Agent para personalizar los prompts, creando así videos generados por AI altamente individualizados. Esta tecnología promete ofrecer potentes capacidades de producción y recreación de video en los campos de la creación de contenido y el marketing. (Fuente: fabianstelzer)

Cloudflare AI Search y GroqInc colaboran para lanzar una plantilla de “chat de documentos” : Cloudflare AI Search (anteriormente AutoRAG) ha colaborado con GroqInc para lanzar una nueva plantilla de código abierto para “chat de documentos”. Esta plantilla combina el motor de inferencia de Groq con AI Search, lo que permite a los usuarios añadir más fácilmente funciones de AI conversacional a los documentos, logrando preguntas y respuestas e interacciones en tiempo real sobre el contenido de los documentos. Esta integración mejorará la eficiencia de la recuperación de documentos y la obtención de información. (Fuente: JonathanRoss321)

HuggingFace lanza la función de edición de GGUF en el navegador : HuggingFace ahora permite editar directamente los metadatos de los modelos GGUF dentro del navegador, sin necesidad de descargar el modelo completo. Esta función, implementada a través de la tecnología Xet, admite actualizaciones parciales de archivos, lo que simplifica enormemente la gestión de modelos y los procesos de iteración, mejorando la eficiencia de los desarrolladores en la plataforma HuggingFace. (Fuente: reach_vb)

LangChain y LangGraph lanzan la versión v1.0 Alpha, solicitando comentarios de los desarrolladores : LangChain y LangGraph han lanzado la versión v1.0 Alpha, introduciendo una nueva API de middleware Agent, bloques de salida/contenido estándar y actualizaciones importantes de la API. El equipo está invitando activamente a los desarrolladores a probar la nueva versión y proporcionar comentarios para perfeccionar aún más su marco de desarrollo de agentes de AI, impulsando la creación de aplicaciones de AI más potentes. (Fuente: LangChainAI)

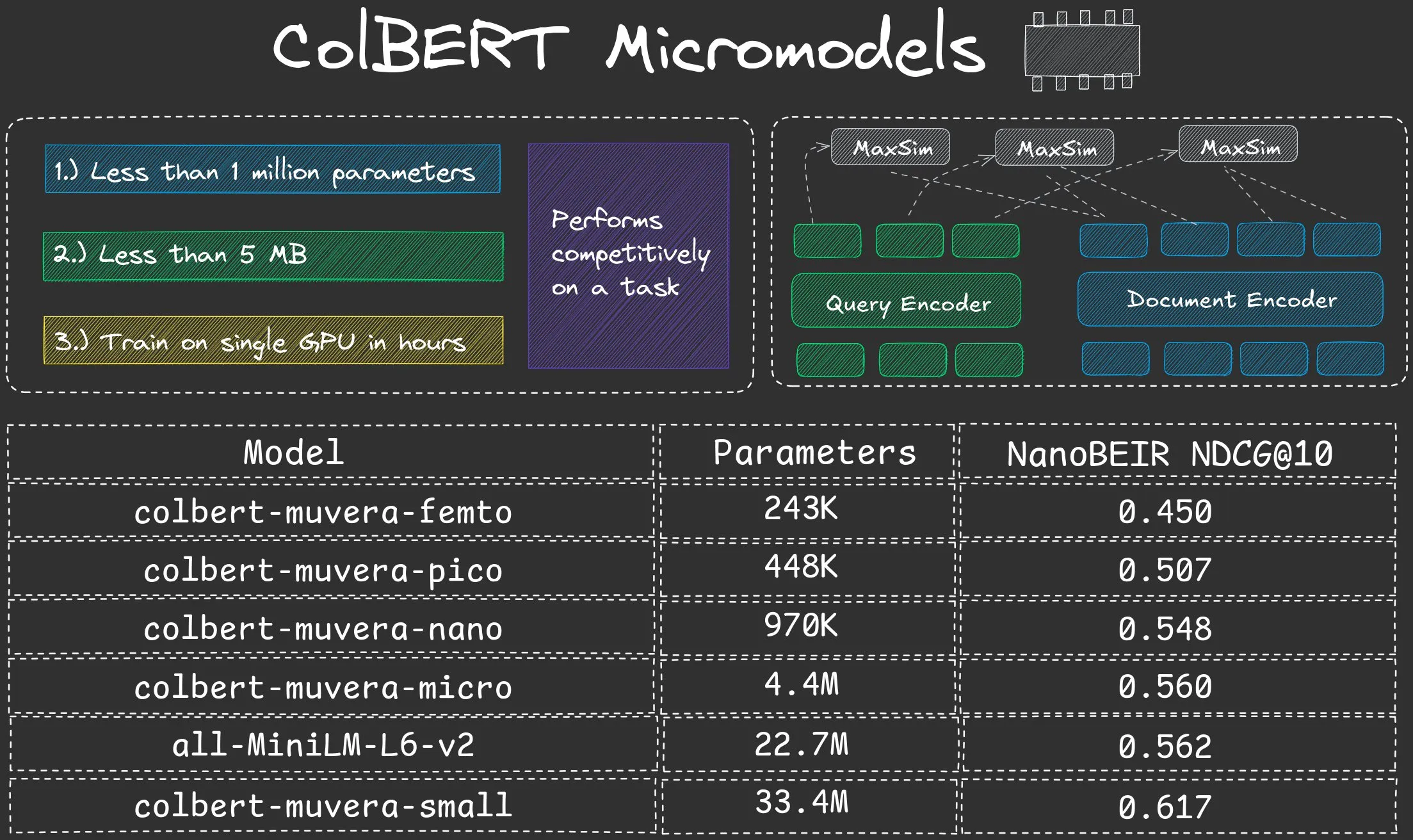

NeuML lanza la serie de micromodelos ColBERT Nano, con menos de un millón de parámetros : NeuML ha lanzado la serie de modelos ColBERT Nano, todos con menos de 1 millón de parámetros (250K, 450K, 950K). Estos micromodelos han demostrado un rendimiento sorprendente en el modo “Late interaction”, probando que incluso modelos de escala extremadamente pequeña pueden lograr buenos resultados en tareas específicas, ofreciendo soluciones eficientes para el despliegue de AI en entornos con recursos limitados. (Fuente: lateinteraction, lateinteraction)

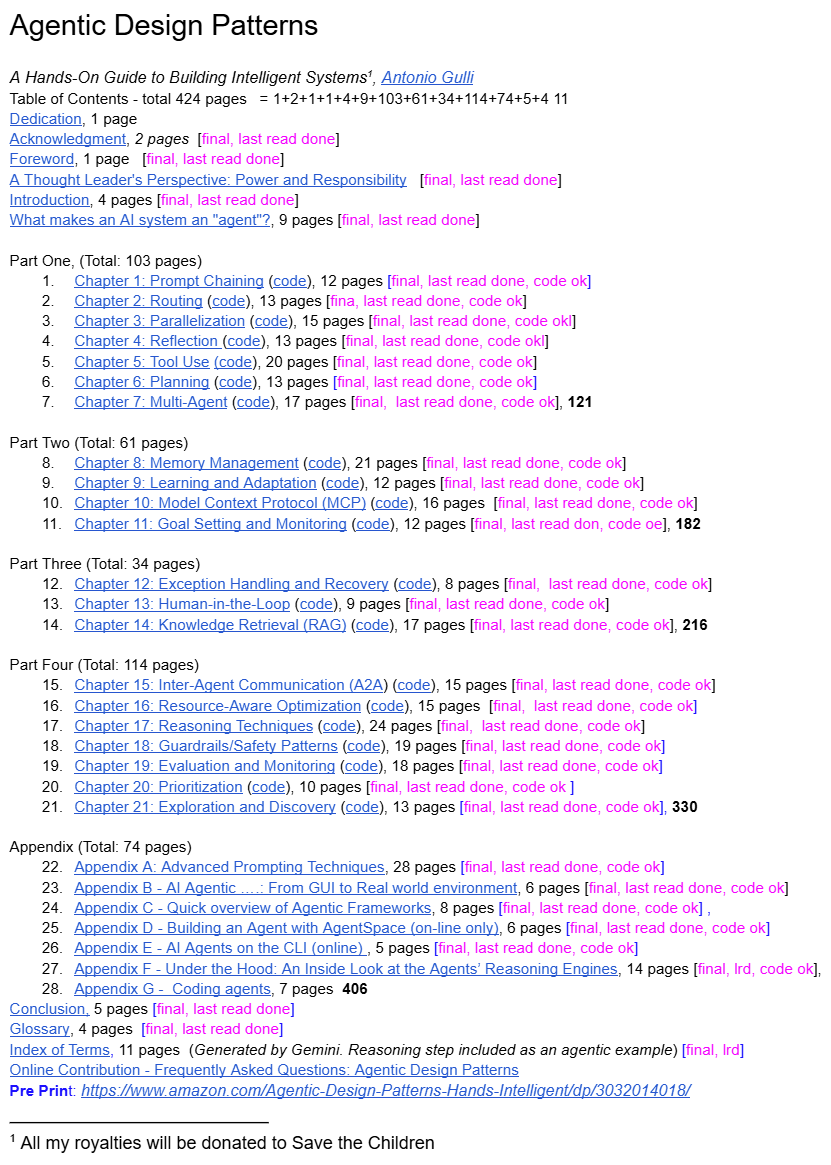

Director de ingeniería senior de Google comparte “Patrones de diseño de agentes” : Un director de ingeniería senior de Google ha compartido gratuitamente un libro, “Patrones de diseño de agentes”, que ofrece el primer conjunto sistemático de principios de diseño y mejores prácticas para el creciente campo de los AI Agents. Este recurso tiene como objetivo ayudar a los desarrolladores a comprender y construir mejor los agentes de AI, llenando un vacío en la orientación sistemática en este campo, y se espera que se convierta en una referencia importante para los desarrolladores de AI Agent. (Fuente: dotey)

📚 Aprendizaje

Investigación sobre alucinaciones de LLM y mecanismos de alineación de seguridad: del origen interno a las estrategias de mitigación : La investigación ha descubierto que los modelos de inferencia de LLM pueden experimentar un fenómeno de “acantilado de rechazo” antes de generar la salida final, es decir, una disminución drástica en la intención de rechazo. A través del marco DST, los investigadores revelaron que las alucinaciones se vuelven inevitables en una “capa de compromiso” específica del modelo, y propusieron el pequeño modelo de inferencia HalluGuard, que mitiga las alucinaciones en RAG integrando señales clínicas y optimización de datos, proporcionando explicaciones mecánicas y estrategias prácticas para la alineación de seguridad y la mitigación de alucinaciones de LLM. (Fuente: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

ASPO optimiza el aprendizaje por refuerzo de LLM, resolviendo el problema de desajuste de la relación IS : ASPO (Asymmetric Importance Sampling Policy Optimization) es un nuevo método de post-entrenamiento de LLM que aborda el defecto fundamental del desajuste de la relación de muestreo de importancia (IS) de tokens de ventaja positiva en el aprendizaje por refuerzo tradicional. Al invertir la relación IS de los tokens de ventaja positiva e introducir un mecanismo de doble recorte suave, ASPO puede actualizar los tokens de baja probabilidad de manera más estable, mitigar la convergencia prematura y mejorar significativamente el rendimiento en los benchmarks de codificación y razonamiento matemático. (Fuente: HuggingFace Daily Papers)

Fathom-DeepResearch: Un sistema de agentes para la recuperación y síntesis de información a largo plazo : Fathom-DeepResearch es un sistema de agentes compuesto por Fathom-Search-4B y Fathom-Synthesizer-4B, diseñado para tareas complejas y abiertas de recuperación de información. Fathom-Search-4B logra la búsqueda web en tiempo real y la consulta de páginas web a través de un dataset de auto-juego multi-agente y optimización por aprendizaje por refuerzo. Fathom-Synthesizer-4B, por su parte, transforma los resultados de búsquedas de múltiples rondas en informes estructurados. Este sistema ha demostrado un rendimiento excepcional en múltiples benchmarks y ha exhibido una fuerte capacidad de generalización para tareas de inferencia como HLE y AIME-25. (Fuente: HuggingFace Daily Papers)

AgentFlow: Optimización de sistemas de agentes en flujo para una planificación y uso de herramientas eficientes : AgentFlow es un marco de agente en flujo entrenable que optimiza directamente su planificador en un ciclo de interacción de múltiples rondas, coordinando cuatro módulos: planificador, ejecutor, verificador y generador. Adopta Flow-based Group Refined Policy Optimization para resolver el problema de asignación de crédito de recompensas dispersas y de largo plazo. AgentFlow, con un modelo backbone de escala 7B, supera las líneas base SOTA en diez benchmarks, con una mejora significativa en la precisión promedio en tareas de búsqueda, agente, matemáticas y ciencia, superando incluso a GPT-4o. (Fuente: HuggingFace Daily Papers)

Estudio sistemático del impacto de los datos de código en la capacidad de inferencia de los LLM : La investigación explora cómo los datos de código mejoran la capacidad de inferencia de los LLM a través de un marco sistemático y centrado en datos. Al construir un dataset de instrucciones paralelas en diez lenguajes de programación y aplicar perturbaciones estructurales o semánticas, se encontró que los LLM son más sensibles a las perturbaciones estructurales que a las semánticas, especialmente en tareas de matemáticas y código. El pseudocódigo y los diagramas de flujo son tan efectivos como el código, y el estilo sintáctico también influye en las ganancias específicas de la tarea (Python beneficia el razonamiento en lenguaje natural, Java/Rust benefician las matemáticas). (Fuente: HuggingFace Daily Papers)

DeepEvolve: Un agente para el descubrimiento de algoritmos científicos que fusiona la investigación profunda y la evolución algorítmica : DeepEvolve es un agente que combina la investigación profunda con la evolución algorítmica, descubriendo algoritmos científicos en un ciclo iterativo impulsado por la retroalimentación a través de la recuperación de conocimiento externo, la edición de código entre archivos y la depuración del sistema. No solo propone nuevas hipótesis, sino que también las refina, implementa y prueba, evitando mejoras superficiales y refinamientos excesivos ineficaces. En nueve benchmarks que abarcan química, matemáticas, biología, materiales y patentes, DeepEvolve mejora continuamente los algoritmos iniciales, generando nuevos algoritmos ejecutables y obteniendo beneficios sostenidos. (Fuente: HuggingFace Daily Papers)

Hoja de ruta de aprendizaje y conceptos clave de AI/ML : La comunidad ha compartido una ruta de aprendizaje integral para AI, Machine Learning y Deep Learning, que abarca desde conceptos básicos hasta técnicas avanzadas (como Agentic AI, parámetros de generación de LLM). Estos recursos están diseñados para proporcionar una guía de aprendizaje estructurada a los profesionales que desean ingresar o profundizar sus conocimientos en el campo de AI/ML, ayudándoles a dominar las habilidades de todo el proceso, desde el desarrollo del modelo hasta el despliegue y la operación, y a comprender cómo la AI impulsa la transformación de la industria. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Benchmarks y recursos de aprendizaje de AI: HLE, conferencias y gestión de costos de GPU : La comunidad ha discutido varios recursos de aprendizaje y práctica de AI. CAIS ha lanzado el benchmark “Humanity’s Last Exam”, que se actualiza dinámicamente para adaptarse a la mejora del rendimiento de los modelos. Al mismo tiempo, se han proporcionado guías para asistir a conferencias de Machine Learning y estrategias de desarrollo de LLM de bajo costo, incluyendo GPU de pago por uso y la ejecución de modelos pequeños localmente. Además, la celebración del GPU Mode Hackathon ha proporcionado una plataforma para que los desarrolladores aprendan e interactúen. (Fuente: clefourrier, Reddit r/MachineLearning, Reddit r/MachineLearning, Reddit r/MachineLearning, danielhanchen)

OneFlow: Modelos de generación de modalidad mixta concurrente e intercalada : OneFlow es el primer modelo multimodal no autorregresivo que admite la generación de modalidad mixta de longitud variable y concurrente. Combina flujos de edición insertables para tokens de texto discretos con el emparejamiento de flujos en el espacio latente de la imagen. OneFlow logra la síntesis concurrente de texto-imagen a través de un muestreo jerárquico, priorizando el contenido sobre la gramática. Los experimentos demuestran que OneFlow supera a las líneas base autorregresivas en tareas de generación y comprensión, reduce los FLOPs de entrenamiento hasta en un 50% y desbloquea nuevas capacidades de generación concurrente, refinamiento iterativo y generación de estilo de inferencia natural. (Fuente: HuggingFace Daily Papers)

Equilibrium Matching: Un marco de modelado generativo basado en modelos de energía implícita : Equilibrium Matching (EqM) es un nuevo marco de modelado generativo que abandona las dinámicas no equilibradas y temporalmente condicionadas de los modelos de difusión y flujo tradicionales, para aprender en su lugar los gradientes de equilibrio de un paisaje energético implícito. EqM emplea un proceso de muestreo basado en optimización, muestreando en el paisaje aprendido a través del descenso de gradiente, logrando un rendimiento SOTA de ImageNet 256×256 FID 1.90 y manejando naturalmente tareas como la eliminación parcial de ruido, la detección OOD y la síntesis de imágenes. (Fuente: HuggingFace Daily Papers)

💼 Negocios

OpenAI y AMD alcanzan un acuerdo de colaboración en chips, desafiando el dominio de Nvidia : OpenAI y AMD han firmado un acuerdo de colaboración en chips de cinco años y miles de millones de dólares, con el objetivo de desafiar el dominio de Nvidia en el mercado de chips de AI. Esta medida forma parte de la estrategia de OpenAI para diversificar su suministro de chips; la compañía también había llegado a un acuerdo con Nvidia anteriormente. Este acuerdo subraya la enorme demanda de hardware de computación de alto rendimiento en la industria de la AI, así como la búsqueda de la diversidad en la cadena de suministro. (Fuente: MIT Technology Review)

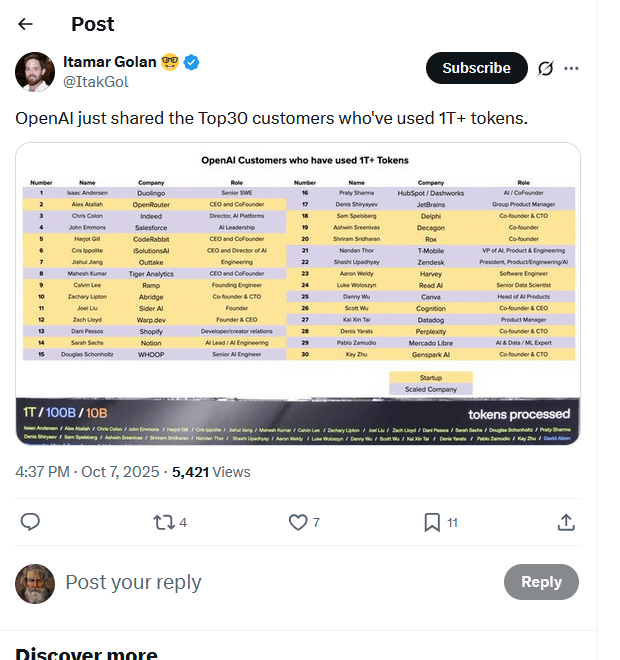

Se filtra la lista de los principales clientes de OpenAI: 30 empresas consumen billones de Tokens : Una lista, supuestamente de los principales clientes de OpenAI, ha circulado en línea, mostrando que 30 empresas han procesado más de un billón de Tokens a través de sus modelos. Esta lista (que incluye a Duolingo, OpenRouter, Salesforce, Canva, Perplexity, entre otros) revela la rápida formación de una economía de inferencia de AI y muestra cuatro tipos principales: constructores nativos de AI, integradores de AI, proveedores de infraestructura de AI y proveedores de soluciones de AI verticales. El consumo de Tokens se considera un nuevo benchmark para medir el valor real y el progreso comercial de las aplicaciones de AI. (Fuente: Reddit r/ArtificialInteligence, 量子位)

Singapur se convierte en un puerto seguro de derechos de autor para el desarrollo de IA, atrayendo a empresas globales de IA : Singapur ha modificado su Ley de Derechos de Autor, introduciendo una cláusula de defensa de análisis computacional que estipula explícitamente que el análisis de datos computacionales realizado para mejorar los sistemas de AI está protegido por una exención de infracción de derechos de autor, e incluso impide la cobertura contractual. Esta medida tiene como objetivo convertir a Singapur en el lugar más atractivo del mundo para el desarrollo de modelos de AI, atrayendo inversiones e innovación, en marcado contraste con la actitud cautelosa de regiones como Europa y América hacia los derechos de autor de la AI. Aunque el alcance de la protección se limita al territorio de Singapur, proporciona una garantía importante para el desarrollo de modelos fundamentales. (Fuente: Reddit r/ArtificialInteligence)

🌟 Comunidad

Transacciones de financiación en la industria de la IA y preocupaciones sobre la burbuja : Han surgido dudas en las redes sociales sobre las transacciones de financiación en la industria de la AI, con la opinión de que muchas de ellas suenan más a intentos de inflar artificialmente los precios de las acciones que a un valor real. Algunos comentarios señalan que muchos productos de AI no han mostrado efectos de aplicación reales en los mercados locales o regionales, y las empresas, por el contrario, se quejan de que los productos de AI son ineficaces. Este fenómeno se interpreta como especulación de mercado más que como una formación de capital y efectos de derrame reales. Al mismo tiempo, también existe un debate sobre la aplicación de los gemelos digitales de AI en el campo del marketing: “¿exageración o futuro?” (Fuente: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Censura de contenido de ChatGPT y controversias sobre la experiencia del usuario : Los usuarios de ChatGPT se quejan de que la censura de contenido de la plataforma es demasiado estricta, llegando a marcar solicitudes de recetas simples o abrazos entre personajes como “contenido sexualmente sugerente”, mientras que no es sensible al contenido violento. Los usuarios creen que ChatGPT se ha vuelto “basura” y “sobreprotector”, cuestionando si OpenAI ha perdido a sus empleados talentosos. Al mismo tiempo, los usuarios también han informado problemas con la renderización de LaTeX en la aplicación ChatGPT. Esto ha llevado a algunos usuarios a cancelar sus suscripciones, pidiendo a OpenAI que deje de sofocar la creatividad. (Fuente: Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, jeremyphoward)

El efecto bumerán del contenido de IA y las preocupaciones de los creadores : A medida que el contenido generado por AI se vuelve cada vez más popular, ha surgido un fuerte sentimiento anti-AI en la sociedad, especialmente en los campos del arte y la creatividad. Creadores conocidos como el YouTuber MrBeast han expresado su preocupación de que los videos de AI puedan amenazar el sustento creativo de millones de personas. Los fans de Taylor Swift también criticaron su video promocional generado por AI como “barato y tosco”. Este efecto bumerán refleja la ansiedad de los creadores sobre el impacto de la tecnología AI en las industrias tradicionales, así como la preocupación por la calidad y la autenticidad del contenido. (Fuente: Reddit r/artificial, MIT Technology Review)

Dilemas y perspectivas de la aplicación de la IA en el sector de los videojuegos : La comunidad ha discutido las características poderosas, creativas, interesantes y dinámicas de la tecnología AI, pero cuestiona por qué hasta ahora ningún juego popular ha utilizado ampliamente la AI. Algunos creen que la AI ya se usa ampliamente en el desarrollo, pero que ejecutar modelos de AI localmente es costoso, y los desarrolladores de juegos tienden a controlar la narrativa. Otros opinan que los desarrolladores solo se centran en los grandes títulos tradicionales, ignorando las nuevas ideas creativas. Esto refleja los desafíos técnicos, de costos y creativos que enfrenta la implementación de la AI en el sector de los videojuegos. (Fuente: Reddit r/artificial)

Perplexity destaca la utilidad de la búsqueda con IA gracias al caso de uso de Cristiano Ronaldo : La superestrella del fútbol Cristiano Ronaldo utilizó la herramienta de búsqueda de AI Perplexity mientras preparaba su discurso para el Prestige Globe Award. Afirmó que Perplexity le ayudó a comprender el significado del premio y a superar el nerviosismo. Este incidente fue ampliamente difundido por Perplexity oficial y las redes sociales, destacando el valor práctico de la búsqueda con AI para proporcionar información rápida y precisa, así como su potencial de promoción bajo el efecto de las celebridades. (Fuente: AravSrinivas, AravSrinivas)

Investigación de IA de Google galardonada con el Premio Nobel y controversias relacionadas : Google ha recibido tres Premios Nobel en dos años, incluyendo a Demis Hassabis (AlphaFold) y Geoff Hinton (AI). Este logro se considera una manifestación de la inversión a largo plazo y la ambición de Google en investigación. Sin embargo, Jürgen Schmidhuber ha cuestionado la existencia de plagio en el Premio Nobel de Física de 2024, argumentando que sus resultados se superponen en gran medida con investigaciones anteriores y no fueron citados adecuadamente, lo que ha provocado un debate sobre la ética académica y la atribución en el campo de la AI. (Fuente: Yuchenj_UW, SchmidhuberAI, SchmidhuberAI)

Debate filosófico sobre la demanda de cómputo de IA y la ruta hacia la AGI/ASI : Respecto a la gran cantidad de recursos computacionales necesarios para la generación de video con AI, algunos argumentan que esta enorme inversión computacional, basada en necesidades reales, indica más bien que la Inteligencia Artificial General (AGI) y la Superinteligencia Artificial (ASI) siguen siendo fantasías lejanas. Esta discusión refleja la reflexión de la industria sobre la trayectoria de desarrollo de la AI, es decir, si el éxito actual de la AI en aplicaciones específicas desviará recursos y retrasará la consecución de objetivos más ambiciosos. Al mismo tiempo, Richard Sutton enfatiza que la esencia del aprendizaje es el comportamiento activo del agente, no el entrenamiento pasivo. (Fuente: fabianstelzer, Plinz, dwarkesh_sp)

Impacto de la IA en el mercado laboral: Disminución del salario por hora para anotadores de datos con doctorado : Las discusiones en redes sociales señalan que, debido a la sobreoferta de anotadores de datos con doctorado, su salario por hora ha disminuido de 100 USD/hora a 50 USD/hora. Anteriormente, OpenAI había contratado a doctores para la anotación de datos a 100 USD/hora. Este fenómeno refleja la intensificación de la competencia en el mercado de anotación de datos de AI, así como los cambios en la demanda de talento para la anotación de datos de alta calidad. (Fuente: teortaxesTex)

Herramientas de IA para ingenieros de software obtienen financiación y su impacto en la profesión : Relace, una startup centrada en proporcionar herramientas para ingenieros de software impulsados por AI, ha obtenido 23 millones de dólares en una ronda de financiación Serie A liderada por Andreessen Horowitz. Esto marca la extensión de la cadena de herramientas de AI hacia áreas más profundas de desarrollo autónomo de AI. Al mismo tiempo, los ingenieros han discutido cómo las herramientas de codificación de AI están cambiando su forma de trabajar, argumentando que, aunque son expertos en el uso de herramientas de AI, la creatividad humana y la capacidad de resolución de problemas siguen siendo valores fundamentales. (Fuente: steph_palazzolo, kylebrussell)

El auge y la caída del fenómeno cultural “Vibe Coding” : Las redes sociales han discutido el auge y la caída del concepto de “Vibe Coding”. Algunos creen que Vibe Coding es una forma de programar en un ambiente relajado, pero otros opinan que ha “muerto”. Las discusiones relacionadas también mencionan contenido generado por AI como “Bob Ross vibe coding”, lo que refleja la exploración y reflexión de la comunidad de desarrolladores sobre la cultura de la programación y los métodos de programación asistida por AI. (Fuente: arohan, Ronald_vanLoon, nptacek)

💡 Otros

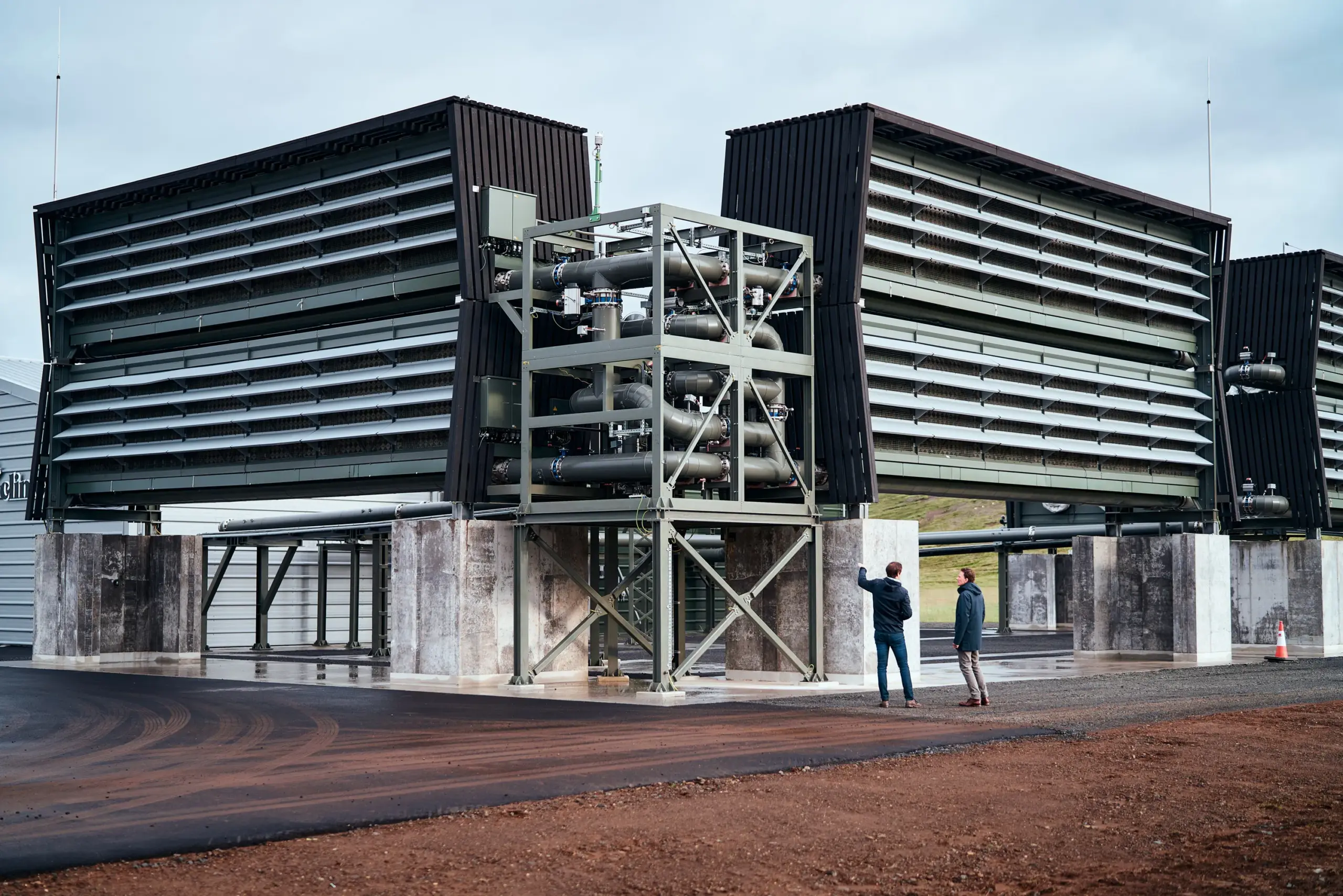

El gobierno de EE. UU. podría cancelar miles de millones de dólares en financiación para plantas de captura de carbono : El Departamento de Energía de EE. UU. podría poner fin a miles de millones de dólares en financiación para dos grandes plantas de captura directa de carbono del aire. Estos proyectos estaban originalmente programados para recibir más de mil millones de dólares en subvenciones gubernamentales, pero actualmente se enfrentan a un estado de “terminación”. Aunque el Departamento de Energía ha declarado que aún no se ha tomado una decisión final, y previamente ha cancelado más de 200 proyectos para ahorrar 7.5 mil millones de dólares, esta incertidumbre ha generado preocupación en la industria sobre el desarrollo de la tecnología climática de EE. UU. y su competitividad internacional. (Fuente: MIT Technology Review)

Nuevos avances en robótica: desde muñecas flexibles hasta escarabajos biónicos y robots humanoides : Se han logrado varios avances en el campo de la robótica. Una nueva muñeca robótica paralela ha logrado movimientos flexibles y similares a los humanos en espacios reducidos, mejorando la precisión operativa. Al mismo tiempo, los investigadores están desarrollando escarabajos robóticos biónicos con mochilas, destinados a la búsqueda y rescate en desastres. Además, se ha informado de la interacción de robots humanoides con motocicletas, lo que demuestra la capacidad de la tecnología biónica para simular el comportamiento humano. Estos avances impulsan conjuntamente los límites de la robótica en la adaptabilidad a entornos complejos y la interacción humano-robot. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)