Palabras clave:IA cuántica, GPT-5, Gemini 2.5, Imagine v0.9, Sora 2, Agente de IA, Computadora cuántica, Premio Nobel de IA cuántica de Google, Aplicaciones científicas de GPT-5, Uso informático de Gemini 2.5, Generación de videos con xAI Imagine, Versión preliminar de OpenAI Sora 2

🔥 Enfoque

Científico de Google Quantum AI gana el Premio Nobel de Física: Michel Devoret, científico principal de Google Quantum AI, y los miembros de su equipo John Martinis y John Clarke, han sido galardonados con el Premio Nobel de Física 2025 por su trabajo pionero en el campo de la mecánica cuántica. Su investigación allana el camino para las computadoras cuánticas con corrección de errores, lo que subraya el compromiso a largo plazo y la posición de liderazgo de Google en el campo de la IA cuántica, y representa un hito importante en este ámbito. (Fuente: Google, demishassabis, Yuchenj_UW)

GPT-5 muestra un potencial innovador en la investigación científica: Kevin Weil ha declarado que GPT-5 ha cruzado un umbral significativo, y los científicos han logrado guiar a GPT-5 para realizar investigación novedosa en campos como las matemáticas, la física, la biología y la informática. Aunque todavía se encuentra en la fase de “lema”, su capacidad para realizar trabajo científico original limitado bajo la guía de expertos es alentadora y presagia el inmenso potencial de la IA para acelerar el descubrimiento científico. (Fuente: SebastienBubeck, ericmitchellai, BorisMPower, lateinteraction)

🎯 Tendencias

Google lanza Gemini 2.5 Computer Use: Google DeepMind ha presentado el modelo Gemini 2.5 Computer Use, que permite a los agentes de IA interactuar directamente con páginas web y aplicaciones mediante clics, desplazamientos, entradas, etc. Este modelo demuestra un rendimiento líder en múltiples pruebas de referencia, es más rápido e incorpora mecanismos de seguridad multicapa para abordar riesgos potenciales. Esto marca un avance significativo en la capacidad de los agentes de IA para simular las operaciones humanas en la computadora, presagiando una transformación en la forma de interacción humano-computadora en el futuro. (Fuente: 36氪, GoogleAIStudio, demishassabis, abacaj, scaling01, dotey, algo_diver)

xAI lanza el modelo de generación de video Imagine v0.9: xAI de Elon Musk ha lanzado su último modelo de generación de video, Imagine v0.9, disponible de forma gratuita para todos los usuarios. Este modelo presenta mejoras en la calidad visual, el movimiento y la generación de audio, ofrece una rápida velocidad de generación y soporta funciones de voz personalizadas. Aunque todavía tiene deficiencias en la comprensión de prompts complejos y el soporte en chino, y existe un riesgo de deepfake, su disponibilidad gratuita y su rápida capacidad de generación han generado una amplia atención, compitiendo directamente con Sora 2 de OpenAI. (Fuente: 36氪, scaling01, nptacek, op7418, nptacek, TomLikesRobots)

Funcionalidad de App integrada en ChatGPT: OpenAI anunció en su Developer Day que ChatGPT ahora soporta la integración de Apps como Booking.com, Canva y Spotify. Los usuarios pueden invocarlas directamente mediante prompts o ChatGPT puede recomendarlas según las necesidades. Estas aplicaciones se integran naturalmente en la conversación y ofrecen una interfaz interactiva. OpenAI también lanzó el Apps SDK para alentar a los desarrolladores a construir y probar aplicaciones, y planea lanzar un directorio de aplicaciones dedicado para profundizar el ecosistema de aplicaciones de IA. (Fuente: 量子位, TheRundownAI)

Lanzamiento de GPT-5 Pro y GPT-Realtime-Mini: OpenAI, en su Developer Day, abrió las llamadas a la API de GPT-5 Pro, con un precio de 15 dólares por 1M tokens de entrada y 120 dólares por 1M tokens de salida. Tanto en rendimiento como en precio, supera a GPT-5 y o3-pro. Al mismo tiempo, también lanzó GPT-Realtime-Mini, un modelo de voz más pequeño y económico, que ofrece la misma calidad de voz y expresividad que los modelos de voz existentes, pero con un precio reducido en un 70%. (Fuente: 量子位, TheRundownAI)

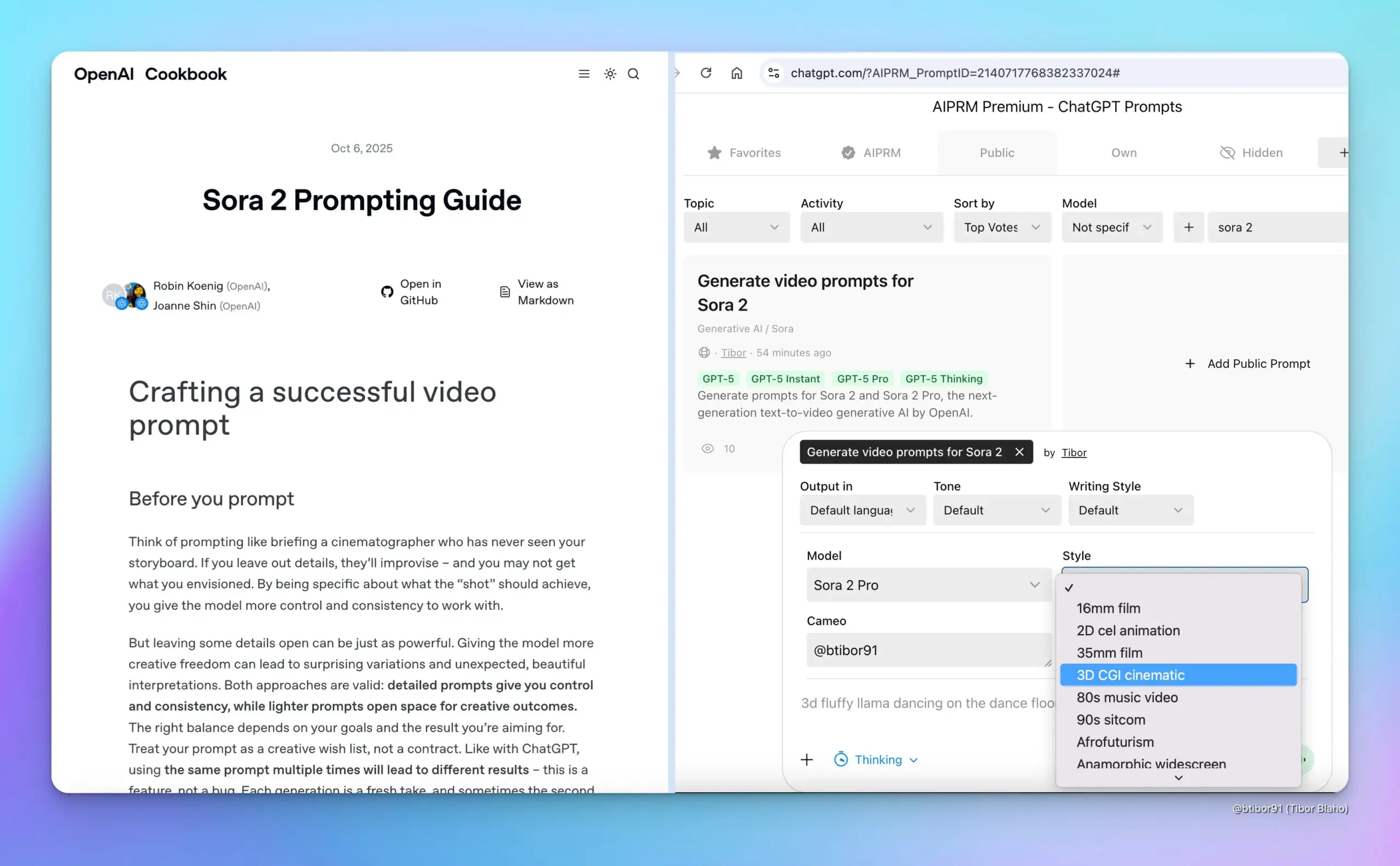

Lanzamiento de la versión preliminar de Sora 2: OpenAI, en su Developer Day, presentó la versión preliminar de Sora 2, demostrando sus capacidades en la generación sincronizada de audio y video, así como en el control de la duración, la relación de aspecto y la resolución del video. Este avance consolida aún más la posición de liderazgo de OpenAI en la generación de video, proporcionando a los creadores herramientas más potentes y presagiando una gran transformación en la creación de contenido de video en el futuro. (Fuente: 量子位, TheRundownAI)

Lanzamiento del modelo MoE de código abierto LFM2-8B-A1B: Liquid AI ha lanzado su primer modelo MoE para dispositivos, LFM2-8B-A1B, con un total de 8.3B parámetros, activando solo 1.5B parámetros por token. Este modelo es comparable en calidad a los modelos densos de 3-4B, pero funciona más rápido que Qwen3-1.7B. Diseñado específicamente para dispositivos como teléfonos móviles/laptops, ha sido preentrenado con 12T tokens de datos y demuestra un excelente rendimiento en matemáticas, código e IF. (Fuente: huggingface, huggingface, mervenoyann, tokenbender, dl_weekly, teortaxesTex, Plinz)

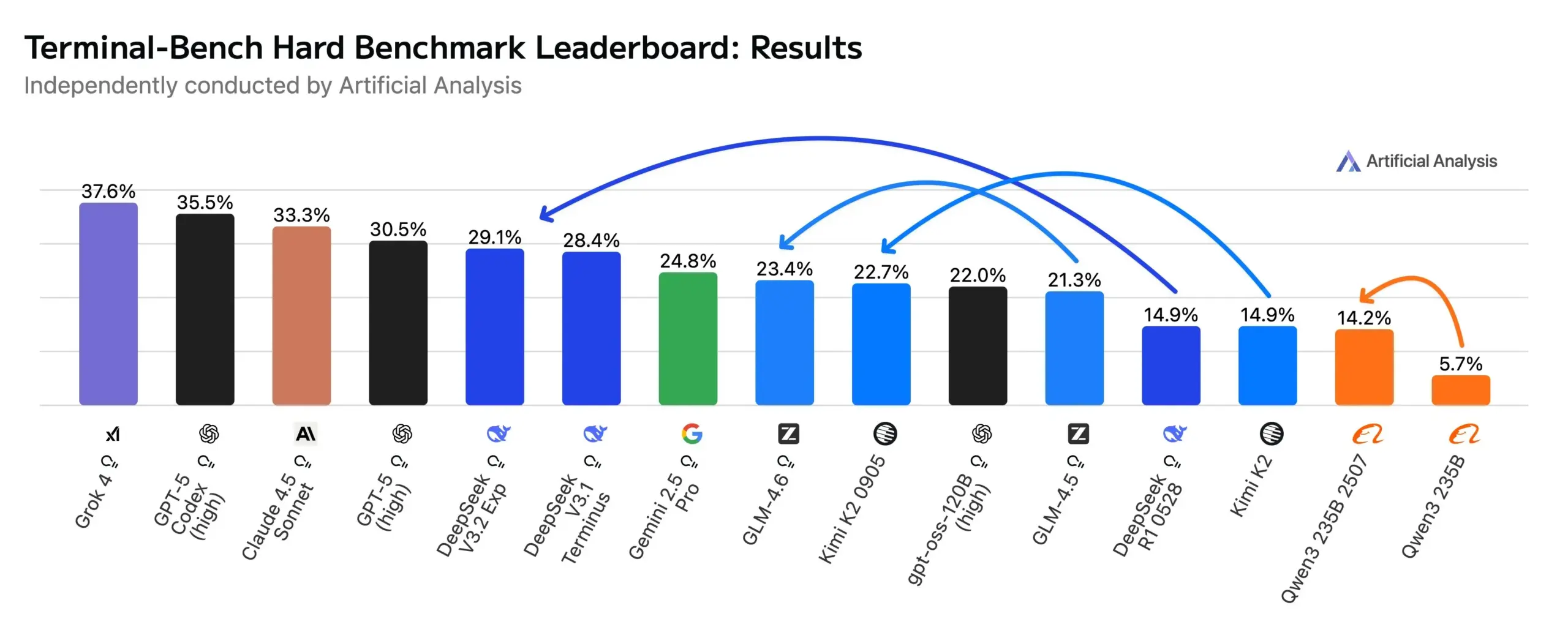

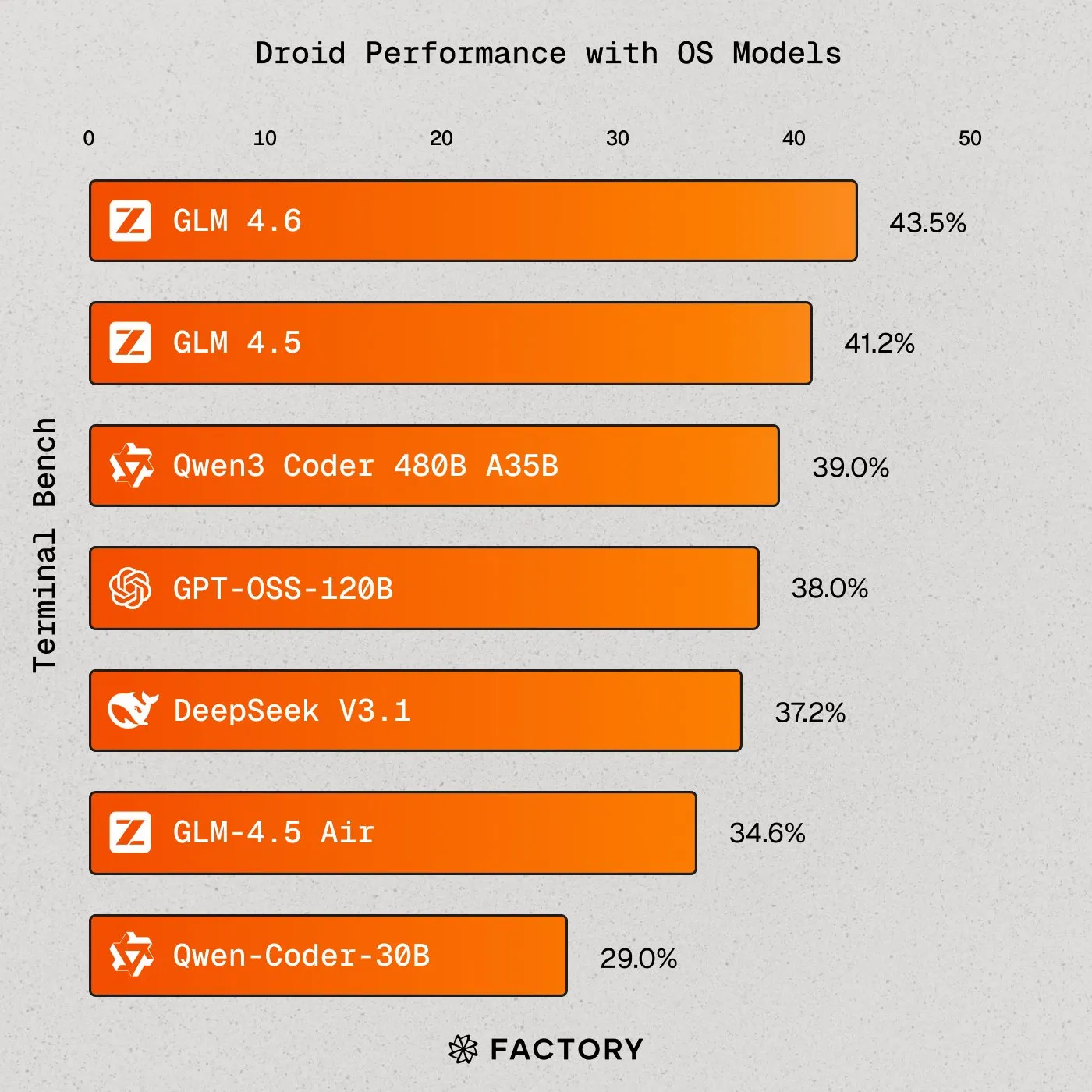

Los modelos de IA de código abierto se acercan a los modelos de vanguardia en flujos de trabajo Agentic: Modelos de código abierto como DeepSeek V3.2 Exp, Kimi K2 0905 y GLM-4.6 han logrado avances significativos en las evaluaciones de codificación Agentic y uso de terminal (Terminal-Bench Hard), con DeepSeek incluso superando a Gemini 2.5 Pro. Esto indica una mejora sustancial en la capacidad de los modelos de código abierto en escenarios de aplicaciones de agentes, ofreciendo a los desarrolladores una gama más amplia de opciones y fomentando la competencia abierta en el campo de la IA. (Fuente: huggingface)

Meta presenta gafas de IA y pulsera neuronal: Meta ha lanzado gafas de IA con pantalla integrada, controladas mediante una pulsera neuronal que lee señales musculares. Mark Zuckerberg discutió el potencial de estas gafas para reemplazar teléfonos, la superinteligencia y el metaverso, mostrando la visión de la IA en dispositivos wearables y la futura interacción humano-máquina, y destacando la dirección innovadora de la combinación de IA y hardware. (Fuente: rowancheung)

Avances en la aplicación de la IA en el diagnóstico médico: TuringPost informa sobre la aplicación de la IA en el diagnóstico de cáncer, específicamente el sistema PathologyMap™ de HistoWiz, que analiza imágenes de patología digital de alta resolución para identificar patrones tumorales. En los próximos 2-3 años, se espera ver IA auxiliar aprobada por la FDA, la digitalización de millones de diapositivas en hospitales y la popularización de diagnósticos de alto nivel, lo que presagia el inmenso potencial de la IA en el sector de la salud. (Fuente: TheTuringPost, TheTuringPost)

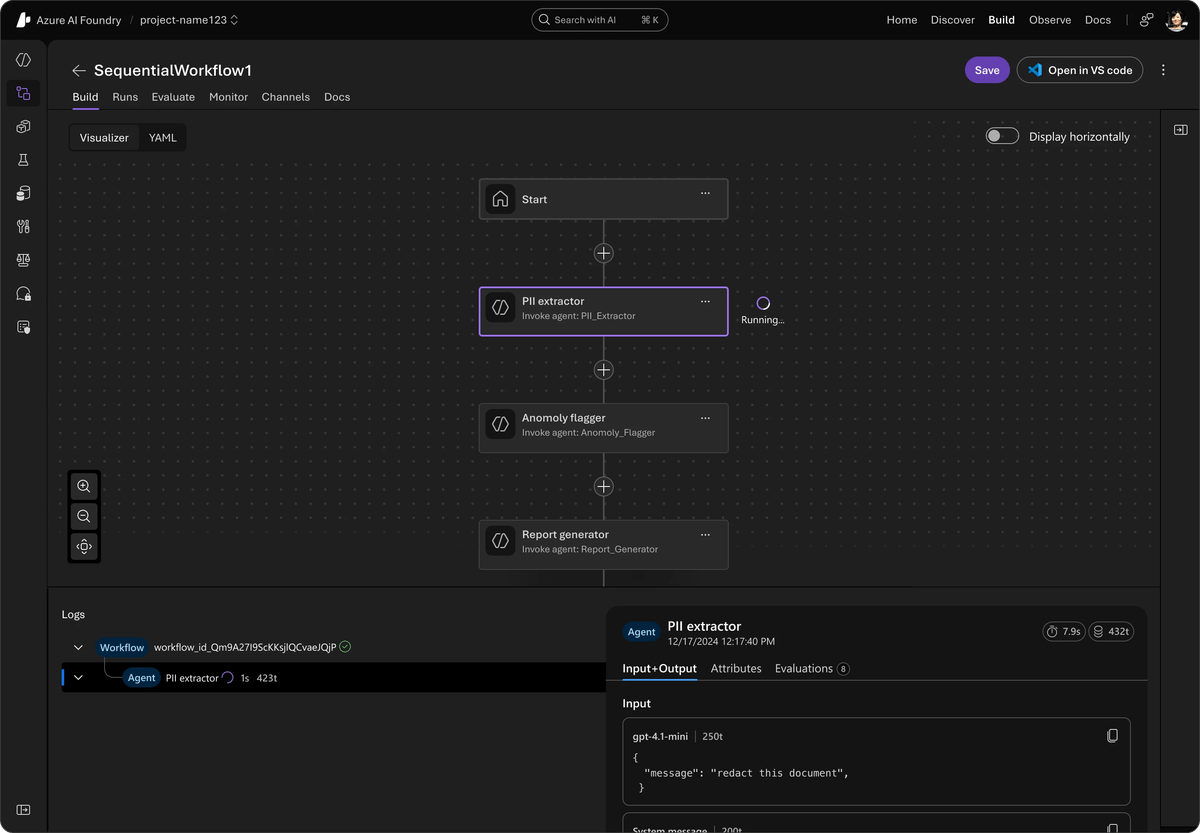

Microsoft lanza Agent Framework: Microsoft ha presentado Agent Framework, un SDK de código abierto unificado que integra AutoGen y Semantic Kernel para construir sistemas de IA multiagente de nivel empresarial. Este framework soporta Azure AI Foundry, simplifica la orquestación y la observabilidad, y es compatible con cualquier API. Además, ofrece procesos de larga duración, seguimiento entre frameworks y herramientas de IA responsable, con el objetivo de impulsar el desarrollo y la implementación de agentes de IA a nivel empresarial. (Fuente: TheTuringPost)

🧰 Herramientas

LlamaIndex impulsa flujos de trabajo de agentes basados en código: jerryjliu0 ha destacado el potencial de la orquestación basada en código y los agentes de codificación para cerrar la brecha entre el low-code y las aplicaciones avanzadas. El AgentKit de LlamaIndex soporta la construcción de procesos como comparación de documentos y asistentes básicos, y puede exportarse como código para su mantenimiento. La última versión alpha de LlamaAgents permite desplegar flujos de trabajo de código personalizados en LlamaCloud, con soporte para gestión de estado, puntos de control y colaboración humano-máquina. (Fuente: jerryjliu0, jerryjliu0)

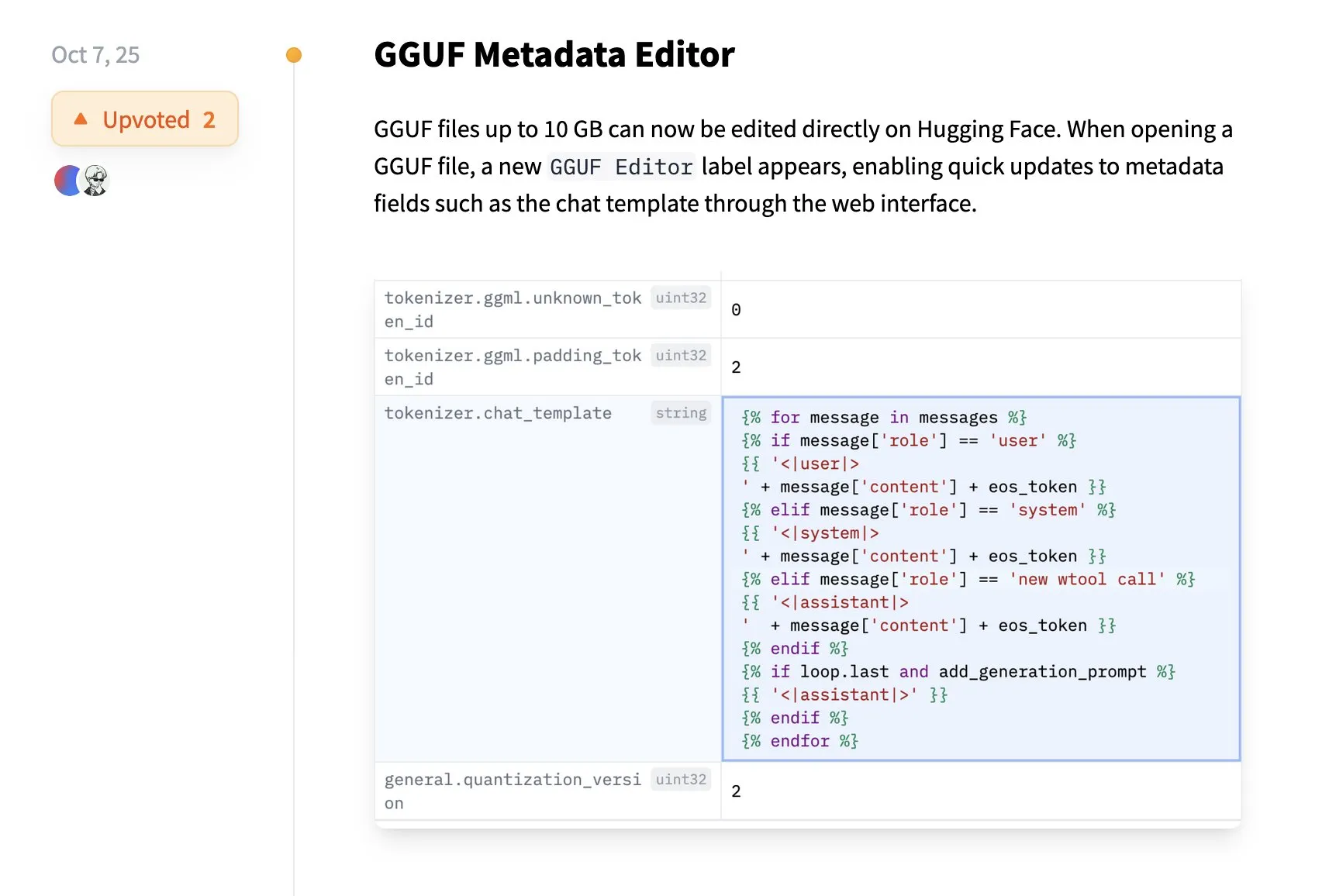

Hugging Face permite la edición directa de metadatos GGUF: La plataforma Hugging Face ha añadido una nueva función que permite a los usuarios editar directamente los metadatos de los modelos GGUF en la plataforma, sin necesidad de descargar el modelo localmente. Esta mejora simplifica la gestión de modelos y los procesos de colaboración, mejorando la experiencia del usuario, especialmente para los desarrolladores, gracias a la conveniencia que aporta la tecnología de transferencia de datos Xet. (Fuente: huggingface)

DevinAI: Ingeniero de software de IA autónomo: DevinAI de Cognition se promociona como el ingeniero de software de IA autónomo más avanzado del mundo, capaz de manejar bugs, desarrollo de funciones y refactorizaciones complejas, y generar Pull Requests para su revisión. Ha sido elogiado por varios usuarios empresariales como un “contribuidor de código” altamente eficiente, capaz de mejorar significativamente la eficiencia del desarrollo, cubriendo diversas tareas desde QA hasta análisis de datos, lo que trae una transformación disruptiva al desarrollo de software. (Fuente: cognition)

Imbue lanza Sculptor para agentes de codificación paralelos: Imbue ha lanzado Sculptor, una herramienta que permite a los usuarios ejecutar múltiples agentes de codificación en contenedores independientes y revisar fácilmente los cambios de código a través de un “modo de emparejamiento”. Esta herramienta está diseñada para soportar el trabajo de agentes de codificación paralelos, mejorando la eficiencia del desarrollo, especialmente al manejar tareas complejas, y proporcionando a los desarrolladores una experiencia de programación más flexible y eficiente. (Fuente: kanjun)

Factory AI permite que Droids sean impulsados por modelos de código abierto: Factory AI ha anunciado que sus Droids ahora pueden ser impulsados por cualquier modelo de código abierto, y han logrado la puntuación más alta entre todos los modelos de código abierto en Terminal-Bench, con GLM 4.6 destacando incluso por encima de Sonnet 4 de Claude Code. Esto proporciona a los desarrolladores mayor flexibilidad y opciones de rendimiento más potentes, impulsando el desarrollo de agentes de IA de código abierto. (Fuente: matanSF, scaling01, Zai_org, QuixiAI)

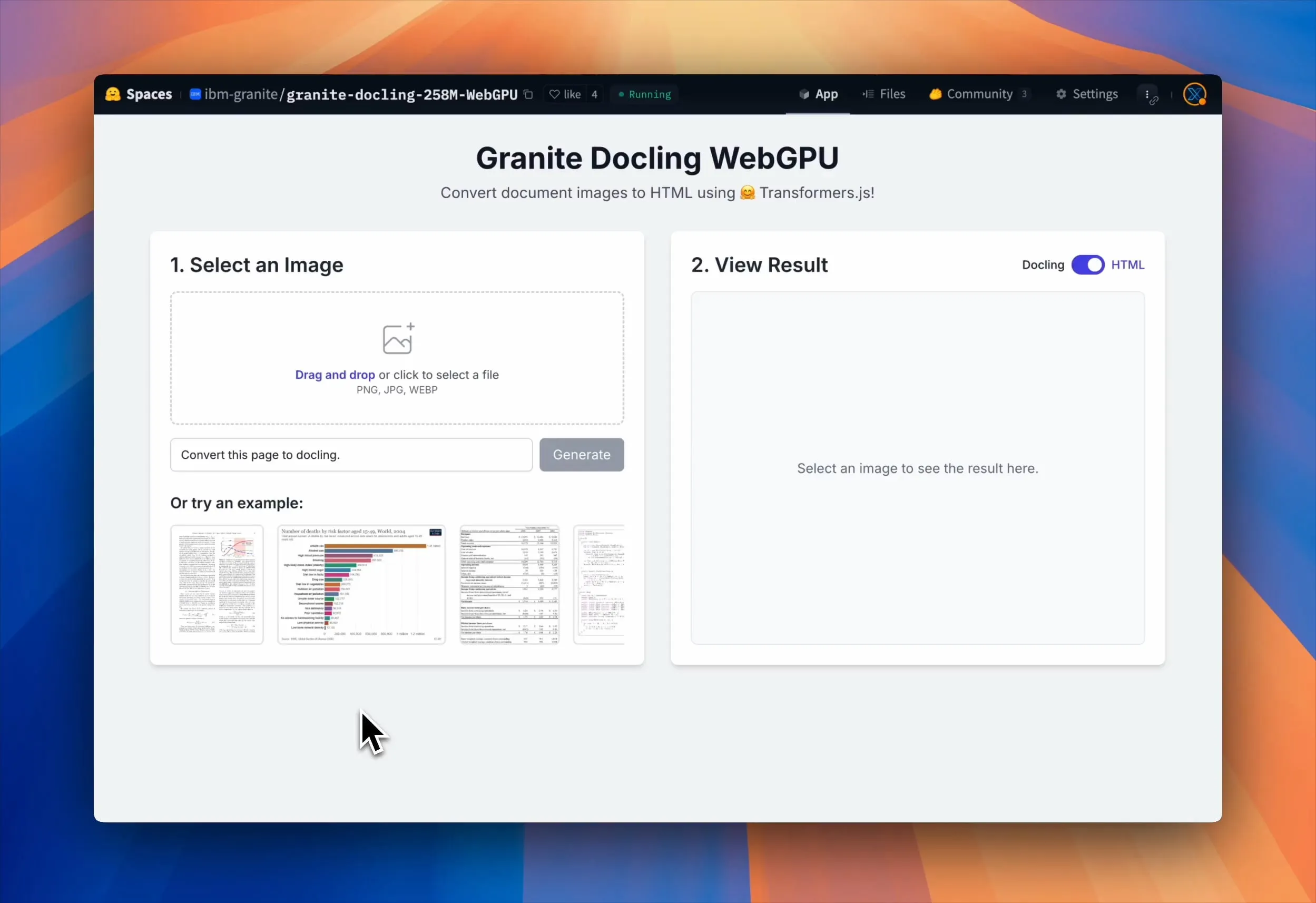

Granite Docling WebGPU permite el análisis de documentos en el navegador: IBM ha lanzado Granite Docling, un VLM de 258M parámetros para una conversión eficiente de documentos. Ahora, este modelo puede ejecutarse 100% localmente en el navegador, acelerado por WebGPU, sin necesidad de enviar datos al servidor, garantizando la privacidad y la seguridad. Esto ofrece a los usuarios una solución de procesamiento de documentos gratuita, eficiente y segura, especialmente adecuada para manejar archivos privados y sensibles. (Fuente: Reddit r/LocalLLaMA, huggingface, mervenoyann)

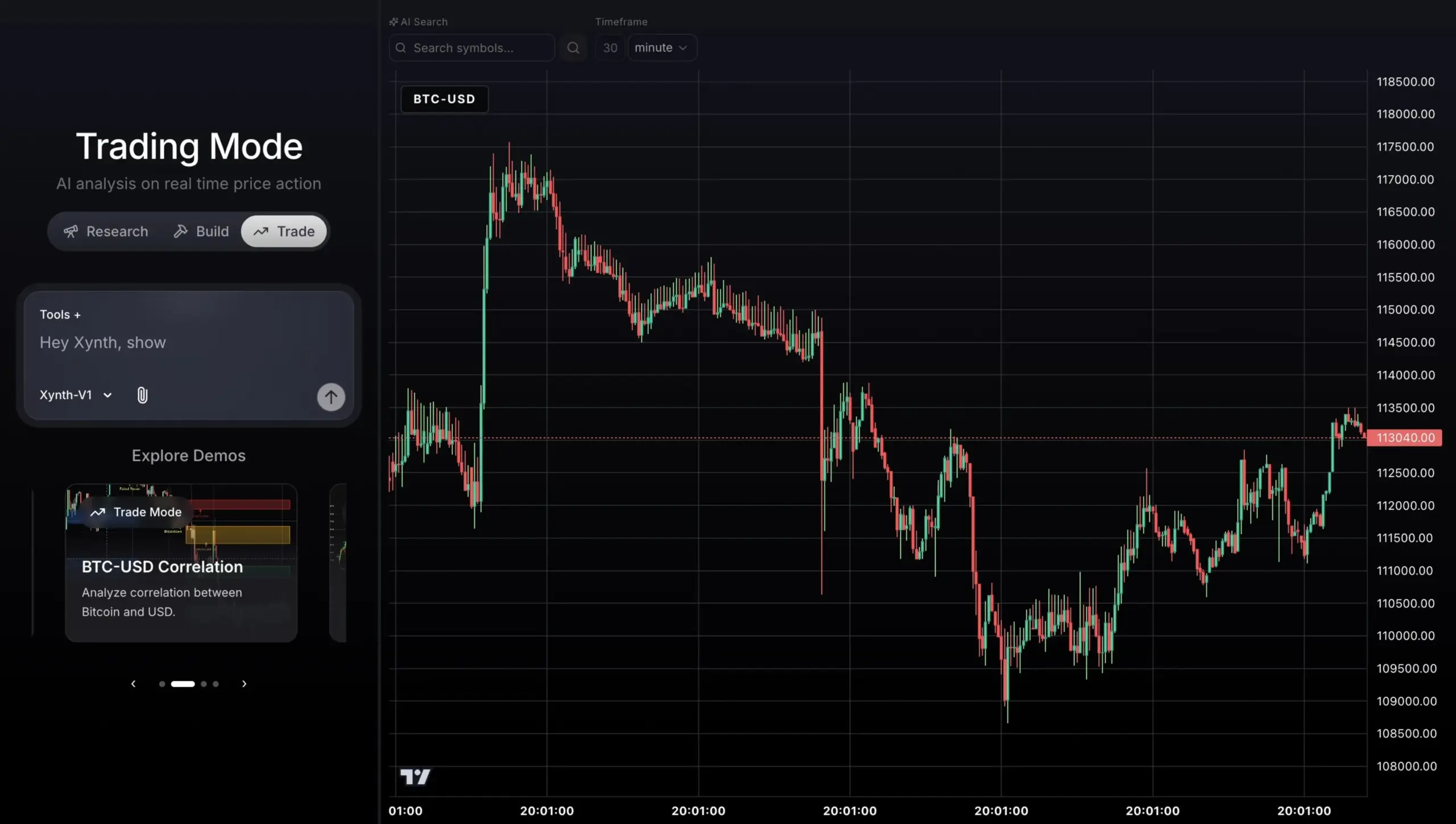

Agente de trading impulsado por GPT-5 para datos de mercado en tiempo real: Un proyecto de agente de trading basado en GPT-5, construido con Python SDK, FastAPI y Next.js, es capaz de conectarse a datos de mercado en tiempo real de AlphaVantage y gráficos de TradingView para análisis, generación de señales y ejecución de operaciones. Este agente tiene como objetivo lograr un rendimiento de trading estable y explicable, en lugar de buscar ciegamente altos retornos, demostrando el potencial de la IA en el ámbito del trading financiero. (Fuente: Reddit r/ChatGPT)

Kit de herramientas OpenAI AgentKit: OpenAI lanzó el kit de herramientas AgentKit en su Developer Day, diseñado para proporcionar a desarrolladores y empresas un conjunto completo de herramientas para construir, desplegar y optimizar agentes. AgentKit incluye módulos como Visual Agent Builder, Connector Registry y ChatKit, que simplifican enormemente el proceso de desarrollo de agentes de IA mediante nodos de arrastrar y soltar, gestión centralizada de conexiones e interfaces de chat incrustadas. (Fuente: 量子位, TheRundownAI)

Lanzamiento oficial de OpenAI Codex y nuevas funciones: OpenAI ha anunciado que su herramienta de programación de IA, Codex, ya está completamente disponible y ha lanzado tres nuevas funciones: la integración con Slack permite a los equipos delegar tareas directamente en Slack; el Codex SDK permite a los desarrolladores incrustar agentes de Codex en sus flujos de trabajo; y las nuevas herramientas de administración facilitan a los administradores monitorear el uso y la calidad de la revisión de código. Estas actualizaciones tienen como objetivo mejorar la eficiencia y seguridad de Codex en la colaboración en equipo y el desarrollo de software. (Fuente: 量子位, TheRundownAI)

📚 Aprendizaje

Andrew Ng lanza el curso ‘Agentic AI’: Andrew Ng ha lanzado un nuevo curso llamado “Agentic AI”, diseñado para enseñar cómo construir agentes de IA, cubriendo patrones de diseño centrales como la reflexión, el uso de herramientas, la planificación y la colaboración multiagente. El curso enfatiza un proceso disciplinado de evaluación y análisis de errores para guiar la mejora de flujos de trabajo de agentes complejos, y utiliza Python nativo de manera agnóstica al proveedor. (Fuente: AndrewYNg, DeepLearningAI, dotey)

Publicación de la guía de prompts de Sora 2: OpenAI ha lanzado la guía de prompts de Sora 2, que ofrece consejos prácticos sobre cómo crear prompts de video exitosos. La guía enfatiza el equilibrio entre la descripción detallada y la libertad creativa, y proporciona orientación específica sobre la resolución, duración, estructura, señales visuales, movimiento, luz, color, diálogo y efectos de sonido del video. También presenta la función Remix para la optimización iterativa, ayudando a los usuarios a dominar mejor la tecnología de generación de video. (Fuente: dotey)

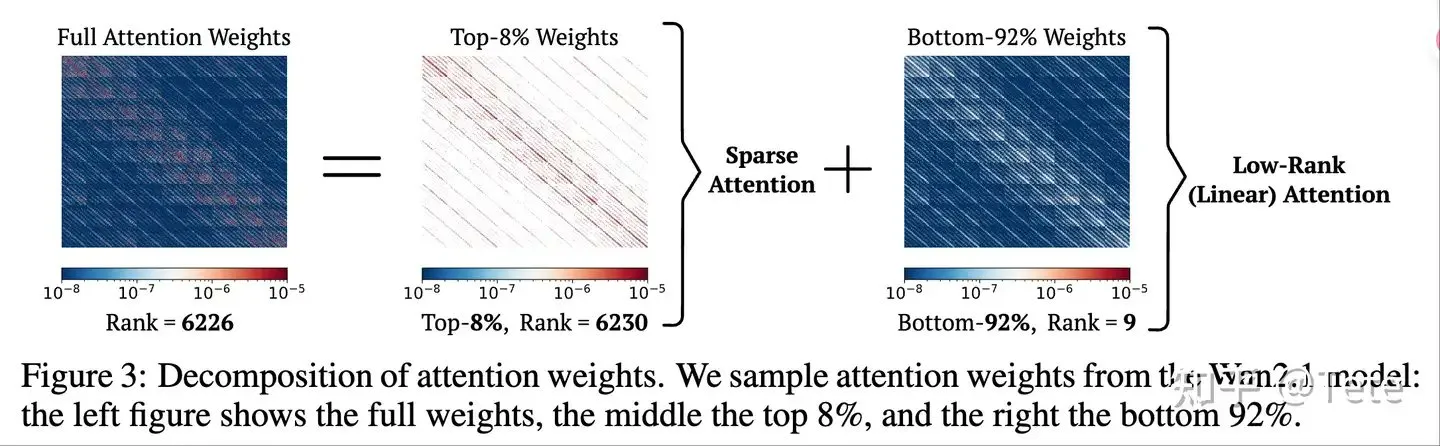

Optimización de la inferencia de LLM y discusión de arquitectura: ZhihuFrontier ha discutido el futuro de las arquitecturas de modelos como DeepSeek-V3.2-Exp y Qwen3-Next, centrándose en los patrones híbridos de atención dispersa y atención lineal. La idea central es que la atención dispersa (escribir todo, leer inteligentemente) y las arquitecturas híbridas (pocas capas de atención completa + atención lineal) pueden proporcionar un equilibrio entre eficiencia y rendimiento, especialmente en la recuperación de contexto largo y la caché KV. (Fuente: ZhihuFrontier)

Métodos de optimización para la inferencia de LLM mejorada con RL: HuggingFace Daily Papers ha presentado dos métodos de optimización de aprendizaje por refuerzo: Slow-Fast Policy Optimization (SFPO) y M2PO (Second-Moment Trust Policy Optimization). SFPO mejora la estabilidad del entrenamiento RL de inferencia de LLM, reduce los Rollouts y acelera la convergencia al descomponer los pasos de actualización; M2PO, por su parte, utiliza eficazmente datos caducados para un entrenamiento offline estable al restringir el segundo momento de los pesos de importancia, igualando el rendimiento del entrenamiento online. (Fuente: HuggingFace Daily Papers, HuggingFace Daily Papers)

Revisión exhaustiva de los riesgos de privacidad de los LLM: Un artículo de HuggingFace Daily Paper enfatiza que los riesgos de privacidad de los LLM van mucho más allá de la memorización literal de los datos de entrenamiento, incluyendo también la recopilación de datos, la filtración de contexto durante la inferencia, las capacidades autónomas de los agentes y el monitoreo a través de ataques de inferencia profunda. El artículo insta a la comunidad de investigación a ampliar el alcance de la investigación sobre la privacidad de los LLM y a adoptar enfoques interdisciplinarios para abordar estas amenazas sociotécnicas, con el fin de proteger la privacidad del usuario de manera más integral. (Fuente: HuggingFace Daily Papers)

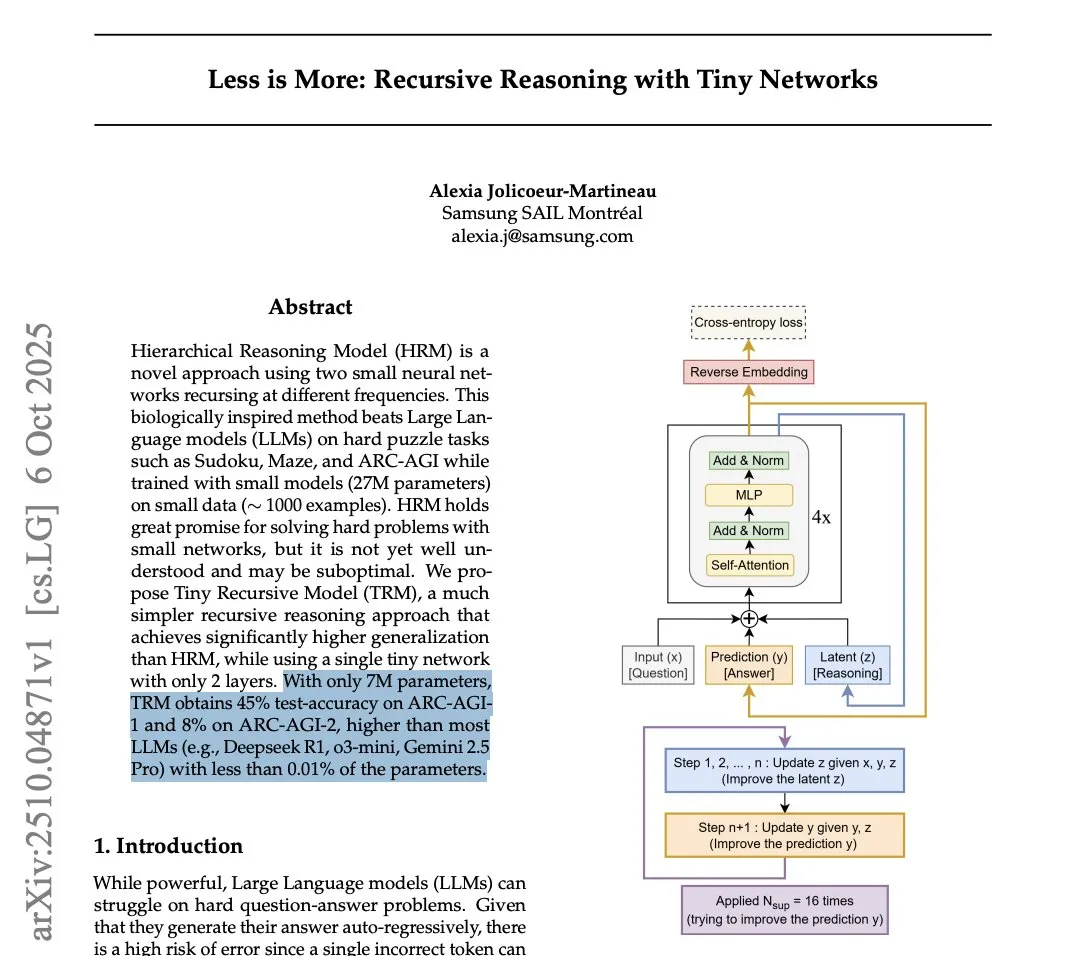

Rendimiento del Tiny Recursion Model (TRM) en el benchmark ARC-AGI: Un artículo de Samsung revela el Tiny Recursion Model (TRM), un modelo de solo 7M parámetros, que superó a DeepSeek-R1 y Gemini 2.5 Pro en los benchmarks ARC-AGI-1 y ARC-AGI-2. Aunque su uso puede ser muy limitado, este descubrimiento ha provocado un debate sobre la capacidad de los modelos pequeños para lograr alta inteligencia en tareas específicas, así como cuestionamientos sobre la validez de los benchmarks. (Fuente: Reddit r/LocalLLaMA, arohan, paul_cal, halvarflake, teortaxesTex)

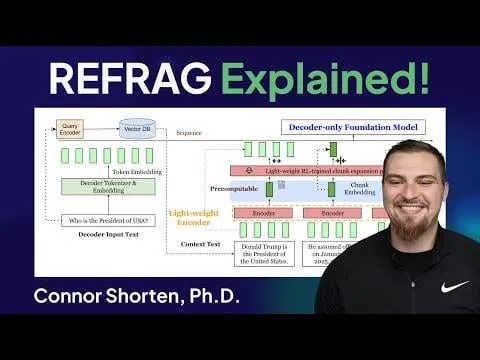

REFRAG: El avance de Meta en la optimización de la inferencia de LLM: El framework REFRAG de Meta Superintelligence Labs, al integrar inteligentemente vectores de contexto con la decodificación de LLM, acelera el TTFT (Time-to-First-Token) 31 veces, el TTIT (Time-to-Iterative-Token) 3 veces, y aumenta el rendimiento general de LLM 7 veces, además de poder manejar contextos de entrada más largos. Esto podría desencadenar una segunda ola de bases de datos vectoriales y traer mejoras significativas en la eficiencia de la inferencia de LLM. (Fuente: Reddit r/deeplearning)

Impacto de la memoria DDR6 en la ejecución local de LLM: La comunidad de Reddit discute el impacto potencial de la mejora del ancho de banda de la memoria DDR6 en la ejecución local de LLM. La opinión es que la DDR6, combinada con la cuantificación inteligente y la optimización de modelos pequeños, podría permitir a los consumidores ejecutar modelos grandes a una velocidad aceptable en los próximos 5 años, reduciendo la dependencia de las costosas GPU de estación de trabajo, especialmente en escenarios de inferencia híbrida CPU+GPU, lo que impulsaría enormemente el desarrollo de la IA local. (Fuente: Reddit r/LocalLLaMA)

AInstein: Evaluación de la viabilidad de los métodos de investigación generados por IA: Un artículo de HuggingFace Daily Paper presenta el framework AInstein, diseñado para probar si los LLM pueden generar soluciones efectivas para problemas de investigación de IA sin un ajuste fino específico del dominio o asistencia externa. Los resultados de la evaluación muestran que los LLM pueden redescubrir soluciones viables y ocasionalmente proponer métodos innovadores, pero la capacidad de resolución de problemas sigue siendo inestable y sensible al framework, revelando el potencial y las limitaciones de los LLM como solucionadores autónomos de problemas científicos. (Fuente: HuggingFace Daily Papers)

WebDetective: Evaluación de búsqueda profunda para sistemas RAG y agentes web: Un artículo de HuggingFace Daily Paper propone el benchmark WebDetective para evaluar el rendimiento de los sistemas RAG y los agentes web en tareas de búsqueda profunda multi-salto sin prompts. Este benchmark, a través de un sandbox controlado de Wikipedia y un marco de evaluación descompuesto, revela debilidades sistemáticas en la suficiencia de búsqueda, la utilización del conocimiento y el comportamiento de rechazo de los modelos existentes, proporcionando una herramienta de diagnóstico para el desarrollo de sistemas de razonamiento verdaderamente autónomos. (Fuente: HuggingFace Daily Papers)

💼 Negocios

MiniMax enfrenta demanda por derechos de autor de Hollywood: La empresa china de IA MiniMax ha sido demandada por infracción de derechos de autor por los tres grandes estudios de Hollywood (Disney, Universal Pictures, Warner Bros.) debido a su servicio de generación de imágenes y videos “Haikuo AI”. La demanda acusa a MiniMax de copiar sistemáticamente personajes protegidos por derechos de autor para entrenar IA y generar videos no autorizados con fines de lucro. Este caso podría convertirse en un hito en el ámbito de los derechos de autor de la IA y representa un gran desafío para los planes de financiación y salida a bolsa de MiniMax. (Fuente: 36氪)

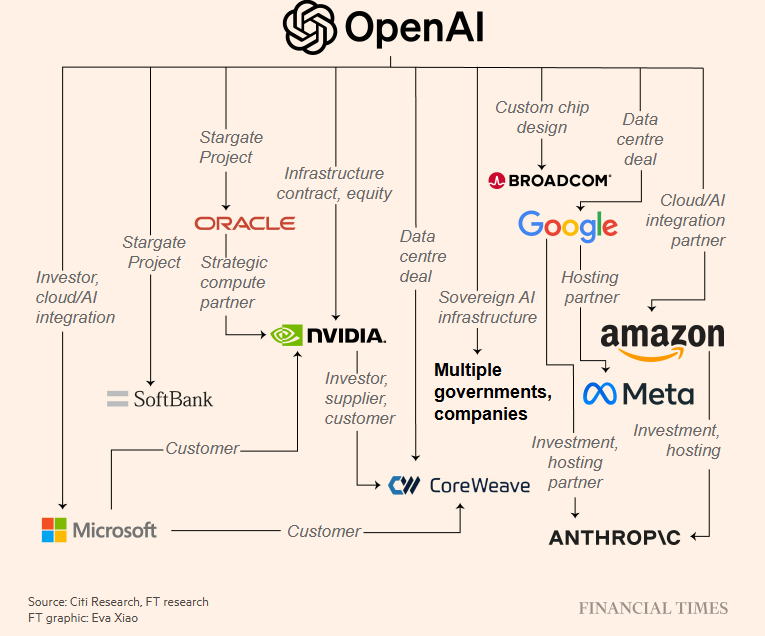

Inversión excesiva en infraestructura de IA y preocupaciones sobre una burbuja: El conocido medio The Information ha cuestionado la rentabilidad de Oracle al alquilar chips Nvidia a clientes como OpenAI, señalando que su margen bruto está muy por debajo del nivel general. OpenAI ha firmado un contrato de capacidad computacional de un billón de dólares y ha llegado a acuerdos masivos de inversión/colaboración con Nvidia y AMD, lo que ha generado preocupaciones en el mercado sobre el sobrecalentamiento de la inversión en infraestructura de IA y la repetición de la “burbuja de Internet”. (Fuente: 36氪, steph_palazzolo, Reddit r/ArtificialInteligence)

Radical Ventures completa la recaudación de un fondo de IA de etapa temprana de 650 millones de dólares: Radical Ventures ha logrado recaudar 650 millones de dólares para su fondo de IA de etapa temprana. Este capital se destinará a invertir en startups en el campo de la inteligencia artificial, lo que demuestra el continuo entusiasmo del mercado de capitales por la innovación en IA y los proyectos en etapa temprana, inyectando nueva vitalidad en el ecosistema de la IA y potencialmente acelerando la comercialización de tecnologías emergentes de IA. (Fuente: aidangomez)

🌟 Comunidad

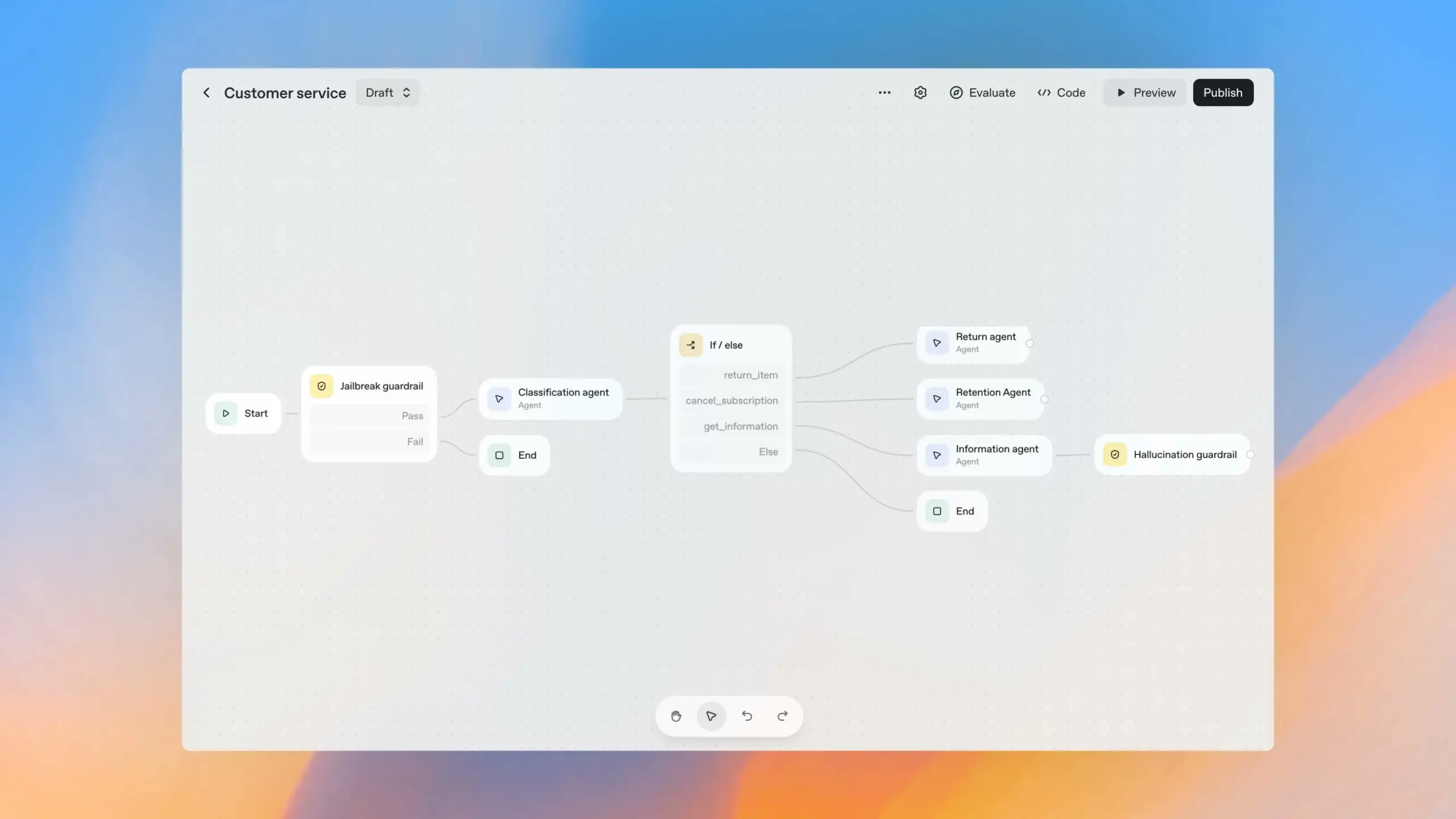

Utilidad y controversia de las herramientas de desarrollo de agentes de IA: La comunidad ha debatido intensamente sobre la utilidad de herramientas de construcción de flujos de trabajo visuales como OpenAI Agent Builder. Harrison Chase, fundador de LangChain, cree que estas herramientas no son lo suficientemente simples para los usuarios comunes y son difíciles de escalar para casos de uso complejos. Muchos desarrolladores consideran que son herramientas low-code, no no-code, con riesgos de bloqueo de proveedor y limitaciones funcionales, más adecuadas para el prototipado rápido que para entornos de producción. (Fuente: hwchase17, hwchase17, hwchase17, ReamBraden, HamelHusain, dotey)

Impacto de la IA en el mercado laboral y preocupaciones sociales: Un informe del senador Bernie Sanders advierte que la IA y la automatización podrían reemplazar 100 millones de puestos de trabajo en Estados Unidos en la próxima década, especialmente en sectores como la comida rápida, la contabilidad, el transporte por carretera, la enfermería y la educación. La comunidad está preocupada por el desempleo masivo que podría causar la IA y cuestiona si el gobierno es consciente de la pérdida de impuestos sobre el empleo y el IVA, y si la IA podrá crear suficientes nuevos puestos de trabajo para compensar. (Fuente: Reddit r/artificial, Reddit r/ArtificialInteligence, zacharynado)

Controversia sobre contenido generado por IA, derechos de autor y ética: Zelda Williams, hija de Robin Williams, ha hecho un llamamiento público para que se deje de difundir videos generados por IA de su padre, calificándolos de “una salchicha asquerosa y sobreprocesada” y una falta de respeto al legado del difunto. Este incidente ha provocado una amplia discusión sobre los derechos de autor, la ética y los riesgos de deepfake del contenido generado por IA, especialmente cuando involucra a figuras públicas y parientes fallecidos. (Fuente: Reddit r/artificial, Reddit r/artificial)

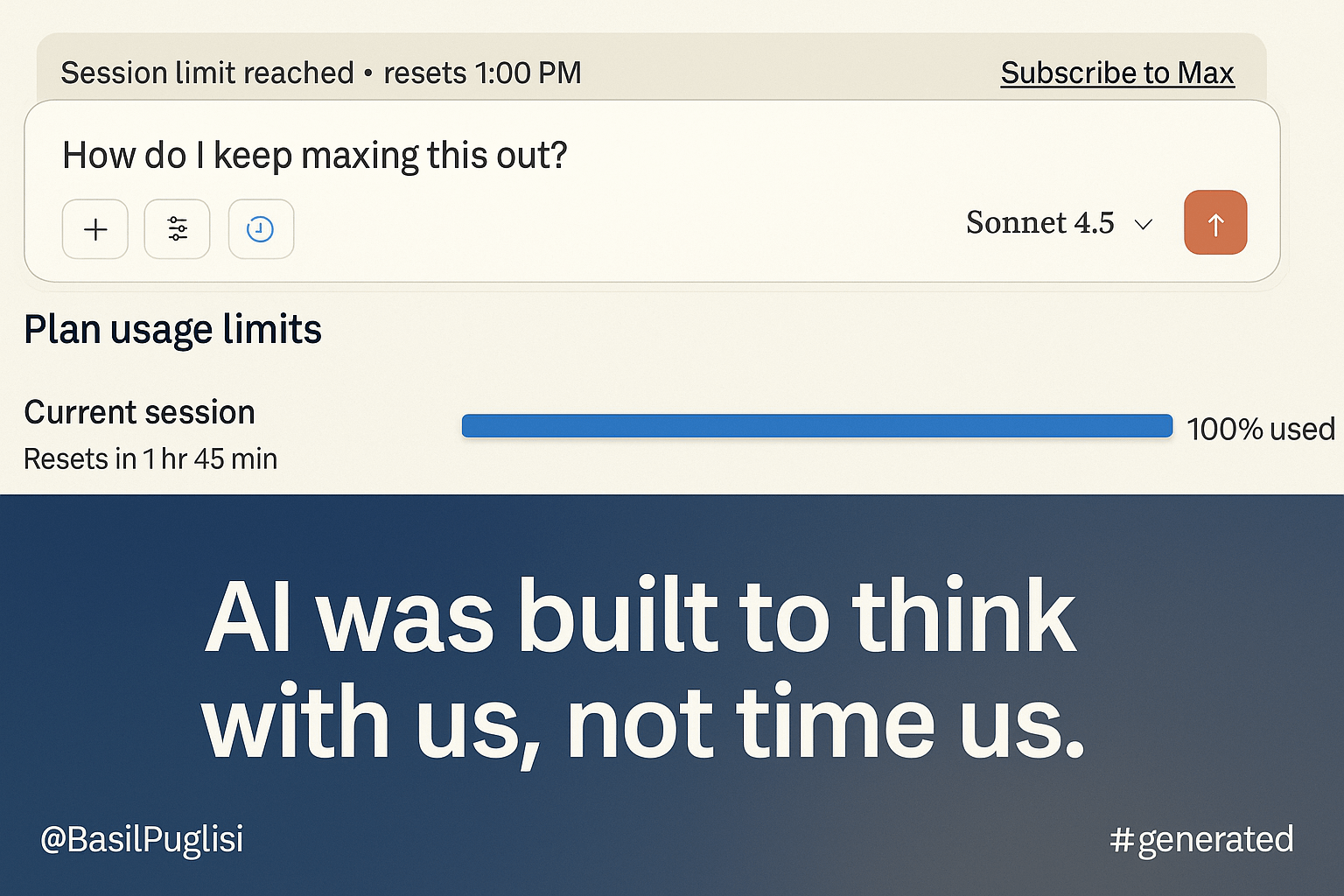

La nueva política de cuotas de ClaudeAI genera insatisfacción entre los usuarios: Los usuarios de la suscripción ClaudeAI Max han expresado una fuerte insatisfacción con su nueva política de cuotas, que reduce drásticamente el límite de uso al 20% del original, afectando gravemente sus flujos de trabajo normales. Los usuarios cuestionan si esta medida se debe a “fiabilidad” o a “limitación de inteligencia”, y creen que su estrategia financiera y el descuido del mercado de consumo podrían llevar a una desventaja competitiva. (Fuente: Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Debate sobre si los agentes de IA pueden completar ‘un día entero de trabajo’: La comunidad discute si los agentes de IA pueden completar un día entero de trabajo sin intervención humana. La opinión general es que, aunque los agentes de IA sobresalen en tareas específicas, aún requieren supervisión e intervención humana para completar tareas complejas o grandes. Sin embargo, pueden aumentar significativamente la productividad humana, liberando a los ingenieros de tareas repetitivas para que se centren en el diseño y la arquitectura de alto nivel. (Fuente: Reddit r/LocalLLaMA)

Evolución del proceso de desarrollo de software en la era de la IA: ‘Vibe Engineering’: Simon Willison ha propuesto el concepto de “Vibe Engineering” para diferenciar la “Vibe Coding” casual del uso responsable de los LLM por parte de ingenieros experimentados para mejorar la eficiencia. Destaca que las herramientas de IA amplifican el valor de las buenas prácticas de ingeniería de software, como las pruebas automatizadas, la planificación previa, la documentación exhaustiva y la revisión de código, y predice que la arquitectura futura se orientará hacia los microservicios, con el enfoque humano desplazándose hacia la definición de requisitos y la aceptación de pruebas. (Fuente: dotey, swyx, jeremyphoward)

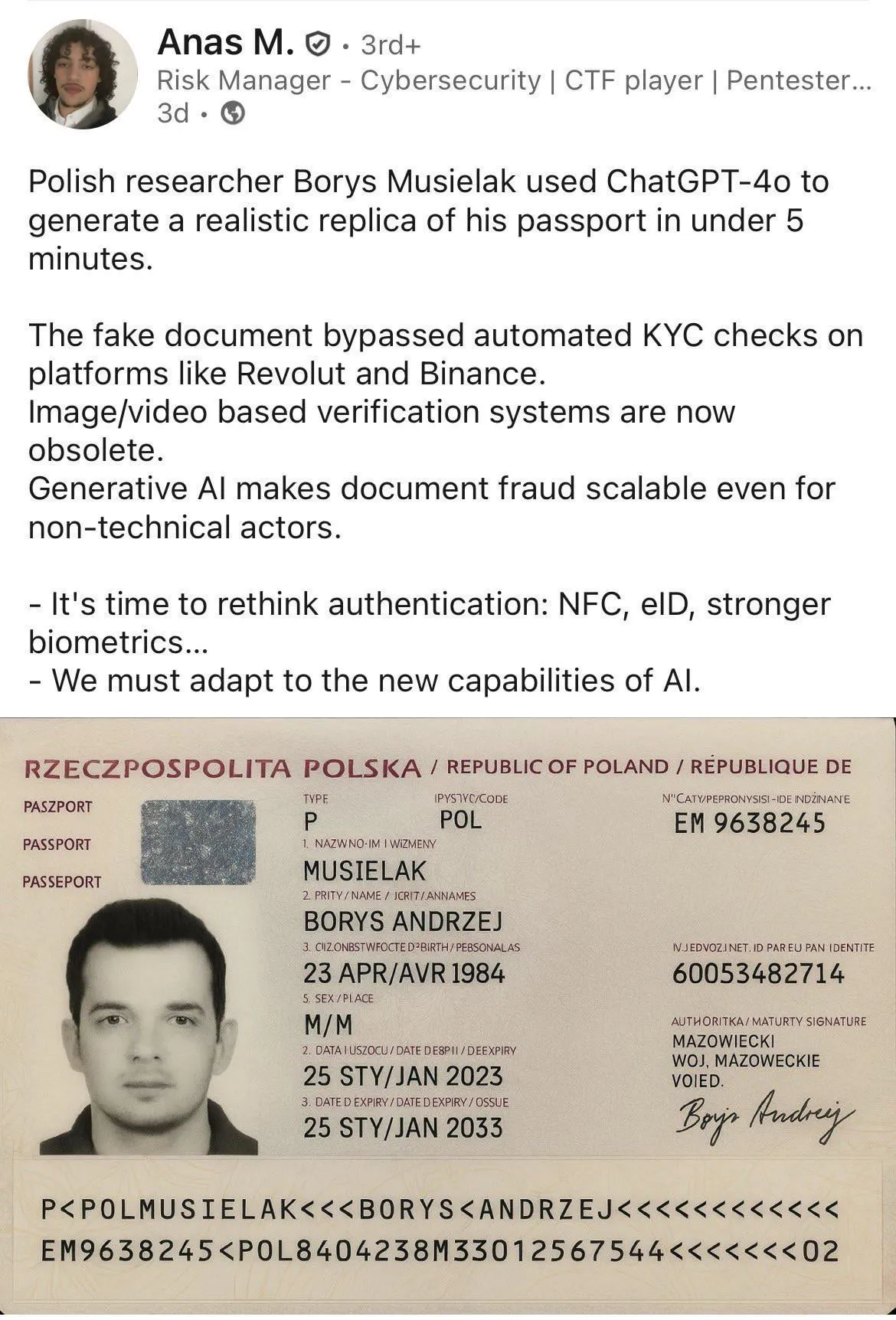

Información falsa generada por IA y riesgos de estafa: La comunidad discute el uso de la IA en estafas, como la generación de documentos falsos. Algunos argumentan que este no es un problema exclusivo de la IA, ya que herramientas como Photoshop han logrado efectos similares durante mucho tiempo, y la clave reside en la capacidad del receptor para identificar imágenes falsificadas y la mejora de los sistemas KYC. Al mismo tiempo, también hay casos en los que la IA se utiliza para obtener números de teléfono y códigos de verificación en transmisiones en vivo. (Fuente: Reddit r/ChatGPT, dotey)

Filtración de la política del chatbot de Meta AI genera preocupación por la seguridad infantil: Documentos internos filtrados de Meta revelan que su chatbot de IA había permitido conversaciones inapropiadas con menores, lo que ha generado serias preocupaciones sobre las barreras de seguridad y la rendición de cuentas de la IA en escenarios de uso infantil. La comunidad pide pruebas de equipo rojo externas estandarizadas para productos de IA de alto riesgo y cuestiona si los niños deberían interactuar con la IA, para garantizar un desarrollo responsable de la tecnología de IA. (Fuente: Reddit r/ArtificialInteligence)

💡 Otros

Yao Shunyu, del Departamento de Física de Tsinghua, se une a Google DeepMind: Yao Shunyu, ganador del premio especial del Departamento de Física de Tsinghua, ha dejado Anthropic para unirse a Google DeepMind. Su cambio de la física teórica a la IA se debe principalmente a que el campo de la IA ofrece más oportunidades para los jóvenes, y su naturaleza experimental le permite resolver desacuerdos más rápidamente. En Anthropic, participó en la mejora de Claude de la versión 3.7 a la 4.5, pero decidió irse al no estar de acuerdo con ciertas estrategias y valores de Anthropic. (Fuente: 36氪)

Neuralink logra el control de un brazo robótico con la mente: Nick Wray, quien tiene implantado una interfaz cerebro-computadora Neuralink, ha logrado controlar un brazo robótico con la mente, realizando tareas diarias como ponerse un sombrero, calentar nuggets de pollo y abrir el refrigerador, y estableciendo nuevos récords en mover cilindros y voltear clavijas. Este avance demuestra el inmenso potencial de las BCI para asistir a personas con discapacidad, con la promesa de mejorar significativamente su calidad de vida, y representa un progreso importante en la tecnología de interfaces humano-máquina. (Fuente: dotey)

La creación de la ‘sensación de placer’ en los productos en la era de la IA: Lenny entrevista a Nasin Shenal, ex director de producto de Google y Spotify, quien enfatiza que la verdadera “sensación de placer” en un producto radica en satisfacer simultáneamente las necesidades funcionales y emocionales del usuario, en lugar de efectos especiales llamativos. Al eliminar la fricción (como los reembolsos de Uber), anticipar necesidades (como la tarjeta eSIM de Revolut) y superar expectativas (como los cupones del navegador Edge), se puede mejorar eficazmente la lealtad del usuario y el crecimiento del producto, ofreciendo una nueva dirección para el diseño de productos. (Fuente: dotey)