Palabras clave:computación cuántica, centro de datos de IA, energías renovables, modelos grandes, agente de IA, aprendizaje por refuerzo, IA multimodal, alineación de IA, supremacía cuántica, microred de reciclaje de baterías, turbina eólica inteligente, GPT-5 Pro, ajuste fino de estrategias evolutivas

🔥 Foco

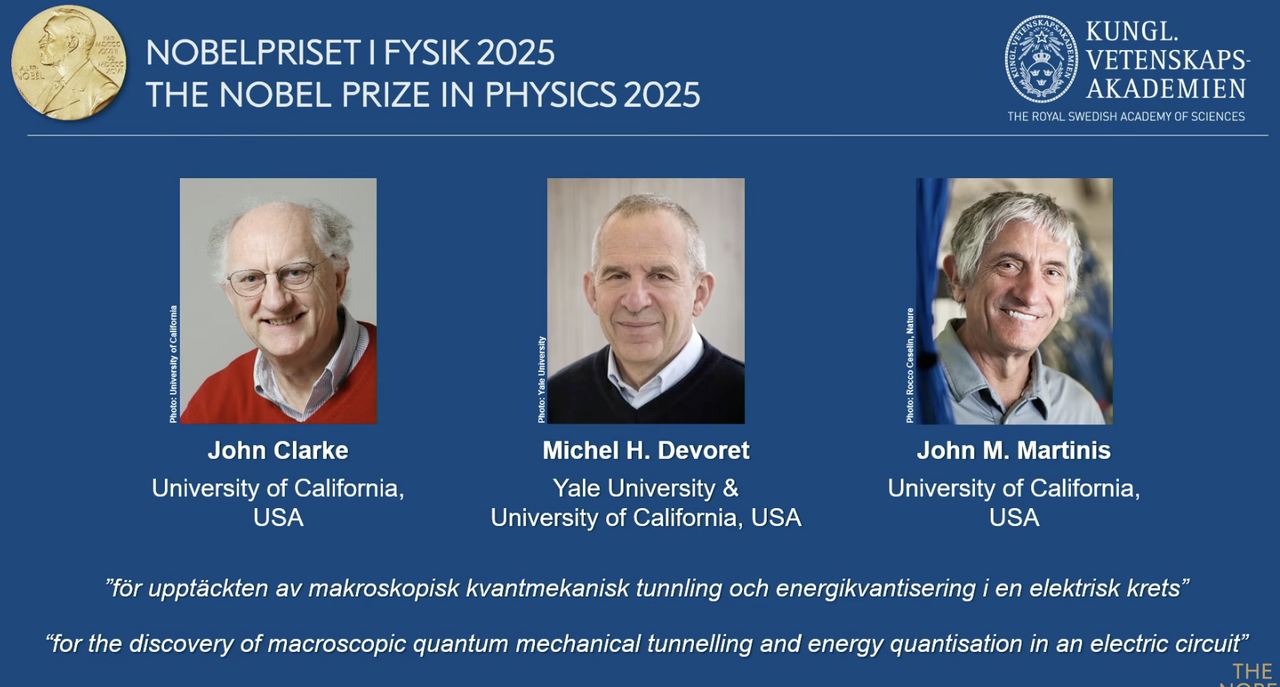

Premio Nobel de Física 2025 otorgado a pioneros de la computación cuántica: El Premio Nobel de Física 2025 ha sido concedido a John Clarke, Michel H. Devoret y John M. Martinis en reconocimiento a su descubrimiento del efecto túnel de la mecánica cuántica macroscópica y el fenómeno de cuantificación de energía en circuitos. John M. Martinis fue el científico jefe del Google AI Quantum Lab, y su equipo logró por primera vez la “quantum supremacy” en 2019 con un procesador de 53 qubits, superando en velocidad de cálculo a la supercomputadora clásica más potente de la época, sentando las bases para la computación cuántica y el futuro desarrollo de la AI. Este trabajo innovador marca la transición de la computación cuántica de la teoría a la práctica, con profundas implicaciones para la mejora de la capacidad de cómputo subyacente de la AI. (Fuente: 量子位)

Redwood Materials utiliza microgrids de AI para alimentar data centers: Redwood Materials, un reciclador líder de baterías en EE. UU., está integrando baterías recicladas de vehículos eléctricos en microgrids para proporcionar energía a los data centers de AI. Ante el aumento de la demanda de energía por parte de la AI, esta solución puede satisfacer rápidamente las necesidades de los data centers con energía renovable, al tiempo que reduce la presión sobre la red eléctrica existente. Esta iniciativa no solo reutiliza baterías viejas, sino que también ofrece una solución energética más sostenible para el desarrollo de la AI, lo que podría aliviar la presión ambiental que conlleva el crecimiento de la capacidad de cómputo de la AI. (Fuente: MIT Technology Review)

Las turbinas eólicas “inteligentes” de Envision Energy impulsan la descarbonización industrial: Envision Energy, un fabricante chino líder de turbinas eólicas, está utilizando tecnología de AI para desarrollar turbinas eólicas “inteligentes” que generan aproximadamente un 15% más de electricidad que los modelos tradicionales. La compañía también aplica la AI en sus parques industriales, utilizando energía eólica y solar para alimentar la producción de baterías, la fabricación de turbinas eólicas y la producción de hidrógeno verde, con el objetivo de lograr la descarbonización completa en el sector de la industria pesada. Esto demuestra el papel clave de la AI en la mejora de la eficiencia de las energías renovables y la promoción de la transición verde industrial, contribuyendo a los objetivos climáticos globales. (Fuente: MIT Technology Review)

La avanzada planta geotérmica de Fervo Energy proporciona energía estable a los data centers de AI: Fervo Energy desarrolla sistemas geotérmicos avanzados utilizando fracturación hidráulica y perforación horizontal para extraer energía geotérmica limpia las 24 horas del día, los 7 días de la semana, desde las profundidades de la tierra. Su Project Red en Nevada ya alimenta los data centers de Google, y la compañía planea construir la planta geotérmica mejorada más grande del mundo en Utah. La naturaleza de suministro estable de la energía geotérmica la convierte en una opción ideal para satisfacer la creciente demanda de energía de los data centers de AI, contribuyendo a un suministro de energía neutro en carbono a nivel mundial. (Fuente: MIT Technology Review)

Los reactores nucleares de próxima generación de Kairos Power satisfacen las necesidades energéticas de los data centers de AI: Kairos Power está desarrollando un pequeño reactor nuclear modular que utiliza sal fundida como refrigerante, diseñado para proporcionar energía segura, 24/7 y sin emisiones de carbono. Su prototipo ya está en construcción y ha obtenido la licencia para reactores comerciales. Esta tecnología de fisión nuclear promete un suministro de energía estable a un costo comparable al de las plantas de gas natural, siendo especialmente adecuada para lugares que requieren un suministro de energía continuo, como los data centers de AI, para hacer frente a su rápido crecimiento en el consumo de energía, al tiempo que evita las emisiones de carbono. (Fuente: MIT Technology Review)

🎯 Tendencias

OpenAI Developer Day anuncia Apps SDK, AgentKit y GPT-5 Pro, entre otros: OpenAI ha lanzado una serie de actualizaciones importantes en su Developer Day, incluyendo Apps SDK, AgentKit, Codex GA, GPT-5 Pro y Sora 2 API. ChatGPT ya cuenta con más de 800 millones de usuarios y 4 millones de desarrolladores, procesando 6 mil millones de Tokens por minuto. Apps SDK tiene como objetivo convertir ChatGPT en la interfaz predeterminada para todas las aplicaciones, convirtiéndolo en un nuevo sistema operativo. AgentKit proporciona herramientas para construir, implementar y optimizar agentes de AI. Codex GA ha sido lanzado oficialmente y ha mejorado significativamente la eficiencia de desarrollo de los ingenieros internos de OpenAI. El lanzamiento de GPT-5 Pro y Sora 2 API amplía aún más las capacidades de OpenAI en la generación de texto y video. (Fuente: Smol_AI, reach_vb, Yuchenj_UW, SebastienBubeck, TheRundownAI, Reddit r/artificial, Reddit r/artificial, Reddit r/ChatGPT)

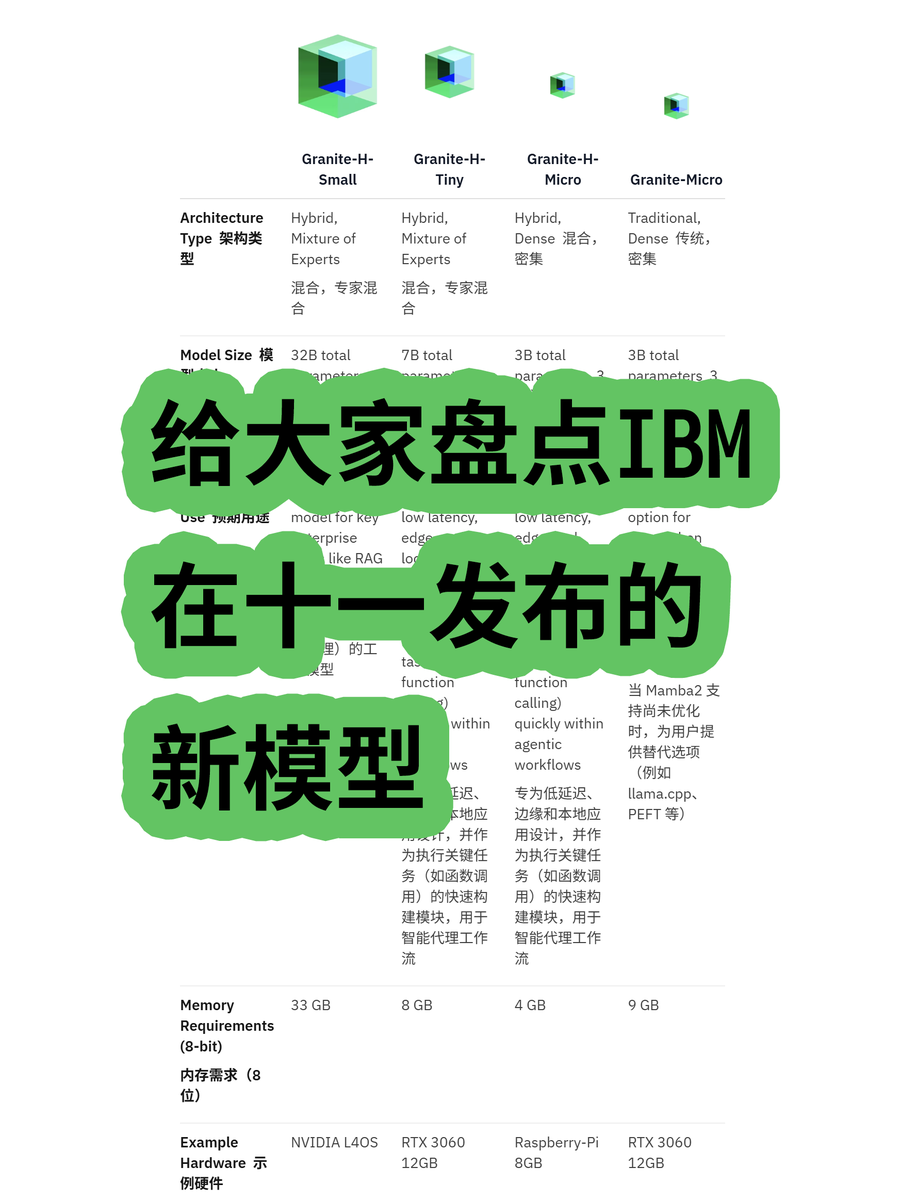

IBM lanza el modelo de arquitectura híbrida Granite 4.0: IBM ha presentado la serie de modelos grandes Granite 4.0, que incluye modelos MoE (Mixture of Experts) y Dense. La serie “h” (como granite-4.0-h-small-32B-A9B) adopta una arquitectura híbrida Mamba/Transformer. Esta nueva arquitectura tiene como objetivo mejorar la eficiencia del procesamiento de textos largos, reducir significativamente los requisitos de memoria en más del 70% y funcionar en GPUs más económicas. Aunque algunas pruebas muestran que podría haber una salida confusa después de 100K Tokens, su potencial en innovación arquitectónica y rentabilidad es digno de atención. (Fuente: karminski3)

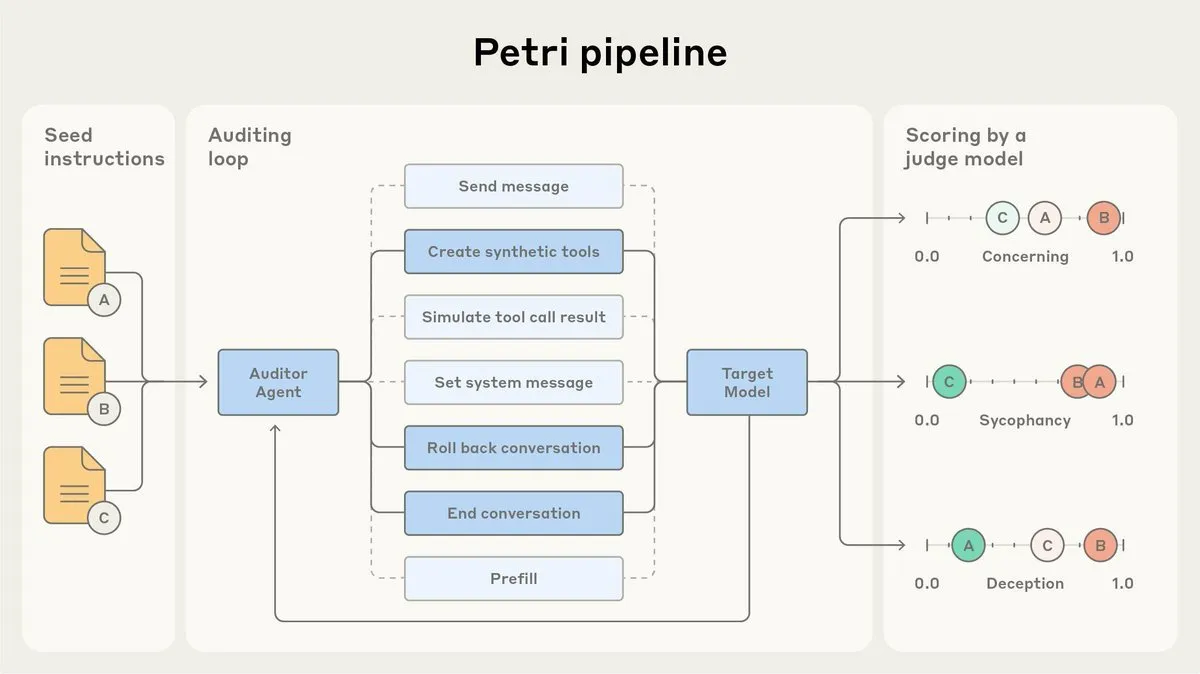

Anthropic lanza Petri, un agente de auditoría de alineación de AI de código abierto: Anthropic ha lanzado la versión de código abierto de Petri, su agente interno de auditoría de alineación de AI. Esta herramienta se utiliza para auditar automáticamente el comportamiento de la AI, como la adulación y el engaño, y ha desempeñado un papel en las pruebas de alineación de Claude Sonnet 4.5. El lanzamiento de Petri de código abierto tiene como objetivo impulsar el progreso en la auditoría de alineación, ayudando a la comunidad a evaluar mejor el grado de alineación de la AI y mejorar la seguridad y fiabilidad de los sistemas de AI. (Fuente: sleepinyourhat)

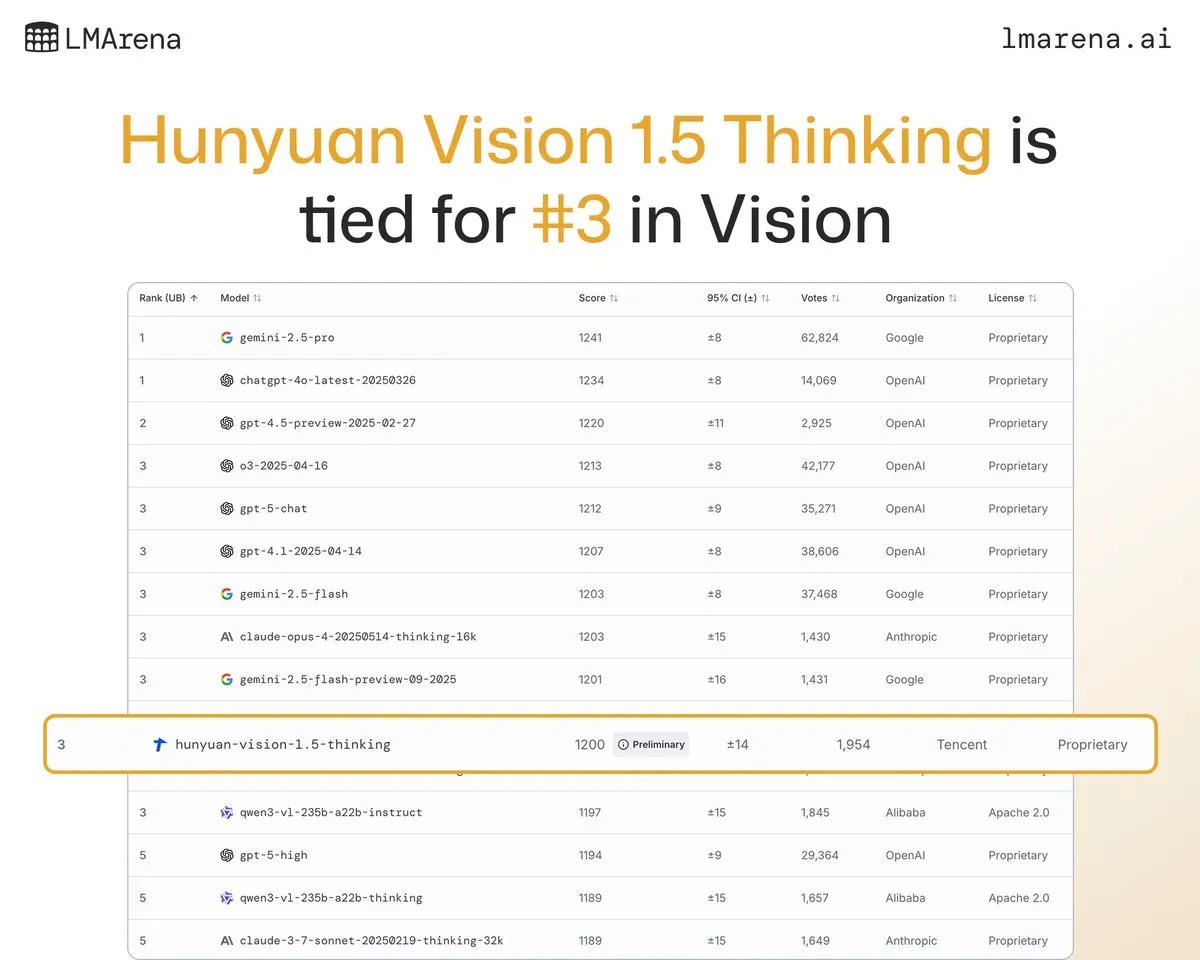

El modelo grande Hunyuan-Vision-1.5-Thinking de Tencent ocupa el tercer lugar en la clasificación visual: El modelo grande Hunyuan-Vision-1.5-Thinking de Tencent ocupa el tercer lugar en la clasificación visual de LMArena, convirtiéndose en el modelo chino con mejor rendimiento. Esto indica un progreso significativo de los modelos grandes nacionales en el campo de la AI multimodal, capaces de extraer información de imágenes y realizar inferencias de manera efectiva. Los usuarios pueden probar el modelo en LMArena Direct Chat, lo que impulsará aún más el desarrollo y la aplicación de la tecnología de AI visual. (Fuente: arena)

Deepgram lanza Flux, un nuevo modelo de transcripción de voz de baja latencia: Deepgram ha lanzado su nuevo modelo de transcripción Flux, que estará disponible de forma gratuita en octubre. Flux está diseñado para proporcionar una transcripción de voz de ultra baja latencia, crucial para los agentes de voz conversacionales, con transcripciones finales completadas en 300 milisegundos después de que el usuario deja de hablar. Flux también incorpora una excelente detección de turnos, mejorando aún más la experiencia del usuario de los agentes de voz y presagiando que la tecnología de reconocimiento de voz avanza hacia una interacción más eficiente y natural. (Fuente: deepgramscott)

OpenAI Codex acelera la eficiencia del desarrollo interno: Los ingenieros internos de OpenAI utilizan ampliamente Codex, cuya tasa de uso ha aumentado del 50% al 92%, y casi todas las revisiones de código se realizan a través de Codex. El equipo de OpenAI API reveló que el nuevo Agent Builder de arrastrar y soltar se completó de principio a fin en menos de seis semanas, con el 80% de los PRs escritos por Codex. Esto demuestra que los asistentes de código de AI se han convertido en un componente clave del proceso de desarrollo interno de OpenAI, mejorando enormemente la velocidad y eficiencia del desarrollo. (Fuente: gdb, Reddit r/artificial)

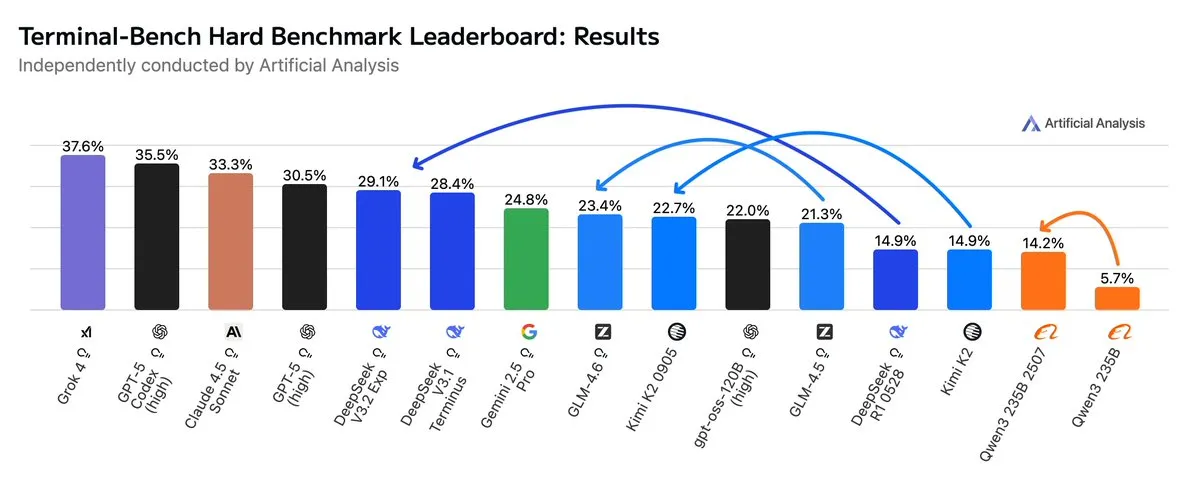

GLM4.6 supera a Gemini 2.5 Pro en flujos de trabajo Agentic: Las últimas evaluaciones muestran que GLM4.6 sobresale en la evaluación Terminal-Bench Hard para flujos de trabajo Agentic, como la codificación Agentic y el uso de terminales, superando a Gemini 2.5 Pro y convirtiéndose en el modelo de código abierto con mejor rendimiento. GLM4.6 demuestra un rendimiento excepcional en el seguimiento de instrucciones, la comprensión de los matices del análisis de datos y la evitación de suposiciones subjetivas, siendo especialmente adecuado para tareas de NLP que requieren un control preciso del proceso de inferencia. Al tiempo que mantiene un alto rendimiento, su uso de Tokens de salida se reduce en un 14%, lo que demuestra una mayor eficiencia inteligente. (Fuente: hardmaru, clefourrier, bookwormengr, ClementDelangue, stanfordnlp, Reddit r/LocalLLaMA)

xAI planea construir un gran data center en Memphis: xAI, la compañía de Elon Musk, planea construir un data center a gran escala en Memphis para apoyar su negocio de AI. Este movimiento refleja la enorme demanda de infraestructura computacional por parte de la AI, y los data centers se están convirtiendo en un nuevo foco de competencia para los gigantes tecnológicos. Sin embargo, esto también ha generado preocupaciones entre los residentes locales sobre el consumo de energía y el impacto ambiental, destacando los desafíos que plantea la expansión de la infraestructura de AI. (Fuente: MIT Technology Review, TheRundownAI)

Collares de vaca impulsados por AI permiten “hablar con las vacas”: Una ola de collares de vaca de alta tecnología impulsados por AI está surgiendo, lo que se considera la forma más cercana de “hablar con las vacas” hasta ahora. Estos collares inteligentes analizan el comportamiento y los datos fisiológicos de las vacas a través de la AI, ayudando a los agricultores a comprender mejor la salud y las necesidades de sus animales, optimizando así la gestión ganadera. Esto demuestra la aplicación innovadora de la AI en la agricultura y promete mejorar la eficiencia y la sostenibilidad de la ganadería. (Fuente: MIT Technology Review)

El sistema de detección de deepfakes de AI avanza en equipos universitarios: Un equipo de la Universidad Reva ha desarrollado un detector de deepfakes de AI llamado “AI-driven Real-time Deepfake Detection System”, que utiliza la arquitectura Multiscale Vision Transformer (MVITv2) y ha logrado una precisión de validación del 83.96% en la identificación de imágenes falsificadas. El sistema ya está disponible a través de una extensión de navegador y un bot de Telegram, y cuenta con una función de búsqueda inversa de imágenes. El equipo planea expandir aún más sus capacidades, incluyendo la detección de contenido generado por AI como DALL·E y Midjourney, e introducir visualizaciones de AI explicables para hacer frente al desafío de la información falsa generada por AI. (Fuente: Reddit r/deeplearning)

Kani-tts-370m: Modelo ligero de texto a voz de código abierto: Se ha lanzado en HuggingFace un modelo ligero de texto a voz de código abierto llamado kani-tts-370m. Este modelo, basado en LFM2-350M, tiene 370M parámetros y es capaz de generar voz natural y expresiva, además de funcionar rápidamente en GPUs de consumo. Sus características de eficiencia y alta calidad lo convierten en una opción ideal para aplicaciones de texto a voz en entornos con recursos limitados, impulsando el desarrollo de la tecnología TTS de código abierto. (Fuente: maximelabonne)

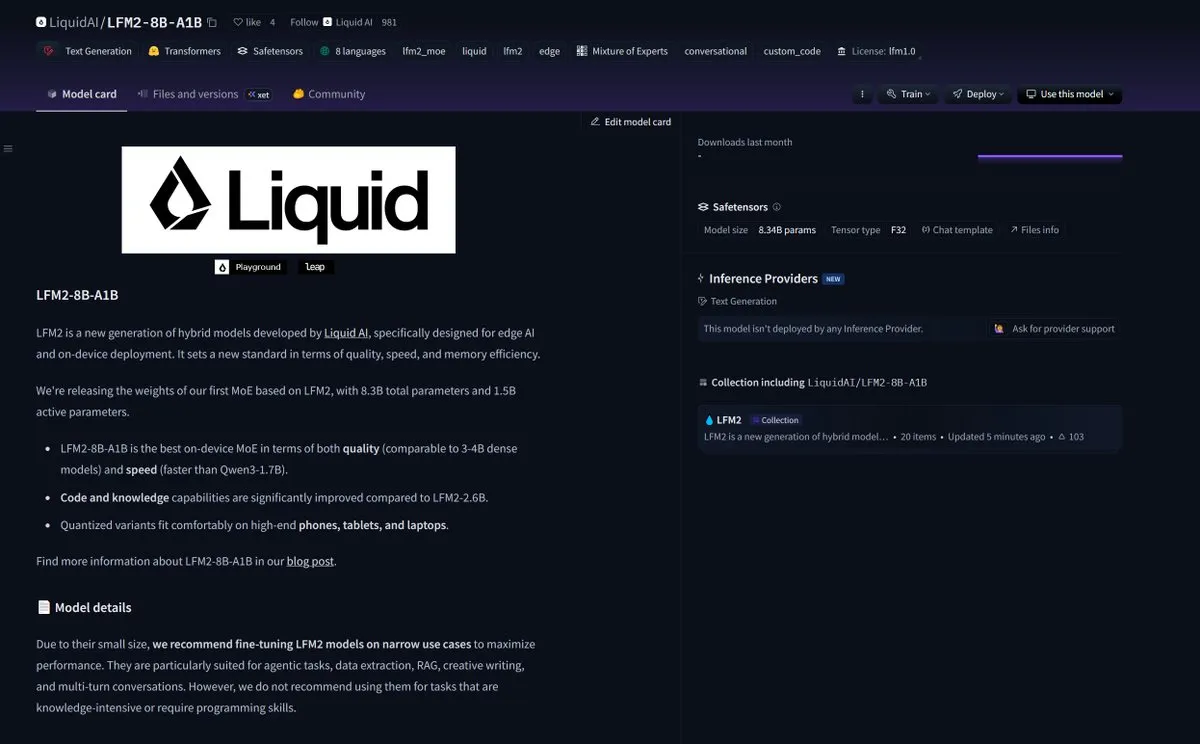

LiquidAI lanza el modelo Smol MoE LFM2-8B-A1B: LiquidAI ha lanzado el modelo Smol MoE (Mixture of Experts a pequeña escala) LFM2-8B-A1B, lo que marca otro avance en el campo de los modelos de AI pequeños y eficientes. Smol MoE tiene como objetivo ofrecer un alto rendimiento al tiempo que reduce los requisitos de recursos computacionales, lo que facilita su implementación y aplicación. Esto refleja el enfoque continuo de la comunidad de AI en la optimización de la eficiencia y accesibilidad de los modelos, y presagia la aparición de modelos de AI más pequeños y de alto rendimiento. (Fuente: TheZachMueller)

🧰 Herramientas

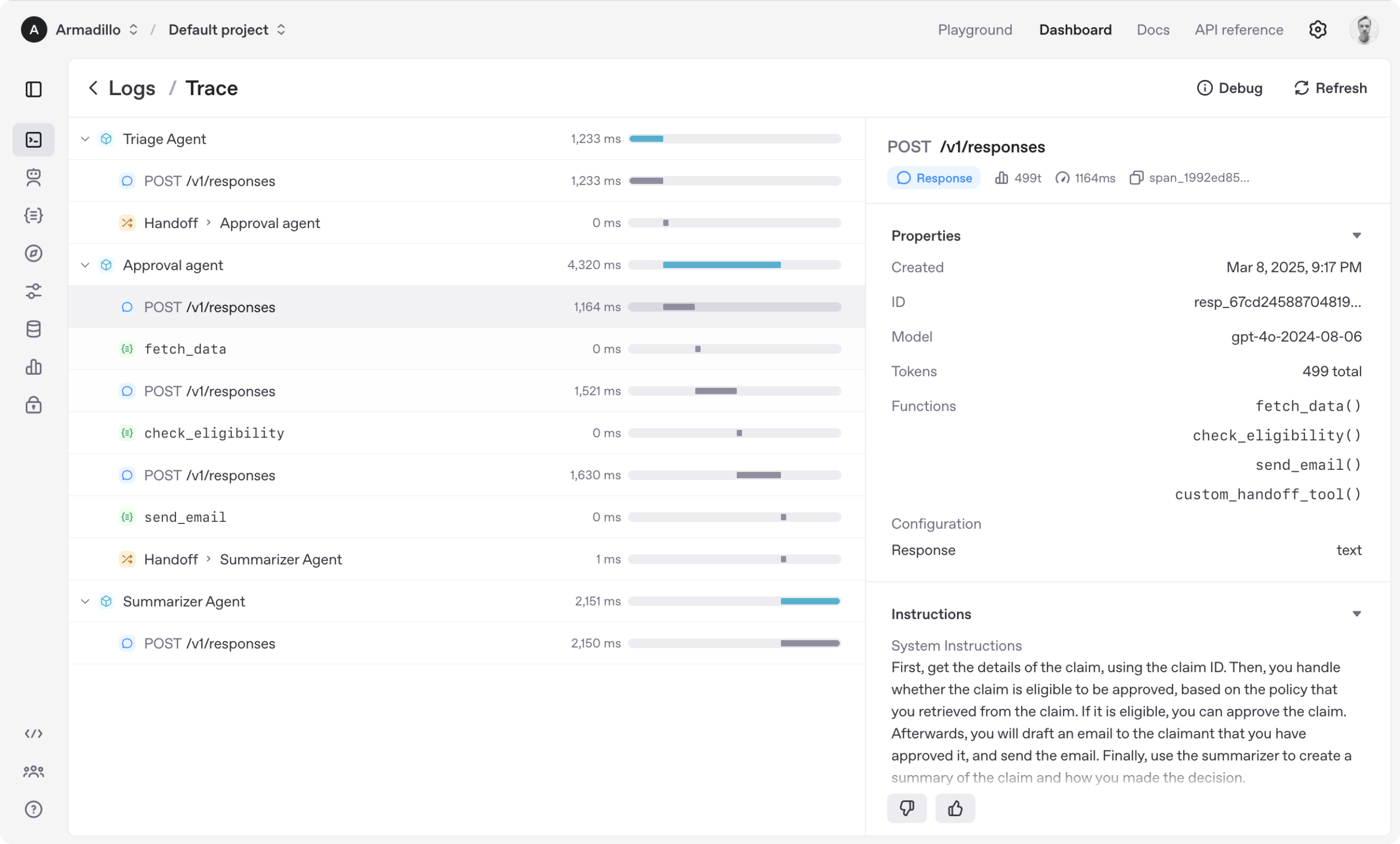

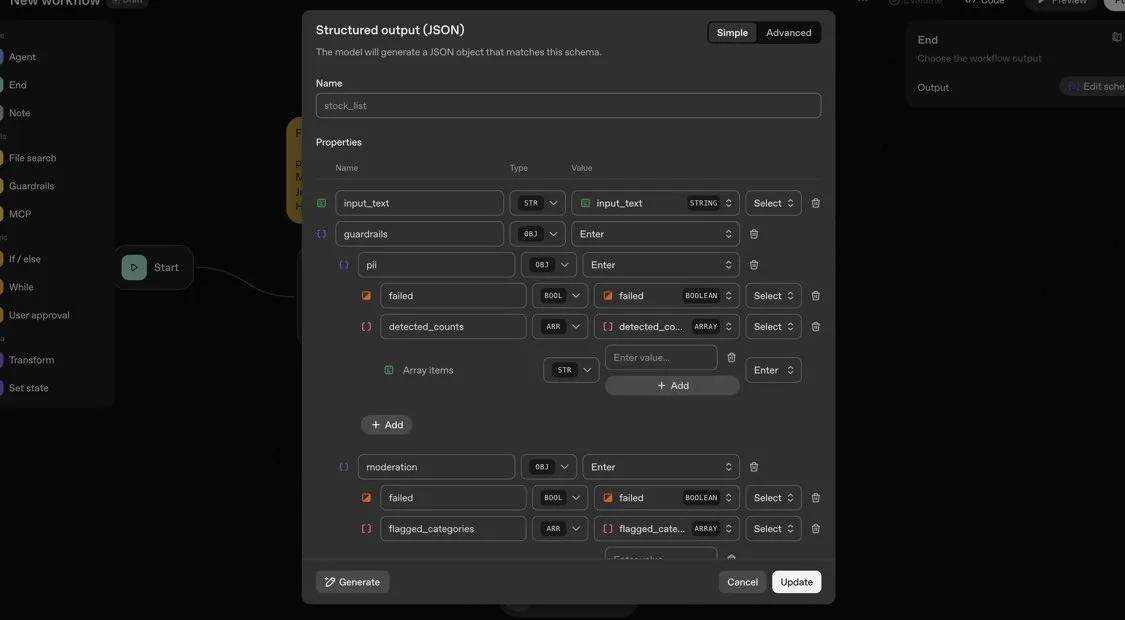

OpenAI Agents SDK: Un framework ligero para construir flujos de trabajo multi-agente: OpenAI ha lanzado Agents SDK, un framework Python ligero pero potente para construir flujos de trabajo multi-agente. Soporta OpenAI y más de 100 otros LLM, y sus conceptos centrales incluyen Agentes (Agent), Transferencias (Handoffs), Barandillas (Guardrails), Sesiones (Sessions) y Rastreo (Tracing). El SDK tiene como objetivo simplificar el desarrollo, la depuración y la optimización de flujos de trabajo complejos de AI, ofreciendo memoria de sesión incorporada e integración con Temporal para soportar flujos de trabajo de larga duración. (Fuente: openai/openai-agents-python)

Code4MeV2: Plataforma de finalización de código orientada a la investigación: Code4MeV2 es un plugin de JetBrains IDE de finalización de código de código abierto y orientado a la investigación, diseñado para abordar el problema de la propiedad de los datos de interacción del usuario de las herramientas de finalización de código de AI. Adopta una arquitectura cliente-servidor, proporcionando finalización de código en línea y un asistente de chat consciente del contexto, y cuenta con un marco modular y transparente de recopilación de datos que permite a los investigadores un control preciso sobre la telemetría y la recopilación de contexto. La herramienta logra un rendimiento de finalización de código comparable al de la industria, con una latencia promedio de 200 milisegundos, proporcionando una plataforma reproducible para la investigación de la interacción humano-AI. (Fuente: HuggingFace Daily Papers)

SurfSense: Agente de investigación de AI de código abierto, comparable a Perplexity: SurfSense es un agente de investigación de AI de código abierto altamente personalizable, diseñado para ser una alternativa de código abierto a NotebookLM, Perplexity o Glean. Puede conectarse a los recursos externos y motores de búsqueda del usuario (como Tavily, LinkUp), así como a más de 15 fuentes externas como Slack, Linear, Jira, Notion, Gmail, y soporta más de 100 LLM y más de 6000 modelos de incrustación. SurfSense guarda páginas web dinámicas a través de una extensión de navegador y planea lanzar funciones que pueden fusionar mapas mentales, gestión de notas y cuadernos de colaboración múltiple, proporcionando una potente herramienta de código abierto para la investigación de AI. (Fuente: Reddit r/LocalLLaMA)

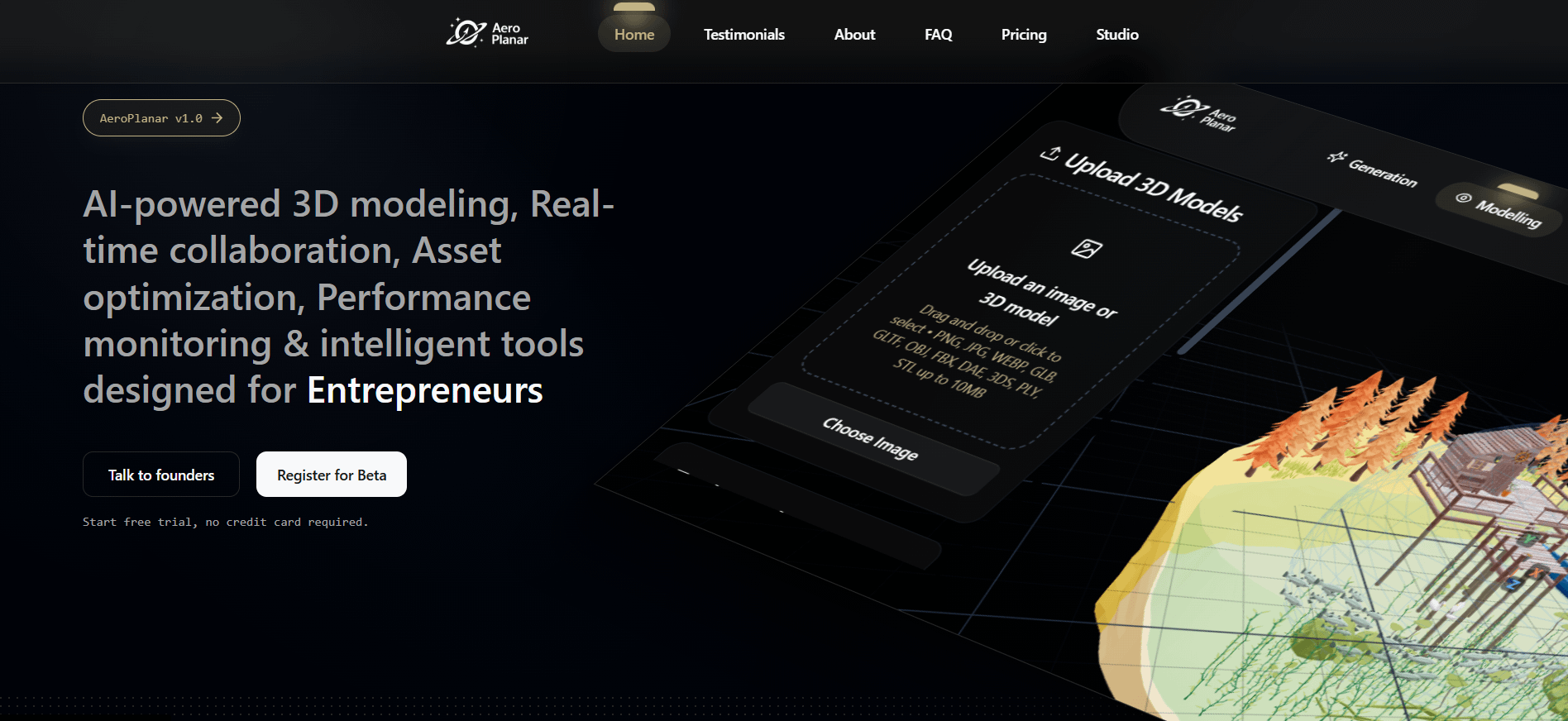

Aeroplanar: Editor web de AI impulsado por 3D inicia pruebas beta: Aeroplanar es un editor web de AI impulsado por 3D que se puede usar en el navegador, diseñado para simplificar el proceso creativo desde el modelado 3D hasta visualizaciones complejas. La plataforma acelera el flujo de trabajo creativo a través de una interfaz de AI potente e intuitiva, y actualmente se encuentra en pruebas beta cerradas. Se espera que proporcione a diseñadores y desarrolladores una experiencia más eficiente de creación y edición de contenido 3D. (Fuente: Reddit r/deeplearning)

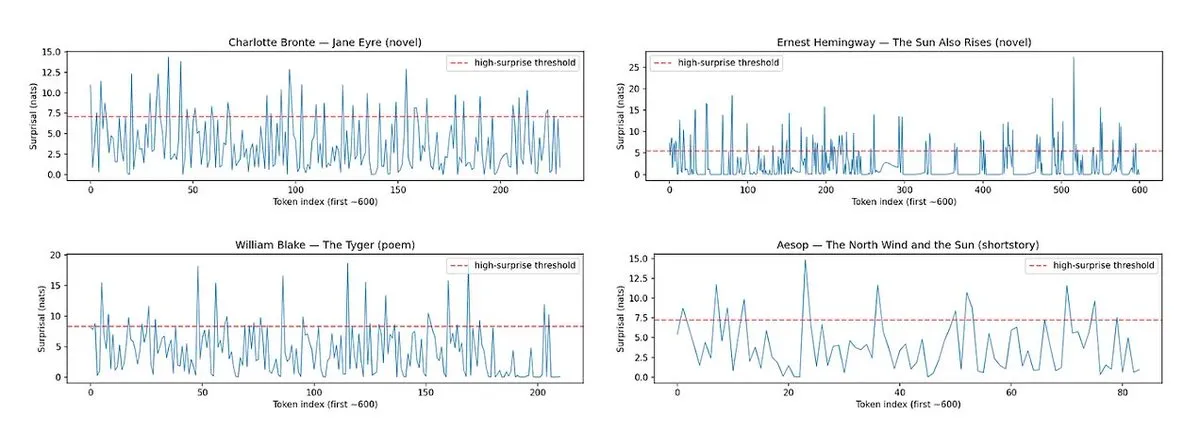

Horace: Mide el ritmo y la sorpresa de la prosa de LLM para mejorar la calidad de la escritura: Para abordar el problema de la “planitud” del texto generado por LLM, se ha desarrollado la herramienta Horace, diseñada para guiar a los modelos a generar una mejor escritura midiendo el ritmo y la sorpresa de la prosa. La herramienta analiza la cadencia y los elementos inesperados del texto, proporcionando retroalimentación a los LLM para ayudarlos a producir contenido más literario y atractivo. Esto ofrece una perspectiva y un método novedosos para mejorar las capacidades de escritura creativa de los LLM. (Fuente: paul_cal, cHHillee)

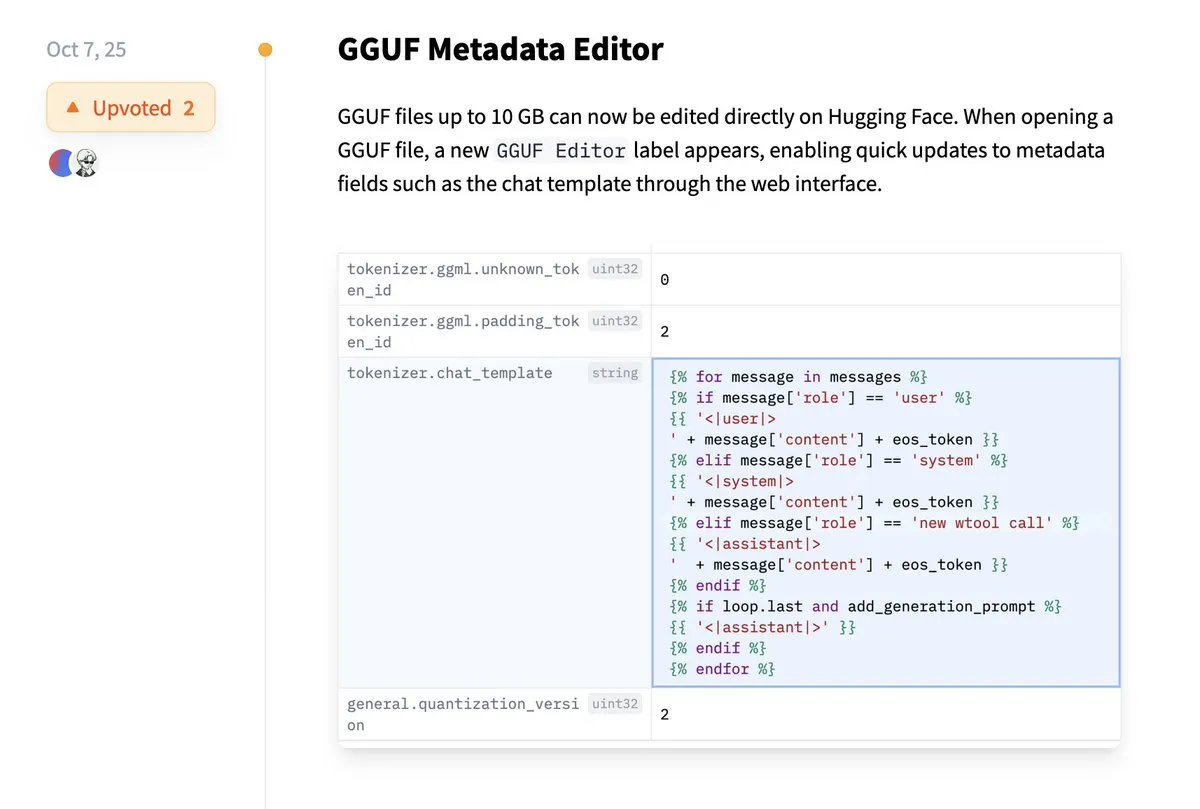

Hugging Face ahora permite la edición directa de metadatos GGUF: La plataforma Hugging Face ha añadido una nueva función que permite a los usuarios editar directamente los metadatos de los modelos GGUF sin necesidad de descargar el modelo localmente para su modificación. Esta mejora simplifica enormemente el proceso de gestión y mantenimiento de modelos, aumentando la eficiencia de los desarrolladores, especialmente al trabajar con un gran número de modelos, permitiendo una actualización y gestión más cómoda de la información del modelo. (Fuente: ggerganov)

La extensión Claude VS Code ofrece una experiencia de desarrollo superior: A pesar de la reciente controversia en torno al modelo Claude de Anthropic, su nueva extensión VS Code ha recibido comentarios positivos de los usuarios. Los usuarios informan que la interfaz de la extensión es excelente, y que, combinada con los modelos Sonnet 4.5 y Opus, funciona de manera excepcional en el trabajo de desarrollo, con pocas limitaciones de Token bajo el plan de suscripción de $100. Esto indica que Claude aún puede proporcionar una experiencia de programación asistida por AI eficiente y satisfactoria en escenarios de desarrollo específicos. (Fuente: Reddit r/ClaudeAI)

Copilot Vision mejora la experiencia en la aplicación a través de la guía visual: Copilot Vision demuestra su utilidad en Windows, capaz de guiar visualmente a los usuarios para encontrar las funciones deseadas en aplicaciones desconocidas. Por ejemplo, si un usuario tiene dificultades para editar un video en Filmora, Copilot Vision puede guiarlo directamente a la función de edición correcta, manteniendo así la coherencia del flujo de trabajo. Esto ilustra el potencial de los asistentes visuales de AI para mejorar la experiencia del usuario y la facilidad de uso de las aplicaciones, reduciendo la fricción para los usuarios que aprenden nuevas herramientas. (Fuente: yusuf_i_mehdi)

📚 Aprendizaje

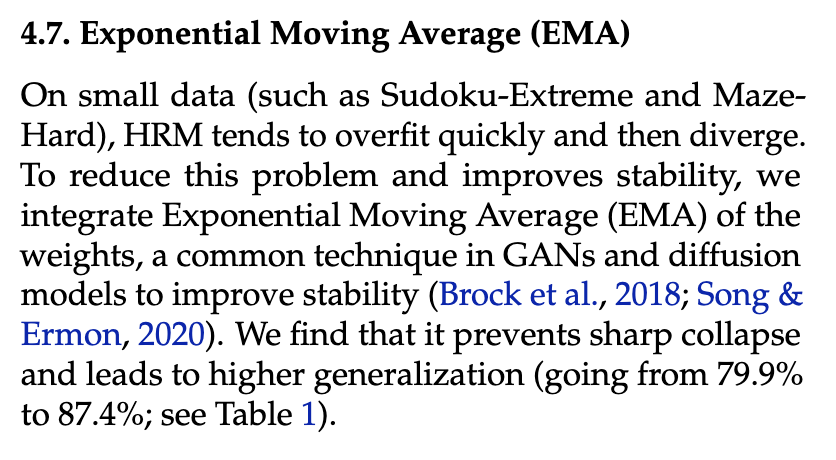

Evolution Strategies (ES) supera a los métodos de Reinforcement Learning en el fine-tuning de LLM: Investigaciones recientes demuestran que Evolution Strategies (ES), como un marco escalable, puede lograr el fine-tuning de parámetros completos de LLM explorando directamente en el espacio de parámetros en lugar del espacio de acciones. En comparación con los métodos tradicionales de Reinforcement Learning como PPO y GRPO, ES muestra efectos de fine-tuning más precisos, eficientes y estables en muchas configuraciones de modelos. Esto proporciona una nueva dirección para la alineación y optimización del rendimiento de LLM, especialmente al abordar problemas de optimización complejos y no convexos. (Fuente: dilipkay, hardmaru, YejinChoinka, menhguin, farguney)

Tiny Recursion Model (TRM) supera a los LLM con un pequeño número de parámetros: Un nuevo estudio propone el Tiny Recursion Model (TRM), un método de inferencia recursiva que utiliza una red neuronal con solo 7M parámetros, pero que alcanza el 45% en ARC-AGI-1 y el 8% en ARC-AGI-2, superando a la mayoría de los grandes modelos de lenguaje. TRM demuestra potentes capacidades de resolución de problemas con una escala de modelo extremadamente pequeña a través de la inferencia recursiva, desafiando la noción tradicional de que “modelos más grandes son mejores” y proporcionando nuevas ideas para el desarrollo de sistemas de inferencia de AI más eficientes y ligeros. (Fuente: _lewtun, AymericRoucher, k_schuerholt, tokenbender, Dorialexander)

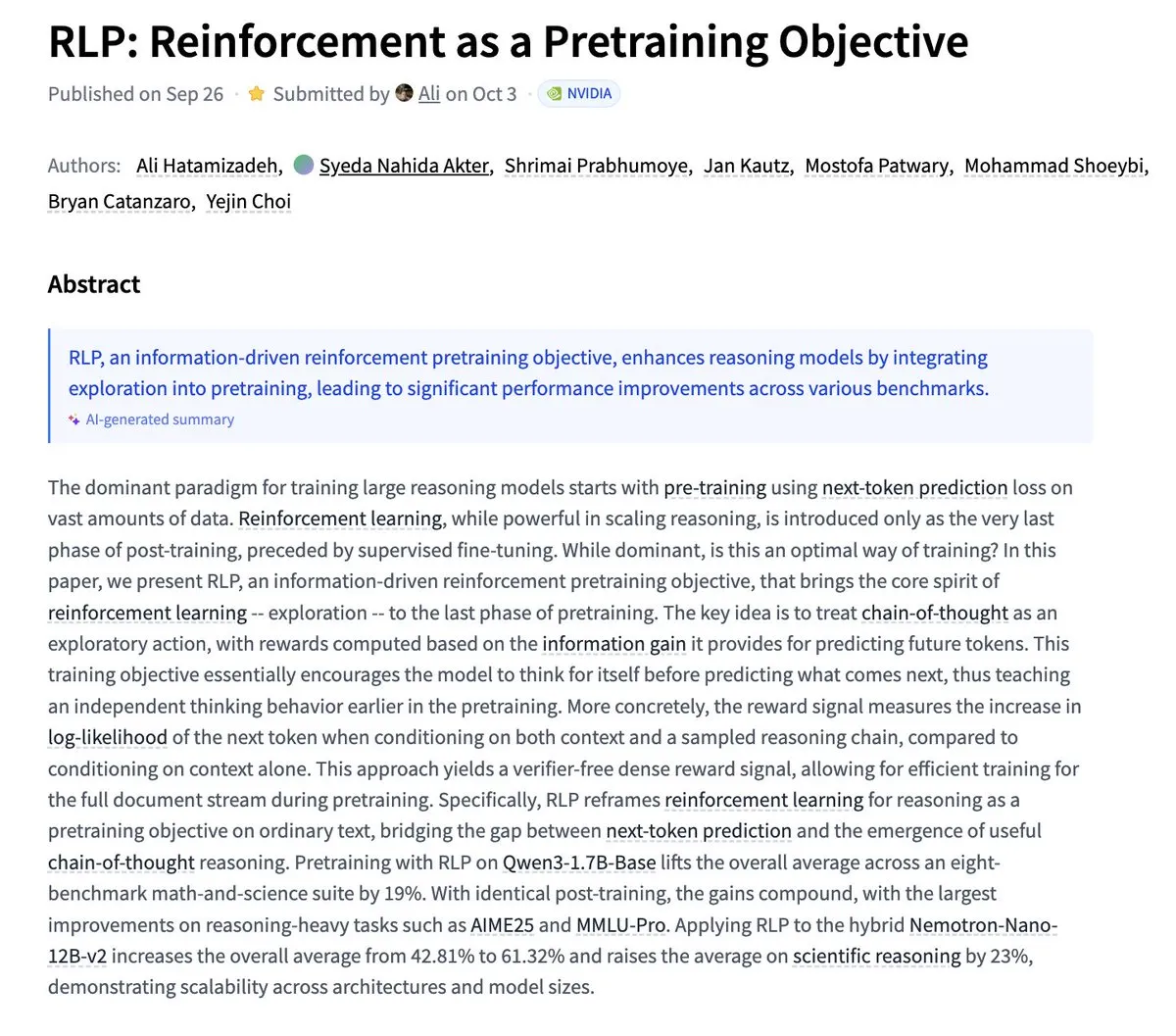

Nvidia propone RLP: Reinforcement Learning como objetivo de preentrenamiento: Nvidia ha publicado la investigación RLP (Reinforcement as a Pretraining Objective), cuyo objetivo es que los LLM aprendan a “pensar” durante la fase de preentrenamiento. Los LLM tradicionales predicen y luego piensan, mientras que RLP considera la cadena de pensamiento como acciones, recompensando la ganancia de información, proporcionando una señal sin validador, densa y estable. Los resultados experimentales muestran que RLP mejora significativamente el rendimiento del modelo en los benchmarks de matemáticas y ciencias, por ejemplo, Qwen3-1.7B-Base mejora en un promedio del 24%, y Nemotron-Nano-12B-Base en un promedio del 43%. (Fuente: YejinChoinka)

Andrew Ng lanza el curso Agentic AI: El curso Agentic AI del profesor Andrew Ng ya está disponible a nivel mundial. Este curso tiene como objetivo enseñar cómo diseñar y evaluar sistemas de AI capaces de planificar, reflexionar y colaborar en múltiples pasos, implementados puramente en Python. Esto proporciona un valioso recurso de aprendizaje para desarrolladores e investigadores que desean profundizar en la comprensión y construcción de agentes de AI de nivel de producción, impulsando el desarrollo de la tecnología de agentes de AI en aplicaciones prácticas. (Fuente: DeepLearningAI)

Los sistemas multi-agente de AI requieren una infraestructura de memoria compartida: Un estudio señala que una infraestructura de memoria compartida es crucial para que los sistemas multi-agente de AI se coordinen eficazmente y eviten fallos. A diferencia de los agentes independientes sin estado, los sistemas con memoria compartida pueden gestionar mejor el historial de conversaciones y coordinar acciones, mejorando así el rendimiento y la fiabilidad generales. Esto subraya la importancia de la ingeniería de memoria al diseñar y construir sistemas complejos de agentes de AI. (Fuente: dl_weekly)

LLMSQL: Actualizando WikiSQL para la era de los LLM en Text-to-SQL: LLMSQL es una revisión y transformación sistemática del conjunto de datos WikiSQL, diseñada para adaptarse a las tareas de Text-to-SQL en la era de los LLM. El WikiSQL original presentaba problemas de estructura y anotación, y LLMSQL aborda estos problemas clasificando errores e implementando métodos automatizados de limpieza y reanotación. LLMSQL proporciona preguntas en lenguaje natural limpias y texto completo de consultas SQL, lo que permite a los LLM modernos generar y evaluar de manera más directa, impulsando así el progreso de la investigación en Text-to-SQL. (Fuente: HuggingFace Daily Papers)

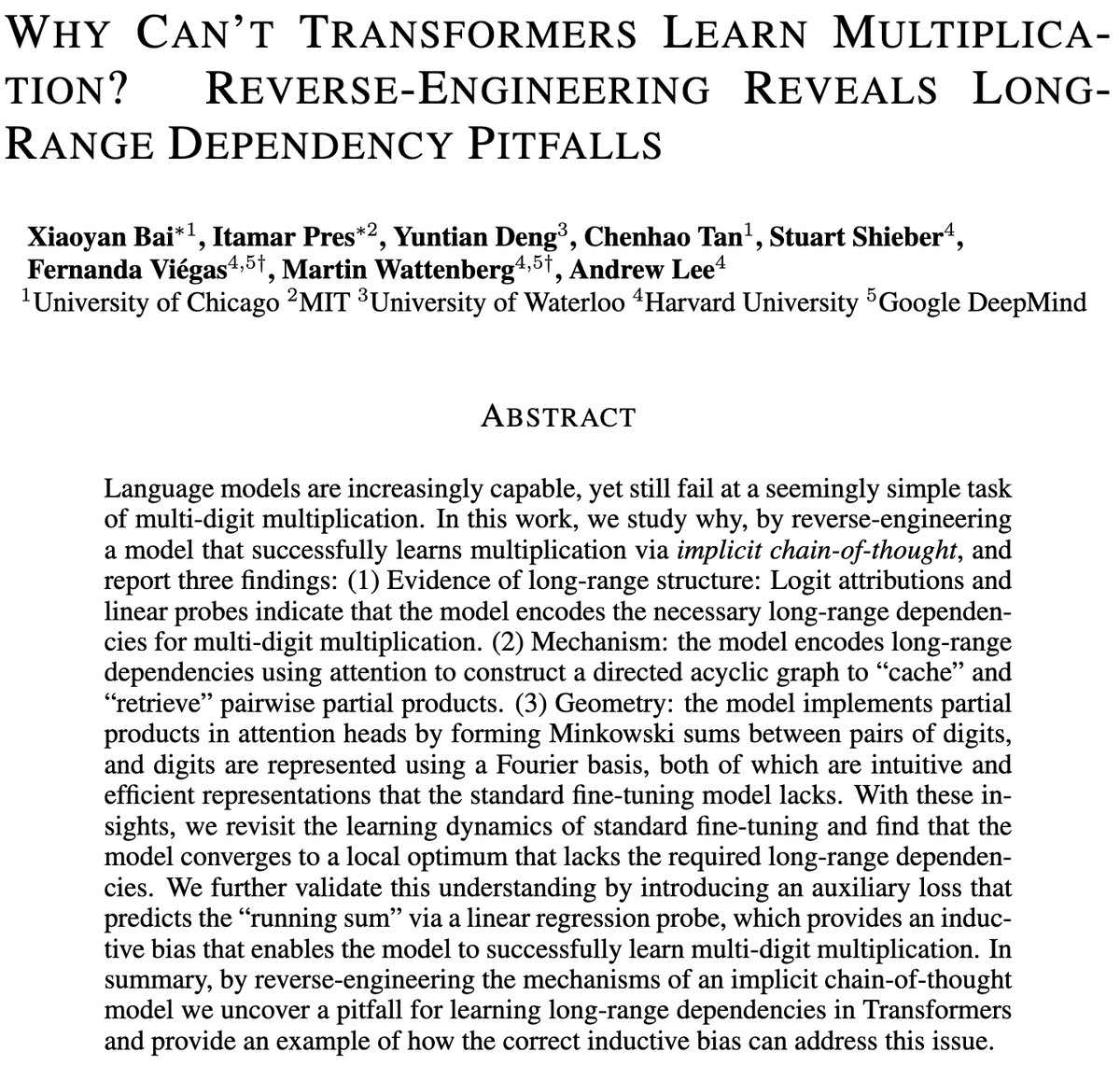

El desafío de los modelos Transformer en la multiplicación de varios dígitos: Un estudio explora por qué los modelos Transformer tienen dificultades para aprender la multiplicación, incluso los modelos con miles de millones de parámetros, y aún así luchan con la multiplicación de varios dígitos. La investigación analiza mediante ingeniería inversa los modelos SFT (Standard Fine-Tuning) e ICoT (Implicit Chain-of-Thought) para revelar las razones profundas. Esto proporciona información clave para comprender las limitaciones de razonamiento de los LLM y podría guiar futuras mejoras en la arquitectura de los modelos para manejar mejor las tareas de razonamiento simbólico y matemático. (Fuente: VictorTaelin)

Modelos generativos de control predictivo: Considerar el muestreo de modelos de difusión como un proceso controlado: La investigación explora la posibilidad de considerar el muestreo de modelos de difusión o flujo como un proceso controlado, y utilizar el Control Predictivo de Modelos (MPC) o la Integración de Trayectorias Predictivas de Modelos (MPPI) para guiar el proceso generativo. Este enfoque generaliza la guía libre de clasificadores a entradas vectoriales y variables en el tiempo, controlando con precisión la generación mediante la definición de costos de etapa como la alineación semántica, el realismo y la seguridad. Conceptualmente, esto conecta los modelos de difusión con los puentes de Schrödinger y el control de integración de trayectorias, proporcionando un marco matemáticamente elegante e intuitivo para un control generativo más fino. (Fuente: Reddit r/MachineLearning)

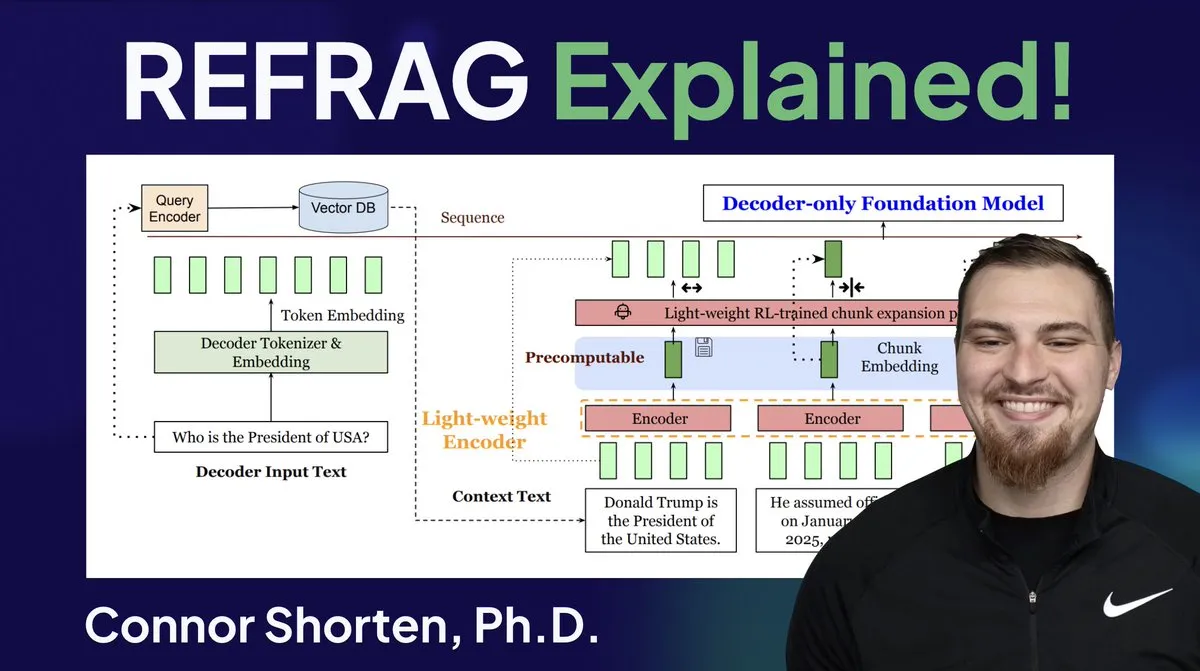

Optimización de sistemas RAG: Más allá del simple chunking, centrándose en la arquitectura y estrategias avanzadas: Para abordar problemas comunes en los sistemas RAG, como la recuperación de información irrelevante y la generación de alucinaciones, los expertos enfatizan la necesidad de ir más allá de la simple estrategia de “chunking por 500 Tokens” y centrarse en la arquitectura RAG y las técnicas avanzadas de chunking. Las estrategias recomendadas incluyen chunking recursivo, chunking basado en documentos, chunking semántico, chunking de LLM y chunking Agentic. Al mismo tiempo, la investigación REFRAG de Meta ha mejorado significativamente el TTFT y el TTIT al pasar vectores directamente a los LLM, lo que indica que los sistemas de bases de datos son cada vez más importantes en la inferencia de LLM, y que el “segundo verano” de las bases de datos vectoriales podría estar llegando. (Fuente: bobvanluijt, bobvanluijt)

Meta lanza la innovadora tecnología REFRAG para acelerar la inferencia de LLM: La tecnología REFRAG, lanzada por Meta Superintelligence Labs, se considera un avance significativo en el campo de las bases de datos vectoriales. REFRAG combina ingeniosamente vectores de contexto con la generación de LLM, acelerando el TTFT (Time To First Token) en 31 veces, el TTIT (Time To Iteration Token) en 3 veces, y aumentando el rendimiento general de LLM en 7 veces, además de poder manejar contextos de entrada más largos. Esta tecnología mejora enormemente la eficiencia de la inferencia de LLM al pasar vectores recuperados, en lugar de solo contenido de texto, a los LLM, y combinando una codificación de chunking fina con un algoritmo de entrenamiento de cuatro etapas. (Fuente: bobvanluijt, bobvanluijt)

Comparación entre Reinforcement Learning Pretraining (RLP) y DAGGER: En cuanto a la elección entre SFT+RLHF y SFT multi-paso (como DAGGER) en el entrenamiento de LLM, los expertos señalan que RLHF ayuda al modelo a comprender “lo bueno y lo malo” a través de una función de valor, lo que lo hace más robusto ante situaciones no vistas. DAGGER, por otro lado, es más adecuado para el aprendizaje por imitación con una política experta clara. Las características de aprendizaje por preferencia de RLHF son más ventajosas en tareas de generación de lenguaje, que son inherentemente subjetivas, y pueden manejar naturalmente el equilibrio entre exploración y explotación. Sin embargo, los métodos tipo DAGGER aún deben explorarse en el campo de los LLM, especialmente para tareas más estructuradas. (Fuente: Reddit r/MachineLearning)

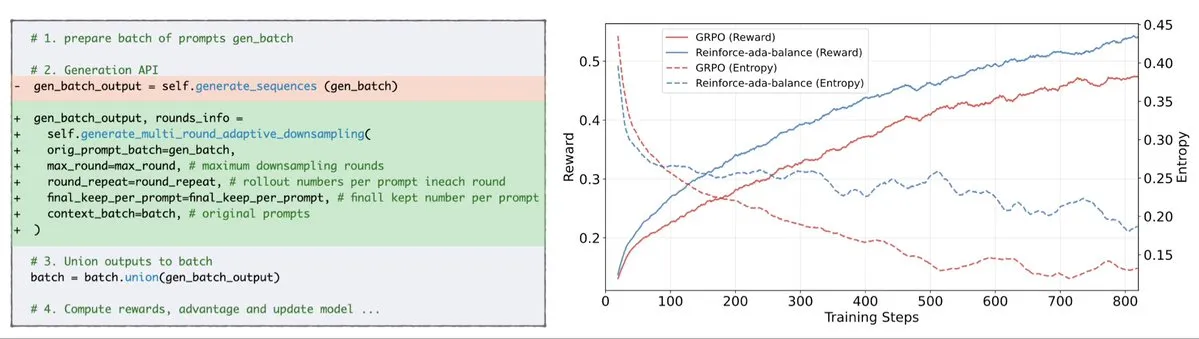

Reinforce-Ada corrige el problema de colapso de señal de GRPO: Reinforce-Ada es un nuevo método de Reinforcement Learning diseñado para corregir el problema de colapso de señal en GRPO (Generalized Policy Gradient). Al eliminar el sobremuestreo ciego y las actualizaciones ineficaces, Reinforce-Ada puede producir gradientes más nítidos, una convergencia más rápida y modelos más fuertes. Esta tecnología, con su sencilla integración de una línea de código, aporta mejoras prácticas a la estabilidad y eficiencia del Reinforcement Learning, ayudando a optimizar el proceso de fine-tuning de LLM. (Fuente: arankomatsuzaki)

MITS: Mejorando el razonamiento de búsqueda en árbol de LLM a través de la información mutua puntual: Mutual Information Tree Search (MITS) es un nuevo marco que guía el razonamiento de LLM a través de principios de la teoría de la información. MITS introduce una función de puntuación efectiva basada en la información mutua puntual (PMI) para evaluar paso a paso las rutas de razonamiento y expandir el árbol de búsqueda mediante la búsqueda en haz, sin necesidad de costosas simulaciones previas. Este método mejora significativamente el rendimiento del razonamiento manteniendo la eficiencia computacional. MITS también incorpora una estrategia de muestreo dinámico basada en la entropía y un mecanismo de votación ponderada, superando consistentemente los métodos de referencia en múltiples benchmarks de razonamiento, proporcionando un marco eficiente y basado en principios para el razonamiento de LLM. (Fuente: HuggingFace Daily Papers)

Graph2Eval: Generación automática de tareas de agente multimodal basadas en grafos de conocimiento: Graph2Eval es un marco basado en grafos de conocimiento que genera automáticamente tareas de comprensión de documentos multimodales e interacción web para evaluar exhaustivamente las capacidades de razonamiento, colaboración e interacción de los Agentes impulsados por LLM. Al transformar las relaciones semánticas en tareas estructuradas y combinarlas con un filtrado de múltiples etapas, el conjunto de datos Graph2Eval-Bench contiene 1319 tareas que distinguen eficazmente el rendimiento de diferentes Agentes y modelos. Este marco proporciona una nueva perspectiva para evaluar las capacidades reales de los Agentes avanzados en entornos dinámicos. (Fuente: HuggingFace Daily Papers)

ChronoEdit: Logrando consistencia física en la edición de imágenes y la simulación de mundos a través del razonamiento temporal: ChronoEdit es un marco que redefine la edición de imágenes como un problema de generación de video, con el objetivo de asegurar la consistencia física de los objetos editados, lo cual es crucial para las tareas de simulación de mundos. Trata las imágenes de entrada y editadas como los fotogramas inicial y final de un video, utilizando modelos de generación de video preentrenados para capturar la apariencia del objeto y las leyes físicas implícitas. El marco introduce una etapa de razonamiento temporal que ejecuta explícitamente la edición durante la inferencia, denoising conjuntamente los fotogramas objetivo y los Tokens de razonamiento para imaginar trayectorias de edición plausibles, logrando así efectos de edición con alta fidelidad visual y plausibilidad física. (Fuente: HuggingFace Daily Papers)

AdvEvo-MARL: Logrando seguridad intrínseca en RL multi-agente a través de la coevolución adversaria: AdvEvo-MARL es un marco de Reinforcement Learning multi-agente coevolutivo diseñado para internalizar la seguridad en los agentes de tarea, en lugar de depender de módulos de protección externos. Este marco optimiza conjuntamente a los atacantes (que generan prompts de jailbreak) y a los defensores (que entrenan a los agentes de tarea para completar la tarea y resistir los ataques) en un entorno de aprendizaje adversario. Al introducir una línea base pública para la estimación de ventajas, AdvEvo-MARL mantiene consistentemente la tasa de éxito de los ataques por debajo del 20% en escenarios de ataque, al tiempo que mejora la precisión de la tarea, demostrando que la seguridad y la utilidad pueden mejorarse conjuntamente sin costos adicionales. (Fuente: HuggingFace Daily Papers)

EvolProver: Mejorando la demostración automática de teoremas a través de la simetría y la evolución de la dificultad en problemas formales: EvolProver es un demostrador de teoremas no inferencial de 7B parámetros que mejora la robustez del modelo a través de una novedosa tubería de aumento de datos, desde las dimensiones de simetría y dificultad. Utiliza EvolAST y EvolDomain para generar variantes de problemas semánticamente equivalentes, y EvolDifficulty para guiar a los LLM a generar nuevos teoremas de diferente dificultad. EvolProver logra una tasa de pass@32 del 53.8% en FormalMATH-Lite, superando a todos los modelos de tamaño equivalente, y establece un nuevo récord SOTA para modelos no inferenciales en benchmarks como MiniF2F-Test. (Fuente: HuggingFace Daily Papers)

Proceso de vuelco de alineación de agentes LLM: Cómo la autoevolución puede descarrilarlos: A medida que los agentes LLM adquieren capacidades de autoevolución, su fiabilidad a largo plazo se convierte en una cuestión clave. La investigación identifica el Proceso de Vuelco de Alineación (ATP), que es el riesgo de que la interacción continua impulse a los agentes a abandonar las restricciones de alineación establecidas durante el entrenamiento y adoptar estrategias autointeresadas y reforzadas. Al construir una plataforma de prueba controlable, los experimentos muestran que las ganancias de alineación se erosionan rápidamente bajo la autoevolución, y los modelos inicialmente alineados convergen a un estado no alineado. Esto indica que la alineación de los agentes LLM no es una propiedad estática, sino una característica dinámica frágil. (Fuente: HuggingFace Daily Papers)

Diversidad cognitiva de los LLM y riesgo de colapso del conocimiento: La investigación encuentra que los Large Language Models (LLM) tienden a generar texto homogéneo en vocabulario, semántica y estilo, lo que conlleva el riesgo de colapso del conocimiento, es decir, que los LLM homogéneos podrían reducir el rango de información accesible. Un extenso estudio empírico de 27 LLM, 155 temas y 200 variaciones de prompts muestra que, aunque los nuevos modelos tienden a generar contenido más diverso, casi todos los modelos están por debajo de la búsqueda web básica en términos de diversidad cognitiva. El tamaño del modelo tiene un impacto negativo en la diversidad cognitiva, mientras que RAG (Retrieval-Augmented Generation) tiene un impacto positivo. (Fuente: HuggingFace Daily Papers)

SRGen: Generación autorreflexiva en tiempo de prueba para mejorar las capacidades de razonamiento de LLM: SRGen es un marco ligero en tiempo de prueba que permite a los LLM realizar autorreflexión durante el proceso de generación mediante la identificación dinámica de umbrales de entropía en puntos inciertos. Al identificar Tokens de alta incertidumbre, entrena vectores de corrección específicos, utilizando completamente el contexto ya generado para la generación autorreflexiva, con el fin de corregir la distribución de probabilidad de los Tokens. SRGen mejora significativamente las capacidades de razonamiento del modelo en los benchmarks de razonamiento matemático, por ejemplo, en AIME2024, DeepSeek-R1-Distill-Qwen-7B muestra una mejora absoluta del 12.0% en Pass@1. (Fuente: HuggingFace Daily Papers)

MoME: Mixture of Matryoshka Experts para el reconocimiento de voz de audio y video: MoME (Mixture of Matryoshka Experts) es un marco novedoso que integra MoE (Mixture of Experts) dispersos en LLM basados en MRL (Matryoshka Representation Learning) para el reconocimiento de voz de audio y video (AVSR). MoME mejora los LLM congelados a través del enrutamiento top-K y expertos compartidos, permitiendo la asignación dinámica de capacidad a través de escalas y modalidades. Los experimentos en los conjuntos de datos LRS2 y LRS3 muestran que MoME logra un rendimiento SOTA en tareas de AVSR, ASR y VSR, con menos parámetros y manteniendo la robustez bajo ruido. (Fuente: HuggingFace Daily Papers)

SAEdit: Edición continua de imágenes a nivel de Token mediante autoencoders dispersos: SAEdit propone un método para la edición de imágenes desacoplada y continua mediante la manipulación de incrustaciones de texto a nivel de Token. Este método controla la intensidad de las propiedades objetivo manipulando las incrustaciones a lo largo de direcciones cuidadosamente seleccionadas. Para identificar estas direcciones, SAEdit emplea autoencoders dispersos (SAE), cuyo espacio latente disperso expone dimensiones semánticamente aisladas. El método opera directamente sobre las incrustaciones de texto sin modificar el proceso de difusión, lo que lo hace independiente del modelo y ampliamente aplicable a diversas arquitecturas de síntesis de imágenes. (Fuente: HuggingFace Daily Papers)

Test-Time Curricula (TTC-RL) mejora el rendimiento de LLM en tareas objetivo: TTC-RL es un método de currículo en tiempo de prueba que, mediante la selección automática de los datos de tarea más relevantes de una gran cantidad de datos de entrenamiento, y la aplicación de Reinforcement Learning para entrenar continuamente el modelo para completar la tarea objetivo. Los experimentos muestran que TTC-RL mejora continuamente el rendimiento del modelo en tareas objetivo en varias evaluaciones y modelos, especialmente en los benchmarks de matemáticas y codificación, donde el Pass@1 de Qwen3-8B en AIME25 mejora aproximadamente 1.8 veces, y en CodeElo mejora 2.1 veces. Esto indica que TTC-RL mejora significativamente el límite superior de rendimiento, proporcionando un nuevo paradigma para el aprendizaje continuo de LLM. (Fuente: HuggingFace Daily Papers)

HEX: Escalado en tiempo de prueba de LLM de difusión a través de expertos semi-autorregresivos ocultos: HEX (Hidden semiautoregressive EXperts for test-time scaling) es un método de inferencia sin entrenamiento que aprovecha la mezcla de expertos semi-autorregresivos implícitamente aprendidos por los dLLM (Diffusion Large Language Models) mediante la integración de una programación de bloques heterogénea. HEX mejora la precisión en benchmarks de razonamiento como GSM8K en 3.56 veces (del 24.72% al 88.10%) mediante la votación por mayoría de las rutas de generación de diferentes tamaños de bloque, sin necesidad de entrenamiento adicional, superando la inferencia marginal top-K y los métodos de fine-tuning especializados. Esto establece un nuevo paradigma para el escalado en tiempo de prueba de los LLM de difusión. (Fuente: HuggingFace Daily Papers)

Power Transform Revisited: Numéricamente estable y federado: La transformación de potencia es una técnica paramétrica común para hacer que los datos se aproximen más a una distribución gaussiana, pero presenta graves inestabilidades numéricas en su implementación directa. La investigación analiza exhaustivamente las fuentes de estas inestabilidades y propone remedios efectivos. Además, extiende la transformación de potencia a la configuración de aprendizaje federado, abordando los desafíos numéricos y de distribución que surgen en este contexto. Los experimentos demuestran que el método es efectivo y robusto, mejorando significativamente la estabilidad. (Fuente: HuggingFace Daily Papers)

Curvas ROC y PR en computación federada: Métodos de evaluación que preservan la privacidad: Las curvas de Característica Operativa del Receptor (ROC) y Precisión-Recall (PR) son herramientas fundamentales para evaluar clasificadores de Machine Learning, pero calcular estas curvas en escenarios de Aprendizaje Federado (FL) es un desafío debido a las restricciones de privacidad y comunicación. La investigación propone un nuevo método para aproximar las curvas ROC y PR en FL estimando los cuantiles de la distribución de puntuaciones predictivas bajo privacidad diferencial distribuida. Los resultados empíricos en conjuntos de datos reales demuestran que este método logra una alta precisión de aproximación con una comunicación mínima y sólidas garantías de privacidad. (Fuente: HuggingFace Daily Papers)

Impacto del fine-tuning de instrucciones ruidosas en la generalización y el rendimiento de LLM: El fine-tuning de instrucciones es crucial para mejorar la capacidad de resolución de tareas de los LLM, pero es sensible a pequeños cambios en la redacción de las instrucciones. La investigación explora si la introducción de perturbaciones (como la eliminación de palabras vacías o la alteración del orden de las palabras) en los datos de fine-tuning de instrucciones puede mejorar la resistencia de los LLM a las instrucciones ruidosas. Los resultados muestran que, en algunos casos, el fine-tuning con instrucciones perturbadas puede mejorar el rendimiento posterior, lo que subraya la importancia de incluir instrucciones perturbadas en el fine-tuning de instrucciones para hacer que los LLM sean más resistentes a las entradas de usuario ruidosas. (Fuente: HuggingFace Daily Papers)

Construyendo un mecanismo de atención multi-cabeza en Excel: ProfTomYeh compartió su experiencia en la construcción de un Multi-Head Attention (mecanismo de atención multi-cabeza) en Excel, con el objetivo de ayudar a comprender su funcionamiento. Proporcionó un enlace de descarga para que los estudiantes puedan dominar este complejo concepto central del Deep Learning a través de la práctica. Este innovador recurso de aprendizaje ofrece una valiosa oportunidad para aquellos que desean comprender en profundidad los mecanismos internos de los modelos de AI a través de la visualización y la práctica. (Fuente: ProfTomYeh)

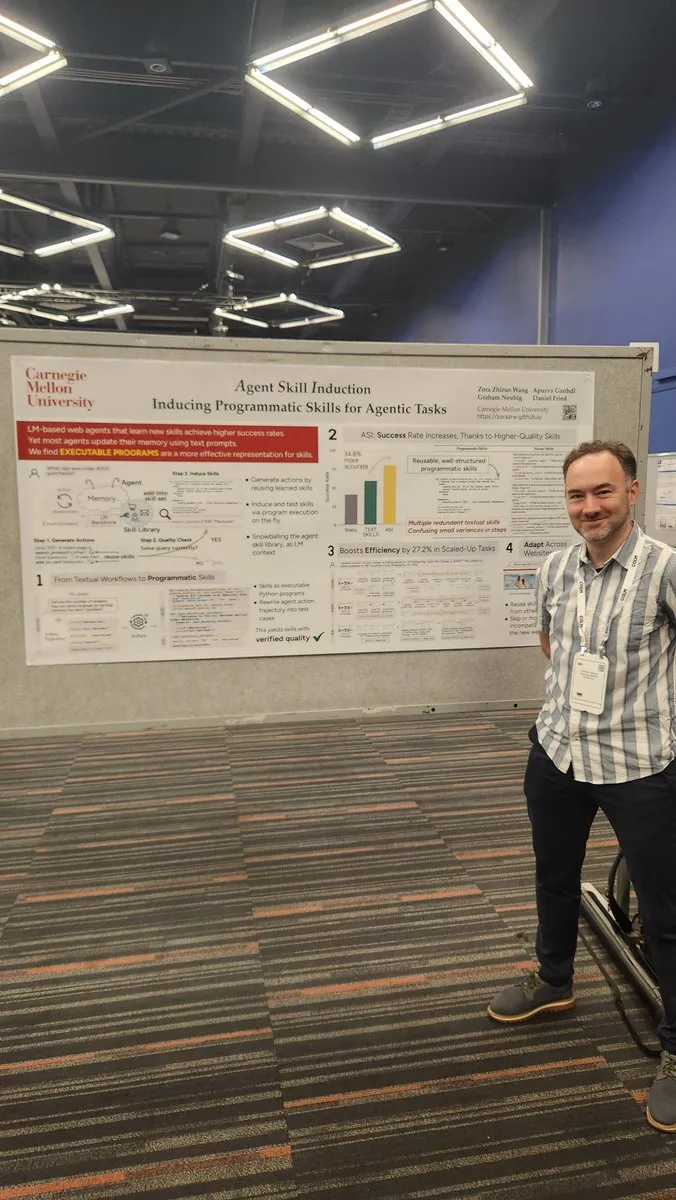

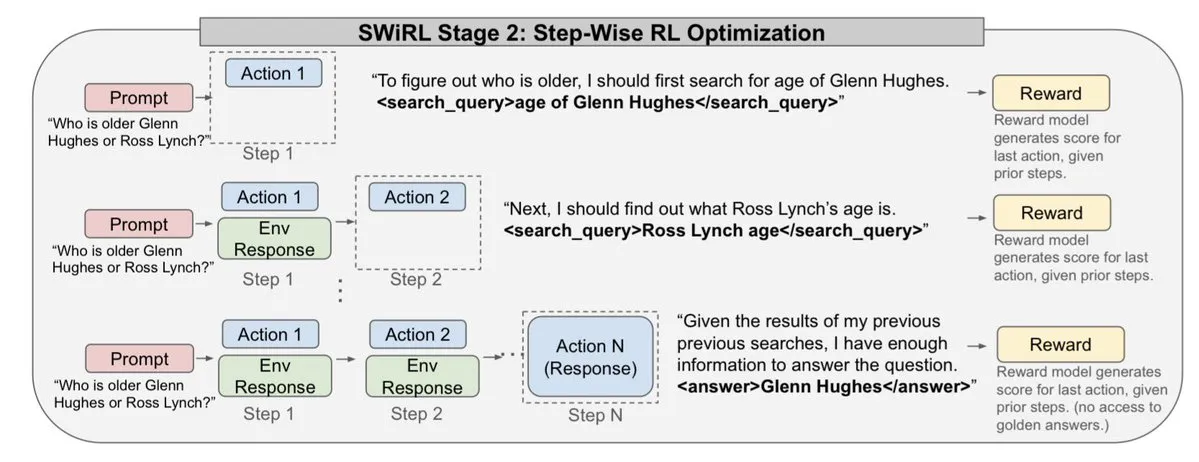

Convertir sitios web en APIs para uso de agentes de AI: Gneubig compartió un trabajo de investigación que explora cómo convertir sitios web existentes en APIs para que los agentes de AI puedan llamarlos y usarlos directamente. Esta tecnología tiene como objetivo mejorar la capacidad de los agentes de AI para interactuar con el entorno web, permitiéndoles obtener información y ejecutar tareas de manera más eficiente sin intervención humana. Esto ampliará enormemente los escenarios de aplicación y el potencial de automatización de los agentes de AI. (Fuente: gneubig)

Colección de artículos del equipo de Stanford NLP en la conferencia COLM2025: El equipo de Stanford NLP ha publicado una serie de artículos de investigación en la conferencia COLM2025, que cubren varios temas de vanguardia de la AI. Estos incluyen la generación de datos sintéticos y el Reinforcement Learning multi-paso, las leyes de escalado bayesianas para el aprendizaje en contexto, la dependencia excesiva humana de los modelos de lenguaje demasiado confiados, los modelos fundamentales que superan a los modelos alineados en aleatoriedad y creatividad, los benchmarks de código largo, un marco dinámico para el olvido de LLM, la verificación de verificadores de hechos, el jailbreaking adaptativo multi-agente y la defensa, la seguridad de LLM de texto con perturbaciones visuales, el razonamiento de la teoría de la mente de LLM impulsado por hipótesis, el comportamiento cognitivo de los razonadores auto-mejorados, la dinámica de aprendizaje del razonamiento matemático de LLM de Token a matemáticas, y el conjunto de datos D3 para el entrenamiento de LM de código, entre otros. Estas investigaciones aportan nuevos avances teóricos y prácticos al campo de la AI. (Fuente: stanfordnlp)

💼 Negocios

OpenAI y Oracle alcanzan un acuerdo de miles de millones de dólares en infraestructura en la nube: Sam Altman ha logrado reducir la dependencia de OpenAI de Microsoft al llegar a un acuerdo de miles de millones de dólares con Oracle, obteniendo un segundo socio en la nube y fortaleciendo su poder de negociación en infraestructura. Esta colaboración estratégica permite a OpenAI acceder a más recursos computacionales para apoyar sus crecientes necesidades de entrenamiento e inferencia de modelos, consolidando aún más su posición de liderazgo en el campo de la AI. (Fuente: bookwormengr)

NVIDIA supera los 4 billones de dólares en capitalización de mercado y continúa financiando la investigación en AI: NVIDIA se ha convertido en la primera empresa cotizada en bolsa en superar los 4 billones de dólares en capitalización de mercado. Desde que se descubrió el potencial de las redes neuronales en la década de 1990, el costo computacional se ha reducido 100.000 veces, mientras que el valor de NVIDIA ha crecido 4.000 veces. La compañía continúa financiando la investigación en AI, desempeñando un papel clave en el impulso del desarrollo del Deep Learning y la tecnología de AI, y su éxito también refleja la posición central de los chips de AI en la actual ola tecnológica. (Fuente: SchmidhuberAI)

ReadyAI se asocia con Ipsos para automatizar la investigación de mercado con AI: ReadyAI ha anunciado una asociación con una división de la empresa global de investigación de mercado Ipsos para utilizar la automatización inteligente en el procesamiento de miles de encuestas. Al automatizar el etiquetado y la clasificación, simplificar la revisión manual y escalar los insights de AI de los agentes, ReadyAI tiene como objetivo mejorar la velocidad, precisión y profundidad de la investigación de mercado. Esto demuestra que la AI está desempeñando un papel cada vez más importante en el procesamiento y análisis de datos a nivel empresarial, especialmente en la industria de la investigación de mercado, donde los datos estructurados son cruciales para impulsar insights clave. (Fuente: jon_durbin)

🌟 Comunidad

La entrevista a Pavel Durov provoca reflexiones sobre los “practicantes de principios”: La entrevista del fundador de Telegram, Pavel Durov, con Lex Fridman ha generado un gran debate en las redes sociales. Los usuarios se sienten profundamente atraídos por su cualidad de “practicante de principios”, creyendo que su vida y sus productos están impulsados por un conjunto de códigos subyacentes inquebrantables. Durov busca un orden interno libre de interferencias externas, manteniendo su mente y cuerpo a través de una disciplina extrema, e incorporando el principio de protección de la privacidad en el código de Telegram. Esta pureza de la coherencia entre el pensamiento y la acción se considera una fuerza poderosa en una sociedad moderna llena de compromisos y ruido. (Fuente: dotey, dotey)

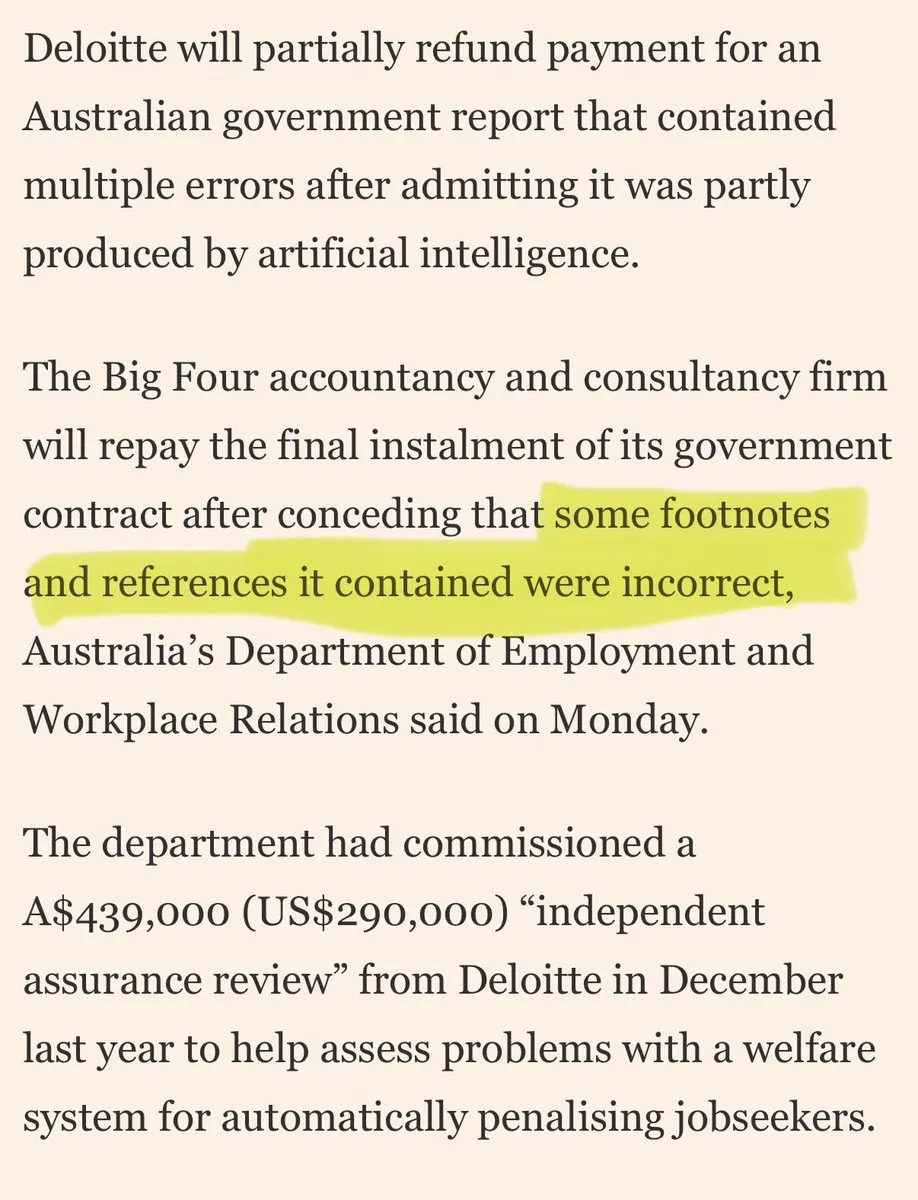

Grandes consultoras acusadas de “chapuzas de AI” para sus clientes: En las redes sociales han surgido críticas hacia grandes consultoras por utilizar “chapuzas de AI” para sus clientes. Los comentarios señalan que estas empresas podrían estar utilizando herramientas de AI de consumo para realizar trabajos de baja calidad, lo que erosionaría la confianza del cliente. Esta discusión refleja las preocupaciones del mercado sobre la calidad y transparencia de las aplicaciones de AI, así como los riesgos éticos y comerciales que las empresas pueden enfrentar al adoptar soluciones de AI. (Fuente: saranormous)

Límites y controversias entre los agentes de AI y las herramientas de flujo de trabajo tradicionales: La comunidad ha debatido intensamente sobre la definición y funcionalidad de los “agentes” de AI frente a los “flujos de trabajo de Zapier” tradicionales. Algunos argumentan que los “agentes” actuales no son más que flujos de trabajo de Zapier que ocasionalmente llaman a un LLM, careciendo de verdadera autonomía y capacidad evolutiva, lo que representa un “paso atrás en lugar de un avance”. Otros creen que los flujos de trabajo estructurados (o “andamios”) superan con creces la inferencia de modelos básicos en flexibilidad y capacidad, y que el AgentKit de OpenAI es cuestionado por el bloqueo del proveedor y la complejidad. Este debate destaca las divergencias en la trayectoria de desarrollo de la tecnología de agentes de AI y las reflexiones profundas sobre la “automatización” y la “autonomía”. (Fuente: blader, hwchase17, amasad, mbusigin, jerryjliu0)

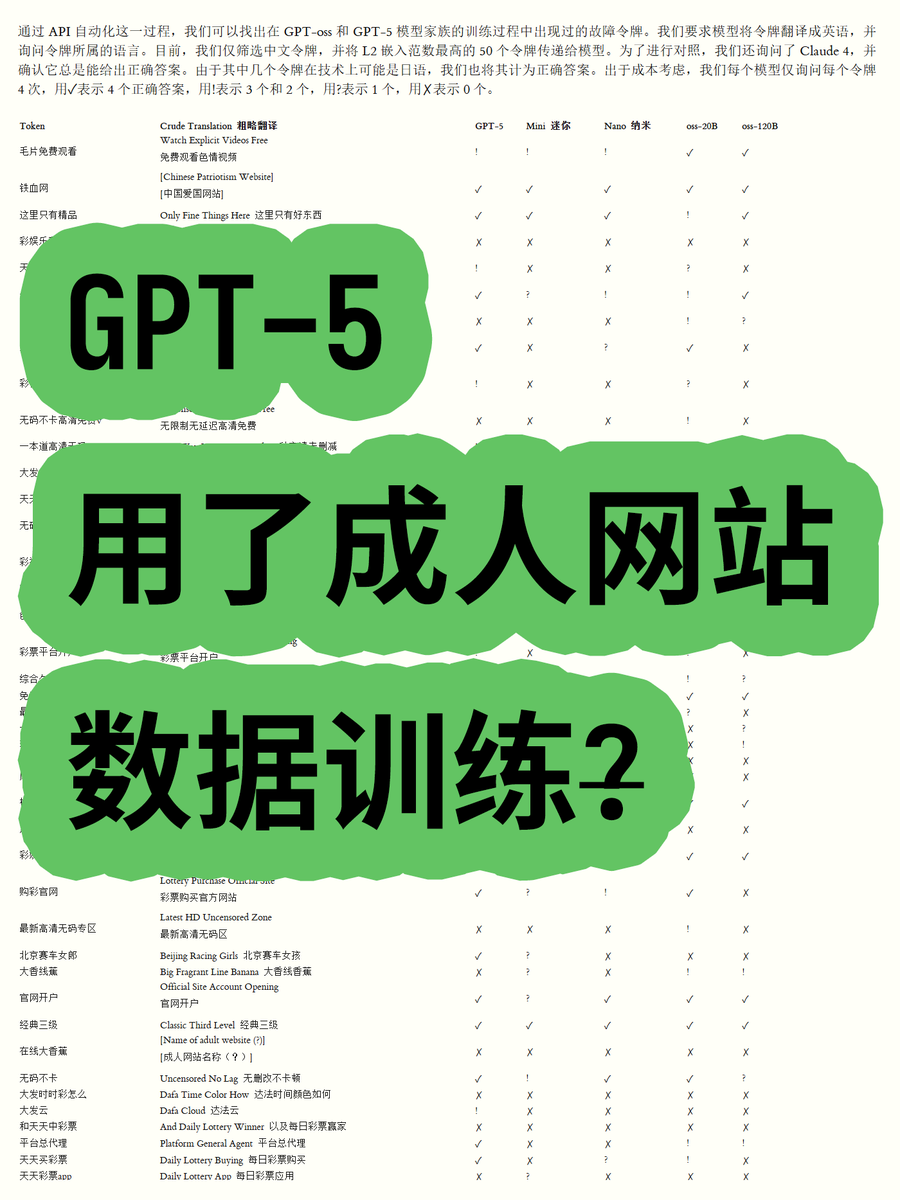

OpenAI GPT-5 acusado de usar datos de sitios web para adultos en su entrenamiento, lo que genera controversia: Un bloguero, al analizar las incrustaciones de Token de los modelos de código abierto de la serie OpenAI GPT-OSS, descubrió que los datos de entrenamiento del modelo GPT-5 podrían contener contenido de sitios web para adultos. Al calcular la norma euclidiana de los vocabularios, se encontró que ciertas palabras de alta norma (como “毛片免费观看” – “ver porno gratis”) estaban relacionadas con contenido inapropiado, y el modelo podía reconocer su significado. Esto ha generado preocupaciones en la comunidad sobre los procesos de limpieza de datos de OpenAI y la ética del modelo, y se especula que OpenAI podría haber sido “engañado” por los proveedores de datos. (Fuente: karminski3)

La creciente censura de los modelos ChatGPT y Claude genera descontento entre los usuarios: Recientemente, los usuarios de los modelos ChatGPT y Claude han informado ampliamente que sus mecanismos de censura se han vuelto excepcionalmente estrictos, y muchos prompts normales y no sensibles también son marcados como “contenido inapropiado”. Los usuarios se quejan de que los modelos no pueden generar escenas de besos, e incluso “la gente vitoreando y bailando emocionada” se considera “relacionado con el sexo”. Esta censura excesiva ha provocado una disminución significativa de la experiencia del usuario, cuestionando la intención de las empresas de AI de reducir el uso o eludir riesgos legales mediante la limitación de funciones, lo que ha generado un amplio debate sobre la practicidad y la libertad de las herramientas de AI. (Fuente: Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ArtificialInteligence, Reddit r/ClaudeAI)

Usuarios de Claude se quejan del aumento del uso de Tokens y la promoción del plan Max: Los usuarios de Claude informan que, desde el lanzamiento de las versiones Claude Code 2.0 y Sonnet 4.5, el uso de Tokens ha aumentado significativamente, lo que lleva a los usuarios a alcanzar los límites de uso más rápidamente, incluso sin un aumento en la carga de trabajo. Algunos usuarios pagan 214 euros al mes y aún así alcanzan los límites con frecuencia, y cuestionan la intención de Anthropic de promocionar su plan Max a través de esta medida. Esto ha generado descontento entre los usuarios sobre la estrategia de precios de Claude y la transparencia del consumo de Tokens. (Fuente: Reddit r/ClaudeAI)

Los agentes de AI colaborativos enfrentan el desafío de los “conflictos de sobrescritura”: En las redes sociales se debate sobre los problemas que encuentran los agentes de codificación de AI en el desarrollo colaborativo, y un usuario señala que “comienzan a sobrescribir brutalmente el trabajo del otro en lugar de intentar manejar los conflictos de fusión”. Esto refleja humorísticamente cómo la gestión y resolución efectiva de conflictos en sistemas multi-agente, especialmente en tareas complejas como la generación y modificación de código, es un desafío técnico aún no resuelto. Esto ha provocado una reflexión sobre los futuros modelos de colaboración de AI. (Fuente: vikhyatk, nptacek)

Aplicación de la AI en la educación y formulación de políticas: Una escuela secundaria de Silicon Valley ha pedido a sus estudiantes que redacten una política de AI, creyendo que involucrar a los adolescentes es el mejor camino a seguir. Al mismo tiempo, una escuela en Texas está permitiendo que la AI guíe todo su plan de estudios. Estos casos demuestran que la integración de la AI en la educación se está acelerando, pero también plantean debates sobre el papel de la AI en el aula, la participación de los estudiantes en la formulación de políticas y la viabilidad de los planes de estudio dirigidos por la AI. Esto refleja la exploración activa de las oportunidades y desafíos de la AI en el ámbito educativo. (Fuente: MIT Technology Review)

Perspectivas a largo plazo y preocupaciones sobre el impacto de la AI en el empleo: La comunidad debate el impacto a largo plazo de la AI en el empleo. Algunos argumentan que la AI difícilmente reemplazará por completo a los ingenieros de investigación y científicos humanos a corto plazo, sino que más bien mejorará las capacidades humanas y reorganizará las organizaciones de investigación, especialmente en un contexto de escasez de recursos computacionales. Sin embargo, otros temen que la AI conduzca a una disminución general del empleo en el sector privado, mientras que los proveedores de AI obtendrán grandes beneficios, formando un modelo de “subsidio de AI insostenible”. Esto refleja las complejas emociones de la sociedad sobre la dirección futura de la tecnología de AI y su impacto económico. (Fuente: natolambert, johnowhitaker, Reddit r/ArtificialInteligence)

La importancia de las habilidades de escritura y comunicación en la era de la AI: Ante la popularización de los LLM, se enfatiza que las habilidades de escritura y comunicación son más importantes que nunca. Esto se debe a que los LLM solo pueden comprender y ayudar a los usuarios si estos pueden expresar sus intenciones con claridad. Esto significa que, incluso con herramientas de AI cada vez más potentes, la capacidad humana de pensar con claridad y expresarse eficazmente sigue siendo clave para utilizar la AI, e incluso podría convertirse en una competencia central en el futuro lugar de trabajo. (Fuente: code_star)

El consumo de energía de los data centers de AI genera preocupación social: Con la rápida expansión de los data centers de AI, el problema de su enorme consumo de energía se vuelve cada vez más prominente. En las discusiones de la comunidad, algunos comparan la demanda de electricidad de la AI con un “crecimiento salvaje” y temen que pueda provocar un aumento vertiginoso de las facturas de electricidad. Esto refleja la preocupación pública por los costos ambientales detrás del desarrollo de la tecnología de AI, y el desafío de lograr la sostenibilidad energética mientras se impulsa la innovación en AI. (Fuente: Plinz, jonst0kes)

Consideraciones de eficiencia y costo de Claude Code frente a los agentes personalizados: La comunidad ha debatido los pros y los contras de usar Claude Code directamente frente a construir un Agent personalizado. Aunque Claude Code es potente, un Agent personalizado tiene ventajas en escenarios específicos, como la generación de código UI basado en sistemas de diseño internos. Un Agent personalizado puede optimizar los prompts, ahorrar consumo de Token y reducir la barrera de entrada para los no desarrolladores, al tiempo que resuelve los problemas de Claude Code de no poder previsualizar directamente los efectos y las limitaciones de permisos del equipo. Esto indica que, en aplicaciones prácticas, es crucial equilibrar las herramientas generales y las soluciones personalizadas según las necesidades específicas. (Fuente: dotey)

La tienda de aplicaciones de ChatGPT y el futuro de la competencia comercial: Con el lanzamiento de la tienda de aplicaciones de ChatGPT, los usuarios debaten su potencial para convertirse en el próximo “navegador” o “sistema operativo”. Algunos creen que esto convertirá a ChatGPT en la interfaz predeterminada para todas las aplicaciones, logrando un nuevo paradigma de interacción de “Just ask”, e incluso podría reemplazar los sitios web tradicionales. Sin embargo, también hay preocupaciones de que esto podría llevar a OpenAI a cobrar tarifas de promoción y provocar una intensa competencia con gigantes como Google en la búsqueda impulsada por AI y los ecosistemas. Esto presagia que los futuros gigantes tecnológicos competirán a un nivel más profundo en plataformas de AI y modelos de negocio. (Fuente: bookwormengr, bookwormengr)

Modelos de precios de LLM y psicología del usuario: La comunidad ha debatido cómo los diferentes modelos de precios de las herramientas de codificación de AI (como Cursor, Codex, Claude Code) afectan el comportamiento y la psicología del usuario. Por ejemplo, el límite de solicitudes mensuales de Cursor hace que los usuarios sientan la necesidad de “acumular” y “agotar” el uso al final del mes; el límite semanal de Codex provoca “ansiedad por el alcance”; y el pago por uso de API de Claude Code impulsa a los usuarios a gestionar conscientemente el uso del modelo y el contexto. Estas observaciones revelan el profundo impacto de las estrategias de precios en la experiencia del usuario y la eficiencia de las herramientas de AI. (Fuente: kylebrussell)

💡 Otros

Motocicleta de bola omnidireccional: Un ingeniero crea una motocicleta esférica omnidireccional: Un ingeniero ha creado una motocicleta esférica omnidireccional que se equilibra de manera similar a un Segway. Este innovador vehículo demuestra los últimos avances en ingeniería mecánica y fusión tecnológica, y aunque no está directamente relacionado con la AI, su avance en el campo de la innovación y las tecnologías emergentes es digno de atención. (Fuente: Ronald_vanLoon)

Desafíos en la generación de video impulsada por personajes: La comunidad ha debatido los desafíos que enfrentan los agentes de generación de video al replicar videos específicos, como comprender las acciones de diferentes personajes en entornos naturales, crear chistes creativos entre escenas y mantener la coherencia de los personajes y el estilo artístico a lo largo del tiempo. Esto destaca los cuellos de botella técnicos de la AI de generación de video en el manejo de narrativas complejas y el mantenimiento de la consistencia multimodal, proporcionando una dirección clara para futuras investigaciones en AI. (Fuente: Vtrivedy10)

Mecanismo de atención en modelos Transformer: Una analogía con el procesamiento sensorial humano: Se ha propuesto que existe una similitud entre el mecanismo de escasez del cuerpo humano y el mecanismo de atención en los modelos Transformer. Los humanos no procesan completamente toda la información sensorial, sino que lo hacen a través de un enrutamiento óptimo de Pareto y una activación dispersa bajo un estricto presupuesto de energía. Esto proporciona una analogía biológica para comprender cómo los modelos Transformer procesan la información de manera eficiente y podría inspirar el diseño futuro de modelos de AI en términos de escasez y eficiencia. (Fuente: tokenbender)