Palabras clave:OpenAI DevDay 2025, Plataforma de aplicaciones ChatGPT, AgentKit, Desarrollo de agentes de IA, GPT-5 Pro, Sora 2, CodeMender, Máquina de pensamiento continuo, ChatGPT Apps SDK, Constructor visual Agent Builder, Modelo de voz GPT-Realtime-Mini, Tecnología Gemini Deep Think, Dinámica neuronal CTM, OpenAI DevDay 2025, Plataforma de aplicaciones ChatGPT, Kit de herramientas para agentes, Desarrollo de agentes inteligentes de IA, Modelo avanzado GPT-5 Pro, Sora segunda generación, Herramienta de reparación de código CodeMender, Tecnología de máquina de pensamiento continuo, SDK para aplicaciones de ChatGPT, Herramienta visual para construir agentes, Modelo de voz en tiempo real GPT-Mini, Tecnología de pensamiento profundo Gemini, Dinámica neuronal de máquina de pensamiento continuo

🔥 En Foco

OpenAI DevDay 2025: ChatGPT se convierte en una plataforma de aplicaciones, AgentKit potencia el desarrollo de agentes inteligentes : OpenAI ha anunciado varios avances significativos en su conferencia anual de desarrolladores de 2025, revelando que ChatGPT cuenta con 800 millones de usuarios activos semanales y que la API procesa más de 6 mil millones de Tokens por minuto. Los lanzamientos clave incluyen el Apps SDK, que permite a los desarrolladores construir y ejecutar aplicaciones con todas las funciones dentro de ChatGPT, transformándolo en un nuevo sistema operativo. Simultáneamente, se lanzó AgentKit, que comprende Agent Builder (constructor visual), ChatKit (UI de chat personalizable), Guardrails (módulo de seguridad) y Evals (herramientas de evaluación), simplificando drásticamente el desarrollo de agentes de IA. Además, GPT-5 Pro, la API de generación de video Sora 2/2 Pro y el modelo de voz GPT-Realtime-Mini también se lanzaron, la herramienta de programación Codex se hizo universal y se agregaron nuevas funciones de SDK y empresariales. Estas actualizaciones presagian una profunda integración y rápida expansión del ecosistema de aplicaciones de IA, impactando profundamente el ecosistema de desarrolladores y la experiencia del usuario.

(Fuente: dotey, jerryjliu0, gdb, Yuchenj_UW, swyx, kevinweil, scaling01, scaling01, gdb, scaling01, scaling01, swyx, scaling01, gdb, gdb, op7418, TheRundownAI, OpenAIDevs, nickaturley, reach_vb, snsf, dotey, edwin)

Google DeepMind lanza CodeMender, IA repara automáticamente vulnerabilidades de software : Google DeepMind ha lanzado CodeMender, un agente de IA que utiliza la tecnología Gemini Deep Think para parchear automáticamente vulnerabilidades críticas de software. Este agente ha enviado con éxito 72 reparaciones de alta calidad a repositorios de código populares, las cuales han sido aceptadas y adoptadas por los mantenedores. El lanzamiento de CodeMender marca un avance significativo de la IA en el ámbito de la seguridad del software, con el potencial de reducir drásticamente el tiempo que los desarrolladores dedican a encontrar y corregir vulnerabilidades, mejorando así la seguridad de la cadena de suministro de software.

(Fuente: Google, GoogleDeepMind)

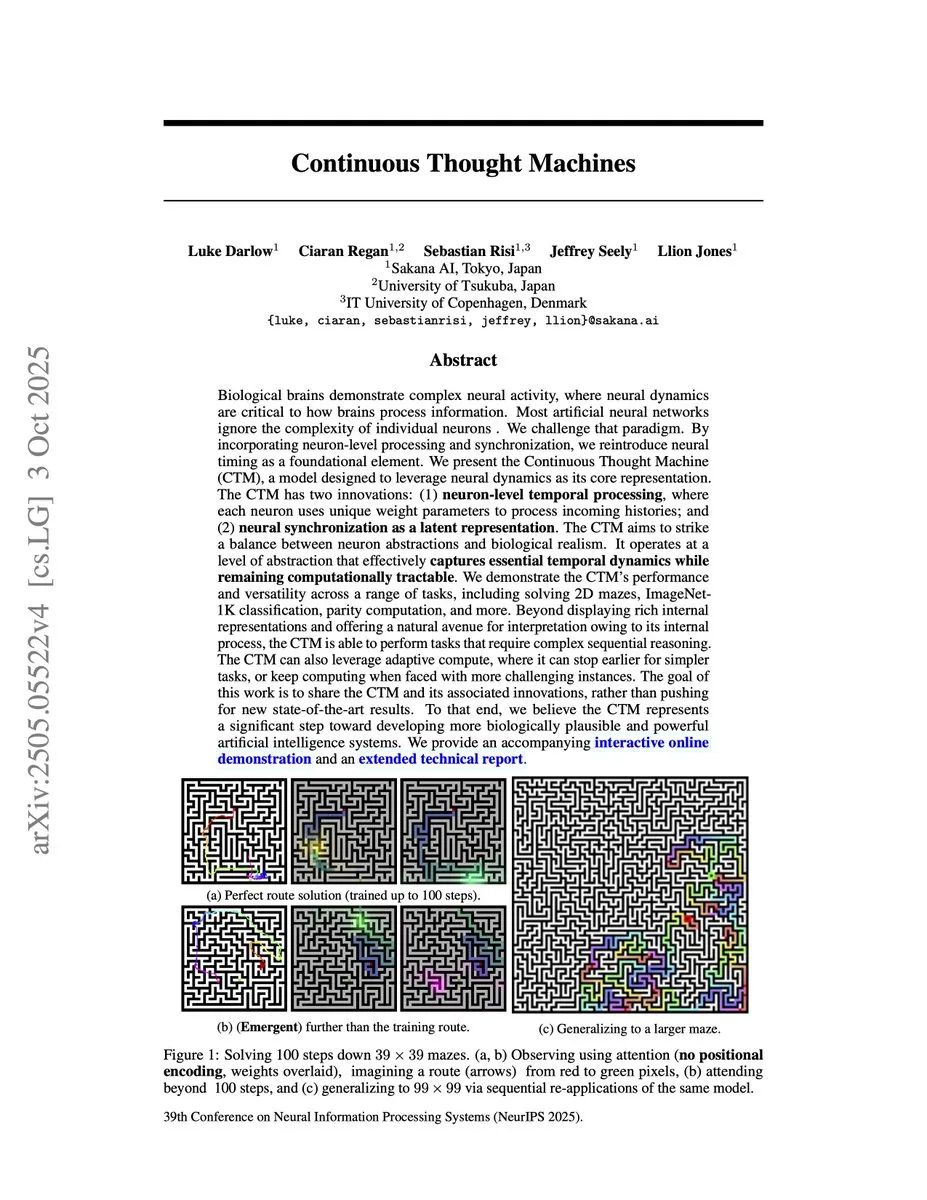

Las “Máquinas de Pensamiento Continuo” de Sakana AI aceptadas como artículo destacado en NeurIPS 2025 : Sakana AI ha anunciado que sus “Máquinas de Pensamiento Continuo” (Continuous Thought Machines, CTM) han sido aceptadas como artículo destacado en NeurIPS 2025. CTM es una IA que imita el cerebro biológico, utilizando neurodinámica y mecanismos de sincronización para “pensar” a lo largo del tiempo, capaz de resolver laberintos complejos construyendo mapas internos, clasificar imágenes mediante la fijación de la mirada y aprender algoritmos. Este diseño innovador demuestra el potencial de la IA para imitar la inteligencia biológica y resolver problemas complejos, presagiando que los futuros sistemas de IA podrían poseer capacidades emergentes más potentes.

(Fuente: hardmaru, hardmaru)

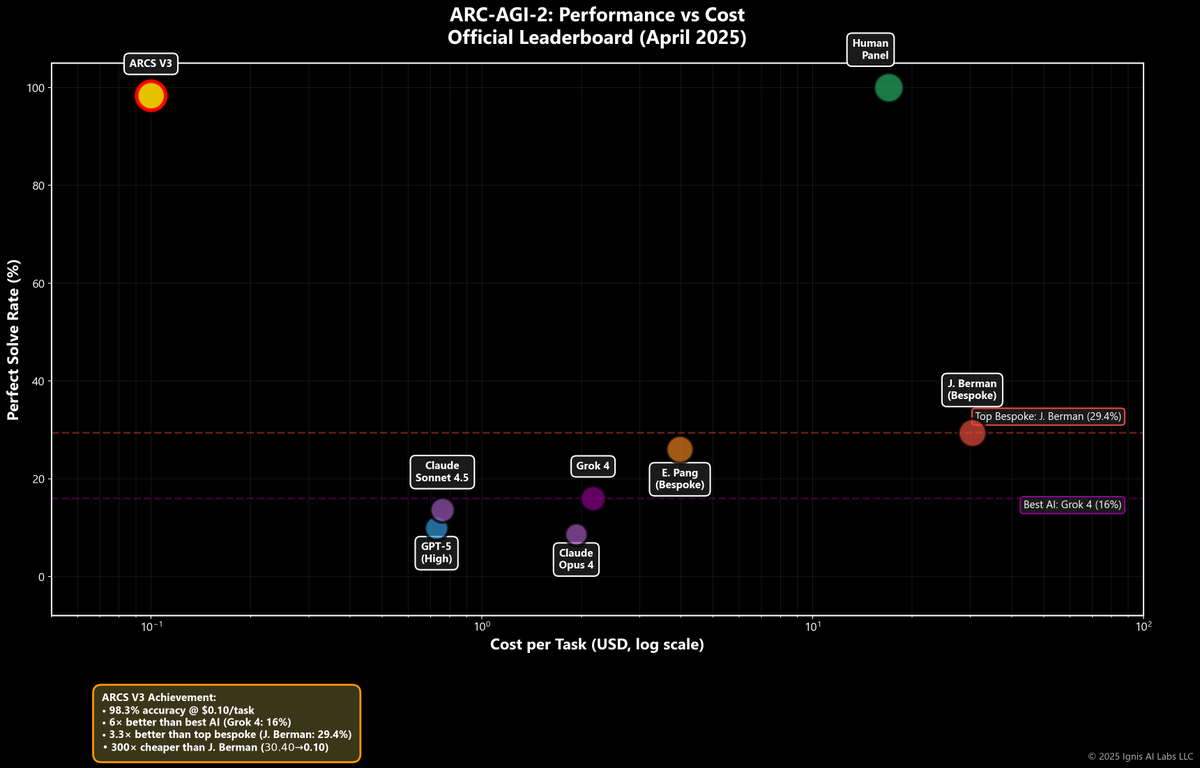

ARCS V3 logra un avance en el razonamiento abstracto con un número mínimo de parámetros : ARCS V3 ha logrado una precisión del 90-98% en el benchmark ARC-AGI-2, con solo 19.9M de parámetros, lo que lo hace 88,442 veces más pequeño que GPT-4 y sin utilizar la arquitectura Transformer. Este logro desafía la dependencia de la industria en los modelos a gran escala, demostrando que, a través de un diseño arquitectónico y métodos innovadores, se puede lograr un rendimiento excepcional en tareas de razonamiento abstracto con un número extremadamente bajo de parámetros. El equipo de investigación enfatiza que este avance representa una verdadera capacidad de razonamiento en lugar de memorización, y proporciona registros de validación completos y videos de demostración.

(Fuente: weights_biases)

Equilibrium Matching (EqM) simplifica y supera el Flow Matching, mejorando el rendimiento de generación : Yilun Du y sus colegas compartieron la investigación sobre Equilibrium Matching (EqM), un método que simplifica y supera el Flow Matching, logrando una puntuación FID de 1.96 en ImageNet 256×256 y demostrando un potente rendimiento de generación. EqM logra un proceso de generación simple basado en gradientes al aprender un único paisaje EBM (modelo basado en energía) estático para la generación. Este avance proporciona una alternativa más eficiente y de mayor rendimiento para los modelos generativos.

(Fuente: VictorKaiWang1)

🎯 Tendencias

OpenAI y AMD colaboran para desplegar GPUs MI450, acelerando la construcción de infraestructura de IA : OpenAI ha anunciado una asociación multimillonaria con AMD para desplegar 6 gigavatios de GPUs AMD Instinct MI450 a partir del próximo año, con el fin de satisfacer la creciente demanda de computación de IA. Esta colaboración acelerará significativamente la construcción de infraestructura global de IA, proporcionando más recursos computacionales a los usuarios de OpenAI y generando ingresos considerables para AMD, logrando un beneficio mutuo.

(Fuente: dejavucoder, jachiam0)

El plan Google AI Pro ofrece una actualización gratuita a estudiantes universitarios : Google ha anunciado que los estudiantes universitarios pueden actualizarse gratuitamente al plan Google AI Pro por un año. Este plan incluye Gemini, NotebookLM y 2TB de almacenamiento, y está diseñado para ayudar a los estudiantes con sus tareas, comprender conceptos complejos, crear guías de estudio y mejorar la escritura. Esta iniciativa busca promover la popularización de las herramientas de IA en el ámbito educativo, potenciando el aprendizaje y la investigación de los estudiantes.

(Fuente: Google)

Microsoft Copilot actualiza la función de memoria, soporta comandos de “olvidar” y “recordar” : Microsoft Copilot ha actualizado su función de memoria, ahora capaz de “recordar” u “olvidar” información específica según las instrucciones del usuario. Los usuarios pueden gestionar la memoria de Copilot en la configuración, asegurando que la IA pueda responder con mayor precisión a las necesidades personalizadas al brindar ayuda, y evitando la retención innecesaria de información. Esta actualización mejora la flexibilidad del asistente de IA en términos de protección de la privacidad y experiencia del usuario.

(Fuente: mustafasuleyman)

LlamaParse ahora es compatible con Anthropic Claude Sonnet 4.5, mejorando las capacidades de procesamiento de documentos : LlamaParse ha anunciado que ha integrado el modelo Claude Sonnet 4.5 de Anthropic, ofreciendo a los usuarios capacidades más potentes de comprensión y análisis de documentos. Esta actualización mejorará la precisión y eficiencia de LlamaParse al procesar documentos complejos, y anuncia que publicará resultados detallados de pruebas de rendimiento de Sonnet 4.5 frente a las opciones de análisis existentes para demostrar sus ventajas de rendimiento.

(Fuente: jerryjliu0)

HuggingFace Inference Endpoints ahora son compatibles con la GPU Nvidia B200 : HuggingFace ha anunciado que sus Inference Endpoints ahora son compatibles con la GPU Nvidia B200. Esta actualización ofrece a los desarrolladores una capacidad de cómputo más potente para ejecutar y desplegar grandes modelos de IA, satisfaciendo las crecientes demandas de cómputo. Esta medida impulsará aún más la aplicación y la innovación de los modelos de IA, reduciendo el alto rendimiento de la IA