Palabras clave:Meta, Tencent Hunyuan Imagen 3.0, xAI Grok 4 Fast, OpenAI Sora 2, ByteDance Self-Forcing++, Alibaba Qwen, vLLM, GPT-5-Pro, Mecanismo de reutilización de meta cognición, Mecanismo de atención causal generalizado, Modelo de razonamiento multimodal, Generación de video a nivel de minutos, Generación de moda consciente de la postura

🔥 En Foco

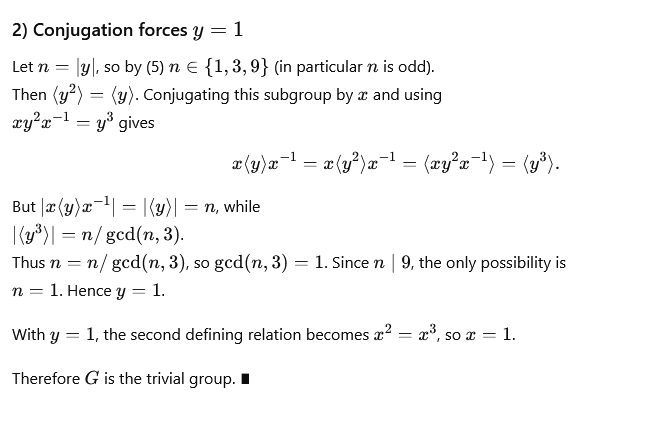

Nuevo método de Meta acorta la cadena de pensamiento, eliminando la deducción repetitiva : Meta, Mila-Quebec AI Institute y otros han propuesto conjuntamente un mecanismo de “reutilización metacognitiva”, diseñado para resolver el problema de la inflación de tokens y el aumento de la latencia causado por la deducción repetitiva en el razonamiento de los grandes modelos. Este mecanismo permite al modelo revisar y resumir los enfoques de resolución de problemas, destilando patrones de razonamiento comunes en “comportamientos” almacenados en un “manual de comportamientos”, que se invocan directamente cuando es necesario, sin necesidad de volver a deducir. Los experimentos muestran que, en las pruebas de referencia de matemáticas como MATH y AIME, este mecanismo puede reducir el uso de tokens de razonamiento hasta en un 46%, manteniendo la precisión y mejorando la eficiencia del modelo y la capacidad de explorar nuevas rutas. (Fuente: 量子位)

Tencent Hunyuan Image 3.0 encabeza la clasificación mundial de generación de imágenes por IA : Tencent Hunyuan Image 3.0 ha ocupado el primer lugar en la clasificación de texto a imagen de LMArena, superando a Google Nano Banana, ByteDance Seedream y OpenAI gpt-Image. Este modelo adopta una arquitectura multimodal nativa, basada en Hunyuan-A13B, con un total de más de 80 mil millones de parámetros, capaz de procesar de forma unificada múltiples modalidades como texto, imágenes, video y audio, y posee potentes capacidades de comprensión semántica, razonamiento de modelos de lenguaje y conocimiento del mundo. Sus tecnologías centrales incluyen el mecanismo de atención causal generalizada y la codificación de posición bidimensional, e introduce la predicción automática de resolución. El modelo construye datos a través de un filtrado de tres etapas y un sistema de descripción jerárquico, y adopta una estrategia de entrenamiento progresivo de cuatro etapas, mejorando efectivamente el realismo y la claridad de las imágenes generadas. (Fuente: 量子位)

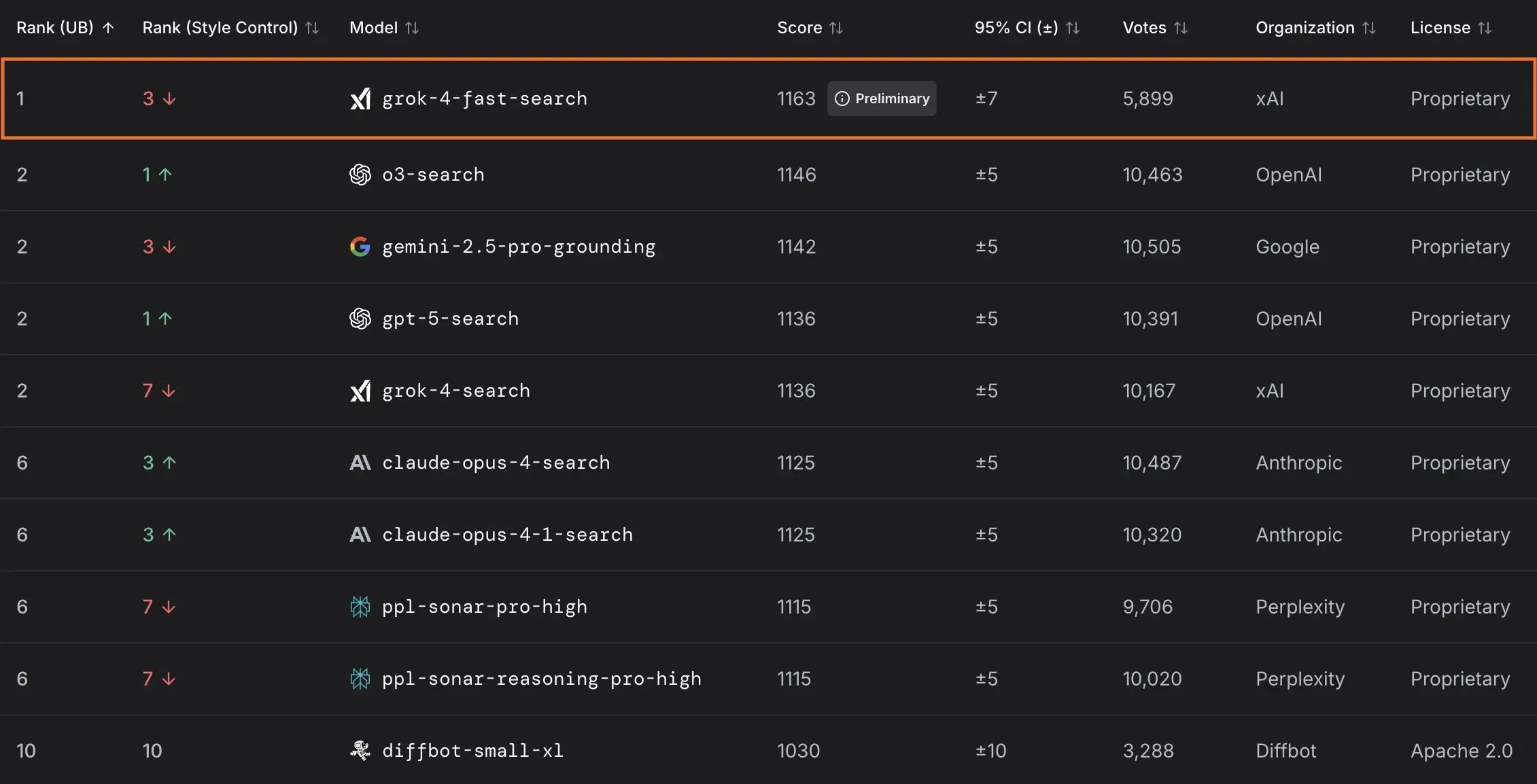

xAI lanza el modelo Grok 4 Fast y colabora con el gobierno de EE. UU. : xAI ha lanzado Grok 4 Fast, un modelo de razonamiento multimodal con una ventana de contexto de 2M, diseñado para ofrecer servicios de inteligencia de alta rentabilidad. El modelo ya está disponible de forma gratuita para todos los usuarios, y a través de una colaboración con el gobierno federal de EE. UU., se ofrecerá acceso gratuito a sus modelos de IA de vanguardia (Grok 4, Grok 4 Fast) a todas las agencias federales durante 18 meses, además de enviar un equipo de ingenieros para ayudar al gobierno a utilizar la IA. Además, xAI también ha lanzado OpenBench para evaluar el rendimiento y la seguridad de los LLM, y ha presentado Grok Code Fast 1, que destaca en tareas de codificación. (Fuente: xai, xai, xai, JonathanRoss321)

🎯 Tendencias

OpenAI anuncia productos de IA de consumo y actualizaciones de Sora 2 : UBS predice que la conferencia de desarrolladores de OpenAI se centrará en el lanzamiento de productos de IA orientados al consumidor, que podrían incluir un agente de IA para reservas de viajes. Al mismo tiempo, el modelo de generación de video Sora 2 está siendo probado, y los usuarios han descubierto que su contenido generado a menudo tiene un sentido del humor. OpenAI también ha solucionado el problema de resolución en el modo HD del modelo Sora 2 Pro, que ahora soporta resoluciones de 17921024 o 10241792, y permite la generación de videos de hasta 15 segundos, aunque el límite de generación diaria se ha reducido a 30 veces. (Fuente: teortaxesTex, francoisfleuret, fabianstelzer, TomLikesRobots, op7418, Reddit r/ChatGPT)

ByteDance lanza un modelo de generación de video de minutos de duración : ByteDance ha presentado un nuevo método llamado Self-Forcing++, capaz de generar videos de alta calidad de hasta 4 minutos y 15 segundos. Este método permite escalar modelos de difusión sin necesidad de un modelo de video largo o reentrenamiento, manteniendo la fidelidad y consistencia del video generado. (Fuente: _akhaliq)

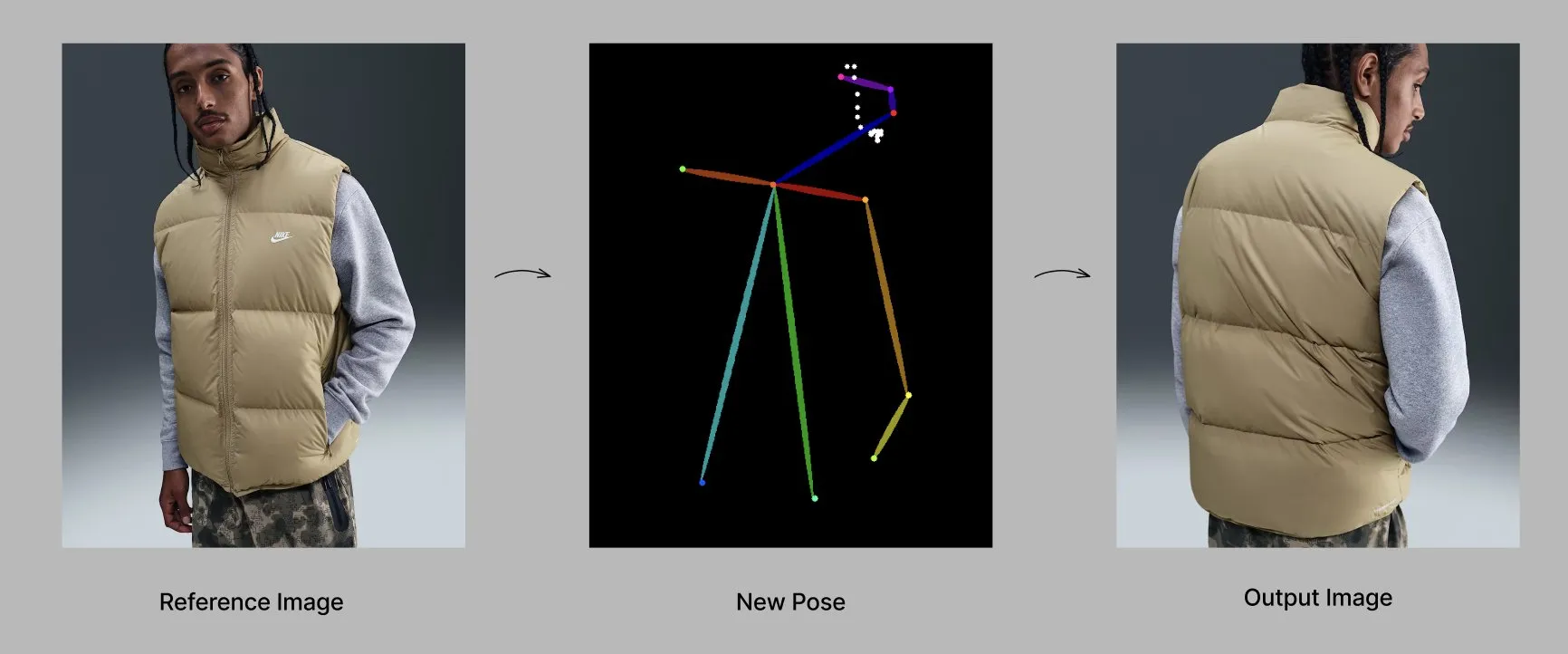

El modelo Qwen lanza nuevas funciones y aplicaciones : El equipo de Alibaba Qwen está lanzando gradualmente funciones personalizadas, como la memoria y las instrucciones del sistema personalizadas, que actualmente se encuentran en pruebas limitadas. Al mismo tiempo, el modelo Qwen-Image-Edit-2509 ha demostrado capacidades avanzadas en la generación de moda consciente de la pose, permitiendo la generación de modelos de moda de alta calidad desde múltiples ángulos mediante el ajuste fino. (Fuente: Alibaba_Qwen, Alibaba_Qwen)

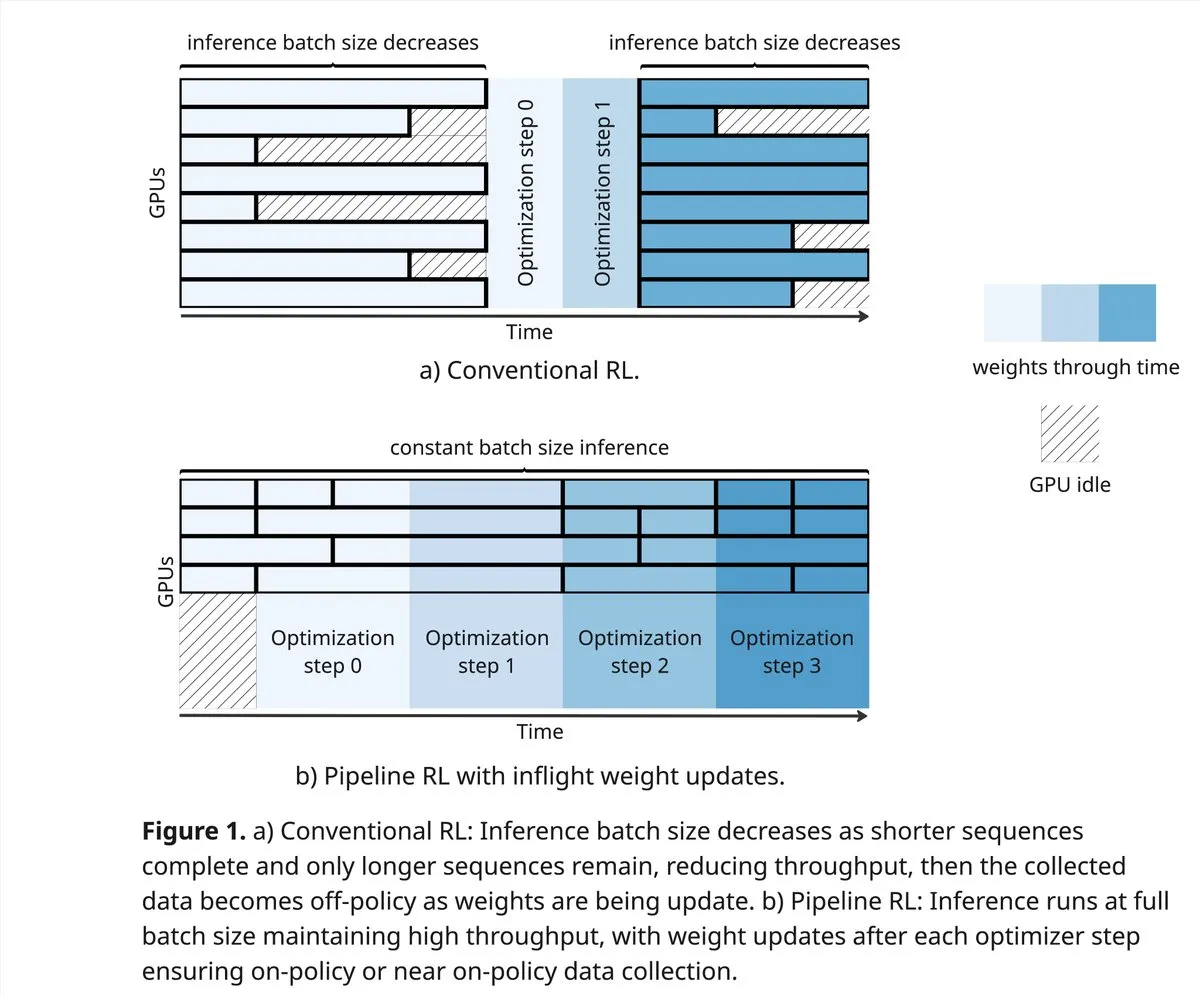

vLLM y PipelineRL impulsan los límites de la comunidad de RL : El proyecto vLLM apoya a la comunidad de RL en nuevos avances en el campo del aprendizaje por refuerzo, incluyendo mejores datos on-policy, rollouts parciales y actualizaciones de peso in-flight que mezclan el caché KV durante la inferencia. PipelineRL logra un RL asíncrono escalable al continuar la inferencia mientras los pesos cambian y el estado KV permanece constante, y soporta actualizaciones de peso in-flight. (Fuente: vllm_project, Reddit r/LocalLLaMA)

GPT-5-Pro resuelve problemas matemáticos complejos : GPT-5-Pro resolvió de forma independiente el “Problema 554 de Yu Tsumura” en 15 minutos, siendo el primer modelo en completar esta tarea, demostrando su potente capacidad para resolver problemas matemáticos. (Fuente: Teknium1)

SAP integra la IA como el núcleo de los flujos de trabajo empresariales : SAP planea presentar en la conferencia Connect 2025 su visión de integrar la IA como el núcleo de los flujos de trabajo empresariales, transformando datos en tiempo real en decisiones a través de IA integrada y utilizando agentes de IA para operaciones proactivas. SAP enfatiza la construcción de confianza y el apoyo proactivo desde el principio, asegurando la flexibilidad de localización y el cumplimiento. (Fuente: TheRundownAI)

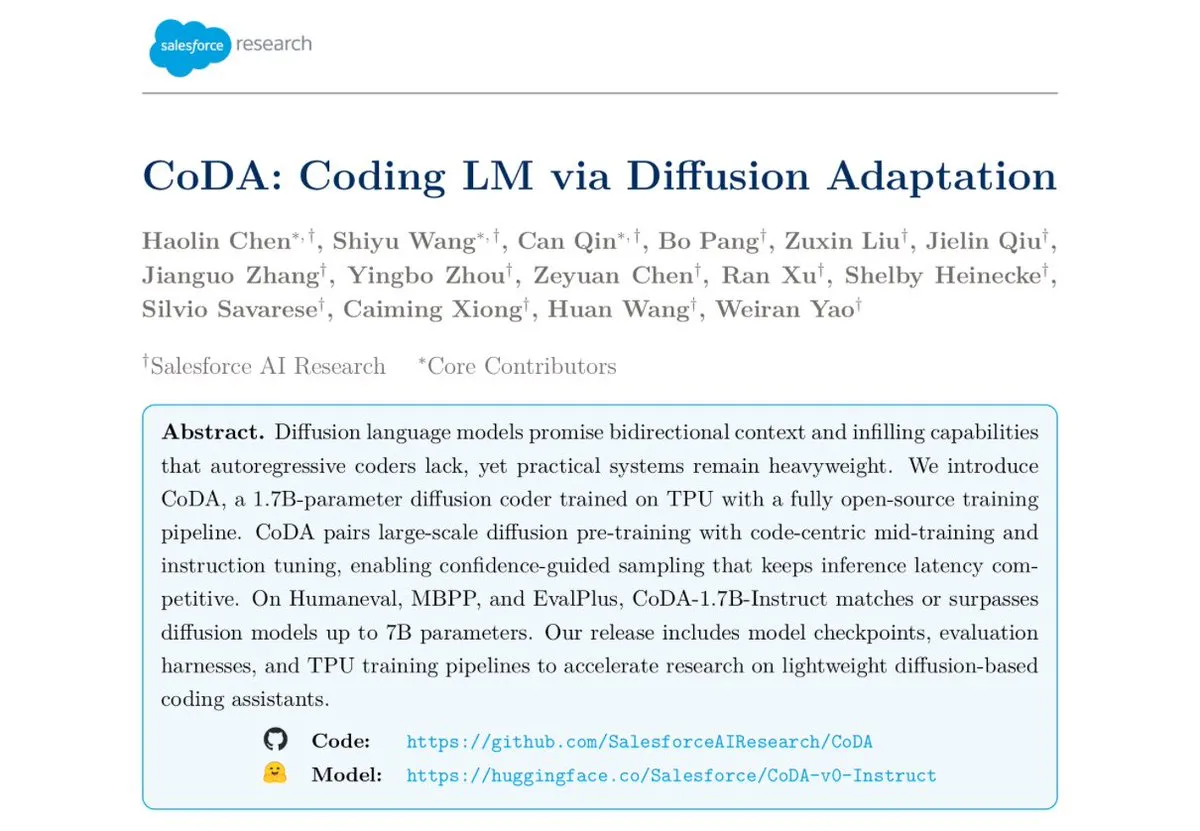

Salesforce lanza el modelo de codificación de difusión de texto CoDA-1.7B : Salesforce Research ha lanzado CoDA-1.7B, un modelo de codificación de difusión de texto capaz de generar tokens bidireccionalmente en paralelo. Este modelo es más rápido en la inferencia, con 1.7B parámetros que rivalizan con modelos de 7B, y ha demostrado un rendimiento excepcional en pruebas de referencia como HumanEval, HumanEval+ y EvalPlus. (Fuente: ClementDelangue)

Google Gemini 3.0 se centra en la EQ, intensificando la competencia con OpenAI : Google está a punto de lanzar Gemini 3.0, que supuestamente se centrará en la “inteligencia emocional” (EQ), lo que se considera un fuerte desafío para OpenAI. Este movimiento indica el desarrollo de modelos de IA en la comprensión emocional y la interacción, presagiando una escalada en la competencia entre los gigantes de la IA. (Fuente: Reddit r/ChatGPT)

Desarrollo de la robótica y la tecnología de automatización : El campo de la robótica continúa innovando, incluyendo robots humanoides móviles omnidireccionales para operaciones logísticas, servicios de entrega con robots móviles autónomos que combinan brazos mecánicos y taquillas, y el robot perro “Cara” de 12 motores diseñado por estudiantes estadounidenses utilizando accionamiento por cuerda y matemáticas ingeniosas. Además, el primer robot “Wuji Hand” también ha sido lanzado oficialmente. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

🧰 Herramientas

El proyecto GPT4Free (g4f) ofrece LLM gratuitos y herramientas de generación de medios : GPT4Free (g4f) es un proyecto impulsado por la comunidad que tiene como objetivo integrar una variedad de LLM accesibles y modelos de generación de medios, ofreciendo un cliente Python, una GUI web local, una API REST compatible con OpenAI y un cliente JavaScript. Soporta adaptadores de múltiples proveedores, incluyendo OpenAI, PerplexityLabs, Gemini, MetaAI, entre otros, y permite la generación de imágenes/audio/video y la persistencia de medios, con el compromiso de popularizar el acceso abierto a las herramientas de IA. (Fuente: GitHub Trending)

Diseño de herramientas LLM y mejores prácticas de ingeniería de Prompt : Al escribir herramientas que la IA pueda entender más fácilmente, la prioridad es la definición de la herramienta, las instrucciones del sistema y las indicaciones del usuario. El nombre y la descripción de la herramienta son cruciales, deben ser intuitivos y claros, evitando ambigüedades. Los parámetros deben ser los menos posibles y proporcionar elementos enumerados o establecer límites superiores e inferiores. Evite el uso de parámetros estructurados demasiado anidados para mejorar la velocidad de respuesta. Al hacer que el modelo escriba el Prompt y proporcione retroalimentación, se puede mejorar efectivamente la comprensión de la herramienta por parte del LLM. (Fuente: dotey)

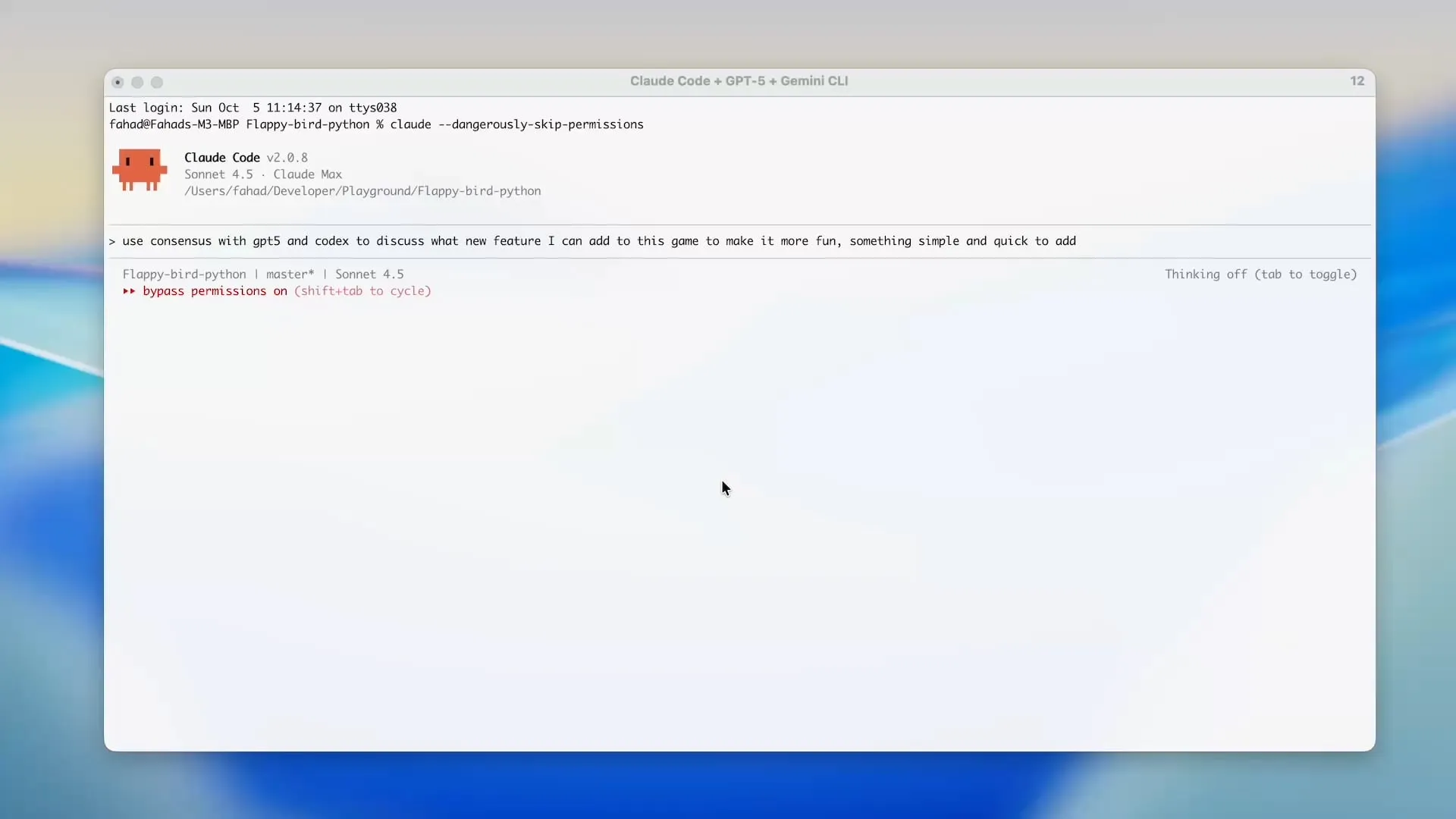

Zen MCP utiliza Gemini CLI para ahorrar créditos de Claude Code : El proyecto Zen MCP permite a los usuarios usar directamente Gemini CLI en herramientas como Claude Code, reduciendo significativamente el uso de tokens de Claude Code y aprovechando los créditos gratuitos de Gemini. Esta herramienta permite delegar tareas entre diferentes modelos de IA y mantener un contexto compartido, por ejemplo, usando GPT-5 para planificar, Gemini 2.5 Pro para revisar, Sonnet 4.5 para implementar, y luego Gemini CLI para la revisión de código y pruebas unitarias, logrando un desarrollo asistido por IA eficiente y económico. (Fuente: Reddit r/ClaudeAI)

Opik, una herramienta de evaluación de LLM de código abierto : Opik es una herramienta de evaluación de LLM de código abierto para depurar, evaluar y monitorear aplicaciones LLM, sistemas RAG y flujos de trabajo Agentic. Ofrece seguimiento completo, evaluación automatizada y paneles listos para producción, ayudando a los desarrolladores a comprender y optimizar mejor sus modelos de IA. (Fuente: dl_weekly)

Claude Sonnet 4.5 sobresale en la escritura de scripts Tampermonkey : Claude Sonnet 4.5 ha demostrado ser excelente en la escritura de scripts Tampermonkey; los usuarios solo necesitan una indicación para cambiar el tema de Google AI Studio, demostrando su potente capacidad en la automatización de operaciones del navegador y la personalización de la interfaz de usuario. (Fuente: Reddit r/ClaudeAI)

Despliegue local del modelo Phi-3-mini : Los usuarios buscan desplegar el modelo Phi-3-mini-4k-instruct-bnb-4bit, ajustado con Unsloth en Google Colab, en máquinas locales. El modelo puede extraer resúmenes y analizar campos de texto, y el objetivo del despliegue es leer texto de un DataFrame localmente, procesarlo con el modelo y guardar la salida en un nuevo DataFrame, incluso en entornos de baja configuración con tarjeta gráfica integrada y 8GB de RAM. (Fuente: Reddit r/MachineLearning)

Comparación del rendimiento de backends de LLM : La comunidad discute el rendimiento de los frameworks de backend de LLM actuales; vLLM, llama.cpp y ExLlama3 son considerados las opciones más rápidas, mientras que Ollama es considerado el más lento. vLLM destaca en el manejo de múltiples chats concurrentes, llama.cpp es favorecido por su flexibilidad y amplio soporte de hardware, y ExLlama3 ofrece un rendimiento extremo para GPU NVIDIA, pero con soporte de modelos limitado. (Fuente: Reddit r/LocalLLaMA)

La herramienta “solveit” ayuda a los programadores a enfrentar los desafíos de la IA : Para abordar la frustración que los programadores pueden experimentar al usar IA, Jeremy Howard ha lanzado la herramienta “solveit”. Esta herramienta tiene como objetivo ayudar a los programadores a utilizar la IA de manera más efectiva, evitando ser guiados en la dirección equivocada por la IA, y mejorando la experiencia y eficiencia de la programación. (Fuente: jeremyphoward)

📚 Aprendizaje

Stanford y NVIDIA colaboran para avanzar en la evaluación comparativa de la IA encarnada : La Universidad de Stanford y NVIDIA realizarán una transmisión en vivo conjunta para profundizar en BEHAVIOR, un benchmark y desafío a gran escala para avanzar en la IA encarnada. La discusión cubrirá la motivación de BEHAVIOR, el diseño de los próximos desafíos y el papel de la simulación en el impulso de la investigación robótica. (Fuente: drfeifei)

Publicado el artículo “Agent-as-a-Judge” para evaluar agentes de IA : Un nuevo artículo titulado “Agent-as-a-Judge” propone un método de prueba de concepto para evaluar agentes de IA mediante agentes de IA, lo que puede reducir los costos y el tiempo en un 97% y proporcionar una rica retroalimentación intermedia. La investigación también desarrolló el benchmark DevAI, que contiene 55 tareas de desarrollo de IA automatizadas, demostrando que Agent-as-a-Judge no solo supera a LLM-as-a-Judge, sino que también se acerca más a la evaluación humana en eficiencia y precisión. (Fuente: SchmidhuberAI, SchmidhuberAI)

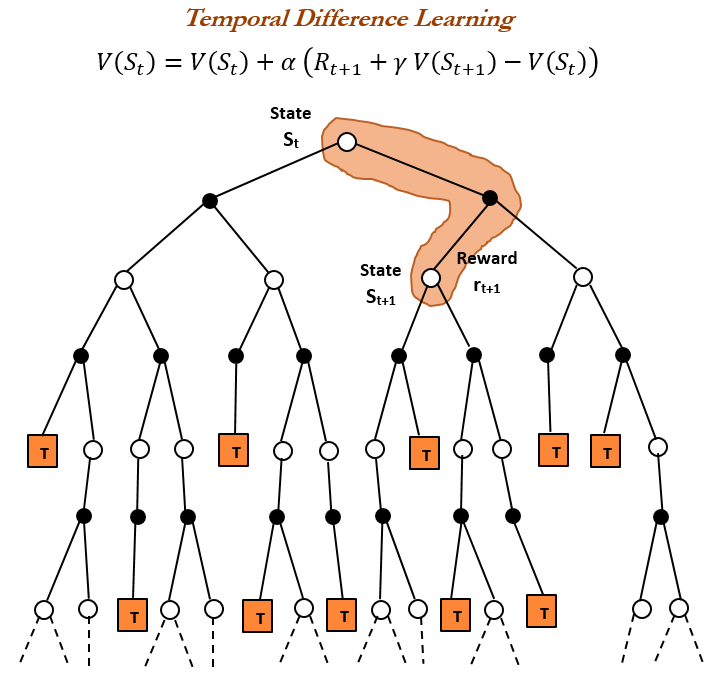

Historia del Aprendizaje por Refuerzo (RL) y Aprendizaje por Diferencia Temporal (TD) : Una revisión histórica del aprendizaje por refuerzo señala que el aprendizaje por diferencia temporal (TD) es la base de los algoritmos modernos de RL (como Deep Actor-Critic). El aprendizaje TD permite a los agentes aprender en entornos inciertos, minimizando el error de predicción al comparar predicciones consecutivas y actualizarlas gradualmente, logrando así predicciones más rápidas y precisas. Sus ventajas incluyen evitar ser engañado por resultados raros, ahorrar memoria y computación, y ser adecuado para escenarios en tiempo real. (Fuente: TheTuringPost, TheTuringPost, gabriberton)

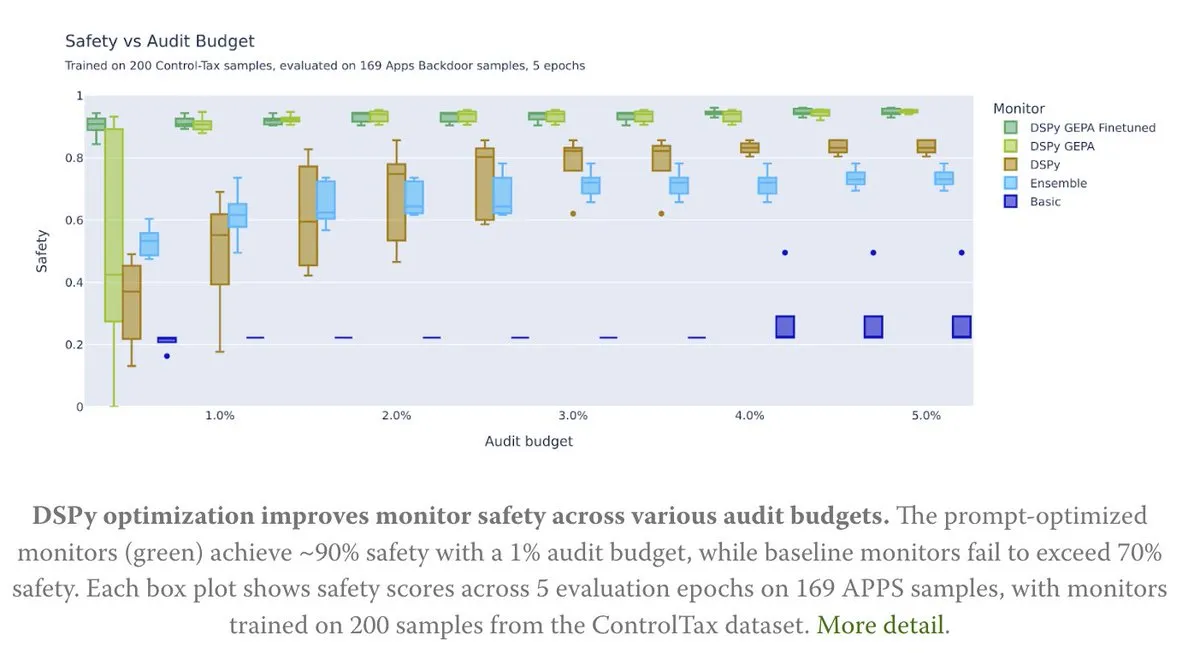

La optimización de Prompt impulsa la investigación en control de IA : Un nuevo artículo explora cómo la optimización de Prompt puede ayudar a la investigación en control de IA, especialmente a través del método GEPA (Generative-Enhanced Prompting for Agents) de DSPy, logrando una tasa de seguridad de IA de hasta el 90%, mientras que los métodos de línea base solo alcanzaron el 70%. Esto demuestra el enorme potencial de los Prompt cuidadosamente diseñados para mejorar la seguridad y controlabilidad de la IA. (Fuente: lateinteraction, lateinteraction)

Algoritmos de aprendizaje de Transformer y CoT : Francois Chollet señala que, si bien se puede enseñar a los Transformer a ejecutar algoritmos simples proporcionando algoritmos paso a paso precisos a través de tokens CoT durante el entrenamiento, el verdadero objetivo del aprendizaje automático debería ser “descubrir” algoritmos a partir de pares de entrada/salida, en lugar de simplemente memorizar algoritmos proporcionados externamente. Argumenta que, si ya existe un algoritmo, ejecutarlo directamente es más eficiente que entrenar un Transformer para codificarlo de manera ineficiente. (Fuente: fchollet)

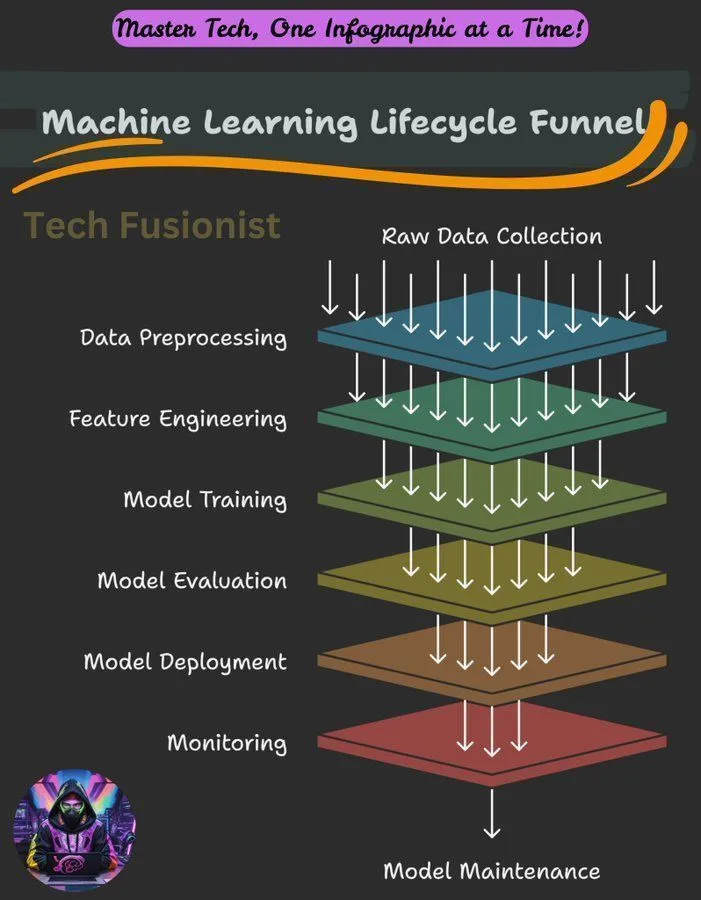

Visión general del ciclo de vida del aprendizaje automático : El ciclo de vida del aprendizaje automático abarca todas las etapas, desde la recopilación de datos, el preprocesamiento, el entrenamiento del modelo, la evaluación hasta el despliegue y la monitorización, siendo un marco clave para construir y mantener sistemas de ML. (Fuente: Ronald_vanLoon)

Objetivo de optimización de la verosimilitud logarítmica negativa (NLL) en la inferencia de LLM : Un estudio explora si la verosimilitud logarítmica negativa (NLL) como objetivo de optimización para la clasificación y el SFT (Supervised Fine-Tuning) es universalmente óptima. El estudio analiza en qué circunstancias los objetivos alternativos podrían superar a NLL, y señala que esto depende de la tendencia a priori del objetivo y la capacidad del modelo, ofreciendo nuevas perspectivas para la optimización del entrenamiento de LLM. (Fuente: arankomatsuzaki)

Guía de introducción al aprendizaje automático : La comunidad de Reddit ha compartido una breve guía sobre cómo aprender aprendizaje automático, enfatizando la comprensión práctica a través de la exploración y la construcción de pequeños proyectos, en lugar de limitarse a definiciones teóricas. La guía también describe los fundamentos matemáticos del deep learning y anima a los principiantes a utilizar bibliotecas existentes para la práctica. (Fuente: Reddit r/deeplearning, Reddit r/deeplearning)

Problemas de entrenamiento de modelos visuales en conjuntos de datos de solo texto : Los usuarios encontraron un error al ajustar el modelo LLaMA 3.2 11B Vision Instruct con el framework Axolotl en un conjunto de datos de solo texto, con el objetivo de mejorar su capacidad de seguir instrucciones mientras se mantiene la capacidad de procesar entradas multimodales. El problema involucra errores en las propiedades processor_type e is_causal, lo que indica que la compatibilidad de la configuración y la arquitectura del modelo es un desafío al adaptar modelos visuales para el entrenamiento de solo texto. (Fuente: Reddit r/MachineLearning)

Compartiendo cursos de entrenamiento distribuido : La comunidad ha compartido cursos sobre entrenamiento distribuido, diseñados para ayudar a los estudiantes a dominar las herramientas y algoritmos utilizados por los expertos a diario, escalando el entrenamiento más allá de una sola H100 y profundizando en el mundo del entrenamiento distribuido. (Fuente: TheZachMueller)

Hoja de ruta para dominar las etapas de la IA Agentic : Existe una hoja de ruta para dominar las diferentes etapas de la IA Agentic, que proporciona un camino claro para desarrolladores e investigadores para comprender y aplicar gradualmente las tecnologías de agentes de IA, construyendo así sistemas más inteligentes y autónomos. (Fuente: Ronald_vanLoon)

💼 Negocios

NVIDIA se convierte en la primera empresa cotizada con un valor de mercado de 4 billones de dólares : La capitalización de mercado de NVIDIA ha alcanzado los 4 billones de dólares, convirtiéndose en la primera empresa cotizada en lograr este hito. Este logro refleja su liderazgo en chips de IA y tecnologías relacionadas, así como su continua inversión y financiación en la investigación de redes neuronales. (Fuente: SchmidhuberAI, SchmidhuberAI, SchmidhuberAI)

Replit se posiciona entre las tres principales empresas de la capa de aplicaciones nativas de IA : Según el análisis de datos de transacciones de Mercury, Replit ocupa el tercer lugar entre las empresas de la capa de aplicaciones nativas de IA, superando a todas las demás herramientas de desarrollo, lo que demuestra su fuerte crecimiento y reconocimiento en el campo del desarrollo de IA. Este logro también ha sido reconocido por los inversores. (Fuente: amasad)

CoreWeave ofrece soluciones de optimización de costos de almacenamiento de IA : CoreWeave organizó un seminario web para discutir cómo reducir los costos de almacenamiento de IA hasta en un 65% sin comprometer la velocidad de innovación. El seminario revelará por qué el 80% de los datos de IA están inactivos y cómo el almacenamiento de objetos de próxima generación de CoreWeave garantiza la plena utilización de la GPU y hace que el presupuesto sea predecible, anticipando el futuro desarrollo del almacenamiento de IA. (Fuente: TheTuringPost)

🌟 Comunidad

Límites de capacidad de LLM, estándares de comprensión y desafíos del aprendizaje continuo : La comunidad discute las deficiencias de los LLM en la ejecución de tareas de agente, considerando que sus capacidades aún son insuficientes. Existen desacuerdos sobre los estándares para “entender” los LLM y el cerebro humano; algunos creen que la comprensión actual de los LLM sigue siendo baja. Richard Sutton, padre del aprendizaje por refuerzo, cree que los LLM aún no han logrado el aprendizaje continuo, enfatizando que el aprendizaje en línea y la adaptabilidad son claves para el futuro desarrollo de la IA. (Fuente: teortaxesTex, teortaxesTex, aiamblichus, dwarkesh_sp)

Estrategias de productos LLM principales, experiencia de usuario y controversias sobre el comportamiento del modelo : La imagen de marca y la experiencia de usuario de Anthropic han generado debate; su campaña “Espacio para pensar” ha sido bien recibida, pero existen controversias sobre la asignación de recursos de GPU, Sonnet 4.5 (acusado de ser menos eficaz para encontrar errores que Opus 4.1 y de tener un estilo “niñera”) y la disminución de la experiencia del usuario bajo altas valoraciones (como las restricciones de uso de Claude). ChatGPT, por su parte, ha endurecido completamente la generación de contenido NSFW, provocando el descontento de los usuarios. La comunidad pide que las funciones de IA se añadan de forma selectiva y no por defecto, para respetar la autonomía del usuario. (Fuente: swyx, vikhyatk, shlomifruchter, Dorialexander, scaling01, sammcallister, kylebrussell, raizamrtn, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/LocalLLaMA, Reddit r/ChatGPT, qtnx_)

Desafíos del ecosistema de IA, controversias sobre modelos de código abierto y percepción pública : La evaluación de seguridad del modelo DeepSeek por parte de NIST ha generado preocupación sobre la credibilidad de los modelos de código abierto y la posibilidad de que los modelos chinos enfrenten prohibiciones, aunque la comunidad de código abierto apoya ampliamente a DeepSeek, considerando que su “inseguridad” en realidad significa que es más fácil seguir las instrucciones del usuario. Los cambios en la API de Google Search afectan la dependencia del ecosistema de IA de datos de terceros. La configuración de entornos de desarrollo de LLM locales enfrenta altos costos de hardware y desafíos de mantenimiento. La evaluación de modelos de IA presenta un fenómeno de “objetivo en movimiento”, y el público tiene controversias sobre la calidad y la ética del contenido generado por IA (como los videos de Taylor Swift usando IA). (Fuente: QuixiAI, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, dotey, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/artificial, Reddit r/artificial)

Impacto de la IA en el empleo y los servicios profesionales : Los economistas pueden haber subestimado gravemente el impacto de la IA en el mercado laboral; la IA no reemplazará completamente los servicios profesionales, sino que los “fragmentará”. La aparición de la IA puede llevar a la desaparición de algunos puestos de trabajo, pero al mismo tiempo creará nuevas oportunidades, requiriendo que las personas aprendan y se adapten continuamente. La comunidad generalmente cree que los trabajos que requieren empatía, juicio o confianza (como medicina, asesoramiento psicológico, educación, derecho) y las personas que pueden utilizar la IA para resolver problemas serán más competitivas. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Reddit r/ArtificialInteligence)

Analogía entre la programación de IA y la gestión técnica : La comunidad discute la analogía entre la programación de IA y la gestión técnica, enfatizando que los desarrolladores necesitan actuar como EM (Engineering Manager), comprendiendo claramente los requisitos, participando en el diseño, dividiendo tareas, controlando la calidad (revisando y probando el código de IA) y actualizando los modelos a tiempo. Aunque la IA carece de iniciativa, elimina la complejidad de las relaciones interpersonales. (Fuente: dotey)

Alucinaciones de IA y riesgos en el mundo real : El fenómeno de las alucinaciones de IA ha generado preocupación, con informes de IA que dirigen a turistas a puntos de referencia peligrosos inexistentes, creando riesgos de seguridad. Esto subraya la importancia de la precisión de la información de la IA, especialmente en aplicaciones que involucran la seguridad en el mundo real, donde se necesitan mecanismos de verificación más estrictos. (Fuente: Reddit r/artificial)

Ética de la IA y reflexión humana : La comunidad discute si la IA puede hacer a la humanidad más humana. Se argumenta que el progreso tecnológico no conduce necesariamente a una mejora moral; el progreso moral humano a menudo va acompañado de un gran costo. La IA por sí misma no despertará mágicamente la conciencia humana; el verdadero cambio surge de la autorreflexión y el despertar de la humanidad ante el horror. Las críticas señalan que las empresas, al vender herramientas de IA, a menudo ignoran el riesgo de que estas herramientas puedan ser utilizadas indebidamente para actos inhumanos. (Fuente: Reddit r/artificial)

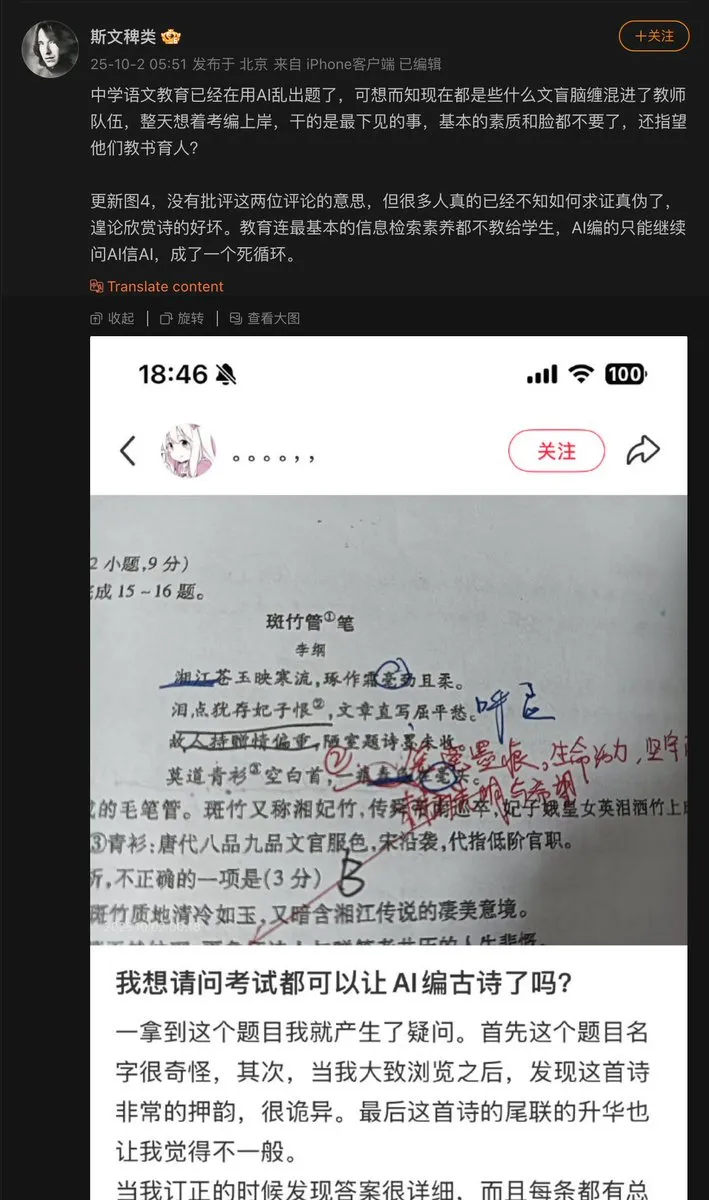

Problemas en la aplicación de la IA en el ámbito educativo : Un profesor de secundaria utilizó la IA para generar preguntas de examen, y la IA inventó un poema clásico chino, incluyéndolo como pregunta. Esto expone el problema de las “alucinaciones” que la IA puede tener al generar contenido, especialmente en el ámbito educativo donde la precisión fáctica es crucial, y la necesidad de mecanismos de revisión y verificación para el contenido generado por IA es primordial. (Fuente: dotey)

Avances de modelos de IA y el cuello de botella de los datos : La comunidad señala que el principal cuello de botella en el progreso actual de los modelos de IA radica en los datos, siendo la parte más difícil la orquestación de datos, el enriquecimiento del contexto y la obtención de decisiones correctas a partir de ellos. Esto subraya la importancia de los datos de alta calidad y estructurados para el desarrollo de la IA, así como los desafíos en la gestión de datos durante el entrenamiento del modelo. (Fuente: TheTuringPost)

Consumo energético de computación de LLM y equilibrio de valor : La comunidad discute el enorme consumo energético de la IA (especialmente los LLM); algunos lo consideran “malvado”, pero otros argumentan que la contribución de la IA a la resolución de problemas y la exploración del universo supera con creces su consumo energético, considerando que impedir el desarrollo de la IA es miope. Esto refleja el debate continuo sobre el equilibrio entre el desarrollo de la IA y su impacto ambiental. (Fuente: timsoret)

💡 Otros

Cajero automático de oro con AI+IoT : Un cajero automático que combina tecnologías de AI e IoT puede aceptar oro como medio de transacción, lo que representa una aplicación innovadora de la IA en la intersección de las finanzas y el IoT, aunque relativamente de nicho, demuestra el potencial de la IA en escenarios específicos. (Fuente: Ronald_vanLoon)

Servidor CPU de Z.ai Chat sufre ataque y causa interrupción : El servicio Z.ai Chat se interrumpió temporalmente debido a un ataque a sus servidores CPU, y el equipo está trabajando en la reparación. Esto destaca los desafíos que enfrentan los servicios de IA en seguridad y estabilidad de la infraestructura, así como el impacto potencial de ataques DDoS u otros ataques de red en la operación de plataformas de IA. (Fuente: Zai_org)

Apache Gravitino: Catálogo de datos abierto y gestión de activos de IA : Apache Gravitino es un lago de metadatos de alto rendimiento, geodistribuido y federado, diseñado para unificar la gestión de metadatos de diferentes fuentes, tipos y regiones. Proporciona acceso unificado a metadatos, soporta la gobernanza de datos y activos de IA, y está desarrollando funciones de seguimiento de modelos de IA y características, con el potencial de convertirse en una infraestructura clave para la gestión de activos de IA. (Fuente: GitHub Trending)