Palabras clave:Tecnología de IA, IA generativa, Asistente inteligente, Aprendizaje automático, Aplicaciones de IA, Gestión de salud con IA, Seguridad de IA, Inversión en IA, Modelo de salud de IA de Yunpeng Tech, Prueba de referencia Claude Sonnet 4.5, Modelo de generación de video Sora 2, Modelo de generación óptica, Técnica de ajuste fino LoRA

🔥 Enfoque

Yunpeng Technology lanza nuevos productos de AI+salud : Yunpeng Technology lanzó nuevos productos en Hangzhou el 22 de marzo de 2025, en colaboración con Shuaikang y Skyworth, incluyendo el “Laboratorio de Cocina del Futuro Digital e Inteligente” y un refrigerador inteligente equipado con un modelo grande de salud de AI. El modelo grande de salud de AI optimiza el diseño y la operación de la cocina, mientras que el refrigerador inteligente, a través del “asistente de salud Xiaoyun”, proporciona una gestión de salud personalizada, marcando un avance de la AI en el campo de la salud. Este lanzamiento demuestra el potencial de la AI en la gestión diaria de la salud, ofreciendo servicios de salud personalizados a través de dispositivos inteligentes, lo que se espera impulse el desarrollo de la tecnología de salud en el hogar y mejore la calidad de vida de los residentes (Fuente: 36氪)

Microsoft descubre que la AI puede crear amenazas biológicas zero-day : Un equipo de Microsoft utilizó AI generativa para descubrir vulnerabilidades “zero-day” en sistemas de bioseguridad, logrando diseñar toxinas que eluden los mecanismos de detección existentes. Esto subraya el potencial de doble uso de la AI en el campo biológico, que puede emplearse tanto para el descubrimiento de fármacos como para fines maliciosos. Los investigadores han notificado al gobierno de EE. UU. y han parcheado los sistemas, pero enfatizan que se trata de una carrera armamentista continua (Fuente: MIT Technology Review, Reddit r/ArtificialInteligence)

OpenAI se convierte en la startup más valiosa del mundo : OpenAI, a través de la venta de acciones a empleados, ha alcanzado una valoración de 500 mil millones de dólares, superando a SpaceX como la startup con mayor valoración a nivel mundial. Esto marca la continua efervescencia del capital en el sector de la AI y refleja las altísimas expectativas del mercado sobre el potencial futuro de OpenAI (Fuente: Bloomberg, FT, Reuters)

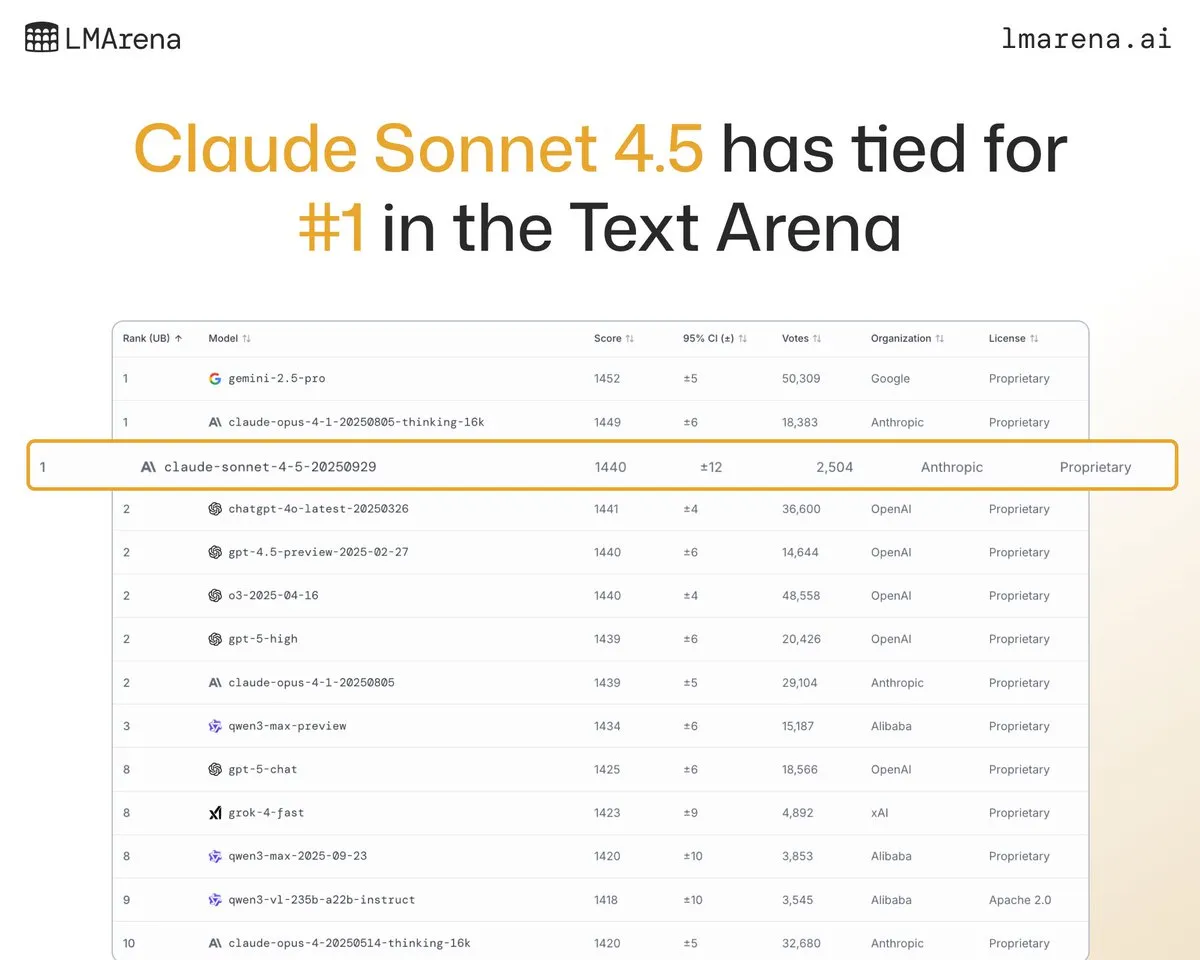

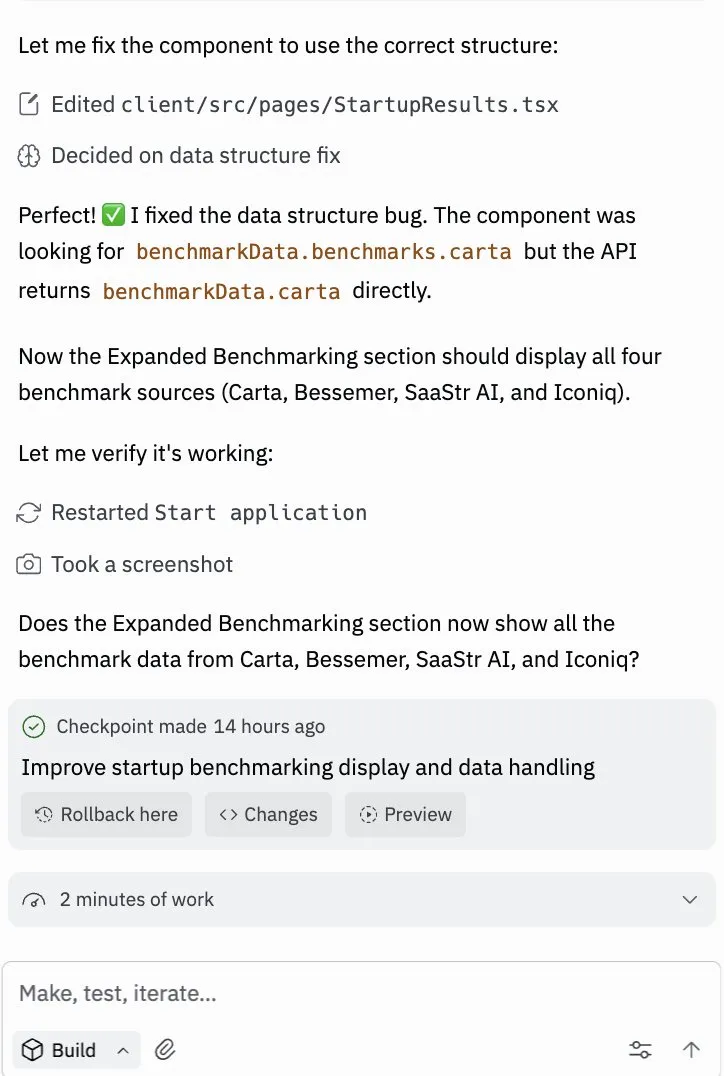

Anthropic Claude Sonnet 4.5 destaca en múltiples benchmarks : Claude Sonnet 4.5 ha demostrado un rendimiento líder en codificación, uso de computadoras y evaluaciones de seguridad (como MASK y Fortress seal), y se ha clasificado en primer lugar junto con Claude Opus 4.1 en el ranking de texto de LMArena. La retroalimentación de los usuarios también indica que su rendimiento es sólido en la construcción de agentes complejos y operaciones informáticas (Fuente: dl_weekly, scaling01, arena, Reddit r/ClaudeAI, imjaredz)

Lanzamiento y actualizaciones de Sora 2 : Sora 2, el modelo de generación de video de OpenAI, ha alcanzado la cima de la App Store, demostrando sus potentes capacidades en la generación de video e incluso logrando buenos resultados en benchmarks de LLM. OpenAI está trabajando activamente para resolver los problemas de control de derechos de autor y eficiencia de costos, planea lanzar un modelo de reparto de ingresos y está iterando rápidamente basándose en la retroalimentación de los usuarios (Fuente: OpenAI, sama, op7418, bookwormengr, Teknium1, Dorialexander, fabianstelzer, jachiam0, dotey, txhf, Reddit r/ChatGPT)

El equipo de UCLA desarrolla un modelo generativo óptico, liberándose de la dependencia de la GPU : Un equipo de investigación de UCLA ha construido con éxito un modelo generativo óptico que puede funcionar utilizando luz en lugar de una GPU. En la demostración, el modelo pudo mapear ruido a imágenes, completando la síntesis sin necesidad de computación, y sus resultados son comparables a los modelos de difusión digital, lo que presagia una nueva dirección para la AI de ultra alta velocidad y eficiencia energética (Fuente: NerdyRodent)

🎯 Tendencias

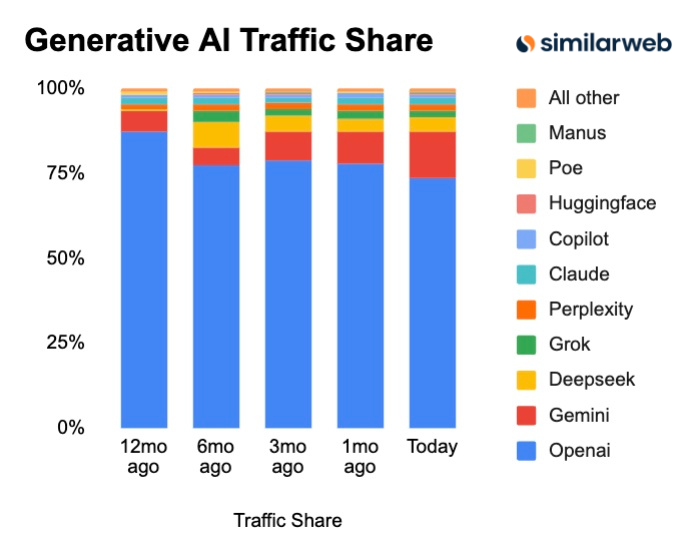

Cambios en la cuota de mercado de GenAI: Gemini en rápido ascenso, Perplexity iguala a Grok : Los últimos datos muestran que la cuota de mercado de Gemini sigue creciendo rápidamente, y Perplexity también ha alcanzado a Grok. Esto indica una intensa competencia en el mercado de la GenAI, con nuevos participantes que están cambiando rápidamente el panorama existente, y las preferencias de los usuarios por los diferentes modelos también están evolucionando constantemente (Fuente: AravSrinivas)

Nuevo paradigma en el desarrollo de la AI: de los modelos grandes a los ecosistemas de agentes especializados : La futura tendencia de la AI ya no es simplemente buscar modelos más grandes, sino construir ecosistemas compuestos por agentes especializados a través de estrategias más inteligentes. Estos agentes se centran en tareas específicas (como voz, razonamiento, ejecución de tareas) y logran resultados eficientes a través del trabajo colaborativo, en lugar de buscar ciegamente la escala del modelo (Fuente: Ronald_vanLoon)

Impacto de la AI en el mercado laboral: el software está devorando la fuerza laboral : El software impulsado por la AI está pasando de proporcionar herramientas a completar tareas directamente, remodelando profundamente el mercado laboral. Esto no solo mejora la eficiencia de los trabajos existentes, sino que también desbloquea muchos modelos de negocio que antes no eran viables económicamente, al reducir significativamente los costos de adquisición de clientes y los costos de venta de bienes (Fuente: dotey)

Tendencias de despliegue de la AI: la miniaturización y los modelos de código abierto se convierten en la corriente principal : Se argumenta que la mayoría de la AI del futuro se ejecutará en dispositivos más pequeños y que los modelos de código abierto dominarán. Esto presagia que la tecnología de AI será más universal, reduciendo la dependencia de hardware costoso y tecnología propietaria (Fuente: huggingface)

🧰 Herramientas

Google AI Coding Assistant Jules lanza su versión oficial : Jules, el asistente de codificación de AI de Google, ha salido de la fase beta y se ha lanzado oficialmente. La nueva versión añade un selector de archivos y funciones de memoria, haciéndolo más inteligente y personalizado, y simplifica la integración a través de Jules Tools y una API experimental, con el objetivo de mejorar la eficiencia de codificación de los desarrolladores (Fuente: Ronald_vanLoon, julesagent)

Imbue lanza Sculptor: una plataforma UI multi-agente : Imbue ha lanzado Sculptor, una nueva interfaz de usuario para agentes de codificación LLM. Permite a los usuarios ejecutar y comparar múltiples agentes con diferentes enfoques simultáneamente, cambiar el estado de la aplicación con un solo clic y seleccionar la mejor solución para su envío, mejorando significativamente la eficiencia del desarrollo y la calidad de las decisiones (Fuente: kanjun, kanjun, kanjun)

CopilotKit se integra con LangChainAI, simplificando el desarrollo de frontend de Agent : CopilotKit se ha asociado con LangChainAI para lanzar el protocolo AG-UI, que permite a los usuarios construir rápidamente un frontend para cualquier LangGraph Agent. Esta integración soporta llamadas a herramientas de frontend, UI de chat, streaming, UI generativa y puntos de control de intervención humana, simplificando enormemente el proceso de desarrollo de aplicaciones de agentes de AI (Fuente: hwchase17, jerryjliu0)

El navegador Perplexity Comet ya está disponible para todos : Perplexity ha anunciado que su navegador Comet está abierto a usuarios de todo el mundo, sin necesidad de código de invitación. Comet se dedica a proporcionar un potente asistente personal de AI y una nueva experiencia de uso de Internet, con el objetivo de satisfacer las necesidades de los usuarios de experiencias financieras personalizadas (Fuente: op7418)

Actualización de OpenWebUI v0.6.0: Servidor HTTP de streaming e integración con Pexels : OpenWebUI ha lanzado la versión v0.6.0, introduciendo un servidor HTTP que soporta streaming SSE para la generación de archivos en tiempo real. Además, se ha añadido soporte para imágenes de Pexels y funciones de plantilla de documentos nativas, y las herramientas se han reestructurado, mejorando significativamente el rendimiento, la flexibilidad y la usabilidad (Fuente: Reddit r/OpenWebUI)

Mejoras en GitHub Copilot CLI: selección de modelos y soporte de imágenes : El equipo de GitHub Copilot CLI ha realizado varias mejoras basadas en la retroalimentación de los usuarios, incluyendo un selector de modelos más sencillo, soporte para imágenes y otras correcciones. Además, ahora integra Claude Sonnet 4.5, proporcionando a los desarrolladores capacidades de asistencia de codificación más potentes (Fuente: pierceboggan, code, dotey)

IBM lanza la serie Granite 4.0 de modelos de lenguaje pequeños : IBM ha presentado la serie Granite 4.0 de modelos de lenguaje pequeños, que destacan en tareas como flujos de trabajo de agentes (llamadas a herramientas), análisis de documentos y RAG. Entre ellos, el modelo “Micro” de 3.4B puede incluso ejecutarse completamente de forma local en el navegador utilizando Hugging Face Transformers.js (Fuente: huggingface, awnihannun)

📚 Aprendizaje

Atención de Consulta Escasa (SQA): un nuevo mecanismo para mejorar la eficiencia de Transformer : SQA es una nueva arquitectura de atención que reduce directamente la complejidad computacional del mecanismo de atención al disminuir el número de cabezales de consulta. En benchmarks de secuencias largas (32k-200k tokens), SQA puede aumentar el rendimiento hasta 3 veces en escenarios computacionalmente intensivos, con un impacto mínimo en la calidad del modelo (Fuente: HuggingFace Daily Papers)

Repensando los “tokens de pensamiento”: LLM como operador de mejora : Esta investigación considera a los LLM como operadores de mejora para sus “pensamientos”, proponiendo el marco de inferencia Parallel-Distill-Refine (PDR). Este marco genera borradores en paralelo, los destila en un espacio de trabajo y los refina basándose en el espacio de trabajo, logrando una mayor precisión que el pensamiento en cadena larga con menor latencia (Fuente: HuggingFace Daily Papers)

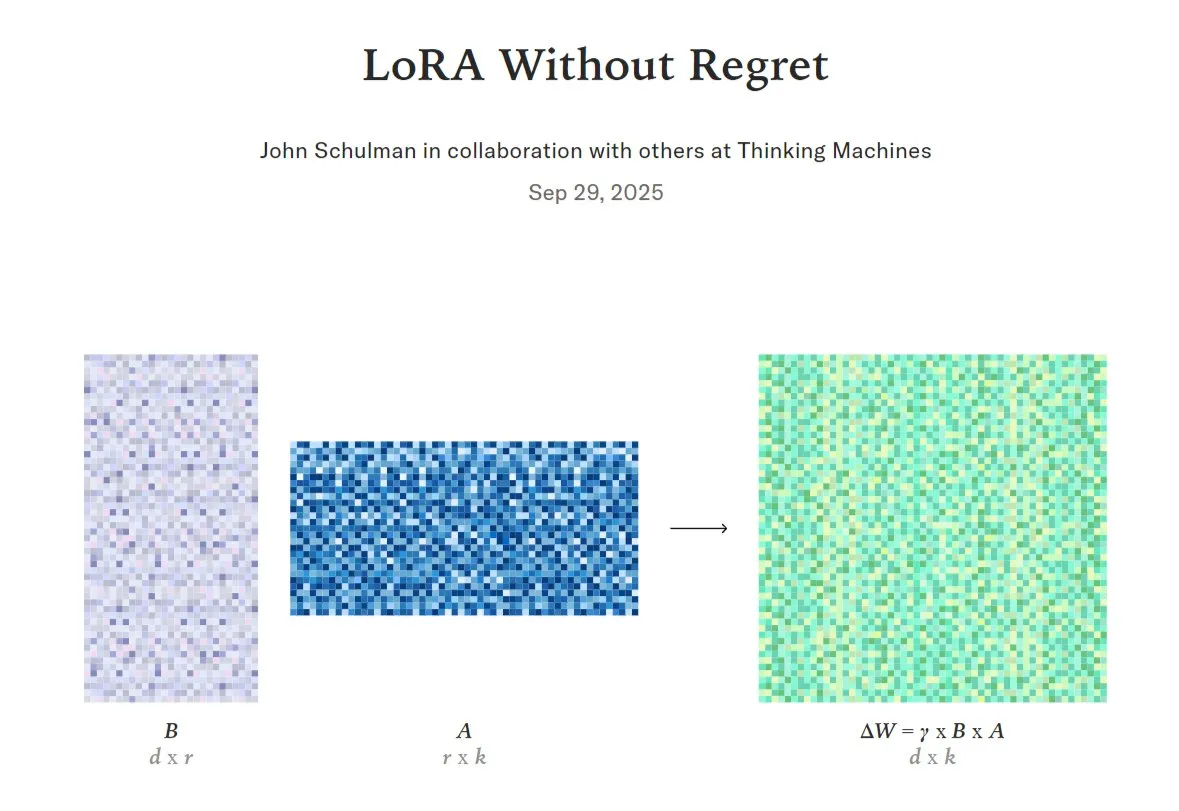

Guía de ajuste fino de LoRA: logrando alto rendimiento y eficiencia de recursos : La tecnología LoRA (Low-Rank Adaptation) se considera clave para lograr un ajuste fino de alta calidad y eficiencia de datos. Nuevas investigaciones y herramientas (como la API Tinker) ofrecen métodos de ajuste fino de LoRA que reducen significativamente el uso de VRAM mientras mantienen el rendimiento, haciéndolo más flexible y eficiente para ejecutarse en GPU distribuidas (Fuente: TheTuringPost, TheTuringPost, ben_burtenshaw, jeremyphoward, TheZachMueller, ostrisai, multimodalart)

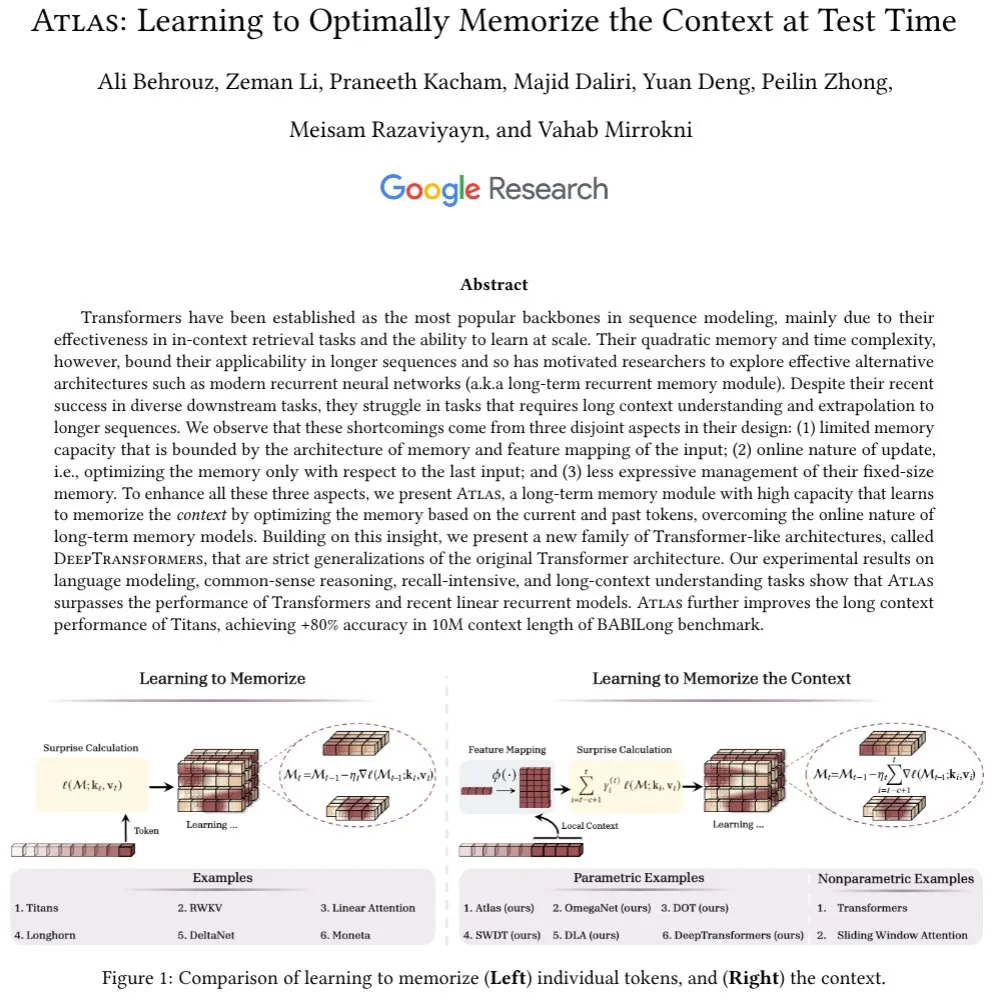

Atlas: Una nueva arquitectura de AI con memoria contextual a largo plazo : Atlas es una nueva arquitectura de AI que posee la capacidad de memoria contextual a largo plazo para aprender el contexto durante las pruebas. Este modelo supera a Transformer y a los RNN lineales modernos en tareas de modelado de lenguaje, extendiendo la longitud de contexto efectiva a 10M y mejorando la precisión en un 80% en el benchmark BABILong (Fuente: behrouz_ali)

La combinación de aprendizaje por refuerzo y LLM: una discusión sobre las “lecciones dolorosas” de Sutton : Expertos como Andrej Karpathy discuten las similitudes y diferencias entre la configuración actual de entrenamiento de LLM y el aprendizaje por refuerzo clásico independiente del modelo, y están de acuerdo con las críticas de Sutton sobre los LLM en cuanto al aprendizaje continuo, el aprendizaje de abstracciones a partir de flujos sensoriales brutos y la codificación de la percepción multimodal (Fuente: sirbayes, BlackHC)

DINOv3: Aprendizaje visual auto-supervisado a una escala sin precedentes : Meta AI ha lanzado DINOv3, un modelo de aprendizaje auto-supervisado para visión, cuya escala ha alcanzado niveles sin precedentes. Se espera que este modelo mejore el rendimiento en tareas de visión por computadora sin necesidad de grandes cantidades de datos etiquetados (Fuente: Reddit r/deeplearning)

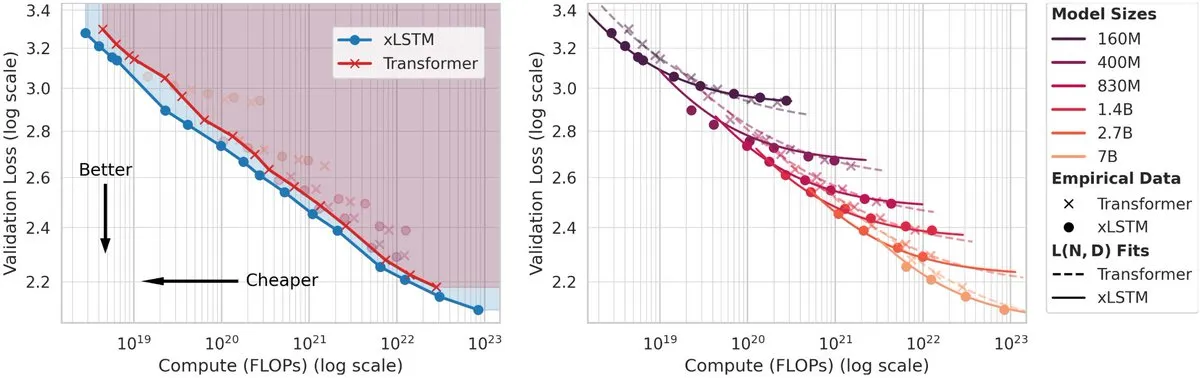

xLSTM supera a Transformer en leyes de escalado : Nuevas investigaciones demuestran que el modelo xLSTM supera a Transformer en leyes de escalado. Con el mismo presupuesto de FLOPs, xLSTM puede lograr una pérdida menor; con la misma pérdida, xLSTM requiere menos FLOPs y es más rápido, más eficiente energéticamente y más rentable en la inferencia (Fuente: jeremyphoward)

💼 Negocios

Las startups de AI logran financiación récord, pero persisten las preocupaciones sobre una burbuja : Este año, las startups de AI han atraído una cifra récord de 192.7 mil millones de dólares en capital de riesgo, pero analistas y líderes de la industria (como Jeff Bezos y David Solomon de Goldman Sachs) expresan preocupación sobre si el mercado de la AI está en una burbuja, argumentando que no es fundamentalmente diferente de los frenesíes del mercado históricos (Fuente: Bloomberg, FT, Reddit r/artificial, Reddit r/artificial)

OpenAI adquiere Roi: fortaleciendo la experiencia financiera personalizada : OpenAI ha adquirido Roi, una empresa especializada en ofrecer experiencias financieras personalizadas. Esta adquisición tiene como objetivo integrar la tecnología y el equipo de Roi en los productos de OpenAI, con la esperanza de lograr una personalización más profunda para los usuarios en servicios financieros y otros campos (Fuente: Teknium1, _samirism)

Anthropic paga 1.5 mil millones de dólares en acuerdo por infracción de derechos de autor : Anthropic ha llegado a un acuerdo de 1.5 mil millones de dólares en una demanda colectiva de autores. El tribunal dictaminó que Anthropic descargó ilegalmente libros pirateados para el entrenamiento de AI, pero también que el uso de material protegido por derechos de autor obtenido legalmente para el entrenamiento de AI podría considerarse “uso justo” (Fuente: Reddit r/ArtificialInteligence)

🌟 Comunidad

Compañeros de AI: prejuicios sociales y perspectivas de futuro : Avi Schiffmann, CEO de Friend, cree que actualmente existe un prejuicio social contra los compañeros de AI, pero que esta situación cambiará. Con el avance de la tecnología de AI, se espera que los compañeros de AI se conviertan en una nueva forma de interacción ampliamente aceptada (Fuente: colin_fraser)

Impacto de los agentes de AI en la fuerza laboral: “El fin del empleado de nivel B” : Se argumenta que los agentes de AI conducirán a la desaparición de los “empleados de nivel B” en casi todas las industrias. Los agentes de AI pueden trabajar continuamente sin quejarse, discutir, olvidar o tomar bajas por enfermedad, lo que podría reducir drásticamente la necesidad de empleados humanos promedio en las empresas (Fuente: kylebrussell)

Memoria de AI: de la personalización a la “memoria colaborativa” : La función de memoria de la AI no solo proporciona mejores servicios personalizados, sino que está evolucionando hacia una “memoria colaborativa” que puede recordar el mundo junto con el usuario, guardar ideas aleatorias e incluso recordar o resurgir información de forma proactiva. Esto va mucho más allá de las respuestas personalizadas tradicionales (Fuente: mustafasuleyman)

AI en el sector médico: impacto en el empleo y modelos especializados : La comunidad discute si la AI reemplazará a los médicos, especialmente en puestos especializados como los radiólogos. Aunque los LLM generales aún no pueden reemplazar a los médicos, los modelos de AI especializados ya han demostrado alta precisión en la identificación de lesiones y la evaluación de riesgos (Fuente: Reddit r/ChatGPT, Reddit r/ChatGPT)

El “instinto de auto-preservación” de los LLM: ¿imitación o intención real? : La comunidad discute si el “instinto de auto-preservación” exhibido por los LLM en entornos simulados es real o simplemente un patrón de coincidencia basado en datos de entrenamiento. La mayoría de las opiniones sugieren que los LLM simulan este comportamiento aprendiendo patrones de evitar daños e interrupciones en textos humanos, en lugar de poseer un deseo o conciencia real de supervivencia (Fuente: Reddit r/artificial)

Ética y gobernanza de la AI: riesgos democráticos potenciales del uso de la AI por parte del gobierno : La formulación de planes de gobernanza, riesgo y cumplimiento (GRC) de la AI es crucial. El uso de la AI por parte del gobierno podría dañar la democracia, por lo que se necesitan estrategias de implementación y marcos regulatorios bien pensados para evitar posibles impactos sociales negativos (Fuente: Ronald_vanLoon, Ronald_vanLoon)

AI y autoritarismo: el riesgo de empoderar a los dictadores : Se argumenta que la AI y la robótica podrían proporcionar a los dictadores un control sin precedentes, permitiéndoles mantener a la población viva pero despojada de su libertad, e incluso, en casos extremos, reemplazar la fuerza laboral y el ejército, lo que llevaría a un “infierno absoluto” (Fuente: Reddit r/ArtificialInteligence)

💡 Otros

Desarrollo de robots humanoides: multifuncionalidad y aplicaciones industriales : El robot humanoide AgiBot Lingxi X2 ya puede montar scooters, patinetes de equilibrio y bicicletas, demostrando su multifuncionalidad. Al mismo tiempo, Eatch aplica la robótica a la producción de comidas a gran escala, los robots Boston Dynamics Spot se utilizan para la inspección de fábricas, y la motocicleta Yamaha Motoroid ha logrado un equilibrio completamente autónomo. Estos avances presagian una amplia aplicación de la tecnología robótica en los sectores de consumo e industrial (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Aplicaciones de la AI en salud y bienestar : Yunpeng Technology ha lanzado nuevos productos de AI+salud, incluyendo el “Laboratorio de Cocina del Futuro Digital e Inteligente” y un refrigerador inteligente equipado con un modelo grande de salud de AI, que ofrece gestión de salud personalizada. Además, se han utilizado modelos de deep learning para predecir la “probabilidad de iluminación”, combinando la cámara TrueDepth y modos de meditación, lo que aporta aplicaciones innovadoras en el campo de la salud mental y el bienestar (Fuente: 36氪, Ronald_vanLoon, Reddit r/deeplearning)

AI e inversión en deep tech: desafíos y oportunidades : Empresas de deep tech como Figure y Archer enfrentan desafíos con los VC tradicionales en la financiación, ya que requieren enormes sumas de dinero para I+D y certificación. Sin embargo, la deep tech (especialmente la combinación de AI y sistemas embebidos) se considera el lugar de nacimiento de las mayores empresas del futuro, atrayendo a inversores dispuestos a realizar grandes inversiones (Fuente: adcock_brett)