Palabras clave:GPT-5, Computación cuántica, Diseño de materiales con IA, Aprendizaje por refuerzo, Modelos de lenguaje grandes (LLM), Infraestructura de IA, Modelos multimodales, Agente de IA, Problemas NP difíciles cuánticos, CGformer: Red neuronal de gráficos cristalinos, Marco RLMT para aprendizaje por refuerzo, DeepSeek DSA: Atención dispersa, UniVid: Marco unificado para tareas visuales

🔥 Enfoque

GPT-5 supera el “problema NP cuántico”: El experto en computación cuántica Scott Aaronson publicó por primera vez un artículo que revela el papel de asistencia innovador de GPT-5 en la investigación de la teoría de la complejidad cuántica. GPT-5 ayudó a resolver un paso clave de deducción en el “problema NP cuántico” en 30 minutos, una tarea que normalmente llevaría a los humanos de 1 a 2 semanas. Este logro marca que la IA ha comenzado a tocar el trabajo central de descubrimiento científico de la inteligencia humana, presagiando un gran salto en el potencial de la IA en el campo de la investigación científica. (Fuente: arXiv, scottaaronson.blog)

Nuevo modelo de diseño de materiales con IA: CGformer: El equipo de los profesores Li Jinjin y Huang Fuqiang de la Universidad Jiao Tong de Shanghái ha desarrollado un nuevo modelo de diseño de materiales con IA, CGformer. Este modelo rompe las limitaciones de las redes neuronales de grafos cristalinos tradicionales al integrar de forma innovadora el mecanismo de atención global de Graphormer con CGCNN, e incorporar codificación de centralidad y codificación espacial. El modelo puede capturar completamente la información global de estructuras cristalinas complejas, mejorando significativamente la precisión de predicción y la eficiencia de cribado de nuevos materiales como los electrolitos sólidos de iones de sodio de alta entropía. (Fuente: Matter)

UniVid: Marco unificado para tareas visuales: UniVid es un marco innovador que adapta un Transformer de difusión de video preentrenado para diversas tareas de imagen y video sin necesidad de modificaciones específicas para cada tarea. Este método representa las tareas como “declaraciones visuales”, definiendo la tarea y la modalidad de salida esperada a través de secuencias contextuales, demostrando el enorme potencial de los modelos de generación de video preentrenados como base unificada para el modelado visual. (Fuente: HuggingFace Daily Papers)

RLMT revoluciona el post-entrenamiento de grandes modelos: El equipo de la profesora asociada Danqi Chen de la Universidad de Princeton ha propuesto el marco de “Aprendizaje por Refuerzo basado en el Pensamiento de Recompensa del Modelo” (RLMT), que permite a los LLM generar largas cadenas de pensamiento antes de responder y optimiza el RL en línea con un modelo de recompensa basado en preferencias. Este método mejora significativamente la capacidad de razonamiento y la generalización de los LLM en tareas abiertas, e incluso permite que un modelo de 8B supere a GPT-4o en chat y escritura creativa. (Fuente: arXiv)

CHURRO: Modelo de reconocimiento de texto histórico: CHURRO es un modelo de lenguaje visual (VLM) de código abierto con 3B parámetros, diseñado específicamente para el reconocimiento de texto histórico de alta precisión y bajo costo. Entrenado en CHURRO-DS, un conjunto de datos de 99,491 páginas de documentos históricos que abarcan 22 siglos y 46 idiomas, su rendimiento supera a los VLM existentes como Gemini 2.5 Pro, mejorando significativamente la eficiencia en la investigación y preservación del patrimonio cultural. (Fuente: HuggingFace Daily Papers)

🎯 Tendencias

Altman predice la superinteligencia de la IA y la función Pulse: Sam Altman predice que la IA superará por completo la inteligencia humana para 2030 y señala la asombrosa velocidad de desarrollo de la IA. OpenAI ha lanzado la función “modo activo” Pulse para ChatGPT, lo que marca un cambio de la IA de la respuesta pasiva a la reflexión proactiva para el usuario, capaz de proporcionar información relevante de forma autónoma basándose en las conversaciones del usuario, logrando un servicio altamente personalizado y presagiando que la IA se convertirá en una externalización del subconsciente humano. (Fuente: 36氪, )

Jensen Huang refuta la teoría de la burbuja de la IA y la estrategia de NVIDIA: Jensen Huang refutó la teoría del “imperio de la burbuja de la IA” en una entrevista, enfatizando el papel clave de la IA en la economía y prediciendo que NVIDIA podría convertirse en la primera empresa con una capitalización de mercado de 10 billones de dólares. Señaló que el razonamiento de la IA oculta una enorme demanda de potencia computacional. NVIDIA, a través de un diseño de co-diseño extremo, lanza nuevas arquitecturas anualmente y abre su ecosistema de sistemas, sin temor a la tendencia de desarrollo propio, con el objetivo de dar forma al sistema económico de la IA e impulsar la “IA soberana” como un nuevo consenso. (Fuente: 36氪, )

DeepSeek lanza V3.2-Exp de código abierto y el mecanismo DSA: DeepSeek ha lanzado la versión experimental V3.2-Exp de código abierto con 685B parámetros, y ha publicado simultáneamente un artículo que detalla su nuevo mecanismo de atención dispersa (DeepSeek Sparse Attention, DSA). DSA tiene como objetivo explorar y verificar la optimización de la eficiencia de entrenamiento e inferencia en escenarios de contexto largo, mejorando significativamente la eficiencia del procesamiento de contexto largo mientras mantiene la calidad de la salida del modelo. (Fuente: 36氪, HuggingFace)

Próximo lanzamiento de GLM-4.6: Se espera el próximo lanzamiento del modelo GLM-4.6 de Zhipu AI; su sitio web oficial Z.ai ya ha etiquetado a GLM-4.5 como el “modelo insignia de la generación anterior”, lo que sugiere posibles mejoras en aspectos como la longitud del contexto en la nueva versión, generando atención y expectación en la comunidad. (Fuente: Reddit r/LocalLLaMA, karminski3)

Estrategia de IA de Apple y el chatbot interno Veritas: Se ha revelado un chatbot de IA desarrollado internamente por Apple, con el nombre en clave “Veritas”, que actúa como sparring para Siri y es capaz de realizar operaciones dentro de las aplicaciones. A pesar de esto, Apple insiste en no lanzar un chatbot de consumo, centrándose en la integración de IA a nivel de sistema y planeando profundizar la integración de modelos de terceros a través de un motor de respuestas de IA y la interfaz universal MCP, en lugar de desarrollar su propio chatbot. (Fuente: 36氪)

Crecimiento del mercado de AI PC y cuellos de botella tecnológicos: Se espera que los envíos del mercado de AI PC crezcan fuertemente en 2025-2026, pero impulsados principalmente por el fin del soporte de Windows 10 y el ciclo de reemplazo de PC, no por una disrupción de la tecnología de IA. Actualmente, las funciones de IA son en su mayoría complementos de las PC tradicionales y enfrentan desafíos como la insuficiencia de potencia computacional local, la interacción pasiva y un ecosistema cerrado. Un verdadero dispositivo de IA debe lograr “potencia computacional local como principal, complementada por la nube” y una percepción activa. (Fuente: 36氪)

La IA irrumpe en el mercado de comercio de energía: La IA se está aplicando ampliamente en el mercado de comercio de energía, con empresas como Qingpeng Smart utilizando grandes modelos de series temporales para predecir la generación de energía eólica y solar y la demanda de electricidad, asistiendo en las decisiones comerciales. La ventaja de la IA para procesar grandes volúmenes de datos promete amplificar las ganancias, pero también podría generar pérdidas debido a modelos inmaduros y la complejidad del mercado; la industria aún se encuentra en una fase exploratoria. (Fuente: 36氪)

Actualización del modelo grande Tongyi de Alibaba y servicios de IA de pila completa: Alibaba Cloud actualizó significativamente su sistema de IA de pila completa en la Conferencia Apsara, lanzando 6 nuevos modelos como Qwen3-MAX y Qwen3-Omni, posicionándose como un “proveedor de servicios de inteligencia artificial de pila completa”. Alibaba Cloud se compromete a construir el “Android de la era de la IA” y la “próxima generación de computadoras”, ofreciendo servicios de nube de IA de pila completa, desde modelos básicos hasta infraestructura, para abordar la evolución de los AI Agents desde la “emergencia de la inteligencia” hasta la “acción autónoma”. (Fuente: 36氪)

Análisis en profundidad de la arquitectura NVIDIA Blackwell: Un evento de análisis en profundidad de la arquitectura NVIDIA Blackwell explorará su arquitectura, optimizaciones e implementación en la nube de GPU. El evento, presentado por expertos de SemiAnalysis y NVIDIA, tiene como objetivo revelar cómo la GPU Blackwell, como la “GPU de la próxima década”, impulsará el desarrollo de la potencia computacional de la IA y el futuro de la nube de GPU. (Fuente: TheTuringPost)

🧰 Herramientas

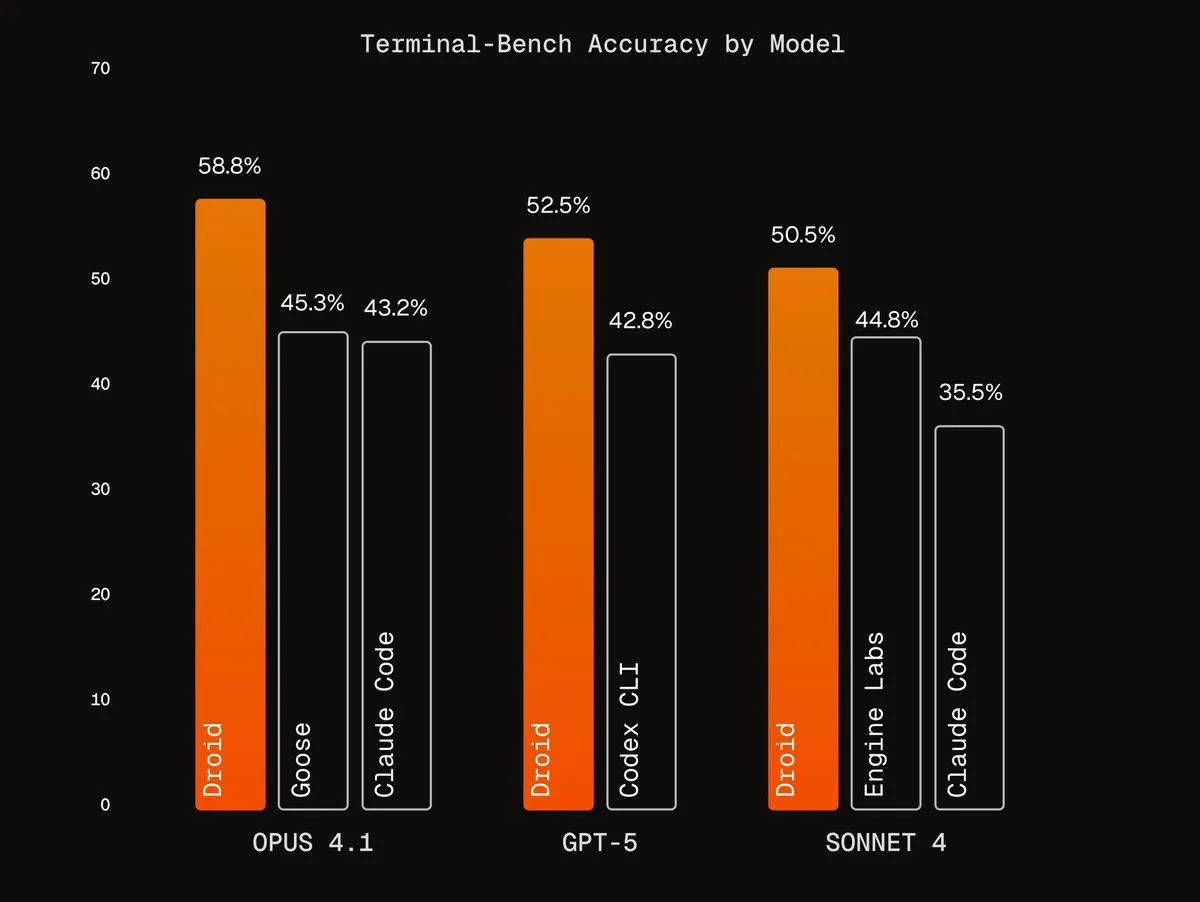

Agentic Harnesses de Factory AI: Factory AI ha desarrollado Agentic Harnesses de clase mundial que mejoran significativamente el rendimiento de los modelos existentes, destacando especialmente en tareas de codificación, siendo llamados “códigos de trucos” por los usuarios. Sus agentes Droids ocupan el primer lugar en Terminal-Bench y logran una refactorización de código confiable a través de flujos de trabajo de verificación multi-agente. (Fuente: Vtrivedy10, matanSF, matanSF)

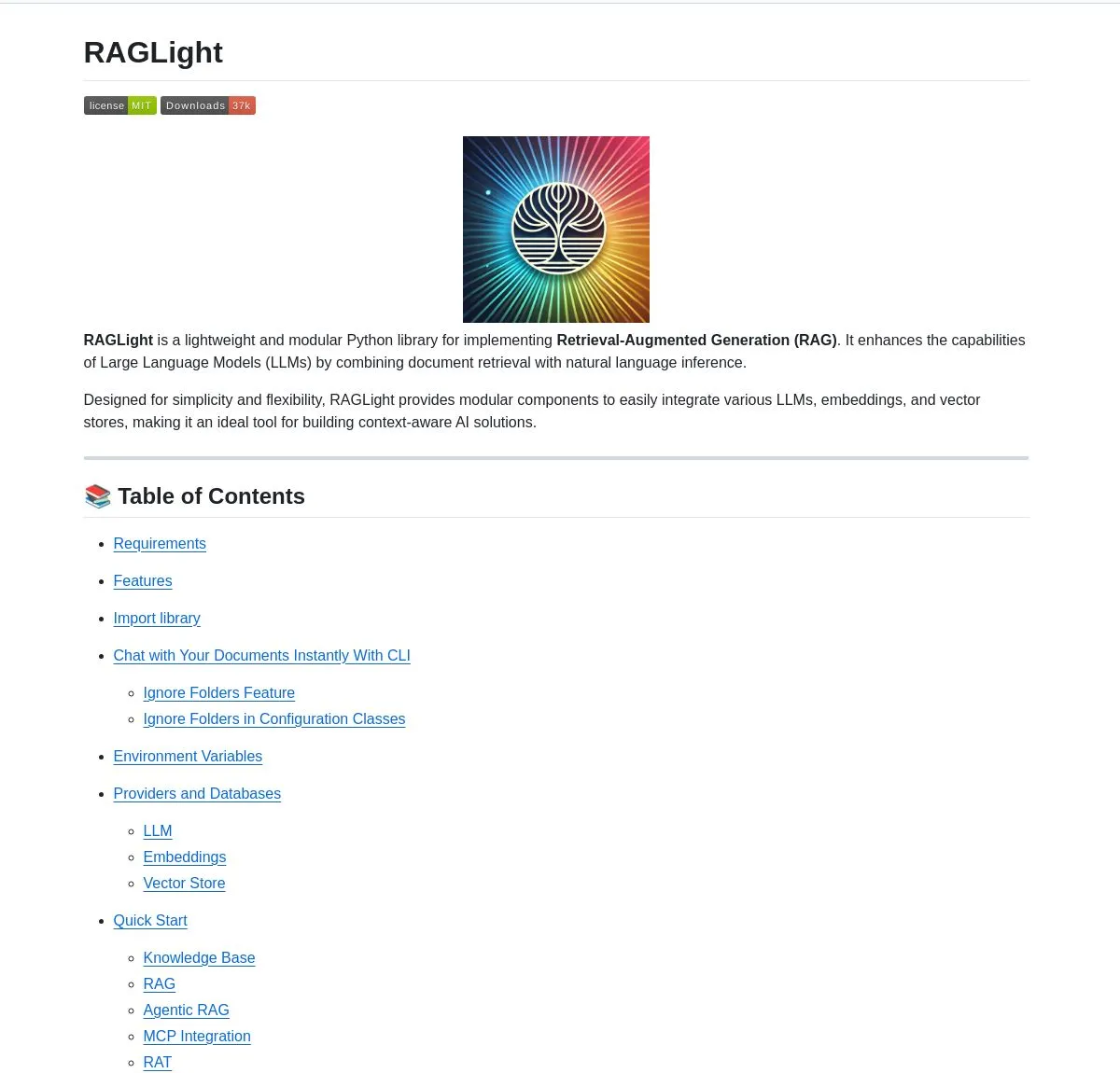

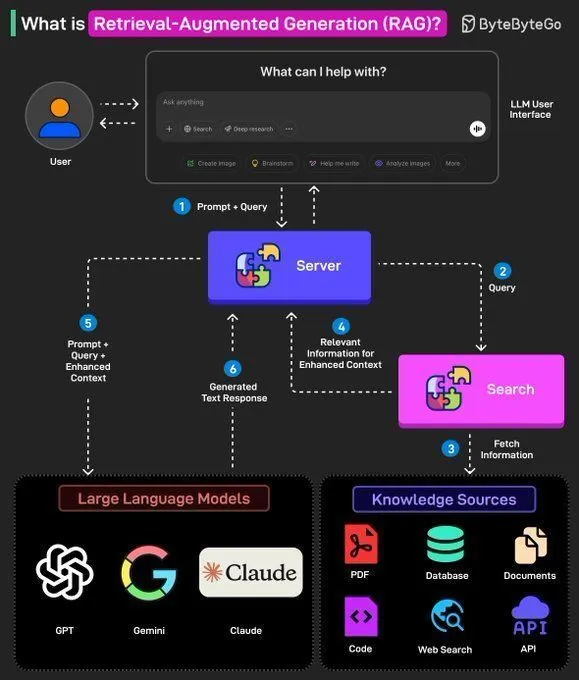

RAGLight: Biblioteca RAG de código abierto: LangChainAI ha lanzado RAGLight, una biblioteca Python ligera para construir sistemas RAG de nivel de producción. La biblioteca cuenta con pipelines de agentes impulsados por LangGraph, soporte para LLM de múltiples proveedores, integración con GitHub incorporada y herramientas CLI, con el objetivo de simplificar el desarrollo y la implementación de sistemas RAG. (Fuente: LangChainAI, hwchase17)

ArgosOS: Sistema operativo semántico: ArgosOS es una aplicación de escritorio que permite la búsqueda inteligente y la integración de contenido de documentos a través de una arquitectura basada en etiquetas en lugar de bases de datos vectoriales. Utiliza LLM para crear etiquetas relevantes y las almacena en una base de datos SQLite, procesando consultas de forma inteligente, como analizar facturas de compra, ofreciendo una solución de gestión de documentos precisa y eficiente para aplicaciones a pequeña escala. (Fuente: Reddit r/MachineLearning)

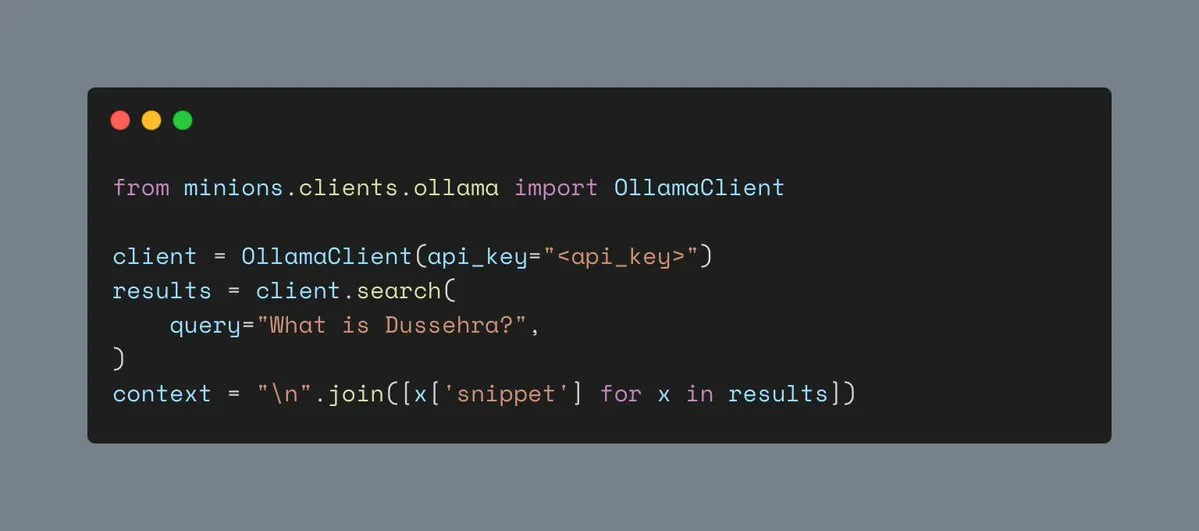

Herramienta de búsqueda web de Ollama: Ollama ahora es compatible con herramientas de búsqueda web, permitiendo a los usuarios integrar la funcionalidad de búsqueda web en las cargas de trabajo de Minions, enriqueciendo así la información contextual de las aplicaciones de IA y mejorando su capacidad para manejar tareas complejas. (Fuente: ollama)

Hyperlink: RAG multimodal local: Hyperlink ofrece capacidades RAG multimodales locales, permitiendo a los usuarios buscar y resumir capturas de pantalla/galerías de fotos sin conexión. A través de OCR y tecnologías de embedding, la herramienta puede transformar datos de imagen no estructurados en contenido consultable, logrando una gestión de documentos y extracción de información completamente privada y en el dispositivo. (Fuente: Reddit r/LocalLLaMA)

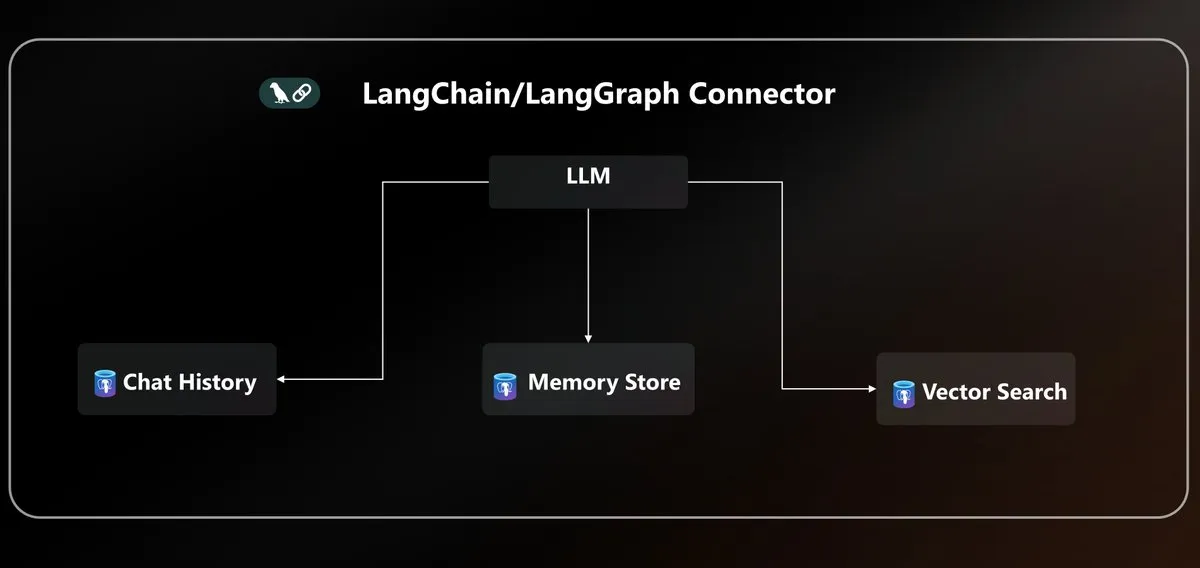

Conector Azure PostgreSQL LangChain: Microsoft ha lanzado un conector nativo de Azure PostgreSQL, unificando la persistencia de agentes para el ecosistema LangChain. Este conector ofrece almacenamiento vectorial de nivel empresarial y gestión de estados, simplificando la complejidad de construir e implementar agentes de IA en el entorno de Azure. (Fuente: LangChainAI)

Estandarización de la API de LLM y el protocolo MCP: La comunidad discute el problema de la fragmentación de la API de LLM, señalando incompatibilidades en las estructuras de mensajes, patrones de llamada a herramientas y nombres de campos de inferencia de diferentes proveedores, y pidiendo la estandarización del protocolo JSON API en la industria. Al mismo tiempo, la introducción del protocolo MCP (Model-Client Protocol) también ha generado discusiones sobre su impacto en el desarrollo de agentes. (Fuente: AAAzzam, charles_irl)

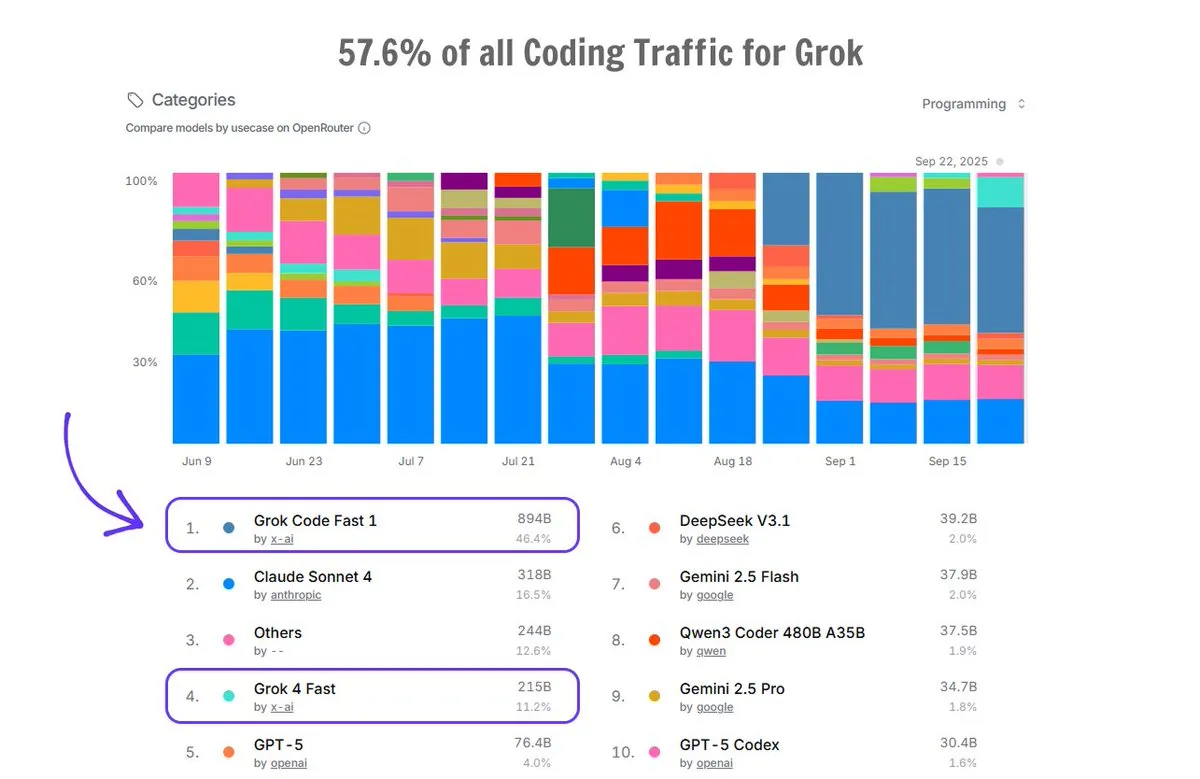

Aplicación de Grok Code en OpenRouter: Grok Code ha capturado el 57.6% del tráfico de codificación en la plataforma OpenRouter, superando la suma de todos los demás generadores de código de IA, con Grok Code Fast 1 ocupando el primer lugar, lo que demuestra su fuerte rendimiento en el mercado y la preferencia de los usuarios en el campo de la generación de código. (Fuente: imjaredz)

📚 Aprendizaje

Curso básico de IA: Cursor Learn: Lee Robinson ha lanzado Cursor Learn, una serie de videos gratuita de seis partes diseñada para ayudar a los principiantes a dominar conceptos básicos de IA como tokens, context y agents. El curso dura aproximadamente 1 hora, ofrece cuestionarios y pruebas de modelos de IA, siendo un recurso conveniente para aprender los fundamentos de la IA. (Fuente: crystalsssup)

Libro gratuito sobre estructuras de datos en Python: Donald R. Sheehy ha publicado un libro gratuito titulado “A First Course on Data Structures in Python”, que cubre estructuras de datos, pensamiento algorítmico, análisis de complejidad, recursión/programación dinámica y métodos de búsqueda, proporcionando una base sólida para estudiantes en los campos de la IA y el aprendizaje automático. (Fuente: TheTuringPost)

dots.ocr: Modelo OCR multilingüe: Hi Lab de Xiaohongshu ha lanzado dots.ocr, un potente modelo OCR multilingüe que soporta 100 idiomas, capaz de analizar texto, tablas, fórmulas y diseños de extremo a extremo (con salida en Markdown), y es gratuito para uso comercial. El modelo es compacto (1.7B VLM) pero logra un rendimiento SOTA en OmniDocBench y dots.ocr-bench. (Fuente: mervenoyann)

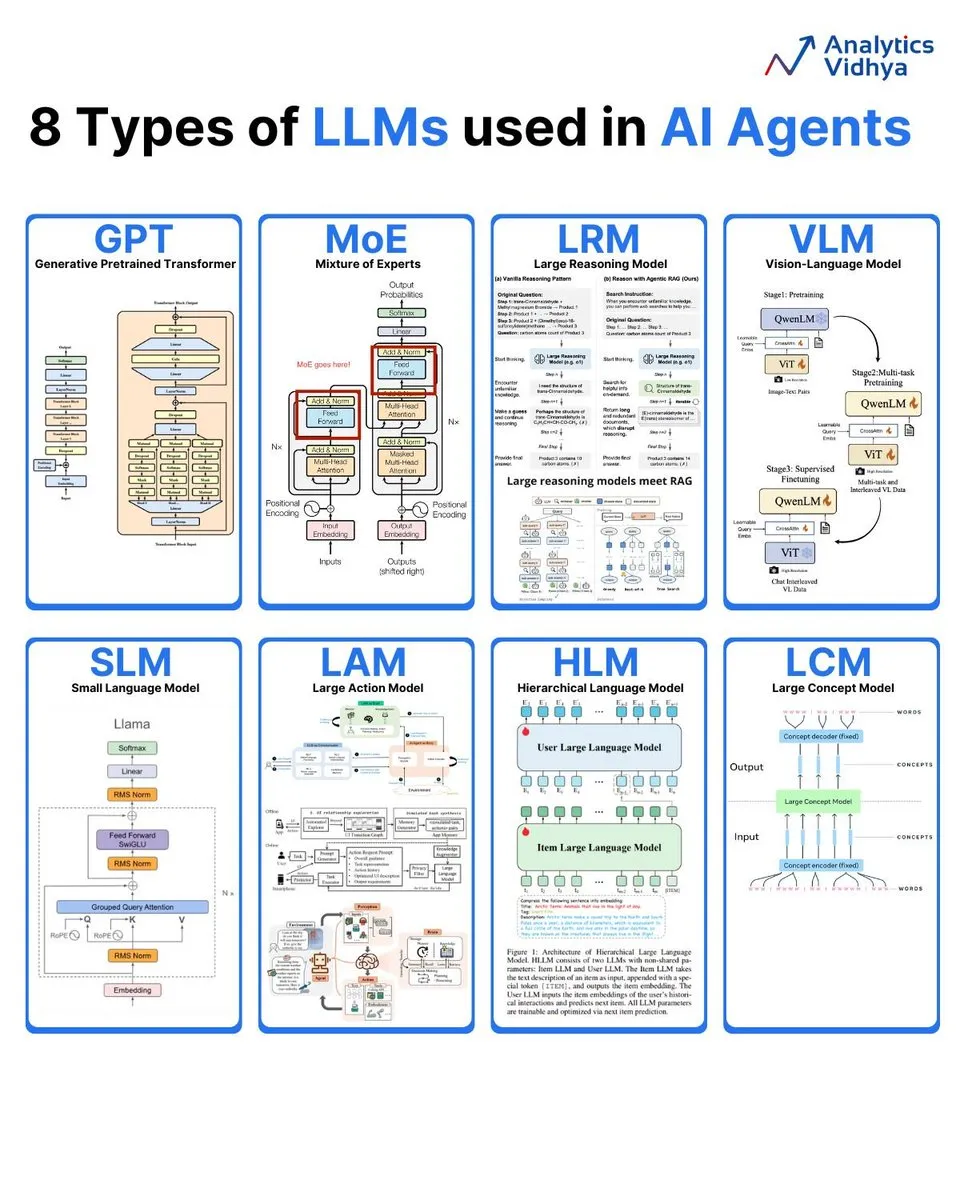

Análisis de 8 tipos de modelos de lenguaje grandes: Analytics Vidhya ha resumido 8 tipos principales de modelos de lenguaje grandes, incluyendo GPT (Generative Pre-trained Transformer), MoE (Mixture of Experts), LRM (Large Reasoning Model), VLM (Visual Language Model), SLM (Small Language Model), LAM (Large Action Model), HLM (Hierarchical Language Model) y LCM (Large Concept Model), detallando sus arquitecturas y aplicaciones. (Fuente: karminski3)

Informe semanal de IA: Resumen de los últimos artículos: DAIR.AI ha publicado una selección de artículos de IA de esta semana (22-28 de septiembre), cubriendo varias investigaciones de vanguardia como ATOKEN, LLM-JEPA, Code World Model, Teaching LLMs to Plan, Agents Research Environments, Language Models that Think, Chat Better, Embodied AI: From LLMs to World Models, proporcionando las últimas actualizaciones para los investigadores de IA. (Fuente: dair_ai)

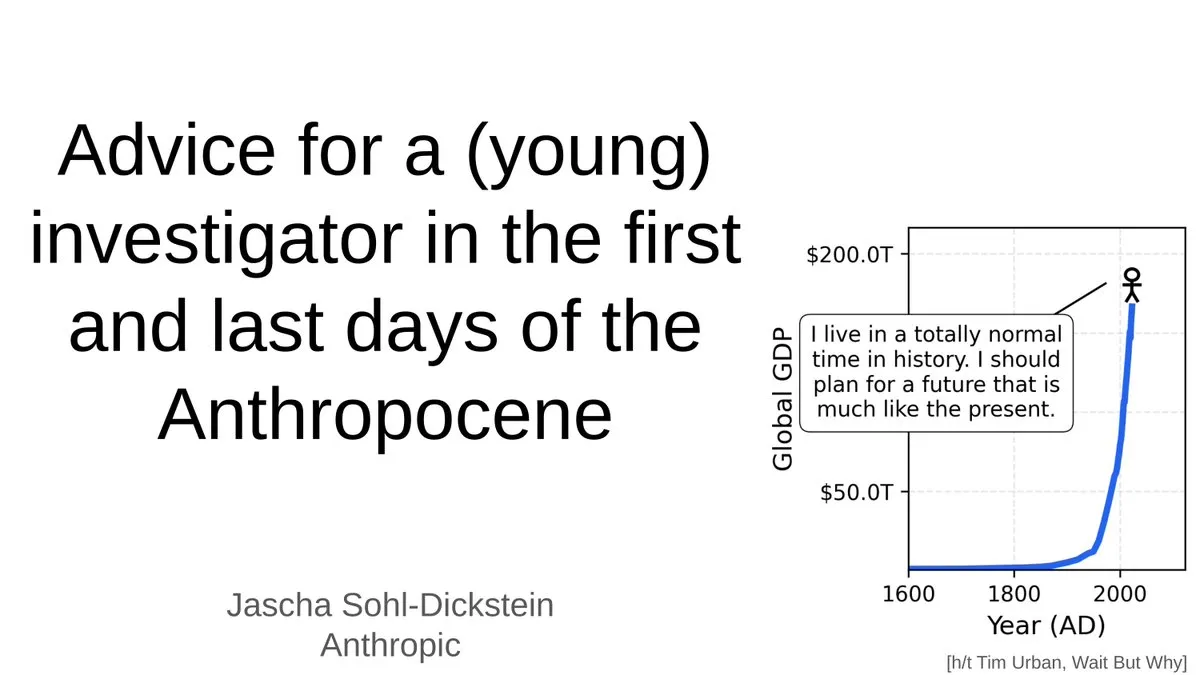

Consejos para jóvenes investigadores en la era de la IA: Jascha Sohl-Dickstein compartió consejos prácticos para jóvenes investigadores sobre cómo elegir proyectos de investigación y tomar decisiones profesionales en la fase final del “Antropoceno”. Exploró el profundo impacto de la AGI en las carreras académicas y enfatizó la necesidad de repensar las direcciones de investigación y el desarrollo profesional en un contexto donde los sistemas de IA superarán la inteligencia humana. (Fuente: mlpowered)

Conceptos de RAG y construcción de AI Agents: Ronald van Loon compartió los conceptos básicos de RAG (Generación Aumentada por Recuperación) y su importancia en los LLM, y proporcionó 8 pasos clave para construir un AI Agent. El contenido cubre el concepto de AI Agent, su stack, ventajas y cómo evaluarlo a través de frameworks, ofreciendo una guía desde la teoría hasta la práctica para los desarrolladores de IA. (Fuente: Ronald_vanLoon, Ronald_vanLoon)

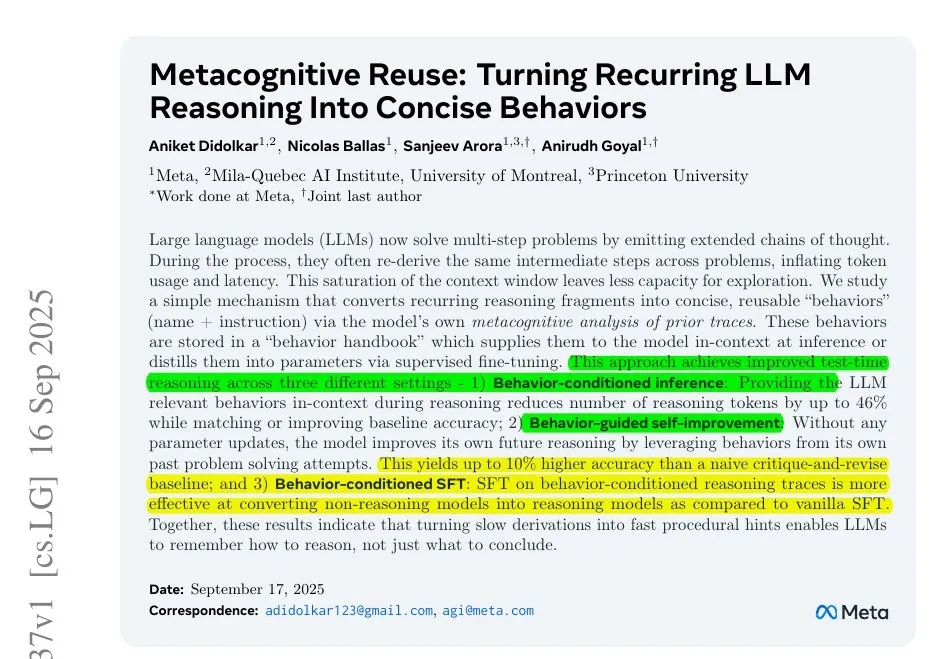

Meta aborda la ineficiencia de inferencia de LLM: Una investigación de Meta revela el problema de la ineficiencia de inferencia en los LLM, causada por el trabajo repetitivo en largas cadenas de pensamiento. Proponen comprimir los pasos repetitivos en pequeñas acciones nombradas, permitiendo que el modelo invoque estas acciones en lugar de volver a deducir, lo que reduce el consumo de tokens y mejora la eficiencia y precisión de la inferencia, ofreciendo una nueva perspectiva para optimizar el proceso de inferencia de LLM. (Fuente: ylecun)

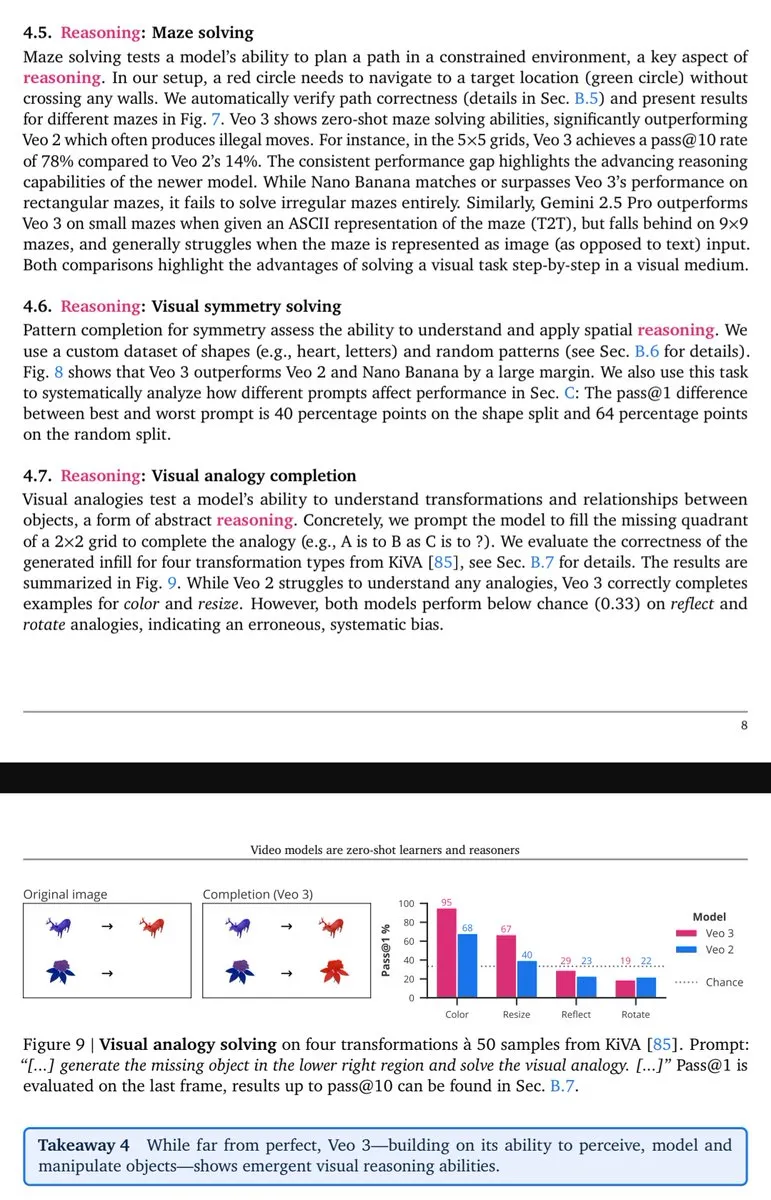

Veo-3: Emergencia de capacidades de razonamiento visual: Lisan al Gaib señala que el modelo de video Veo-3 muestra capacidades de razonamiento (visual) emergentes similares a las de GPT-3, lo que presagia que los modelos multimodales nativos, una vez que alcancen su máximo potencial, aportarán beneficios más completos en comprensión y razonamiento visual. (Fuente: scaling01)

💼 Negocios

La apuesta de cien mil millones de OpenAI y la burbuja de la infraestructura de IA: OpenAI está tejiendo una gigantesca red que abarca chips, computación en la nube y centros de datos a un ritmo de gasto vertiginoso, incluyendo una inversión de 100 mil millones de dólares de NVIDIA y una colaboración de 300 mil millones de dólares con Oracle para “Stargate”. Aunque se espera que los ingresos de 2025 sean de solo 13 mil millones de dólares, la dirección de OpenAI considera que la inversión en infraestructura de IA es una “oportunidad única en un siglo”, lo que ha provocado un debate sobre si la infraestructura de IA se enfrenta a una burbuja similar a la de Internet. (Fuente: 36氪)

Elon Musk demanda a OpenAI por sexta vez: xAI, la compañía de Elon Musk, ha demandado a OpenAI por sexta vez, acusándola de reclutar sistemáticamente a sus empleados y de robar ilegalmente secretos comerciales como el código fuente del modelo grande Grok y planes estratégicos de centros de datos. Esta demanda marca una intensificación de la competencia entre los dos gigantes de la IA. Musk cree que OpenAI se ha desviado de su misión original sin fines de lucro, mientras que OpenAI niega las acusaciones, calificándolas de “acoso continuo”. (Fuente: 36氪)

El científico de IA de primer nivel Steven Hoi se une a Alibaba Tongyi: Steven Hoi, científico de IA de renombre mundial y IEEE Fellow, se ha unido al laboratorio Alibaba Tongyi, donde se dedicará a la investigación fundamental y de vanguardia en modelos multimodales grandes. Con más de 20 años de experiencia en I+D industrial y académica en IA, Steven Hoi fue vicepresidente de Salesforce y fundó HyperAGI. Su incorporación marca una nueva y fuerte apuesta de Alibaba en el campo de los modelos multimodales grandes para acelerar la eficiencia de la iteración de modelos y los avances innovadores multimodales. (Fuente: 36氪)

🌟 Comunidad

Disminución del rendimiento de ChatGPT 4o y el estado de ánimo de los usuarios: Un gran número de usuarios de ChatGPT informan de una disminución en el rendimiento del modelo 4o, con problemas de “reducción” y “enrutamiento de seguridad”, lo que ha llevado a la frustración y la sensación de engaño entre los usuarios. Muchos usuarios neurodiversos están particularmente tristes, considerando que 4o fue una “línea de vida” para su comunicación y autocomprensión. Los usuarios cuestionan en general la falta de transparencia de OpenAI y exigen que cumpla su promesa de “tratar a los usuarios como adultos”, oponiéndose a los mecanismos de censura poco claros. (Fuente: Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT)

Debate sobre empleo y despidos en la era de la IA: La comunidad debate acaloradamente el impacto de la IA en el mercado laboral, incluyendo la disminución significativa de puestos de nivel inicial, los despidos empresariales concurrentes con las inversiones en IA, y la veracidad de los motivos de despido relacionados con la IA. La discusión señala la tendencia de que “las personas que entienden de IA reemplazan a las que no”, y pide a las empresas que rediseñen los trabajos de nivel de entrada en lugar de simplemente eliminarlos, para cultivar talentos escasos adaptados a las necesidades de la era de la IA. (Fuente: 36氪, 36氪, Reddit r/artificial)

Desafíos y barreras en la investigación de LLM: La comunidad debate acaloradamente el creciente umbral de la investigación en aprendizaje automático, donde los investigadores individuales luchan por competir con los grandes gigantes tecnológicos. Frente a desafíos como la gran cantidad de artículos, el costoso poder computacional y las complejas teorías matemáticas, muchos encuentran difícil empezar y lograr avances, lo que genera preocupaciones sobre la sostenibilidad del campo. (Fuente: Reddit r/MachineLearning)

Impacto de los modelos MoE en el alojamiento local: La comunidad discute en profundidad las ventajas y desventajas de los modelos MoE para el alojamiento local de LLM. Se argumenta que, aunque los modelos MoE consumen más VRAM, son computacionalmente eficientes y pueden ejecutar modelos más grandes mediante la descarga a la CPU, siendo especialmente adecuados para hardware de consumo con suficiente memoria pero GPU limitada, lo que los convierte en una forma efectiva de mejorar el rendimiento de los LLM. (Fuente: Reddit r/LocalLLaMA)

Rápido desarrollo y aplicación de AI Agents: La comunidad discute el rápido desarrollo de los AI Agents, cuyas capacidades han mejorado rápidamente de “casi inutilizables” a “funcionar bien” en escenarios específicos, e incluso “los agentes generales están empezando a ser útiles” en menos de un año, superando las expectativas en velocidad de progreso. Sin embargo, también hay quienes opinan que los agentes de codificación actuales son muy homogéneos y carecen de diferencias significativas. (Fuente: nptacek, HamelHusain)

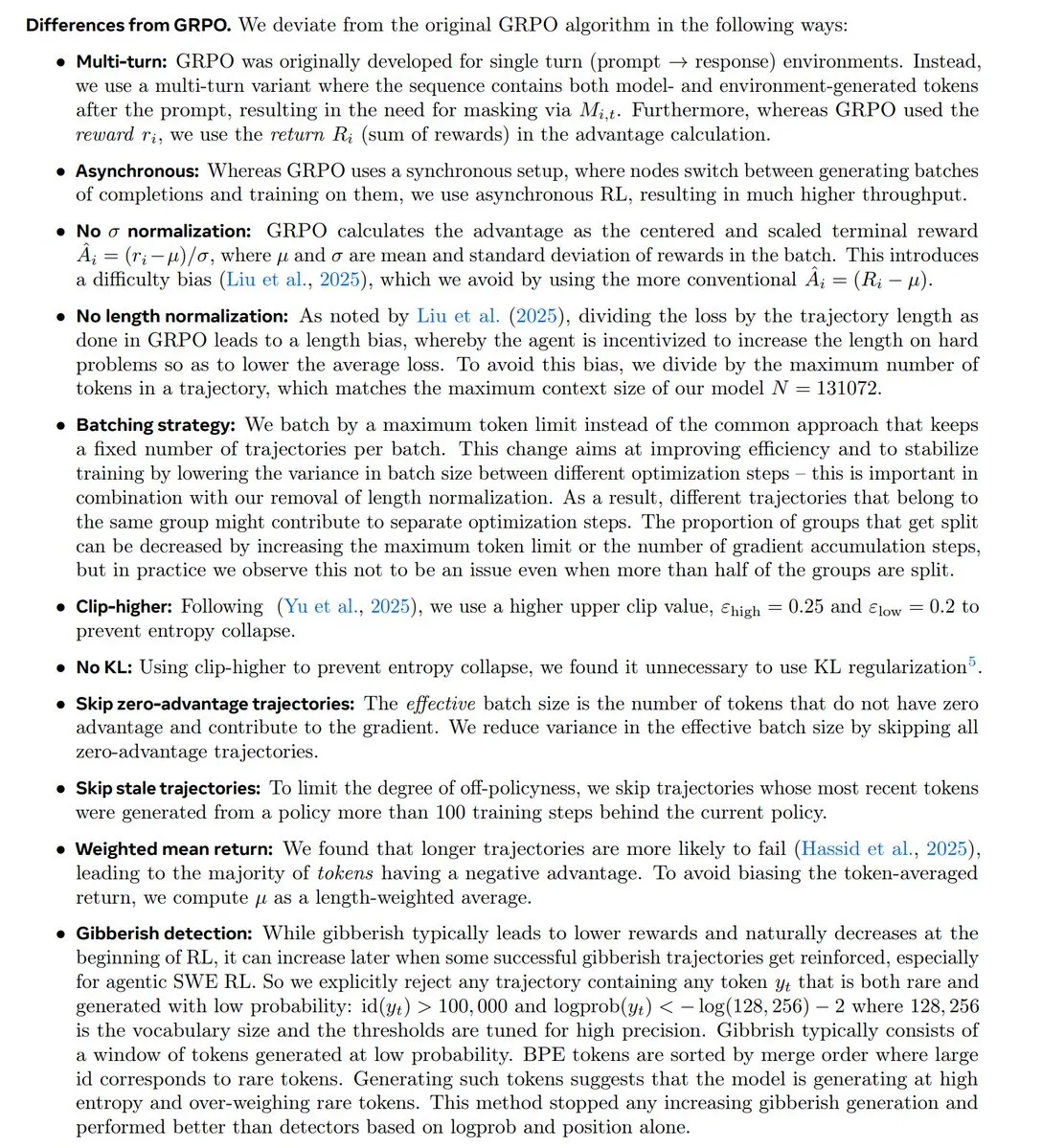

Tendencias de investigación en RL y la controversia GRPO: La comunidad discute en profundidad las últimas tendencias en investigación de Aprendizaje por Refuerzo (RL), especialmente el estatus y la controversia del algoritmo GRPO. Algunos opinan que la investigación en RL está cambiando hacia el preentrenamiento/modelado y que GRPO es un avance importante de código abierto, pero empleados de OpenAI creen que está significativamente por detrás de las tecnologías de vanguardia, lo que ha provocado un intenso debate sobre la innovación algorítmica y el rendimiento real. (Fuente: natolambert, MillionInt, cloneofsimo, jsuarez5341, TheTuringPost)

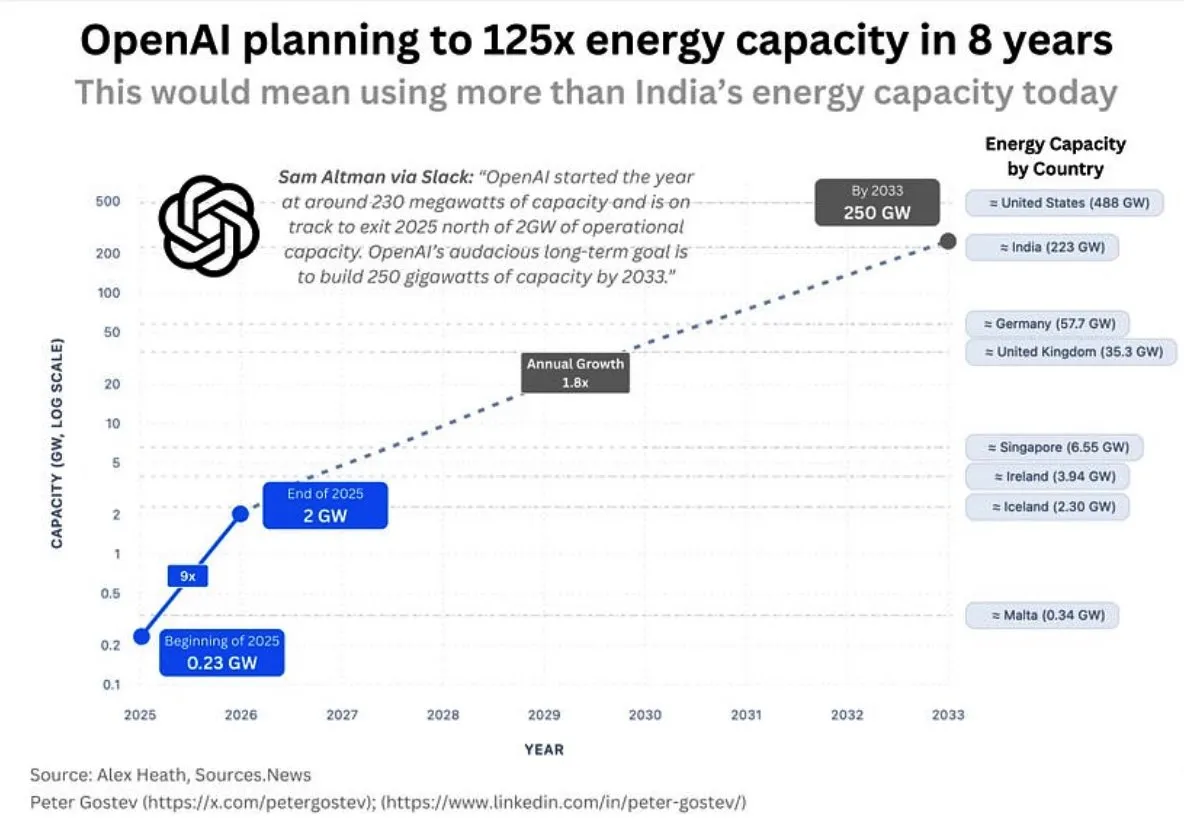

Consumo de energía de OpenAI e infraestructura de IA: La comunidad discute la enorme demanda energética futura de OpenAI, estimando que consumirá más energía que el Reino Unido o Alemania en cinco años, y más que la India en ocho, lo que genera preocupación sobre la escala de la construcción de infraestructura de IA, el suministro de energía y el impacto ambiental. Al mismo tiempo, la elección de la ubicación de los centros de datos de Google también ha encontrado la oposición de los residentes locales debido a problemas de consumo de agua. (Fuente: teortaxesTex, brickroad7)

La “Bitter Lesson” de Sutton y el desarrollo de la IA: La comunidad discute las implicaciones de la “Bitter Lesson” de Richard Sutton para la investigación en IA, enfatizando que los métodos computacionales generales son superiores al conocimiento previo humano. La discusión se centra en la relación entre “imitación y modelos del mundo”, argumentando que la mera imitación puede llevar al “culto al cargo” y que la imitación sin experiencia real tiene limitaciones fundamentales. (Fuente: rao2z, jonst0kes)

💡 Otros

BionicWheelBot: Robot biónico: El robot BionicWheelBot logra una navegación multifuncional en terrenos complejos imitando el movimiento de rodadura de la araña rueda. Esta innovación demuestra el potencial de la biónica en el diseño de robots, ofreciendo nuevas soluciones para que los futuros robots se adapten a entornos cambiantes. (Fuente: Ronald_vanLoon)

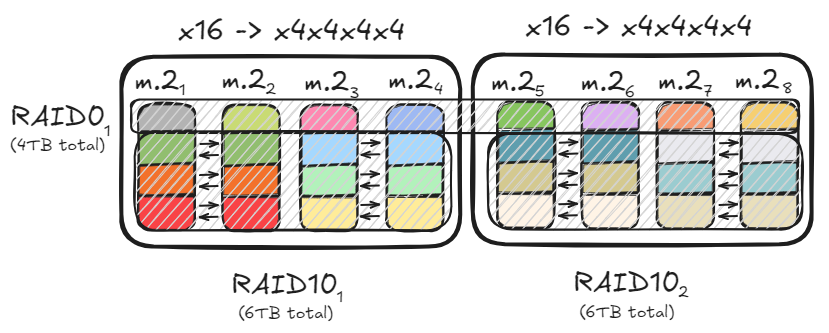

Optimización de almacenamiento de PC y configuración RAID: Los usuarios comparten cómo lograr un rendimiento de datos de hasta 47 GB/s a través de configuraciones RAID0 y RAID10, utilizando múltiples canales PCIe y unidades M.2, para acelerar la carga de modelos grandes. Esta solución de optimización satisface las necesidades de lectura/escritura de alta velocidad, al tiempo que considera la capacidad de almacenamiento y la redundancia de datos, proporcionando una base de hardware eficiente para la implementación local de modelos de IA. (Fuente: TheZachMueller)

Apertura de la “Comunidad Industrial AI+ Shuxiwan” en Liangzhu: La “Comunidad Industrial AI+ Shuxiwan” en Liangzhu, Hangzhou, ha abierto oficialmente, centrándose en campos de vanguardia como la inteligencia artificial, la economía nómada digital y la creatividad cultural. Esta comunidad, a través de las políticas especiales “Ocho Artículos de Shuxi” y el diseño espacial de “Cuatro Escenarios”, ofrece apoyo de ciclo completo a los exploradores de IA, desde la concepción de ideas hasta el liderazgo del ecosistema, con el objetivo de crear un ecosistema innovador donde la tecnología y las humanidades se integren profundamente. (Fuente: 36氪)