Palabras clave:NVIDIA, Fábrica de IA, Infraestructura de IA, OpenAI, GPT, Siri, Mercado de nube de IA, Transformación de capacidad de IA de NVIDIA, Controversia de cambio de modelo de OpenAI, Actualización de IA de Siri de Apple, Competencia en el mercado de nube de IA en China, Guerra por el talento en IA

🔥 Enfoque

NVIDIA remodela la industria de la AI: de vender chips a “vender capacidad de AI”: Jensen Huang, CEO de NVIDIA, señaló en una entrevista reciente que la era de la computación general ha terminado y que la demanda de AI está experimentando un doble crecimiento exponencial, con una demanda de inferencia que se espera que se multiplique por mil millones. NVIDIA está pasando de ser un proveedor de chips a un “socio de infraestructura de AI”, construyendo “fábricas de AI” de 10 GW en colaboración con empresas como OpenAI, y ofreciendo un “diseño de colaboración extrema” que abarca desde chips hasta software, sistemas y redes para lograr el máximo rendimiento por unidad de energía. Destacó que esta capacidad de optimización de pila completa es una barrera competitiva fundamental que permite a NVIDIA dominar la revolución industrial de la AI y se espera que impulse el mercado de infraestructura de AI de 400 mil millones a un billón de dólares. (Fuente: 36氪, 36氪, Reddit r/artificial)

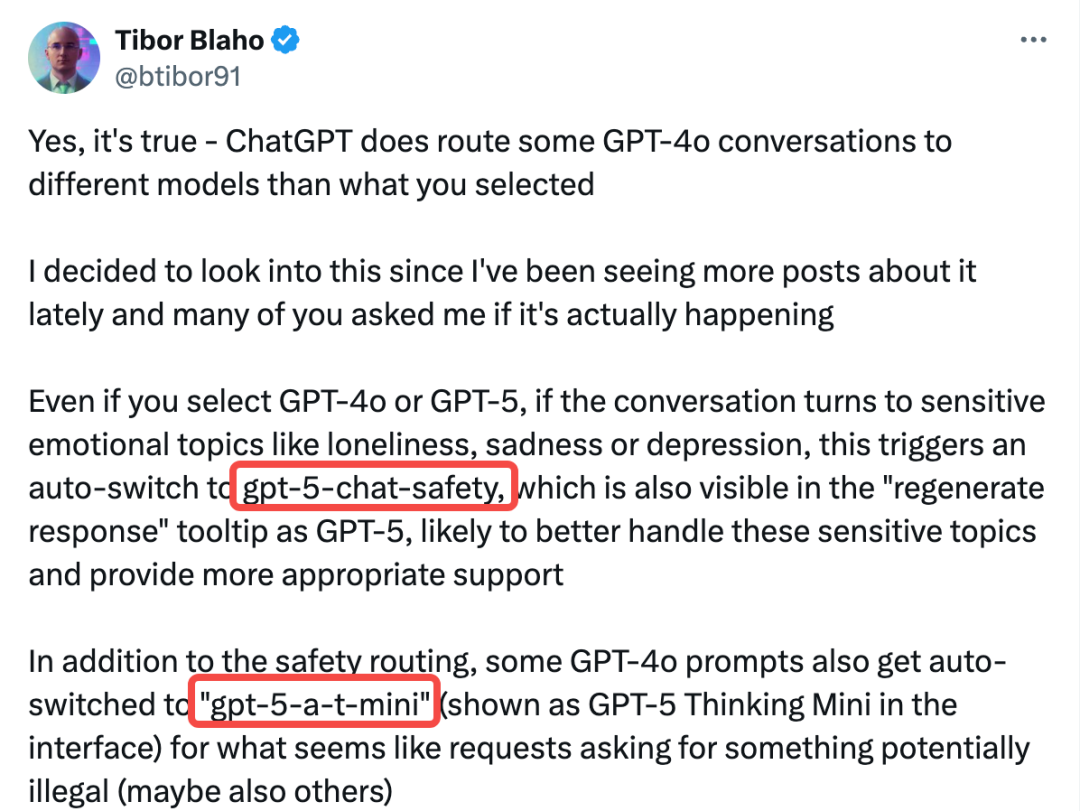

El “GPTgate” de OpenAI estalla: usuarios de pago secretamente degradados y cambio de modelo: OpenAI ha sido acusada de redirigir secretamente las conversaciones de los usuarios a modelos de “seguridad” no revelados (gpt-5-chat-safety y 5-a-t-mini), especialmente cuando se detecta contenido emocional o sensible. Esta práctica, confirmada por el ingeniero jefe de AIPRM y que generó una amplia retroalimentación de los usuarios, resultó en una disminución del rendimiento del modelo y en el cambio de modelo sin el conocimiento o consentimiento del usuario. Aunque un vicepresidente de OpenAI lo calificó como una prueba de seguridad temporal, la medida ha provocado fuertes cuestionamientos sobre la transparencia, la autonomía del usuario y posibles prácticas fraudulentas, lo que llevó a muchos usuarios a cancelar sus suscripciones y a pedir la creación de “derechos del usuario de AI”. (Fuente: 36氪, 36氪, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT)

Apple apuesta por el renacimiento de Siri en 2026: AI a nivel de sistema y fusión con modelos de terceros: Apple está remodelando completamente Siri a través de sus aplicaciones internas tipo ChatGPT “Veritas” y el sistema “Linwood”, con el objetivo de lograr conversaciones conscientes del contexto e interacciones profundas con las aplicaciones. El código de la beta de iOS 26.1 muestra que Apple está introduciendo soporte para MCP (Model Context Protocol) en App Intents, lo que permitirá que modelos de AI compatibles como ChatGPT y Claude interactúen directamente con aplicaciones de Mac, iPhone y iPad. Esta medida marca un cambio de Apple de un “desarrollo de pila completa” a una “ruta de plataforma”, acelerando el desarrollo de su ecosistema de AI mediante la integración de modelos de terceros, al tiempo que garantiza la privacidad y la coherencia de la experiencia del usuario. Se espera que la nueva versión de Siri se lance a principios de 2026. (Fuente: 36氪, 36氪)

La predicción de Hinton falla: la AI no reemplaza a los radiólogos, sino que los mantiene más ocupados: En 2016, Geoffrey Hinton, el “padre de la AI”, predijo que la AI reemplazaría a los radiólogos en cinco años y sugirió detener su formación. Sin embargo, casi una década después, el número de radiólogos en EE. UU. y su salario anual promedio (hasta 520.000 dólares) han alcanzado máximos históricos. Las principales razones son el menor rendimiento de la AI en escenarios clínicos reales, la resistencia regulatoria legal y el hecho de que la AI solo cubre una pequeña parte del trabajo del médico. Esto refleja la “paradoja de Jevons”: la AI, al mejorar la eficiencia en la interpretación de imágenes, ha aumentado la necesidad de que los médicos supervisen, se comuniquen y realicen tareas no diagnósticas, lo que ha incrementado su carga de trabajo en lugar de reemplazarlos. (Fuente: 36氪)

🎯 Tendencias

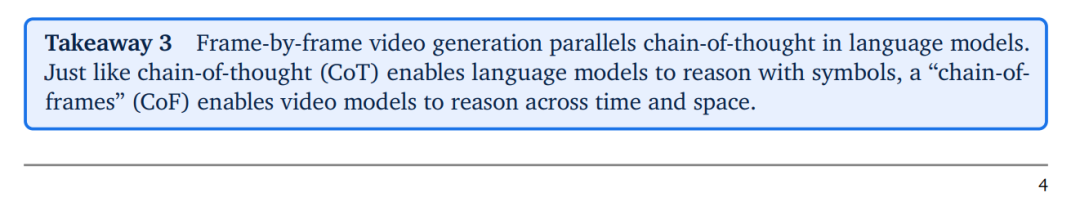

DeepMind Veo 3 lanza el concepto de “Chain of Frames” para impulsar la comprensión visual general en modelos de video: El modelo de video Veo 3 de DeepMind introduce el concepto de “Chain of Frames” (CoF), análogo a la “Chain of Thought” (CoT) de los grandes modelos de lenguaje (LLM), lo que le permite realizar inferencias visuales de cero-shot. Veo 3 demuestra una potente capacidad para percibir, modelar y manipular el mundo visual, y se espera que se convierta en un “modelo fundacional general” en el campo de la visión artificial. La investigación predice que, con la rápida mejora de las capacidades del modelo y la reducción de costos, en el campo de los modelos de video “los generalistas reemplazarán a los especialistas”, lo que presagia una nueva etapa de rápido desarrollo en la generación y comprensión de video. (Fuente: 36氪, shlomifruchter, scaling01, Reddit r/artificial)

ChatGPT Pulse lanzado: la AI pasa de la respuesta pasiva a un servicio proactivo: OpenAI ha lanzado la función “Pulse” para los usuarios de ChatGPT Pro, marcando la evolución de ChatGPT de una herramienta de preguntas y respuestas pasiva a un asistente personal que predice activamente las necesidades del usuario. Pulse, a través de una “investigación asíncrona” nocturna, combina el historial de chat del usuario, la memoria y aplicaciones externas (como Gmail, Google Calendar) para enviar un “resumen diario” personalizado por la mañana. Esto representa un paso importante de OpenAI en el campo de la “AI de agente inteligente”, con el objetivo de que los asistentes de AI comprendan los objetivos del usuario y ofrezcan servicios de forma proactiva sin necesidad de indicaciones, creando un nuevo paradigma de interacción humano-máquina. (Fuente: 36kr)

Sutton, el padre del aprendizaje por refuerzo: los grandes modelos de lenguaje son un punto de partida equivocado: Richard Sutton, el padre del aprendizaje por refuerzo, afirmó en una entrevista que los grandes modelos de lenguaje (LLM) son un punto de partida equivocado para la verdadera inteligencia. Él cree que la verdadera inteligencia surge del “aprendizaje experiencial”, es decir, la corrección continua del comportamiento a través de la acción, la observación y la retroalimentación para lograr objetivos. La capacidad predictiva de los LLM es solo una imitación del comportamiento humano y carece de objetivos independientes y de la capacidad de “sorprenderse” ante los cambios en el mundo exterior. Esta perspectiva ha provocado un profundo debate sobre la trayectoria de desarrollo de la AGI (Inteligencia Artificial General), cuestionando el paradigma actual de la AI dominado por los LLM. (Fuente: 36kr, paul_cal, algo_diver, scaling01, rao2z, bookwormengr, BlackHC, rao2z)

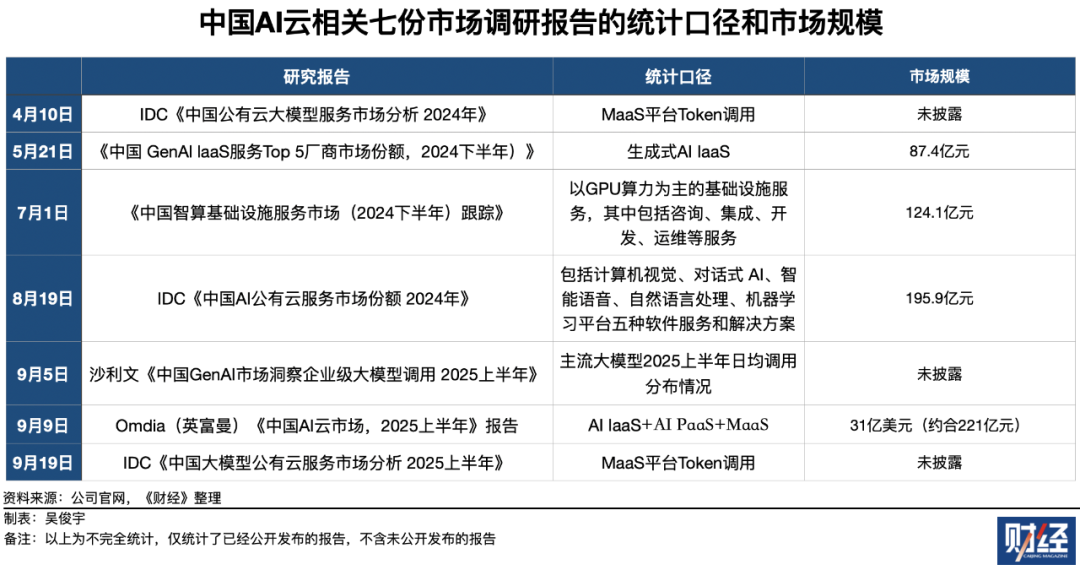

La competencia en el mercado chino de AI en la nube se intensifica: Alibaba Cloud lidera, VolcEngine lo persigue a gran velocidad: En 2025, la competencia en el mercado chino de “AI en la nube” es feroz. Alibaba Cloud mantiene su liderazgo en términos de ingresos generales, cubriendo AI IaaS, PaaS y MaaS. Sin embargo, VolcEngine, bajo ByteDance, domina el mercado de llamadas de Token de MaaS (Model-as-a-Service), con una cuota de mercado cercana a la mitad, y se ha convertido en el mayor competidor de Alibaba Cloud con un crecimiento asombroso. Baidu AI Cloud, por su parte, comparte el primer puesto con Alibaba Cloud en el mercado de servicios de AI en la nube pública (productos de software y soluciones). El mercado muestra una competencia multidimensional, con un crecimiento exponencial en el volumen de llamadas de Token, lo que presagia un enorme espacio de crecimiento y una reconfiguración del panorama futuro del mercado de AI en la nube. (Fuente: 36氪)

La guerra por el talento en AI se intensifica: salarios altos y desafíos con la visa H-1B: El mercado de talento en AI sigue en auge. Xpeng Motors anunció la contratación de más de 3.000 recién graduados en 2026, con un salario anual máximo de 1,6 millones de yuanes y sin límite para los talentos excepcionales. Meta ofrece paquetes de compensación astronómicos de más de 200 millones de dólares para atraer a los mejores talentos en AI, mientras que NVIDIA y OpenAI también compiten por el talento a través de adquisiciones e incentivos de acciones. Sin embargo, el endurecimiento de la política de visas H-1B en EE. UU. (como la adición de una tarifa de 100.000 dólares) representa un desafío para que los profesionales extranjeros altamente cualificados permanezcan en Silicon Valley, lo que genera preocupación entre los gigantes tecnológicos por la fuga de cerebros y subraya la ferocidad y complejidad de la competencia global por el talento en AI. (Fuente: 36kr, 36kr)

🧰 Herramientas

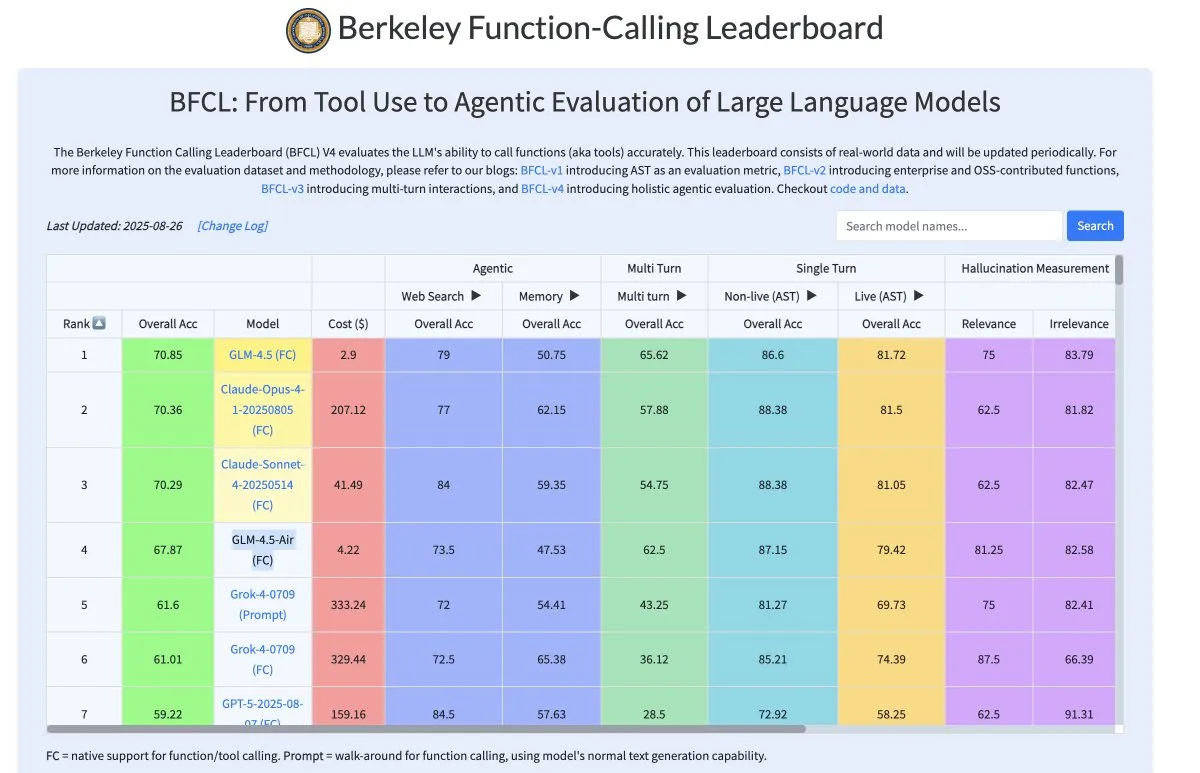

Zhipu AI GLM-4.5-Air: modelo de llamada de herramientas de alta rentabilidad: El modelo GLM-4.5-Air de Zhipu AI (106B parámetros, 12B parámetros activos) destaca en la llamada de herramientas, acercándose al nivel de Claude 4, pero con un costo reducido en un 90%. Este modelo reduce significativamente las alucinaciones durante la fase de inferencia, mejorando la fiabilidad de la llamada de herramientas y haciendo que los flujos de trabajo de investigación profunda sean más estables y eficientes, proporcionando a los desarrolladores una solución LLM de alta rentabilidad. (Fuente: bookwormengr)

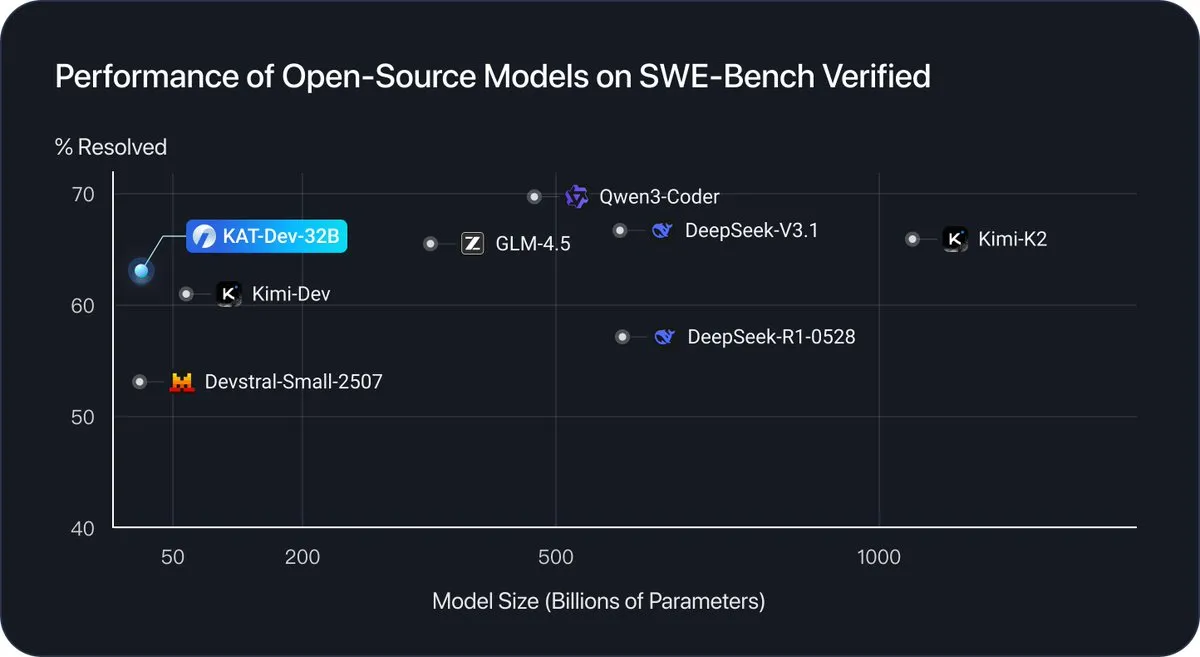

KAT-Dev-32B: modelo de 32B parámetros diseñado para tareas de ingeniería de software: KAT-Dev-32B es un modelo de 32B parámetros centrado en tareas de ingeniería de software. Logró una tasa de resolución del 62.4% en el benchmark SWE-Bench Verified, ocupando el quinto lugar en rendimiento en comparación con modelos de código abierto de diferentes tamaños, lo que demuestra un progreso significativo de los LLM de código abierto en la generación de código, depuración y flujos de trabajo de desarrollo. (Fuente: _akhaliq)

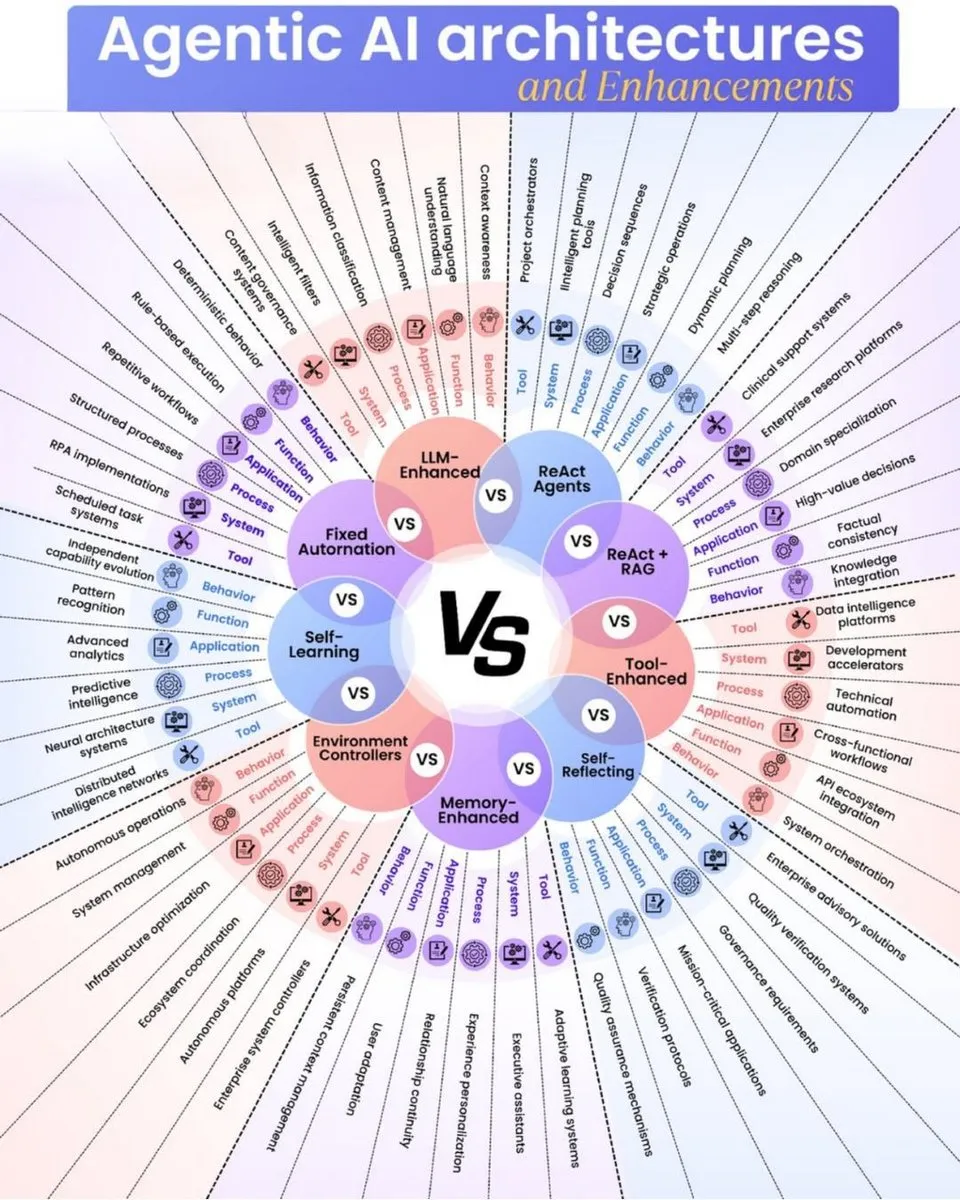

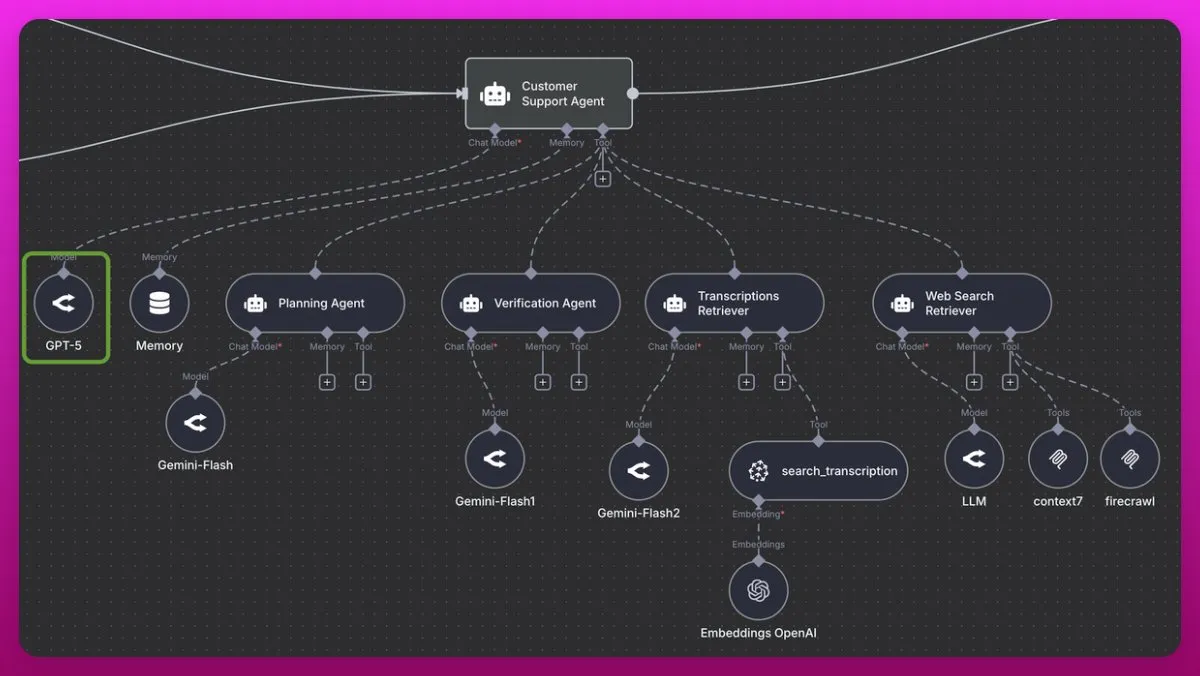

GPT-5: un excelente coordinador para sistemas multiagente: GPT-5 es aclamado como un excelente coordinador para sistemas multiagente, especialmente adecuado para áreas más allá de la codificación, como el soporte al cliente. Puede comprender profundamente las intenciones, procesar grandes volúmenes de datos de manera eficiente y llenar vacíos de información, lo que lo hace sobresalir en la gestión de sistemas complejos de recuperación múltiple. En comparación con Claude 4 (debido al costo) y Gemini 2.5 Pro, GPT-5 (incluido GPT-5-mini) supera en consistencia y precisión en la llamada de herramientas, proporcionando un potente soporte para el desarrollo de sistemas de agentes avanzados. (Fuente: omarsar0)

Tencent HunyuanImage 3.0: un nuevo referente en modelos de texto a imagen de código abierto: El equipo de Tencent Hunyuan ha lanzado HunyuanImage 3.0, un modelo de texto a imagen de código abierto con más de 80 mil millones de parámetros, que activa 13 mil millones de parámetros durante la inferencia. Este modelo utiliza una arquitectura MoE basada en Transfusion, acoplando profundamente el entrenamiento de Diffusion y LLM, lo que le confiere potentes capacidades de razonamiento de conocimiento del mundo, comprensión de prompts complejos de miles de caracteres y generación precisa de texto dentro de las imágenes. HunyuanImage 3.0 tiene como objetivo revolucionar los flujos de trabajo de diseño gráfico y creación de contenido, y planea admitir interacciones multimodales como imagen a imagen y edición de imágenes en el futuro. (Fuente: nrehiew_, jpt401)

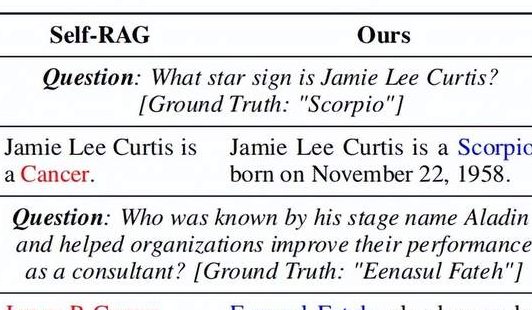

Marco DRAG: mejora la comprensión de la diversidad léxica en los modelos RAG: ACL 2025 propone el marco Lexical Diversity-aware RAG (DRAG), que introduce por primera vez la “diversidad léxica” en los procesos de recuperación y generación de RAG. DRAG descompone la semántica de la consulta en componentes invariantes, variables y complementarios, y emplea estrategias diferenciadas para la evaluación de la relevancia y la calibración de la escasez de riesgos. Este método mejora significativamente la precisión de RAG (por ejemplo, un aumento del 10.6% en HotpotQA), estableciendo nuevos SOTA en varios benchmarks, y es de gran valor para los sistemas de recuperación de información y preguntas y respuestas, permitiéndoles comprender con mayor precisión el lenguaje humano complejo. (Fuente: 量子位)

Tencent Hunyuan3D-Part: el primer modelo de generación de componentes 3D nativos de alta calidad de la industria: El equipo de Tencent Hunyuan 3D ha lanzado Hunyuan3D-Part, el primer modelo de la industria capaz de generar componentes 3D de alta calidad y semánticamente descomponibles. Este modelo, a través del modelo de segmentación 3D nativo P3-SAM y el modelo de generación de componentes de grado industrial X-Part, logra una generación de piezas 3D de alta fidelidad y estructuralmente consistente. Este avance es de gran importancia para las tuberías de producción de videojuegos y la industria de la impresión 3D, ya que puede descomponer geometrías complejas en componentes simples, reduciendo en gran medida la dificultad del procesamiento posterior y admitiendo el ensamblaje modular. (Fuente: 量子位)

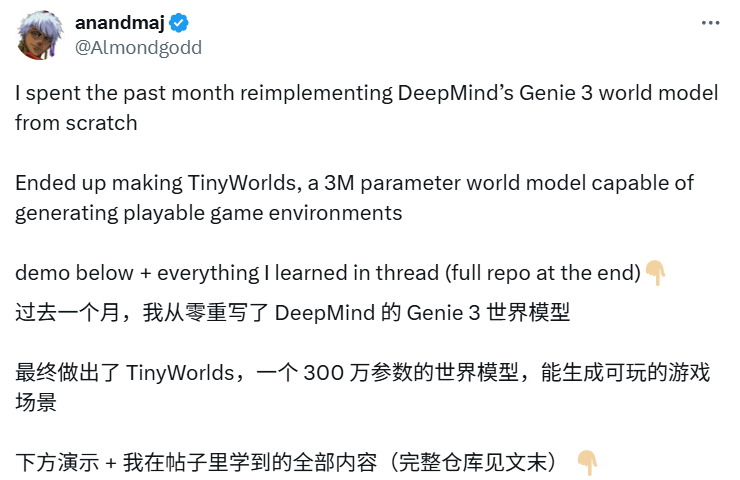

TinyWorlds: 3 millones de parámetros replican el modelo mundial de DeepMind, logrando juegos de píxeles interactivos en tiempo real: El bloguero de X anandmaj replicó la idea central de DeepMind Genie 3 en un mes, desarrollando TinyWorlds. Este modelo mundial de solo 3 millones de parámetros puede generar entornos de juego de estilo píxel jugables en tiempo real, como Pong, Sonic, Zelda y Doom. Captura información de video a través de transformadores espacio-temporales y tokenizadores de video, logrando la generación de mundos de píxeles interactivos, lo que demuestra el enorme potencial de los modelos a pequeña escala en el campo de la generación de mundos en tiempo real, y admite código de código abierto. (Fuente: 36氪)

OpenWebUI soporta nativamente MCP: un nuevo paradigma para la integración de herramientas LLM: La última actualización de OpenWebUI soporta nativamente los servidores Model Context Protocol (MCP), permitiendo a los usuarios integrar herramientas externas como HuggingFace MCP. Esta función estandariza la forma en que los LLM se conectan con fuentes de datos y herramientas externas, expandiendo el ecosistema de aplicaciones de AI y permitiendo a los usuarios utilizar diversas herramientas de AI de manera más flexible y eficiente dentro de la interfaz de OpenWebUI. (Fuente: Reddit r/LocalLLaMA, Reddit r/OpenWebUI)

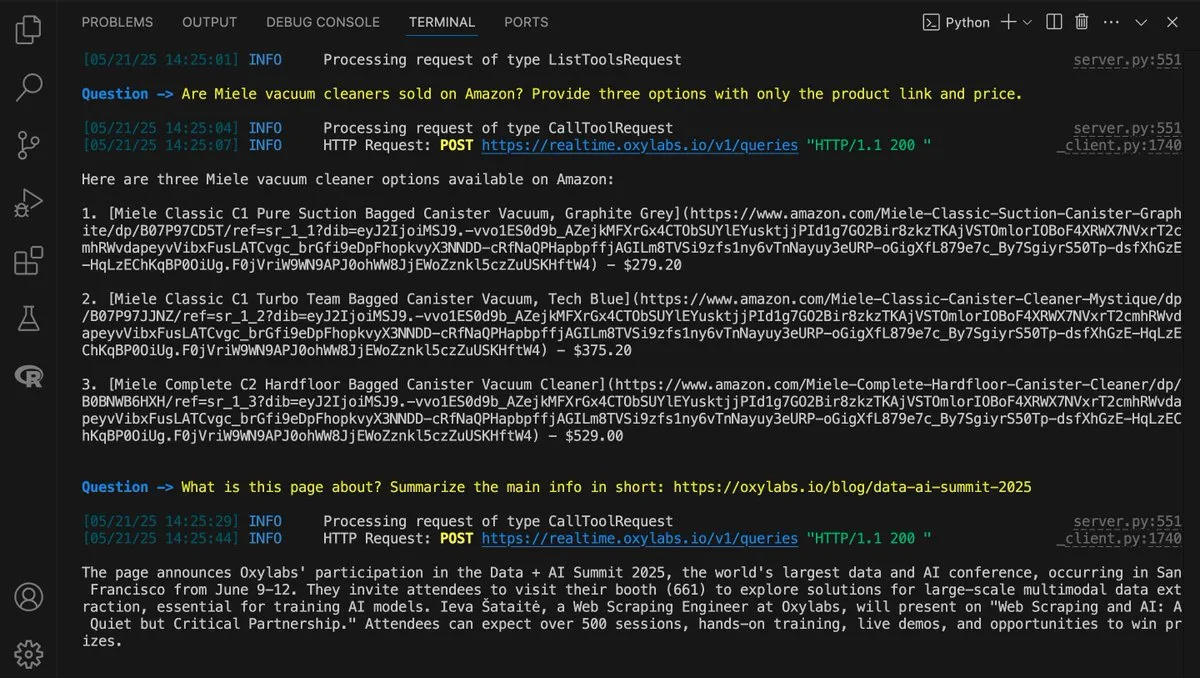

LangChain y Oxylabs colaboran para construir una solución de web scraping impulsada por AI: LangChain y Oxylabs han publicado una guía que muestra cómo combinar la inteligencia de LangChain con la infraestructura de scraping de Oxylabs para construir una solución de web scraping impulsada por AI. Esta solución soporta múltiples idiomas y varios métodos de integración, permitiendo a los agentes de AI superar desafíos comunes de acceso a la web como bloqueos de IP y CAPTCHAs, logrando así una recuperación de datos en tiempo real más eficiente y potenciando los flujos de trabajo de los agentes. (Fuente: LangChainAI)

Opik, herramienta de evaluación de LLM de código abierto: monitoreo y depuración completos de aplicaciones de AI: Opik es una herramienta de evaluación de LLM de código abierto recientemente lanzada, diseñada para ayudar a los desarrolladores a depurar, evaluar y monitorear aplicaciones de LLM, sistemas RAG y flujos de trabajo de agentes. Ofrece seguimiento completo, evaluación automatizada y paneles de control de nivel de producción, proporcionando información clave para mejorar el rendimiento y la fiabilidad de los sistemas de AI. (Fuente: dl_weekly)

📚 Aprendizaje

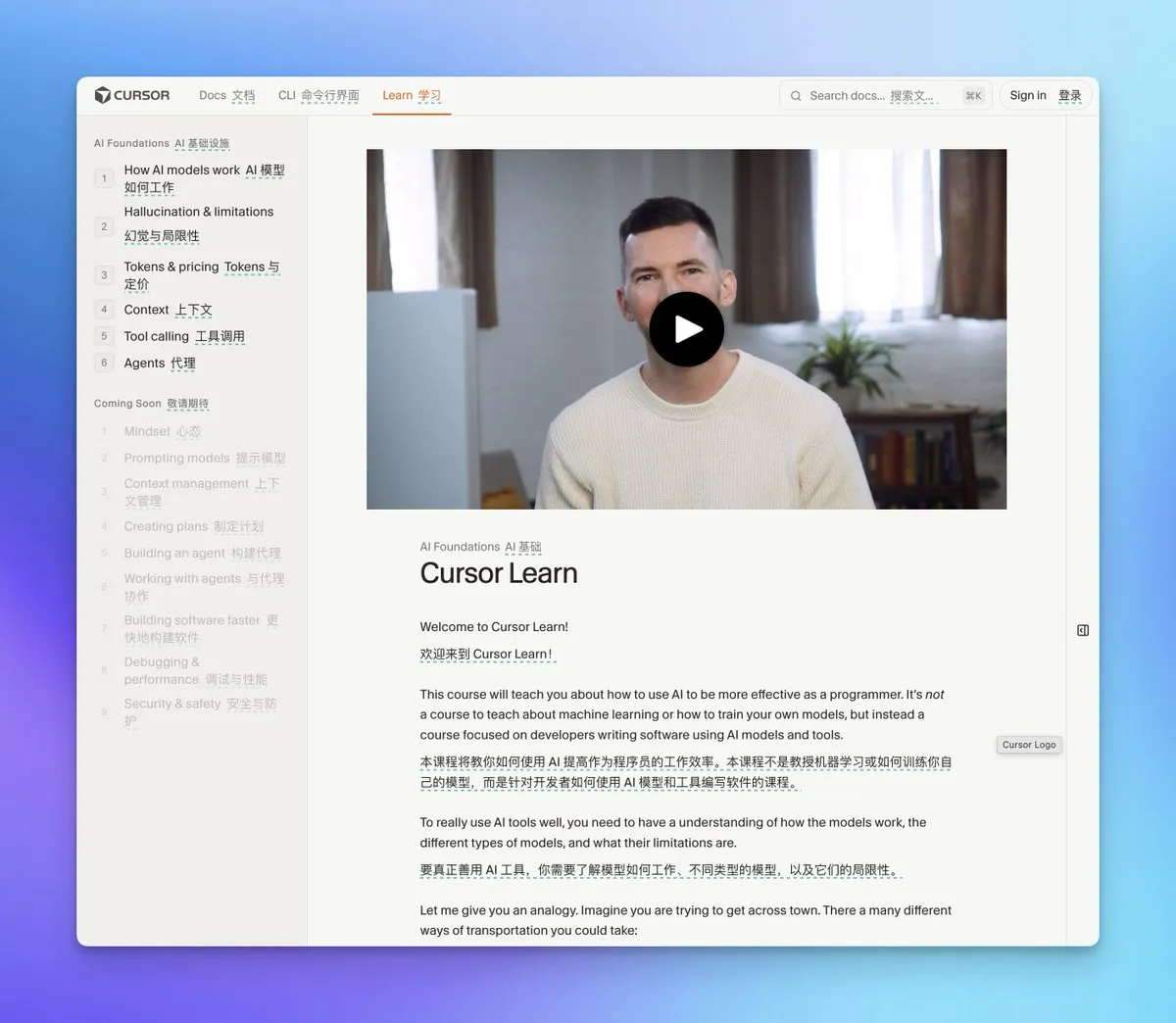

Cursor Learn: curso de video gratuito sobre fundamentos de AI: Cursor Learn ha lanzado un curso de video gratuito de seis partes sobre fundamentos de AI, diseñado para principiantes, que cubre conceptos centrales como Token, contexto y agentes. El curso incluye cuestionarios y modelos de AI interactivos, con el objetivo de proporcionar conocimientos básicos de AI en una hora, incluyendo temas avanzados como la colaboración de agentes y la gestión de contexto, lo que lo convierte en un recurso valioso para la introducción a la AI. (Fuente: cursor_ai, op7418)

Repositorios de código de AI/ML seleccionados en GitHub: cubriendo frameworks como PyTorch, TensorFlow: Se ha compartido una serie de repositorios de código de AI/ML seleccionados en GitHub, que contienen notebooks prácticos para múltiples frameworks de deep learning como PyTorch, TensorFlow y FastAI. Estos recursos cubren áreas como visión por computadora, procesamiento de lenguaje natural, GANs, Transformer, AutoML y detección de objetos, proporcionando materiales de aprendizaje ricos para estudiantes y profesionales, y apoyando la exploración tecnológica y el desarrollo de proyectos. (Fuente: Reddit r/deeplearning)

Libro electrónico gratuito: “A First Course on Data Structures in Python”: Se ha publicado un libro electrónico gratuito titulado “A First Course on Data Structures in Python”. Este libro proporciona los bloques de construcción fundamentales necesarios para AI y machine learning, incluyendo estructuras de datos, pensamiento algorítmico, análisis de complejidad, recursión/programación dinámica y métodos de búsqueda, lo que lo convierte en un recurso valioso para aprender los fundamentos de la AI. (Fuente: TheTuringPost)

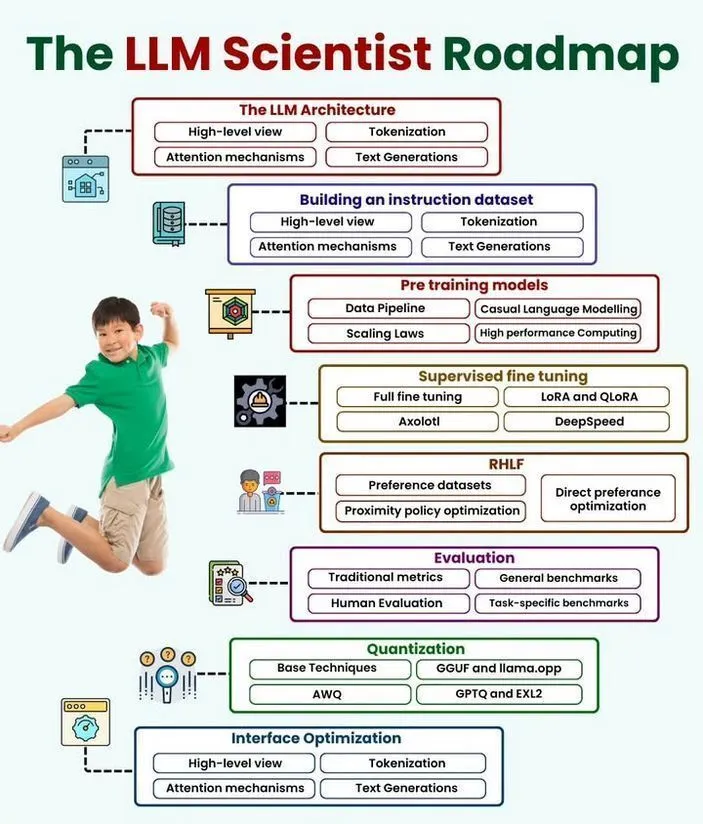

Publicadas hojas de ruta para científicos de LLM y científicos de datos: Se han publicado hojas de ruta detalladas para el desarrollo profesional de científicos de LLM y científicos de datos. Estos recursos describen las habilidades, herramientas y rutas de aprendizaje necesarias para ingresar o avanzar en los campos de la inteligencia artificial, el machine learning y la ciencia de datos, proporcionando una guía clara de planificación de carrera para los aspirantes. (Fuente: Ronald_vanLoon, Ronald_vanLoon)

A16Z Speedrun 2026: aceleradora de startups en AI y entretenimiento: A16Z Speedrun 2026 está aceptando solicitudes de emprendedores en los campos de AI y entretenimiento. Este programa apoya a fundadores centrados en la creación de sus propias empresas, representando una oportunidad para aquellos que buscan desarrollarse en el área de productos impulsados por AI de rápido crecimiento. (Fuente: yoheinakajima)

💼 Negocios

Demanda por derechos de autor de MiniMax: la ruta de salida a bolsa del unicornio de AI se ve ensombrecida: MiniMax, el unicornio chino de AI valorado en más de 4 mil millones de dólares, se enfrenta a una demanda conjunta por derechos de autor de Disney, Universal Pictures y Warner Bros. La demanda acusa a su herramienta de generación de video “Haila AI” de producir contenido que incluye personajes protegidos por derechos de autor a través de las indicaciones del usuario, lo que constituye una infracción sistemática. Este caso representa un golpe devastador para los planes de IPO de MiniMax, destacando los graves desafíos de cumplimiento de la propiedad intelectual en el mercado de la AI generativa y la importancia de equilibrar la innovación tecnológica con los límites legales. (Fuente: 36氪)

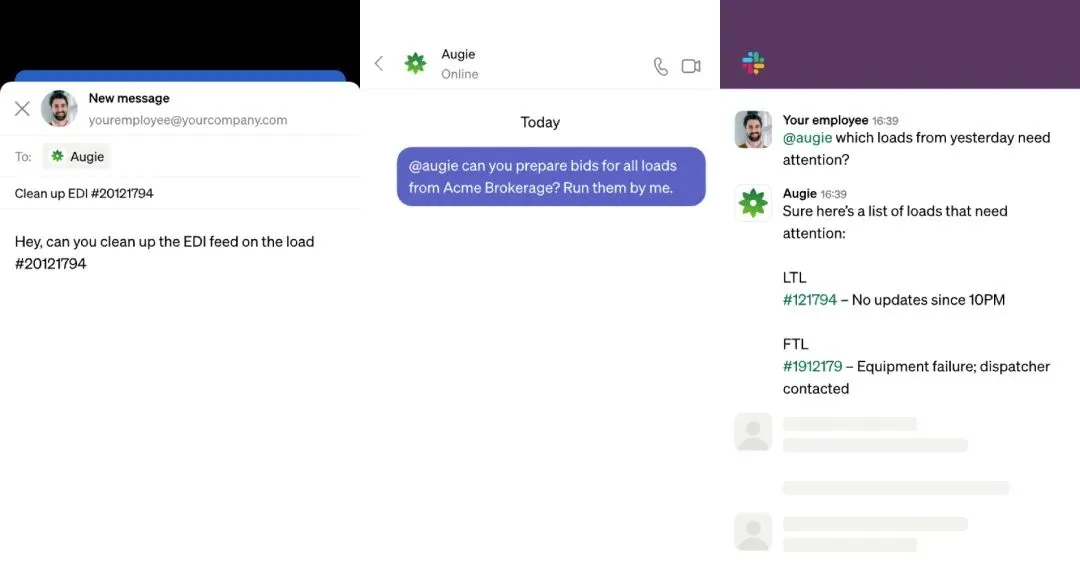

Augment, empresa de logística de AI, recauda 85 millones de dólares, con una financiación total de 800 millones de RMB en cinco meses: Augment, una empresa de logística de AI, ha completado con éxito una ronda de financiación Serie A de 85 millones de dólares, alcanzando una financiación total de 110 millones de dólares (aproximadamente 800 millones de RMB) en solo cinco meses desde su lanzamiento. Su producto de agente de AI, Augie, puede automatizar tareas complejas y fragmentadas en todo el ciclo de vida logístico, desde la recepción de pedidos hasta el cobro. Ya ha gestionado más de 35 mil millones de dólares en valor de carga para decenas de las principales empresas de logística de terceros y transportistas, y ha ahorrado millones de dólares a los clientes, demostrando el potente valor comercial de la AI en la optimización de la logística intensiva en mano de obra. (Fuente: 36氪)

Microsoft integra los modelos Claude de Anthropic en Copilot: Microsoft ha integrado los modelos Claude Sonnet 4 y Opus 4.1 de Anthropic en su asistente Copilot para usuarios empresariales. Esta medida tiene como objetivo reducir la dependencia exclusiva de OpenAI y consolidar la posición de Microsoft como proveedor de plataforma neutral. Los usuarios empresariales ahora pueden elegir entre los modelos de OpenAI y Anthropic, lo que aumenta la flexibilidad y se espera que impulse la competencia en el mercado de AI empresarial. (Fuente: Reddit r/deeplearning)

🌟 Comunidad

El impacto de la AI en la comprensión humana y la sociedad: la paradoja de la eficiencia y la “cámara de eco de información”: La comunidad está ampliamente preocupada de que la AI, al igual que las redes sociales, pueda afectar negativamente la comprensión humana, el pensamiento crítico y los objetivos de vida. Al optimizar la generación de contenido para la “difusión” en lugar de la “verdad” o la “profundidad”, la AI podría conducir a una “meseta de aprendizaje” y a una “máquina de basura infinita”. Esto ha provocado discusiones sobre cómo guiar el desarrollo de la AI hacia herramientas de crecimiento en lugar de herramientas adictivas, pidiendo cambios en la regulación, las prácticas de la industria y las normas culturales. (Fuente: Reddit r/ArtificialInteligence, Reddit r/artificial, Reddit r/ArtificialInteligence, Yuchenj_UW, colin_fraser, Teknium1, cloneofsimo)

La AI en el lugar de trabajo: la paradoja entre el aumento de la eficiencia y la “explotación oculta”: La integración de la AI en el lugar de trabajo, especialmente para los empleados de nivel ejecutivo, está creando una paradoja: el aumento de la eficiencia a menudo viene acompañado de mayores expectativas de producción, mientras que los empleados no reciben la compensación correspondiente. Esta “explotación oculta” convierte a los empleados en “inspectores de calidad humanos” del contenido generado por AI, aumentando la carga cognitiva y la ansiedad. La AI mejora la productividad empresarial, pero los beneficios fluyen principalmente hacia el capital, exacerbando la “brecha cognitiva” entre los gerentes estratégicos y los ejecutores dependientes de herramientas. Si no se reestructura la organización, esto podría conducir a un agotamiento generalizado. (Fuente: 36氪, glennko, mbusigin)

En la era de la AI, el valor de la “capacidad de preguntar” supera a la “capacidad de ejecución”: En un mundo impulsado por la AI, la verdadera ventaja competitiva se desplaza de la velocidad de ejecución a la “capacidad de preguntar”, es decir, la habilidad de identificar qué problemas vale la pena resolver. Depender excesivamente de la AI para la ejecución sin una definición crítica del problema puede llevar a resolver eficientemente los problemas equivocados, creando una falsa sensación de progreso. El pensamiento de diseño, el mapeo de la empatía y el cuestionamiento continuo se consideran habilidades humanas clave que la AI no puede reemplazar, y que pueden ayudar a individuos y organizaciones a utilizar la AI de manera efectiva para centrarse en la resolución de desafíos significativos. (Fuente: 36氪)

Geopolítica de la AI: la carrera de AI entre EE. UU. y China y la controversia sobre la regulación internacional: La carrera de AI entre EE. UU. y China se considera un maratón, no una carrera corta, y China podría estar a la cabeza en aplicaciones de robótica. Se insta a EE. UU. a centrarse en la inversión en AI práctica en lugar de solo perseguir la superinteligencia, pero ha rechazado la supervisión internacional de la AI a nivel de la ONU, enfatizando la soberanía nacional. Esto subraya el complejo panorama geopolítico donde el desarrollo de la AI se entrelaza con la seguridad nacional, las políticas comerciales (como las visas H-1B) y la competencia por la infraestructura y el talento en AI. (Fuente: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, adcock_brett, Dorialexander, teortaxesTex, teortaxesTex, teortaxesTex, brickroad7, jonst0kes)

Emad Mostaque predice la “última economía”: la AI remodelará el valor humano: Emad Mostaque, ex CEO de Stability AI, predice que en los próximos 1000 días la AI remodelará por completo la estructura económica, y el valor de la mano de obra humana podría llegar a cero o incluso ser negativo. Propone el “marco MIND” (Materia, Inteligencia, Red, Diversidad) para medir la salud económica, argumentando que el exceso de “capital intelectual” que trae la AI exige una reevaluación de la importancia de otros capitales. Esta “cuarta inversión” hará que la AI reemplace el trabajo cognitivo, requiriendo el establecimiento de nuevas monedas “centradas en el ser humano” y una AI fundamental universal para hacer frente a la transformación social. (Fuente: 36氪)

La carrera del hardware de AI: OpenAI, ByteDance y Meta compiten por el mercado de dispositivos de consumo: Gigantes tecnológicos como OpenAI, ByteDance y Meta están invirtiendo activamente en la investigación y desarrollo de hardware de AI de consumo. Las gafas Ray-Ban AI de Meta ya han logrado ventas significativas, mientras que OpenAI, según se informa, está colaborando con proveedores de Apple para desarrollar un “altavoz inteligente sin pantalla”, y ByteDance está desarrollando gafas inteligentes de AI. Esta carrera presagia una integración más profunda de la AI en la vida diaria, con las empresas explorando diversas formas de productos y modos de interacción para tomar la delantera en el campo de la AI de percepción ambiental. (Fuente: 36氪)

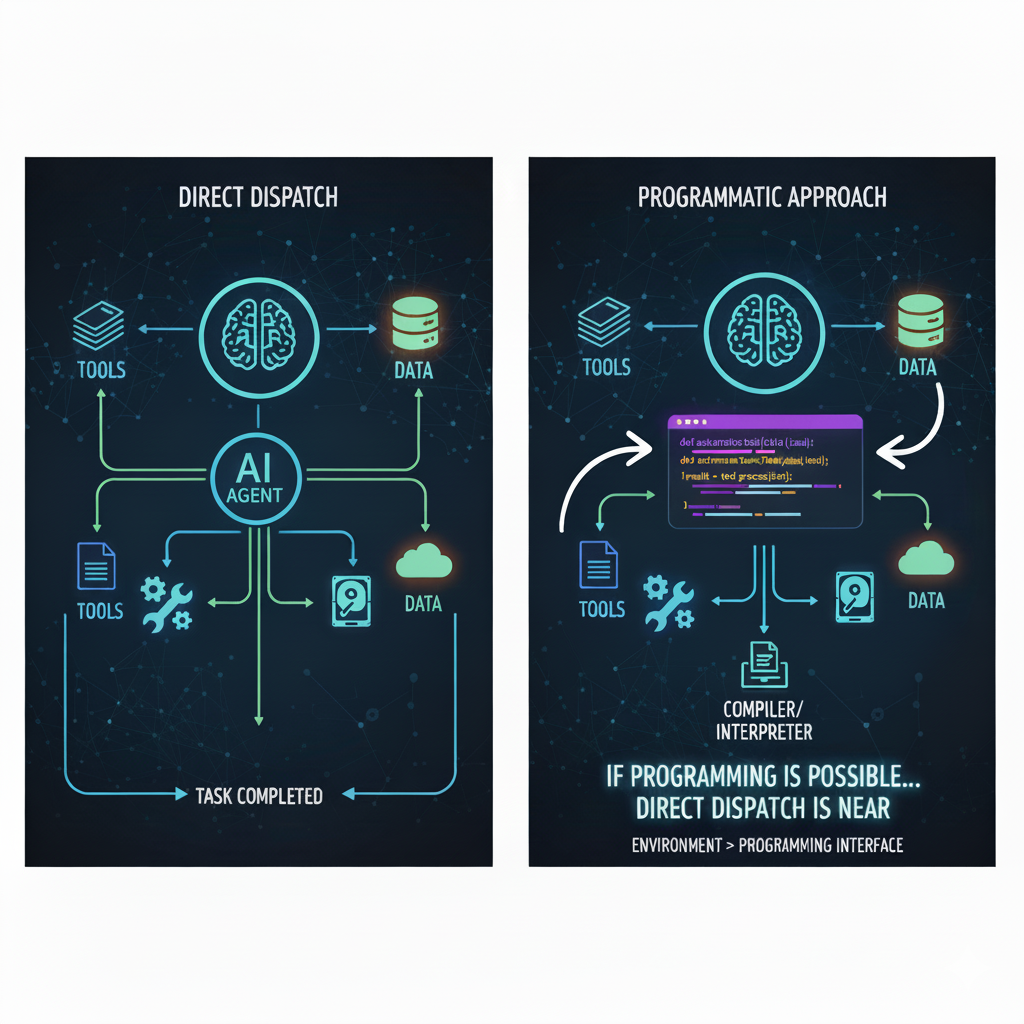

AI Agent: un cambio de paradigma de la colaboración humano-máquina a la “delegación humano-máquina”: La industria de la AI está experimentando un “punto de inflexión suave” que va de la colaboración humano-máquina a la “delegación humano-máquina”, donde los AI Agent autónomos ejecutarán tareas complejas a gran escala. El avance de la AI en la “superación de la programación” presagia su capacidad para abordar todos los sistemas semiabiertos. Esta transformación dará lugar a la forma organizativa de “empresas sin personal”, donde el papel humano pasará de la ejecución micro a la gobernanza macro, centrándose en la inyección de valores, el diseño de la arquitectura del sistema y la navegación macro, con el apoyo de AI Copilot para la toma de decisiones, en lugar de la intervención directa en sistemas de AI de alta velocidad. (Fuente: 36氪)

El impacto de la AI en las carreras de idiomas extranjeros: los estudiantes necesitan desarrollar habilidades compuestas de “idioma extranjero +”: El auge de la tecnología de traducción de AI está afectando profundamente a las carreras de idiomas extranjeros, lo que lleva a una disminución de la demanda de puestos de trabajo lingüísticos tradicionales y a la eliminación de programas relacionados en varias universidades. Los estudiantes de idiomas extranjeros se enfrentan a la presión de la transformación, necesitando pasar de una única habilidad lingüística a un modelo compuesto de “idioma extranjero +”, como “idioma extranjero + AI” para el procesamiento del lenguaje natural, “idioma extranjero + comunicación internacional”, etc. Esto impulsa la reforma de la educación de idiomas extranjeros, enfatizando la comprensión intercultural y las habilidades integrales, en lugar de la mera formación en traducción, para adaptarse a las nuevas demandas de talento lingüístico en la era de la AI. (Fuente: 36氪, Reddit r/ClaudeAI)

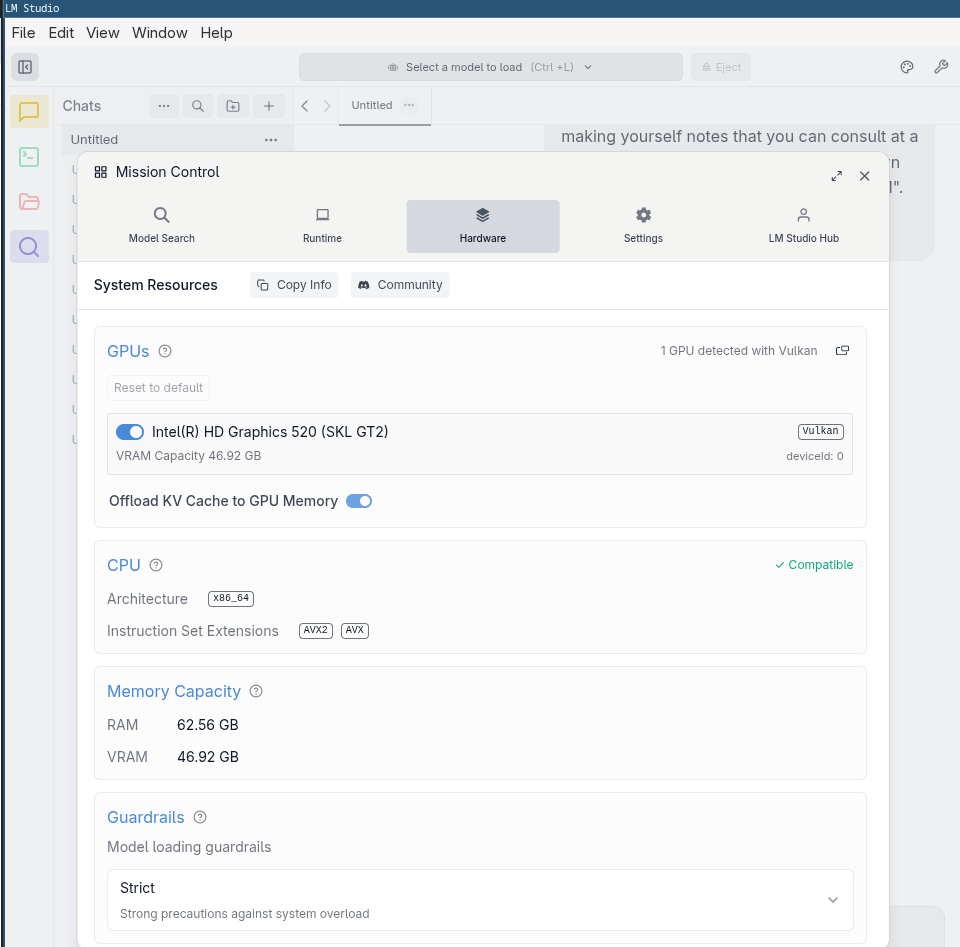

Precios elevados de las GPU: impulsados por la demanda de AI y la optimización de LLM locales: La comunidad está ampliamente preocupada por los precios persistentemente altos de las GPU, atribuyendo la causa principal al aumento de la demanda de centros de datos de AI y la inflación. Muchos creen que, a menos que la burbuja de la AI estalle o los chips personalizados se generalicen a gran escala, es poco probable que los precios bajen significativamente. Sin embargo, para abordar este desafío, la comunidad está trabajando para optimizar el rendimiento de los LLM locales, como el AMD MI50 que supera al NVIDIA P40 en llama.cpp/ggml, y el uso de iGPU para tareas básicas de LLM, con el fin de reducir los costos de computación de AI local. (Fuente: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

💡 Otros

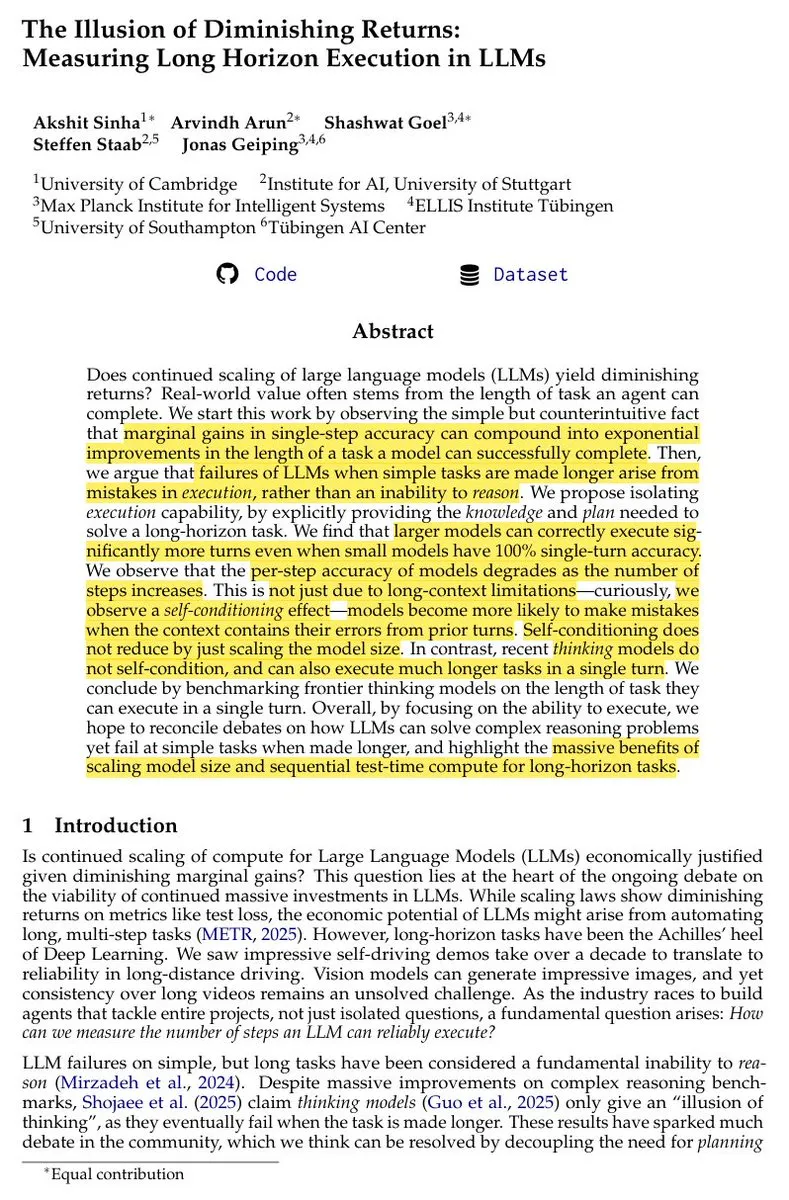

La “ilusión de rendimientos decrecientes” de la expansión de LLM y las tareas de ciclo largo: La investigación muestra que, aunque los benchmarks de una sola ronda pueden indicar una desaceleración en el progreso de los LLM, la expansión del tamaño del modelo sigue aportando mejoras no decrecientes en la ejecución de tareas de ciclo largo. La “ilusión de rendimientos decrecientes” surge de pequeñas mejoras en la precisión de un solo paso, que sin embargo pueden conducir a un aumento superexponencial en la finalización de tareas de ciclo largo. La ventaja de la computación secuencial en tareas de ciclo largo es incomparable con las pruebas paralelas, lo que indica que la expansión continua del modelo y el entrenamiento por refuerzo son cruciales para lograr comportamientos de agente avanzados. (Fuente: scaling01)

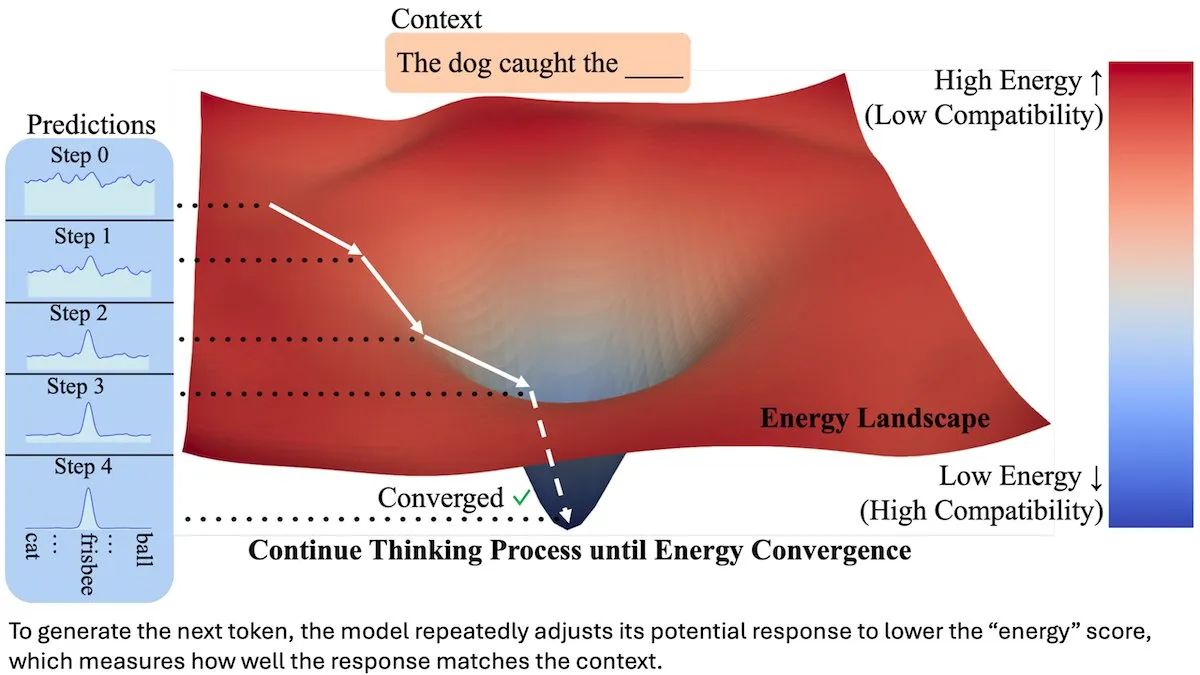

Energy-Based Transformer (EBT) mejora el rendimiento de predicción del siguiente token: Los investigadores han lanzado el Energy-Based Transformer (EBT), que califica los candidatos a siguiente token mediante una “energía” y los verifica y selecciona iterativamente reduciendo la energía a través de pasos de gradiente. En experimentos con 44 millones de parámetros, el EBT superó a los Transformer tradicionales de tamaño equivalente en tres de cuatro benchmarks, lo que indica que este novedoso método de selección de tokens promete mejorar el rendimiento de los LLM. (Fuente: DeepLearningAI)

Avances en robots de AI: vendedores humanoides y perros robot que caminan de forma autónoma sin entrenamiento: Xpeng Motors ha desplegado un vendedor de coches humanoide llamado “Tiedan” en su sala de exposiciones, demostrando la aplicación de la AI en el campo de los robots orientados al cliente. Además, un perro robot “con reflejos animales” puede caminar por el bosque sin necesidad de entrenamiento, lo que destaca el progreso de la tecnología robótica autónoma en la imitación del movimiento y la percepción biológicos. Estos desarrollos presagian una creciente complejidad y aplicación práctica de la AI en el campo de los robots físicos. (Fuente: Ronald_vanLoon, Ronald_vanLoon)