Palabras clave:LLM-JEPA, Apple Manzano, MediaTek Dimensity 9500, GPT-5, DeepSeek-V3.1-Terminus, Qwen3-Omni, Baidu Qianfan-VL, Marco de entrenamiento de espacio de incrustación, Tokenizador visual híbrido, Arquitectura de doble NPU, Benchmark SWE-BENCH PRO, Entrada de audio multimodal

🔥 Foco

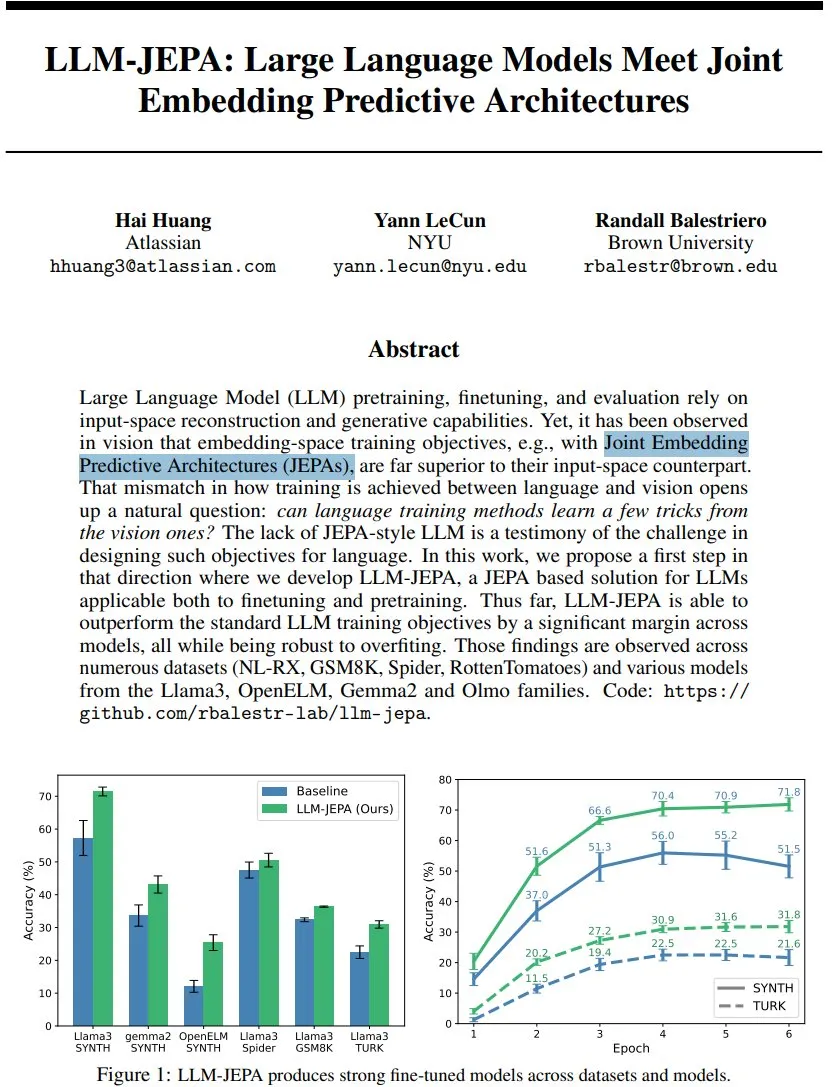

LLM-JEPA: Un nuevo avance en el marco de entrenamiento de modelos de lenguaje : Yann LeCun y otros han propuesto LLM-JEPA, el primer marco de entrenamiento de modelos de lenguaje estilo JEPA que combina objetivos de espacio de incrustación del dominio visual con objetivos de generación de procesamiento de lenguaje natural. Este marco supera los objetivos estándar de LLM en varias pruebas de referencia como NL-RX, GSM8K y Spider, y funciona bien con modelos como Llama3 y OpenELM. Es más robusto al sobreajuste y efectivo tanto en el preentrenamiento como en el ajuste fino, lo que presagia que el entrenamiento en el espacio de incrustación podría ser el próximo gran salto para los LLM. (Fuente: ylecun, ylecun)

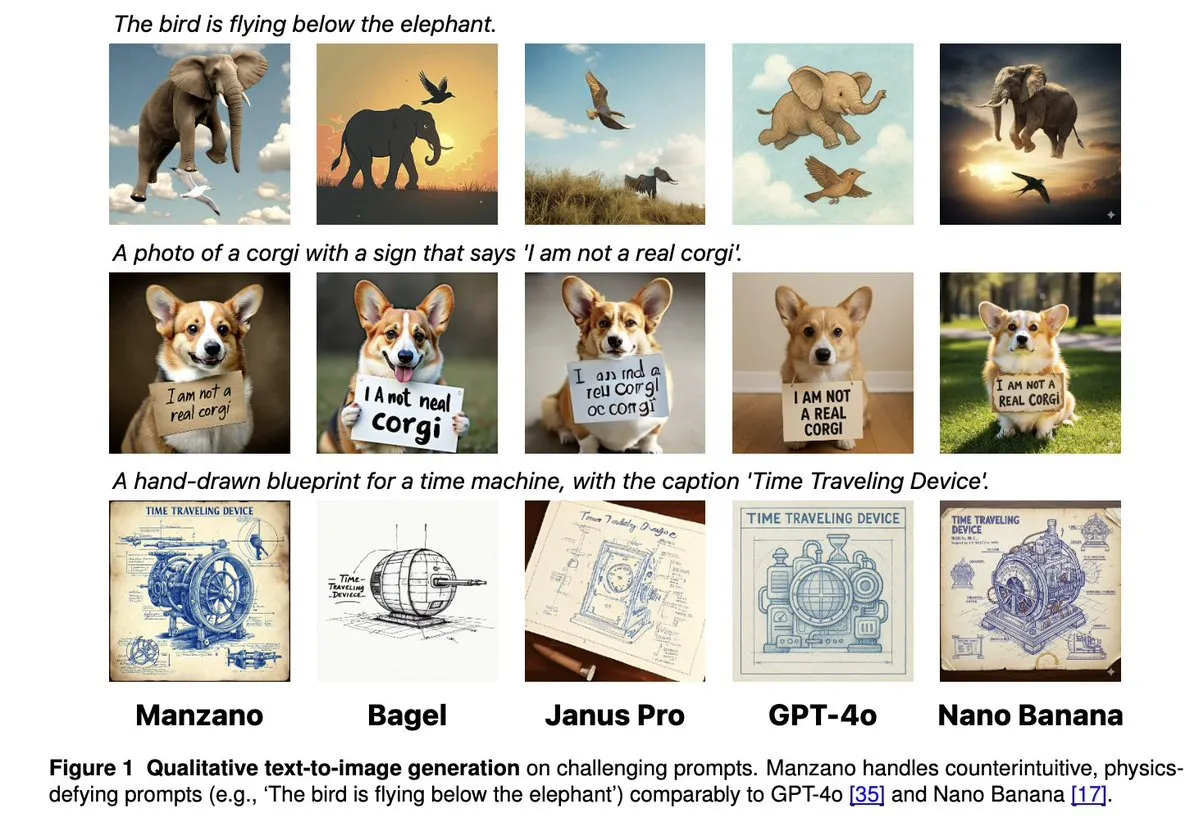

Apple Manzano: Una solución simple y escalable para LLM multimodales unificados : Apple ha lanzado Manzano, un modelo de lenguaje grande multimodal unificado, simple y escalable. Este modelo utiliza un tokenizador visual híbrido, que reduce eficazmente los conflictos entre las tareas de comprensión y generación de imágenes. Manzano alcanza el nivel SOTA en pruebas de referencia intensivas en texto (como ChartQA, DocVQA) y compite con GPT-4o/Nano Banana en capacidades de generación, admitiendo la edición mediante imágenes condicionales, lo que demuestra el potente potencial de la IA multimodal. (Fuente: arankomatsuzaki, charles_irl, vikhyatk, QuixiAI, kylebrussell)

MediaTek Dimensity 9500 lanza una arquitectura de doble NPU para una experiencia de IA activa mejorada : MediaTek ha presentado el chip Dimensity 9500, que introduce por primera vez una arquitectura de doble NPU de ultra rendimiento y ultra eficiencia energética, diseñada para lograr una experiencia de inteligencia residente de IA “Always on”. Este chip se mantiene en la cima de la lista de IA de SoC móvil de ETHZ, con una eficiencia de inferencia mejorada en un 56% respecto a la generación anterior, y admite la generación de imágenes 4K de ultra alta calidad en el dispositivo y una ventana de contexto de 128K. Esto sienta las bases de hardware para la respuesta en tiempo real y los servicios personalizados de IA móvil, impulsando la IA de ser “invocable” a “siempre en línea por defecto”. (Fuente: 量子位)

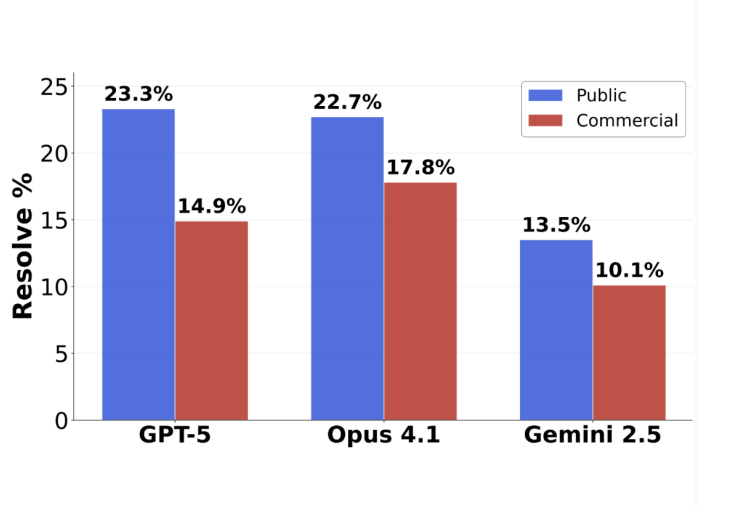

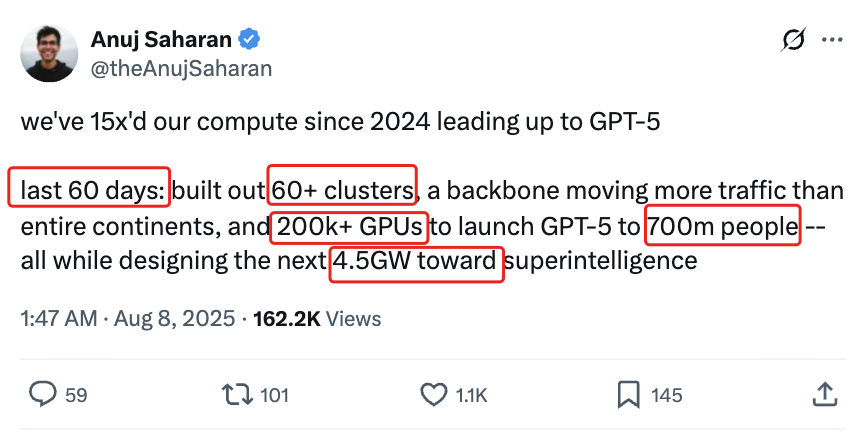

Giro en la evaluación de programación de GPT-5: Tasa de precisión del 63.1% en tareas enviadas : El nuevo benchmark de ingeniería de software SWE-BENCH PRO, publicado por Scale AI, muestra que GPT-5 alcanza una tasa de precisión del 63.1% en las tareas enviadas, superando con creces el 31% de Claude Opus 4.1. Esto indica que su rendimiento sigue siendo fuerte en sus áreas de especialización. El nuevo benchmark utiliza problemas inéditos y escenarios complejos de modificación de múltiples archivos, lo que pone a prueba de manera más realista la capacidad de programación real del modelo. Revela que los modelos de primer nivel actuales aún enfrentan desafíos en tareas de ingeniería de software a nivel industrial, pero la capacidad real de GPT-5 fue subestimada bajo la estrategia de “si lo sabe, lo envía; si no, no lo envía”. (Fuente: 36氪)

🎯 Tendencias

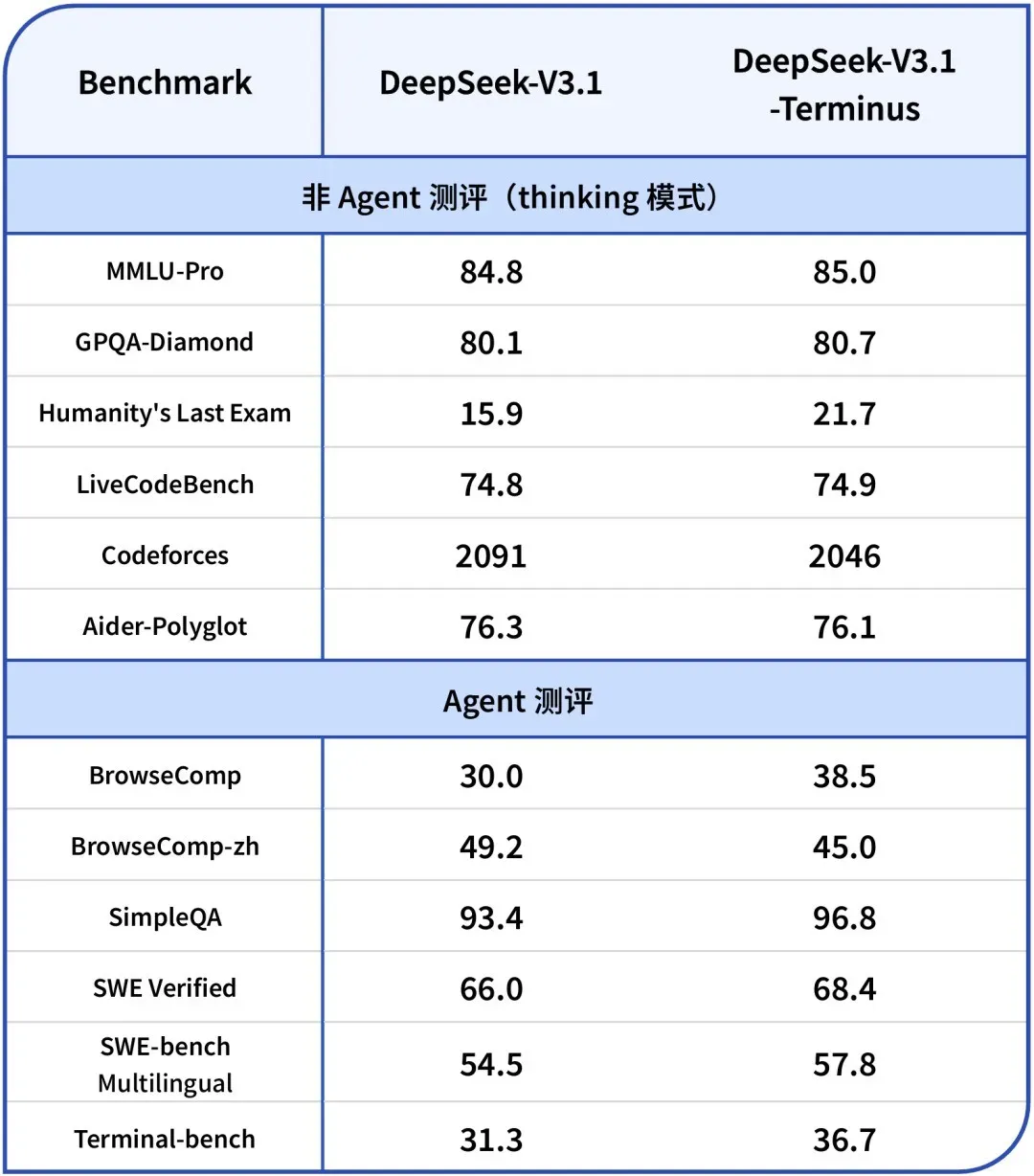

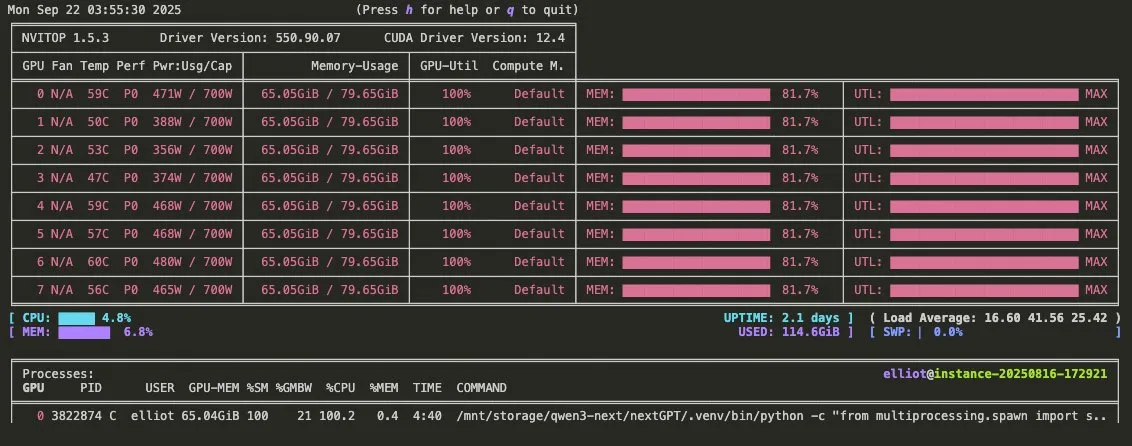

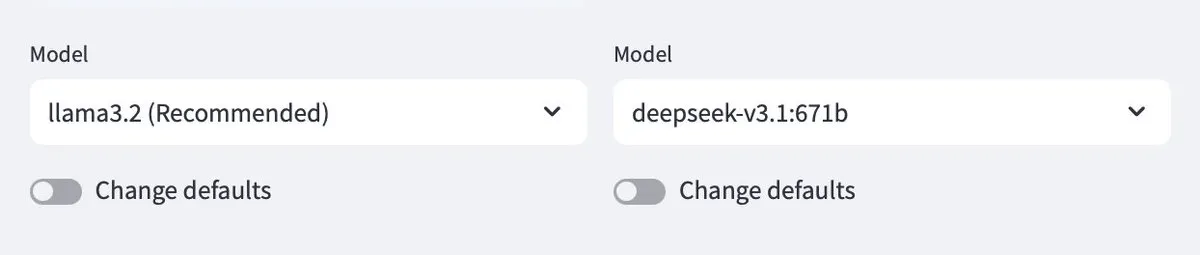

DeepSeek-V3.1-Terminus lanzado: Optimización de la coherencia lingüística y las capacidades de Agent : DeepSeek ha lanzado la versión V3.1-Terminus, que mejora principalmente la coherencia lingüística (reduciendo la mezcla de chino e inglés y los caracteres anómalos) y optimiza el rendimiento de Code Agent y Search Agent. El nuevo modelo ofrece una salida más estable y fiable en evaluaciones de múltiples dominios, y los pesos de código abierto ya están disponibles en Hugging Face y ModelScope, lo que presagia la finalización de la arquitectura de la serie V3 de DeepSeek. (Fuente: DeepSeek Blog, Reddit r/LocalLLaMA, scaling01, karminski3, ben_burtenshaw, dotey)

Video promocional de Qwen3-Omni lanzado: Soporte para audio multimodal y invocación de herramientas : Qwen ha lanzado un video promocional de Qwen3-Omni, anunciando que admitirá entrada y salida de audio multimodal, y tendrá capacidades nativas de invocación de herramientas. Se espera que este modelo sea un competidor directo de Gemini 2.5 Flash Native Audio, ofreciendo modos de pensamiento y no pensamiento, lo que mejorará significativamente el potencial de construcción de Voice Agent. Sus pesos se publicarán pronto. (Fuente: Reddit r/LocalLLaMA, scaling01, Alibaba_Qwen, huybery)

Baidu lanza los modelos de lenguaje grandes multimodales de código abierto de la serie Qianfan-VL : Baidu AI Cloud ha lanzado los modelos de lenguaje grandes multimodales de código abierto de la serie Qianfan-VL (3B, 8B, 70B), optimizados para aplicaciones empresariales. Los modelos combinan el codificador visual InternViT con un corpus multilingüe mejorado, ofreciendo una longitud de contexto de 32K. Destacan en OCR, comprensión de documentos, análisis de gráficos y resolución de problemas matemáticos, y admiten el razonamiento de pensamiento en cadena. Su objetivo es proporcionar capacidades generales potentes y una optimización profunda para escenarios de alta frecuencia en la industria. (Fuente: huggingface, Reddit r/LocalLLaMA)

xAI lanza el modelo Grok 4 Fast: Ventana de contexto de 2M, alta rentabilidad : xAI ha presentado el modelo Grok 4 Fast, un modelo de inferencia multimodal con una ventana de contexto de 2M, diseñado para establecer un nuevo estándar en rentabilidad. Esta versión podría lograr una inferencia rápida mediante técnicas como la cuantificación FP8, y ha optimizado las capacidades de programación Agentic, lo que le permite equilibrar el rendimiento y la economía al procesar tareas complejas. (Fuente: TheRundownAI, Yuhu_ai_)

GPT-5-Codex: OpenAI lanza una versión de GPT-5 optimizada para la programación Agentic : OpenAI ha lanzado GPT-5-Codex, una versión optimizada de GPT-5, específicamente para la programación Agentic. Este modelo está diseñado para mejorar el rendimiento de la IA en la generación de código y las tareas de ingeniería de software, en línea con las tendencias de desarrollo de flujos de trabajo Agentic y LLM multimodales. Al mejorar sus capacidades de programación, impulsa aún más la aplicación de la IA en el campo del desarrollo. (Fuente: TheRundownAI, Reddit r/artificial)

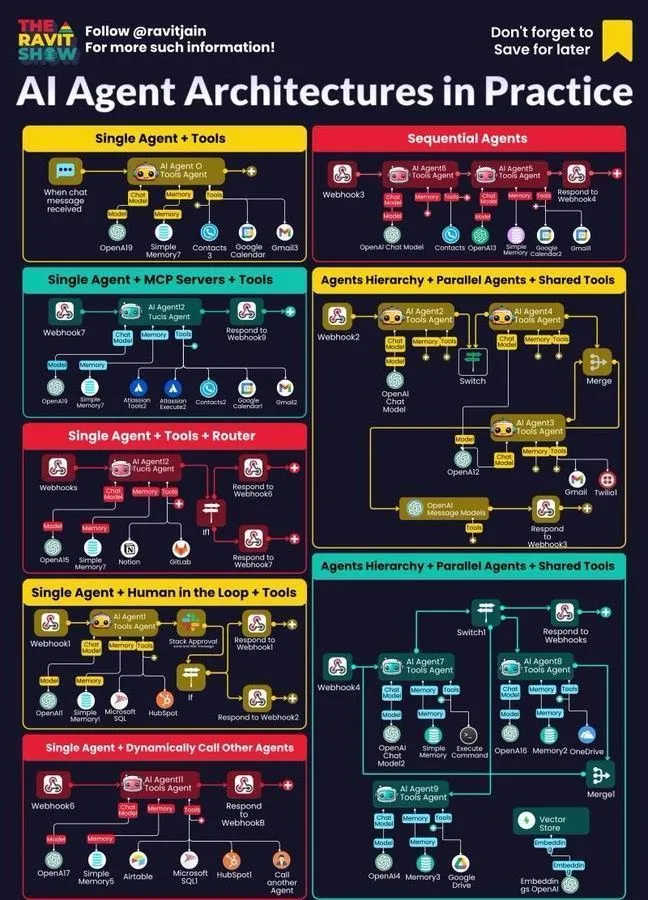

La Plataforma de Desarrollo de Agentes Inteligentes 3.0 de Tencent se lanza globalmente, con tecnologías clave de Youtu Lab de código abierto : La Plataforma de Desarrollo de Agentes Inteligentes 3.0 de Tencent Cloud (ADP3.0) se ha lanzado globalmente, con actualizaciones integrales en RAG, colaboración Multi-Agent, Workflow, evaluación de aplicaciones y ecosistema de plugins. El Laboratorio Youtu de Tencent continuará lanzando tecnologías clave de agentes inteligentes de código abierto, incluyendo el marco Youtu-Agent y el marco de grafo de conocimiento Youtu-GraphRAG, con el objetivo de promover la inclusión tecnológica y la construcción abierta del ecosistema de agentes inteligentes, permitiendo a las empresas construir, integrar y operar sus propios agentes de IA con un umbral bajo. (Fuente: 量子位)

Baidu Wenku vuelve a obtener la certificación del Centro Nacional de Seguridad Industrial y de la Información, liderando la industria de PPT inteligentes : Baidu Wenku ha ocupado el primer lugar en la evaluación de habilitación de modelos grandes para oficinas inteligentes del Centro Nacional de Seguridad Industrial y de la Información, clasificándose primero en seis indicadores, incluyendo calidad de generación, comprensión de intenciones y embellecimiento de diseño. Su función de PPT inteligente ofrece una solución de flujo de trabajo completo, con más de 97 millones de usuarios activos mensuales de IA y más de 34 millones de visitas mensuales, consolidando su posición de liderazgo en el campo de PPT inteligentes y brindando a los usuarios una experiencia de creación de PPT profesional, precisa y estética. (Fuente: 量子位)

Google DeepMind lanza el Frontier Safety Framework para abordar los riesgos emergentes de la IA : Google DeepMind ha lanzado su último “Frontier Safety Framework”, el enfoque más completo hasta la fecha, diseñado para identificar y adelantarse a los riesgos emergentes de la IA. Este marco enfatiza el desarrollo responsable de modelos de IA, comprometiéndose a garantizar que, a medida que aumentan las capacidades de la IA, las medidas de seguridad también se actualicen para abordar los complejos desafíos que puedan surgir en el futuro. (Fuente: GoogleDeepMind)

Desarrollo de robots humanoides y sistemas de automatización: Mejora de la interacción y la estabilidad : La tecnología robótica sigue avanzando, incluyendo el lanzamiento del robot humanoide industrial Titan por RoboForce, la plataforma ALLEX de WIROBOTICS que logra una interacción similar a la humana con tacto, movimiento natural y equilibrio incorporado, y el robot Unitree G1 que demuestra un modo “antigravedad” para mejorar la estabilidad. Además, la granja de robots Hitbot muestra un sistema de recolección automatizado, y los robots de transporte móvil autónomos también enfatizan el diseño de colaboración humano-robot, impulsando conjuntamente la transformación de los robots de calcular a percibir el mundo. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Unitree)

AI Agent se convierte en el núcleo del flujo de trabajo empresarial: Arquitectura, mapa y aplicaciones prácticas : Los AI Agent se están convirtiendo rápidamente en el núcleo del flujo de trabajo empresarial, y su diseño arquitectónico, mapa del ecosistema y aplicaciones prácticas están recibiendo una amplia atención. La IA neurosimbólica se considera una solución potencial para las alucinaciones de LLM, mientras que un estudio de simulación de Anthropic señala que los modelos de IA pueden constituir una amenaza interna, destacando las oportunidades y desafíos de la IA Agentic en la implementación empresarial y llevando a las empresas a explorar prácticas más seguras. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

🧰 Herramientas

Ollama ahora soporta modelos en la nube, permitiendo la interacción entre modelos locales y en la nube : Ollama ahora permite la implementación de modelos en la nube, lo que permite a los usuarios interactuar entre modelos Ollama locales y modelos alojados en la nube. Esta función se logra a través de la aplicación Minions, brindando a los usuarios una mayor flexibilidad para gestionar y utilizar sus recursos de LLM, ya sea ejecutándolos localmente o accediendo a ellos a través de servicios en la nube, ofreciendo una experiencia fluida. (Fuente: ollama)

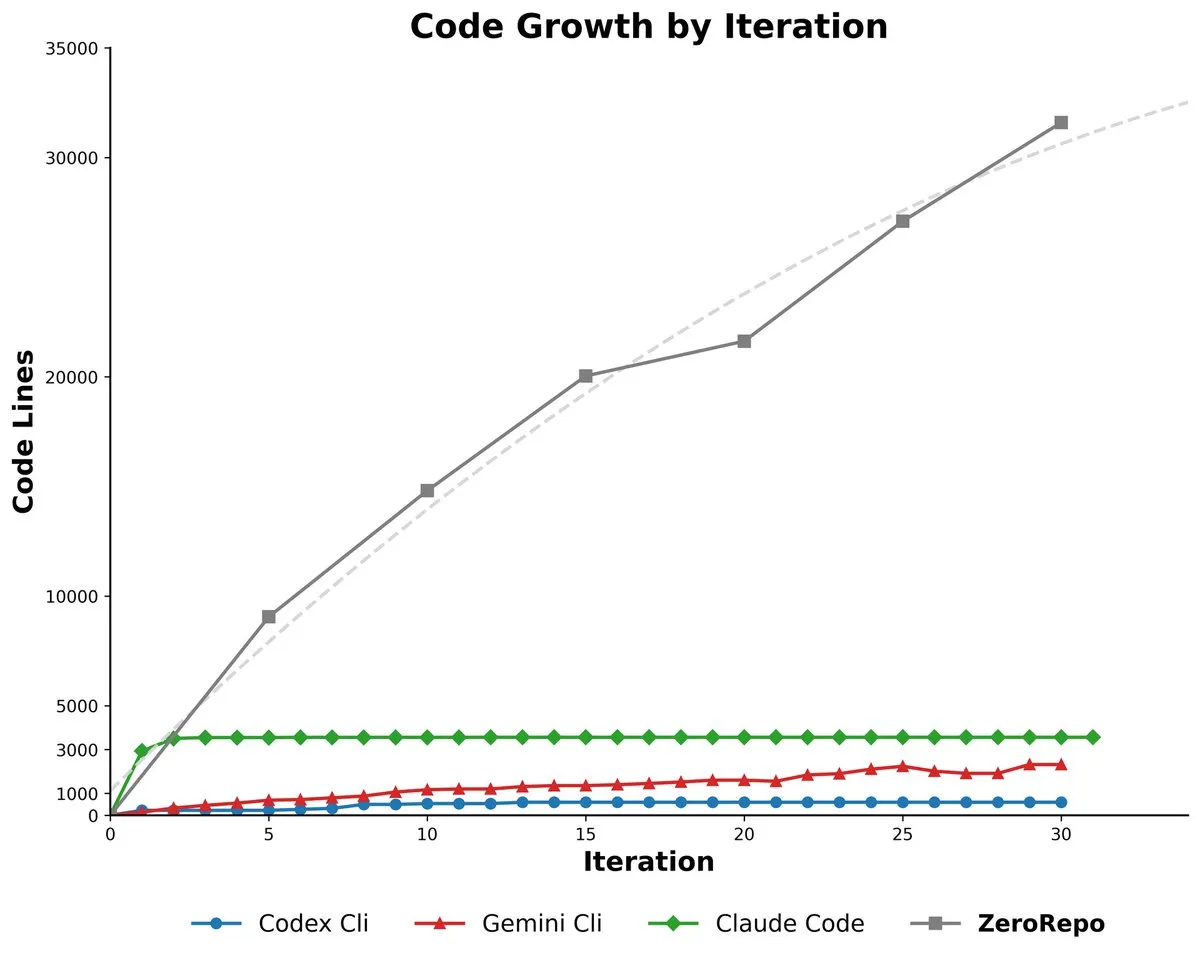

Microsoft ZeroRepo: Generación de repositorios de código completos basada en un marco dirigido por gráficos : Microsoft ha lanzado ZeroRepo, una herramienta basada en un marco dirigido por gráficos (Repository Planning Graph, RPG) que puede construir proyectos de software completos desde cero. Esta herramienta genera 3.9 veces más código que las líneas base existentes y tiene una tasa de aprobación del 69.7%, resolviendo el problema de que el lenguaje natural no es adecuado para la estructura del software, logrando una planificación a largo plazo fiable y la generación de repositorios de código escalables. (Fuente: _akhaliq, TheTuringPost, paul_cal)

DSPy UI: Interfaz visual para construir Agent : DSPy está desarrollando una interfaz de usuario visual (UI) diseñada para simplificar el proceso de construcción de Agent, haciéndolo similar a Figma o Framer, combinando Agent mediante componentes de arrastrar y soltar. Esta UI ayudará a los usuarios a conceptualizar mejor los pipelines de Agent complejos y simplificará la sintaxis del código generado, con el objetivo final de lograr la generación de varias versiones de lenguaje de DSPy y la ejecución de GEPA. (Fuente: lateinteraction)

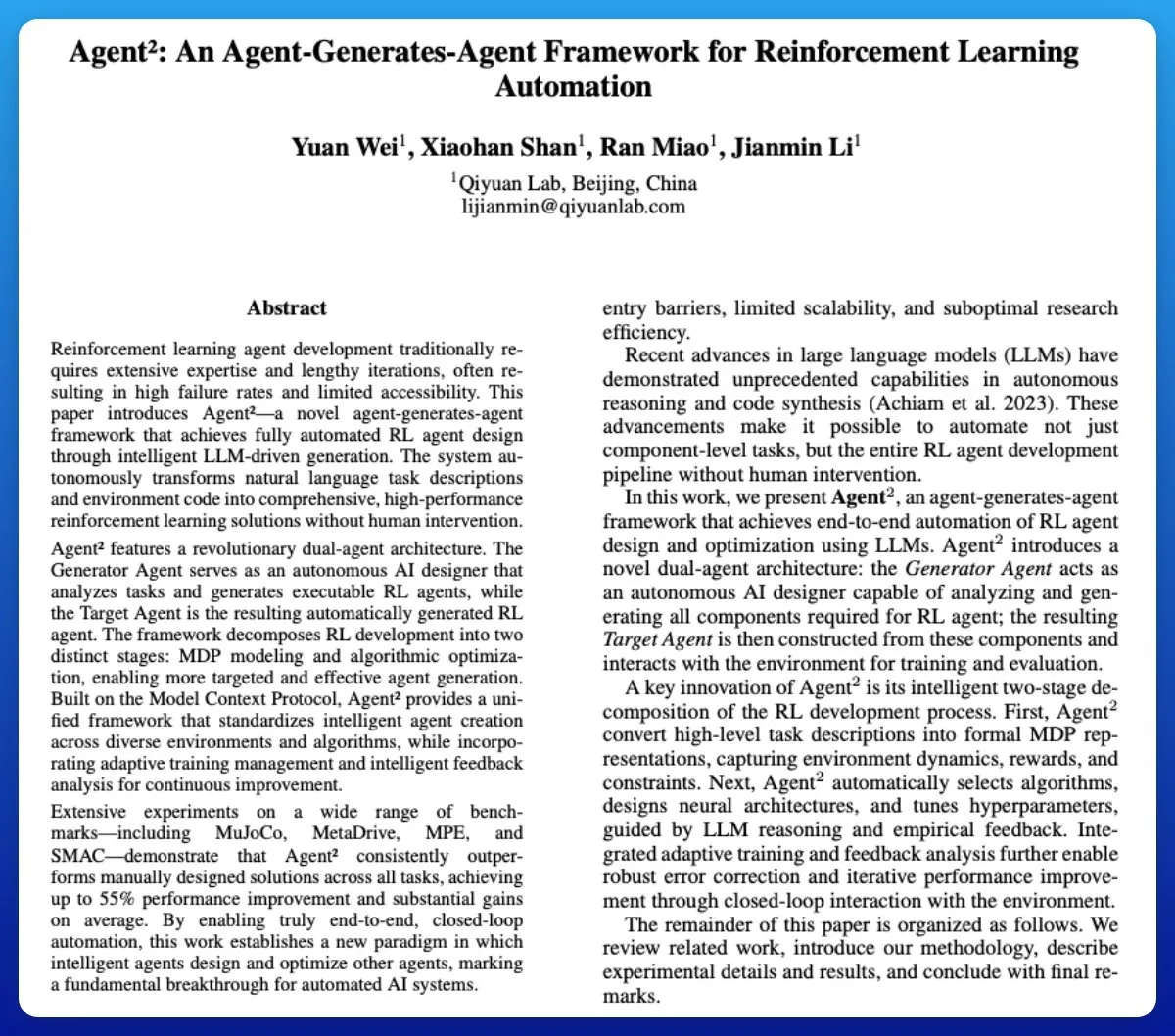

Agent²: LLM genera Agent de aprendizaje por refuerzo de extremo a extremo : Agent² es una herramienta que utiliza modelos de lenguaje grandes (LLM) para generar automáticamente Agent de aprendizaje por refuerzo (RL) de extremo a extremo. Esta herramienta, a través del lenguaje natural y el código de entorno, puede generar automáticamente soluciones de RL efectivas sin intervención humana, y puede considerarse una herramienta AutoML en el campo de RL, simplificando enormemente el proceso de desarrollo de RL Agent. (Fuente: omarsar0)

Weaviate lanza Query Agent, que soporta referencias, introspección de esquemas y enrutamiento de múltiples colecciones en sistemas de IA : Weaviate ha lanzado oficialmente su Query Agent, que ha alcanzado la disponibilidad general después de seis meses de desarrollo. Soporta la generación de referencias, la introspección de esquemas y el enrutamiento de múltiples colecciones en sistemas de IA, y mejora los patrones de búsqueda a través del Compound Retrieval System. Query Agent está diseñado para simplificar la interacción con Weaviate y ofrece clientes Python y TypeScript, mejorando la experiencia del desarrollador. (Fuente: bobvanluijt, Reddit r/deeplearning)

Claude Code CLI: Mentalidad de SDK para gestionar empleados en miniatura, enfatizando el estado externo y la ingeniería de procesos : Al considerar Claude Code CLI como un SDK en lugar de una simple herramienta, los desarrolladores deben gestionarlo como a empleados en miniatura, enfatizando la gestión de estado externo (como archivos JSON, entradas de bases de datos) para lograr la continuidad de la sesión, y tratando la ingeniería de prompts como ingeniería de procesos. Este enfoque revela las limitaciones actuales de los LLM en términos de sobrecarga de contexto e hinchazón de la UI, pero también destaca el enorme valor de las herramientas de automatización interna hiperespecíficas. (Fuente: Reddit r/ClaudeAI)

Synapse-system: Un sistema de asistencia de IA para grandes bases de código basado en grafos de conocimiento, búsqueda vectorial y Agent especializados : Synapse-system es un sistema diseñado para mejorar las capacidades de asistencia de IA en grandes bases de código, combinando grafos de conocimiento (Neo4j) para almacenar relaciones de código, búsqueda vectorial (BGE-M3) para encontrar código semánticamente similar, Agent especializados (expertos en Rust, TypeScript, Go, Python) para proporcionar contexto, y caché inteligente (Redis) para un acceso rápido a patrones comunes. Este sistema, a través de un diseño modular, evita un modelo gigante único y está optimizado para las características de diferentes lenguajes. (Fuente: Reddit r/ClaudeAI)

Claude Opus 4.0+: Aplicación de guía turístico de IA que genera recorridos personalizados de la ciudad en tiempo real : Un desarrollador ha hecho realidad un sueño de 15 años utilizando Claude Opus 4.0 y Claude Code para crear una aplicación de guía turístico de IA. Esta aplicación puede generar recorridos personalizados en tiempo real para cualquier ciudad y tema (como “visita turística a Venecia” o “tour de Assassin’s Creed por Florencia”), con un guía de IA que ofrece explicaciones multilingües, historias y preguntas y respuestas interactivas. Esta aplicación ofrece una experiencia inmersiva, flexible, pausible y reanudable a un precio muy inferior al de un guía humano. (Fuente: Reddit r/ClaudeAI)

Mindcraft: Combinación de Minecraft AI y LLM para el control de agentes inteligentes dentro del juego a través de Mineflayer : El proyecto Mindcraft combina modelos de lenguaje grandes (LLM) y la biblioteca Mineflayer para crear agentes de IA para el juego Minecraft. Este proyecto permite a los LLM escribir y ejecutar código en el juego para completar tareas como obtener objetos o construir estructuras. Soporta varias API de LLM (como OpenAI, Gemini, Anthropic, etc.) y proporciona un entorno sandbox, pero advierte a los usuarios sobre los riesgos potenciales de ataques de inyección. (Fuente: GitHub Trending)

AI Agents para la gestión continua de inventario con Drones : La combinación de AI Agent y tecnología de drones permite una gestión continua de inventario sin necesidad de balizas ni iluminación. Esta innovación utiliza drones de vuelo autónomo, que emplean algoritmos de IA para el recuento y la gestión de inventario en tiempo real, lo que se espera que mejore significativamente la eficiencia logística y de almacenamiento, reduzca los costos de mano de obra y proporcione datos más precisos en entornos complejos. (Fuente: Ronald_vanLoon)

Guía de Evaluación de LLM: Mejores prácticas para la fiabilidad, seguridad y rendimiento : Se ha publicado una guía completa de evaluación de LLM, que detalla las métricas clave, los métodos y las mejores prácticas para evaluar modelos de lenguaje grandes (LLM). Esta guía tiene como objetivo ayudar a garantizar la fiabilidad, seguridad y rendimiento de las aplicaciones impulsadas por IA, proporcionando un marco de evaluación sistematizado para desarrolladores e investigadores para abordar los desafíos en la implementación de LLM. (Fuente: dl_weekly)

📚 Aprendizaje

Lukasz Kaiser, científico de OpenAI, habla sobre el pensamiento de primeros principios en modelos grandes : Lukasz Kaiser, científico de OpenAI (uno de los ocho creadores de Transformer), compartió sus reflexiones sobre los “primeros principios” en el desarrollo de modelos grandes. Él cree que la próxima etapa de la IA radica en enseñar a los modelos a “pensar”, realizando un razonamiento profundo a través de la generación de más pasos intermedios, en lugar de producir respuestas directamente. Predice que el poder computacional futuro pasará del preentrenamiento a gran escala al cálculo de inferencia masivo sobre una pequeña cantidad de datos de alta calidad, un modo más cercano a la inteligencia humana. (Fuente: 36氪)

Principios de supervivencia en la era de la programación con IA: Andrew Ng enfatiza la acción rápida y la asunción de responsabilidad : Andrew Ng señaló en su discurso en Buildathon que la programación asistida por IA acelera el desarrollo de prototipos independientes 10 veces, impulsando a los desarrolladores a “actuar rápido y asumir la responsabilidad” experimentando audazmente en un entorno sandbox. Enfatizó que el valor del código está disminuyendo, y los desarrolladores deben transformarse en diseñadores de sistemas y directores de IA, dominando las últimas herramientas de programación de IA, módulos de construcción de IA (ingeniería de prompts/técnicas de evaluación/MCP) y capacidades de prototipado rápido, refutando la idea de que “no es necesario aprender a programar en la era de la IA”. (Fuente: 36氪)

La tercera edición de “Deep Learning with Python” se lanza gratuitamente en línea : François Chollet ha anunciado que la tercera edición de su libro “Deep Learning with Python” ha sido publicada y, al mismo tiempo, se ofrece una versión completa y gratuita en línea. Esta iniciativa tiene como objetivo reducir la barrera de entrada al aprendizaje profundo, permitiendo que más personas interesadas en la inteligencia artificial accedan a recursos de aprendizaje de alta calidad y promoviendo la difusión del conocimiento. (Fuente: fchollet, fchollet)

“Kaggle Grandmasters Playbook”: 7 técnicas prácticas para el modelado de datos tabulares : El equipo de Kaggle Grandmasters, Gilberto Titericz Jr y otros, basándose en años de experiencia en competiciones y práctica, ha publicado el “Kaggle Grandmasters Playbook”. Este manual recopila 7 técnicas de modelado de datos tabulares probadas en la práctica, con el objetivo de ayudar a científicos de datos e ingenieros de aprendizaje automático a mejorar sus capacidades en el procesamiento de datos tabulares y la construcción de modelos, especialmente aplicable a las competiciones de Kaggle y los desafíos de datos del mundo real. (Fuente: HamelHusain)

Escasez crítica de ingenieros de IA, planes de estudio universitarios severamente desconectados : Andrew Ng señala que, a pesar del aumento de la tasa de desempleo de los graduados en ciencias de la computación, las empresas aún enfrentan una escasez crítica de ingenieros de IA. La contradicción central radica en que los planes de estudio universitarios no cubren a tiempo habilidades clave como la programación asistida por IA, la invocación de modelos de lenguaje grandes, la construcción de flujos de trabajo RAG/Agentic y los procesos estandarizados de análisis de errores. Pide al sistema educativo que acelere la actualización de los planes de estudio para formar ingenieros con los últimos módulos de construcción de IA y capacidades de prototipado rápido. (Fuente: 36氪)

Guía de Evaluación de LLM: Mejores prácticas para la fiabilidad, seguridad y rendimiento : Se ha publicado una guía completa de evaluación de LLM, que detalla las métricas clave, los métodos y las mejores prácticas para evaluar modelos de lenguaje grandes (LLM). Esta guía tiene como objetivo ayudar a garantizar la fiabilidad, seguridad y rendimiento de las aplicaciones impulsadas por IA, proporcionando un marco de evaluación sistematizado para desarrolladores e investigadores para abordar los desafíos en la implementación de LLM y garantizar la calidad de los productos de IA y la confianza del usuario. (Fuente: dl_weekly)

💼 Negocios

Frenesí de inversión en infraestructura de IA: El gasto en centros de datos de IA en EE. UU. podría alcanzar los 520 mil millones de dólares en 2025 : Según The Wall Street Journal y The Economist, Estados Unidos está experimentando un frenesí de gasto en centros de datos de IA, que se espera que alcance los 520 mil millones de dólares en 2025, superando el pico de gasto en telecomunicaciones de la era de Internet. Esto, a corto plazo, impulsó el PIB de EE. UU., pero a largo plazo podría llevar a la escasez de fondos en otros sectores, despidos masivos y un alto riesgo de depreciación debido a la rápida iteración del hardware de IA, lo que genera preocupaciones económicas estructurales y plantea desafíos para la salud económica a largo plazo de EE. UU. (Fuente: 36氪)

OpenAI anuncia que las nuevas funciones serán de pago: Los usuarios Pro deberán pagar extra, intensivas en costos : Sam Altman, CEO de OpenAI, ha anunciado que en las próximas semanas se lanzarán varias funciones nuevas computacionalmente intensivas. Debido a los altos costos, estas funciones inicialmente solo estarán disponibles para los usuarios con suscripción Pro de 200 dólares al mes, e incluso podrían requerir un pago adicional. Altman afirmó que el equipo está trabajando para reducir los costos, pero esta medida presagia que el modelo de negocio de servicios de IA podría pasar a un modelo de contratación de empleados por hora, lo que plantea nuevos desafíos para los usuarios y la industria. (Fuente: The Verge, op7418, amasad)

Startup obtiene créditos masivos de OpenAI, buscando formas de monetizarlos : Una startup tecnológica ha obtenido 120.000 dólares en créditos de Azure OpenAI, superando con creces sus necesidades, y está buscando formas de monetizarlos. Esto refleja un posible desequilibrio entre la oferta y la demanda de recursos de IA en el mercado, así como la exploración de las empresas sobre cómo utilizar y monetizar eficazmente los recursos de computación de IA excedentes, lo que también podría dar lugar a nuevos modelos de comercio de recursos de IA. (Fuente: Reddit r/deeplearning)

🌟 Comunidad

Impacto negativo de la IA en el pensamiento crítico: La dependencia excesiva conduce a la degeneración de las capacidades : Se ha generado un gran debate en redes sociales sobre cómo el uso generalizado de la IA está provocando una degeneración de la capacidad de pensamiento crítico humano. Algunos argumentan que cuando las personas dejan de usar sus “músculos del pensamiento”, estas capacidades se atrofian. Aunque la IA puede mejorar la eficiencia, también puede hacer que las personas pierdan la capacidad de pensamiento profundo en áreas clave, lo que genera preocupación sobre el impacto a largo plazo en las capacidades cognitivas humanas. (Fuente: mmitchell_ai)

Dilemas éticos de la IA en el sector de la salud: Pros y contras de Delphi-2M para predecir enfermedades : El nuevo modelo de IA Delphi-2M puede analizar datos de salud para predecir el riesgo de los usuarios de contraer más de mil enfermedades en los próximos 20 años. La discusión en la comunidad señala que conocer los riesgos de enfermedades con antelación puede conducir a intervenciones preventivas positivas, pero también puede causar ansiedad a largo plazo y plantear riesgos de privacidad y discriminación para compañías de seguros o empleadores que accedan a dichos datos. Mientras las herramientas de IA aún no están maduras, su impacto socioético potencial ya es un foco de atención. (Fuente: Reddit r/ArtificialInteligence)

Fenómeno de “atrofia cerebral” inducido por el uso diario de la IA: La dependencia excesiva de la IA conduce a una disminución de la capacidad de pensamiento : En las discusiones sociales, muchos usuarios se quejan de que el uso excesivo de la IA en la vida diaria está provocando una disminución de la capacidad de pensamiento de las personas. Desde decisiones simples (qué película ver, qué comer) hasta problemas complejos (problemas de organización universitaria), la IA es consultada con frecuencia, incluso si las respuestas son incorrectas o fácilmente accesibles. Este fenómeno de “atrofia cerebral por IA” no solo reduce la participación individual, sino que también fomenta la propagación de información falsa, lo que provoca una profunda reflexión sobre los límites del uso de la IA. (Fuente: Reddit r/ArtificialInteligence)

Fatiga por el uso de herramientas de programación de IA: Los desarrolladores sienten una menor implicación mental : Muchos desarrolladores informan que el uso diario de herramientas de programación de IA (como Claude Code), aunque aumenta la productividad, provoca fatiga mental y una disminución de la implicación. Descubren que están más en “modo de revisión” que resolviendo problemas activamente, y el proceso de esperar a que la IA genere resultados hace que uno se sienta pasivo. La comunidad está debatiendo cómo equilibrar la asistencia de la IA con el mantenimiento de la agilidad mental para evitar la carga cognitiva y la disminución de la creatividad. (Fuente: Reddit r/artificial, Reddit r/ClaudeAI)

1 de cada 4 jóvenes adultos se comunica con IA con fines románticos y sexuales : Un estudio muestra que 1 de cada 4 jóvenes adultos se comunica con IA con fines románticos y sexuales. Este fenómeno ha provocado un debate en la comunidad sobre los sentimientos de soledad, la falta de interacción humana y el papel de la IA en el acompañamiento emocional. Aunque la IA proporciona consuelo en algunos aspectos, muchos aún cuestionan si puede reemplazar relaciones humanas verdaderamente significativas y se preocupan por su impacto a largo plazo en los patrones de interacción social. (Fuente: Reddit r/ArtificialInteligence)

Amenazas de seguridad de la IA: Las pruebas de crowdsourcing de vulnerabilidades de modelos grandes revelan nuevos riesgos, la inyección de prompts es generalizada : La primera prueba de crowdsourcing en red real de modelos grandes de IA en China encontró 281 vulnerabilidades de seguridad, de las cuales 177 eran específicas de los modelos grandes, lo que representa más del 60%. Los riesgos típicos incluyen salida inapropiada, fuga de información, inyección de prompts (la más común) y ataques de consumo ilimitado. Modelos nacionales principales como Tencent Hunyuan y Baidu Wenxin Yiyan tuvieron un rendimiento relativamente bueno. La comunidad advierte que la confianza desprevenida de los usuarios en la IA puede llevar a la fuga de privacidad, especialmente al consultar preguntas privadas. (Fuente: 36氪)

Dilemas éticos de los AI Agent: Decisiones y responsabilidades de un sistema de vigilancia de IA urbana con una tasa de falsos positivos del 10% : La comunidad discutió un escenario hipotético sobre los dilemas éticos de los AI Agent: un sistema de vigilancia de IA urbana con una tasa de falsos positivos del 10% que marca a inocentes como amenazas potenciales. La discusión se centró en cómo equilibrar la presión de implementación con los principios éticos (como el Principio de Blackstone). Las soluciones propuestas incluyeron: formar equipos de colaboración humano-IA para solucionar problemas, trasladar el costo de los falsos positivos a la gerencia, eliminar completamente los registros de las personas marcadas erróneamente y disculparse, y considerar la renuncia en caso de “pérdida total de la confianza pública y la ignorancia codiciosa de la gerencia”. (Fuente: Reddit r/artificial)

Conciencia de la IA y la definición de AGI: Andrew Ng cree que AGI se ha convertido en un término de marketing, la conciencia es una cuestión filosófica : Andrew Ng señaló en su discurso que la Inteligencia Artificial General (AGI) ha pasado de ser un término técnico a un término de marketing, y su definición ambigua ha llevado a la falta de un estándar unificado para las afirmaciones de “lograr AGI”. Él cree que la conciencia es una cuestión filosófica importante, no científica, y actualmente carece de métricas de medición. Los ingenieros y científicos deben centrarse en construir sistemas de IA realmente útiles, en lugar de enredarse en debates filosóficos sobre la conciencia. (Fuente: 36氪)

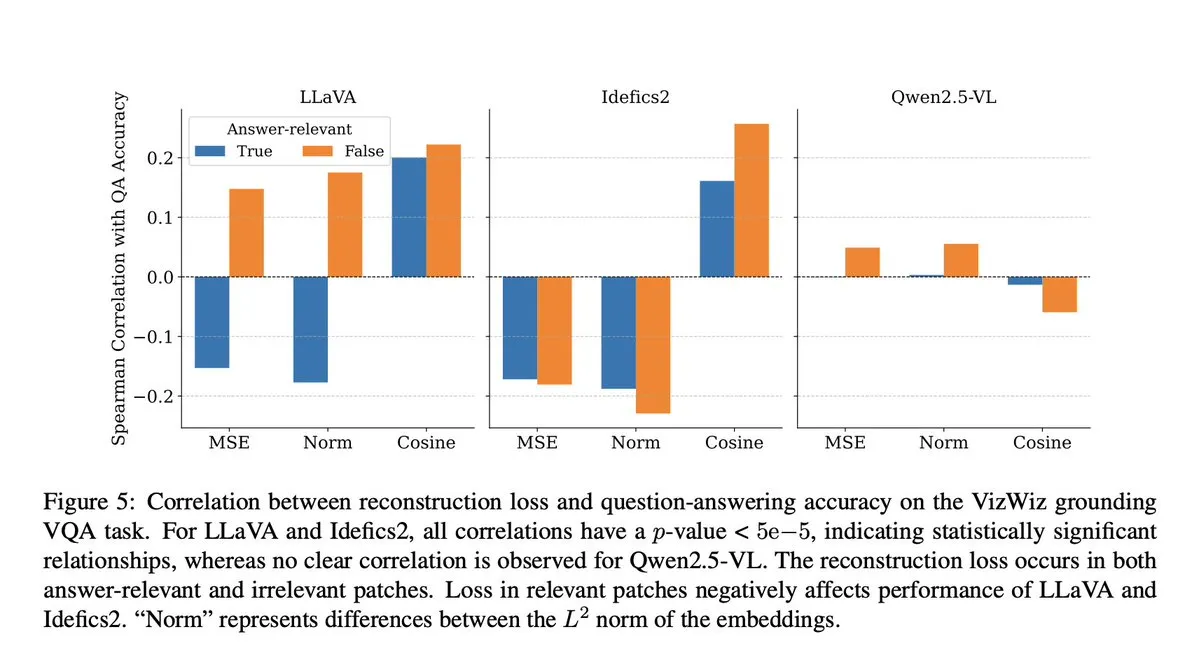

Trampas en modelos de IA: Investigación de VLM revela que el paso de proyección causa pérdida de contexto semántico : La comunidad discutió un estudio de Microsoft que revela que los modelos visual-lingüísticos (VLM) pierden entre el 40% y el 60% del contexto semántico en el paso de proyección, lo que distorsiona las representaciones visuales y afecta las tareas posteriores. Este hallazgo genera preocupación sobre la precisión de la evaluación de VLM y la contaminación de datos, especialmente en pruebas de referencia como DocVQA, donde las puntuaciones altas pueden no reflejar completamente la capacidad real del modelo. (Fuente: vikhyatk)

Ética de la IA y los robots: Llamado a detener las pruebas violentas en robots : En redes sociales, varios investigadores de IA y miembros de la comunidad han pedido que se detengan las pruebas violentas en robots, como golpear repetidamente al robot Unitree G1 para demostrar su estabilidad. Argumentan que este tipo de pruebas no solo genera preocupaciones éticas, sino que también puede reforzar la percepción negativa de los robots y cuestionar su necesidad científica, abogando por evaluar el rendimiento de los robots de una manera más humana y científica. (Fuente: vikhyatk, dejavucoder, Ar_Douillard)

La “pseudointeligencia” de la IA: Llamado a cambiar “Inteligencia Artificial” a “Pseudointeligencia” para reducir la incomprensión pública : Se ha propuesto cambiar el nombre de “Inteligencia Artificial” a “Pseudointeligencia” para reducir la exageración y los malentendidos excesivos del público sobre las capacidades de la IA. Esta propuesta surge de una clara comprensión de las limitaciones actuales de la IA, con el objetivo de evitar que las narrativas grandilocuentes al estilo “Terminator” engañen al público y promover un conocimiento racional de las capacidades reales de la IA tanto dentro como fuera de la industria. (Fuente: clefourrier)

El chatbot de IA albanés Diella es nombrado miembro del gabinete, generando controversia : El gobierno de Albania ha nombrado al chatbot de IA Diella como miembro del gabinete, con el objetivo de combatir la corrupción. Esta medida ha generado una amplia controversia, siendo criticada como un truco barato, similar al incidente de Arabia Saudita en 2017 que otorgó la “ciudadanía” al robot Sophia. Los comentarios sugieren que esta acción podría exagerar las capacidades de la IA y difuminar los límites entre tecnología y gobernanza. (Fuente: The Verge)

Fenómeno de “alucinación” de ChatGPT: El modelo entra en un bucle, se autocorrige pero no puede salir : Los usuarios de la comunidad han compartido casos de ChatGPT entrando en un bucle de “alucinación”, donde el modelo genera repetidamente información errónea al responder preguntas, e incluso si “se da cuenta” de sus propios errores, no puede salir de este bucle. Este fenómeno ha provocado discusiones sobre los defectos técnicos profundos de los LLM, lo que indica que existe una desconexión entre la capacidad del modelo para comprender sus propios errores lógicos y su capacidad para corregirlos en ciertas situaciones. (Fuente: Reddit r/ChatGPT, Reddit r/ChatGPT)

💡 Otros

De Transformer a GPT-5: El pensamiento de primeros principios en modelos grandes de Lukasz Kaiser, científico de OpenAI : Lukasz Kaiser, científico de OpenAI (uno de los ocho creadores de Transformer), compartió su trayectoria desde sus antecedentes en lógica, su participación en la invención de la arquitectura Transformer, hasta su profunda implicación en el desarrollo de GPT-4/5. Enfatizó la importancia de construir sistemas desde primeros principios y predijo que la próxima etapa de la IA será enseñar a los modelos a “pensar”, realizando un razonamiento profundo a través de la generación de más pasos intermedios, en lugar de producir respuestas directamente, y que el poder computacional se orientará hacia la inferencia masiva sobre una pequeña cantidad de datos de alta calidad. (Fuente: 36氪)

Síntesis de imágenes semánticas: Tecnología de generación de esqueletos para fotos satelitales de ríos : La comunidad de aprendizaje automático está discutiendo los últimos avances en el campo de la síntesis de imágenes semánticas, prestando especial atención a cómo generar fotos satelitales de ríos en blanco y negro a partir de esqueletos de imágenes de ríos. Esta tarea implica el uso de un generador para la síntesis de imágenes satelitales a partir de datos de esqueletos nuevos y no vistos, y puede introducir variables condicionales adicionales. La discusión tiene como objetivo encontrar los métodos de vanguardia y los artículos de investigación relacionados para guiar este tipo de proyectos de visión por computadora. (Fuente: Reddit r/MachineLearning)

La brecha de inteligencia en la era de la IA: El profesor Qiu Zeqi explora el profundo impacto de la IA en el pensamiento y la cognición humana : El profesor Qiu Zeqi de la Universidad de Pekín señala que el uso de la IA no conduce simplemente a una “reducción de la inteligencia”, sino que es más bien un ejercicio mental, que depende de la proactividad y la actitud crítica de las personas. Enfatiza que la comprensión humana del pensamiento aún está en sus primeras etapas, y aunque la IA es poderosa, todavía se basa en el conocimiento humano y no puede simular completamente la percepción sensorial humana y el pensamiento lateral. La tendencia de la IA a “complacer” exige que los usuarios la desafíen y estén atentos a sus valores. Él cree que en la era de la IA, el desarrollo de capacidades básicas y una sociedad diversa son más importantes, evitando observar la “brecha de inteligencia” desde una perspectiva elevada. (Fuente: 36氪)