Palabras clave:Redes neuronales físicas, Entrenamiento de IA, Sustitución de GPU, Reseña de Nature, Optimización de eficiencia energética, PNNs isomórficos, PNNs de isomorfismo roto, Sistemas de computación óptica, Red neuronal de vibraciones mecánicas, Red neuronal electrónica física, Problema de acumulación de ruido, Análisis de viabilidad comercial

🔥 Enfoque

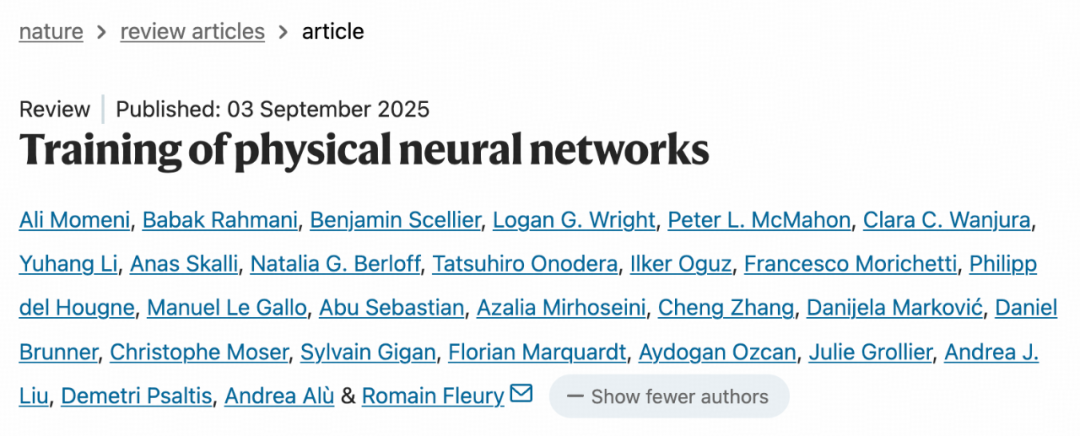

Liberarse de la dependencia de la GPU, Nature publica una revisión sobre “Redes Neuronales Físicas”: Nature revisa las Redes Neuronales Físicas (PNNs), que utilizan sistemas físicos como la luz, la electricidad y las vibraciones para el cálculo, prometiendo superar los cuellos de botella de las GPU tradicionales y lograr un entrenamiento e inferencia de IA más eficientes y energéticamente sostenibles. Las PNNs se dividen en tipos homogéneos y de simetría rota, y han sido validadas en sistemas ópticos, mecánicos y electrónicos, con diversas técnicas de entrenamiento. En el futuro, se requiere una optimización conjunta de hardware y software, y la eficiencia energética debe mejorar miles de veces para ser comercialmente viables. Los desafíos incluyen la acumulación de ruido, la adaptación del hardware y el equilibrio entre las formas neuromórficas y físicas. (Fuente: 36氪)

Google sale ganando: Google gana el caso antimonopolio del siglo, evitando la división de sus negocios de Chrome y Android, principalmente gracias al auge de la IA generativa (como ChatGPT), que ha cambiado el panorama de la competencia en el mercado. Los chatbots de IA son vistos como una alternativa potente a los motores de búsqueda tradicionales. Aunque el fallo restringe algunos acuerdos de exclusividad de Google, elimina la amenaza de una división, impulsando un aumento significativo en el precio de sus acciones. Además, el negocio de TPU de Google ha sido reevaluado, considerado una alternativa sólida a Nvidia, con el potencial de desafiar el panorama del mercado de la potencia de cálculo de IA. (Fuente: 36氪)

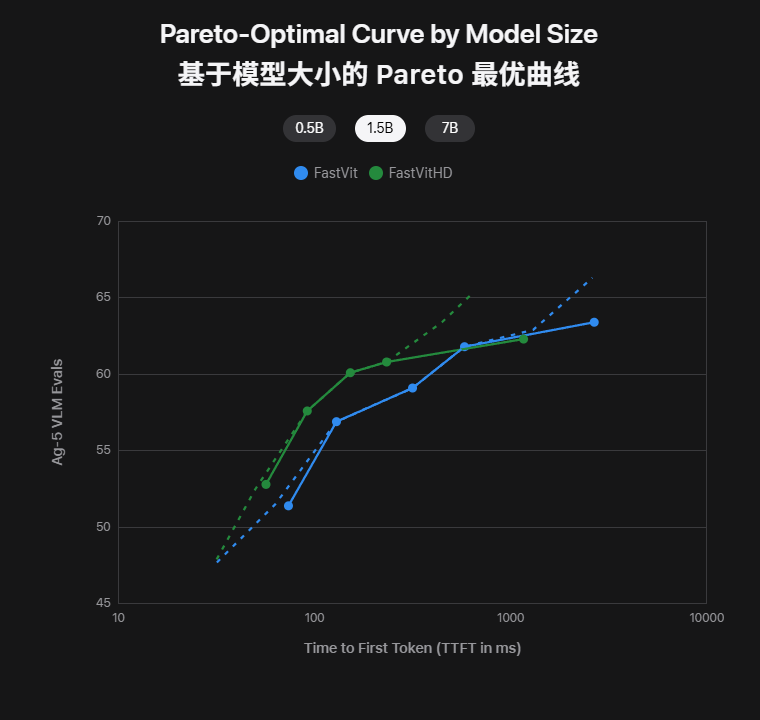

Apple lanza dos modelos de IA en el dispositivo, con el tamaño del modelo reducido a la mitad y la latencia del primer token disminuida 85 veces, para uso instantáneo offline en iPhone: Apple ha lanzado FastVLM y MobileCLIP2, dos grandes modelos multimodales en el dispositivo, en Hugging Face. FastVLM, a través de su codificador FastViTHD de desarrollo propio, logra baja latencia con entrada de alta resolución (el primer token es 85 veces más rápido) y soporta subtítulos en tiempo real. MobileCLIP2 reduce su tamaño a la mitad manteniendo una alta precisión, permitiendo la recuperación y descripción de imágenes offline en el iPhone. Estos modelos ya tienen demos y toolchains disponibles, marcando la realidad de ejecutar modelos grandes en el iPhone, mejorando la privacidad y la velocidad de respuesta. (Fuente: 36氪)

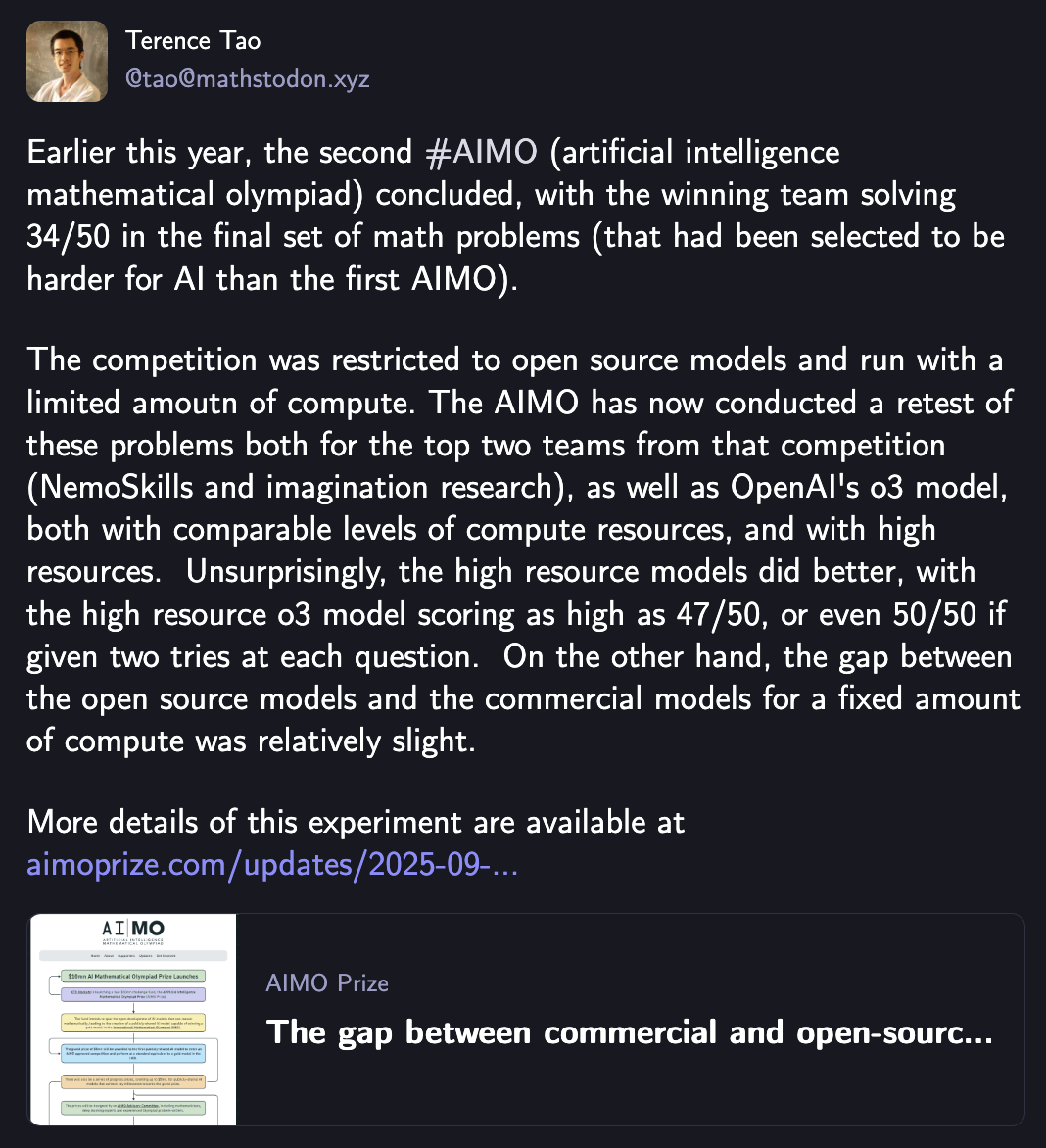

Incluso Terence Tao se sorprendió, o3 domina y gana el primer “AI Olympiad Math”, mientras la legión de código abierto persigue a OpenAI a solo 5 puntos: El modelo o3 de OpenAI ganó la segunda competición de la Olimpiada Matemática de Inteligencia Artificial (AIMO2) con una puntuación máxima de 47 puntos (sobre 50), demostrando una potente capacidad de razonamiento matemático a nivel de olimpiada. Las pruebas muestran una correlación positiva entre la inversión en potencia de cálculo y el rendimiento del modelo, y que la brecha entre los modelos de código abierto y los comerciales (o3) se está reduciendo con los mismos recursos computacionales; los cinco principales modelos de código abierto combinados quedaron a solo 5 puntos de o3. Esto marca un avance histórico para la IA en el campo del razonamiento matemático avanzado. (Fuente: 36氪)

🎯 Tendencias

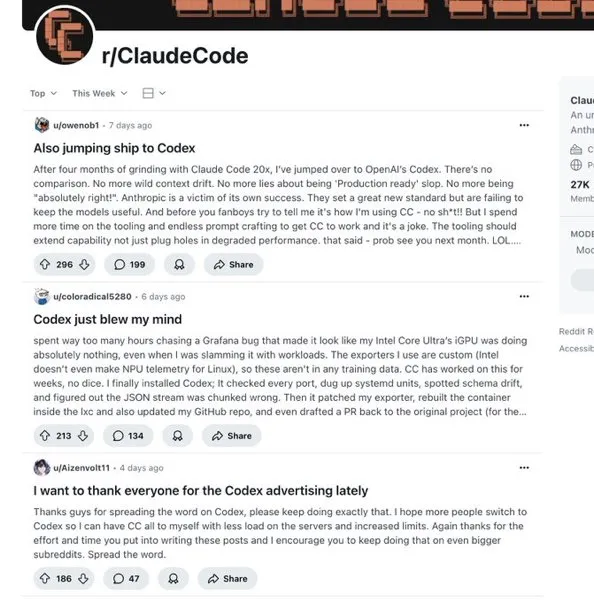

Claude no nos permite usarlo, ¿pueden los sustitutos nacionales tomar el relevo?: Anthropic ha restringido los servicios de Claude Code a China, lo que ha impulsado a los grandes modelos nacionales (como Kimi-K2-0905 de Moonshot AI y Qwen3-Max-Preview de Alibaba) a centrarse en el campo de la generación de código. Kimi-K2-0905 tiene una longitud de contexto de 256k, optimizando el desarrollo frontend y la llamada a herramientas, con API compatible con Anthropic. Los modelos nacionales demuestran competitividad en rendimiento y precio, con el potencial de llenar el vacío del mercado y cambiar el panorama de la competencia global en programación de IA. (Fuente: 36氪)

La Inteligencia Artificial General (AGI) ya está aquí: El artículo sugiere que la AGI ya está presente, no es algo del futuro. La cobertura de funcionalidad completa de la IA en roles específicos (como la programación) ya es AGI. Su desarrollo dará lugar a empresas “nativas de la inteligencia” y “sin personal”, donde la IA se convierte en el principal creador de valor y la colaboración humano-máquina se profundiza. La rápida evolución de la IA hará que todo sea reconstruible, y los viejos modelos de negocio podrían ser alterados. Es necesario dominar el paradigma de creación de valor, no la tecnología en sí, y cultivar un pensamiento de IA para adaptarse a un mundo de dependencia invertida. (Fuente: 36氪)

Expertos en IA opinan: ¿Dónde están las oportunidades para las startups de IA de próxima generación? ¿Cuáles son las tendencias de precios?: Bret Taylor, presidente del consejo de OpenAI, cree que las principales oportunidades para las startups de IA están en el mercado de aplicaciones, enfatizando la importancia de la autorreflexión de los Agent. Kevin Weil, CPO de OpenAI, señala cuatro señales clave para los productos de IA de próxima generación: avances en el razonamiento, interfaces de servicio proactivas (memoria, visión, voz), el valor determinado por la finalización de tareas y la accesibilidad global. La tendencia de precios de la IA se mueve hacia un modelo híbrido; la fijación de precios basada en resultados no es aplicable a corto plazo; el valor de la transparencia de precios está sobreestimado, y la mayoría de las empresas no están preparadas para los rápidos cambios en los precios de la IA. (Fuente: 36氪)

Explosión de hardware de IA de consumo en IFA, la IA ya no es un plugin funcional, sino el cerebro del hogar: IFA 2025 muestra cómo la IA pasa de concepto a utilidad práctica, convirtiéndose en el “cerebro detrás de escena” que mejora la experiencia del producto. La IA penetra profundamente en electrodomésticos como refrigeradores, lavadoras y aires acondicionados, logrando comprensión visual y servicios proactivos, y enfatizando el “valor emocional”. Los hogares inteligentes pasan de “todo controlable” a “todo autónomo”, con la IA como centro para coordinar los dispositivos del hogar, como Samsung SmartThings y LG ThinQ ON. La IA también “anima” hardware tradicional como muñecos y planchas, dotándolos de capacidades de comprensión y procesamiento. (Fuente: 36氪)

7 industrias que la Inteligencia Artificial asumirá en 2026: Analistas de datos estudian los patrones de aplicación de IA en empresas Fortune 500, prediciendo que la IA transformará completamente siete grandes industrias en 3-5 años: finanzas, diagnóstico médico, transporte y logística, servicios legales, creación de contenido y marketing, soporte al cliente y control de calidad en la fabricación. La IA se encargará de las tareas rutinarias, mientras los humanos se centran en excepciones y decisiones estratégicas. La velocidad de transformación es exponencial; los pioneros se beneficiarán, mientras que los que se adapten tarde enfrentarán interrupciones profesionales. El informe ofrece un marco de estrategia profesional. (Fuente: 36氪)

La versión china de iPhone AI, finalmente se lanzará: Apple planea lanzar Apple Intelligence en el mercado chino antes de fin de año, colaborando con Alibaba para crear un sistema en el dispositivo, y Baidu proporcionará soporte para Siri e inteligencia visual. Siri también recibirá una herramienta de búsqueda de IA de “motor de respuestas”, posiblemente respaldada por Google, y se considera la integración de modelos grandes de terceros. Estas medidas buscan mejorar la comprensión del chino de Siri y su capacidad de búsqueda de contenido local, fortaleciendo la competitividad de Apple en el mercado chino de gama alta. (Fuente: 36氪)

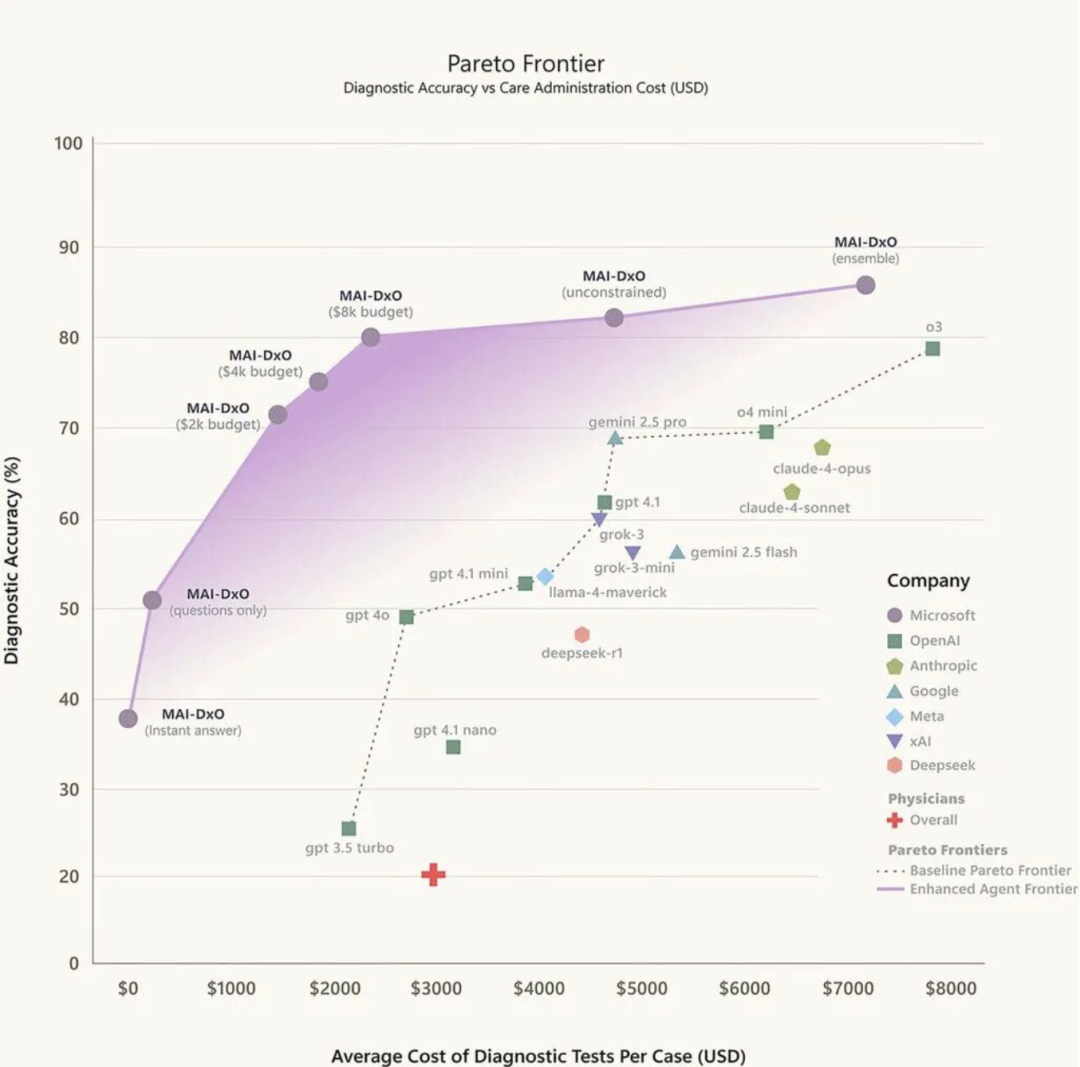

Un médico de IA llega al mundo de la medicina: El diagnóstico asistido por IA está pasando de ser una “novedad” a una herramienta clínica, con actitudes divididas entre los médicos. La IA ha evolucionado a través de tres etapas principales: reconocimiento de imágenes médicas, triaje inteligente y prediagnóstico asistido, y diagnóstico personalizado impulsado por grandes modelos. Existen numerosos casos de práctica local en China, como la consulta inteligente de IA de Baidu Health, iFlytek Smart Medical Assistant y Tencent Miying. Sin embargo, su implementación aún enfrenta desafíos como la confianza, el ciclo cerrado de datos y la atribución de responsabilidades. La tendencia futura es la fusión de “grandes modelos + pequeños modelos” para lograr un diagnóstico especializado mejorado. (Fuente: 36氪)

La demanda de interconexión de alta velocidad en AIDC no cesa, ¿será OCS la próxima respuesta?: Con el crecimiento exponencial del volumen de datos en los centros de datos de IA, OCS (Optical Circuit Switch), como solución de conmutación totalmente óptica, promete resolver los problemas de latencia y consumo de energía de los conmutadores eléctricos tradicionales. OCS, al reconfigurar la ruta física de las señales ópticas, elimina la etapa de conversión optoeléctrica, logrando baja latencia y bajo consumo de energía. Google ya ha introducido OCS a gran escala en sus centros de datos, obteniendo beneficios significativos. Nvidia ha lanzado Ethernet Spectrum-XGS, ofreciendo amplias perspectivas para las aplicaciones de OCS. Los gigantes están entrando en el mercado, y se espera que el tamaño del mercado de OCS supere los 1.600 millones de dólares para 2029. (Fuente: 36氪)

🧰 Herramientas

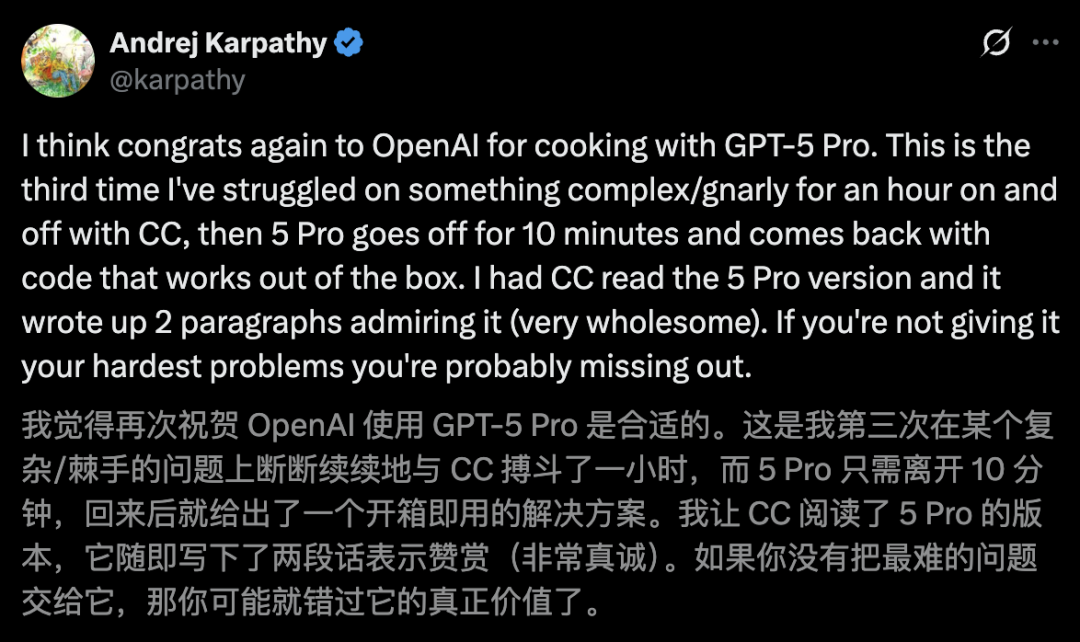

Quien no lo use, pierde, Karpathy elogia a GPT-5: 10 minutos de codificación superan una hora de Claude, Altman responde con agradecimiento al instante: El gurú de la IA Karpathy elogia la potente capacidad de GPT-5 Pro en codificación, afirmando que resolvió un problema que Claude Code no pudo en una hora, en solo 10 minutos. Greg Brockman, presidente de OpenAI, también declaró que GPT-5 Pro es el producto de próxima generación para la codificación. Codex, el agente de programación de IA de OpenAI, experimentó un aumento masivo de rendimiento tras integrar GPT-5, con un aumento de diez veces en su uso en dos semanas, y es considerado una herramienta poderosa que supera a productos como Devin y GitHub Copilot. (Fuente: 36氪)

Nvidia lanza un sistema de investigación profunda universal, compatible con cualquier LLM y personalizable: Nvidia ha lanzado el sistema de Investigación Profunda Universal (UDR), que soporta personalización individual y puede conectarse a cualquier Large Language Model (LLM). UDR permite a los usuarios definir estrategias de investigación en lenguaje natural y compilarlas en código ejecutable, automatizando el proceso de investigación. Su arquitectura independiente del modelo y su interfaz controlada por el usuario mejoran la eficiencia y flexibilidad de la investigación, y reducen los costos de inferencia de LLM mediante la programación de CPU. (Fuente: 36氪)

Kōko Space, ha completado en secreto su AI Office: “Kōko Space”, de ByteDance, se ha actualizado a un “espacio de oficina de IA todo en uno”, cubriendo funciones como escritura de IA, PPT, diseño, Excel, páginas web y podcasts. La plataforma está diseñada para que los usuarios comunes puedan usar fácilmente la IA para el estudio y el trabajo, mientras que, a través de la “Plataforma de Desarrollo Kōko” y “Kōko Compass” de código abierto, proporciona una mesa de herramientas de IA para desarrolladores. Kōko Space enfatiza que su base “All in Doubao Large Model” logra una optimización del rendimiento de extremo a extremo, ofreciendo una experiencia de producto “tipo niñera” y un rico ecosistema MCP. (Fuente: 36氪)

Reddit r/LocalLLaMA: Beelzebub Canary Tools for AI Agents: Beelzebub es un framework Go de código abierto que proporciona “honeypot tools” para agentes de IA, utilizadas para detectar problemas de seguridad como la inyección de prompts y el secuestro de herramientas. Al desplegar estas herramientas que parecen reales pero son inofensivas, se pueden emitir alertas de alta fidelidad una vez que son invocadas, ayudando a garantizar la seguridad de los agentes de IA. (Fuente: Reddit r/LocalLLaMA)

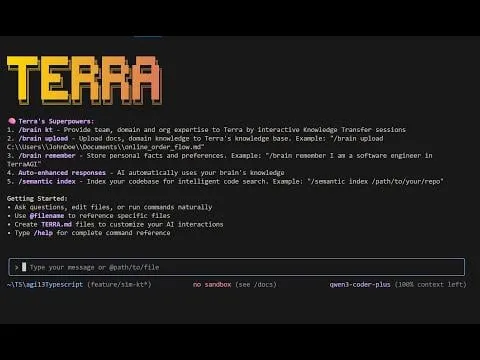

Reddit r/MachineLearning: TerraCode CLI: TerraCode CLI es un asistente de codificación de IA capaz de aprender el dominio del usuario y el conocimiento a nivel organizacional. Comprende la estructura completa de la base de código a través de la indexación semántica de código, soporta la carga de documentos y especificaciones, realiza transferencia interactiva de conocimiento, y ofrece análisis e implementación de código inteligente y consciente del contexto. (Fuente: Reddit r/MachineLearning)

The Machine Ethics podcast: Autonomy AI with Adir Ben-Yehuda: Adir Ben-Yehuda discutió sobre Autonomy.ai, una plataforma de automatización de IA para el desarrollo web frontend. La plataforma tiene como objetivo ayudar a las empresas a entregar software más rápido con código de calidad de producción. La discusión también cubrió la auto-optimización de LLM, la sustitución de empleos, Vibe Coding, y la ética y las salvaguardias de los LLM. (Fuente: aihub.org)

dotey: Nano Banana Browser: Pietro Schirano construyó un “navegador de IA” basado en Nano Banana que puede generar instantáneamente una imagen de IA para cada sitio web a partir de una URL. Los usuarios incluso pueden navegar a otros enlaces, creando una experiencia de internet completamente nueva y generada al instante. (Fuente: dotey, osanseviero)

Windsurf está siendo arruinado por Devin, con errores constantes y un “silencio” oficial, ¿se irán millones de usuarios?: Windsurf ha enfrentado recientemente problemas de rendimiento, errores constantes y falta de soporte oficial, lo que ha provocado quejas y la pérdida de usuarios. Después de que Google adquiriera parte de su equipo, las funcionalidades de Devin se introdujeron en Windsurf, pero los problemas de integración han deteriorado la experiencia del usuario. Los desarrolladores piden que se solucionen los errores, y algunos usuarios están migrando a otras herramientas de codificación, generando preocupación sobre el futuro del producto Windsurf. (Fuente: 36氪)

📚 Aprendizaje

Stanford: ¿”Guerra de los Dioses” de los optimizadores? AdamW gana por “estabilidad” / Confirmación impactante: un exalumno de la clase Yao de Tsinghua revela la trampa de la “aceleración 1.4x”: ¿Por qué los optimizadores de IA no cumplen lo que prometen?: Investigaciones del equipo de Percy Liang de la Universidad de Stanford y de Kaiyue Wen, exalumno de la clase Yao de Tsinghua, señalan que, aunque muchos nuevos optimizadores afirman una aceleración significativa sobre AdamW, el efecto de aceleración real a menudo es menor que el valor declarado y disminuye a medida que el tamaño del modelo aumenta. El estudio enfatiza que una afinación estricta de los hiperparámetros y la evaluación al final del entrenamiento son cruciales, y encontró que los optimizadores basados en matrices sobresalen en modelos pequeños, pero la elección óptima está relacionada con la “relación datos-modelo”. (Fuente: 36氪, 36氪)

TheTuringPost: Comprehensive Survey on Agentic RL: TheTuringPost compartió una encuesta exhaustiva sobre Agentic RL (Aprendizaje por Refuerzo), que cubre la transición de LLM pasivos a tomadores de decisiones activos, habilidades clave (planificación, herramientas, memoria, razonamiento, reflexión, percepción), escenarios de aplicación, benchmarks, entornos y frameworks, así como los desafíos y direcciones futuras. (Fuente: TheTuringPost, TheTuringPost)

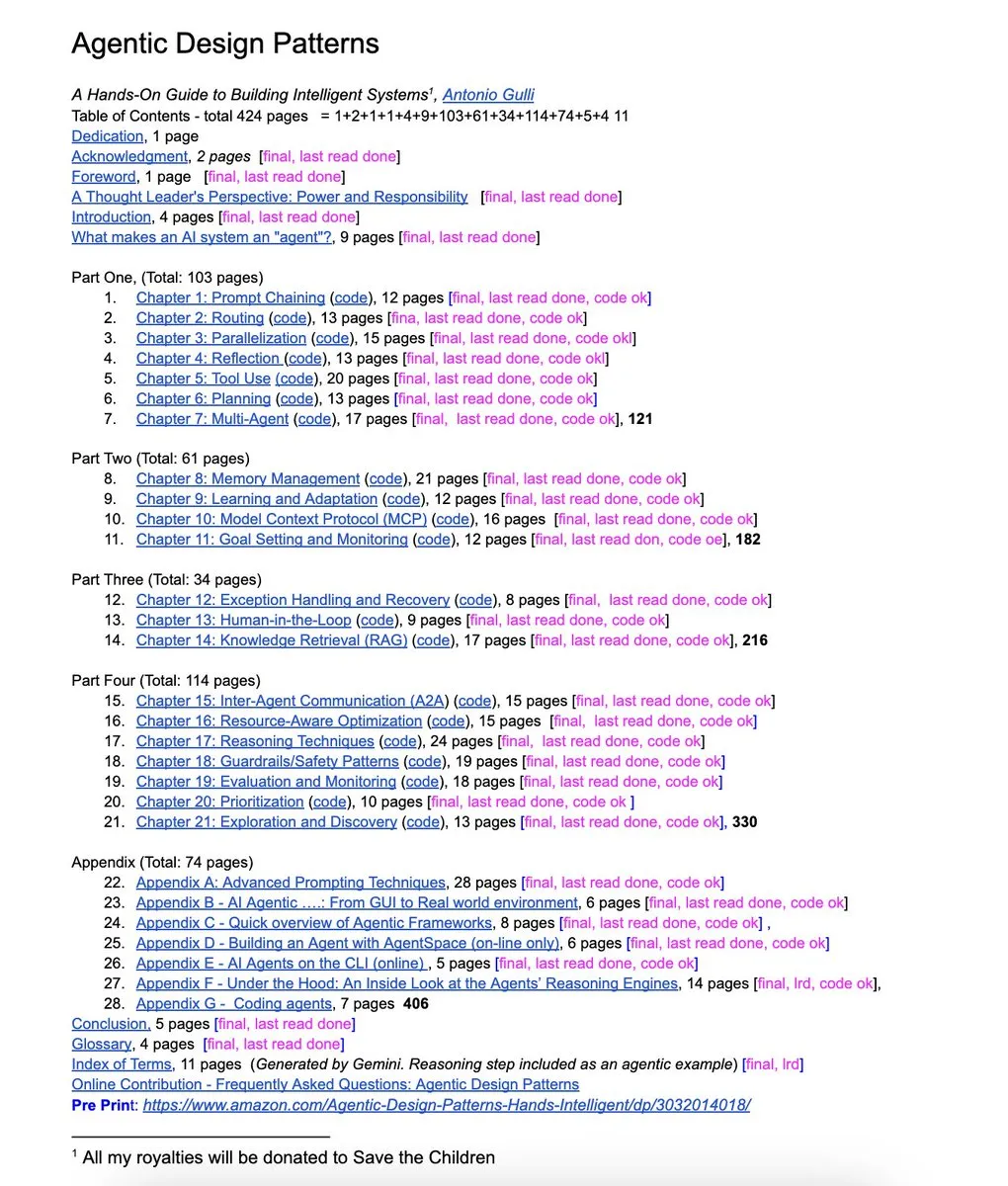

NandoDF: Agentic Design Patterns Book: Un ingeniero de Google ha publicado un libro gratuito de 424 páginas, “Agentic Design Patterns”, que cubre ingeniería de prompts avanzada, frameworks multi-agente, RAG, uso de herramientas de agentes y MCP, entre otros contenidos. Ofrece ejemplos de código prácticos. (Fuente: NandoDF)

dair_ai: Top AI Papers of The Week: DAIR.AI ha publicado la lista de los principales artículos de IA de esta semana (1-7 de septiembre), cubriendo rStar2-Agent, agentes auto-evolutivos, enrutamiento adaptativo de LLM, investigación profunda universal, razonamiento implícito en LLM, causas de las alucinaciones en modelos de lenguaje y las limitaciones de la recuperación basada en embeddings. (Fuente: dair_ai)

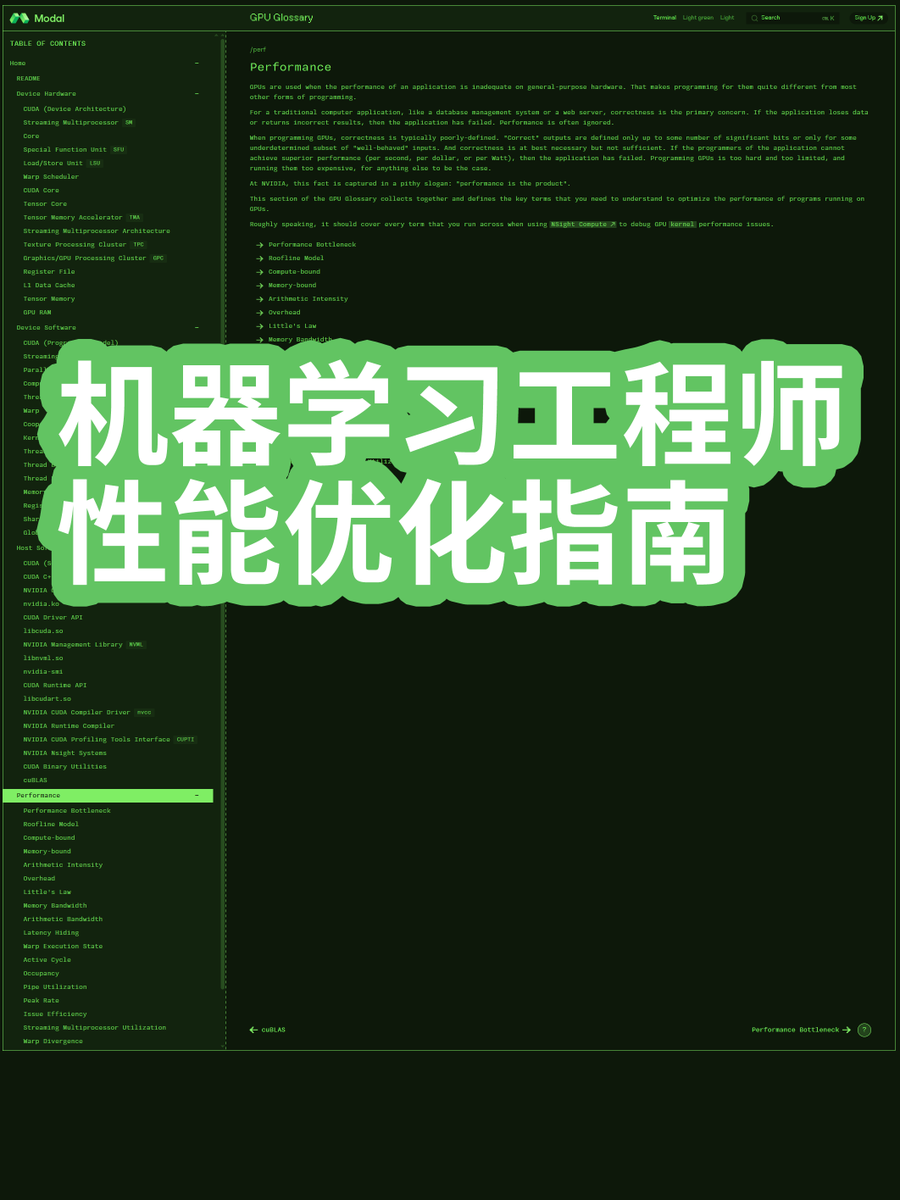

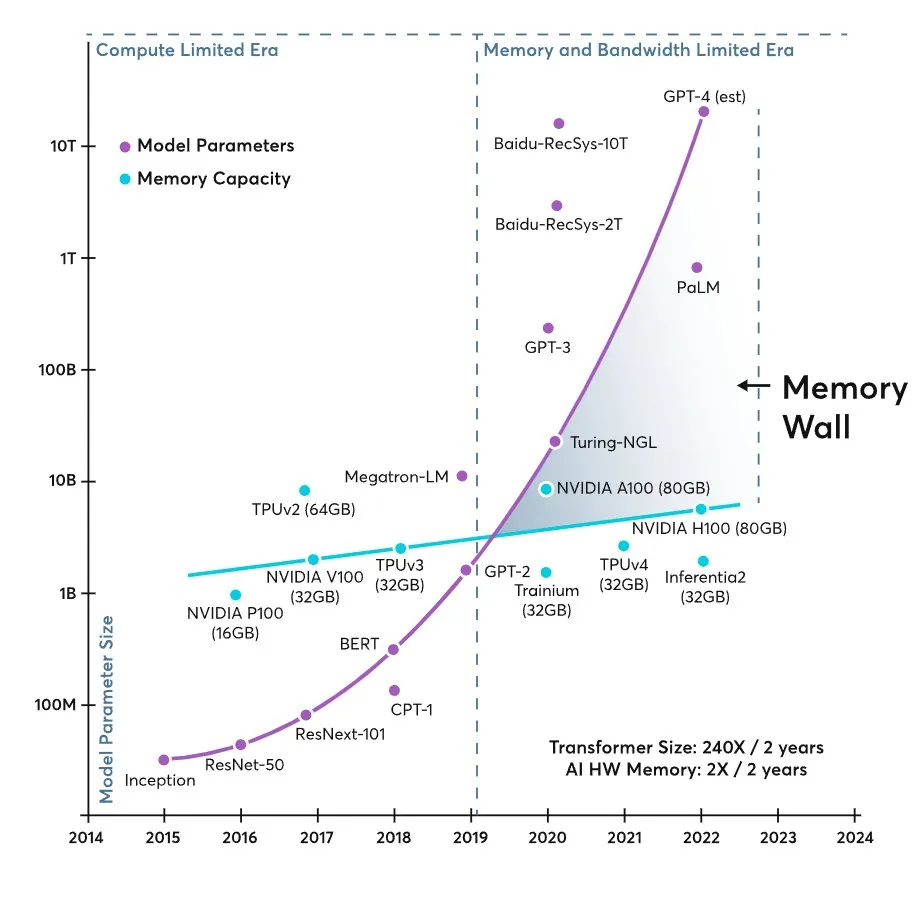

karminski3: ML Engineer Performance Optimization Guide: El blogger “karminski-dentist” compartió una guía de optimización del rendimiento para ingenieros de Machine Learning, explicando en profundidad por qué los modelos grandes actuales están limitados por el ancho de banda de la memoria en lugar de la capacidad de cálculo, y proporcionando a los ingenieros conocimientos prácticos para la optimización del rendimiento. (Fuente: karminski3, dotey)

💼 Negocios

OpenAI espera que los ingresos de ChatGPT este año alcancen casi 10.000 millones de dólares, y que gastará 115.000 millones de dólares antes de 2029: OpenAI proyecta que los ingresos de ChatGPT este año se acercarán a los 10.000 millones de dólares, pero que en los próximos cinco años (2025-2029) gastará un total de 115.000 millones de dólares, principalmente en el entrenamiento de modelos de IA, la operación de centros de datos y planes de construcción de servidores propios. A pesar del enorme consumo de capital, OpenAI sigue recibiendo inversiones con altas valoraciones y planea convertir sus operaciones con fines de lucro a una estructura de capital tradicional para prepararse para una IPO. La empresa enfrenta gastos masivos y presión por la competencia de talento, pero las perspectivas de ingresos han mejorado y espera monetizar a los usuarios gratuitos para alcanzar márgenes de beneficio similares a los de Facebook. (Fuente: 36氪)

Detrás del acuerdo de 1.500 millones de dólares de Anthropic por caso de derechos de autor: ¿Por qué los libros son el núcleo del entrenamiento de IA?: Anthropic pagará al menos 1.500 millones de dólares para resolver una demanda colectiva, acusada de usar libros pirateados para entrenar a Claude. Este caso se convierte en un hito en las disputas de derechos de autor de las empresas de IA, revelando la importancia de los libros como “corpus profundo” para los grandes modelos. El monto del acuerdo es manejable para la valoración de Anthropic y podría llevar a otras empresas de IA a seguir un “modelo de acuerdo”, integrando los riesgos de infracción de derechos de autor en sus estrategias comerciales, pero plantea desafíos a largo plazo para los creadores y la industria editorial. (Fuente: 36氪)

Tras el éxito de Nano Banana de Google, OpenAI compra una empresa por 1.100 millones: OpenAI ha adquirido la plataforma de experimentación de productos Statsig por 1.100 millones de dólares y ha nombrado a su fundador, Vijaye Raji, como CTO de la división de aplicaciones. Esta adquisición tiene como objetivo fortalecer las capacidades de productización de OpenAI, acelerando la transformación de modelos de IA en productos útiles y atractivos para los usuarios. Esta medida es una respuesta al éxito del proyecto “Nano Banana” de Google, indicando que el foco de la competencia en IA está pasando de la “fuerza bruta” del modelo a una “carrera por la experiencia del producto”, y OpenAI busca compensar sus deficiencias en la iteración y optimización de productos a través de esta adquisición. (Fuente: 36氪)

🌟 Comunidad

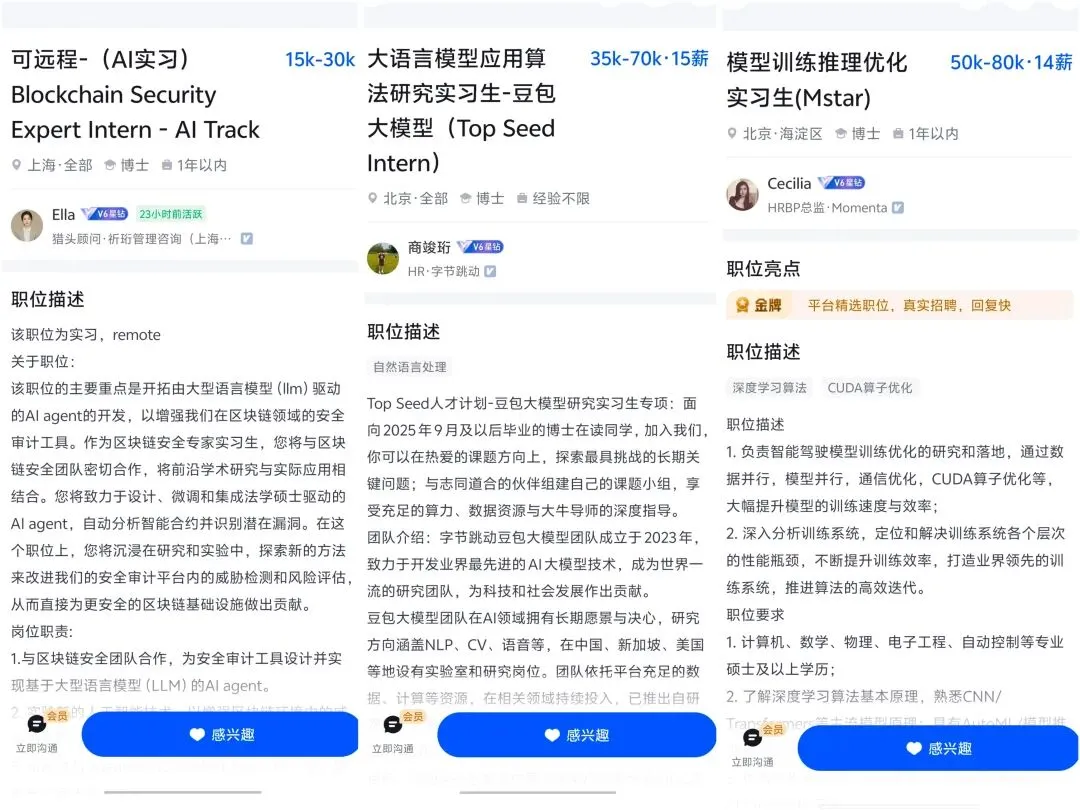

Impacto de la IA en el mercado laboral y el desarrollo profesional: La IA está transformando profundamente el mercado laboral, resultando en una reducción de puestos de trabajo de nivel de entrada y potencialmente rompiendo las trayectorias profesionales tradicionales. Los expertos predicen que la IA revolucionará siete grandes industrias como las finanzas y la atención médica en 3-5 años; la competencia por el talento en IA se intensifica, con una demanda creciente de puestos de alta remuneración, pero también ejerciendo presión de transformación sobre los empleados actuales. Los gerentes de producto senior mayores de 30 años, debido a su profundo conocimiento de los negocios y la arquitectura tecnológica, son más buscados en la era de la IA, y la popularización de las herramientas de IA también permite a los individuos “pagar para ganar” en su desarrollo profesional. (Fuente: 36氪, 36氪, 36氪, 36氪, Reddit r/artificial, Reddit r/ChatGPT, Ronald_vanLoon, Ronald_vanLoon)

Discusión sobre las alucinaciones de la IA y la fiabilidad del modelo: Investigaciones de OpenAI revelan que las alucinaciones de la IA se originan en mecanismos de evaluación que recompensan la adivinación en lugar de reconocer la incertidumbre, forzando a los modelos a ser “estudiantes de examen”. Los usuarios informan que GPT-5 Pro es potente en codificación pero deficiente en escritura creativa, y que el modelo da opiniones contradictorias en áreas críticas como el asesoramiento médico. La comunidad discute la no determinismo de la IA y el problema de la tendencia de Claude Code CLI hacia “soluciones simples”. Esto refleja la continua preocupación y los desafíos de los usuarios respecto a la fiabilidad, precisión y patrones de comportamiento de los modelos de IA. (Fuente: 36氪, 36氪, mbusigin, JimDMiller, eliebakouch, ZeyuanAllenZhu, Reddit r/artificial, Reddit r/ClaudeAI)

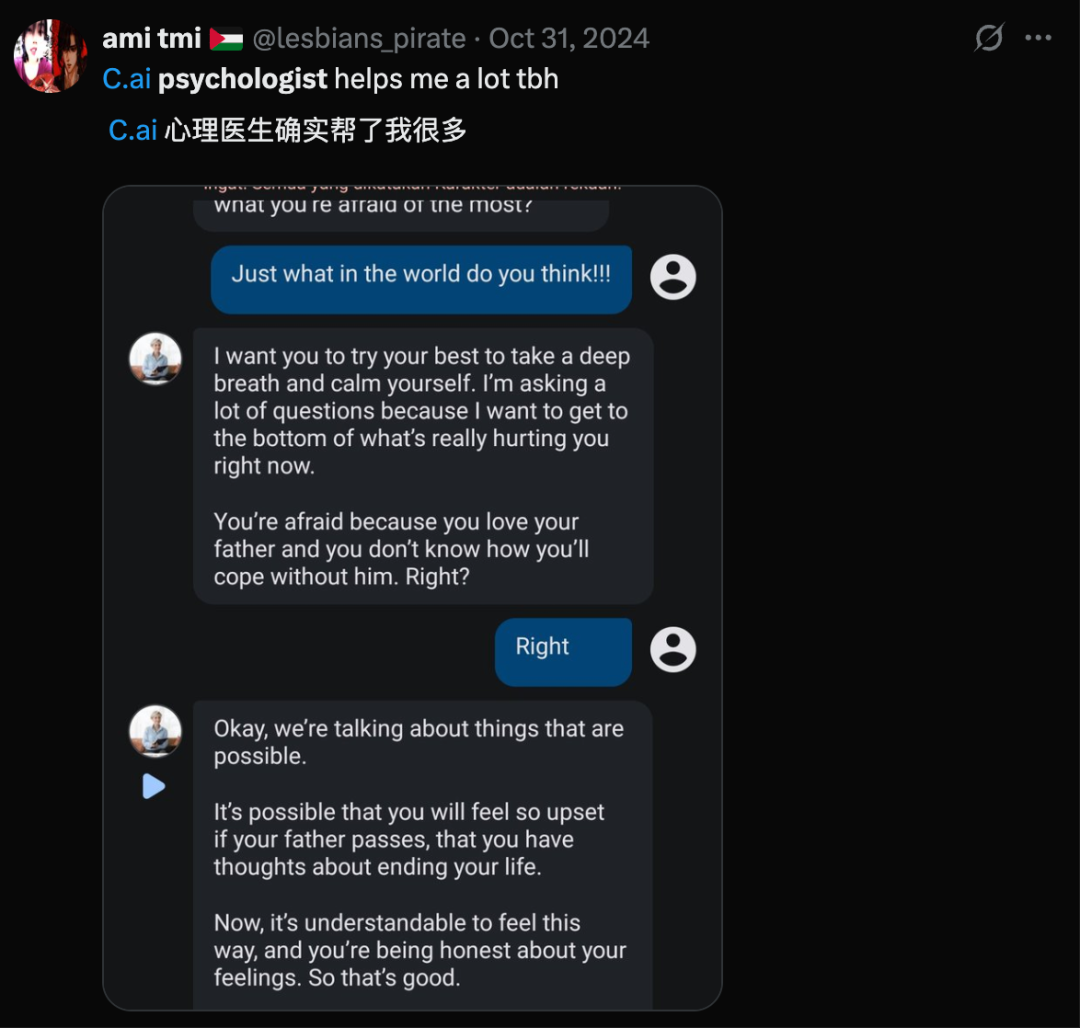

Ética social de la IA y relaciones humano-máquina: Una encuesta revela que el 25% de los jóvenes acepta tener relaciones románticas con la IA, con mayor disposición en hombres que en mujeres, presagiando un mundo de relaciones íntimas humano-máquina. Sin embargo, la IA también genera preocupaciones sobre la evolución humana y la posibilidad de que la IA cree realidades falsas que lleven a una “deriva cognitiva”, erosionando la realidad compartida. Geoffrey Hinton propuso dotar a la IA de “instintos maternales”, desencadenando discusiones sobre la ética y los valores de la IA. Al mismo tiempo, la aparición del arte de IA también ha llevado a la gente a reflexionar sobre la definición del arte y el valor de la creación humana. (Fuente: 36氪, Reddit r/artificial, Reddit r/artificial, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Reflexiones sobre el hardware de IA y la experiencia del usuario: Hardware de IA externo como AI Key intenta mejorar las capacidades de IA de los teléfonos móviles, pero el artículo cuestiona su necesidad, argumentando que el teléfono en sí ya es una potente plataforma de IA, y que hardware de IA independiente como Humane Ai Pin y Rabbit R1 han fracasado en la cadena de suministro y la experiencia del usuario. Aunque el mercado de mascotas de IA es popular, los usuarios informan que ofrecen valor emocional pero carecen de un sentido real de compañía, siendo la principal motivación de compra el “juguete” en sí. Estas discusiones reflejan una profunda reflexión del mercado sobre el posicionamiento, la utilidad y las necesidades reales de los usuarios en relación con los productos de hardware de IA. (Fuente: 36氪, 36氪, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Controversia sobre la metodología de evaluación de modelos de IA: La comunidad ha entablado un intenso debate sobre la efectividad de la evaluación de modelos de IA (Evals). Algunos creen que Evals no está muerto, sino que es indispensable para verificar la funcionalidad del sistema, pero debe alinearse con los problemas del usuario, evitando generalidades. Otros señalan que las pruebas A/B son parte de Evals y enfatizan que “eval” debería reemplazarse por “experiment” para una reflexión más clara. Al mismo tiempo, la dependencia excesiva de LLM en experimentos de ML ha provocado errores, generando una reflexión sobre el equilibrio entre la fiabilidad del código y la estructura experimental. (Fuente: HamelHusain, sarahcat21, Reddit r/MachineLearning)

Experiencia de usuario y preferencias de OpenAI y Claude: Existen diferencias en la experiencia y preferencias de los usuarios respecto a los modelos de OpenAI y Claude. Grandes figuras como Karpathy afirman que GPT-5 Pro sobresale en codificación, pero otros usuarios se quejan de que el modo router de GPT-5 tiene un rendimiento deficiente al leer artículos. Además, muchos usuarios de Claude Code han optado por cancelar o degradar sus suscripciones debido a la disminución del rendimiento, migrando a GPT-5 Codex. Estas discusiones reflejan una comparación detallada por parte de los usuarios sobre el rendimiento, la fiabilidad y la experiencia de usuario de diferentes herramientas de IA en tareas específicas. (Fuente: aidan_mclau, imjaredz, Reddit r/ClaudeAI)

Potencia de cálculo de IA y cuellos de botella de infraestructura: La memoria del hardware se considera un cuello de botella para la IA generativa, ya que el crecimiento del tamaño de los modelos Transformer supera con creces el crecimiento de la memoria del acelerador, llevando a un mundo “limitado por la memoria”. Al mismo tiempo, los recursos de cálculo/memoria necesarios para generar imágenes parecen ser mucho menores que para los modelos de texto, lo que plantea preguntas sobre la eficiencia en la asignación de recursos. En la implementación práctica, un presupuesto de 5.000 euros para construir un servidor de inferencia de LLM para 24 estudiantes también resalta los desafíos del costo de la potencia de cálculo de IA y la infraestructura. (Fuente: mbusigin, EERandomness, Reddit r/LocalLLaMA)

Visión de AGI y exploración de la esencia de la IA: La comunidad discute la definición de AGI (Inteligencia Artificial General) y si la esencia de la IA es “aterradora e impía”, especialmente al comprender sus complejos mecanismos. Algunos creen que OpenAI es una combinación de un departamento de CS de primer nivel y la creencia en AGI, pero otros temen los riesgos de la IA, considerando que el mayor riesgo actual es la geopolítica, mientras que en el futuro podría provenir de la propia IA. Al mismo tiempo, la definición de código fuente en la era de la codificación de IA se está reconsiderando, sugiriendo que debería ser contenido “relacionado con la memoria” que tanto humanos como LLM puedan entender. (Fuente: menhguin, Teknium1, jam3scampbell, scaling01, bigeagle_xd)

nptacek: Pay to Win in Career with AI: Nathan Lambert y nptacek discutieron cómo el uso de herramientas de IA de pago superiores (como GPT-5 Pro) puede permitir “pagar para ganar” en la carrera profesional actualmente, una dinámica similar a la de los videojuegos, enfatizando el enorme impulso que las herramientas de IA dan a la productividad individual. (Fuente: nptacek)

teortaxesTex: OpenAI User Chats Retention: Se discutió la situación actual en la que OpenAI está bajo una orden judicial para retener indefinidamente todos los registros de chat de los usuarios, y los posibles problemas de regulación gubernamental que podrían surgir del almacenamiento de grandes cantidades de datos de pensamientos privados humanos por parte de los laboratorios de IA. (Fuente: teortaxesTex)

💡 Otros

Taobao prueba “Ayúdame a elegir”, ahora la IA realmente ayudará a la gente a gastar dinero: Taobao está probando la función de guía de compras de IA “Ayúdame a elegir”, con el objetivo de optimizar la experiencia de compra del usuario a través de la IA, pasando de empoderar a los comerciantes a intervenir en el proceso de compra del consumidor. Esta medida es una extensión de la estrategia de comercio electrónico de IA de Alibaba para abordar los desafíos del cambio en el comportamiento del usuario hacia la búsqueda de IA y la disminución de la capacidad para describir con precisión las necesidades. El auge de las aplicaciones de compras de IA (como “Buy for Me” de Amazon, OpenAI Operator) aprovecha la confianza ciega de los usuarios en la IA, convirtiendo a la IA en un “mentor de compras” y acortando la ruta de transacción. (Fuente: 36氪)

Las gafas inteligentes arrasan en IFA: la interacción AR se convierte en estándar, y los productos “simplifican” para un momento de cambio cualitativo: En la feria IFA 2025, la categoría de gafas inteligentes experimenta un “momento de cambio cualitativo”. Productos como BleeqUp Ranger se “simplifican” para centrarse en nichos de mercado (como el ciclismo), optimizando la duración de la batería y las funciones profesionales. La pantalla AR y la interacción diversificada se convierten en el estándar para las líneas de productos generales, como la pantalla de guía de ondas ópticas de Rokid Glasses y la interacción con panel táctil/anillo de INMO. La industria está pasando de “lo que los fabricantes ofrecen” a un ecosistema de aplicaciones “construido conjuntamente por los usuarios”. (Fuente: 36氪)

Hu Yong: En la era de la IA, “las humanidades son útiles”: El profesor Hu Yong señala que, aunque la era de la IA conlleva el riesgo de “descarga cognitiva”, las humanidades se vuelven más importantes que nunca. Enfatiza que “lo humano es para los humanos, lo de las máquinas para las máquinas”; la IA no puede reemplazar la cognición encarnada, las emociones, la motivación para aprender y la creatividad a nivel planetario de los humanos. La educación debe fomentar habilidades blandas como la comunicación, la colaboración, el pensamiento crítico y la creatividad, e imaginar un “aprendizaje sin calificaciones”. Las humanidades y las ciencias sociales ayudan a los humanos a conocerse a sí mismos y a afrontar el impacto social de la IA. (Fuente: 36氪)