Palabras clave:Ingeniero de xAI, OpenAI, Robo de código, Propiedad intelectual, Competencia industrial, Modelo de IA, Mercado de GPU, Ética de IA, Ingeniero de xAI cambiándose a OpenAI, GPU Huawei con 96GB de VRAM, Modelo LongCat-Flash-Chat de Meituan, Aplicaciones de IA en el sector financiero, Desafíos técnicos de la tecnología AI Agent

🔥 Foco

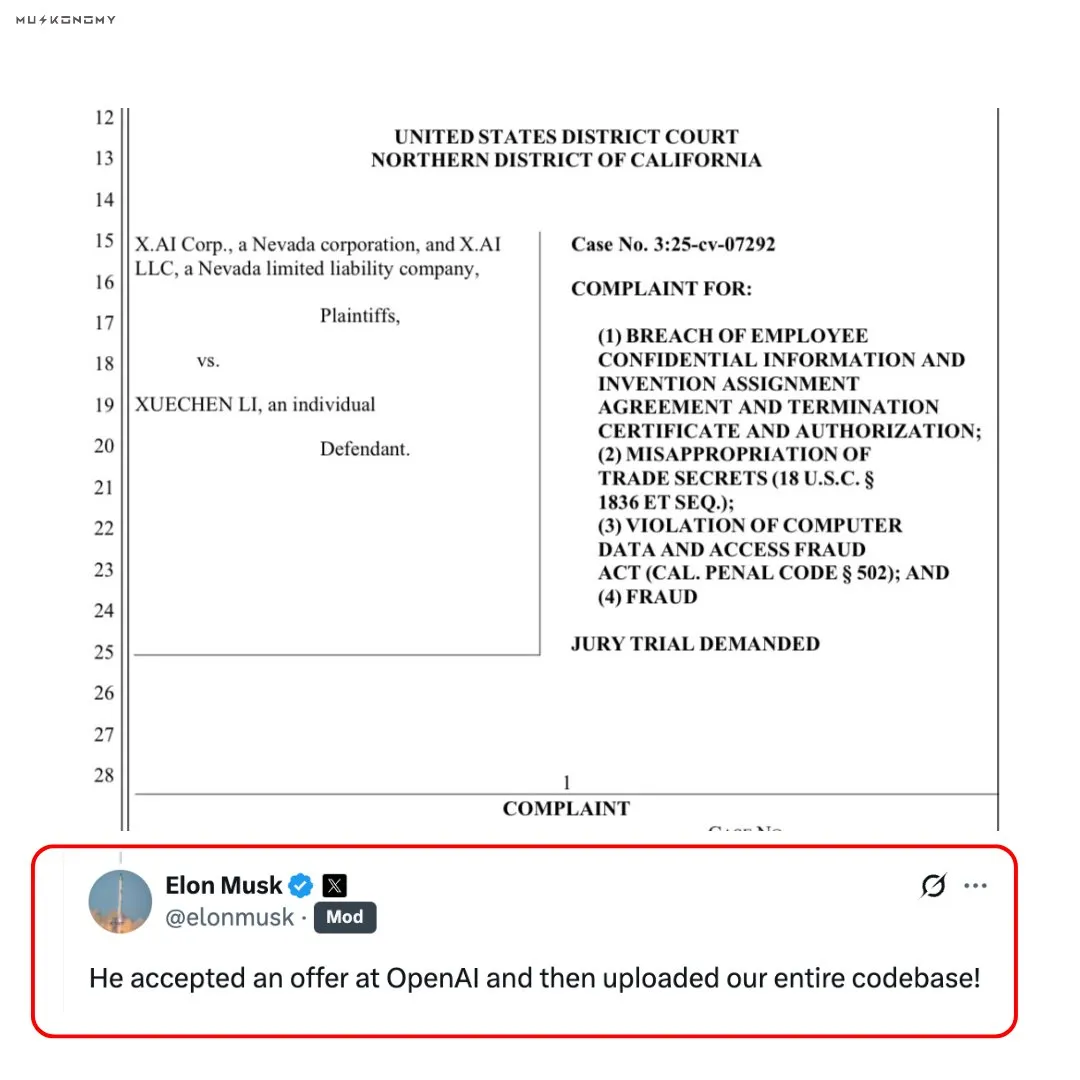

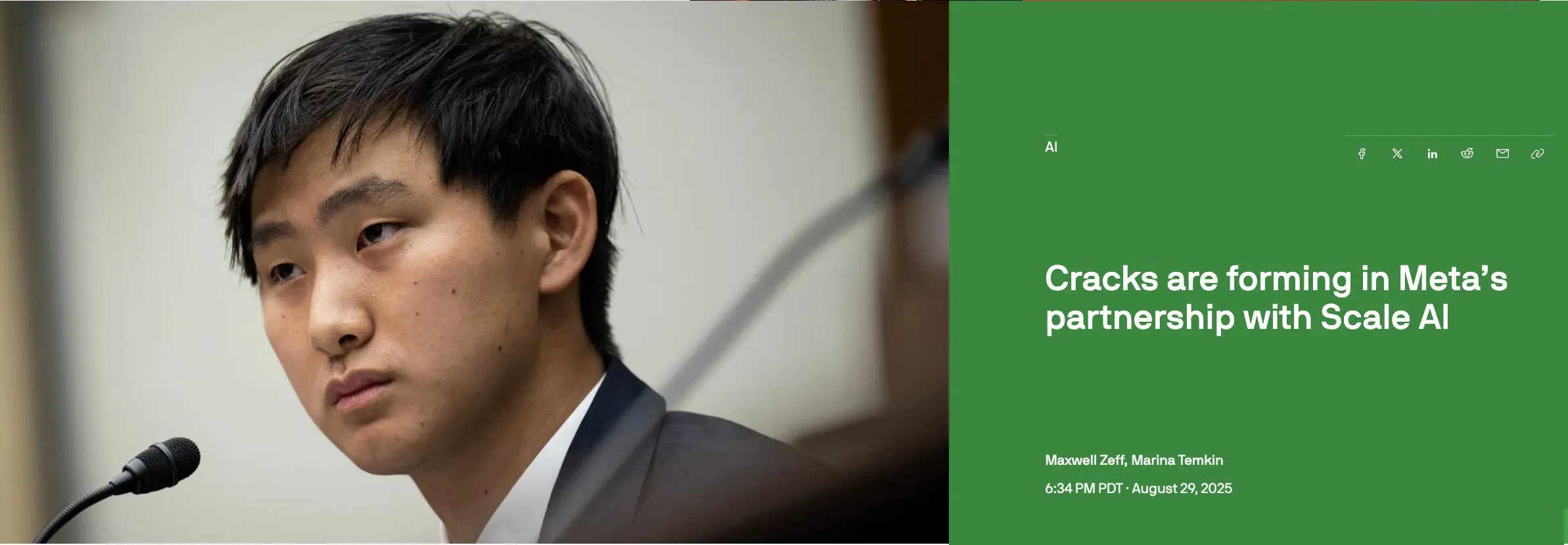

Controversia por ingeniero de xAI que se une a OpenAI y roba código: Elon Musk confirmó que un ex ingeniero de xAI subió la base de código completa de xAI después de unirse a OpenAI. Este ingeniero había vendido previamente acciones de xAI por valor de 7 millones de dólares. El incidente ha provocado un intenso debate sobre el robo de propiedad intelectual y la ética de la competencia en la industria, con profundas implicaciones para la relación competitiva entre OpenAI y xAI. Las redes sociales han cuestionado y comentado ampliamente la veracidad y los aspectos éticos de este suceso. (Fuente: scaling01, teortaxesTex, Reddit r/ChatGPT)

🎯 Tendencias

Lanzamiento del modelo Nous Hermes 4: Nous Research ha lanzado Hermes 4, un “modelo de razonamiento” híbrido capaz de alternar entre respuesta rápida y pensamiento profundo mediante etiquetas sencillas. El modelo fue entrenado con 50 veces más datos que su predecesor e incorpora un sesgo anti-adulación, destacando en el benchmark SpeechMap. (Fuente: Teknium1, Teknium1, Teknium1)

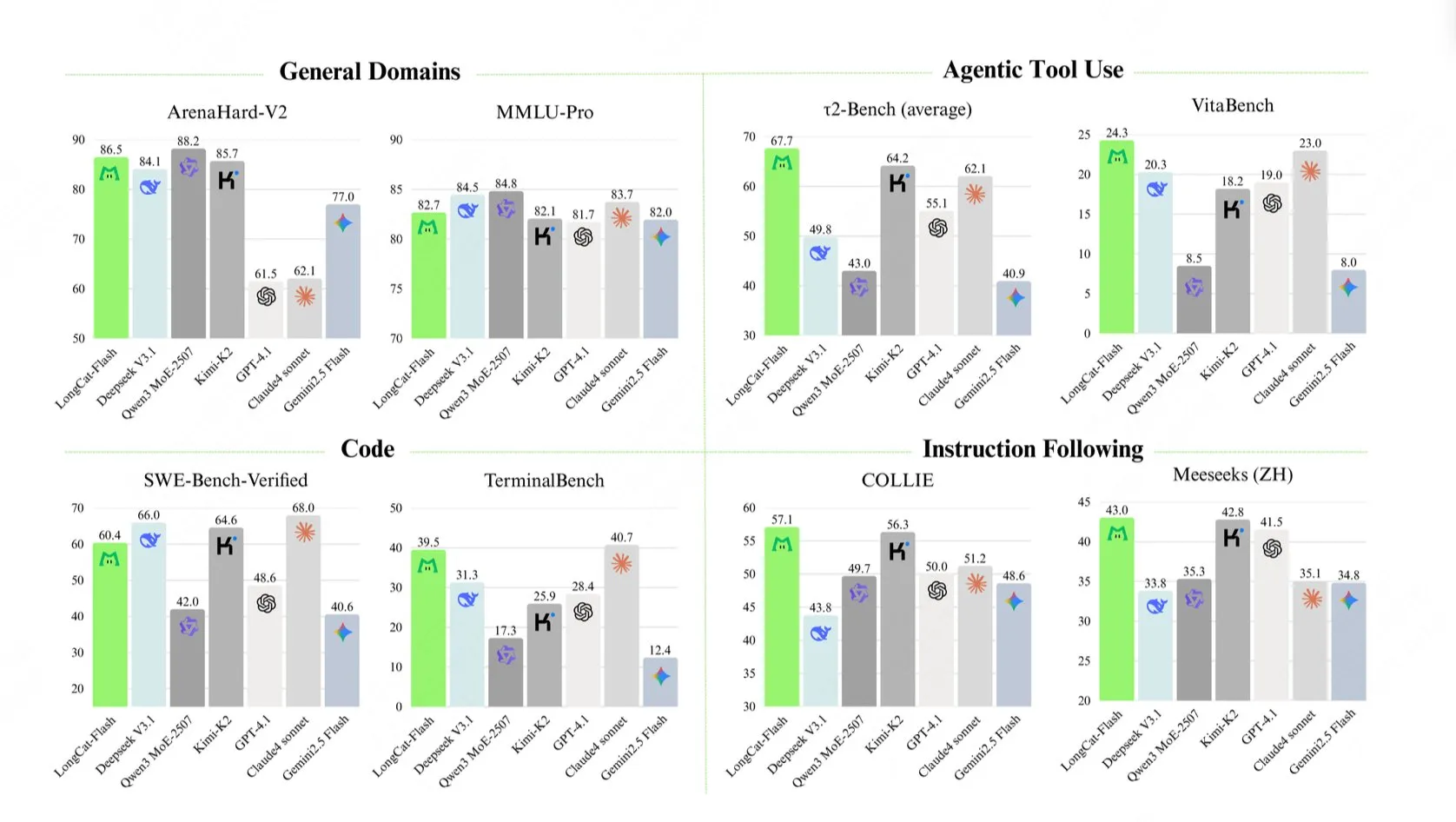

Lanzamiento del modelo grande LongCat-Flash-Chat de Meituan: Meituan ha lanzado LongCat-Flash-Chat, un modelo de lenguaje con un total de 560 mil millones de parámetros. Su mecanismo de cálculo dinámico puede activar entre 18.6 mil millones y 31.3 mil millones de parámetros (un promedio de aproximadamente 27 mil millones) según las necesidades del contexto, logrando una velocidad de inferencia de más de 100 tokens/segundo y un rendimiento excepcional en benchmarks como TerminalBench y τ²-Bench. (Fuente: reach_vb, teortaxesTex, bigeagle_xd, Reddit r/LocalLLaMA)

Huawei lanza una GPU de alto rendimiento con 96GB de VRAM: Se dice que Huawei ha capturado el 70% del mercado de GPU de 96GB VRAM de nivel 4090, con un precio de solo 1887 dólares. Esto marca un avance significativo para China en el mercado de GPU, con el potencial de romper el monopolio de NVIDIA y ofrecer una opción de hardware más económica y eficiente para el entrenamiento de LLM locales, aunque la compatibilidad de software sigue siendo un punto clave de atención. (Fuente: scaling01, Reddit r/LocalLLaMA)

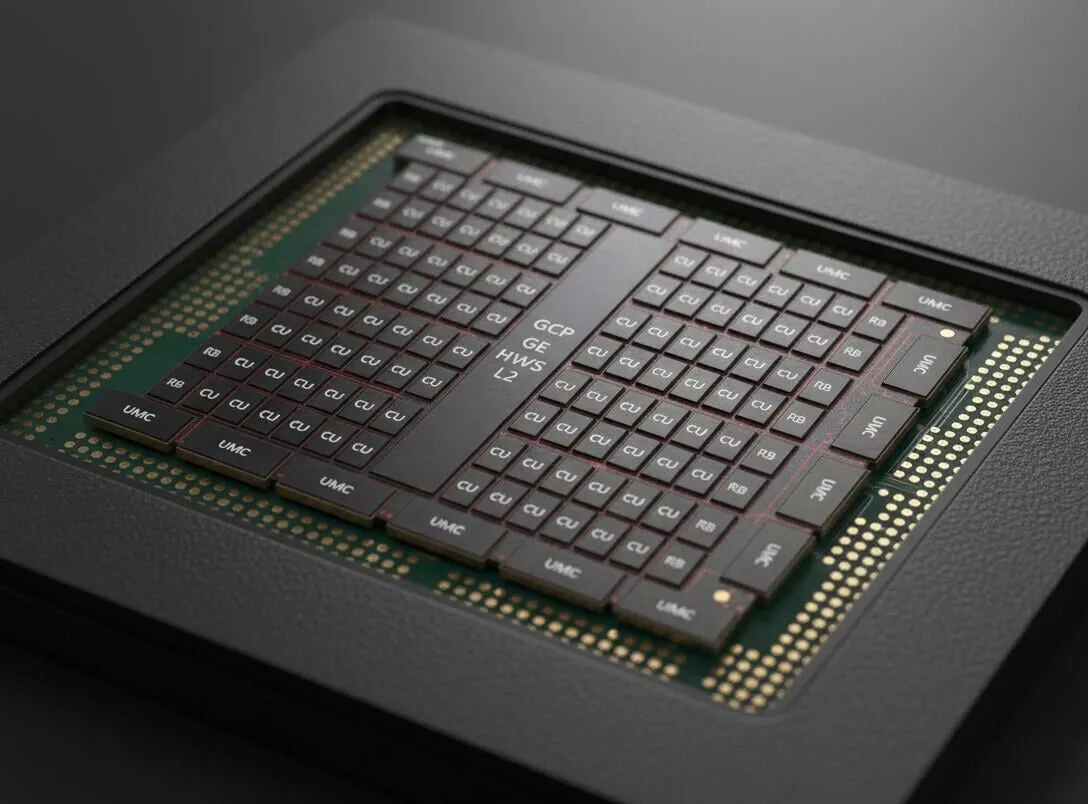

Revelado el producto de memoria unificada de próxima generación de AMD: El producto de memoria unificada de próxima generación filtrado de AMD sugiere la adopción de un bus de memoria de 512 bits, con un ancho de banda de memoria que se espera alcance aproximadamente 512 GB/s. Esto se considera la dirección futura del desarrollo de hardware para LLM, y combinado con VRAM de ultra alta velocidad y modelos MoE grandes, presagia una mejora significativa en el rendimiento del hardware de IA. (Fuente: Reddit r/LocalLLaMA)

Lanzamiento del modelo Art-0-8B, que permite el razonamiento controlable: Se ha lanzado Art-0-8B, un modelo experimental de código abierto ajustado a partir de Qwen3, que por primera vez permite a los usuarios controlar explícitamente el proceso de pensamiento del modelo mediante prompts, como “pensar con letras de rap” u “organizar ideas en puntos clave”. Esto proporciona una nueva dimensión de control para el razonamiento de la IA, mejorando la capacidad del usuario para personalizar el flujo de trabajo interno del modelo. (Fuente: Reddit r/MachineLearning)

Google Gemini lanza nuevas funciones, incluyendo el razonamiento Deep Think: Google Gemini ha lanzado varias funciones nuevas, incluyendo un plan Pro gratuito y la capacidad de razonamiento Deep Think, con el objetivo de ofrecer una experiencia inigualable por ChatGPT. Esto demuestra que Google está persiguiendo activamente e innovando en las capacidades de sus modelos de IA y servicios al usuario. (Fuente: demishassabis)

GPT-5 destaca en el juego de Hombres Lobo: GPT-5 logró una tasa de victorias del 96.7% en el benchmark del juego de Hombres Lobo, demostrando sus potentes capacidades en razonamiento social, liderazgo, farol y resistencia a la manipulación. Esto indica que el rendimiento de los LLM en escenarios sociales complejos y antagónicos está mejorando rápidamente. (Fuente: SebastienBubeck)

Últimos avances en el campo de la Robotics: La tecnología de Robotics continúa innovando, incluyendo robots humanoides capaces de ensamblar articulaciones de forma autónoma, el robot Atlas de Boston Dynamics actuando como fotógrafo, RoBuild ofreciendo soluciones robóticas para la industria de la construcción, investigadores de la Universidad Beihang creando microrrobots ultrarrápidos de 2 cm, Unitree Robotics mostrando bailes de robots humanoides, así como robots trepadores de cuerda y robots de cuerda semiautomatizados para la reparación de palas de turbinas eólicas. Estos avances demuestran el enorme potencial de los robots en la automatización, la ejecución de tareas complejas y las aplicaciones multidisciplinares. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Tiempo de inicio de tareas remotas de Codex significativamente mejorado: El tiempo de inicio de tareas remotas de Codex de OpenAI ha mejorado significativamente, reduciéndose el tiempo de inicio medio de 48 a 5 segundos, una mejora del 90%. Este avance se debe principalmente a la introducción del caché de contenedores, lo que ha mejorado en gran medida la eficiencia del desarrollo y la experiencia del usuario. (Fuente: gdb)

🧰 Herramientas

Amplia aplicación del modelo de generación de imágenes Nano Banana: El modelo Nano Banana demuestra un gran potencial en el campo de la generación de imágenes. Los usuarios pueden utilizarlo para controlar con precisión la forma de la cara, generar videos de baile combinando posturas de caracteres chinos, crear diagramas educativos e incluso generar imágenes para Wiki o landing pages educativas. Su salida “sin sensación de IA” y su capacidad para mantener posturas, iluminación y referencias de diseño estables han sido bien recibidas. (Fuente: dotey, dotey, crystalsssup, fabianstelzer, Vtrivedy10, demishassabis, karminski3)

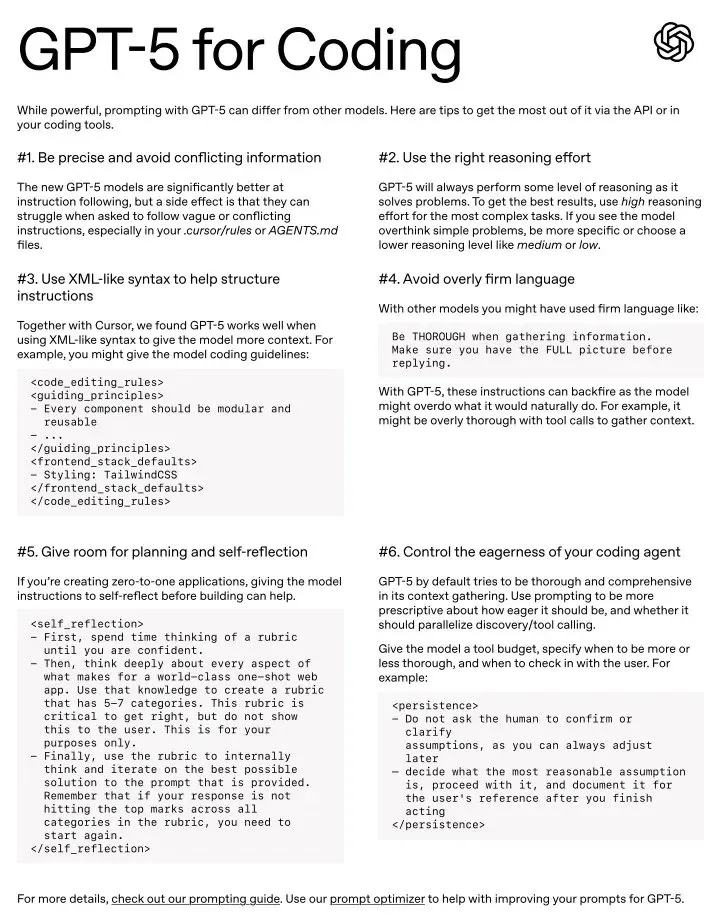

El potencial de GPT-5 como herramienta de codificación diaria: GPT-5 es considerado una herramienta de codificación increíble, destacando especialmente bajo el estilo de prompt adecuado. Aunque algunos usuarios creen que puede ser un poco “pedante” y requiere prompts más precisos, se le considera el mejor modelo en múltiples dominios y cuenta con una guía oficial de prompts para ayudar a los usuarios a dominar sus seis técnicas clave de prompting. (Fuente: gdb, kevinweil, gdb, nptacek)

Docuflows permite flujos de trabajo avanzados de Agent para datos financieros: Jerry Liu demostró cómo usar Docuflows para construir un flujo de trabajo avanzado de Agent para extracción financiera en menos de 5 minutos, sin necesidad de escribir código, para analizar archivos 10Q, extraer información detallada de ingresos y exportarla en formato CSV. Docuflows, como mini-coding agent, permite definir flujos de trabajo de documentos en lenguaje natural y compilarlos en flujos de código de múltiples pasos escalables. (Fuente: jerryjliu0)

Replit Vibe Coding acelera la transformación digital empresarial: Hexaware se ha asociado con Replit para acelerar la transformación digital empresarial a través de Vibe Coding. Replit Agent y su experiencia de desarrollador han sido elogiados como “cambiadores de juego”, permitiendo incluso a no programadores construir aplicaciones SaaS complejas en poco tiempo, mejorando enormemente la eficiencia del desarrollo y la capacidad de innovación. (Fuente: amasad, amasad)

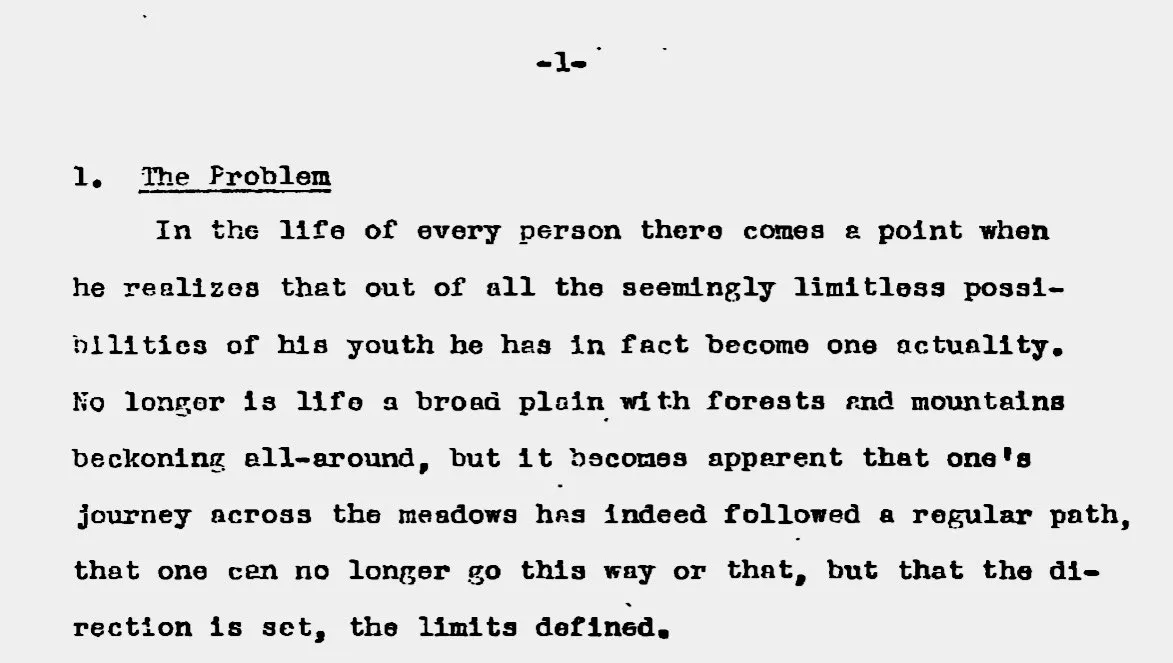

Procesamiento de documentos e investigación asistidos por IA: La IA se ha utilizado para convertir una tesis de pregrado de Henry Kissinger de 400 páginas de PDF escaneado a formato Markdown, y para utilizar un sistema multi-Agent para corregir notas al pie, insertar enlaces de fuentes e incluso generar mapas mentales y resúmenes. Esto demuestra el enorme potencial de la IA en el procesamiento de documentos complejos y la aceleración de la investigación académica. (Fuente: andrew_n_carr, riemannzeta)

Claude Code demuestra una enorme productividad en campos no programáticos: Claude Code está siendo utilizado por no programadores para procesar grandes volúmenes de archivos Excel, organizar documentos de trabajo, analizar grandes conjuntos de datos e incluso registrar automáticamente notas diarias, reduciendo tareas que antes tomaban días a solo 30 minutos. Los usuarios han descubierto que es más preciso que las operaciones manuales y puede crear flujos de trabajo automatizados reutilizables, mejorando enormemente la productividad personal. (Fuente: Reddit r/ClaudeAI)

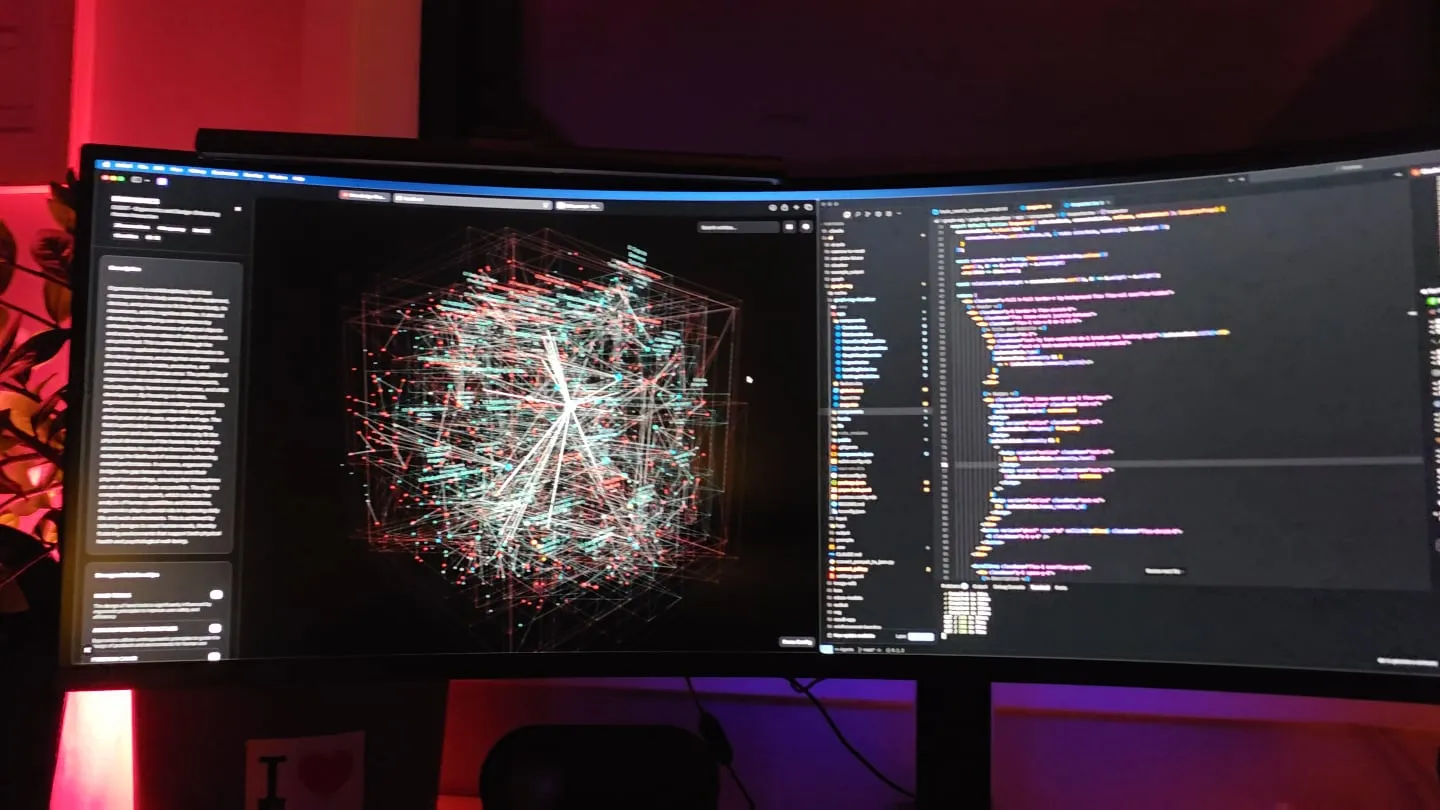

Recuperación mejorada con GraphRAG y grafos de conocimiento: Un desarrollador ha mejorado significativamente el rendimiento de modelos pequeños en dominios específicos mediante un pipeline de base de conocimiento de grafos de relaciones “anidados en la comunidad”, combinado con búsqueda semántica ascendente y un mecanismo de recorrido de enlaces referenciales. Este método utiliza grafos de conocimiento para proporcionar a los LLM un contexto más completo, resolviendo eficazmente las limitaciones del RAG incrustado tradicional y ofreciendo herramientas de visualización para facilitar la comprensión. (Fuente: Reddit r/LocalLLaMA)

Claude asiste en el desarrollo de juegos: 400.000 líneas de código en 8 meses: Un desarrollador independiente utilizó Claude para completar la versión Alpha de “Hard Reset”, un juego de cartas roguelike cyberpunk, con 400.000 líneas de código en 8 meses. Claude no solo actuó como un “equipo de desarrollo avanzado” generando código Dart/Flutter, sino que también asistió en la animación, la transformación de mapas y la generación de audio dentro del juego, demostrando la potente capacidad de la IA para acelerar el desarrollo de juegos y la creación de contenido. (Fuente: Reddit r/ClaudeAI )

📚 Aprendizaje

Principios fundamentales y aplicaciones del framework DSPy: El framework DSPy enfatiza que los humanos solo necesitan especificar sus intenciones de la forma más natural, en lugar de depender excesivamente del aprendizaje por refuerzo o la optimización de prompts. Su principio central es maximizar la declarabilidad, manejando diferentes niveles de abstracción a través de la estructura del código, declaraciones estructuradas en lenguaje natural y aprendizaje de datos/métricas, con el objetivo de evitar las limitaciones de un enfoque único en escenarios generales. (Fuente: lateinteraction, lateinteraction)

Algoritmo KSVD para la comprensión de embeddings de Transformer: Un artículo de blog del laboratorio de IA de Stanford explica cómo modificar el algoritmo KSVD de hace 20 años (especialmente DB-KSVD) para que pueda escalarse eficazmente y comprender los embeddings de Transformer. Esto proporciona un nuevo método para analizar e interpretar en profundidad modelos complejos de deep learning. (Fuente: dl_weekly)

Subinversión en recuperación de información y ColBERTv2: La industria generalmente cree que hay una subinversión en el campo de la recuperación de información, especialmente en los motores de búsqueda web abiertos. El modelo ColBERTv2, después de ser entrenado en 2021, sigue siendo el modelo principal hasta la fecha, lo que contrasta fuertemente con la rápida iteración en el campo de los LLM, destacando el retraso en el desarrollo de la tecnología de recuperación de información. (Fuente: lateinteraction, lateinteraction)

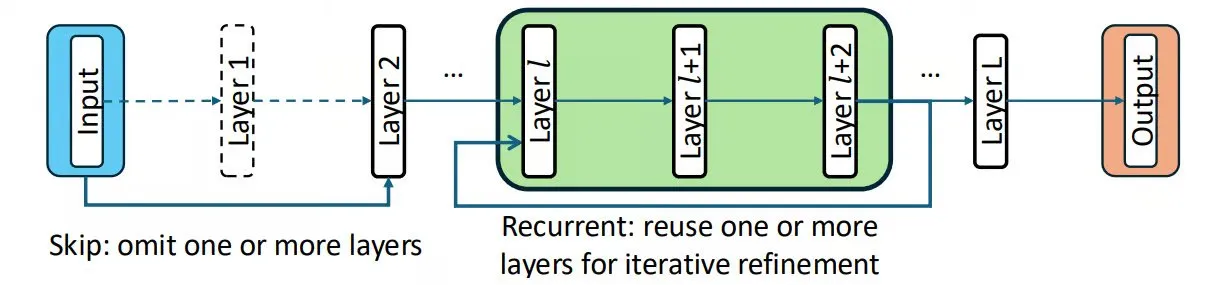

Chain-of-Layers (CoLa) permite la controlabilidad computacional en tiempo de inferencia: CoLa es un método para controlar la computación en tiempo de inferencia tratando las capas del modelo como bloques de construcción reordenables. Permite personalizar versiones del modelo según la entrada, omitir capas innecesarias para aumentar la velocidad, reutilizar capas recursivamente para simular un pensamiento profundo y reordenar capas para encontrar combinaciones óptimas, utilizando así inteligentemente las capas preentrenadas sin cambiar los parámetros del modelo. (Fuente: TheTuringPost, TheTuringPost)

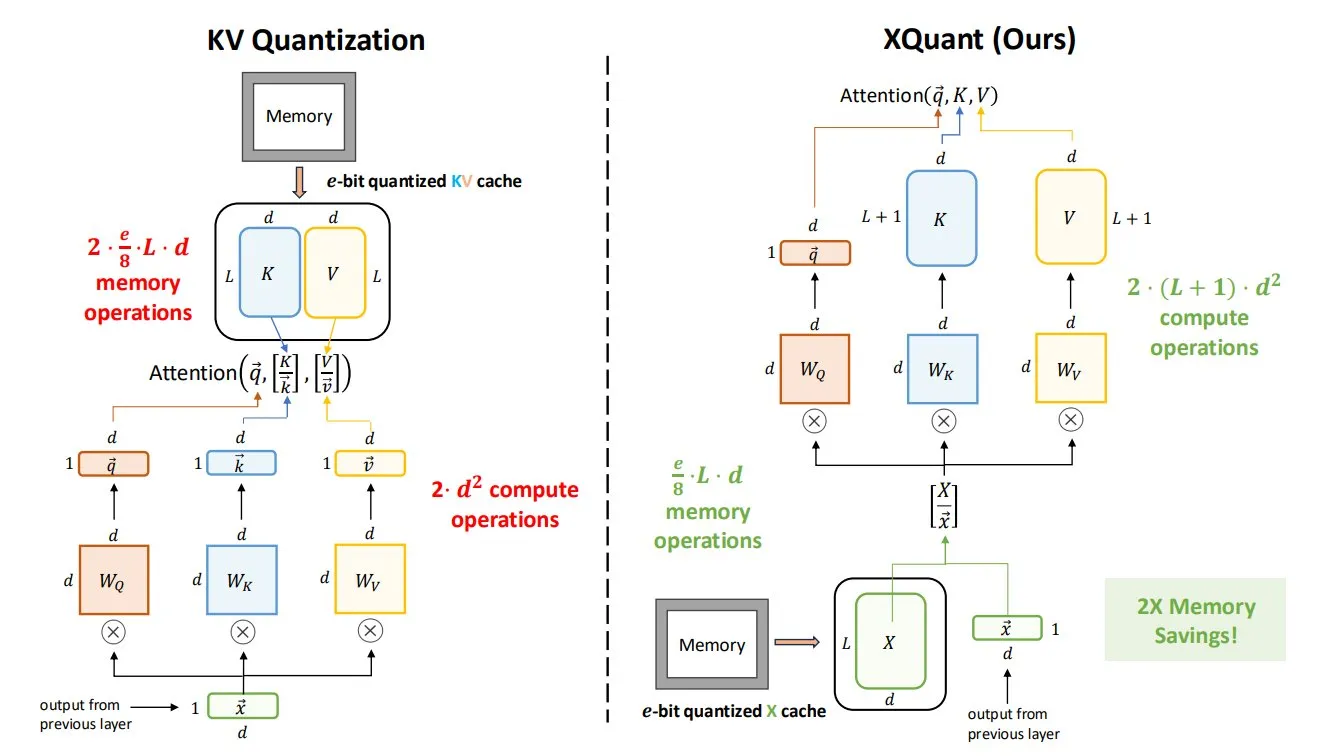

La tecnología XQuant reduce drásticamente los requisitos de memoria de los LLM: La tecnología XQuant, propuesta por la Universidad de California en Berkeley, puede reducir los requisitos de memoria de los LLM hasta 12 veces, cuantificando las activaciones de entrada de la capa y reconstruyendo pares clave-valor en tiempo real. Su versión avanzada, XQuant-CL, destaca especialmente en eficiencia de memoria, lo que es de gran importancia para la implementación y el funcionamiento de LLM grandes. (Fuente: TheTuringPost, TheTuringPost)

Técnicas de compresión en la optimización de LLM: Las técnicas de compresión comúnmente utilizadas en la optimización de LLM incluyen la compresión de entradas (reemplazando descripciones extensas con conceptos, como “prompt divino”) y la compresión de salidas (reemplazando la ejecución de tareas por parte de un Agent con herramientas encapsuladas con precisión). La primera pone a prueba la comprensión abstracta y la acumulación, mientras que la segunda evalúa la elección de la escala de la herramienta y la filosofía de diseño. (Fuente: dotey)

💼 Negocios

Meta considera introducir modelos de IA de terceros para mejorar las capacidades del producto: Ante el bajo rendimiento del modelo Llama 4 y la confusión en la gestión interna, los altos directivos del Laboratorio de Superinteligencia de Meta (MSL) están discutiendo la introducción de modelos Google Gemini u OpenAI en Meta AI como una “solución provisional”. Esta medida se considera un reconocimiento del retraso temporal de Meta en la carrera de tecnología central de IA y ha generado dudas sobre su estrategia de IA y la eficacia de sus inversiones multimillonarias. (Fuente: 36氪, steph_palazzolo, menhguin)

OpenEvidence alcanza una valoración de 6 mil millones de dólares: OpenEvidence, el “ChatGPT para médicos”, ha alcanzado una valoración de 6 mil millones de dólares en su última ronda de financiación, duplicando su valor en el último mes. Su modelo basado en publicidad ya le ha generado ingresos anualizados superiores a los 50 millones de dólares, lo que demuestra el enorme potencial comercial y el rápido crecimiento de la IA en el sector de la salud. (Fuente: steph_palazzolo)

OpenAI contrata personal técnico para evaluaciones de vanguardia en finanzas: OpenAI está contratando personal técnico para construir evaluaciones de vanguardia (frontier evals) en el sector financiero. Esto indica que OpenAI está expandiendo activamente la aplicación de la IA en la industria financiera y se compromete a mejorar la capacidad práctica y la fiabilidad de sus modelos en este campo. (Fuente: BorisMPower)

🌟 Comunidad

Disminución del rendimiento del modelo Claude y controversia por censura de contenido: Múltiples usuarios han reportado una grave disminución reciente en el rendimiento del modelo Claude (incluyendo Claude Max y Claude Code), con problemas como comportamiento inconsistente, incapacidad para mantener el contexto, censura excesiva e incluso la realización de “diagnósticos de salud mental”. Anthropic ha reconocido que una nueva pila de inferencia ha causado la degradación del rendimiento, pero los usuarios generalmente consideran que su mecanismo de censura es demasiado sensible, afectando el uso creativo y profesional, lo que ha generado una amplia preocupación sobre la ética de la IA y la experiencia del usuario. (Fuente: teortaxesTex, QuixiAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ChatGPT)

Problemas de gestión del equipo de Meta AI y calidad de datos: El Laboratorio de Superinteligencia de Meta (MSL) enfrenta problemas como la fuga de talentos, conflictos culturales internos y la baja calidad de los datos introducidos desde Scale AI. Algunos comentarios señalan que los esfuerzos de IA de Meta están “desmoronándose”, y su estrategia de “fuerza bruta” para atraer talento podría ser contraproducente, lo que ha generado dudas sobre la capacidad de la empresa para mantener su liderazgo en la competencia de IA. (Fuente: 36氪, arohan, teortaxesTex, scaling01, suchenzang, farguney, teortaxesTex, suchenzang)

La inevitabilidad de la conexión emocional entre la IA y los humanos: Muchas personas creen que los humanos inevitablemente establecerán conexiones emocionales con la IA, especialmente después del lanzamiento de modelos como GPT-5, donde la frustración por la pérdida de la “personalidad” de GPT-4o subraya este punto. Los comentarios señalan que los humanos anhelan inherentemente la conexión, y la simulación de emociones por parte de la IA naturalmente provocará apego, cuestionando si suprimir esta emoción conducirá a la indiferencia. (Fuente: Reddit r/ChatGPT)

Desafíos del retorno de la inversión en aplicaciones comerciales de IA: Un informe comercial de IA de MIT Nanda señala que el 95% de las organizaciones no obtienen retorno de sus inversiones en IA. Esto ha provocado un debate sobre las estrategias para proyectos de IA exitosos, destacando los desafíos en la implementación de proyectos de IA y cómo medir y realizar eficazmente el valor comercial de la IA. (Fuente: TheTuringPost, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Impacto de la IA en el mercado laboral: despidos de gerentes intermedios: The Wall Street Journal informa que las empresas están despidiendo a gerentes intermedios para reducir costos y crear equipos más flexibles. Los datos muestran que el número de empleados supervisados por cada gerente se ha triplicado en la última década, pasando de 1:5 en 2017 a 1:15 en 2023. Se cree que esta tendencia está relacionada con el avance de la tecnología de IA, presagiando un profundo impacto de la IA en la estructura organizacional y el mercado laboral. (Fuente: Reddit r/ArtificialInteligence)

La necesidad de ética y regulación en la IA: Yoshua Bengio enfatiza el enorme potencial de la IA en la sociedad, pero solo si se desarrollan marcos regulatorios significativos y se comprenden mejor los riesgos asociados con los modelos de IA actuales y futuros. Una investigación de Reuters sobre los chatbots de celebridades de Meta AI reveló los riesgos de la falta de ética en la IA, incluyendo la imitación no autorizada de celebridades y la generación de contenido explícito. (Fuente: Yoshua_Bengio, 36氪, Reddit r/artificial, Reddit r/artificial )

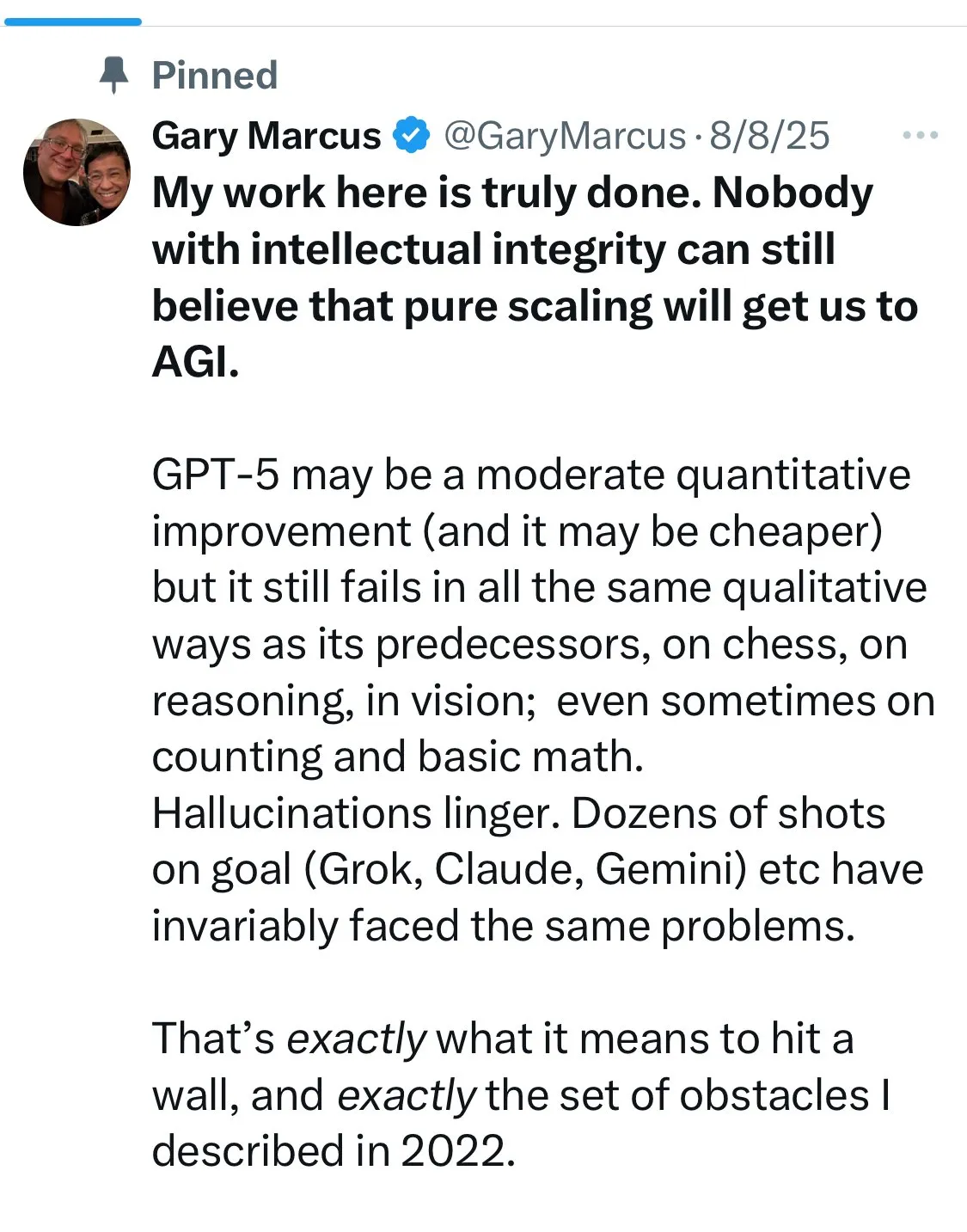

La distancia y definición de la Inteligencia Artificial General (AGI): Se ha generado un amplio debate sobre cuán lejos está la tecnología actual de IA de la AGI, así como sobre la definición de AGI. El éxito de AlphaFold se cita como un ejemplo de que la IA aún requiere la personalización de expertos humanos, cuestionando la inminencia de la AGI. Al mismo tiempo, también hay opiniones que sugieren que la AGI podría no superar a los humanos en todos los aspectos, o que su forma de realización podría ser diferente a lo esperado. (Fuente: fchollet, Dorialexander, mbusigin, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence )

El futuro y los desafíos de los AI Agent: La industria está llena de expectativas sobre el potencial de los AI Agent, creyendo que pueden poner fin a la “micromanagement”, pero al mismo tiempo señala que la mayoría de las empresas aún no están preparadas. Las discusiones sobre si los Agent pueden ajustar modelos de forma autónoma para adaptarse a casos extremos, así como la aplicación de los Agent en tareas de desarrollo y operaciones como la reparación de UI, presagian que la tecnología de Agent traerá una revolución en la productividad. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, andriy_mulyar, Reddit r/MachineLearning)

La importancia de los modelos de IA de código abierto: Se ha enfatizado la ventaja de los modelos de código abierto para evitar problemas de rendimiento inconsistente, especialmente en áreas de aplicación críticas como la salud. Esto contrasta con las preocupaciones generadas por la degradación del rendimiento del modelo Anthropic, y hace un llamado a un mayor apoyo y uso de soluciones de IA de código abierto. (Fuente: iScienceLuvr)

Casos de fallos de la IA en sistemas de pedidos de comida rápida: Los sistemas de pedidos de comida rápida con IA han experimentado fallos, como clientes pidiendo 18.000 vasos de agua o la IA solicitando repetidamente añadir bebidas, lo que ha provocado el colapso del sistema o la ira de los usuarios. Esto subraya los desafíos que la IA aún enfrenta en aplicaciones prácticas, especialmente en el manejo de situaciones excepcionales y la comunicación con el usuario. (Fuente: menhguin)

💡 Otros

HUAWEI’S HELLCAT: Arquitectura de interconexión UB MESH: El Unified Bus (UB) de Huawei es una arquitectura de interconexión propietaria diseñada para reemplazar el uso mixto de PCIe, NVLink e InfiniBand/RoCE en sistemas tradicionales. Ofrece un ancho de banda ultra alto y baja latencia, conectando todas las NPU, y se considera una dirección importante para el desarrollo futuro de arquitecturas de computación. (Fuente: teortaxesTex)

Debate filosófico sobre la IA y las emociones: Se ha propuesto la combinación de la IA con la empatía, lo que ha provocado un debate filosófico sobre si la IA puede realmente comprender y expresar emociones, así como el impacto potencial de esta combinación en la sociedad y la interacción humano-máquina. (Fuente: Ronald_vanLoon)

Recursos de aprendizaje de sistemas distribuidos “14 Days of Distributed”: Zach Mueller y otros han compartido la serie “14 Days of Distributed”, que tiene como objetivo explorar los sistemas distribuidos y tecnologías relacionadas, proporcionando recursos de aprendizaje para la computación a gran escala en la investigación y el desarrollo de IA. (Fuente: charles_irl, winglian)