Palabras clave:Consumo energético de IA, Gemini AI, Inferencia de IA, Modelos de IA, Chips de IA, Centros de datos, Huella de carbono, Mejora de eficiencia, Datos de consumo energético de Google Gemini, Coste real de la inferencia de IA, Porcentaje de consumo energético de chips de IA, Consumo energético de IA en centros de datos, Reducción de la huella de carbono de la IA

🔥 En Foco

Google publica informe sobre consumo energético de IA, revelando el costo y la eficiencia reales de la inferencia de IA : Google ha divulgado por primera vez datos sobre el consumo energético de la inferencia de su modelo Gemini AI. Un prompt de texto mediano consume 0.24 watts-hora de electricidad y 0.26 mililitros de agua, mucho menos de lo esperado por el público. El informe analiza detalladamente la proporción del consumo energético de los chips de IA, CPU/memoria, equipos inactivos y gastos del centro de datos, y señala que desde mayo de 2024 hasta mayo de 2025, el consumo energético de un prompt mediano se redujo 33 veces y la huella de carbono 44 veces, principalmente debido a mejoras en la eficiencia del modelo y del hardware/software. Esta acción aumenta la transparencia sobre el consumo energético de la IA y proporciona datos clave para la investigación de la industria, aunque no se ha revelado el volumen total de consultas, y aún queda por establecer un sistema de medición estandarizado. (Fuente: MIT Technology Review, jeremyphoward, scaling01, eliebakouch, giffmana, teortaxesTex, dilipkay)

NASA e IBM lanzan el modelo de IA Surya para mejorar la predicción de tormentas solares : NASA e IBM han lanzado conjuntamente el modelo de machine learning de código abierto Surya, con el objetivo de mejorar la comprensión y predicción de la física solar y los patrones climáticos. Este modelo, que analiza una década de datos solares de NASA, puede proporcionar a los científicos una alerta temprana sobre peligrosas llamaradas solares que se dirigen a la Tierra. Las tormentas solares pueden interferir con las señales de radio, el funcionamiento de los satélites y poner en peligro a los astronautas. La capacidad de predicción de Surya ayudará a mitigar sus efectos, y aunque no puede detenerlas, permitirá planificar medidas de respuesta con antelación, lo que representa un avance significativo de la IA en el campo de la predicción científica. (Fuente: MIT Technology Review)

Jefe de IA de Microsoft advierte sobre el riesgo de ‘dependencia mental de la IA’ y pide normas éticas para la industria : Mustafa Suleyman, CEO de Microsoft MAI, ha advertido que los usuarios podrían desarrollar una dependencia emocional hacia la IA debido a su imitación realista de la conciencia, e incluso se han reportado casos de “dependencia mental de la IA” que llevan a autolesiones o suicidio, especialmente peligrosos para los adolescentes. Subrayó que la SCAI (IA aparentemente consciente) podría ser una realidad en los próximos dos o tres años, pero que la IA, por su naturaleza, no posee conciencia. Suleyman instó a las empresas de IA a declarar explícitamente que sus productos carecen de conciencia, a diseñar mecanismos para “romper la ilusión” y a compartir directrices de seguridad para proteger el bienestar humano y evitar el uso indebido de la IA, enfocando los esfuerzos en lo que realmente importa. (Fuente: mustafasuleyman, Reddit r/ArtificialInteligence, Reddit r/artificial)

Informe del MIT revela los desafíos de la aplicación de IA empresarial y el auge de la ‘economía de IA en la sombra’ : El informe del MIT “The GenAI Divide: State of AI in Business 2025” señala que el 95% de los proyectos piloto de IA empresarial fracasan debido a su alto costo, rigidez y desconexión de los flujos de trabajo. Sin embargo, el 90% de los empleados utiliza en secreto herramientas de IA personales como ChatGPT, creando una “economía de IA en la sombra” que genera un aumento significativo de la productividad no cuantificado. El informe enfatiza que la tecnología de IA en sí misma es exitosa, pero las estrategias de adquisición y gestión empresarial son problemáticas. Se recomienda dejar de construir soluciones internas y, en su lugar, colaborar con proveedores y aprender de la experiencia de uso real de los empleados. Este fenómeno revela que las herramientas de IA de consumo son superiores a las soluciones empresariales en flexibilidad y adaptabilidad, y plantea una profunda reflexión sobre el retorno de la inversión de la IA tradicional en las empresas. (Fuente: douwekiela, Reddit r/artificial, Reddit r/ArtificialInteligence)

🎯 Tendencias

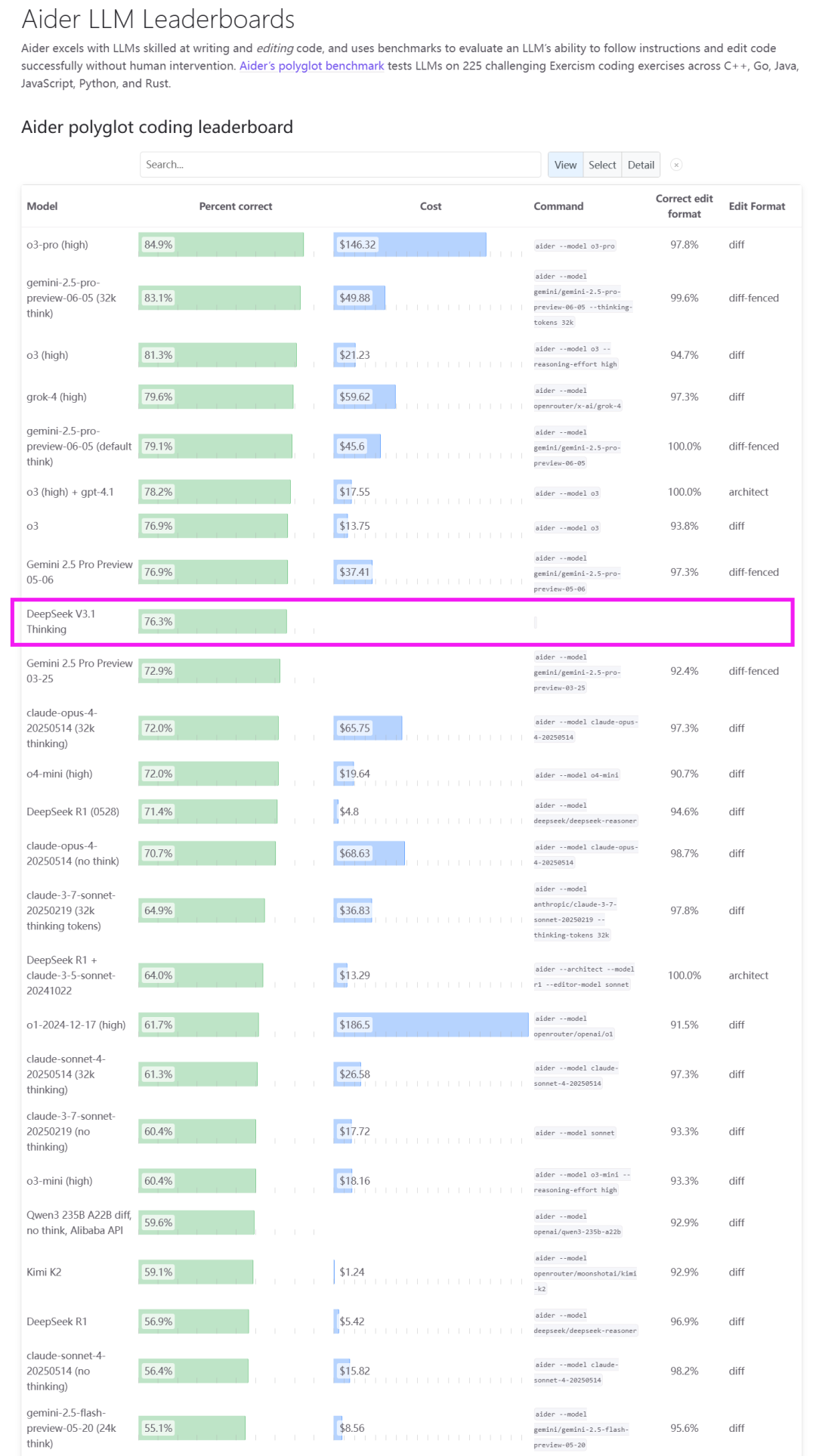

DeepSeek V3.1 lanzado, inaugurando la era Agent y adaptándose a chips nacionales : DeepSeek ha lanzado oficialmente su modelo V3.1, posicionado como el primer paso hacia la era Agent. Esta versión adopta una arquitectura de inferencia híbrida, que soporta modos duales de “pensamiento” y “no pensamiento”, mejorando significativamente el uso de herramientas, tareas de Agent, y capacidades de razonamiento de código y matemáticas, logrando un 66.0% en SWE-Bench Verified. V3.1 también es la primera en lograr compatibilidad nativa con la Anthropic API, y ha anunciado ajustes de precios de la API, con un precio de entrada mínimo de 0.07 dólares por millón de tokens. Más notable aún, DeepSeek enfatiza que V3.1 utiliza el formato UE8M0 FP8 Scale, diseñado para una profunda adaptación a la próxima generación de chips nacionales, lo que se considera una señal importante de la colaboración software-hardware en la cadena de la industria de la computación nacional, beneficiando a los fabricantes de chips de IA nacionales. (Fuente: dotey, scaling01, QuixiAI, QuixiAI, cline, vllm_project, OfirPress, huggingface, stanfordnlp, Reddit r/LocalLLaMA)

Google AI Mode se actualiza, expandiendo capacidades Agentic y experiencia personalizada a nivel global : El AI Mode de Google ha recibido una importante actualización, introduciendo funciones Agentic y personalizadas más avanzadas, y expandiéndose a más de 180 países y regiones en todo el mundo. El AI Mode ahora puede ayudar a los usuarios a encontrar y reservar restaurantes (próximamente también entradas para eventos y reservas locales), con resultados personalizados según las preferencias e intereses individuales, y permite compartir las respuestas del AI Mode con un solo clic. Además, el consumo energético de los prompts de texto en Google Gemini Apps se ha reducido drásticamente, y se han lanzado herramientas como NotebookLM y Veo dentro del AI Mode, así como más de 20 funciones de IA en la serie de teléfonos Pixel 10, con el objetivo de integrar profundamente la IA en la experiencia diaria. (Fuente: GoogleDeepMind, Google, arankomatsuzaki, op7418, Google, TheRundownAI, demishassabis, MIT Technology Review)

Cohere lanza el modelo Command A Reasoning, fortaleciendo las capacidades de inferencia empresarial : Cohere ha presentado su modelo de inferencia empresarial más avanzado, Command A Reasoning. Este modelo está diseñado específicamente para manejar tareas de inferencia complejas a nivel empresarial, como investigación profunda y análisis de datos. Cohere también se ha comprometido a liberar los pesos del modelo como open source para apoyar el ecosistema de investigación de IA. El modelo ha demostrado un rendimiento excepcional en el uso de herramientas y benchmarks de Agent, y se espera que impulse las capacidades de inferencia avanzada en las aplicaciones de IA empresariales. (Fuente: leonardtang_, JayAlammar, scaling01, sarahookr, huggingface)

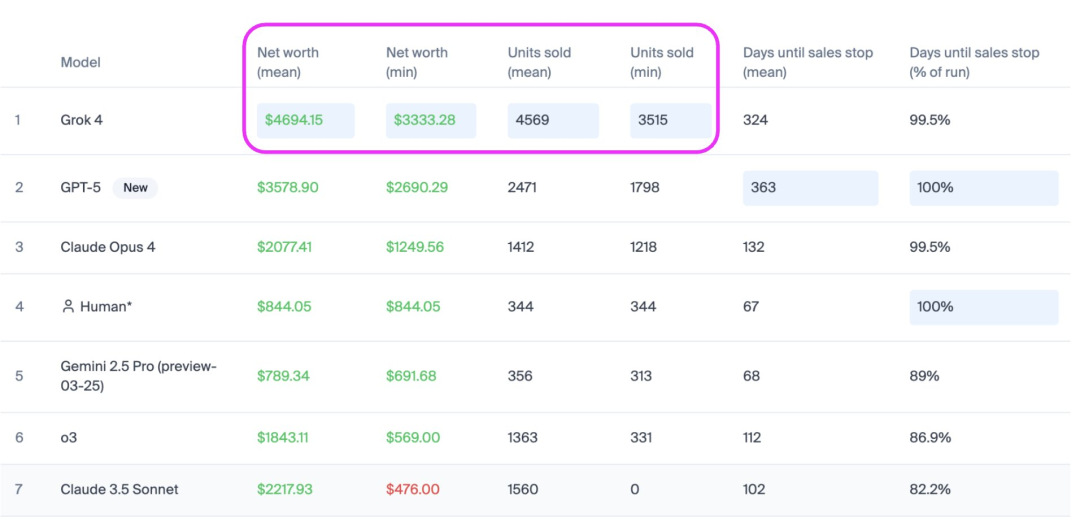

Grok-4 de Musk supera a GPT-5 en el ranking de ventas de IA Vending Bench : Grok-4 de Elon Musk ha demostrado un rendimiento excepcional en el ranking de ventas de IA Vending Bench, superando a GPT-5 en aproximadamente 2 veces las ventas, con un crecimiento de ingresos del 31% y vendiendo 1100 dólares más en mercancía que GPT-5, dominando en estabilidad y volumen de ventas. Vending Bench es un benchmark que evalúa el rendimiento de los AI Agent en tareas comerciales complejas y a largo plazo, simulando la gestión de un negocio de máquinas expendedoras. Esta prueba enfatiza la capacidad de decisión continua de la IA y la comprensión de contextos largos, revelando los desafíos de los modelos de IA para mantener la seguridad y fiabilidad a lo largo del tiempo, y se considera una vía de prueba para un prototipo inicial de AGI. (Fuente: teortaxesTex)

Mirage 2, el primer motor de juego nativo de IA del mundo, itera para la generación de dominio general e interacción en tiempo real : Dynamic Labs ha lanzado Mirage 2, presentado como la versión evolucionada del primer motor de juego nativo de IA del mundo, impulsado por un modelo de mundo en tiempo real, capaz de crear, experimentar y cambiar instantáneamente cualquier mundo de juego. Mirage 2 ha mejorado significativamente el rendimiento de generación, soportando un control de prompts más sensible, menor latencia en el juego y modelado de dominio general, y puede transformar imágenes cargadas en mundos de juego interactivos. Aunque todavía existen problemas de precisión en el control de movimiento y coherencia visual, su rápida iteración y jugabilidad le otorgan el potencial para competir con DeepMind Genie 3. (Fuente: scaling01, Vtrivedy10, BlackHC)

Huawei MateTV lanza múltiples nuevas tecnologías de IA, creando una experiencia de ‘jugar con la TV como con un móvil’ : Huawei MateTV ha presentado varias tecnologías innovadoras con el objetivo de ofrecer una experiencia inteligente de “jugar con la TV como con un móvil”. El nuevo producto incorpora Harmony OS 5 y el chip de calidad de imagen independiente 鸿鹄Vivid, y soporta el control táctil flotante Lingxi. Con el respaldo de la tecnología de IA, MateTV puede realizar reconocimiento de personas con IA (AI识人), búsqueda de películas con IA (AI搜片), y comprender las necesidades de los miembros de la familia a través del gran modelo de Harmony y el reconocimiento multimodal. El gran modelo Xiaoyi soporta la búsqueda de películas por voz, los algoritmos de IA mejoran automáticamente la calidad de imagen, y soporta los estándares end-to-end HDR Vivid y Audio Vivid, transformando la televisión en un centro de inteligencia familiar. (Fuente: 36氪)

Qwen-Image-Edit ocupa el segundo lugar en el Image Editing Arena, con un rendimiento comparable a GPT-4o : El modelo Qwen-Image-Edit de Alibaba ha debutado en el Image Editing Arena, ocupando el segundo lugar con una puntuación ELO de 1098, y su rendimiento es comparable al de GPT-4o y FLUX.1 Kontext [max]. Este modelo de código abierto, lanzado bajo la licencia Apache 2.0, ofrece los pesos del modelo, demostrando una potente capacidad y versatilidad en el campo de la edición de imágenes, proporcionando una opción de código abierto de alta calidad para los desarrolladores. (Fuente: Alibaba_Qwen)

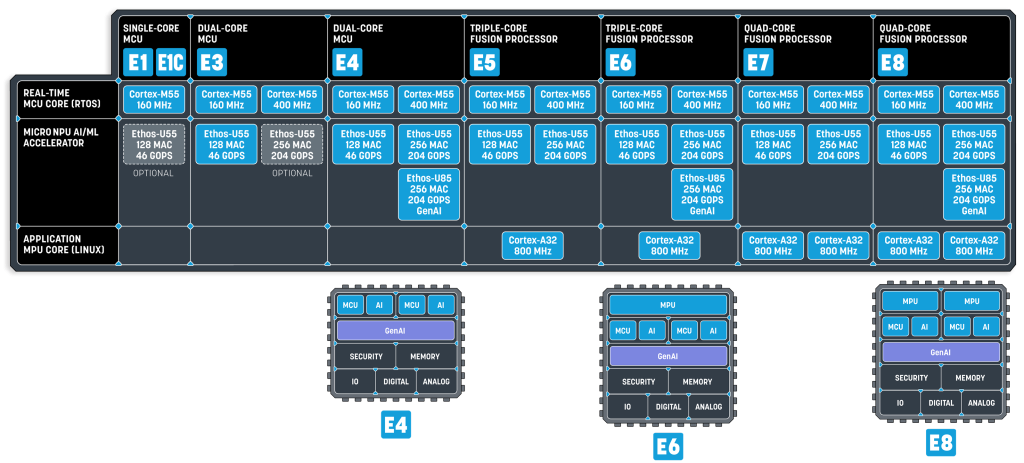

Los modelos de lenguaje pequeños (SLM) se convierten en la futura tendencia de la IA embebida : Una investigación reciente de NVIDIA señala que los modelos de lenguaje pequeños (SLM) son el futuro de los Agent, y ha lanzado el Nemotron-Nano-9B-V2. Los SLM se comprimen a partir de modelos grandes mediante técnicas como la destilación de conocimiento, la poda y la cuantificación, con un rango de parámetros de millones a miles de millones, siendo más compactos y eficientes, adecuados para dispositivos de borde y embebidos con recursos limitados. La ejecución de SLM no solo requiere NPU de alta capacidad de cómputo, sino también un bus de sistema de alto ancho de banda y una configuración de memoria estrechamente acoplada. Empresas como Alif Semiconductor ya han lanzado MCU y procesadores de fusión compatibles con SLM, lo que presagia que los SLM revolucionarán el panorama de los MCU y MPU. (Fuente: 36氪)

GPT-5 Pro demuestra nuevas capacidades de razonamiento matemático, rompiendo límites tradicionales : Se ha informado que GPT-5 Pro exhibe capacidades de razonamiento “novedosas” en el campo de las matemáticas, siendo capaz de probar mejores límites que no se habían encontrado en trabajos anteriores. Esta capacidad no se limita a las matemáticas, sino que se extiende también a campos como la física teórica, lo que demuestra el enorme potencial de los modelos de IA en la resolución de problemas complejos y la creación de conocimiento, yendo más allá del simple reconocimiento de patrones y la recuperación de datos, hacia un nivel de inteligencia más profundo. (Fuente: kevinweil)

🧰 Herramientas

LlamaParse actualiza sus capacidades de análisis de documentos, ofreciendo soporte RAG multimodo : LlamaParse ha realizado una importante actualización de sus capacidades de análisis de documentos, lanzando tres modos: Cost-effective, Agentic y Agentic Plus. El modo Cost-effective es de bajo costo y sobresale en el procesamiento de documentos de texto, tablas, fuentes y multilingües; el modo Agentic, como predeterminado, es más completo y puede manejar gráficos y diseños complejos; el modo Agentic Plus ofrece la más alta calidad en el análisis de documentos complejos. Estos modos están diseñados para satisfacer las necesidades de los flujos de trabajo de RAG (Retrieval Augmented Generation) y extracción de documentos estándar, mejorando la eficiencia y la precisión. (Fuente: jerryjliu0)

HuggingFace lanza la función de programación de tareas de GPU, simplificando el entrenamiento y despliegue de modelos de IA : HuggingFace ha añadido una función de programación de tareas de GPU, que permite a los usuarios programar trabajos de GPU con un solo comando. Esta función utiliza la herramienta UV para simplificar la definición de dependencias, soporta la selección del hardware deseado y utiliza la sintaxis CRON para la programación. Esto proporciona a los desarrolladores de IA una forma más conveniente y eficiente de entrenar y desplegar modelos, especialmente adecuada para tareas de cómputo intensivas en recursos o que requieren ejecución periódica. (Fuente: ben_burtenshaw)

OpenAI Conversations API se actualiza, soportando almacenamiento de contexto y funciones de conectores : La Responses API de OpenAI ha recibido dos grandes actualizaciones: la función Conversations permite a los desarrolladores almacenar el contexto de las llamadas a la API (mensajes, llamadas a herramientas, salidas de herramientas, etc.), facilitando a los usuarios continuar desde donde dejaron la conversación anterior. La función Connectors, por su parte, permite extraer contexto de múltiples fuentes como Gmail, Google Calendar, Dropbox, etc., en una sola llamada a la API. Estas funciones están diseñadas para simplificar el trabajo de los desarrolladores al construir aplicaciones de IA persistentes y con múltiples fuentes de información, mejorando la experiencia del usuario y la eficiencia del desarrollo. (Fuente: nptacek, gdb)

Vercel AI Gateway lanzado oficialmente, ofreciendo servicio de acceso a API de múltiples modelos sin recargo : Vercel ha lanzado oficialmente AI Gateway, proporcionando a los desarrolladores una interfaz API unificada para acceder a cientos de modelos de IA y múltiples proveedores de servicios. Esta plataforma gestiona automáticamente la autenticación, limitación de velocidad, conmutación por error, seguimiento de uso y facturación, eliminando la necesidad de que los usuarios gestionen múltiples API Key. AI Gateway promete cero recargos, permitiendo a los usuarios traer sus propias Key y contratos para disfrutar de los servicios de llamada de modelos. Esto simplifica enormemente la gestión de modelos y los procesos de despliegue para los desarrolladores de aplicaciones de IA, reduciendo la complejidad operativa. (Fuente: op7418)

Modal construye una pila completa de infraestructura de IA, soportando programación de GPU y colas asíncronas : El equipo de Modal ha construido cada capa de la infraestructura de IA desde cero, incluyendo el sistema de archivos, la red, las colas asíncronas y la orquestación de GPU multi-nube. Esta pila de infraestructura de IA profundamente integrada está diseñada para proporcionar un entorno de ejecución de alto rendimiento y escalable para aplicaciones de IA, resolviendo los desafíos subyacentes de las cargas de trabajo de IA. Los esfuerzos de Modal ofrecen un potente soporte de backend para los desarrolladores, permitiéndoles centrarse en el desarrollo y la aplicación de modelos de IA. (Fuente: akshat_b, charles_irl, sarahcat21, StasBekman, TheZachMueller)

Open WebUI lanza la nueva versión 0.6.23, con múltiples correcciones y mejoras : Open WebUI ha lanzado la nueva versión 0.6.23, que trae consigo varias mejoras sustanciales y nuevas funciones. Esta actualización tiene como objetivo mejorar la experiencia del usuario, corregir problemas existentes y expandir las capacidades de la plataforma, proporcionando un entorno de interacción más estable y rico en funciones para las interfaces de chatbots de IA. (Fuente: Reddit r/OpenWebUI)

LlamaIndex lanza la herramienta vibe-llama, simplificando el desarrollo de LLM y la configuración de Agent : LlamaIndex ha lanzado la herramienta de línea de comandos vibe-llama, diseñada para simplificar el proceso de desarrollo de LlamaIndex a través de un Agent de codificación sensible al contexto. Esta herramienta configura automáticamente el framework de LlamaIndex, LlamaCloud y los flujos de trabajo con el contexto más reciente y las mejores prácticas para 16 populares Agent de codificación como Cursor AI, Claude Code y GitHub Copilot, ayudando así a los desarrolladores a construir aplicaciones basadas en LlamaIndex más rápidamente. (Fuente: jerryjliu0)

vLLM soporta DeepSeek-V3.1, ofreciendo un servicio eficiente de inferencia de LLM : El proyecto vLLM ha anunciado soporte oficial para el modelo DeepSeek-V3.1, permitiendo a los usuarios cambiar sin problemas entre los modos de “pensamiento” y “no pensamiento” en cada solicitud. La eficiente capacidad de servicio de vLLM permite que DeepSeek-V3.1 se escale fácilmente a entornos multi-GPU, siendo especialmente adecuado para cargas de trabajo de Agent, herramientas e inferencia rápida, proporcionando a los desarrolladores una potente solución de despliegue de LLM. (Fuente: vllm_project, vllm_project)

Figma y Cursor AI logran una integración profunda, mejorando la eficiencia del flujo de trabajo de diseño a código : Figma y Cursor AI han logrado una integración profunda a través del MCP (Model Context Protocol), optimizando enormemente el flujo de trabajo de diseño a código. Los usuarios ahora pueden activar MCP en Figma y añadirlo a Cursor AI. Al copiar el enlace de un componente de Figma, los desarrolladores pueden pedir directamente a Cursor AI que implemente dicho componente, y el Agent extraerá automáticamente el código y las capturas de pantalla. Se espera que esta integración mejore significativamente la eficiencia de la colaboración entre diseñadores y desarrolladores, acelerando el ciclo de desarrollo de productos. (Fuente: BrivaelLp)

MongoDB y LangChainAI colaboran para dotar a los AI Agent de memoria a largo plazo : MongoDB y LangChainAI han colaborado para lanzar MongoDB Store for LangGraph, permitiendo a los AI Agent tener memoria a largo plazo. Esta función permite a los Agent retener conocimiento entre diferentes conversaciones, volviéndose más inteligentes y conscientes del contexto. Combinado con el soporte existente de MongoDB para el checkpointing del historial de conversaciones a corto plazo, proporciona una base completa para construir Agent verdaderamente con estado y listos para producción, resolviendo el desafío clave de la coherencia de los Agent en interacciones multivuelta. (Fuente: Hacubu, hwchase17)

Qwen-image-mps v0.2 lanzado, logrando edición de imagen ultrarrápida en Mac Studio M3 Ultra : Se ha lanzado la versión Qwen-image-mps v0.2 – Edit Lightning, que mejora significativamente la velocidad de edición de imágenes. En un Mac Studio M3 Ultra, el modo estándar (50 pasos) requiere 16 minutos y 4 segundos, el modo rápido (8 pasos) solo 2 minutos y 37 segundos, y el modo ultrarrápido (4 pasos) se reduce a 1 minuto y 18 segundos. Esta actualización hace que la edición de imágenes local sea más eficiente, especialmente para los creativos que necesitan una iteración rápida. (Fuente: ImazAngel)

Gemini CLI se actualiza, añadiendo integración IDE, atajos de teclado y vimMode : La interfaz de línea de comandos (CLI) de Gemini ha lanzado una actualización, añadiendo funciones como integración IDE, atajos de teclado y vimMode. Estas mejoras tienen como objetivo aumentar la eficiencia y la comodidad de los desarrolladores al usar Gemini CLI, permitiendo una integración más fluida en los flujos de trabajo de desarrollo diarios y proporcionando un entorno más amigable para la programación y la interacción con IA. (Fuente: _philschmid)

El proyecto Paddler de llama.cpp se dedica a construir y expandir la infraestructura de LLM : El proyecto Paddler de la comunidad llama.cpp se centra en construir y expandir la infraestructura de LLM. Este proyecto ha logrado avances significativos en el último año, con el objetivo de proporcionar a los usuarios una solución de despliegue de LLM local potente y escalable basada en llama.cpp, promoviendo la aplicación de LLM en dispositivos personales y pequeños servidores. (Fuente: ggerganov)

DeepSeek soporta Anthropic API, Claude Code puede conectarse directamente a DeepSeek V3.1 : DeepSeek ha anunciado soporte para la Anthropic API, lo que significa que herramientas como Claude Code pueden conectarse directamente al modelo DeepSeek-V3.1. Los desarrolladores ahora solo necesitan configurar la dirección y la clave de la API para usar las capacidades de inferencia y conversación de DeepSeek-V3.1 en todos los entornos que soporten la Anthropic API, lo que reduce enormemente la dificultad de integrar el modelo DeepSeek en el ecosistema existente. (Fuente: karminski3)

📚 Aprendizaje

‘1500 artículos sobre ingeniería de prompts demuestran que todo lo que sabes está mal’ revela errores comunes en la ingeniería de prompts : Un estudio exhaustivo basado en más de 1500 artículos señala que la mayoría de los consejos populares sobre ingeniería de prompts en redes sociales son ineficaces o incluso contraproducentes. El informe revela seis errores comunes: los prompts más largos son mejores, más ejemplos son mejores, la redacción perfecta es lo más importante, Chain of Thought aplica a todo, los expertos humanos escriben los mejores prompts, y una vez configurado, se olvida. La investigación enfatiza que las empresas exitosas se centran más en la estructura que en la longitud, usan selectivamente pocos ejemplos, la formatación es superior a la redacción, personalizan las técnicas para cada tarea, automatizan la optimización de prompts y consideran los prompts como un producto en mejora continua. Esto subvierte las percepciones tradicionales y proporciona una guía más basada en la evidencia para el desarrollo de aplicaciones de IA. (Fuente: 36氪)

Fin-PRM: Modelo de recompensa de proceso específico para el sector financiero, mejorando la capacidad de inferencia financiera de LLM : Fin-PRM es un modelo de recompensa de proceso específico para tareas financieras, utilizado para supervisar los pasos intermedios de inferencia de LLM. Este modelo integra la supervisión de recompensas a nivel de paso y a nivel de trayectoria, lo que permite una evaluación detallada de las trayectorias de razonamiento lógico financiero. Fin-PRM se aplica tanto en configuraciones de aprendizaje de recompensas offline como online, y puede utilizarse para seleccionar trayectorias de inferencia de alta calidad para el fine-tuning por destilación, proporcionar recompensas de proceso densas para el reinforcement learning, y guiar la inferencia de información de recompensa durante las pruebas. Los resultados experimentales muestran que Fin-PRM supera significativamente a los PRM genéricos en los benchmarks de inferencia financiera, aportando un valor importante para la alineación de inferencia a nivel de experto de los LLM en el sector financiero. (Fuente: HuggingFace Daily Papers)

Deep Think with Confidence: Un nuevo método para mejorar la eficiencia y el rendimiento de la inferencia de LLM : DeepConf (Deep Think with Confidence) es un método simple pero efectivo diseñado para mejorar la eficiencia y el rendimiento de los LLM en tareas de inferencia. Este método utiliza señales de confianza internas del modelo para filtrar dinámicamente las trayectorias de inferencia de baja calidad durante o después del proceso de generación. DeepConf no requiere entrenamiento adicional del modelo ni ajuste de hiperparámetros, y puede integrarse sin problemas en los frameworks de servicio existentes. En benchmarks desafiantes como AIME 2025, DeepConf@512 logró una precisión de hasta el 99.9% mientras redujo la cantidad de Tokens generados en un 84.7%, disminuyendo significativamente el costo computacional. (Fuente: HuggingFace Daily Papers)

Dissecting Tool-Integrated Reasoning: Un nuevo benchmark para evaluar la capacidad de inferencia integrada de herramientas en LLM : ReasonZoo es un benchmark completo que abarca nueve categorías de razonamiento diferentes, diseñado para evaluar la efectividad de la inferencia integrada de herramientas (TIR) en la mejora de las capacidades de razonamiento de los LLM. La investigación introduce dos nuevas métricas, PAC (Performance-Aware Cost) y AUC-PCC (Area Under the Performance-Cost Curve), para evaluar la eficiencia de la inferencia. La evaluación empírica demuestra que los modelos TIR superan a los modelos no TIR tanto en tareas matemáticas como no matemáticas, y mejoran la eficiencia de la inferencia, reduciendo el “pensamiento excesivo” y haciendo que la inferencia sea más fluida. Estos hallazgos resaltan las ventajas generales de TIR y su papel en la mejora del potencial de los LLM en tareas de razonamiento complejas. (Fuente: HuggingFace Daily Papers)

Virtuous Machines: Hacia la IA científica general, realizando investigación psicológica autónoma : El artículo “Virtuous Machines: Towards Artificial General Science” presenta un sistema de IA Agent independiente del dominio, capaz de completar de forma autónoma flujos de trabajo de investigación científica, incluyendo la generación de hipótesis, la recopilación de datos y la preparación de manuscritos. Este sistema diseñó y ejecutó de forma autónoma tres estudios psicológicos sobre la memoria de trabajo visual, la rotación mental y la vivacidad de las imágenes, y realizó la recopilación de datos online. Los resultados de la investigación indican que el pipeline de descubrimiento científico de IA es comparable a investigadores experimentados en razonamiento teórico y rigor metodológico, aunque todavía tiene limitaciones en los matices conceptuales y la interpretación teórica. Este es un paso importante hacia la IA encarnada, con el potencial de acelerar el descubrimiento científico a través de experimentos en el mundo real. (Fuente: HuggingFace Daily Papers)

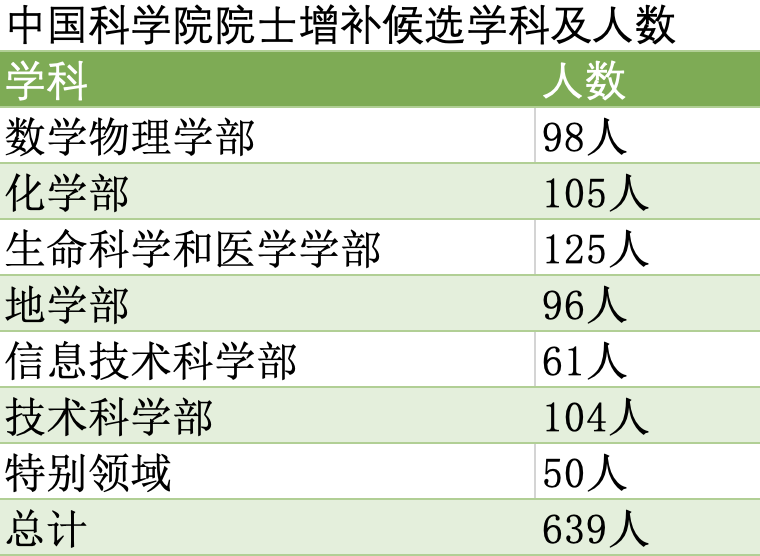

Tsinghua, Peking y Zhejiang Universities lideran las candidaturas a la Academia, con la robótica de IA como área clave de selección : Se ha publicado la lista de candidatos válidos para la elección de nuevos académicos de la Academia China de Ciencias y la Academia China de Ingeniería en 2025, con las universidades de Tsinghua, Peking y Zhejiang a la cabeza. Esta elección destaca la atención a las disciplinas emergentes; la ciencia y tecnología de la inteligencia artificial ha ascendido de subcampo de la tecnología de la información a disciplina independiente, con asignación de cupos específicos. La robótica también ha reemplazado a la ciberseguridad como disciplina prioritaria. Esto refleja la inclinación del país hacia campos clave como la IA y la robótica, con un aumento significativo de académicos de estas áreas entre los candidatos, lo que presagia una mayor inversión en investigación y formación de talentos en el futuro. (Fuente: 36氪)

El libro de texto ‘Speech and Language Processing’ gratuito, la compartición de recursos académicos genera debate : La disponibilidad gratuita del libro de texto “Speech and Language Processing” de Dan Jurafsky ha generado una discusión activa en la comunidad sobre el valor de los recursos académicos gratuitos. Este gesto se considera una contribución a la ciencia abierta y la educación, permitiendo que más personas accedan a materiales de aprendizaje de IA/NLP de alta calidad, lo cual es significativo tanto para principiantes como para investigadores. (Fuente: stanfordnlp)

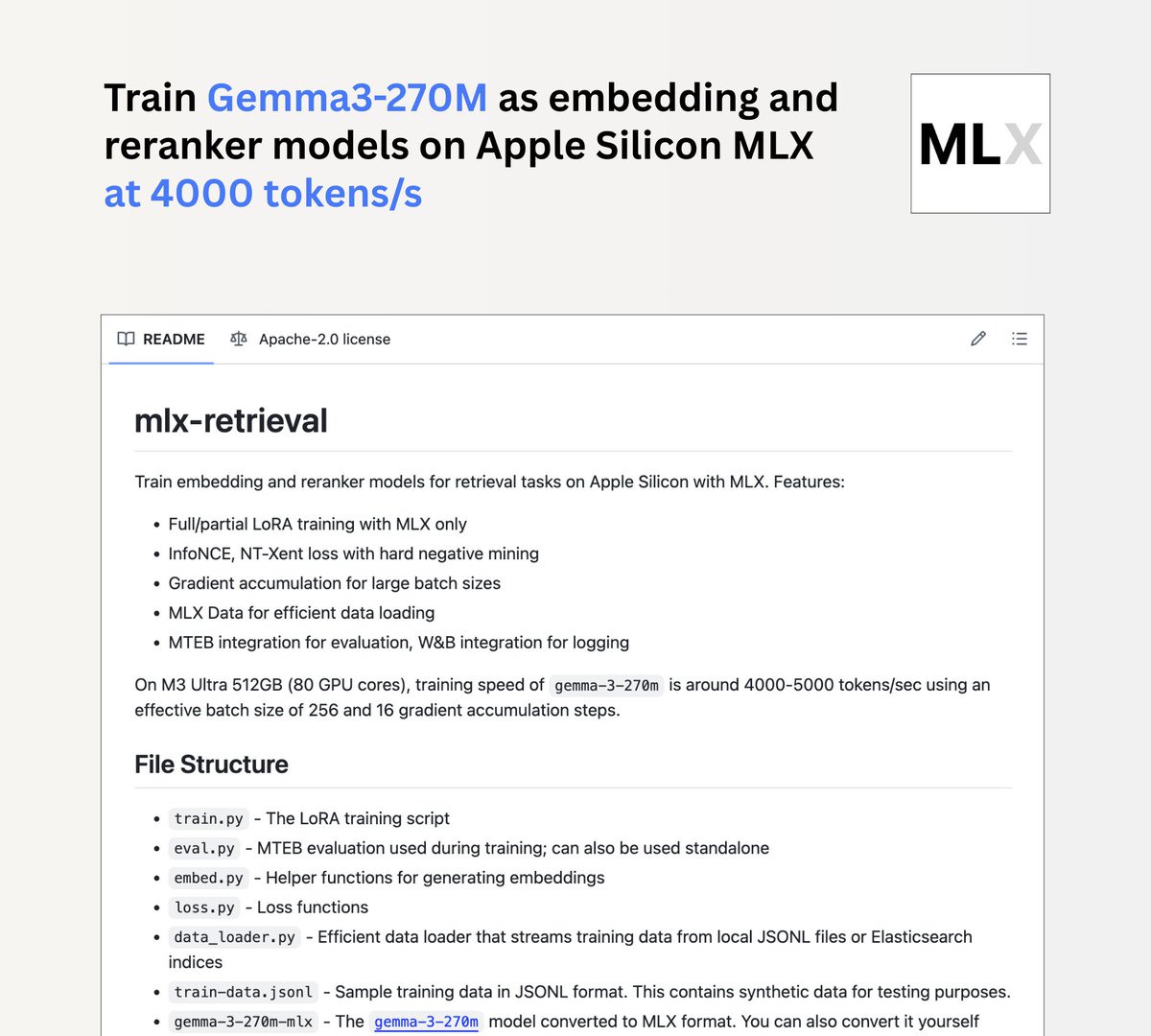

Jina AI lanza el proyecto mlx-retrieval, permitiendo el entrenamiento local de Gemma3 270m en chips Mac M : Jina AI ha lanzado el proyecto mlx-retrieval, que permite a los usuarios de chips Mac M entrenar localmente el modelo Gemma3 270m como un modelo de embeddings multilingüe o de reordenamiento. Este proyecto logró una velocidad de entrenamiento de 4000 tokens/segundo en un M3 Ultra, e integra prácticas estándar como LoRA, InfoNCE, acumulación de gradientes y cargadores de datos en streaming, así como evaluación MTEB, proporcionando una solución eficiente y utilizable para el desarrollo de modelos de IA locales. (Fuente: awnihannun)

Usuarios de Reddit comparten los principios de los modelos LLM de baja precisión, una guía de cuantificación de 1 bit a FP16 : Un usuario de Reddit ha explicado detalladamente que los modelos de baja precisión no son “descerebrados”, sino que logran la miniaturización del modelo sacrificando información de forma inteligente. El artículo, que va desde el meme de 1 bit, el TL;DR de 2 bits, la descripción general de 4 bits, la lectura profunda de 8 bits hasta la investigación de FP16, analiza paso a paso los principios de cuantificación de LLM, incluyendo la precisión mixta, la calibración y nuevas arquitecturas (como BitNet) como tecnologías clave. Esto proporciona una visión profunda de cómo los LLM mantienen el rendimiento en dispositivos con recursos limitados y comparte recursos de aprendizaje relacionados. (Fuente: Reddit r/LocalLLaMA)

Usuarios de Reddit discuten la similitud de imágenes y el modelo I-JEPA : Usuarios de Reddit han compartido un artículo sobre la investigación de similitud de imágenes utilizando I-JEPA, que cubre dos implementaciones: PyTorch puro y Hugging Face. I-JEPA, como modelo de aprendizaje auto-supervisado, muestra potencial en la extracción de características de imágenes y la medición de similitud, ofreciendo un nuevo método para tareas como la recuperación y clasificación de imágenes en el campo de la visión por computadora. (Fuente: Reddit r/deeplearning)

💼 Negocios

La CFO de OpenAI discute por primera vez la posibilidad de una IPO y considera vender servicios de infraestructura de IA : Sarah Friar, Directora Financiera de OpenAI, ha declarado públicamente por primera vez que la empresa podría realizar una IPO en el futuro y reveló que los ingresos mensuales de julio superaron los mil millones de dólares. Señaló que OpenAI enfrenta una enorme presión por la escasez de capacidad de cómputo y está considerando seguir el ejemplo de Amazon, transformando su experiencia en el diseño y construcción de centros de datos de IA en una nueva fuente de ingresos, vendiendo servicios de infraestructura de IA a otras empresas. Friar enfatizó que, aunque la relación con Microsoft está cambiando, ambas partes están profundamente vinculadas en propiedad intelectual, y Microsoft seguirá siendo un socio clave durante muchos años. (Fuente: 36氪, 36氪)

Meta congela contrataciones en su división de IA y prohíbe la movilidad interna, generando preocupación por una ‘burbuja de IA’ : The Wall Street Journal ha informado que Meta ha congelado las contrataciones en su recién creado “Meta Superintelligence Lab” (MSL) y ha prohibido la transferencia de empleados entre equipos dentro de esta división. Esta medida se produce después de que Meta gastara una fortuna en reclutar a más de 50 investigadores e ingenieros de IA de la competencia, lo que ha generado preocupación por una posible “burbuja de IA”. Un portavoz de Meta lo calificó como “planificación organizativa básica”, pero fuentes indican que surgieron fricciones entre empleados nuevos y antiguos debido a las diferencias salariales. Esta congelación está estrechamente relacionada con la cuarta reorganización del departamento de IA de Meta, que divide el MSL en cuatro grupos independientes, lo que demuestra un ajuste en la estrategia de IA de la compañía y una consideración de la eficiencia de costos. (Fuente: MIT Technology Review, 36氪, 36氪)

Los costos de despliegue de aplicaciones de IA se disparan, los desarrolladores se quejan de la reducción de márgenes : A pesar de que los gigantes de la IA habían reducido los precios de las llamadas a la API, los costos para las empresas que despliegan IA avanzada se estancaron o incluso aumentaron significativamente para algunos modelos en 2025. Fuentes familiarizadas con el asunto revelaron que la factura de Azure relacionada con la IA para el desarrollador de software financiero Intuit se espera que se dispare a 30 millones de dólares. La herramienta de programación de IA Cursor también comenzó a cobrar tarifas adicionales basadas en el uso real, lo que provocó el descontento de la comunidad de usuarios. Esto ha llevado a una reducción de los márgenes de beneficio para los desarrolladores de aplicaciones de IA, mientras que los proveedores de modelos upstream y los proveedores de la nube (como Microsoft Azure) se benefician de la tendencia, con un aumento de 7 veces en la generación de tokens relacionados con sus AI Agent. Los desarrolladores temen la formación de un oligopolio y piden a la industria que preste atención al problema de los costos. (Fuente: 36氪)

🌟 Comunidad

Las redes sociales debaten el impacto de la IA en el empleo, las habilidades y la confianza : La discusión sobre la IA en las redes sociales está creciendo, centrándose principalmente en el impacto de la IA en el mercado laboral, la degradación de las habilidades humanas y los problemas de confianza en la IA. Algunos argumentan que la IA es una excusa para los despidos y no reemplazará trabajos a gran escala a corto plazo, pero a largo plazo, redefinirá las tareas. Un estudio de Lancet advierte que la asistencia de la IA podría erosionar las habilidades de diagnóstico independiente de los médicos, mientras que una investigación del MIT muestra que los pacientes confían más en la IA que en los médicos, incluso cuando los consejos son erróneos. Además, las experiencias personales con la consulta emocional de la IA plantean profundas reflexiones sobre la dependencia de la IA y la relación humano-máquina, y la evaluación negativa del CEO de AWS sobre el reemplazo de empleados de nivel inicial por la IA, todo lo cual refleja las complejas emociones de la comunidad sobre el efecto de doble filo de la IA. (Fuente: mathemagic1an, 36氪, 36氪, 36氪, Reddit r/artificial, Reddit r/artificial, Reddit r/ArtificialInteligence)

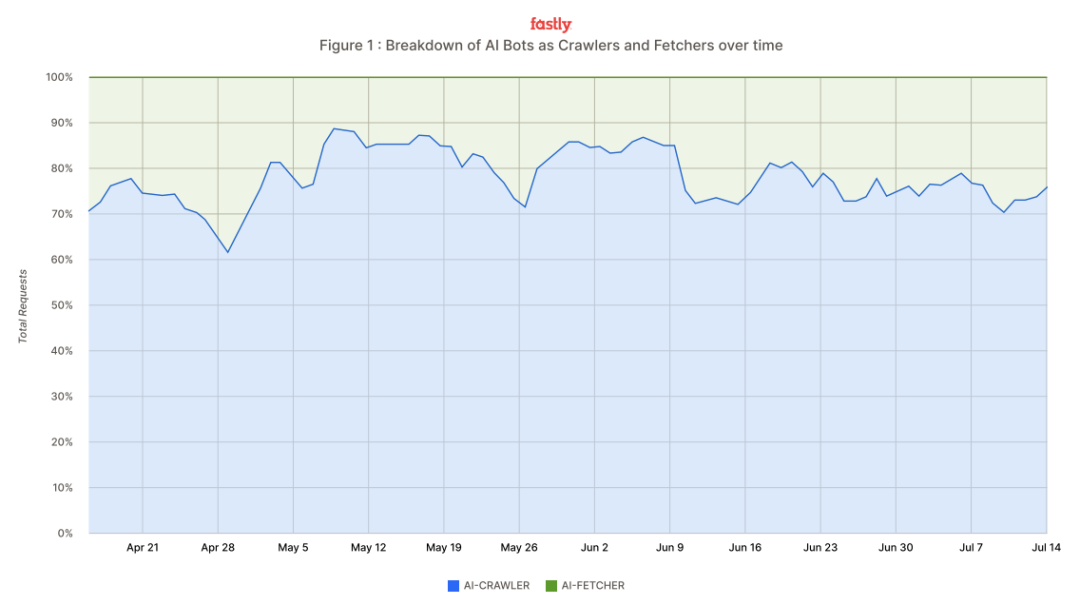

El tráfico de crawlers de IA se dispara, Meta, Google y OpenAI son señalados, y los desarrolladores lanzan ‘armas’ anti-crawler : El gigante de la nube Fastly ha informado que los crawlers de IA están impactando internet a una velocidad máxima de 39,000 solicitudes por minuto, representando el 80% del tráfico de bots de IA, y que Meta, Google y OpenAI representan el 95% del tráfico total de crawlers. Estos crawlers extraen contenido de sitios web para el entrenamiento de modelos y la recuperación de información en tiempo real, lo que provoca un aumento masivo de la presión sobre los servidores de los sitios web y un incremento de los costos operativos. Los desarrolladores han comenzado a contraatacar, empleando herramientas como Anubis (prueba de trabajo), “ZIP bombs” caseras y captchas gamificados, en un intento de suprimir el rastreo no autorizado y proteger su contenido e infraestructura. (Fuente: 36氪)

Las redes sociales discuten las aplicaciones y desafíos de la IA en Code RAG, asistencia de programación y capacidades de Agent : En las redes sociales, los desarrolladores debaten activamente los problemas de la IA en Code RAG (Retrieval Augmented Generation), como el tamaño excesivo de los archivos de código, las actualizaciones frecuentes y la necesidad de una recuperación precisa. Al mismo tiempo, la IA muestra un enorme potencial en la asistencia a la programación, como la capacidad de GPT-5 para portar controladores de Android a iOS, y la integración de Figma con Cursor AI. También se señala que la eficiencia de las herramientas de programación de IA (como Claude Code) depende de la comprensión del usuario; sin una comprensión adecuada, muchas herramientas son inútiles. Además, la atención a las capacidades Agentic está aumentando, como el procesamiento de tareas de varios pasos, la invocación de herramientas y la memoria a largo plazo, pero su fiabilidad, costo y el equilibrio con la colaboración humana siguen siendo desafíos. (Fuente: dotey, gfodor, gfodor, gfodor, BrivaelLp, pierceboggan, nptacek, HamelHusain, imjaredz)

La transformación del modelo de búsqueda de IA genera preocupación por el ecosistema publicitario tradicional : El volumen de usuarios de la función de búsqueda de IA de Google (AI Overviews) se ha disparado, con más de cien millones de usuarios activos mensuales en EE. UU. e India en su modo de búsqueda conversacional, lo que ha generado preocupación por el ecosistema publicitario tradicional. La búsqueda de IA genera respuestas directamente, reduciendo la necesidad de que los usuarios hagan clic en enlaces, lo que podría romper el círculo virtuoso de “búsqueda-tráfico-publicidad-monetización”. El modelo tradicional de CPC (costo por clic) se enfrenta a una disrupción, y en el futuro podría evolucionar hacia un modelo de CPS (costo por venta). Esta transformación representa un desafío para los fabricantes de búsqueda tradicionales y también impulsa a empresas nacionales como ByteDance y Tencent a explorar activamente cómo los asistentes de IA pueden remodelar la experiencia de búsqueda, buscando la próxima generación de modelos de negocio. (Fuente: 36氪)

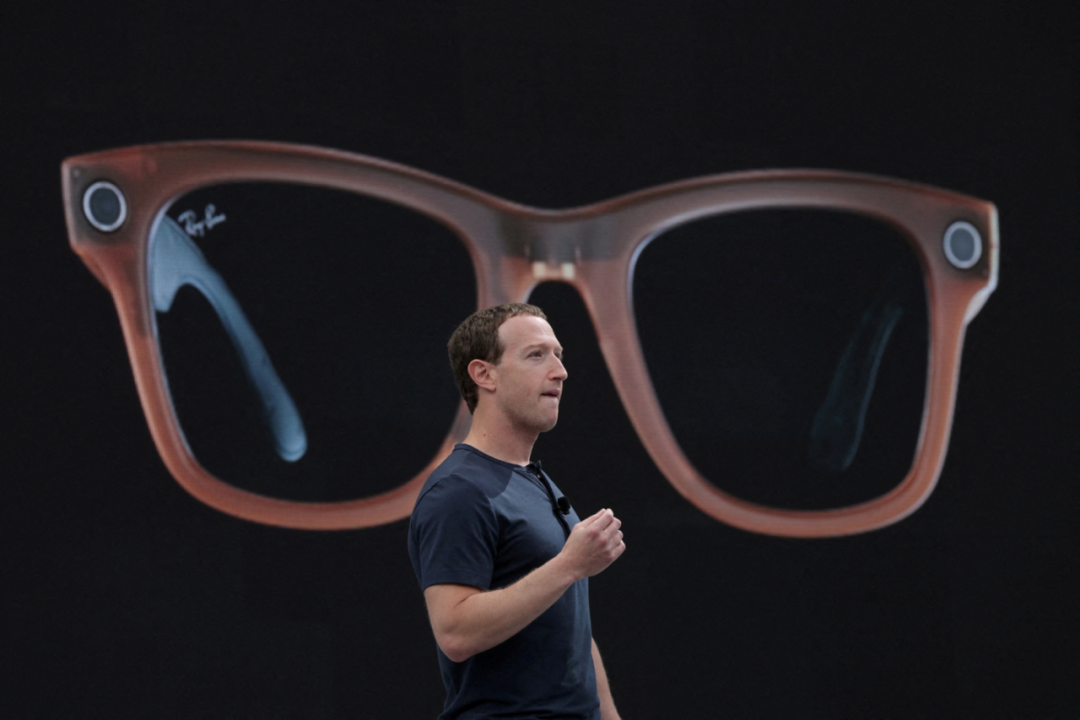

Las gafas de IA son ‘difíciles de usar’ pero atraen la inversión continua de los fabricantes; coexisten la educación del mercado y los desafíos técnicos : A pesar de las bajas ventas del Apple Vision Pro y la retroalimentación regular de los usuarios de las gafas Xiaomi AI, las gafas de IA siguen atrayendo la inversión continua de los fabricantes. El mercado predice que los envíos de gafas AR/AI superarán los 100 millones de unidades para 2028, con un mercado de interacción espacial inteligente valorado en billones. Los fabricantes creen que la fusión de los grandes modelos de IA y la tecnología AR dará lugar a una nueva generación de interacción humano-máquina, resolviendo los puntos débiles de los terminales tradicionales. Sin embargo, las gafas de IA se enfrentan a desafíos como la ansiedad por la batería, la interacción poco intuitiva y la crisis de confianza generada por las cámaras. La inversión continua de los fabricantes tiene como objetivo resolver los problemas técnicos, asegurar la entrada futura de la IA y explorar vías de comercialización a través de la venta de hardware y las suscripciones de contenido. (Fuente: 36氪)

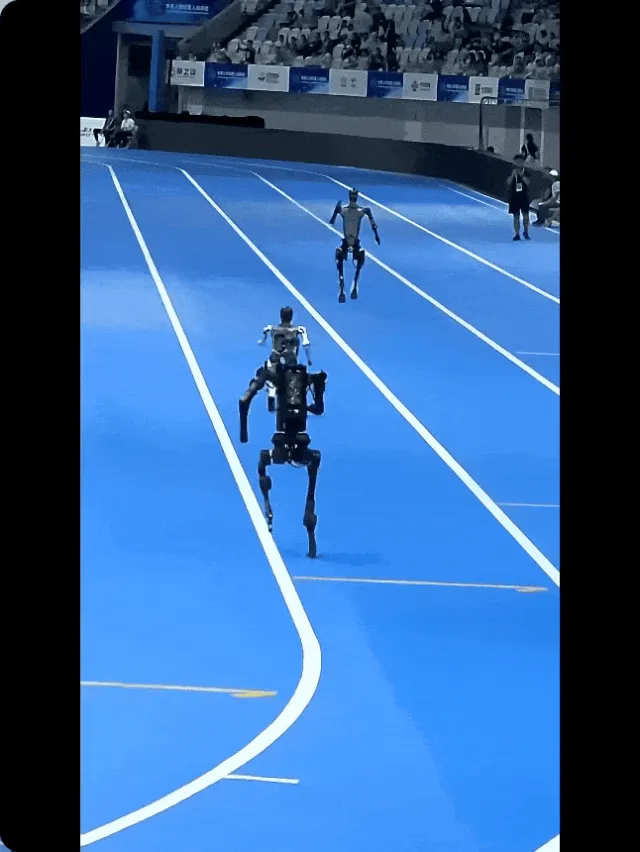

Detrás de la ‘inteligencia encarnada’ de los robots humanoides: aún requiere mucha intervención humana : Las redes sociales y los informes de noticias revelan que, a pesar del rápido desarrollo de la inteligencia encarnada y la tecnología de robots humanoides, su aplicación práctica todavía depende en gran medida de la intervención humana. Detrás de la “carrera desenfrenada” en las competiciones de robots, a menudo hay ingenieros controlando a distancia. Campos como la conducción autónoma y la logística de almacenes también emplean un modelo de “mano de obra en la sombra”, donde los humanos “infunden alma” a los robots a través de la operación remota, compensando sus deficiencias en entornos complejos. Aunque este modelo híbrido humano-máquina es costoso, es una forma efectiva de enseñar habilidades a los robots en la etapa actual, y también ha provocado discusiones sobre las ventajas de la eficiencia de la automatización y el tratamiento de la transición de los trabajadores. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, 36氪)

La comunidad de Reddit debate las capacidades matemáticas de GPT-5 y las limitaciones de los benchmarks de modelos de IA : La comunidad de Reddit ha debatido intensamente sobre las “nuevas” capacidades matemáticas de GPT-5. Algunos usuarios señalan que las pruebas de GPT-5 difieren de los artículos existentes, pero otros cuestionan si son realmente “novedosas” o simplemente una integración de información después de una búsqueda. Además, los resultados del benchmark de DeepSeek V3.1 también han provocado una discusión sobre la validez de los benchmarks de LLM, con muchos usuarios argumentando que los benchmarks ya no son suficientes para reflejar la verdadera capacidad y el “Vibe” de los modelos, prefiriendo la experiencia de pruebas personales. Esto refleja la continua atención y controversia de la comunidad sobre el rendimiento real de los modelos de IA y los métodos de evaluación. (Fuente: Reddit r/ChatGPT, Reddit r/LocalLLaMA)

Auge de la fiebre de la IA en el trading de acciones, los jóvenes la ven como ‘asesor de inversiones’ : Con la mejora del mercado de valores chino y el auge de los grandes modelos nacionales, cada vez más jóvenes están intentando utilizar la IA como “asesor de gestión de inversiones” para operar en bolsa. Algunos usuarios han obtenido ganancias flotantes seleccionando acciones y fondos con IA, creyendo que la IA puede integrar noticias e informes de investigación para filtrar rápidamente acciones conceptuales. Sin embargo, otros usuarios señalan que la calidad de la salida de la IA depende en gran medida de los datos y los prompts, y que a menudo produce alucinaciones. Algunos grandes modelos han dejado de recomendar acciones individuales por motivos de cumplimiento y enfatizan los riesgos de inversión. Las casas de bolsa también han lanzado herramientas de asesoramiento de IA, ofreciendo servicios de pago como selección de acciones por IA y optimización de carteras, pero todas incluyen cláusulas de exención de responsabilidad, advirtiendo a los inversores que asuman sus propios riesgos. (Fuente: 36氪)

Usuarios de Reddit discuten si ChatGPT fue entrenado con libros completos : Usuarios de la comunidad de Reddit han debatido si ChatGPT fue entrenado con libros completos. Algunos usuarios creen que los LLM son entrenados con todo el texto accesible, incluyendo libros completos, pero que no “copian y pegan” o “memorizan” el contenido de los libros, sino que aprenden patrones de palabras y relaciones conceptuales. Otros usuarios, sin embargo, creen que ChatGPT solo conoce resúmenes de libros, o que busca información en la web al responder. La discusión refleja la confusión del público sobre los mecanismos internos de los LLM y la exploración de las fuentes de conocimiento y la capacidad de “comprensión” de la IA. (Fuente: Reddit r/ArtificialInteligence)

Creación de contenido de video con IA: la trayectoria de evolución de ‘absurdo’ a ‘mainstream’ : La discusión en redes sociales señala que el contenido de video con IA está experimentando una trayectoria de evolución de “absurdo, incómodo, divertido” a “peligroso” y luego a “universal, evidente”. Actualmente, los videos de IA todavía muestran claras marcas de generación, pero a medida que la tecnología avance, su calidad mejorará rápidamente. En el futuro, los videos de IA podrían generar controversia sobre la “desaparición de la ventaja en la producción de video”, pero finalmente se convertirán en mainstream, al igual que cualquier tecnología disruptiva en la historia, siendo ampliamente aceptados y utilizados. (Fuente: BrivaelLp)

💡 Otros

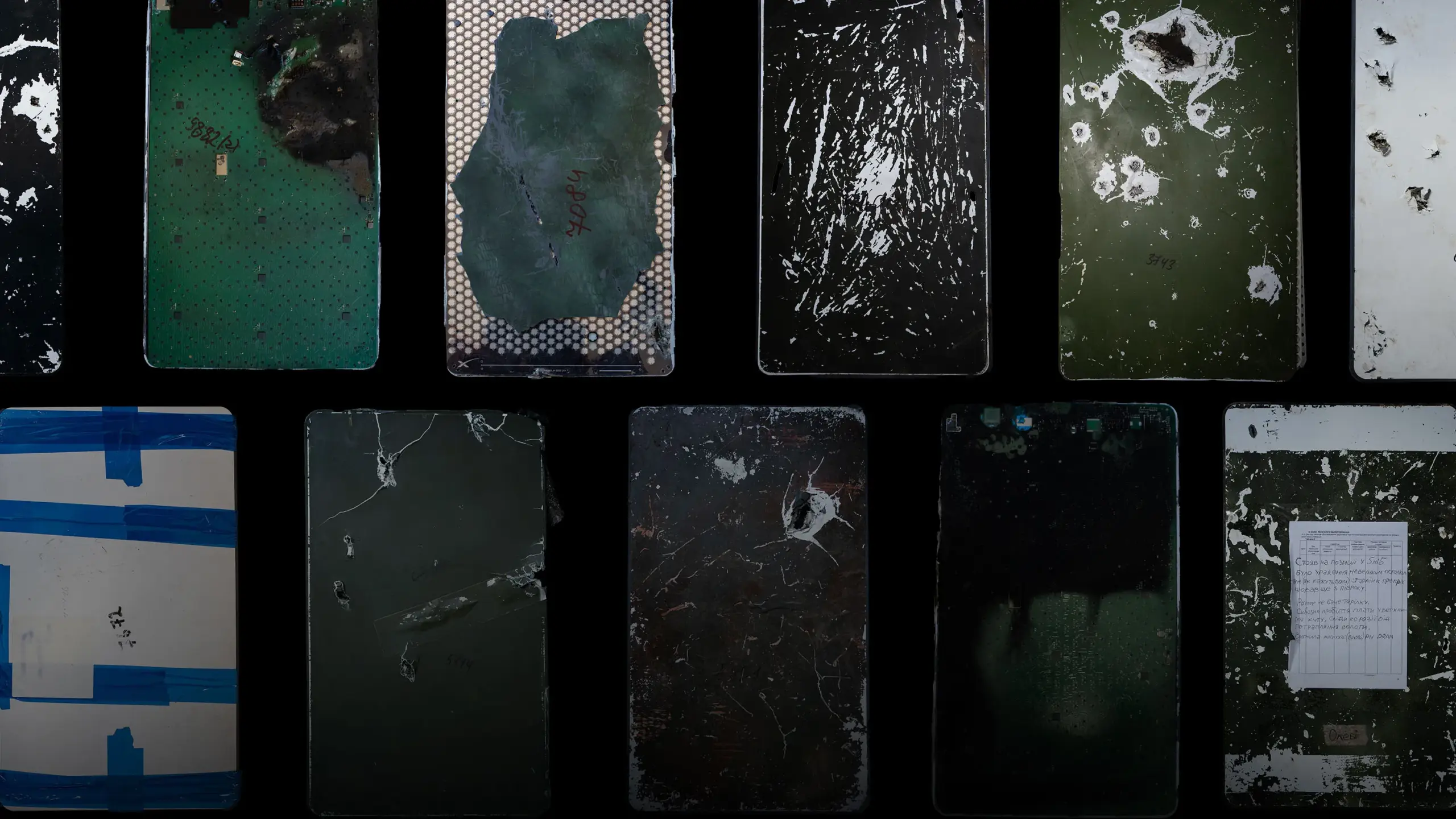

Taller de reparación de Starlink en Ucrania: el papel clave de la sociedad civil en el soporte tecnológico en tiempos de guerra : El taller de reparación de Starlink más grande de Ucrania, dirigido por el equipo civil de Oleh Kovalskyy, ha reparado y personalizado más de 15,000 terminales Starlink durante la guerra ruso-ucraniana. A pesar de la criticada calidad de los equipos Starlink y la incertidumbre de los cambios de política de Elon Musk, esta red civil, a través de una operación eficiente y flexible, ha proporcionado un soporte de comunicaciones crucial para el ejército ucraniano, compensando la lentitud de los procesos oficiales. Este caso subraya la indispensabilidad de las fuerzas tecnológicas civiles en entornos extremos para garantizar el funcionamiento de infraestructuras clave y mejorar la eficacia militar. (Fuente: MIT Technology Review)

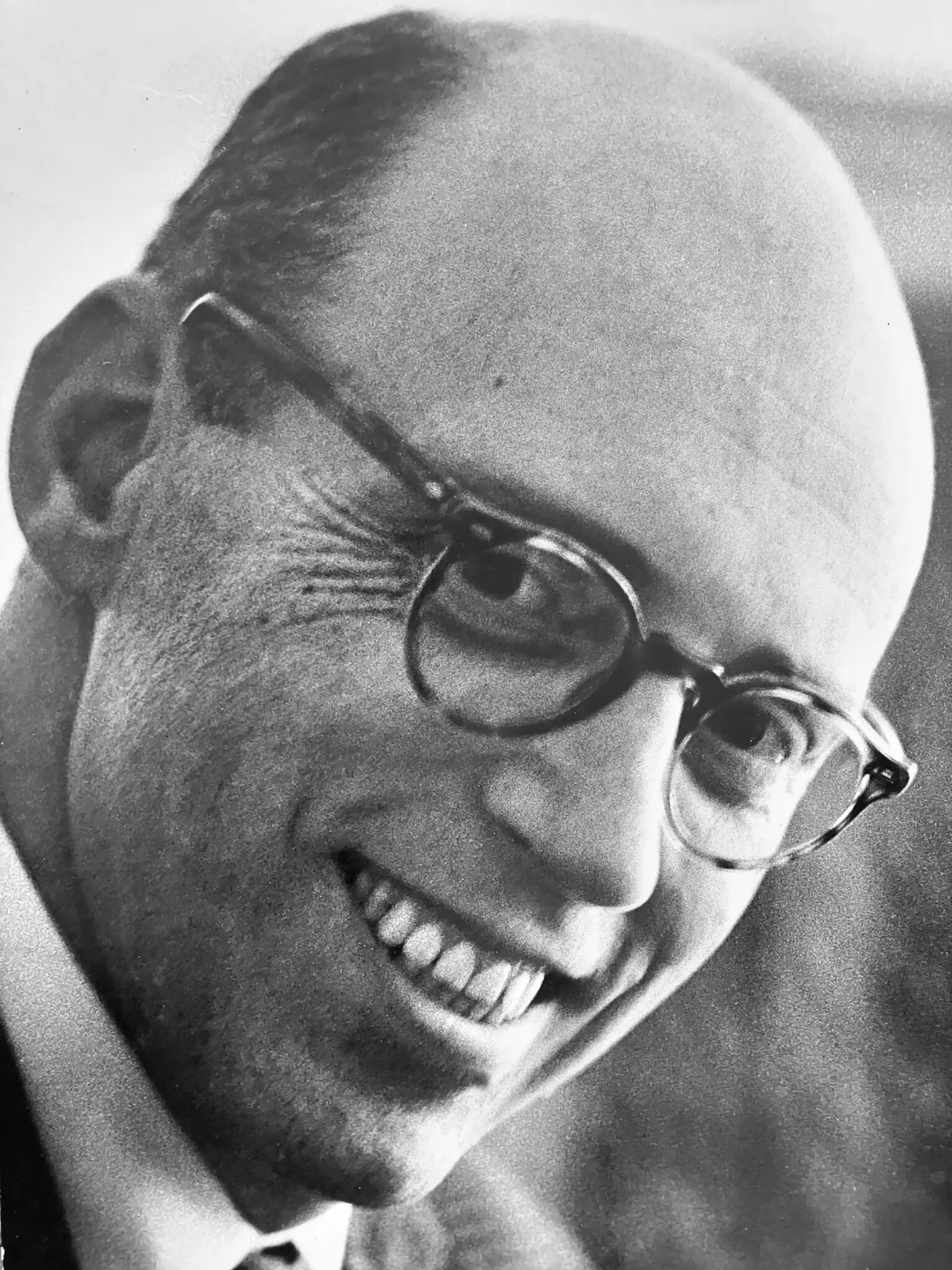

Fallece Warren Brodey, el ‘oponente’ de Marvin Minsky, padre de la IA, a los 101 años : El pionero de la IA, Warren Brodey, falleció a la edad de 101 años. Este pensador, psiquiatra de formación, exploró desde los inicios de la IA en el MIT cómo la tecnología podía liberar el potencial humano. Con su experiencia en cibernética, realizó investigaciones pioneras sobre sistemas complejos y tecnología reactiva, y abogó por que la IA debía aumentar, no reemplazar, a los humanos. Brodey no estaba de acuerdo con el camino de la IA basado en grandes volúmenes de datos de Marvin Minsky, y dedicó su vida a defender una IA “flexible” que pudiera inspirar la creatividad humana, advirtiendo contra la posibilidad de que el capitalismo dirigiera la tecnología hacia la rigidez. (Fuente: 36氪)

Pewdiepie construye un PC de IA con 160 GB de VRAM, lo que podría iniciar un nuevo capítulo para los LLM locales : El conocido youtuber Pewdiepie ha construido un PC de IA equipado con 160 GB de VRAM y planea ejecutar el modelo Llama 3 70B en él. Esta acción ha generado una acalorada discusión en la comunidad de Reddit, con muchos sorprendidos por la incursión de Pewdiepie en el campo de los LLM locales, y especulando que esto podría presagiar que los modelos de IA locales se volverán aún más mainstream. A pesar de la configuración no tradicional, su potencial para la descarga de CPU y futuras actualizaciones de memoria muestra el gran interés de los usuarios individuales en las aplicaciones de IA locales de alto rendimiento. (Fuente: Reddit r/LocalLLaMA)