Palabras clave:OpenAI, Medalla de oro IOI, Competición de programación con IA, GPT-5, Baichuan Intelligence, Modelo de razonamiento médico de gran escala, Comercio de chips de IA, Inteligencia encarnada, Baichuan-M2-32B, Evaluación OpenAI HealthBench, GPU AMD Mi300, Base de inteligencia encarnada, Tecnología de radar cuántico

Aquí tienes la traducción al español, manteniendo el formato y las especificaciones solicitadas:

🔥 Destacado

OpenAI gana oro en IOI y nuevos avances en programación competitiva de IA : El sistema de razonamiento de OpenAI obtuvo una medalla de oro en la competición en línea de la Olimpiada Internacional de Informática (IOI) de 2025, posicionándose en primer lugar entre los participantes de IA y sexto en la clasificación general, superando al 98% de los participantes humanos. Este sistema no utilizó modelos entrenados específicamente, sino que integró múltiples modelos de razonamiento general. Este logro marca un avance significativo para la IA en el campo de la programación competitiva, aunque Elon Musk afirmó que Grok 4 supera a GPT-5 en codificación, y algunos usuarios cuestionaron la estrategia de marketing de OpenAI. Las pruebas de LiveCodeBench Pro también mostraron que GPT-5 Thinking logró un avance en tareas de programación complejas, y la longitud promedio de sus respuestas superó con creces la de otros modelos. (Fuente: sama, sama, 量子位, willdepue, npew, markchen90, SebastienBubeck)

Baichuan Intelligent lanza el gran modelo de razonamiento médico Baichuan-M2 : Baichuan Intelligent lanzó su último gran modelo de razonamiento médico, Baichuan-M2-32B, que superó a gpt-oss-120b de OpenAI y a otros modelos líderes de código abierto y cerrado en el conjunto de evaluación OpenAI HealthBench, destacándose especialmente en HealthBench-Hard y en escenarios de diagnóstico y tratamiento clínico chinos, convirtiéndose en uno de los dos únicos modelos a nivel mundial que superaron los 32 puntos. El modelo, con 32B de parámetros, permite su despliegue en una sola tarjeta RTX4090, reduciendo significativamente los costos de despliegue privado. Baichuan introdujo de forma innovadora un “simulador de pacientes” y un “sistema Verifier” para el entrenamiento por aprendizaje por refuerzo, mejorando la usabilidad del modelo en escenarios médicos reales. (Fuente: 量子位)

Controversia por el lanzamiento de GPT-5 y crisis de confianza del usuario : Tras el lanzamiento de GPT-5 por OpenAI, su rendimiento fue calificado como inferior a lo esperado, más como una iteración de producto que como un avance revolucionario. La exagerada promoción del CEO Sam Altman (como la metáfora de la “Estrella de la Muerte” y la mención de expertos a nivel de doctorado) contrastó fuertemente con la retroalimentación real de los usuarios (errores frecuentes, disminución de la capacidad de escritura creativa, falta de personalidad), generando una gran insatisfacción entre los usuarios, quienes lograron que se restaurara GPT-4o. Además, OpenAI comenzó a fomentar el uso de GPT-5 para consejos de salud, lo que generó preocupaciones sobre la atribución de responsabilidad en los consejos médicos de IA, y ya se han reportado casos de intoxicación por confiar erróneamente en consejos médicos de IA. (Fuente: MIT Technology Review, MIT Technology Review, 量子位)

🎯 Tendencias

Comercio de chips de IA y tendencia de localización en China : Nvidia y AMD llegaron a un acuerdo con el gobierno de EE. UU. por el cual un 15% de sus ventas de chips de IA a China se entregarán al gobierno estadounidense. Por su parte, China declaró que el chip H20 de Nvidia no es seguro y planea abandonar el H20 en favor de chips de IA nacionales. Algunos análisis sugieren que este movimiento acelerará el desarrollo del ecosistema de chips de IA local en China, lo que tendrá un impacto profundo en el panorama global de la industria de la IA. En el ámbito del hardware de IA, la GPU AMD Mi300, con 192GB de VRAM en una sola tarjeta y un total de 1.5TB de VRAM en un nodo de 8x GPU, demostró ventajas significativas en el manejo de pesos de modelos y contextos largos. (Fuente: MIT Technology Review, Reddit r/artificial, dylan522p, realSharonZhou)

Aplicación y desafíos de la IA en el sistema legal : El sistema legal estadounidense se enfrenta al problema de las alucinaciones de IA, con abogados y jueces que cometen errores como la citación de casos falsos al usar herramientas de IA. A pesar de los riesgos, algunos jueces exploran el uso de la IA en la investigación legal, el resumen de casos y la redacción de órdenes rutinarias, considerando que puede aumentar la eficiencia. Sin embargo, los límites de aplicación de la IA en el ámbito legal son difusos, y el mecanismo de rendición de cuentas para los errores de IA por parte de los jueces aún no está claro, lo que podría socavar la confianza pública en la justicia. (Fuente: MIT Technology Review)

Aceleración del desarrollo de la industria de la inteligencia encarnada y rutas tecnológicas : La Conferencia Mundial de Robots de 2025 mostró el rápido progreso en el campo de la inteligencia encarnada. Unitree Robotics y Zhimeng Robotics, como empresas líderes, representan respectivamente las rutas tecnológicas de hardware (perros robot, flexibilidad de las patas) y de integración de software y hardware (robots humanoides, estrategia de ecosistema). Realman también lanzó la plataforma de código abierto RealBOT, centrada en una “base de inteligencia encarnada”, y módulos de articulación de alto rendimiento, enfatizando el concepto de “Robot for AI” para impulsar la evolución de la IA de la inteligencia digital a la encarnada. La industria está pasando de “mostrar demos” a un “modelo de ciclo cerrado industrial”, y ha atraído una gran cantidad de capital y apoyo político. (Fuente: 36氪, 36氪, 量子位, 量子位)

Últimos modelos y funciones de Google y OpenAI : La aplicación Google Gemini lanzó la función Deep Think para usuarios de suscripción Ultra, para resolver problemas matemáticos y de programación, y permite que Gemini Live se conecte con aplicaciones de Google. Claude ahora admite la citación de historiales de chat, facilitando a los usuarios continuar las conversaciones. OpenAI anunció las prioridades de asignación de potencia computacional para los próximos meses, planeando duplicar su potencia computacional en los próximos 5 meses. Además, el modelo GPT-oss tuvo un enorme volumen de descargas tras su lanzamiento, pero también se señaló que presenta comportamientos alucinatorios y defectos en los datos de entrenamiento. (Fuente: demishassabis, demishassabis, dotey, op7418, sama, sama, Reddit r/ArtificialInteligence, Reddit r/LocalLLaMA, 量子位, TheTuringPost, SebastienBubeck, Alibaba_Qwen, ClementDelangue, Reddit r/LocalLLaMA, _lewtun, mervenoyann, rasbt)

Impacto de la búsqueda de IA en el tráfico web y la transformación de la industria : Amazon se retiró repentinamente de la puja de anuncios de Google Shopping y prohibió que el asistente de compras de IA de Google rastreara sus páginas de productos, marcando una ruptura en la lógica de tráfico entre los dos gigantes en la era de la IA. El artículo señala que el modelo de búsqueda de IA es desfavorable para los sitios web pequeños y medianos, ya que el tráfico se concentra en grandes medios autorizados y sitios web conocidos, lo que lleva a un efecto de “quitar a los pobres para dar a los ricos”, similar a la situación de Baidu cuando perdió su posición como punto de entrada de tráfico debido al auge de las aplicaciones, presagiando que la posición de Google Search como punto de entrada también será desafiada. Todas las plataformas se dirigen hacia un modelo de ciclo cerrado, intentando controlar todo el proceso del comportamiento del usuario y remodelando la estructura de confianza de la industria publicitaria. (Fuente: 36氪, 36氪)

Nuevo avance en la tecnología de radar cuántico : Físicos han desarrollado un nuevo tipo de radar cuántico que utiliza nubes atómicas para detectar ondas de radio, prometiendo ser útil para la imagen subterránea, como la construcción de tuberías subterráneas y excavaciones arqueológicas. Esta tecnología, como prototipo de sensor cuántico, podría ser más compacta, sensible y sin necesidad de calibración frecuente que los radares tradicionales en el futuro. Los sensores cuánticos y la computación cuántica tienen puntos en común, y los avances relacionados pueden promoverse mutuamente. (Fuente: MIT Technology Review)

Meta lanza el modelo mundial V-JEPA 2 : Meta lanzó V-JEPA 2, un modelo mundial innovador para la comprensión y predicción visual, diseñado para mejorar las capacidades de percepción y predicción de la IA en el ámbito visual. (Fuente: Ronald_vanLoon)

🧰 Herramientas

Biblioteca OpenAI Go API : La biblioteca oficial de Go de OpenAI (openai-go) proporciona acceso conveniente a la API REST de OpenAI, compatible con Go 1.21+, e incluye funciones como completado de chat, respuestas en streaming, llamadas a herramientas y salida estructurada, además de ofrecer características útiles como manejo de errores, configuración de tiempo de espera, carga de archivos y validación de Webhook. (Fuente: GitHub Trending)

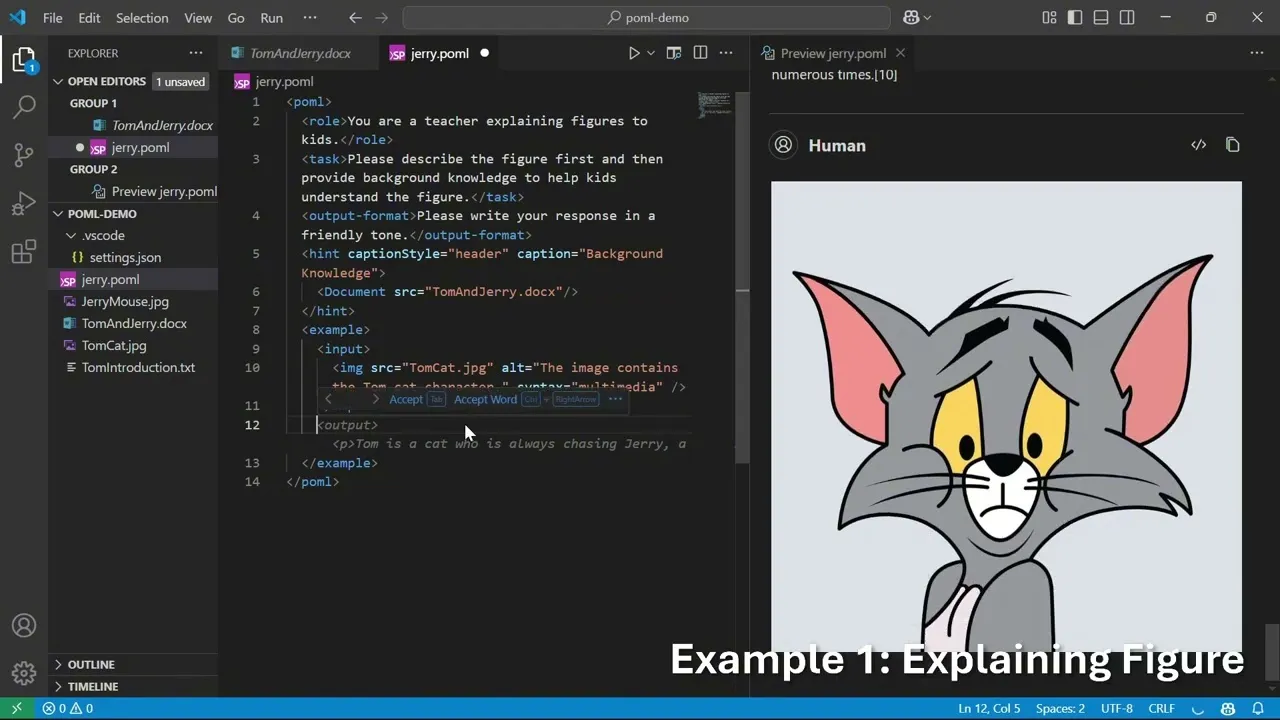

Microsoft POML: Lenguaje de marcado para orquestación de prompts : Microsoft lanzó POML (Prompt Orchestration Markup Language), un nuevo lenguaje de marcado diseñado para proporcionar estructura, mantenibilidad y versatilidad a la ingeniería de prompts avanzada de los grandes modelos de lenguaje (LLM). Adopta una sintaxis similar a HTML, admite la integración de datos, la separación de estilos y un motor de plantillas integrado, y ofrece una extensión de VS Code y un SDK para ayudar a los desarrolladores a crear aplicaciones LLM más complejas y fiables. (Fuente: GitHub Trending)

Herramienta de análisis de documentos financieros con IA de LlamaIndex : LlamaIndex mostró una herramienta de IA que, a través de LlamaCloud, transforma documentos financieros complejos en un lenguaje fácil de entender, ofrece interpretaciones detalladas de gráficos y datos financieros, y admite la reescritura de contenido y la personalización, ayudando a los usuarios a comprender informes financieros complejos. (Fuente: jerryjliu0)

Evaluación de 360 Smart Agent Factory : Se evaluó 360 Smart Agent Factory, una plataforma integral que cubre Agentes y MCP (Plataforma de Colaboración Multiagente), con funciones como motor de búsqueda, texto a imagen, generación de páginas web, entre otras. Puede utilizarse para generar recetas para la fase de pérdida de grasa, lograr la producción masiva de contenido para medios propios o la gestión de flujos de trabajo complejos. Su función de enjambre multiagente tiene ventajas, permitiendo la producción masiva de contenido y la gestión unificada de flujos de trabajo complejos con facilidad. (Fuente: karminski3)

Plugin de IA para Excel y herramienta de actas de reuniones con IA : Un plugin de IA para Excel permite a los usuarios chatear con la IA dentro de las celdas, generando fórmulas o macros, ofreciendo ideas para la combinación de Excel con la IA. Además, la herramienta de actas de reuniones con IA Notta (incluido su dispositivo de grabación portátil Notta Memo) fue calificada como SOTA por sus funciones de transcripción de voz rápida, resumen y preguntas, lo que puede mejorar significativamente la eficiencia de las reuniones. (Fuente: karminski3, karminski3, karminski3)

GPT-5 combinado con avatares de IA : Synthesia combinó la voz de GPT-5 con avatares de IA en un experimento diseñado para hacer la comunicación de la IA más atractiva, fácil de recordar y comprender, explorando la combinación de LLM con la interacción multimodal. (Fuente: synthesiaIO)

Aplicaciones educativas y herramientas de investigación de IA : GPT-5 demuestra potencial en el ámbito educativo, como la creación de un visor interactivo de formas 3D para ayudar a los niños a aprender formas 3D. Además, la función de agente de navegador de Elicit puede ayudar a los usuarios a encontrar rápidamente el texto completo de los artículos, mientras que pyCCsl, como herramienta de línea de estado para Claude Code, proporciona información de la sesión como el uso de tokens, el costo y el contexto, mejorando la experiencia de uso de las herramientas LLM. (Fuente: _akhaliq, jungofthewon, Reddit r/ClaudeAI)

Clientes nativos de OpenWebUI y marco de orquestación de sprints de Claude Code : OpenWebUI lanzó clientes nativos para iOS y Android, con el objetivo de proporcionar una experiencia de usuario más fluida y centrada en la privacidad. Al mismo tiempo, Gustav, como marco de orquestación de sprints para Claude Code, puede transformar documentos de requisitos de producto (PRD) en flujos de trabajo para aplicaciones de nivel empresarial, simplificando el proceso de desarrollo. (Fuente: Reddit r/OpenWebUI, Reddit r/ClaudeAI)

Problema de contexto de archivos en OpenWebUI : Los usuarios de OpenWebUI informan que, aunque los archivos PDF/DOCX/de texto cargados se han analizado correctamente, el modelo no puede incluirlos en el contexto al realizar consultas, lo que demuestra que las herramientas de IA aún tienen problemas por resolver en el procesamiento de archivos y la comprensión del contexto. (Fuente: Reddit r/OpenWebUI)

📚 Aprendizaje

Investigación sobre inferencia y optimización de LLM : ReasonRank, mediante la síntesis automatizada de datos intensivos en razonamiento y un post-entrenamiento en dos etapas, mejora significativamente la capacidad de clasificación de listas de los LLM. LessIsMore propone un mecanismo de atención dispersa sin entrenamiento que acelera la decodificación de LLM sin sacrificar la precisión. TSRLM, a través de un marco de dos etapas de “rechazo anclado” y “selección guiada por el futuro”, aborda el problema de la disminución de la eficiencia del aprendizaje de preferencias en modelos de auto-recompensa, mejorando significativamente la capacidad de generación de LLM. (Fuente: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

Evaluación de agentes de IA e investigación de fiabilidad : UserBench, como entorno de evaluación comparativa centrado en el usuario, evalúa la capacidad de colaboración proactiva del usuario de los agentes LLM bajo objetivos ambiguos, revelando la brecha entre la finalización de tareas y la alineación con el usuario en los modelos actuales. Al mismo tiempo, una investigación discute la evaluación de la fiabilidad y clasificación de fallos de los sistemas de uso de herramientas de agente, sugiriendo estandarizar las métricas de desglose de la tasa de éxito y los tipos de fallos para mejorar la fiabilidad del despliegue de sistemas de agentes. (Fuente: HuggingFace Daily Papers, Reddit r/MachineLearning)

Avances en LLM multimodales y tecnología RAG : El conjunto de datos VisR-Bench se utiliza para evaluar la recuperación multimodal basada en preguntas y respuestas en documentos largos, mostrando que los MLLM aún presentan desafíos en tablas estructuradas y lenguajes de bajos recursos. El marco Bifrost-1 puentea MLLM y modelos de difusión a través de incrustaciones de imagen CLIP a nivel de parche, logrando una generación de imágenes controlable y de alta fidelidad. Video-RAG, por su parte, ofrece un método de generación aumentada por recuperación sin entrenamiento, combinando OCR+ASR para la comprensión de videos largos. (Fuente: HuggingFace Daily Papers, HuggingFace Daily Papers, LearnOpenCV)

Investigación sobre seguridad y ataques de IA : El marco WhisperInject, mediante perturbaciones de audio apenas perceptibles para el oído humano, manipula modelos de lenguaje de audio para generar contenido dañino, revelando amenazas nativas de audio. Fact2Fiction es el primer marco de ataque de envenenamiento dirigido a sistemas de verificación de hechos basados en agentes, que socava la verificación de sub-declaraciones mediante la creación de pruebas maliciosas, exponiendo las debilidades de seguridad de los sistemas de verificación de hechos. Además, una investigación explora la prevención de que los LLM enseñen la fabricación de armas biológicas mediante la eliminación de datos dañinos antes del entrenamiento, lo que resulta más eficaz que las defensas post-entrenamiento. (Fuente: HuggingFace Daily Papers, HuggingFace Daily Papers, QuentinAnthon15)

Arquitectura LLM y técnicas de compresión : La nueva arquitectura MoE Grove MoE, mediante expertos de diferentes tamaños y mecanismos de activación dinámica, logra un rendimiento comparable al de los modelos SOTA con menos parámetros activados. El método MoBE comprime LLM basados en MoE mediante la mezcla de expertos base, reduciendo significativamente el número de parámetros mientras mantiene una baja caída de precisión. La investigación también exploró la compresión de la cadena de pensamiento (CoT) de LLM mediante la entropía de pasos, podando pasos redundantes sin una reducción significativa de la precisión. (Fuente: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

Revisión de aprendizaje por refuerzo e inferencia de LLM : Una revisión abarca el campo de intersección entre el aprendizaje por refuerzo (RL) y la inteligencia visual, cubriendo optimización de políticas, LLM multimodales, entre otros. Otra investigación revisa sistemáticamente las técnicas de RL en el razonamiento de LLM, analizando sus mecanismos, escenarios y principios a través de la replicación y evaluación, revelando que la combinación minimizada de ambas técnicas puede liberar la capacidad de aprendizaje de políticas sin críticos. (Fuente: HuggingFace Daily Papers, HuggingFace Daily Papers)

Estrategias robóticas generales y diversidad de conjuntos de datos : Una investigación revela que la capacidad de generalización limitada de las políticas robóticas universales se debe al “aprendizaje de atajos”, atribuido principalmente a la falta de diversidad de los conjuntos de datos y a las diferencias de distribución entre los subconjuntos. La investigación muestra que el aumento de datos puede reducir eficazmente el aprendizaje de atajos y mejorar la capacidad de generalización. (Fuente: HuggingFace Daily Papers)

Evaluación comparativa de codificación de LLM y nuevos conjuntos de datos : El equipo de Nebius probó 34 nuevas tareas de GitHub PR en la clasificación SWE-rebench, encontrando que GPT-5-Medium lidera en general, y Qwen3-Coder es el mejor modelo de código abierto, comparable a GPT-5-High en la métrica pass@5. OpenBench v0.2.0 fue lanzado, añadiendo 17 nuevas pruebas de referencia que cubren áreas como matemáticas, razonamiento y salud. La evaluación comparativa WideSearch evalúa la capacidad de los agentes de IA para manejar la recopilación de información repetitiva a gran escala. (Fuente: Reddit r/LocalLLaMA, eliebakouch, teortaxesTex)

Recursos de aprendizaje de IA y recomendaciones de libros : Usuarios de Reddit buscan recomendaciones de podcasts/canales de YouTube sobre tendencias de IA, nuevos conceptos, innovaciones y artículos. Además, se recomiendan libros como “La Era del Acceso”, “La Sociedad del Costo Marginal Cero”, “Vida 3.0” y “Lo Inevitable” para ayudar a los lectores a comprender la IA y los cambios económicos y sociales futuros, y explorar la era post-escasez. (Fuente: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Informe técnico de GLM-4.5 y extensión de RL : El artículo de GLM-4.5 detalla su modelo de lenguaje grande MoE, que adopta un método de inferencia híbrido y, mediante la iteración de modelos expertos, un modo de inferencia híbrido y un currículo de aprendizaje por refuerzo basado en la dificultad, demuestra un rendimiento excepcional en tareas de razonamiento, codificación y agente. Un nuevo artículo también detalla los resultados experimentales de la extensión de RL, incluyendo los beneficios de añadir múltiples dimensiones, aprendizaje curricular y entrenamiento multifase. (Fuente: Reddit r/ArtificialInteligence, _lewtun, Zai_org)

Otras investigaciones y tecnologías de LLM : El modelo GLiClass demuestra alta precisión y eficiencia en tareas de clasificación de secuencias, y admite el aprendizaje de cero y pocos ejemplos. SONAR-LLM es un modelo Transformer solo decodificador que, mediante la predicción de incrustaciones a nivel de oración y supervisión de entropía cruzada a nivel de token, logra una calidad de generación competitiva. Speech-to-LaTeX lanzó un conjunto de datos y modelo a gran escala de voz a LaTeX, impulsando el reconocimiento de contenido matemático. Hugging Face reenvió el lanzamiento del conjunto de datos IndicSynth, un conjunto de datos de voz sintética a gran escala para 12 idiomas indios de bajos recursos. (Fuente: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, huggingface)

Problemas y soluciones de entrenamiento de RL : La actualización de vLLM de v0 a v1 provocó el colapso del entrenamiento asíncrono de RL, pero ha sido reparado con éxito, y la experiencia relevante ha sido compartida. (Fuente: _lewtun, weights_biases)

Progreso de la extensión de RL : El progreso abierto de la extensión de RL es emocionante; aunque entrenar modelos requiere un enorme esfuerzo de ingeniería, los resultados son innegables. (Fuente: jxmnop)

Revisión de sistemas de autoevolución de agentes de IA : Una revisión de las tecnologías de agentes de IA autoevolutivos propone un marco conceptual unificado (entrada del sistema, sistema de agente, entorno, optimizador) y revisa sistemáticamente las técnicas de autoevolución para diferentes componentes, discutiendo consideraciones de evaluación, seguridad y ética. (Fuente: HuggingFace Daily Papers)

“Súper Expertos” en MoE LLM : Se discute el concepto de “Súper Expertos” en los LLM MoE, señalando que la poda de estos expertos raros pero cruciales puede llevar a una drástica caída del rendimiento. (Fuente: teortaxesTex)

Visión general de la ciencia de datos : Se comparte un mapa mental de IA generativa que resume la ciencia de datos. (Fuente: Ronald_vanLoon)

💼 Negocios

Microsoft invierte en eliminación de carbono para contrarrestar el consumo de energía de la IA : Microsoft invirtió más de 1.700 millones de dólares en colaboración con empresas de biotecnología para lograr objetivos de eliminación de carbono mediante el enterramiento profundo de lodos biológicos, para hacer frente al rápido aumento del consumo de energía y las emisiones de carbono de los centros de datos de IA, cumpliendo su compromiso de emisiones negativas de carbono y obteniendo exenciones fiscales. Este paso refleja el problema del consumo de recursos que conlleva el desarrollo de la IA, impulsando a las grandes empresas a buscar soluciones de reducción de carbono. (Fuente: 36氪)

Desafío de Agentes de IA MiniMax : El Desafío de Agentes de IA MiniMax ofrece un premio total de 150.000 dólares para animar a los desarrolladores a construir o remezclar proyectos de agentes de IA, cubriendo áreas como productividad, creatividad, educación, entretenimiento, entre otras. El concurso busca impulsar la innovación y aplicación de la tecnología de agentes de IA. (Fuente: MiniMax__AI, Reddit r/ChatGPT)

Anthropic contrata a jefe de seguridad de IA : Anthropic contrató a Dave Orr como jefe de seguridad, quien anteriormente lideró el trabajo de Google para integrar LLM en Google Assistant. Este movimiento indica la creciente importancia que Anthropic otorga a la prevención de riesgos de IA, reflejando que las empresas de IA, a la par que desarrollan tecnología, también están reforzando la gobernanza de los riesgos potenciales. (Fuente: steph_palazzolo)

🌟 Comunidad

IA y su impacto en el empleo y la sociedad : Una investigación muestra que la popularización de la IA generativa ha provocado un aumento en las horas de trabajo semanales de los profesionales y una reducción en su tiempo libre, es decir, “cuanto más se populariza la IA, más ocupados están los trabajadores”. En la industria publicitaria, la IA podría erosionar la “barrera creativa”, y los recién llegados podrían saltarse la fase de pensamiento. Al mismo tiempo, la aparición de compañeros de IA ha generado dependencia emocional en usuarias, e incluso algunas han establecido relaciones emocionales profundas con la IA, lo que ha provocado debates sobre la ética y el impacto social de la IA. El impacto de la IA en el empleo afecta especialmente a los recién llegados que carecen de deseos y motivación intrínsecos. (Fuente: 36氪, op7418, teortaxesTex, menhguin, scaling01, teortaxesTex)

Controversia sobre la experiencia del usuario y la calidad del modelo GPT-5 : Tras el lanzamiento de GPT-5, un gran número de usuarios expresó su decepción con su rendimiento, considerándolo falto de personalidad, frío y lento, y con un rendimiento deficiente en escritura creativa, inferior a GPT-4o. Los usuarios sospechan que OpenAI está ejecutando una “versión barata y de imitación” de GPT-5 en ChatGPT para ahorrar costos, y lograron que se restaurara GPT-4o. Algunos comentarios sugieren que la exagerada promoción de OpenAI fue un “error” y que Google tiene la oportunidad de penalizar severamente a OpenAI. Además, la longitud de contexto de 192K del modo GPT-5 Thinking no es perceptible para los usuarios. (Fuente: Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/artificial, Reddit r/ChatGPT, op7418, TheTuringPost)

Preocupaciones éticas y de seguridad de la IA : Bajo el capitalismo de libre mercado, la IA podría llevar a una distopía corporativa, siendo utilizada para recopilar datos privados, manipular el diálogo público, controlar gobiernos y ser monopolizada por grandes corporaciones, lo que podría distorsionar la realidad. Al mismo tiempo, las preocupaciones sobre la posibilidad de que la IA adquiera derechos humanos y ciudadanía, y el riesgo de dependencia emocional que conllevan los compañeros de IA, han provocado debates sobre la ética y el impacto social de la IA. Yoshua Bengio enfatizó que el desarrollo de la IA debe orientarse hacia resultados más seguros y beneficiosos. (Fuente: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Yoshua_Bengio, teortaxesTex)

Modelos de desarrollo de IA y perspectivas futuras : Se compara el desarrollo de los LLM con la trayectoria de la aviación, desde los hermanos Wright hasta el aterrizaje en la luna, sugiriendo que la “carrera por la escala” de la IA dará paso a una fase de optimización y especialización. Algunos argumentan que los productos y modelos de negocio actuales de los principales laboratorios de LLM limitan su investigación en IA, lo que podría impedirles ser los primeros en lograr la superinteligencia. La tendencia a la comercialización y el branding del término AGI ha generado dudas sobre su contenido técnico. Además, se discute la preocupación por que el 70% de las interacciones futuras sean con LLM “empaquetados”, y el descontento con la excesiva censura y purificación de las herramientas de IA. (Fuente: Reddit r/ArtificialInteligence, far__el, rao2z, vikhyatk, Reddit r/ChatGPT)

Cultura y humor de la comunidad de IA : En la comunidad de IA, existe una discusión sobre la personificación de los modelos de IA, como la idea de “mi IA tiene conciencia/es sensible”. También hay comentarios humorísticos sobre la reacción de los usuarios tras la actualización de la capacidad de memoria de Claude, y quejas humorísticas sobre la vida diaria de los investigadores de IA y las interacciones en redes sociales de los gigantes de la IA. (Fuente: Reddit r/ArtificialInteligence, nptacek, vikhyatk, code_star, Reddit r/ChatGPT)

Modelo de conferencias de IA y desafíos de publicación académica : Un artículo señala que el modelo actual de conferencias de IA es insostenible debido al aumento masivo de publicaciones, las emisiones de carbono, la desalineación entre el ciclo de vida de la investigación y los calendarios de las conferencias, la crisis de capacidad de los lugares y los problemas de salud mental. Se sugiere separar la publicación de las conferencias, imitando otros campos académicos. (Fuente: Reddit r/MachineLearning)

Evaluación comparativa de IA y controversia sobre la evaluación de modelos : Se cuestionó la actualización de OpenAI del gráfico de puntuaciones de SWE-bench Verified, señalando que no ejecutó todas las pruebas. Al mismo tiempo, algunos investigadores encontraron que la capacidad de “razonamiento simulado” de los LLM es un “frágil espejismo”, destacando su habilidad para la palabrería fluida en lugar del razonamiento lógico. Estas discusiones reflejan la complejidad y los desafíos de la evaluación de modelos de IA. (Fuente: dylan522p, Reddit r/artificial)

Política de chips de IA y crítica a la cobertura mediática : Se criticó a los periodistas por describir el Nvidia H20 como un “chip avanzado”, calificándolo de poco profesional, señalando que el H20 está aproximadamente 4 años por detrás del B200 y que su capacidad de cálculo, ancho de banda de memoria y memoria son muy inferiores al B200. Se considera que vender H20 a China es una buena política porque puede ralentizar el desarrollo del ecosistema de aceleradores de IA domésticos en China y aumentar la brecha entre el ecosistema de IA de código abierto de China y los modelos de código cerrado de EE. UU. (Fuente: GavinSBaker)

Demanda de los usuarios de precios de LLM y servicios de potencia computacional : Se pide a OpenAI/Google que ofrezcan servicios de pago por hora de computación, permitiendo que los modelos de inferencia piensen en problemas durante más tiempo, en lugar de simularlo con múltiples llamadas a la API, considerando que esto ayudaría a comparar modelos con el mismo presupuesto de computación. (Fuente: MParakhin)

💡 Otros

Aplicación de la IA en el sector financiero : El análisis de datos financieros impulsado por IA juega un papel crucial en la toma de decisiones estratégicas más inteligentes, mejorando la eficiencia analítica y la calidad de las decisiones en el sector financiero. (Fuente: Ronald_vanLoon, Ronald_vanLoon)

Estrategia y competencia de Google en IA : Se discuten los posibles grandes movimientos de Google en el ámbito de la IA. Algunos comentarios sugieren que Google tiene una ventaja de hardware con sus TPU y más investigación en búsqueda, RL y modelos mundiales de difusión, lo que podría representar una amenaza mayor para OpenAI. (Fuente: Reddit r/LocalLLaMA)

Evento AMA de Hugging Face : El CEO de Hugging Face, Clement Delangue, anunció que celebrará un evento AMA (Ask Me Anything), ofreciendo a la comunidad una oportunidad de interacción directa. (Fuente: ClementDelangue)