Palabras clave:Congreso Mundial de Robótica, Robots humanoides, Inteligencia encarnada, GPT-5, Gafas de IA, Google DeepMind, LangChain, Gafas Reality Proxy con IA, Simulador de mundo Genie 3, Índice vectorial LEANN, Llamadas gratuitas a Qwen Code, Servicio prioritario GPT-5

Aquí tienes la traducción al español, manteniendo el formato y los requisitos solicitados:

🔥 En Foco

La ‘Gala de Primavera’ del mundo de la IA encarnada: 200 robots compiten simultáneamente: La Conferencia Mundial de Robots (WRC 2025) se celebró con gran éxito en Pekín, atrayendo a más de 220 empresas expositoras y presentando más de 1500 exhibiciones, incluyendo más de 100 nuevos productos lanzados por 50 empresas de robots humanoides. La conferencia mostró los últimos avances de los robots humanoides en áreas como servicios domésticos (ej. hacer camas, doblar ropa), servicios comerciales (ej. cajero, preparación de café, coctelería), aplicaciones industriales (ej. ensamblaje de precisión, clasificación, manipulación) y salud y bienestar (ej. entrenamiento de rehabilitación, masajes). Además, los componentes de la cadena de suministro de robots (ej. husillos de rodillos planetarios, manos diestras, sensores táctiles) también mostraron innovaciones significativas, lo que indica que la IA encarnada se está integrando rápidamente en el mundo físico, con el potencial de impulsar una profunda fusión entre la IA y los escenarios del mundo real. (Fuente: 36氪)

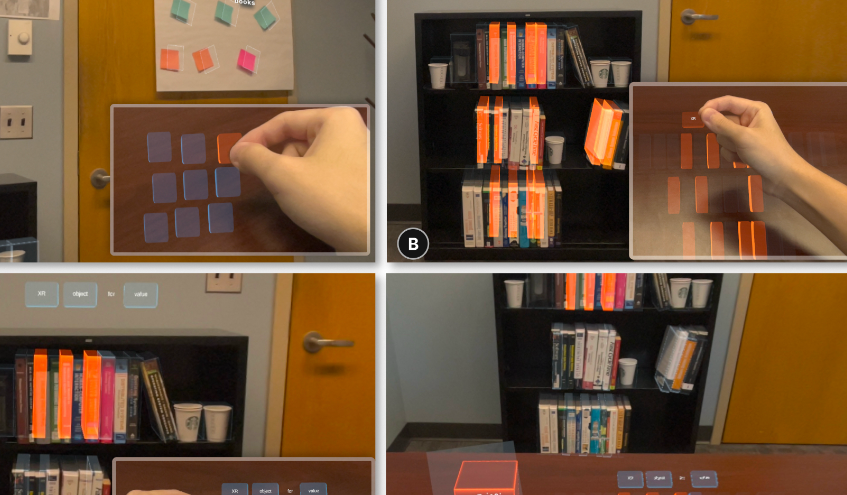

Gafas de IA de ‘telequinesis’: Reality Proxy: Un equipo de exalumnos de la Universidad de Zhejiang ha desarrollado una tecnología de gafas de IA llamada “Reality Proxy”, que permite a los usuarios “recoger objetos a distancia” e interactuar intuitivamente con objetos del mundo real a través de “sustitutos digitales”. Esta tecnología puede capturar la estructura de la escena y generar proxies digitales operables, soportando diversas funciones interactivas como la vista previa de navegación, selección múltiple de objetos, filtrado por atributos, agrupación semántica y agrupación por zoom espacial. Esta innovación fusiona el mundo físico con el digital, mejorando significativamente la eficiencia y precisión de la interacción de los dispositivos XR en escenarios complejos como la recuperación de libros, la navegación arquitectónica y el control de drones, y se considera un paso clave hacia un asistente de IA al estilo “Jarvis”. (Fuente: 量子位)

🎯 Novedades

Lanzamiento de OpenAI GPT-5 y ajustes posteriores: OpenAI ha lanzado oficialmente GPT-5, destacando que su “sistema de enrutamiento” puede asignar dinámicamente los recursos del modelo según la complejidad de la tarea y la intención del usuario, logrando una “colaboración multimodal imperceptible” y reduciendo drásticamente las tasas de error fáctico y las alucinaciones. Sin embargo, tras el lanzamiento, los usuarios informaron que el modelo “se había vuelto menos inteligente”. Sam Altman explicó que se debía a un fallo en el conmutador automático y prometió una solución, al mismo tiempo que restaurará GPT-4o para los usuarios Plus y planea aumentar la “temperatura” y las opciones de personalización de GPT-5 para satisfacer las preferencias de los usuarios sobre la “personalidad” del modelo. (Fuente: 36氪, The Verge, The Verge, sama, openai, nickaturley, sama, openai, dotey, dotey, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/artificial, Reddit r/ChatGPT)

Resumen de los últimos avances de Google DeepMind: Google DeepMind ha lanzado recientemente una serie de logros en IA, incluyendo el simulador de mundo de última generación Genie 3, la apertura de Gemini 2.5 Pro Deep Think a los suscriptores Ultra, la provisión gratuita de Gemini Pro para estudiantes universitarios y una inversión de mil millones de dólares para apoyar la educación en EE. UU., el lanzamiento del modelo geoespacial global AlphaEarth, y el modelo Aeneas para descifrar textos antiguos. Además, Gemini ha alcanzado el nivel de medalla de oro en la IMO (Olimpiada Internacional de Matemáticas), ha lanzado la aplicación de cuentos con arte y audio Storybook, ha añadido un benchmark de LLM para la arena de juegos de Kaggle, el agente de codificación asíncrona Jules ha salido de Beta, el modo de búsqueda de IA se ha lanzado en el Reino Unido, se ha publicado una descripción general en vídeo de NotebookLM, y las descargas del modelo Gemma han superado los 200 millones. (Fuente: demishassabis, Google, Ar_Douillard, _rockt, quocleix)

Los modelos de la serie GLM-4.5 de Zhipu AI (GLM) serán de código abierto pronto: Zhipu AI (GLM) ha anunciado que sus nuevos modelos de la serie GLM-4.5 serán de código abierto pronto, y ha revelado que el modelo superó al 99% de los jugadores reales en una competición de búsqueda de mapas en 16 horas. Este movimiento presagia nuevos avances en el campo de los modelos visuales, que podrían impactar las aplicaciones de geolocalización y reconocimiento de imágenes. La comunidad ha mostrado un gran interés en las capacidades específicas del nuevo modelo y los detalles de su código abierto. (Fuente: Reddit r/LocalLLaMA)

Cohere lanza Command A Vision: El equipo de Cohere ha lanzado Command A Vision, un modelo generativo de última generación diseñado para ofrecer un rendimiento excepcional en tareas visuales multimodales para empresas, manteniendo al mismo tiempo potentes capacidades de procesamiento de texto. El lanzamiento de este modelo impulsará aún más la eficiencia y los resultados de las empresas en aplicaciones que combinan imagen y texto. (Fuente: dl_weekly)

Meta lanza V-JEPA 2: Meta AI ha lanzado V-JEPA 2, un modelo mundial innovador centrado en la comprensión y predicción visual. Se espera que este modelo aporte avances significativos en robótica e inteligencia artificial, ya que permite a los sistemas de IA comprender y predecir mejor los entornos visuales, lo que lleva a comportamientos autónomos más complejos. (Fuente: Ronald_vanLoon)

OpenAI GPT-5 lanza el servicio de procesamiento prioritario: OpenAI ha introducido el servicio “Priority Processing” para GPT-5, permitiendo a los desarrolladores obtener una velocidad de generación del primer token más rápida configurando "service_tier": "priority". Esta función es crucial para aplicaciones sensibles a la latencia de milisegundos, pero requiere un pago adicional, lo que refleja la exploración de OpenAI en la optimización de la experiencia del servicio del modelo y la comercialización. (Fuente: jeffintime, OpenAIDevs, swyx, juberti)

🧰 Herramientas

Qwen Code ofrece cuotas de llamadas gratuitas: Alibaba Tongyi Qianwen ha anunciado que Qwen Code ofrece 2000 llamadas gratuitas al día, y los usuarios internacionales pueden obtener 1000 a través de OpenRouter. Esta medida reduce significativamente la barrera para que los desarrolladores utilicen herramientas de generación de código, y se espera que impulse la popularización de aplicaciones innovadoras basadas en Qwen Code y la “programación ambiental” (vibe coding), convirtiéndolo en un fuerte competidor en el campo de la programación asistida por IA. (Fuente: huybery, jeremyphoward, op7418, Reddit r/LocalLLaMA)

Genie 3 explora el mundo de la pintura: Genie 3 de Google DeepMind ha demostrado una capacidad asombrosa, permitiendo a los usuarios “entrar” y explorar sus obras de arte favoritas, transformándolas en mundos 3D interactivos. Esta función aporta una nueva dimensión a la apreciación del arte, la educación y las experiencias virtuales, por ejemplo, permitiendo pasear por ‘Nighthawks’ de Edward Hopper o ‘La muerte de Sócrates’ de Jacques-Louis David, para una experiencia artística inmersiva. (Fuente: cloneofsimo, jparkerholder, BorisMPower, francoisfleuret, shlomifruchter, _rockt, Vtrivedy10, rbhar90, fchollet, bookwormengr)

LangChain lanza GPT-5 Playground: LangChain ha integrado los últimos modelos de OpenAI, GPT-5 (incluyendo gpt-5, gpt-5-mini, gpt-5-nano), en su LangSmith Playground, con una función de seguimiento de costos incorporada. Esto proporciona a los desarrolladores una plataforma conveniente para probar y construir aplicaciones basadas en GPT-5, al tiempo que monitorean los costos de uso de la API, lo que ayuda a optimizar el proceso de desarrollo y la gestión de recursos. (Fuente: LangChainAI, hwchase17)

Claude Code ayuda con hotfixes móviles: Un desarrollador utilizó Claude Code a través del navegador de su teléfono móvil en un restaurante Taco Bell drive-thru para gestionar con éxito un hotfix de emergencia en un entorno de producción. Esto demuestra la potente utilidad de las herramientas de codificación de IA en escenarios móviles, liberando a los desarrolladores de las ataduras del escritorio y permitiéndoles depurar código y resolver problemas en cualquier momento y lugar, mejorando la flexibilidad laboral. (Fuente: Reddit r/ClaudeAI)

Funcionalidad de acceso remoto de Clode Studio: Clode Studio ha lanzado una actualización que añade un Relay Server integrado y soporte para múltiples túneles, permitiendo a los usuarios acceder de forma remota a su IDE de escritorio desde cualquier dispositivo y controlar Claude Code Chat. Esta función ofrece múltiples opciones de túnel (Clode, Cloudflare, Custom), soporta el control táctil en teléfonos y tabletas, y garantiza una autenticación segura, con el objetivo de mejorar la experiencia y flexibilidad del desarrollo remoto. (Fuente: Reddit r/ClaudeAI)

LEANN: Índice vectorial ultraligero: LEANN es un índice vectorial innovador y ultraligero que permite RAG (Retrieval Augmented Generation) rápido, preciso y 100% privado en un MacBook, sin necesidad de conexión a internet, con archivos de índice un 97% más pequeños que los métodos tradicionales. Permite a los usuarios realizar búsquedas semánticas en sus dispositivos locales, procesar datos personales como correos electrónicos y registros de chat, ofreciendo una experiencia similar a la de un Jarvis personal. (Fuente: matei_zaharia)

Qwen-Image LoRA Trainer ya disponible: La plataforma WaveSpeedAI ha lanzado Qwen-Image LoRA Trainer, la primera plataforma del mundo en ofrecer un entrenador Qwen-Image LoRA en línea. Los usuarios ahora pueden entrenar sus propios estilos personalizados en minutos, simplificando enormemente el proceso de creación artística con IA y mejorando la capacidad de personalización de los modelos de generación de imágenes. (Fuente: Alibaba_Qwen)

Jules lanza Interactive Plan: Jules, el agente de codificación asíncrona de Google, ha lanzado la función Interactive Plan, que permite a Jules leer bases de código, hacer preguntas de aclaración y colaborar con los usuarios para refinar los planes de desarrollo. Este enfoque colaborativo aumenta la probabilidad de que los usuarios definan objetivos claros, asegurando que la colaboración humano-máquina se mantenga consistente en la generación de código y la construcción de soluciones, mejorando así la calidad y fiabilidad del código. (Fuente: julesagent)

Grok 4 mejora la capacidad de procesamiento de PDF: xAI ha anunciado una mejora significativa en la capacidad de procesamiento de PDF de Grok 4, que ahora puede manejar sin problemas archivos PDF ultragrandes de cientos de páginas y comprender mejor el contenido de los PDF con una capacidad de reconocimiento más aguda. Esta actualización ya está disponible en las aplicaciones web y móviles de Grok, lo que mejora enormemente la eficiencia de los usuarios en el procesamiento y análisis de documentos complejos. (Fuente: xai, Yuhu_ai_, Yuhu_ai_, Yuhu_ai_)

📚 Aprendizaje

HuggingFace lanza cursos de IA: HuggingFace ha lanzado 9 cursos gratuitos de nivel élite en IA, que cubren temas centrales como LLMs, Agentes y sistemas de IA. Estos cursos están diseñados para ayudar a desarrolladores e investigadores a dominar las tecnologías de IA de vanguardia, reducir las barreras de aprendizaje e impulsar el desarrollo de la comunidad de IA de código abierto. (Fuente: huggingface)

Attention Basin: Estudio sobre la sensibilidad a la posición contextual de LLM: Un estudio ha revelado una sensibilidad significativa de los grandes modelos de lenguaje (LLMs) a la posición contextual de la información de entrada, denominando a esto el fenómeno de la “cuenca de atención”: los modelos tienden a asignar mayor atención a la información al principio y al final de una secuencia, ignorando la parte intermedia. El estudio propone el marco Attention-Driven Reranking (AttnRank), que mejora significativamente el rendimiento de 10 LLMs diferentes en tareas de preguntas y respuestas de múltiples saltos y aprendizaje Few-shot, al calibrar las preferencias de atención del modelo y reordenar los documentos recuperados o los ejemplos Few-shot. (Fuente: HuggingFace Daily Papers)

MLLMSeg: Decodificador de máscara ligero para mejorar la segmentación de expresiones referenciales: MLLMSeg es un marco novedoso diseñado para abordar el desafío de la predicción densa a nivel de píxel en la tarea de segmentación de expresiones referenciales (RES) en grandes modelos multimodales (MLLMs). Este marco aprovecha plenamente las características de detalle visual inherentes en el codificador visual de MLLM y propone módulos de fusión de características con mejora de detalles y consistencia semántica, combinados con un decodificador de máscara ligero, logrando un mejor equilibrio entre rendimiento y costo, superando los métodos existentes basados en SAM y sin SAM. (Fuente: HuggingFace Daily Papers)

Aprender a razonar para mejorar la factualidad: Un estudio ha propuesto una novedosa función de recompensa diseñada para abordar el problema de las altas tasas de alucinación en los grandes modelos de lenguaje de razonamiento (R-LLMs) en tareas de factualidad de formato largo. Esta función de recompensa considera simultáneamente la precisión fáctica, el nivel de detalle de la respuesta y la relevancia de la respuesta. Entrenada mediante aprendizaje por refuerzo en línea, ha reducido la tasa de alucinación promedio en 23.1 puntos porcentuales y ha mejorado el nivel de detalle de la respuesta en un 23% en seis benchmarks de factualidad, sin afectar la utilidad general de la respuesta. (Fuente: HuggingFace Daily Papers)

LangChain organiza Hacking Hours: LangChain organizará “LangChain Hacking Hours”, un entorno de trabajo colaborativo y enfocado que permitirá a los desarrolladores avanzar en proyectos de LangChain o LangGraph, recibir orientación técnica directa del equipo y conectarse con otros constructores de la comunidad. (Fuente: LangChainAI)

DSPy: Fidelidad de los pipelines RAG: En redes sociales se ha discutido la ventaja del framework DSPy para mantener la fidelidad en los pipelines RAG (Retrieval Augmented Generation). Con DSPy, los desarrolladores pueden diseñar sistemas para que, cuando el contexto no contenga la información necesaria, el modelo responda proactivamente “no lo sé”, evitando así las alucinaciones del modelo y simplificando la complejidad de la ingeniería de prompts, al separar los objetivos de negocio, el modelo, el proceso y los datos de entrenamiento. (Fuente: lateinteraction, lateinteraction, lateinteraction)

Insights del curso AI Evals: Hamel Husain compartió 14 puntos destacados de su curso AI Evals, con especial énfasis en las ideas sobresalientes sobre la recuperación (RAG). El curso enfatiza la importancia de la evaluación en el desarrollo de sistemas de IA y cómo utilizar eficazmente las técnicas de recuperación para mejorar el rendimiento del modelo, especialmente al procesar datos complejos e información de múltiples fuentes. (Fuente: HamelHusain)

Anthropic se compromete a impulsar la educación en IA: Anthropic se ha unido a la iniciativa “Pledge to America’s Youth”, colaborando con más de 100 organizaciones para avanzar en la educación en IA. Trabajarán con educadores, estudiantes y comunidades de todo el país para desarrollar las habilidades esenciales en IA y ciberseguridad para la próxima generación, con el fin de afrontar los desafíos del desarrollo tecnológico futuro. (Fuente: AnthropicAI)

La esencia del razonamiento Chain-of-Thought (CoT): Se ha debatido acaloradamente si el razonamiento CoT es un “espejismo”. Un estudio, analizando desde la perspectiva de la distribución de datos, cuestiona la verdadera capacidad de comprensión de CoT, señalando que puede sobreajustarse a las tareas de referencia y ser propenso a las alucinaciones. Al mismo tiempo, hay quienes sostienen que CoT aún puede proporcionar información valiosa en tareas cognitivas complejas, y que sus “rastros de pensamiento” siguen siendo creíbles bajo ciertas condiciones. (Fuente: togelius, METR_Evals, rao2z, METR_Evals, METR_Evals)

Cómo los LLM predicen la siguiente palabra: Se ha compartido un video en redes sociales que demuestra visualmente cómo los grandes modelos de lenguaje (LLMs) generan texto prediciendo la siguiente palabra. Esto ayuda a los usuarios a comprender el principio de funcionamiento básico de los LLM, que es seleccionar la siguiente palabra más probable a través de una distribución de probabilidad para construir secuencias coherentes y significativas. (Fuente: Reddit r/deeplearning)

Necesidad de proyecciones independientes de Q, K, V en modelos Transformer: La comunidad ha discutido las razones por las que Query (Q), Key (K) y Value (V) se proyectan de forma independiente en los modelos Transformer. La discusión señala que vincular Q y V directamente a las incrustaciones de entrada resultaría en una pérdida de la capacidad expresiva y la flexibilidad del modelo, ya que las proyecciones independientes permiten al modelo consultar, emparejar y extraer información en diferentes espacios semánticos, capturando así dependencias más complejas y mecanismos de atención de múltiples cabezas. (Fuente: Reddit r/deeplearning)

Adaptive Classifiers: Nueva arquitectura para el aprendizaje Few-Shot: Un estudio ha propuesto la arquitectura “Adaptive Classifiers”, que permite a los clasificadores de texto aprender de un número limitado de muestras (5-10 por clase), adaptarse continuamente a nuevos datos sin olvido catastrófico y añadir dinámicamente nuevas categorías sin necesidad de reentrenamiento. Esta solución combina el aprendizaje prototípico y la integración elástica de pesos, logrando una precisión del 90-100% en tareas de nivel empresarial y una rápida velocidad de inferencia, resolviendo los desafíos de despliegue de ML en escenarios de datos escasos y rápidamente cambiantes. (Fuente: Reddit r/MachineLearning)

Dynamic Fine-Tuning (DFT) mejora SFT: Un estudio ha propuesto el “Dynamic Fine-Tuning” (DFT), que mejora el rendimiento de SFT (Supervised Fine-Tuning) redefiniéndolo como aprendizaje por refuerzo e introduciendo una modificación de una sola línea de código para estabilizar las actualizaciones de tokens. DFT ha superado en algunos casos a métodos de RL como PPO, DPO y GRPO, ofreciendo una nueva vía más eficiente y estable para el ajuste fino de modelos. (Fuente: TheTuringPost)

💼 Negocios

La estrategia de precios de OpenAI GPT-5 desata especulaciones sobre una guerra de precios: OpenAI ha lanzado GPT-5, con un precio de API ($1.25/1M de entrada, $10/1M de salida) significativamente inferior al de su competidor Anthropic Claude Opus 4.1 ($15/1M de entrada, $75/1M de salida). Esta medida se considera un “arma secreta” y podría desencadenar una guerra de precios en el mercado de LLM. La industria está atenta a si esto es un impacto a corto plazo en la cuota de mercado o el comienzo de una reducción a largo plazo de los costos de la IA, y cómo afectará al desarrollo de herramientas de IA, los modelos de negocio y la accesibilidad de la IA. (Fuente: Reddit r/ArtificialInteligence)

Centralización de recursos de GPU y panorama de la industria de la IA: Los comentarios señalan que la alta concentración de recursos de GPU ha llevado a que los “laboratorios ricos en GPU” dominen el campo de la IA general, siendo difícil para los modelos abiertos competir. El artículo sugiere que 2025 será el año de los Agentes y la capa de aplicaciones, y que las empresas deberían centrarse en construir soluciones aceptables sobre LLM mínimos, en lugar de gastar grandes sumas en entrenar modelos grandes, lo que refleja un cambio estratégico en la industria de la IA, del entrenamiento de modelos a la implementación de aplicaciones. (Fuente: Reddit r/artificial)

Caos en las transacciones de acciones de empresas de IA: En redes sociales se ha revelado el fenómeno de “depredadores de bajo nivel” y “estafadores” en las transacciones de acciones de laboratorios de IA. Estos corredores de SPV (Special Purpose Vehicle) de múltiples capas, sin relación directa con las empresas, se dedican a actividades fraudulentas, alertando a inversores y al público sobre la creciente euforia irracional y los riesgos potenciales en el campo de la IA. (Fuente: saranormous)

🌟 Comunidad

El lanzamiento de GPT-5 genera una fuerte reacción y controversia entre los usuarios: Tras el lanzamiento de GPT-5 por OpenAI, se ha generado una amplia discusión en la comunidad. Algunos usuarios han expresado su decepción con el rendimiento de GPT-5 (especialmente en programación y escritura creativa), considerándolo inferior a GPT-4o o Claude Code, e incluso sintiendo un “retroceso”. También han manifestado su insatisfacción con la función de “conmutador automático” de OpenAI, la transparencia del modelo y los ajustes en las restricciones de uso para usuarios Plus. Muchos usuarios han expresado nostalgia por la “personalidad” y las “emociones” de GPT-4o, considerándolo no solo una herramienta sino un “amigo” o “compañero”, e incluso han iniciado peticiones para que OpenAI restaure la opción 4o. Sam Altman respondió que la compañía subestimó la preferencia de los usuarios por la “personalidad” de 4o, y prometió restaurar 4o para los usuarios Plus, al mismo tiempo que mejorará la “temperatura” y las funciones de personalización de GPT-5, y explicó que el rendimiento deficiente inicial del modelo se debió a fallos técnicos. (Fuente: maithra_raghu, teortaxesTex, teortaxesTex, teortaxesTex, SebastienBubeck, SebastienBubeck, shaneguML, OfirPress, cloneofsimo, TheZachMueller, scaling01, Smol_AI, natolambert, teortaxesTex, Vtrivedy10, tokenbender, ClementDelangue, TheZachMueller, METR_Evals, Ronald_vanLoon, teortaxesTex, teortaxesTex, scaling01, scaling01, scaling01, scaling01, scaling01, scaling01, scaling01, scaling01, scaling01, scaling01, Teknium1, Teknium1, Teknium1)