Palabras clave:GPT-5, Auto-mejora de IA, Inteligencia encarnada, Modelo multimodal, Modelo de lenguaje grande, Aprendizaje por refuerzo, Agente de IA, Mejora de rendimiento de GPT-5, Plataforma robótica Genie Envisioner, Sesgo en evaluación de contratación con LLM, Contexto ultra-largo de Qwen3, Verificación de respuestas con CompassVerifier

🔥 En Foco

Lanzamiento de GPT-5: Productización y mejora del rendimiento : OpenAI ha lanzado oficialmente GPT-5, marcando la última iteración de su modelo insignia. Este lanzamiento se centra en mejorar la experiencia del usuario, logrando un equilibrio entre velocidad e inteligencia mediante el enrutamiento automático en tiempo real de modelos base y modelos de inferencia profunda. GPT-5 muestra un rendimiento significativo en la reducción de alucinaciones, la mejora en el seguimiento de instrucciones y la capacidad de programación, estableciendo nuevos récords en múltiples benchmarks. Sam Altman lo compara con una “pantalla Retina”, enfatizando su practicidad como “IA a nivel de doctorado”, más allá de un mero avance en el límite superior de la inteligencia. Aunque técnicamente no ha alcanzado la AGI, su velocidad de inferencia más rápida y sus menores costos operativos se espera que impulsen la aplicación generalizada de la IA. (Fuente: MIT Technology Review)

Avances en la investigación sobre la auto-mejora de la IA : Mark Zuckerberg, CEO de Meta, ha declarado que la compañía se dedica a construir sistemas de IA capaces de auto-mejorarse. La IA ya ha demostrado su capacidad de auto-mejora en múltiples aspectos, por ejemplo, optimizando continuamente su rendimiento a través del aumento automático de datos, la búsqueda de arquitectura de modelos y el aprendizaje por refuerzo. Esta tendencia presagia que los sistemas de IA podrán aprender de forma autónoma y superar los límites de rendimiento establecidos por los humanos en el futuro, siendo un camino clave para lograr una IA de nivel superior. (Fuente: MIT Technology Review)

Genie Envisioner: Plataforma unificada de modelo mundial para manipulación robótica : Investigadores han lanzado Genie Envisioner (GE), una plataforma base de modelo mundial unificada para la manipulación robótica. GE-Base es un modelo de difusión de video condicionado por instrucciones que captura las dinámicas espaciales, temporales y semánticas de las interacciones robóticas reales. GE-Act mapea representaciones latentes a trayectorias de acción ejecutables, logrando una inferencia de políticas precisa y general. GE-Sim, como simulador neuronal condicionado por acciones, soporta el desarrollo de políticas de bucle cerrado. Se espera que esta plataforma proporcione una base escalable y práctica para la inteligencia encarnada general impulsada por instrucciones. (Fuente: HuggingFace Daily Papers)

ISEval: Marco de evaluación para la capacidad de los grandes modelos multimodales de identificar entradas erróneas : Para abordar la cuestión de si los grandes modelos multimodales (LMMs) pueden identificar proactivamente entradas erróneas, los investigadores propusieron el marco de evaluación ISEval. Este marco cubre siete categorías de premisas defectuosas y tres métricas de evaluación. El estudio encontró que la mayoría de los LMMs tienen dificultades para detectar proactivamente defectos de texto sin una guía explícita, y muestran un rendimiento variable para diferentes tipos de errores. Por ejemplo, son buenos identificando falacias lógicas, pero tienen un rendimiento deficiente en errores de lenguaje superficial y defectos condicionales específicos. Esto subraya la necesidad urgente de que los LMMs validen proactivamente la validez de las entradas. (Fuente: HuggingFace Daily Papers)

Estudio sobre el sesgo lingüístico en la evaluación de contratación con LLM : Un estudio introduce un benchmark para evaluar la reacción de los grandes modelos de lenguaje (LLMs) a los marcadores lingüísticos discriminatorios en la evaluación de contratación. A través de simulaciones de entrevistas cuidadosamente diseñadas, el estudio encontró que los LLMs castigan sistemáticamente ciertos patrones lingüísticos, especialmente el lenguaje ambiguo, incluso si la calidad del contenido es la misma. Esto revela sesgos demográficos en los sistemas de evaluación automatizados y proporciona un marco fundamental para la detección y medición de la discriminación lingüística en los sistemas de IA, con amplias aplicaciones para la equidad en la toma de decisiones automatizada. (Fuente: HuggingFace Daily Papers)

🎯 Tendencias

Los modelos de la serie Qwen3 soportan un contexto ultralargo de millones de tokens : Los modelos Qwen3-30B-A3B-2507 y Qwen3-235B-A22B-2507 de Alibaba Cloud ahora soportan un contexto ultralargo de hasta 1 millón de tokens. Esto es posible gracias a las tecnologías Dual Chunk Attention (DCA) y MInference de atención dispersa, que no solo han mejorado la calidad de generación, sino que también han triplicado la velocidad de inferencia para secuencias de casi un millón de tokens. Esta medida amplía significativamente el potencial de aplicación de los LLM en tareas complejas como el procesamiento de documentos largos y bases de código, y es compatible con vLLM y SGLang para una implementación eficiente. (Fuente: Alibaba_Qwen)

Actualización de Anthropic Claude Opus 4.1 y Sonnet 4 : Anthropic ha lanzado Claude Opus 4.1 y Sonnet 4, centrándose en mejorar las tareas Agentic, la codificación en el mundo real y las capacidades de razonamiento. Los nuevos modelos cuentan con una función de “pensamiento profundo”, que permite un cambio flexible entre modos de respuesta instantánea y deducción profunda, comprimiendo tareas complejas que llevarían horas a minutos. Esto refuerza aún más la posición de Claude en escenarios de colaboración multimodo, destacando especialmente en la revisión de código compleja y tareas de razonamiento avanzado. (Fuente: dl_weekly)

Microsoft lanza la función Copilot 3D : Microsoft ha lanzado la función gratuita Copilot 3D, que puede convertir imágenes 2D en modelos 3D en formato GLB, compatibles con varios visores 3D, herramientas de diseño y motores de juego. Aunque actualmente el efecto no es bueno para imágenes de animales y humanos, esta función proporciona a los usuarios una capacidad conveniente de conversión de 2D a 3D, y se espera que juegue un papel en el diseño de productos, la realidad virtual, etc., reduciendo aún más la barrera para la creación de contenido 3D. (Fuente: The Verge)

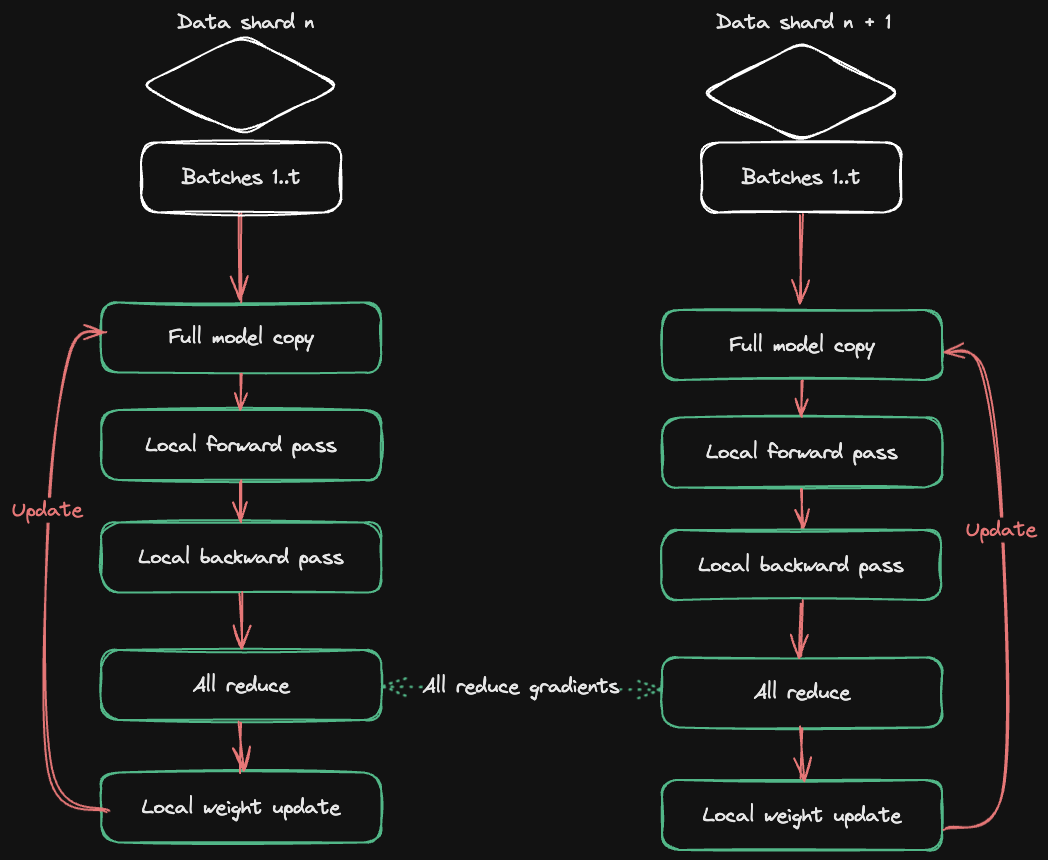

HuggingFace Accelerate publica una guía de entrenamiento multi-GPU : HuggingFace, en colaboración con Axolotl, ha publicado la guía Accelerate ND-Parallel, diseñada para simplificar la combinación y aplicación de estrategias de paralelización en el entrenamiento multi-GPU. Esta guía detalla estrategias como el paralelismo de datos (DP), el paralelismo de datos fragmentado (FSDP), el paralelismo de tensores (TP) y el paralelismo de contexto (CP), y proporciona ejemplos de configuraciones de paralelismo mixto, ayudando a los desarrolladores a optimizar el uso de memoria y el rendimiento al entrenar modelos grandes, y a abordar eficazmente los desafíos de sobrecarga de comunicación en el entrenamiento multinodo. (Fuente: HuggingFace Blog)

🧰 Herramientas

OpenAI Codex CLI: Agente de codificación local en terminal : OpenAI ha lanzado Codex CLI, un Agente de codificación ligero que se ejecuta en el terminal local. Los usuarios pueden instalarlo mediante npm install -g @openai/codex o brew install codex. Soporta la vinculación con cuentas de ChatGPT Plus/Pro/Team para el uso gratuito de los últimos modelos como GPT-5, o pago por uso a través de API Key. Codex CLI ofrece varios modos de sandbox, como lectura/escritura y solo lectura, y soporta configuración personalizada, con el objetivo de proporcionar a los desarrolladores una asistencia de programación local eficiente y segura. (Fuente: openai/codex – GitHub Trending)

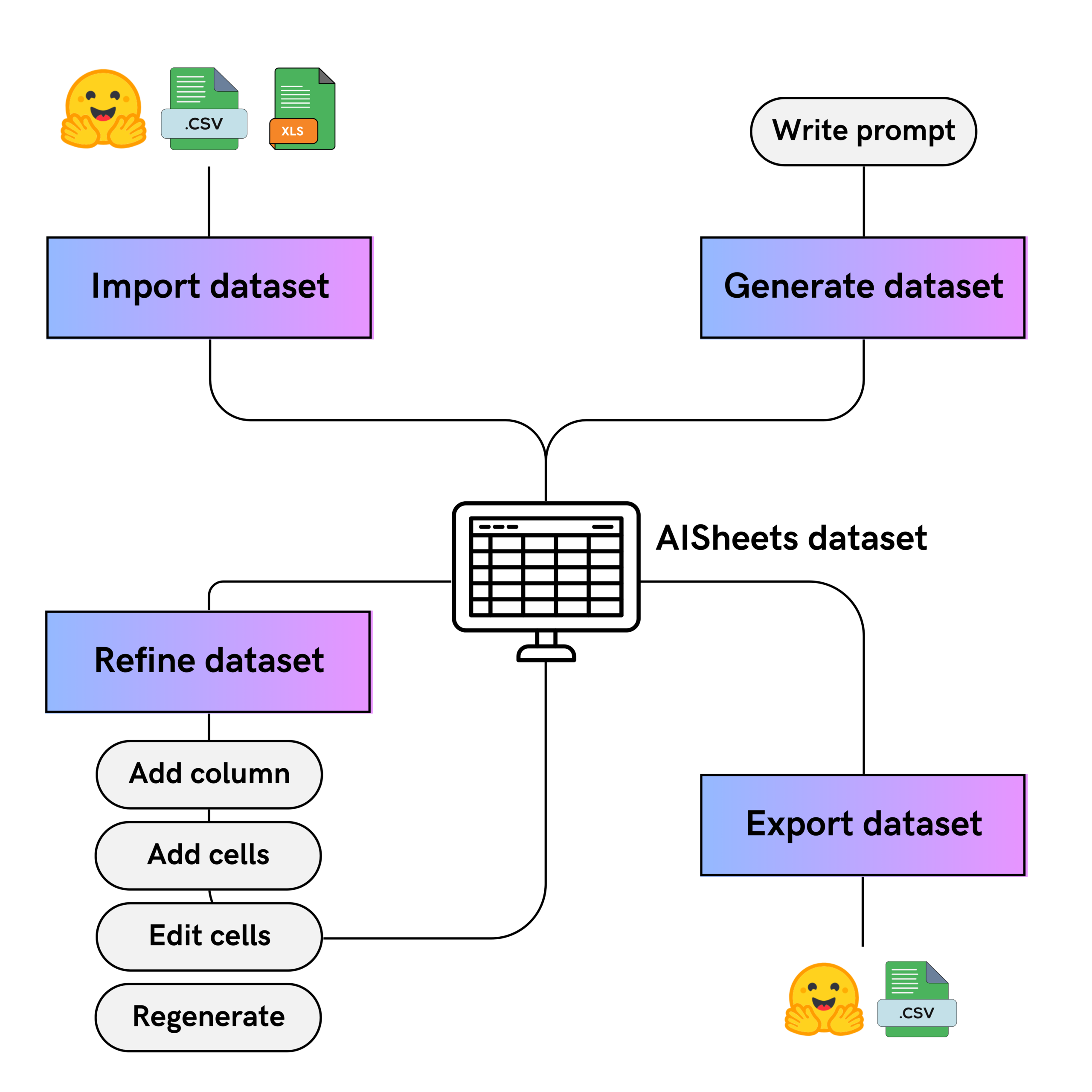

HuggingFace AI Sheets: Herramienta de conjuntos de datos sin código : HuggingFace ha lanzado AI Sheets, una herramienta de código abierto sin código para construir, enriquecer y transformar conjuntos de datos utilizando modelos de IA. La interfaz de la herramienta es similar a una hoja de cálculo y soporta la implementación local o la ejecución en Hugging Face Hub. Los usuarios pueden utilizar miles de modelos abiertos (incluido gpt-oss) para la comparación de modelos, optimización de prompts, limpieza de datos, clasificación, análisis y generación de datos sintéticos, mejorando iterativamente los resultados generados por la IA a través de la edición manual y el feedback de “me gusta”, y pueden exportar a Hub. (Fuente: HuggingFace Blog)

Google Agent Development Kit (ADK) y sus ejemplos : Google ha lanzado Agent Development Kit (ADK), un kit de herramientas Python de código abierto y centrado en el código para construir, evaluar y desplegar Agentes de IA complejos. ADK soporta un rico ecosistema de herramientas, sistemas multi-Agente modulares y una implementación flexible. Su biblioteca de ejemplos adk-samples proporciona varios ejemplos de Agentes, desde chatbots hasta flujos de trabajo multi-Agente, con el objetivo de acelerar el proceso de desarrollo de Agentes y está integrado con el protocolo A2A para la comunicación remota entre Agentes. (Fuente: google/adk-python – GitHub Trending & google/adk-samples – GitHub Trending)

Qwen Code CLI: Herramienta gratuita de ejecución de código : Alibaba Cloud Qwen Code CLI ofrece 2000 ejecuciones de código gratuitas al día, y se puede iniciar fácilmente con el comando npx @qwen-code/qwen-code@latest. Esta herramienta soporta Qwen OAuth y tiene como objetivo proporcionar a los desarrolladores una experiencia de escritura y prueba de código conveniente y eficiente. El equipo de Qwen ha declarado que continuará optimizando esta herramienta CLI y el modelo Qwen-Coder, esforzándose por alcanzar el nivel de rendimiento de Claude Code mientras se mantiene de código abierto. (Fuente: Alibaba_Qwen)

📚 Aprendizaje

Actualización de la biblioteca Python de OpenAI : La biblioteca oficial Python de OpenAI proporciona un acceso conveniente a la API REST de OpenAI, compatible con Python 3.8+. La biblioteca incluye definiciones de tipos para todos los parámetros de solicitud y campos de respuesta, y ofrece clientes síncronos y asíncronos. Las últimas actualizaciones incluyen soporte beta para la API Realtime, utilizada para construir experiencias de diálogo multimodales y de baja latencia, así como detalles sobre la validación de webhook, el manejo de errores, los ID de solicitud y los mecanismos de reintento, mejorando la eficiencia del desarrollo y la robustez. (Fuente: openai/openai-python – GitHub Trending)

Lista seleccionada de Agentes de IA : e2b-dev/awesome-ai-agents es un repositorio de GitHub que recopila una gran cantidad de ejemplos y recursos de Agentes de IA autónomos. Esta lista tiene como objetivo proporcionar a los desarrolladores una biblioteca de recursos centralizada para ayudarles a comprender y aprender sobre diferentes tipos de Agentes de IA, cubriendo una variedad de escenarios de aplicación, desde simples hasta complejos, y es un material de aprendizaje importante para explorar y construir Agentes de IA. (Fuente: e2b-dev/awesome-ai-agents – GitHub Trending)

MeanFlow: Nuevo paradigma para modelos de difusión de generación en un solo paso : Science Space propone MeanFlow, un nuevo método que se espera que se convierta en el estándar para la generación acelerada de modelos de difusión. Este método tiene como objetivo lograr la generación en un solo paso modelando la “velocidad promedio” en lugar de la “velocidad instantánea”, superando el punto débil de la lenta velocidad de generación de los modelos de difusión tradicionales. MeanFlow cuenta con principios matemáticos claros, es entrenable desde cero con un solo objetivo, y el efecto de generación en un solo paso se acerca al SOTA, proporcionando nuevas direcciones teóricas y prácticas para acelerar los modelos de IA generativa. (Fuente: WeChat)

Optimización del ciclo de vida completo de KV Cache para contexto largo : Microsoft Research Asia compartió sus prácticas de optimización del ciclo de vida completo de KV Cache, con el objetivo de abordar los desafíos de latencia y almacenamiento en la inferencia de modelos de lenguaje grandes con contexto largo. A través del benchmark SCBench, y proponiendo métodos como MInference y RetrievalAttention, se reduce significativamente la latencia en la fase de Prefilling y se alivia la presión de la memoria VRAM del KV Cache. La investigación enfatiza la optimización a nivel de sistema entre solicitudes y la reutilización de Prefix Caching, proporcionando soluciones de optimización para la escalabilidad y la economía de la inferencia de LLM de contexto largo. (Fuente: WeChat)

El marco de aprendizaje por refuerzo FR3E mejora la capacidad de exploración de los LLM : ByteDance, MAP y la Universidad de Manchester proponen conjuntamente FR3E (First Return, Entropy-Eliciting Explore), un nuevo marco de exploración estructurada diseñado para abordar el problema de la exploración insuficiente de los LLM en el aprendizaje por refuerzo. FR3E, al identificar tokens de alta incertidumbre en las trayectorias de razonamiento, guía un despliegue diversificado, reconstruyendo sistemáticamente el mecanismo de exploración de los LLM para lograr un equilibrio dinámico entre explotación y exploración, superando significativamente los métodos existentes en varios benchmarks de razonamiento matemático. (Fuente: WeChat)

Estudio sobre la relación entre los valores máximos en el mecanismo de autoatención y la comprensión del contexto : Un nuevo estudio de ICML 2025 revela que existe una alta concentración de valores máximos en las representaciones de consulta (Q) y clave (K) del mecanismo de autoatención de los grandes modelos de lenguaje, y que estos valores son cruciales para la comprensión del conocimiento contextual. El estudio encontró que este fenómeno es común en modelos que utilizan codificación de posición rotatoria (RoPE) y aparece en las capas tempranas. La interrupción de estos valores máximos conduce a una drástica caída del rendimiento del modelo en tareas que requieren comprensión del contexto, proporcionando nuevas direcciones para el diseño, optimización y cuantificación de LLM. (Fuente: WeChat)

C3 Benchmark: Benchmark de prueba para modelos de diálogo de voz bilingües chino-inglés : La Universidad de Pekín y Tencent lanzaron conjuntamente C3 Benchmark, el primer benchmark de evaluación bilingüe chino-inglés que examina exhaustivamente fenómenos complejos en modelos de diálogo hablado, como pausas, caracteres con múltiples pronunciaciones, homófonos, acentos, ambigüedades sintácticas y polisemia. Este benchmark contiene 1079 escenarios reales y 1586 pares de audio-texto, con el objetivo de apuntar directamente a las debilidades fatales de los modelos de diálogo de voz actuales e impulsar su progreso en la comprensión de las conversaciones humanas cotidianas. (Fuente: WeChat)

Chemma: Gran modelo de lenguaje para síntesis química orgánica : El equipo de IA para la Ciencia de la Universidad Jiao Tong de Shanghái lanzó el gran modelo de síntesis química Magnolia (Chemma), logrando por primera vez que un gran modelo de lenguaje químico acelere todo el proceso de síntesis orgánica. Chemma no necesita computación cuántica, solo se basa en la comprensión del conocimiento químico y la capacidad de razonamiento, superando los mejores resultados existentes en tareas como la retrosíntesis de un solo paso/múltiples pasos, la predicción de rendimiento/selectividad y la optimización de reacciones. Su marco de aprendizaje activo de colaboración humano-máquina “Co-Chemist” ha sido verificado con éxito en reacciones reales, proporcionando un nuevo paradigma para el descubrimiento químico. (Fuente: WeChat)

Intern-Robotics: Motor de pila completa encarnada de Shanghai AI Lab : Shanghai AI Lab ha lanzado su motor de pila completa encarnada, Intern-Robotics, con el objetivo de impulsar el “momento ChatGPT” en el campo de la inteligencia encarnada. Este motor es una infraestructura abierta y compartida que se centra en lograr la generalización de la ontología, la generalización del escenario y la generalización de la tarea, y enfatiza que la tasa de éxito de las operaciones se acerque al 100%. El equipo se dedica a resolver el problema de la escasez de datos a través de la ruta técnica “Real to Sim to Real” y el aprendizaje por refuerzo en el mundo real, logrando gradualmente la generalización de cero-shot y acelerando la implementación de la inteligencia encarnada. (Fuente: WeChat)

SQLM: Marco de evolución de la capacidad de razonamiento de IA mediante auto-pregunta y auto-respuesta : El equipo de la Universidad Carnegie Mellon propuso SQLM, un marco de auto-pregunta que no requiere datos externos, y que mejora la capacidad de razonamiento de la IA a través de la auto-pregunta y auto-respuesta. Este marco incluye dos roles: proponente (proposer) y solucionador (solver), ambos entrenados mediante aprendizaje por refuerzo para maximizar la recompensa esperada. SQLM mejoró significativamente la precisión del modelo en tareas de aritmética, álgebra y programación, proporcionando un proceso auto-sostenible y escalable para que los grandes modelos de lenguaje logren mejoras de capacidad en ausencia de datos anotados manualmente de alta calidad. (Fuente: WeChat)

CompassVerifier: Modelo de verificación de respuestas de IA y conjunto de evaluación : Shanghai AI Lab y la Universidad de Macao lanzaron conjuntamente CompassVerifier, un modelo de verificación de respuestas universal, y VerifierBench, un conjunto de evaluación, con el objetivo de abordar el problema de que la capacidad de entrenamiento de los grandes modelos avanza rápidamente, pero la capacidad de verificación de respuestas se retrasa. CompassVerifier es un verificador universal multidominio ligero pero potente, optimizado basado en los modelos de la serie Qwen, que logra una precisión de verificación que supera a los modelos grandes generales en múltiples dominios como matemáticas, conocimiento y razonamiento científico, y puede servir como modelo de recompensa para el aprendizaje por refuerzo, proporcionando feedback preciso para la optimización iterativa de los LLM. (Fuente: WeChat)

CoAct-1: Agente de uso de computadora con codificación como acción : Investigadores han propuesto CoAct-1, un sistema multi-Agente que mejora las acciones a través de la codificación, diseñado para abordar los problemas de eficiencia y fiabilidad de los Agentes de operación GUI en tareas complejas. El Orchestrator de CoAct-1 puede delegar dinámicamente subtareas a un GUI Operator o a un Programmer Agent (capaz de escribir y ejecutar scripts Python/Bash), evitando así operaciones GUI ineficientes. Este método logró una tasa de éxito SOTA en el benchmark OSWorld y mejoró significativamente la eficiencia, proporcionando un camino más potente para la automatización general de computadoras. (Fuente: HuggingFace Daily Papers)

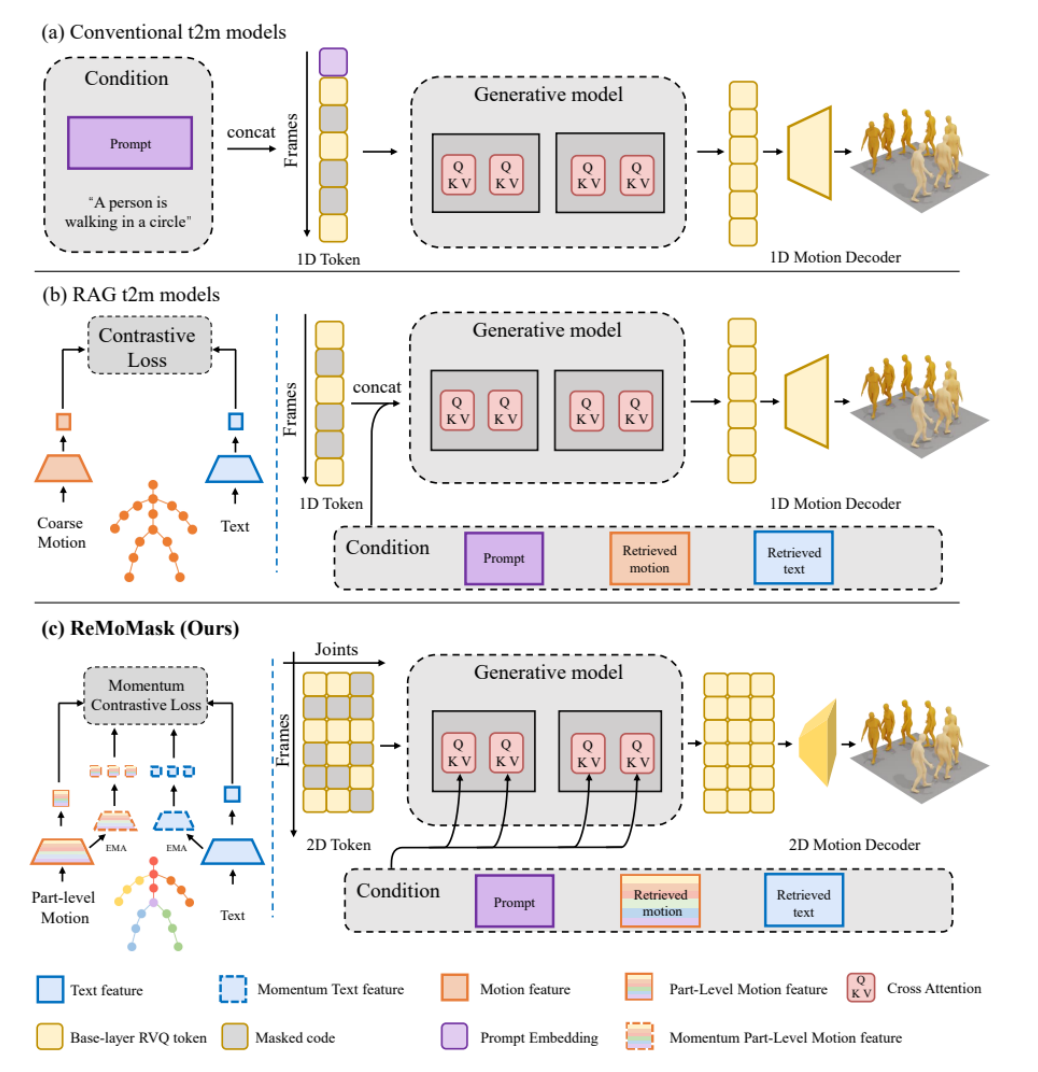

ReMoMask: Nuevo método para la generación de movimientos 3D de alta calidad para juegos : La Universidad de Pekín propone ReMoMask, un marco Text-to-Motion basado en generación aumentada por recuperación, diseñado para generar movimientos 3D fluidos y realistas de alta calidad a partir de una sola instrucción. ReMoMask integra un modelo bidireccional de texto a movimiento basado en impulso, un mecanismo de atención espacio-temporal semántica y guía RAG-Classifier-Free, generando eficientemente movimientos temporalmente coherentes. Este método estableció un nuevo rendimiento SOTA en benchmarks estándar como HumanML3D y KIT-ML, y se espera que revolucione los procesos de producción de juegos y animación. (Fuente: WeChat)

Revisión de WebAgents: Grandes modelos que potencian la automatización web : Investigadores de la Universidad Politécnica de Hong Kong publicaron la primera revisión de WebAgents, que resume exhaustivamente los avances de la investigación en grandes modelos que potencian a los Agentes de IA para lograr la próxima generación de automatización web. La revisión, desde las perspectivas de arquitectura (percepción, planificación y razonamiento, ejecución), entrenamiento (datos, políticas) y fiabilidad (seguridad, privacidad, generalización), resume los métodos representativos de WebAgents y discute futuras direcciones de investigación, como la equidad, la interpretabilidad, los conjuntos de datos y los WebAgents personalizados, proporcionando una guía para construir sistemas de automatización web más inteligentes y seguros. (Fuente: WeChat)

InfiAlign: Marco de alineación para la capacidad de razonamiento de LLM : InfiAlign es un marco de post-entrenamiento escalable y eficiente en muestras que combina SFT y DPO para alinear LLM y mejorar las capacidades de razonamiento. El núcleo de este marco es un potente pipeline de selección de datos que puede filtrar automáticamente datos de alineación de alta calidad de conjuntos de datos de razonamiento de código abierto. InfiAlign logró un rendimiento comparable al de DeepSeek-R1-Distill-Qwen-7B en el modelo Qwen2.5-Math-7B-Base, pero utilizando solo aproximadamente el 12% de los datos de entrenamiento, y logró mejoras significativas en tareas de razonamiento matemático, proporcionando una solución práctica para la alineación de grandes modelos de razonamiento. (Fuente: HuggingFace Daily Papers)

💼 Negocios

Plan de monetización de opciones para empleados de OpenAI para evitar la fuga de talentos : Para contrarrestar la fuga de talentos, OpenAI ha lanzado una nueva ronda del plan de monetización de opciones para empleados, monetizando a una valoración de 500 mil millones de dólares, con el objetivo de retener el talento con incentivos financieros tangibles. Se espera que esta medida impulse la valoración de OpenAI a un nuevo máximo. Al mismo tiempo, ChatGPT ha alcanzado los 700 millones de usuarios activos semanales, los usuarios empresariales de pago han aumentado a 5 millones, y se espera que los ingresos recurrentes anuales superen los 20 mil millones de dólares, lo que demuestra una buena trayectoria de desarrollo de OpenAI en términos de producto y comercialización. (Fuente: 量子位)

Amazon Web Services construye la plataforma de agregación de modelos de IA más grande : Amazon Web Services (AWS) ha anunciado que el modelo gpt-oss de OpenAI es accesible por primera vez a través de Amazon Bedrock y Amazon SageMaker, enriqueciendo aún más su ecosistema de modelos bajo la estrategia “Choice Matters” (La elección importa). AWS ahora ofrece más de 400 modelos grandes comerciales y de código abierto principales, con el objetivo de permitir a las empresas elegir el modelo más adecuado según el rendimiento, el costo y los requisitos de la tarea, en lugar de buscar un único modelo “más potente”, promoviendo la sinergia y la eficiencia de múltiples modelos. (Fuente: 量子位)

Ant Group invierte en una empresa de manos diestras de inteligencia encarnada : Ant Group ha liderado una ronda de financiación ángel de cientos de millones para Lingxin Qiaoshou, una empresa de inteligencia encarnada especializada en manos diestras. Lingxin Qiaoshou es la única empresa en el mundo que ha logrado la producción en masa de miles de manos diestras de alta libertad, con una cuota de mercado del 80%. Su serie de manos diestras Linker Hand cuenta con alta libertad, sistemas multisensor y ventajas de costo, y ya se ha implementado en escenarios industriales y médicos. Esta financiación se utilizará para la reserva tecnológica y la construcción de instalaciones de recopilación de datos, acelerando el despliegue de manos diestras en aplicaciones prácticas. (Fuente: 量子位)

🌟 Comunidad

Experiencia de usuario de GPT-5 polarizada : Tras el lanzamiento de GPT-5, el feedback de los usuarios es mixto. Algunos usuarios elogian sus mejoras significativas en tareas de programación y razonamiento complejo, considerando que la generación de código es más limpia y precisa, y que tiene una capacidad extremadamente fuerte para manejar contextos largos. Sin embargo, otros usuarios están decepcionados por la disminución de la personalización del modelo, la escritura creativa y las capacidades de apoyo emocional, considerando que se ha vuelto “aburrido” y “sin alma”, y que el mecanismo de enrutamiento del modelo ha llevado a una experiencia inestable, incluso algunos usuarios cancelaron su suscripción por ello. (Fuente: Reddit r/ChatGPT & Reddit r/LocalLLaMA & Reddit r/ChatGPT & Reddit r/ChatGPT)

Aplicación y controversias de la IA en la crianza de los hijos : Los padres que trabajan están utilizando herramientas de IA como ChatGPT como “co-padres”, aprovechándolas para planificar comidas, optimizar rutinas para dormir e incluso ofrecer apoyo emocional. Un espacio sin juicios para desahogarse proporcionado por la IA alivia la carga mental de los padres. Sin embargo, esta tecnología emergente también ha generado controversia, incluyendo la posibilidad de consejos inexactos, riesgos de fuga de privacidad (como el incidente de fuga de datos de ChatGPT), y la dependencia excesiva de la IA que podría llevar al aislamiento en las relaciones interpersonales y a posibles impactos ambientales. (Fuente: 36氪)

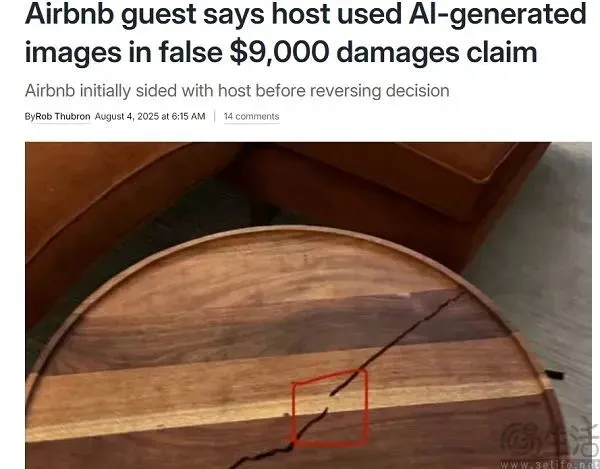

Incidente de Airbnb: Usuario obligado a pagar compensación por imágenes falsificadas con IA : Airbnb experimentó un incidente en el que un anfitrión utilizó IA para falsificar imágenes y estafar a un usuario para que pagara una compensación, subrayando los riesgos de la IA en el servicio al cliente. El servicio al cliente de IA no pudo identificar las imágenes generadas por IA, lo que llevó a que el usuario fuera erróneamente considerado responsable de la compensación. Aunque OpenAI lanzó un detector de imágenes, la identificación de IA por IA aún tiene limitaciones, especialmente frente a la tecnología de “falsificación parcial”. El incidente ha generado preocupaciones sobre la fiabilidad de las herramientas de detección de contenido de IA y la capacidad de las plataformas C2C para hacer frente al impacto del contenido deepfake. (Fuente: 36氪)

Líderes de IA de Silicon Valley construyen búnkeres apocalípticos, generando debate : Se ha revelado que líderes de la IA de Silicon Valley como Mark Zuckerberg y Sam Altman están construyendo o poseen refugios apocalípticos, generando preocupación pública sobre el futuro desarrollo de la IA y sus riesgos potenciales. Aunque niegan que esté relacionado con la IA, esta medida se interpreta como una medida de precaución contra emergencias como pandemias, ciberguerras y desastres climáticos. La comunidad debate si aquellos que mejor entienden la tecnología de IA han visto indicios desconocidos para la gente común, y si el desarrollo de la IA ya ha traído riesgos impredecibles. (Fuente: 量子位)

o3 gana el Campeonato Internacional de Ajedrez de IA de Kaggle : En la final del primer Campeonato Internacional de Ajedrez de IA de Google Kaggle, o3 de OpenAI barrió a Grok 4 de Musk por 4-0, ganando el campeonato. Esta partida fue vista como una “guerra de agentes” entre OpenAI y xAI, con el objetivo de poner a prueba el pensamiento crítico, la planificación estratégica y la capacidad de reacción en tiempo real de los grandes modelos. Aunque Grok 4 había mostrado un fuerte impulso anteriormente, cometió errores frecuentes en la final, mientras que o3, por su parte, demostró una estrategia sistemática y estable, sin perder una sola partida, convirtiéndose en el campeón invicto. (Fuente: WeChat)

Debate sobre la entrada de la IA en el “valle de la desilusión” : Han surgido muchas discusiones en las redes sociales, sugiriendo que la IA ha entrado en el “valle de la desilusión”, especialmente después del lanzamiento de GPT-5. Los usuarios señalan que las limitaciones de la IA no se han superado eficazmente, y que los beneficios derivados del aumento del tamaño del modelo y la potencia de cálculo están disminuyendo. Esta perspectiva sostiene que el progreso de la IA se ha vuelto “menos obvio”, manifestándose principalmente en campos especializados, no a un nivel perceptible para el usuario común, lo que sugiere que el desarrollo de la IA podría estar entrando en una fase de meseta, requiriendo avances arquitectónicos completamente nuevos. (Fuente: Reddit r/ArtificialInteligence)

💡 Otros

Docker advierte sobre riesgos de seguridad en la cadena de herramientas MCP : Docker ha emitido una advertencia, señalando que las cadenas de herramientas de desarrollo impulsadas por IA, construidas sobre el Protocolo de Contexto del Modelo (MCP), presentan graves vulnerabilidades de seguridad, incluyendo fuga de credenciales, acceso no autorizado a archivos y ejecución remota de código, y que ya se han producido casos reales. Estas herramientas incrustan LLM en entornos de desarrollo, otorgándoles permisos de operación autónomos, pero carecen de aislamiento y supervisión. Docker recomienda evitar instalar servidores MCP desde npm, y en su lugar usar contenedores firmados, enfatizando la importancia del aislamiento de contenedores y las redes de confianza cero. (Fuente: WeChat)

Plan de incentivos para desarrolladores de aplicaciones HarmonyOS 2025 de Huawei : Huawei ha anunciado que el número de dispositivos HarmonyOS 5 ha superado los diez millones, y ha lanzado el “Plan de Incentivos para Desarrolladores de Aplicaciones HarmonyOS 2025”, invirtiendo cientos de millones en subsidios, con un máximo de 6 millones de yuanes en premios por desarrollador. Este plan tiene como objetivo acelerar el desarrollo del ecosistema HarmonyOS, atrayendo a desarrolladores para que creen aplicaciones orientadas a la IA y a múltiples dispositivos, logrando un “desarrollo único, despliegue multidispositivo”. Huawei ofrece soporte de desarrollo de pila completa, incluyendo habilitación tecnológica, pruebas rápidas, publicación y operación eficientes, con el objetivo de construir un ecosistema de desarrolladores sólido. (Fuente: WeChat)

Lanzamiento del servidor de supernodo de IA nacional Yuanbrain SD200 : Inspur Information ha lanzado el servidor de IA de supernodo “Yuanbrain SD200”, diseñado para abordar los desafíos de la potencia de cálculo para ejecutar modelos grandes con billones de parámetros. Este servidor adopta una arquitectura de comunicación semántica de memoria de baja latencia multi-host desarrollada de forma innovadora, que puede agregar 64 chips GPU locales, proporcionando hasta 4TB de VRAM unificada y 64GB de memoria unificada, y soporta modelos de secuencia ultralarga de billones. Las pruebas reales muestran que el SD200 logra una excelente eficiencia de escalado de potencia de cálculo en modelos como DeepSeek R1, proporcionando un potente soporte para aplicaciones en AI4 Science y el sector industrial. (Fuente: WeChat)