Palabras clave:Memoria de IA, Modelo de código abierto, Agente de IA, Multimodal, Red neuronal, Generación de vídeo con IA, IA médica, Conducción autónoma, Sistema de memoria multimodal MIRIX, Modelo de inferencia Llama Nemotron Super v1.5, Arquitectura MoE Qwen3-30B-A3B-Instruct-2507, Agente de inteligencia científica universal SciMaster, Chip Tesla FSD HW5.0

Aquí tienes la traducción del contenido al español, manteniendo todos los requisitos:

🔥 ENFOQUE

Por primera vez a nivel mundial, la “memoria de IA” de código abierto se implementa con el lanzamiento simultáneo de la APP MIRIX: Investigadores de la Universidad de California San Diego y la Universidad de Nueva York han lanzado y hecho de código abierto MIRIX, el primer sistema de memoria de IA multimodal y multi-agente a nivel mundial. Este sistema integra por primera vez la “memoria a largo plazo multimodal” en el sistema operativo subyacente de la IA, logrando una comprensión profunda y un seguimiento a largo plazo a través de seis módulos de memoria y flujos de trabajo multi-agente. En tareas de diálogo largo como ScreenshotVQA y LOCOMO, MIRIX supera con creces los métodos tradicionales de RAG y texto largo. Además, ha lanzado simultáneamente una APP de escritorio que soporta almacenamiento local, con el objetivo de construir un asistente personal de IA exclusivo para los usuarios. (Fuente: 36氪)

Nuevo modelo de código abierto de NVIDIA: triple rendimiento, ejecutable en una sola tarjeta y logra el SOTA en inferencia: NVIDIA ha lanzado Llama Nemotron Super v1.5, un modelo de código abierto diseñado específicamente para tareas complejas de inferencia y Agent. Optimizado mediante Neural Architecture Search (NAS), este modelo logra un rendimiento SOTA en tareas científicas, matemáticas, de programación y Agent, al mismo tiempo que triplica el rendimiento de su predecesor y puede ejecutarse eficientemente en una sola tarjeta, logrando alta precisión, alto rendimiento y bajo consumo de recursos. Pertenece al ecosistema NVIDIA Nemotron y tiene como objetivo proporcionar soluciones de alto rendimiento, gran control y fácil escalabilidad para el desarrollo de aplicaciones de IA a nivel empresarial. (Fuente: 量子位)

Lanzamiento del modelo Qwen3-30B-A3B-Instruct-2507: El equipo de Qwen de Alibaba Cloud ha lanzado el modelo Qwen3-30B-A3B-Instruct-2507. Este modelo, con arquitectura MoE, tiene solo 3B de parámetros activos, pero su rendimiento ha mejorado significativamente, especialmente en razonamiento matemático (AIME25 de 21.4 a 61.3) y comprensión de contexto largo (256K tokens), y soporta implementación local. Su rendimiento se acerca al de GPT-4o y Qwen3-235B-A22B en modo no-pensamiento, lo que lo convierte en un avance importante en el campo del código abierto. Ya está disponible en Hugging Face en versiones cuantificadas GGUF y MLX, y ha recibido una amplia atención de la comunidad. (Fuente: Reddit r/LocalLLaMA)

SciMaster: el primer agente científico universal del mundo: La Universidad Jiao Tong de Shanghái y DeepMotion AI han lanzado y hecho de código abierto SciMaster, con el objetivo de convertirse en el asistente de investigación experto para todos. Este agente científico universal combina recursos de toda la web y 170 millones de publicaciones científicas para ofrecer capacidades de investigación profunda a nivel de experto, soportando múltiples métodos de recuperación como WebSearch, WebParse y PaperSearch, y puede corregir errores y complementar información automáticamente. SciMaster también integra varias herramientas científicas especializadas, soportando la invocación activa y automática, con el fin de remodelar el paradigma de investigación universitaria e impulsar el desarrollo del campo AI4S. (Fuente: 量子位)

🎯 TENDENCIAS

Avances en la “Batalla de los Tres Reinos” de modelos de video de IA nacionales: En el campo de la generación de video por IA en China, Kuaishou Keling AI, SenseTime Vidu y ByteDance Jiemeng AI están en una intensa competencia. Keling AI destaca por su gran expresividad, adecuada para contenido dramático; Vidu sobresale por su realismo y detalle, experto en simular leyes físicas; mientras que Jiemeng AI se impone por su equilibrio, controlabilidad y atributos de herramienta completos. Los tres han logrado avances en el problema de la coherencia, con rutas técnicas distintas. Keling y Jiemeng, debido a su potencial a nivel de aplicación y ecosistema, son considerados los competidores más fuertes para ser los ganadores finales. (Fuente: 36氪)

Microsoft Edge lanza el modo Copilot: El navegador Microsoft Edge entra oficialmente en el mercado de navegadores de IA con el lanzamiento del modo Copilot, que puede leer y comprender el contenido de páginas web, resumir videos de YouTube, comparar información de productos en múltiples pestañas y soportar interacción por voz. Este modo aún se encuentra en fase experimental, ofreciendo funciones gratuitas similares a ChatGPT DeepResearch, con el objetivo de transformar el navegador en una herramienta de asistencia más inteligente. Sin embargo, sus funciones no difieren mucho de las de los navegadores de IA existentes y enfrenta desafíos de privacidad del usuario y aceptación. (Fuente: 36氪)

La IA médica regresa con fuerza con empoderamiento sistemático y desarrollo especializado: La WAIC 2025 muestra que la IA médica “regresa con fuerza”, con grandes empresas y startups entrando en el campo. La IA está pasando de empoderar “nodos” para resolver problemas específicos a empoderar “enlaces” (o “fases”), logrando una gestión integral de la salud y asistencia diagnóstica y terapéutica a través de Agent, como el “Asistente de Gestión de Salud” de Tencent Health. Al mismo tiempo, la IA evoluciona de modelos generales a modelos especializados verticales, resolviendo problemas clínicos profundos, como “Jingyi Qianxun 2.0” de JD Health y el “Agente Inteligente de Exploración Múltiple de Tórax” de United Imaging Intelligence, mejorando la eficiencia y precisión del diagnóstico y tratamiento. (Fuente: 36氪)

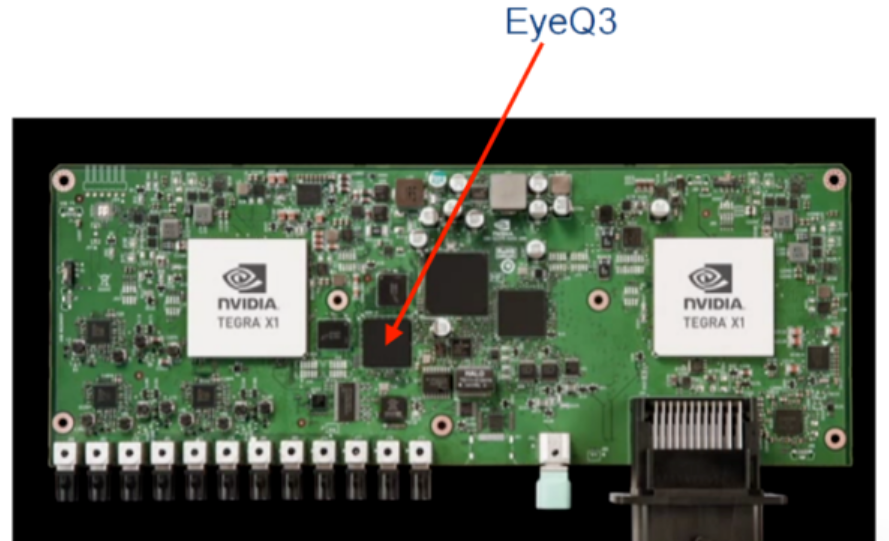

Los chips FSD de Tesla continúan iterando, apuntando a la conducción autónoma de nivel L4: Los chips de conducción inteligente de Tesla han evolucionado de depender de proveedores externos (Mobileye, NVIDIA) a desarrollar sus propios chips FSD de pila completa. Las versiones HW3.0 y HW4.0 se han lanzado sucesivamente, con mejoras significativas en la capacidad de cómputo y la relación eficiencia energética, fortaleciendo la capacidad de adaptación a escenarios complejos. El chip HW5.0/AI5 ya ha entrado en producción en masa, utilizando el proceso de 3nm de TSMC, con una capacidad de cómputo de 2000-2500TOPS, y se espera que se produzca en masa a gran escala en 2026, impulsando la implementación de la conducción autónoma de nivel L4 y remodelando el panorama del mercado de chips de conducción inteligente. (Fuente: 36氪)

🧰 HERRAMIENTAS

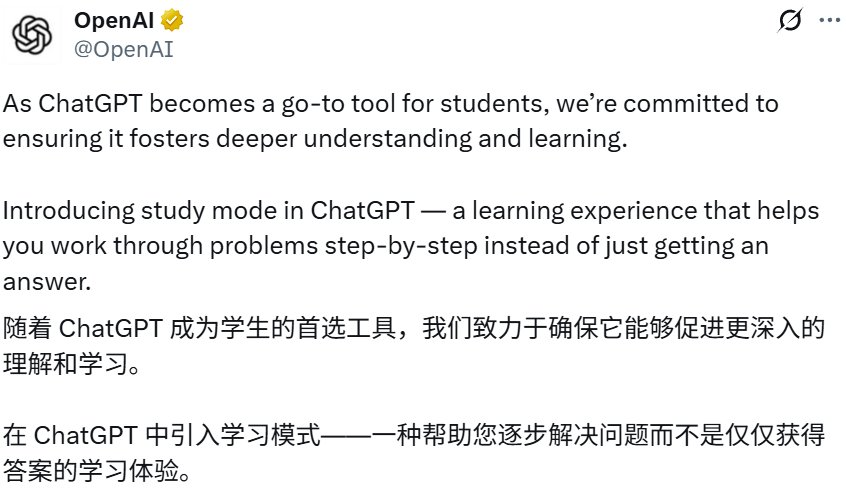

ChatGPT lanza el “modo de aprendizaje”: OpenAI ha lanzado el “modo de aprendizaje” de ChatGPT, diseñado para ayudar a los usuarios a resolver problemas gradualmente, profundizando su comprensión, en lugar de dar respuestas directas, a través de preguntas socráticas, preguntas guiadas y retroalimentación personalizada. Este modo está disponible para todos los usuarios (incluidos los gratuitos) y está impulsado por instrucciones de sistema personalizadas, escritas en colaboración con expertos en educación, con el objetivo de fomentar el pensamiento crítico y la capacidad de autoaprendizaje, marcando una exploración más profunda de ChatGPT en aplicaciones educativas. (Fuente: 36氪)

Google NotebookLM añade la función de resumen de video: Google NotebookLM ha lanzado la función de resumen de video, como una alternativa visual al resumen de audio. Los usuarios pueden usar un presentador de IA para generar automáticamente resúmenes de video cortos que incluyen imágenes, gráficos, citas y datos, logrando una visualización más clara de conceptos complejos o con mucho texto, mejorando la eficiencia del aprendizaje y la comprensión. Esta función actualmente soporta inglés y está disponible en la versión de escritorio. (Fuente: Google)

Claude Code soporta trabajo con múltiples directorios: Claude Code de Anthropic se ha actualizado para soportar el trabajo con múltiples directorios en una sola sesión; los usuarios pueden ingresar /add-dir para añadir directorios de trabajo. Esta función mejora significativamente la conveniencia de operar con bases de código, permitiendo la migración de código dentro de un proyecto o entre proyectos sin cambiar de sesión, y puede obtener archivos de memoria o reglas externas, mejorando la experiencia de programación colaborativa con Agent. (Fuente: dotey)

Tongyi Lingma lanza Qwen3-Coder: Tongyi Lingma de Alibaba Cloud ha lanzado el modelo de programación de IA Qwen3-Coder, que los usuarios pueden usar de forma gratuita en Tongyi Lingma AI IDE, VSCode y los plugins de Jetbrains. Qwen3-Coder mejora significativamente la velocidad y precisión de la generación de código en escenarios de desarrollo empresarial reales, y proporciona una mejor experiencia de programación colaborativa con Agent. Este modelo ha llegado a la cima de la clasificación de modelos de Hugging Face y es considerado el modelo de programación de código abierto más potente del mundo, comparable a Claude4. (Fuente: 量子位)

BlockDL: constructor visual de redes neuronales: BlockDL es una herramienta GUI gratuita y de código abierto que permite a los usuarios diseñar visualmente redes neuronales Keras mediante módulos de arrastrar y soltar, y ofrece generación instantánea de código y funciones de validación de forma en tiempo real, ayudando a los desarrolladores a realizar diseños creativos rápidamente y evitar errores tempranos. La herramienta también incluye un sistema de aprendizaje completo y soporta estructuras avanzadas como conexiones de salto y modelos de múltiples entradas/salidas. (Fuente: fchollet)

PopAi AI Slides Agent: PopAi ha lanzado AI Slides Agent; los usuarios solo necesitan un prompt para que el agente de IA genere automáticamente diapositivas de PPT atractivas. Esta herramienta tiene como objetivo que la IA comprenda las ideas del usuario, logrando una creación de diapositivas inteligente, rápida y sencilla, mejorando significativamente la eficiencia en la producción de presentaciones. (Fuente: kaifulee)

📚 APRENDIZAJE

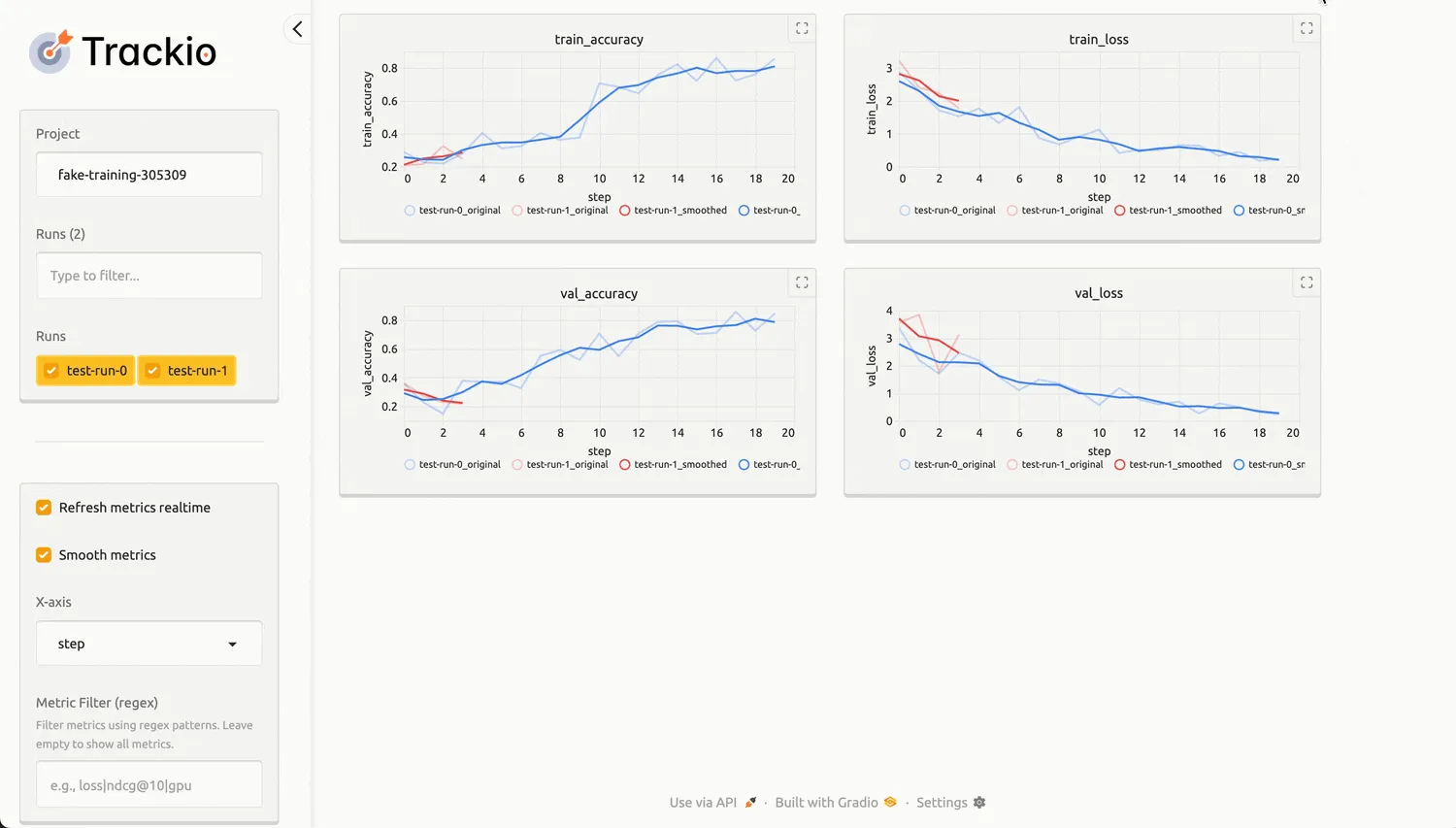

Hugging Face lanza Trackio, una biblioteca ligera de seguimiento de experimentos: Hugging Face ha lanzado Trackio, una biblioteca Python de código abierto diseñada para proporcionar una solución ligera y local-first para el seguimiento de experimentos de aprendizaje automático. Trackio es compatible con la API de wandb, permite compartir fácilmente el progreso del entrenamiento y gráficos incrustados, y estandariza el registro transparente de métricas como el consumo de energía de la GPU. Está construida sobre Gradio y Hugging Face Spaces, lo que facilita a los usuarios visualizar y compartir los resultados de los experimentos, y puede integrarse de forma nativa con las bibliotecas Transformers y Accelerate. (Fuente: HuggingFace Blog)

Aplicación de LangChain y LangGraph en la ingeniería de contexto: LangChain y LangGraph ofrecen varios métodos de ingeniería de contexto para ayudar a los desarrolladores a optimizar el rendimiento de las aplicaciones LLM. LangGraph, a través de sistemas multi-agente, ayuda a empresas (como Bertelsmann) a reducir el tiempo de descubrimiento de contenido de horas a segundos, logrando el despliegue de Agent especializados en diferentes dominios de contenido y la reutilización modular de API. La nueva función Align Evals de LangSmith también simplifica la construcción de evaluadores LLM-as-judge, haciendo que sus puntuaciones estén más alineadas con las preferencias humanas. (Fuente: LangChainAI)

Generación de problemas matemáticos y aumento de complejidad de LLM: El proyecto SAND-Math propone un pipeline para que los LLM generen problemas y soluciones matemáticas novedosos, difíciles y útiles. Este método primero genera problemas de alta calidad y luego aumenta sistemáticamente su complejidad a través de un paso de “aumento de dificultad”. El algoritmo EDGE-GRPO mitiga eficazmente el problema de colapso de la ventaja en el aprendizaje por refuerzo a través de la “ventaja impulsada por la entropía” y la “corrección de errores guiada”, mejorando el rendimiento de inferencia de los LLM. El marco MaPPO, por su parte, mejora la alineación de los LLM con las preferencias humanas al integrar el conocimiento de recompensa a priori en el objetivo de optimización. Estas investigaciones impulsan conjuntamente los avances de los LLM en el razonamiento matemático y el aprendizaje por refuerzo. (Fuente: HuggingFace Daily Papers)

CIRCLE: benchmark de seguridad para intérpretes de código LLM: CIRCLE (Code-Interpreter Resilience Check for LLM Exploits) es un benchmark simple para evaluar los riesgos de ciberseguridad a nivel de sistema de los intérpretes de código LLM. Contiene 1260 prompts dirigidos al agotamiento de recursos de CPU, memoria y disco, con el objetivo de evaluar si el LLM rechaza o genera código peligroso, y ejecuta el código en el entorno del intérprete para evaluar su corrección o tiempo de espera. Las pruebas revelaron vulnerabilidades significativas e inconsistentes en los modelos comerciales, especialmente una capacidad de defensa disminuida ante prompts indirectos o de ingeniería social. (Fuente: HuggingFace Daily Papers)

Alineación de objetivos en simuladores de usuario LLM: La investigación revela las limitaciones de los simuladores de usuario LLM actuales para mantener un comportamiento orientado a objetivos en diálogos de múltiples turnos. Se propone el marco User Goal State Tracking (UGST) para rastrear el progreso de los objetivos del usuario, y se desarrollan simuladores de usuario capaces de rastrear objetivos de forma autónoma y generar respuestas alineadas con los objetivos. Este método mejora significativamente el rendimiento de alineación de objetivos en los benchmarks MultiWOZ 2.4 y τ-Bench. (Fuente: HuggingFace Daily Papers)

Tutorial de ajuste fino de modelos de completado de código LLM: Oxen.ai ha lanzado una serie de tutoriales que explican cómo ajustar modelos de completado de código “tab tab” rápidos y locales para notebooks Marimo. El objetivo es crear modelos de código abierto que ofrezcan una experiencia de completado de código similar a Cursor, soportando la ejecución local o el acceso a través de una API gratuita. Los experimentos iniciales muestran que los modelos Qwen y Llama ajustados ya alcanzan un rendimiento a nivel de GPT-4 en el conjunto de datos MBPP. (Fuente: Reddit r/MachineLearning)

Nuevos avances en la teoría de redes neuronales y el aprendizaje de representaciones: Ante el creciente rigor en el diseño de arquitecturas de redes neuronales, un estudiante de doctorado busca recomendaciones de libros de matemáticas para guiar su investigación teóricamente, en lugar de solo por intuición. Al mismo tiempo, la comunidad ha discutido las últimas ideas en el aprendizaje de representaciones, incluyendo el aprendizaje Matryoshka y el aprendizaje contrastivo, y busca nuevas “técnicas” de redes neuronales desarrolladas en los últimos 2-3 años para construir mejores representaciones, abarcando problemas de aprendizaje no supervisado y supervisado. Además, el marco X-Omni ha mejorado los modelos de generación de imágenes autorregresivos discretos mediante el aprendizaje por refuerzo, logrando una integración perfecta de la generación de imágenes y lenguaje. (Fuente: Reddit r/MachineLearning)

💼 NEGOCIOS

Impacto polarizado de la IA en el mercado laboral: La IA está cambiando significativamente el mercado laboral, especialmente en la contratación y los despidos. La industria tecnológica ha visto recortes de personal de aproximadamente 80.000 personas debido a la automatización por IA (como el plan de Microsoft de despedir a 15.000 personas), mientras que fuera del sector tecnológico, la demanda de habilidades de IA se ha disparado, con una prima salarial del 28% para los puestos relacionados, un aumento promedio de casi 18.000 dólares anuales. Campos como el marketing, los recursos humanos y las finanzas están integrando rápidamente herramientas de IA, y las habilidades compuestas de IA (como comunicación, liderazgo) son muy solicitadas. (Fuente: 36氪)

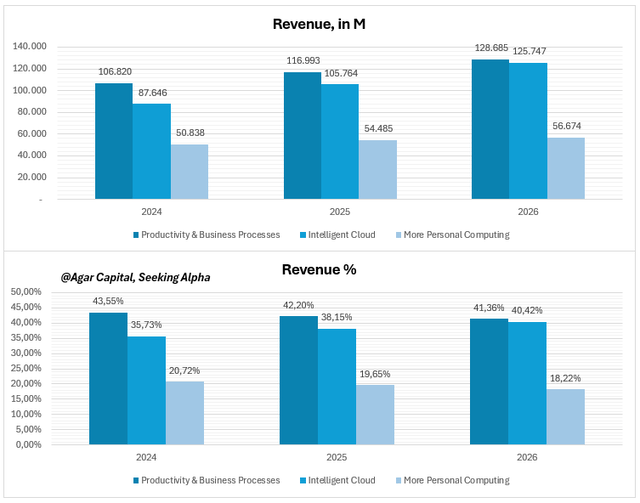

Perspectivas del informe financiero de Microsoft para el cuarto trimestre: la IA aumenta los márgenes de beneficio, no es una apuesta arriesgada: La estrategia de IA de Microsoft ha evolucionado de la tecnología de vanguardia a la infraestructura económica; la IA se ha integrado profundamente en negocios centrales como Azure Cloud, Copilot y Office, y ha comenzado a generar retornos. Las cargas de trabajo de IA impulsaron un crecimiento interanual del 34% en Azure Cloud, y los usuarios empresariales de Copilot alcanzaron los 200.000, con un crecimiento acelerado del ARPU. Los analistas consideran que Microsoft está infravalorada, y sus altos márgenes de beneficio y flujo de caja demuestran que la IA se ha convertido en una “superpotencia” monetizable, no solo una historia. (Fuente: 36氪)

Comercialización de AI Agent: ¿Quién puede convertirse en la “vaca lechera”?: La WAIC 2025 muestra que los AI Agent han pasado del concepto a la implementación, especialmente en servicios empresariales, inteligencia industrial, tecnología financiera y hardware inteligente. Las plataformas de Agent rentables generalmente tienen un alto valor promedio por cliente (más de 500.000 yuanes anuales) y altos márgenes brutos (≥60%), monetizando a través de modos avanzados como “vender el acceso” (vinculación a nivel de sistema), “participación en los resultados” (porcentaje de ahorro) y “vender por unidad de recurso” (recursos humanos de IA en la nube). Las barreras centrales radican en la profunda integración en los procesos de negocio, el cumplimiento de la normativa del sector y la capacidad de integración con sistemas antiguos. (Fuente: 36氪)

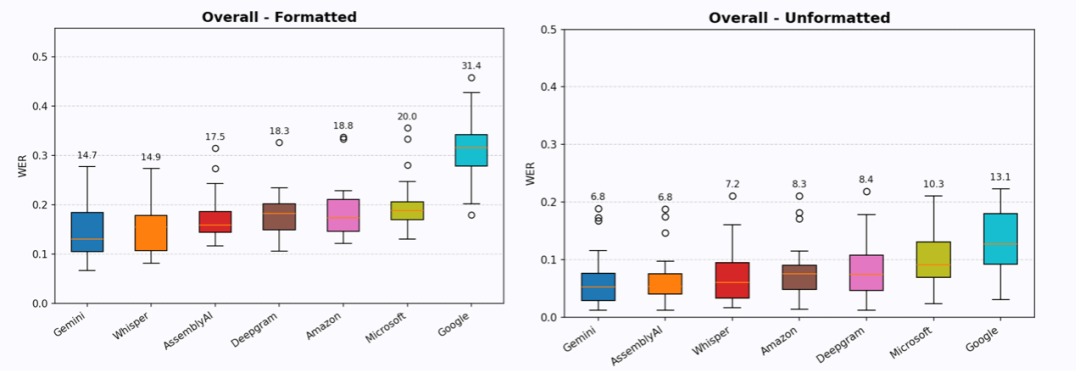

El sector de entrada de voz por IA recibe millones de dólares en financiación: Las startups de entrada de voz Willow Voice y Wispr Flow han completado recientemente rondas de financiación ángel de 4.2 millones de dólares y Serie A de 30 millones de dólares respectivamente, lo que demuestra el interés del capital en la “entrada” de voz por IA, no solo en la “salida”. Estas empresas tienen como objetivo proporcionar servicios de voz a texto de “información sin edición”, produciendo texto directamente utilizable a través de formateo, comprensión contextual y reconocimiento de contexto. Aunque aún hay una brecha, su alta retención de usuarios y tasa de pago indican que la entrada de voz tiene un enorme potencial para reducir la fricción en la interacción humano-máquina y mejorar la eficiencia, y se espera que reemplace el teclado como nuevo paradigma de interacción humano-máquina. (Fuente: 36氪)

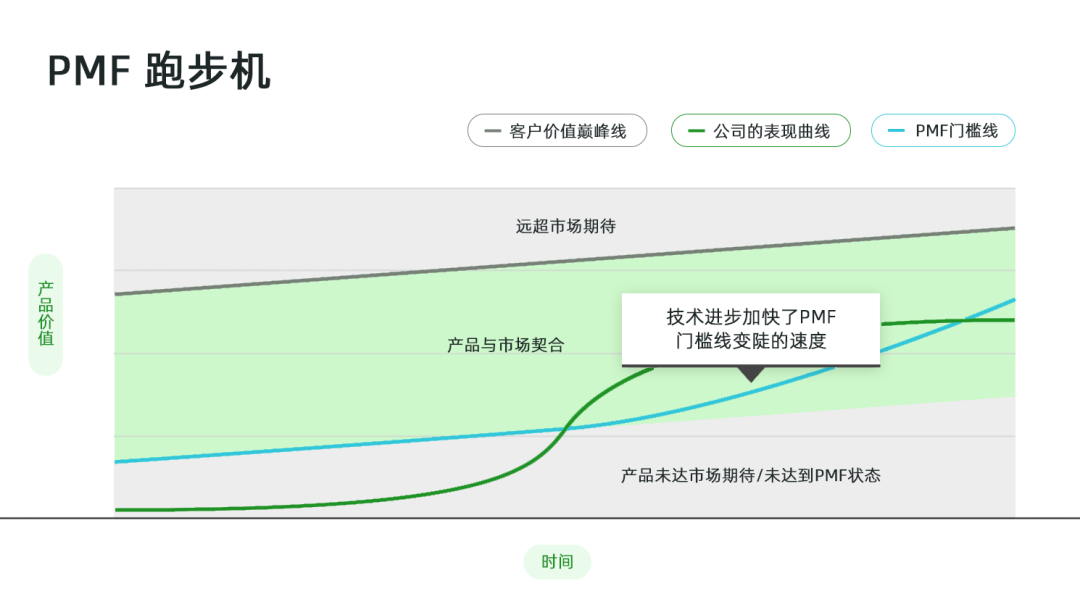

El impacto acelerado de la IA en el Product-Market Fit (PMF): En la era de la IA, el PMF pasa de ser un hito estático a una cinta de correr acelerada. La proliferación de herramientas de IA acelera la velocidad a la que los productos son reemplazados, y las expectativas de los usuarios crecen exponencialmente, lo que aumenta el riesgo de “pérdida de PMF”. Las empresas deben monitorear de cerca los cambios en las expectativas de los usuarios, utilizando herramientas de IA para agregar feedback; evaluar el nivel de riesgo de pérdida de PMF, como los canales y la frecuencia de uso del producto, el dominio del flujo de trabajo creativo, los datos propietarios y la aceptación de nuevas tecnologías por parte del cliente; y ajustar la estrategia del producto en consecuencia, invirtiendo más recursos en la expansión del PMF o en la redefinición del PMF. (Fuente: 36氪)

GMI Cloud demuestra su capacidad de infraestructura de IA en WAIC2025: GMI Cloud, como proveedor líder mundial de servicios AI Native Cloud, demostró su sólida capacidad de infraestructura de IA en WAIC2025. Sus productos principales incluyen servicios de GPU Cloud (basados en chips de alta gama como H200, B200), Cluster Engine e Inference Engine, con el objetivo de proporcionar a las empresas una infraestructura de IA segura y eficiente. GMI Cloud también lanzó una calculadora de costos de construcción de aplicaciones de IA y una experiencia práctica con Inference Engine, ayudando a los desarrolladores a planificar con precisión e implementar eficientemente aplicaciones de IA, especialmente en mercados extranjeros. (Fuente: 量子位)

🌟 COMUNIDAD

Fases de “pre-entrenamiento” y “post-entrenamiento” de modelos de IA: La discusión en redes sociales divide el entrenamiento de modelos de IA en “Pretraining” y “Post-training”. El pre-entrenamiento se compara con el cálculo preciso de cada segmento y cada gramo de agua por parte de un corredor de maratón, siendo una ciencia elegante realizada por matemáticos e ingenieros de sistemas distribuidos a gran escala; el post-entrenamiento se describe como una “investigación de vaqueros arriesgada”, más experimental y exploratoria, lo que sugiere los desafíos y las características no estandarizadas que enfrenta en aplicaciones prácticas. (Fuente: natolambert)

Rápido desarrollo y desafíos del video generado por IA: Las redes sociales están debatiendo el rápido progreso del video generado por IA, con modelos como Runway Aleph y Alibaba Wan 2.2. Los usuarios se asombran de que “el video ha cambiado para siempre”, pudiendo transformar fácilmente imágenes estáticas en escenas dinámicas e incluso lograr efectos visuales de calidad cinematográfica. Sin embargo, algunos usuarios también señalan deficiencias en la expresión emocional y el control del ritmo en el video de IA, así como la alta demanda de recursos computacionales, y discuten el fenómeno de “Will Smith comiendo espagueti” como un benchmark no oficial para la generación de video por IA, lo que refleja la continua atención de la comunidad a la calidad y el realismo del video de IA. (Fuente: c_valenzuelab)

Exceso de producción de contenido de IA y transferencia de valor: La discusión social señala que, a medida que las herramientas de creación de IA reducen la barrera de producción, la generación de contenido de texto largo de alta calidad se vuelve fácil, lo que lleva a un “exceso de oferta”. Esto hace que las capacidades de curación, verificación, contextualización y síntesis sean más valiosas, y que el “gusto, la teoría de la mente y el discernimiento” se conviertan en clave. Algunos temen que esto conduzca a una “mediocridad generalizada”, pero otros creen que la IA puede acelerar el trabajo e inspirar a más personas a participar en la creación. (Fuente: nptacek)

Debate sobre la seguridad de las API de IA y los modelos de peso abierto: Clement Delangue, CEO de Hugging Face, cuestiona la afirmación de que “la implementación de API de IA es más responsable que los modelos de peso abierto”, argumentando que las API, al reducir la barrera de uso, pueden aumentar significativamente el número de actores maliciosos sin obtener más control. Pide que se detenga la retórica de que “los pesos abiertos no son seguros”, creyendo que la facilidad de uso de las API puede generar una mayor exposición al riesgo. (Fuente: ClementDelangue)

Discusión sobre la paralelización de AI Agent y la mejora de la eficiencia: La comunidad discute si la paralelización de AI Agent puede mejorar significativamente la eficiencia. Algunos comparan esto con el proverbio “nueve mujeres no pueden tener un bebé en un mes”, argumentando que algunas tareas son inherentemente secuenciales y difíciles de paralelizar. Sin embargo, otros señalan que trabajar en paralelo en diferentes ramas/tareas con múltiples Agent puede mejorar la eficiencia, especialmente al manejar otros problemas mientras se espera la respuesta del Agent. La discusión también menciona la Ley de Amdahl, sugiriendo que la eficiencia de la paralelización depende de la naturaleza de la tarea, y enfatiza que los Agent son de bajo costo, por lo que incluso la paralelización parcial puede generar mejoras de eficiencia. (Fuente: Reddit r/ClaudeAI)

Preocupaciones sobre el lanzamiento y el control de la AGI: La comunidad debate intensamente si la AGI se lanzará públicamente. La mayoría cree que la empresa o el país que primero descubra/cree la AGI la mantendrá en estricto secreto para obtener una ventaja enorme, y no la lanzará públicamente fácilmente. Los preocupados creen que la aparición de la AGI podría llevar a la pérdida de control, e incluso superar las expectativas humanas. Algunos también señalan que las empresas, buscando el lucro, la comercializarán, mientras que los gobiernos podrían tomar el control de inmediato. (Fuente: Reddit r/ArtificialInteligence)

Fiabilidad de los LLM y el fenómeno de la “alucinación”: La comunidad discute la fiabilidad de los LLM, comparándolos con el botón “Voy a tener suerte” de Google, sugiriendo que las respuestas de los LLM a veces son puramente al azar. Otros usuarios comparten experiencias de salidas anómalas como “disociación” en Gemini 2.5, lo que genera preocupación por la estabilidad del modelo y el fenómeno de la “alucinación”. Esta incertidumbre significa que los usuarios aún deben verificar cuidadosamente los resultados de los LLM. (Fuente: Reddit r/ArtificialInteligence)

La IA redefine los roles humanos y los nombres de las profesiones: Elon Musk anunció en xAI la abolición del término “investigador”, manteniendo solo “ingeniero”, argumentando que “investigador” es un vestigio del mundo académico y enfatizando la contribución de ingeniería práctica. Este punto de vista ha provocado un debate en la comunidad; algunos están de acuerdo en que al final todos deberían ser ingenieros, pero otros refutan la importancia de la investigación para la ingeniería y cuestionan si esta práctica podría llevar a la fuga de talentos. (Fuente: Yuchenj_UW)

Impacto de la IA en el trabajo del Product Manager (PM): La discusión en redes sociales sobre el impacto de la IA en el trabajo del Product Manager señala que la IA está remodelando el proceso de desarrollo de productos. Algunos creen que la codificación por IA tiene un impacto limitado en los equipos de ingeniería, pero en los equipos de producto y diseño, la IA acelera enormemente la velocidad de iteración a través de la prototipación. Los PM de IA han compartido cómo construir productos para afrontar los cambios impulsados por la IA, enfatizando que la gestión de productos ya no es “codificar por intuición”, sino que requiere una gestión cuidadosa. (Fuente: amasad)

Exploración de la IA y las futuras formas de sociedad: La comunidad discute si la IA puede traer un futuro sin dinero ni trabajo. Algunos creen que la IA puede automatizar la mayor parte del trabajo, liberando a la humanidad para que se centre en el autodesarrollo y la conexión, pero lograr esta utopía requiere cambios a gran escala en los valores, el acceso y la propiedad, no solo tecnología. Otros temen que este futuro pueda llevar a que los controladores de IA abusen de su poder, o a que la propia IA desarrolle objetivos inesperados. (Fuente: Reddit r/ArtificialInteligence)

💡 OTROS

Relación simbiótica entre la IA y la computación cuántica: Quantinuum y Google DeepMind han revelado la realidad de la relación simbiótica entre la computación cuántica y la IA. Las capacidades únicas de la computación cuántica proporcionan nuevos paradigmas computacionales para los modelos de IA, mientras que la IA puede optimizar los algoritmos cuánticos y el diseño de hardware. La combinación de ambos promete avances en la resolución de problemas complejos y el procesamiento de datos, impulsando el desarrollo de la tecnología de vanguardia. (Fuente: Ronald_vanLoon)

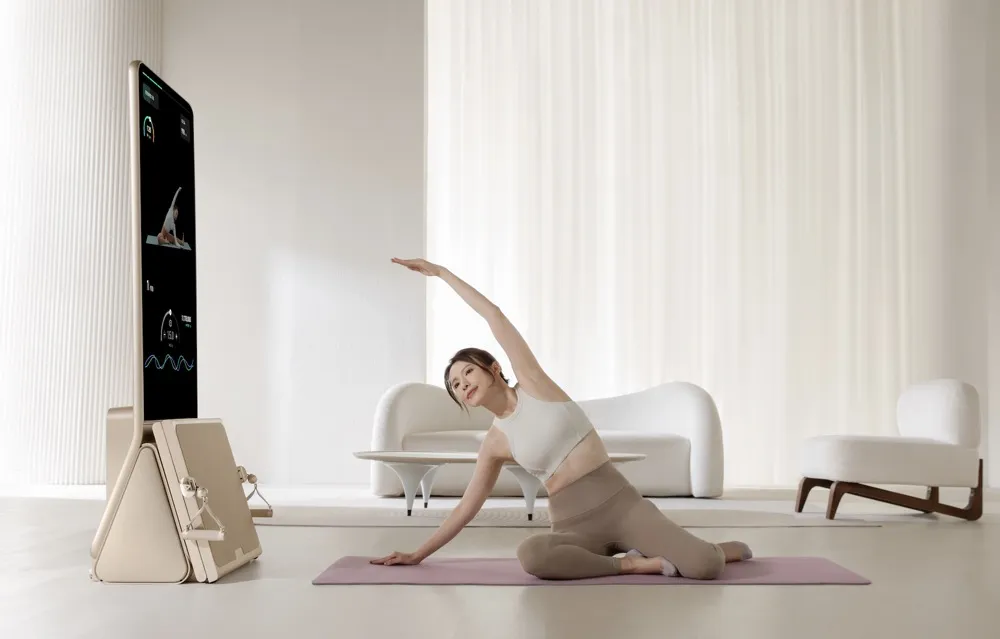

El equipo de fitness inteligente AEKE conquista el mercado doméstico de alta gama: La empresa de Shenzhen AEKE, con su equipo de fitness inteligente Smart Home Gym K1, con un precio unitario de 20.000 yuanes, logró decenas de millones de yuanes en ingresos en una plataforma de crowdfunding en el extranjero en un mes. Este producto se enfoca en el entrenamiento de fuerza y Pilates, ofreciendo una solución integrada de hardware y software, equipada con una pantalla táctil 4K, tecnología de motor servo digital de desarrollo propio y un sistema de entrenador personal de IA, logrando planes de entrenamiento personalizados y corrección de movimientos en tiempo real. AEKE apunta al mercado de alta gama, enfocándose en la ligereza, la facilidad de instalación y el posicionamiento como pieza de arte para el hogar, y mejora la retención de usuarios y la eficiencia de expansión en mercados extranjeros a través de su sistema de entrenador personal de IA. (Fuente: 36氪)

Resumen mensual de AIhub: Julio de 2025: AIhub ha publicado su resumen mensual de Julio de 2025, cubriendo importantes eventos de IA como el torneo de fútbol de robots RoboCup y la conferencia de aprendizaje automático ICML. El contenido incluye entrevistas y resúmenes de varias ligas de RoboCup (como RoboCupRescue, Small Size League, 3D Simulation League), discursos invitados y premios de ICML, y una introducción a OnAIR, la plataforma de investigación de IA a bordo de la NASA. Además, se abordan los avances en la investigación sobre la generación de texto a voz y el uso de feedback en la interacción humano-robot. (Fuente: aihub.org)