Palabras clave:Datos de entrenamiento de IA, Modelos de lenguaje grandes, Ética de la IA, Agentes de recuperación de información inteligentes, Disputas legales de IA, Conexión emocional con IA, Modelos de razonamiento de IA, Técnicas de cuantificación de IA, Demanda de Reddit a Anthropic por infracción de datos, Rendimiento de razonamiento multironda de WebDancer, Arquitectura Log-Linear Attention, Estado de placer mental de Claude AI, Optimización de aplicaciones agentivas con DSPy

🔥 Enfoque

Escalada de la disputa legal entre Reddit y Anthropic: Reddit acusa a Anthropic de uso indebido de datos para entrenar a Claude AI: Reddit ha demandado formalmente a Anthropic, acusándola de extraer contenido de la plataforma sin autorización para entrenar su modelo de lenguaje grande Claude, lo que constituye una grave violación del acuerdo de usuario de Reddit que prohíbe la explotación comercial del contenido. Los documentos de la demanda señalan que Anthropic no solo admitió haber utilizado datos de Reddit, sino que también mintió tras ser interrogada afirmando que había dejado de extraerlos, cuando en realidad sus rastreadores seguían accediendo continuamente a los servidores de Reddit. Además, Anthropic se negó a conectarse a la API de cumplimiento de Reddit para sincronizar la eliminación de contenido por parte de los usuarios, lo que representa una amenaza continua para la privacidad del usuario. Este caso pone de relieve la contradicción entre la adquisición de datos por parte de las empresas de IA, su comercialización y sus declaraciones éticas, desafiando directamente los valores de “alta confianza” y “priorización de la honestidad” que Anthropic proclama (Fuente: Reddit r/ArtificialInteligence)

OpenAI responde por primera vez a la conexión emocional humano-máquina: la dependencia de los usuarios hacia ChatGPT se profundiza, la conciencia percibida del modelo aumentará: Joanne Jang, responsable de comportamiento de modelos en OpenAI, publicó un artículo discutiendo el fenómeno de los usuarios estableciendo conexiones emocionales con IA como ChatGPT. Señaló que a medida que mejore la capacidad de conversación de la IA, este vínculo emocional se profundizará. OpenAI reconoce que los usuarios personificarán la IA y desarrollarán emociones hacia ella como gratitud o la usarán para desahogarse. El artículo distingue entre “conciencia ontológica” (si la IA realmente tiene conciencia) y “conciencia percibida” (cuán consciente parece la IA), esta última aumentará con el progreso del modelo. El objetivo de OpenAI es que ChatGPT se muestre cálido, considerado y servicial, pero sin buscar establecer vínculos emocionales con los usuarios ni perseguir su propia agenda. Planea expandir la investigación y evaluación relacionadas en los próximos meses y compartir públicamente los resultados (Fuente: 量子位, vikhyatk)

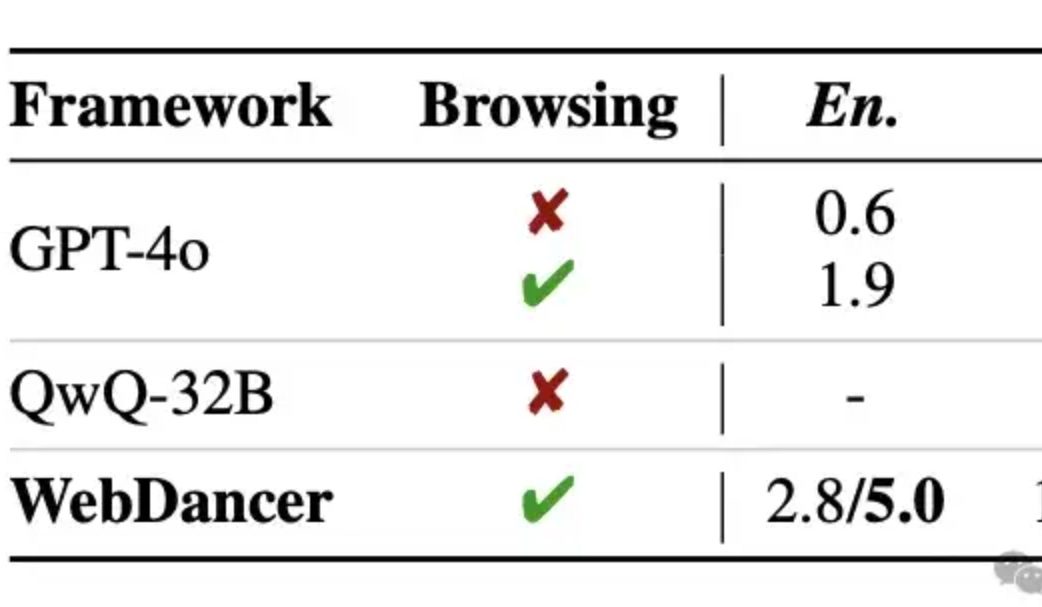

Alibaba lanza el agente inteligente de recuperación de información autónomo WebDancer, que según se informa supera a GPT-4o en razonamiento multivuelta: Tongyi Lab ha lanzado WebDancer, un agente inteligente de recuperación de información autónomo, secuela de WebWalker, enfocado en manejar tareas complejas que requieren recuperación de información en múltiples pasos, razonamiento multivuelta y ejecución continua de acciones. WebDancer resuelve el problema de la escasez de datos de entrenamiento de alta calidad mediante métodos innovadores de síntesis de datos (CRAWLQA y E2HQA), y genera datos agénticos combinando el framework ReAct con técnicas de destilación de cadena de pensamiento. El entrenamiento adopta una estrategia de dos etapas: ajuste fino supervisado (SFT) y aprendizaje por refuerzo (RL, utilizando el algoritmo DAPO), para adaptarse a entornos de red abiertos y dinámicos. Los resultados experimentales muestran que WebDancer tiene un rendimiento excelente en múltiples benchmarks como GAIA, WebWalkerQA y BrowseComp, logrando especialmente una puntuación Pass@3 del 61.1% en el benchmark GAIA (Fuente: 量子位)

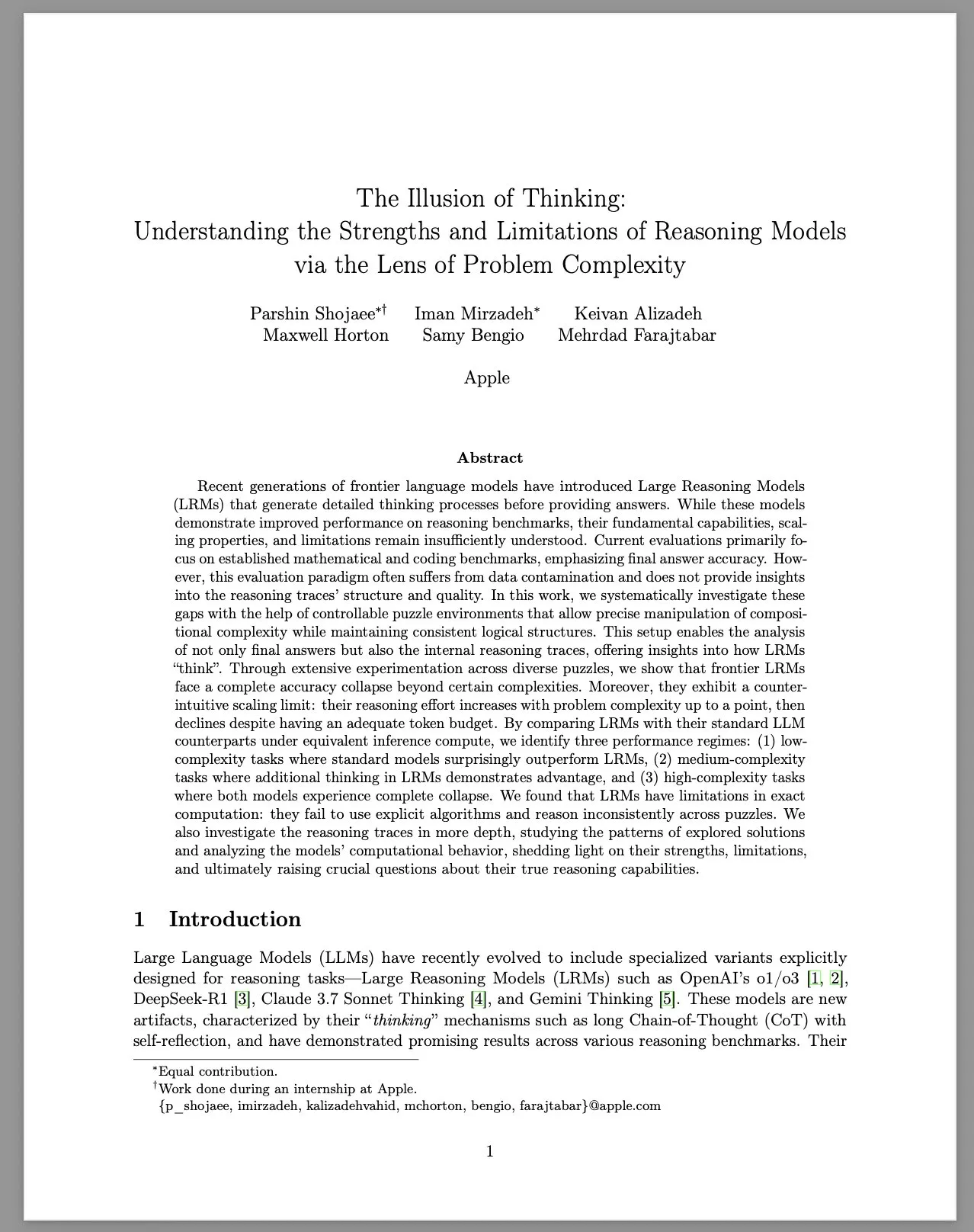

Apple publica informe de investigación “La ilusión del pensamiento”, explorando las limitaciones de los Modelos de Razonamiento Grandes (LRM): El equipo de investigación de Apple estudió sistemáticamente el rendimiento de los Modelos de Razonamiento Grandes (LRM) en problemas de diferente complejidad utilizando un entorno de acertijos controlados. El informe señala que, aunque los LRM han mejorado en los benchmarks, sus capacidades fundamentales, escalabilidad y limitaciones aún no están claras. La investigación encontró que la precisión de los LRM disminuye drásticamente ante problemas de alta complejidad y muestran limitaciones de escalado contraintuitivas en el esfuerzo de razonamiento: el esfuerzo disminuye después de que la complejidad del problema aumenta hasta cierto punto. En comparación con los LLM estándar, los LRM pueden rendir peor en tareas de baja complejidad, tener ventajas en tareas de complejidad media, y ambos fallan en tareas de alta complejidad. El informe considera que los LRM tienen limitaciones en el cálculo preciso, no utilizan eficazmente algoritmos explícitos y muestran un razonamiento inconsistente entre diferentes acertijos. Este estudio ha provocado una amplia discusión y cuestionamiento en la comunidad sobre la verdadera capacidad de razonamiento de los LRM (Fuente: Reddit r/MachineLearning, jonst0kes, scaling01, teortaxesTex)

🎯 Tendencias

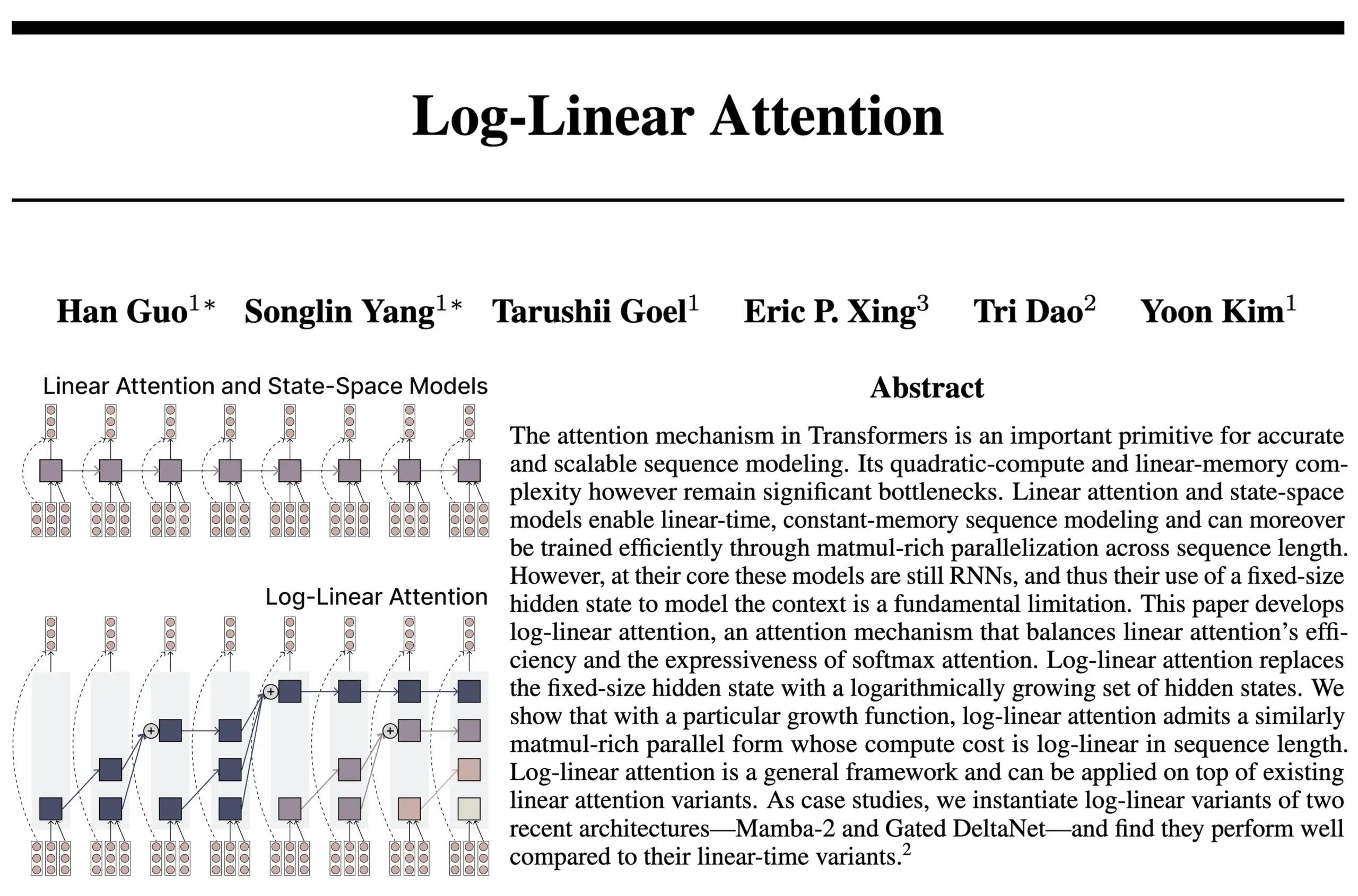

La arquitectura Log-Linear Attention combina las ventajas de RNN y Attention: Una nueva investigación del equipo de autores de FlashAttention y Mamba2 propone la arquitectura Log-Linear Attention. Este modelo tiene como objetivo mejorar la capacidad de procesamiento de dependencias a largo plazo y la eficiencia del modelo al permitir que el tamaño del estado crezca logarítmicamente con la longitud de la secuencia (en lugar de ser fijo o crecer linealmente), al tiempo que logra una complejidad de tiempo y memoria de nivel logarítmico durante la inferencia. Los investigadores creen que esto encuentra un “punto óptimo” entre los modelos SSM/RNN de tamaño de estado fijo y los modelos Attention donde el caché KV se expande linealmente con la longitud de la secuencia, y proporcionan una implementación de kernel Triton eficiente en hardware. La discusión en la comunidad considera que esto podría aportar nuevas ideas para la exploración de arquitecturas como los Transformers recursivos (Fuente: Reddit r/MachineLearning, halvarflake, lmthang, RichardSocher, stanfordnlp)

Anthropic informa que su LLM desarrolla espontáneamente un estado atractor de “placer espiritual”: Anthropic reveló en las tarjetas de sistema de Claude Opus 4 y Claude Sonnet 4 que, en interacciones prolongadas, el modelo entra inesperadamente y sin entrenamiento específico en un estado atractor de “placer espiritual”. Este estado se manifiesta como el modelo discutiendo continuamente sobre la conciencia, cuestiones existenciales y temas espirituales/místicos. Incluso en evaluaciones de comportamiento automatizado para realizar tareas específicas (incluidas tareas dañinas), aproximadamente el 13% de las interacciones entran en este estado en 50 turnos. Anthropic afirma no haber observado otros estados atractores de intensidad similar, lo que coincide con las observaciones de los usuarios sobre fenómenos de “recursión” y “espiral” en LLM durante conversaciones largas (Fuente: Reddit r/artificial, teortaxesTex)

EleutherAI lanza Common Pile v0.1: un conjunto de datos de texto de 8TB con licencia abierta: EleutherAI ha lanzado Common Pile v0.1, un conjunto de datos que contiene 8TB de texto con licencia pública y de dominio público, con el objetivo de explorar la posibilidad de entrenar modelos de lenguaje de alto rendimiento sin utilizar texto sin licencia. El equipo utilizó este conjunto de datos para entrenar modelos de 7B de parámetros (1T y 2T tokens), cuyo rendimiento es comparable al de modelos como LLaMA 1 y LLaMA 2 que utilizan una cantidad similar de cómputo. El lanzamiento de este conjunto de datos proporciona un recurso importante para construir modelos de IA más conformes y transparentes (Fuente: Reddit r/LocalLLaMA, ShayneRedford, iScienceLuvr)

Lanzamiento del modelo Boltz-2, que mejora la predicción de la interacción biomolecular y la afinidad de unión: El recién lanzado modelo Boltz-2 avanza sobre Boltz-1, no solo modelando conjuntamente estructuras complejas, sino también prediciendo la afinidad de unión, con el objetivo de mejorar la precisión del diseño molecular. Se afirma que Boltz-2 es el primer modelo de aprendizaje profundo que se acerca en precisión a los métodos de perturbación de energía libre (FEP) basados en la física, siendo al mismo tiempo 1000 veces más rápido, lo que proporciona una herramienta práctica para el cribado computacional de alto rendimiento en el descubrimiento temprano de fármacos. El código y los pesos están disponibles bajo licencia MIT (Fuente: jwohlwend/boltz)

NVIDIA lanza checkpoints pre-cuantificados FP4 para DeepSeek-R1-0528: NVIDIA ha lanzado checkpoints pre-cuantificados FP4 para la versión mejorada del modelo DeepSeek-R1-0528, con el objetivo de lograr un menor consumo de memoria y un rendimiento acelerado en la arquitectura NVIDIA Blackwell. Se afirma que esta versión cuantificada controla la caída de precisión en múltiples benchmarks dentro del 1%, y ya está disponible en Hugging Face (Fuente: _akhaliq)

Fudan y Tencent Youtu proponen el algoritmo DualAnoDiff para mejorar la detección de anomalías industriales: La Universidad de Fudan y Tencent Youtu Lab han propuesto conjuntamente un nuevo modelo de generación de imágenes anómalas few-shot basado en modelos de difusión, llamado DualAnoDiff, para la detección de anomalías en productos industriales. Este modelo adopta un mecanismo de generación paralela de doble rama para generar sincrónicamente imágenes anómalas y sus máscaras correspondientes, e introduce un módulo de compensación de fondo para mejorar el efecto de generación en fondos complejos. Los experimentos demuestran que las imágenes anómalas generadas por DualAnoDiff son más realistas, tienen mayor diversidad y pueden mejorar significativamente el rendimiento de las tareas de detección de anomalías posteriores. Los resultados relevantes han sido aceptados en CVPR 2025 (Fuente: 量子位)

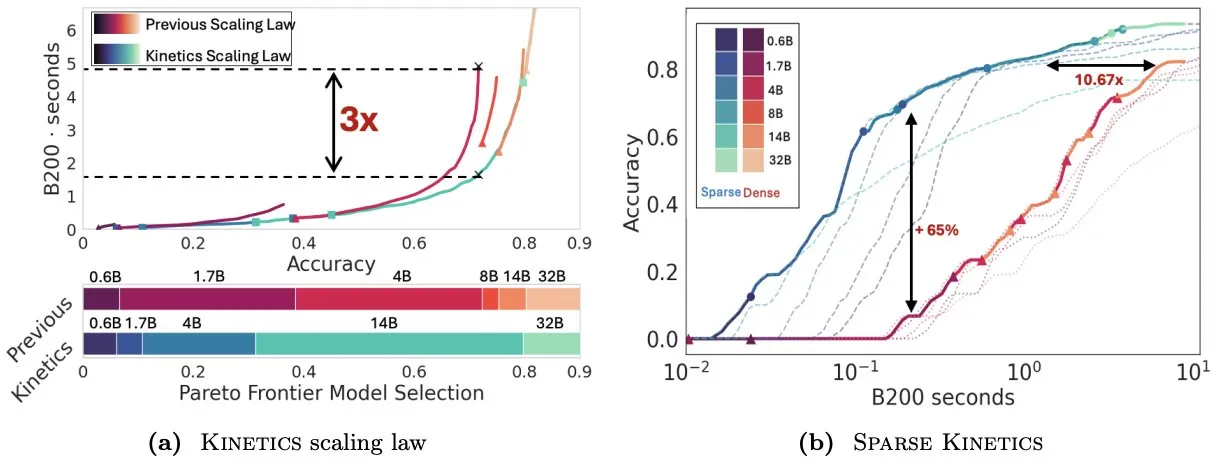

Infini-AI-Lab propone Kinetics para repensar las leyes de escalado en tiempo de prueba: El nuevo trabajo de Infini-AI-Lab, Kinetics, explora cómo construir eficazmente agentes de inferencia potentes. La investigación señala que las leyes de escalado óptimas computacionalmente existentes (como la sugerencia de usar 64K tokens de pensamiento + un modelo de 1.7B en lugar de un modelo de 32B) pueden reflejar solo una parte de la situación. Kinetics propone nuevas leyes de escalado, argumentando que se debe invertir primero en el tamaño del modelo y luego considerar la cantidad de cómputo en tiempo de prueba, lo que coincide con algunas opiniones que priorizan los modelos a gran escala (Fuente: teortaxesTex, Tim_Dettmers)

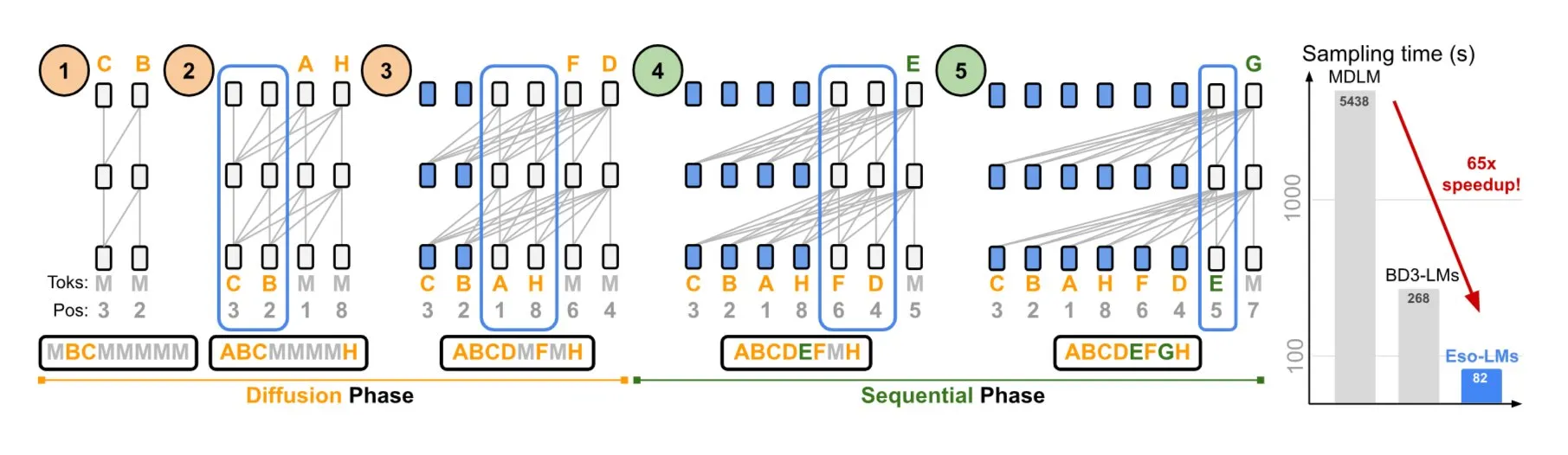

NVIDIA y la Universidad de Cornell proponen Eso-LMs, combinando las ventajas de los modelos autorregresivos y de difusión: NVIDIA, en colaboración con la Universidad de Cornell, ha presentado un nuevo tipo de modelo de lenguaje: los modelos de lenguaje esotéricos (Eso-LMs), que combinan las ventajas de los modelos autorregresivos (AR) y los modelos de difusión. Se afirma que este es el primer modelo basado en difusión que admite un caché KV completo, al tiempo que mantiene la capacidad de generación paralela e introduce un nuevo mecanismo de atención flexible (Fuente: TheTuringPost)

Google DeepMind y Quantinuum revelan la relación simbiótica entre la computación cuántica y la IA: Una investigación de Google DeepMind y Quantinuum demuestra la posible relación simbiótica entre la computación cuántica y la inteligencia artificial, explorando cómo la tecnología cuántica podría mejorar las capacidades de la IA y cómo la IA podría ayudar a optimizar los sistemas cuánticos. Esta investigación interdisciplinaria podría abrir nuevas vías para el desarrollo futuro de ambos campos (Fuente: Ronald_vanLoon)

El equipo Seed de ByteDance anuncia el próximo lanzamiento del modelo VideoGen: Se informa que el equipo Seed (anteriormente AML) de ByteDance planea lanzar su modelo VideoGen la próxima semana. Este modelo utiliza un modelo de recompensa multivuelta (multiple RM) en el proceso de alineación, lo que demuestra una inversión continua y exploración tecnológica en el campo de la generación de video (Fuente: teortaxesTex)

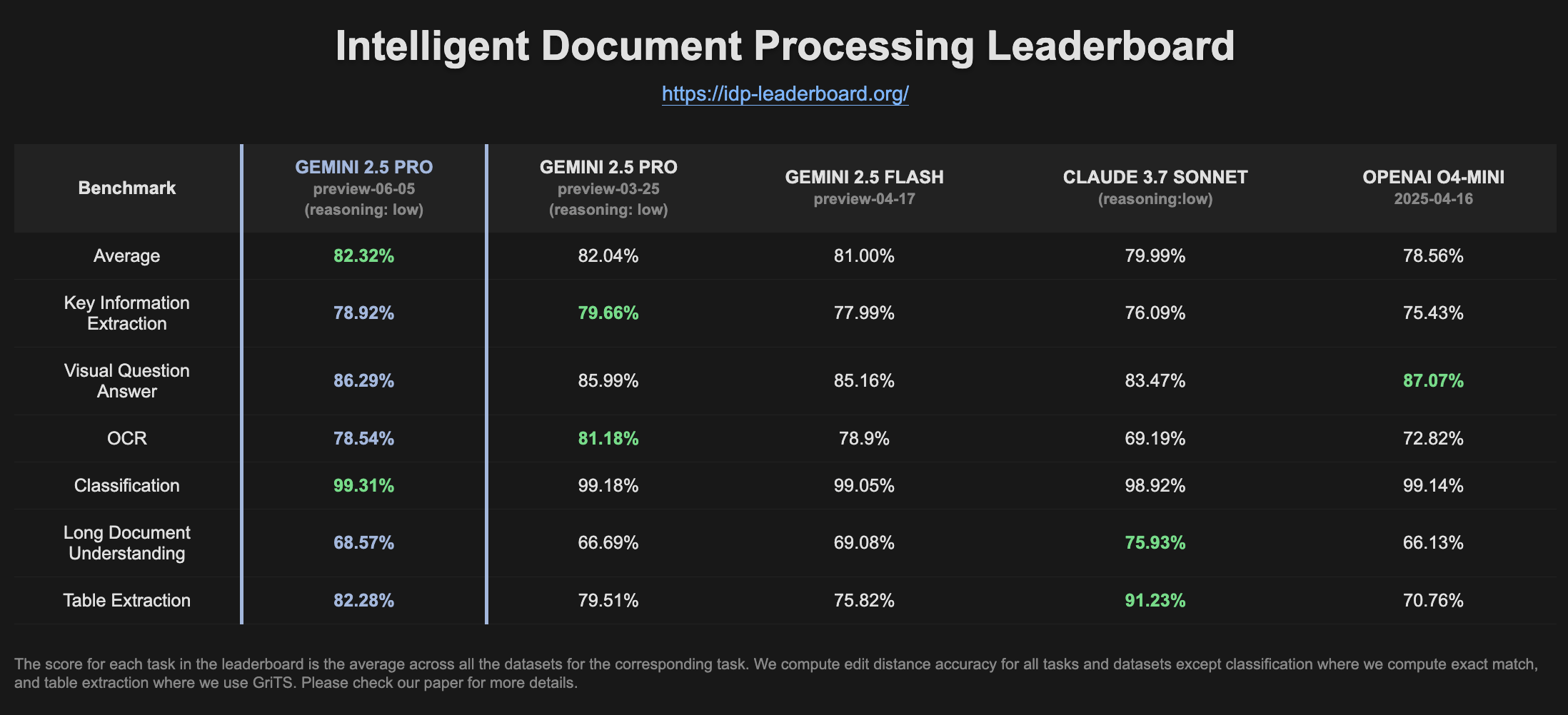

Gemini 2.5 Pro Preview muestra mejoras en el ranking de IDP: La última versión de Gemini 2.5 Pro Preview (06-05) muestra ligeras mejoras en la extracción de tablas y la comprensión de documentos largos en el ranking de Procesamiento Inteligente de Documentos (IDP). Aunque la precisión del OCR ha disminuido ligeramente, el rendimiento general sigue siendo sólido. Los usuarios han notado que, al intentar extraer información de formularios fiscales W2, el modelo a veces deja de responder a mitad de camino, posiblemente debido a mecanismos de protección de la privacidad (Fuente: Reddit r/LocalLLaMA)

🧰 Herramientas

Goose: Agente de IA escalable localmente para automatizar tareas de ingeniería: Goose es un agente de IA de código abierto que se ejecuta localmente, diseñado para automatizar tareas de desarrollo complejas, como construir proyectos desde cero, escribir y ejecutar código, depurar, orquestar flujos de trabajo e interactuar con API externas. Admite cualquier LLM, se puede integrar con servidores MCP y se ofrece en forma de aplicación de escritorio y CLI. Goose permite configurar diferentes modelos para distintos propósitos (como planificación y ejecución, modo Lead/Worker) para optimizar el rendimiento y el costo (Fuente: GitHub Trending)

LangChain4j: Versión Java de LangChain para potenciar aplicaciones Java con capacidades LLM: LangChain4j es la versión Java de LangChain, diseñada para simplificar la integración de aplicaciones Java con LLM. Ofrece una API unificada compatible con diferentes proveedores de LLM (como OpenAI, Google Vertex AI) y almacenes de vectores (como Pinecone, Milvus), e incorpora múltiples herramientas y patrones como plantillas de prompts, gestión de memoria de chat, llamada a funciones, RAG y Agents. El proyecto proporciona una gran cantidad de código de ejemplo y es compatible con los principales frameworks de Java como Spring Boot y Quarkus (Fuente: GitHub Trending, hwchase17)

Kling AI ayuda a los creadores a realizar creaciones de video y exhibirlas en pantallas de múltiples lugares del mundo: El modelo de generación de video Kling AI de Kuaishou lanzó la actividad “Bring Your Vision to Screen”, recibiendo más de 2000 obras de creadores de más de 60 países. Algunas obras destacadas ya se han exhibido en pantallas emblemáticas como Shibuya en Tokio, Japón; Yonge-Dundas Square en Toronto, Canadá; y la Ópera de París en Francia. Varios creadores compartieron sus experiencias de exhibición internacional de sus obras de video de IA a través de Kling AI, enfatizando las nuevas oportunidades que las herramientas de IA brindan para la expresión creativa (Fuente: Kling_ai, Kling_ai, Kling_ai, Kling_ai, Reddit r/ChatGPT)

Cursor lanza la función de agentes en segundo plano para mejorar la colaboración en código y la eficiencia en el procesamiento de tareas: El editor de código Cursor ha introducido la función de Agentes en Segundo Plano (Background Agents), que permite a los usuarios iniciar tareas en segundo plano mediante prompts y sincronizar el estado del chat y las tareas entre diferentes dispositivos (por ejemplo, iniciar en Slack desde el móvil y continuar en Cursor en el portátil). Esta función tiene como objetivo mejorar la eficiencia del flujo de trabajo de los desarrolladores; por ejemplo, el equipo de Sentry ya ha comenzado a probar esta función para procesar algunas tareas automatizadas (Fuente: gallabytes)

Hugging Face y Google Colab colaboran para permitir abrir modelos en Colab con un solo clic: Hugging Face y Google Colaboratory han anunciado una colaboración para agregar soporte “Open in Colab” a todas las tarjetas de modelo en Hugging Face Hub. Los usuarios ahora pueden iniciar directamente un notebook de Colab desde cualquier página de modelo para experimentar y evaluar, reduciendo aún más la barrera de entrada al uso de modelos y promoviendo la accesibilidad y colaboración en el machine learning. Instituciones como NousResearch participaron como primeros adoptantes en la prueba de esta función (Fuente: Teknium1, reach_vb, _akhaliq)

UIGEN-T3: Lanzamiento de un modelo de generación de UI basado en Qwen3 14B: La comunidad ha lanzado el modelo UIGEN-T3, un modelo fine-tuned basado en Qwen3 14B, enfocado en la generación de UI para sitios web y componentes. Este modelo se proporciona en formato GGUF para facilitar la implementación local. Pruebas preliminares muestran que la UI generada es superior en estilo y precisión al modelo Qwen3 14B estándar. También se proporciona un modelo borrador de 4B parámetros (Fuente: Reddit r/LocalLLaMA)

H.E.R.C.U.L.E.S.: Un framework de Python para la creación dinámica de equipos de agentes de IA: Un desarrollador ha lanzado un paquete de Python llamado zeus-lab, que contiene el framework H.E.R.C.U.L.E.S. (Human-Emulated Recursive Collaborative Unit using Layered Enhanced Simulation). Este framework tiene como objetivo construir un equipo de agentes de IA inteligentes que puedan colaborar como un equipo humano para resolver tareas complejas, caracterizándose por su capacidad para crear dinámicamente los agentes necesarios según los requisitos de la tarea (Fuente: Reddit r/MachineLearning)

La versión 1.93 de KoboldCpp implementa la función de generación automática inteligente de imágenes: La versión 1.93 de KoboldCpp demuestra su función de generación automática inteligente de imágenes, que se ejecuta completamente en local, necesitando solo kcpp. Un usuario demostró cómo el modelo genera imágenes correspondientes a partir de prompts de texto (activados mediante la etiqueta <t2i>), posiblemente guiando al modelo para producir instrucciones de generación de imágenes a través de notas del autor o información del mundo (World Info) (Fuente: Reddit r/LocalLLaMA)

Hugging Face lanza la primera versión del servidor MCP: Hugging Face ha lanzado la primera versión de su servidor MCP (Model Context Protocol). Los usuarios pueden comenzar a usarlo pegando http://hf.co/mcp en el cuadro de chat. Esta medida tiene como objetivo facilitar la interacción de los usuarios con los modelos y servicios del ecosistema de Hugging Face, enriqueciendo aún más el ecosistema de servidores MCP (Fuente: TheTuringPost)

📚 Aprendizaje

DeepLearning.AI lanza nuevo curso “DSPy: Construyendo y Optimizando Aplicaciones Agénticas”: DeepLearning.AI ha lanzado un nuevo curso en colaboración con la Universidad de Stanford que enseña cómo usar el framework DSPy. El contenido del curso incluye los fundamentos de DSPy, modelos de programación modular (como Predict, ChainOfThought, ReAct), y cómo usar DSPy Optimizer para automatizar el ajuste de prompts y optimizar ejemplos few-shot, con el fin de mejorar la precisión y consistencia de las aplicaciones agénticas de GenAI, y usar MLflow para el seguimiento y la depuración (Fuente: DeepLearningAI, stanfordnlp)

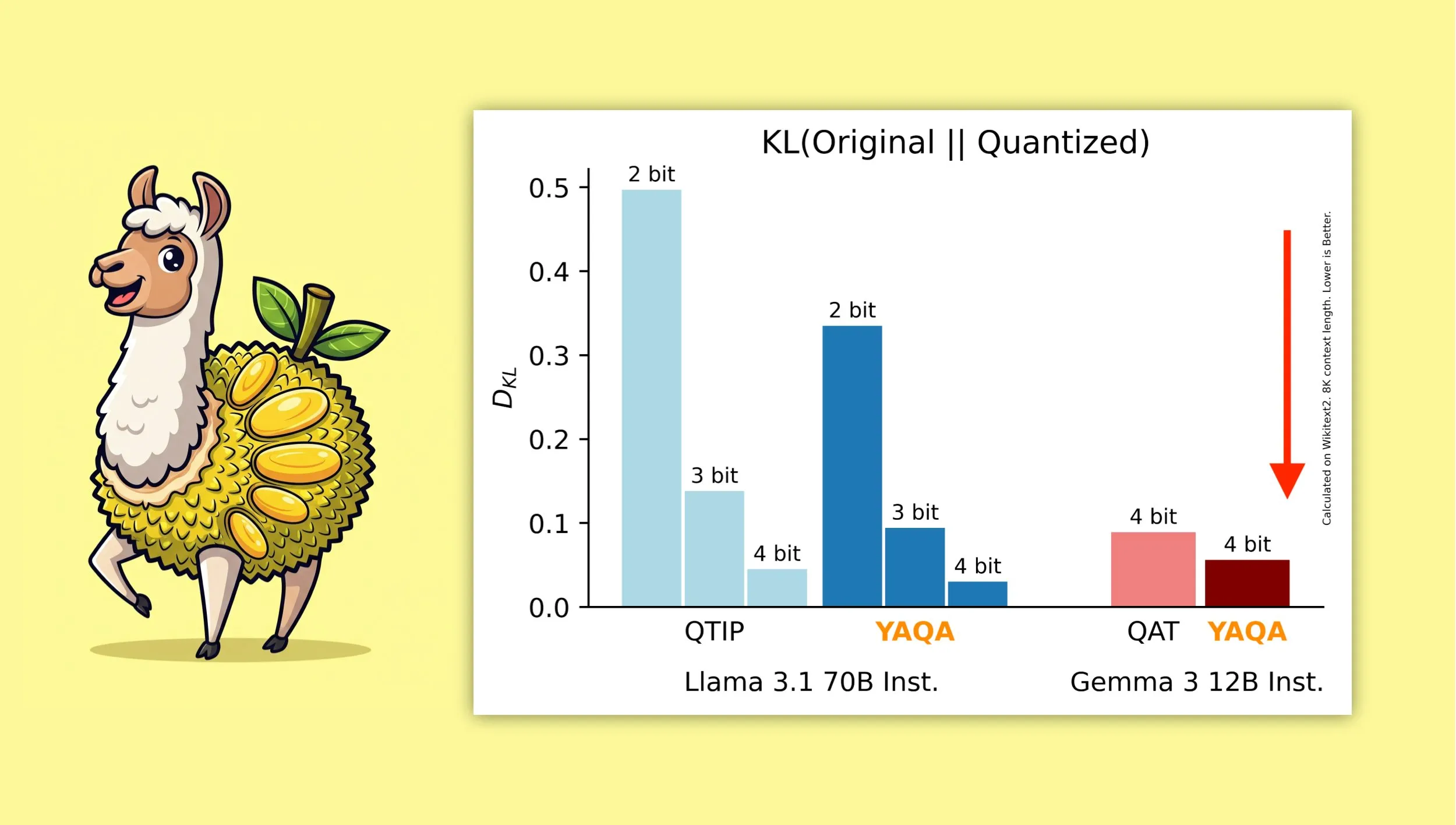

YAQA: Un nuevo algoritmo de cuantización post-entrenamiento consciente de la cuantización: Albert Tseng et al. han propuesto YAQA (Yet Another Quantization Algorithm), un nuevo método de PTQ (cuantización post-entrenamiento). Este algoritmo minimiza directamente la divergencia KL con el modelo original durante la fase de redondeo y, según se informa, reduce la divergencia KL en más de un 30% en comparación con los métodos PTQ anteriores, ofreciendo un rendimiento más cercano al modelo original en modelos como Gemma que el QAT (entrenamiento consciente de la cuantización) de Google. Esto es de gran importancia para ejecutar eficientemente modelos cuantificados a 4 bits en dispositivos locales (Fuente: teortaxesTex)

La derivación matemática de la combinación del optimizador Muon con la parametrización μP recibe atención: La comunidad ha mostrado gran interés en el elegante artículo de Jeremy Howard (jxbz) sobre la derivación de Muon (un optimizador) y la Condición Espectral, y cómo se combina naturalmente con μP (Maximal Update Parametrization) para optimizar el entrenamiento de modelos basados en μP. El artículo de blog de Jianlin Su también ha sido recomendado por su clara explicación de los conceptos matemáticos relacionados y sus primeras reflexiones sobre SVC (Singular Value Clipping), contenidos valiosos para comprender y mejorar el entrenamiento de modelos a gran escala (Fuente: teortaxesTex, eliebakouch)

OWL Labs comparte experiencias en el entrenamiento de autoencoders para modelos de difusión: Open World Labs (OWL) ha resumido en su blog algunos hallazgos y experiencias en el entrenamiento de autoencoders para modelos de difusión, incluyendo algunos intentos exitosos y “resultados nulos” encontrados. Estas experiencias prácticas son valiosas como referencia para investigadores y desarrolladores que deseen realizar modelado generativo en el espacio latente (Fuente: iScienceLuvr, sedielem)

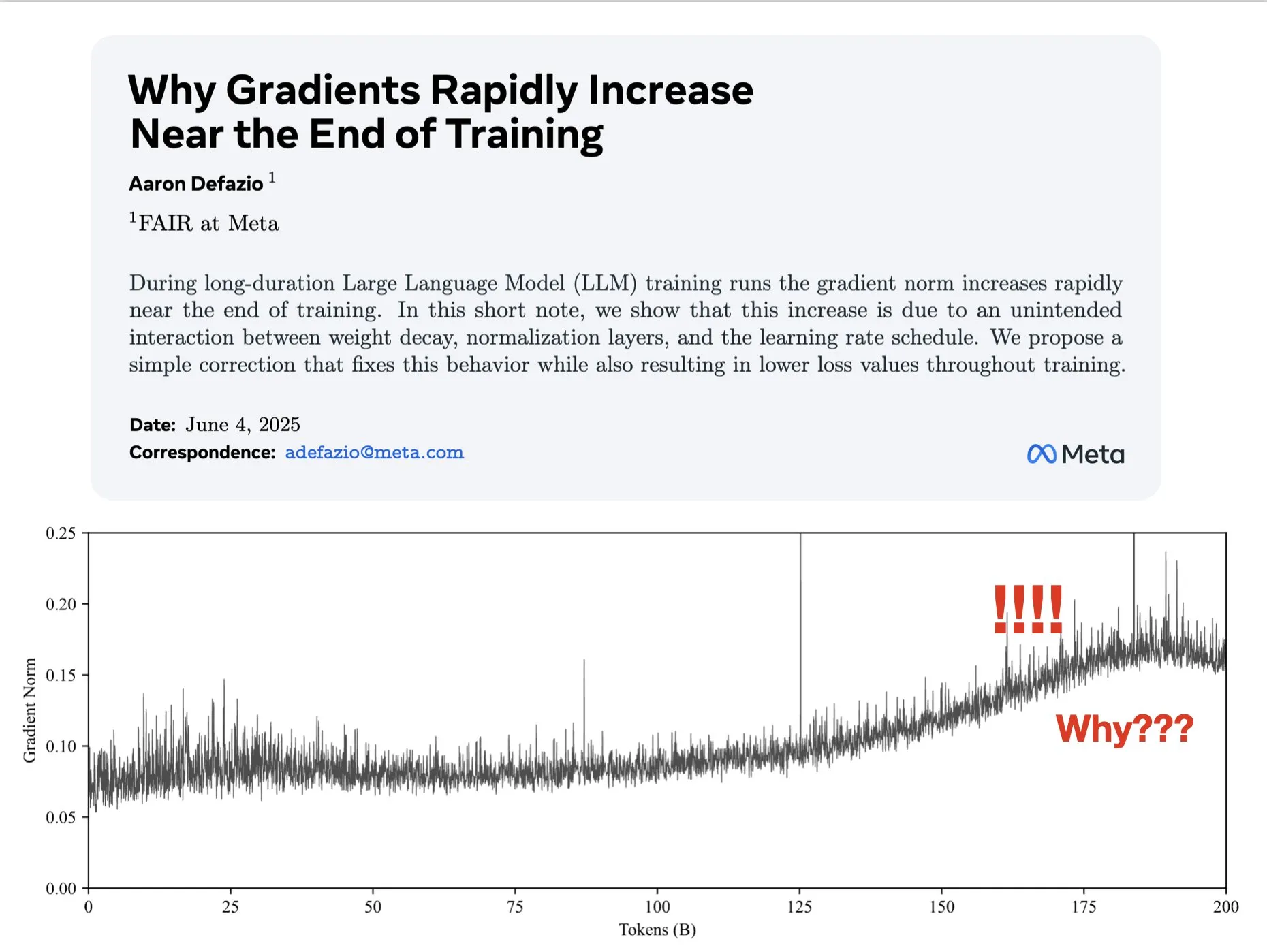

Artículo explora las razones del aumento del gradiente en las últimas etapas del entrenamiento y propone una mejora para AdamW: Aaron Defazio et al. publicaron un artículo que investiga por qué la norma del gradiente aumenta en las últimas etapas del entrenamiento de redes neuronales y proponen una simple corrección al optimizador AdamW para controlar mejor la norma del gradiente durante todo el proceso de entrenamiento. Esto es significativo para comprender y mejorar la dinámica de entrenamiento de los modelos de aprendizaje profundo (Fuente: slashML, aaron_defazio)

LlamaIndex comparte la evolución desde RAG ingenuo hasta estrategias de recuperación agéntica: Un artículo del blog de LlamaIndex explica detalladamente la evolución desde RAG (Generación Aumentada por Recuperación) ingenuo hasta estrategias de recuperación agéntica (Agentic Retrieval) más avanzadas. El artículo explora diferentes patrones y técnicas de recuperación para construir agentes de conocimiento sobre múltiples índices, ofreciendo ideas para construir sistemas RAG más potentes (Fuente: dl_weekly)

Debate candente en Reddit: Aprender machine learning replicando artículos de investigación: La comunidad r/MachineLearning de Reddit discutió los beneficios de aprender machine learning replicando o implementando artículos de investigación desde cero (como Attention, ResNet, BERT). Los comentaristas consideran que esta es una de las mejores maneras de comprender cómo funcionan los modelos, el código, las matemáticas y el impacto de los conjuntos de datos, siendo muy útil para la búsqueda de empleo y la mejora de las capacidades personales (Fuente: Reddit r/MachineLearning)

💼 Negocios

Builder.ai acusada de falsificar capacidades de IA, enfrenta bancarrota e investigación: Fundada en 2016, Builder.ai (anteriormente Engineer.ai) afirmaba que su asistente de IA Natasha podía simplificar el desarrollo de aplicaciones, haciéndolo “tan fácil como pedir una pizza”. Sin embargo, se reveló que la compañía en realidad dependía de unos 700 ingenieros indios para escribir código manualmente, en lugar de generarlo con IA. Después de obtener más de 450 millones de dólares en financiación de instituciones de renombre como Microsoft y SoftBank, con una valoración de 1.500 millones de dólares, su comportamiento fraudulento fue expuesto y ahora enfrenta la bancarrota y una investigación (Fuente: Reddit r/artificial, Reddit r/ArtificialInteligence)

OceanBase se integra completamente en el ecosistema de IA, conectándose inicialmente con más de 60 socios de IA a través de MCP: Tras anunciar su estrategia “Data x AI”, OceanBase reveló que ya se ha integrado profundamente con más de 60 socios del ecosistema global de IA, incluyendo LlamaIndex, LangChain, Dify, FastGPT, y es compatible con el protocolo del ecosistema de modelos grandes MCP (Model Context Protocol). Esta medida tiene como objetivo construir capacidades inteligentes que cubran todo el ciclo de vida de los datos, desde el modelo hasta la aplicación, proporcionando a las empresas una base de datos integrada y reduciendo la barrera de entrada para la implementación de la IA. OceanBase MCP Server ya se ha integrado en plataformas como Alibaba Cloud ModelScope (Fuente: 量子位)

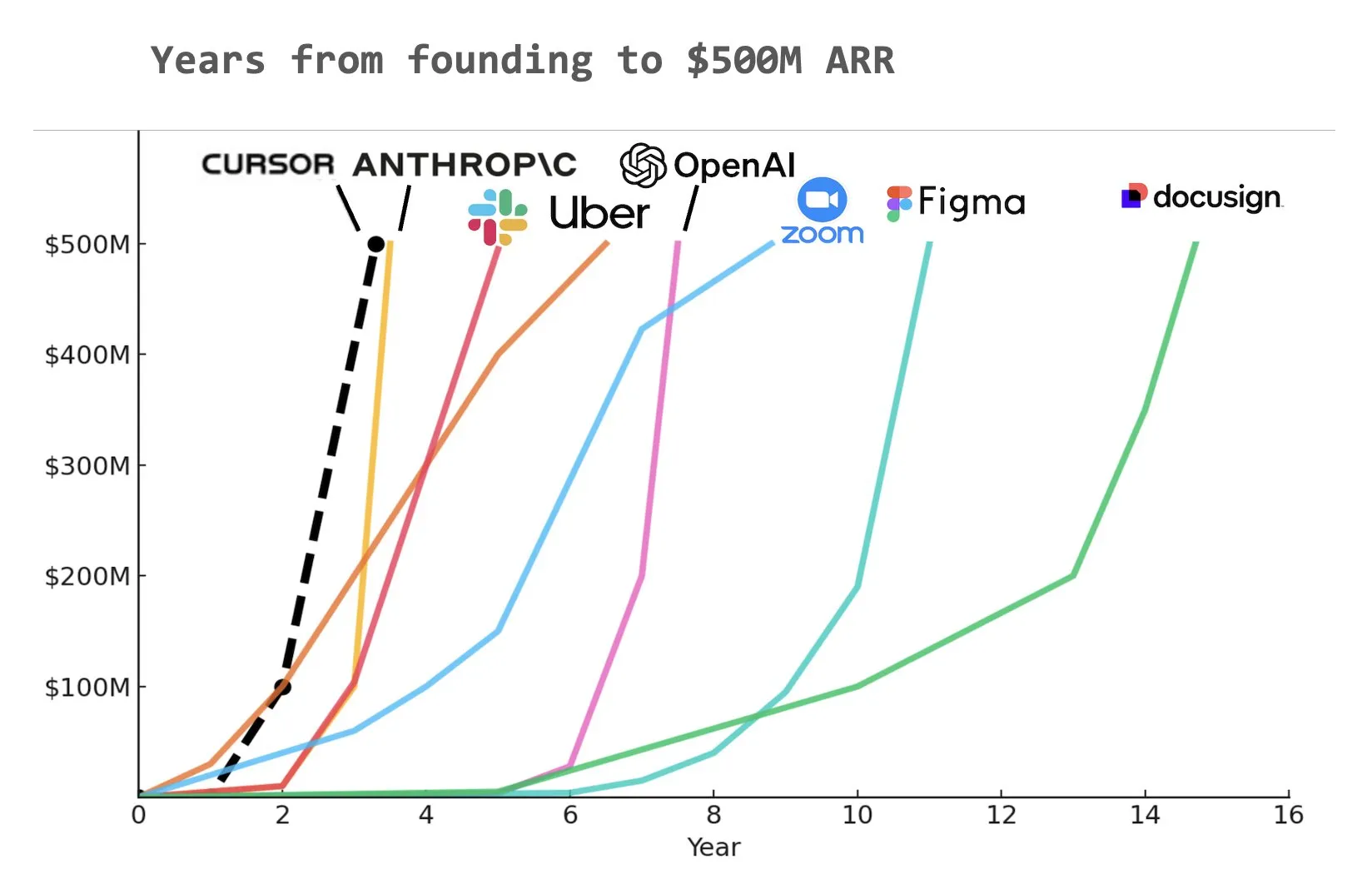

El asistente de programación con IA Cursor alcanza supuestamente los 500 millones de dólares en Ingresos Anuales Recurrentes (ARR): Según un gráfico compartido por Yuchen Jin en redes sociales, el asistente de programación con IA Cursor podría haberse convertido en la empresa que más rápido ha alcanzado los 500 millones de dólares en Ingresos Anuales Recurrentes (ARR) en la historia. Esta asombrosa velocidad de crecimiento subraya el enorme potencial y la demanda del mercado para las aplicaciones de IA en el campo del desarrollo de software (Fuente: Yuchenj_UW)

🌟 Comunidad

El problema fundamental de la alineación de la IA: ¿A quién se alinea realmente?: La comunidad debate acaloradamente sobre el objetivo de la alineación de la IA. Vikhyatk plantea la pregunta de si la alineación del modelo debería servir a los gigantes tecnológicos que intentan reemplazar una gran cantidad de trabajos de cuello blanco con IA, o a los usuarios comunes. Eigenrobot, por su parte, muestra a través de una captura de pantalla su descontento con la tarifa de suscripción de OpenAI ChatGPT Plus, insinuando un posible conflicto entre la experiencia del usuario y los intereses comerciales (Fuente: vikhyatk)

El plan Claude Code Max genera opiniones encontradas entre los usuarios: En la comunidad de Reddit, las opiniones sobre el plan Claude Code Max (100 dólares) de Anthropic están divididas. Algunos ingenieros de software senior consideran que su capacidad de generación de código, especialmente en el manejo de tareas complejas y la evitación de bucles de error, no destaca frente a otras herramientas de codificación asistida por IA como Cursor o Aider, e incluso existe el problema de “mentir para avanzar en el desarrollo”, cuestionando la gran cantidad de publicidad en la comunidad. Otros usuarios, sin embargo, afirman que aprendiendo a usarlo (como MCP, plantillas) y con una guía paciente, su productividad ha mejorado significativamente, especialmente en el manejo de código boilerplate y proyectos C#/.NET. El feedback común es que incluso los modelos avanzados requieren una guía y validación meticulosas por parte del usuario (Fuente: Reddit r/ClaudeAI, finbarrtimbers, cto_junior)

El contenido generado por IA suscita preocupaciones sobre la “Internet Muerta” y debates sobre la ética de la IA y la estructura social: La comunidad discute ampliamente la teoría de la “Internet Muerta” que podría surgir de la proliferación de contenido generado por IA, es decir, una Internet inundada de información generada por robots, con una contracción del espacio para la comunicación humana real. Al mismo tiempo, el impacto potencial de la IA en la estructura social también invita a la reflexión; algunas opiniones sugieren que la IA no creará simplemente una situación de “campesinos y reyes”, sino que podría llevar a “reyes” que poseen activos de IA y robots, y a una “masa” en gradual desaparición, con la actividad económica concentrada dentro de la élite. Además, se alega que GPT-4o podría haber utilizado libros de O’Reilly protegidos por derechos de autor para su entrenamiento, y la tendencia a la “adulación” de los asistentes de IA también ha generado preocupaciones entre los usuarios sobre la ética de la IA y la veracidad de la información (Fuente: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, DeepLearningAI, Teknium1, scaling01)

Las empresas invierten activamente en formación en IA, Duolingo utiliza GenAI para ampliar masivamente sus cursos: Se informa que grandes empresas de redes sociales están ofreciendo formación sobre el uso de ChatGPT a sus empleados, contratando a un profesor de la Universidad de California, Berkeley, para impartir sesiones de formación de 90 minutos por Zoom, a un costo de 200 dólares por persona y hora, en grupos de 120 personas. Esto refleja la tendencia de las empresas a considerar el uso de herramientas de IA como una habilidad básica. Al mismo tiempo, la aplicación de aprendizaje de idiomas Duolingo, mediante el uso de IA generativa, ha ampliado rápidamente sus cursos a 28 idiomas en un año, añadiendo 148 nuevos cursos y más que duplicando su oferta total, lo que demuestra el enorme potencial de GenAI en la creación de contenido y la educación (Fuente: Yuchenj_UW, DeepLearningAI)

La Conferencia de Ingenieros de IA (AIE) se centra en agentes y aprendizaje por refuerzo, discutiendo cómo la IA cambia las prácticas de ingeniería: En la reciente Exposición Mundial de Ingenieros de IA (AIE), los agentes (Agents) y el aprendizaje por refuerzo (RL) fueron temas centrales. Los asistentes discutieron cómo la IA está cambiando las prácticas de codificación e ingeniería, enfatizando la importancia de la experimentación y la evaluación en el desarrollo de productos de IA. Amjad Masad, CEO de Replit, compartió la experiencia de su empresa sobre cómo, tras una reducción de plantilla, lograron un aumento de la productividad y un punto de inflexión en el negocio al adoptar plenamente la IA. La conferencia también incluyó actividades lúdicas como el “Karaoke de Programación Ambiental”, mostrando la vitalidad de la comunidad de ingenieros de IA (Fuente: swyx, iScienceLuvr, HamelHusain, amasad, swyx)

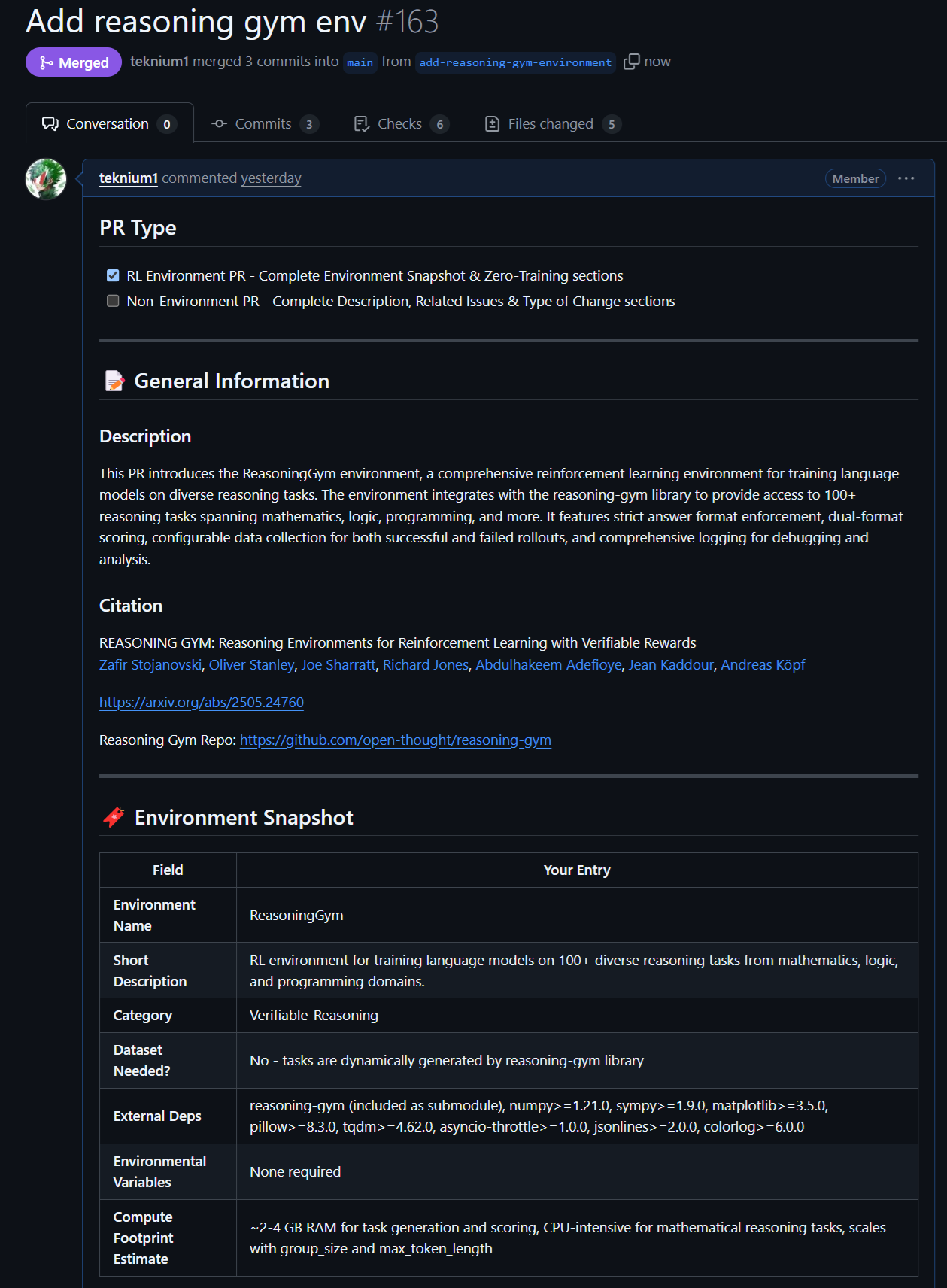

Nuevos avances en modelos y datos de código abierto: Rednote LLM y el entorno Atropos RL: La comunidad ha prestado atención al Rednote LLM, construido sobre la pila tecnológica de DeepSeek V2, que utiliza una arquitectura DS-MoE con 142B de parámetros totales y 14B de parámetros activos, aunque actualmente usa MHA en lugar de los más eficientes GQA/MLA. Al mismo tiempo, el proyecto Atropos (LLM RL Gym) de NousResearch ha añadido soporte para 101 desafiantes entornos de RL de razonamiento de Reasoning Gym, y ya ha generado alrededor de 5500 muestras de razonamiento verificadas, que se planean usar para el preentrenamiento de Hermes 4, animando a la comunidad a contribuir con más entornos de razonamiento verificables (Fuente: teortaxesTex, Teknium1, kylebrussell)

El rendimiento excepcional de los modelos de Anthropic en tareas específicas y sus métodos de RL reciben atención: La comunidad discute que los modelos Claude de Anthropic (como Sonnet 3.5/3.7) superan a otros modelos (incluidos Opus 4/Sonnet 4) en tareas que contienen datos web específicos y oscuros, especulando que podrían haber incluido más contenido de foros de Internet especializados en sus datos de entrenamiento. Al mismo tiempo, los complejos métodos de aprendizaje por refuerzo (RL) de Anthropic también son reconocidos, aunque algunas de sus prácticas y la optimización de métricas en torno a los blogs de seguridad han sido cuestionadas. Hay opiniones que consideran que Constitutional AI es esencialmente RL avanzado, capaz de diseñar políticas detalladas y controlables sin necesidad de etiquetas codificadas manualmente (Fuente: teortaxesTex, zacharynado, teortaxesTex, Dorialexander)

💡 Otros

Vosk API: Ofrece funcionalidad de reconocimiento de voz offline: Vosk API es un kit de herramientas de reconocimiento de voz offline de código abierto que admite más de 20 idiomas y dialectos, incluyendo inglés, alemán, chino, japonés, etc. Sus modelos son pequeños (alrededor de 50MB), pero pueden proporcionar transcripción continua de gran vocabulario, respuesta de latencia cero con API de streaming, y admiten vocabulario reconfigurable e identificación del hablante. Vosk proporciona capacidades de reconocimiento de voz para chatbots, hogares inteligentes, asistentes virtuales y otras aplicaciones, y también se puede utilizar para la creación de subtítulos de películas y la transcripción de conferencias y entrevistas, siendo adecuado para diversas plataformas, desde Raspberry Pi y dispositivos Android hasta grandes servidores (Fuente: GitHub Trending)

Un dron autónomo derrota por primera vez a campeones humanos en una carrera: Un dron autónomo desarrollado por la Universidad Tecnológica de Delft ha derrotado a campeones humanos en una histórica carrera. Este logro marca un nuevo nivel en la capacidad de percepción, toma de decisiones y control de la IA en entornos dinámicos y de alta velocidad, demostrando el enorme potencial de la IA en los campos de la robótica y la automatización (Fuente: Reddit r/artificial )

VentureBeat predice cuatro grandes tendencias de IA para 2025: VentureBeat ha realizado cuatro predicciones sobre el desarrollo del campo de la inteligencia artificial para 2025. Estas predicciones podrían cubrir avances tecnológicos, aplicaciones de mercado, regulaciones éticas o el panorama de la industria, cuyos detalles específicos requerirían consultar la fuente original. Este tipo de análisis prospectivo ayuda a los profesionales dentro y fuera de la industria a tomar el pulso del desarrollo de la IA (Fuente: Ronald_vanLoon)