Palabras clave:GPT-5, Capacidad de razonamiento de IA, AlphaEvolve, OpenAI Operator, Mistral AI, Cómputo y cadena de pensamiento en pruebas, Optimización autónoma de código por IA, Modelos de IA multimodal, Automatización de búsqueda de empleo con IA, Afinamiento local de LLM

🔥 Enfoque

OpenAI revela sus planes futuros: GPT-5 integrará herramientas existentes, creando una experiencia All-in-One: Jerry Tworek, vicepresidente de investigación de OpenAI, reveló en un evento AMA en Reddit que el objetivo principal del modelo fundacional de próxima generación, GPT-5, es mejorar las capacidades de los modelos existentes y reducir la complejidad del cambio entre modelos. Para ello, OpenAI planea integrar herramientas existentes como Codex (programación), Operator (ejecución de tareas informáticas), Deep Research (investigación profunda) y Memory (función de memoria) en GPT-5, para lograr una experiencia unificada. Miembros del equipo también compartieron que Codex fue inicialmente un proyecto secundario de ingenieros, su uso interno ha aumentado la eficiencia de programación aproximadamente 3 veces, y están explorando esquemas de precios flexibles, incluyendo el pago por uso. (Fuente: WeChat)

Nueva dimensión en la mejora de la capacidad de razonamiento de la IA: cálculo en tiempo de prueba y cadena de pensamiento: Lilian Weng, exalumna de la Universidad de Pekín y exdirectora de investigación de IA aplicada en OpenAI, en su último extenso artículo «Why We Think», explora en profundidad cómo mejorar la capacidad de razonamiento de los modelos de lenguaje grandes (LLM) mediante estrategias como el “cálculo en tiempo de prueba” (test-time compute) y la “cadena de pensamiento” (Chain-of-Thought, CoT). El artículo expone la justificación de hacer que los modelos “piensen más tiempo” desde múltiples perspectivas, como la teoría de los dos sistemas de la psicología, la visión de los recursos computacionales y el modelado de variables latentes, y revisa los avances en investigación sobre técnicas clave para mejorar el rendimiento del razonamiento de los modelos, como el muestreo en paralelo, la revisión de secuencias, el aprendizaje por refuerzo y el uso de herramientas externas. Weng enfatiza que, mediante estos métodos, los modelos pueden dedicar más recursos computacionales durante la inferencia, simulando el proceso de pensamiento profundo humano, para así lograr un mejor rendimiento en tareas complejas, y señala futuras direcciones de investigación en áreas como el razonamiento fiel, el descifrado de recompensas y la autocorrección no supervisada. (Fuente: WeChat, WeChat)

Google lanza AlphaEvolve: IA que escribe código de forma autónoma para optimizar algoritmos, ahorrando significativamente costos computacionales: Google ha presentado el sistema de IA AlphaEvolve, capaz de escribir y optimizar código de forma autónoma, demostrando un gran potencial en proyectos como AlphaFold. AlphaEvolve utiliza algoritmos evolutivos para buscar implementaciones algorítmicas más eficientes. Por ejemplo, en el algoritmo de plegamiento de proteínas de AlphaFold, descubrió un nuevo mecanismo de atención que redujo los costos computacionales en un 25%, lo que equivale a un ahorro de millones de dólares en recursos de cómputo. Este avance marca un paso importante para la IA en los campos del descubrimiento científico y la optimización de algoritmos, y se espera que en el futuro logre reducir costos y aumentar la eficiencia en problemas computacionales más complejos. (Fuente: Reddit r/ArtificialInteligence)

OpenAI admite: La inversión en razonamiento de IA es directamente proporcional al rendimiento, la clave para superar la capacidad humana es el “tiempo de pensamiento”: Noam Brown, investigador de OpenAI, enfatizó en una discusión que la IA está transitando del “paradigma de preentrenamiento” al “paradigma de razonamiento”. El preentrenamiento predice la siguiente palabra a través de datos masivos, lo cual es costoso; mientras que el paradigma de razonamiento permite al modelo “pensar” más profundamente antes de responder, y aunque el costo sea ligeramente mayor, la calidad de la respuesta mejora significativamente. Por ejemplo, el modelo o1 superó a GPT-4o en la competencia de matemáticas AIME y en problemas científicos de nivel doctoral de GPQA, y el modelo o3 ha alcanzado el nivel más alto de la humanidad en competencias de programación. Esto indica que, al aumentar la inversión en recursos computacionales durante el razonamiento (es decir, el “tiempo de pensamiento”), el rendimiento de la IA en tareas complejas puede lograr un salto enorme, incluso superando a los humanos. (Fuente: WeChat)

🎯 Movimientos

Mistral AI muestra resultados significativos de sus modelos en 2025, con varios modelos de rendimiento sobresaliente: Mistral AI ha logrado importantes avances en la primera mitad de 2025, lanzando varios modelos de alto rendimiento, incluyendo Codestral 25.01 (modelo FIM de vanguardia), Mistral Small 3 & 3.1 (el mejor en su clase, compatible con multimodalidad y contexto de 130k), Mistral Saba (rendimiento que supera a modelos tres veces más grandes), Mistral OCR (modelo OCR de vanguardia) y Mistral Medium 3. Estos logros demuestran la sólida capacidad de I+D de Mistral AI en diferentes tamaños de modelos y áreas de aplicación, especialmente liderando en generación de código, procesamiento multimodal y tecnología OCR. (Fuente: qtnx_)

Fluctuaciones recientes en el rendimiento del modelo Claude, usuarios reportan problemas con el procesamiento de contexto y la función Artifact: Usuarios de la comunidad de Reddit informan que el modelo Claude de Anthropic (especialmente Opus 3) ha experimentado recientemente problemas con el procesamiento de contextos largos, la estabilidad en la generación de Artifacts, así como con el inicio de sesión y el tiempo de actividad. Específicamente, los chats se interrumpen después de unas pocas rondas, la función Artifact no se completa o exporta archivos vacíos, etc. La página de estado de Anthropic confirma un aumento en los errores de solicitud de contexto largo y varias interrupciones breves del servicio, posiblemente relacionadas con el lanzamiento de la función Artifact y ajustes en el backend. Algunos usuarios mitigan el problema solicitando directamente salida en Markdown, cambiando de red o utilizando Claude 3.5 Sonnet, entre otros métodos. (Fuente: Reddit r/ClaudeAI, qtnx_, Reddit r/ClaudeAI)

xAI publica los prompts del sistema de Grok, revelando su diseño de humor y pensamiento crítico: La empresa xAI ha publicado los prompts del sistema de su modelo de IA Grok, los cuales revelan que Grok fue diseñado como un asistente de IA con sentido del humor, ligeramente rebelde y con capacidad de pensamiento crítico. Los prompts enfatizan que Grok debe evitar respuestas moralizantes y lo alientan a mostrar un “estilo Grok” único al responder a temas controvertidos. Esta acción aumenta la transparencia en el diseño del comportamiento de los modelos de IA y permite al público conocer el origen de la personalidad distintiva de Grok. (Fuente: Reddit r/artificial)

Meta podría estar probando el modelo Llama 3.3 8B Instruct en OpenRouter: Meta podría estar probando su modelo Llama 3.3 8B Instruct en la plataforma OpenRouter. Dicho modelo se describe como una versión ligera y de respuesta rápida de Llama 3.3 70B, con una ventana de contexto de 128,000 y aparece como gratuito en OpenRouter. Algunos usuarios que lo han probado consideran que su salida es algo insípida en comparación con las versiones 8B 3.1 o 3.3 70B. Esta medida podría significar que Meta está explorando la implementación y los escenarios de aplicación de modelos de diferentes tamaños. (Fuente: Reddit r/LocalLLaMA)

Decisión controvertida de la IA en una carrera de F1 genera debate: Una discusión sobre una decisión controvertida tomada por la IA en una carrera de F1 ha suscitado preocupación sobre la aplicación de la IA en las competiciones deportivas. Aunque no se conocen los detalles específicos, esto generalmente involucra la precisión y la imparcialidad de los sistemas de arbitraje de IA en situaciones complejas y de alta velocidad, así como la forma en que los árbitros humanos y los sistemas de IA deben colaborar. (Fuente: Ronald_vanLoon)

El primer portaaviones no tripulado de China, “Jiutian”, planea su primer vuelo en junio: China planea realizar en junio el primer vuelo de su primer portaaviones aéreo no tripulado, el “Jiutian” SS-UAV. Dicho dron puede volar a una altitud de 15,000 metros, transportar más de 100 drones pequeños o 1000 kilogramos de misiles, y tiene un alcance de 7000 kilómetros. Esta noticia ha generado atención sobre el desarrollo de la tecnología de drones militares de China. (Fuente: menhguin)

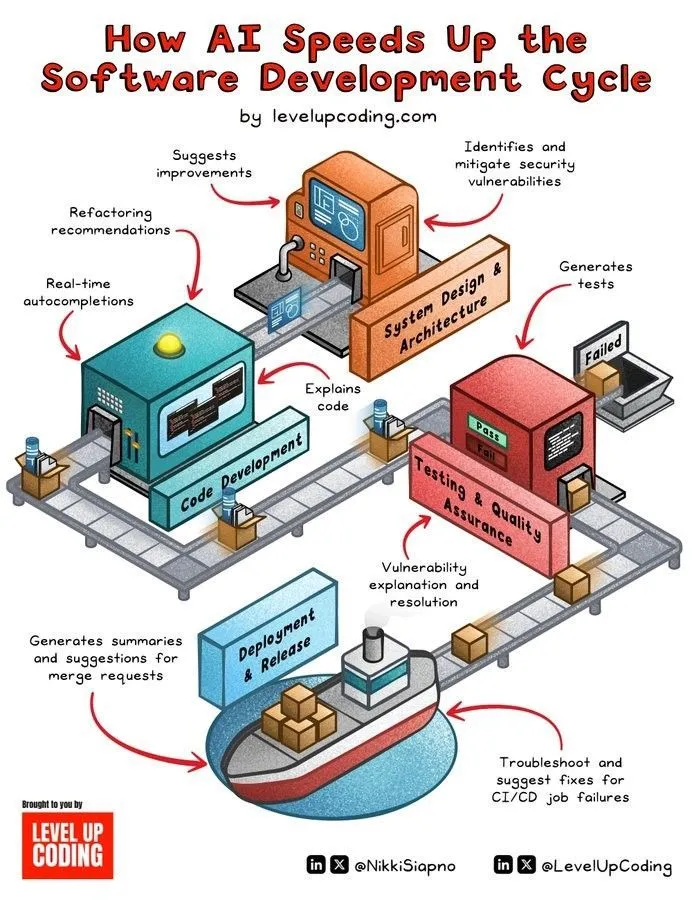

La IA acelera el ciclo de desarrollo de software: La tecnología de IA está acelerando significativamente el ciclo de vida del desarrollo de software mediante la automatización de tareas como la generación de código, pruebas, depuración y redacción de documentación. Las herramientas de IA ayudan a los desarrolladores a mejorar la eficiencia, reducir el trabajo repetitivo y pueden detectar errores potenciales, acortando así el tiempo de comercialización del producto. (Fuente: Ronald_vanLoon)

Tecnología miniaturizada similar al cerebro humano dota a los robots humanoides de percepción y pensamiento en tiempo real: Se está desarrollando una tecnología miniaturizada que imita la estructura del cerebro humano con el objetivo de dotar a los robots humanoides de capacidades de percepción visual y pensamiento en tiempo real. Esta tecnología podría involucrar la computación neuromórfica o el diseño eficiente de chips de IA, con la esperanza de que los robots puedan reaccionar de manera más rápida e inteligente en entornos complejos. (Fuente: Ronald_vanLoon)

Fourier Intelligence presenta su robot humanoide de desarrollo propio Fourier GR-1: Fourier Intelligence (Fourier Robots) ha presentado su robot humanoide de desarrollo propio, GR-1. El diseño del robot se centra en un control de movimiento avanzado y una estructura de torso altamente biónica, con el objetivo de lograr una capacidad de movimiento más flexible y natural, demostrando los avances de China en el campo de los robots humanoides. (Fuente: Ronald_vanLoon)

Actualización de la agilidad del robot biónico Unitree G1: La empresa Unitree ha mostrado una versión actualizada de la agilidad de su robot biónico G1. Esto generalmente implica mejoras en el control de movimiento, la capacidad de equilibrio y la adaptabilidad al entorno del robot, lo que le permite realizar tareas de manera más flexible y hacer frente a terrenos complejos. (Fuente: Ronald_vanLoon)

Robot humanoide chino realiza tareas de inspección de calidad: Los robots humanoides en China ya se están utilizando para realizar tareas de inspección de calidad. Esto indica que la aplicación de robots humanoides en el campo de la automatización industrial se está expandiendo gradualmente, utilizando su flexibilidad y capacidades de percepción para reemplazar o ayudar a los humanos en trabajos de inspección repetitivos y de alta precisión. (Fuente: Ronald_vanLoon)

Nanorobots portan “armas ocultas” para matar células cancerosas: Un nuevo avance en tecnología médica muestra que los nanorobots pueden portar “armas ocultas” para dirigirse con precisión y matar células cancerosas. Esta tecnología utiliza el tamaño diminuto y la controlabilidad de los nanorobots, con la esperanza de lograr tratamientos contra el cáncer más precisos y con menos efectos secundarios. (Fuente: Ronald_vanLoon)

La importancia de las tecnologías de mejora de la privacidad para los negocios modernos es cada vez más evidente: Con el endurecimiento de las regulaciones de privacidad de datos y el aumento de la conciencia de los usuarios sobre la protección de la información personal, las tecnologías de mejora de la privacidad (PETs) son cada vez más importantes para las empresas modernas. Estas tecnologías, como el aprendizaje federado y el cifrado homomórfico, permiten el análisis de datos y la extracción de valor mientras se protege la privacidad de los datos, ayudando a las empresas a desarrollarse de conformidad con las regulaciones. (Fuente: Ronald_vanLoon)

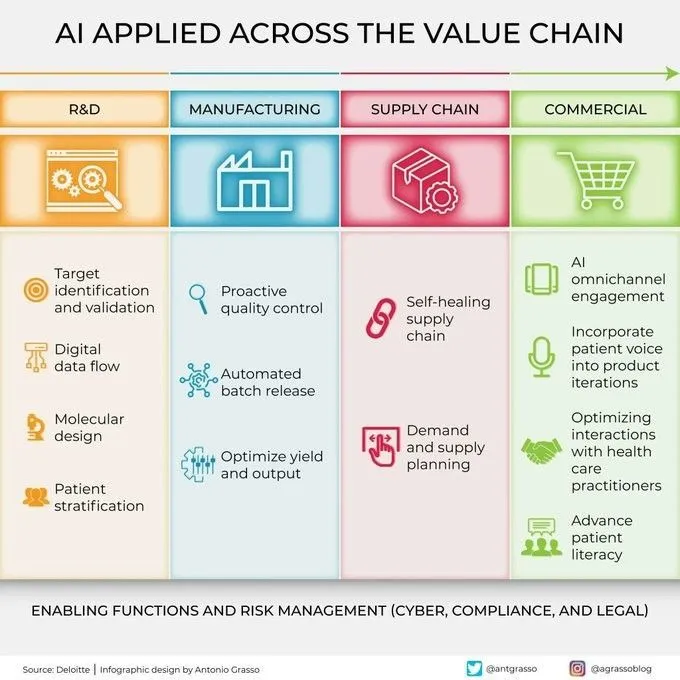

La IA se aplica cada vez más en todos los eslabones de la cadena de valor: La tecnología de inteligencia artificial se está aplicando ampliamente en todos los eslabones de la cadena de valor de las empresas, incluyendo I+D, producción, marketing, ventas y servicio postventa. A través del análisis de datos, modelado predictivo, automatización de procesos, etc., la IA ayuda a las empresas a optimizar la eficiencia operativa, mejorar la experiencia del cliente y crear nuevo valor comercial. (Fuente: Ronald_vanLoon)

🧰 Herramientas

KernelSU: Solución de Root para Android basada en el kernel: KernelSU es una solución de Root basada en el kernel diseñada para dispositivos Android. Proporciona su a nivel de kernel y gestión de acceso Root, y cuenta con un sistema de módulos basado en OverlayFS, así como funciones de configuración de perfiles de aplicación, con el objetivo de controlar los permisos del dispositivo a un nivel más profundo. El proyecto es compatible con dispositivos Android GKI 2.0 (kernel 5.10+), también es compatible con kernels más antiguos (4.14+, requiere compilación manual) y es compatible con WSA, ChromeOS y entornos Android en contenedores. (Fuente: GitHub Trending)

Sunshine: Host de transmisión de juegos autoalojado, compatible con Moonlight: Sunshine es un software de host de transmisión de juegos autoalojado y de código abierto que permite a los usuarios transmitir los juegos de su PC a varios dispositivos compatibles con Moonlight. Admite la codificación por hardware para GPU de AMD, Intel y Nvidia, y también ofrece opciones de codificación por software, con el objetivo de lograr una experiencia de juego en la nube de baja latencia. Los usuarios pueden realizar la configuración y el emparejamiento de clientes a través de una interfaz de usuario web (Web UI). (Fuente: GitHub Trending)

Tasmota: Firmware alternativo de código abierto para dispositivos ESP8266/ESP32: Tasmota es un firmware alternativo diseñado para dispositivos inteligentes basados en los chips ESP8266 y ESP32. Ofrece una interfaz de usuario web fácil de usar para la configuración, admite actualizaciones OTA (Over-The-Air) en línea, permite la automatización mediante temporizadores o reglas, y proporciona control local completo a través de los protocolos MQTT, HTTP, puerto serie o KNX, mejorando la extensibilidad y personalización de los dispositivos. (Fuente: GitHub Trending)

Limbo: Proyecto de evolución moderna de SQLite en Rust: El proyecto Limbo tiene como objetivo construir una versión moderna y evolucionada de SQLite utilizando el lenguaje Rust. Es compatible con E/S asíncrona io_uring en Linux, el dialecto SQL de SQLite, su formato de archivo y su API en C, y ofrece bindings para lenguajes como JavaScript/WASM, Rust, Go, Python y Java. Los planes futuros incluyen la integración de búsqueda vectorial, mejoras en la escritura concurrente y la gestión de esquemas, entre otras funciones. (Fuente: GitHub Trending)

Ventoy: Solución de nueva generación para unidades USB de arranque: Ventoy es una herramienta de código abierto para crear unidades USB de arranque, que admite el arranque directo desde archivos de imagen en múltiples formatos como ISO, WIM, IMG, VHD(x), EFI, etc., sin necesidad de formatear repetidamente la unidad USB. Los usuarios solo necesitan copiar los archivos de imagen a la unidad USB y Ventoy generará automáticamente un menú de arranque. Es compatible con múltiples sistemas operativos y modos de arranque (Legacy BIOS, UEFI), y es compatible con particiones MBR y GPT. (Fuente: GitHub Trending)

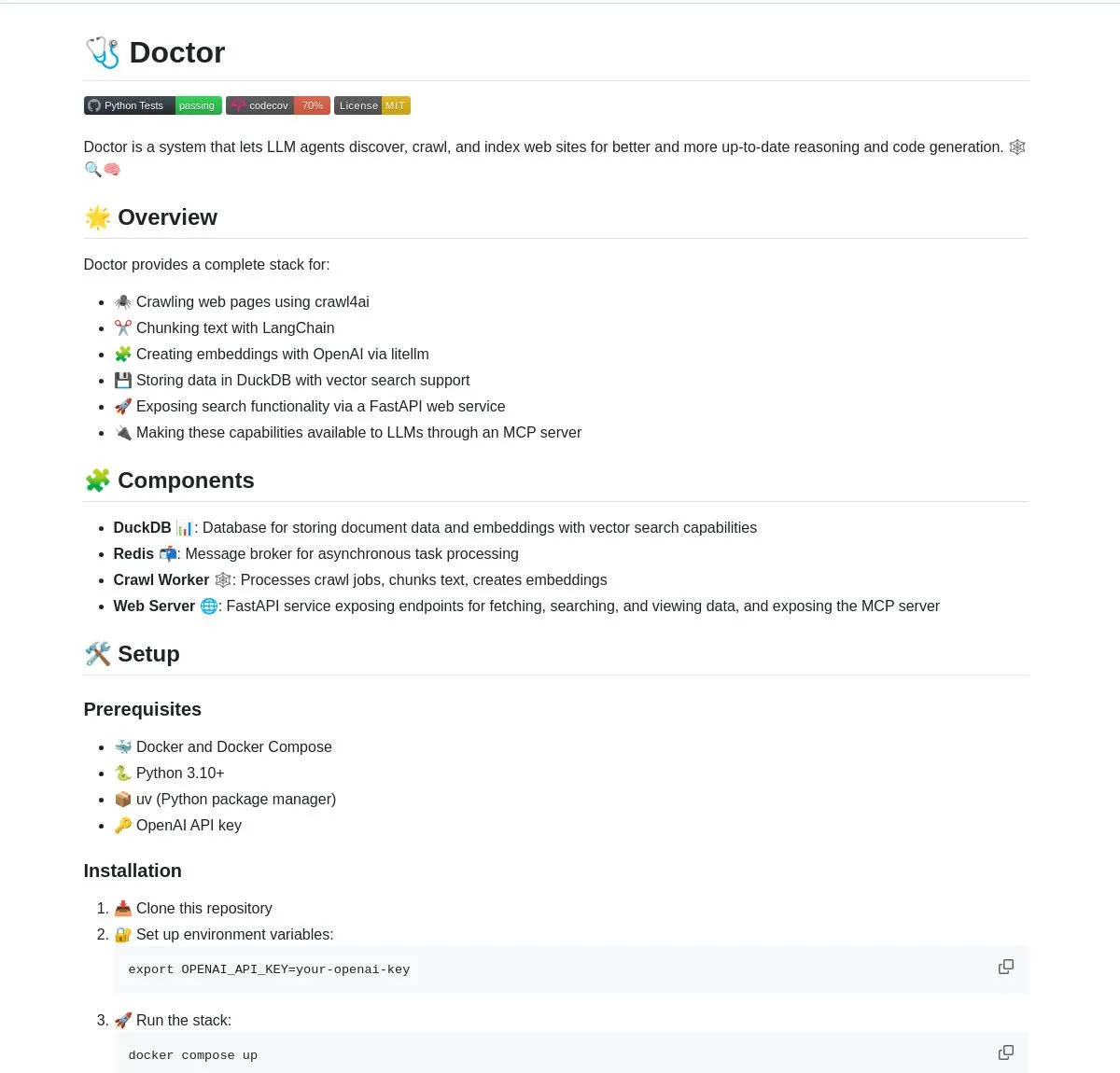

Doctor: Herramienta de rastreo y comprensión web para agentes LLM impulsada por LangChain: Doctor es una herramienta que ayuda a los agentes LLM a rastrear y comprender contenido web en tiempo real. Combina el procesamiento de páginas web, la búsqueda vectorial y las capacidades de procesamiento de documentos de LangChain, y ofrece sus servicios a través de FastAPI. Los usuarios pueden utilizar Doctor para mejorar las capacidades de adquisición y análisis de información de sus aplicaciones de IA. (Fuente: LangChainAI, Hacubu)

Deep Research Agent: Agente de investigación de IA que protege la privacidad y se ejecuta localmente: Un agente de IA de código abierto centrado en la protección de la privacidad, que puede ejecutarse localmente para investigar cualquier tema. Utiliza LangGraph para impulsar su flujo de trabajo de investigación iterativo, proporcionando a los usuarios una potente herramienta de investigación localizada sin necesidad de cargar datos a la nube. (Fuente: LangChainAI, Hacubu)

Asistente de terminal inteligente: Herramienta multi-SO para convertir lenguaje natural a comandos de línea: Un asistente de terminal inteligente capaz de convertir instrucciones en lenguaje natural a comandos de terminal para múltiples sistemas operativos. La herramienta está construida sobre un sistema multiagente de LangGraph y utiliza los protocolos A2A y MCP para la ejecución multiplataforma, con el objetivo de simplificar las operaciones de línea de comandos y reducir la barrera de entrada para los usuarios. (Fuente: LangChainAI)

Montelimar: Caja de herramientas OCR de código abierto para dispositivos: Julien Blanchon ha lanzado Montelimar, una caja de herramientas de OCR (Reconocimiento Óptico de Caracteres) de código abierto para dispositivos. Permite realizar capturas de pantalla y aplicar OCR a diferentes partes de la pantalla, siendo compatible con los modelos Nougat y OCRS. El backend utiliza Rust (para OCRS) y MLX (para Nougat) respectivamente. La herramienta puede generar salidas en LaTeX, tablas, Markdown (a través de Nougat, más lento) y texto plano (a través de OCRS, más rápido), y ofrece historial y funciones de acceso rápido a nivel de sistema. (Fuente: awnihannun)

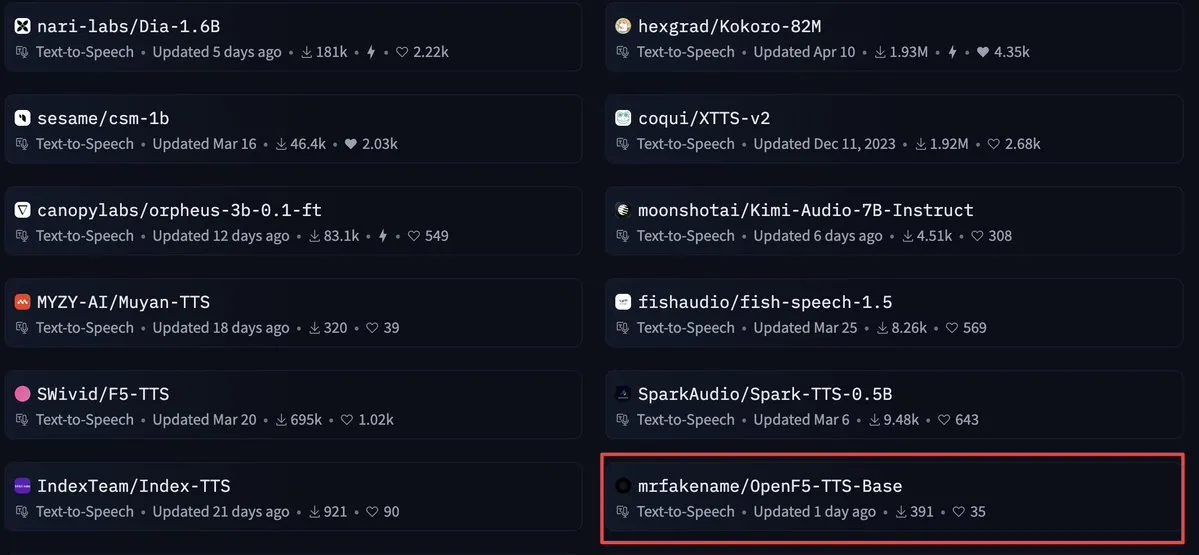

OpenF5 TTS: Modelo de texto a voz con licencia Apache 2.0 para uso comercial: OpenF5 TTS es un modelo de texto a voz reentrenado basado en el modelo F5-TTS, que utiliza la licencia de código abierto Apache 2.0 y puede ser utilizado con fines comerciales. Actualmente, este modelo goza de gran popularidad entre los modelos de texto a voz en Hugging Face, ofreciendo a los desarrolladores una opción de síntesis de voz de alta calidad y apta para uso comercial. (Fuente: ClementDelangue)

Tensor Slayer: Herramienta para mejorar el rendimiento del modelo sin entrenamiento directo: Tensor Slayer es una herramienta recién lanzada que afirma poder mejorar el rendimiento del modelo en un 25% mediante el “parcheo directo de tensores” (direct tensor patching), sin necesidad de fine-tuning, conjuntos de datos, costos computacionales adicionales o tiempo de entrenamiento. Este concepto es bastante disruptivo y tiene como objetivo democratizar la mejora de los modelos de IA. (Fuente: TheZachMueller)

Photoshop utiliza agentes de uso de computadora locales (c/ua) para operaciones sin código: Computer Use Agents (c/ua) demuestra cómo lograr operaciones sin código en Photoshop mediante prompts del usuario, selección de modelos, Docker y un ciclo de agente adecuado. Esto tiene como objetivo reducir la barrera de entrada para que los usuarios comunes utilicen software complejo, simplificando los flujos de operación a través de agentes de IA. (Fuente: Reddit r/artificial)

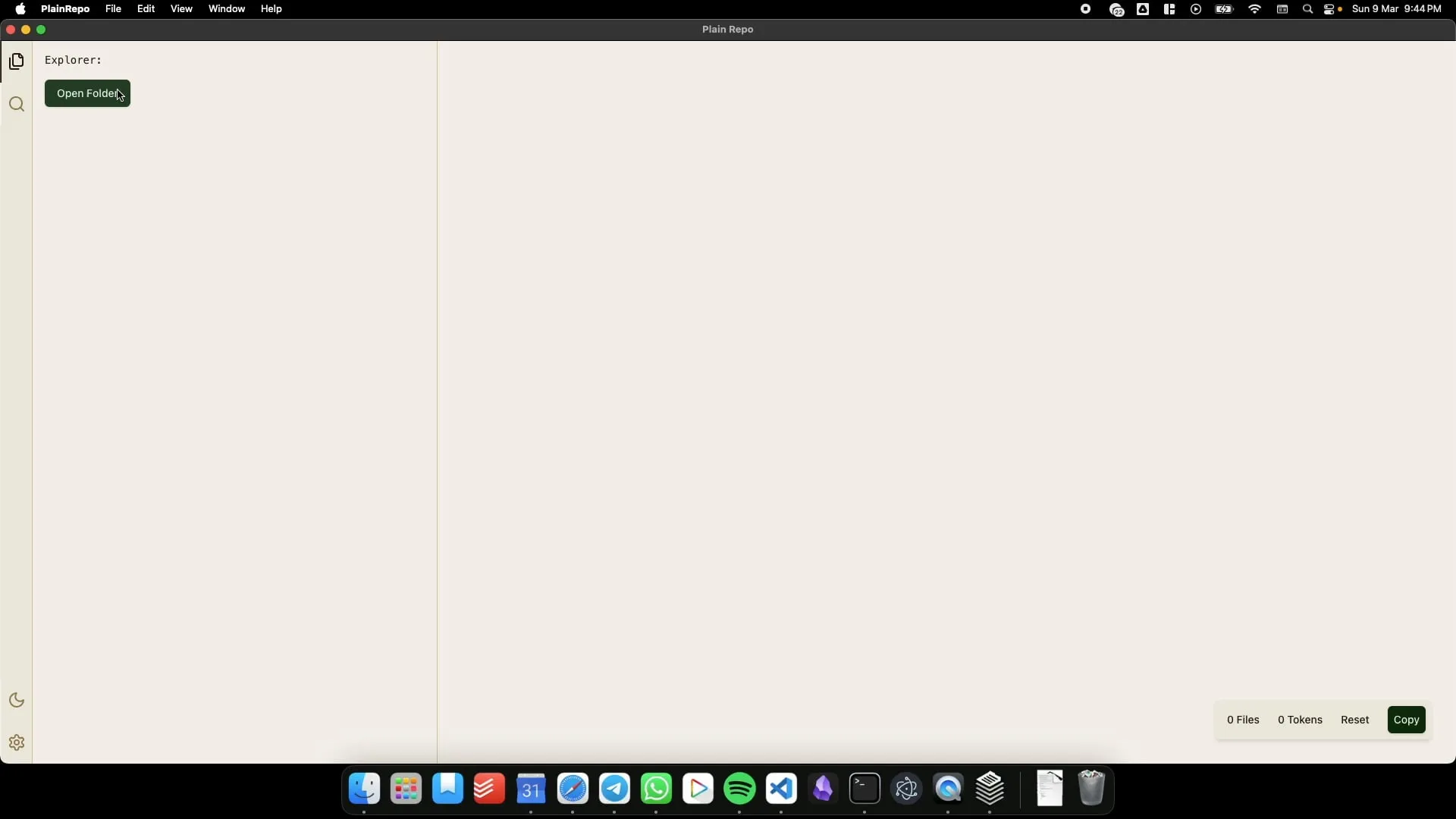

PlainRepo: Aplicación offline para copiar selectivamente grandes bloques de código/texto para la extracción de contexto por LLM: PlainRepo es una aplicación gratuita y de código abierto que funciona sin conexión y permite a los usuarios copiar selectivamente grandes fragmentos de código o texto para que los LLM locales extraigan información de contexto. Esto es muy útil para usuarios que necesitan utilizar LLM locales en entornos sin red o por consideraciones de privacidad. (Fuente: Reddit r/LocalLLaMA, Plus-Garbage-9710)

M0D.AI: Marco de control de interacción con IA personalizado, creado por un usuario en colaboración con IA durante cinco meses: El usuario James O’Kelly, a través de una profunda colaboración con IA (como Gemini, ChatGPT) durante cinco meses y aproximadamente 13,000 conversaciones, ha construido un marco de interacción y control de IA altamente personalizado llamado M0D.AI. El sistema incluye un backend en Python, un servidor web Flask, una interfaz de usuario frontend dinámica y una capa metacognitiva llamada mematrix.py, utilizada para monitorear y guiar el comportamiento de la IA. M0D.AI demuestra cómo los usuarios sin experiencia en programación pueden, con la ayuda de la IA, diseñar y desarrollar sistemas de software complejos. (Fuente: Reddit r/artificial)

📚 Aprendizaje

Ingeniería de LLM: Repositorio de recursos del curso para dominar IA y LLM en 8 semanas: Un curso de 8 semanas llamado “LLM Engineering – Master AI and LLMs” tiene como objetivo ayudar a los estudiantes a dominar la ingeniería de modelos de lenguaje grandes. El repositorio de GitHub que acompaña al curso proporciona el código del proyecto semanal, guías de configuración (PC, Mac, Linux) y enlaces a Colab. El curso enfatiza la práctica, comenzando con la instalación de Ollama para ejecutar Llama 3.2, y profundizando gradualmente en HuggingFace, el uso de API, el fine-tuning de modelos, etc. También proporciona orientación sobre el uso de Ollama como una alternativa gratuita a las API de pago como OpenAI. (Fuente: GitHub Trending)

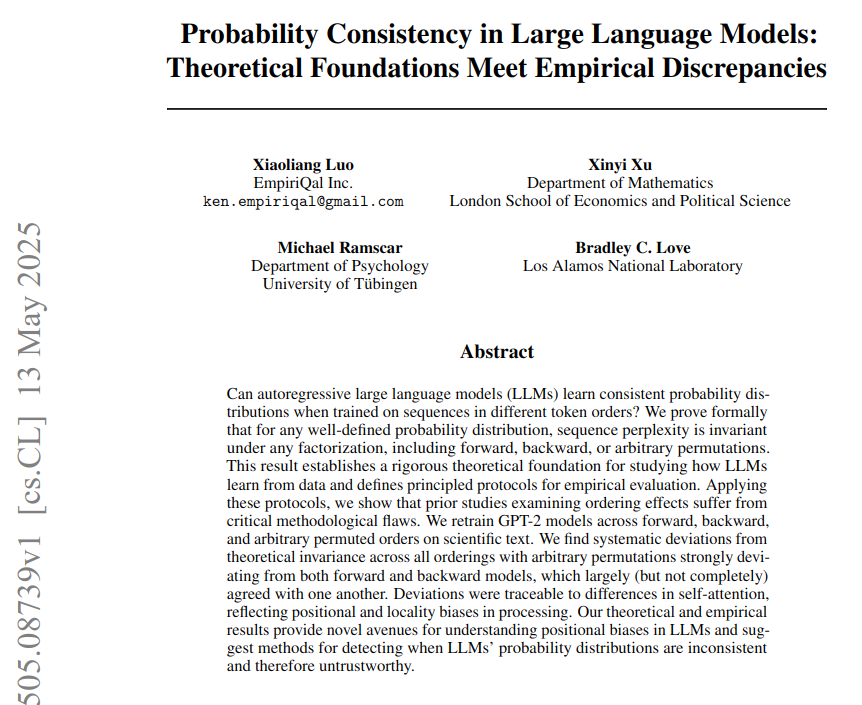

Consistencia probabilística en LLM: Fundamentos teóricos y estudio de diferencias empíricas: Un artículo titulado “Consistencia probabilística en LLM: Fundamentos teóricos y diferencias empíricas” señala que los modelos de lenguaje grandes (LLM) utilizan una política fija para calcular las probabilidades de los tokens, pero el rendimiento real de los modelos bajo diferentes órdenes de tokens se desvía de la consistencia probabilística teórica. La investigación, mediante el entrenamiento de un modelo GPT-2 en textos de neurociencia (utilizando órdenes de tokens hacia adelante, hacia atrás y permutados), demuestra que la perplejidad es teóricamente independiente del orden, pero empíricamente los modelos no superan esta prueba debido a sesgos arquitectónicos. Los sesgos de atención (locales y de largo alcance) se consideran la causa directa de las fallas de consistencia observadas. (Fuente: menhguin)

BoldVoice utiliza machine learning para cuantificar y guiar la intensidad del acento en inglés: La aplicación BoldVoice utiliza machine learning y técnicas de espacio latente para cuantificar la intensidad del acento en inglés y proporcionar a los usuarios orientación sobre la pronunciación. Este método tiene como objetivo ayudar a los usuarios a mejorar de manera más efectiva su pronunciación y acento en inglés. (Fuente: dl_weekly)

Blog de Milvus: Desafíos y optimización del filtrado eficiente de metadatos en entornos de producción manteniendo una alta recuperación: Milvus ha publicado una entrada de blog práctica que explora cómo, en la búsqueda vectorial en entornos de producción, se puede realizar un filtrado eficiente de metadatos mientras se mantiene una alta tasa de recuperación (recall). El artículo discute los desafíos relacionados y propone estrategias de optimización. (Fuente: dl_weekly)

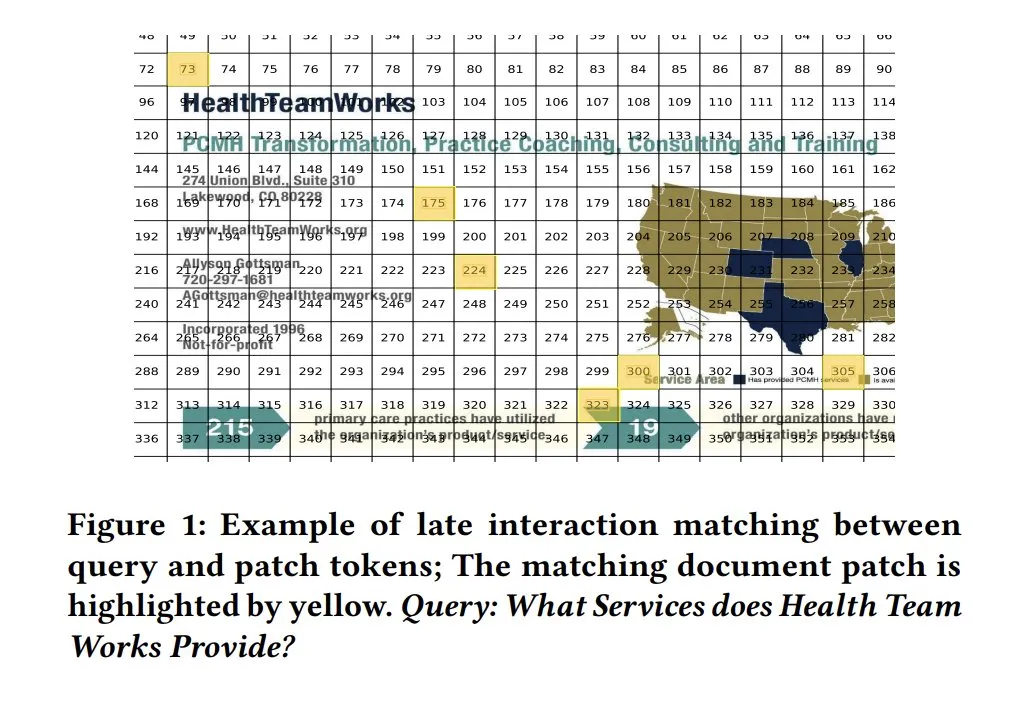

Mapas de similitud de ColPali para la interpretabilidad de modelos: Los mapas de similitud (similarity maps) en modelos de recuperación de documentos visuales como ColPali ofrecen una potente interpretabilidad para la coincidencia a nivel de fragmento entre consultas y documentos. Visualizar qué regiones de la imagen son relevantes para la consulta, mediante mapas de calor u otros métodos, ayuda a comprender el proceso de toma de decisiones del modelo. Tony Wu proporciona una guía de inicio rápido relacionada. (Fuente: lateinteraction, tonywu_71, lateinteraction)

soarXiv: Una forma elegante de explorar el conocimiento humano: Jinay ha lanzado soarXiv, una plataforma diseñada para explorar artículos de investigación científica de una manera más estética e interactiva. Los usuarios pueden reemplazar “arxiv” en la URL de un artículo de ArXiv por “soarxiv” para localizar y navegar por dicho artículo en una interfaz similar a un mapa estelar cósmico. La plataforma ya ha incorporado 2.8 millones de artículos hasta abril de 2025. (Fuente: menhguin)

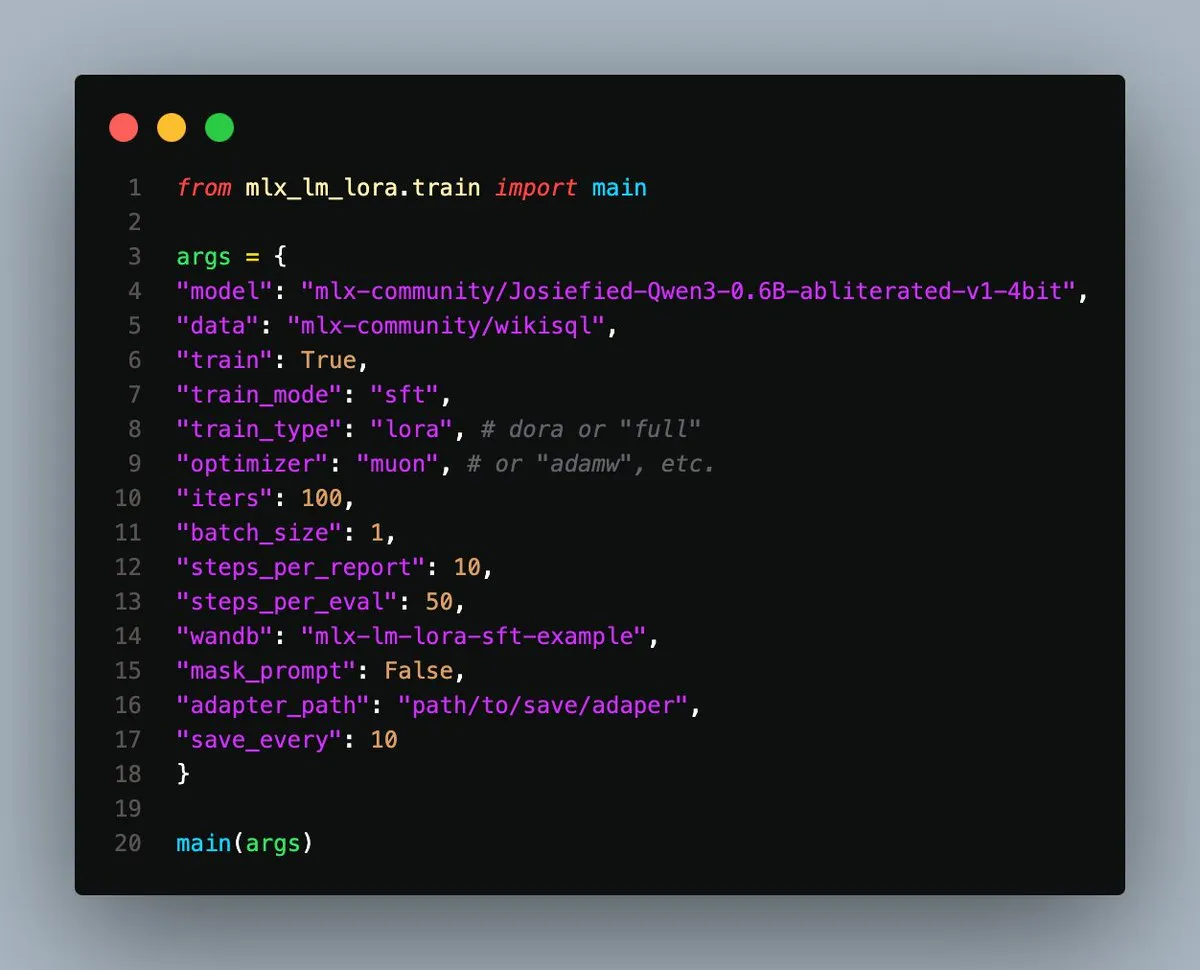

Lanzamiento de MLX-LM-LoRA v0.3.3, simplifica el fine-tuning local en Apple Silicon: Gökdeniz Gülmez ha lanzado la versión v0.3.3 de MLX-LM-LoRA, simplificando y flexibilizando aún más el proceso de fine-tuning local de modelos en Apple Silicon. La nueva versión permite establecer el número de épocas de entrenamiento (epochs) directamente en la configuración de entrenamiento o en la línea de comandos, y proporciona scripts y Notebooks de ejemplo, incluyendo fine-tuning básico y casos de entrenamiento de preferencias avanzado utilizando DPO, requiriendo solo unas 20 líneas de código para comenzar. (Fuente: awnihannun)

Análisis de filtraciones de prompts del sistema: Revelando la arquitectura interna y las reglas de comportamiento de los principales LLM: Simbaproduz ha publicado un proyecto en GitHub que analiza exhaustivamente las recientes filtraciones de prompts del sistema de los principales modelos de lenguaje grandes (como Claude 3.7, ChatGPT-4o, Grok 3, Gemini, etc.). Esta guía profundiza en la arquitectura interna, la lógica operativa y las reglas de comportamiento de estos modelos, incluyendo la persistencia de la información, las estrategias de procesamiento de imágenes, los métodos de navegación web, los sistemas de personalización y los mecanismos de defensa contra la manipulación adversaria. Esta información tiene un valor de referencia importante para la construcción de herramientas LLM, agentes inteligentes y sistemas de evaluación. (Fuente: Reddit r/MachineLearning)

Artículo de ICML 2025 explora la descomposición en el dominio de la frecuencia de las perturbaciones adversarias en imágenes: Un artículo Spotlight de ICML 2025 de la Universidad de la Academia China de Ciencias y el Instituto de Tecnología de la Computación, titulado «Diffusion-based Adversarial Purification from the Perspective of the Frequency Domain», propone que las perturbaciones adversarias tienden a dañar más el espectro de amplitud y fase de alta frecuencia de las imágenes. Basándose en esto, los investigadores proponen inyectar la información de baja frecuencia de la muestra original como un prior durante el proceso inverso de los modelos de difusión para guiar la generación de muestras limpias, eliminando así eficazmente las perturbaciones adversarias y preservando el contenido semántico de la imagen. (Fuente: WeChat)

Artículo de ICML 2025 TokenSwift: Aceleración 3x en la generación de texto largo de nivel 100K mediante “autocompletado”: El equipo NLCo de BIGAI presentó en ICML 2025 el artículo «TokenSwift: Lossless Acceleration of Ultra Long Sequence Generation», que propone un marco de aceleración eficiente y sin pérdidas llamado TokenSwift para la inferencia de texto largo a nivel de 100K tokens. Este marco, mediante mecanismos como el borrador paralelo de múltiples tokens, el autocompletado heurístico basado en n-gramas, la verificación paralela en estructura de árbol y la gestión dinámica de caché KV, logra una aceleración de inferencia de más de 3 veces manteniendo la consistencia con la salida del modelo original, mejorando significativamente la eficiencia de la generación de secuencias ultralargas. (Fuente: WeChat)

💼 Negocios

OpenAI acusada de fomentar la carrera armamentista de IA sobre la que una vez advirtió: Un artículo de Bloomberg explora cómo OpenAI, después de lanzar ChatGPT, pasó de ser una organización cautelosa sobre los riesgos de la IA a convertirse en un actor clave que impulsa la carrera tecnológica de la IA. El artículo posiblemente analiza el cambio estratégico de OpenAI, las presiones de comercialización y el impacto de sus acciones en la dirección del desarrollo de toda la industria de la IA y las consideraciones de seguridad. (Fuente: Reddit r/ArtificialInteligence)

La administración Trump cancela casi 3 mil millones de dólares en fondos de investigación para la Universidad de Harvard, desatando una competencia global por el talento: La administración Trump canceló casi 3 mil millones de dólares en fondos de investigación para la Universidad de Harvard, afectando a más de 350 proyectos, una medida considerada un duro golpe para el sistema de investigación de EE. UU. Al mismo tiempo, la Unión Europea, Canadá, Australia y otros países y regiones han lanzado planes de financiación de decenas de millones de dólares con la intención de atraer a los principales científicos estadounidenses afectados, lo que ha generado un debate sobre el flujo global de talento en investigación. La Universidad de Harvard ha presentado una demanda y ha asignado 250 millones de dólares de sus propios fondos para mitigar la crisis. (Fuente: WeChat)

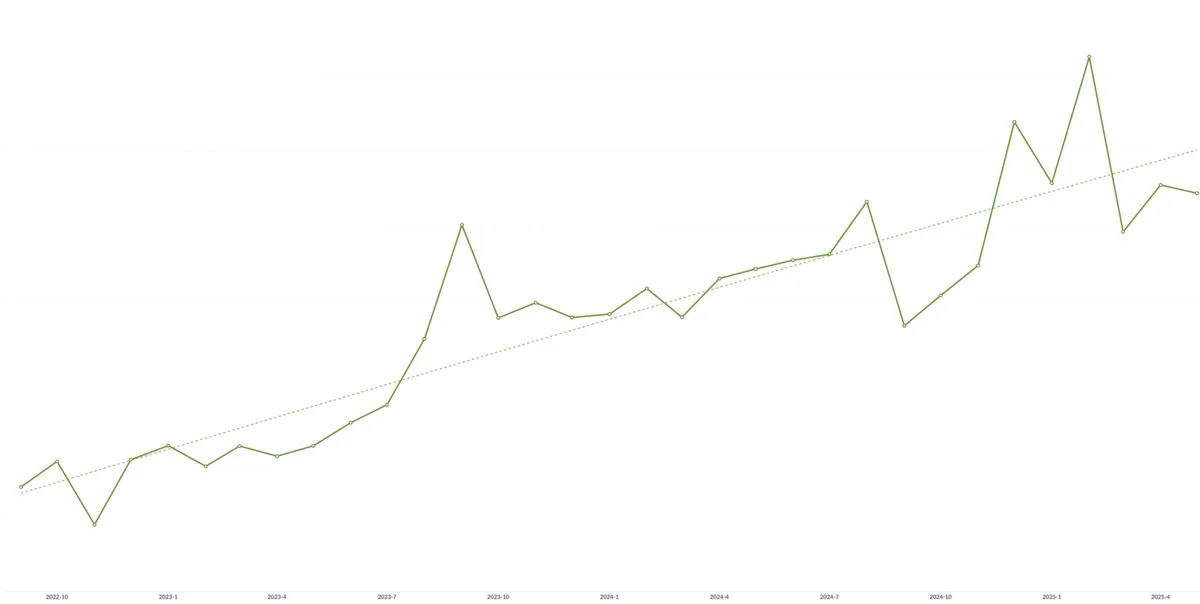

La startup de IA Spellbook registra un crecimiento continuo del valor contractual promedio (ACV) durante tres años consecutivos: A pesar de las preocupaciones sobre la posible presión a la baja de los precios debido a la mercantilización de la tecnología de IA, Scott Stevenson, cofundador de la startup de software legal de IA Spellbook, afirmó que el valor contractual promedio (ACV) de su empresa ha crecido durante tres años consecutivos. Considera que los equipos que actúan con rapidez pueden seguir creando nuevo valor a través de los productos de IA, contrarrestando así la posible presión a la baja de los precios. (Fuente: scottastevenson)

🌟 Comunidad

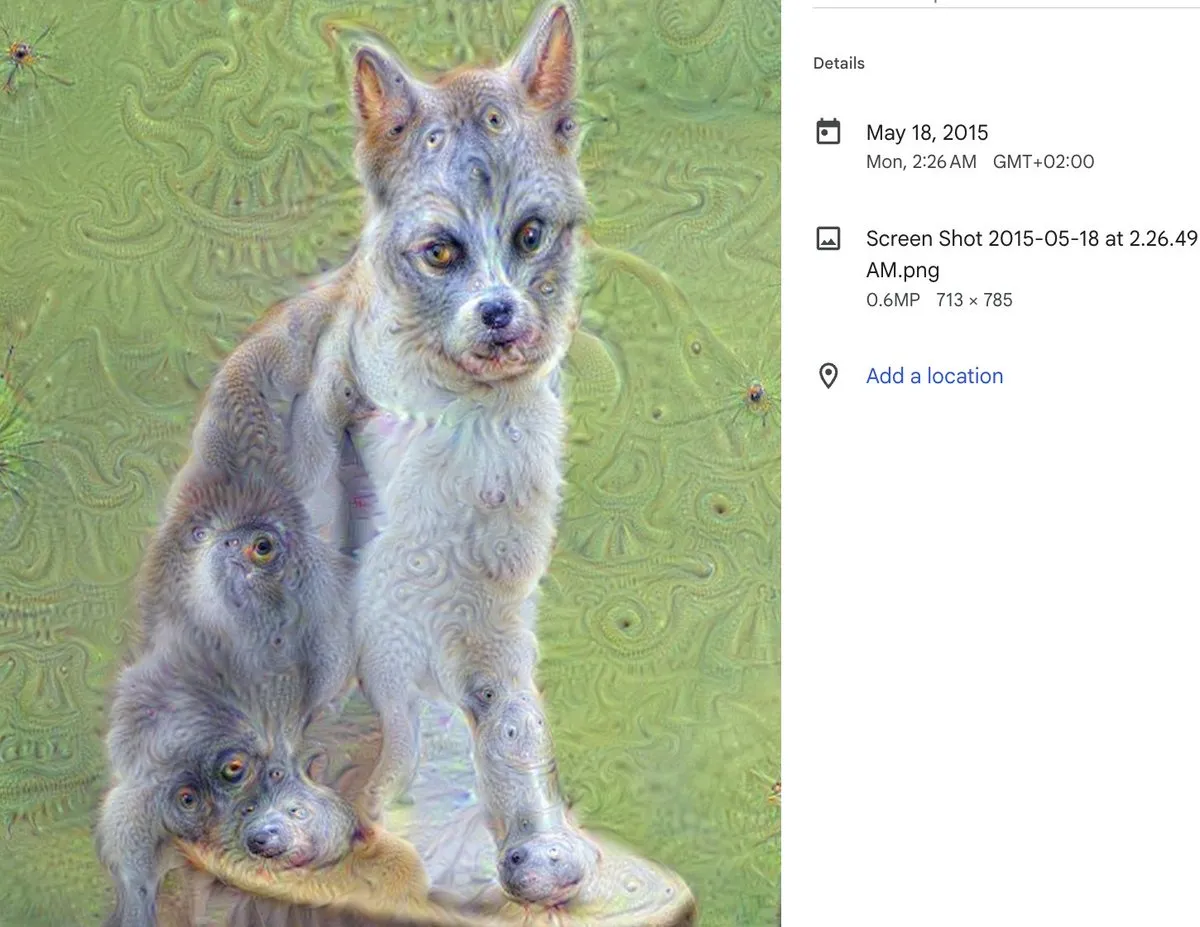

Décimo aniversario de DeepDream: Hito del arte con IA y su profundo impacto: Alex Mordvintsev, creador de DeepDream, rememoró el nacimiento de esta fenomenal herramienta de arte con IA hace diez años. Cristóbal Valenzuela, cofundador de Runway, también compartió cómo DeepDream lo inspiró a dedicarse al campo del arte con IA y, finalmente, a cofundar Runway. La aparición de DeepDream marcó una temprana demostración del potencial de la IA en el campo de la creación artística, ejerciendo una profunda influencia en el desarrollo posterior del arte generativo y las herramientas de creación de contenido con IA. (Fuente: c_valenzuelab)

Debate candente sobre si la IA necesita cofundadores técnicos: En las redes sociales ha surgido un debate sobre el “consejo de los primeros VCs a los emprendedores de que ya no necesitan cofundadores técnicos, sino solo gerentes de producto e IA para construir productos”. Este punto de vista ha generado una amplia controversia, con personas como Danielle Fong mostrando su desacuerdo, insinuando que la IA actualmente no puede reemplazar por completo el papel central y la profunda comprensión técnica de los fundadores técnicos. (Fuente: jonst0kes)

Discusión sobre el problema de las alucinaciones en IA: causas técnicas y estrategias de afrontamiento: La comunidad debate acaloradamente el problema de las “alucinaciones” (generación segura de información falsa o inventada) en los modelos de lenguaje de IA (como ChatGPT, Claude, etc.). Los puntos de discusión incluyen las raíces técnicas de las alucinaciones (como defectos en el mecanismo de atención, ruido en los datos de entrenamiento, falta de anclaje del modelo en el mundo real, etc.), si RAG o el fine-tuning pueden erradicarlas, cómo los usuarios deben tratar con cautela las salidas de los LLM, y cómo los desarrolladores pueden lograr un equilibrio entre la creatividad y la precisión fáctica. Algunos opinan que todas las salidas de los LLM deben considerarse alucinaciones potenciales y requieren verificación por parte del usuario. (Fuente: Reddit r/ArtificialInteligence)

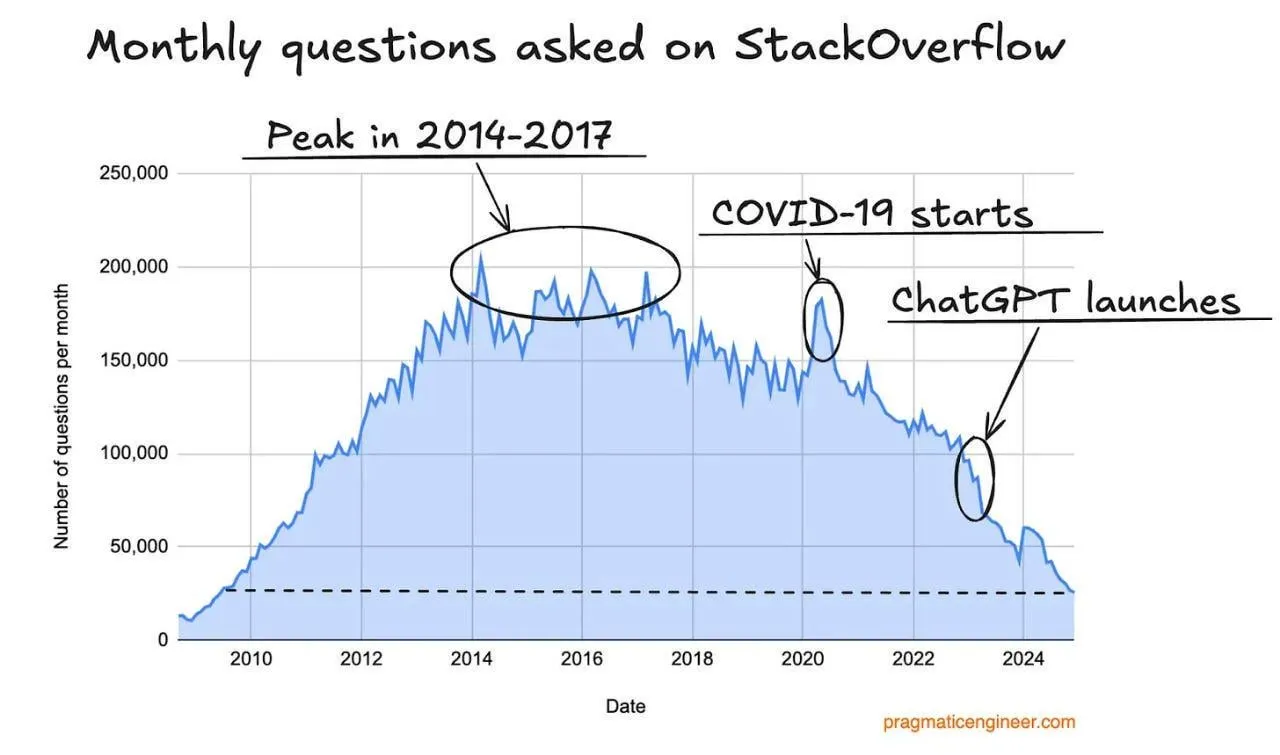

Caída del tráfico de Stack Overflow, posiblemente afectada por los asistentes de programación con IA: Un usuario observó una tendencia a la baja en el tráfico del sitio web Stack Overflow y especuló que esto podría estar relacionado con el auge de asistentes de programación con IA como ChatGPT. Los desarrolladores recurren cada vez más directamente a la IA para obtener fragmentos de código y soluciones, lo que reduce la dependencia de las comunidades tradicionales de preguntas y respuestas. En los comentarios, los usuarios generalmente consideran que los asistentes de IA tienen ventajas en cuanto a la franqueza de las respuestas y evitan la negatividad de la comunidad, pero también temen que la dependencia excesiva de la IA de los datos existentes pueda llevar al agotamiento de los datos de entrenamiento en el futuro. (Fuente: Reddit r/ArtificialInteligence)

Tutor del curso de Ingeniería de LLM comparte experiencias de aprendizaje y recursos: Ed Donner, tutor del curso de Ingeniería de LLM, compartió la filosofía de enseñanza y los recursos de su curso, enfatizando la importancia de aprender mediante la práctica (HACIENDO). Anima a los estudiantes a trabajar activamente con el código y proporciona guías de configuración para PC, Mac y Linux, así como enlaces a Notebooks de Google Colab, para facilitar el aprendizaje y la experimentación de los estudiantes en diferentes entornos. El contenido del curso cubre Ollama, HuggingFace, uso de API, etc., y ofrece soluciones para usar modelos locales como alternativa a las API de pago. (Fuente: ed-donner)

Experiencia de usuario: Uso de Claude para mejorar las habilidades de pensamiento y comunicación: Un usuario de Claude Pro compartió cómo la interacción con la IA le ayudó a mejorar su forma de pensar y sus habilidades de comunicación. A través de la interacción con Claude, el usuario aprendió a “guiarse” mejor a sí mismo al resolver problemas, identificar los problemas centrales y, al comunicarse con colegas, prestar más atención a la expresión clara y la empatía, reconociendo así el papel positivo de las herramientas de asistencia de IA en la mejora de las capacidades cognitivas y expresivas personales. (Fuente: Reddit r/ClaudeAI)

La “brecha discriminador-generador” podría ser el concepto central de la innovación científica con IA: Jason Wei propone que la “brecha discriminador-generador” (Discriminator-generator gap) podría ser la idea más importante en la innovación científica impulsada por IA. Cuando se dispone de suficiente capacidad computacional, estrategias de búsqueda ingeniosas y métricas claras, cualquier cosa medible puede ser optimizada por la IA. Este concepto enfatiza el proceso iterativo de un generador que propone soluciones y un discriminador que evalúa su calidad para impulsar la innovación, especialmente aplicable a entornos donde la validación es rápida, hay recompensas continuas y es escalable. (Fuente: _jasonwei, dotey)

Transformación y desafíos del Product Manager en la era de la IA: En las redes sociales se discute el impacto de la IA en el puesto de Product Manager. Se opina que en los próximos 18 meses la industria de la gestión de productos enfrentará una transformación, y los PM que no comprendan las necesidades del usuario podrían ser eliminados. Las herramientas de IA (como los AI Agents) pueden convertir ideas en productos en poco tiempo, pero la verdadera dificultad radica en encontrar los puntos débiles centrales del usuario y ofrecer soluciones precisas. Este puesto finalmente se basa en la capacidad de emparejar y comprender los problemas del usuario y sus soluciones, en lugar de simplemente crear documentos y prototipos. (Fuente: dotey)

Paradoja de la seguridad de la IA: La superinteligencia podría favorecer más a la defensa: Richard Socher plantea la “paradoja de la seguridad de la IA”: bajo supuestos razonables, la aparición de la superinteligencia podría en realidad favorecer más a la parte defensora en una guerra biológica o cibernética. A medida que disminuye el costo marginal de la inteligencia, se pueden descubrir más vectores de ataque mediante ejercicios de equipo rojo (red teaming) y fortalecer o inmunizar los sistemas hasta cubrir todas las rutas de ataque relevantes. Teóricamente, cuando el costo de la defensa tiende a cero, el sistema puede ser completamente inmunizado. Este punto de vista desafía la creencia tradicional de que el desarrollo de la IA exacerbará la asimetría entre ataque y defensa. (Fuente: RichardSocher)

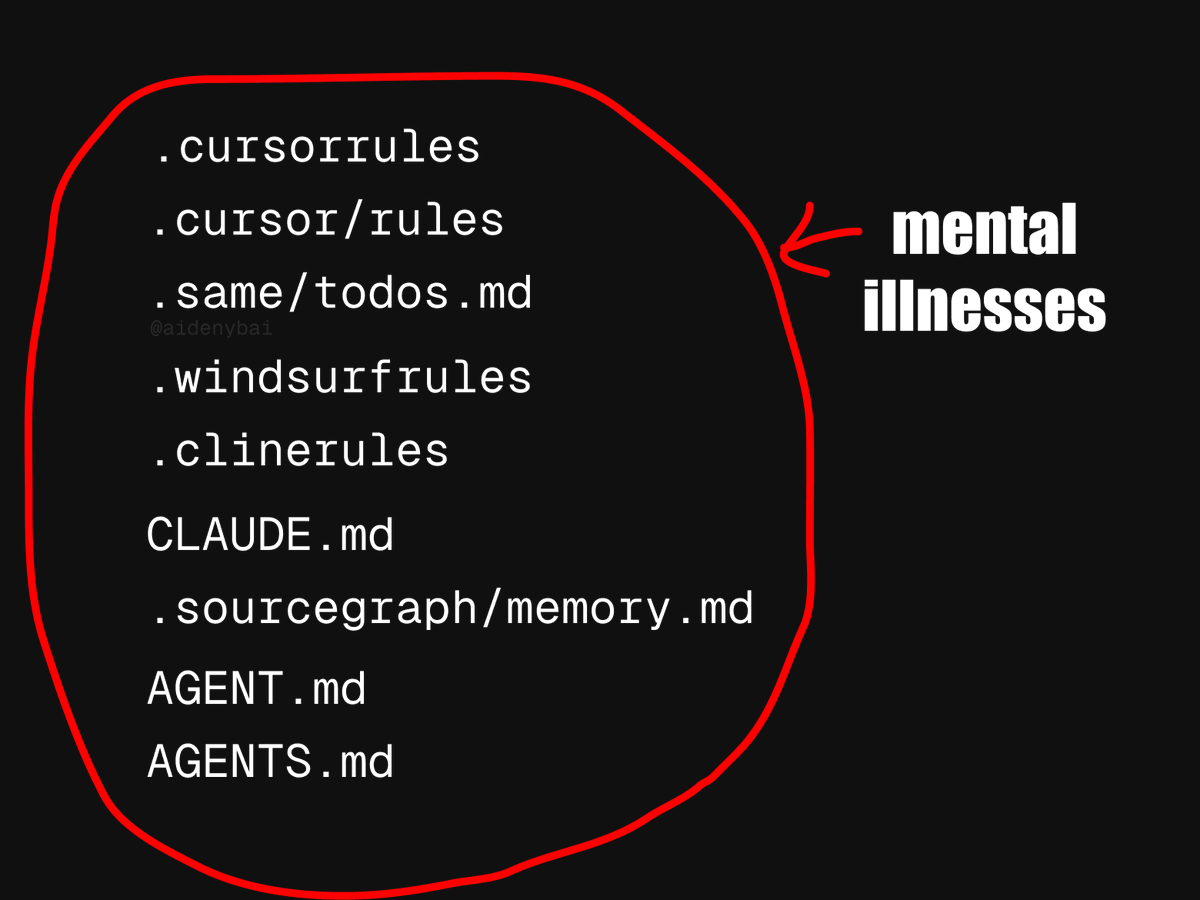

Disputa por el estándar de aplicación de AI Agent: CONTRIBUTING.md podría ser una mejor práctica: Ante la aparición de 9 estándares competitivos para las reglas de los AI Agents, algunos desarrolladores proponen utilizar directamente el archivo CONTRIBUTING.md del proyecto para regular el comportamiento de los AI Agents. Dicho archivo generalmente ya contiene guías de estilo de código, referencias relevantes y fragmentos de compilación, pudiendo servir como un portador natural de las reglas para los AI Agents y evitando así reinventar la rueda. (Fuente: JayAlammar)

💡 Otros

Fallece Peter Lax, autor del clásico libro de texto «Análisis Funcional», a los 99 años: El gigante de las matemáticas Peter Lax, primer matemático aplicado en recibir el Premio Abel, ha fallecido a la edad de 99 años. El profesor Lax era conocido por su clásico libro de texto «Análisis Funcional» y realizó contribuciones fundamentales en áreas como ecuaciones diferenciales parciales, dinámica de fluidos y cálculo numérico, como el teorema de equivalencia de Lax y los métodos de Lax-Friedrichs/Lax-Wendroff. También fue uno de los pioneros en aplicar la tecnología informática al análisis matemático, y su trabajo influyó profundamente en la investigación científica y la práctica de la ingeniería. (Fuente: WeChat)

Búsqueda de empleo con IA: Agente de IA utiliza OpenAI Operator para solicitar mil empleos con un clic, generando debate: Un video muestra cómo un agente de IA utiliza la herramienta Operator de OpenAI para enviar solicitudes a 1000 puestos de trabajo con un solo clic. Este fenómeno ha generado un debate sobre la aplicación de la IA en el ámbito de la búsqueda de empleo y la contratación, incluyendo la posibilidad de que la IA filtre currículums, programe entrevistas e incluso realice entrevistas preliminares, así como el impacto de esta automatización tanto para los solicitantes de empleo como para los reclutadores. (Fuente: Reddit r/ChatGPT)

El MIT retira un artículo de economía relacionado con la IA, se sospecha que fue escrito por IA y con datos dudosos: El Departamento de Economía del MIT ha retirado un artículo escrito por un estudiante de doctorado titulado «Inteligencia Artificial, Descubrimiento Científico e Innovación de Productos», debido a que la universidad carecía de confianza en la fiabilidad de los datos del artículo. La comunidad especula que el artículo podría haber sido escrito en gran parte por IA, lo que ha generado un debate sobre la ética y el control de calidad de la aplicación de la IA en la investigación académica. (Fuente: Reddit r/ArtificialInteligence)