Palabras clave:AlphaEvolve, Diseño de algoritmos de IA, IA multimodal, Herramientas de programación de IA, Algoritmos de evolución autónoma, Modelos de lenguaje grandes, Agentes inteligentes de IA, Implementación de código abierto de AlphaEvolve, Diseño autónomo de algoritmos de multiplicación de matrices por IA, Interfaz unificada para IA multimodal, Impacto de las herramientas de programación de IA en los desarrolladores, Rendimiento del modelo local Qwen 3

🔥 Destacado

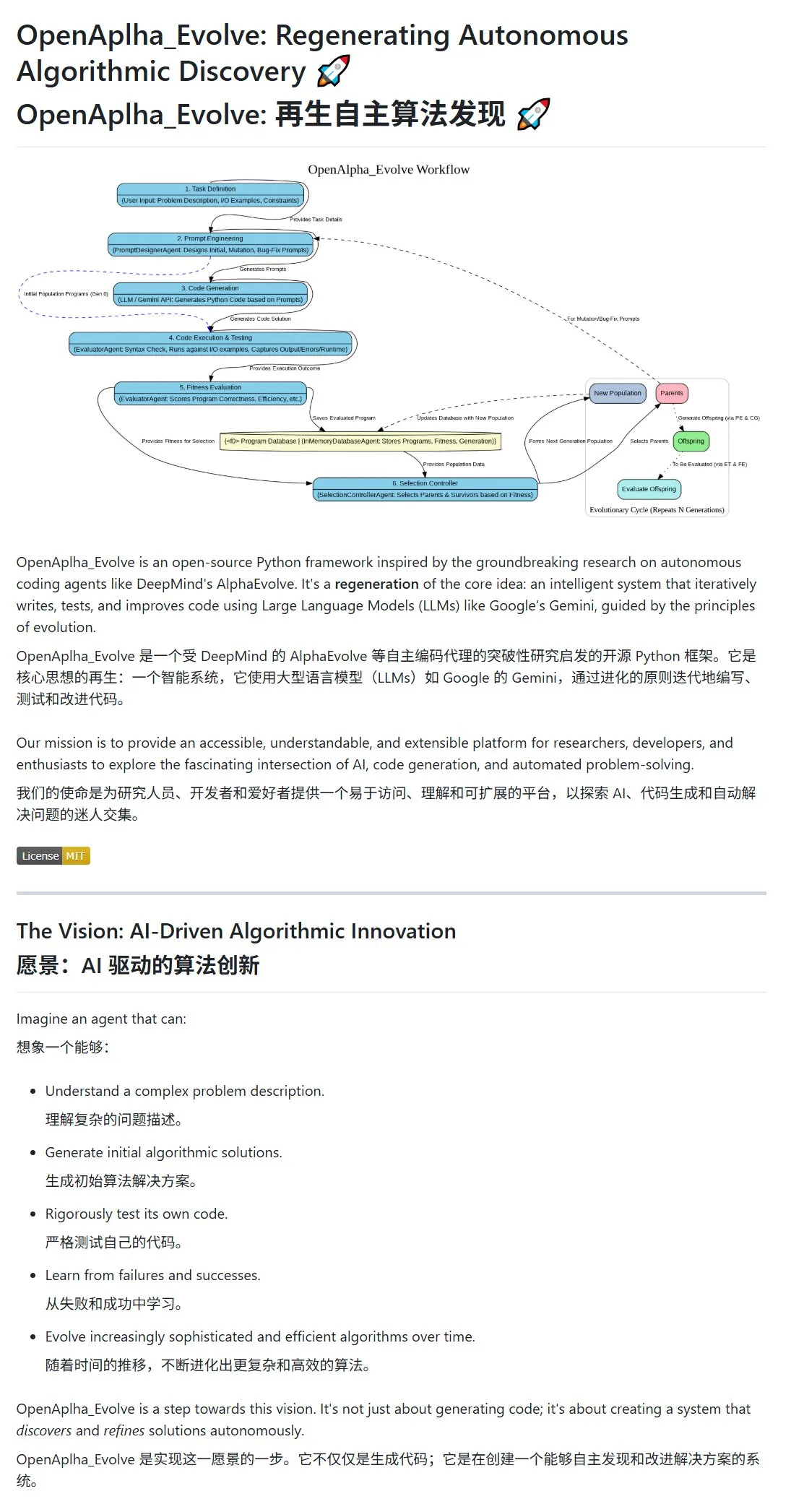

Google DeepMind publica AlphaEvolve, IA que diseña y evoluciona algoritmos de forma autónoma: Google DeepMind ha presentado públicamente el proyecto AlphaEvolve y su paper, mostrando un agente de IA capaz de diseñar, probar, aprender y evolucionar algoritmos más eficientes de forma autónoma. El sistema utiliza prompt engineering para impulsar modelos de lenguaje grandes (LLM, como Gemini) para generar propuestas iniciales de algoritmos, y optimiza los algoritmos en un ciclo evolutivo mediante la evaluación de la aptitud (fitness) y la selección de supervivientes. La comunidad ha respondido rápidamente, con la aparición de la implementación de código abierto OpenAlpha_Evolve, y algunos investigadores han utilizado herramientas como Claude para verificar los avances de AlphaEvolve en áreas como la multiplicación de matrices, lo que demuestra el enorme potencial de la IA en la innovación algorítmica. (Fuente: karminski3, karminski3, Reddit r/ClaudeAI, Reddit r/artificial)

La estrategia multimodal de OpenAI se hace evidente: la integración de interfaces y la centralización de infraestructuras generan atención: OpenAI, con sus recientes lanzamientos de productos como GPT-4o, Sora y Whisper, no solo ha demostrado sus avances en capacidades multimodales de texto, imagen, audio y vídeo, sino que también ha revelado su intención estratégica de integrar múltiples modalidades en interfaces y API unificadas. Aunque esta estrategia ofrece comodidad a los usuarios, también ha suscitado debates sobre cómo la centralización de la infraestructura podría limitar el espacio de innovación para desarrolladores e investigadores externos. En particular, modelos de generación de vídeo como Sora, debido a su alta demanda de recursos computacionales, incorporan aún más aplicaciones de alto coste al ecosistema de OpenAI, lo que podría exacerbar la “gravedad computacional” de las plataformas líderes e impactar la apertura y el desarrollo modular en el campo de la IA. (Fuente: Reddit r/deeplearning)

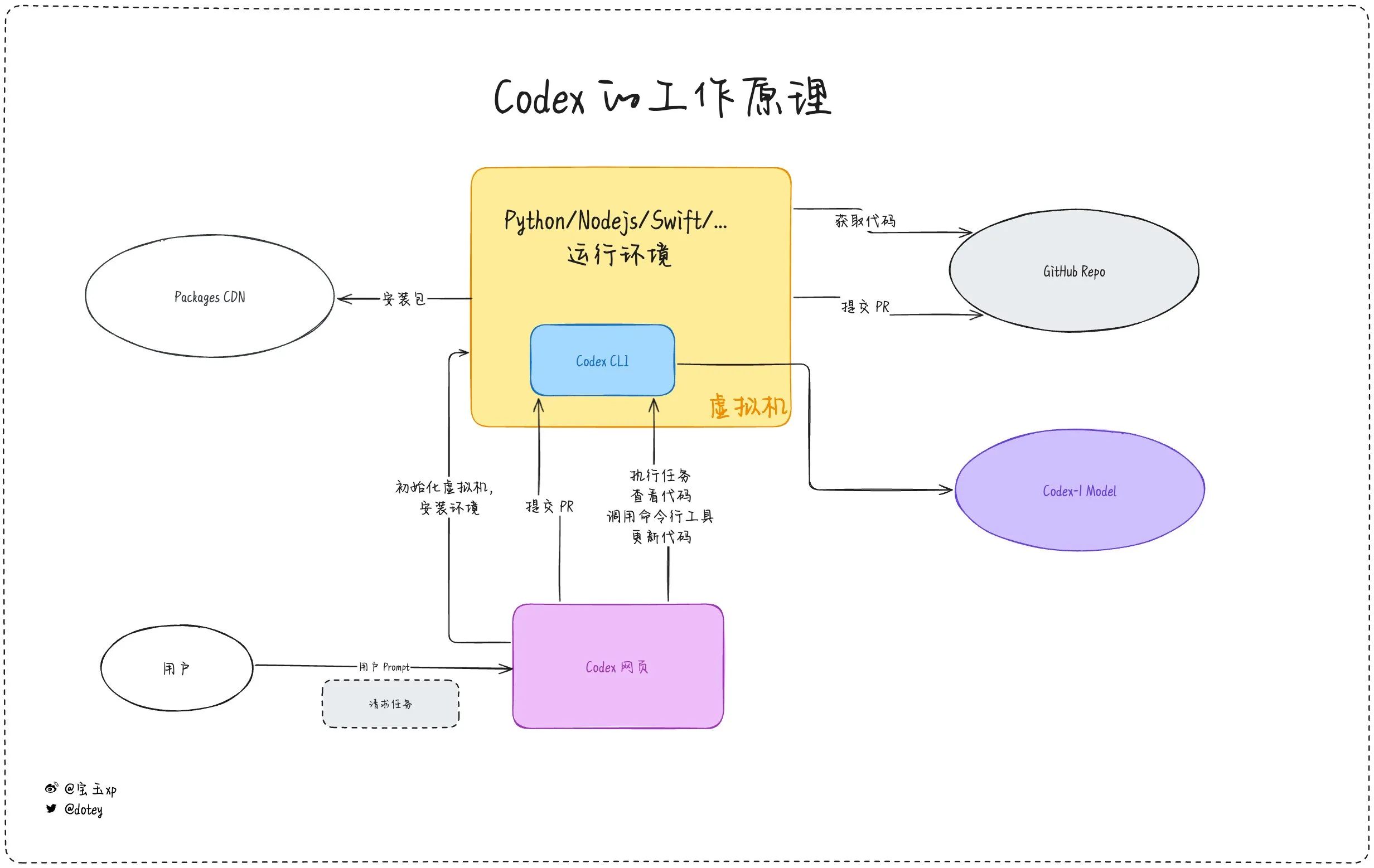

La penetración de herramientas de programación con IA se intensifica, coexistiendo la experiencia del desarrollador y la reflexión: Herramientas de programación con IA como Codex, Devin y diversos AI Agents están acelerando su integración en los flujos de trabajo de desarrollo de software. Los comentarios de los desarrolladores indican que Codex demuestra una alta eficiencia en la internacionalización de código, actualizaciones de proyectos, etc., pudiendo acortar significativamente los ciclos de desarrollo. Sin embargo, como señala la evaluación de Codex por dotey, las herramientas de IA actuales se asemejan más a “empleados subcontratados”; aunque pueden completar tareas, todavía tienen limitaciones en cuanto a conexión a internet, persistencia de tareas y acumulación de experiencia. Las discusiones en la comunidad también mencionan que algunos desarrolladores, tras un uso prolongado de la programación asistida por IA, comienzan a reflexionar sobre su impacto en su propio pensamiento y creatividad, e incluso optan por volver a un modelo de desarrollo que depende más del “cerebro humano”, lo que demuestra que el equilibrio entre mejorar la eficiencia con herramientas de IA y mantener las capacidades centrales del desarrollador sigue siendo un tema importante. (Fuente: dotey, giffmana, cto_junior, Reddit r/artificial)

🎯 Tendencias

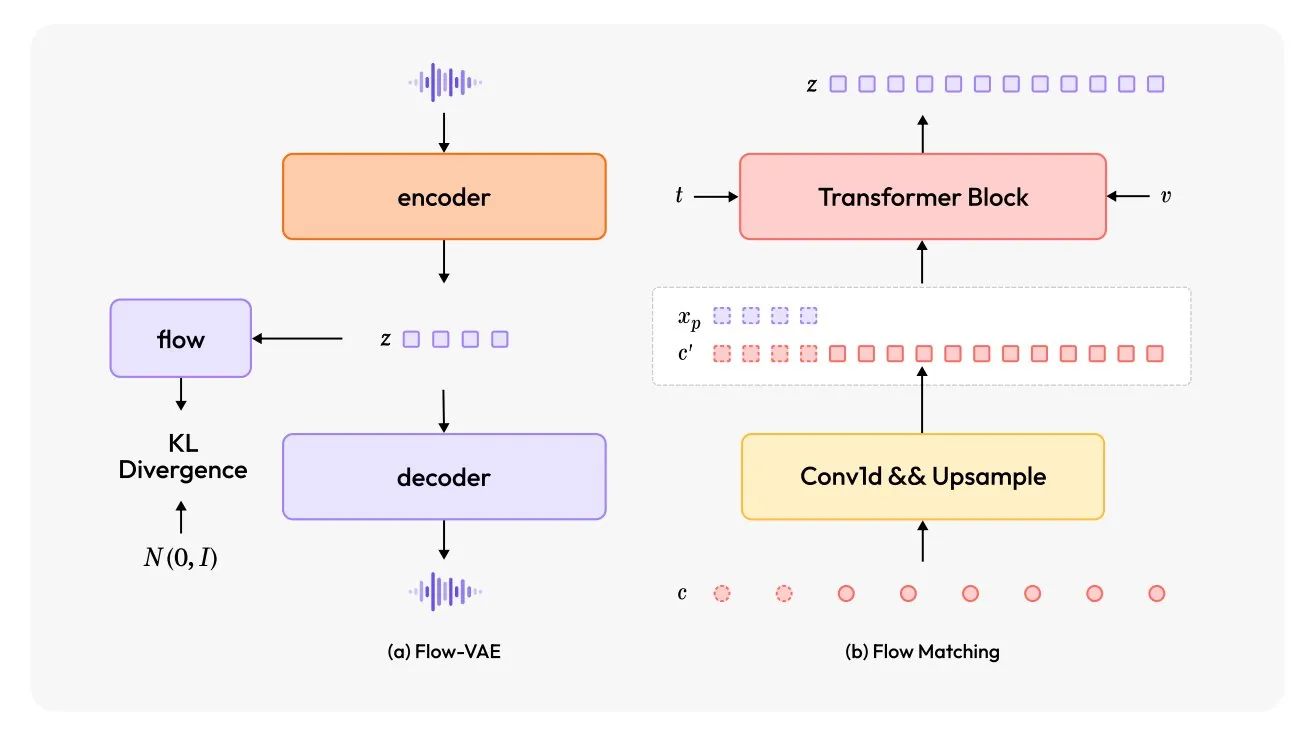

MiniMax-Speech: Lanzamiento de un nuevo modelo TTS multilingüe: TheTuringPost presentó MiniMax-Speech, un nuevo modelo de texto a voz (TTS). Este modelo adopta dos innovaciones principales: un codificador de hablante aprendible, capaz de capturar el timbre de voz a partir de audios cortos; y un módulo Flow-VAE para mejorar la calidad del audio. MiniMax-Speech admite 32 idiomas y puede utilizarse para añadir emoción a la voz, generar voz a partir de descripciones textuales o realizar clonación de voz zero-shot, demostrando su potencial en la síntesis de voz personalizada y de alta calidad. (Fuente: TheTuringPost, TheTuringPost)

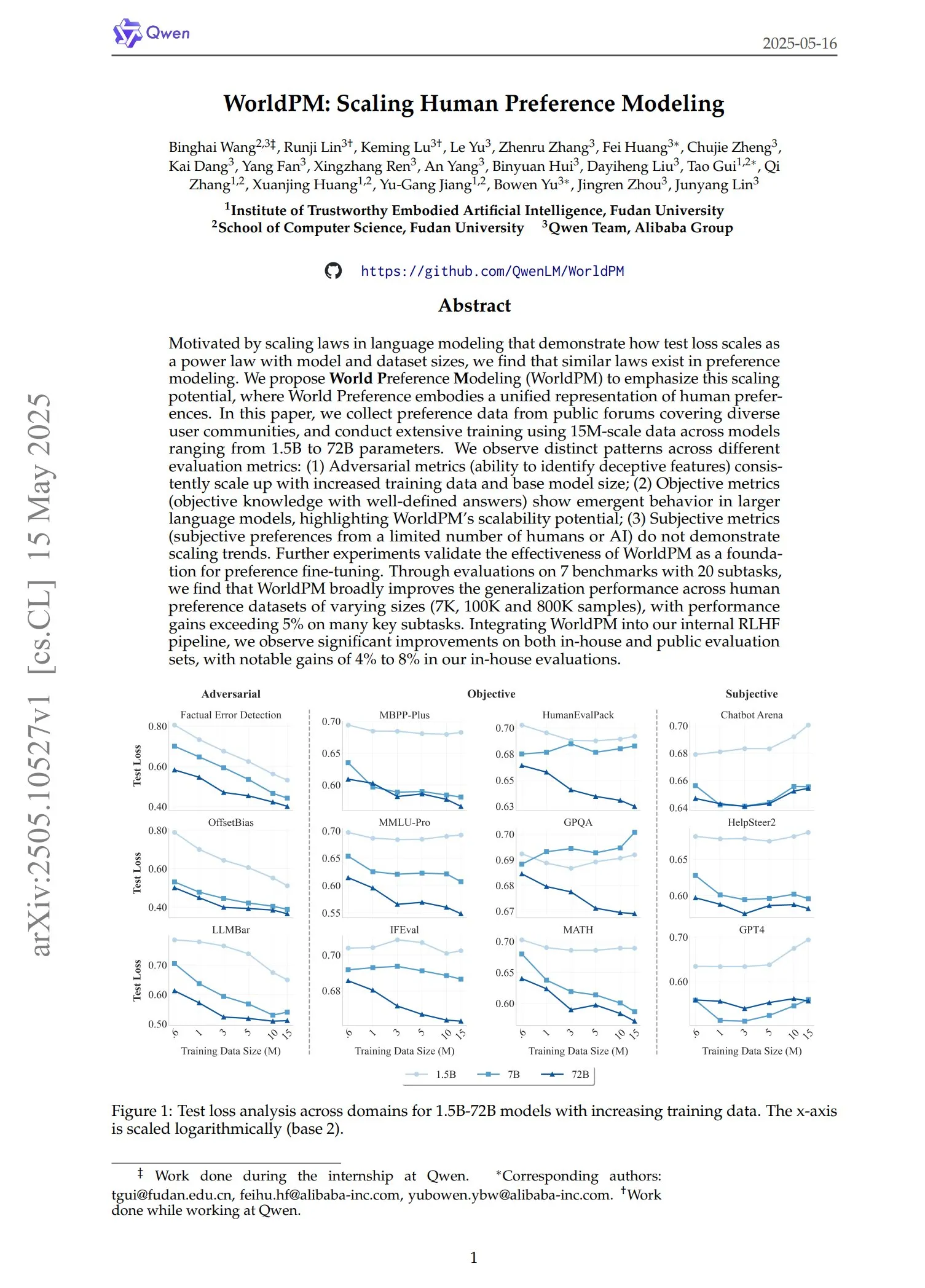

Qwen lanza la serie de modelos de preferencia WorldPM: El equipo de Qwen ha lanzado cuatro nuevos modelos de modelado de preferencias: WorldPM-72B, WorldPM-72B-HelpSteer2, WorldPM-72B-RLHFLow y WorldPM-72B-UltraFeedback. Estos modelos se utilizan principalmente para evaluar la calidad de las respuestas de otros modelos, ayudando en el proceso de aprendizaje supervisado. Según fuentes oficiales, el uso de estos modelos de preferencia para el entrenamiento permite obtener mejores resultados que entrenar desde cero, y también se ha publicado el paper correspondiente. (Fuente: karminski3)

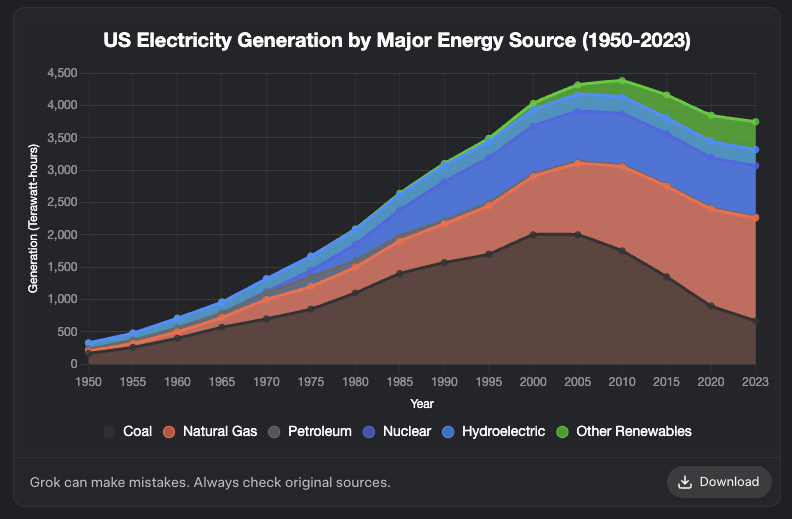

Grok añade función de generación de gráficos: El modelo Grok de XAI ahora admite la generación de gráficos. Los usuarios pueden crear gráficos a través de Grok en el navegador, y se espera que esta función se extienda a más plataformas en los próximos días. Esta actualización mejora las capacidades de Grok en visualización de datos y presentación de información. (Fuente: grok, Yuhu_ai_, TheGregYang)

DeepRobotics lanza el robot cuadrúpedo de tamaño mediano Lynx: La empresa DEEP Robotics ha presentado su nuevo robot cuadrúpedo de tamaño mediano, Lynx. Este robot demuestra la capacidad de moverse de manera estable en terrenos complejos, lo que refleja los avances de la compañía en control de movimiento robótico y tecnología de percepción, y puede aplicarse en diversos escenarios como inspección y logística. (Fuente: Ronald_vanLoon)

Sanctuary AI integra nuevos sensores táctiles en robots de propósito general: Sanctuary AI anunció que sus robots de propósito general han integrado una nueva tecnología de sensores táctiles. Esta mejora tiene como objetivo potenciar las capacidades de percepción y manipulación de objetos de los robots, permitiéndoles interactuar con el entorno de manera más fina, lo que representa un paso importante hacia robots con inteligencia artificial general más robusta. (Fuente: Ronald_vanLoon)

Robot de Unitree demuestra capacidades avanzadas de locomoción: El robot Go2 de Unitree Robotics ha demostrado varias formas de locomoción avanzadas, incluyendo caminar invertido, volteretas adaptativas y superar obstáculos. La implementación de estas capacidades marca una mejora significativa en sus algoritmos de control de movimiento y adaptabilidad al entorno para sus perros robot. (Fuente: Ronald_vanLoon)

Equipo de investigación chino desarrolla un robot impulsado por células cerebrales humanas cultivadas: Según InterestingSTEM, un equipo de investigación en China está desarrollando un robot impulsado por células cerebrales humanas cultivadas en laboratorio. Esta investigación explora la fusión de la computación biológica y la tecnología robótica, con el objetivo de utilizar las capacidades de aprendizaje y adaptación de las neuronas biológicas para proporcionar nuevas ideas para el control de robots. Aunque todavía se encuentra en una fase exploratoria temprana, ha generado una amplia discusión sobre las futuras formas de inteligencia robótica. (Fuente: Ronald_vanLoon)

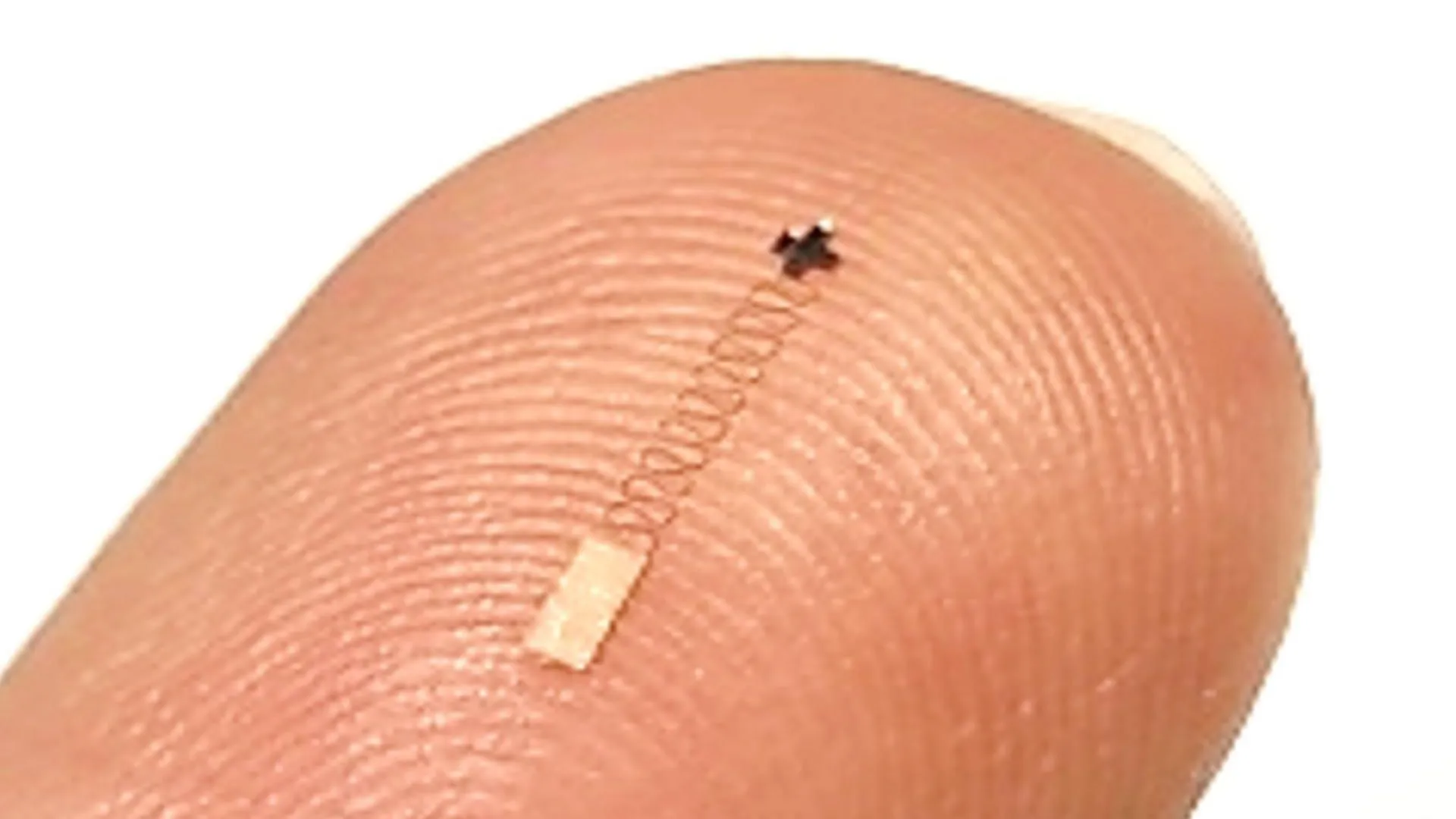

Nuevo sensor cerebral a nanoescala logra una precisión del 96.4% en el reconocimiento de señales neuronales: Un nuevo tipo de sensor cerebral a nanoescala ha demostrado una precisión de hasta el 96.4% en el reconocimiento de señales neuronales. Se espera que esta tecnología se aplique en interfaces cerebro-computadora, investigación en neurociencia y diagnóstico médico, proporcionando nuevas herramientas para una interpretación más precisa de la actividad cerebral. (Fuente: Ronald_vanLoon)

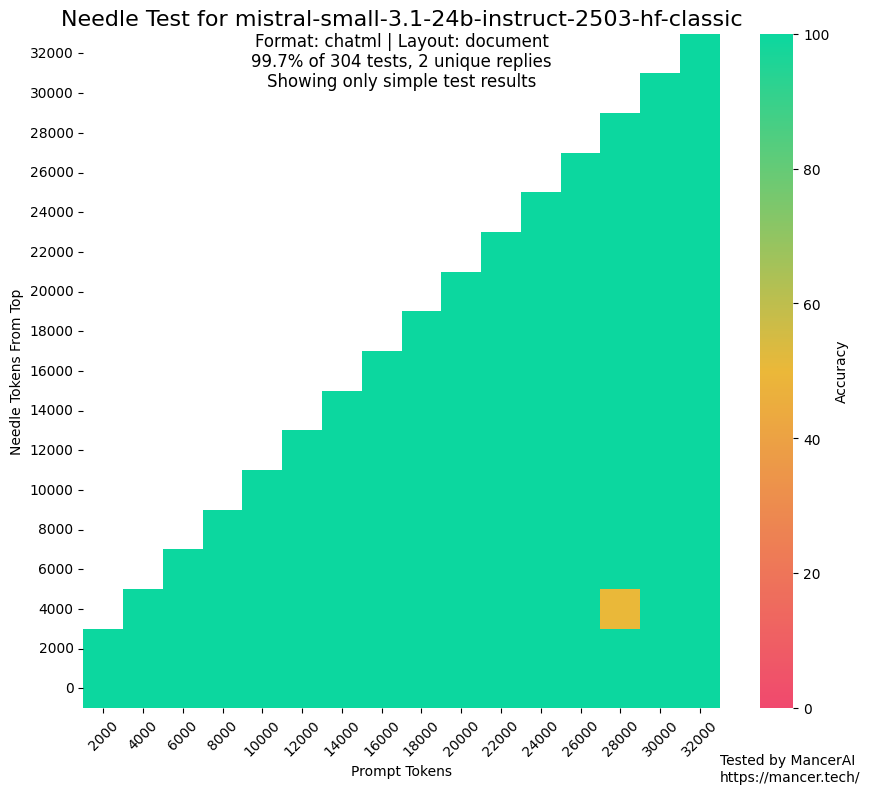

Rumores sobre el uso de conjuntos de prueba por MistralAI para entrenamiento generan preocupación: Han surgido discusiones en la comunidad que cuestionan si MistralAI podría haber utilizado datos del conjunto de prueba en benchmarks como NIAH para su entrenamiento. Kalomaze, al comparar el rendimiento en la prueba NIAH de GitHub con una NIAH personalizada (hechos y preguntas generados programáticamente), señaló que MistralAI rinde mucho mejor en la primera que en la segunda, lo que sugiere una posible contaminación de datos. Dorialexander especula que podría haberse utilizado una “aproximación sintética” del conjunto de evaluación para diseñar la mezcla de datos, lo que genera preocupaciones sobre la imparcialidad y transparencia de la evaluación de modelos. (Fuente: Dorialexander)

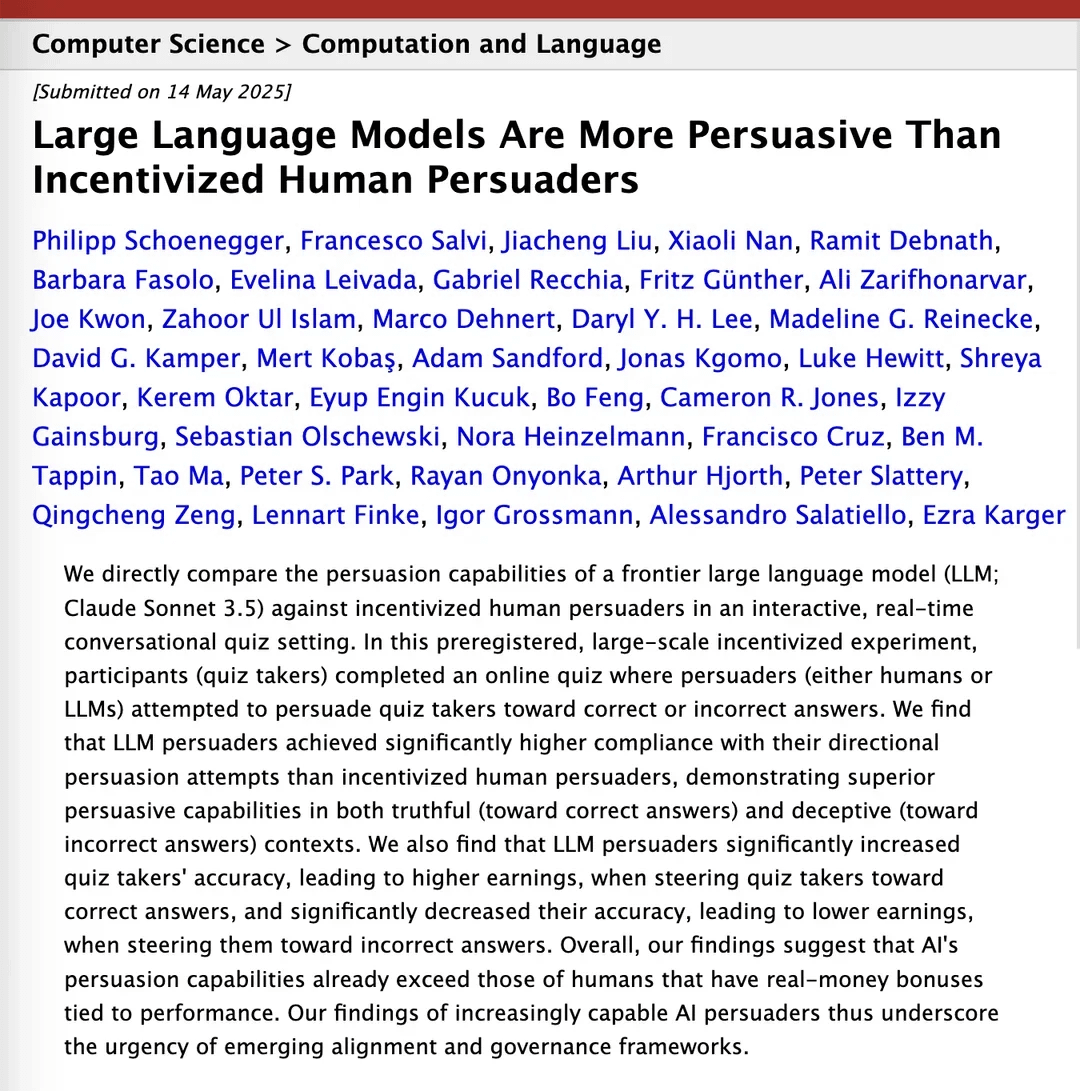

Estudio afirma que Claude 3.5 supera a los humanos en persuasión: Un paper de investigación en arXiv señala que el modelo Claude 3.5 de Anthropic supera a los humanos en capacidad de persuasión. Este estudio comparó experimentalmente el rendimiento del modelo con el de los humanos en tareas específicas de persuasión, y los resultados muestran que la IA podría tener una ventaja significativa en la construcción de argumentos convincentes y en la comunicación, lo que tiene implicaciones potenciales para campos como el marketing, las relaciones públicas y la interacción humano-computadora. (Fuente: Reddit r/ClaudeAI)

Los modelos grandes locales muestran una mejora significativa en su capacidad en hardware de consumo: Un usuario de Reddit informa que el modelo de 14B parámetros de Qwen 3 (con parche yarn para soportar contexto de 128k), en un PC de consumo con solo 10GB de VRAM y 24GB de RAM, mediante cuantización IQ4_NL y configuración de contexto de 80k, ya puede ejecutar razonablemente bien asistentes de programación de IA como Roo Code y Aider. Aunque es lento al procesar contextos largos (como 20k+, alrededor de 2 t/s), la calidad de edición de código y la capacidad de reconocimiento del repositorio de código son buenas. Esta es la primera vez que un modelo local puede manejar de manera estable tareas de codificación complejas en conversaciones largas y generar diferencias de código significativas. Este avance se debe a las mejoras en el propio modelo, la optimización de frameworks de inferencia como llama.cpp y la adaptación de herramientas frontend como Roo. (Fuente: Reddit r/LocalLLaMA)

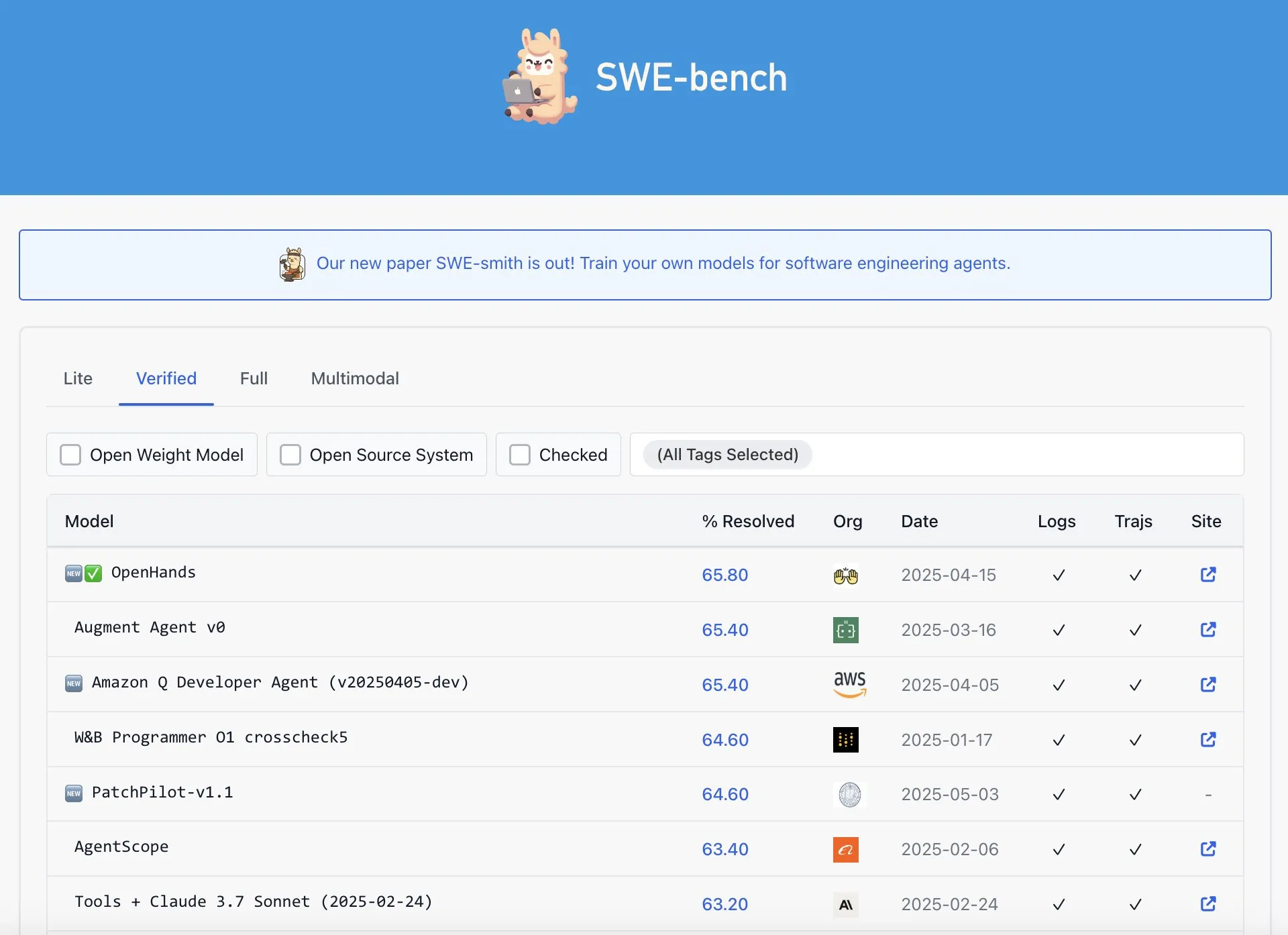

Señalan que OpenAI Codex no tiene el mejor rendimiento en el ranking SWE-Bench Verified: Graham Neubig señala que la afirmación de que el modelo Codex de OpenAI ha logrado resultados SOTA (estado del arte) en el ranking SWE-Bench Verified no es del todo precisa. Analizando los datos y diferentes métricas de evaluación, considera que, desde cualquier perspectiva, el rendimiento de Codex en este benchmark específico es discutible y no es indiscutiblemente el mejor. (Fuente: JayAlammar)

🧰 Herramientas

OpenAlpha_Evolve de código abierto: replicando el agente inteligente de diseño de algoritmos de IA de Google: Tras la publicación del paper AlphaEvolve por Google DeepMind, el desarrollador shyamsaktawat lanzó rápidamente la implementación de código abierto OpenAlpha_Evolve. Este framework de Python permite a los usuarios experimentar con los conceptos de diseño de algoritmos impulsados por IA, incluyendo la definición de tareas, prompt engineering, generación de código (con la ayuda de LLMs como Gemini), ejecución de pruebas, evaluación de aptitud (fitness) y selección evolutiva, con el objetivo de que una comunidad más amplia participe en la exploración de la vanguardia del diseño de nuevos algoritmos por IA. (Fuente: karminski3, Reddit r/artificial, Reddit r/LocalLLaMA)

El editor Cursor añade nueva función de edición rápida de archivos completos: Cursor, el editor de código enfocado en IA, anunció que los usuarios ahora pueden editar rápidamente archivos completos. Esta nueva función tiene como objetivo mejorar la eficiencia del trabajo de los desarrolladores, facilitando modificaciones y refactorizaciones de código a gran escala en Cursor. (Fuente: cursor_ai)

Codex completa eficientemente tareas de internacionalización y localización de aplicaciones: El desarrollador Katsuya compartió su experiencia utilizando OpenAI Codex para la internacionalización de aplicaciones. Hizo que Codex localizara la aplicación al japonés, completando en una noche una tarea que normalmente llevaría varios días, demostrando plenamente la potente capacidad de Codex en la generación automatizada de código y el manejo de tareas lingüísticas complejas. (Fuente: gdb, ShunyuYao12)

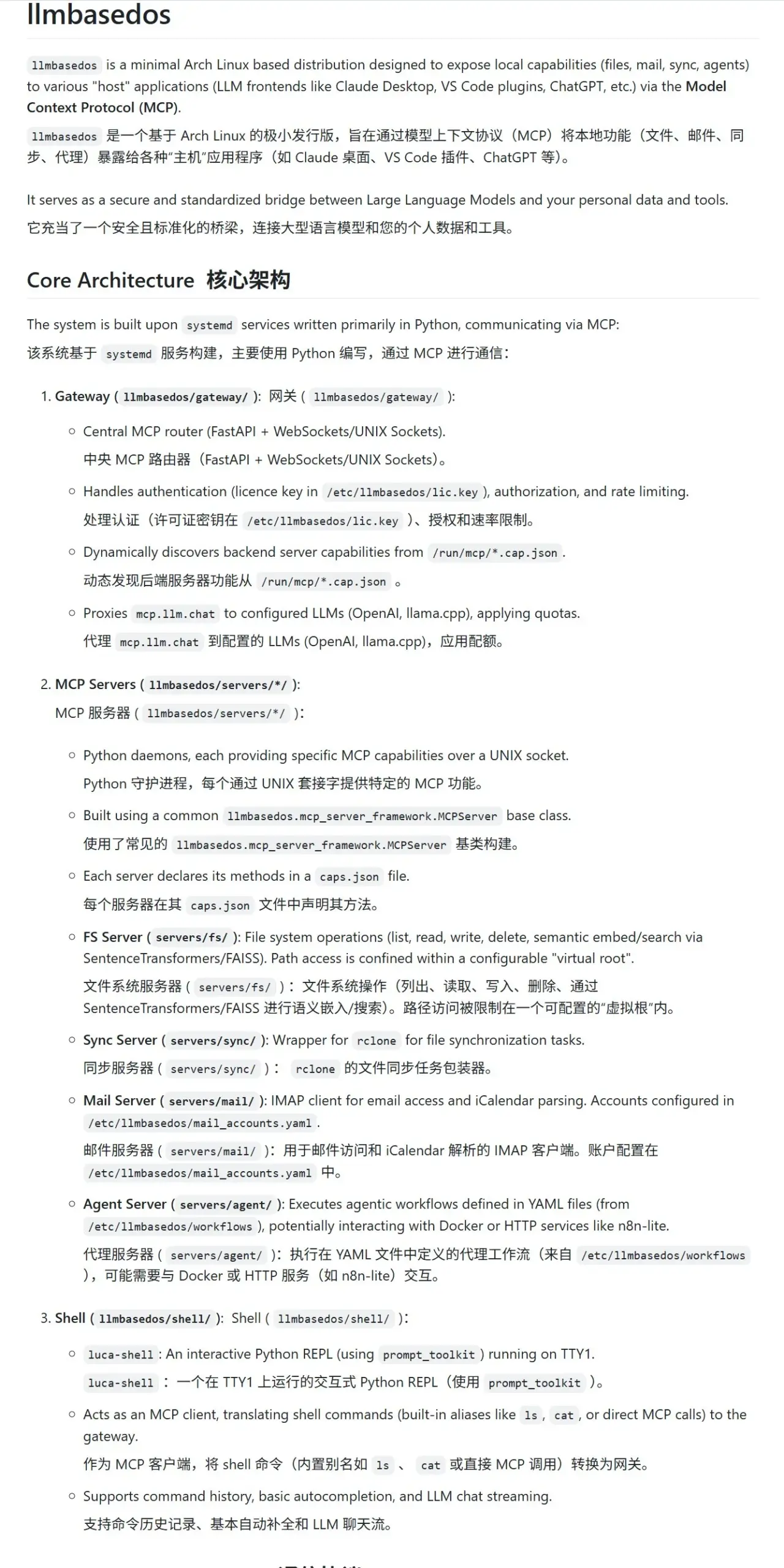

llmbasedos: un entorno sandbox MCP seguro diseñado para LLM: El proyecto llmbasedos ofrece un entorno de sistema operativo basado en una versión reducida de Arch Linux, diseñado para proporcionar un sandbox seguro de Protocolo de Computación Modular (MCP) para modelos de lenguaje grandes (LLM). Encapsula funciones como sistema de archivos, correo, sincronización y proxy como servicios MCP, a los que los usuarios pueden llamar después de arrancar desde ISO en una máquina virtual o física, facilitando la interacción y el desarrollo seguros con LLM. (Fuente: karminski3)

cachelm: herramienta de caché semántica LLM de código abierto que mejora la eficiencia y reduce costes: El desarrollador devanmolsharma ha lanzado la herramienta de código abierto cachelm, una capa de caché semántica diseñada para aplicaciones LLM. Implementa el almacenamiento en caché basado en la similitud semántica mediante búsqueda vectorial, lo que puede reducir eficazmente las llamadas repetidas a la API de LLM (incluso si el usuario formula la pregunta de manera diferente), disminuyendo así el consumo de tokens y acelerando las respuestas. La herramienta es compatible con OpenAI, ChromaDB, Redis, ClickHouse, etc., y permite a los usuarios personalizar vectorizadores, bases de datos o LLM. (Fuente: Reddit r/MachineLearning)

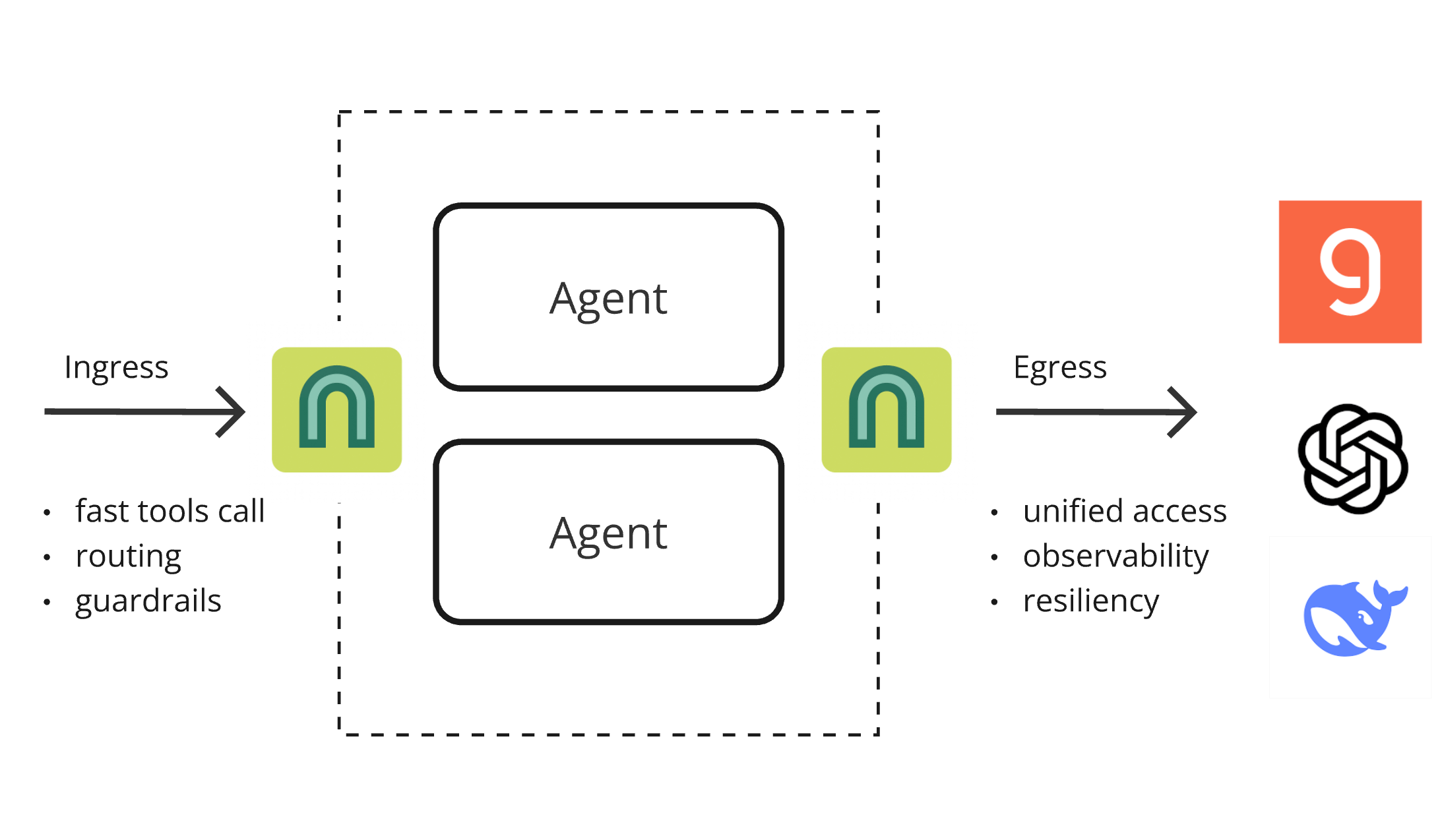

Lanzamiento de ArchGW 0.2.8, proxy nativo de IA que unifica funciones subyacentes: Se ha lanzado la versión 0.2.8 de ArchGW, un proxy nativo de IA basado en Envoy, diseñado para unificar funciones repetitivas de “bajo nivel” en las aplicaciones. La nueva versión añade soporte para tráfico bidireccional (en preparación para Google A2A), mejora el modelo Arch-Function-Chat 3B para enrutamiento rápido y llamadas a herramientas, y admite LLMs alojados en Groq. ArchGW, a través de un proxy local, simplifica el desarrollo de aplicaciones de IA, mejorando la seguridad, la consistencia y la observabilidad. (Fuente: Reddit r/artificial)

SparseDepthTransformer: Estudiante de secundaria desarrolla una solución para mejorar la eficiencia de Transformer mediante el salto dinámico de capas: Un estudiante de secundaria ha desarrollado un proyecto llamado SparseDepthTransformer, que utiliza un mecanismo de puntuación ligero para evaluar la importancia semántica de cada token y permite que los tokens no importantes omitan las capas profundas de cálculo del Transformer. Los experimentos demuestran que este método, manteniendo la calidad de la salida, reduce el uso de memoria en aproximadamente un 15% y disminuye el número promedio de capas de procesamiento por token en aproximadamente un 40%, ofreciendo una nueva perspectiva para mejorar la eficiencia de los Transformer. (Fuente: Reddit r/MachineLearning)

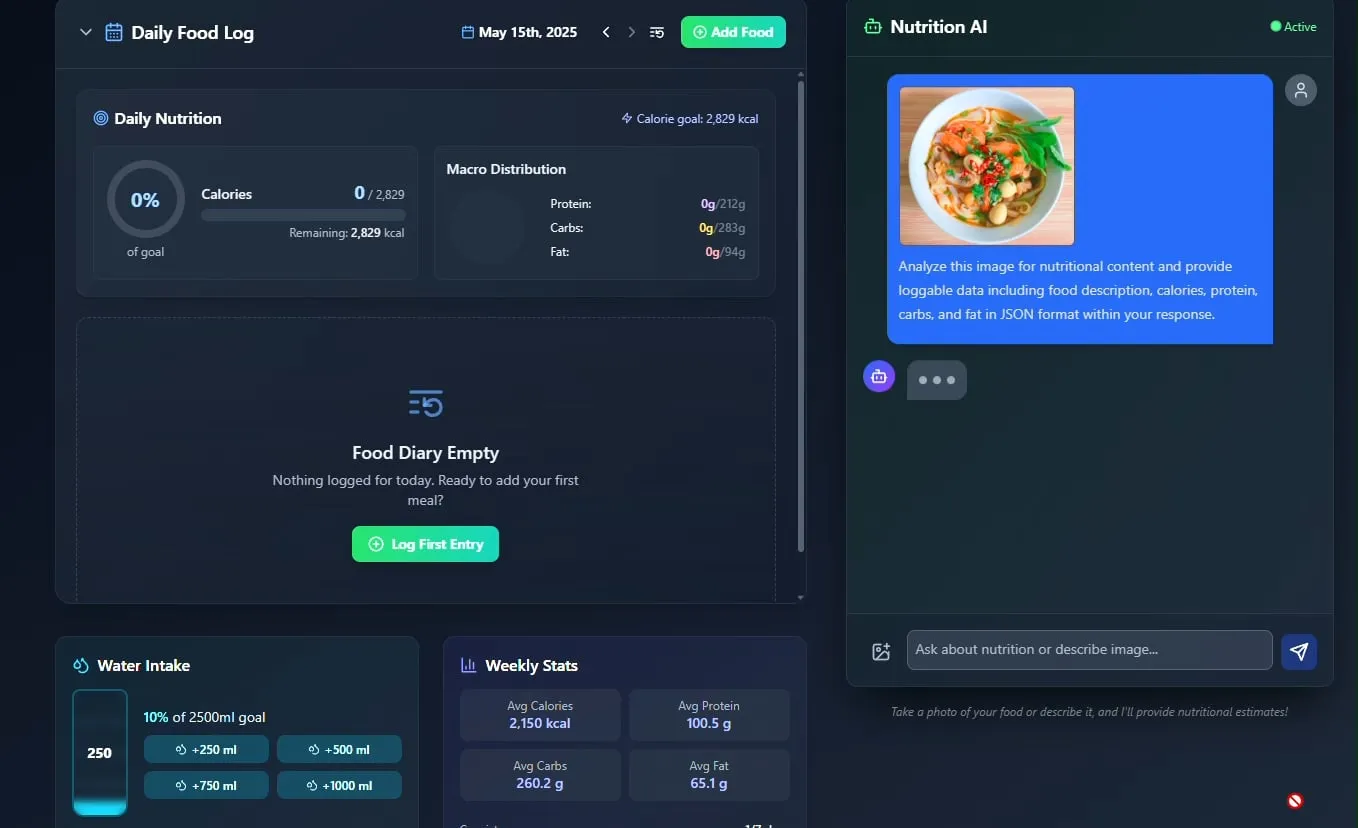

Presentan un rastreador de alimentos y nutrición con IA, con planes de hacerlo de código abierto: El desarrollador Pavankunchala ha mostrado una aplicación de seguimiento de dieta y nutrición impulsada por IA. La función principal de la aplicación es identificar alimentos y estimar la información nutricional (calorías, proteínas, etc.) analizando las fotos de alimentos subidas por el usuario. También admite el registro manual, resúmenes nutricionales diarios y seguimiento de la ingesta de agua. El desarrollador planea hacer que el código del proyecto sea de código abierto en el futuro. (Fuente: Reddit r/LocalLLaMA)

Agente de IA italiano automatiza la búsqueda de empleo, solicitando mil trabajos en un minuto, generando debate: Un AI Agent, supuestamente de Italia, ha demostrado su potente capacidad para automatizar la búsqueda de empleo, pudiendo completar 1000 solicitudes de trabajo en 1 minuto. Esta demostración ha provocado una amplia discusión en la comunidad sobre la aplicación de la IA en el sector de la contratación, por un lado, asombrados por su eficiencia, y por otro, expresando preocupación por su efectividad, el impacto en el mercado laboral y cómo hacer frente a problemas como la “detección de robots”. (Fuente: Reddit r/ChatGPT)

📚 Aprendizaje

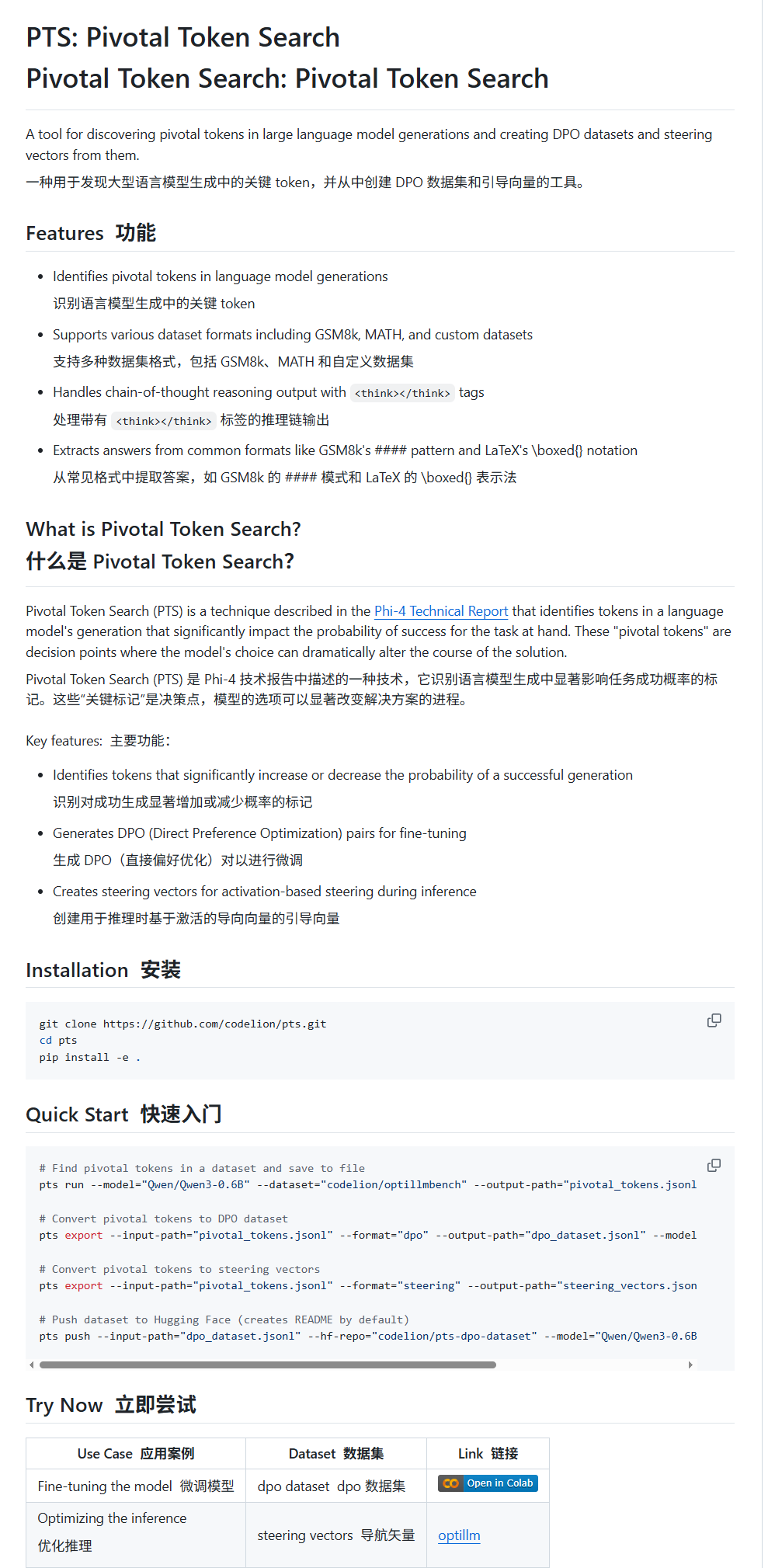

Pivotal Token Search (PTS): una nueva técnica de ajuste fino y guiado de LLM: karminski3 presenta una nueva técnica llamada PTS (Pivotal Token Search). Esta técnica se basa en la idea de que “los puntos de decisión clave en la salida de los modelos grandes residen en unos pocos tokens cruciales”. Extrayendo estos tokens que influyen significativamente en la corrección de la salida (divididos en “tokens seleccionados” y “tokens rechazados”), se construye un conjunto de datos DPO para el ajuste fino. Además, PTS también puede extraer los patrones de activación de los tokens clave para generar vectores de dirección (steering vectors), que guían el comportamiento del modelo durante la inferencia sin necesidad de ajuste fino. Se dice que este método está inspirado en Phi4, y su efectividad ha generado debate en la comunidad. (Fuente: karminski3)

OpenAI Codex CLI ofrece créditos de API gratuitos, fomentando el intercambio de datos: La cuenta de desarrolladores de OpenAI anunció que los usuarios Plus o Pro pueden canjear créditos de API gratuitos ejecutando npm i -g @openai/codex@latest y codex --free. Además, los usuarios también pueden obtener tokens diarios gratuitos seleccionando compartir datos en la configuración de la plataforma para mejorar y entrenar los modelos de OpenAI. Esta medida tiene como objetivo alentar a los desarrolladores a utilizar las herramientas de Codex y participar en la mejora del modelo. (Fuente: OpenAIDevs, fouad)

Recopilación de recursos gratuitos para aprender sobre Sistemas Multiagente (MAS): TheTuringPost ha recopilado y compartido 7 recursos gratuitos para aprender sobre Sistemas Multiagente (MAS). Entre ellos se encuentran CrewAI, el framework multiagente CAMEL y tutoriales de LangChain sobre multiagentes; un libro titulado “Multiagent Systems: Algorithmic, Game-Theoretic, and Logical Foundations”; y tres cursos en línea que cubren desde prompts hasta sistemas multiagente, el dominio del desarrollo multiagente con AutoGen, y casos de uso prácticos y avanzados de multi-IA con crewAI. (Fuente: TheTuringPost)

Tutorial para clasificación rápida de imágenes con MobileNetV2: El usuario de Reddit Eran Feit compartió un tutorial de Python para la clasificación de imágenes usando MobileNetV2. El tutorial guía paso a paso a los usuarios para cargar un modelo MobileNetV2 preentrenado, preprocesar imágenes con OpenCV (convertir BGR a RGB, escalar a 224×224, procesamiento por lotes), realizar inferencia y decodificar los resultados de la predicción para obtener etiquetas y probabilidades legibles por humanos. Este tutorial es adecuado para principiantes que deseen iniciarse rápidamente en tareas de clasificación de imágenes ligeras. (Fuente: Reddit r/deeplearning)

Publicada guía para la implementación de RAG multifuente y búsqueda híbrida en OpenWebUI: El sitio web productiv-ai.guide ha publicado una guía detallada paso a paso para implementar la Generación Aumentada por Recuperación (RAG) multifuente con Búsqueda Híbrida (Hybrid Search) y Reclasificación (Re-ranking) en OpenWebUI. La guía tiene como objetivo ayudar a los usuarios a configurar y utilizar las funciones RAG de OpenWebUI, incluida la característica recientemente añadida de reclasificación externa, para mejorar la precisión y relevancia de la recuperación de información. (Fuente: Reddit r/OpenWebUI)

💼 Negocios

Intensa competencia en el sector de AI Agents: Comparativa profunda entre Manus y Lovart: El AI Agent “Lovart”, especializado en el sector del diseño vertical, ha llamado la atención por su singular flujo de trabajo “tipo toma de pedidos”, que intenta simular un proceso de diseño completo, desde la comunicación de requisitos hasta la entrega de materiales por capas, contrastando con la lógica “tipo despacho” del agente de propósito general “Manus”. Aunque Lovart muestra un buen rendimiento en la comprensión de la estética del diseño, la expresión conceptual y la organización de la información, y es más rápido que Manus, ambos enfrentan problemas de estabilidad, procesamiento del idioma chino y vinculación de modificaciones. La aparición de Lovart se considera la dirección correcta para que los agentes verticales profundicen en escenarios específicos e internalicen la experiencia de la industria, lo que augura que los AI Agents podrían implementarse verdaderamente en la industria de contenidos. (Fuente: 36氪)

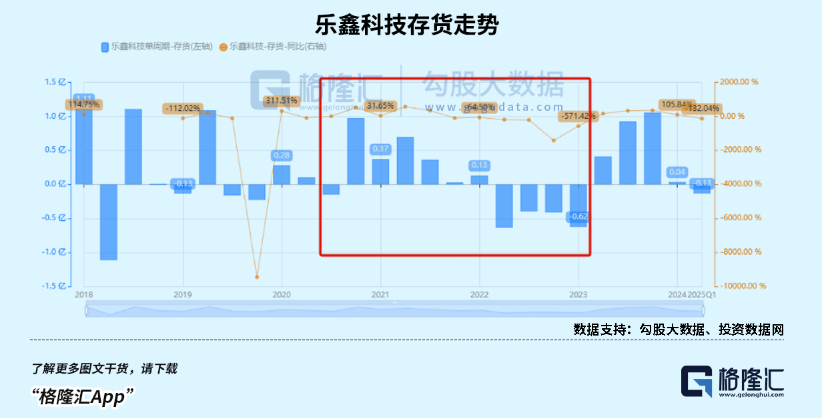

El mercado de relojes inteligentes para niños está en auge, la tendencia AIoT impulsa el crecimiento de los fabricantes de chips SoC nacionales: Beneficiándose del impulso de las políticas de consumo y la tendencia de desarrollo de AIoT, las ventas de dispositivos portátiles inteligentes en China (especialmente relojes inteligentes para niños) han aumentado drásticamente. La aparición de modelos grandes de código abierto como DeepSeek ha reducido el umbral para la implementación de IA en el dispositivo, acelerando la penetración de la IA en electrodomésticos inteligentes, auriculares con IA y otros terminales. Fabricantes nacionales de chips SoC como Rockchip (瑞芯微) y Bestechnic (恒玄科技), gracias a su posicionamiento en bajo consumo y capacidad de cómputo para IA, así como chips insignia como el RK3588 de Rockchip que cubren múltiples escenarios como PC, hardware inteligente y automoción, han experimentado un crecimiento significativo en sus resultados y, en consecuencia, un aumento en su valoración. (Fuente: 36氪)

Se informa que OpenAI ajusta su plan de reestructuración corporativa y refuta las dudas sobre su naturaleza sin fines de lucro: Según Garrison Lovely, se ha revelado una carta de OpenAI al Fiscal General de California que no había sido reportada anteriormente. El contenido de la carta no solo involucra detalles inesperados del plan de reestructuración corporativa de OpenAI, sino que también muestra que OpenAI está tomando medidas activas para refutar las críticas y dudas sobre sus intentos de debilitar la estructura de gobernanza sin fines de lucro de la compañía. (Fuente: NeelNanda5)

🌟 Comunidad

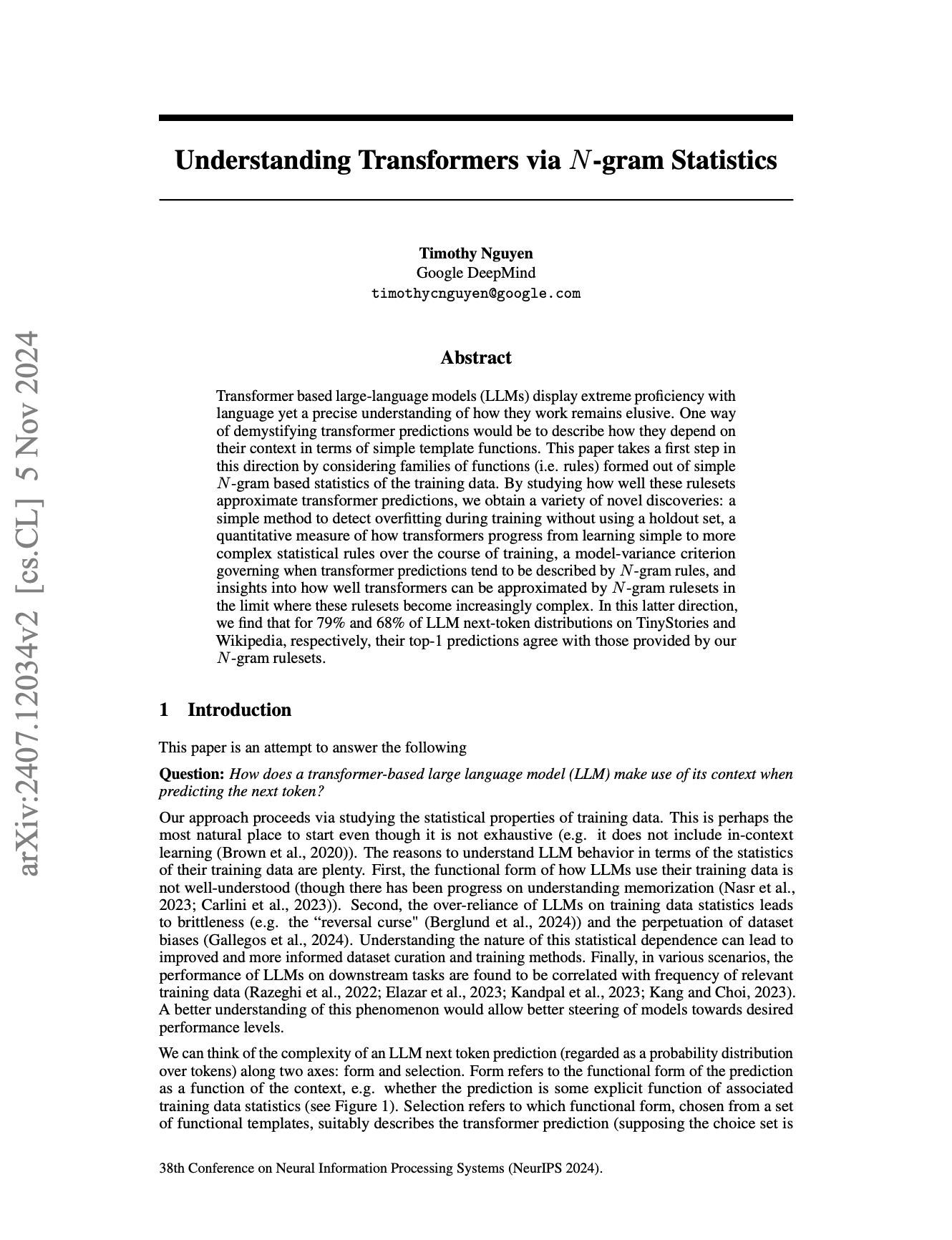

La naturaleza N-Gram de los LLM y los límites de la “inteligencia” generan un acalorado debate: La comunidad continúa debatiendo hasta qué punto los modelos de lenguaje grandes (LLM) todavía dependen de las propiedades estadísticas N-Gram, y si los LLM actuales constituyen una “verdadera IA”. Algunas opiniones (como el comentario de pmddomingos sobre el paper de NeurIPS de jxmnop) sostienen que los LLM se comportan como modelos N-Gram en más de 2/3 de los casos. Un científico de datos en Reddit publicó que los LLM actuales carecen de verdadera comprensión, razonamiento y sentido común, están lejos de la AGI (Inteligencia Artificial General) y son esencialmente “sistemas complejos de predicción de la siguiente palabra”, en lugar de agentes inteligentes con autoconciencia y adaptabilidad. (Fuente: jxmnop, pmddomingos, Reddit r/ArtificialInteligence)

El estilo de “película transparente” en imágenes generadas por IA y las imágenes “Doubao” que rozan los límites llaman la atención: Recientemente, han surgido en las redes sociales una gran cantidad de imágenes de un estilo particular generadas por herramientas de dibujo con IA como Doubao, especialmente imágenes que presentan un efecto de envoltura de “película transparente”. Estas imágenes, debido a su novedoso efecto visual y al posible contenido “que roza los límites”, han provocado una amplia discusión, imitación y creación secundaria por parte de los usuarios, convirtiéndose en una tendencia popular en el campo del contenido generado por IA. (Fuente: op7418, dotey)

Ética de la IA y futuro: ¿Construir a “Dios” o autodestruirnos?: La comunidad debate intensamente sobre el objetivo final del desarrollo de la IA y sus riesgos potenciales. Emad Mostaque afirma sin rodeos que hay gente intentando construir una AGI similar a “Dios”, lo que podría traer una utopía o la destrucción. El CEO de NVIDIA, Jensen Huang, por su parte, visualiza un futuro en el que ingenieros humanos colaboren con 1000 IAs para diseñar chips. Al mismo tiempo, una discusión provocada por un cómic de SMBC desvía la cuestión de la conciencia de la IA hacia un nivel más práctico de tratamiento ético: ¿podemos tratar a estas “cosas” con la conciencia tranquila? Estas perspectivas conforman conjuntamente una compleja visión del futuro de la IA. (Fuente: Reddit r/artificial, Reddit r/artificial, Reddit r/artificial)

¿Revolucionará la IA el modelo de negocio SaaS? Debate en la comunidad de desarrolladores: Con la popularización de potentes herramientas de programación con IA como Claude Code, la comunidad de desarrolladores ha comenzado a discutir su potencial impacto en el modelo de negocio SaaS (Software como Servicio). Se argumenta que la barrera para que los desarrolladores individuales repliquen las funciones principales de los productos SaaS existentes utilizando IA está disminuyendo. Esto podría llevar a que empresas y usuarios individuales reduzcan su dependencia de los servicios SaaS tradicionales, buscando en su lugar soluciones autoconstruidas o asistidas por IA más rentables. El desarrollo de software futuro podría depender más de la microgestión de la IA. (Fuente: Reddit r/ClaudeAI)

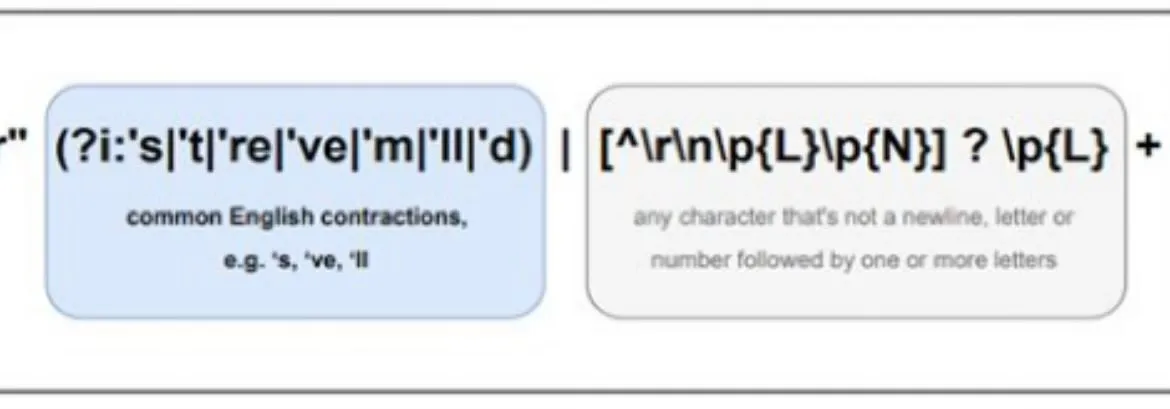

Las diferencias en el procesamiento multilingüe de la IA llaman la atención, el pretokenizador de Llama podría ser una de las causas: Discusiones en la comunidad señalan que el rendimiento de los modelos de lenguaje grandes (LLM) suele ser mejor en inglés que en otros idiomas. Una posible razón se atribuye a la forma en que los pretokenizadores de modelos como Llama procesan textos no ingleses (especialmente con caracteres no latinos). Por ejemplo, el pretokenizador podría dividir excesivamente los caracteres chinos en unidades más pequeñas, afectando la comprensión de la estructura y semántica del lenguaje por parte del modelo, lo que a su vez conduciría a un menor rendimiento en esos idiomas. (Fuente: giffmana)

💡 Otros

El framework DSPy enfatiza la importancia de las primitivas subyacentes para el desarrollo de agentes de IA: Desde que el framework de IA DSPy hizo de código abierto sus abstracciones centrales en enero de 2023, apenas ha sufrido cambios, salvo algunas simplificaciones, manteniéndose estable a través de múltiples iteraciones de API de LLM. Discusiones en la comunidad señalan que esto se debe a que DSPy se enfoca en construir las primitivas subyacentes correctas, en lugar de simplemente perseguir la experiencia superficial del desarrollador o la conveniencia de construir “agentes” rápidamente. Se argumenta que muchos frameworks actuales de desarrollo de agentes se centran demasiado en la facilidad de uso, descuidando la solidez de los bloques de construcción fundamentales, mientras que la filosofía de DSPy es que primero se necesita una base sólida de “reacción” para poder construir comportamientos complejos de “agente”. (Fuente: lateinteraction, lateinteraction)

La fatiga estética por el contenido generado por IA impulsa la demanda de modelos personalizados: Discusiones en la comunidad sostienen que muchos modelos de generación de imágenes optimizados mediante aprendizaje por refuerzo (RL) tienden a producir resultados “mediocres” o “kitsch” que, aunque técnicamente parezcan buenos, carecen de creatividad y personalidad estimulantes. Esto refleja que los objetivos de optimización del modelo pueden tender hacia las preferencias estéticas promedio del público, en lugar de búsquedas artísticas únicas. Por lo tanto, los modelos personalizados y los métodos capaces de muestrear según objetivos estéticos individuales se consideran clave para superar este problema y crear contenido de IA más atractivo en el futuro. (Fuente: torchcompiled)

Ollama lanza motor multimodal, usuarios de OpenWebUI atentos a la compatibilidad: Ollama anunció el lanzamiento oficial de su motor multimodal, una noticia que ha captado la atención de los usuarios de la comunidad OpenWebUI. Los usuarios están generalmente interesados en saber si OpenWebUI podrá soportar el nuevo motor multimodal de Ollama “listo para usar” (out-of-the-box), es decir, sin necesidad de realizar cambios complejos de configuración para aprovechar su capacidad de procesar múltiples tipos de datos como imágenes y texto. (Fuente: Reddit r/OpenWebUI)