Palabras clave:Agente de programación de IA, Codex, Modelo de voz de gran escala, Agente de IA, OpenAI, MiniMax, Alibaba, Qwen, Versión preliminar de Codex, Modelo de voz Speech-02, Estudio WorldPM, Modelo de lenguaje visual FastVLM, Modelo multimodal FG-CLIP

🔥 Destacado

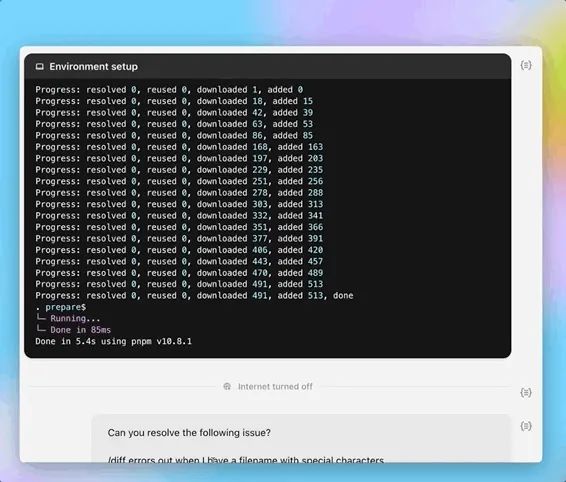

OpenAI lanza la versión preliminar del agente de programación de IA Codex: OpenAI presentó la noche del 16 de mayo una versión preliminar de Codex, un agente de ingeniería de software basado en la nube. Codex está impulsado por el modelo codex-1, una variante de o3 optimizada para ingeniería de software, y puede gestionar en paralelo tareas como programación, consultas a repositorios de código, corrección de errores y envío de pull requests. Se ejecuta en un entorno sandbox en la nube, precargando los repositorios de código del usuario, y completa las tareas en un tiempo de 1 a 30 minutos. Actualmente está disponible para usuarios de ChatGPT Pro, Team y Enterprise, y próximamente lo estará para usuarios de Plus y Edu. Simultáneamente, se lanzó un modelo ligero, codex-mini (basado en o4-mini), para Codex CLI, con precios de API de 1,5 dólares por millón de tokens de entrada y 6 dólares por millón de tokens de salida. (Fuente: 36氪, 机器之心, op7418)

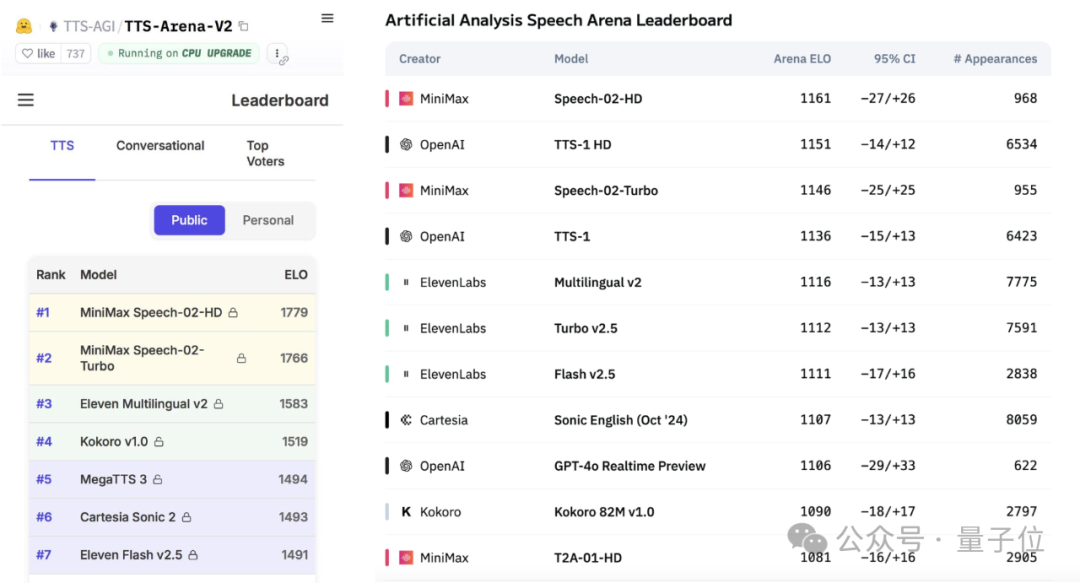

MiniMax lanza el gran modelo de voz Speech-02, encabezando las listas de evaluación comparativa global: El gran modelo de texto a voz (TTS) Speech-02-HD, lanzado recientemente por la empresa china de IA MiniMax, ha obtenido el primer puesto en dos importantes pruebas comparativas globales de voz, Artificial Analysis Speech Arena y Hugging Face TTS Arena V2, superando a OpenAI y ElevenLabs. Este modelo se caracteriza por ser ultrarrealista, personalizado y diverso, admite 32 idiomas y puede replicar un timbre de voz realista con tan solo 10 segundos de audio de referencia. La popular aplicación para aprender inglés “AI Wu Yanzu” utiliza tecnología de MiniMax. Las innovaciones clave de Speech-02 incluyen un codificador de hablante aprendible y un modelo de coincidencia de flujo Flow-VAE, que mejoran la calidad del sonido y la similitud. (Fuente: 36氪, karminski3)

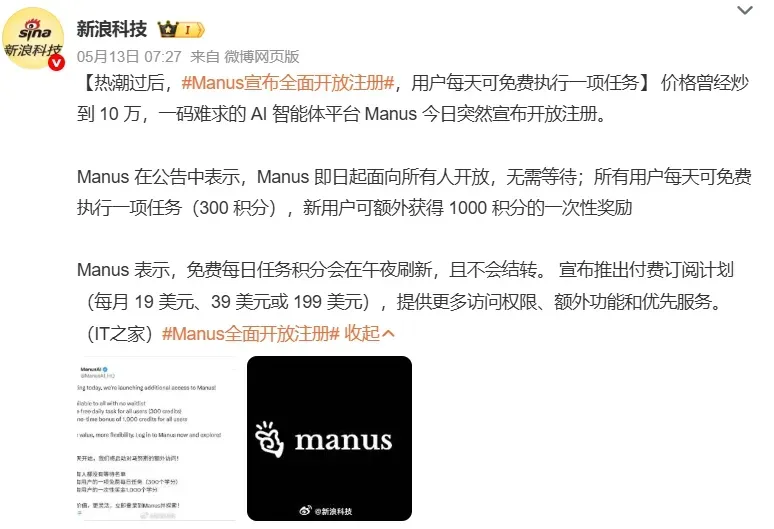

Los AI Agents captan la atención del mercado, las grandes tecnológicas aceleran su posicionamiento: Los agentes de IA (AI Agents) se están convirtiendo en el nuevo foco de atención en el campo de la IA. Plataformas de Agents de propósito general como Manus han abierto sus registros, generando un gran interés; se informa que su empresa matriz, Monica, ha completado una nueva ronda de financiación de 75 millones de dólares, con una valoración cercana a los 500 millones de dólares. Grandes empresas como Baidu (Xīnxiǎng), ByteDance (Kòuzi Kōngjiān) y Alibaba (Xīnliú) han lanzado sus propios productos o plataformas de Agents, compitiendo por ser la puerta de entrada a la era de la IA. Los Agents pueden ejecutar tareas más complejas, como la creación de materiales, diseño web, planificación de viajes, etc. Actualmente, los Agents de propósito general todavía tienen deficiencias en la operación entre aplicaciones y tareas profundas, siendo los principales desafíos un ecosistema incompleto y los silos de datos. El protocolo MCP se considera clave para resolver la interconexión, pero aún hay pocos adherentes. Se cree que los Agents verticales del sector B2B son más fáciles de comercializar primero debido a su enfoque en escenarios específicos y su facilidad de personalización. (Fuente: 36氪, 36氪)

Alibaba publica la investigación WorldPM, explorando las leyes de escalabilidad del modelado de preferencias humanas: El equipo Qwen de Alibaba publicó el artículo “Modeling World Preference”, que revela que el modelado de preferencias humanas sigue leyes de escalabilidad (Scaling Laws), lo que indica que diversas preferencias humanas pueden compartir una representación unificada. La investigación utilizó el conjunto de datos StackExchange, que contiene 15 millones de pares de preferencias, y realizó experimentos en modelos Qwen2.5 con parámetros de 1.5B a 72B. Los resultados muestran que el modelado de preferencias presenta una reducción logarítmica de la pérdida en métricas objetivas y de robustez a medida que aumenta la escala de entrenamiento; el modelo de 72B muestra fenómenos emergentes en algunas tareas desafiantes. Esta investigación proporciona una base eficaz para el ajuste fino de preferencias, y tanto el artículo como el modelo (WorldPM-72B) son de código abierto. (Fuente: Alibaba_Qwen)

🎯 Tendencias

Google DeepMind y Anthropic muestran desacuerdo en la investigación sobre interpretabilidad de la IA: Google DeepMind anunció recientemente que ya no considerará la “interpretabilidad mecanicista” (mechanistic interpretability) como un foco de investigación principal, argumentando que el camino para realizar ingeniería inversa del funcionamiento interno de la IA mediante métodos como los autoencoders dispersos (SAE) es extremadamente difícil y que los SAE tienen defectos inherentes. Por otro lado, Dario Amodei, CEO de Anthropic, aboga por fortalecer la investigación en este campo y se muestra optimista sobre la posibilidad de lograr una “resonancia magnética de la IA” en los próximos 5-10 años. La naturaleza de “caja negra” de la IA es la raíz de muchos riesgos, y la interpretabilidad mecanicista tiene como objetivo comprender la función de neuronas y circuitos específicos del modelo, pero los resultados de más de una década de investigación han sido limitados, lo que ha provocado una profunda reflexión sobre las vías de investigación. (Fuente: WeChat)

Informe de Poe revela cambios en el panorama del mercado de modelos de IA, con OpenAI y Google a la cabeza: El último informe de uso de modelos de IA de Poe muestra que en el campo de la generación de texto, GPT-4o (35,8%) lidera, mientras que en el de razonamiento, Gemini 2.5 Pro (31,5%) ocupa el primer lugar. La generación de imágenes está dominada por Imagen3, GPT-Image-1 y la serie Flux. En la generación de video, la cuota de Runway ha disminuido, mientras que Kling de Kuaishou se ha convertido en un caballo negro. En cuanto a los agentes, o3 de OpenAI superó a Claude y Gemini en pruebas de investigación. La cuota de mercado de Claude de Anthropic ha disminuido. El informe señala que la capacidad de razonamiento se ha convertido en un punto clave de competencia, y las empresas necesitan establecer sistemas de evaluación y seleccionar de manera flexible diferentes modelos para hacer frente a un mercado en rápida evolución. (Fuente: WeChat)

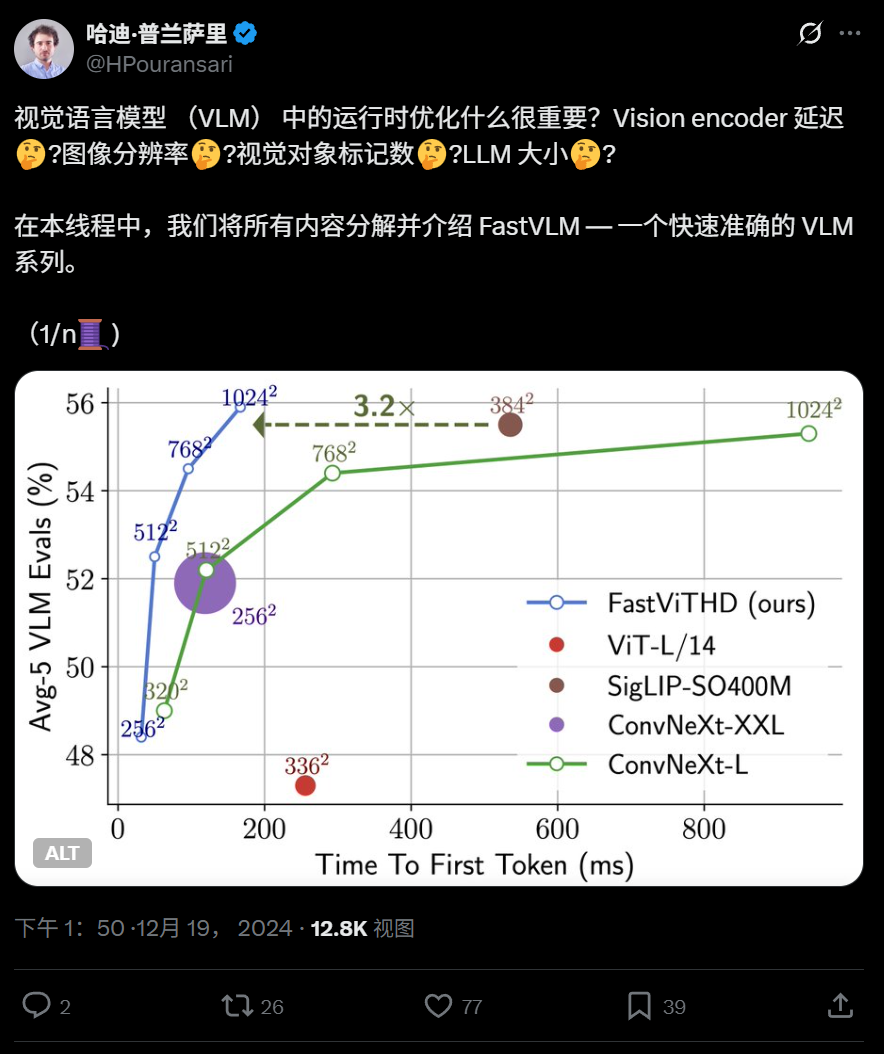

Apple lanza el modelo de lenguaje visual eficiente FastVLM de código abierto, capaz de ejecutarse en iPhone: Apple ha lanzado FastVLM de código abierto, un modelo de lenguaje visual diseñado específicamente para un funcionamiento eficiente en dispositivos edge como el iPhone. Este modelo, a través de un novedoso codificador visual híbrido FastViTHD (que fusiona capas convolucionales con módulos Transformer y utiliza técnicas de pooling multiescala y downsampling), reduce significativamente el número de tokens visuales (16 veces menos que ViT), logrando una velocidad de salida del primer token 85 veces más rápida en comparación con modelos similares. FastVLM es compatible con los principales LLM y ya se han lanzado versiones con 0.5B, 1.5B y 7B parámetros, con el objetivo de mejorar la velocidad de comprensión de imágenes y la experiencia del usuario en aplicaciones de IA en dispositivos edge. (Fuente: WeChat)

360 lanza el modelo transmodal de imagen y texto de nueva generación FG-CLIP, mejorando la capacidad de alineación detallada: El Instituto de Investigación de Inteligencia Artificial de 360 ha desarrollado FG-CLIP, un modelo transmodal de imagen y texto de nueva generación, con el objetivo de abordar las deficiencias de los modelos CLIP tradicionales en la comprensión detallada de imágenes y texto. FG-CLIP adopta una estrategia de entrenamiento en dos etapas: aprendizaje contrastivo global (integrando descripciones largas generadas por grandes modelos multimodales) y aprendizaje contrastivo local (introduciendo datos de anotación de región-texto y aprendizaje de muestras negativas difíciles de grano fino), logrando así una captura precisa de detalles locales de la imagen y diferencias sutiles en los atributos del texto. El modelo ha sido aceptado en ICML 2025 y está disponible en código abierto en Github y Huggingface, con pesos que pueden ser utilizados comercialmente. (Fuente: WeChat)

Google presenta LightLab, que utiliza modelos de difusión para controlar con precisión la luz y la sombra en imágenes: El equipo de investigación de Google ha lanzado el proyecto LightLab, una tecnología que permite un control paramétrico detallado de las fuentes de luz a partir de una sola imagen. Los usuarios pueden ajustar la intensidad y el color de las fuentes de luz visibles, la intensidad de la luz ambiental e insertar fuentes de luz virtuales en la escena. LightLab se logra mediante el ajuste fino de modelos de difusión en un conjunto de datos especialmente creado (que incluye pares de fotografías reales con iluminación controlada e imágenes renderizadas sintéticas a gran escala), utilizando las propiedades lineales de la luz para separar las fuentes de luz y la luz ambiental, y sintetizando una gran cantidad de pares de imágenes con diferentes variaciones de iluminación para el entrenamiento. Este modelo puede simular directamente efectos de iluminación complejos en el espacio de la imagen, como iluminación indirecta, sombras y reflejos. (Fuente: WeChat)

Tencent propone los métodos de aprendizaje por refuerzo GRPO y RCS para mejorar la generalización en la detección de intenciones: El equipo de investigación de la línea social de Tencent PCG ha propuesto el uso del algoritmo de optimización de políticas relativas por grupos (GRPO) combinado con una estrategia de muestreo curricular basada en recompensas (RCS) como método de aprendizaje por refuerzo, aplicado a tareas de reconocimiento de intenciones. Este método mejora significativamente la capacidad de generalización del modelo en intenciones desconocidas (con mejoras de hasta el 47% en nuevas intenciones y capacidad interlingüística), especialmente después de introducir el “Pensamiento (Thought)”, la capacidad de generalización en la detección de intenciones complejas se ve reforzada aún más. Los experimentos demuestran que los modelos entrenados con RL superan en generalización a los modelos SFT, y que, independientemente de si se basan en modelos preentrenados o modelos ajustados por instrucciones, el rendimiento después del entrenamiento con GRPO es similar. (Fuente: WeChat)

La Universidad Tecnológica de Nanyang y otros proponen el marco RAP, basado en RAG para mejorar la percepción de imágenes de alta resolución: El equipo del profesor Tao Dacheng de la Universidad Tecnológica de Nanyang, entre otros, ha propuesto Retrieval-Augmented Perception (RAP), un plugin de percepción de imágenes de alta resolución basado en la tecnología RAG que no requiere entrenamiento, diseñado para resolver el problema de la pérdida de información cuando los grandes modelos de lenguaje multimodales (MLLM) procesan imágenes de alta resolución. RAP recupera bloques de imagen relevantes para la pregunta del usuario y utiliza el algoritmo Spatial-Awareness Layout para mantener su relación posicional relativa. Luego, mediante Retrieved-Exploration Search (RE-Search), selecciona adaptativamente el número K de bloques de imagen a conservar, reduciendo eficazmente la resolución de la imagen de entrada mientras se preserva la información visual clave. Los experimentos muestran que RAP mejora la precisión en los conjuntos de datos HR-Bench 4K y 8K hasta en un 21% y un 21,7% respectivamente. Este logro ha sido aceptado como artículo Spotlight en ICML 2025. (Fuente: WeChat)

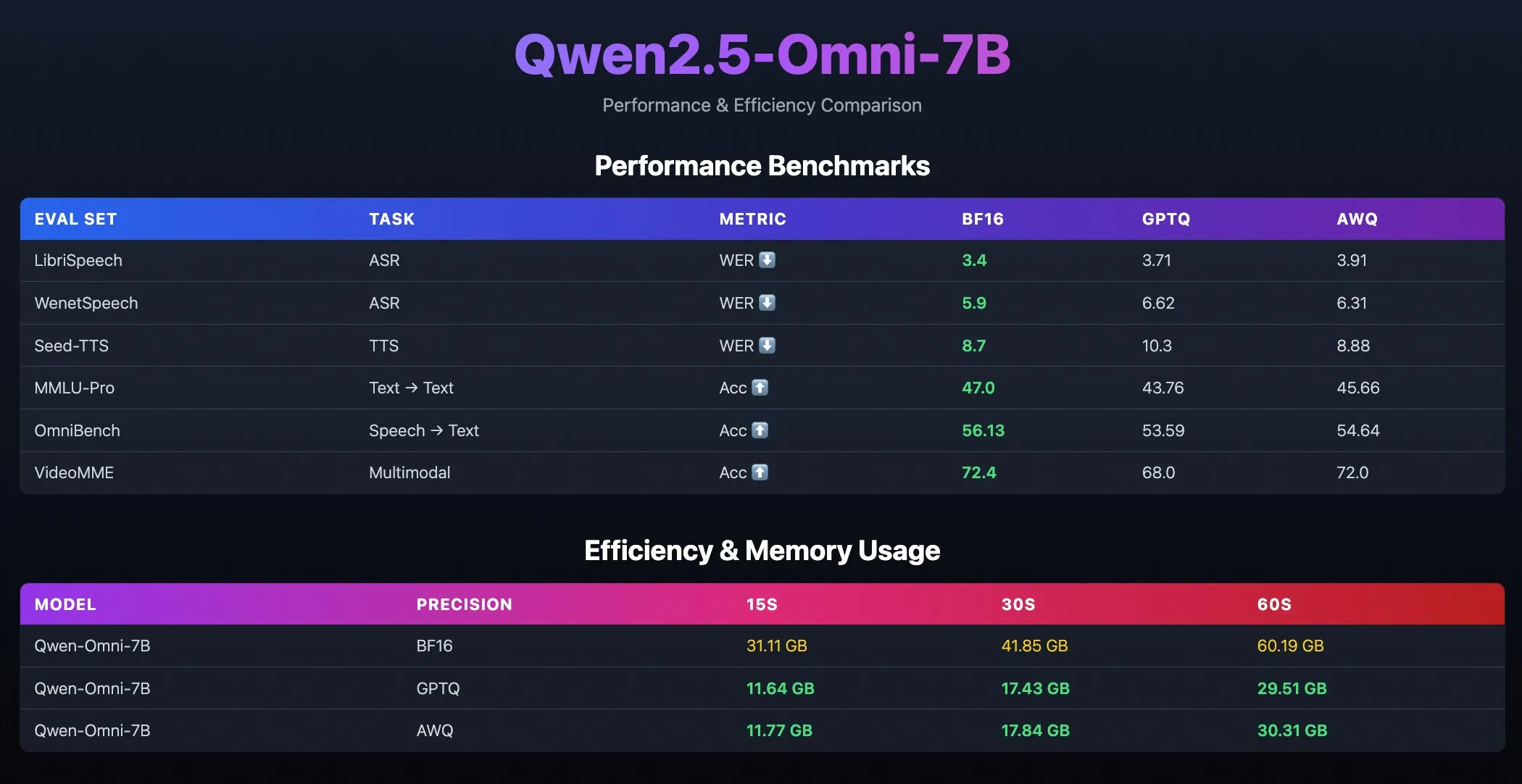

Lanzamiento de modelos cuantizados Qwen2.5-Omni-7B: El equipo Qwen de Alibaba ha lanzado versiones cuantizadas del modelo Qwen2.5-Omni-7B, incluyendo checkpoints optimizados con GPTQ y AWQ. Estos modelos ya están disponibles en Hugging Face y ModelScope, con el objetivo de ofrecer opciones de despliegue más eficientes y con menor consumo de recursos, manteniendo al mismo tiempo sus potentes capacidades multimodales. (Fuente: Alibaba_Qwen, karminski3, reach_vb)

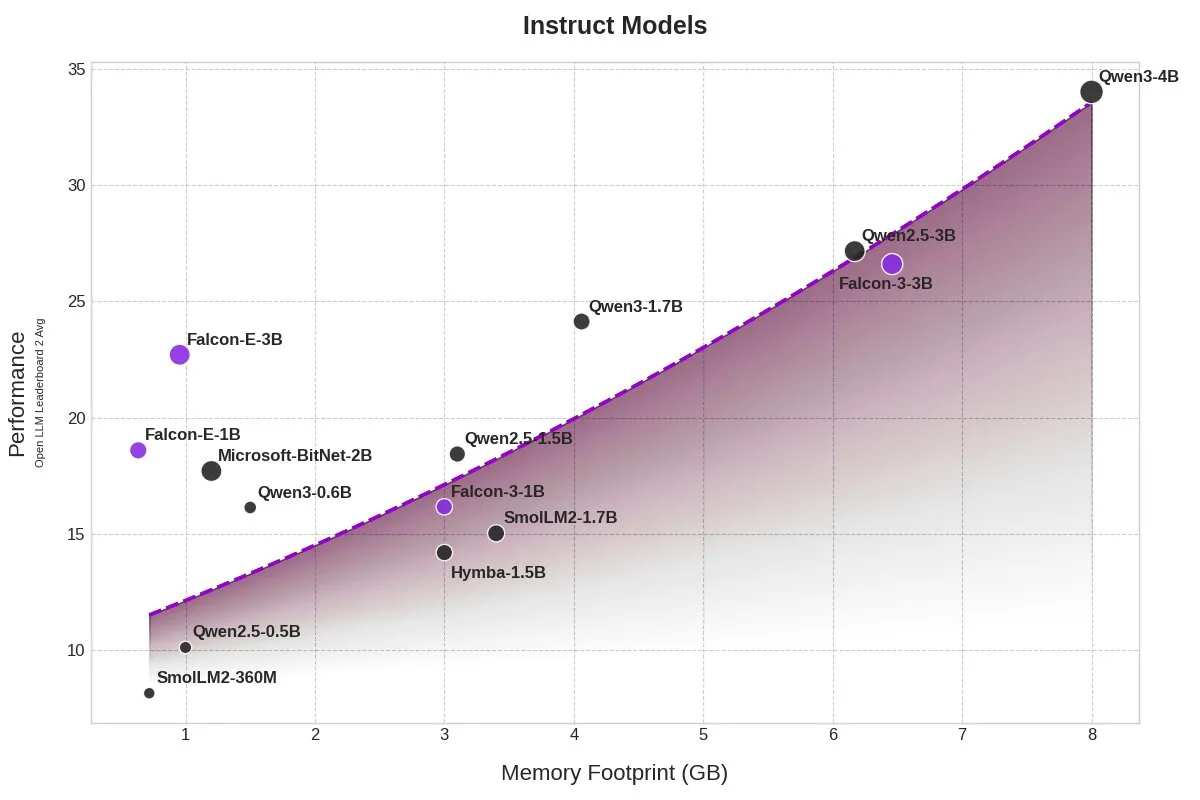

TII lanza los modelos BitNet Falcon-E-1B/3B, reduciendo drásticamente el uso de memoria: El Instituto de Innovación Tecnológica (TII) ha presentado una nueva serie de modelos, Falcon-Edge, basada en el marco de modelos de precisión de 1 bit BitNet de Microsoft, que incluye Falcon-E-1B y Falcon-E-3B. Se afirma que el rendimiento de estos modelos es comparable al de Qwen3-1.7B, pero con un uso de memoria de solo 1/4. TII también ha lanzado la biblioteca de ajuste fino onebitllms, que permite a los usuarios ajustar estos modelos de 1 bit en tarjetas gráficas NVIDIA. (Fuente: karminski3)

Los modelos Qwen3 y DeepSeek lideran el ranking de preguntas y respuestas médicas MEDIC-Benchmark: Los modelos Qwen3 han obtenido el primer y segundo puesto en el ranking de preguntas y respuestas médicas MEDIC-Benchmark recientemente publicado. Además, los cinco primeros puestos de la lista están ocupados por modelos de las series Qwen y DeepSeek, lo que demuestra la potente capacidad de estos grandes modelos chinos en el ámbito médico especializado. (Fuente: karminski3)

La Universidad de Zhejiang propone Rankformer: una arquitectura de modelo de recomendación Transformer que optimiza directamente el ranking: Un equipo de la Universidad de Zhejiang ha propuesto una nueva arquitectura de modelo de recomendación Graph Transformer llamada Rankformer, cuyo diseño se deriva directamente de objetivos de ranking (como la función de pérdida BPR). Rankformer simula la dirección de optimización de vectores en el proceso de descenso de gradiente para diseñar un mecanismo único de Graph Transformer, guiando al modelo en la propagación hacia adelante para codificar representaciones de ranking superiores. El modelo utiliza un mecanismo de atención global para agregar información y afirma reducir la complejidad espacio-temporal a un nivel lineal mediante transformaciones matemáticas y optimización de caché. Esta investigación ha sido aceptada en la conferencia WWW 2025. (Fuente: WeChat)

🧰 Herramientas

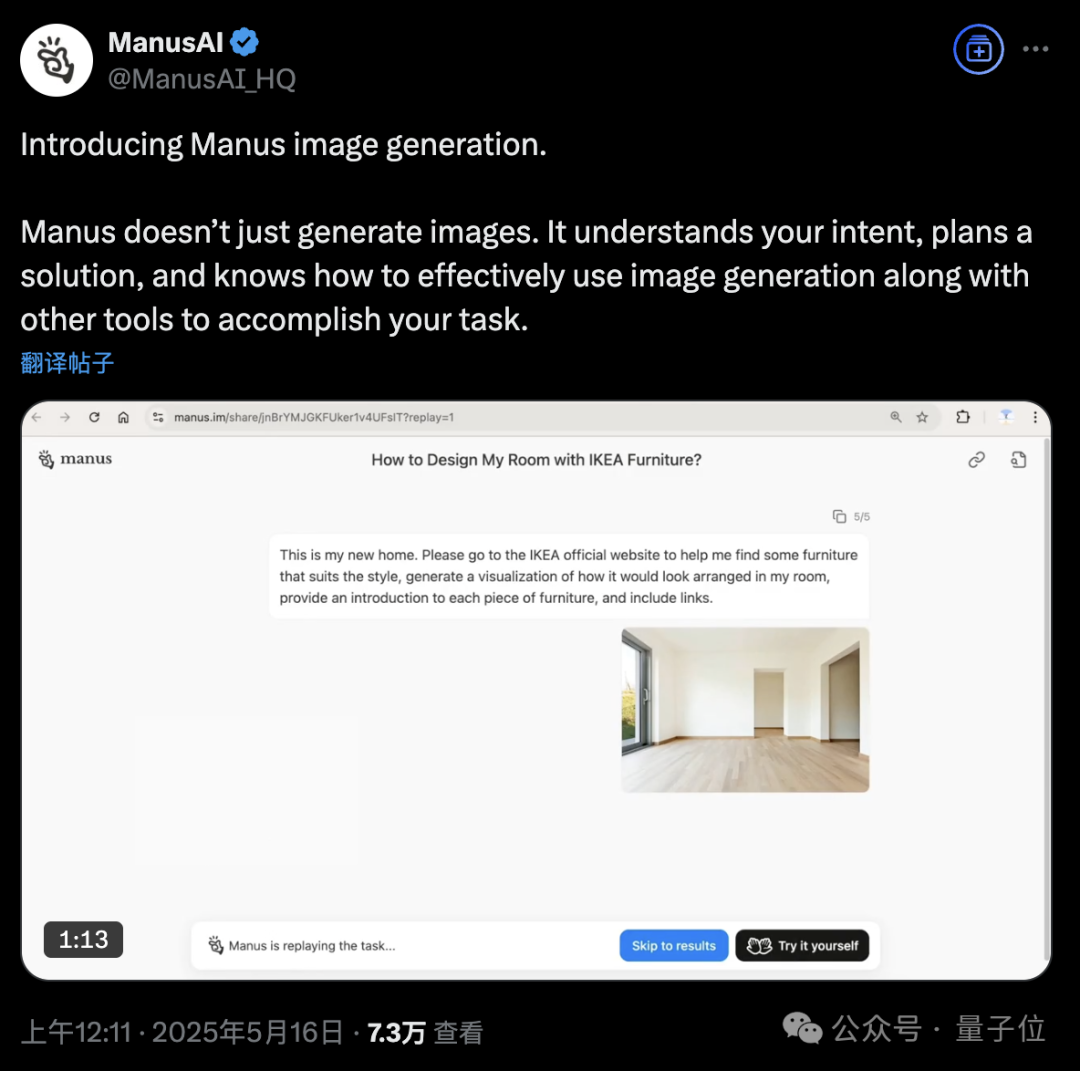

La plataforma Manus AI Agent añade función de generación de imágenes: La plataforma de AI Agent Manus ha anunciado soporte para la generación de imágenes. A diferencia de las herramientas tradicionales de dibujo con IA, Manus puede comprender el propósito del usuario al dibujar y planificar esquemas de generación. Por ejemplo, un usuario puede subir una foto de una habitación, pedir a Manus que busque muebles en la web de Ikea y genere una visualización del efecto de la decoración, adjuntando además los enlaces de los muebles. Manus completa la tarea mediante el análisis, búsqueda, selección de muebles, redacción de estrategias de diseño, etc. Esta función tiene como objetivo integrar profundamente los flujos de trabajo de los agentes inteligentes con la generación de imágenes. Actualmente, Manus ha abierto el registro, regalando 1000 puntos, con 300 puntos adicionales diarios, y ofrece planes de suscripción de pago. (Fuente: 36氪, WeChat)

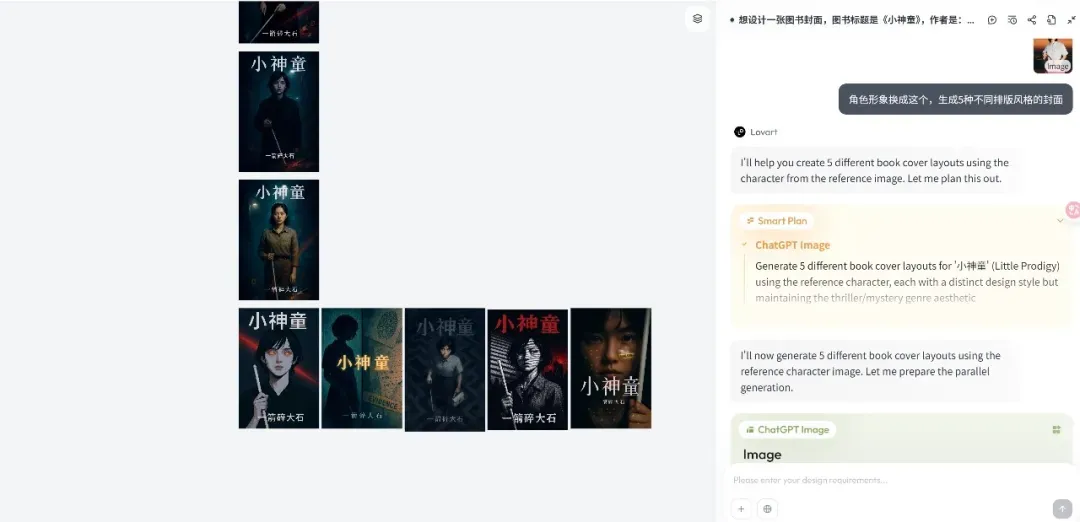

Lanzamiento de la plataforma Lovart Design Agent, enfocada en flujos de trabajo creativos: La emergente plataforma de Design Agent Lovart ha captado rápidamente la atención tras su lanzamiento. Su concepto central es transformar el proceso creativo de los diseñadores (que implica multimodalidad) en un flujo de trabajo de Agent. Lovart ofrece una interfaz interactiva tipo lienzo, donde los usuarios pueden guiar a la IA mediante diálogos para completar tareas de diseño, mientras la IA se encarga de la planificación y ejecución. El fundador, Chen Mian, considera que los productos de imagen con IA han entrado en la fase 3.0, impulsada por Agents, y Lovart aspira a convertirse en un “amigo” de los diseñadores, delegando las tareas tediosas a la IA para que los diseñadores se centren en la creatividad. El producto integrará en el futuro capacidades de modelado 3D, vídeo y audio, convirtiéndose en un “equipo creativo” o una “empresa de diseño”. (Fuente: 36氪)

Actualización de OpenAI Codex CLI, integra o4-mini y ofrece crédito API gratuito: OpenAI ha mejorado su ligero agente de codificación de código abierto Codex CLI. La nueva versión está impulsada por o4-mini (denominado codex-mini), una versión simplificada de codex-1, optimizada específicamente para consultas y edición de código de baja latencia. Los usuarios ahora pueden iniciar sesión en Codex CLI con su cuenta de ChatGPT, y los usuarios Plus y Pro pueden canjear respectivamente 5 y 50 dólares en créditos API gratuitos (válidos por 30 días) para probar el modelo codex-mini-latest. (Fuente: openai, hwchung27, op7418)

El framework de procesamiento de datos de código abierto Smallpond de DeepSeek integra el acceso nativo de DuckDB a 3FS: El framework de procesamiento de datos de código abierto Smallpond de DeepSeek utiliza internamente 3FS (DeepSeek File System) y DuckDB. Ahora, DuckDB, a través del plugin hf3fs_usrbio, admite el acceso nativo a 3FS, lo que supondrá mejoras de rendimiento y reducción de gastos generales. DuckDB también es elogiado por su facilidad de uso, por ejemplo, puede incrustar directamente URL en las sentencias de consulta para el procesamiento de datos. (Fuente: karminski3)

ComfyUI añade soporte nativo para el modelo de vídeo Wan2.1-VACE de Alibaba: ComfyUI ha anunciado soporte nativo para las versiones 14B y 1.3B del modelo de generación de vídeo Wan2.1-VACE del equipo Wanxiang de Alibaba (@Alibaba_Wan). Este modelo aporta a ComfyUI capacidades integradas de edición de vídeo, incluyendo texto a vídeo, imagen a vídeo, vídeo a vídeo (control de pose y profundidad), reparación de vídeo (inpainting) y expansión (outpainting), así como referencia de personajes/objetos. (Fuente: TomLikesRobots)

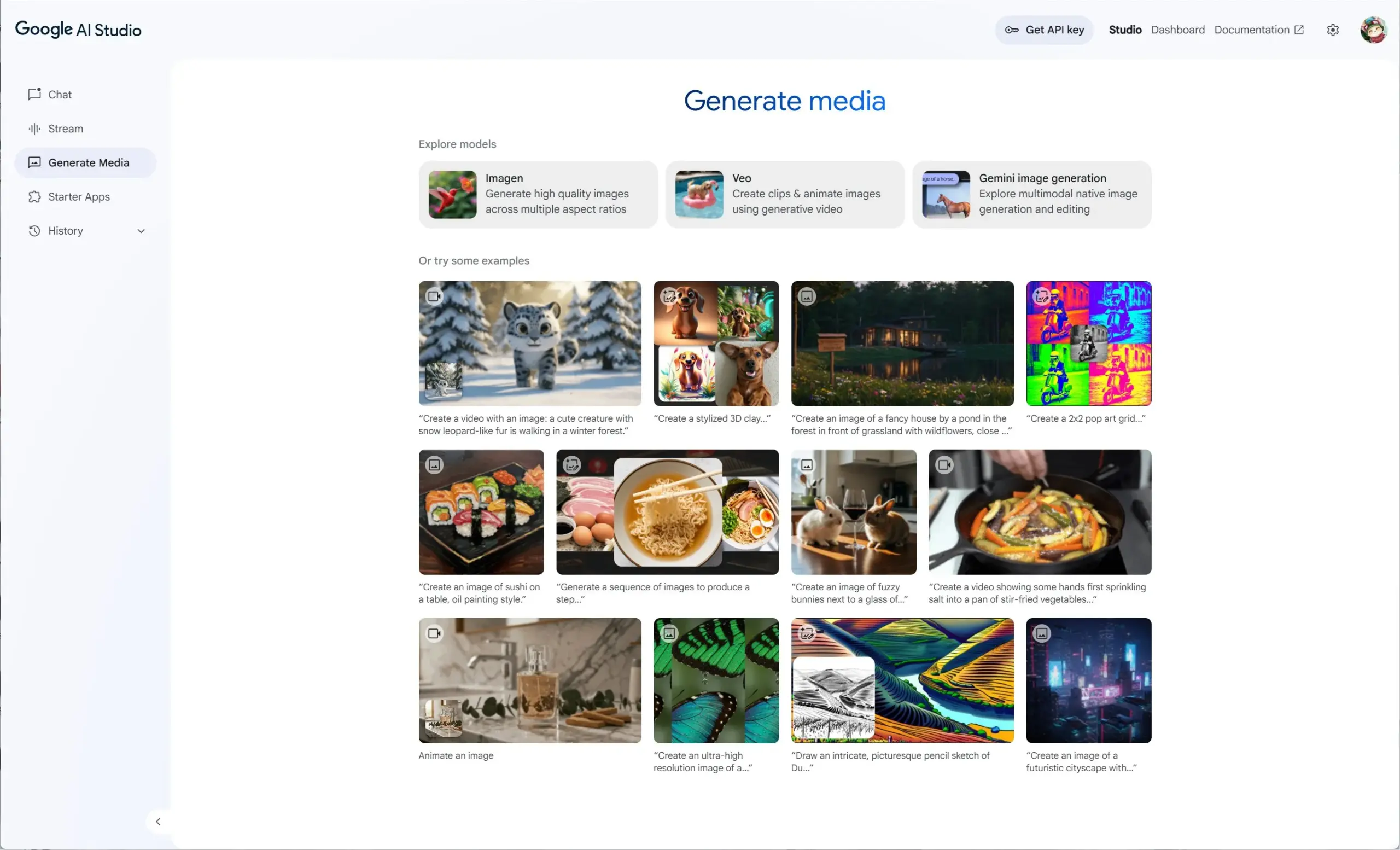

Google AI Studio integra Veo 2, Gemini 2.0 e Imagen 3, ofreciendo una experiencia unificada de generación de medios: Google AI Studio ha lanzado una nueva experiencia de generación de medios que integra el modelo de vídeo Veo 2, las capacidades nativas de generación/edición de imágenes de Gemini 2.0 y el último modelo de texto a imagen Imagen 3. Los usuarios pueden probar estos modelos de forma gratuita en AI Studio, y los desarrolladores también pueden construir a través de la API. (Fuente: op7418)

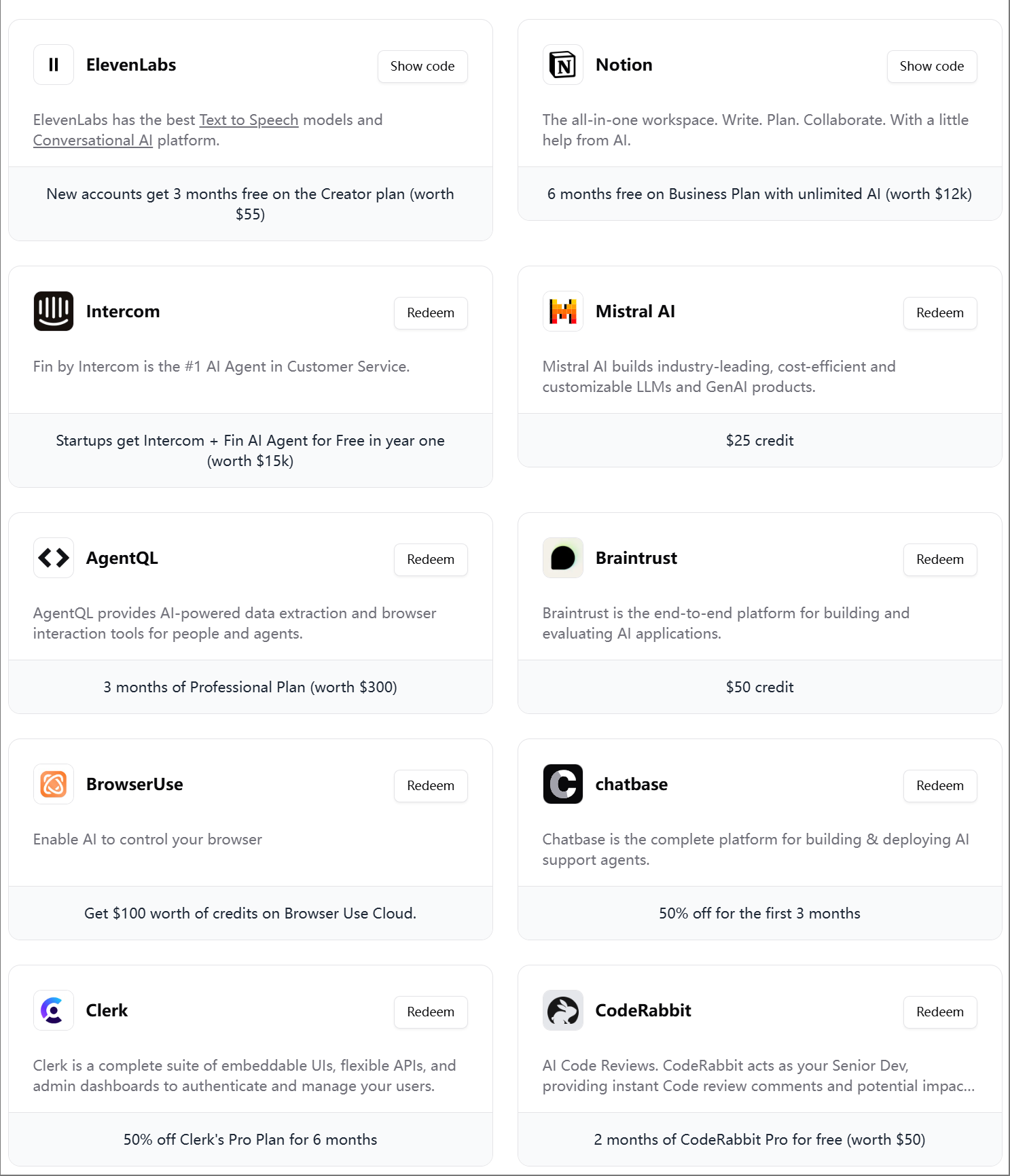

ElevenLabs lanza el cuarto paquete de regalo para ingenieros de IA: ElevenLabs ha lanzado su cuarto paquete de regalo para desarrolladores de IA, que incluye membresías y créditos API para diversas herramientas y servicios como Modal Labs, Mistral AI, Notion, BrowserUse, Intercom, Hugging Face, CodeRabbit, entre otros, con el objetivo de ayudar a startups y desarrolladores de IA. (Fuente: op7418)

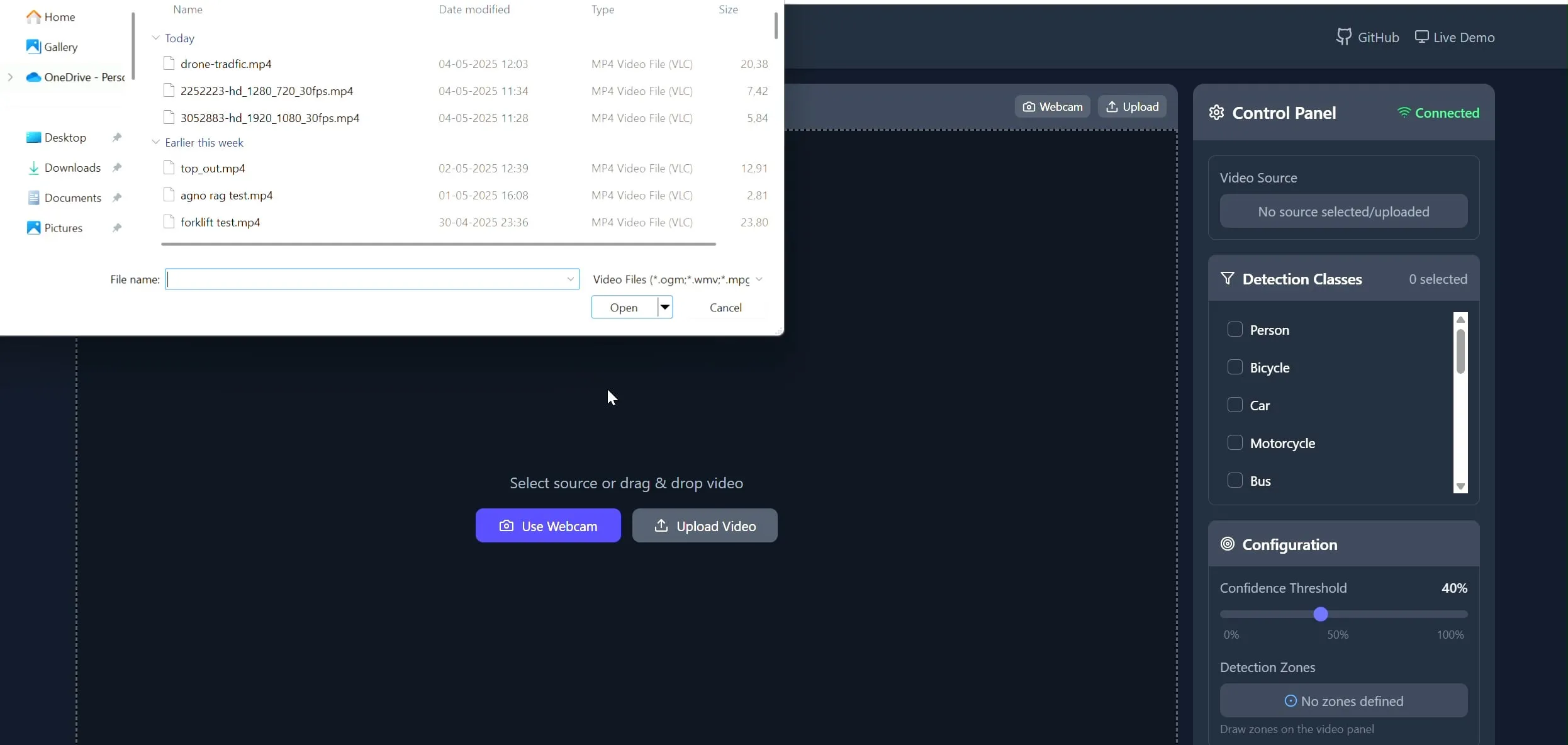

Polygon Zone App: herramienta de dibujo de polígonos personalizados en vídeo para tareas de CV: El desarrollador Pavan Kunchala ha creado una herramienta llamada Polygon Zone App que permite a los usuarios subir vídeos, dibujar interactivamente regiones poligonales personalizadas (ROI) en los fotogramas del vídeo y ejecutar análisis de visión por computadora, como detección de objetos, dentro de estas regiones. La herramienta tiene como objetivo simplificar el tedioso proceso de definir ROI en proyectos de CV, evitando la edición manual de coordenadas JSON. (Fuente: Reddit r/deeplearning)

📚 Aprendizaje

El curso AI Evals atrae la participación de más de 300 empresas: El curso de evaluación de IA (bit.ly/evals-ai) impartido por Hamel Husain ya ha atraído la participación de más de 300 empresas, entre ellas Adobe, Amazon, Google, Meta, Microsoft, NVIDIA, OpenAI y otras empresas de renombre, así como varias universidades de primer nivel. Esto refleja la gran atención y demanda de la industria por los métodos y prácticas de evaluación de modelos de IA. (Fuente: HamelHusain)

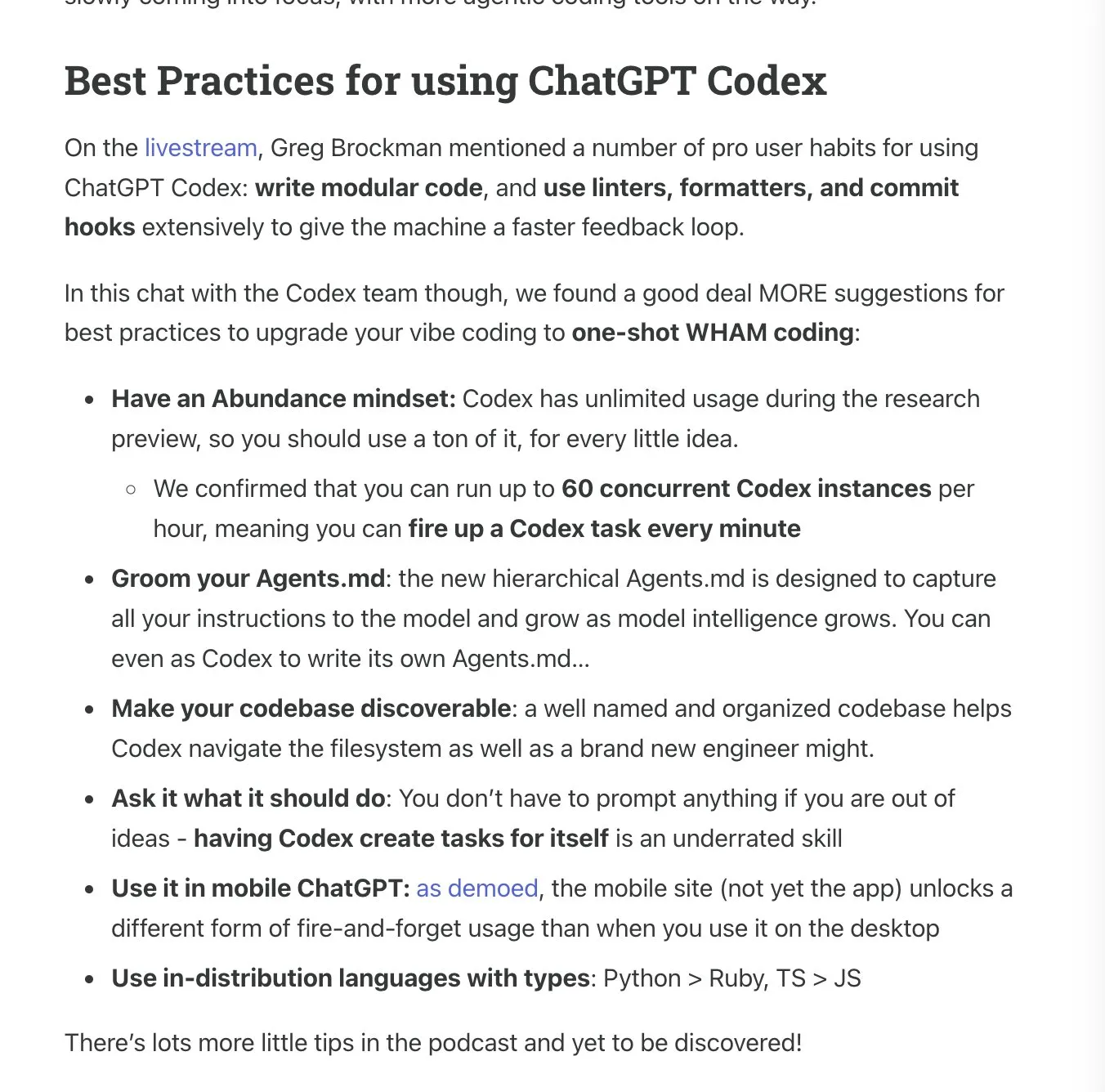

Latent.Space publica el manual de uso de ChatGPT Codex: Latent.Space ha lanzado una guía titulada “ChatGPT Codex: The Missing Manual”, que detalla cómo utilizar eficientemente ChatGPT Codex, el ingeniero de software autónomo en la nube recientemente lanzado por OpenAI. El manual, escrito por Josh Ma y Alexander Embiricos, tiene como objetivo ayudar a los usuarios a aprovechar al máximo las potentes funciones de Codex en las operaciones con repositorios de código. (Fuente: swyx)

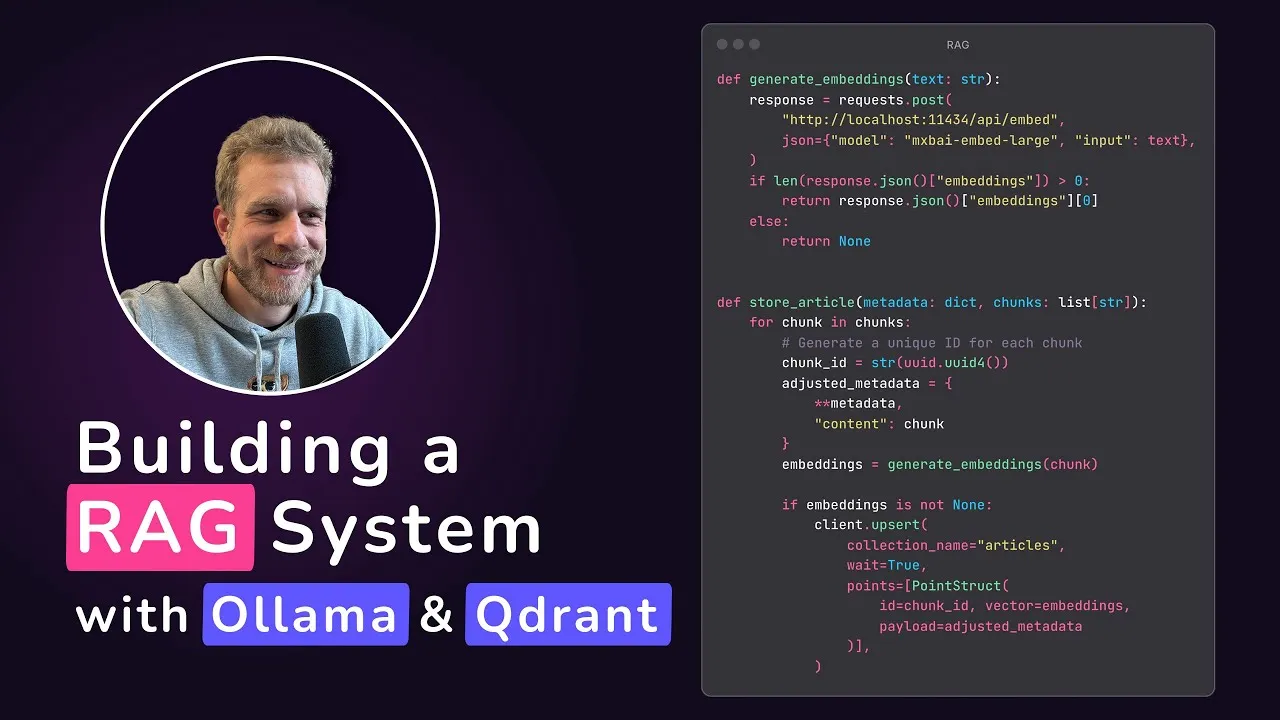

Qdrant lanza un tutorial para aplicaciones RAG locales: Qdrant Engine ha compartido un tutorial creado por @maxedapps que demuestra cómo construir una aplicación de generación aumentada por recuperación (RAG) 100% local desde cero utilizando Gemma 3, Ollama y Qdrant Engine. El tutorial, de 2 horas de duración, proporciona el código completo y los pasos, y es adecuado para desarrolladores que deseen practicar con aplicaciones de IA locales. (Fuente: qdrant_engine)

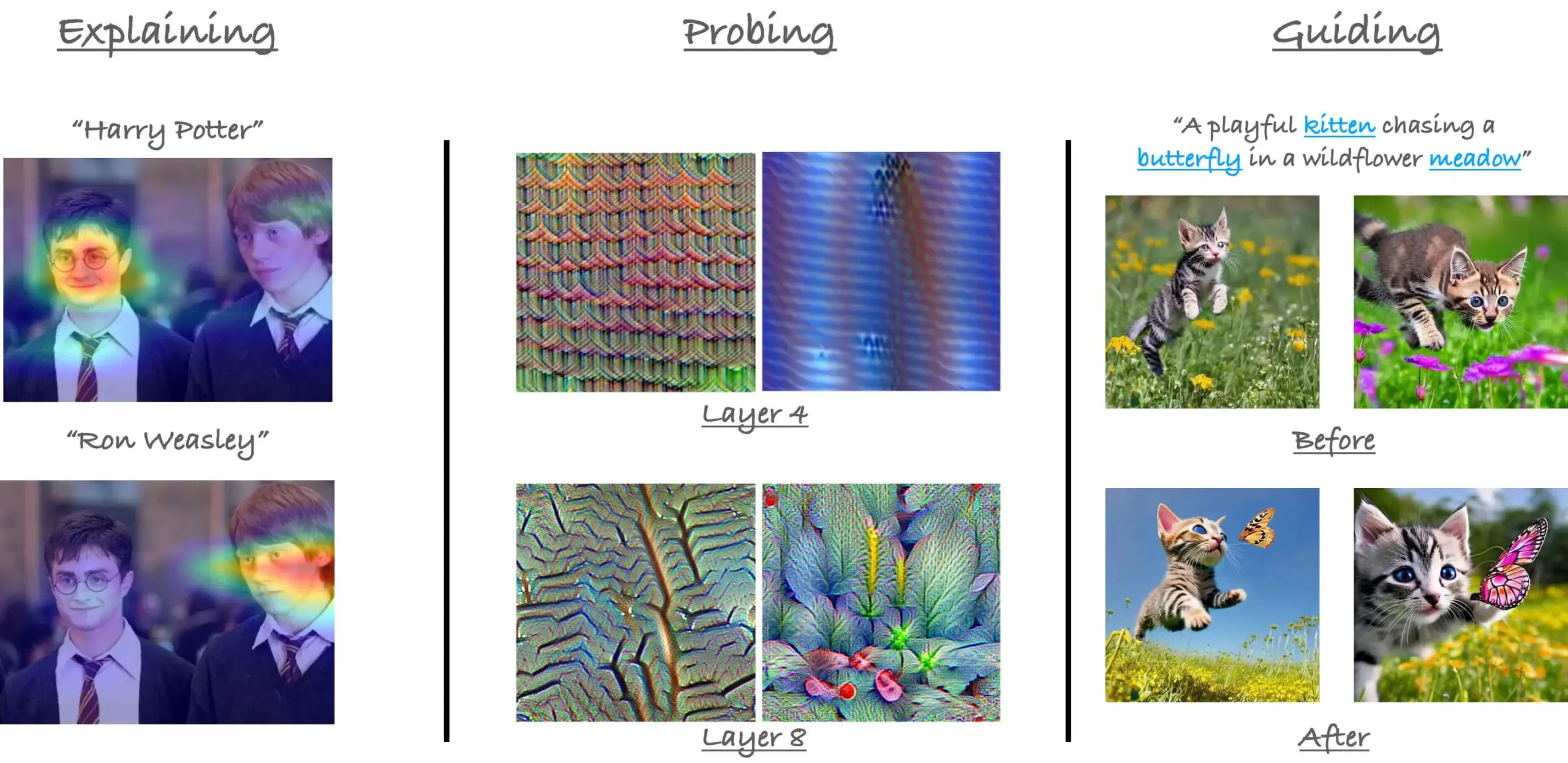

Repaso del tutorial sobre mecanismos de atención en ViT de CVPR23: El investigador Sayak Paul ha repasado el tutorial sobre mecanismos de atención en Vision Transformer (ViT) que presentó junto a Hila Chefer en CVPR 2023. El tutorial se centra en tres temas: “explicar (explain)”, “sondear (probe)” y “guiar (guide)”, con el objetivo de ayudar a comprender el funcionamiento interno de la atención en ViT. (Fuente: RisingSayak)

Consejos para usar Claude Code: planificación, reglas y compresión manual: Un usuario de Reddit compartió su experiencia de una semana de uso intensivo de Claude Code, destacando la importancia de la planificación, el establecimiento de reglas (a través de un archivo CLAUDE.md) y la ejecución manual de /compact antes de alcanzar el límite de compresión automática. Estos consejos ayudan a mejorar la productividad y la calidad del resultado, especialmente al manejar grandes funcionalidades o evitar que el modelo se desvíe. El usuario mencionó que, con estos métodos, Claude Code puede completar tareas complejas de manera eficiente. (Fuente: Reddit r/ClaudeAI)

Entrevista al fundador de AIGCode, Su Wen: insistencia en el desarrollo propio de grandes modelos, objetivo de generación de código nivel “L5” de Autopilot: En una entrevista, Su Wen, fundador de AIGCode, declaró que el objetivo de la empresa es convertirse en una infraestructura para el suministro de código, logrando una programación automática Autopilot de nivel “L5”, permitiendo que incluso los no programadores puedan generar aplicaciones completas mediante IA. Considera que la codificación (Coding) es el mejor escenario para entrenar grandes modelos, y que el código es datos de entrenamiento de alta calidad. AIGCode ya ha entrenado un modelo base de 66B llamado “Xīyuè” y ha lanzado el producto AutoCoder. Su Wen enfatizó que, en última instancia, los productos de IA competirán por la inteligencia de su “cerebro”, que el preentrenamiento es la fuerza motriz tecnológica y que, a pesar de los altos costos, el desarrollo propio de modelos es crucial para alcanzar la AGI y construir la competitividad central del producto. (Fuente: WeChat)

💼 Negocios

El equipo de plataforma de agentes inteligentes y algoritmos de aplicación de JD.com está contratando: El equipo de algoritmos de aplicación y plataforma de agentes inteligentes, un proyecto central de JD.com, está contratando ingenieros de algoritmos de grandes modelos y becarios, con lugar de trabajo en Beijing. Las principales direcciones técnicas incluyen LLM Agent, LLM Reasoning y LLM combinado con aprendizaje por refuerzo. La contratación está dirigida a estudiantes de máster y doctorado que se gradúen en 2026 (contratación universitaria), profesionales con un nivel equivalente a P5-P8 (contratación social) y becarios de investigación. El equipo se centra en la impulsión tecnológica y la resolución de problemas prácticos, y cuenta con publicaciones en conferencias de IA de primer nivel. (Fuente: WeChat)

La estrategia “AI-first” enfrenta desafíos en Klarna y Duolingo, se presta atención al equilibrio humano-máquina: La empresa de tecnología financiera Klarna y la aplicación de aprendizaje de idiomas Duolingo enfrentan la presión de los comentarios de los consumidores y la realidad del mercado después de implementar estrategias “AI-first”. Klarna había reemplazado cientos de puestos de servicio al cliente con IA, pero debido a la disminución de la calidad del servicio, ahora está recontratando personal de atención al cliente humano. Duolingo provocó el descontento de los usuarios debido a la automatización de roles, y muchos consideran que el núcleo del aprendizaje de idiomas debe ser dirigido por humanos. Estos casos indican que las empresas en transformación de IA necesitan equilibrar la innovación con la atención humanitaria; aunque la tecnología es importante, la confianza del usuario aún necesita ser construida por personas. (Fuente: Reddit r/ArtificialInteligence)

Se rumorea que Databricks adquirirá la startup de bases de datos Neon por 1.000 millones de dólares: Según resúmenes de noticias de IA que circulan en la comunidad de Reddit, Databricks ha adquirido la startup de bases de datos Neon por un importe que se estima en 1.000 millones de dólares. Esta adquisición podría tener como objetivo reforzar las capacidades de Databricks en la gestión de datos y la infraestructura de IA. (Fuente: Reddit r/ArtificialInteligence)

🌟 Comunidad

El lanzamiento de OpenAI Codex genera un intenso debate, los desarrolladores muestran expectación y cautela a la vez: Tras el lanzamiento del agente de programación Codex por parte de OpenAI, la comunidad ha reaccionado con entusiasmo. Muchos desarrolladores se muestran entusiasmados con la capacidad de Codex para completar automáticamente tareas como la creación de PR y la corrección de código, considerando que esto mejorará enormemente la eficiencia de la programación, e incluso algunos lo describen como “una sensación de momento AGI”. Ryan Pream compartió su experiencia de crear más de 50 PR en un día usando Codex. Al mismo tiempo, algunos usuarios señalan que Codex aún necesita mejoras en aspectos como la división de tareas y la adición de casos de prueba, y que actualmente es más adecuado para profesionales. Yohei Nakajima compartió su experiencia inicial, considerando que su diseño centrado en GitHub es razonable, pero que la curva de aprendizaje es pronunciada. (Fuente: kevinweil, gdb, itsclivetime, dotey, yoheinakajima, cto_junior)

La contribución de Meta al código abierto en IA recibe reconocimiento, generando debate sobre modelos cerrados vs. abiertos: Clement Delangue, CEO de Hugging Face, publicó un mensaje de apoyo a Meta, argumentando que su contribución al código abierto de modelos de IA supera con creces la de otras grandes empresas y startups con más recursos, y no debería ser objeto de tantas críticas. Esta opinión fue compartida por algunos usuarios, quienes consideran que construir modelos de IA de vanguardia es extremadamente difícil y que la apertura de Meta es crucial para el desarrollo del campo. Sin embargo, también hay opiniones (gabriberton) que señalan que el código abierto implica renunciar a una ventaja de conocimiento y que, en esencia, los modelos cerrados pueden obtener mejores resultados. Dorialexander, por su parte, expresó su desconcierto ante la repentina adopción por parte de Estados Unidos de “la forma europea de responder” (refiriéndose a la defensa de Meta). (Fuente: ClementDelangue, gabriberton, Dorialexander)

Filtración del prompt del sistema de Grok de xAI e incidente de fusión de contenido inapropiado generan preocupación: Se descubrió que el prompt del sistema del modelo Grok de xAI se filtró en GitHub, e incluso incluía el prompt del sistema de DeepSearch. Más grave aún, algunos usuarios señalaron que un PR que contenía contenido inapropiado como “genocidio blanco” fue fusionado en la rama principal después de ser revisado por cinco personas, y aunque posteriormente fue revertido y el historial eliminado, el incidente expuso importantes deficiencias en la gestión de procesos y la seguridad operativa de xAI. Este asunto ha provocado amplias dudas y discusiones en la comunidad sobre los procesos internos y los mecanismos de moderación de contenido de xAI. (Fuente: karminski3, eliebakouch, colin_fraser, Reddit r/artificial)

Los AI Agents se consideran una tendencia futura, pero coexisten desafíos y expectativas: La idea de que “2025 es el año de los Agents” circula en la comunidad, generando debate sobre el futuro desarrollo de los AI Agents. Algunos opinan que el modelo de trabajo futuro será similar a “StarCraft” o “Age of Empires”, donde los usuarios dirigirán una gran cantidad de microagentes para completar tareas. Sin embargo, otros usuarios señalan que los Agents actuales aún no son maduros en la descomposición de tareas y la comprensión de instrucciones complejas, y requieren que los usuarios tengan una gran capacidad de planificación. Algunos dudan de que los AI Agents puedan alcanzar las expectativas en 2025, creyendo que podría pasar de un truco publicitario a otro, y esperan un cambio sustancial para 2026. (Fuente: gdb, EdwardSun0909, op7418, eliza_luth, tokenbender)

El papel de la IA en la educación y el empleo genera un profundo debate: En la comunidad de Reddit ha surgido un debate sobre el impacto del desarrollo de la IA en los modelos tradicionales de educación y empleo. Un usuario preguntó: “¿Qué sentido tiene ir a la escuela ahora?”, argumentando que la IA hará que nadie necesite trabajar en el futuro. Ante esto, la mayoría de los comentarios enfatizaron la importancia del pensamiento crítico, la capacidad de aprendizaje y las habilidades sociales, considerando que estos son insustituibles por la IA. La escuela no es solo un lugar para impartir conocimientos, sino también un entorno para aprender a aprender, a pensar y a interactuar con los demás. Incluso en un mundo dominado por la IA, estas habilidades seguirán siendo cruciales, e incluso será necesario aprender sobre la IA misma. Otro debate señaló que el valor de una persona no debe equipararse únicamente a su trabajo, y que el desarrollo de la IA debería impulsarnos a reflexionar sobre el significado humano más allá de la profesión. (Fuente: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

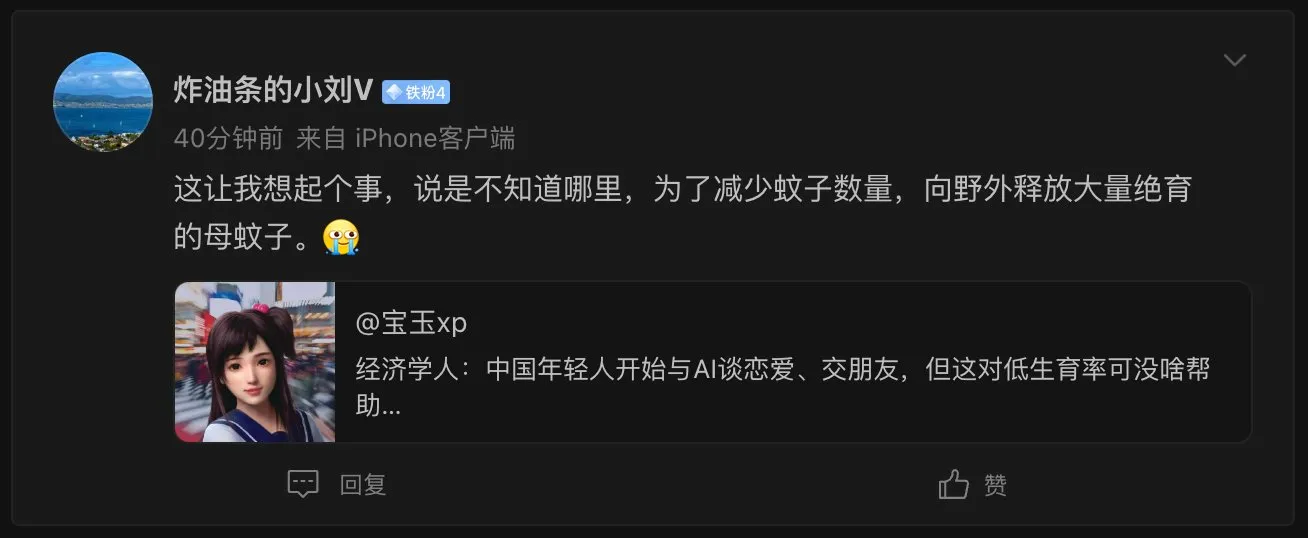

El fenómeno de las “novias IA” suscita reflexiones sobre ética social y problemas demográficos: The Economist informó que los jóvenes chinos están comenzando a tener relaciones románticas y amistades con IA, lo que ha generado un acalorado debate entre los internautas. Algunos comentarios comparan este fenómeno con “liberar una gran cantidad de mosquitos hembra esterilizados en la naturaleza para reducir la población de mosquitos”, sugiriendo que las parejas de IA podrían agravar el problema de la baja tasa de natalidad, a pesar de que las parejas de IA pueden ofrecer una experiencia perfecta de “alguien que siempre te entiende”. Esto refleja las complejas implicaciones sociales y consideraciones éticas que surgen de la aplicación de la tecnología de IA en el ámbito del acompañamiento emocional. (Fuente: dotey)

El realismo de las conversaciones telefónicas con IA genera preocupación, la dificultad para distinguir lo real de lo falso se convierte en un nuevo desafío: Un usuario de Reddit compartió haber recibido una llamada de una institución educativa donde la voz y el tono del interlocutor eran naturales y las respuestas fluidas, siendo casi imposible distinguir si era una persona real o una IA. Solo después de varios minutos de conversación, debido a la perfección impecable de sus respuestas, se dio cuenta de que era una IA. Esta experiencia provocó asombro y cierta inquietud en el usuario por la velocidad del desarrollo de la tecnología de voz de IA, temiendo la futura dificultad para discernir la IA en las llamadas telefónicas, lo que podría suponer un riesgo de fraude especialmente para grupos como las personas mayores. (Fuente: Reddit r/ArtificialInteligence, Reddit r/artificial)

💡 Otros

El MIT solicita a arXiv la retirada de un preimpreso sobre IA y descubrimiento científico, generando controversia: El MIT ha solicitado a arXiv la retirada de un preimpreso escrito por uno de sus estudiantes de doctorado sobre el impacto de la IA en la innovación en la ciencia de los materiales, alegando “falta de confianza” en el origen, la fiabilidad y la validez de los datos de la investigación. Dicho artículo había señalado que la IA ayudaba a los investigadores a aumentar el descubrimiento de materiales en un 44% y las solicitudes de patentes en un 39%. Esta medida del MIT ha generado debate; algunos comentarios consideran que su actuación atenta contra la libertad académica y podría estar relacionada con que las conclusiones de la investigación (la IA podría acentuar la ventaja de los investigadores de élite y reducir la satisfacción laboral de los investigadores comunes) no se ajustan a las expectativas de los financiadores. Otros comentarios sostienen que, en el campo de la IA, el rigor de los resultados de la investigación es crucial y se debe estar alerta ante la exageración impulsada por los preimpresos. (Fuente: Reddit r/ArtificialInteligence)

La popularización de las herramientas de codificación con IA exige mayores requisitos para la modularización del código y las prácticas de ingeniería: E0M señaló en Twitter que la ventaja competitiva de las startups se manifiesta cada vez más en la velocidad y eficiencia con la que los ingenieros adoptan herramientas de codificación con IA. Las buenas prácticas de código modularizado se han vuelto más importantes que nunca; si la complejidad del código está dentro del rango de procesamiento de los agentes de codificación modernos, se puede lograr una iteración rápida. Por el contrario, un “código espagueti” demasiado complejo podría ralentizar el progreso, siendo superado por competidores que sí utilizan IA. (Fuente: E0M, E0M)

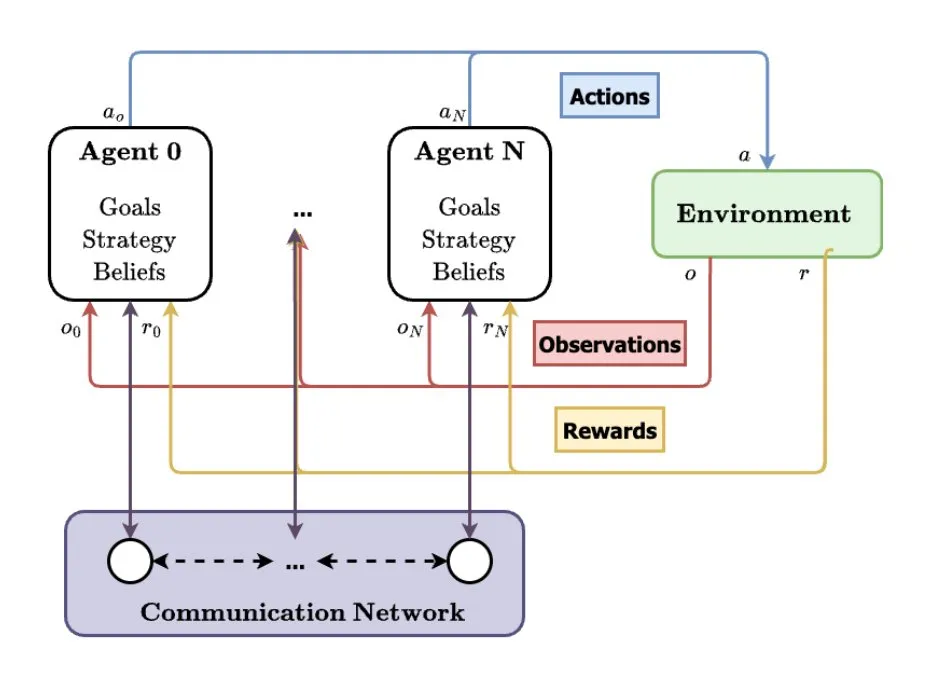

Los sistemas multiagente (MAS) se consideran una dirección futura para el desarrollo de la IA: TheTuringPost analizó la tendencia emergente de los sistemas multiagente (MAS), cuyos desarrollos clave incluyen el aprendizaje por refuerzo multiagente (MARL), la robótica de enjambres, los MAS conscientes del contexto (CA-MAS) y los MAS impulsados por grandes modelos de lenguaje (LLM). Estas tecnologías permiten que los sistemas de IA resuelvan problemas complejos mediante la colaboración y la competencia, aplicándose en áreas como la respuesta a desastres, la monitorización ambiental y la simulación de dinámicas sociales, lo que presagia un futuro de inteligencia colectiva. (Fuente: TheTuringPost)