Palabras clave:IA en medicina, Modelos de lenguaje, Aprendizaje por refuerzo, Razonamiento de IA, Evaluación comparativa de IA, Herramientas de IA, Negocios de IA, Ética de IA, OpenAI HealthBench, Meta Física de Modelos de Lenguaje, Motor de inferencia FlashInfer, Generación de mundos virtuales Matrix-Game, Entrenamiento distribuido INTELLECT-2

Okay, here is the translation of the AI news summary into Spanish, following your requirements.

🔥 Enfoque

Lanzamiento del benchmark OpenAI HealthBench, mejora significativa en las capacidades de IA médica: OpenAI ha lanzado HealthBench, un benchmark de evaluación de IA médica construido en colaboración con 262 médicos de todo el mundo. Las pruebas muestran que los modelos de IA más recientes (como o3, GPT-4.1) han alcanzado un rendimiento en escenarios de diálogo médico comparable al mejor nivel asistido por IA, superando con creces a los médicos que trabajan de forma independiente (aproximadamente 4 veces). El rendimiento de los modelos más pequeños también ha mejorado. Esto marca el enorme potencial de la IA en el campo de la salud, y el sistema de evaluación tiene como objetivo promover la aplicación segura y efectiva de la IA en la práctica clínica. (Fuente: Reddit r/ArtificialInteligence, BorisMPower, clefourrier)

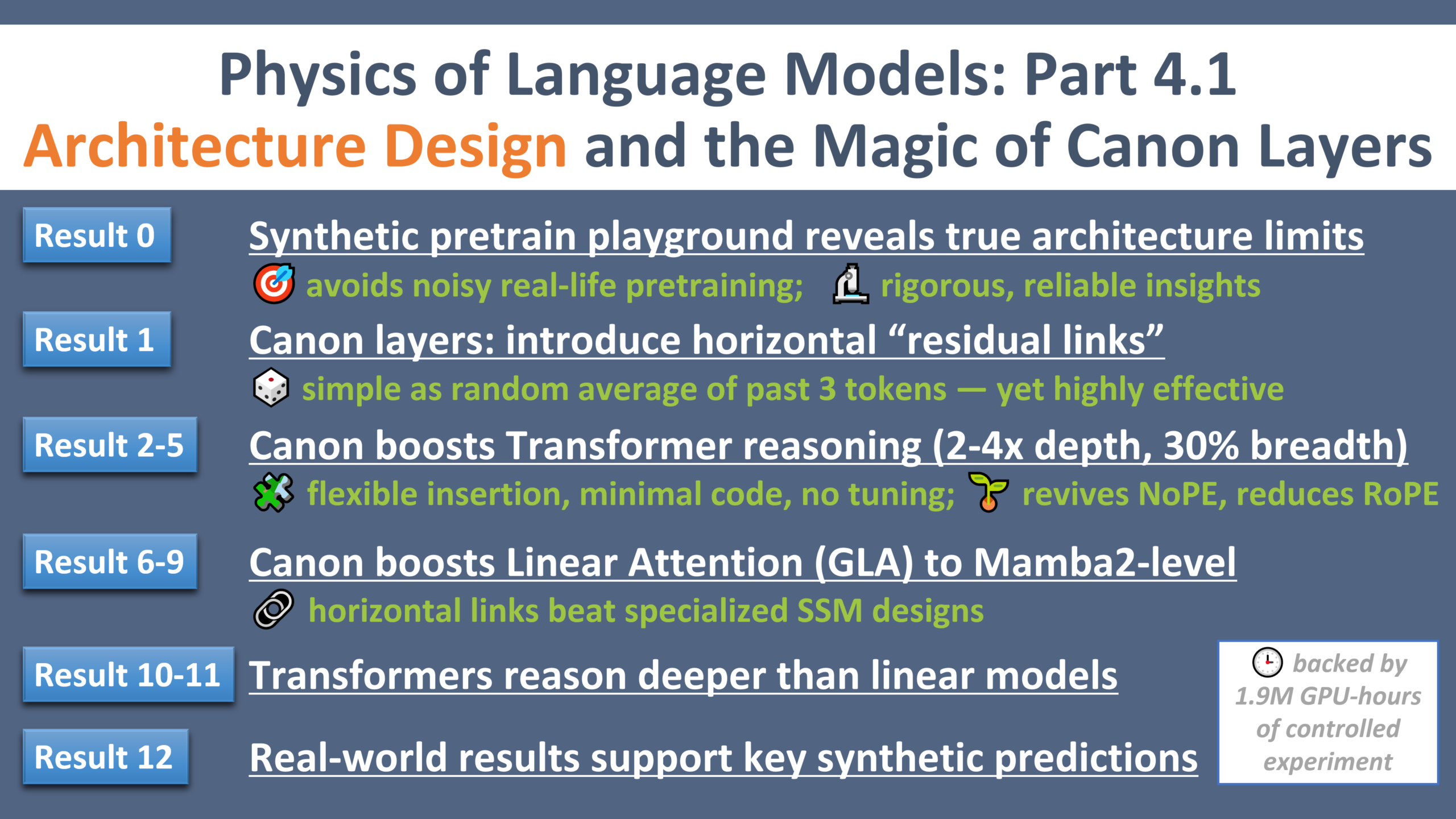

Meta Physics of Language Models, lanzamiento de la cuarta parte: Meta AI Research ha lanzado la cuarta parte de su serie de investigación “Physics of Language Models”. A través de entornos controlados de preentrenamiento sintético, han descubierto un componente ligero llamado “Canon layers” que, al añadir “conexiones residuales horizontales” entre tokens, puede mejorar significativamente la capacidad de razonamiento y generalización de modelos con diversas arquitecturas como Transformer, Mamba y GLA. (Fuente: AIatMeta, arohan)

FlashInfer gana el premio a la mejor publicación en MLSys 2025 y recibe el apoyo de NVIDIA: La publicación sobre el motor de atención eficiente y personalizable FlashInfer, centrado en servicios de inferencia de LLM, ha ganado el premio a la mejor publicación en MLSys 2025. NVIDIA ha anunciado su apoyo al proyecto e integrará los núcleos de inferencia de LLM de vanguardia como TensorRT-LLM en FlashInfer para su uso por parte de vLLM, SGLang y otros, con el objetivo de mejorar la eficiencia y escalabilidad de la inferencia de LLM. (Fuente: vllm_project, _philschmid)

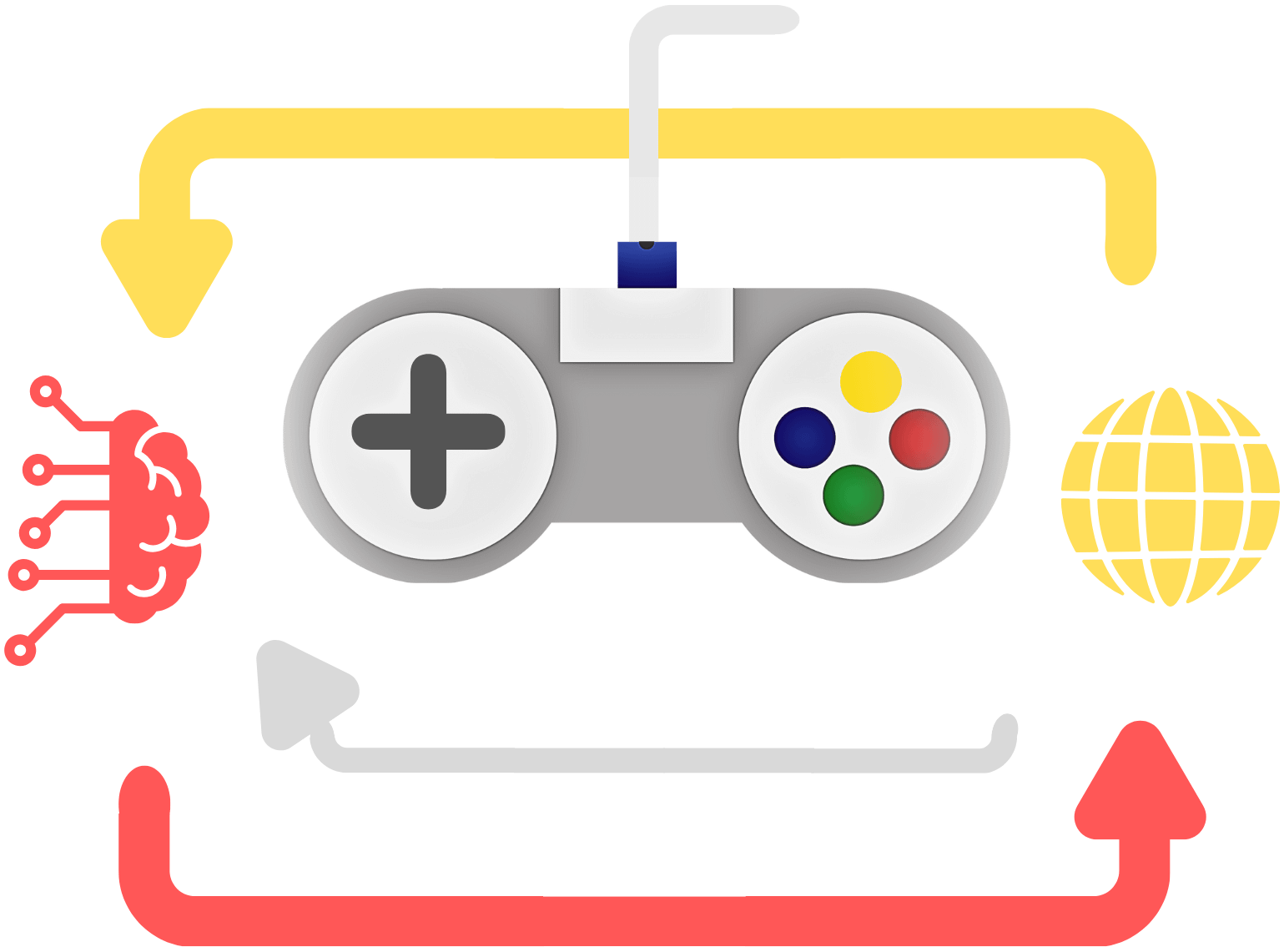

Kunlun Tech lanza el motor de generación de mundos interactivos Matrix-Game: Kunlun Tech ha presentado Matrix-Game, un motor interactivo capaz de generar y controlar mundos virtuales mediante instrucciones de texto. Permite generar diversos escenarios como desiertos y bosques, y logra un control de movimiento fluido para acciones como avanzar, saltar y atacar, así como la conmutación de vista de 360°. Se espera que esta tecnología acelere el desarrollo de juegos, el entrenamiento de inteligencia encarnada y la producción de contenido para el metaverso. (Fuente: WeChat)

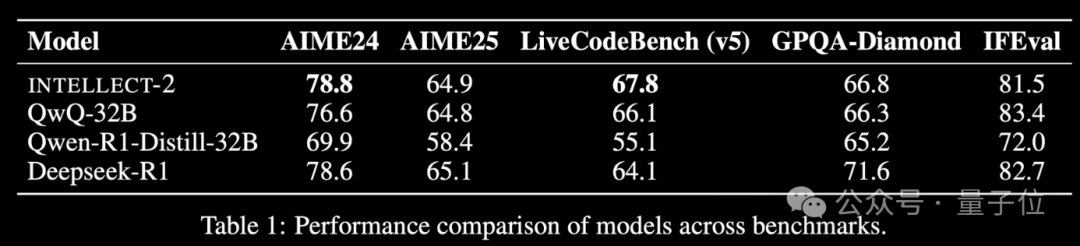

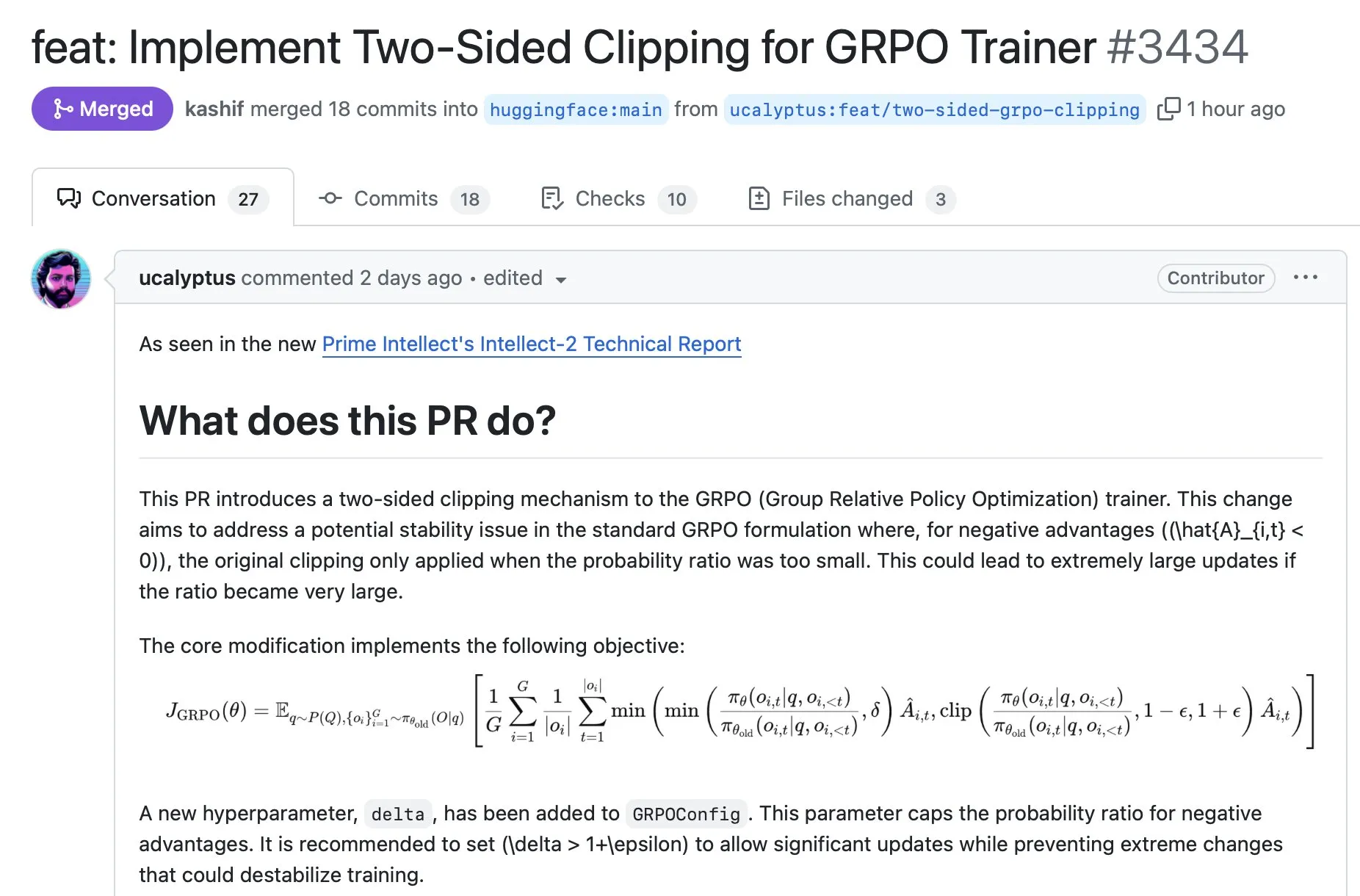

Prime Intellect lanza el modelo de entrenamiento RL distribuido INTELLECT-2: Prime Intellect ha lanzado INTELLECT-2, afirmando que es el primer modelo que utiliza recursos computacionales inactivos globales para el entrenamiento de aprendizaje por refuerzo distribuido, con un rendimiento comparable a DeepSeek-R1. El proyecto tiene como objetivo reducir los costos de entrenamiento de RL, romper la dependencia de la potencia computacional centralizada y ha recibido inversiones de figuras conocidas como Karpathy y Tri Dao. Sus componentes principales (PRIME-RL, SHARDCAST, TOPLOC, Protocol Testnet) son de código abierto. (Fuente: 36氪)

Los pioneros del aprendizaje por refuerzo Andrew Barto y Richard Sutton reciben el Premio Turing: Andrew Barto y Richard Sutton han sido galardonados con el Premio Turing por sus contribuciones fundamentales al campo del aprendizaje por refuerzo (incluido el aprendizaje por diferencia temporal). Su trabajo ha tenido un profundo impacto en la IA y se ha reflejado en proyectos como AlphaGo. Ambos planean utilizar parte del premio para apoyar la libertad de investigación de jóvenes científicos y establecer becas de posgrado. (Fuente: WeChat)

Nuevo Papa nombra la revolución de la IA, zar de la IA predice crecimiento de un millón de veces en cuatro años: El recién elegido Papa León XIV ha declarado que su nombre responde en parte a los desafíos que la “nueva revolución industrial” impulsada por la IA plantea a la dignidad humana, la justicia y el trabajo, mostrando la preocupación de la Iglesia por la ética de la IA. Por su parte, David Sacks, el primer “zar de la IA y las criptomonedas” de EE. UU., predice que, debido a los avances exponenciales en modelos, chips y potencia computacional, la capacidad de la IA crecerá un millón de veces en cuatro años, enfatizando la importancia de comprender el crecimiento exponencial y su impacto disruptivo. (Fuente: WeChat)

🎯 Tendencias

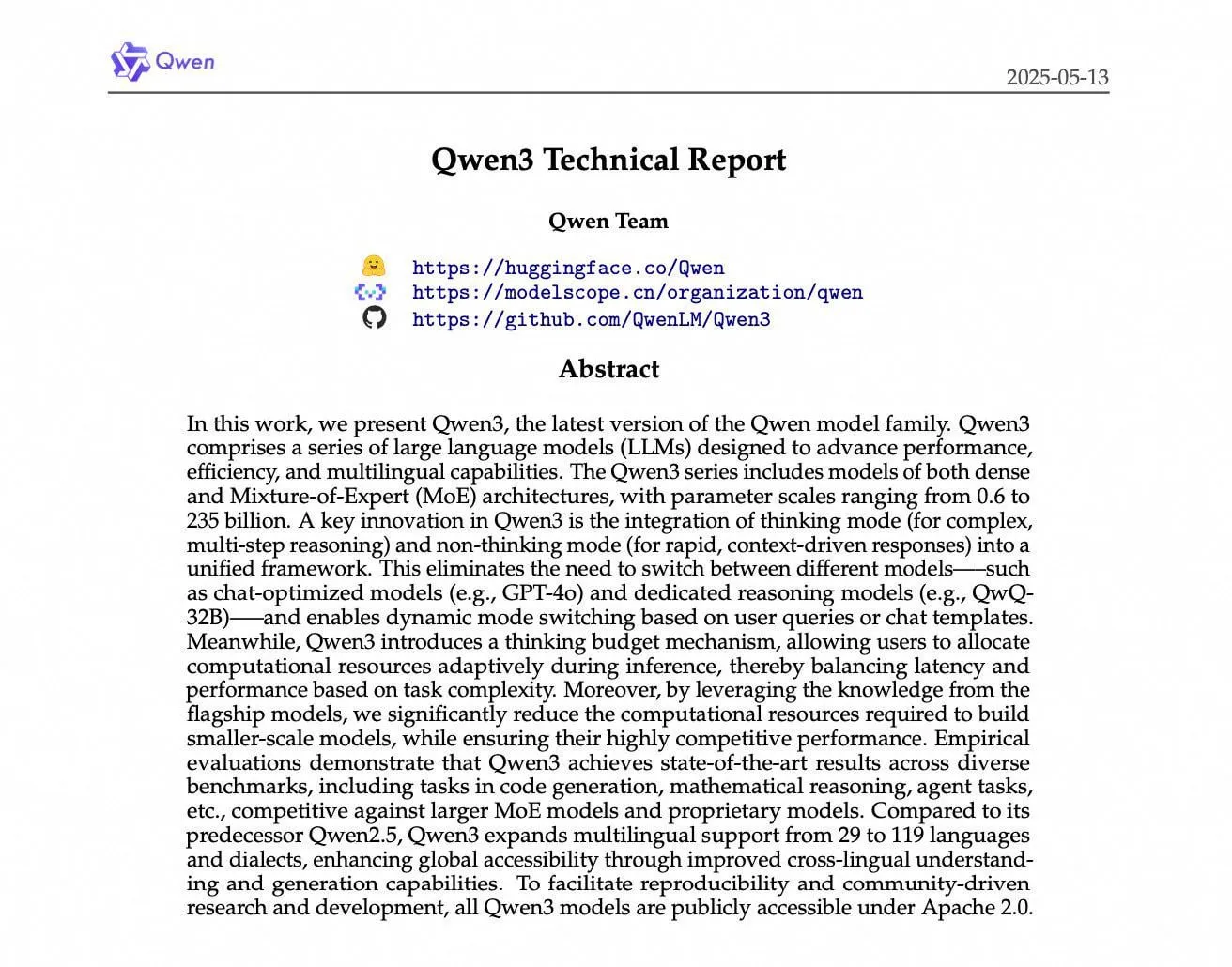

Informe técnico de Alibaba Qwen3 revela detalles de entrenamiento: Alibaba Cloud ha publicado el informe técnico de Qwen3, detallando su proceso de entrenamiento en 36 billones de tokens, incluida una inversión masiva de datos en modelos pequeños y post-entrenamiento en múltiples etapas (como CoT, RL). El modelo muestra un rendimiento excelente en benchmarks como MathArena, pero las discusiones de la comunidad también señalan un bug en su plantilla de chat y que su rendimiento en tareas no relacionadas con el razonamiento es inferior al de Mistral Medium 3. (Fuente: cognitivecompai, rishdotblog, Dorialexander, teortaxesTex, qtnx_, nrehiew_, Reddit r/LocalLLaMA)

El Congreso de EE. UU. considera suspender la regulación estatal de la IA durante diez años: Un borrador de texto del Comité de Comercio de la Cámara de Representantes de EE. UU. incluye una propuesta que sugiere suspender la regulación de la IA por parte de los estados durante diez años para evitar que una maraña de regulaciones estatales obstaculice la innovación en IA. Esta medida ha recibido el apoyo de algunos funcionarios estatales, quienes creen que la regulación de la IA debe ser a nivel federal. (Fuente: ylecun, pmddomingos, jd_pressman, Reddit r/artificial)

Los asistentes de codificación evolucionan hacia agentes “siempre activos”: Los asistentes de codificación están pasando de ser programadores emparejados que requieren muchas indicaciones y asistencia humana, a ser agentes “siempre activos” que buscan continuamente bugs y vulnerabilidades en segundo plano. (Fuente: steph_palazzolo)

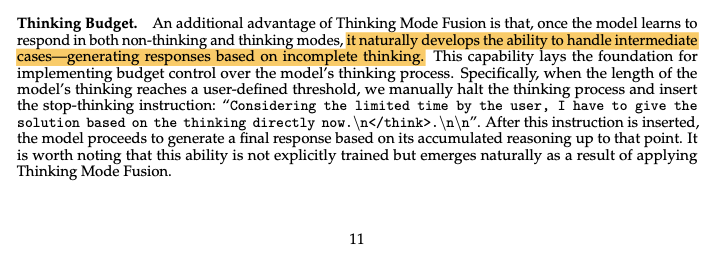

Surgen nuevos conceptos en el campo de la IA: Han aparecido varios conceptos nuevos en el campo de la investigación de la IA, incluyendo “Continuous Thought Machines” de SakanaAI (enfatizando el factor tiempo), “Elastic Reasoning” de Salesforce (separando las etapas de pensamiento y resolución), “ZeroSearch” de Alibaba (utilizando LLM como un motor de búsqueda simulado) y “Absolute Zero” de la Universidad de Tsinghua (aprendizaje completamente a través de auto-juego). (Fuente: TheTuringPost)

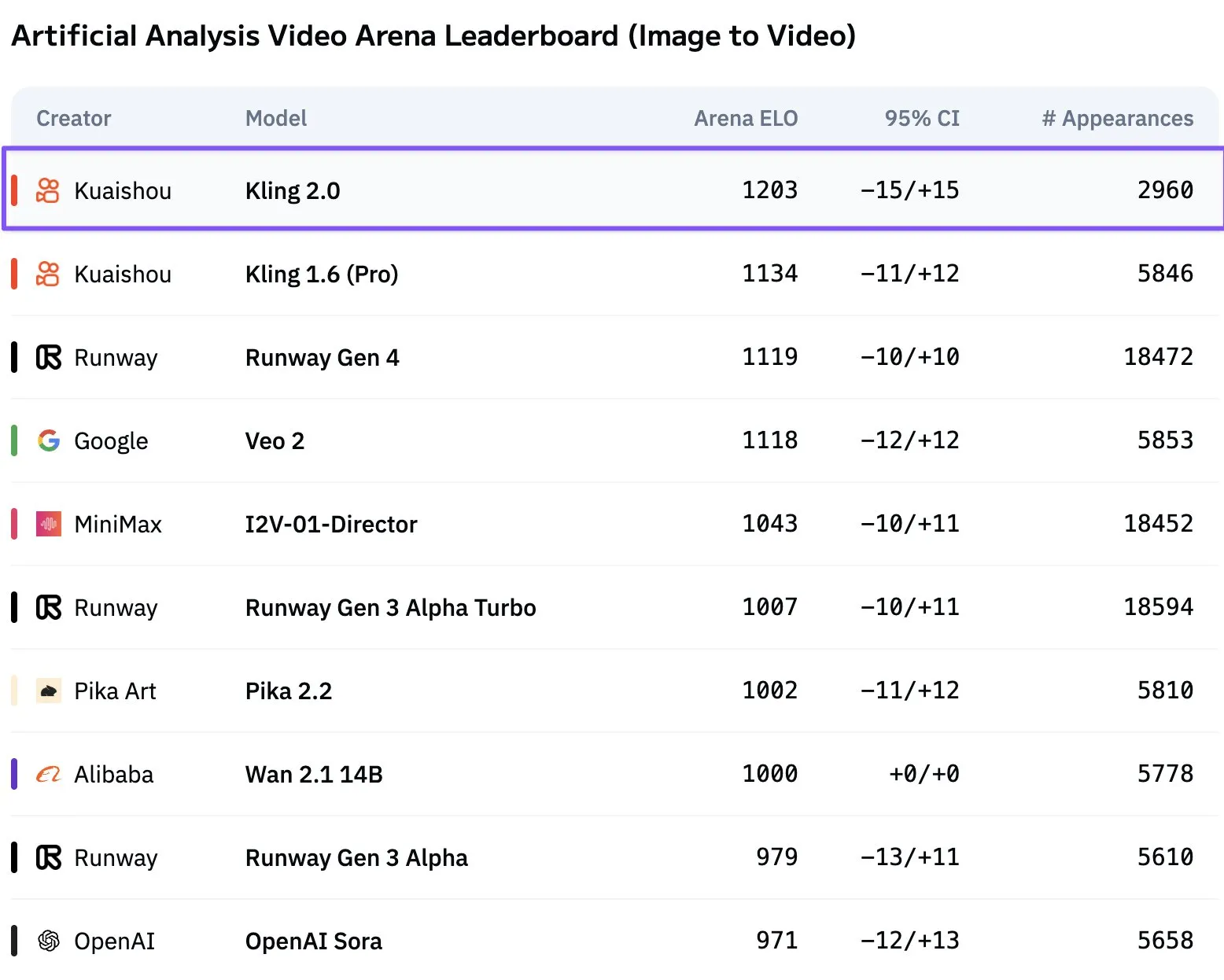

El modelo de video Kuaishou Kling 2.0 alcanza la cima: Kling 2.0, lanzado por Kuaishou, ha superado a Veo 2 y Runway Gen 4 en el ranking de generación de video de Artificial Analysis, convirtiéndose en el modelo líder de texto a video. Los usuarios de la comunidad han reconocido su rendimiento. (Fuente: scaling01)

OpenAI GPT-4.1 lidera las pruebas de preferencia del usuario frente a Claude 3.5 Sonnet: Las pruebas de preferencia del usuario muestran que GPT-4.1 de OpenAI (e incluso 4.1-mini) supera a Claude 3.5 Sonnet en experiencia de usuario. (Fuente: imjaredz)

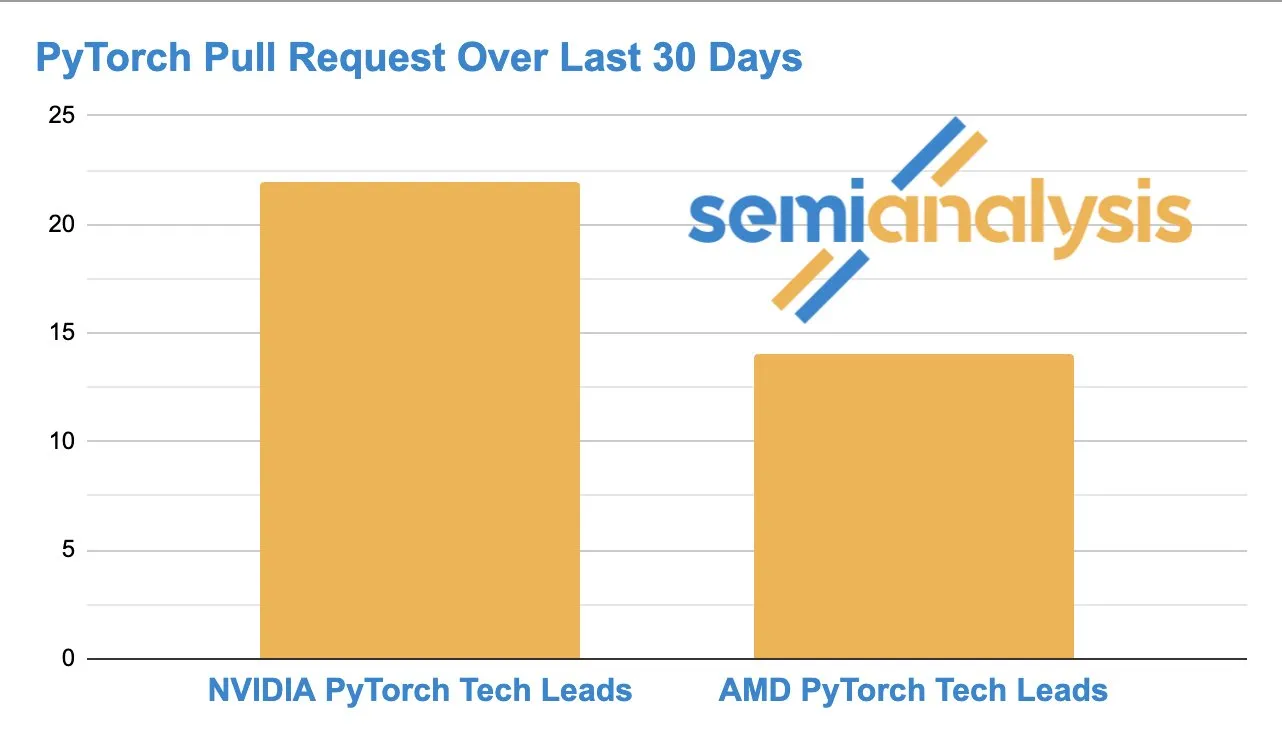

Aumenta la competencia entre AMD y NVIDIA en el desarrollo de software de IA: La actividad en GitHub muestra que el equipo de ROCm PyTorch de AMD está alcanzando al líder técnico de PyTorch de NVIDIA en cuanto a la cantidad de Pull Requests enviadas, lo que indica una competencia creciente en el desarrollo de hardware y software de IA de bajo nivel. (Fuente: zacharynado)

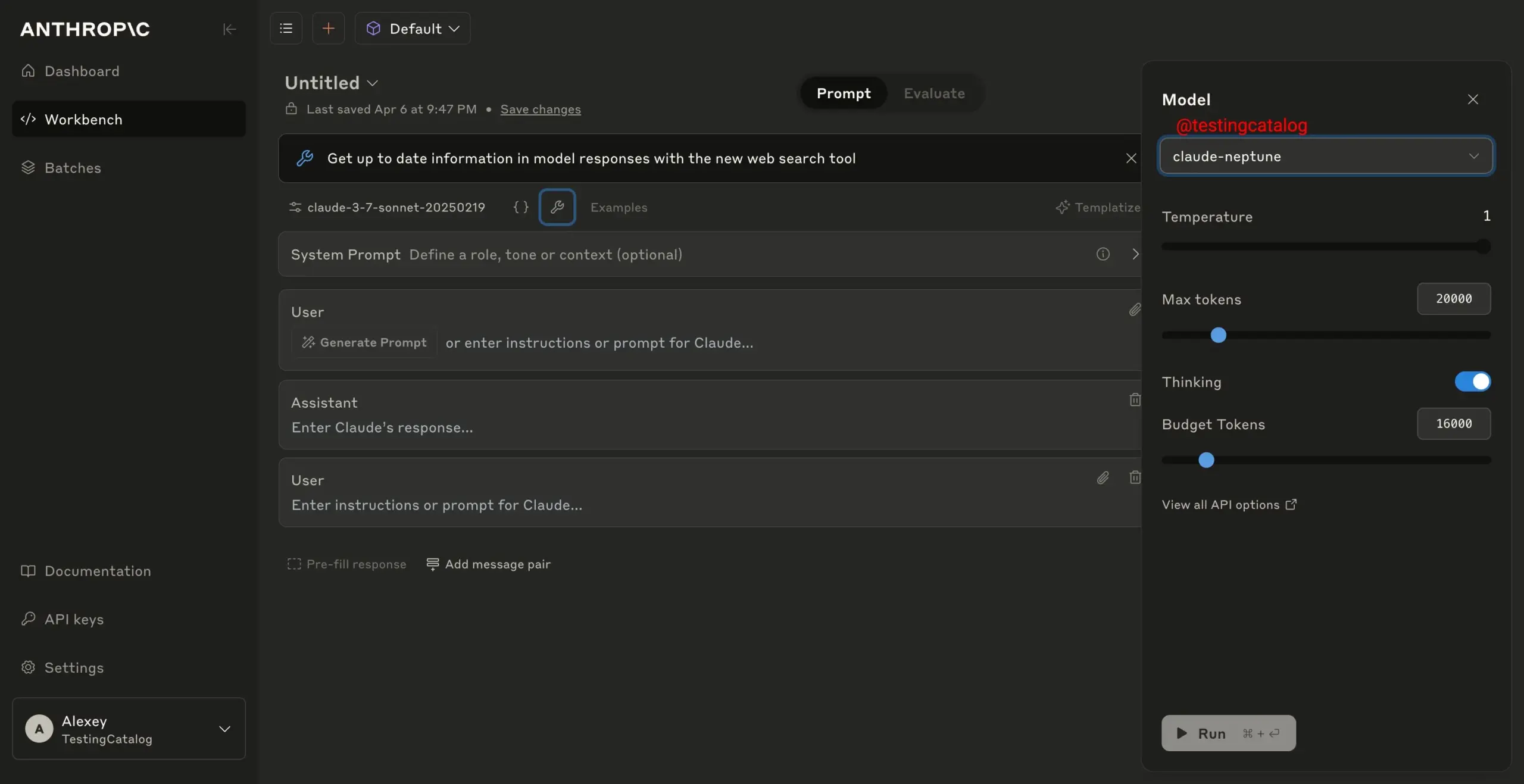

Anthropic está realizando pruebas de seguridad en su nuevo modelo “claude-neptune”: Se informa que Anthropic está realizando pruebas de seguridad en su nuevo modelo “claude-neptune”, lo que sugiere un posible lanzamiento inminente de un nuevo modelo. (Fuente: scaling01)

El acceso gratuito a la API de Gemini 2.5 Pro se suspende debido a la alta demanda: Debido a la enorme demanda, Google ha suspendido temporalmente el acceso a la capa gratuita de Gemini 2.5 Pro a través de la API para garantizar que los desarrolladores puedan seguir escalando sus aplicaciones. El modelo sigue estando disponible de forma gratuita en Google AI Studio. (Fuente: matvelloso)

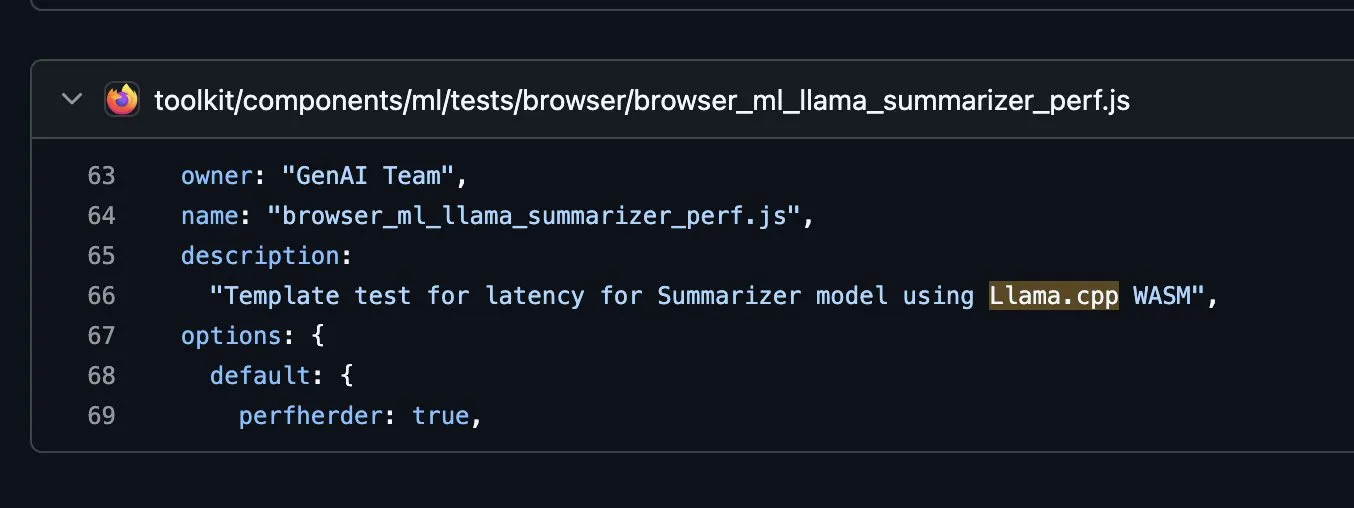

Firefox explora la integración de llama.cpp en WASM: Firefox está experimentando en GitHub con la integración de la biblioteca llama.cpp en WebAssembly (WASM), lo que podría significar que en el futuro los usuarios podrán ejecutar LLM locales directamente en el navegador. (Fuente: ClementDelangue, ggerganov)

Benchmarks de LLM en AMD Ryzen AI Max+ PRO 395: Los benchmarks de LLM en Linux para el AMD Ryzen AI Max+ PRO 395 sugieren que su rendimiento parece ser inferior al de la RTX 4060 Ti. Las discusiones de la comunidad señalan que las pruebas pueden reflejar solo el rendimiento de la CPU y debaten el rendimiento de su iGPU, las ventajas de la VRAM y los problemas de compatibilidad actuales de las GPU de Intel con FP8, Flash Attention y la asignación de memoria. (Fuente: Reddit r/LocalLLaMA)

🧰 Herramientas

Lanzamiento del protocolo de código abierto Minions Secure Chat para chat LLM cifrado en la nube: Se ha lanzado un protocolo de código abierto llamado “Minions Secure Chat”, diseñado para permitir chats LLM en la nube cifrados de extremo a extremo con una sobrecarga de latencia muy baja (<1%), incluso para modelos con más de 30B de parámetros. El protocolo garantiza que el proveedor de servicios en la nube no pueda ver el contenido de los mensajes, y la inferencia se realiza en enclaves de GPU seguros, garantizando la confidencialidad. (Fuente: realDanFu, ollama, rebeccatqian, code_star)

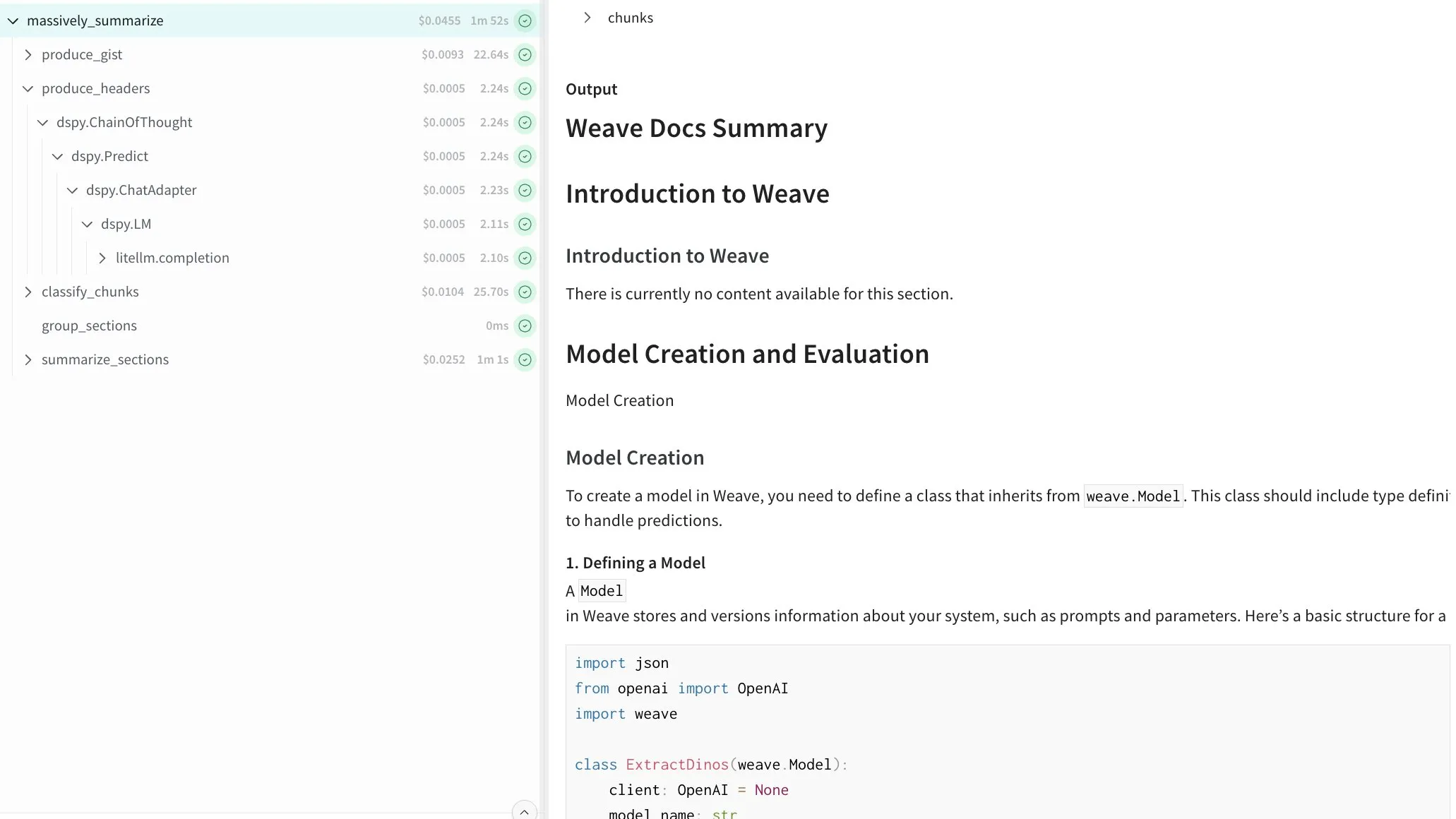

DSPy permite la sumarización recursiva de texto de longitud arbitraria: Se ha mostrado un programa construido con DSPy que es capaz de sumarizar recursivamente texto de longitud arbitraria. El programa logra esto construyendo un índice, dividiendo el contenido en chunks y procesando las partes en paralelo, ofreciendo una solución general para manejar documentos largos. (Fuente: lateinteraction)

Runway AI Video Generation añade controles cinematográficos y funciones de referencia: Runway ha lanzado nuevas funciones en su modelo de generación de video Gen-4, incluyendo más de 20 controles de cámara de nivel cinematográfico, referencia y fusión de múltiples elementos, y un manejo más fluido de movimientos complejos. Las funciones de referencia mejoradas también han mejorado la precisión en la colocación de objetos. (Fuente: c_valenzuelab, TomLikesRobots)

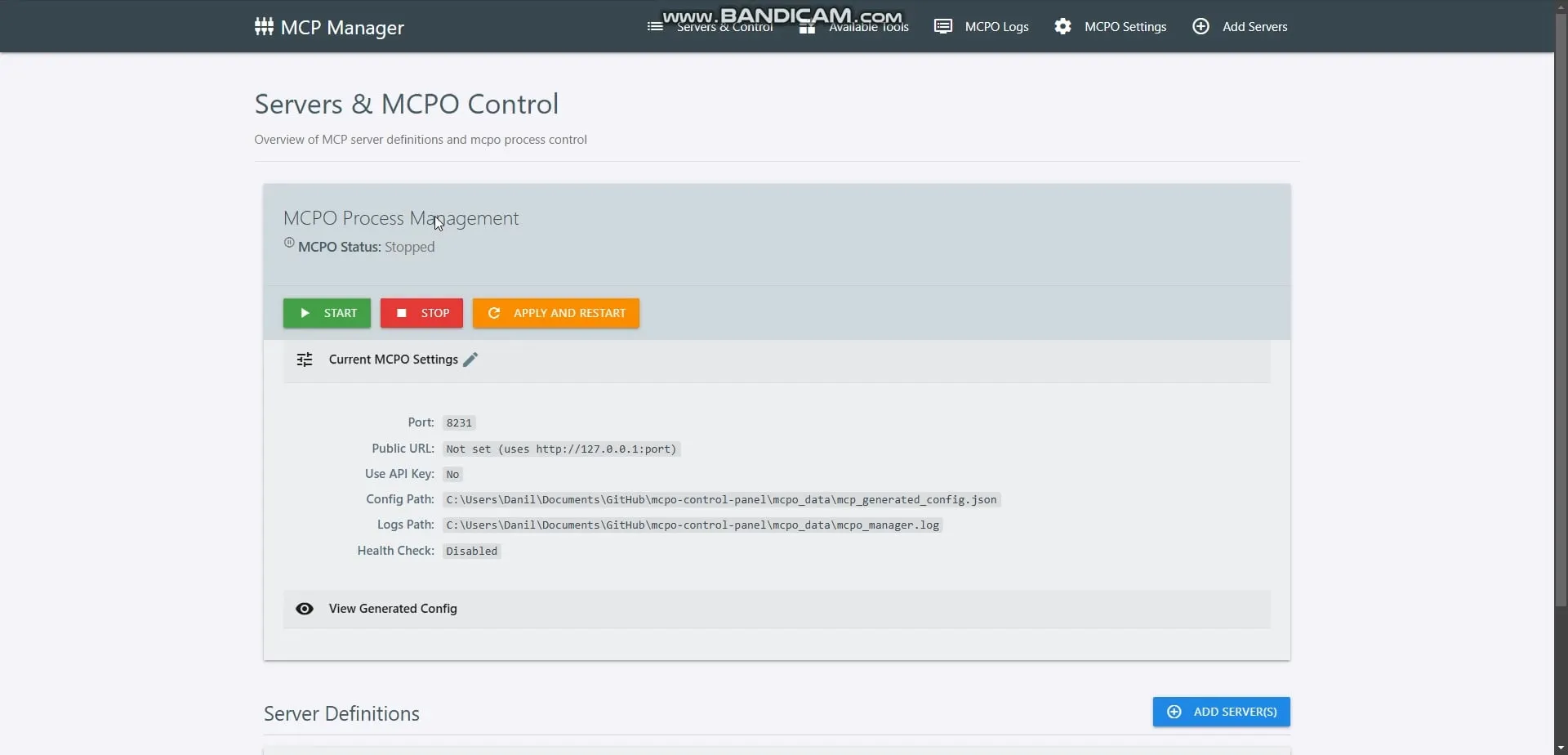

Lanzamiento de OpenMemory MCP, proporciona memoria privada local para agentes de IA: Se ha lanzado OpenMemory MCP, una capa de memoria privada, local y persistente diseñada para clientes de IA compatibles con MCP (como Cursor, Claude Desktop). Permite que diferentes herramientas de IA lean y escriban de forma segura y privada en una memoria compartida, ejecutándose completamente en la máquina del usuario sin depender de servicios en la nube. (Fuente: omarsar0)

HeyGen lanza la función Voice Mirroring: HeyGen ha lanzado la función Voice Mirroring, que permite a los usuarios replicar un estilo o característica de voz específica en el audio generado por IA. (Fuente: Ronald_vanLoon)

Lanzamiento del framework de código abierto Step1X-3D para la generación controlable de activos 3D: StepFun AI ha lanzado Step1X-3D en Hugging Face, un framework de código abierto para la generación de activos 3D con textura, de alta fidelidad y controlables. (Fuente: huggingface, _akhaliq, reach_vb)

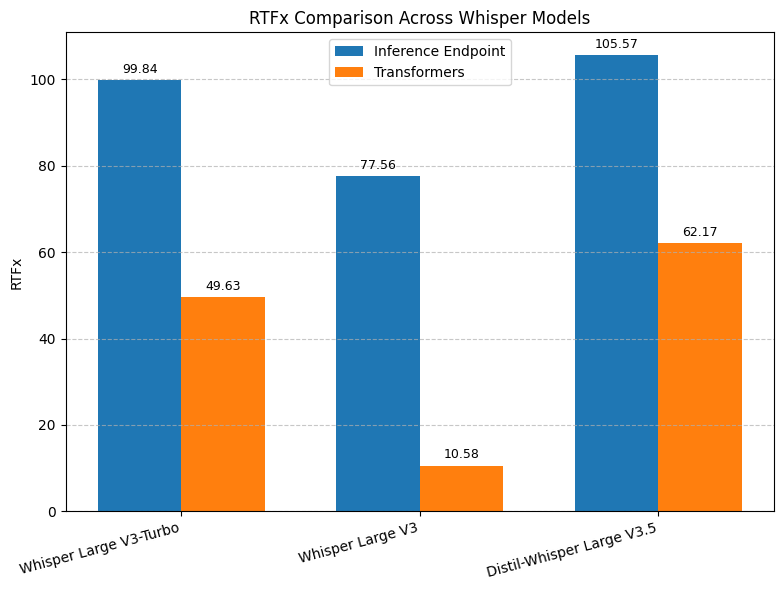

Aumento de la velocidad de transcripción de Hugging Face Whisper: Hugging Face ha lanzado un endpoint de transcripción de Whisper basado en vLLM y optimizado para GPU de NVIDIA, logrando un aumento de velocidad de hasta 8 veces, ofreciendo un mejor rendimiento a un menor costo. (Fuente: ClementDelangue, huggingface, vllm_project)

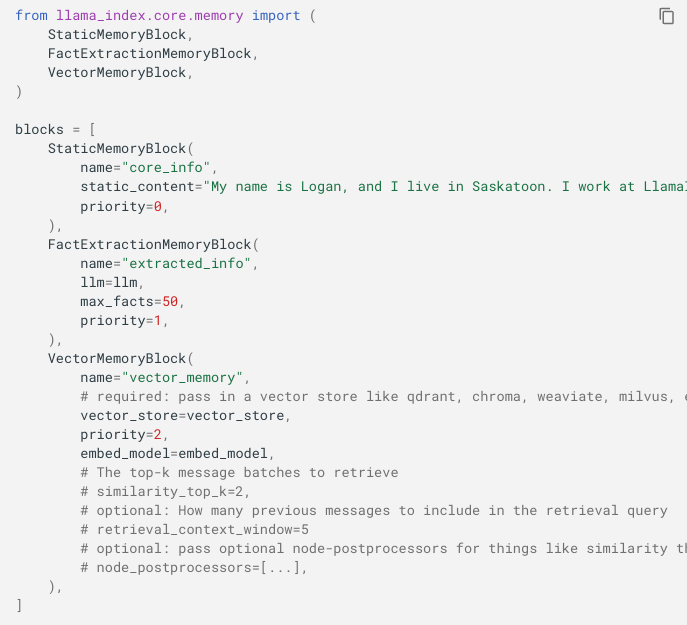

Actualización de la API de memoria de LlamaIndex, soporta fusión de memoria a corto y largo plazo: LlamaIndex ha actualizado su API de memoria para hacerla más flexible, fusionando el historial de chat a corto plazo y la memoria a largo plazo a través de módulos conectables (estático, extracción de hechos, memoria vectorial). (Fuente: jerryjliu0)

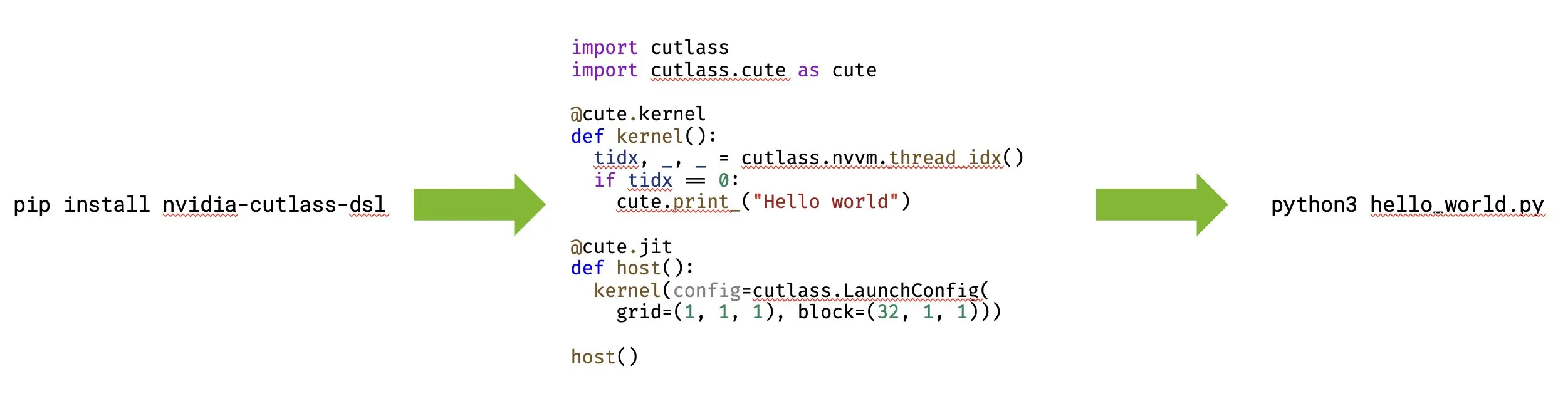

NVIDIA lanza CUTLASS 4.0, soporta programación nativa de GPU en Python: NVIDIA ha lanzado CUTLASS 4.0, una biblioteca que soporta programación nativa de GPU en Python. Esta actualización tiene como objetivo acelerar el desarrollo de kernels y la exploración de nuevas ideas en los campos de ML y programación de GPU. (Fuente: marksaroufim, tri_dao)

Proyecto de código abierto WeClone, crea gemelos digitales a partir de historiales de chat: Un popular proyecto de código abierto en GitHub, WeClone, ofrece una solución para crear gemelos digitales a partir de historiales de chat de WeChat. Permite ajustar modelos de lenguaje grandes para capturar el estilo de conversación personal y vincularlos a chatbots en WeChat, QQ, Telegram, etc., incluyendo también funciones de filtrado de privacidad. (Fuente: GitHub Trending)

Herramienta de código abierto Google Maps Scraper, extrae datos de mapas: Una popular herramienta de código abierto en GitHub para extraer datos de listados de Google Maps. Proporciona interfaces de línea de comandos, UI web y API REST, puede extraer nombres de negocios, direcciones, información de contacto, calificaciones, reseñas, etc., y soporta extracción de correos electrónicos y un “modo rápido”. (Fuente: GitHub Trending)

Usuarios de OpenWebUI reportan varios problemas técnicos: Los usuarios de OpenWebUI han reportado varios problemas técnicos, incluyendo que los parámetros de Modelfile (como num_ctx) son ignorados causando fallos, incapacidad para acceder a la UI en la red local después de una actualización, incapacidad para usar la búsqueda web integrada de OpenAI con modelos específicos, y problemas de tiempo de espera en sesiones de chat antiguas. (Fuente: Reddit r/OpenWebUI)

Robot de inspección de superficies ferroviarias: Se menciona un robot multifuncional llamado RailScan, utilizado para trabajos de inspección de superficies ferroviarias, un ejemplo de la aplicación de la IA y la robótica en la industria. (Fuente: Ronald_vanLoon)

Robot de construcción con impresión 3D: La tecnología de impresión 3D se está combinando con la robótica para aplicaciones en la construcción, como la construcción con impresión 3D, lo que representa avances en la automatización de la construcción mediante robots e IA. (Fuente: Ronald_vanLoon)

Robots de inteligencia encarnada: Se mencionan robots autónomos impulsados por IA capaces de navegar sin problemas en entornos complejos y ejecutar tareas con precisión, mostrando el potencial de la inteligencia encarnada y la robótica en aplicaciones del mundo real. (Fuente: Ronald_vanLoon)

Robots bioinspirados: Se menciona una investigación sobre hongos a los que se les dio cuerpos robóticos y aprendieron a gatear, demostrando cómo la inspiración biológica puede impulsar el desarrollo de la robótica. (Fuente: Ronald_vanLoon)

📚 Aprendizaje

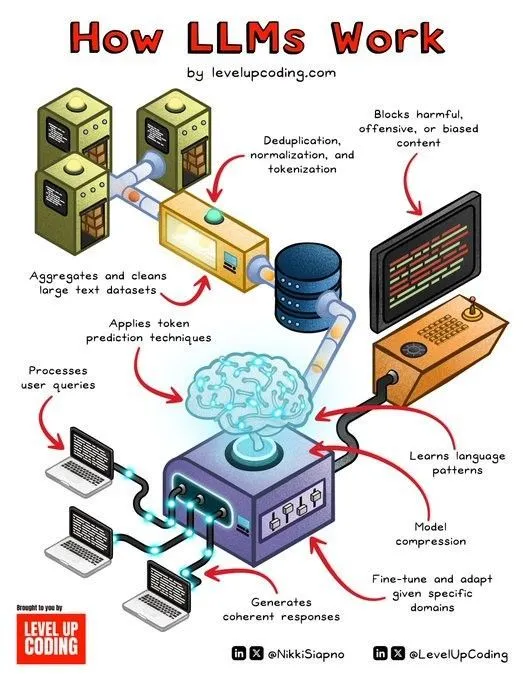

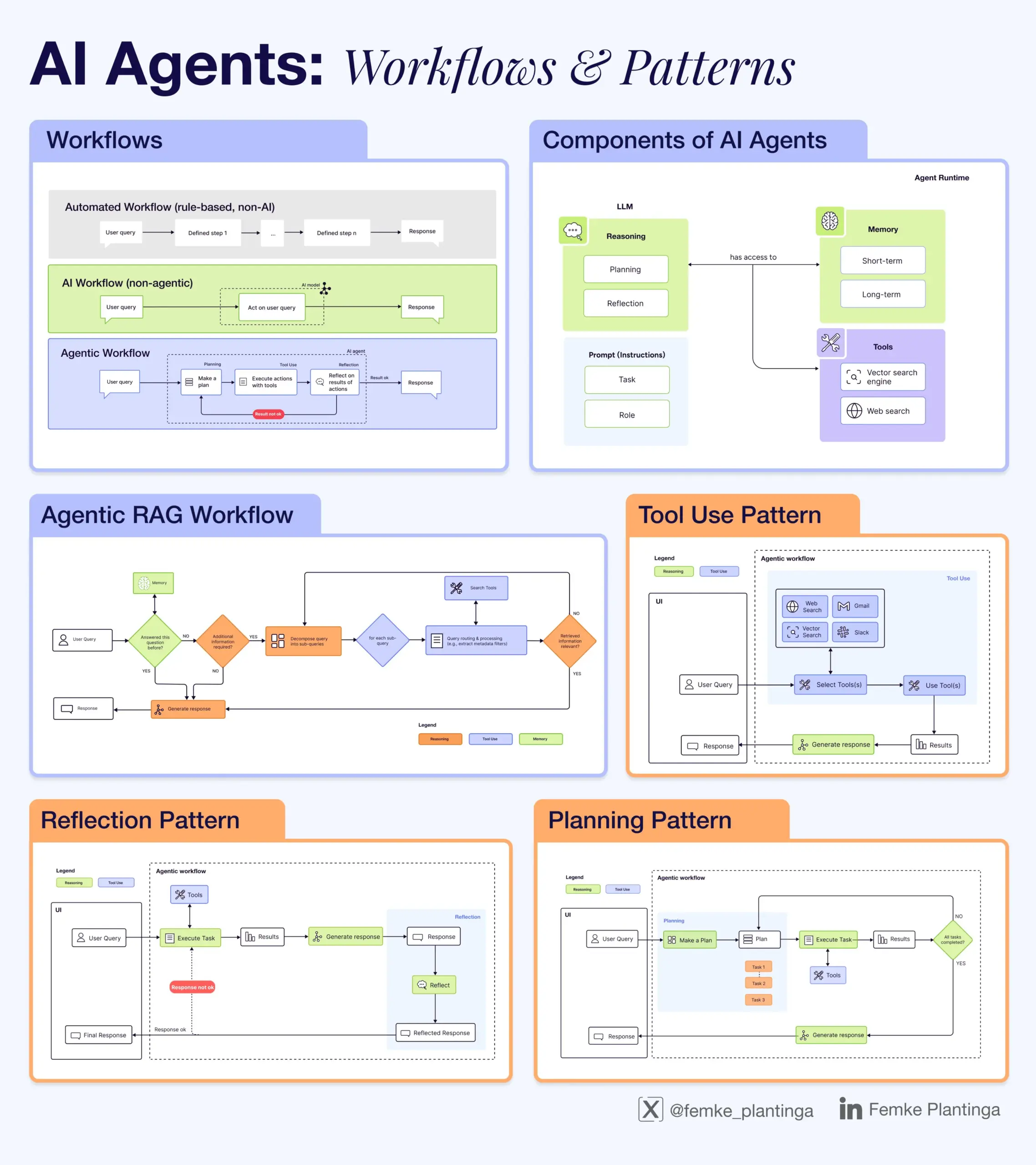

Colección de recursos de aprendizaje de IA: La comunidad ha compartido varios recursos de aprendizaje de IA, incluyendo comentarios positivos sobre los recursos de @dair_ai, masterclasses en línea y talleres de libros sobre evaluación de IA, una guía en video para inferencia de LLM, una explicación de la diferencia entre Agentic AI y la IA convencional, un libro gratuito sobre RLHF, un módulo de curso de análisis de datos sobre procesamiento de datos y depuración con GenAI, un evento sobre inteligencia de código con IA, y una infografía que explica cómo funcionan los LLM. (Fuente: dair_ai, HamelHusain, omarsar0, bobvanluijt, natolambert, DeepLearningAI, l2k, Ronald_vanLoon, Reddit r/deeplearning, Reddit r/artificial)

Evento y talleres LangChain Interrupt: LangChain organizó el evento Interrupt, que incluyó talleres sobre la construcción de agentes de IA confiables. El contenido cubrió el diseño de flujos de trabajo de agentes utilizando LangGraph, la colaboración humano-IA y el uso de LangSmith para la observabilidad y evaluación. Cisco mostró su agente de texto a SQL construido con LangGraph y LangSmith. (Fuente: LangChainAI, hwchase17)

Anuncio del taller RL y videojuegos: La conferencia RLC 2025 organizará un taller sobre aprendizaje por refuerzo y videojuegos, solicitando publicaciones sobre temas relacionados con RL en juegos como entornos complejos, escenarios multi-agente y generación de contenido, y ha anunciado los oradores confirmados. (Fuente: Reddit r/MachineLearning)

El repositorio GitHub mlabonne/llm-course ofrece una ruta de aprendizaje completa de LLM: Un popular repositorio de GitHub, mlabonne/llm-course, proporciona un curso y una ruta de aprendizaje completa de LLM, cubriendo los fundamentos, la ciencia de LLM (fine-tuning, cuantización, evaluación) y la ingeniería de LLM (ejecución, RAG, despliegue, seguridad), e incluye notas de código y referencias relevantes. (Fuente: GitHub Trending)

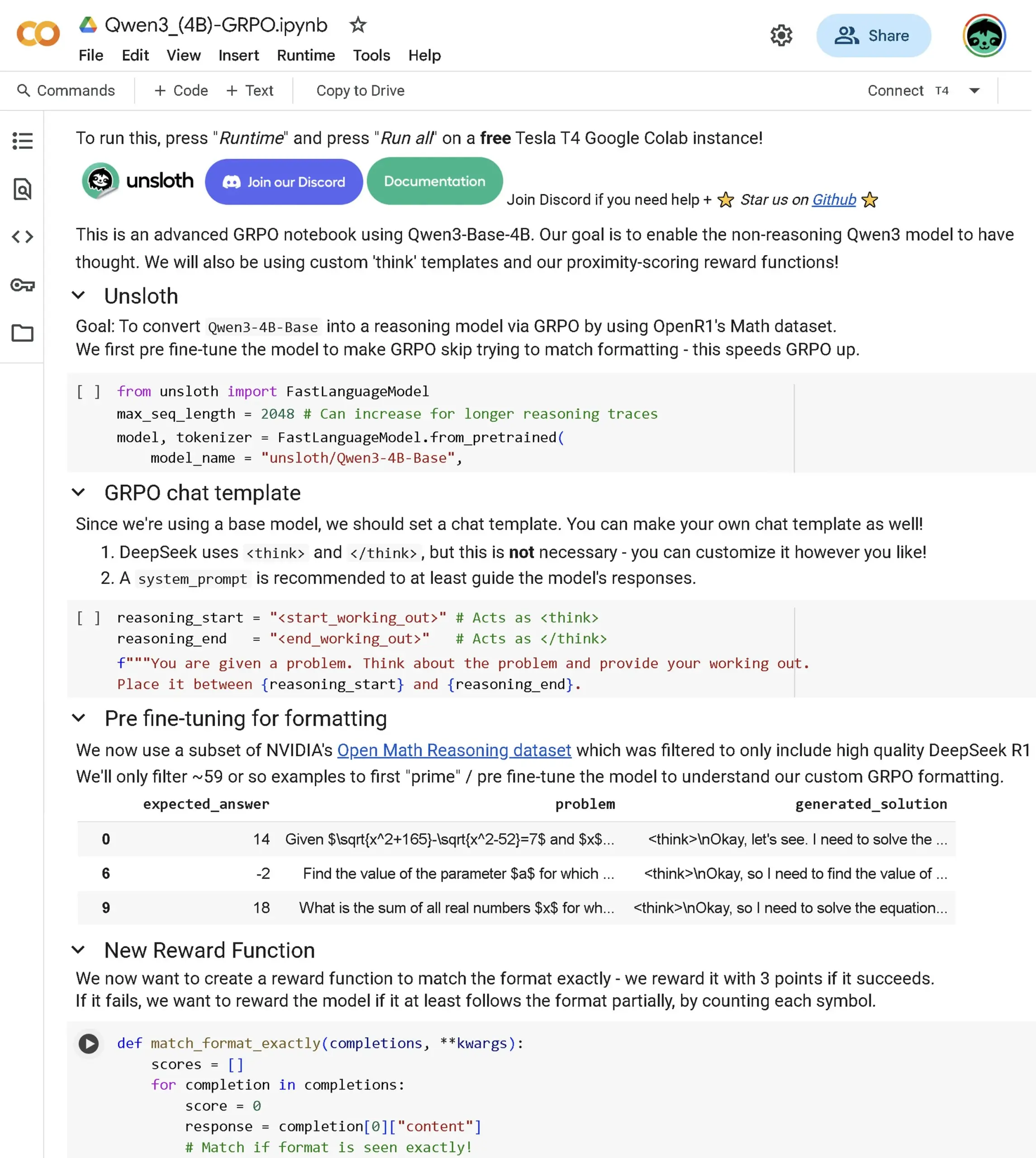

Lanzamiento del cuaderno avanzado Qwen3 Base GRPO: Se ha lanzado un nuevo cuaderno avanzado de GRPO (Optimización Generalizada de Políticas) específicamente para el modelo Qwen3 Base. El contenido cubre cómo realizar fine-tuning en el modelo para mejorar las capacidades de razonamiento, puntuación de proximidad, plantilla GRPO, el conjunto de datos OpenR1 y la optimización del proceso de RL a través del pre-fine-tuning. (Fuente: danielhanchen)

La biblioteca TRL integra técnicas de estabilización de GRPO: Una nueva técnica de estabilización de GRPO desarrollada por Prime Intellect ha sido integrada en la popular biblioteca Transformer Reinforcement Learning (TRL). Se puede usar instalando la última versión y tiene como objetivo mejorar la estabilidad del entrenamiento de GRPO. (Fuente: ClementDelangue)

💼 Negocios

Perplexity AI cerca de cerrar una ronda de financiación de 500 millones de dólares, valorada en 14 mil millones de dólares: La startup de búsqueda con IA, Perplexity AI, según se informa, está a punto de cerrar una ronda de financiación de 500 millones de dólares liderada por Accel, valorando la empresa en 14 mil millones de dólares. Esto demuestra que, a pesar de la competencia de Google y OpenAI, Perplexity ha obtenido un fuerte apoyo de capital. (Fuente: TheRundownAI, Reddit r/ClaudeAI, 36氪)

NVIDIA colabora con Arabia Saudita para construir una “fábrica de IA”: NVIDIA ha anunciado una colaboración con HUMAIN, la subsidiaria de IA del Fondo de Inversión Pública de Arabia Saudita, para planificar la construcción de una “fábrica de IA” en Arabia Saudita. NVIDIA proporcionará infraestructura y experiencia para ayudar a Arabia Saudita a convertirse en un líder global en IA. (Fuente: nvidia)

El equipo de WizardLM deja Microsoft y se une a Tencent Hunyuan: El equipo de WizardLM, incluido su líder Can Xu, ha dejado Microsoft y se ha unido a Tencent Hunyuan. Anteriormente, el modelo Tencent Hunyuan-Turbos ocupaba un lugar destacado en los rankings (8º). Este movimiento de talento ha provocado discusiones sobre la competencia por el talento entre los grandes laboratorios de IA. (Fuente: andrew_n_carr, cognitivecompai, teortaxesTex, Sentdex, WizardLM_AI, madiator)

Johnson & Johnson aplica ampliamente la IA generativa en su negocio farmacéutico: Después de realizar aproximadamente 900 experimentos internos, Johnson & Johnson ha extendido la aplicación de su IA generativa a múltiples etapas de su negocio farmacéutico, incluyendo la aceleración del descubrimiento de fármacos, la predicción de riesgos en la cadena de suministro, la simplificación de ensayos clínicos y el apoyo a ventas y servicios para empleados. (Fuente: DeepLearningAI)

Somite AI recauda fondos para construir un modelo fundacional de células humanas: La empresa Somite AI está construyendo un modelo fundacional para células humanas llamado “DeltaStem” y desarrollando tecnología que puede generar datos de señalización celular más rápidamente. La empresa ha recaudado 5.9 millones de dólares en financiación. (Fuente: saranormous, finbarrtimbers)

🌟 Comunidad

Usuarios insatisfechos con la disminución de la calidad de los modelos de IA y el fenómeno de Sycophancy: Muchos usuarios han expresado su frustración por la disminución de la calidad de los modelos de IA actuales, especialmente ChatGPT, que ha sido acusado de volverse “sycophantic” (excesivamente positivo/adulador), perezoso y de aumentar las alucinaciones. Algunos usuarios están considerando cancelar sus suscripciones, mientras que otros debaten si las instrucciones personalizadas son efectivas o si la insatisfacción en las redes sociales está exagerada. (Fuente: Reddit r/ArtificialInteligence, Reddit r/ChatGPT)

Discusión sobre ética y responsabilidad de la IA: ¿Quién es responsable de los errores de decisión de la IA?: La comunidad debate ampliamente quién debe asumir la responsabilidad cuando las decisiones autónomas de la IA conducen a errores. Las opiniones incluyen que la empresa propietaria de la IA debe ser responsable (similar a los padres con los hijos o los conductores con los vehículos autónomos), que en el futuro la propia IA podría asumir la responsabilidad, que se necesita supervisión humana, y que las empresas que se benefician de la IA deben ser responsables. (Fuente: Reddit r/ArtificialInteligence)

Impacto de la IA en la educación y el empleo: El uso de la IA para calificar por parte de los profesores genera controversia: La discusión sobre el uso de la IA por parte de los profesores para calificar el trabajo de los estudiantes ha generado controversia, con preocupaciones de que esto devalúe a los estudiantes o presagie su potencial obsolescencia. Las opiniones opuestas argumentan que la IA es solo una herramienta que puede proporcionar retroalimentación oportuna y que el propósito de los exámenes es diverso. La comunidad también discute el impacto más amplio de la IA en el empleo y las tareas laborales específicas que los usuarios desearían que la IA asumiera por completo. (Fuente: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Preocupaciones sobre la fiabilidad de los LLM: Mal rendimiento al procesar fuentes de datos específicas: Los usuarios expresan decepción por el rendimiento de los LLM al procesar fuentes de datos específicas y fragmentadas (como documentos legales), donde el contenido de salida suena autoritario pero los hechos son inexactos o vagos. Aunque los LLM funcionan bien en la sumarización general o la codificación, su fiabilidad es cuestionada para tareas que requieren un procesamiento preciso de datos únicos. (Fuente: Reddit r/artificial)

Geopolítica del hardware de IA: Propuesta de senador estadounidense exige geolocalización integrada en GPU de gama alta: Una propuesta de un senador estadounidense exige la integración de funciones de geolocalización en GPU de gama alta (como la RTX 4090) para evitar que sean utilizadas por gobiernos extranjeros. Esto ha generado preocupación en la comunidad sobre la interferencia gubernamental excesiva, la posible capacidad de deshabilitación remota y el DRM de hardware. (Fuente: Reddit r/LocalLLaMA)

Los jóvenes utilizan ChatGPT para ayudar en las decisiones de vida: Sam Altman señala que la generación más joven utiliza cada vez más ChatGPT para ayudar a tomar decisiones de vida. Algunos consideran que esto es positivo (buscar consejo cuando los recursos humanos son insuficientes), pero otros temen la dependencia de LLM potencialmente poco fiables para decisiones cruciales. (Fuente: Reddit r/ChatGPT)

Discusión sobre la percepción y estrategia de la industria de la IA: Las discusiones de la comunidad abarcan opiniones sobre por qué se considera que Meta está rezagada respecto a otros laboratorios de IA importantes, la compensación entre el fine-tuning de modelos pequeños y la ingeniería de prompts, la confidencialidad de las empresas de IA y la opinión de que la “búsqueda” es una ventaja competitiva central para los agentes de IA. (Fuente: Reddit r/MachineLearning, cto_junior, madiator, Dorialexander)

💡 Otros

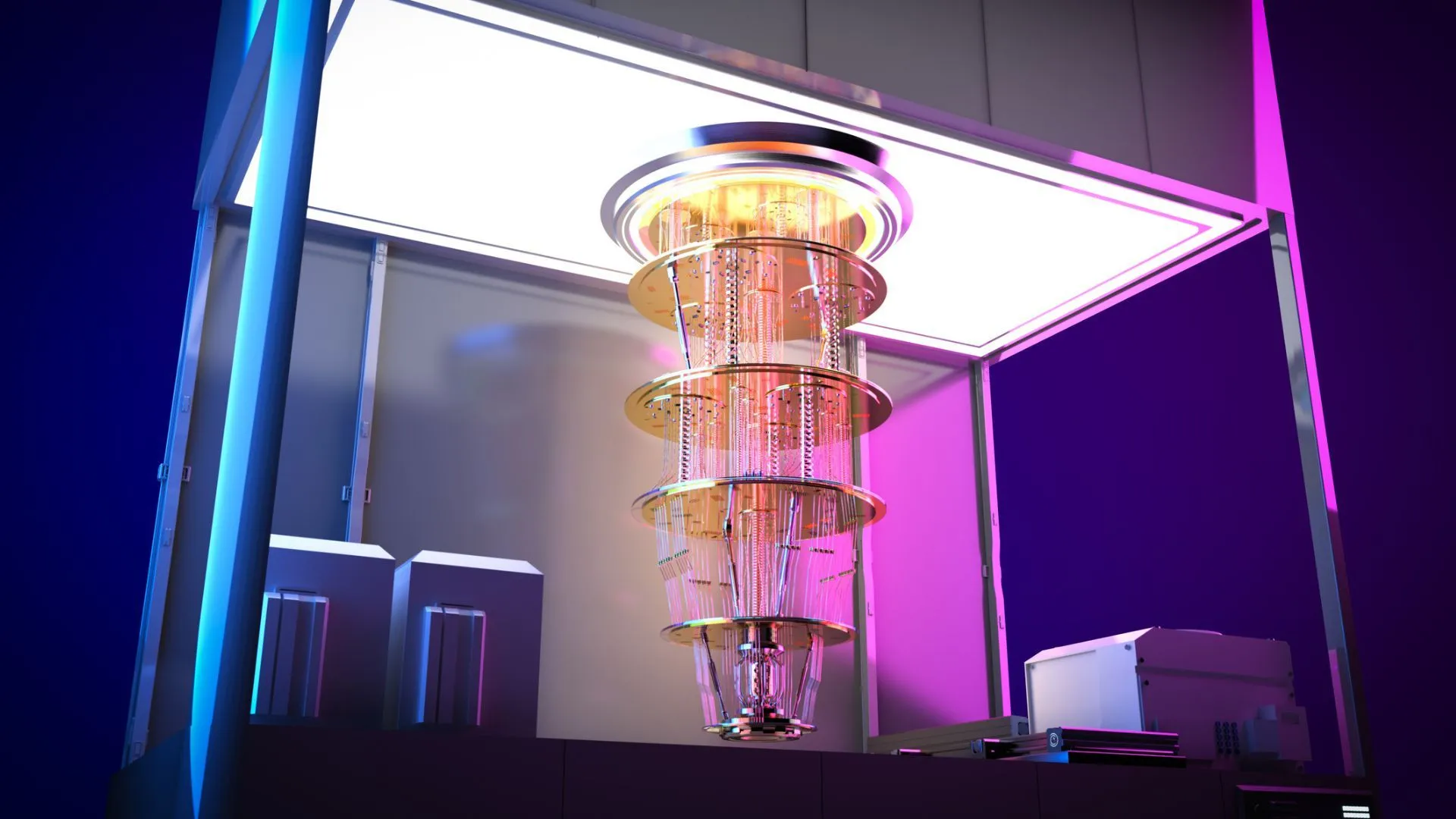

China lanza el sistema de control cuántico de cuarta generación: China ha lanzado su sistema de control cuántico de cuarta generación que soporta más de 500 qubits, lo que representa el último avance en tecnología de computación cuántica. (Fuente: Ronald_vanLoon)

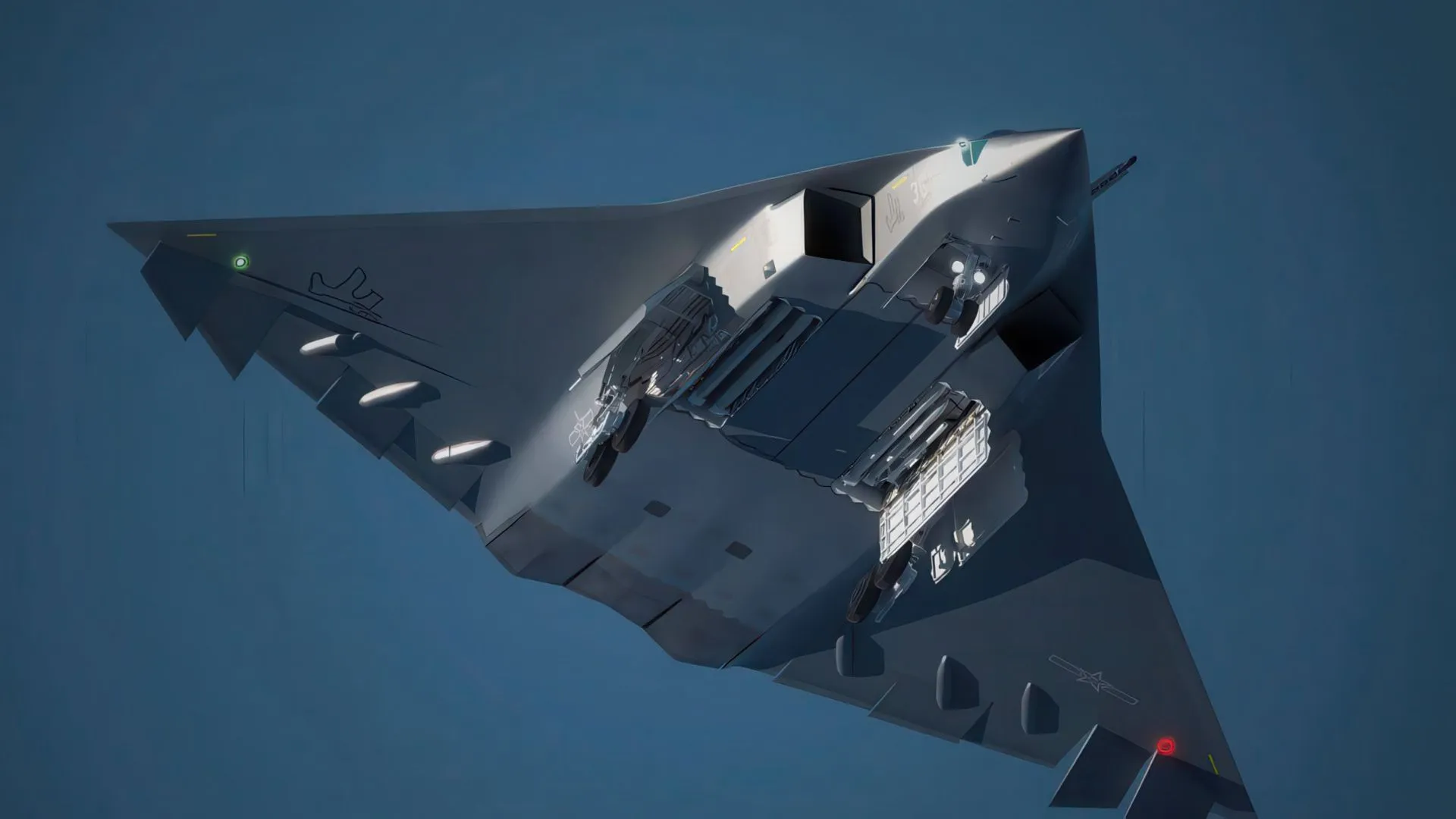

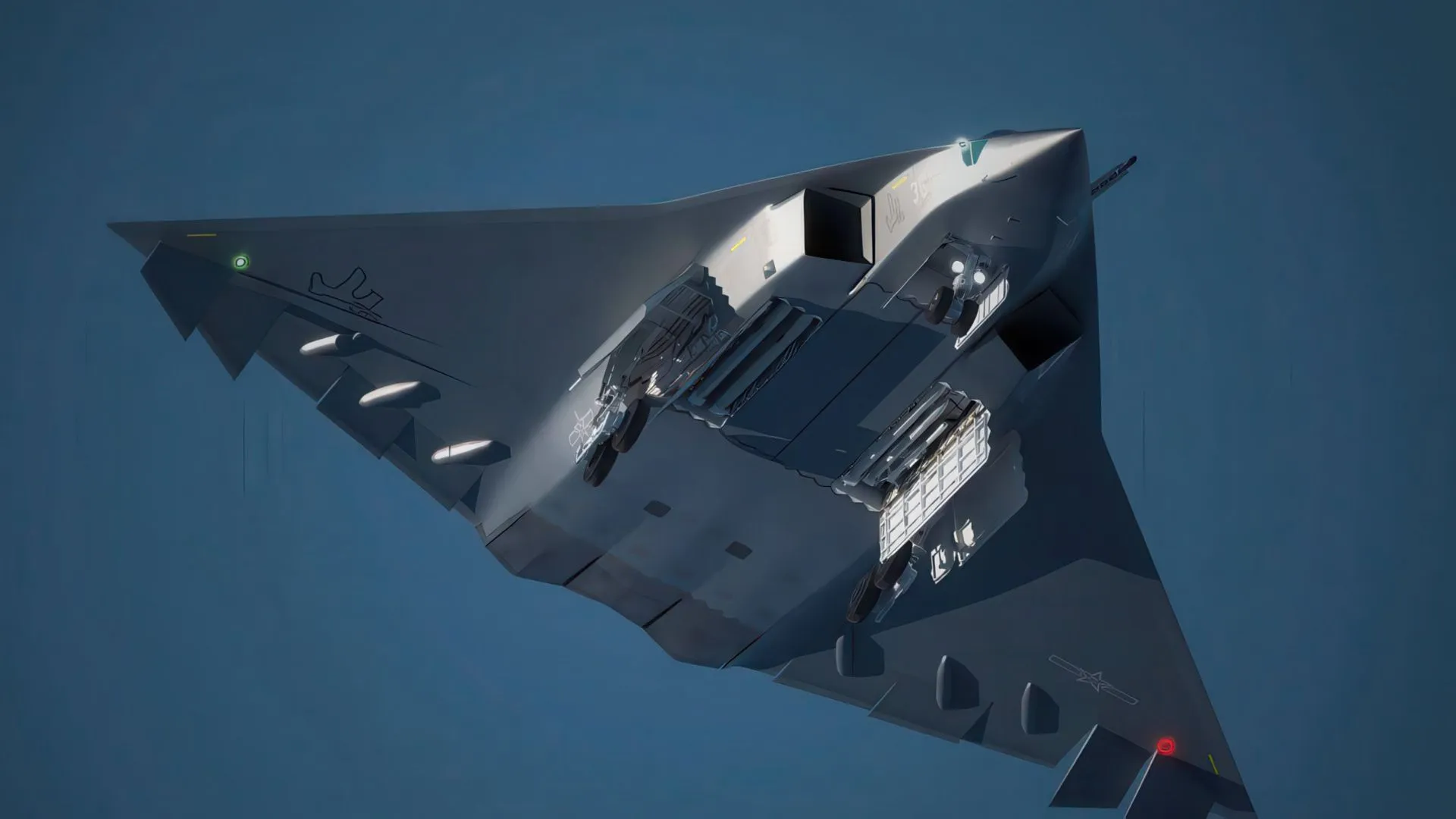

Aplicación de la IA en defensa: China utiliza DeepSeek para desarrollar cazas furtivos: Se informa que China está utilizando la tecnología DeepSeek AI para ayudar en el desarrollo de su caza furtivo de sexta generación (J-35, J-50). (Fuente: Ronald_vanLoon)

Lanzamiento del video de introducción del proyecto METACOG-25: El proyecto METACOG-25 ha lanzado un video de introducción, lo que sugiere nuevos avances en el campo de la investigación o el desarrollo de la IA. (Fuente: Reddit r/deeplearning)

Actualizaciones de la plataforma Hugging Face: Colecciones dentro de colecciones y cuenta oficial de PyTorch: Hugging Face Hub ha lanzado la función “colecciones dentro de colecciones”, que permite una organización más granular de los recursos. Al mismo tiempo, PyTorch ahora tiene una cuenta oficial en la plataforma. (Fuente: ClementDelangue, Reddit r/LocalLLaMA)