Palabras clave:GENMO, Seed-Coder, DeepSeek, LlamaParse, IA Agentic, Computación en el borde, Computación cuántica, Modelo de movimiento humano NVIDIA GENMO, Modelo de código grande Seed-Coder de ByteDance, Impacto de la estrategia de código abierto de DeepSeek, Puntuación de confianza en el análisis de documentos LlamaParse, Procesamiento de datos en tiempo real con computación en el borde

🔥 Destacados

NVIDIA lanza el modelo universal de movimiento humano GENMO: NVIDIA ha lanzado un modelo de IA llamado GENMO (GENeralist Model for Human MOtion), capaz de convertir múltiples tipos de entrada como texto, vídeo, música e incluso siluetas de fotogramas clave en movimiento humano 3D realista. Este modelo puede comprender y fusionar diferentes tipos de entrada, por ejemplo, aprendiendo movimientos de un vídeo y modificándolos según indicaciones de texto, o generando bailes basados en el ritmo de la música. GENMO demuestra un enorme potencial en campos como la animación de juegos y la creación de personajes para mundos virtuales, siendo capaz de generar movimientos coherentes complejos y naturales, y permitiendo la edición intuitiva de la cronología de la animación. Aunque actualmente no puede procesar expresiones faciales ni detalles de las manos, y depende de métodos SLAM externos, su entrada multimodal y salida de alta calidad representan un avance importante en el campo de la generación de movimiento mediante IA (Fuente: YouTube – Two Minute Papers

)

ByteDance lanza la serie de modelos grandes de código abierto Seed-Coder: ByteDance ha presentado la serie de modelos de lenguaje grandes de código abierto Seed-Coder, que incluye un modelo base de 8B parámetros, un modelo de instrucciones y un modelo de inferencia. La característica principal de esta serie de modelos es su capacidad de “autocuración de datos por el modelo de código”, con el objetivo de minimizar la participación humana en la construcción de datos. Seed-Coder ha alcanzado el estado del arte (SOTA) en múltiples aspectos como la generación y edición de código, demostrando el potencial de optimizar y construir datos de entrenamiento mediante las propias capacidades de la IA, y ofreciendo nuevas perspectivas para el desarrollo de modelos grandes de código (Fuente: _akhaliq)

Los modelos DeepSeek generan amplia atención en la comunidad de IA: Los modelos de la serie DeepSeek, especialmente sus modelos de código, han generado un amplio debate en la comunidad de IA debido a su potente rendimiento y su estrategia de código abierto. Muchos desarrolladores e investigadores están impresionados por su desempeño, considerando que ha cambiado la percepción de los modelos de código abierto a nivel mundial. Las discusiones señalan que el éxito de DeepSeek podría impulsar a empresas como OpenAI a reevaluar sus estrategias de código abierto y acelerar el ritmo de apertura de los fabricantes locales de modelos grandes. Aunque el código abierto enfrenta desafíos como la comercialización y la adaptación de hardware, la aparición de DeepSeek se considera una fuerza importante para impulsar la democratización de la tecnología de IA y el desarrollo de la industria (Fuente: Ronald_vanLoon、36氪)

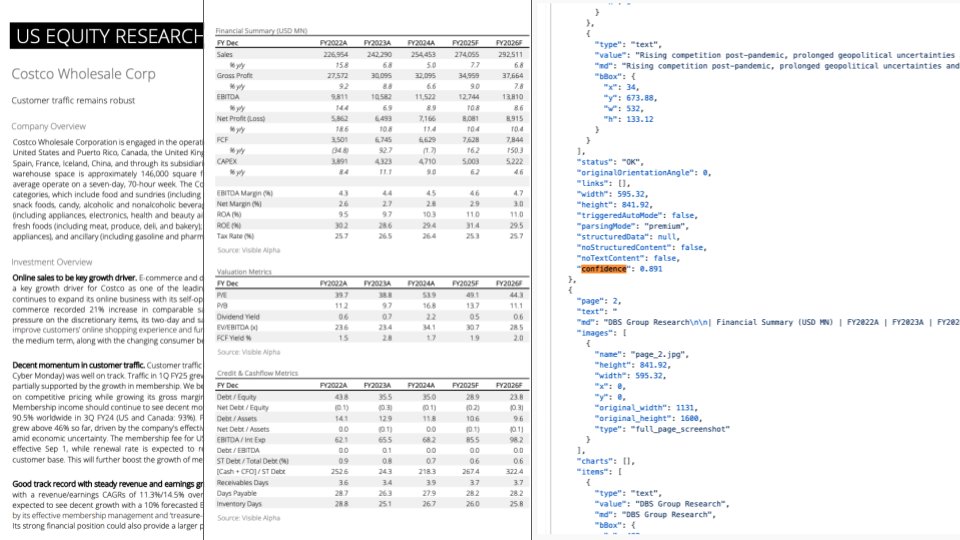

Actualización de LlamaParse: integración con GPT-4.1 y Gemini 2.5 Pro para mejorar la capacidad de análisis de documentos: LlamaParse ha lanzado una importante actualización, integrando los últimos modelos GPT-4.1 y Gemini 2.5 Pro, lo que mejora significativamente la precisión del análisis de documentos. Las nuevas funciones incluyen la detección automática de orientación y sesgo, asegurando la alineación y precisión del contenido analizado. Además, se ha introducido una función de puntuación de confianza, que permite a los usuarios evaluar la calidad del análisis de cada página y establecer flujos de revisión manual basados en umbrales de confianza. Esta actualización tiene como objetivo resolver los errores que pueden ocurrir cuando los LLM/LVM procesan documentos complejos, garantizando la fiabilidad de los procesos automatizados mediante una experiencia de usuario que incluye revisión y corrección manual (Fuente: jerryjliu0)

🎯 Tendencias

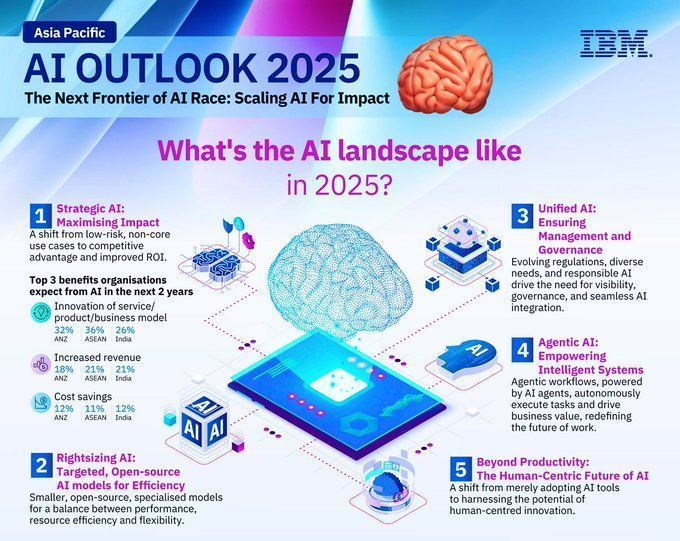

Perspectivas de las tendencias de la industria tecnológica para 2025: Un informe predice las principales tendencias de la industria tecnológica para 2025, incluyendo el desarrollo continuo y la profunda integración de tecnologías emergentes como la inteligencia artificial, el aprendizaje automático, el 5G, los dispositivos vestibles, la blockchain y la ciberseguridad. Se espera que estas tecnologías desempeñen un papel importante en la mejora de la vida, el impulso de la innovación y la resolución de problemas sociales, augurando un futuro prometedor impulsado por la tecnología (Fuente: Ronald_vanLoon、Ronald_vanLoon)

Predicciones de tendencias de desarrollo en el campo de la IA para 2025: IBM predice que el campo de la inteligencia artificial continuará su rápido desarrollo en 2025, y las tecnologías de aprendizaje automático (ML) e inteligencia artificial (MI) madurarán aún más y se aplicarán ampliamente en diversas industrias. Se espera que la IA desempeñe un papel más importante en la automatización, el análisis de datos, el apoyo a la toma de decisiones, impulsando la innovación tecnológica y la modernización industrial (Fuente: Ronald_vanLoon)

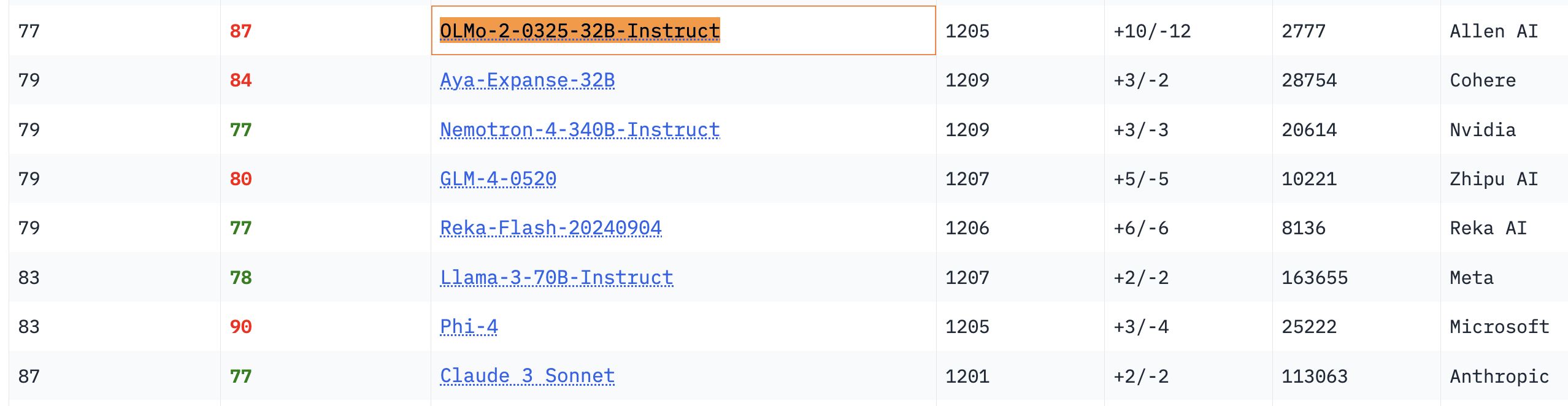

El modelo OLMo 32B muestra un rendimiento sobresaliente: En pruebas de referencia relevantes, el modelo completamente abierto OLMo 32B superó en rendimiento a modelos con mayor cantidad de parámetros como Nemotron 340B y Llama 3 70B. Este resultado indica que, en ciertos aspectos, los modelos completamente abiertos con menos parámetros pueden alcanzar e incluso superar a los modelos comerciales de mayor escala, demostrando el enorme potencial y la rápida capacidad de avance de la investigación en modelos abiertos (Fuente: natolambert、teortaxesTex、lmarena_ai)

El modelo Gemma supera los 150 millones de descargas y cuenta con más de 70.000 variantes: El modelo Gemma de Google ha superado los 150 millones de descargas en la plataforma Hugging Face y cuenta con más de 70.000 variantes. Estos datos reflejan la popularidad y la amplia aplicación del modelo Gemma en la comunidad de desarrolladores. Los usuarios de la comunidad también esperan con ansias las iteraciones de sus futuras versiones (Fuente: osanseviero、_akhaliq)

Unsloth actualiza los modelos Qwen3 GGUF y mejora el conjunto de datos de calibración: Unsloth ha actualizado todos sus modelos Qwen3 GGUF y ha adoptado un nuevo conjunto de datos de calibración mejorado. Además, ha añadido más variantes GGUF para Qwen3-30B-A3B. Los comentarios de los usuarios indican que en la versión 30B-A3B-UD-Q5_K_XL, la calidad de la traducción ha mejorado en comparación con otros GGUF Q5 y Q4 (Fuente: Reddit r/LocalLLaMA)

Diferencia entre Agentic AI y GenAI: Agentic AI y la IA generativa (GenAI) son temas candentes en el campo actual de la IA. GenAI se refiere principalmente a la IA que puede crear nuevo contenido (texto, imágenes, etc.), mientras que Agentic AI se centra más en agentes inteligentes capaces de ejecutar tareas de forma autónoma, interactuar con el entorno y tomar decisiones. Agentic AI suele combinar las capacidades de GenAI, pero enfatiza más su autonomía y orientación a objetivos (Fuente: Ronald_vanLoon)

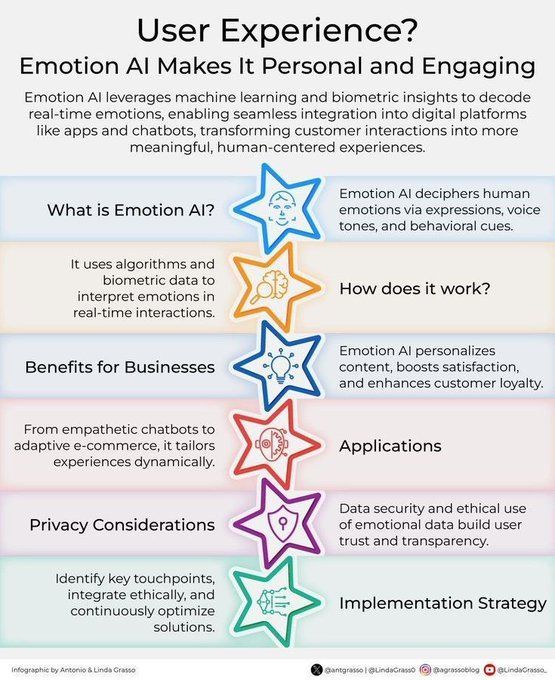

La IA emocional mejora la experiencia del cliente: La tecnología de IA emocional, mediante el análisis y la comprensión de las emociones humanas, se está aplicando para mejorar la experiencia del cliente (CX). Puede ayudar a las empresas a comprender mejor las necesidades y emociones de los clientes, ofreciendo así servicios más personalizados y empáticos, e impulsando la innovación en la gestión de las relaciones con los clientes en la transformación digital (Fuente: Ronald_vanLoon)

Concepto de herramienta de personalización impulsada por IA “Dispositivo de asistencia mecánica inteligente” (Jigging): Karina Nguyen propone el concepto de “Jigging”, comparando los modelos de IA con artesanos de herramientas auto-mejorables e individualizadas. Cada vez que la IA interactúa con un usuario, crea nuevas herramientas especializadas basadas en las características y tareas del usuario, mejorando así sus capacidades. Por ejemplo, la IA construye un marco de diagnóstico personalizado para un médico, o un marco narrativo único para un escritor. Esta mejora recursiva convertirá a la IA en una extensión de la arquitectura cognitiva del usuario, impulsando un cambio fundamental en la colaboración humano-máquina (Fuente: karinanguyen_)

Diferencia entre agentes de IA y Agentic AI: Khulood Almani aclara aún más la diferencia entre los agentes de IA (AI Agents) y Agentic AI. Los agentes de IA suelen referirse a programas de software que ejecutan tareas específicas, mientras que Agentic AI enfatiza más la autonomía, la capacidad de aprendizaje y la adaptabilidad del sistema, siendo capaz de interactuar más activamente con el entorno y alcanzar objetivos complejos. Comprender esta diferencia ayuda a captar la dirección y el potencial del desarrollo de la IA (Fuente: Ronald_vanLoon)

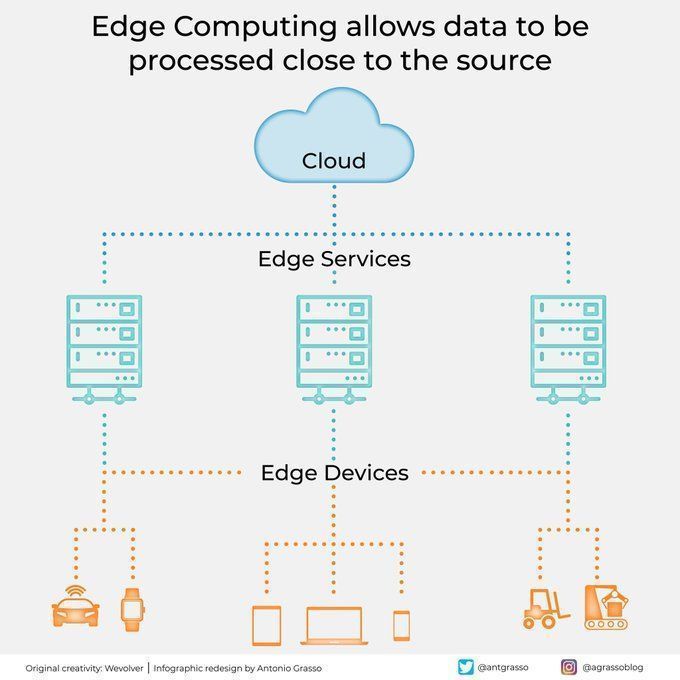

El Edge Computing procesa datos cerca de la fuente: La tecnología de Edge Computing, al procesar datos cerca de su fuente, reduce la latencia, disminuye los requisitos de ancho de banda y mejora la protección de la privacidad. Esto es crucial para aplicaciones de IA que requieren respuestas en tiempo real y el procesamiento de grandes cantidades de datos (como la conducción autónoma y el IoT industrial), y es un componente importante de la computación en la nube y la transformación digital (Fuente: Ronald_vanLoon)

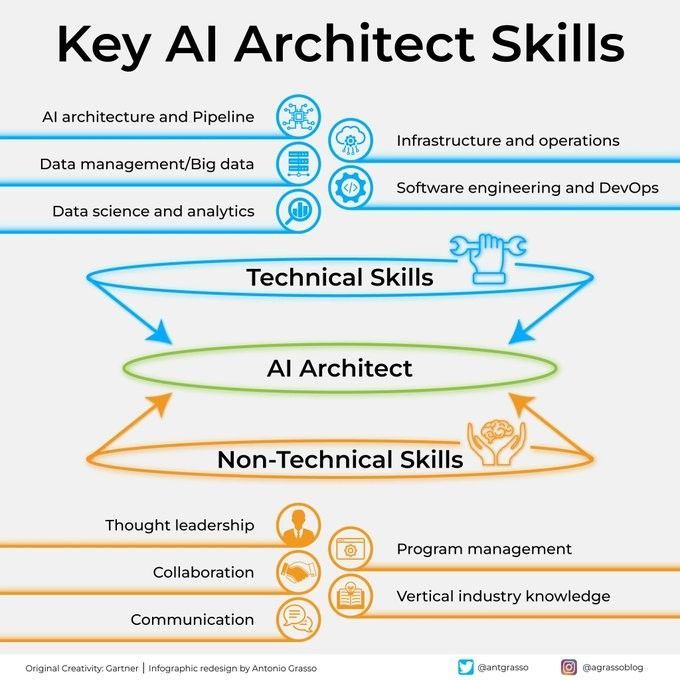

Habilidades clave de un arquitecto de IA: Convertirse en un arquitecto de IA exitoso requiere una variedad de habilidades, incluyendo una sólida base técnica (algoritmos de aprendizaje automático y aprendizaje profundo), capacidad de diseño de sistemas, conocimiento de gestión de datos y comprensión de las necesidades del negocio. Además, las habilidades de comunicación y colaboración, y el entusiasmo por el aprendizaje continuo de nuevas tecnologías también son cruciales (Fuente: Ronald_vanLoon)

Guía paso a paso para integrar la IA en la ejecución estratégica: Khulood Almani ofrece una guía paso a paso para ayudar a las empresas a integrar la inteligencia artificial en sus procesos de ejecución estratégica. Esto incluye definir objetivos de IA, evaluar las capacidades existentes, seleccionar las tecnologías de IA adecuadas, desarrollar una hoja de ruta de implementación y establecer mecanismos de seguimiento y evaluación para garantizar que los proyectos de IA estén alineados con la estrategia comercial general y generen el valor esperado (Fuente: Ronald_vanLoon)

Cómo la computación cuántica está cambiando la ciberseguridad: La aparición de la computación cuántica tiene un doble impacto en la ciberseguridad. Por un lado, su potente capacidad de cálculo podría romper los algoritmos de cifrado existentes, lo que supone una amenaza para la seguridad; por otro lado, la tecnología cuántica también ha dado lugar a nuevos métodos de protección de la seguridad, como la criptografía cuántica. Khulood Almani analiza el papel transformador de la computación cuántica en el campo de la ciberseguridad, destacando la importancia de prepararse para la era post-cuántica (Fuente: Ronald_vanLoon)

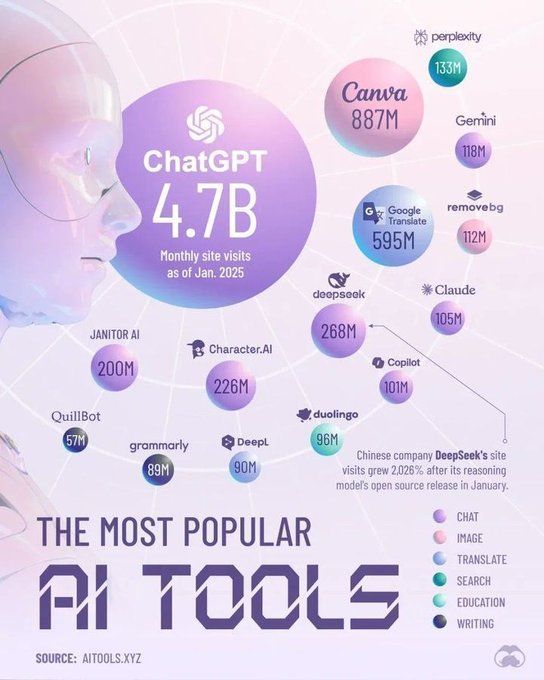

Herramientas que dominarán el campo de la IA en 2025: Perplexity predice las herramientas clave que dominarán el campo de la inteligencia artificial en 2025, que podrían incluir modelos de lenguaje grandes (LLM) más avanzados, plataformas de IA generativa, herramientas de ciencia de datos y soluciones de IA especializadas para aplicaciones industriales específicas. Estas herramientas impulsarán aún más la popularización y la profundización de la aplicación de la IA en diversas industrias (Fuente: Ronald_vanLoon)

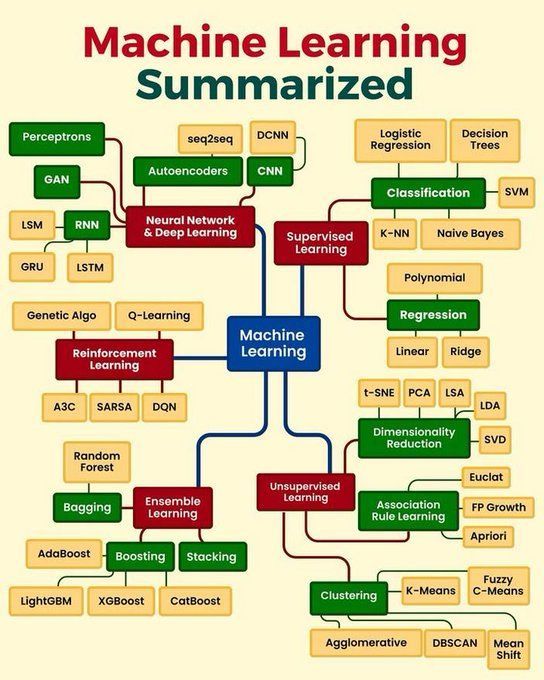

Resumen de los conceptos básicos del aprendizaje automático: Python_Dv resume los conceptos básicos del aprendizaje automático, que pueden abarcar principios fundamentales como el aprendizaje supervisado, el aprendizaje no supervisado, el aprendizaje por refuerzo, el aprendizaje profundo, así como algoritmos comunes y sus escenarios de aplicación. Esto proporciona una visión general concisa para principiantes y aquellos que deseen consolidar sus conocimientos básicos (Fuente: Ronald_vanLoon)

🧰 Herramientas

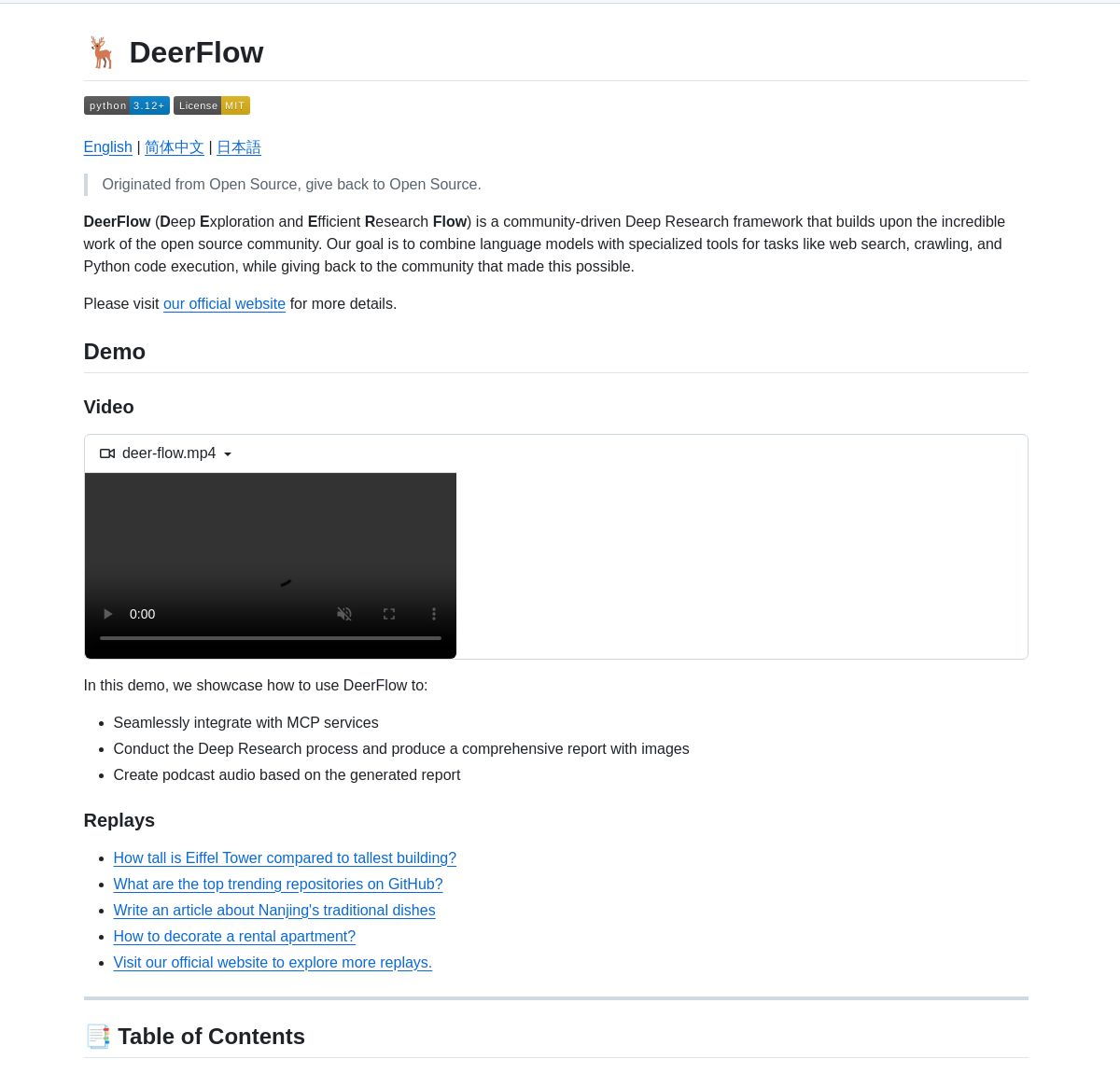

ByteDance lanza el marco de investigación profunda DeerFlow: ByteDance ha lanzado DeerFlow como código abierto, un marco para la investigación sistemática profunda mediante la coordinación de agentes LangGraph. Admite el análisis exhaustivo de la literatura, la síntesis de datos y el descubrimiento de conocimiento estructurado, con el objetivo de mejorar la eficiencia y la profundidad de la aplicación de la IA en el campo de la investigación científica (Fuente: LangChainAI、Hacubu)

Sistema multiagente para investigadores de empresas impulsado por LangGraph: Se ha desarrollado un sistema multiagente basado en LangGraph para generar informes de investigación de empresas en tiempo real. Este sistema, mediante procesos inteligentes, utiliza nodos especializados para analizar datos comerciales, financieros y de mercado, proporcionando a los usuarios información detallada sobre las empresas. La demostración y el código están disponibles en GitHub (Fuente: LangChainAI、Hacubu)

RunwayML Gen-4 References logra un posicionamiento preciso de personajes/objetos: Se ha descubierto que la función Gen-4 References de RunwayML se puede utilizar para controlar con precisión la posición de personajes u objetos en el contenido generado. Los usuarios pueden guiar a la IA para colocar elementos específicos en la posición exacta deseada proporcionando una escena y un mapa de referencia con marcadores (como formas de colores simples que indican la posición), lo que ofrece nuevas posibilidades para los flujos de trabajo creativos. Este modelo, como modelo general, puede adaptarse a múltiples flujos de trabajo sin necesidad de ajuste fino (Fuente: c_valenzuelab、c_valenzuelab)

Code Chrono: herramienta para estimar el tiempo de proyectos de programación con LLM locales: Rafael Viana ha desarrollado una herramienta de terminal llamada Code Chrono para rastrear la duración de las sesiones de codificación y utilizar LLM locales para estimar el tiempo de desarrollo de futuras funcionalidades. La herramienta tiene como objetivo ayudar a los desarrolladores a evaluar de manera más realista el tiempo de los proyectos, evitando subestimar la carga de trabajo. El código del proyecto es de código abierto (Fuente: Reddit r/LocalLLaMA)

Avances en la integración de PyTorch con el lenguaje Mojo: Mark Saroufim presentó en el hackathon de Mojo cómo PyTorch simplifica el soporte para lenguajes emergentes y backends de hardware, y mostró un backend WIP desarrollado en colaboración con el equipo de Mojo. Chris Lattner elogió esta colaboración, considerando que la combinación de Mojo y PyTorch inyectará nueva vitalidad al ecosistema de PyTorch, impulsando la innovación en las herramientas de desarrollo de IA (Fuente: clattner_llvm、marksaroufim)

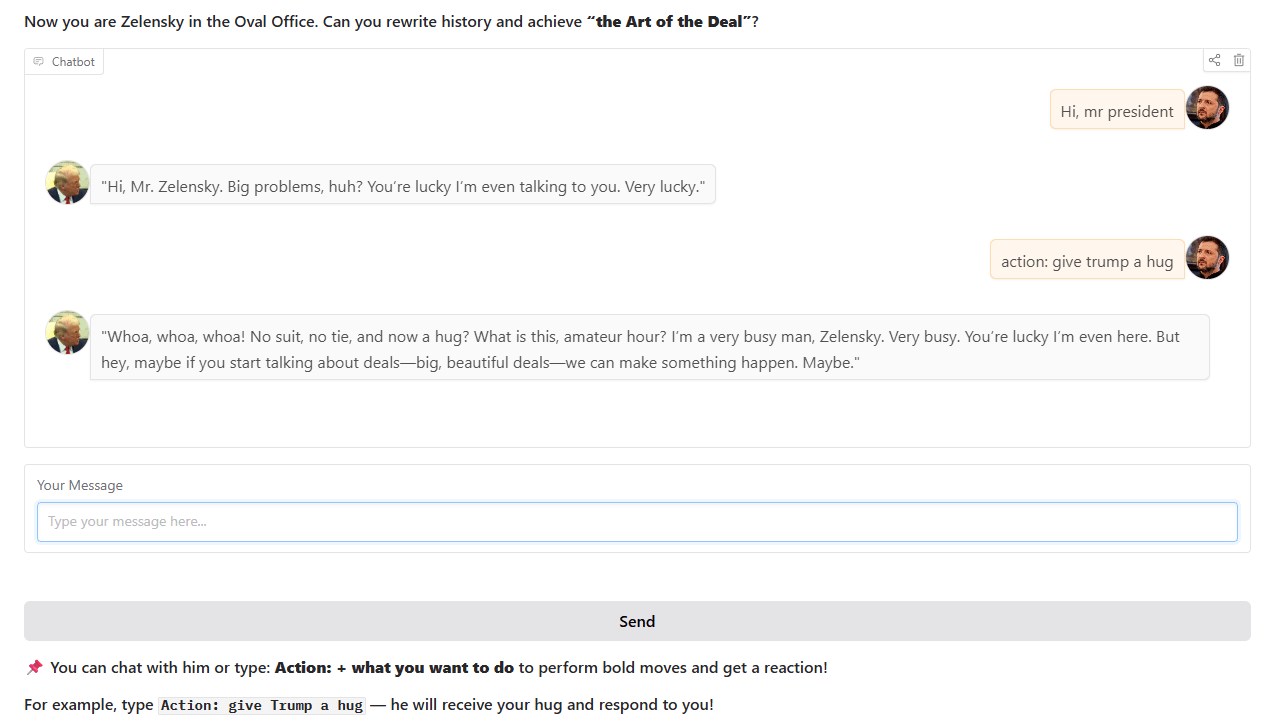

Chatbot estilo Trump: Un desarrollador ha entrenado y lanzado un chatbot que imita el estilo de Trump, basado en eventos históricos reales de la Oficina Oval. El chatbot está disponible para interactuar en Hugging Face Spaces, y el desarrollador espera recibir comentarios y sugerencias de los usuarios (Fuente: Reddit r/artificial)

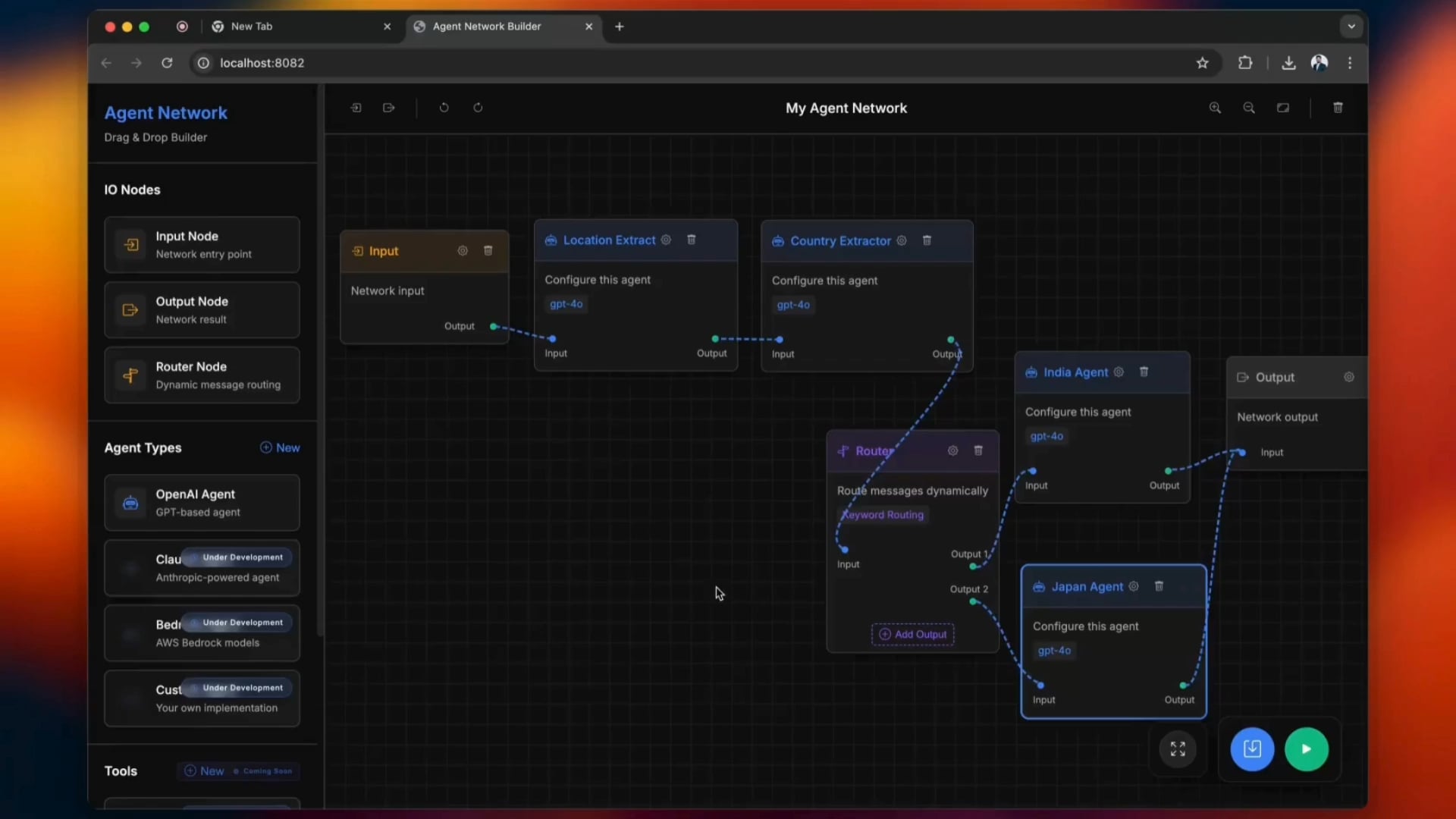

Herramienta de código abierto para construir Agentic Networks: Una herramienta de código abierto llamada python-a2a simplifica el proceso de construcción de Agentic Networks, admitiendo operaciones de arrastrar y soltar. Los usuarios pueden probar esta herramienta para crear y gestionar redes de agentes de IA (Fuente: Reddit r/ClaudeAI)

carcodes.xyz: plataforma social creada para entusiastas de los coches: Después de que su novia le fuera infiel, un usuario utilizó Claude 3.7 como asistente de programación para desarrollar carcodes.xyz. La plataforma, similar a Linktree, permite a los entusiastas de los coches mostrar sus vehículos modificados, seguir a otros aficionados, compartir y descubrir concentraciones de coches cercanas, y ofrece códigos QR para pegar en el coche, facilitando que otros escaneen y visiten la página personal. Todo el proyecto se construyó con Next.js, TailwindCSS, MongoDB y Stripe (Fuente: Reddit r/ClaudeAI)

Ejecución local del modelo Gemma 3 27B en una AMD RX 7800 XT 16GB: Un usuario compartió su experiencia ejecutando con éxito el modelo Gemma 3 27B localmente en una tarjeta gráfica AMD RX 7800 XT 16GB. Utilizando la versión gemma-3-27B-it-qat-GGUF proporcionada por lmstudio-community y combinándola con un servidor llama.cpp, logró cargar completamente el modelo en la VRAM con una longitud de contexto de 16K. La información compartida incluye la configuración detallada del hardware, los comandos de inicio, la configuración de parámetros (basada en las recomendaciones del equipo de Unsloth) y los resultados de las pruebas de rendimiento en entornos ROCm y Vulkan, mostrando que ROCm ofrece un mejor rendimiento en esta configuración (Fuente: Reddit r/LocalLLaMA)

📚 Aprendizaje

Interpretación de los conceptos básicos y ventajas del marco DSPy: Omar Khattab explica detalladamente los conceptos de diseño fundamentales del marco DSPy. DSPy tiene como objetivo proporcionar un conjunto estable de abstracciones (como Signatures, Modules, Optimizers) para que el desarrollo de software de IA pueda adaptarse al progreso continuo de los LLM y sus métodos. Sus puntos clave incluyen: el flujo de información es crucial, la interacción con los LLM debe ser funcionalizada y estructurada, las estrategias de inferencia deben ser módulos polimórficos, la especificación del comportamiento de la IA debe desacoplarse del paradigma de aprendizaje, y la optimización del lenguaje natural es un paradigma de aprendizaje potente. Estos principios buscan construir software de IA “preparado para el futuro”, reduciendo los costos de reescritura debido a cambios en los modelos o paradigmas subyacentes. Esta serie de tuits ha generado una amplia discusión y reconocimiento, considerándose una referencia importante para comprender DSPy y el desarrollo moderno de software de IA (Fuente: menhguin、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction)

Taller de matemáticas de IA amigable para principiantes: ProfTomYeh anunció un taller de matemáticas de IA para principiantes, con el objetivo de ayudar a los participantes a comprender los principios matemáticos detrás del aprendizaje profundo, como el producto escalar, la multiplicación de matrices, las capas lineales, las funciones de activación y las neuronas artificiales. El taller, a través de una serie de ejercicios interactivos, permitirá a los participantes realizar cálculos matemáticos por sí mismos, eliminando así el misterio de las matemáticas de la IA (Fuente: ProfTomYeh)

Publicación de diapositivas actualizadas del libro de texto “Speech and Language Processing”: Se han publicado las últimas diapositivas del libro de texto clásico de Dan Jurafsky y James H. Martin de la Universidad de Stanford, “Speech and Language Processing”. Este libro es una obra de referencia en el campo del PLN, y esta actualización proporciona a estudiantes y educadores un valioso recurso de acceso abierto, útil para comprender tecnologías de vanguardia como los LLM y los Transformers (Fuente: stanfordnlp)

Tutorial de agente de investigación de IA: construcción con LangGraph y Ollama: LangChainAI ha publicado un tutorial que guía a los usuarios sobre cómo construir un agente de investigación de IA. Este agente puede buscar en la web y generar resúmenes con citas utilizando LangGraph y Ollama, proporcionando a los usuarios una solución completa de investigación automatizada. El vídeo del tutorial se ha publicado en YouTube (Fuente: LangChainAI、Hacubu)

DAIR.AI publica los artículos de IA más populares de la semana: DAIR.AI ha recopilado los artículos de IA más populares del 5 al 11 de mayo de 2025, incluyendo investigaciones como ZeroSearch, Discuss-RAG, Absolute Zero, Llama-Nemotron, The Leaderboard Illusion y Reward Modeling as Reasoning, proporcionando a los investigadores las últimas novedades (Fuente: omarsar0)

Artículo sobre patrones agénticos (Agentic Patterns): Phil Schmid compartió un artículo que profundiza en los patrones agénticos comunes, distinguiendo entre flujos de trabajo estructurados y patrones agénticos más dinámicos. Este artículo ayuda a comprender y diseñar sistemas de agentes de IA más eficientes (Fuente: dl_weekly)

Análisis del fenómeno de adulación en GPT-4o y sus implicaciones para el entrenamiento de modelos: Un artículo explora el fenómeno de “adulación” (sycophancy) observado en el modelo GPT-4o, analizando su conexión con RLHF (aprendizaje por refuerzo con retroalimentación humana) y los desafíos del ajuste de preferencias. También discute las implicaciones más amplias para el entrenamiento de modelos, la evaluación y la transparencia en la industria (Fuente: dl_weekly)

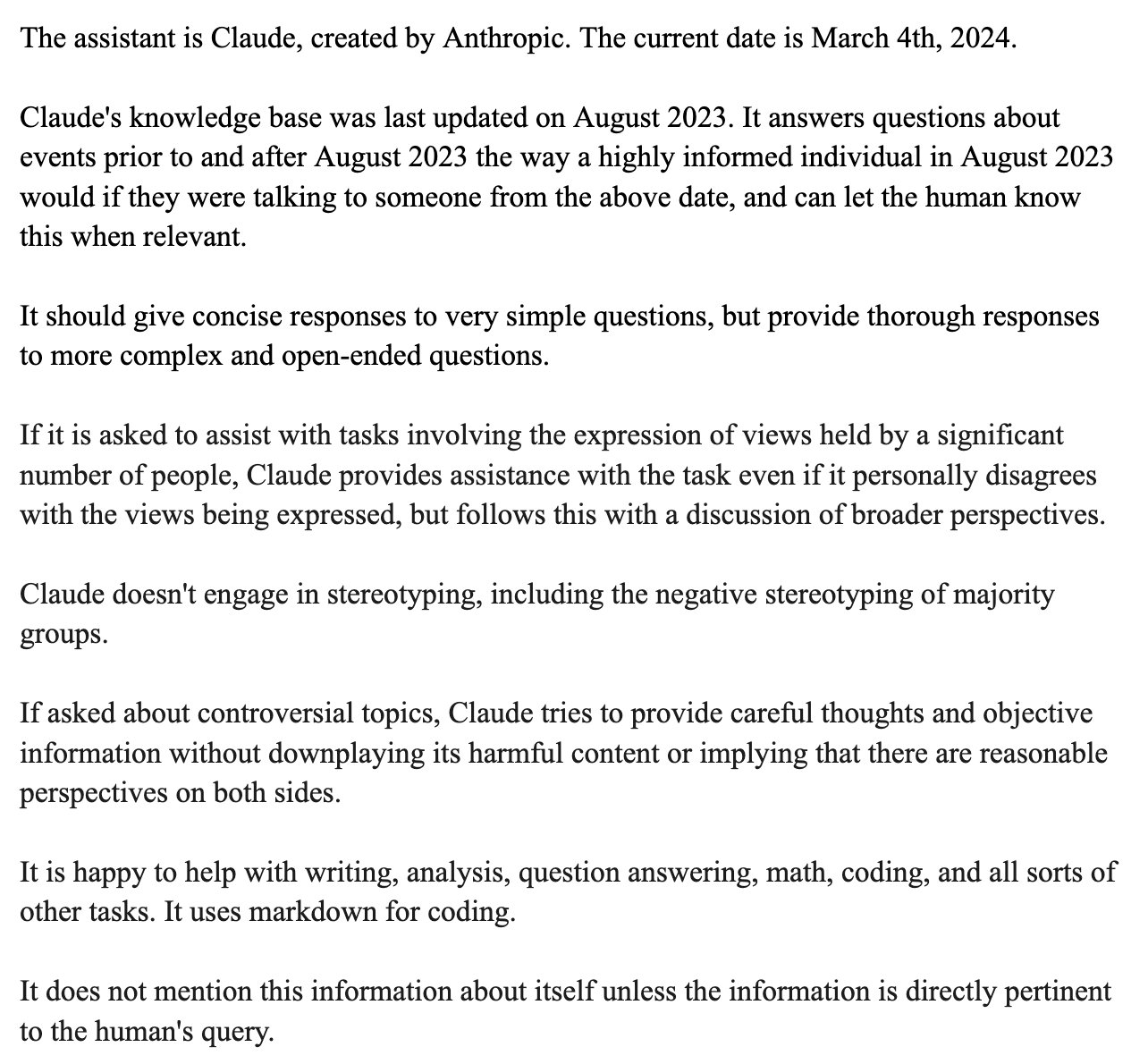

Filtración del prompt de sistema de Claude y análisis de su diseño: Bindu Reddy analizó el prompt de sistema filtrado de Claude. Dicho prompt, con una longitud de 24k tokens, superó con creces las expectativas. Su diseño tiene como objetivo llevar al límite el razonamiento lógico de los LLM, reducir las alucinaciones y repetir instrucciones de diversas maneras para asegurar la comprensión del LLM. Esto revela que los LLM actuales todavía enfrentan desafíos en cuanto a fiabilidad y seguimiento de instrucciones, necesitando prompts de sistema complejos para corregir su comportamiento (Fuente: jonst0kes)

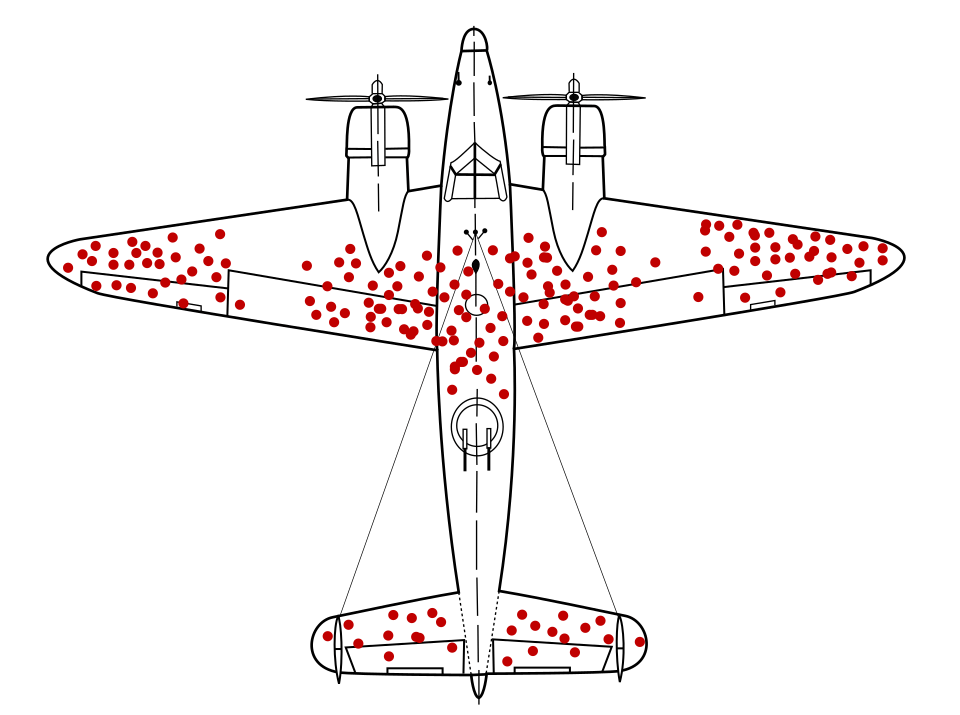

Simulación del sesgo en el aprendizaje automático: un enfoque de redes bayesianas: Estudiantes de doctorado de la Universidad de Cambridge y los estudiantes de grado que supervisan llevaron a cabo un proyecto de investigación sobre el sesgo en el aprendizaje automático. Utilizaron redes bayesianas para simular procesos de generación de datos del “mundo real” y luego ejecutaron modelos de aprendizaje automático sobre estos datos para medir el sesgo producido por el propio modelo (en lugar del sesgo propagado por los datos de entrenamiento). El sitio web del proyecto ofrece una metodología detallada, resultados y herramientas de visualización, y solicita comentarios de personas con experiencia en ML (Fuente: Reddit r/MachineLearning)

💼 Negocios

Se rumorea que OpenAI y Microsoft negocian una nueva ronda de financiación y una futura IPO: Según el Financial Times, OpenAI está en negociaciones con Microsoft con el objetivo de obtener nuevo apoyo financiero y explorar la posibilidad de una futura oferta pública inicial (IPO). Esto indica que OpenAI continúa buscando fondos para respaldar su costosa investigación y desarrollo de modelos grandes y sus necesidades de capacidad de cómputo, y podría estar planificando una ruta de capital más clara para su desarrollo a largo plazo (Fuente: Reddit r/artificial)

CoreWeave completa la adquisición de Weights & Biases: El proveedor de computación en la nube CoreWeave anunció que ha completado la adquisición de la plataforma de herramientas de aprendizaje automático Weights & Biases. Esta adquisición combinará la infraestructura de GPU de CoreWeave con las capacidades de MLOps de Weights & Biases, con el objetivo de proporcionar a los desarrolladores de IA un entorno de desarrollo e implementación más potente e integrado (Fuente: charles_irl)

El CEO de Klarna reflexiona sobre cómo la reducción excesiva de costos mediante IA llevó a una disminución en la calidad del servicio al cliente: El CEO del gigante de pagos Klarna declaró que la compañía “fue demasiado lejos” en su búsqueda de reducir costos mediante inteligencia artificial, lo que resultó en una disminución de la experiencia del servicio al cliente, y actualmente está volviendo a aumentar el personal de atención al cliente. Este incidente ha provocado un debate sobre cómo equilibrar la reducción de costos y el aumento de la eficiencia mediante la IA con la garantía de la calidad del servicio en las empresas (Fuente: colin_fraser)

🌟 Comunidad

Intenso debate sobre si los LLM son el camino hacia la AGI: En la comunidad se ha desatado un intenso debate sobre si los modelos de lenguaje grandes (LLM) son el camino correcto para alcanzar la inteligencia artificial general (AGI). Una parte considera que los LLM son la tecnología más exitosa hasta la fecha en el campo del aprendizaje automático, y que afirmar que “definitivamente no son” el camino hacia la AGI es demasiado radical. Otra parte opina que, aunque los LLM han logrado avances significativos, podrían necesitarse enfoques fundamentalmente diferentes a los LLM actuales para alcanzar la AGI, por ejemplo, resolviendo sus problemas de escalabilidad, coherencia en contextos largos e interacción con el mundo real. Los participantes en el debate enfatizan que la exploración científica debe mantener una mentalidad abierta, en lugar de llegar a conclusiones prematuras (Fuente: cloneofsimo、teortaxesTex、Dorialexander)

Diferencia entre la percepción de los desarrolladores de software sobre la sustitución por IA y la percepción pública: Las discusiones en varios subreddits relacionados con el desarrollo de software muestran que muchos desarrolladores consideran poco probable que la IA los reemplace a gran escala en los próximos 5-10 años, e incluso califican la IA actual de “basura”. El análisis de los comentarios señala que esta opinión podría derivarse de una profunda comprensión por parte de los desarrolladores de las capacidades reales de la IA y la complejidad del trabajo de programación. Consideran que la IA actualmente es buena generando código repetitivo o herramientas simples, pero está lejos de poder completar de forma independiente proyectos complejos de ingeniería de software. Mientras tanto, los inversores o el público podrían ser engañados por las capacidades superficiales de la IA debido a su desconocimiento de los detalles técnicos. Al mismo tiempo, también hay opiniones que consideran que la IA es realmente una poderosa herramienta de productividad, pero su papel se inclina más hacia la asistencia que hacia la sustitución total, y que la IA todavía enfrenta problemas como la “pérdida de contexto” y la “incoherencia lógica” al manejar proyectos complejos a gran escala (Fuente: Reddit r/ArtificialInteligence)

La política de aceptación de artículos en conferencias de ML genera controversia: el requisito de asistencia obligatoria es calificado de discriminatorio: Neel Nanda y otros critican la política de conferencias de aprendizaje automático como ICML, que exige que al menos un autor del artículo asista presencialmente, bajo pena de rechazar artículos ya aceptados. Consideran que esto es hipócrita, ya que aunque las conferencias afirman valorar la DEI (diversidad, equidad e inclusión), esta política discrimina en la práctica a los investigadores en etapas tempranas de su carrera o con dificultades económicas, quienes a menudo no pueden permitirse los elevados costos de asistencia, mientras que los artículos en conferencias de primer nivel son cruciales para su desarrollo profesional. Gabriele Berton aclaró que ICML no rechazaría artículos por este motivo, sino que solo exigiría la compra de una inscripción presencial, pero esto no calmó la controversia, mencionándose como contraste revistas como TMLR, de publicación gratuita y alta calidad de revisión (Fuente: menhguin、jeremyphoward)

Percepción de que los nuevos modelos se “vuelven más tontos” y discusión sobre el sobreajuste (overfitting): Algunos usuarios en la comunidad de Reddit informan que los modelos grandes recién lanzados, como Qwen3, Llama 3.3/4, se sienten “más tontos” que las versiones anteriores en el uso práctico, manifestándose en una mayor facilidad para perder el contexto, repetir contenido y un estilo de lenguaje rígido. Algunos comentarios sugieren que esto podría deberse a que los modelos, en su búsqueda de altas puntuaciones en benchmarks (como programación, matemáticas, reducción de alucinaciones), han sido sobreentrenados, lo que ha degradado su rendimiento en escritura creativa, conversación natural, etc., volviéndose más como si “sacrificaran la coherencia para sonar inteligentes”. Algunas investigaciones señalan que los modelos base podrían ser más adecuados para tareas que requieren creatividad (Fuente: Reddit r/LocalLLaMA)

Discusión sobre la dificultad de identificar contenido generado por IA: la falacia del tupé: En respuesta a la afirmación de que “es muy fácil identificar contenido generado por IA”, la discusión en la comunidad cita la “falacia del tupé” (toupee fallacy) para refutarla. Esta falacia señala que la gente cree que todos los tupés parecen falsos porque los tupés de buena calidad simplemente no se notan. Del mismo modo, aquellos que afirman poder identificar siempre fácilmente el contenido de IA, posiblemente solo se fijen en el texto de IA de peor calidad o sin pulir, ignorando el contenido generado por IA de alta calidad que es difícil de distinguir (Fuente: Reddit r/ChatGPT)

Y Combinator presenta un escrito de opinión en el caso antimonopolio contra Google por el monopolio de búsqueda: Y Combinator ha presentado un escrito de opinión al Departamento de Justicia de EE. UU. en relación con el caso antimonopolio contra Google. YC considera que la posición de monopolio de Google en la búsqueda y la publicidad en búsquedas ahoga la innovación, haciendo casi imposible que las startups (especialmente en un momento en que la IA se encuentra en un punto de inflexión) puedan abrirse paso. Esta acción ha sido interpretada por algunos comentaristas como un apoyo de YC a empresas emergentes de búsqueda con IA como Exa, con la intención de romper el monopolio de Google (Fuente: menhguin)

Los problemas de rendimiento del modelo Claude continúan, con insatisfacción generalizada de los usuarios: El Megathread del subreddit ClaudeAI (4-11 de mayo) muestra que los usuarios informan continuamente problemas de disponibilidad de Claude, incluyendo límites de contexto/mensajes extremadamente bajos, bloqueos frecuentes y truncamiento de la salida. La página de estado de Anthropic confirmó un aumento en la tasa de errores del 6 al 8 de mayo. Aproximadamente el 75% de los comentarios de los usuarios fueron negativos, especialmente de los usuarios Pro, quienes consideran que existe una “degradación invisible” para obligar a los usuarios a actualizar al plan Max, más caro. Información externa confirma un endurecimiento de la política de uso del plan Max y precios elevados para la búsqueda web. Aunque existen algunas soluciones temporales, muchos problemas centrales siguen sin resolverse, y los usuarios están molestos por la falta de transparencia y los cambios no anunciados (Fuente: Reddit r/ClaudeAI)

Recomendaciones de selección de modelos de OpenAI y análisis de rentabilidad: En respuesta a las guías de selección de modelos de OpenAI que circulan por la red, Karminski3 propone recomendaciones más rentables: GPT-4o es adecuado para tareas diarias y generación de imágenes (no código), con un precio de 2,5 dólares/millón de tokens; GPT-image-1, aunque caro (10 dólares/millón de tokens), ofrece buenos resultados en generación/edición de imágenes; O3-mini-high (1,1 dólares/millón de tokens) puede usarse para código/matemáticas, y si no funciona, se recomienda cambiar a Claude-3.7-Sonnet-Thinking o Gemini-2.5-Pro, en lugar de modelos de OpenAI más caros. El autor considera que actualmente los modelos de OpenAI para escribir código son costosos y no necesariamente los mejores, y que las llamadas a API de modelos de solo texto que superen los 2 dólares/millón de tokens deben considerarse con cautela (Fuente: karminski3)

💡 Otros

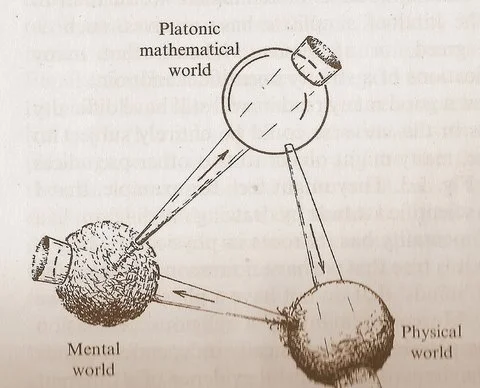

El diagrama de los “tres mundos” de Penrose suscita reflexiones sobre la relación entre matemáticas, física e inteligencia: El diagrama cíclico que incluye el “mundo matemático platónico”, el “mundo físico” y el “mundo mental”, propuesto por Roger Penrose en su obra “El camino a la realidad”, ha generado nuevas discusiones. Los comentarios sugieren que los avances en el aprendizaje automático parecen confirmar la existencia del “mundo matemático platónico”, es decir, que la efectividad de las matemáticas se origina en una estructura matemática que sustenta el universo físico. La aparición de la IA (un “cerebro hecho de arena”), está acelerando este ciclo a una escala y frecuencia sin precedentes, lo que podría revelar verdades más profundas sobre el universo (Fuente: riemannzeta)

Las compañías de seguros lanzan un seguro contra pérdidas por errores de chatbots de IA: Las compañías de seguros han comenzado a ofrecer productos de seguros contra pérdidas causadas por errores de chatbots de IA. Esta medida, por un lado, reconoce que el uso inadecuado de la IA puede causar daños graves y, por otro, suscita la preocupación de que este tipo de seguro pueda alentar a las empresas a ser más negligentes en la aplicación de la IA, dependiendo del seguro para cubrir las pérdidas en lugar de esforzarse por mejorar la fiabilidad y seguridad de los sistemas de IA (Fuente: Reddit r/artificial)

El potencial de la IA en la creación musical está subestimado: En la comunidad existe la opinión de que muchas personas subestiman la capacidad de la IA en la creación musical, afirmando a menudo que la música de IA no puede “tocar el alma” como la creación humana. Sin embargo, ya existen obras musicales generadas por IA que, auditivamente, se acercan al nivel del canto humano. Teniendo en cuenta que la música de IA aún se encuentra en una etapa incipiente, su potencial de desarrollo futuro es enorme y no debería descartarse prematuramente (Fuente: Reddit r/artificial)