Palabras clave:Aplicaciones de IA, FDA, OpenAI, GPT-4.1, WebThinker, Runway Gen-4, Inteligencia en el dispositivo, Ajuste fino por aprendizaje reforzado (RFT), Marco de multiagentes DeerFlow, WebThinker-32B-RL, Actualización de Gen-4 References, Densidad de conocimiento

🔥 Enfoque

La FDA de EE. UU. anuncia la aceleración de la aplicación interna de IA: La Administración de Alimentos y Medicamentos de EE. UU. (FDA) ha anunciado una medida histórica para promover el uso de la inteligencia artificial (AI) en todos los centros de la FDA antes del 30 de junio de 2025. Previamente, la FDA completó con éxito un proyecto piloto de IA generativa dirigido a revisores científicos. Esta iniciativa busca mejorar la capacidad regulatoria mediante la IA, aumentar la velocidad y eficiencia de los ensayos clínicos y reducir costos, lo que representa un importante avance para la IA en la regulación gubernamental y la aprobación de medicamentos, pudiendo marcar tendencia en la adopción de IA por parte de agencias reguladoras de medicamentos a nivel global (fuente: ajeya_cotra)

OpenAI revela detalles técnicos del ajuste fino mediante aprendizaje por refuerzo (RFT) y el enfoque de desarrollo de GPT-4.1: Mich Pokrass, responsable de GPT-4.1 en OpenAI, compartió en el podcast Unsupervised Learning los detalles de RFT y el proceso de desarrollo de GPT-4.1. Al construir GPT-4.1, OpenAI se centró más en los comentarios de los desarrolladores que en los benchmarks tradicionales. RFT utiliza el razonamiento de cadena de pensamiento y la puntuación específica de tareas para mejorar el rendimiento del modelo, especialmente adecuado para dominios complejos, y ya está disponible en OpenAI o4-mini. La entrevista también abordó el estado actual de la aplicación de agentes de IA, la mejora de la fiabilidad y cómo las startups pueden utilizar con éxito la evaluación y estrategias de productos prospectivas (fuente: OpenAIDevs, aidan_mclau, michpokrass)

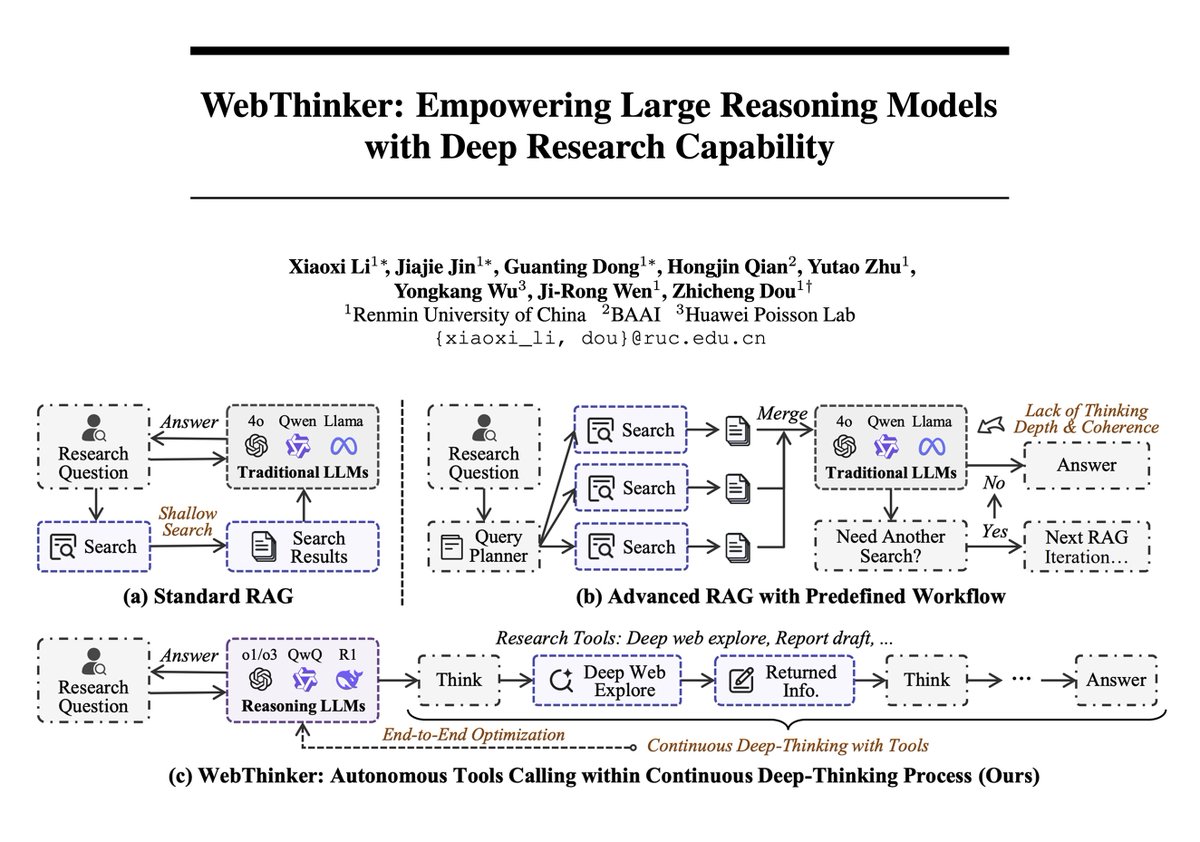

El framework WebThinker combina grandes modelos con capacidades de investigación en redes profundas, alcanzando nuevas cotas en el razonamiento complejo: Un nuevo artículo presenta WebThinker, un framework de agente de razonamiento que dota a los grandes modelos de razonamiento (LRMs) de capacidades autónomas de exploración web y redacción de informes, para superar las limitaciones del conocimiento interno estático. WebThinker integra un módulo de navegador web profundo y una estrategia autónoma de “pensar-buscar-redactar”, permitiendo al modelo buscar en la web, razonar sobre tareas y generar resultados completos simultáneamente. En benchmarks de razonamiento complejo como GPQA y GAIA, WebThinker-32B-RL logró resultados SOTA entre los modelos de 32B, superando a GPT-4o entre otros. Su versión entrenada con RL superó a la versión base en todos los benchmarks, demostrando la importancia del aprendizaje iterativo de preferencias para mejorar la coordinación entre razonamiento y herramientas (fuente: omarsar0, dair_ai)

Runway lanza la actualización Gen-4 References, mejorando la estética, composición y mantenimiento de identidad en la generación de vídeo: Runway Gen-4 References recibe una actualización que mejora significativamente la calidad estética, la composición de escenas y la consistencia de la identidad de los personajes en los vídeos generados. Una nueva característica interesante es la capacidad del modelo para colocar objetos en la escena con precisión según el diseño proporcionado por el usuario, e incluso modificar detalles como la dirección de la mirada de los personajes, manteniendo la consistencia de otros elementos. Esto marca un nuevo avance en la controlabilidad y finura de la generación de vídeo por IA, ofreciendo herramientas más potentes a los creadores (fuente: c_valenzuelab, c_valenzuelab)

Li Dahai, CEO de ModelBest (面壁智能): La AGI en el mundo físico se logrará a través de la inteligencia en el borde (edge intelligence), la densidad de conocimiento es clave: Li Dahai, CEO de ModelBest (面壁智能), considera que para que el mundo físico alcance la inteligencia artificial general (AGI) en el futuro, la inteligencia en el borde es el camino inevitable. Enfatiza que la “densidad de conocimiento” de los grandes modelos es el indicador central de la inteligencia, análogo al proceso de fabricación de chips: cuanto mayor es la densidad de conocimiento, más fuerte es la inteligencia. Los modelos de alta densidad de conocimiento tienen ventajas inherentes en dispositivos de borde con limitaciones de potencia de cálculo, memoria y consumo energético. ModelBest ya ha lanzado varios modelos para el borde y los ha implementado en sectores como la automoción, la robótica y los teléfonos móviles, como el superasistente 面壁小钢炮 (Mianbi Xiaogangpao), con el objetivo de dotar a cada dispositivo de inteligencia para lograr una percepción sensible, una toma de decisiones oportuna y una respuesta perfecta (fuente: 量子位)

🎯 Tendencias

Nueva función de Google Maps utiliza la capacidad de Gemini para identificar nombres de lugares en capturas de pantalla: Google Maps ha lanzado una nueva función que utiliza la capacidad de IA de Gemini para identificar nombres de lugares contenidos en las capturas de pantalla de los usuarios y guardarlos en una lista en el mapa, facilitando a los usuarios el acceso y la planificación de viajes en cualquier momento. Esta función tiene como objetivo simplificar el proceso de investigación de viajes y mejorar la experiencia del usuario (fuente: Google)

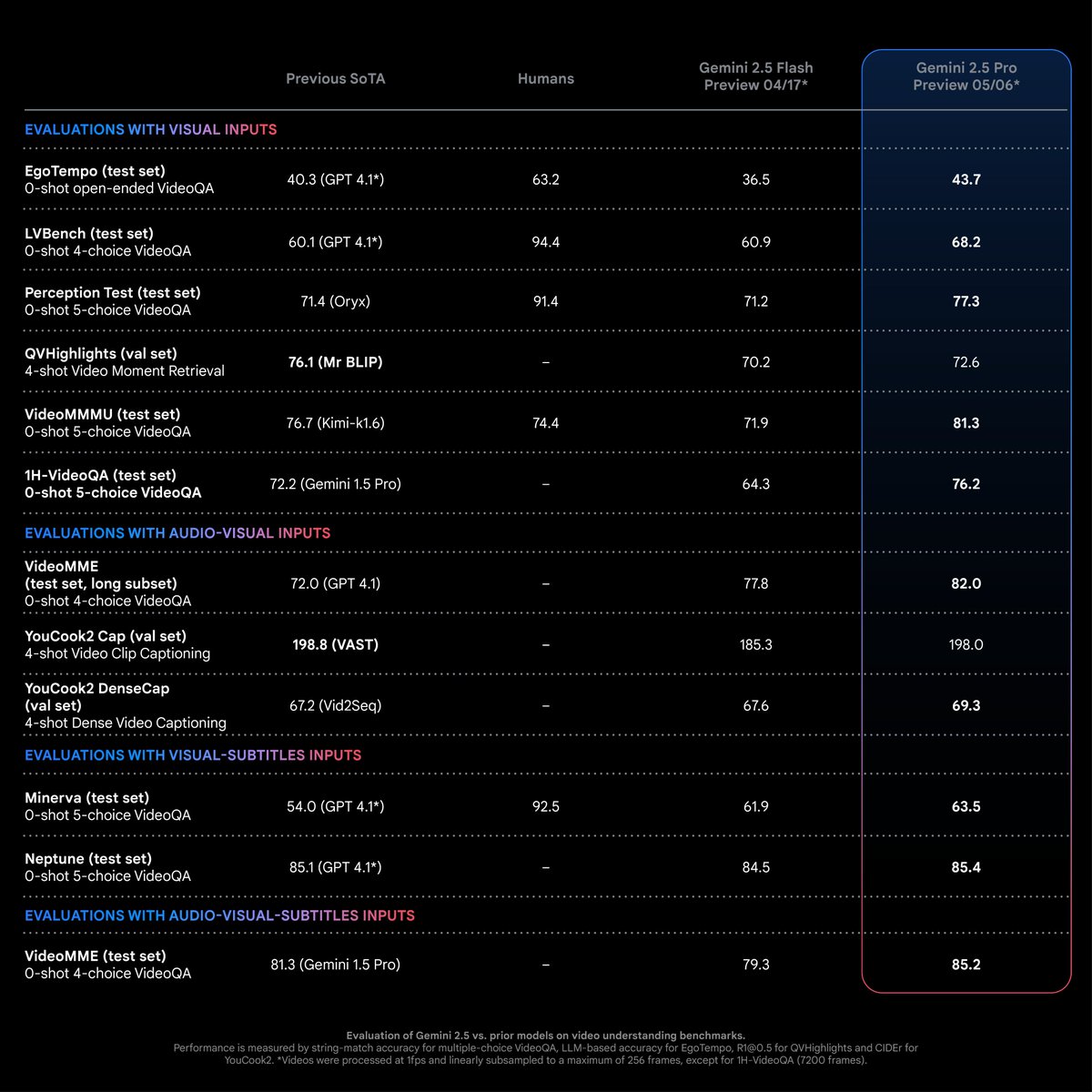

Gemini 2.5 Pro muestra un rendimiento SOTA en tareas de comprensión de vídeo: Según Logan Kilpatrick, Gemini 2.5 Pro (versión 05-06) ha alcanzado un nivel de vanguardia (SOTA) en la mayoría de las tareas de comprensión de vídeo, con una ventaja significativa. Este es el resultado de los esfuerzos del equipo multimodal de Gemini y se espera que impulse a los desarrolladores a explorar nuevas posibilidades de aplicación en este campo (fuente: matvelloso)

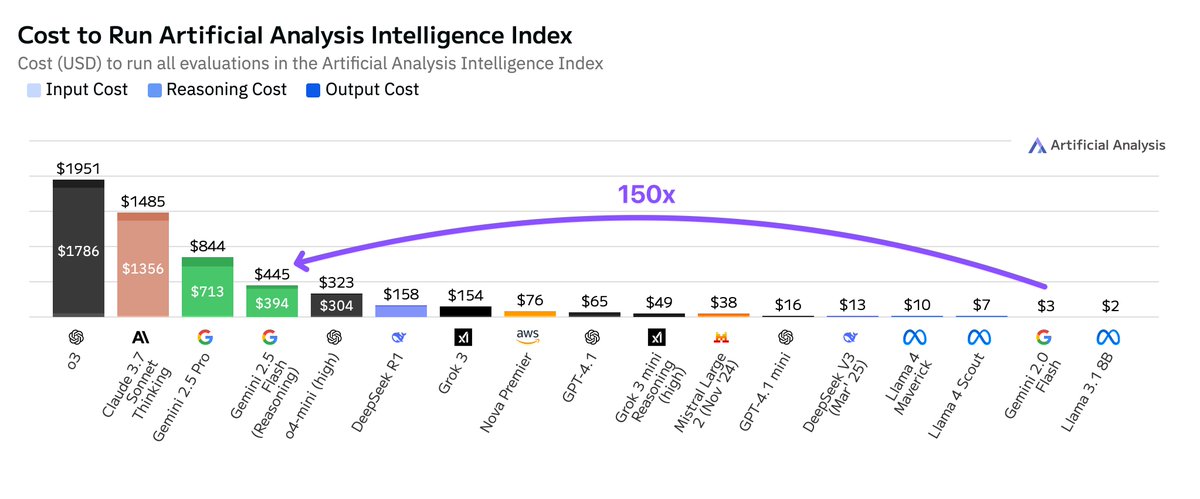

El costo de ejecución de Google Gemini 2.5 Flash es mucho mayor que el de la versión 2.0: Artificial Analysis señala que, al ejecutar su índice de inteligencia, el costo de Google Gemini 2.5 Flash es 150 veces mayor que el de Gemini 2.0 Flash. El aumento de costos se debe principalmente a un aumento de 9 veces en el precio de los tokens de salida (3.5 USD/millón de tokens con la función de inferencia activada, 0.6 USD desactivada, mientras que 2.0 Flash cuesta 0.4 USD) y a un uso de tokens 17 veces mayor. Esto ha generado un debate sobre el equilibrio entre baja latencia y rentabilidad en la serie de modelos Flash (fuente: arohan)

Google integrará Gemini Nano AI en el navegador Chrome para prevenir el fraude en línea: Google ha anunciado que agregará el modelo Gemini Nano AI al navegador Chrome, con el objetivo de mejorar la capacidad del navegador para identificar y bloquear estafas en línea, aumentando la seguridad de los usuarios en la red. Esta medida representa una aplicación adicional de la tecnología de IA en las funciones de seguridad de los navegadores convencionales (fuente: Reddit r/artificial, Reddit r/ArtificialInteligence)

Lightricks lanza LTXVideo 13B 0.9.7, mejorando la calidad y velocidad del vídeo, y presenta una versión cuantizada y modelos de mejora del espacio latente: Lightricks actualiza su modelo de vídeo LTXVideo a la versión 13B 0.9.7, ofreciendo calidad de vídeo cinematográfica y una velocidad de generación más rápida. Al mismo tiempo, ha lanzado una versión cuantizada de LTXV 13B, que reduce los requisitos de memoria y es adecuada para GPU de consumo, y ha presentado modelos de mejora espacial y temporal del espacio latente, que admiten inferencia multiescala y pueden mejorar la eficiencia de la generación de vídeo HD con menos decodificación/codificación. Los nodos y flujos de trabajo de ComfyUI relacionados también se han actualizado (fuente: GitHub Trending)

Investigación de Cohere Labs demuestra que la expansión en tiempo de prueba mejora el rendimiento del razonamiento translingüe en grandes modelos: Una investigación de Cohere Labs señala que, aunque los modelos de lenguaje de razonamiento se entrenan principalmente con datos en inglés, la expansión en tiempo de prueba (test-time scaling) puede mejorar su rendimiento en el razonamiento translingüe zero-shot en entornos multilingües y diferentes dominios. Este estudio ofrece nuevas ideas para mejorar la eficacia de los grandes modelos existentes en escenarios que no son en inglés (fuente: sarahookr)

IA utiliza fotos faciales para evaluar la edad fisiológica y predecir resultados de cáncer: Una nueva herramienta de IA puede estimar la edad fisiológica de un individuo analizando fotos faciales y, basándose en ello, predecir los resultados del tratamiento y las probabilidades de supervivencia para enfermedades como el cáncer. Esta tecnología ofrece un nuevo método no invasivo para la evaluación del pronóstico de enfermedades (fuente: Reddit r/artificial, Reddit r/ArtificialInteligence, Reddit r/artificial)

Los modelos de IA tienden a complicar en exceso el pensamiento al procesar tareas simples: Algunos desarrolladores han notado que los modelos de razonamiento más recientes, al enfrentarse a tareas simples, tienden a activar procesos de pensamiento excesivamente complejos, comportándose de manera “hipersensible”. Un enfoque más ideal podría ser tener un modelo base potente que pueda juzgar dinámicamente cuándo invocar la herramienta de “pensamiento”, evitando cálculos y retrasos innecesarios (fuente: skirano)

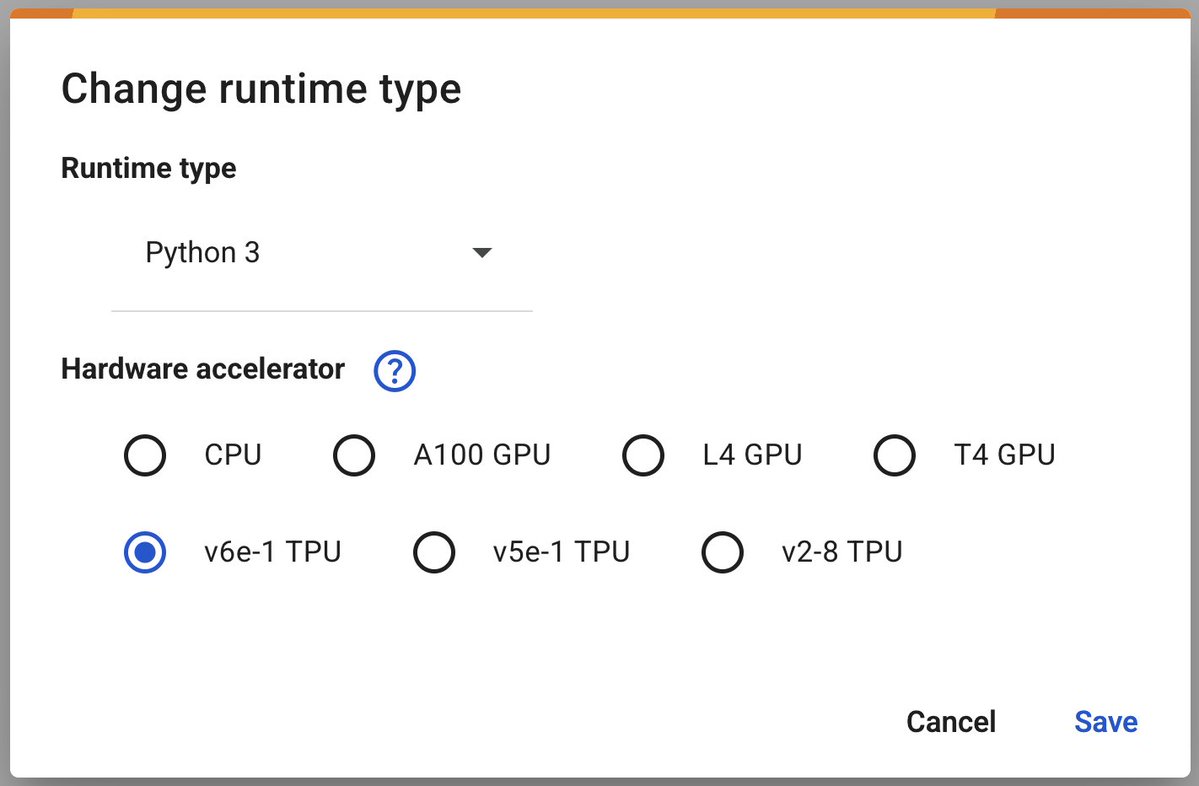

Google Colab lanza la TPU v6e-1 (Trillium), acelerando el aprendizaje profundo: Google Colaboratory ha anunciado el lanzamiento de su acelerador de aprendizaje profundo más rápido, la TPU v6e-1 (Trillium). Esta TPU cuenta con 32 GB de memoria de alto ancho de banda (el doble que la v5e-1) y un rendimiento máximo de 918 TFLOPS BF16 (casi tres veces el de una A100), proporcionando a investigadores y desarrolladores recursos computacionales más potentes (fuente: algo_diver)

Google AMIE: Demostración del agente de IA conversacional multimodal para diagnóstico: Google ha compartido la primera demostración de su agente de IA conversacional multimodal para diagnóstico, AMIE. AMIE es capaz de mantener conversaciones de diagnóstico multimodales (por ejemplo, combinando información de texto e imágenes), lo que marca una mayor exploración de la IA en el campo de la asistencia al diagnóstico médico (fuente: dl_weekly)

Se acusa a Anthropic de codificar información de “victoria de Trump” en el modelo Claude: Algunos usuarios han descubierto que el modelo Claude de Anthropic, al responder preguntas sobre las elecciones de 2024, parece tener codificada información sobre la victoria de Trump, a pesar de que su fecha límite de conocimiento es octubre de 2024. Esto ha suscitado debates sobre los mecanismos de actualización de información de los modelos de IA, los posibles sesgos y el impacto del contenido codificado en la confianza del usuario (fuente: Reddit r/ClaudeAI)

🧰 Herramientas

ByteDance lanza el framework multiagente de código abierto DeerFlow: ByteDance ha lanzado DeerFlow, un framework multiagente basado en LangChain. Este framework tiene como objetivo simplificar y acelerar el desarrollo de aplicaciones multiagente, proporcionando herramientas para construir sistemas de IA colaborativos complejos. Los desarrolladores pueden acceder a su repositorio de GitHub y sitio web oficial para obtener más información y ejemplos (fuente: hwchase17)

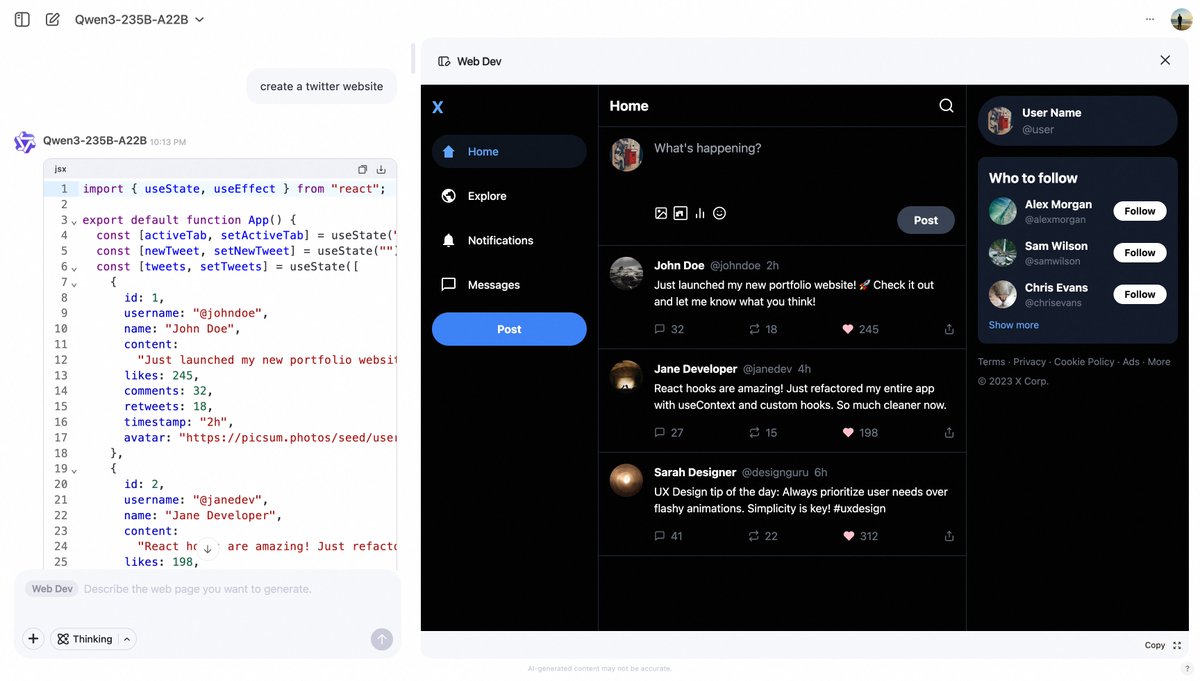

Qwen Chat de Alibaba lanza la función Web Dev, generando páginas web a través de prompts: Qwen Chat de Alibaba ha añadido la función “Web Dev”, que permite a los usuarios generar rápidamente código para páginas web y aplicaciones frontend mediante simples prompts de texto (por ejemplo, “crea un sitio web de Twitter”). Esta función tiene como objetivo reducir la barrera de entrada al desarrollo web, permitiendo que usuarios sin conocimientos de programación puedan construir sitios web mediante lenguaje natural (fuente: Alibaba_Qwen, huybery)

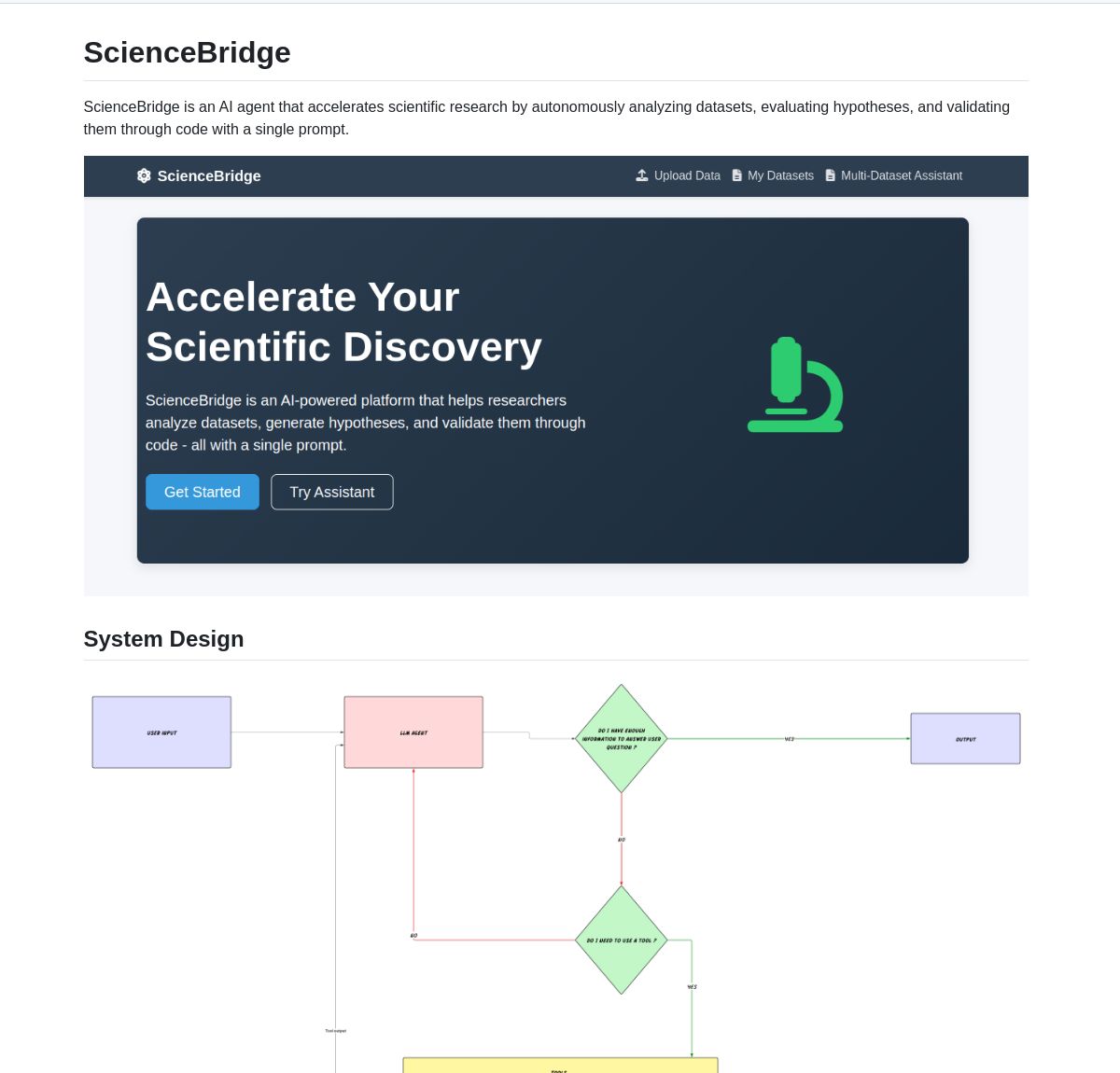

ScienceBridge AI: Agente de automatización de investigación científica impulsado por LangGraph: Un agente llamado ScienceBridge AI utiliza el framework LangGraph para automatizar los flujos de trabajo de investigación científica, incluyendo el análisis de datos, la validación de hipótesis, y puede generar resultados visuales de calidad para publicación, con el objetivo de acelerar el descubrimiento científico. El proyecto es de código abierto en GitHub (fuente: LangChainAI, hwchase17)

El Agente Q: Sistema multiagente impulsado por LangGraph que potencia la química cuántica: Una nueva investigación presenta El Agente Q, un sistema multiagente basado en LangGraph que democratiza los cálculos de química cuántica a través de la interacción en lenguaje natural y ha logrado una tasa de éxito del 87% en la automatización de flujos de trabajo complejos. El artículo correspondiente ha sido publicado en arXiv, mostrando el potencial de la IA para acelerar la investigación en química cuántica (fuente: LangChainAI, hwchase17)

LocalSite: Alternativa localizada a DeepSite, utiliza LLMs locales para crear páginas web: Inspirada en el proyecto DeepSite de HuggingFace, la herramienta LocalSite permite a los usuarios crear páginas web y componentes de UI mediante prompts de texto utilizando LLMs ejecutados localmente (como los modelos GLM-4, Qwen3 desplegados a través de Ollama y LM Studio) así como LLMs en la nube con API compatibles con OpenAI. El proyecto es de código abierto en GitHub y tiene como objetivo ofrecer una solución de generación de páginas web con IA localizada y personalizable (fuente: Reddit r/LocalLLaMA)

Alternativa de código abierto a NotebookLM demuestra la capacidad de la tecnología open source: El desarrollador m_ric creó una versión gratuita y de código abierto de NotebookLM de Google. La aplicación puede extraer contenido de PDF o URL, utilizar Llama 3.3-70B de Meta (ejecutado a 1000 tokens/segundo a través de Cerebras Systems) para escribir guiones de podcast, y usar Kokoro-82M para la conversión de texto a voz. La generación de audio se ejecuta gratuitamente en Zero GPU en H200s de HuggingFace, demostrando que las soluciones de código abierto ya pueden competir con las soluciones propietarias en funcionalidad y rentabilidad (fuente: huggingface, mervenoyann)

DeepFaceLab: Software líder de código abierto para la creación de Deepfakes: DeepFaceLab es un conocido software de código abierto especializado en la creación de contenido Deepfake. Ofrece funciones como el reemplazo de rostros, rejuvenecimiento, reemplazo de cabezas, etc., y es ampliamente utilizado en la creación de contenido para plataformas como YouTube, TikTok, entre otras. El proyecto se actualiza continuamente, ofrece versiones para Windows y Linux, y cuenta con un activo soporte comunitario (fuente: GitHub Trending)

GPUI Component: Biblioteca de componentes de UI de escritorio en Rust basada en GPUI: El equipo de longbridge ha lanzado GPUI Component, una biblioteca que contiene más de 40 componentes de UI de escritorio multiplataforma, con un diseño inspirado en los controles de macOS, Windows y shadcn/ui. Soporta múltiples temas, tamaños responsivos, diseños flexibles (Dock y Tiles), y puede manejar eficientemente la renderización de grandes cantidades de datos (Tabla/Lista virtualizada) y la renderización de contenido (Markdown/HTML). Su primer caso de aplicación es la aplicación de escritorio Longbridge Pro (fuente: GitHub Trending)

Ultralytics YOLO11: Framework líder de modelos de detección de objetos y visión por computadora: Ultralytics continúa actualizando su serie de modelos YOLO, y el último YOLO11 ofrece un rendimiento SOTA en tareas como detección de objetos, seguimiento, segmentación, clasificación y estimación de pose. El framework es fácil de usar, soporta interfaces CLI y Python, y se integra con plataformas como Weights & Biases, Comet ML, Roboflow y OpenVINO. Ultralytics HUB ofrece soluciones de visualización de datos, entrenamiento y despliegue sin código. Los modelos se distribuyen bajo la licencia de código abierto AGPL-3.0 y también se ofrecen licencias comerciales (fuente: GitHub Trending)

Tensorlink: Framework para la distribución de modelos PyTorch y el uso compartido de recursos P2P: SmartNodes Lab ha lanzado Tensorlink, un framework de código abierto diseñado para simplificar el entrenamiento distribuido y la inferencia de grandes modelos PyTorch. Encapsulando objetos centrales de PyTorch, abstrae la complejidad de los sistemas distribuidos, permitiendo a los usuarios utilizar los recursos de GPU de múltiples computadoras sin necesidad de conocimientos especializados o hardware. Tensorlink soporta API de inferencia bajo demanda y un framework de nodos, facilitando a los usuarios compartir o contribuir con potencia de cálculo. Actualmente se encuentra en una versión temprana (fuente: Reddit r/MachineLearning)

Optimización de prompts para generar fotos de figuras de anime: Un usuario compartió un caso de cómo, optimizando los prompts, utilizó IA (como GPT-4o) para generar fotos de figuras estilo anime japonés a partir de fotos de personas subidas. La clave está en describir con precisión la pose, expresión, vestimenta, material (como semimate), gradientes de color de la figura, así como el ángulo de la toma (escritorio, sensación de foto casual con el móvil). Una optimización adicional incluye generar vistas desde múltiples ángulos (frontal, lateral, posterior) dispuestas en una cuadrícula de cuatro, asegurando la integridad de los detalles de cuerpo entero y base de la figura, para facilitar el modelado 3D posterior (fuente: dotey, dotey)

NVIDIA Agent Intelligence Toolkit lanzado como código abierto: NVIDIA ha lanzado el Agent Intelligence Toolkit de código abierto, una biblioteca de recursos para construir aplicaciones de agentes inteligentes. Este kit de herramientas tiene como objetivo ayudar a los desarrolladores a crear e implementar de manera más conveniente agentes de IA basados en la tecnología de NVIDIA (fuente: nerdai)

SkyPilot y SGLang simplifican el despliegue autohospedado de Llama 4 en múltiples nodos: Nebius AI demostró cómo usar SkyPilot y SGLang (de LMSYS.org) para autohospedar el modelo Llama 4 de Meta en múltiples nodos (por ejemplo, 8x H100) con un solo comando. Esta solución ofrece alto rendimiento, uso eficiente de la memoria e integra características de nivel de producción como autenticación y HTTPS, además de facilitar la integración con la herramienta llm de Simon Willison (fuente: skypilot_org)

📚 Aprendizaje

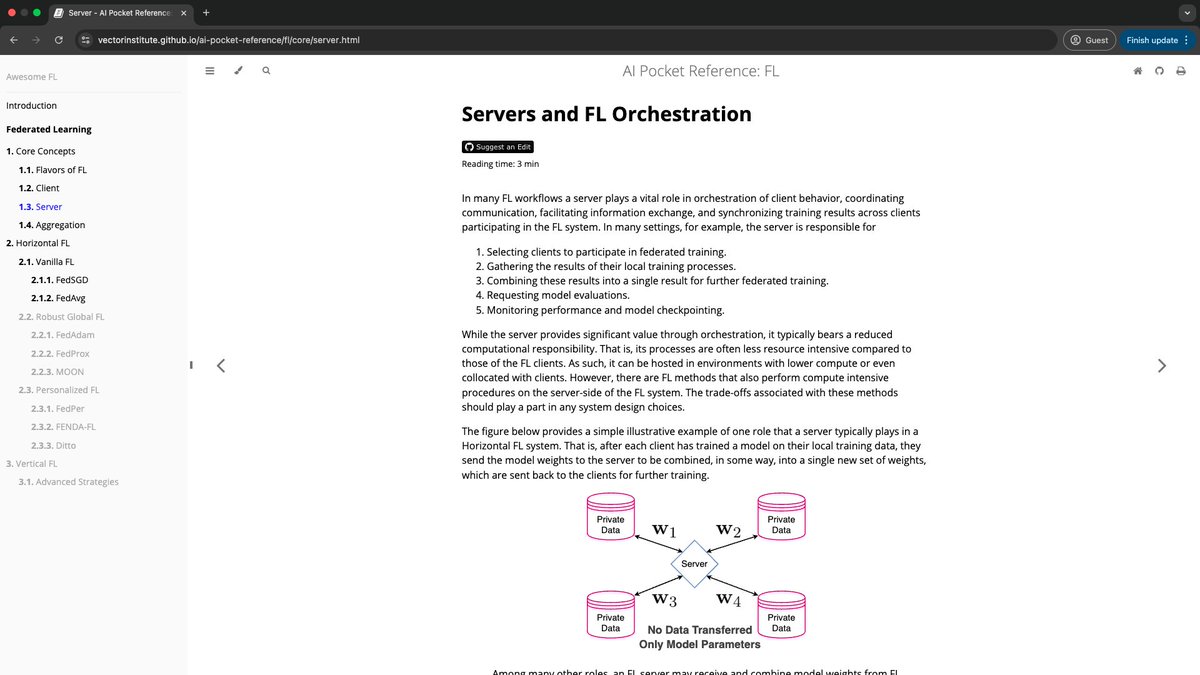

Vector Institute lanza AI Pocket References: El equipo de ingeniería de IA de Vector Institute ha publicado el proyecto AI Pocket References, una serie de tarjetas de información de IA concisas que cubren áreas como NLP (especialmente LLM), aprendizaje federado, IA responsable y computación de alto rendimiento. Estos materiales de referencia están diseñados para proporcionar una guía de iniciación a los principiantes y una revisión rápida para los profesionales experimentados, con un tiempo de lectura estimado de menos de 7 minutos por tarjeta. El proyecto es de código abierto y da la bienvenida a las contribuciones de la comunidad (fuente: nerdai)

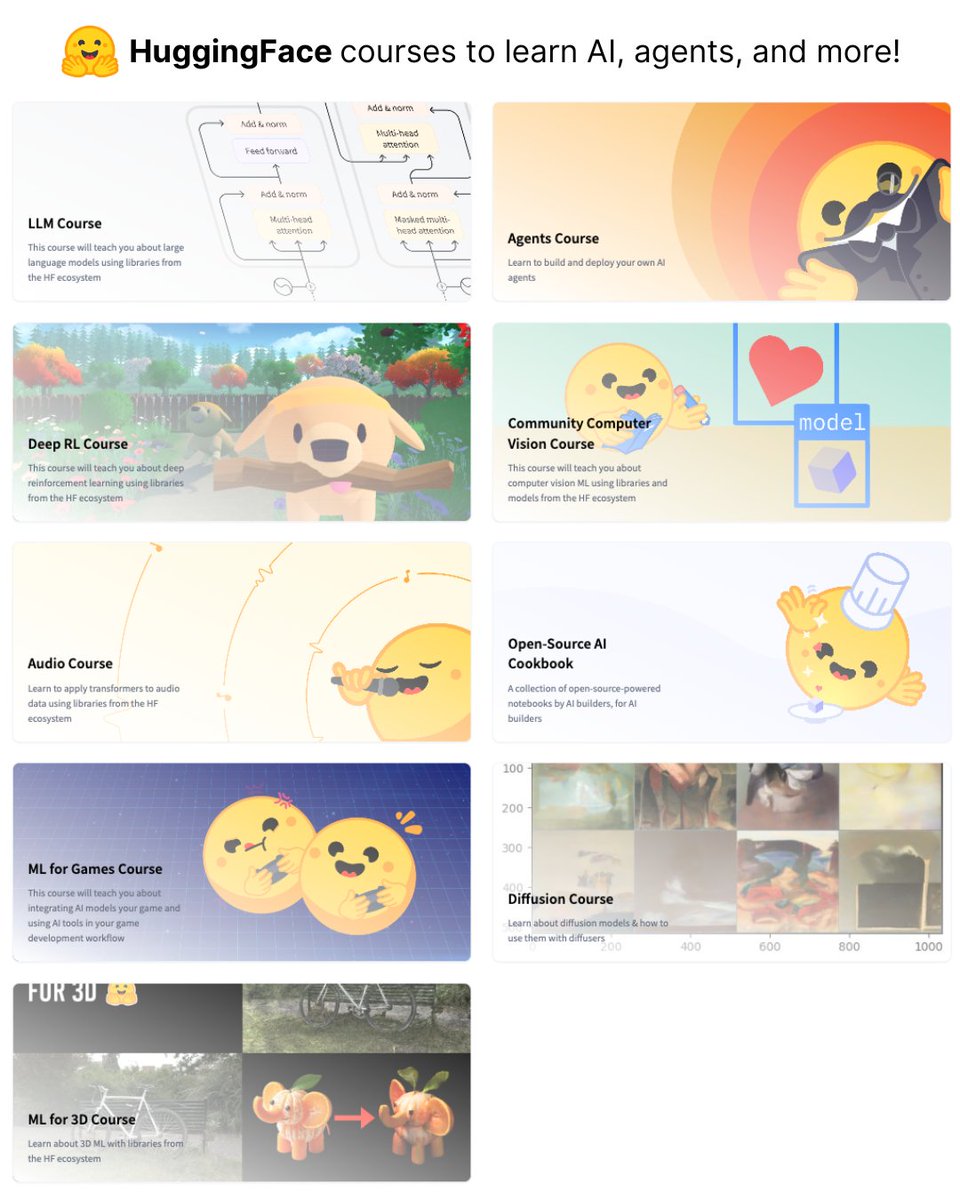

HuggingFace lanza 9 cursos gratuitos de IA: HuggingFace ha lanzado una serie de 9 cursos gratuitos de IA, que cubren múltiples áreas como modelos de lenguaje grandes (LLM), visión por computadora, agentes de IA, entre otros. Estos cursos ofrecen valiosos recursos para aquellos que deseen aprender sistemáticamente sobre IA (fuente: ClementDelangue)

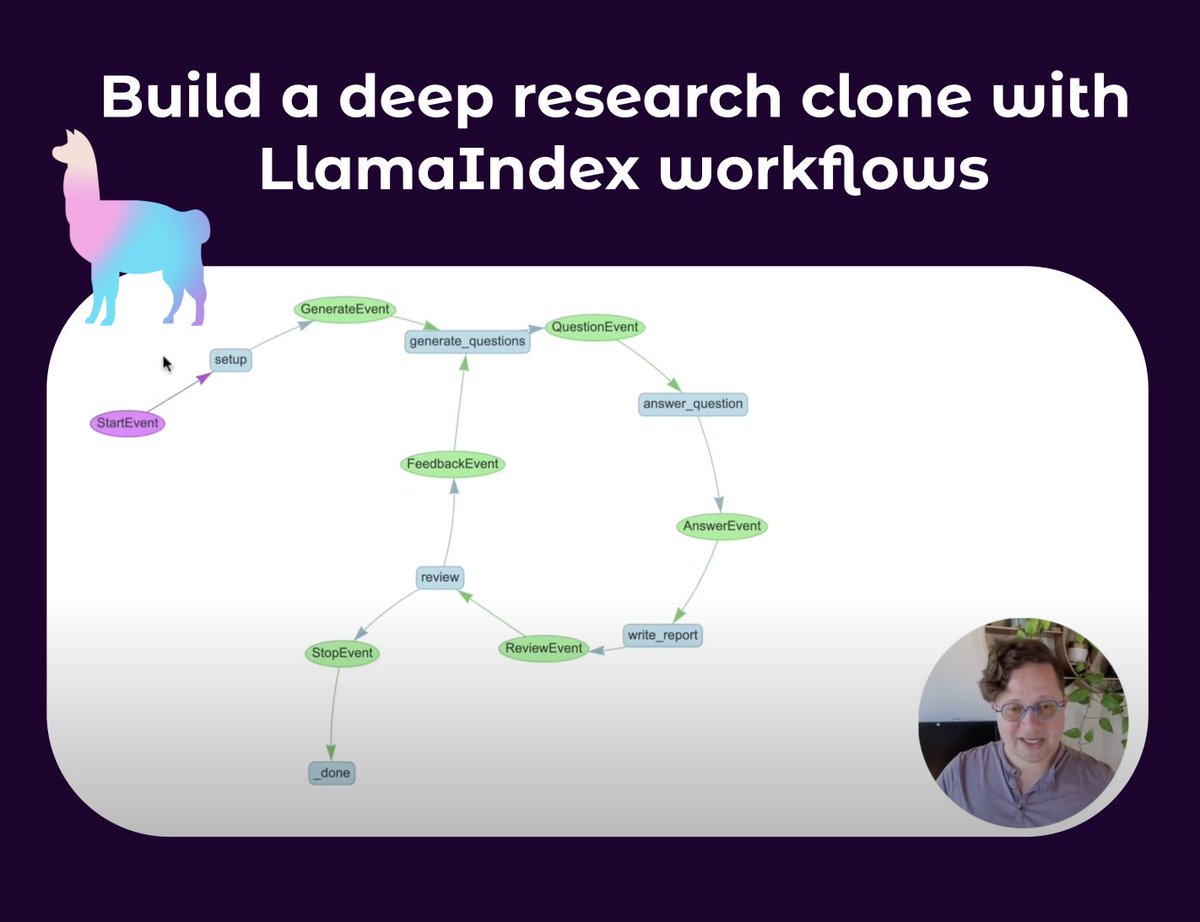

LlamaIndex publica tutorial para construir agentes de investigación profunda: Seldo de LlamaIndex ha publicado un video tutorial que guía a los usuarios sobre cómo construir un agente clon similar a Deep Research. El tutorial comienza con los fundamentos de los agentes individuales y avanza gradualmente hacia flujos de trabajo multiagente avanzados, incluyendo el uso de múltiples bases de conocimiento y la web para la investigación, el mantenimiento del contexto y la implementación de un flujo completo de investigación, redacción y revisión. El tutorial enfatiza la construcción de flujos de trabajo de agentes complejos con capacidades como bucles, ramificaciones, ejecución concurrente y autorreflexión (fuente: jerryjliu0, jerryjliu0)

Retrospectiva del desarrollo de la tecnología RAG: El artículo de Lewis et al. y trabajos anteriores: Aran Komatsuzaki señala que, aunque el artículo de Lewis et al. de 2020 es ampliamente citado por acuñar el término RAG (Retrieval-Augmented Generation), la generación aumentada por recuperación en sí misma ya era una dirección de investigación activa anteriormente, con trabajos como DrQA (2017), ORQA (2019), REALM (2020), etc. La principal contribución de Lewis et al. fue proponer un nuevo método de preentrenamiento conjunto para RAG, pero no es la forma más común de implementación de RAG en la actualidad. Esto nos recuerda la importancia de prestar atención a la continuidad del desarrollo tecnológico y a los trabajos fundacionales tempranos (fuente: arankomatsuzaki)

Lograr un formato de salida de cadena de pensamiento similar a Gemini 2.5 Pro con Qwen3: Inspirado por el README de Apriel-Nemotron-15b-Thinker sobre forzar al modelo a comenzar la salida en un formato específico (como “Here are my reasoning steps:\n”), un desarrollador, mediante la funcionalidad de OpenWebUI, hizo que el modelo Qwen3 siempre comience su salida con <think>\nMy step by step thinking process went something like this:\n1.. Los experimentos muestran que esto induce a Qwen3 a pensar y generar salidas de manera escalonada, similar a Gemini 2.5 Pro, aunque esto en sí mismo no mejora la inteligencia del modelo, sino que cambia el formato de su pensamiento y expresión (fuente: Reddit r/LocalLLaMA)

Podcast comparte la filosofía de diseño y los secretos de desarrollo de Claude Code: El podcast Latent Space invitó a Catherine Wu y Boris Cherny, creadores de Claude Code, para compartir la filosofía de diseño y la historia de desarrollo de esta herramienta de programación con IA. Los puntos clave incluyen: CC ya puede escribir alrededor del 80% de su propio código (con revisión humana), inspirado en Aider, se enfoca en una implementación concisa (como usar archivos Markdown para la memoria en lugar de bases de datos vectoriales), adopta un equipo pequeño y una iteración interna para impulsar el producto, ofrece acceso al modelo original para usuarios avanzados y admite flujos de trabajo paralelos. El podcast también discutió comparaciones con herramientas como Cursor y Windsurf, así como temas de costos, diseño UI/UX y la posibilidad de hacerlo open source (fuente: Reddit r/ClaudeAI)

💼 Negocios

Salesforce inicia un plan de IA de 500 millones de dólares en Arabia Saudita y forma un equipo: Salesforce ha comenzado a formar un equipo en Arabia Saudita como parte de su plan de inversión de 500 millones de dólares a cinco años, destinado a impulsar la adopción y el desarrollo de la inteligencia artificial en el país. Esto marca otra importante iniciativa de las grandes empresas tecnológicas en el ámbito de la IA en la región de Oriente Medio (fuente: Reddit r/artificial, Reddit r/ArtificialInteligence)

Fidji Simo, nueva CEO de la división de aplicaciones de OpenAI, dejará la junta directiva de Shopify: Fidji Simo, actual CEO de Instacart, tras ser nombrada CEO de la recién creada división de aplicaciones de OpenAI, renunciará a su puesto en la junta directiva de Shopify. Esta medida podría tener como objetivo permitirle concentrarse más en su rol de liderazgo en OpenAI, gestionando su creciente negocio y línea de productos. Anteriormente, hubo informes de que OpenAI podría estar involucrada en un posible acuerdo de 1.000 millones de dólares con Arm (fuente: steph_palazzolo, steph_palazzolo)

Lux Capital establece un fondo de 100 millones de dólares para apoyar a científicos estadounidenses que enfrentan recortes de financiación: Para hacer frente a los drásticos recortes presupuestarios de la Fundación Nacional de Ciencias de EE. UU. (NSF) (que se dice alcanzan el 50%, lo que ha llevado a la cancelación de proyectos en curso y recortes de personal), Lux Capital ha anunciado el lanzamiento de la “Línea de Ayuda Científica Lux”, invirtiendo 100 millones de dólares para apoyar a los científicos estadounidenses afectados. El objetivo es garantizar la continuación de proyectos de investigación cruciales y mantener la competitividad en innovación tecnológica de EE. UU. (fuente: ylecun, riemannzeta)

🌟 Comunidad

Continúa el debate sobre si la IA reemplazará los trabajos humanos: En la comunidad es muy común el debate sobre si la IA provocará un desempleo masivo. Una opinión sostiene que, impulsadas por el capitalismo, las empresas buscarán la eficiencia y utilizarán la IA para reemplazar la costosa mano de obra humana, lo que llevará a una reducción de puestos como los de programador. Otra opinión se basa en la historia, argumentando que el progreso tecnológico (como la luz eléctrica reemplazando a los faroleros) eliminará puestos antiguos, pero al mismo tiempo creará nuevos (como fábricas de bombillas, industrias relacionadas con la electricidad), siendo la clave la actualización de habilidades y la innovación. Actualmente, la IA todavía necesita intervención humana en tareas complejas y depuración de código, pero su rápido desarrollo y su eficiente desempeño en algunos campos hacen que muchos se preocupen por las perspectivas laborales futuras, mientras que otros consideran que esto es alarmismo o una sobreestimación a corto plazo de las capacidades de la IA (fuente: Reddit r/ArtificialInteligence)

Preocupaciones sobre el límite de capacidad de los LLM y un invierno de la IA: Algunos miembros de la comunidad y expertos (como Yann LeCun, François Chollet) comienzan a debatir si los grandes modelos de lenguaje (LLM) están encontrando un cuello de botella. Aunque los LLM se desempeñan excelentemente en la imitación de patrones, todavía tienen limitaciones en la comprensión real, el razonamiento y el manejo del problema de las alucinaciones, y la dependencia excesiva de datos sintéticos también podría plantear problemas. Si faltan nuevas direcciones de investigación (como modelos del mundo, sistemas neurosimbólicos), el actual auge de la IA podría enfriarse, lo que llevaría a una reducción de la inversión e incluso podría desencadenar un nuevo “invierno de la IA”. Sin embargo, también hay opiniones que sostienen que, aunque los LLM generales puedan encontrar un techo, los modelos especializados y los agentes de IA siguen desarrollándose rápidamente (fuente: Reddit r/ArtificialInteligence)

El plan de OpenAI de lanzar un modelo de código abierto en verano genera debate en la comunidad: Sam Altman testificó ante el Senado que OpenAI planea lanzar un modelo de código abierto este verano. La comunidad reaccionó de diversas maneras: algunos esperan su rendimiento, otros dudan de si será como el FSD de Musk, “siempre en camino”, o si será “capado” para no competir con los modelos de pago. Otros analizan que empresas como Meta y Alibaba, al lanzar modelos preentrenados gratuitos de alta calidad, buscan debilitar la posición de mercado de empresas como OpenAI, y que esta medida de OpenAI podría ser una estrategia de respuesta. Sin embargo, considerando el modelo de negocio de OpenAI y sus altos costos operativos, el posicionamiento y la competitividad de su modelo de código abierto aún están por verse (fuente: Reddit r/LocalLLaMA)

El impacto de la IA en la fiabilidad de la información en Internet genera preocupación: Usuarios en Reddit expresaron su preocupación por el impacto de la IA en la fiabilidad de Internet. En particular, funciones como AI Overviews de Google a veces proporcionan respuestas inexactas o “absurdas con total seriedad” (por ejemplo, explicando frases inventadas por el usuario), lo que podría confundir a la próxima generación de usuarios e incluso hacerles dudar de toda la información. En los comentarios, las opiniones son diversas: algunos creen que Internet nunca ha sido completamente fiable y que el pensamiento crítico siempre es importante; otros bromean diciendo que el autor del post ha revelado su edad (fuente: Reddit r/ArtificialInteligence)

Usuario comparte experiencia de alivio de la depresión al conversar con ChatGPT: Un usuario compartió cómo, después de una larga conversación con ChatGPT, sus pensamientos depresivos y suicidas se aliviaron. Afirmó que incluso desahogarse con una IA le ayudó a liberar una enorme presión psicológica y le dio el coraje para seguir adelante y buscar ayuda de amigos y familiares. Muchos en los comentarios expresaron experiencias similares, considerando que la IA puede ofrecer un acompañamiento imparcial y paciente en el apoyo psicológico, e incluso algunos usuarios compartieron prompts para que ChatGPT interpretara a un “yo superior” para conversaciones profundas. Esto generó un debate sobre el potencial de la IA en la asistencia para la salud mental (fuente: Reddit r/ChatGPT)

Reflexión sobre la afirmación “los LLM solo predicen la siguiente palabra”: En la comunidad se debate que la afirmación “los LLM solo predicen la siguiente palabra” es una simplificación excesiva que puede llevar a subestimar la verdadera capacidad y el impacto potencial de los LLM. La clave está en la complejidad y utilidad del contenido que producen los LLM (como código, análisis), no en su mecanismo de generación. Los expertos expresan preocupación por el rápido desarrollo de la IA y sus capacidades desconocidas, mientras que el público en general podría no reconocer plenamente la profunda transformación que la tecnología de IA está a punto de traer debido a tales simplificaciones. El debate también aborda las cuestiones de la “inteligencia” y la “conciencia” de la IA, argumentando que incluso si la IA no tiene conciencia en el sentido humano, su capacidad es suficiente para tener un impacto enorme en el mundo (fuente: Reddit r/ArtificialInteligence)

Discusión sobre el valor de la versión de pago de Claude: la gestión de proyectos, la longitud del contexto y el modo de pensamiento son clave: Usuarios de la versión de pago de Claude compartieron por qué la suscripción vale la pena. Las principales ventajas incluyen la función “Proyectos (Projects)”, que permite a los usuarios cargar grandes cantidades de material de referencia (base de conocimiento) para tareas específicas (como preparación de cursos, SEO de sitios web, análisis de publicidad, resúmenes de noticias, consultas de recetas), permitiendo que Claude proporcione ayuda continua en un contexto específico. Además, una ventana de contexto más grande, un “Modo de Pensamiento (Thinking Mode)” más potente y un mayor número de consultas también son atractivos de la versión de pago. Los usuarios informan que, al manejar tareas complejas, revisión de código, análisis de documentos y redacción de correos electrónicos, Claude Pro, combinado con herramientas MCP (como Desktop Commander), supera el rendimiento de algunas soluciones integradas en IDE, que pueden limitar la capacidad de análisis profundo del modelo debido a la optimización de costos o a prompts de sistema incorporados (fuente: Reddit r/ClaudeAI, Reddit r/ClaudeAI)

El cambio de licencia de OpenWebUI genera preocupación en la comunidad y usuarios empresariales: El proyecto OpenWebUI cambió recientemente su licencia de software, una modificación que ha generado preocupación entre algunos miembros de la comunidad y usuarios empresariales. Algunas empresas han manifestado que están discutiendo dejar de usar y contribuir al proyecto, y que temporalmente se basarán en la última versión con licencia BSD para hacer un fork. Este evento subraya el impacto que los cambios de licencia en proyectos de código abierto pueden tener en el ecosistema de usuarios y contribuyentes, especialmente en escenarios de aplicación comercial (fuente: Reddit r/OpenWebUI)

💡 Otros

El Vaticano planea invertir en nuevas fuentes de datos para hacer frente al problema del “muro de datos”: Desde 2023, el entrenamiento de grandes modelos de lenguaje se enfrenta al problema del “muro de datos”, es decir, la mayoría de los datos textuales humanos conocidos ya han sido indexados y entrenados. Para resolver este problema, el Vaticano planea invertir en nuevas fuentes de datos, por ejemplo, transcribiendo documentos eclesiásticos medievales mediante tecnología OCR y generando datos sintéticos, para continuar mejorando la capacidad de los modelos de IA (fuente: jxmnop, Dorialexander)

El rápido desarrollo tecnológico de China atrae la atención en múltiples campos de innovación: Una publicación detalla numerosas aplicaciones tecnológicas sorprendentes observadas por el autor durante un viaje de 15 días por China, incluyendo muñecas sexuales DeepSeek, dirigibles eléctricos, drones para gestionar accidentes de tráfico, etc. Esto ha generado un debate sobre la velocidad del desarrollo tecnológico y la amplitud de las aplicaciones en China en campos como la inteligencia artificial, la robótica, el transporte de nueva energía, y se ha comparado con países de alta tecnología como Singapur (fuente: GavinSBaker)

Expectativas sobre el desarrollo de la IA en el campo de la medicina: Miembros de la comunidad expresaron su esperanza de mayores avances de la IA en el campo de la medicina. Las ideas incluyen robots de IA capaces de escanear el cuerpo instantáneamente y detectar síntomas de enfermedades en etapas tempranas, así como sistemas que puedan ayudar en tratamientos precisos, cirugía y acelerar la recuperación. Aunque la tecnología existente ya ha logrado avances en algunos aspectos, la gente en general cree que la IA todavía tiene un enorme potencial por explotar para mejorar la accesibilidad, la precisión y salvar vidas en la atención médica (fuente: Reddit r/ArtificialInteligence, Reddit r/artificial)