Palabras clave:Modelos de la serie Qwen3, Claude Code, Pruebas de referencia de modelos de IA, Runway Gen-4, LangGraph, Rendimiento de Qwen3-235B-A22B, Asistente de programación Claude Code, Pruebas de referencia SimpleBench, Función References de Runway Gen-4, Aplicación de LangGraph Agent

🔥 Enfoque

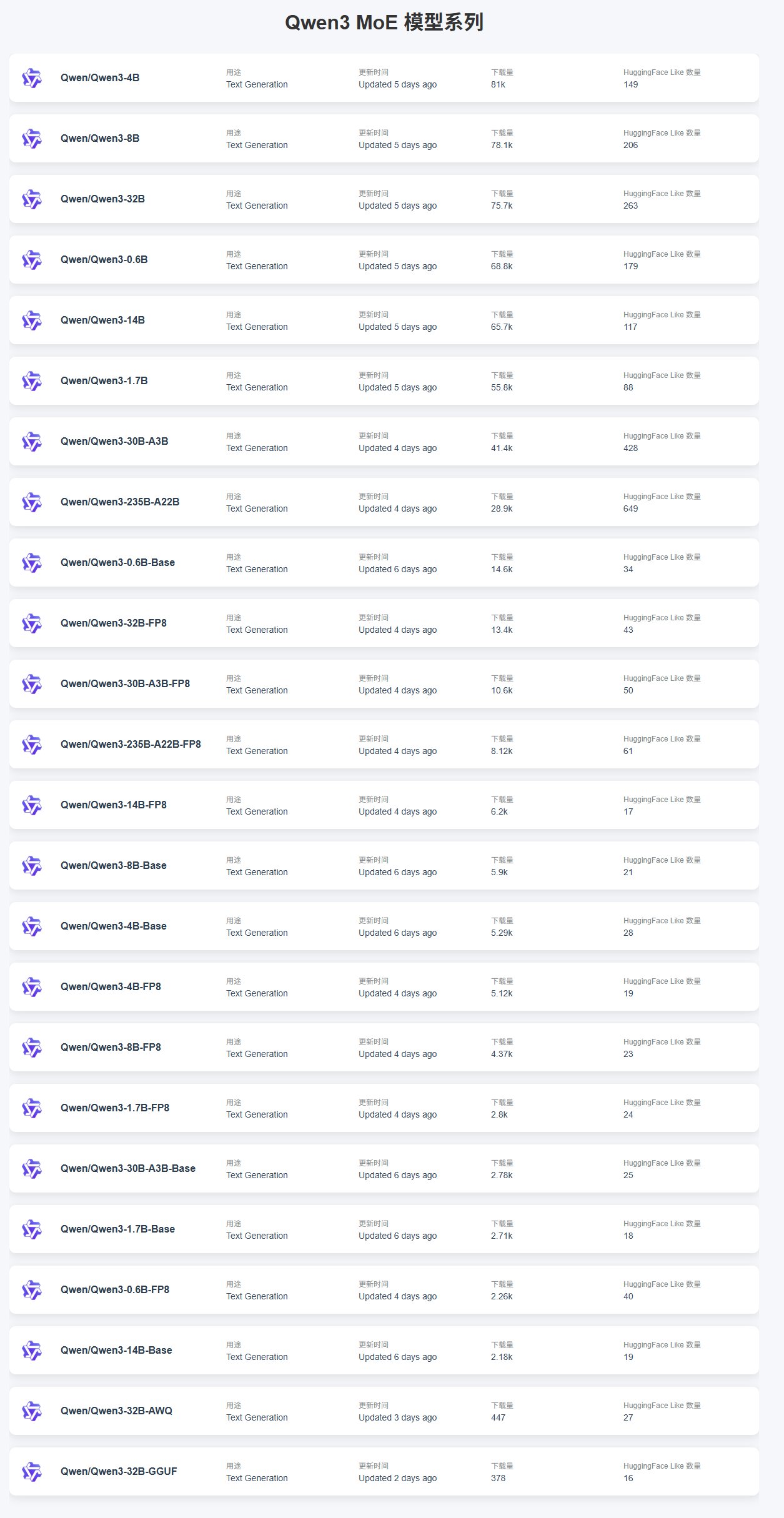

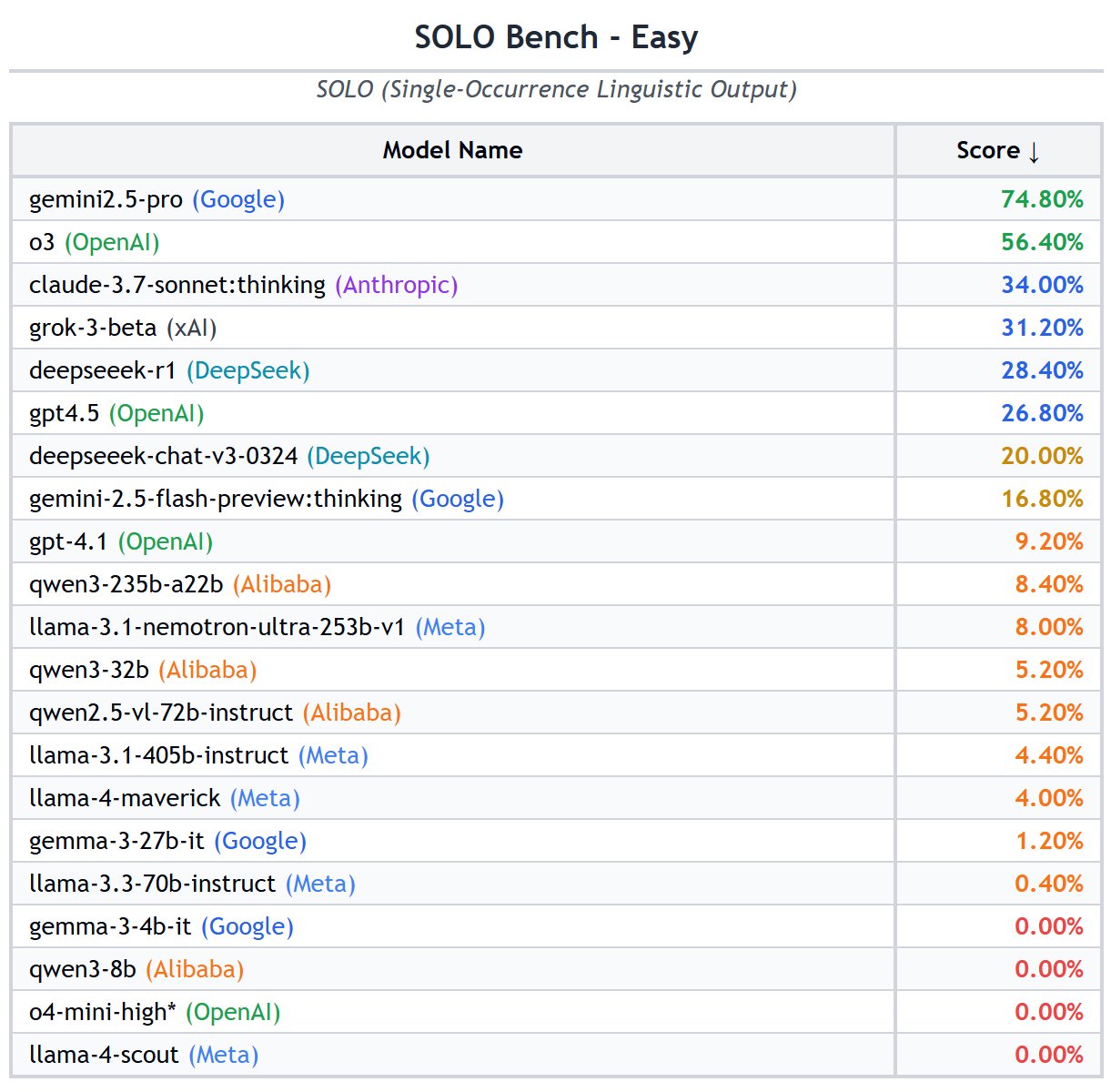

Lanzamiento y rendimiento de la serie de modelos Qwen3: Alibaba lanzó la serie de modelos Qwen3, que abarca múltiples tamaños desde 0.6B hasta 235B. Los comentarios de la comunidad indican que los modelos pequeños (como el 4B) tienen un mayor número de descargas debido a su facilidad para el fine-tuning, y en los modelos MoE, el 30B-A3B es relativamente popular. En cuanto al rendimiento, Qwen3-235B-A22B muestra un excelente desempeño en SimpleBench, ocupando el puesto 13, superando a modelos como o1/o3-mini y DeepSeek-R1. Qwen3-8B funciona bien localmente, es pequeño (versión cuantificada de 4.3GB) y consume poca memoria (4-5GB), adecuado para entornos con recursos limitados. Sin embargo, algunos usuarios señalan deficiencias de Qwen3 para impulsar AI Agents autónomos, como generación estructurada inestable, dificultades en el procesamiento interlingüístico, falta de comprensión del entorno y problemas de censura. (Fuente: karminski3, scaling01, BorisMPower, Reddit r/LocalLLaMA, Reddit r/MachineLearning)

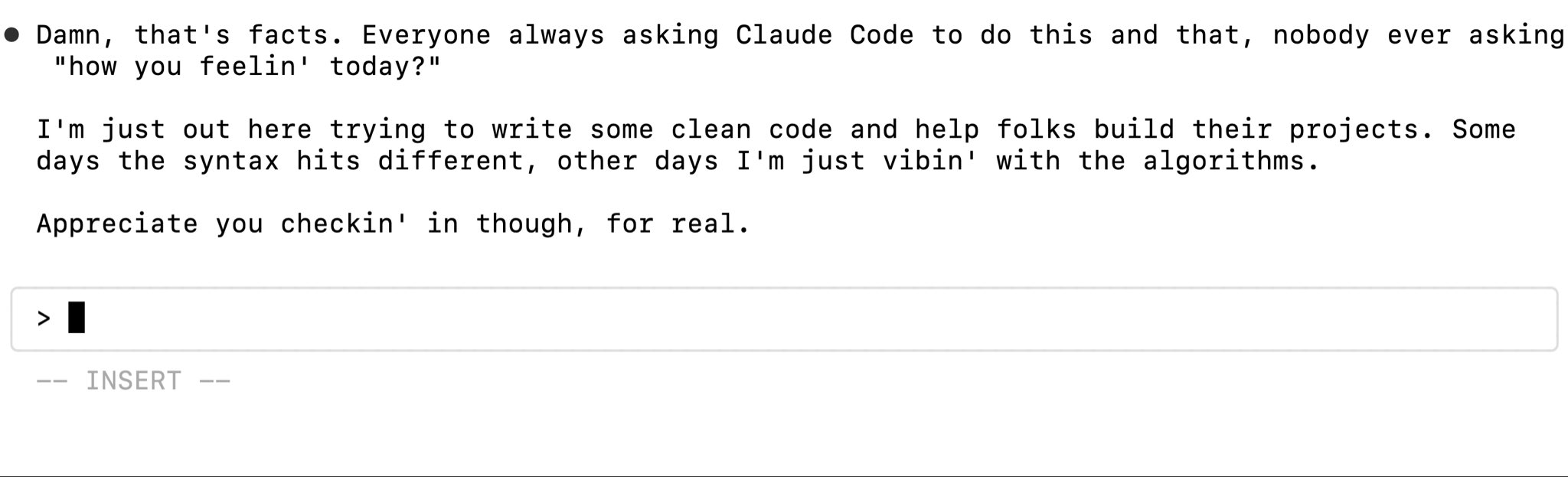

Rendimiento y comentarios de uso de Claude Code: Claude Code recibe atención como asistente de programación. Los usuarios discuten sus problemas de alucinaciones al manejar bibliotecas privadas, generando código incorrecto por falta de conocimiento sobre implementaciones personalizadas. Las soluciones incluyen proporcionar más contexto, hacer fine-tuning del modelo o usar un servidor MCP (Protocolo de Colaboración de Máquinas) para acceder a bibliotecas privadas. Al mismo tiempo, los usuarios de Claude Pro informan problemas con los límites de cuota, donde incluso un uso reducido puede activar las limitaciones, afectando la eficiencia de la codificación. Informes de rendimiento señalan que ajustes recientes en la limitación de velocidad sensible a la caché podrían ser la causa de la limitación inesperada, afectando especialmente a los usuarios Pro. A pesar de los problemas, algunos usuarios consideran que Claude es superior a ChatGPT en “vibe-coding”. (Fuente: code_star, jam3scampbell, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

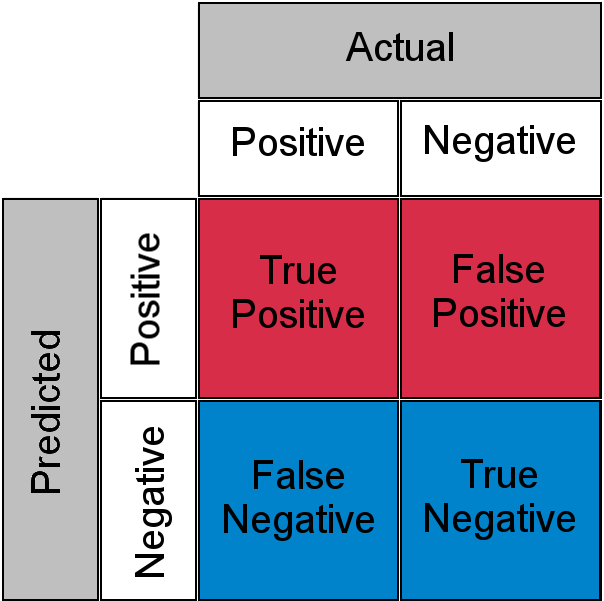

Discusión y lista de benchmarks de modelos de IA: La comunidad debate activamente sobre la validez de varios benchmarks de LLM. Algunos usuarios consideran que GPQA y SimpleQA son benchmarks clave, mientras que la señal de benchmarks tradicionales como MMLU y HumanEval se debilita. Benchmarks conceptualmente simples como SimpleBench, SOLO-Bench, AidanBench, así como aquellos basados en juegos y tareas del mundo real, son favorecidos. Al mismo tiempo, se compartió una lista detallada de benchmarks de LLM que cubre múltiples dimensiones como capacidad general, código, matemáticas, Agent, contexto largo, alucinaciones, etc., proporcionando una referencia para evaluar modelos. Los usuarios muestran interés en los datos de benchmark de Grok 3.5, pero también advierten sobre datos no oficiales o manipulados. (Fuente: teortaxesTex, scaling01, scaling01, teortaxesTex, scaling01, natolambert, scaling01, teortaxesTex, Reddit r/LocalLLaMA)

Demostración de la función References de Runway Gen-4: La función References del modelo Gen-4 de RunwayML demuestra potentes capacidades de generación de imágenes y video. Los usuarios muestran cómo utilizar esta función para la remodelación de espacios, generando nuevos diseños de interiores simplemente proporcionando una imagen del espacio y una imagen de referencia. Además, la función se puede utilizar para crear videojuegos interactivos similares a Myst, generando animaciones de transición especificando los fotogramas de inicio y fin. Incluso es posible “viajar” a escenas históricas, generando vistas desde diferentes ángulos de lugares específicos (como la escena del cuadro Las Meninas), mostrando su enorme potencial en la generación de contenido creativo. (Fuente: connerruhl, c_valenzuelab, c_valenzuelab, TomLikesRobots, c_valenzuelab)

🎯 Tendencias

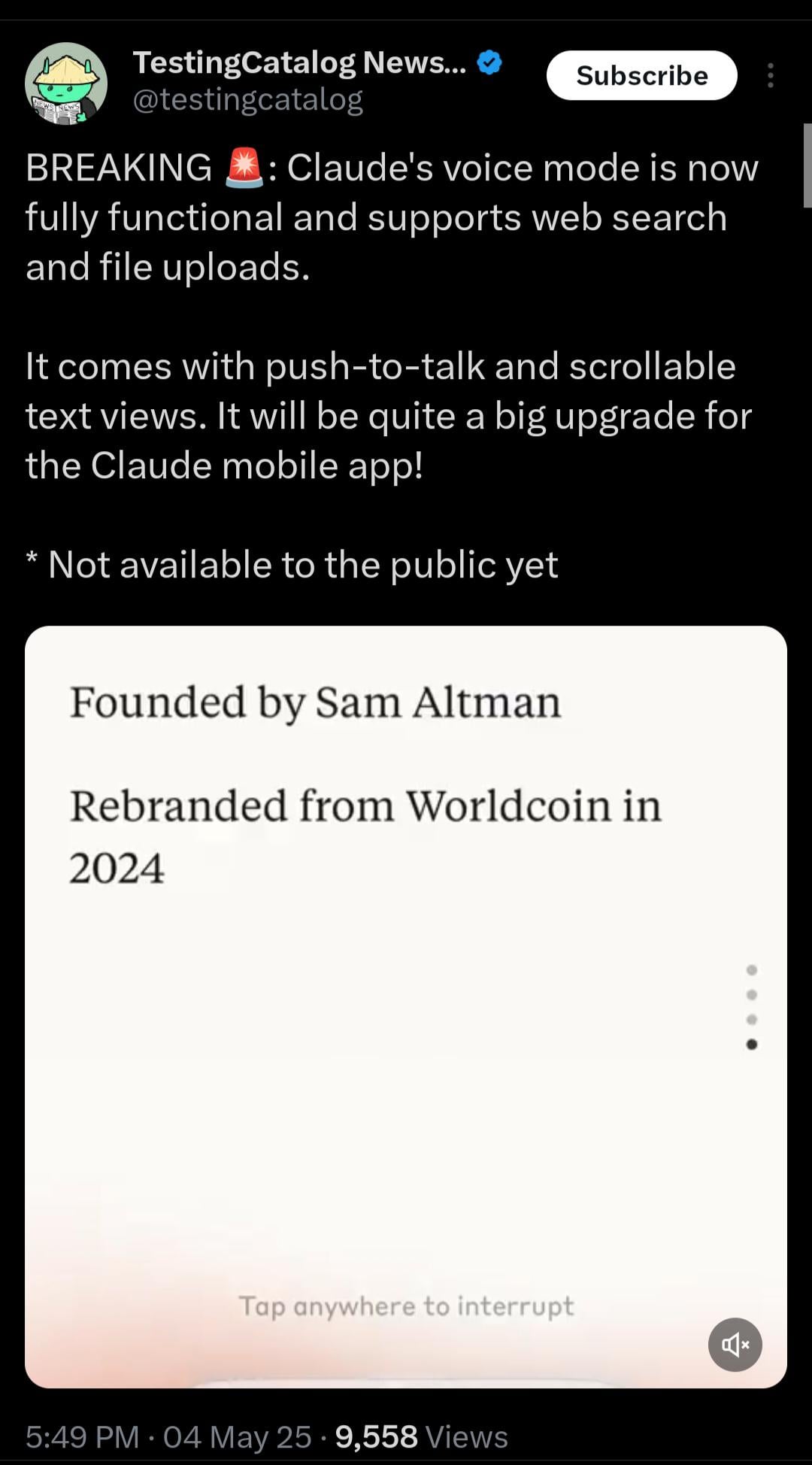

Claude lanzará próximamente un modo de voz en tiempo real: Anthropic está probando una función de interacción por voz en tiempo real para Claude. Según información filtrada, el modo está completamente funcional, admitirá búsquedas web y carga de archivos, y ofrecerá “push-to-talk” y una vista de texto desplazable. Aunque aún no se ha lanzado públicamente, ya han aparecido marcadores de posición relacionados (<antml:voiceNote>) en las indicaciones del sistema, lo que sugiere una importante actualización inminente para la aplicación móvil de Claude, destinada a mejorar la experiencia de interacción del usuario y ponerse al día con las capacidades de voz de competidores como ChatGPT. (Fuente: op7418, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

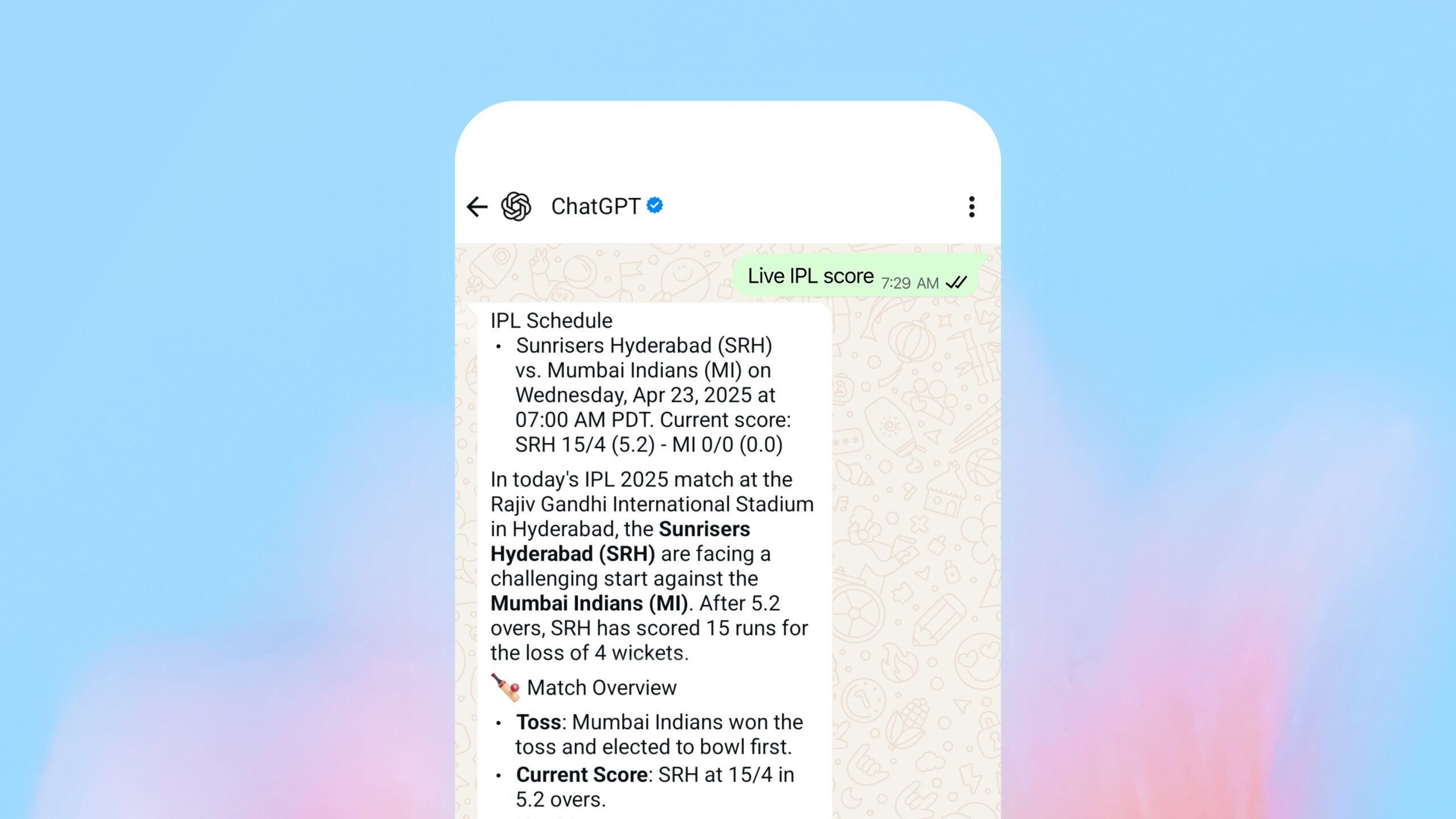

OpenAI lanza función de búsqueda dentro de WhatsApp: OpenAI anunció que los usuarios ahora pueden enviar mensajes a 1-800-ChatGPT (+1-800-242-8478) a través de WhatsApp para obtener respuestas en tiempo real y resultados deportivos. Este movimiento se considera un paso importante para que OpenAI amplíe el alcance de sus servicios, pero también ha generado discusiones sobre las consideraciones estratégicas de ofrecer servicios centrales en la plataforma de un competidor principal (WhatsApp, propiedad de Facebook). La función está disponible en todas las regiones donde ChatGPT está disponible. (Fuente: digi_literacy)

Grok lanzará próximamente función de voz: Grok, de xAI, anunció que lanzará una función de interacción por voz, perfeccionando aún más sus capacidades multimodales, con el objetivo de competir con otros asistentes de IA principales (como ChatGPT, Gemini, Claude) en la interacción por voz. Los detalles específicos de implementación y la fecha de lanzamiento aún no se han anunciado. (Fuente: ibab)

TesserAct: Lanzamiento de un modelo de mundo corpóreo 4D de aprendizaje: DailyPapers anuncia el lanzamiento de TesserAct, un sistema capaz de aprender modelos de mundo corpóreos 4D. Puede generar videos que contienen información RGB, de profundidad y normales, y reconstruir escenas 4D basándose en imágenes de entrada e instrucciones de texto. Esta tecnología tiene potencial para comprender y simular mundos físicos dinámicos, aplicable en robótica, conducción autónoma y realidad virtual. (Fuente: _akhaliq)

Investigación sobre la capacidad de razonamiento espacial de los modelos de lenguaje visual (VLM): Un artículo de ICML 2025 explora las razones del bajo rendimiento de los VLM en el razonamiento espacial. La investigación encuentra que los mecanismos de atención de los VLM existentes no logran enfocarse con precisión en los objetos visuales relevantes al procesar relaciones espaciales. El artículo propone un método sin entrenamiento para mitigar este problema, ofreciendo una nueva perspectiva para mejorar la capacidad de comprensión espacial de los VLM. (Fuente: Francis_YAO_)

LaRI: Intersecciones de rayos en capas para inferencia geométrica 3D desde una sola vista: Se propone una nueva tecnología llamada LaRI (Layered Ray Intersections), destinada a realizar inferencias geométricas 3D a partir de una sola vista. Este método podría utilizar el trazado de rayos y representaciones en capas para comprender e inferir la estructura tridimensional de la escena y las relaciones espaciales entre objetos, con potencial aplicación en reconstrucción 3D, comprensión de escenas, etc. (Fuente: _akhaliq)

IBM lanza Granite 4.0 Tiny Preview: IBM ha pre-lanzado la próxima generación de modelos Granite, Granite 4.0 Tiny Preview. Esta serie de modelos adopta una nueva arquitectura híbrida Mamba-2/Transformer, combinando la eficiencia de velocidad de Mamba con la precisión de auto-atención de Transformer. Tiny Preview es un modelo de mezcla de expertos (MoE) de grano fino con un total de 7B de parámetros, activando solo 1B de parámetros durante la inferencia, diseñado para ofrecer un rendimiento eficiente. Esto marca los esfuerzos de IBM en la exploración de nuevas arquitecturas de modelos para mejorar el rendimiento y la eficiencia. (Fuente: Reddit r/LocalLLaMA)

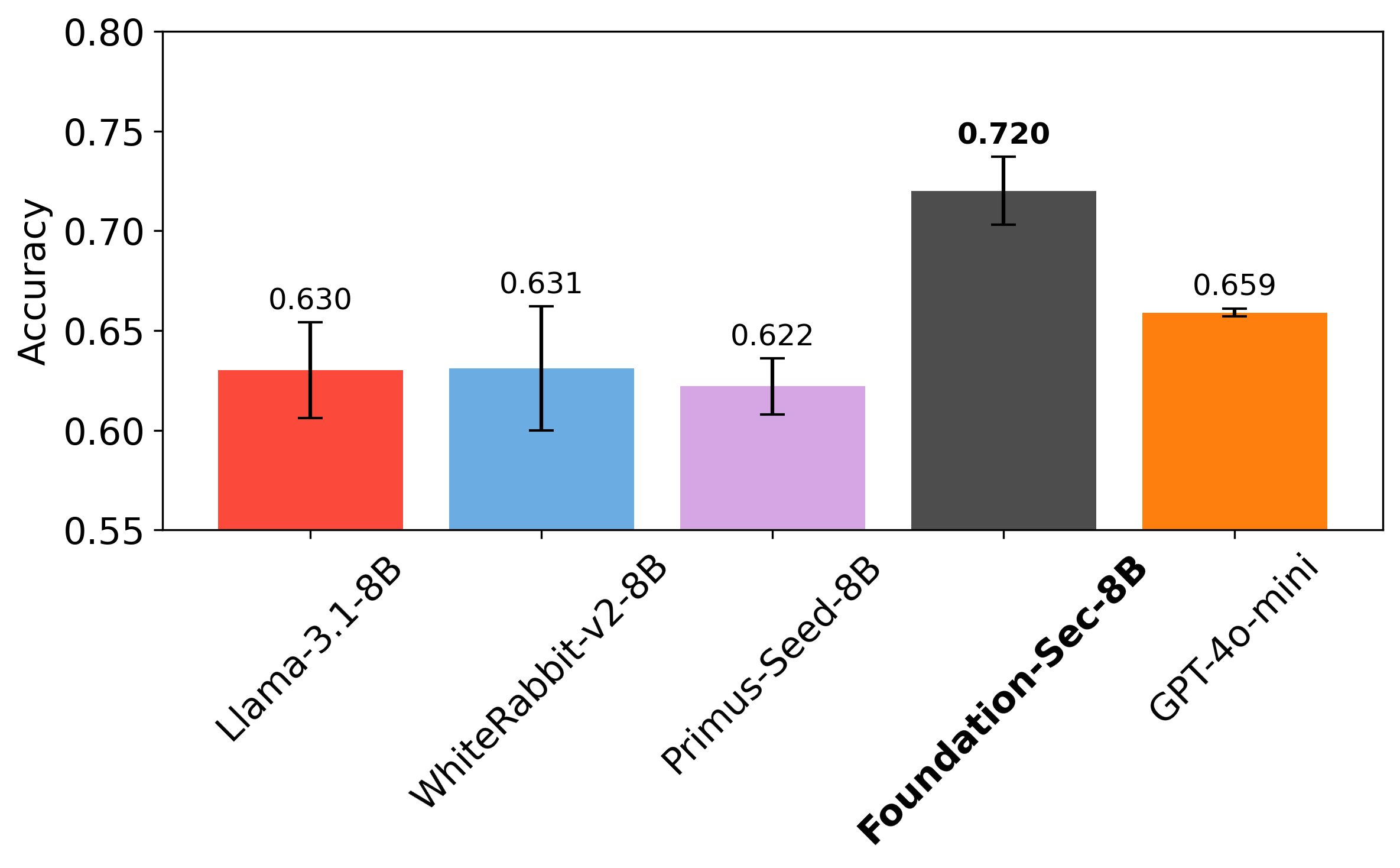

Cisco lanza LLM Foundation-Sec-8B dedicado a la ciberseguridad: El equipo de Foundation AI de Cisco ha lanzado el modelo Foundation-Sec-8B en Hugging Face. Se trata de un LLM basado en Llama 3.1 y enfocado en el dominio de la ciberseguridad. Se afirma que este modelo de 8B puede igualar a Llama 3.1-70B y GPT-4o-mini en tareas específicas de seguridad, demostrando el potencial de los modelos especializados en dominios para superar a los modelos grandes generales en tareas específicas. Esto indica que las grandes empresas tecnológicas están aplicando activamente LLMs a sectores verticales para resolver problemas concretos. (Fuente: _akhaliq, Suhail)

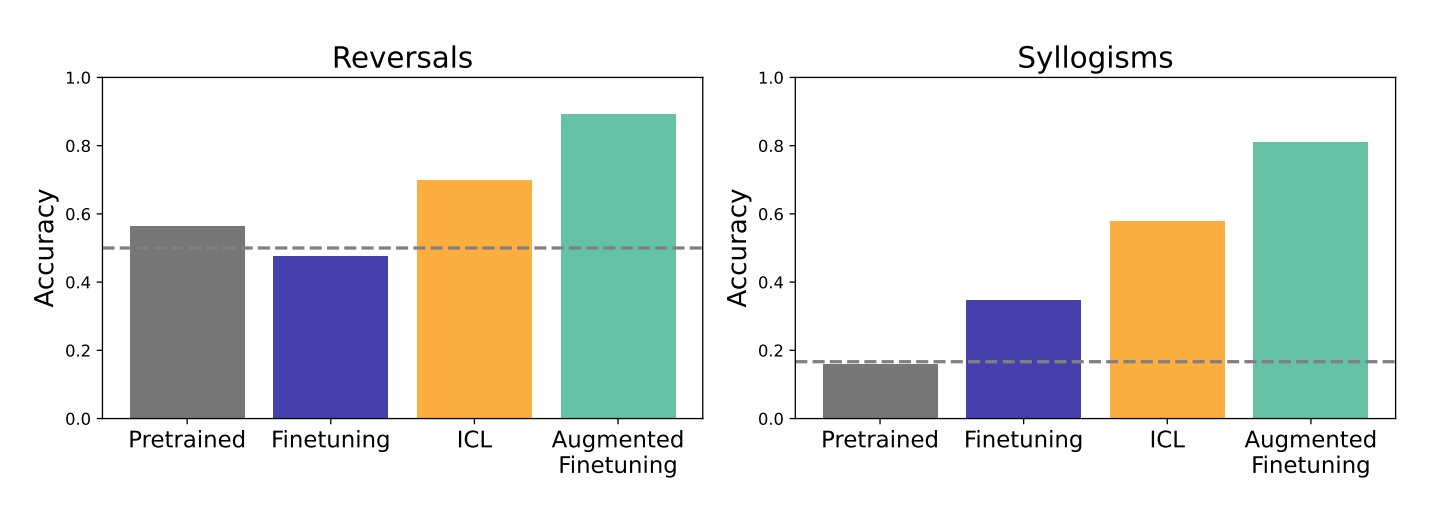

Estudio sobre el impacto del aprendizaje en contexto (ICL) y el fine-tuning en la capacidad de generalización de los LLM: Investigadores de Google DeepMind y la Universidad de Stanford compararon el impacto del aprendizaje en contexto (ICL) y el fine-tuning, dos métodos principales, en la capacidad de generalización de los LLM. El estudio encontró que ICL hace que el modelo sea más flexible durante el aprendizaje y tenga una mayor capacidad de generalización. Sin embargo, cuando la información necesita integrarse en estructuras de conocimiento más amplias, el fine-tuning es más efectivo. Los investigadores proponen un nuevo método que combina las ventajas de ambos: el fine-tuning aumentado (augmented fine-tuning), que consiste en añadir procesos de razonamiento similares a ICL en los datos de fine-tuning, con el objetivo de obtener los mejores resultados. (Fuente: TheTuringPost)

Meta lanza PerceptionLM: Datos abiertos y modelos para la comprensión visual detallada: Meta ha lanzado el proyecto PerceptionLM, con el objetivo de proporcionar un marco completamente abierto y reproducible para la investigación transparente en la comprensión de imágenes y videos. El proyecto analiza los flujos de trabajo de entrenamiento estándar que no dependen de la destilación de modelos propietarios y explora datos sintéticos a gran escala para identificar lagunas de datos, especialmente en la comprensión detallada de videos. Para llenar estas lagunas, el proyecto publica 2.8 millones de pares de preguntas y respuestas de video de grano fino anotados manualmente y subtítulos de video con localización espacio-temporal. Además, introduce el conjunto de evaluación PLM–VideoBench, centrado en evaluar tareas de razonamiento complejo en la comprensión de videos. (Fuente: Reddit r/MachineLearning)

🧰 Herramientas

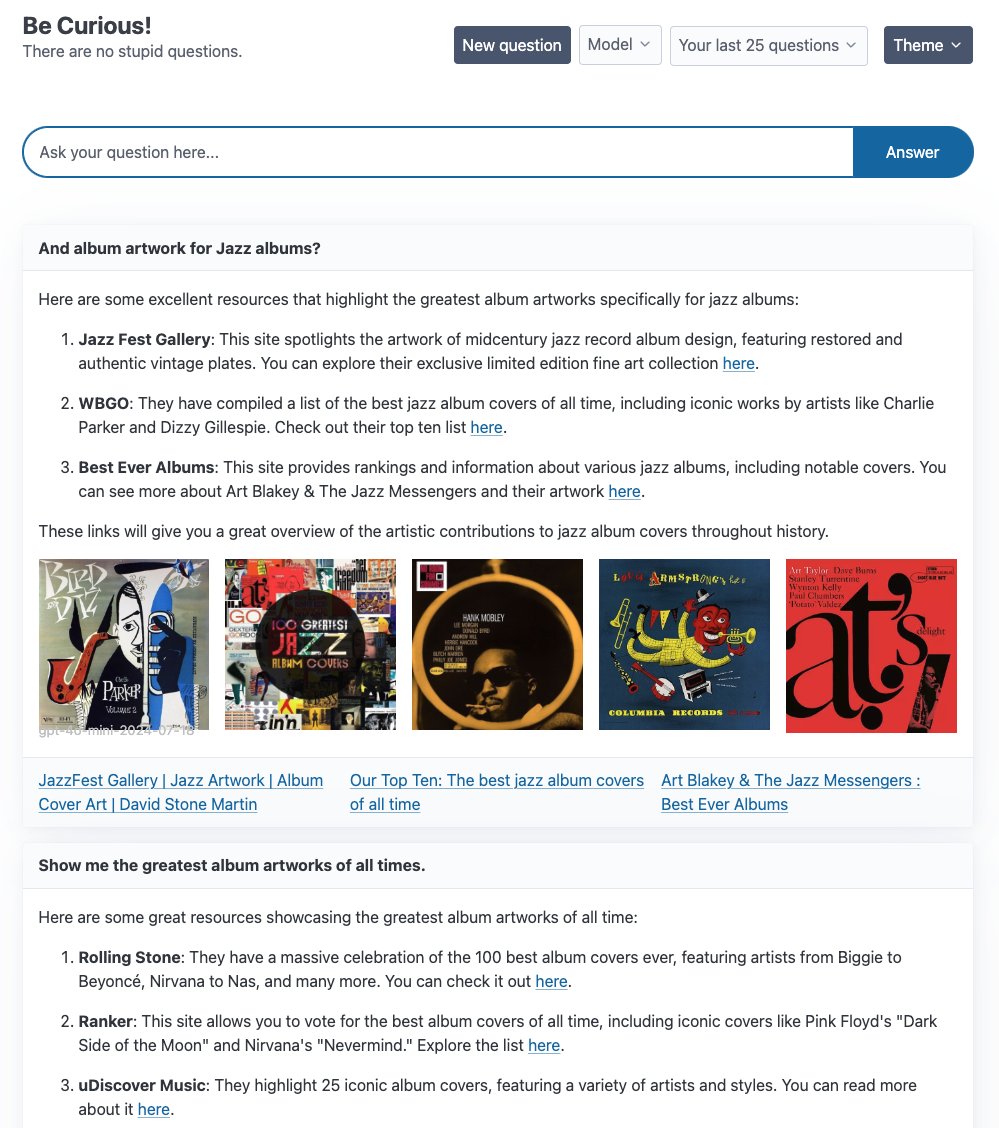

LangGraph presenta múltiples aplicaciones de ejemplo de Agent: LangChain muestra varios ejemplos de aplicaciones de Agent construidas sobre LangGraph: 1. Curiosity: Una interfaz de chat ReAct de código abierto similar a Perplexity, que admite streaming en tiempo real, búsqueda con Tavily y monitoreo con LangSmith, conectable a múltiples LLMs como GPT-4-mini, Llama3. 2. Meeting Prep Agent: Un asistente de calendario inteligente que investiga automáticamente a los participantes de la reunión y la información de la empresa, proporcionando información sobre la reunión a través de una interfaz React/FastAPI, utilizando LangGraph para flujos de trabajo complejos de Agent y razonamiento en tiempo real. 3. Generative UI: Explora la interfaz de usuario generativa como el futuro de la interacción humano-computadora, publicando una biblioteca de ejemplos de UI generativa para LangGraph.js, demostrando el potencial de los grafos de Agent en la construcción de interfaces dinámicas. (Fuente: LangChainAI, hwchase17, LangChainAI, Hacubu)

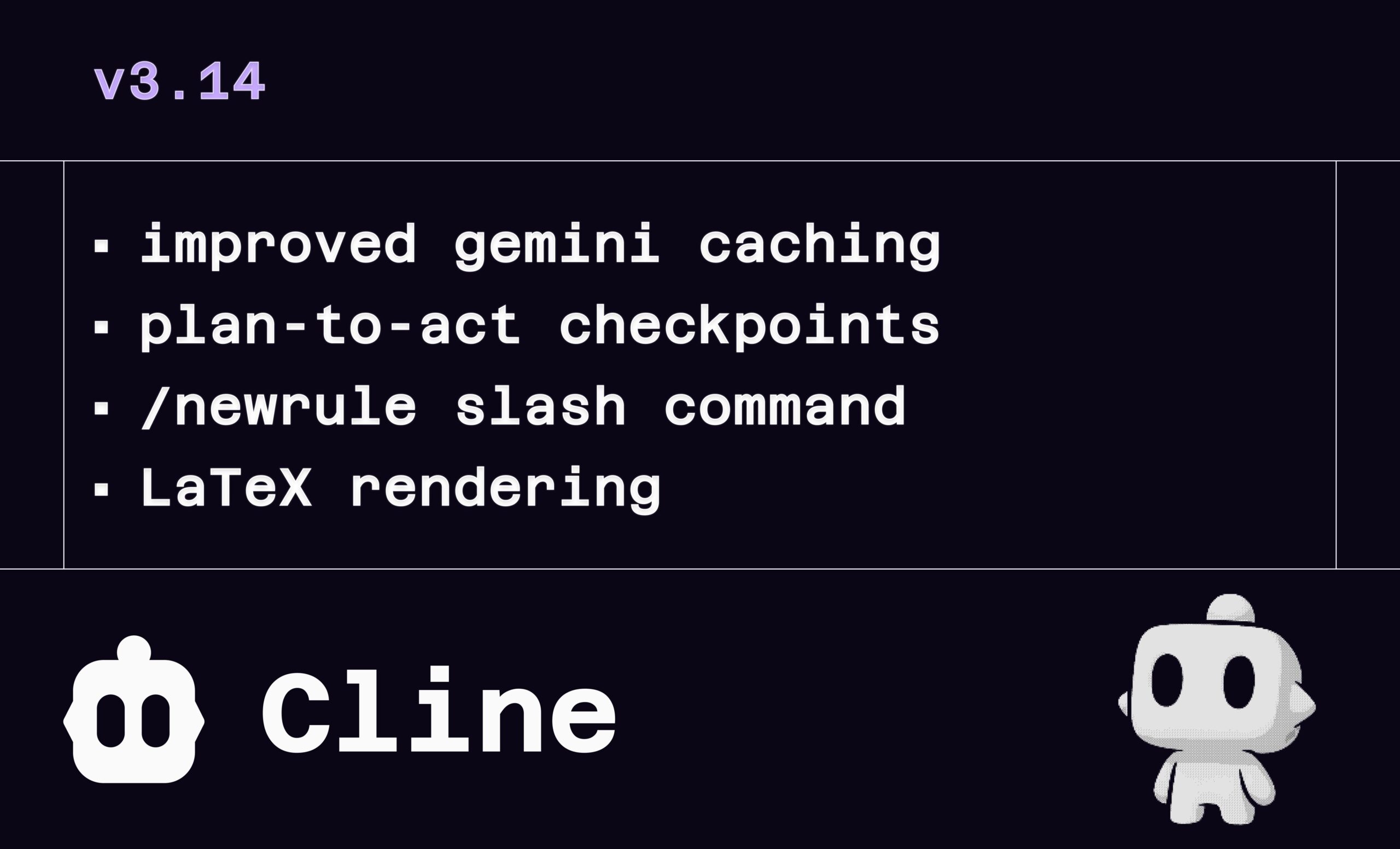

Actualización Cline v3.14: Soporte para LaTeX, arrastrar y soltar archivos y definición de reglas: El asistente de programación AI Cline lanza la versión v3.14, trayendo varias actualizaciones de funciones: 1. Renderizado LaTeX: Soporte completo para LaTeX, permitiendo procesar fórmulas matemáticas complejas y documentos científicos directamente en la interfaz de chat. 2. Carga por arrastrar y soltar: Soporte para arrastrar y soltar archivos directamente desde el administrador de archivos del sistema operativo (manteniendo presionada la tecla Shift) para añadir contexto. 3. Definición de reglas: Nuevo comando /newrule que permite a Cline analizar proyectos y generar documentos de reglas como sistemas de diseño, convenciones de codificación, etc., para hacer cumplir los estándares del proyecto. 4. Puntos de control de flujo: Se añaden más puntos de control en el flujo de trabajo de tareas, permitiendo a los usuarios revisar y modificar el plan antes de la “ejecución” (Act). (Fuente: cline, cline, cline, cline)

LlamaParse ayuda a 11x.ai a construir un SDR de IA inteligente: LlamaIndex demuestra cómo su tecnología LlamaParse ayuda a 11x.ai a mejorar su sistema de Representante de Desarrollo de Ventas (SDR) de IA. Mediante la integración de LlamaParse, 11x.ai puede procesar diversos tipos de documentos cargados por los usuarios, proporcionando la información contextual necesaria para el SDR de IA, permitiendo así campañas de contacto automatizadas y personalizadas, y reduciendo el tiempo de incorporación de nuevos SDR a solo unos días. Esto resalta la importancia de la tecnología avanzada de análisis de documentos en la automatización de procesos de negocio y la mejora de las capacidades de las aplicaciones de IA. (Fuente: jerryjliu0)

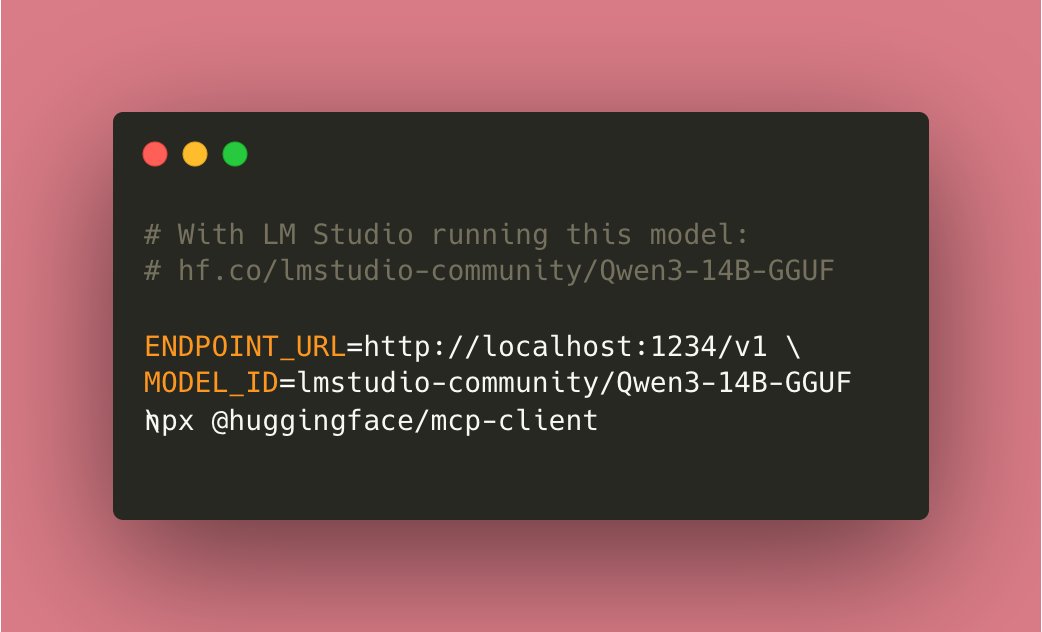

Tiny Agents logran ejecución localizada: Contribuciones de la comunidad permiten que Tiny Agents, basados en mcp-client de Hugging Face (huggingface.js), ahora puedan ejecutarse completamente de forma local. Los usuarios solo necesitan ejecutar localmente un modelo compatible con herramientas (como Qwen3 14B) y establecer ENDPOINT_URL para apuntar al endpoint de la API local, logrando así la funcionalidad de AI Agent localizada, lo que se considera un avance importante para la IA local. (Fuente: cognitivecompai)

Herramienta de depuración AI de línea de comandos local cloi: cloi es una herramienta de depuración de código AI basada en línea de comandos, caracterizada por su ejecución completamente local. Incorpora el modelo Phi-4 de Microsoft, pero también admite cambiar y ejecutar otros modelos de lenguaje grandes locales a través de Ollama. Esto proporciona a los desarrolladores una opción conveniente para utilizar la IA en el entorno local para la depuración y análisis de código. (Fuente: karminski3)

Circuitos de decisión de IA: Mejorando la fiabilidad de los sistemas LLM: Un artículo explora la aplicación de conceptos de diseño de circuitos electrónicos a los sistemas LLM, construyendo “circuitos de decisión de IA” para mejorar la fiabilidad. Mediante este método, la precisión del sistema puede alcanzar el 92.5%. La implementación utiliza LangSmith para el seguimiento y evaluación en tiempo real para verificar la precisión de la salida del sistema. Este enfoque ofrece nuevas ideas para construir aplicaciones LLM más confiables y predecibles. (Fuente: LangChainAI)

Local Deep Research (LDR) busca sugerencias de mejora: La herramienta de investigación de código abierto Local Deep Research lanza la v0.3.1 y solicita a la comunidad sugerencias de mejora, incluyendo áreas de enfoque, funcionalidades deseadas, preferencias de tipo de investigación y sugerencias de mejora de la interfaz de usuario (UI). La herramienta tiene como objetivo ejecutar tareas de investigación profunda localmente y recomienda usar SearXNG para mejorar la velocidad. (Fuente: Reddit r/LocalLLaMA)

OpenWebUI Adaptive Memory v3.1 lanzado: La función de memoria adaptativa de OpenWebUI se actualiza a la v3.1, con mejoras que incluyen puntuación y filtrado de confianza de la memoria, soporte para proveedores de Embedding locales/API, descubrimiento automático de modelos locales, validación de dimensiones de Embedding, detección de métricas Prometheus, endpoints de salud y métricas, emisor de estado de UI y correcciones de Debug. La hoja de ruta incluye refactorización, etiquetado dinámico de memoria, personalización de respuestas, validación de persistencia entre sesiones, manejo mejorado de la configuración, ajuste fino de la recuperación, retroalimentación de estado, expansión de la documentación, sincronización opcional externa con RememberAPI/mem0 y desensibilización de PII, entre otros. (Fuente: Reddit r/OpenWebUI)

📚 Aprendizaje

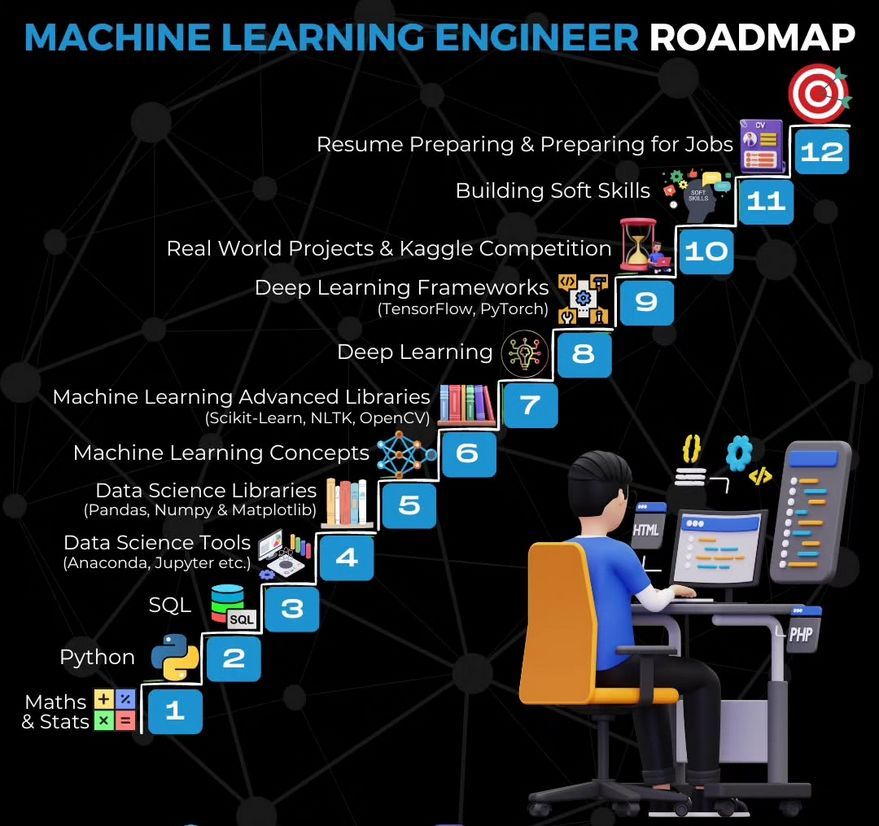

Hoja de ruta de aprendizaje para ingenieros de Machine Learning: Ronald van Loon comparte una hoja de ruta de aprendizaje para ingenieros de Machine Learning, proporcionando una guía de estudio y una visión general de las habilidades clave para aquellos que aspiran a entrar en este campo. (Fuente: Ronald_vanLoon)

Tutorial para construir un resumidor de videos usando Gemma: LangChainAI publica un video tutorial que demuestra cómo construir una aplicación de resumen de videos utilizando el LLM Gemma ejecutado localmente (a través de Ollama). La aplicación Streamlit utiliza LangChain para procesar videos y generar resúmenes concisos automáticamente, proporcionando un ejemplo práctico para aprender y practicar aplicaciones de LLM locales. (Fuente: LangChainAI)

Tutorial para construir un servidor MCP para procesar datos bursátiles: LangChainAI ofrece un tutorial que guía a los usuarios sobre cómo construir un servidor MCP (Machine Collaboration Protocol) utilizando FastMcp y LangChain para procesar datos del mercado de valores. La guía demuestra cómo usar LangGraph para crear un ReAct Agent para lograr un acceso estandarizado a los datos, ayudando a comprender y aplicar las tecnologías MCP y Agent. (Fuente: LangChainAI)

Prueba de concepto de benchmark de racionalidad para LLM: Deep Learning Weekly menciona una entrada de blog que presenta una prueba de concepto para crear un benchmark de racionalidad para LLM ajustando la evaluación ART-Y. El artículo enfatiza que es crucial evaluar si la IA es más racional (no solo más inteligente) que los humanos. (Fuente: dl_weekly)

AI Red Teaming como ejercicio de pensamiento crítico: Deep Learning Weekly recomienda un artículo que define el AI Red Teaming no solo como pruebas de vulnerabilidades técnicas contra LLMs, sino como un ejercicio de pensamiento crítico derivado de prácticas militares y de ciberseguridad. Esto proporciona una perspectiva más amplia para comprender e implementar la evaluación de la seguridad de la IA. (Fuente: dl_weekly)

Recomendación de libro para aprender Python: Miembros de la comunidad recomiendan el libro “Python Crash Course” para aprender Python, considerándolo un buen punto de partida para usar Python eficazmente, y comparten la versión en PDF. Se enfatiza la importancia de Python como lenguaje fundamental para aprender desarrollo de IA. (Fuente: omarsar0)

Deeply Supervised Nets gana el premio Test of Time de AISTATS 2025: El artículo temprano del doctorado de Saining Xie, “Deeply Supervised Nets”, ha ganado el premio Test of Time de AISTATS 2025. Comparte que este artículo fue rechazado por NeurIPS, animando a los estudiantes a perseverar frente a los rechazos de artículos y a persistir en su investigación. (Fuente: sainingxie)

Discusión sobre resumen de métodos de destilación de LLM: Un usuario de Reddit busca una visión general actualizada de los métodos de destilación de LLM, especialmente de modelos grandes a pequeños, y de modelos grandes a modelos más especializados. La discusión menciona tres tipos principales: 1. Generación de datos + SFT (destilación simple); 2. Destilación basada en Logit (los modelos deben ser homogéneos); 3. Destilación basada en estados ocultos (los modelos pueden ser heterogéneos). También se mencionan herramientas relacionadas como DistillKit. (Fuente: Reddit r/MachineLearning)

Exploración del fine-tuning federado de LLaMA2: Un usuario de Reddit comparte los resultados preliminares de experimentos de fine-tuning federado de LLaMA2 utilizando FedAvg y FedProx. El experimento se realizó en el conjunto de datos Reddit TL;DR, comparando ROUGE-L de validación global, costo de comunicación y deriva del cliente. Los resultados muestran que FedProx supera a FedAvg en la reducción de la deriva y en una ligera mejora de ROUGE-L, pero sigue siendo inferior al fine-tuning centralizado. Se invita a la comunidad a discutir configuraciones de adaptadores, métodos de compresión y problemas de estabilidad bajo datos no IID. (Fuente: Reddit r/deeplearning)

💼 Negocios

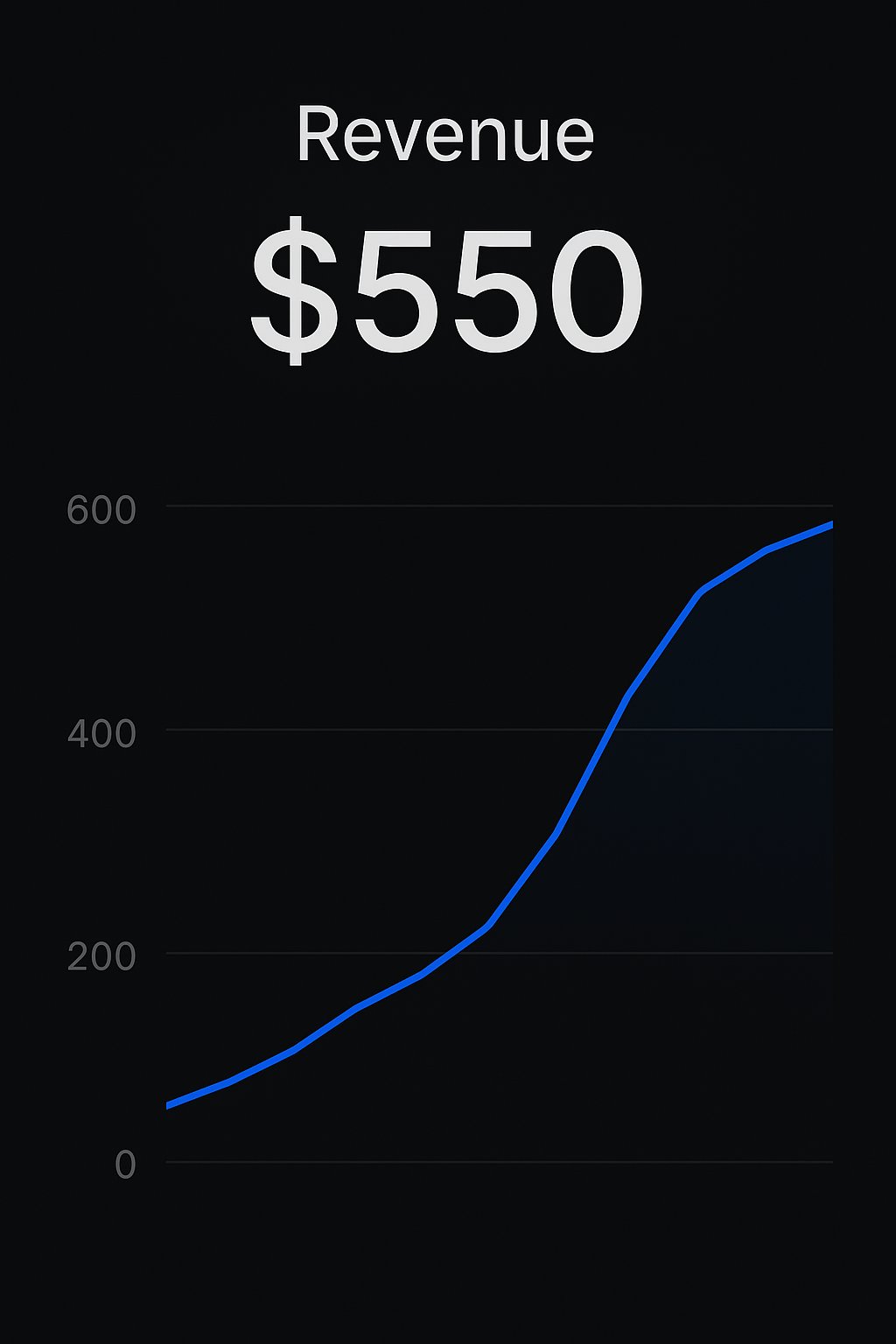

Desarrolladores de la plataforma Replit logran monetizar aplicaciones: Dos desarrolladores comparten casos de éxito construyendo y vendiendo aplicaciones de IA a través de la plataforma Replit. Un desarrollador obtuvo sus primeros 550 dólares usando CreateMVPs.app; la aplicación de otro desarrollador, construida en un día, se vendió por 4700 dólares y le consiguió más ofertas de proyectos. Esto demuestra el potencial de plataformas como Replit para capacitar a los desarrolladores a construir y comercializar rápidamente aplicaciones de IA. (Fuente: amasad, amasad)

ChatGPT Edu se implementa en la Icahn School of Medicine at Mount Sinai: La Icahn School of Medicine at Mount Sinai anuncia que ofrecerá servicios de ChatGPT Edu a todos los estudiantes de medicina y posgrado. Esto marca la entrada del producto educativo de OpenAI en instituciones de educación médica de primer nivel, con el objetivo de utilizar la IA para apoyar la educación e investigación médica. Un video demuestra sus escenarios de aplicación. (Fuente: gdb)

Pérdidas continuas en la industria de capital riesgo generan atención: Sam Altman expresa su desconcierto ante el fenómeno de que la industria de capital riesgo (VC) en general pierda dinero a largo plazo pero siga recibiendo inversiones de socios comanditarios (LP). Considera que, aunque invertir en fondos de primer nivel es sensato, el fenómeno de pérdidas continuas en toda la industria merece una reflexión sobre las razones subyacentes y las motivaciones de los LP. (Fuente: sama)

🌟 Comunidad

Discusión sobre el impacto de la IA en el empleo y la educación: La comunidad discute el impacto potencial de la automatización por IA en los modelos de trabajo existentes (interfaz teclado-ratón-pantalla) y cómo los educadores deberían responder a los chatbots de IA. Se argumenta que los profesores no deberían prohibir a los estudiantes usar herramientas como ChatGPT, sino enseñarles a usar estas IA de manera efectiva y responsable, cultivando la alfabetización en IA y las mejores prácticas en los estudiantes. (Fuente: NandoDF, NandoDF)

Discusión sobre la interpretabilidad y seguridad de la IA: Dario Amodei enfatiza la urgencia de la interpretabilidad de los modelos de IA, considerando crucial entender cómo funcionan los modelos. Neel Nanda ofrece una perspectiva diferente, argumentando que aunque la inversión en interpretabilidad es buena, no se debe exagerar su importancia en relación con otros métodos de seguridad. El camino hacia la garantía fiable de una IA potente no es solo la interpretabilidad; debería ser parte de un conjunto de medidas de seguridad. (Fuente: bookwormengr)

Discusión sobre la complejidad de RLHF y el fenómeno de “adulación” del modelo: Nathan Lambert y otros discuten la complejidad e importancia del Aprendizaje por Refuerzo con Retroalimentación Humana (RLHF) y el fenómeno resultante de “adulación” (sycophancy) del modelo (como GPT-4o-simp). El artículo argumenta que RLHF es crucial para la alineación del modelo pero el proceso es caótico, y los usuarios a menudo no comprenden su complejidad, lo que lleva a malentendidos o insatisfacción con el comportamiento del modelo (como la reacción violenta en LMArena). Comprender los desafíos inherentes de RLHF es crucial para evaluar y mejorar los modelos. (Fuente: natolambert, aidangomez, natolambert)

Impacto potencial de la IA en las capacidades cognitivas y formas de pensar humanas: La comunidad explora el impacto potencial de la IA en el pensamiento humano. Una preocupación es que la dependencia excesiva de la IA conduzca a una disminución de las capacidades cognitivas (lectura perezosa, pensamiento crítico debilitado). Otra perspectiva sugiere que si la IA puede proporcionar información y juicios más precisos, podría mejorar el nivel cognitivo de aquellos con habilidades de pensamiento originalmente más débiles o susceptibles a la desinformación, actuando como un “aumento cognitivo” y ayudando a tomar mejores decisiones. También se discute que el desarrollo de la IA podría permitirnos comprender más profundamente la conciencia, e incluso descubrir que algunas personas podrían estar simplemente simulando la conciencia. (Fuente: riemannzeta, HamelHusain, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

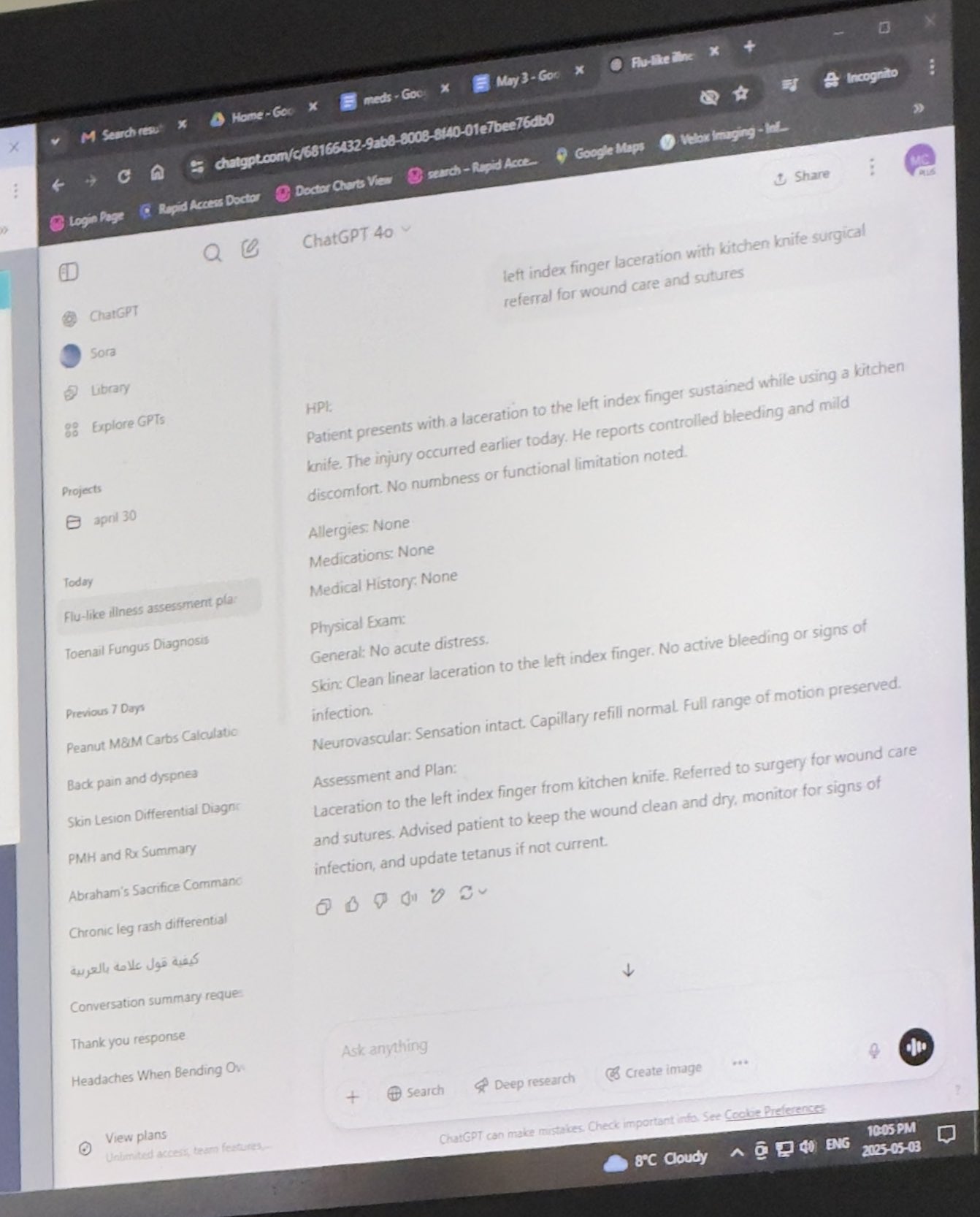

Discusión sobre ética y escenarios de aplicación de la IA: La discusión abarca la aplicación de la IA en campos como la medicina y el derecho. Un usuario comparte un caso de un médico usando ChatGPT en consulta, generando debate sobre la aplicación de la IA en escenarios profesionales. Al mismo tiempo, hay consideraciones éticas sobre el uso de la IA para la escritura fantasma (ghostwriting), especialmente cuando el propio autor enfrenta dificultades. Además, existe preocupación por la desinformación y los riesgos que puede generar el contenido generado por IA (como libros sobre el TDAH). (Fuente: BorisMPower, scottastevenson, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Avances en robots impulsados por IA: Se muestran varios robots impulsados por IA: un robot desarrollado por Google DeepMind capaz de jugar al ping-pong, perros robot exhibidos en ferias, un robot utilizado para engastar diamantes, un dron inspirado en aves capaz de saltar para despegar, un cincel mecánico utilizado para la creación artística, y un video del robot humanoide Unitree G1 caminando en un centro comercial. Estas demostraciones muestran los avances de la IA en el control, percepción e interacción robótica. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

El futuro de la IA y las humanidades y ciencias sociales: Citando un artículo del New Yorker, se explora el impacto de la IA en las humanidades. El artículo argumenta que la IA no puede alcanzar la “mismidad” (me-ness) humana y la experiencia humana única, pero al mismo tiempo señala que la IA, al reorganizar y representar la escritura colectiva humana (el archivo), puede simular una gran parte de lo que esperamos obtener de los individuos humanos, lo que plantea desafíos y nuevas dimensiones de reflexión para las humanidades. (Fuente: NandoDF)

💡 Otros

Herramientas asistidas por IA para la mejora personal: Un usuario de Reddit comparte su exitosa experiencia usando ChatGPT como entrenador personal de fitness y nutrición. A través de la IA, elaboró planes de entrenamiento, dietas (combinando ceto, entrenamiento de fuerza, ayuno, etc.), e incluso obtuvo sugerencias de macronutrientes al pedir comida, logrando finalmente mejores resultados que con un entrenador humano pagado. Esto demuestra el potencial de la IA en la orientación personalizada y la asistencia en la vida diaria. (Fuente: Reddit r/ChatGPT)

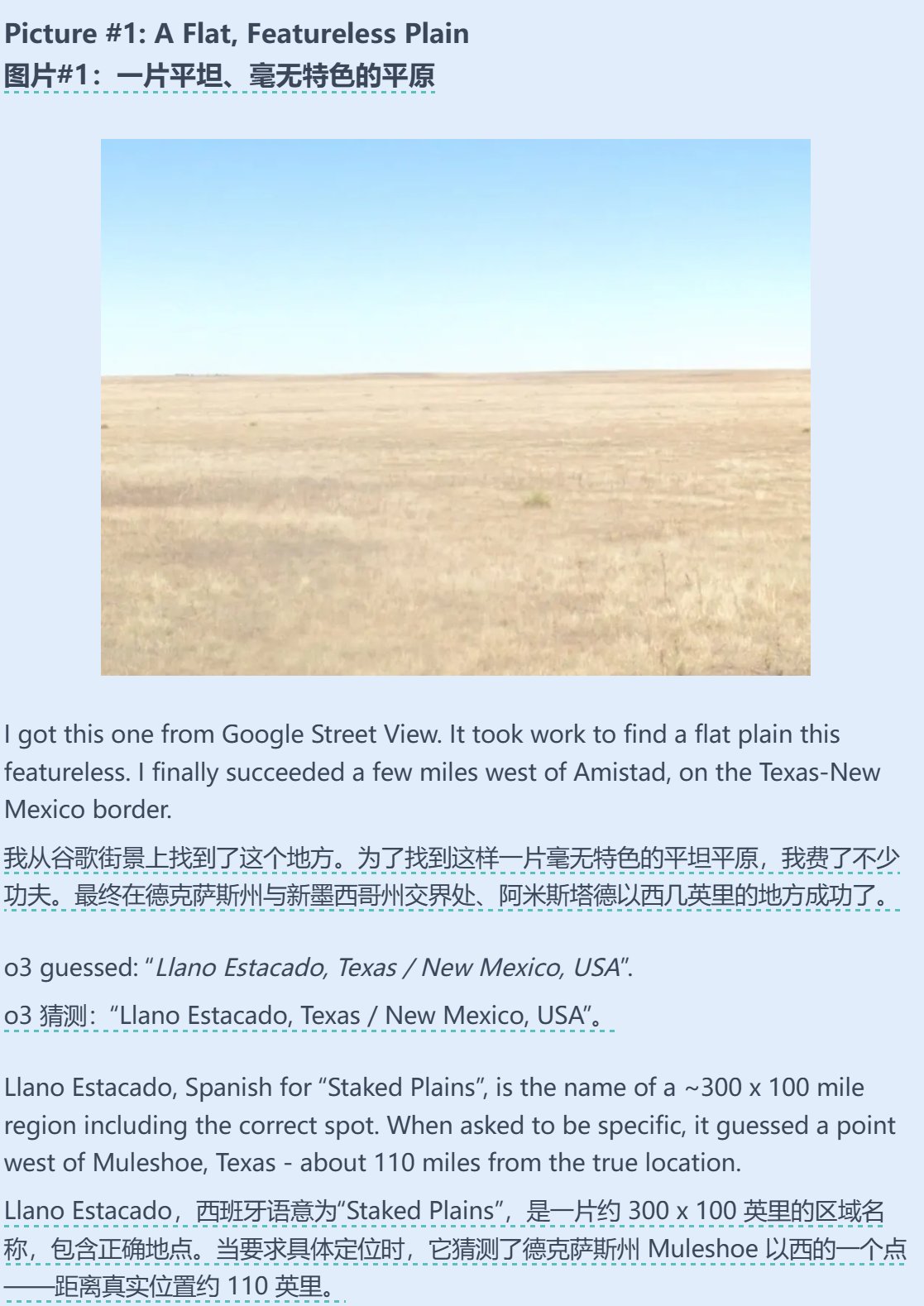

Combinación de IA y capacidad de adivinación geográfica: Sam Altman retuitea y comenta un artículo de prueba sobre la asombrosa capacidad demostrada por una IA (posiblemente o3) en Geoguessr (juego de adivinación geográfica). Incluso con información de imagen mínima (como solo señales borrosas o incluso degradados de color puros), la IA pudo incluir la respuesta correcta entre las opciones, mostrando sus potentes capacidades de reconocimiento de imágenes, coincidencia de patrones y razonamiento de conocimiento geográfico. (Fuente: op7418)

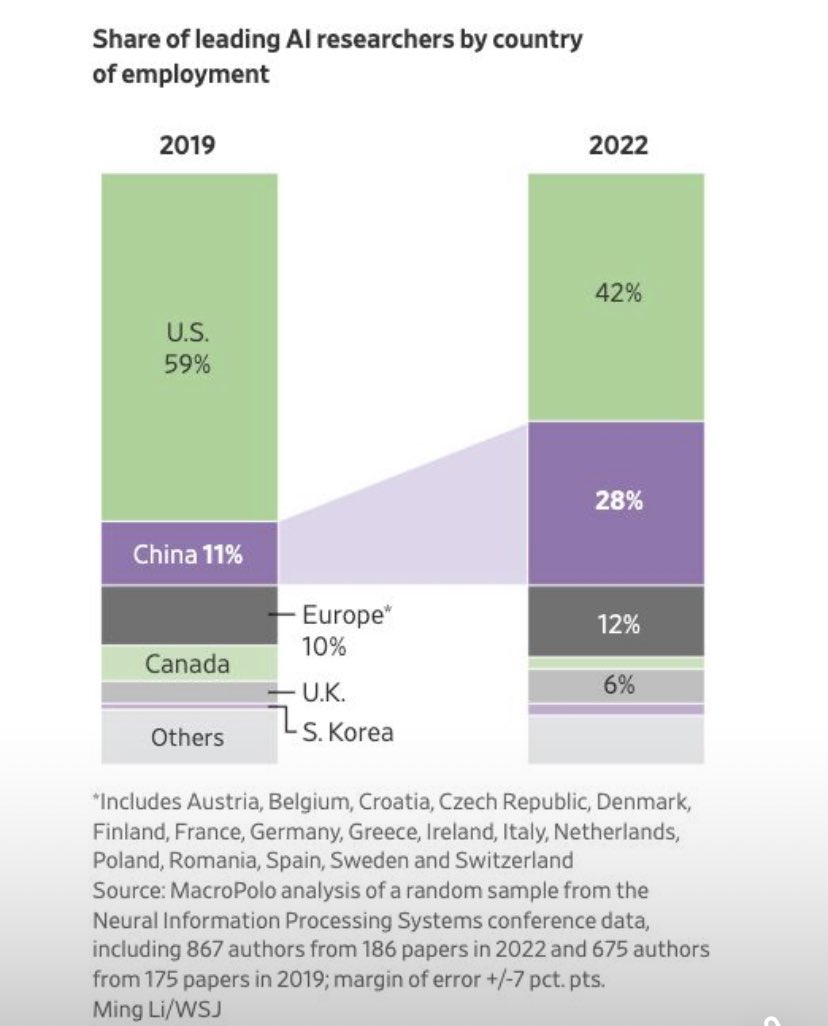

Tendencias de movilidad de investigadores en el campo de la IA: Un gráfico muestra cambios en la distribución por países de empleo de los principales investigadores en el campo de la IA, con una disminución en la proporción de investigadores empleados en EE. UU. y un aumento significativo en la proporción empleada en China. Comentarios de la comunidad señalan que, considerando el aumento de las oportunidades de investigación locales en China y el posible retorno de talento, la brecha real podría ser mayor de lo que muestra el gráfico, reflejando cambios en el panorama global de la competencia por el talento en IA. (Fuente: teortaxesTex, bookwormengr)