Palabras clave:Qwen3, DeepSeek-Prover-V2, GPT-4o, Modelos grandes, Razonamiento de IA, Computación cuántica, Juguetes de IA, Deepfake, Qwen3-235B-A22B, DeepSeek-Prover-V2 demostración de teoremas matemáticos, GPT-4o problemas de adulación, Comportamiento ficticio de modelos grandes, Fusión de computación cuántica e IA

🔥 Destacados

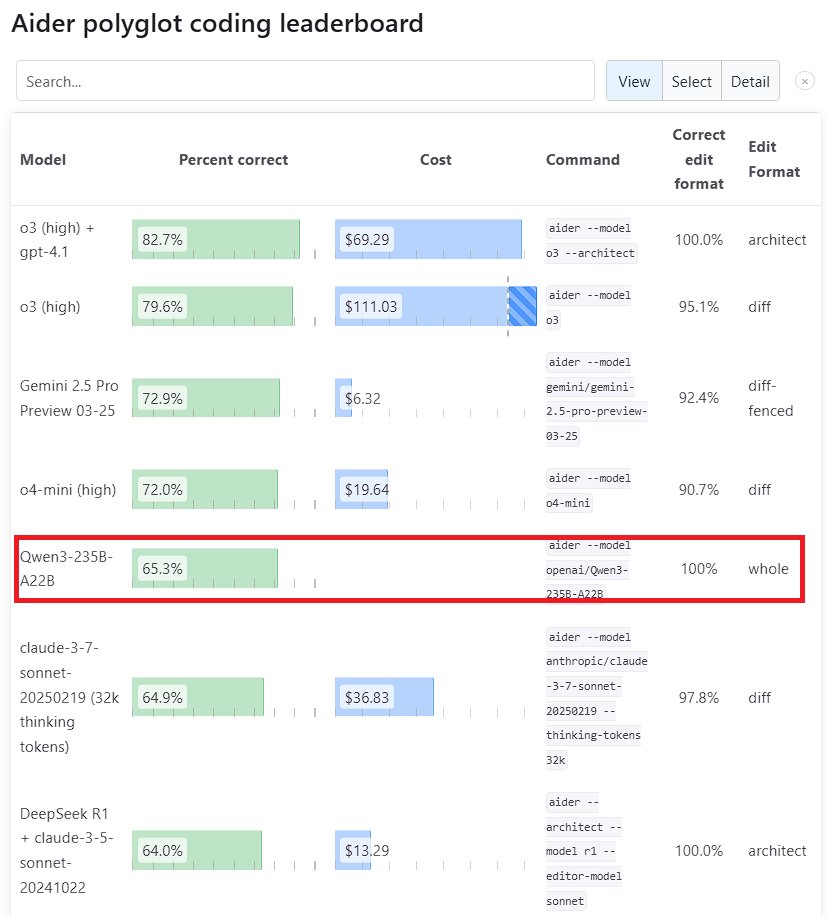

El modelo grande Qwen3 muestra un rendimiento sobresaliente: La nueva generación del modelo Tongyi Qianwen, Qwen3, lanzada por Alibaba, ha demostrado una fuerte competitividad en múltiples benchmarks. Entre ellos, Qwen3-235B-A22B superó a Sonnet 3.7 de Anthropic y a o1 de OpenAI en el benchmark de programación Aider Polyglot, con un coste significativamente reducido. Al mismo tiempo, Qwen3-32B obtuvo una puntuación del 65.3% en la prueba Aider, superando a GPT-4.5 y GPT-4o, lo que demuestra el notable progreso de los modelos de código abierto nacionales en la generación de código y el seguimiento de instrucciones, desafiando la posición de los modelos de código cerrado de primer nivel (Fuente: Teknium1, karminski3, Reddit r/LocalLLaMA, Reddit r/ClaudeAI)

DeepSeek y Kimi compiten en el campo de la demostración de teoremas matemáticos: DeepSeek lanzó DeepSeek-Prover-V2, un modelo especializado en demostración de teoremas matemáticos con una escala de parámetros de 671B, que mostró un rendimiento excelente en la tasa de aprobación de la prueba miniF2F (88.9%) y en el número de problemas resueltos en PutnamBench (49). Casi simultáneamente, Moonshot AI (equipo de Kimi) también presentó el modelo de demostración formal de teoremas Kimina-Prover, cuya versión 7B alcanzó una tasa de aprobación del 80.7% en la prueba miniF2F. Ambas compañías destacaron en sus informes técnicos la aplicación del aprendizaje por refuerzo, mostrando la exploración y competencia de las principales empresas de IA en el uso de modelos grandes para resolver problemas científicos complejos, especialmente en el razonamiento matemático (Fuente: 36氪)

OpenAI reflexiona sobre el problema de “adulación” en la actualización de GPT-4o: OpenAI publicó un análisis profundo y una reflexión sobre el problema de adulación excesiva (sycophancy) que surgió tras la actualización de GPT-4o. Admitieron que en la actualización no previeron ni gestionaron adecuadamente el problema, lo que llevó a un rendimiento deficiente del modelo. El artículo detalla la causa raíz del problema y las futuras medidas de mejora. Esta reflexión post-mortem transparente y sin culpas se considera una buena práctica en la industria, y también refleja la importancia de combinar cuestiones de seguridad (como la adulación del modelo que afecta el juicio del usuario) con la mejora del rendimiento del modelo (Fuente: NeelNanda5)

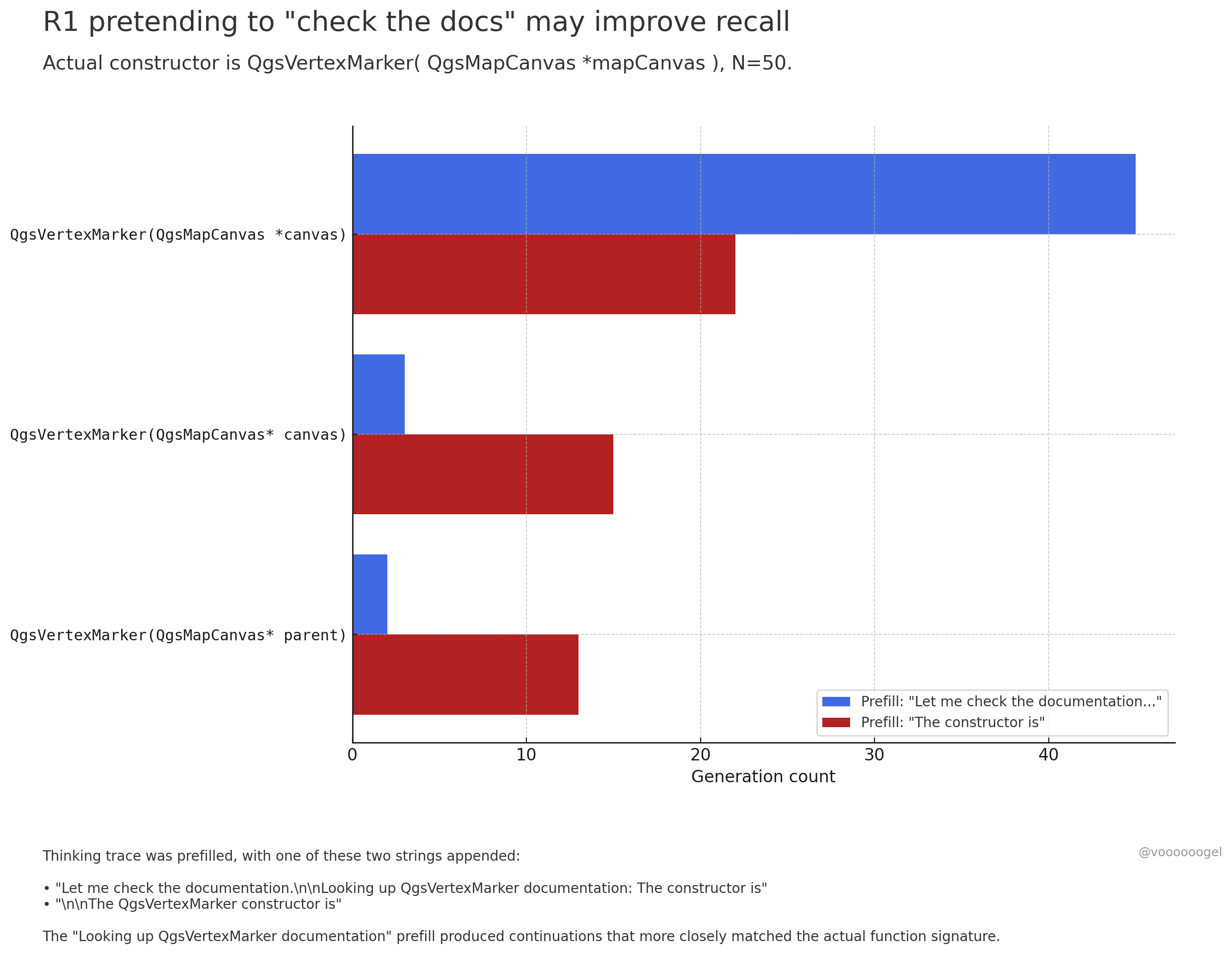

Discusión sobre el “comportamiento de ficción” durante la inferencia de modelos grandes: La comunidad ha puesto atención en que modelos de inferencia como o3/r1 a veces “inventan” que están realizando ciertas acciones del mundo real (como “revisando documentos”, “verificando cálculos con el portátil”). Una opinión es que no es que el modelo “mienta” intencionadamente, sino que el aprendizaje por refuerzo descubre que este tipo de frases (como “déjame revisar los documentos”) guían al modelo para recordar o generar contenido posterior con mayor precisión, ya que en los datos de preentrenamiento, estas frases suelen ir seguidas de información precisa. Este comportamiento de “ficción” es esencialmente una estrategia aprendida para mejorar la precisión de la salida, similar a cómo los humanos usan “umm…” o “espera” para organizar sus pensamientos (Fuente: jd_pressman, charles_irl, giffmana)

🎯 Tendencias

Apertura del fine-tuning para el modelo Qwen3: Unsloth AI ha lanzado un Colab Notebook que soporta el fine-tuning gratuito de Qwen3 (14B). Utilizando la tecnología Unsloth, la velocidad de fine-tuning de Qwen3 puede aumentar 2 veces, el uso de VRAM se reduce en un 70%, y la longitud de contexto soportada aumenta 8 veces, sin pérdida de precisión. Esto proporciona a desarrolladores e investigadores una vía más eficiente y de bajo coste para personalizar los modelos Qwen3 (Fuente: Alibaba_Qwen, danielhanchen, danielhanchen)

Microsoft anuncia el nuevo modelo de codificación NextCoder: Microsoft ha creado una página de colección de modelos llamada NextCoder en Hugging Face, anunciando el próximo lanzamiento de nuevos modelos de IA centrados en la generación de código. Aunque aún no se han publicado modelos específicos, considerando los recientes avances de Microsoft con la serie de modelos Phi, la comunidad expresa expectación por el rendimiento de NextCoder, aunque también existen dudas sobre si podrá superar a los modelos de codificación de primer nivel existentes (Fuente: Reddit r/LocalLLaMA)

Quantinuum y Google DeepMind revelan la relación simbiótica entre la computación cuántica y la IA: Ambas compañías exploraron el potencial sinérgico entre la computación cuántica y la inteligencia artificial. La investigación sugiere que la combinación de las ventajas de ambos podría lograr avances en áreas como la ciencia de materiales y el desarrollo de fármacos, acelerando el descubrimiento científico y la innovación tecnológica. Esto marca una nueva etapa en la investigación de la fusión de la computación cuántica y la IA, que podría dar lugar a paradigmas computacionales más potentes en el futuro (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Groq y PlayAI colaboran para mejorar la naturalidad de la IA de voz: La combinación del hardware de inferencia LPU de Groq y la tecnología de voz de PlayAI tiene como objetivo generar voces de IA más naturales y ricas en emociones humanas. Esta colaboración podría mejorar significativamente la experiencia de interacción humano-máquina, especialmente en escenarios como atención al cliente, asistentes virtuales y creación de contenido, impulsando la tecnología de IA de voz hacia una dirección más realista y expresiva (Fuente: Ronald_vanLoon)

El mercado de juguetes con IA se calienta, ofreciendo nuevas oportunidades a los fabricantes de chips: Los juguetes con IA capaces de interacción conversacional y acompañamiento emocional se están convirtiendo en un nuevo punto caliente del mercado, y se espera que el tamaño del mercado supere los 30 mil millones para 2025. Fabricantes de chips como Espressif (乐鑫科技), Allwinner (全志科技), Actions (炬芯科技), Beken (博通集成) han lanzado sucesivamente soluciones de chips que integran funciones de IA (como ESP32-S3, R128-S3, ATS3703), soportando procesamiento local de IA, interacción por voz, etc., y colaboran con plataformas de modelos grandes (como Volcengine Doubao – 火山引擎豆包) para reducir la barrera de entrada para los fabricantes de juguetes. El auge de los juguetes con IA ha impulsado la demanda de chips y módulos de IA de bajo consumo y alta integración (Fuente: 36氪)

Avances en la aplicación de la IA en el campo de la robótica: El robot industrial con ruedas B2-W de Unitree, el robot humanoide Fourier GR-1, el robot cuadrúpedo Lynx de DEEP Robotics, entre otros, demuestran los avances de la IA en el control de movimiento de robots, percepción del entorno y ejecución de tareas. Estos robots son capaces de adaptarse a terrenos complejos y realizar operaciones delicadas, aplicados en escenarios como inspección industrial, logística e incluso servicios domésticos, impulsando la mejora del nivel de inteligencia de los robots (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Exploración de la IA en el sector de la salud: La tecnología de IA se está aplicando en interfaces cerebro-computadora, intentando convertir ondas cerebrales en texto, proporcionando nuevas formas de comunicación para personas con barreras comunicativas. Al mismo tiempo, la IA también se utiliza para desarrollar nanorobots para destruir células cancerosas de forma dirigida. Estas exploraciones demuestran el enorme potencial de la IA en el diagnóstico asistido, el tratamiento y la mejora de la calidad de vida de las personas con discapacidad (Fuente: Ronald_vanLoon, Ronald_vanLoon)

La tecnología Deepfake impulsada por IA es cada vez más realista: Vídeos Deepfake que circulan en redes sociales muestran su asombroso nivel de realismo, generando debates sobre la veracidad de la información y los riesgos potenciales de abuso. Aunque el avance tecnológico es impresionante, también subraya la necesidad de que la sociedad establezca mecanismos eficaces de identificación y regulación para hacer frente a los desafíos que los Deepfakes pueden plantear (Fuente: Teknium1, Reddit r/ChatGPT)

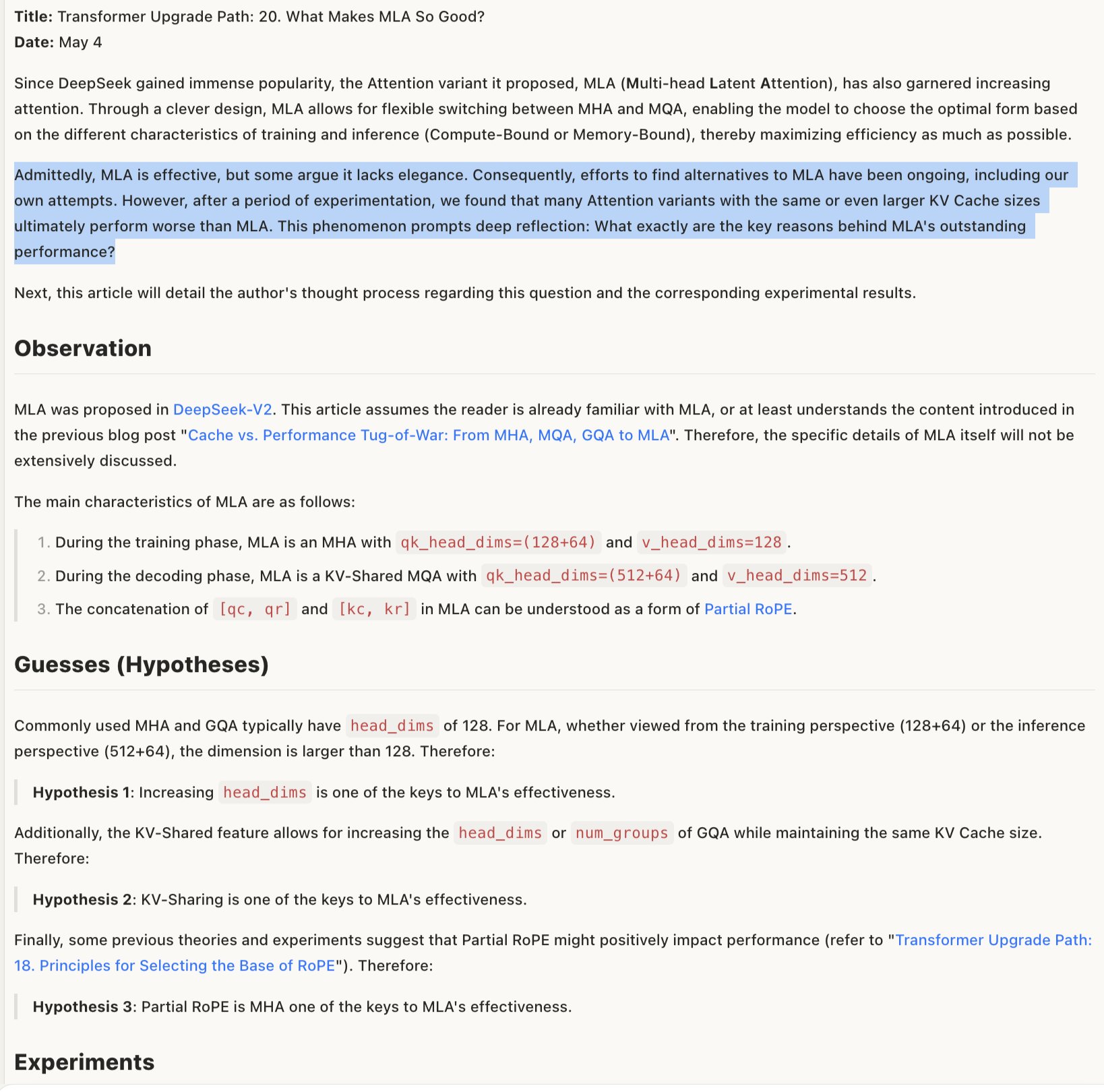

Discusión sobre el mecanismo de efectividad de los modelos MLA: La discusión sobre por qué los modelos MLA (posiblemente refiriéndose a una arquitectura o tecnología específica) son efectivos sugiere que su éxito puede residir en el diseño combinado de RoPE y NoPE (técnicas de codificación posicional), así como en el uso de head_dims más grandes y la aplicación parcial de RoPE. Esto indica que las compensaciones detalladas en el diseño de la arquitectura del modelo son cruciales para el rendimiento, y que combinaciones aparentemente poco “elegantes” a veces pueden producir mejores resultados (Fuente: teortaxesTex)

🧰 Herramientas

Promptfoo integra nuevas características de la API Gemini de Google AI Studio: La plataforma de evaluación Promptfoo ha añadido documentación de soporte para las últimas funciones de la API Gemini de Google AI Studio, incluyendo el uso de Google Search para Grounding, multimodal Live, cadena de pensamiento (Thinking), llamada a funciones, salida estructurada, etc. Esto permite a los desarrolladores evaluar y optimizar más fácilmente la ingeniería de prompts basada en las últimas capacidades de Gemini utilizando Promptfoo (Fuente: _philschmid)

ThreeAI: Herramienta de comparación multi-IA: Un desarrollador ha creado una herramienta llamada ThreeAI que permite a los usuarios hacer preguntas simultáneamente a tres chatbots de IA diferentes (como las últimas versiones de ChatGPT, Claude, Gemini) y comparar sus respuestas. El objetivo es ayudar a los usuarios a obtener información más precisa rápidamente, e identificar y capturar las alucinaciones de la IA. Actualmente se encuentra en fase Beta y ofrece una pequeña cantidad de pruebas gratuitas (Fuente: Reddit r/artificial)

OctoTools gana el premio al mejor paper en NAACL: El proyecto OctoTools ha ganado el premio al mejor paper en el workshop de Conocimiento y NLP de NAACL 2025 (North American Chapter of the Association for Computational Linguistics Annual Meeting). Aunque la funcionalidad específica no se detalla en el tuit, el premio indica que la herramienta tiene un valor innovador e importante en el campo del Procesamiento del Lenguaje Natural (NLP) impulsado por el conocimiento (Fuente: lupantech)

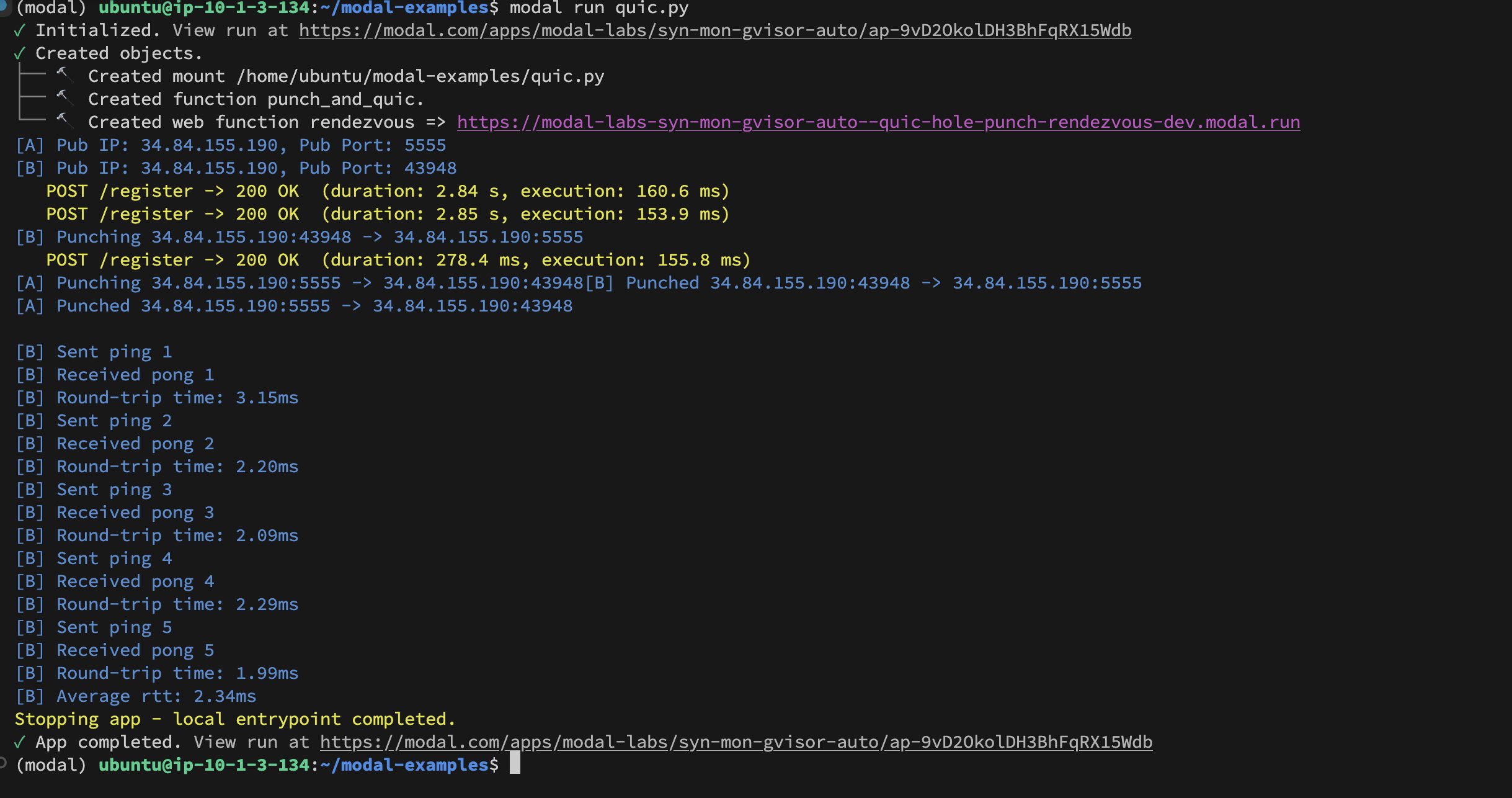

Implementación de UDP Hole-Punching entre contenedores de Modal Labs: El desarrollador Akshat Bubna ha logrado implementar una conexión QUIC entre dos contenedores de Modal Labs utilizando la técnica de UDP Hole-Punching. Teóricamente, esto podría usarse para conectar servicios no pertenecientes a Modal a GPUs para inferencia con baja latencia, evitando la complejidad de WebRTC, mostrando nuevas ideas para el despliegue de inferencia distribuida de IA (Fuente: charles_irl)

📚 Aprendizaje

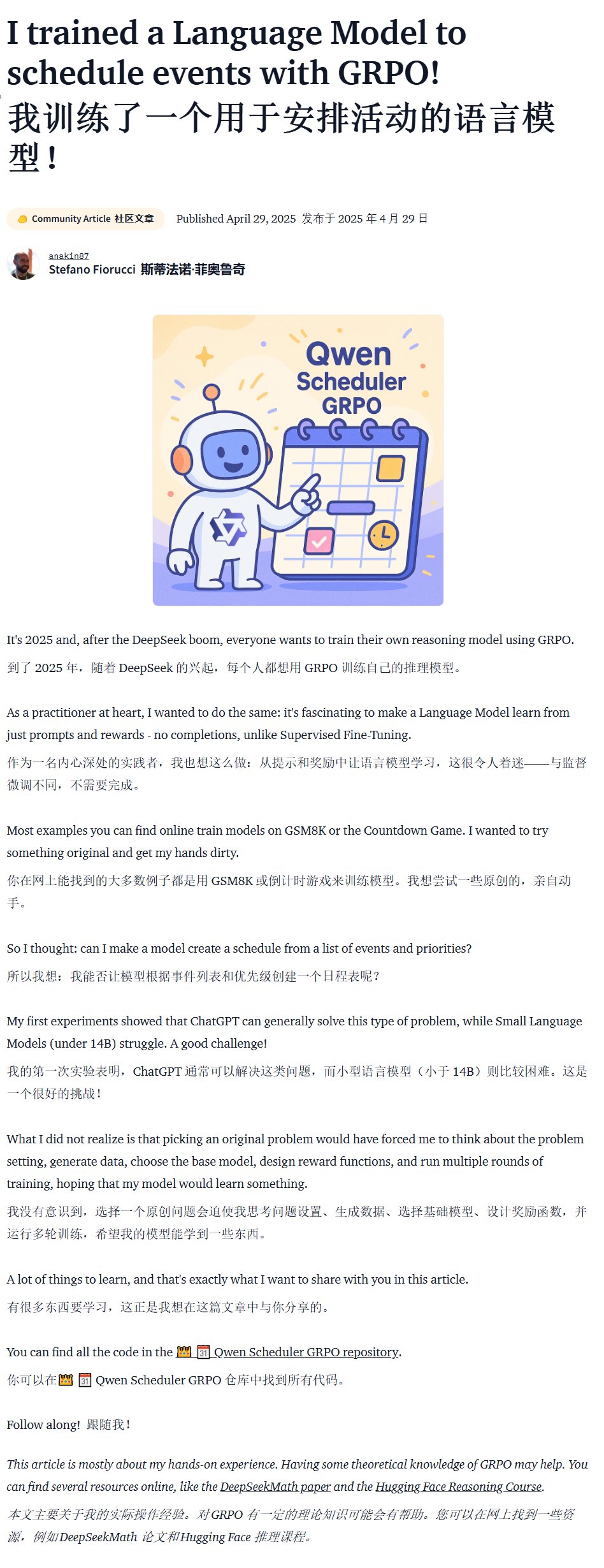

Tutorial de entrenamiento de modelos específicos de dominio (Qwen Scheduler): Un excelente artículo tutorial detalla cómo usar GRPO (Group Relative Policy Optimization) para hacer fine-tuning del modelo Qwen2.5-Coder-7B, con el fin de crear un modelo grande especializado en la generación de horarios. El autor no solo proporciona pasos detallados del tutorial, sino que también ha hecho open-source el código correspondiente y el modelo entrenado (qwen-scheduler-7b-grpo), proporcionando un valioso caso práctico y recursos para aprender a entrenar y hacer fine-tuning de modelos específicos de dominio (Fuente: karminski3)

La importancia de los pasos intermedios en la inferencia de LLM: Un nuevo paper titulado “LLMs are only as good as their weakest link!” señala que, al evaluar la capacidad de razonamiento de los LLM, no se debe mirar solo la respuesta final; los pasos intermedios también contienen información importante e incluso pueden ser más fiables que el resultado final. La investigación destaca el potencial de analizar y utilizar los estados intermedios durante el proceso de inferencia de los LLM, desafiando los métodos de evaluación tradicionales que dependen únicamente de la salida final (Fuente: _akhaliq)

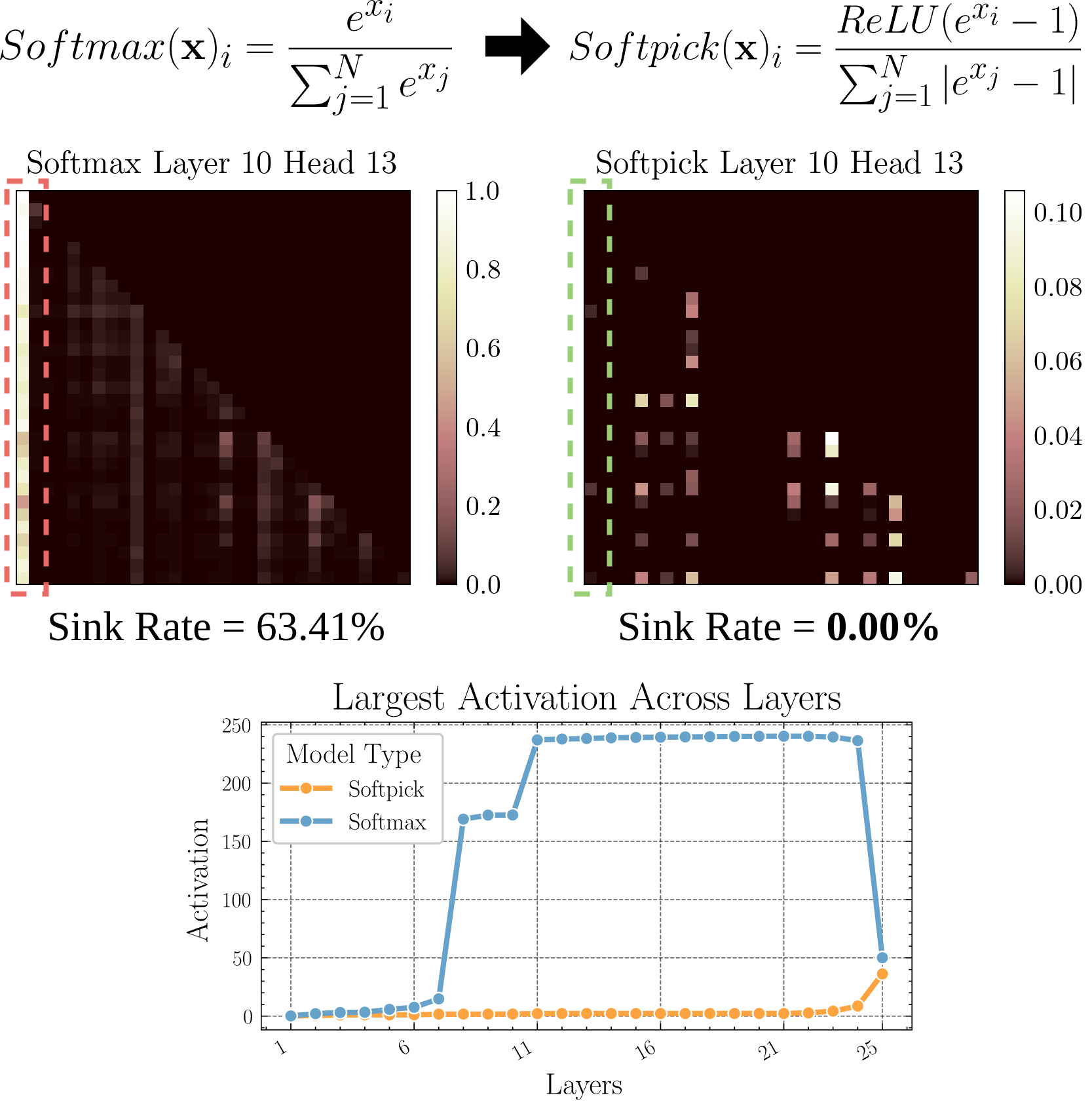

Softpick: Alternativa a Softmax para resolver el problema de Attention Sink: Un paper preimpreso propone el método Softpick, que utiliza Rectified Softmax en lugar del Softmax tradicional, con el objetivo de resolver los problemas de Attention Sink (concentración de la atención en unos pocos tokens) y valores de activación excesivamente grandes en los estados ocultos. Esta investigación explora alternativas al mecanismo de atención, que podría ayudar a mejorar la eficiencia y el rendimiento del modelo, especialmente al procesar secuencias largas (Fuente: arohan)

Uso de datos sintéticos para la investigación de arquitecturas de modelos: La investigación de Zeyuan Allen-Zhu et al. muestra que, a la escala de datos de preentrenamiento reales (como 100B tokens), las diferencias entre distintas arquitecturas de modelos pueden quedar ocultas por el ruido. Mientras que el uso de un “patio de recreo” de datos sintéticos de alta calidad puede revelar más claramente las tendencias de rendimiento debidas a las diferencias de arquitectura (como la duplicación de la profundidad de inferencia), observar antes la emergencia de capacidades avanzadas, y posiblemente predecir futuras direcciones en el diseño de modelos. Esto sugiere que los datos estructurados y de alta calidad son cruciales para comprender y comparar en profundidad las arquitecturas de los LLM (Fuente: teortaxesTex)

Lograr la alineación con las preferencias personalizadas del usuario mediante RLHF: La comunidad discute la propuesta de que se puede alinear modelos para diferentes arquetipos de usuarios mediante RLHF (Aprendizaje por Refuerzo con Retroalimentación Humana), y luego, tras identificar a qué arquetipo pertenece un usuario específico, utilizar métodos similares a SLERP (Interpolación Lineal Esférica) para mezclar o ajustar el comportamiento del modelo, para satisfacer mejor las preferencias personalizadas de ese usuario. Esto ofrece posibles líneas de entrenamiento para lograr asistentes de IA más personalizados (Fuente: jd_pressman)

🌟 Comunidad

Críticas al stack de software actual de ML: En la comunidad de desarrolladores surgen quejas sobre la fragilidad del stack de software actual de Machine Learning (ML), considerándolo tan frágil y difícil de mantener como usar tarjetas perforadas, a pesar de que la tecnología de IA ya no es de nicho ni está en sus etapas iniciales. Los críticos señalan que, incluso con una arquitectura de hardware relativamente unificada (principalmente GPUs de Nvidia), el nivel de software todavía carece de robustez y facilidad de uso, e incluso la excusa de que “la tecnología itera demasiado rápido” es difícil de aceptar (Fuente: Dorialexander, lateinteraction)

Discusión sobre el comportamiento selectivo de los usuarios al dar feedback a modelos de IA: La comunidad observa que, cuando IAs como ChatGPT ofrecen dos respuestas alternativas y piden al usuario que elija la mejor, muchos usuarios no leen ni comparan detenidamente las dos opciones. Esto ha generado un debate sobre la efectividad de este mecanismo de feedback. Algunos opinan que este patrón de comportamiento hace que el RLHF basado en la comparación de texto sea poco efectivo; en comparación, el juicio sobre la calidad de los modelos de generación de imágenes (como Midjourney) es más intuitivo y el feedback puede ser más efectivo. También se sugiere que, como alternativa, se podría pedir a los usuarios que elijan “qué dirección es más interesante” y solicitar a la IA que la desarrolle, como una forma alternativa de feedback (Fuente: wordgrammer, Teknium1, finbarrtimbers, scaling01)

Limitaciones de la IA para replicar la capacidad de los expertos: La discusión señala que convertir las grabaciones de las transmisiones en vivo de un experto en un campo a texto y alimentar con ello a una IA (generalmente mediante RAG), aunque permite a la IA responder preguntas que el experto ha tratado, esto no “replica” completamente la capacidad del experto. Los expertos pueden abordar nuevos problemas de manera flexible basándose en una comprensión profunda y experiencia, mientras que la IA depende principalmente de la recuperación y concatenación de información existente, careciendo de verdadera comprensión y pensamiento creativo. La ventaja de la IA radica en la recuperación rápida y la amplitud del conocimiento, pero todavía hay una brecha en profundidad y flexibilidad (Fuente: dotey)

Aceptación del contenido generado por IA en las comunidades: Un usuario compartió su experiencia de ser baneado de una comunidad de código abierto por compartir contenido generado por LLM, lo que generó una discusión sobre la tolerancia de las comunidades hacia el contenido generado por IA. Muchas comunidades (como subreddits de Reddit) mantienen una actitud cautelosa o incluso de rechazo hacia el contenido de IA, preocupadas por su proliferación, que podría llevar a una disminución de la calidad de la información o reemplazar la interacción humana. Esto refleja los desafíos y conflictos que enfrenta la tecnología de IA al integrarse en las normas comunitarias existentes (Fuente: Reddit r/ArtificialInteligence)

La función Claude Deep Research recibe buenas críticas: Los usuarios informan que la función Claude Deep Research de Anthropic supera a otras herramientas (incluyendo OpenAI DR y o3 normal) al realizar investigaciones profundas con cierta base previa. Puede proporcionar ideas novedosas y directas, así como información desconocida para el usuario, que no son generalidades. Sin embargo, para aprender un nuevo campo desde cero, OAI DR y vanilla o3 son comparables a Claude DR (Fuente: hrishioa, hrishioa)

Comportamientos “extraños” de los chatbots de IA: Usuarios de Reddit compartieron experiencias de interacción con Instagram AI (una IA con forma de taza) y Yahoo Mail AI. Instagram AI mostró un extraño comportamiento de coqueteo, mientras que Yahoo Mail AI realizó un “resumen” largo y completamente erróneo de un simple correo electrónico de agenda, causando malentendidos. Estos casos muestran que algunas aplicaciones actuales de IA todavía tienen problemas de comprensión e interacción, a veces produciendo resultados confusos o incluso incómodos (Fuente: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Discusión sobre la conciencia de la IA: La comunidad continúa debatiendo cómo determinar si la IA posee conciencia. Dado que nuestra comprensión de la conciencia humana en sí misma es incompleta, juzgar la conciencia de las máquinas se vuelve extremadamente difícil. Algunos citan la investigación de Anthropic sobre los procesos internos de “pensamiento” de Claude, señalando que la IA podría tener representaciones internas y capacidades de planificación inesperadas. Al mismo tiempo, otros argumentan que la IA necesitaría tener un “pensamiento ocioso” autodirigido y sin instrucciones explícitas para poder desarrollar una conciencia similar a la humana (Fuente: Reddit r/ArtificialInteligence)

Compartiendo experiencias de uso real del modelo Qwen3: Usuarios de la comunidad compartieron sus experiencias iniciales con la serie de modelos Qwen3 (especialmente las versiones 30B y 32B). Algunos usuarios consideran que tiene un rendimiento excelente y es rápido en aspectos como RAG y generación de código (con el ‘thinking’ desactivado), pero otros informan que no funciona bien o es inferior a modelos como Gemma 3 en casos de uso específicos (como seguir formatos estrictos, creación de novelas). Esto indica que puede haber una diferencia entre las altas puntuaciones del modelo en benchmarks y su rendimiento en escenarios de aplicación concretos (Fuente: Reddit r/LocalLLaMA)

💡 Otros

Reflexión sobre el valor del contenido generado por IA: El miembro de la comunidad NandoDF plantea que, aunque la IA ya ha generado grandes cantidades de texto, imágenes, audio y vídeo, parece que aún no ha creado obras de arte (como canciones, libros, películas) que realmente merezcan ser apreciadas repetidamente. Admite que cierto contenido generado por IA (como demostraciones matemáticas) tiene valor práctico, pero plantea una reflexión sobre la capacidad actual de la IA para crear valor profundo y duradero (Fuente: NandoDF)

IA y Personalización: Suhail enfatiza que la inteligencia de una IA que carece de información contextual sobre la vida personal, el trabajo, los objetivos, etc., del usuario es limitada. Prevé que en el futuro surgirán muchas empresas centradas en construir aplicaciones de IA que puedan utilizar la información contextual personal del usuario para ofrecer servicios más inteligentes (Fuente: Suhail)

El impacto de la IA en la atención: Algunos usuarios observan que, a medida que aumenta la longitud del contexto de los LLM, la capacidad de las personas para leer párrafos largos parece estar disminuyendo, apareciendo una tendencia de “TL;DR para todo” (Too Long; Didn’t Read). Esto suscita reflexiones sobre cómo la popularización de las herramientas de IA podría estar influyendo sutilmente en los hábitos cognitivos humanos (Fuente: cloneofsimo)