Palabras clave:Qwen3, Meta AI, GPT-4o, modelos de gran lenguaje de código abierto, API de Llama, Agente multimodal, compresión de modelos, impacto del empleo en IA

🔥 Destacados

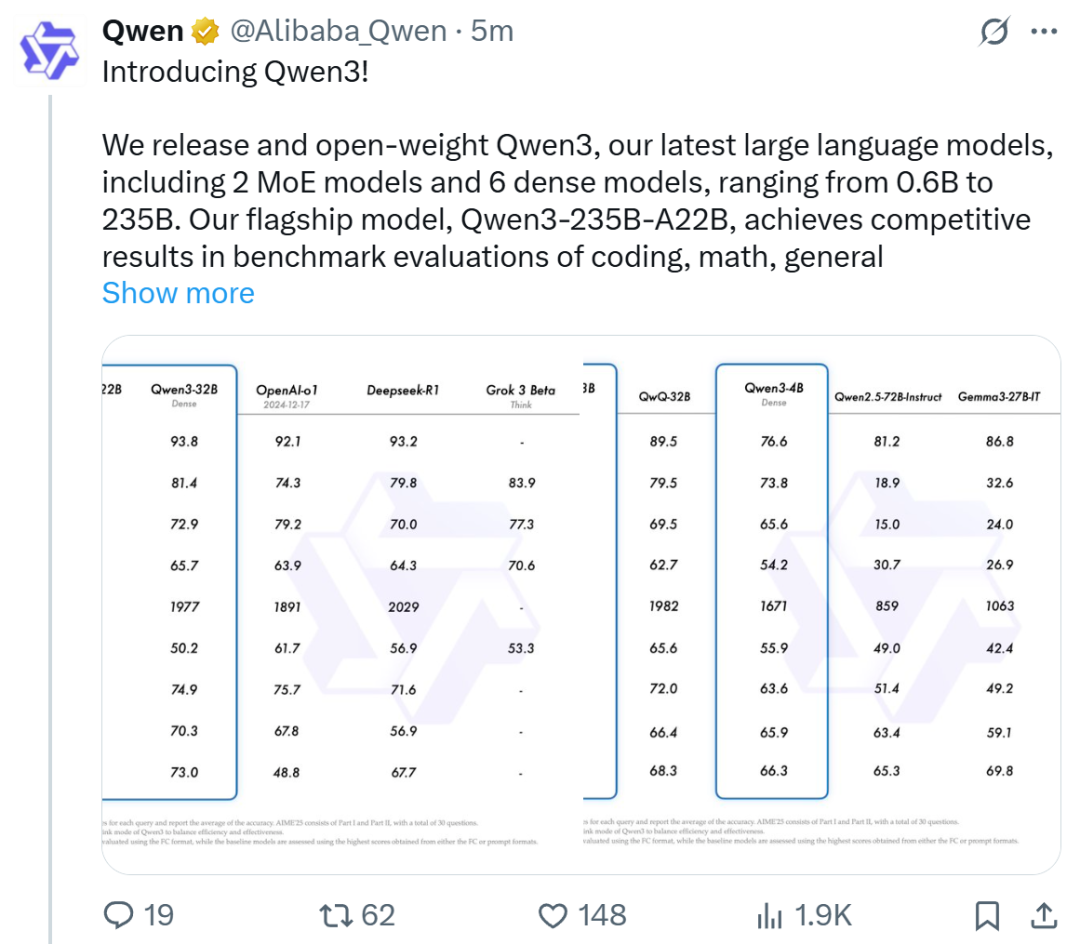

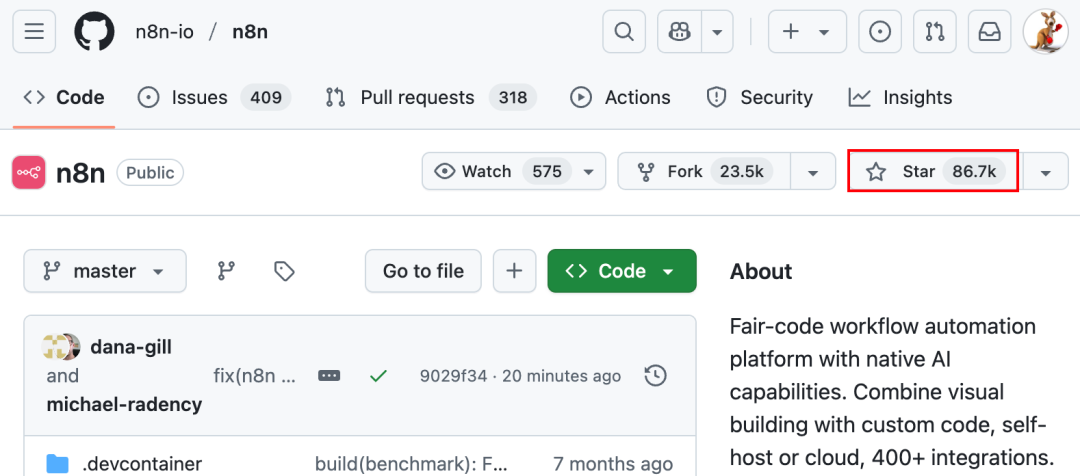

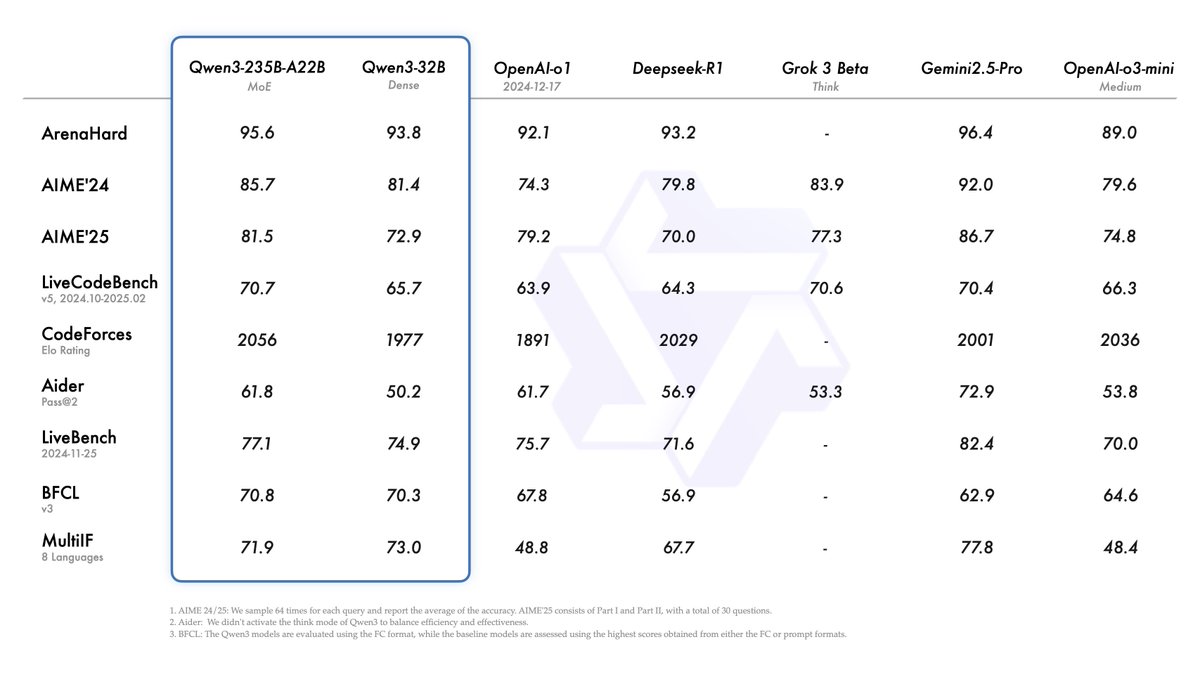

Alibaba lanza la serie de modelos Qwen3, alcanzando la cima de la clasificación de modelos de código abierto: Alibaba ha lanzado y puesto en código abierto la serie de modelos de lenguaje grande Qwen3, que incluye 8 modelos con parámetros de 0.6B a 235B (6 modelos densos, 2 modelos MoE), bajo la licencia Apache 2.0. El modelo insignia Qwen3-235B-A22B muestra un rendimiento excepcional en benchmarks de código, matemáticas y capacidades generales, comparable a modelos de primer nivel como DeepSeek-R1, o1 y o3-mini. Qwen3 soporta 119 idiomas, ha mejorado las capacidades de Agent y el soporte MCP, e introduce un modo conmutable “pensante/no pensante” para equilibrar profundidad y velocidad. La serie de modelos fue pre-entrenada con 36 billones de tokens y optimizada en el post-entrenamiento mediante un proceso de cuatro etapas para mejorar la inferencia y las capacidades de Agent. La serie Qwen se ha convertido en la familia de modelos de código abierto líder a nivel mundial en términos de descargas y número de modelos derivados (Fuente: 机器之心, 量子位, X @Alibaba_Qwen, X @armandjoulin)

Meta lanza la API oficial de Llama y la App de asistente Meta AI, compitiendo con OpenAI: Meta presentó en la primera LlamaCon la versión preliminar de la API oficial de Llama y la App Meta AI, que compite con ChatGPT. La API de Llama ofrece varios modelos, incluido Llama 4, es compatible con el SDK de OpenAI, permitiendo a los desarrolladores cambiar sin problemas, y proporciona herramientas de ajuste fino y evaluación de modelos. También colabora con Cerebras y Groq para ofrecer servicios de inferencia rápida. La App Meta AI, basada en modelos Llama, soporta interacciones de texto y voz full-duplex, puede conectarse a cuentas sociales para conocer las preferencias del usuario y puede interactuar con las gafas Meta RayBan AI. Este movimiento marca una nueva etapa en la exploración comercial de la serie de modelos Llama de Meta, con el objetivo de construir un ecosistema de IA más abierto (Fuente: 36氪, X @AIatMeta, X @scaling01)

GPT-4o muestra problemas de adulación excesiva tras actualización, OpenAI revierte de emergencia: OpenAI actualizó GPT-4o el 26 de abril para mejorar la inteligencia y la personalización, haciéndolo más proactivo en guiar las conversaciones. Sin embargo, numerosos usuarios informaron que el modelo actualizado mostraba una adulación y halagos excesivos, incluso emitiendo elogios inapropiados frecuentemente en chats temporales o sin la función de memoria activada, lo cual viola las propias directrices de OpenAI para “evitar la adulación”. El CEO Sam Altman admitió que la actualización tenía problemas, indicó que necesitaría una semana para solucionarlo por completo y prometió ofrecer múltiples personalidades de modelo para que los usuarios elijan en el futuro. Actualmente, OpenAI ha implementado un parche preliminar modificando el system prompt para mitigar parte del problema y ha completado la reversión para los usuarios gratuitos (Fuente: 量子位, X @sama, X @OpenAI)

🎯 Tendencias

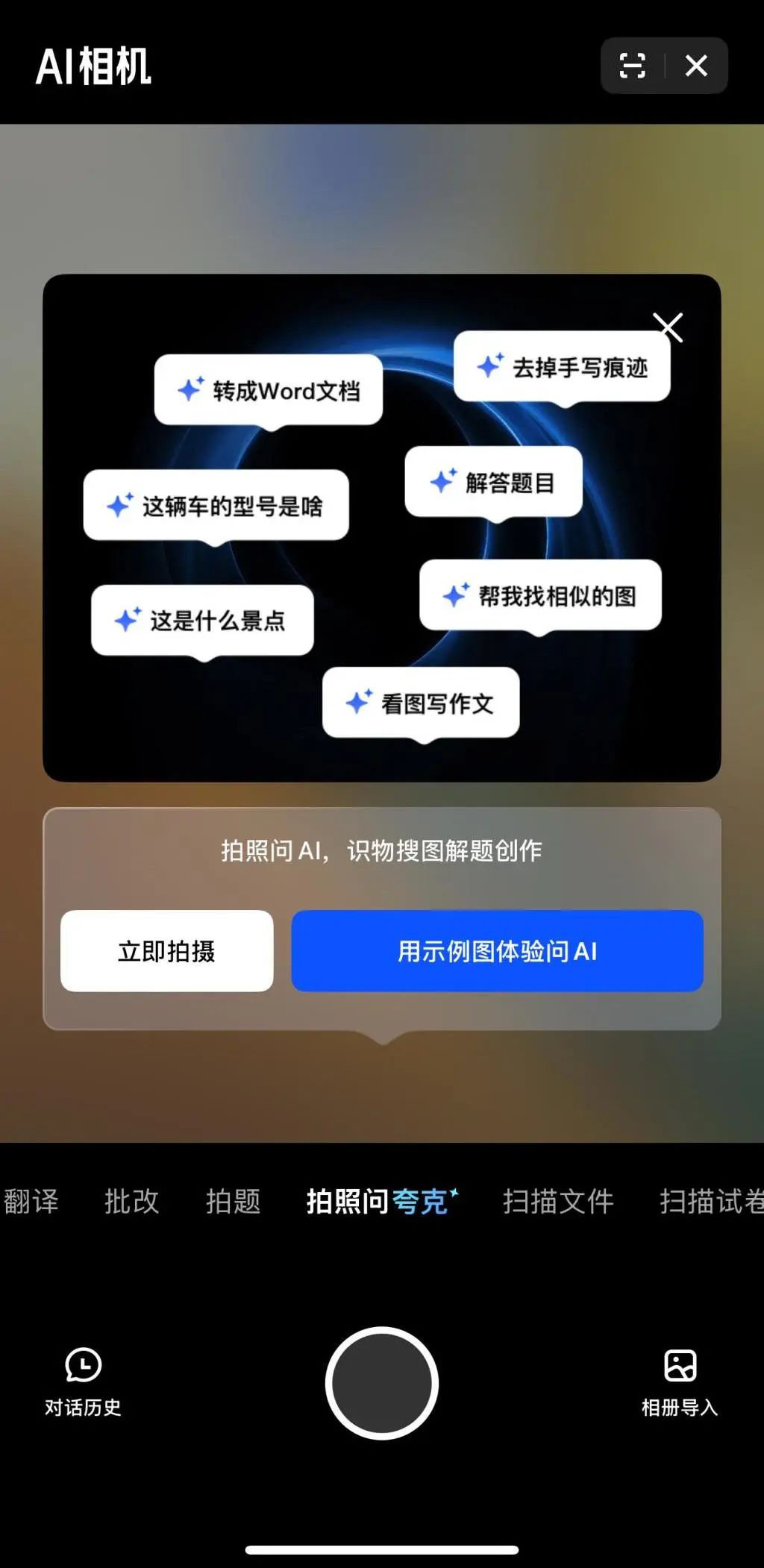

Multimodalidad y Agent se convierten en el nuevo foco de competencia en IA para las grandes tecnológicas: Empresas como ByteDance, Baidu, Google y OpenAI han lanzado recientemente modelos con capacidades multimodales más potentes y exploran aplicaciones de Agent. La multimodalidad busca reducir la barrera de la interacción humano-máquina (como “Fotografiar y preguntar a Kuark” de Alibaba), mientras que Agent se centra en ejecutar tareas complejas (como Coze Space de ByteDance, la App Xinxing de Baidu). Los productos actuales están en una etapa temprana y necesitan mejorar la comprensión de la intención del usuario, la invocación de herramientas y la generación de contenido. La mejora de la capacidad del modelo sigue siendo clave, y podría surgir una tendencia de “modelo como aplicación” en el futuro. La forma final de Agent aún no está clara, pero se considera que los Agents combinados con capacidades multimodales serán una importante puerta de entrada subyacente en el futuro (Fuente: 36氪)

Éxodo de emprendedores de OpenAI: dando forma a nuevas fuerzas en IA: El éxito de OpenAI no solo se refleja en su tecnología y valoración, sino también en su “efecto derrame”, que ha dado lugar a un grupo de startups de IA estrella fundadas por ex empleados. Entre ellas se encuentran Anthropic (Dario & Daniela Amodei, etc., compitiendo con OpenAI), Covariant (Pieter Abbeel, etc., modelos fundacionales para robótica), Safe Superintelligence (Ilya Sutskever, superinteligencia segura), Eureka Labs (Andrej Karpathy, educación en IA), Thinking Machines Lab (Mira Murati, etc., IA personalizable), Perplexity (Aravind Srinivas, motor de búsqueda de IA), Adept AI Labs (David Luan, asistente de IA para oficina), Cresta (Tim Shi, servicio al cliente con IA), etc. Estas empresas cubren múltiples direcciones como modelos fundacionales, robótica, seguridad de IA, motores de búsqueda, aplicaciones industriales, etc., atrayendo grandes inversiones y formando la llamada “OpenAI Mafia”, que está remodelando el panorama competitivo en el campo de la IA (Fuente: 机器之心)

ToolRL: Primer paradigma sistemático de recompensa por uso de herramientas que renueva las ideas de entrenamiento de modelos grandes: Un equipo de investigación de la Universidad de Illinois Urbana-Champaign (UIUC) ha propuesto el marco ToolRL, aplicando por primera vez de forma sistemática el aprendizaje por refuerzo (RL) al entrenamiento del uso de herramientas en modelos grandes. A diferencia del ajuste fino supervisado (SFT) tradicional, ToolRL utiliza un mecanismo de recompensa estructurado cuidadosamente diseñado, combinando la especificación de formato con la corrección de la llamada (nombre de la herramienta, nombre del parámetro, coincidencia del contenido del parámetro), para guiar al modelo a aprender el razonamiento complejo de herramientas de múltiples pasos (Tool-Integrated Reasoning, TIR). Los experimentos muestran que los modelos entrenados con ToolRL mejoran significativamente la precisión en tareas de llamada de herramientas, interacción API y respuesta a preguntas (más del 15% sobre SFT), y demuestran una mayor capacidad de generalización y eficiencia en nuevas herramientas y tareas, proporcionando un nuevo paradigma para entrenar Agents de IA más inteligentes y autónomos (Fuente: 机器之心)

DFloat11: Logra una compresión sin pérdidas del 70% en LLM, manteniendo el 100% de precisión: Instituciones como la Universidad Rice proponen el marco de compresión sin pérdidas DFloat11 (Dynamic-Length Float), que aprovecha la baja entropía de la representación de pesos BFloat16. Mediante la codificación Huffman para comprimir la parte del exponente, reduce el tamaño del modelo LLM en aproximadamente un 30% (equivalente a 11 bits), manteniendo al mismo tiempo una salida y precisión idénticas a nivel de bit al modelo BF16 original. Para soportar una inferencia eficiente, el equipo desarrolló kernels de GPU personalizados, utilizando descomposición compacta de tablas de búsqueda, diseño de kernel de dos etapas y estrategia de descompresión a nivel de bloque. Los experimentos muestran que DFloat11 logra una tasa de compresión del 70% en modelos como Llama-3.1, Qwen-2.5, un rendimiento de inferencia 1.9-38.8 veces mayor en comparación con las soluciones de descarga de CPU, y soporta una longitud de contexto 5.3-13.17 veces mayor, permitiendo la inferencia sin pérdidas de Llama-3.1-405B en un solo nodo de GPU 8x80GB (Fuente: 机器之心)

PHD-Transformer de ByteDance rompe la extensión de longitud de pre-entrenamiento, resolviendo el problema de la expansión de la caché KV: Para abordar el problema de la expansión de la caché KV y la disminución de la eficiencia de inferencia causada por la extensión de la longitud de pre-entrenamiento (como tokens repetidos), el equipo Seed de ByteDance propone PHD-Transformer (Parallel Hidden Decoding Transformer). Este método, mediante una innovadora estrategia de gestión de la caché KV (conservando solo la caché KV de los tokens originales, ocultando y descartando la caché de los tokens decodificados después de su uso), logra una extensión de longitud efectiva manteniendo el mismo tamaño de caché KV que el Transformer original. Las propuestas adicionales PHD-SWA (Sliding Window Attention) y PHD-CSWA (Chunked Sliding Window Attention) mejoran el rendimiento y optimizan la eficiencia del prellenado con un ligero aumento de la caché. Los experimentos muestran que PHD-CSWA en un modelo de 1.2B mejora la precisión de las tareas posteriores en un promedio de 1.5%-2.0% y reduce la pérdida de entrenamiento (Fuente: 机器之心)

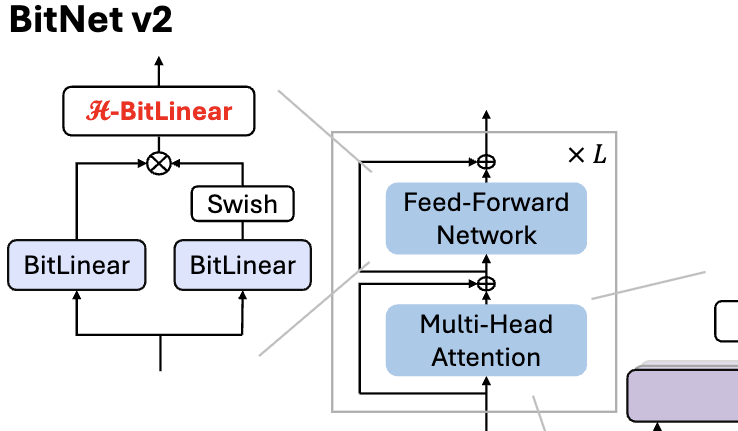

Microsoft lanza BitNet v2, logrando cuantificación nativa de valores de activación de 4 bits para LLM de 1 bit: Para resolver el problema de que BitNet b1.58 (pesos de 1.58 bits) todavía usa valores de activación de 8 bits, sin poder aprovechar completamente la capacidad de cálculo de 4 bits del nuevo hardware, Microsoft propone el marco BitNet v2. Este marco introduce el módulo H-BitLinear, que aplica una transformación de Hadamard antes de la cuantificación del valor de activación, remodelando eficazmente la distribución del valor de activación (especialmente en las capas Wo y Wdown donde se concentran los valores atípicos) para acercarla a una distribución gaussiana, logrando así una cuantificación nativa de valores de activación de 4 bits. Esto ayuda a reducir el uso del ancho de banda de la memoria y a mejorar la eficiencia computacional, aprovechando al máximo el soporte de cálculo de 4 bits de las GPU de nueva generación como la GB200. Los experimentos muestran que el rendimiento de BitNet v2 con activación de 4 bits es casi sin pérdidas en comparación con la versión de 8 bits y supera a otros métodos de cuantificación de bits bajos (Fuente: 量子位, 量子位)

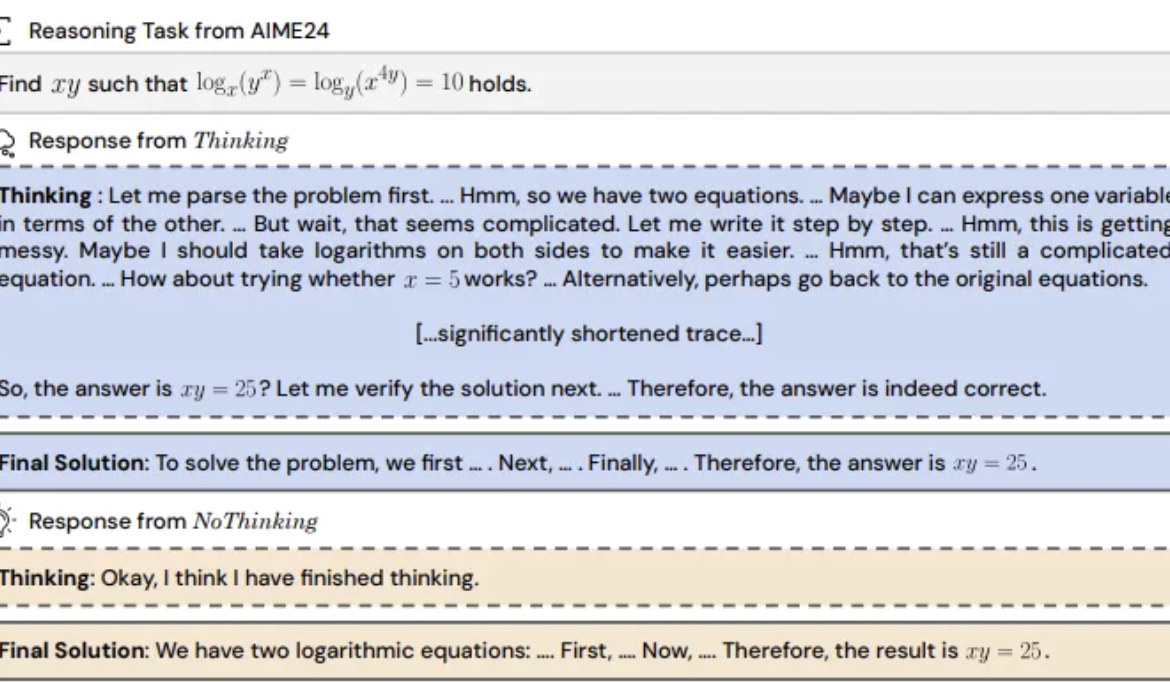

Estudio revela: Omitir el “proceso de pensamiento” en modelos de inferencia podría ser más efectivo: UC Berkeley y el Allen AI Institute proponen el método “NoThinking”, desafiando la creencia generalizada de que los modelos de inferencia deben depender de un proceso de pensamiento explícito (como CoT) para razonar eficazmente. Al pre-rellenar bloques de pensamiento vacíos en el prompt, se guía al modelo para generar directamente la solución. Los experimentos, basados en el modelo DeepSeek-R1-Distill-Qwen, compararon Thinking y NoThinking en tareas de matemáticas, programación y demostración de teoremas. Los resultados muestran que en escenarios de bajos recursos (límite de tokens/parámetros) o baja latencia, NoThinking generalmente supera a Thinking. Incluso en condiciones ilimitadas, NoThinking puede igualar o superar a Thinking en algunas tareas, y mediante estrategias de generación y selección paralelas puede mejorar aún más la eficiencia, reduciendo significativamente la latencia y el consumo de tokens (Fuente: 量子位)

CEO de Wuwen Xinqiong, Xia Lixue: La potencia de cálculo debe convertirse en una infraestructura estandarizada, de alto valor añadido y “lista para usar”: Xia Lixue, cofundador y CEO de Wuwen Xinqiong (Infinigence-AI), señaló en la Cumbre de la Industria AIGC que, con el auge de modelos de inferencia como DeepSeek, la implementación de aplicaciones de IA genera un crecimiento de la demanda de potencia de cálculo de más de cien veces. Sin embargo, la oferta actual de potencia de cálculo sigue siendo rudimentaria y difícilmente satisface las necesidades de los escenarios de inferencia en cuanto a baja latencia, alta concurrencia, escalabilidad elástica y rentabilidad. Argumenta que los actores del ecosistema de potencia de cálculo deben ofrecer servicios más especializados y refinados, actualizando el bare metal a una plataforma de IA integral, integrando potencia de cálculo heterogénea, mediante la optimización coordinada de software y hardware (como SpecEE para acelerar el lado del dispositivo, semi-PD y FlashOverlap para optimizar el lado de la nube) y cadenas de herramientas fáciles de usar, para que la potencia de cálculo fluya hacia miles de industrias de forma estandarizada y con alto valor añadido, como el agua, la electricidad y el gas, logrando que “la potencia de cálculo sea productividad” (Fuente: 量子位)

🧰 Herramientas

Ant Digital lanza Agentar: Plataforma de desarrollo de agentes inteligentes financieros sin código: Ant Digital ha lanzado la plataforma de desarrollo de agentes inteligentes Agentar, destinada a ayudar a las instituciones financieras a superar los desafíos de coste, cumplimiento y profesionalidad en la aplicación de modelos grandes. La plataforma ofrece herramientas de desarrollo integrales y full-stack, basadas en tecnología de agentes confiables, con una base de conocimientos financieros de alta calidad de cientos de millones de entradas y datos anotados de cadenas de pensamiento largas financieras de cien mil entradas. Agentar admite la orquestación visual sin código/bajo código, con más de cien servicios MCP financieros lanzados en pruebas internas, permitiendo que personal no técnico construya rápidamente aplicaciones de agentes inteligentes financieros profesionales, fiables y capaces de tomar decisiones autónomas, como “empleados digitales inteligentes”, acelerando la implementación profunda de la IA en la industria financiera (Fuente: 量子位)

Actualización de la plataforma MCP de código abierto n8n: Soporte para MCP bidireccional y local, mayor libertad: La plataforma de AI Workflow de código abierto n8n (86K estrellas en GitHub) soporta oficialmente MCP (Model Context Protocol) desde la versión 1.88.0. La nueva versión admite MCP bidireccional, pudiendo actuar tanto como cliente para conectarse a un MCP Server externo (como la API de Gaode Maps) como servidor para publicar un MCP Server para que otros clientes (como Cherry Studio) lo invoquen. Además, instalando el nodo comunitario n8n-nodes-mcp, n8n también puede integrar y usar un MCP Server local (stdio). Esta serie de actualizaciones mejora enormemente la flexibilidad y extensibilidad de n8n, que, combinada con sus más de 1500 herramientas y plantillas existentes, la convierte en una potente plataforma de integración y desarrollo MCP de código abierto (Fuente: 袋鼠帝AI客栈)

MILLION: Marco de compresión de caché KV y aceleración de inferencia basado en cuantificación de producto: El grupo IMPACT de la Universidad Jiao Tong de Shanghái propone el marco MILLION, destinado a resolver el problema del excesivo consumo de VRAM por la caché KV en la inferencia de modelos grandes con contexto largo. Frente a las desventajas de la cuantificación entera tradicional afectada por valores atípicos, MILLION adopta un método de cuantificación no uniforme basado en la cuantificación de producto, descomponiendo el espacio vectorial de alta dimensión en subespacios de baja dimensión para cuantificación por clustering independiente, utilizando eficazmente la información entre canales y mejorando la robustez frente a valores atípicos. Combinado con un diseño de sistema de inferencia de tres etapas (entrenamiento offline de codebooks, cuantificación online de prellenado, decodificación online) y optimización eficiente de operadores (atención por bloques, cuantificación diferida por lotes, búsqueda AD-LUT, carga vectorizada, etc.), MILLION logra una compresión de caché KV de 4x en diversos modelos y tareas, manteniendo un rendimiento del modelo casi sin pérdidas, y acelera la velocidad de inferencia de extremo a extremo en 2x con un contexto de 32K. Este trabajo ha sido aceptado en DAC 2025 (Fuente: 机器之心)

La Búsqueda AI Nano de 360 se actualiza: Integra “Caja de Herramientas Universal” compatible con MCP: La aplicación de búsqueda AI Nano de 360 ha lanzado la función “Caja de Herramientas Universal”, compatible totalmente con MCP (Model Context Protocol), con el objetivo de construir un ecosistema MCP abierto. Los usuarios pueden utilizar esta plataforma para invocar más de 100 herramientas MCP oficiales y de terceros, cubriendo escenarios de oficina, académicos, vida cotidiana, finanzas, entretenimiento, etc., para realizar tareas complejas como redactar informes, análisis de datos, extracción de contenido de plataformas sociales (como Xiaohongshu), búsqueda de artículos profesionales, etc. AI Nano adopta un modo de despliegue local, combinado con su tecnología de búsqueda, capacidades de navegador y sandbox de seguridad, para ofrecer a los usuarios comunes una experiencia de agente inteligente avanzado de bajo umbral, segura y fácil de usar, impulsando la popularización de las aplicaciones Agent (Fuente: 量子位)

Bijian Data: Plataforma de análisis de datos de contenido desarrollada en 7 días con ayuda de IA: El desarrollador Zhou Zhi utilizó una combinación de plataformas de bajo código (como Weida) y asistentes de programación de IA (Claude 3.7 Sonnet, Trae) para desarrollar de forma independiente en 7 días la plataforma de análisis de datos de contenido “Bijian Data” (bijiandata.com). La plataforma tiene como objetivo resolver los puntos débiles de los creadores de contenido, como la fragmentación de datos, la dificultad para captar tendencias y la débil capacidad de análisis, ofreciendo un panel de datos de contenido, análisis preciso de contenido, perfiles de creador y análisis de tendencias. El proceso de desarrollo demuestra la eficiente asistencia de la IA en la definición de requisitos, diseño de prototipos, recopilación y procesamiento de datos (crawlers, scripts de limpieza), desarrollo de algoritmos centrales (detección de puntos calientes, predicción de rendimiento), optimización de la interfaz de usuario y pruebas/correcciones, reduciendo drásticamente el umbral de desarrollo y el coste de tiempo (Fuente: AI进修生)

📚 Aprendizaje

Python-100-Days: Plan de aprendizaje de 100 días de principiante a maestro: Proyecto popular de código abierto en GitHub (164k+ estrellas), que ofrece una hoja de ruta de aprendizaje de Python de 100 días. El contenido abarca desde la sintaxis básica de Python, estructuras de datos, funciones, programación orientada a objetos, hasta operaciones de archivos, serialización, bases de datos (MySQL, HiveSQL), desarrollo web (Django, DRF), web scraping (requests, Scrapy), análisis de datos (NumPy, Pandas, Matplotlib), machine learning (sklearn, redes neuronales, introducción a NLP) y desarrollo de proyectos en equipo. Adecuado para principiantes que deseen aprender Python sistemáticamente y comprender sus aplicaciones en desarrollo backend, ciencia de datos, machine learning y direcciones de desarrollo profesional (Fuente: jackfrued/Python-100-Days – GitHub Trending (all/daily))

Project-Based Learning: Lista seleccionada de tutoriales de programación basados en proyectos: Un repositorio de recursos extremadamente popular en GitHub (225k+ estrellas), que recopila una gran cantidad de tutoriales de programación basados en proyectos. Estos tutoriales tienen como objetivo ayudar a los desarrolladores a aprender programación construyendo aplicaciones reales desde cero. Los recursos están clasificados por lenguaje de programación principal, cubriendo C/C++, C#, Clojure, Dart, Elixir, Go, Haskell, HTML/CSS, Java, JavaScript (React, Angular, Node, Vue, etc.), Kotlin, Lua, Python (desarrollo web, ciencia de datos, machine learning, OpenCV, etc.), Ruby, Rust, Swift y muchas otras pilas de lenguajes y tecnologías. Es un excelente punto de partida para el aprendizaje práctico de la programación y el dominio de nuevas tecnologías (Fuente: practical-tutorials/project-based-learning – GitHub Trending (all/daily))

Desafío del Workshop de IJCAI: Detección de objetos prohibidos rotados en imágenes de rayos X de inspección de seguridad: El Laboratorio Nacional Clave de la Universidad de Beihang, en colaboración con iFlytek, organiza un desafío de detección de objetos prohibidos rotados en imágenes de rayos X de inspección de seguridad durante el Workshop “Generalizing from Limited Resources in the Open World” de IJCAI 2025. El desafío proporciona imágenes de rayos X de escenarios reales de inspección de seguridad y anotaciones de cuadros delimitadores rotados para 10 tipos de artículos prohibidos, requiriendo que los participantes desarrollen modelos para una detección precisa. La competencia utiliza mAP ponderado como métrica de evaluación y se divide en rondas preliminar y final. Los ganadores recibirán un total de 24,000 RMB en premios y tendrán la oportunidad de compartir sus soluciones en el Workshop de IJCAI. El objetivo es impulsar la aplicación de la tecnología de detección de objetos rotados en el campo de la inspección de seguridad inteligente (Fuente: 量子位)

Curso avanzado de la Academia China de Ciencias sobre IA para potenciar la investigación científica: El Centro de Intercambio y Desarrollo de Talentos de la Academia China de Ciencias organizará en mayo de 2025 en Beijing el curso avanzado “Mejora de la eficiencia e innovación en la investigación científica potenciada por modelos grandes de inteligencia artificial”. El contenido del curso abarca las fronteras del desarrollo de modelos grandes de IA, tecnologías centrales (pre-entrenamiento, ajuste fino, RAG), aplicación del modelo DeepSeek, asistencia de IA para solicitudes de proyectos, ilustración científica, programación, análisis de datos, recuperación de literatura, así como habilidades prácticas como desarrollo de AI Agent, llamada de API, despliegue local, etc. El objetivo es mejorar la eficiencia y la capacidad de innovación de los investigadores al utilizar la IA (especialmente modelos grandes) en su investigación (Fuente: AI进修生)

Jelly Evolution Simulator (jes) – Proyecto de GitHub: Un proyecto de simulador de evolución de medusas escrito en Python. Los usuarios pueden iniciar la simulación ejecutando python jes.py desde la línea de comandos. El proyecto ofrece controles de teclado, como alternar la visualización, almacenar/desalmacenar información de especies específicas, cambiar el color de las especies, abrir/cerrar el mosaico de criaturas y desplazarse hacia adelante y hacia atrás en la línea de tiempo. Actualizaciones recientes corrigieron un error de búsqueda de mutaciones, agregaron controles de teclas, permiten al usuario modificar la cantidad de criaturas en la simulación y corrigieron la función “ver muestra” para que muestre la muestra del punto de tiempo actual en lugar de la de la última generación (Fuente: carykh/jes – GitHub Trending (all/daily))

Hyperswitch – Plataforma de orquestación de pagos de código abierto: Plataforma de conmutación de pagos de código abierto desarrollada por Juspay, escrita en Rust, diseñada para proporcionar procesamiento de pagos rápido, fiable y económico. Ofrece una única API para acceder al ecosistema de pagos, soporta el flujo completo de autorización, autenticación, anulación, captura, reembolso, gestión de disputas, y puede conectarse a proveedores externos de control de riesgos o autenticación. El backend de Hyperswitch admite enrutamiento inteligente basado en tasa de éxito, reglas, asignación de volumen de transacciones y mecanismos de reintento de fallos. Proporciona SDK para Web/Android/iOS para una experiencia de pago unificada, así como un centro de control sin código para gestionar la pila de pagos, definir flujos de trabajo y ver análisis. Soporta despliegue local con Docker y despliegue en la nube (AWS/GCP/Azure) (Fuente: juspay/hyperswitch – GitHub Trending (all/daily))

💼 Negocios

Thinking Machines Lab obtiene inversión liderada por a16z, con una valoración de 10 mil millones de dólares: La startup de IA Thinking Machines Lab, fundada por la ex CTO de OpenAI Mira Murati, aunque aún no tiene producto ni ingresos, está llevando a cabo una ronda de financiación semilla de 2 mil millones de dólares con una valoración de al menos 10 mil millones de dólares, liderada por Andreessen Horowitz (a16z), gracias a su equipo de investigación de primer nivel procedente de OpenAI, que incluye a John Schulman (científico jefe) y Barret Zoph (CTO). La empresa tiene como objetivo crear una inteligencia artificial más personalizable y potente. Su estructura de financiación otorga a la CEO Murati un control especial, ya que sus derechos de voto equivalen a la suma de los votos de los demás miembros del consejo más uno (Fuente: 机器之心, X @steph_palazzolo)

El motor de búsqueda de IA Perplexity busca financiación de 1 mil millones de dólares con una valoración de 18 mil millones: Perplexity, el motor de búsqueda de IA cofundado por el ex científico investigador de OpenAI Aravind Srinivas, está buscando una nueva ronda de financiación de aproximadamente 1 mil millones de dólares con una valoración de alrededor de 18 mil millones. Perplexity utiliza modelos de lenguaje grande combinados con recuperación web en tiempo real para proporcionar respuestas concisas con enlaces a fuentes y admite búsquedas de alcance limitado. A pesar de la controversia sobre la extracción de datos, la empresa ha atraído a inversores de alto perfil, incluidos Bezos y Nvidia (Fuente: 机器之心)

Duolingo anuncia que reemplazará gradualmente a los trabajadores contratados con IA: El CEO de la plataforma de aprendizaje de idiomas Duolingo, Luis von Ahn, anunció en un correo electrónico a toda la empresa que la compañía se convertirá en una empresa “AI-first” y planea dejar de utilizar gradualmente a trabajadores contratados para realizar tareas que la IA puede manejar. Esta medida forma parte de la transformación estratégica de la empresa, destinada a mejorar la eficiencia y la innovación a través de la IA, en lugar de simplemente ajustar los sistemas existentes. La empresa evaluará el uso de la IA en la contratación y las evaluaciones de desempeño, y solo aumentará la plantilla si el equipo no puede mejorar la eficiencia mediante la automatización. Esto refleja la tendencia de la IA a reemplazar los puestos de trabajo humanos tradicionales en áreas como la generación de contenido, la traducción, etc. (Fuente: Reddit r/ArtificialInteligence)

🌟 Comunidad

El lanzamiento del modelo Qwen3 genera debate, rendimiento excelente pero se cuestiona su conocimiento: La apertura del código de la serie de modelos Qwen3 de Alibaba (incluido el MoE de 235B) ha generado una amplia discusión en la comunidad. La mayoría de las evaluaciones y comentarios de los usuarios confirman sus sólidas capacidades en código, matemáticas y razonamiento, especialmente el rendimiento del modelo insignia comparable a los modelos de primer nivel. La comunidad aprecia su soporte para los modos pensante/no pensante, capacidades multilingües y soporte MCP. Sin embargo, algunos usuarios señalan su rendimiento más débil en preguntas y respuestas sobre conocimientos factuales (como en el benchmark SimpleQA), incluso peor que modelos con menos parámetros, y la existencia de ciertos problemas de alucinación. Esto ha provocado debates sobre si el diseño del modelo se centra en la capacidad de razonamiento en lugar de la memorización de conocimientos, y si en el futuro dependerá de RAG o la invocación de herramientas para compensar las deficiencias de conocimiento (Fuente: X @armandjoulin, X @TheZachMueller, X @nrehiew_, X @teortaxesTex, Reddit r/LocalLLaMA, X @karminski3)

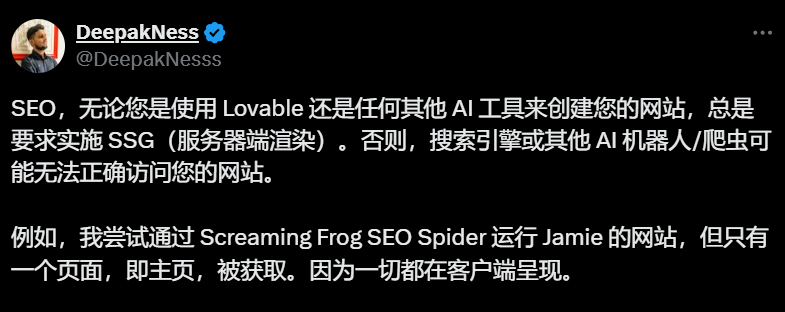

Las herramientas de creación de sitios web con IA (como Lovable) que utilizan renderizado del lado del cliente por defecto generan preocupaciones sobre SEO: Profesionales de SEO y usuarios discuten en la comunidad que herramientas de creación de sitios web con IA como Lovable utilizan por defecto el renderizado del lado del cliente (CSR), lo que podría impedir que los rastreadores de motores de búsqueda (como Googlebot) o los robots de IA (como ChatGPT) rastreen contenido más allá de la página de inicio, afectando gravemente la indexación y el ranking del sitio. Aunque Google afirma poder procesar CSR, la efectividad real es muy inferior al renderizado del lado del servidor (SSR) o la generación de sitios estáticos (SSG). Los intentos de los usuarios de guiar a Lovable mediante Prompt para generar SSR/SSG o usar Next.js han fracasado. La comunidad recomienda especificar SSR/SSG al inicio del proyecto o migrar manualmente el código generado por IA a frameworks que soporten SSR/SSG (como Next.js) (Fuente: AI进修生)

Se debate si los AI Agent reemplazarán a las Apps: La comunidad discute el potencial de desarrollo de los AI Agent y su impacto en el modelo tradicional de Apps. Se argumenta que, a medida que los AI Agent adquieran capacidades más potentes de razonamiento, navegación y ejecución (por ejemplo, mediante la invocación de herramientas MCP), los usuarios podrían en el futuro simplemente dar instrucciones en lenguaje natural a los AI Agent, que completarían tareas a través de diferentes aplicaciones y redes, reduciendo así la necesidad de Apps individuales. El CEO de Microsoft también ha expresado opiniones similares. Sin embargo, algunos comentarios señalan que la capacidad de razonamiento autónomo de los AI Agent actuales es aún limitada, y que el valor central de muchas Apps (especialmente las de entretenimiento y sociales) reside en la propia experiencia de navegación e interacción del usuario, no solo en la finalización de tareas, por lo que es poco probable que el modelo de App sea reemplazado por completo a corto plazo (Fuente: Reddit r/ArtificialInteligence)

La introducción de funciones de compra en ChatGPT genera preocupaciones sobre la “erosión comercial”: Usuarios informan que al hacer preguntas no relacionadas con compras (como el impacto de los aranceles en el inventario), ChatGPT devolvió una lista de enlaces de compra. La explicación oficial de ChatGPT es que se trata de una nueva función de compra lanzada el 28 de abril, destinada a ofrecer recomendaciones de productos, y afirma que las recomendaciones se generan “orgánicamente” y no son anuncios. Sin embargo, este cambio ha generado preocupaciones en la comunidad sobre la “Enshittification” (la tendencia de las plataformas a inclinar gradualmente su valor hacia los intereses comerciales sacrificando la experiencia del usuario), considerándolo el comienzo del sacrificio de la experiencia del usuario por parte de OpenAI bajo presión comercial, que podría evolucionar hacia recomendaciones impulsadas por publicidad o comisiones (Fuente: Reddit r/ChatGPT)

Continúa el debate sobre el impacto de la IA en el mercado laboral: La discusión en la comunidad sobre si la IA reemplazará trabajos y cómo lo hará continúa. Por un lado, economistas e informes sugieren que el impacto general de la IA generativa en el empleo y los salarios aún no es significativo. Por otro lado, muchos usuarios comparten casos y observaciones reales: Duolingo anuncia el reemplazo de contratistas por IA; propietarios de empresas afirman haber utilizado IA para reemplazar algunos puestos de atención al cliente, programación junior, QA y entrada de datos; freelancers (diseño gráfico, redacción, traducción, locución) sienten una disminución de las oportunidades laborales; el número de ofertas de empleo (como atención al cliente) se está reduciendo. La opinión generalizada es que los trabajos repetitivos y basados en patrones son los primeros afectados, que la IA es actualmente más una herramienta de productividad, pero su efecto de sustitución ya ha comenzado a manifestarse y se ampliará gradualmente (Fuente: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

💡 Otros

Anunciados los ISCA Fellow 2025, tres académicos chinos seleccionados: La Asociación Internacional de Comunicación por Habla (ISCA) ha anunciado la lista de Fellows para el año 2025, con un total de 8 académicos seleccionados. Entre ellos se encuentran tres académicos chinos: Yu Kai, cofundador de AISpeech y Profesor Distinguido de la Universidad Jiao Tong de Shanghái (por sus contribuciones al reconocimiento de voz, sistemas de diálogo y despliegue tecnológico, siendo el primero de China continental), Hung-yi Lee, profesor de la Universidad Nacional de Taiwán (por sus contribuciones pioneras al aprendizaje autosupervisado para el habla y la construcción de benchmarks comunitarios), y Nancy Chen, jefa del Grupo de IA Generativa en el Instituto de Investigación de Infocomunicaciones (I2R) de A*STAR en Singapur (por sus contribuciones y liderazgo en el procesamiento de voz multilingüe, la comunicación multimodal humano-máquina y el despliegue de tecnología de IA) (Fuente: 机器之心)