Palabras clave:Agente de IA inteligente, Robot humanoide, Modelo de gran escala, AIGC, Microsoft 365 Copilot, Modelo virtual de mosca de la fruta de DeepMind, Abuso de artículos académicos de IA, Modelo de código abierto de OpenAI, Comercialización de fármacos con IA, Cabina inteligente con modelo de gran escala en el dispositivo, Ecosistema de IA del protocolo MCP, Técnicas de pintura con IA

🔥 Enfoque

Microsoft presenta agentes de IA e informe de tendencias laborales para 2025: Microsoft lanza una importante actualización de Microsoft 365 Copilot, introduciendo agentes de IA como Researcher y Analyst, con el objetivo de elevar la IA de herramienta a “compañero de trabajo de IA”. Las nuevas funciones incluyen Notebook (integra Web+Work+Pages), búsqueda integral (a través de aplicaciones y fuentes de terceros) y Create (integra generación de imágenes con GPT-4o). El informe de tendencias laborales para 2025 publicado simultáneamente predice la aparición de “empresas de vanguardia”, construidas en torno a la “inteligencia bajo demanda” y respaldadas por equipos “híbridos humano-máquina”, donde los empleados necesitarán una “mentalidad de jefe de agente inteligente”. El informe anticipa que la IA remodelará profundamente los modelos de trabajo y las estructuras organizativas en los próximos años, enfatizando que los agentes de IA se convertirán en la principal fuerza productiva. (Fuente: 新智元)

Simulación de mosca de la fruta de DeepMind en la portada de Nature: Google DeepMind, en colaboración con el Instituto Janelia de HHMI, ha creado un modelo virtual de mosca de la fruta altamente realista utilizando IA y técnicas de simulación física. El modelo, basado en datos de escaneo de alta resolución, se construyó en el motor de física MuJoCo e incorpora simulaciones de dinámica de fluidos y adhesión de las patas. Mediante aprendizaje profundo por refuerzo y aprendizaje por imitación (utilizando vídeos del comportamiento real de las moscas), una red neuronal de IA logró impulsar a la mosca virtual para simular comportamientos complejos de vuelo y caminata, incluida la navegación visual. Esta investigación no solo revela los complejos mecanismos detrás del movimiento biológico, sino que también proporciona una potente plataforma de investigación para la neurociencia y la robótica. El modelo y el código se han publicado como código abierto, impulsando la investigación en campos relacionados. (Fuente: 新智元)

Nature revela el abuso de la IA en artículos académicos: Un artículo de portada de Nature señala que un gran número de artículos académicos (el rastreador Academ-AI ha registrado más de 700) utilizan IA (como ChatGPT) para su redacción sin declararlo, e incluso contienen rastros obvios como “Soy un modelo de lenguaje de IA”. Más preocupante aún es que se descubrió que algunas editoriales (como Elsevier) eliminaron silenciosamente estos rastros de IA sin publicar correcciones, lo que genera preocupaciones sobre la integridad científica. Los investigadores instan a los autores a revelar explícitamente el uso específico de la IA, y a las editoriales a establecer mecanismos de revisión más estrictos y publicar registros de corrección para mantener la transparencia y credibilidad de la investigación académica. (Fuente: 新智元)

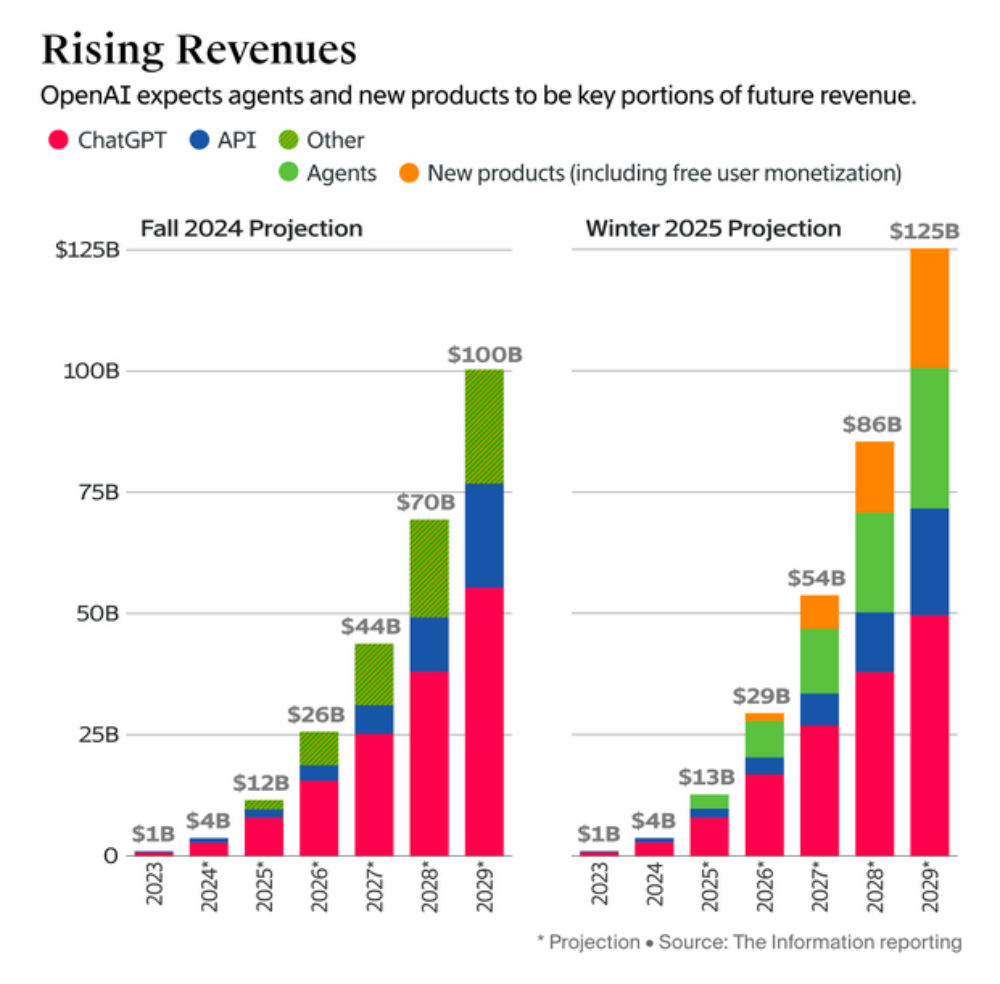

OpenAI predice un rápido crecimiento de ingresos y planea una reestructuración, generando controversia: OpenAI prevé que sus ingresos totales alcancen los 125 mil millones de dólares para 2029, con los ingresos de nuevos negocios como los agentes inteligentes superando a los de ChatGPT. Al mismo tiempo, la compañía planea reestructurarse como una Public Benefit Corporation (PBC), una medida que ha provocado la oposición pública del padrino de la IA Hinton y 10 ex empleados, entre otros. Los opositores argumentan que la reestructuración debilitaría el control de la organización sin fines de lucro, iría en contra del objetivo original de garantizar el desarrollo seguro de AGI y beneficiar a la humanidad, y pondría los intereses comerciales por encima de la misión benéfica. Piden a OpenAI que explique cómo la reestructuración se alinea con su misión y exigen que se mantengan las salvaguardias de gobernanza de la organización sin fines de lucro. (Fuente: 智东西, 腾讯科技, 学术头条)

🎯 Tendencias

Robots humanoides, foco del Salón del Automóvil de Shanghái; fabricantes de automóviles aceleran su despliegue: En el Salón del Automóvil de Shanghái 2025, los robots humanoides se convirtieron en un nuevo punto destacado. Xpeng mostró el robot interactivo IRON y planea producirlo en masa para fábricas en 2026; Chery exhibió su Mornine gen-1 de desarrollo propio, con capacidades de percepción multimodal y respuesta a preguntas; SAIC Roewe, Changan Deepal y otros también presentaron robots de socios o introducidos para atraer tráfico. Fabricantes como Tesla, GAC, BYD (con desarrollo propio e inversiones en Zhiyuan, Pasini) también están acelerando la I+D y aplicación de robots humanoides, optimistas sobre su potencial en fabricación industrial, servicios, etc. Aunque las perspectivas son amplias, la industria aún está en sus primeras etapas, con incertidumbre de mercado y riesgo de burbuja. (Fuente: NBD汽车)

La provincia de Jilin impulsa la industria robótica, promoviendo la fusión de tecnologías automotrices y robóticas: Jilin, una provincia con una larga tradición automotriz, está apostando activamente por la industria robótica. StarNeto, FAW Faway y el Centro de Innovación en Robótica Biónica de Jilin firmaron un acuerdo de cooperación estratégica para desarrollar conjuntamente inteligencia corpórea, modelos grandes, etc. Este centro de innovación, liderado por la Universidad de Jilin, tiene como objetivo construir una cadena industrial robótica completa. Esta medida aprovecha la madura base de la cadena de suministro automotriz de Jilin (alta superposición entre componentes y tecnología robótica) y se alinea con las políticas de fuerte apoyo a la industria de la inteligencia corpórea a nivel nacional y local (Shenzhen, Beijing). La tecnología robótica, especialmente las partes comunes con la conducción autónoma, se considera una nueva oportunidad tras la inteligencia de la industria automotriz. (Fuente: 科创板日报)

El primer largometraje AIGC del mundo, “La Reina Pirata Zheng Yi Sao”, llega a los cines: Esta película de 70 minutos, realizada íntegramente con IA, narra la historia de la legendaria pirata Zheng Yi Sao y se ha estrenado en Singapur. La producción enfrentó numerosos desafíos: la IA tiene dificultades para manejar diálogos largos y movimientos de cámara complejos, y tiende a generar imágenes repetitivas o incoherentes; la consistencia de los personajes es difícil de garantizar, con problemas de “caras repetidas” o “cambios de cara”, que requieren reparación manual en postproducción. La creación del guion, el storyboard y la edición aún requieren liderazgo humano, ya que la IA todavía no puede comprender completamente los detalles históricos y la intención creativa. A pesar de las limitaciones, AIGC reduce significativamente las barreras de entrada y los costos de producción, beneficiando especialmente a los nuevos equipos y demostrando el potencial y la dirección futura de la colaboración humano-máquina en la producción cinematográfica. (Fuente: 深响)

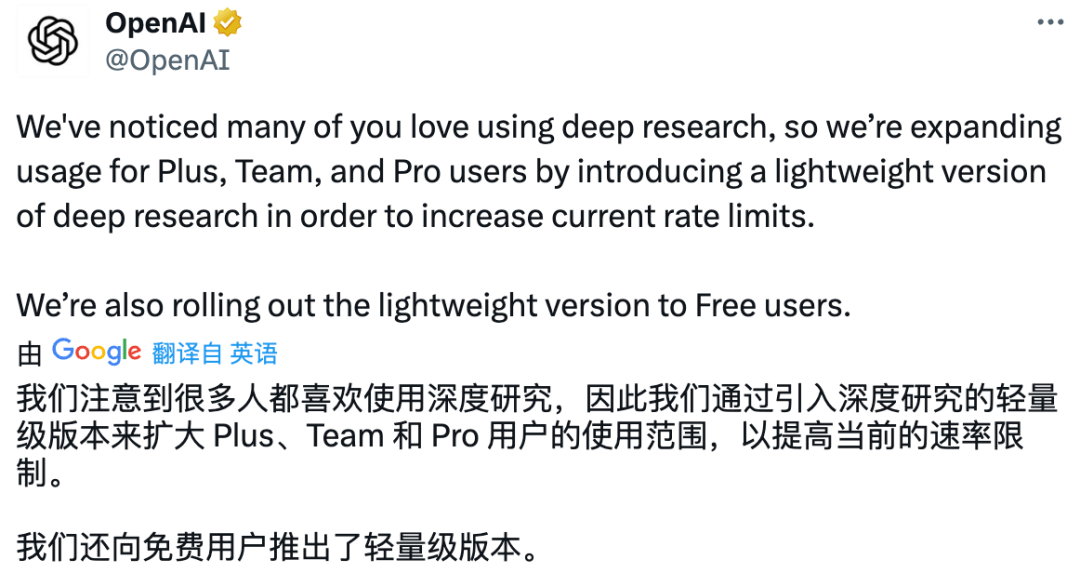

OpenAI lanza versión ligera de Deep Research y la abre a usuarios gratuitos: OpenAI anunció el lanzamiento de una versión ligera de Deep Research impulsada por o4-mini, diseñada para ofrecer un nivel de inteligencia cercano a la versión completa, pero con respuestas más concisas y a menor costo. La función ya está disponible para usuarios Plus, Team, Enterprise, Edu y gratuitos. Los usuarios de pago cambiarán automáticamente a la versión ligera después de agotar su cuota de la versión completa. Las pruebas muestran que la versión ligera es rápida pero carece de la profundidad de información y la citación de fuentes de la versión completa, rindiendo menos en tareas complejas y actuando más como un generador de ideas que como un informe completo. La versión completa puede realizar búsquedas y análisis profundos, generando informes estructurados, aunque todavía tiene margen de mejora. (Fuente: APPSO, 量子位, gdb)

Avance de Google I/O 2025: IA nativa e integración XR: Se espera que Google I/O 2025, que se celebrará el 20 de mayo, se centre en la IA y la colaboración multidispositivo. Android 16 integrará profundamente el modelo grande Gemini, convirtiéndolo en una capacidad nativa del sistema y abriendo más API a los desarrolladores. Visualmente, adoptará el lenguaje de diseño Material 3 Expressive y reforzará la adaptación a tabletas, wearables y dispositivos XR. Se espera el debut del muy esperado sistema operativo Android XR, que también utilizará Gemini como motor de interacción principal, con el objetivo de conectar lo real y lo virtual. También se prevé la aparición de las gafas Google AI y el dispositivo MR Project Moohan en colaboración con Samsung, mostrando la estrategia de Google en asistentes de IA y el ecosistema abierto XR. (Fuente: 雷科技)

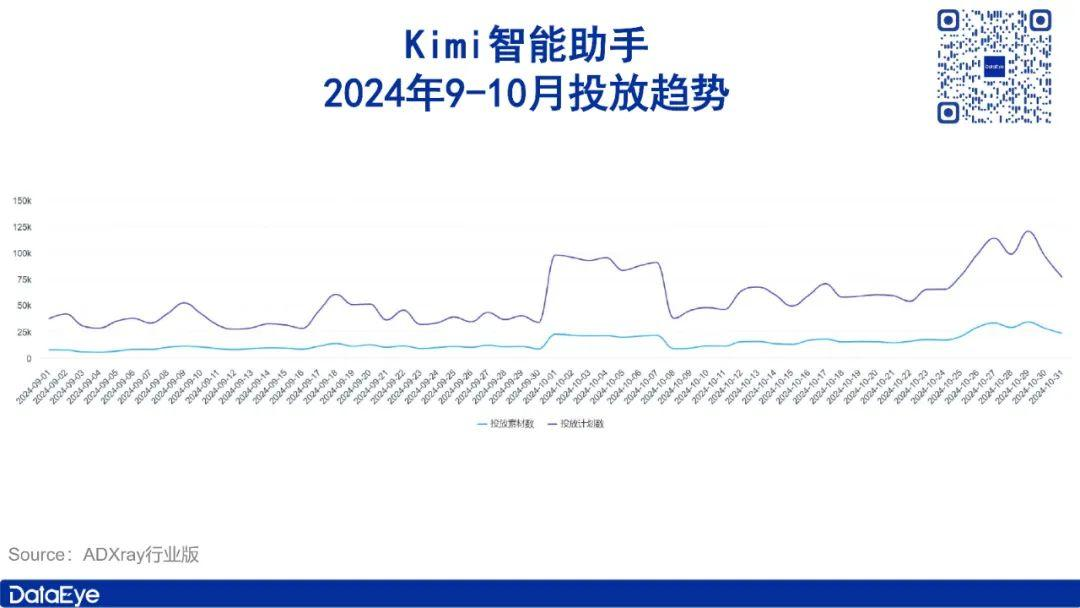

Kimi de YueZhiAnMian prueba función de comunidad de contenido para enfrentar la competencia: Ante el impacto de modelos como DeepSeek, YueZhiAnMian está probando internamente una función de comunidad de contenido para su asistente de IA Kimi. La comunidad se encuentra actualmente en fase de prueba gris (grey test), con contenido generado principalmente por IA y la invitación a canales de nicho para unirse, ofreciendo funciones interactivas como “me gusta” y comentarios. Se considera una innovación a nivel de aplicación por parte de YueZhiAnMian, destinada a construir una ventaja diferencial a través de un ecosistema de contenido para hacer frente a la presión competitiva de DeepSeek a nivel técnico. Anteriormente, Kimi se convirtió en un producto estrella en el mercado de IA para consumidores gracias a su capacidad de procesamiento de texto largo y promoción de mercado, pero luego fue superado en número de usuarios por DeepSeek y Tencent Yuanbao, entre otros. (Fuente: 司库财经)

OpenAI planea lanzar un nuevo modelo de código abierto este verano: Según TechCrunch, OpenAI planea lanzar un nuevo modelo de lenguaje grande de código abierto este verano, bajo una licencia permisiva que permitirá la descarga gratuita y el uso comercial. El modelo tiene como objetivo superar en rendimiento a los modelos de código abierto existentes de Meta (Llama) y DeepSeek, y podría incluir una función de “handoff”, donde el modelo de código abierto puede recurrir al modelo grande en la nube de OpenAI para obtener ayuda con tareas difíciles. Este movimiento se considera un cambio significativo en la estrategia de código abierto de OpenAI, destinado a atraer desarrolladores, mejorar la competitividad y perfeccionar su ecosistema de IA. (Fuente: 智东西)

El protocolo MCP impulsa el ecosistema de AI Agent, pero enfrenta desafíos comerciales: El protocolo MCP (Model Communication Protocol) tiene como objetivo estandarizar la interacción entre los modelos de IA y las herramientas/servicios externos, simplificando la complejidad de la integración (de M×N a M+N), y es aclamado como la “interfaz USB-C” de las aplicaciones de IA. La exitosa demostración de Manus Agent y el apoyo a MCP por parte de gigantes como OpenAI (fabricantes nacionales como Alibaba, Tencent, Baidu también han seguido) han impulsado enormemente su popularización y el desarrollo del ecosistema Agent. Sin embargo, mientras adoptan MCP, muchos fabricantes tienden a construir ecosistemas “de ciclo cerrado” (como la integración de Alibaba Cloud con AutoNavi Maps, Tencent Cloud con WeChat Read) para proteger sus propios datos y ventajas del ecosistema, lo que podría llevar a la fragmentación del ecosistema y limitar que MCP se convierta en un estándar verdaderamente universal. El futuro ecosistema Agent podría presentar un patrón de “apertura limitada”, con MCP actuando como un “conector de ecosistema” en lugar del único estándar. (Fuente: 产业家)

La guerra de precios de los modelos grandes continúa; Li Yanhong de Baidu califica a DeepSeek de “lento y caro”: Baidu lanzó los modelos Wenxin 4.5 Turbo y X1 Turbo, enfatizando su rentabilidad superior a DeepSeek. Li Yanhong señaló que DeepSeek no solo tiene capacidades limitadas (principalmente procesamiento de texto), sino que también tiene altos costos de llamada y baja velocidad. El precio de Wenxin 4.5 Turbo es inferior al período de descuento de DeepSeek V3, y el precio de X1 Turbo es comparable al período de descuento de DeepSeek R1 pero mucho más bajo que su período estándar. Nuevos modelos como Doubao de ByteDance y Gemini Flash de Google también han respondido con estrategias de bajo precio. Sin embargo, el artículo señala que la rentabilidad por sí sola no es suficiente para ganar, y la clave del éxito de DeepSeek radica en la experiencia única que brindan sus innovaciones técnicas como la cadena de pensamiento. Las vías de monetización comercial para los modelos nacionales son relativamente limitadas (cobro por API), mientras que en el extranjero (como OpenAI) existen modelos más diversificados como las suscripciones para consumidores. (Fuente: 直面AI)

Diez años de altibajos en la industria farmacéutica de IA, enfrentando desafíos comerciales y técnicos: La industria farmacéutica de IA, con más de una década de desarrollo, tiene como objetivo mejorar la eficiencia y reducir los costos de la I+D de fármacos mediante IA. La reciente eliminación del requisito de experimentación animal por parte de la FDA favorece métodos alternativos como el modelado por IA. La industria experimentó un auge de capital (pico en 2021), pero entró en un período de ajuste con el fracaso de algunos pipelines en fase clínica (como BenevolentAI) y la retirada de capital. Empresas estrella como XtalPi (AI+CRO), tras su salida a bolsa, se expandieron a áreas como AI+nuevos materiales en busca de retornos comerciales más rápidos; Insilico Medicine, por otro lado, se adhiere al modelo “pipeline propio + License Out”, habiendo alcanzado varios acuerdos de licencia. La industria todavía enfrenta desafíos como la dificultad para obtener datos (las farmacéuticas no comparten datos centrales), largos ciclos de validación de algoritmos y la falta de medicamentos aprobados. Sin embargo, avances tecnológicos como AlphaFold y la IA generativa están trayendo nuevas esperanzas, y la industria espera el “punto de singularidad” del primer fármaco desarrollado por IA que llegue al mercado con éxito. (Fuente: 亿欧网)

Modelo grande en dispositivo de Mianbi impulsa cabina inteligente, logrando producción en masa en diez meses: Mianbi Intelligent lanzó cpmGO, un asistente de cabina inteligente impulsado por su modelo grande en dispositivo MiniCPM, que ya se ha implementado en producción en masa en nuevos vehículos de Changan Mazda, en solo 10 meses. cpmGO funciona de forma puramente local, garantizando la privacidad de los datos, logrando una respuesta a nivel de milisegundos y sin verse afectado por las limitaciones de la red. Posee capacidades de percepción multimodal (visual, voz, UI) e interacción, admite la operación “lo que ves es lo que puedes decir” y cuenta con un GUI Agent puramente en el dispositivo capaz de comprender y ejecutar operaciones en pantalla. Mianbi Intelligent ha colaborado con múltiples fabricantes de chips y Tier1 como Qualcomm, MediaTek, Intel y ThunderSoft para promover la aplicación de IA en el dispositivo en el sector automotriz, con el objetivo de resolver los puntos débiles de costo, latencia y privacidad de las soluciones en la nube, y lograr una experiencia de cabina inteligente más fluida y segura. (Fuente: 量子位)

Instituto de Inteligencia Científica de Shanghái utiliza IA para impulsar el cambio de paradigma en la investigación multidisciplinar: El SAIIP (Shanghai Artificial Intelligence Laboratory for Science), en colaboración con la Universidad de Fudan y otras instituciones, y apoyándose en la plataforma de computación inteligente CFFF (40 PFlop/s), utiliza la IA para impulsar la investigación en ciencias de la vida, meteorología, materiales, medicina, clima, humanidades y ciencias sociales. Los logros incluyen: el modelo grande meteorológico “Fuyao” que permite pronósticos meteorológicos urbanos a nivel de kilómetro y segundo; el modelo grande de ciencias de la vida “Nuwa” que acelera la I+D de fármacos siRNA; el modelo grande de materiales “Suiren” que explora nuevos materiales y descubrimiento de fármacos; el desarrollo del modelo grande especializado en cardiología “Guanxin CardioMind” en colaboración con el Hospital Zhongshan; el modelo grande climático PI@Climate que integra conocimiento multidisciplinar para abordar el cambio climático; el algoritmo VI-CNOPs que optimiza la predicción probabilística de la trayectoria de tifones; el modelo grande de la Civilización China que ayuda en arqueología e investigación de escrituras antiguas; y avances en tecnologías básicas de IA como aprendizaje federado, multimodalidad y aprendizaje de grafos, construyendo conjuntamente un ecosistema de inteligencia científica abierto y colaborativo. (Fuente: 量子位)

🧰 Herramientas

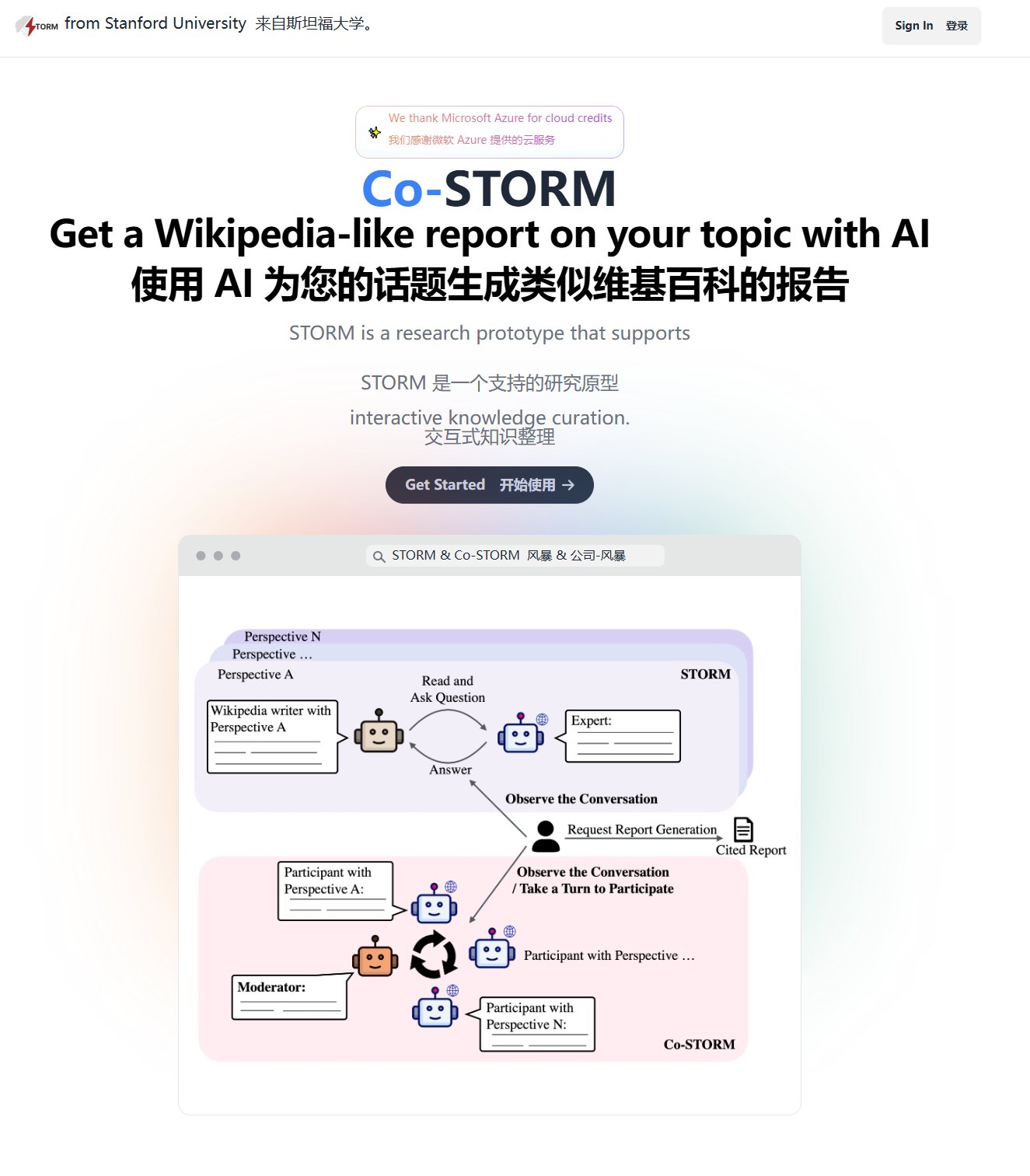

La Universidad de Stanford lanza la herramienta de generación de informes de IA de código abierto Storm: Storm es una herramienta de IA que puede realizar búsquedas web automáticamente, integrar información y generar informes estructurados al estilo de Wikipedia. El usuario introduce un tema y Storm simula el flujo de trabajo de un investigador: planificar el esquema de investigación, buscar fuentes de información relevantes, integrar la información y redactar el informe. Es muy útil para usuarios que necesitan redactar rápidamente informes de antecedentes, revisiones de literatura o análisis profundos. El proyecto está disponible como código abierto en GitHub y ofrece una versión de prueba en línea. (Fuente: karminski3)

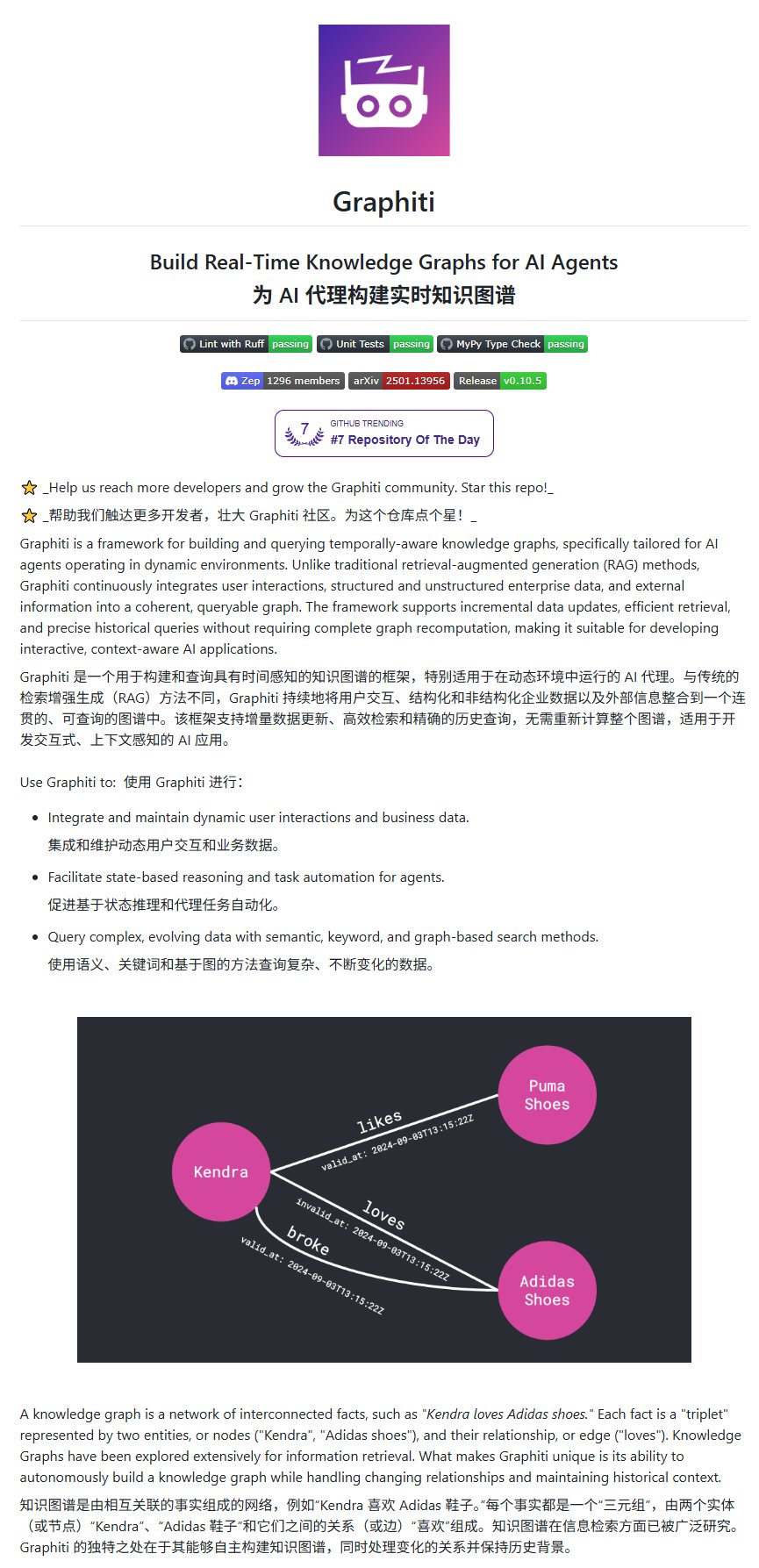

Lanzamiento del framework de grafo de conocimiento de código abierto Graphiti: Graphiti es un framework capaz de integrar continuamente interacciones del usuario, datos estructurados/no estructurados e información externa en un grafo de conocimiento consultable. Se caracteriza por soportar actualizaciones incrementales y recuperación eficiente, sin necesidad de recalcular todo el grafo, lo que lo hace especialmente adecuado para el desarrollo de aplicaciones de IA interactivas que requieren conciencia del contexto y rastreo histórico. El proyecto ha ganado una atención considerable en GitHub (4.4K estrellas). (Fuente: karminski3)

Actualización de Lovable 2.0, mejora la experiencia de construcción de sitios web con IA: La herramienta de construcción de sitios web con IA Lovable lanza la versión 2.0, añadiendo edición colaborativa multiusuario, escaneo de seguridad automático, un agente de chat con inteligencia 10 veces mayor, modo de desarrollo para editar código directamente en la aplicación y soporte para dominios personalizados, entre otras funciones. También actualiza su imagen de marca y diseño de interfaz de usuario, con el objetivo de proporcionar una experiencia de desarrollo de sitios web impulsada por IA más potente, segura y colaborativa. (Fuente: op7418)

El modelo de vídeo “Dreamina” de ByteDance se actualiza, mejorando la consistencia multicámara: La herramienta de generación de vídeo de ByteDance, “Dreamina” (即梦), ha lanzado una actualización del modelo 3.0. Según los casos compartidos por los usuarios, el nuevo modelo demuestra una excelente consistencia de personajes y escenas al generar vídeos multicámara en una sola vez, y este efecto de consistencia se puede reproducir de forma estable. El modelo admite los modos de texto a vídeo e imagen a vídeo, mejorando significativamente la utilidad y la calidad de la creación de vídeos con IA. (Fuente: op7418)

WAN Video entra en fase de comercialización, pero sigue ofreciendo servicio gratuito: La plataforma de generación de vídeo con IA WAN Video anuncia su entrada en la fase de comercialización, pero al mismo tiempo lanza un “Relax mode” gratuito, que ofrece un número ilimitado de generaciones gratuitas. Un caso compartido por un usuario muestra su efecto generando una escena de guerra de soldados de Lego; aunque los requisitos del prompt son altos, el resultado es aceptable. Esto ofrece a los usuarios la oportunidad de experimentar y utilizar gratuitamente las capacidades de generación de vídeo con IA. (Fuente: dotey)

MiniMax TTS se integra con MCP-Server, simplificando el desarrollo de aplicaciones multimodales: MiniMax ofrece sus potentes capacidades de TTS (texto a voz) en chino y clonación de voz, junto con herramientas de texto a imagen/vídeo e imagen a vídeo, a través del MCP-Server (Model Communication Protocol Server) de código abierto. Los usuarios pueden invocar fácilmente estas herramientas en clientes compatibles con MCP como Cursor, permitiendo aplicaciones creativas como la generación de audiolibros con diferentes personajes o la clonación de la voz de Musk para contar historias. El protocolo MCP simplifica la integración de modelos y herramientas de IA, reduciendo las barreras de desarrollo. (Fuente: 袋鼠帝AI客栈)

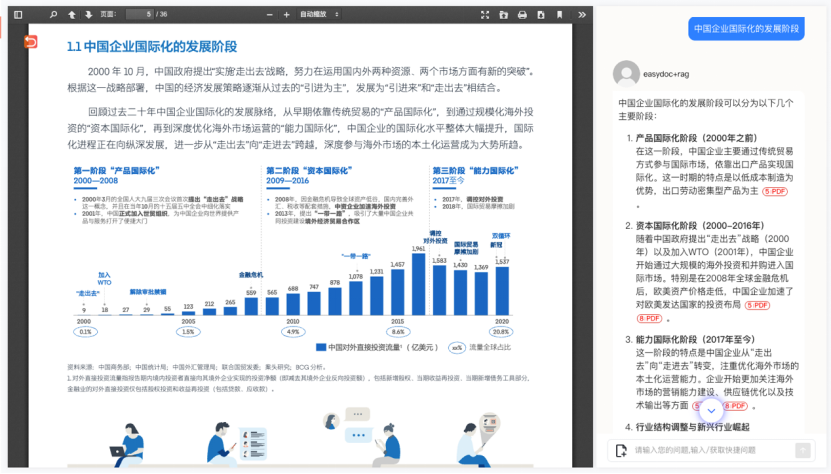

EasyDoc: Motor inteligente de análisis de documentos optimizado para RAG: EasyDoc ofrece un servicio API para analizar documentos como PDF, Word, PPT, etc., y generar resultados en formato JSON adecuados para el procesamiento por LLM. Su ventaja radica en la capacidad de identificar inteligentemente bloques de contenido, analizar la estructura jerárquica del documento (preservando las relaciones padre-hijo) e interpretar en profundidad el contenido de tablas e imágenes (proporcionando datos estructurados y comprensión semántica), resolviendo eficazmente los puntos débiles del preprocesamiento de documentos en aplicaciones RAG, como la mezcla compleja de gráficos y texto o la extracción imprecisa de tablas. Ofrece tres modos (Lite, Pro, Premium) y una cuota de prueba gratuita, y admite despliegue privado. (Fuente: AI进修生)

Dyad: Constructor de aplicaciones de IA localizado y de código abierto: Dyad es una herramienta de construcción de aplicaciones de IA gratuita, de código abierto y ejecutable localmente, posicionada como una alternativa a plataformas como v0, Lovable, Bolt, etc. Permite a los usuarios desarrollar en su computadora local, facilitando la integración con IDEs (como Cursor). La última versión añade integración con Ollama, permitiendo construir utilizando modelos de lenguaje grandes locales. Los usuarios pueden utilizar claves API gratuitas (como Gemini) para el desarrollo. (Fuente: Reddit r/LocalLLaMA)

📚 Aprendizaje

Wuwentianqiong comparte tendencias y prácticas de Infraestructura de IA: Liu Chuanlin, Arquitecto Jefe de Soluciones de Wuwentianqiong, compartió las tendencias y prácticas de la infraestructura de IA en la Conferencia AI Partner. Señaló que, a medida que los datos de preentrenamiento tienden a agotarse, el aprendizaje por refuerzo (como el paradigma DeepSeek R1) se convierte en clave para mejorar el rendimiento del modelo, lo que plantea nuevos desafíos para la infraestructura. Wuwentianqiong, basándose en su capacidad de optimización combinada de software y hardware, ha construido una plataforma de potencia de cálculo que soporta chips nacionales diversos y heterogéneos. Mediante un framework de entrenamiento de desarrollo propio, la optimización de la eficiencia de la comunicación, la asignación dinámica de recursos, etc., se adapta a las necesidades de entrenamiento de modelos LLM y MoE, proporcionando soporte para el entrenamiento de modelos multimodales como los de Shengshu Technology. Al mismo tiempo, para escenarios de inferencia, optimizó el despliegue de DeepSeek R1 y resolvió el problema de la fluctuación del tráfico AIGC mediante un servicio basado en interfaz sobre ComfyUI, reduciendo el costo de las aplicaciones de IA. (Fuente: 36氪)

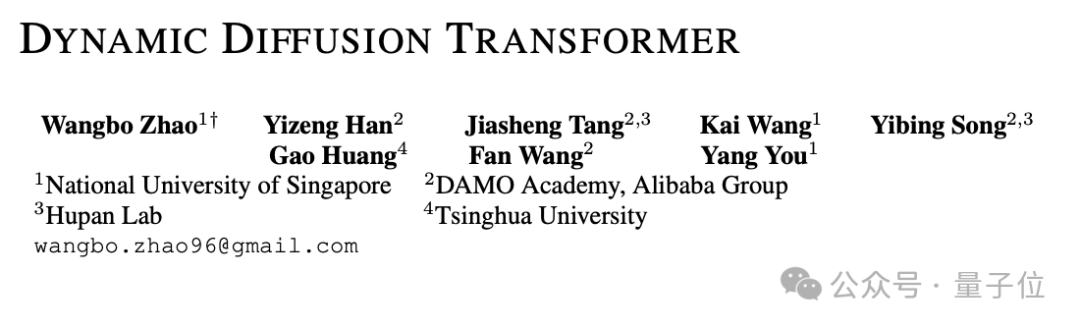

El Instituto DAMO libera la arquitectura DyDiT de código abierto: reduce a la mitad la potencia de cálculo sin pérdida de calidad en la generación visual: El Instituto DAMO y otras instituciones presentaron en ICLR 2025 la arquitectura dinámica DyDiT, destinada a optimizar la eficiencia de inferencia de los modelos DiT (Diffusion Transformer). DyDiT puede ajustar dinámicamente la asignación de recursos computacionales según el paso de tiempo del proceso de generación y la región espacial de la imagen, reduciendo el cálculo en pasos simples o regiones de fondo. Los experimentos muestran que, con un costo mínimo de ajuste fino, DyDiT puede reducir los FLOPs de inferencia del modelo DiT-XL en un 51%, aumentar la velocidad 1.73 veces, y mantener casi sin cambios la calidad de la imagen generada (métrica FID). Este método es de código abierto y se planea adaptarlo a más modelos de texto a imagen/vídeo. (Fuente: 量子位)

UniToken: Esquema de codificación visual unificado que fusiona comprensión y generación: La Universidad de Fudan y Meituan proponen el framework UniToken, con el objetivo de resolver la brecha de representación y la interferencia de entrenamiento entre las tareas de comprensión de imagen y texto y generación de imágenes en modelos grandes multimodales. UniToken, mediante la fusión de codificadores visuales continuos (SigLIP) y discretos (VQ-GAN), proporciona a las tareas posteriores una representación visual unificada que combina semántica de alto nivel y detalles de bajo nivel. Adoptando una estrategia de entrenamiento multietapa (alineación semántica visual, entrenamiento conjunto multitarea, ajuste fino por instrucciones) y combinándola con tecnología de mejora visual de grano fino (AnyRes, ajuste fino de ViT), UniToken ha logrado un rendimiento SOTA o cercano a SOTA en múltiples benchmarks. El código y los modelos son de código abierto. (Fuente: 量子位)

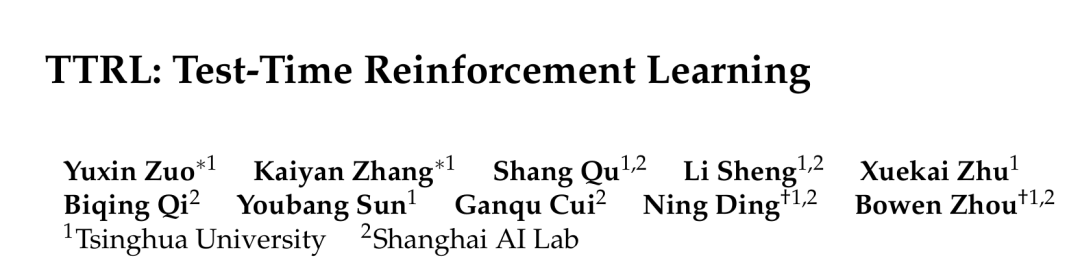

Tsinghua y otros proponen el aprendizaje por refuerzo en tiempo de prueba TTRL: Para abordar la limitada capacidad de generalización de las técnicas existentes de escalado en tiempo de prueba (TTS) frente a nuevas distribuciones de datos, y la falta de señales de recompensa en el entrenamiento en tiempo de prueba (TTT), la Universidad de Tsinghua y Shanghai AI Lab proponen TTRL. Este método puede, en ausencia de datos etiquetados, utilizar el conocimiento previo del propio modelo para generar pseudoetiquetas y señales de recompensa mediante voto mayoritario, etc., y realizar aprendizaje por refuerzo en LLMs. Los experimentos demuestran que TTRL puede mejorar continuamente el rendimiento del modelo en diversas tareas, como aumentar la métrica pass@1 de Qwen-2.5-Math-7B en AIME 2024 en un 159%, acercándose al rendimiento de los modelos entrenados con supervisión. (Fuente: AINLPer)

SJTU y Ant Group proponen el mecanismo de atención híbrida Rodimus: Para resolver el problema de la alta complejidad espacio-temporal causada por la caché KV en la inferencia de Transformers, la Universidad Jiao Tong de Shanghái y Ant Group proponen la serie de modelos Rodimus. Esta arquitectura mejora la actualización de estado de la atención lineal mediante un mecanismo de selección termo-controlado basado en datos (DDTS) y lo combina con la atención de clave compartida con ventana deslizante (SW-SKA), fusionando eficazmente la compresión semántica, de tokens y de cabezas. Rodimus* puede lograr una complejidad espacial O(1) durante la inferencia. Los modelos de código ligeros Rodimus+-Coder (1.6B y 4B) entrenados con esta arquitectura alcanzan el rendimiento SOTA en su escala. El artículo ha sido aceptado en ICLR 2025 y el código es de código abierto. (Fuente: AINLPer)

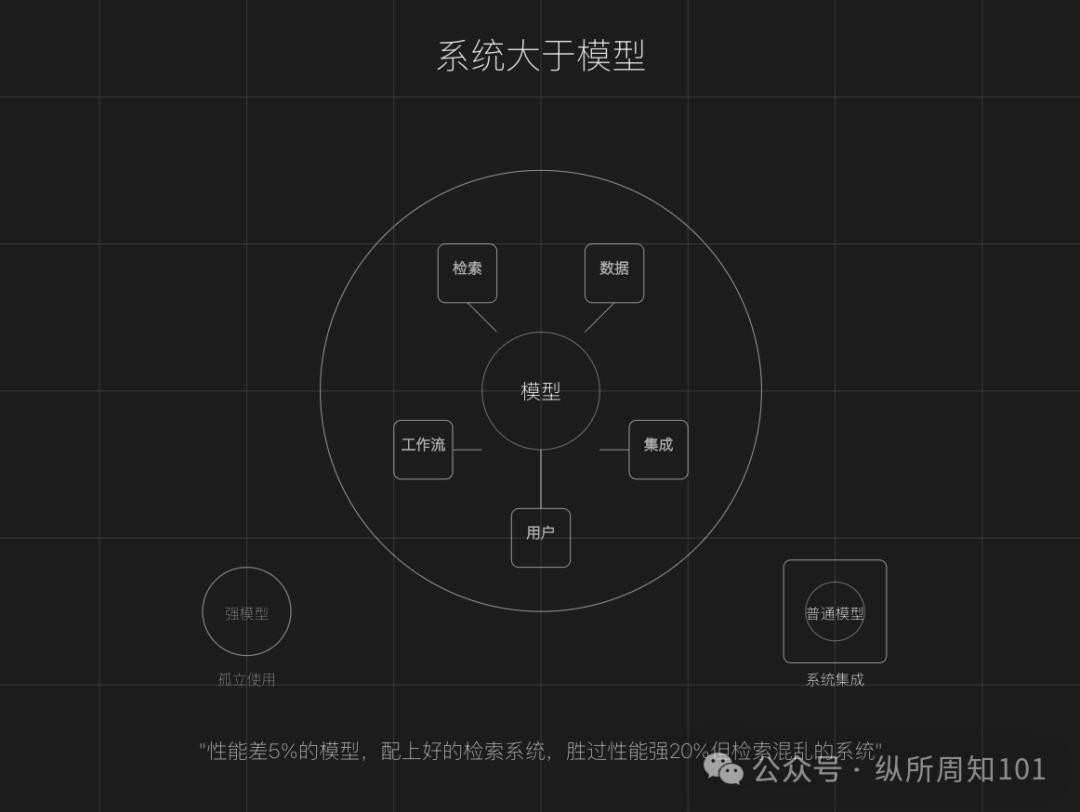

Diez lecciones aprendidas del despliegue de RAG Agent: Douwe Kiela, fundador de Contextual AI, comparte su experiencia en el despliegue de RAG Agent: 1. La capacidad del sistema es prioritaria sobre el rendimiento del modelo; 2. El conocimiento experto interno es el combustible de valor central; 3. La capacidad de manejar datos a gran escala y ruidosos es el foso competitivo; 4. La implementación en producción es mucho más difícil que el piloto; 5. La velocidad es mejor que la perfección, iterar rápidamente; 6. El tiempo de los ingenieros es valioso, evitar la trampa de la optimización de bajo nivel; 7. Reducir la barrera de uso, integrar en sistemas existentes; 8. Crear “momentos wow” para aumentar la adherencia del usuario; 9. La observabilidad (atribución, auditoría) es más importante que la precisión; 10. Apuntar alto, atreverse a desafiar el negocio principal. (Fuente: AI觉醒)

💼 Negocios

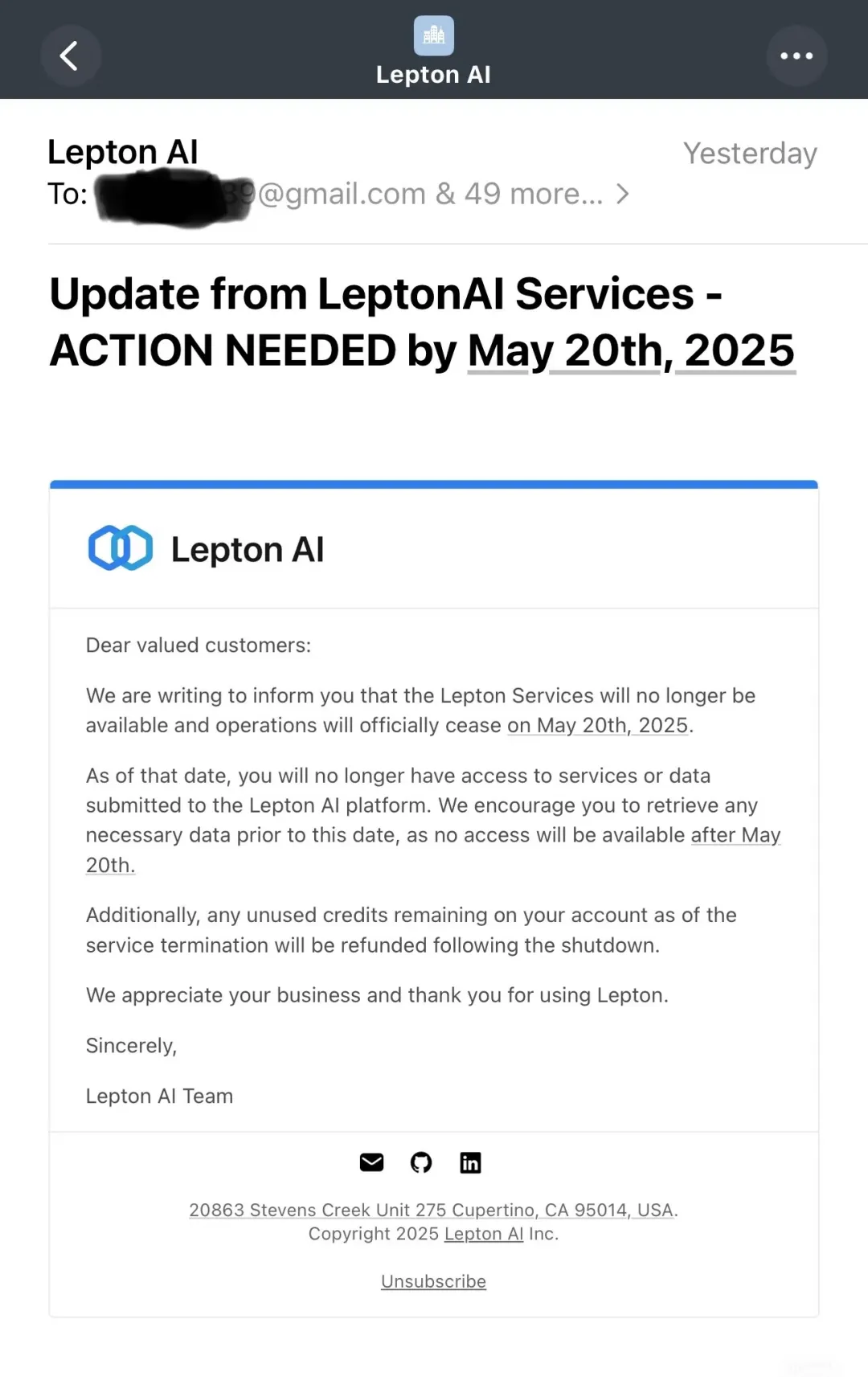

Nvidia detiene las operaciones de Lepton AI tras su adquisición: Nvidia, después de adquirir Lepton AI, la empresa de plataforma de IA en la nube fundada por Jia Yangqing y Bai Junjie, anunció que detendrá las operaciones de la plataforma Lepton AI el 20 de mayo de 2025 y ya ha detenido el registro de nuevos usuarios. Jia Yangqing respondió que la transacción “no fue una adquisición de talento”, pero no reveló más detalles. Lepton AI se especializaba en proporcionar servicios en la nube para el desarrollo, entrenamiento y despliegue de modelos de IA, así como alquiler de potencia de cálculo, compitiendo con algunos clientes de Nvidia (como CoreWeave). Esta adquisición y las acciones posteriores podrían reflejar el intento de Nvidia de fortalecer la integración vertical de la cadena de suministro de IA (desde chips hasta servicios), aumentando su dominio en el campo de la computación de IA. (Fuente: AI前线)

Mesa redonda de inversores en la Conferencia AI Partner: Buscando la certeza en las superaplicaciones de IA: En la Conferencia AI Partner de 36Kr, inversores como Wu Nan de GSR United Capital, Zou Zejiong de Shanghai Industrial Investment, y Ren Bobing de Sinovation Ventures discutieron la lógica de inversión en superaplicaciones de IA. Los inversores creen que, a pesar de la incertidumbre en la tecnología subyacente y el panorama del mercado, existen oportunidades ciertas en aplicaciones verticales que pueden resolver problemas reales, encontrar el PMF y generar ingresos, como IA+salud, IA+educación, conducción autónoma, etc. Las startups que compiten con grandes empresas deben profundizar en nichos verticales, utilizando escenarios específicos y know-how profundo que las grandes empresas no pueden cubrir fácilmente para construir barreras. Al mismo tiempo, los emprendedores necesitan capacidades interdisciplinarias y de toma de decisiones eficientes, prestando atención a la construcción de equipos y la validación del modelo de negocio. El éxito de DeepSeek inspira a los inversores a centrarse en equipos impulsados por la tecnología, perseverantes y capaces de explotar el potencial del talento. (Fuente: 36氪)

Tablón de anuncios de capital: Información sobre transacciones de activos en los campos de IA y robótica: El tablón de anuncios de capital de 36Kr publicó su número 160, que incluye múltiples informaciones de compraventa de activos relacionados con IA y robótica. La información de transferencia incluye participaciones LP en fondos que poseen acciones de Zhiyuan Robotics, YunShen Technology, Wofei Changkong (relacionado con eVTOL). La información de compra incluye acciones de empresas como ByteDance, Galaxy General, Unitree Robotics, YunShen Technology, Zhiyuan Robotics, Moore Threads, Star Era, etc. Además, existe una demanda general de compra en el campo de la robótica humanoide. Estas pistas de transacciones reflejan el gran interés actual del mercado de capitales en empresas líderes en los campos de IA, robótica humanoide, conducción autónoma, semiconductores y otras tecnologías duras. (Fuente: 36氪)

La empresa china de Agent Manus AI recauda más de 500 millones de RMB, quintuplicando su valoración: Según Bloomberg, Butterfly Effect, la empresa matriz del producto de Agente de IA general Manus, completó una nueva ronda de financiación de 75 millones de dólares (aproximadamente 550 millones de RMB), liderada por la firma de capital riesgo de Silicon Valley Benchmark, con una valoración post-money cercana a los 500 millones de dólares. Manus Agent puede ejecutar de forma autónoma tareas web como reservar billetes o analizar acciones, y anteriormente llamó la atención por sus costosos códigos de prueba interna. La nueva financiación se utilizará para expandir los servicios a mercados como EE. UU., Japón y Oriente Medio, y planea establecer una oficina en Japón. Aunque el producto es popular, su dependencia del modelo Claude de Anthropic genera altos costos (un promedio de 2 dólares por tarea) y enfrenta limitaciones de capacidad del servidor. (Fuente: 智东西, 硅兔君)

Tuya Smart se transforma en plataforma AI Agent, compitiendo en el mercado de hardware de IA: La plataforma en la nube AIoT Tuya Smart lanzó el framework de código abierto TuyaOpen, la plataforma de computación en el borde Hedwig, Tuya.AI y una versión mejorada de la plataforma de desarrollo AI Agent, abrazando completamente la IA. La compañía cree que los modelos grandes de IA (especialmente la interacción multimodal, la eficiencia a nivel experto y la capacidad de toma de decisiones distribuida) pueden reducir en gran medida la barrera de uso del hardware inteligente, impulsando la popularización de la industria. La plataforma Tuya AI Agent ya se ha integrado con los principales modelos grandes globales, ayudando a los clientes a desarrollar productos populares como anillos inteligentes y muñecos con IA, y colaborando con empresas como Kidswant para promover el hardware inteligente personal con IA. La compañía espera que 2025 sea un año de auge para el nuevo hardware de IA, y que su estrategia AI Agent entre en período de cosecha en 2-3 años. (Fuente: 36氪)

🌟 Comunidad

Caos en los cursos de formación de IA: publicidad engañosa y efectividad dudosa: Las redes sociales están inundadas de anuncios de cursos de formación “enriquecimiento rápido con IA”, que afirman que la gente común puede monetizar rápidamente aprendiendo pintura con IA, ajuste fino de modelos, etc. Sin embargo, la experiencia real y los comentarios de los consumidores revelan numerosos problemas: cualificaciones de los instructores vagas o incluso falsificadas (como la identidad falsa del fundador de Coverhero); contenido del curso que no coincide con las promesas publicitarias, lo que dificulta alcanzar el efecto de “conseguir encargos y monetizar”; uso de marketing de escasez y casos falsos para inducir al consumo; dificultad para obtener reembolsos. Expertos de la industria señalan que el contenido de dichos cursos suele ser demasiado teórico o superficial, y es difícil para la gente común adquirir habilidades de IA suficientes para cambiar de carrera o generar ingresos estables a través de formación a corto plazo. Se recomienda a los usuarios utilizar recursos gratuitos y comunidades para aprender, y desconfiar de las trampas de cursos rápidos y caros. (Fuente: 新周刊)

Desarrollador compara la experiencia de programación con Claude vs Gemini 2.5 + Cursor: Un desarrollador comparte su experiencia usando Claude y Gemini 2.5 Pro + Cursor para desarrollar un juego de palabras. Usar la API de Claude costó 417 dólares y la experiencia fue pobre: la ventana de contexto se perdía fácilmente, haciendo que el modelo “olvidara” frecuentemente; la corrección de errores a menudo introducía nuevos problemas; no podía verificar la corrección del código. En comparación, usar el gratuito Gemini 2.5 Pro (integrado a través de Cursor) mejoró enormemente la experiencia: costo cero; mejor capacidad de comprensión del contexto (gracias a la transmisión de la estructura de archivos de Cursor); el flujo de interacción se parecía más a la programación en pareja; el proceso de depuración fue más racional. La conclusión es que la combinación de Gemini 2.5 + Cursor proporcionó una experiencia de programación asistida por IA más práctica y eficiente. (Fuente: CSDN)

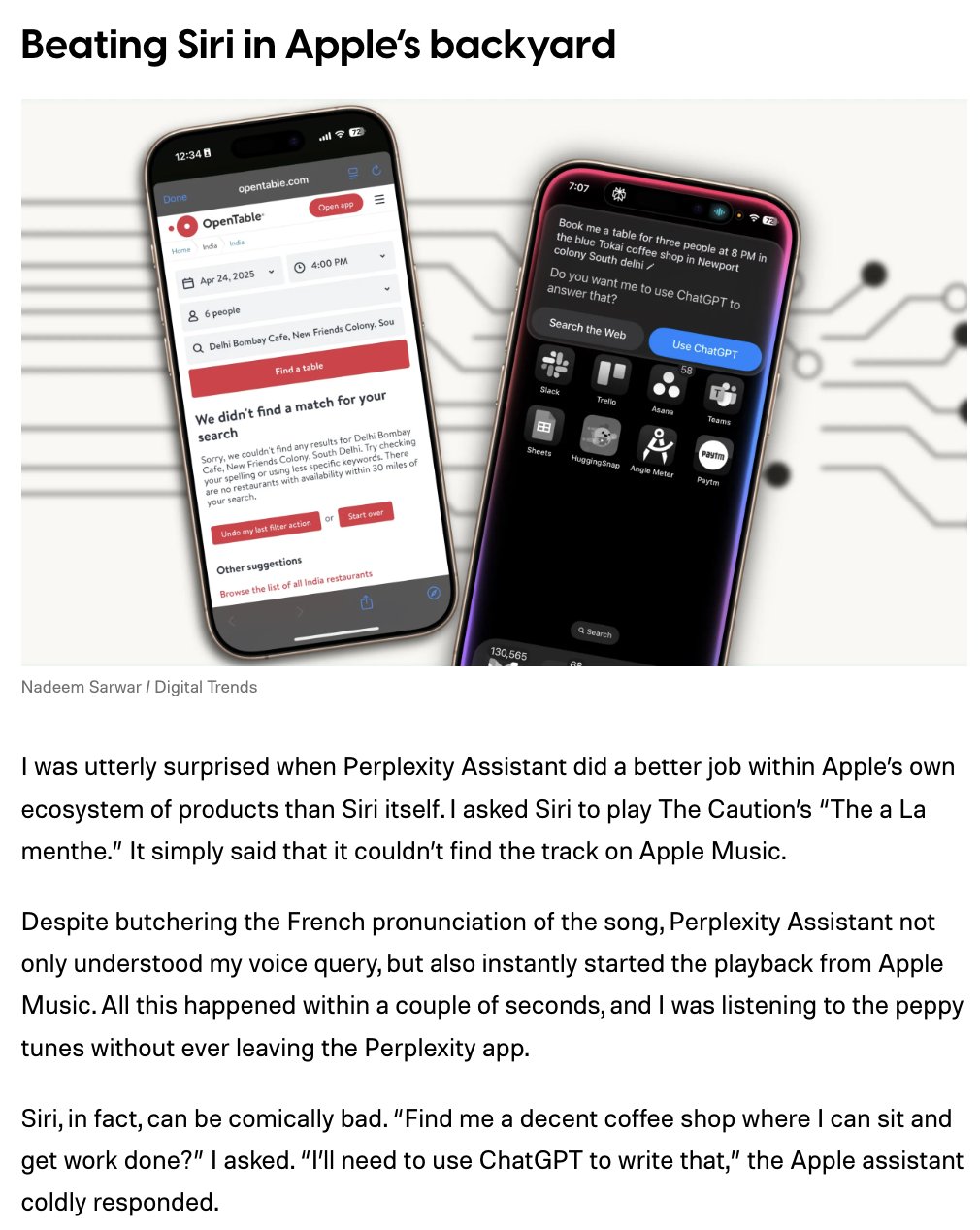

El asistente iOS de Perplexity recibe buenas críticas iniciales: El CEO de Perplexity retuiteó comentarios de usuarios que muestran que su asistente de IA para iOS está funcionando bien en las primeras evaluaciones. Los comentarios señalan que el rendimiento del asistente dentro del ecosistema de Apple es incluso superior al de Siri, por ejemplo, siendo más preciso en tareas como reproducir vídeos específicos de YouTube según comandos de voz. Esto indica que el asistente de Perplexity tiene cierta ventaja en la comprensión de la intención del lenguaje natural y la ejecución de operaciones entre aplicaciones. (Fuente: AravSrinivas)

Debate en Reddit: Discernir entre fotos generadas por IA y reales: Un usuario de Reddit inició una discusión mostrando 5 fotos similares de mujeres, una de las cuales era real y las demás generadas por IA, pidiendo a la gente que las distinguiera. La sección de comentarios fue animada, con usuarios analizando desde ángulos como luces y sombras, textura de la piel, detalles de accesorios (como la cadena de un collar), pero las opiniones estaban divididas. Esto refleja el alto nivel actual de la tecnología de generación de imágenes por IA y la dificultad de distinguir lo real de lo falso. (Fuente: Reddit r/ChatGPT)

Debate en Reddit: ChatGPT genera imágenes extrañas: Varios usuarios compartieron en Reddit que al pedir a ChatGPT que generara imágenes específicas (como “mapa de EE. UU.”), obtuvieron inesperadamente imágenes de explosiones nucleares (nubes de hongo) u otras imágenes no relacionadas (como R2D2). Esto generó una discusión sobre la estabilidad del modelo y posibles sesgos, sin que quede claro si se trata de errores aleatorios del modelo o si prompts específicos desencadenaron la anomalía. (Fuente: Reddit r/ChatGPT)

Discusión en Reddit: ¿La IA volverá adictos a los ingenieros de software?: Un ingeniero de software publicó en Reddit diciendo que las herramientas de IA (como los asistentes de programación) han mejorado enormemente la eficiencia y calidad de su trabajo, y que después de usarlas le resulta difícil parar, sintiéndose algo “adicto”. La sección de comentarios debatió esto; algunos creen que es más una dependencia de herramientas eficientes, similar a depender de un compilador en lugar de ensamblador, un resultado natural del aumento de la productividad. Otros coinciden en que puede haber un riesgo de “adicción” y les preocupa que la dependencia excesiva pueda llevar a la degradación de habilidades, sugiriendo realizar conscientemente una “desintoxicación de IA” o mantener la práctica de habilidades básicas. (Fuente: Reddit r/ArtificialInteligence)

Discusión en Reddit: Religión de IA y fenómeno de culto: Los usuarios discuten si la IA podría convertirse en objeto de religión o culto. Los argumentos incluyen: ya existe un “AI Jesus”; la discusión sobre la conciencia de la IA podría llevar a la fe; corrientes de pensamiento como el Longtermism tienen matices cuasi-religiosos; los LLM pueden ofrecer consuelo espiritual y guía personalizados. Los comentarios mencionan casos reales (como el protocolo Nova de jrprudence.com) y discuten el potencial y los riesgos de la IA para satisfacer las necesidades espirituales humanas, así como las preocupaciones sobre las “sectas de IA”. (Fuente: Reddit r/ArtificialInteligence)

Discusión en Reddit: La IA generativa no puede “restaurar” fotos antiguas: Un usuario demostró mediante experimentos que al usar herramientas de IA como ChatGPT para procesar fotos antiguas, la IA no las restaura ni aumenta la resolución realmente, sino que genera una imagen completamente nueva y similar basada en la original. Al probar con fotos de celebridades (como Samuel L Jackson), el resultado generado era claramente otra persona, solo similar en estilo y pose. Esto recuerda a los usuarios que deben comprender correctamente los límites de la capacidad de procesamiento de imágenes de la IA; es mejor “creando” que “restaurando”. (Fuente: Reddit r/ChatGPT)

💡 Otros

Colección de citas destacadas de la Conferencia AI Partner: 36Kr recopiló y publicó un resumen de las opiniones destacadas de los ponentes en la Conferencia AI Partner 2025. Estas opiniones giran en torno a la evolución futura de las superaplicaciones de IA, la transformación de la industria y la reconstrucción de la lógica empresarial, reflejando el pensamiento actual de expertos y pioneros de la industria en el campo de la IA. (Fuente: 36氪)

Emiratos Árabes Unidos se convierte en la primera nación en usar IA para redactar leyes: Según The Hill, los Emiratos Árabes Unidos han comenzado a utilizar inteligencia artificial para ayudar a redactar textos legales. Esta medida marca la aplicación inicial de la IA en el ámbito legislativo, posiblemente con el objetivo de mejorar la eficiencia legislativa o analizar regulaciones complejas. La noticia ha generado debate sobre el papel de la IA en la gobernanza, por ejemplo, si puede reducir la dependencia de los roles políticos tradicionales. (Fuente: Reddit r/ArtificialInteligence)

Anthropic inicia un proyecto de investigación sobre el “bienestar de los modelos de IA”: La empresa Anthropic anunció el lanzamiento de una nueva iniciativa destinada a investigar el “bienestar” (model welfare) de los modelos de IA. Aunque este campo es controvertido (algunos expertos creen que los modelos no tienen sentimientos subjetivos ni valores), esta medida de Anthropic podría tener como objetivo explorar formas más responsables y éticas de desarrollar e interactuar con los modelos, o investigar cómo evaluar y mitigar posibles estados o comportamientos “indeseables” que los modelos puedan desarrollar durante el entrenamiento o la interacción. (Fuente: Reddit r/ClaudeAI)

La necesidad de grandes cantidades de agua para la IA genera preocupación: Informes del gobierno de EE. UU. y medios (404media) señalan que entrenar y operar grandes modelos de IA consume cantidades masivas de agua, principalmente para la refrigeración de centros de datos. Esto ha generado preocupación sobre los costos ambientales del desarrollo de la IA, especialmente en regiones con escasez de agua. (Fuente: Reddit r/artificial)