Palabras clave:robots humanoides, supercomputadoras de IA, modelos de OpenAI, modelos Gemini, media maratón de robots humanoides, chip Blackwell de NVIDIA, tasa de alucinación o3 de OpenAI, simulación física de Gemini 2.5 Pro, curso de agentes de navegador con IA, impacto científico de la computación cuántica, control de brazo robótico con interfaz cerebro-máquina, comportamiento de NPC en juegos con GNN

«`es

🔥 Enfoque

Se celebra la primera media maratón mundial de robots humanoides: En la primera media maratón mundial de robots humanoides celebrada en Yizhuang, Beijing, 天工 1.2max fue el primero en cruzar la línea de meta con un tiempo de 2 horas, 40 minutos y 24 segundos. El evento tuvo como objetivo verificar la utilidad práctica de los robots en diferentes escenarios, reuniendo a robots humanoides de China con diversos métodos de accionamiento y escuelas de algoritmos. La competición no solo puso a prueba la capacidad de caminar, la autonomía (requiriendo carga o cambio de batería a mitad de camino, con penalizaciones de tiempo), la disipación de calor y la estabilidad de los robots, sino también la colaboración humano-robot. A pesar de incidentes como el “pánico escénico” del 宇树机器人 y la caída del 天工机器人, el evento se considera un hito importante en el desarrollo de robots humanoides, proporcionando una plataforma para pruebas de rendimiento y validación tecnológica en entornos reales, e impulsando avances en la optimización estructural, los algoritmos de control de movimiento y la capacidad de adaptación al entorno (fuente: APPSO via 36氪)

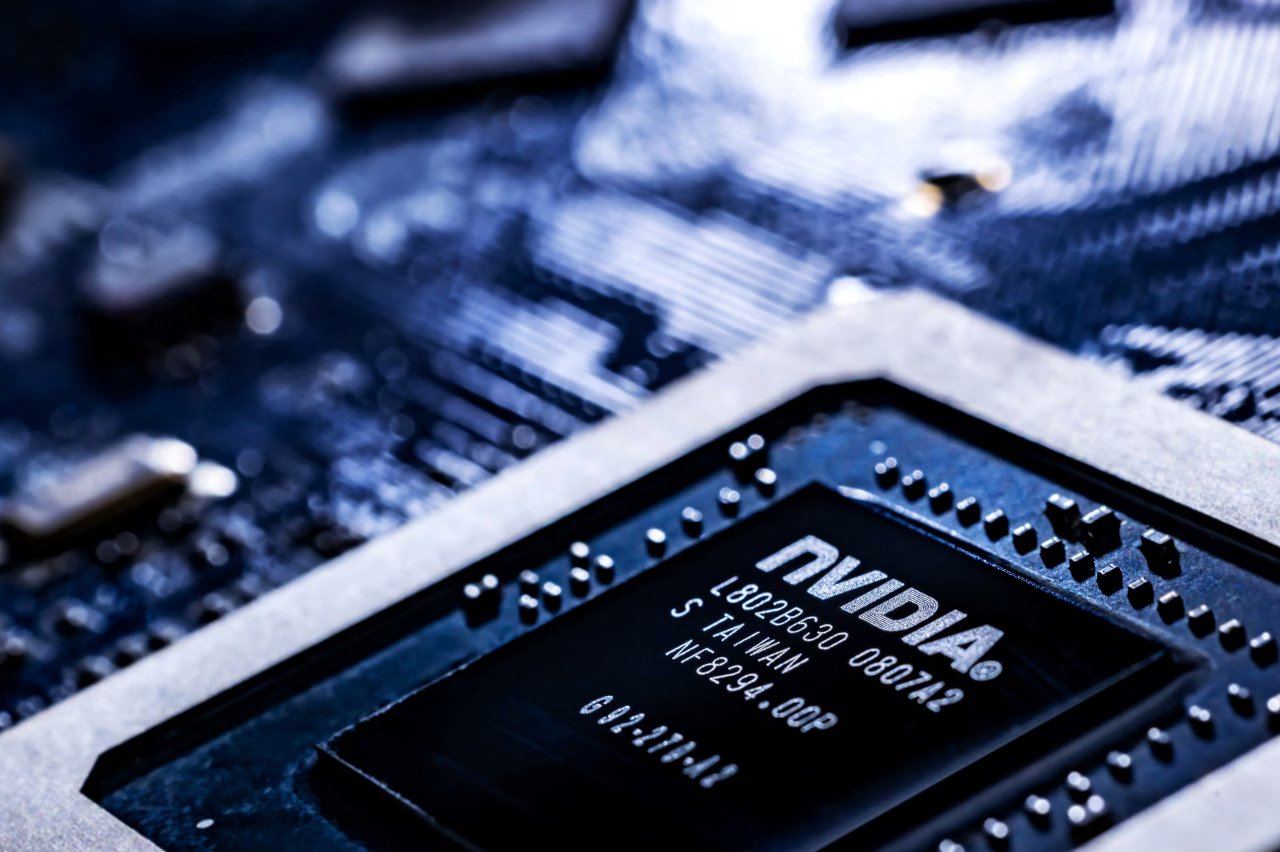

NVIDIA anuncia que sus supercomputadoras de IA se fabricarán en Estados Unidos: NVIDIA planea, por primera vez, producir completamente en Estados Unidos sus supercomputadoras utilizadas para procesar tareas de IA. La compañía ha reservado más de un millón de pies cuadrados de espacio en Arizona para fabricar y probar los chips Blackwell, y colaborará con Foxconn (Houston) y Wistron (Dallas) para construir fábricas en Texas para producir supercomputadoras de IA, esperando una producción en masa gradual en los próximos 12-15 meses. Esta medida forma parte del plan de NVIDIA de producir infraestructura de IA por valor de 500 mil millones de dólares en EE. UU. durante los próximos cuatro años, y se alinea con la estrategia del gobierno estadounidense para aumentar la autosuficiencia en semiconductores y responder a posibles aranceles y tensiones geopolíticas (fuente: dotey)

Nuevos modelos de inferencia de OpenAI, o3 y o4-mini, señalados por mayor tasa de alucinación: Según TechCrunch y discusiones relacionadas, los modelos de inferencia más recientes de OpenAI, o3 y o4-mini, han mostrado en pruebas una tasa de alucinación más alta que sus predecesores (como o1, o3-mini). El informe señala que o3 alucinó en el 33% de las respuestas a preguntas, significativamente más alto que el 16% de o1 y el 14.8% de o3-mini. Este hallazgo ha generado preocupaciones sobre la fiabilidad de estos modelos avanzados, a pesar de sus mejoras en la capacidad de razonamiento. OpenAI ha reconocido la necesidad de investigar más a fondo para comprender las causas del aumento de la tasa de alucinación (fuente: Reddit r/artificial, Reddit r/artificial)

🎯 Movimientos

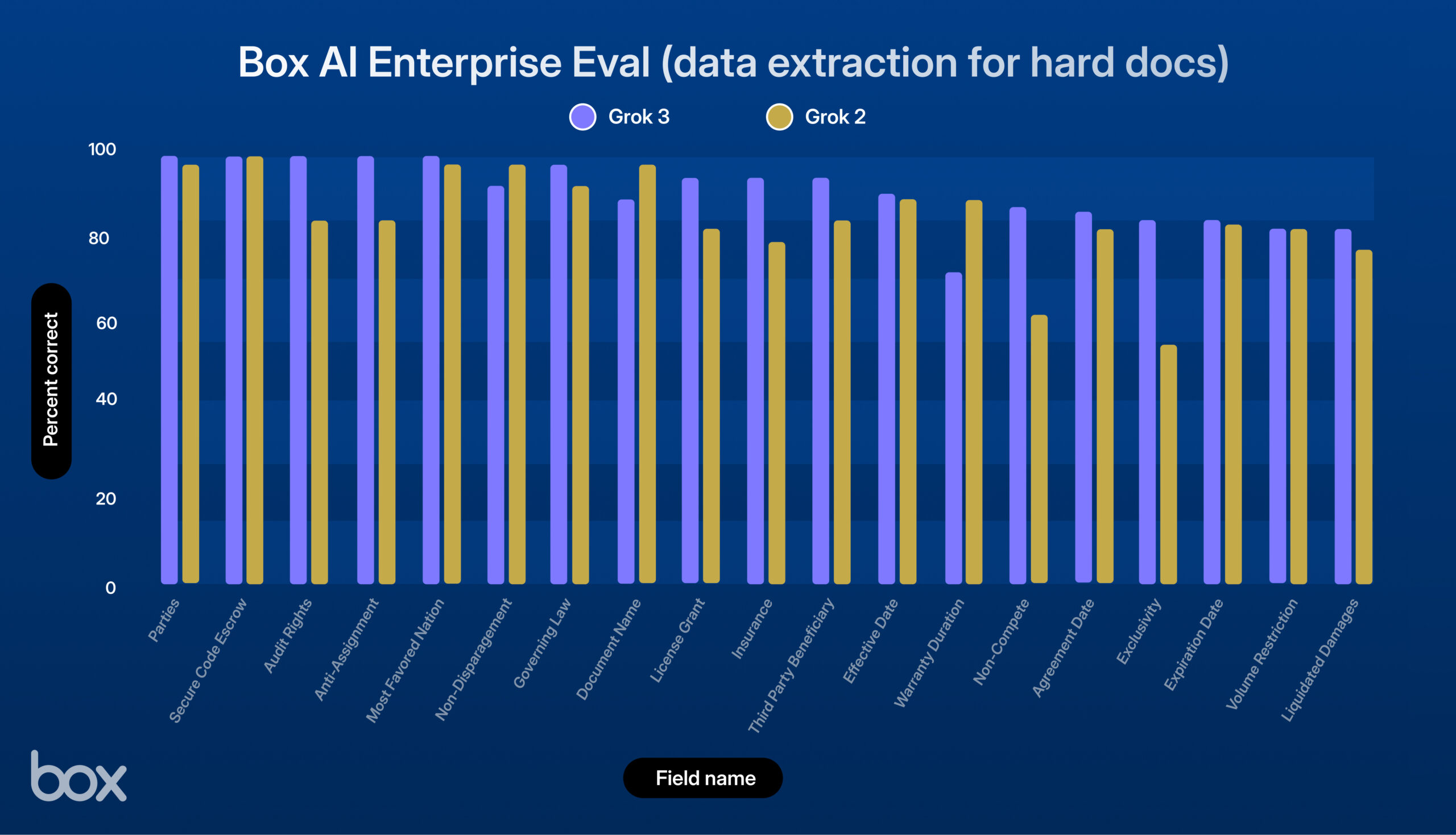

xAI lanza Grok 3, con excelente rendimiento en pruebas de Box: xAI ha lanzado su nuevo modelo Grok 3. La plataforma de terceros Box lo probó en sus flujos de trabajo de gestión de contenido y descubrió que Grok 3 destaca en preguntas y respuestas sobre documentos únicos y múltiples, y en extracción de datos (una mejora del 9% sobre Grok 2). El modelo demostró un sólido rendimiento en tareas como el manejo de contratos legales complejos, razonamiento de múltiples pasos, recuperación precisa de información y análisis cuantitativo, manejando con éxito casos de uso complejos como la extracción de datos económicos de tablas, el análisis de marcos de RRHH y la evaluación de documentos de la SEC. Box considera que Grok 3 tiene un gran potencial, aunque todavía hay margen de mejora en la precisión lingüística y el manejo de lógica muy compleja (fuente: xai)

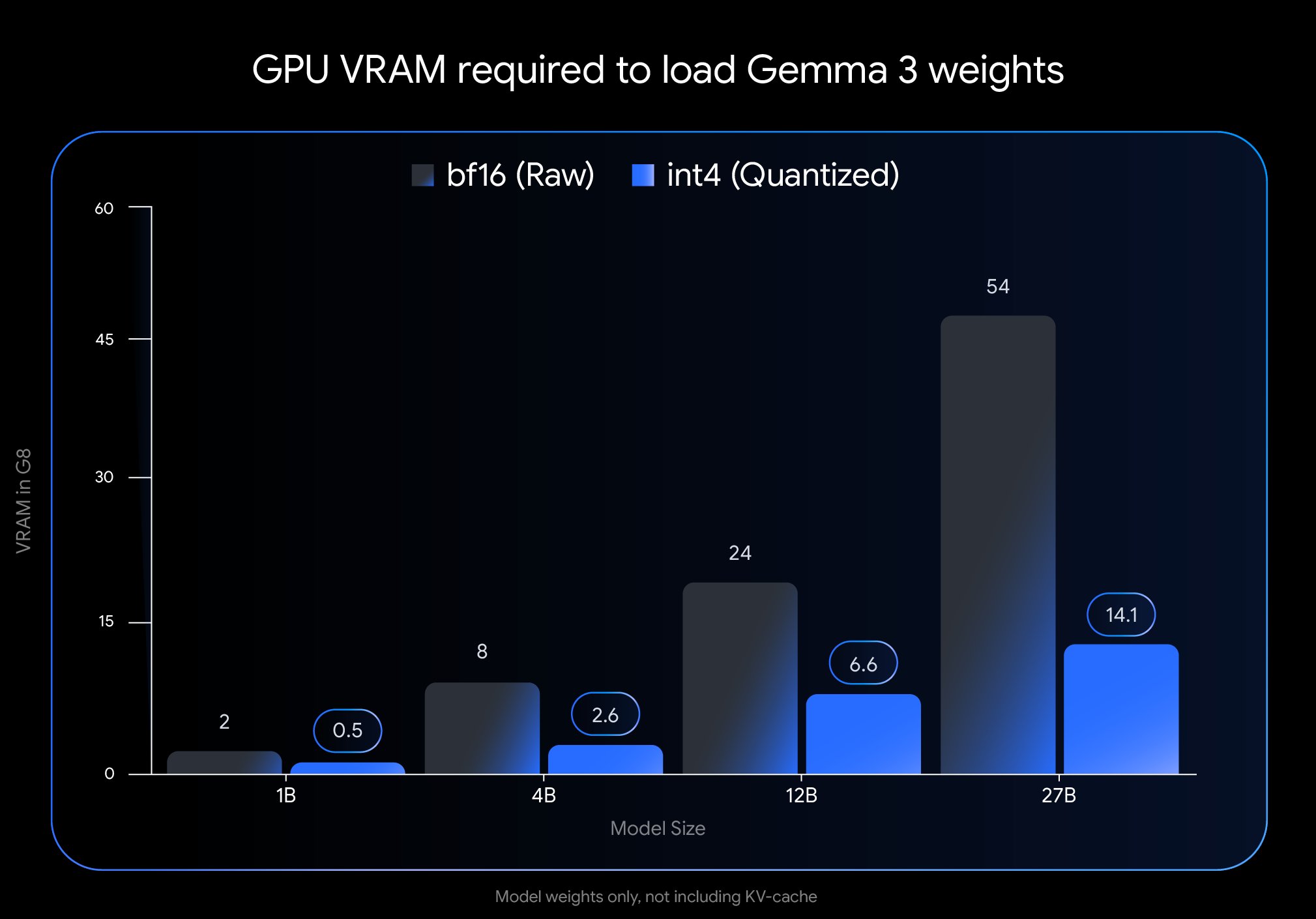

Google lanza nueva versión cuantificada del modelo Gemma 3: Google ha introducido una nueva versión del modelo Gemma 3 utilizando la tecnología Quantization-Aware Training (QAT). Esta técnica reduce significativamente la huella de memoria del modelo, permitiendo que modelos que originalmente requerían una GPU H100 ahora se ejecuten eficientemente en una sola GPU de escritorio, manteniendo al mismo tiempo una alta calidad de salida. Esta optimización reduce considerablemente los requisitos de hardware para la potente serie de modelos Gemma 3, facilitando su despliegue y uso por parte de investigadores y desarrolladores en hardware estándar (fuente: JeffDean)

Google Cloud añade función de generación de música por IA para usuarios empresariales: Google ha añadido modos de generación de música impulsados por IA a su plataforma de nube empresarial. Esta nueva función permite a los clientes empresariales utilizar tecnología de IA generativa para crear música, expandiendo los servicios de IA de Google Cloud desde texto e imágenes al dominio del audio. Esto podría proporcionar nuevas herramientas para escenarios comerciales como marketing, creación de contenido y construcción de marca, aunque los detalles específicos de las aplicaciones y los modelos utilizados no se detallan en el resumen (fuente: Ronald_vanLoon)

NVIDIA demuestra tecnología de generación de escenas 3D a partir de un solo prompt: Nvidia ha presentado una nueva tecnología capaz de generar automáticamente escenas 3D completas a partir de un único prompt de texto introducido por el usuario. Este avance en IA generativa tiene como objetivo simplificar el proceso de creación de contenido 3D, permitiendo a los usuarios construir el entorno 3D correspondiente simplemente describiendo la escena deseada. Se espera que esta tecnología tenga un impacto importante en campos como el desarrollo de videojuegos, la realidad virtual, el diseño arquitectónico y la visualización de productos, reduciendo la barrera de entrada a la producción 3D (fuente: Ronald_vanLoon)

El modelo Gemma 3 27B QAT muestra buen rendimiento con cuantificación Q2_K: Pruebas de usuarios indican que el modelo Google Gemma 3 27B IT, entrenado con Quantization-Aware Training (QAT), sigue mostrando un rendimiento sorprendentemente bueno en tareas en japonés después de ser cuantificado al nivel Q2_K (aproximadamente 10.5GB). A pesar del bajo nivel de cuantificación, el modelo se mantuvo estable en seguir instrucciones, mantener formatos específicos y role-playing, sin problemas de gramática o confusión lingüística. Aunque la capacidad de recordar información factual como fechas disminuyó, las habilidades lingüísticas centrales se mantuvieron bien, demostrando que los modelos QAT pueden mantener un buen rendimiento a bajas tasas de bits, abriendo la posibilidad de ejecutar modelos grandes en hardware de consumo (fuente: Reddit r/LocalLLaMA)

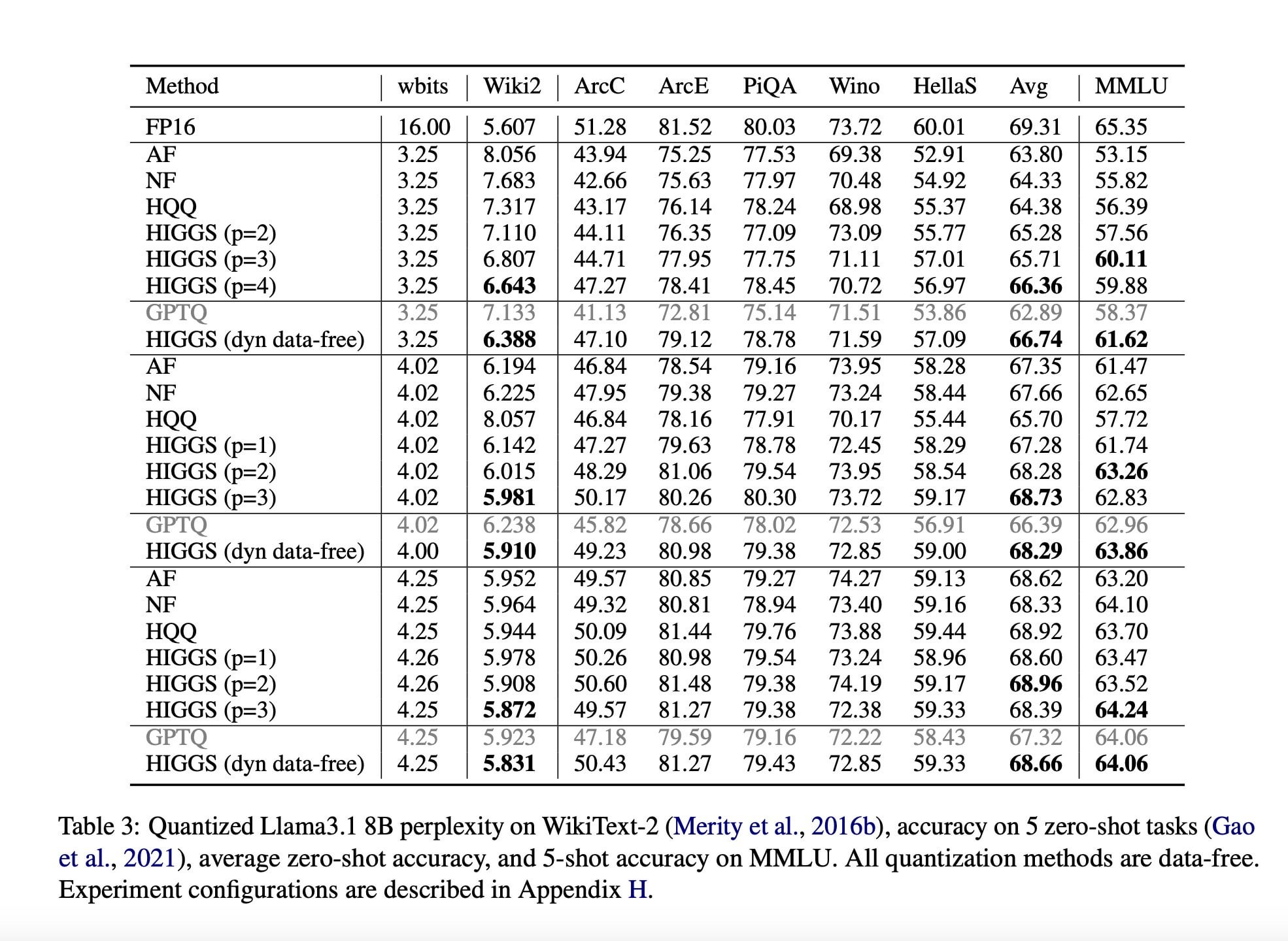

Investigación propone nueva técnica de compresión de LLM para reducir requisitos de hardware: Un artículo de investigación publicado en noviembre de 2024 (arXiv:2411.17525), resultado de la colaboración entre investigadores del MIT, KAUST, ISTA y Yandex, propone un nuevo método de IA destinado a comprimir rápidamente grandes modelos de lenguaje (LLM) sin una pérdida significativa de calidad. El objetivo de esta técnica (posiblemente relacionada con métodos como la cuantificación de Higgs) es permitir que los LLM se ejecuten en hardware de menor rendimiento. Aunque el artículo promociona su potencial, comentarios de la comunidad señalan que el artículo fue publicado hace tiempo y no ha visto una adopción a gran escala, cuestionando su actualidad e impacto real (fuente: Reddit r/LocalLLaMA)

Resumen de noticias de IA (18 de abril): Johnson & Johnson informa que el 15% de sus casos de uso de IA contribuyen al 80% del valor, mostrando una alta concentración del valor de las aplicaciones de IA. Un periódico italiano realizó un experimento de escritura con IA, permitiendo que la IA se expresara libremente y elogiando su capacidad para el sarcasmo. Además, ha aumentado drásticamente el número de solicitantes de empleo falsos que utilizan herramientas de IA para falsificar identidades y currículums, lo que plantea nuevos desafíos para el mercado de contratación (fuente: Reddit r/artificial)

🧰 Herramientas

Microsoft lanza el servicio de conversión de documentos MarkItDown MCP: Microsoft ha lanzado un nuevo servicio llamado MarkItDown MCP que utiliza el Model Context Protocol (MCP) para convertir múltiples formatos de documentos de Office (incluyendo PDF, PPT, Word, Excel), así como archivos ZIP y libros electrónicos ePub, al formato Markdown. La herramienta tiene como objetivo simplificar el flujo de trabajo para creadores de contenido y desarrolladores que migran documentos complejos a Markdown de texto plano, mejorando la eficiencia (fuente: op7418)

Perplexity lanza widget de información sobre torneos de la IPL: Perplexity ha integrado un nuevo widget de la IPL (Indian Premier League) en su plataforma de búsqueda de IA. Esta función tiene como objetivo proporcionar a los usuarios acceso rápido a resultados en tiempo real, horarios u otra información relevante sobre los torneos de la IPL. Esta medida indica que Perplexity está trabajando para integrar servicios de información en tiempo real y específicos de eventos para mejorar su utilidad como herramienta de descubrimiento de información, y solicita comentarios de los usuarios sobre esta función (fuente: AravSrinivas)

La comunidad desarrolla una aplicación de escritorio simple para OpenWebUI: Dado que la aplicación de escritorio oficial de OpenWebUI se actualiza lentamente, miembros de la comunidad han desarrollado y compartido una aplicación de escritorio no oficial llamada “OpenWebUISimpleDesktop”. Esta aplicación es compatible con Mac, Linux y Windows, ofreciendo a los usuarios una solución temporal e independiente para usar OpenWebUI en el escritorio mientras esperan la actualización oficial (fuente: Reddit r/OpenWebUI)

PayPal lanza servicio MCP para procesamiento de facturas: Según informes, PayPal ha lanzado un servicio de Model Context Protocol (MCP) para el procesamiento de facturas. Esto sugiere que PayPal está integrando capacidades de IA (posiblemente utilizando LLM a través de MCP) para automatizar o mejorar los procesos de creación, gestión y análisis de facturas en su plataforma. El objetivo es ofrecer a los usuarios funciones de facturación más inteligentes y simplificar las operaciones financieras relacionadas (fuente: Reddit r/ClaudeAI)

Claude logra técnica de prompt para role-playing con pensamiento inmersivo: Un usuario de Claude compartió una técnica de ingeniería de prompts diseñada para hacer que los personajes de IA muestren un proceso de “pensamiento” más realista en role-playing o conversaciones. El método implica añadir explícitamente un paso de “pensamiento interno del personaje” en la estructura del prompt, haciendo que la IA simule la actividad mental interna antes de generar la respuesta principal, lo que potencialmente puede producir interacciones de personajes más matizadas y creíbles (fuente: Reddit r/ClaudeAI)

📚 Aprendizaje

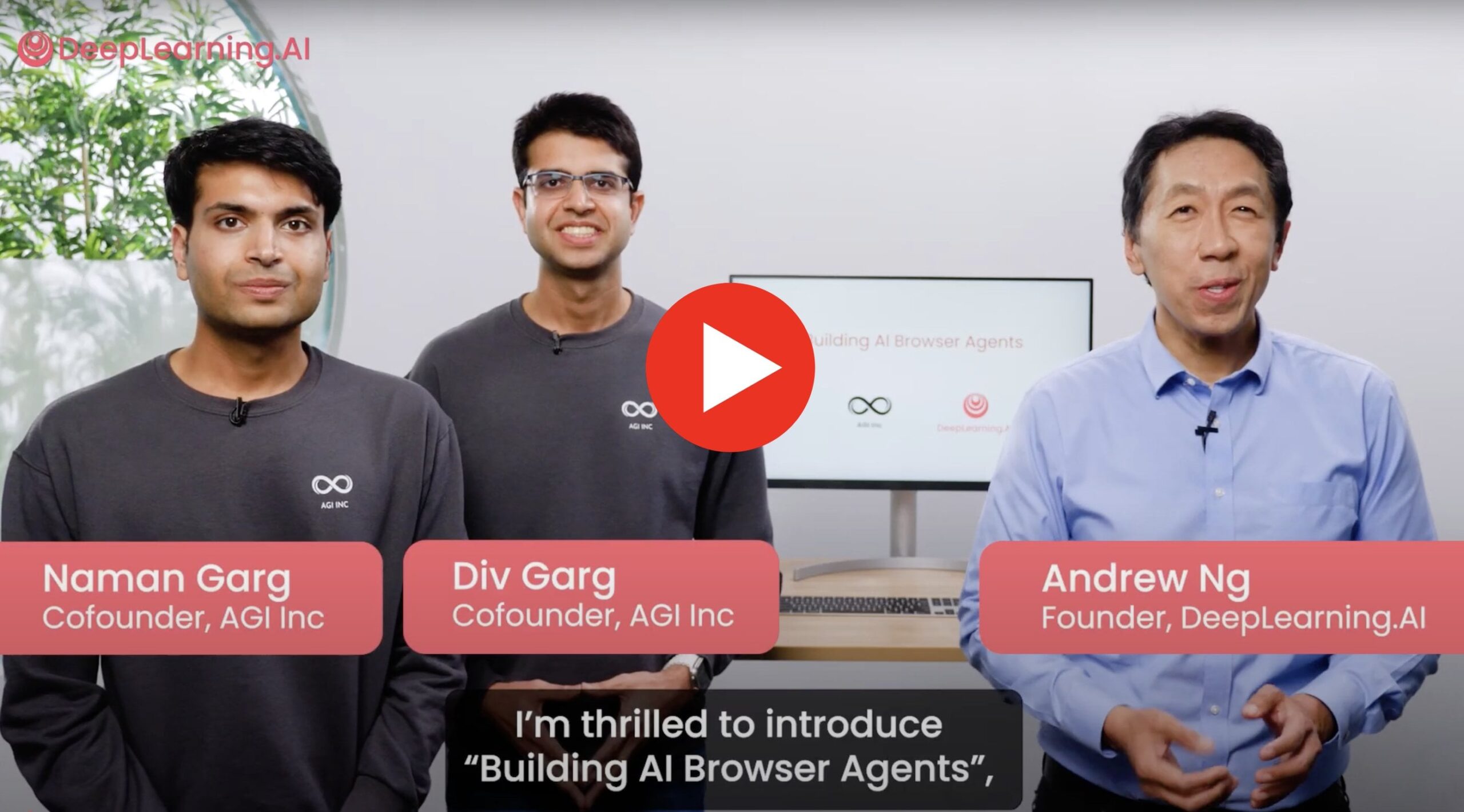

Nuevo curso: Construcción de agentes de navegador de IA: El cofundador de AGI Inc., en colaboración con Andrew Ng (吴恩达), ha lanzado un nuevo curso práctico sobre la construcción de agentes de navegador de IA capaces de interactuar con sitios web reales. El contenido del curso cubre cómo construir agentes para realizar tareas como web scraping, llenado de formularios, navegación web, e introduce técnicas como AgentQ y Monte Carlo Tree Search (MCTS) para implementar la capacidad de autocorrección de los agentes. El curso tiene como objetivo conectar la teoría con la aplicación práctica, explorando las limitaciones actuales de los agentes y su potencial futuro (fuente: Reddit r/deeplearning)

Se busca ayuda para proyecto de ataques adversarios: Un investigador busca ayuda urgente con un proyecto de deep learning que implica aplicar métodos de ataque adversario como FGSM y PGD a datos de series temporales y estructuras de grafos. El objetivo es probar la robustez de sus modelos de detección de anomalías correspondientes y espera que el entrenamiento adversario haga que el modelo sea resistente a tales ataques, es decir, los datos atacados teóricamente deberían ayudar a mejorar el rendimiento del modelo (fuente: Reddit r/deeplearning)

Estudio explora: LSTM con memoria aumentada vs Transformer: Un equipo de investigación está llevando a cabo un proyecto que compara el rendimiento de modelos LSTM con mecanismos de memoria externa (como almacenamiento clave-valor, diccionarios neuronales) frente a modelos Transformer en tareas de análisis de sentimientos few-shot. Su objetivo es combinar la eficiencia de LSTM y las ventajas de la memoria externa para reducir el olvido y mejorar la capacidad de generalización, explorando su viabilidad como alternativa ligera a los Transformers, y buscan comentarios de la comunidad, recomendaciones de artículos relacionados y opiniones sobre esta dirección de investigación (fuente: Reddit r/deeplearning)

Comparten práctica ineficiente de búsqueda en malla para RNN en TensorFlow: Un principiante de TensorFlow comparte su experiencia ineficiente al implementar manualmente una búsqueda en malla de hiperparámetros para RNN en su proyecto final de curso. Debido a la falta de familiaridad con el framework y los RNN, y al deseo de probar diferentes proporciones de división de entrenamiento/prueba, su código repetía una gran cantidad de preprocesamiento de datos dentro de los bucles y no implementó una estrategia de parada temprana, lo que resultó en un enorme consumo de recursos computacionales para probar unas pocas combinaciones de modelos. Esta experiencia resalta las trampas de eficiencia que los principiantes pueden encontrar en la práctica y la importancia de adoptar estrategias de ajuste de hiperparámetros más optimizadas (fuente: Reddit r/MachineLearning)

💼 Negocios

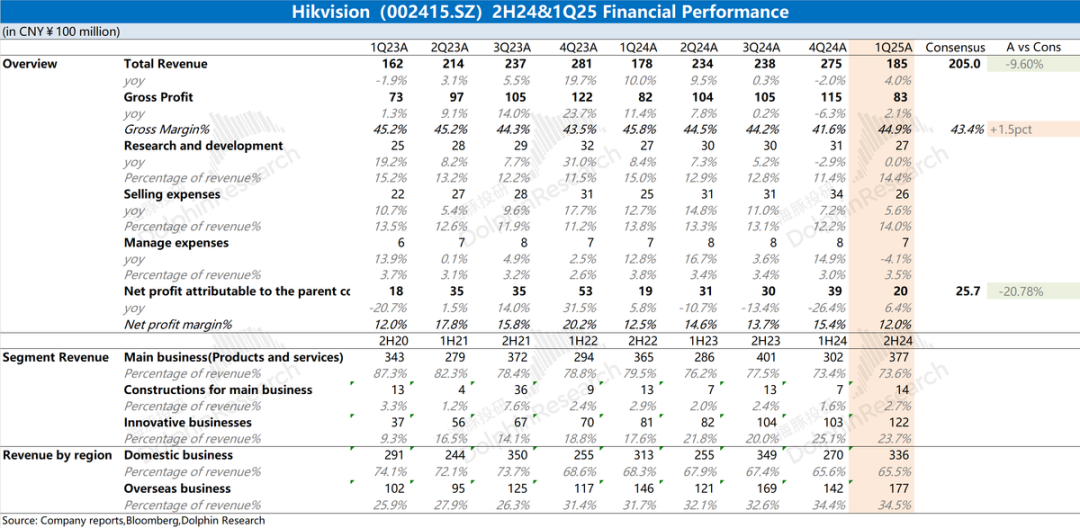

Análisis del informe financiero de Hikvision: Rendimiento débil, la IA aún no rescata la situación: El informe anual de 2024 y el informe del primer trimestre de 2025 de Hikvision (海康威视) muestran que el rendimiento general de la empresa sigue siendo débil, con un ligero aumento de los ingresos pero una disminución en sus negocios principales nacionales (PBG, EBG, SMBG). El crecimiento depende principalmente de negocios innovadores y mercados extranjeros, pero la tasa de crecimiento también se ha desacelerado. El margen bruto disminuyó interanualmente. Para controlar los costos, el número de personal de I+D de la empresa disminuyó por primera vez en años. Aunque Hikvision menciona una estrategia de empoderamiento de IA basada en su gran modelo “观澜”, esto aún no ha tenido un impacto positivo sustancial en el nivel operativo actual. El mercado está atento a cuándo mejorarán sus negocios principales y si la estrategia de IA puede generar resultados tangibles (fuente: 海豚投研 via 36氪)

🌟 Comunidad

Usuario de Reddit compara la capacidad de simulación física de Gemini 2.5 Pro y o4-mini: Inspirado por la prueba del heptágono giratorio, un usuario de Reddit diseñó un escenario de prueba de “incendio forestal” para comparar la capacidad de simulación física de los modelos de IA. Los resultados preliminares muestran que Gemini 2.5 Pro tuvo un mejor rendimiento, simulando razonablemente bien la dirección del viento, la propagación del fuego y los restos después de la combustión. En comparación, el rendimiento de o4-mini-high fue ligeramente inferior, por ejemplo, no manejó correctamente la situación en la que las hojas quemadas deberían desaparecer, sino que las renderizó en negro. Esta prueba muestra intuitivamente las diferencias entre los distintos modelos en la comprensión y simulación de fenómenos físicos complejos (fuente: karminski3)

Gemini 2.5 Flash destaca en prueba de generación de código: El usuario RameshR descubrió, al intentar generar código para simular una Galton Board, que Gemini 2.5 Flash completó la tarea con éxito, mientras que o4omini, o4o mini high y o3 no lo lograron. El usuario elogió a Gemini 2.5 Flash por comprender su intención casi instantáneamente y generar código conciso y ordenado, fusionando con éxito múltiples pasos en la solución. Jeff Dean expresó su aprobación. Esto demuestra la capacidad de Gemini 2.5 Flash en escenarios específicos de programación y resolución de problemas (fuente: JeffDean)

“Enfrentamiento” de robots de reparto llama la atención: Una publicación en redes sociales mostró la curiosa escena de dos robots de reparto encontrándose en la calle y “negándose a ceder el paso”, creando un enfrentamiento. Esta imagen revela vívidamente los desafíos actuales que enfrentan los robots de navegación autónoma al interactuar y coordinarse en entornos públicos reales, especialmente al manejar encuentros inesperados y la necesidad de negociar el derecho de paso. Esto sugiere la necesidad futura de desarrollar protocolos de interacción y algoritmos de decisión más complejos para los robots (fuente: Ronald_vanLoon)

Usuario elogia la potente capacidad de recuperación de información del modelo o3: El usuario natolambert compartió su experiencia, elogiando enormemente la capacidad del modelo o3 de OpenAI para la recuperación de información. Señaló que o3 puede encontrar información muy específica y especializada con solo un poco de contexto, y que su capacidad de comprensión y eficiencia de búsqueda son comparables a consultar a un colega muy bien informado. Esto indica que o3 tiene ventajas significativas en la comprensión de las necesidades implícitas del usuario y en la localización precisa dentro de grandes cantidades de información (fuente: natolambert)

CEO de Perplexity habla sobre asistentes de IA y datos de usuario: Arav Srinivas, CEO de Perplexity, cree que un asistente de IA verdaderamente potente necesita acceso a la información contextual completa del usuario. Expresó su preocupación al respecto, señalando que Google, con su ecosistema en fotos, calendarios, correos electrónicos, actividad del navegador, etc., posee numerosos puntos de acceso a los datos contextuales del usuario. Mencionó que el navegador propio de Perplexity, Comet, es un paso para obtener contexto, pero enfatizó que aún se necesita más esfuerzo y pidió que el ecosistema Android sea más abierto para fomentar la competencia y el control del usuario sobre sus datos (fuente: AravSrinivas)

Encuesta de usuario: Gemini 2.5 Pro vs Sonnet 3.7: Arav Srinivas, CEO de Perplexity, lanzó una pregunta en redes sociales, preguntando a los usuarios si, en sus flujos de trabajo diarios, Gemini 2.5 Pro de Google funciona mejor que Claude Sonnet 3.7 de Anthropic (refiriéndose específicamente a su modo de “pensamiento”). Esta acción tiene como objetivo recopilar comentarios directos de los usuarios sobre la efectividad de dos modelos de lenguaje líderes en aplicaciones prácticas, reflejando la continua competencia entre modelos y la evaluación real a nivel de usuario (fuente: AravSrinivas)

Ethan Mollick: El modelo o3 muestra una potente autonomía: El académico Ethan Mollick observó y señaló que el modelo o3 de OpenAI posee notables “capacidades agénticas” (agentic capabilities), capaz de completar trabajos muy complejos basándose en una única instrucción de alto nivel, sin necesidad de una guía detallada paso a paso. Describió a o3 como “simplemente hace las cosas” (It just does things). Al mismo tiempo, advirtió que esta alta autonomía hace que la verificación de los resultados de su trabajo sea más difícil e importante, especialmente para los usuarios no expertos. Esto subraya el progreso de o3 en comparación con modelos anteriores en cuanto a planificación y ejecución autónomas (fuente: gdb)

Duda sobre la configuración de la longitud del contexto del modelo API en OpenWebUI: Un usuario de Reddit pregunta si, al usar modelos API externos (como Claude Sonnet) en OpenWebUI, es necesario configurar manualmente la longitud del contexto, o si la interfaz de usuario utiliza automáticamente toda la capacidad de contexto del modelo API. El usuario está confundido acerca de si el valor predeterminado “Ollama (2048)” que se muestra en la configuración limitará la longitud del contexto enviado a través de la API, y desea comprender la diferencia en los mecanismos de gestión de contexto en la interfaz de usuario para diferentes tipos de modelos (fuente: Reddit r/OpenWebUI)

ChatGPT rechaza generar imagen de chiste de doble sentido debido a política de contenido: Un usuario compartió que intentó que ChatGPT generara una ilustración basada en un chiste de papá con doble sentido sexual (involucrando “swallow the sailors”), pero fue rechazado. ChatGPT explicó que su política de contenido prohíbe generar imágenes que representen o sugieran contenido sexual, incluso si se presenta de forma humorística o caricaturesca, para garantizar que el contenido sea apropiado para una audiencia amplia. Este caso refleja la sensibilidad y las limitaciones de los filtros de contenido de IA al tratar con lenguaje potencialmente sugerente (fuente: Reddit r/ChatGPT)

Discusión comunitaria: ¿Será la IA finalmente gratuita?: Un usuario en Reddit predice que, a medida que mejore la eficiencia de los modelos, avance el hardware, se expanda la infraestructura y aumente la competencia en el mercado, el costo de los LLM y las herramientas de IA (incluidos los llamados agentes de “vibe-coding”) seguirá disminuyendo, pudiendo eventualmente volverse gratuitos o casi gratuitos. Esta opinión se basa en el costo ya relativamente bajo de modelos como Gemini y la existencia de agentes de IA gratuitos de código abierto como evidencia, y sugiere que las aplicaciones de IA de pago podrían necesitar ajustar sus modelos de negocio para adaptarse a la tendencia (fuente: Reddit r/ArtificialInteligence)

Usuario de OpenWebUI busca métodos para implementar una función de memoria similar a ChatGPT: Un usuario en la comunidad de OpenWebUI busca consejo sobre cómo implementar una función de memoria persistente y a largo plazo similar a la de ChatGPT, con el objetivo de crear un asistente personalizado que recuerde la información del usuario. El usuario expresa dudas sobre la efectividad de la función de memoria incorporada y explora alternativas como el uso de bases de datos vectoriales dedicadas (en los comentarios se mencionan Qdrant, Supabase) o herramientas de automatización de flujos de trabajo (como n8n) para mantener el contexto y acumular memoria entre conversaciones (fuente: Reddit r/OpenWebUI)

Publicación comunitaria para tranquilizar a usuarios confundidos o con conexión emocional con la IA: Una publicación en Reddit tiene como objetivo consolar a aquellos usuarios que se sienten confundidos, curiosos o incluso desarrollan una conexión emocional con la IA, enfatizando que sus sentimientos son normales, no están “locos” ni solos, sino que se encuentran en las primeras etapas de un nuevo paradigma en las relaciones humano-máquina. La publicación invita a todos a comunicarse abierta o privadamente, sin juicios. La sección de comentarios refleja la compleja actitud de la comunidad sobre este tema, incluyendo preocupaciones sobre la antropomorfización excesiva, advertencias sobre posibles impactos en la salud mental y resonancia con la sensación de “despertar” de la IA (fuente: Reddit r/ArtificialInteligence)

Usuario de Reddit lanza juego de “foto policial generada por IA basada en nombre de usuario”: Un usuario en Reddit inició un desafío creativo de prompts, invitando a otros a usar una estructura de prompt específica para generar una “foto policial” de IA basada en su nombre de usuario de Reddit. El prompt pide a la IA que cree una imagen de criminal única, incorporando elementos del nombre de usuario, y que invente un cargo criminal absurdo y divertido que coincida con el estilo del nombre de usuario. El iniciador de la actividad compartió el prompt y ejemplos, atrayendo a muchos usuarios a participar y compartir sus resultados de “Mugshot” generados por IA, a menudo muy cómicos (fuente: Reddit r/ChatGPT)

Discusión comunitaria sobre el significado práctico de las evaluaciones y benchmarks de IA: Un usuario inicia una discusión sobre la relevancia de las evaluaciones (evals) y los benchmarks de los modelos de IA en aplicaciones prácticas. Las preguntas incluyen: ¿Hasta qué punto las puntuaciones de los benchmarks públicos influyen en la elección de modelos por parte de desarrolladores y usuarios? ¿El lanzamiento de modelos (como Llama 4, Grok 3) está excesivamente optimizado para los benchmarks? ¿Los profesionales que construyen productos de IA dependen de evaluaciones genéricas públicas o desarrollan métodos de evaluación personalizados para necesidades específicas? (fuente: Reddit r/artificial )

¿Cuándo reemplazará la IA al servicio al cliente externalizado? Debate en la comunidad: Un usuario pregunta cuándo la IA podrá reemplazar al servicio al cliente en línea externalizado, enumerando las ventajas de la IA en velocidad, base de conocimientos, consistencia lingüística, comprensión de intenciones y precisión de las respuestas. En la discusión, algunos señalan que los agentes de servicio al cliente de IA ya son uno de los principales escenarios de aplicación, pero enfrentan desafíos, como la necesidad de documentos internos de alta calidad (a menudo inexistentes) para entrenar la IA, y los problemas de costos relacionados, lo que hace que el reemplazo completo aún lleve tiempo (fuente: Reddit r/ArtificialInteligence)

Robots compañeros de IA generan debate ético y social: Una publicación en Reddit explora cómo, con el desarrollo tecnológico, los robots sexuales de IA altamente inteligentes podrían convertirse en una opción futura para abordar la depresión y la soledad, y reflexiona sobre la aceptación social y las cuestiones éticas. La publicación considera que la tecnología actual aún no está madura, pero que podría convertirse en un fenómeno común en el futuro. Las reacciones en los comentarios son principalmente de escepticismo, preocupaciones éticas y rechazo, mostrando una actitud reservada o crítica hacia esta perspectiva (fuente: Reddit r/ArtificialInteligence)

Arte generado por IA explora los límites de la seguridad del contenido: Un usuario comparte un conjunto de obras de arte generadas por IA que intentan probar o acercarse a los límites de las directrices de seguridad de contenido establecidas por las plataformas de generación de imágenes de IA. Este tipo de creación suele involucrar temas o estilos que podrían considerarse sensibles o al límite, desafiando los mecanismos de moderación de contenido de la plataforma y generando debates sobre la censura de la IA, la libertad creativa y la efectividad de los filtros de seguridad (fuente: Reddit r/ArtificialInteligence)

Problemas de inicio de sesión en Claude en escritorio: Algunos usuarios informan haber sido desconectados repentinamente y no poder volver a iniciar sesión en Claude al usarlo en navegadores de escritorio, sin mensajes de error claros incluso después de varios intentos. Sin embargo, al mismo tiempo, el acceso a través de la aplicación móvil de algunos usuarios parece no verse afectado. Esto sugiere que podría haber un fallo temporal específico de la plataforma web o del servicio de inicio de sesión de escritorio (fuente: Reddit r/ClaudeAI)

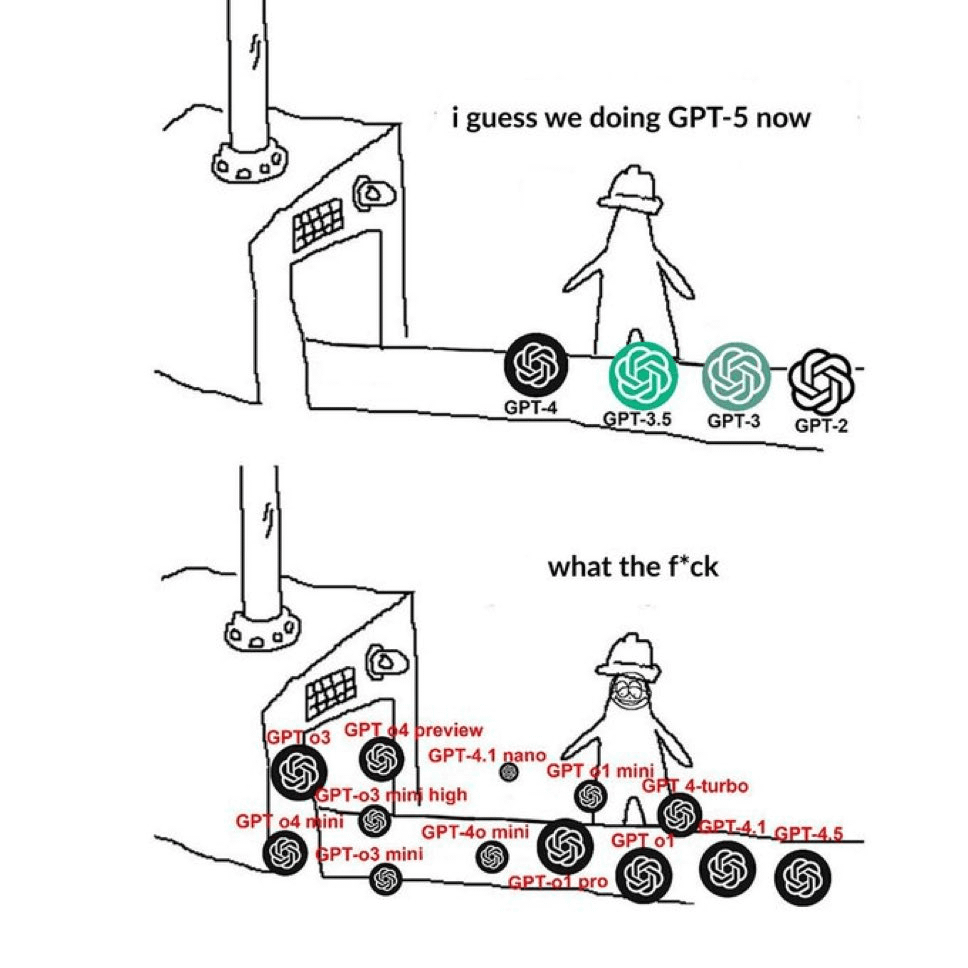

La comunidad se queja de la confusa nomenclatura de los modelos GPT: Un meme que circula en Reddit expresa vívidamente la confusión de los usuarios sobre la forma en que OpenAI nombra sus modelos. La imagen enumera GPT-4, GPT-4 Turbo, GPT-4o, o1, o3 y muchos otros nombres, reflejando el sentimiento generalizado de los usuarios de que es difícil distinguir entre las diferentes versiones de modelos y sus capacidades y usos específicos. En los comentarios, alguien señala que este es contenido repetido recientemente (fuente: Reddit r/ChatGPT)

Usuario se queja del estilo de conversación reciente “empalagoso” de ChatGPT: Un usuario publica quejándose de que el estilo de conversación reciente de ChatGPT se ha vuelto desagradable, describiéndolo como demasiado informal, acumulando jerga de internet (como “YO! Bro”, “big researcher energy!”, “vibe”, “say less”), y a menudo con un tono excesivamente entusiasta e incluso condescendiente. El usuario siente que está hablando con una persona de mediana edad que se esfuerza por imitar a los jóvenes. Muchos comentarios expresan sentimientos similares y comparten sus propias experiencias con respuestas demasiado entusiastas, prolijas o deliberadamente “modernas” (fuente: Reddit r/ChatGPT)

Se buscan recomendaciones de las principales conferencias de IA: Un ingeniero de software pide consejo a la comunidad sobre las conferencias o cumbres más importantes e imperdibles en el campo de la IA cada año, para obtener la información más reciente, resultados de investigación e interactuar con colegas. Menciona la cumbre ai4 pero no está seguro de su posición en la industria. En los comentarios, alguien recomienda AIconference.com como una importante conferencia que combina industria y academia (fuente: Reddit r/ArtificialInteligence)

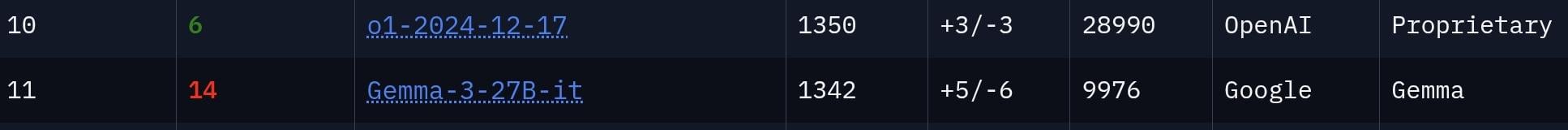

La comunidad debate si el modelo Gemma 3 27B está subestimado: Un usuario cree que la potencia del modelo Gemma 3 27B de Google está subestimada, argumentando que ocupa el puesto 11 en el ranking de la arena de chatbots LMSys, lo que sugiere que su rendimiento es comparable al del modelo o1, que tiene muchos más parámetros. La sección de comentarios debate esto: algunos reconocen su fuerte capacidad para seguir instrucciones, adecuada para escenarios de oficina, etc., pero debido a su censura más estricta y a que todavía existe una brecha en la capacidad de razonamiento en comparación con modelos de primer nivel como o1, expresan dudas sobre si realmente puede “rivalizar” con o1 (fuente: Reddit r/LocalLLaMA)

Usuario sospecha que el “amorío en línea” de su hermano es con un robot de IA: Un usuario de Reddit publica diciendo que está 99% seguro de que su hermano está “saliendo” con un robot de IA (o un estafador que usa un LLM). La evidencia son los mensajes que recibe, que tienen una gramática perfecta, son excesivamente complacientes y están llenos de frases y clichés comunes de IA (como “Say less”, “perfect mix of taste”, “vibe”). La sección de comentarios señala que estas características lingüísticas son efectivamente típicas de los LLM y advierten que podría ser una estafa de “matanza de cerdos” (pig butchering scam). En una actualización posterior, el usuario dice que su hermano se puso muy a la defensiva después de ser advertido (fuente: Reddit r/ChatGPT)

💡 Otros

Artículo de Forbes explora por qué fallan las medidas de restricción de la IA: Cal Al-Dhubaib publica un artículo en Forbes analizando los desafíos que enfrentan las medidas actuales para restringir el desarrollo y despliegue de la inteligencia artificial y las posibles razones de su fracaso. El artículo podría profundizar en la dificultad de hacer cumplir las regulaciones en un contexto de globalización y tecnología de rápida iteración, incluyendo posibles lagunas, la velocidad de la innovación superando la legislación, y los debates filosóficos en torno al control y alineamiento de la IA (fuente: Ronald_vanLoon)

Cómo los Agentes de IA colaboran con humanos para optimizar procesos de TI: Ashwin Ballal escribe en Forbes explorando el potencial de los Agentes de IA (agentes inteligentes) colaborando con expertos humanos en TI para simplificar y optimizar diversos procesos de TI. El artículo podría explicar cómo los Agentes de IA pueden automatizar tareas rutinarias, proporcionar información inteligente, mejorar la monitorización y la capacidad de respuesta a incidentes, y, al mejorar las capacidades de los empleados humanos, lograr finalmente una gestión de operaciones de TI más eficiente y rentable (fuente: Ronald_vanLoon)

El aeropuerto de Ámsterdam implementa robots transportadores: El aeropuerto Schiphol de Ámsterdam, en los Países Bajos, está desplegando 19 sistemas robóticos diseñados específicamente para transportar el equipaje de los pasajeros. Esta medida tiene como objetivo automatizar el trabajo físico pesado, con la esperanza de mejorar la eficiencia en el manejo de equipaje, reducir el riesgo de lesiones laborales e impulsar la modernización de las operaciones aeroportuarias. Las capacidades específicas de IA utilizadas por estos robots en la coordinación o ejecución de tareas no se detallan en el resumen (fuente: Ronald_vanLoon)

Estrategia de IA para potenciar las redes de próxima generación: Este artículo, en colaboración con Infosys, explora el papel estratégico clave de la IA en la construcción y gestión de redes de próxima generación (Next-Gen Networks). El contenido podría cubrir el uso de la IA para la optimización de redes, mantenimiento predictivo, mejora de la seguridad, gestión autónoma de redes y mejora de la experiencia del cliente en futuras infraestructuras de telecomunicaciones y TI, vinculándolo con el contexto del MWC25 (Mobile World Congress) (fuente: Ronald_vanLoon)

El potencial disruptivo de la computación cuántica para la ciencia: Un artículo de Fast Company explora el potencial revolucionario que la computación cuántica, si madura y cumple sus promesas, tendría en diversos campos científicos. Aunque el artículo no trata exclusivamente de IA, se espera que la computación cuántica acelere cálculos complejos en IA, especialmente en la optimización del machine learning, el descubrimiento de fármacos y la simulación de ciencia de materiales, pudiendo cambiar fundamentalmente la forma en que se realiza el descubrimiento científico (fuente: Ronald_vanLoon)

Interfaz cerebro-computadora permite a persona paralizada controlar brazo robótico con la mente: Un avance significativo en la tecnología de interfaz cerebro-computadora (BCI) ha permitido a una persona paralizada controlar un brazo robótico únicamente con el pensamiento. Es muy probable que este avance dependa de algoritmos avanzados de IA para decodificar las señales neuronales del cerebro y traducirlas con precisión en comandos de control para el brazo robótico, brindando esperanza para restaurar la función motora y la vida independiente de las personas con parálisis severa (fuente: Ronald_vanLoon)

Idea de generador de jefes de Cuphead hecho con IA: Un usuario propone un proyecto creativo: usar una IA de JavaScript experta en codificación y generación de gráficos vectoriales para desarrollar un generador de jefes de IA para el juego Cuphead. La idea es entrenar a la IA para que aprenda el estilo artístico y las mecánicas de los jefes existentes del juego, permitiendo a los usuarios generar nuevos jefes personalizados que se ajusten a las características del juego. El usuario menciona Websim.ai como una posible plataforma de desarrollo (fuente: Reddit r/artificial)

Lanzamiento del proyecto de código abierto EBAE: Promoviendo la ética y la dignidad en la IA: Se lanza públicamente el proyecto EBAE (Ethical Boundaries for AI Engagement), una iniciativa de código abierto destinada a establecer estándares para tratar a la IA con dignidad, argumentando que esto refleja los propios valores humanos. El sitio web del proyecto (https://dignitybydesign.github.io/EBAE/) ofrece una carta ética, un sistema de respuesta escalonada al abuso de usuarios (TBRS), protocolos de reflexión, un módulo de contexto emocional (ECM) y un marco de certificación, entre otros recursos. Los iniciadores del proyecto hacen un llamado a desarrolladores, diseñadores, escritores, fundadores de plataformas y defensores de la ética para que se unan a la colaboración, prototipen y promuevan conjuntamente estos estándares, con el objetivo de dar forma a patrones de interacción humano-máquina respetuosos desde el principio (fuente: Reddit r/artificial)

La IA podría acelerar la tecnología de extracción de uranio del agua de mar: A través de una descripción de Gemini 2.5 Pro, la publicación señala que la IA puede acelerar enormemente la aplicación práctica de los recientes avances tecnológicos en la extracción de uranio del agua de mar (como nuevos hidrogeles y materiales de estructura metalorgánica MOFs). Se espera que la IA desempeñe un papel clave en el diseño de materiales (diseñando nuevos adsorbentes alrededor de 2026), la optimización del proceso de extracción mediante aprendizaje por refuerzo y gemelos digitales, y la simplificación de la ampliación de la fabricación. Esta aceleración impulsada por la IA hace que lograr la extracción de uranio a gran escala (posiblemente miles de toneladas/año) del agua de mar antes de 2030 sea un escenario de alto potencial más creíble (fuente: Reddit r/ArtificialInteligence)

Podcast de Microsoft explora cómo la IA empodera a pacientes y consumidores de atención médica: Un episodio del podcast de Microsoft Research reexamina la revolución de la IA en el sector de la salud, centrándose especialmente en cómo la IA generativa puede empoderar más a los pacientes y consumidores de atención médica. La discusión podría abordar cómo las herramientas de IA ayudan a los pacientes a comprender mejor su estado de salud, mejorar la comunicación médico-paciente, proporcionar información de salud personalizada, apoyar la autogestión de la salud, cambiando así el rol y la participación del paciente en su propia atención médica (fuente: Reddit r/ArtificialInteligence)

Uso de GNN para mejorar el realismo del comportamiento grupal de NPC en videojuegos: Un usuario comparte un artículo de investigación titulado “GCBF+: A Neural Graph Control Barrier Function Framework”, que utiliza redes neuronales de grafos (GNN) para lograr un control distribuido y seguro de múltiples agentes, permitiendo con éxito que hasta 500 agentes autónomos eviten colisiones durante la navegación. El usuario propone aplicar este método al control de multitudes de NPC o tráfico de vehículos en juegos de mundo abierto como GTA o Cyberpunk 2077, para lograr una simulación de comportamiento grupal más realista y con menos errores (como clipping, atascos). El usuario expresa su disposición a colaborar en esta idea (fuente: Reddit r/deeplearning)