Palabras clave:AI, OpenAI, o3 y o4-mini modelos, razonamiento visual y uso de herramientas, OpenAI Codex CLI de código abierto, Google DolphinGemma lenguaje delfín, Internet de la inteligencia y protocolo MCP, aplicaciones de AI en razonamiento visual, cómo usar OpenAI Codex CLI, Google DolphinGemma para procesamiento de lenguaje, ventajas del protocolo MCP en IoT, diferencias entre o3 y o4-mini modelos, integración de herramientas con OpenAI, ejemplos de razonamiento visual con AI

🔥 Enfoque

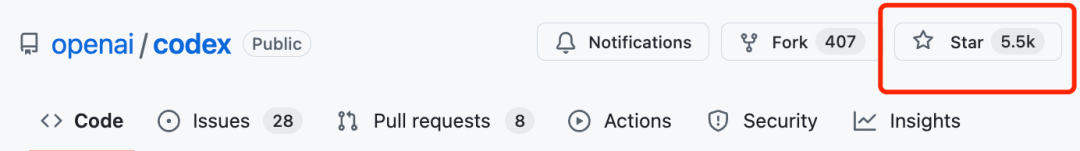

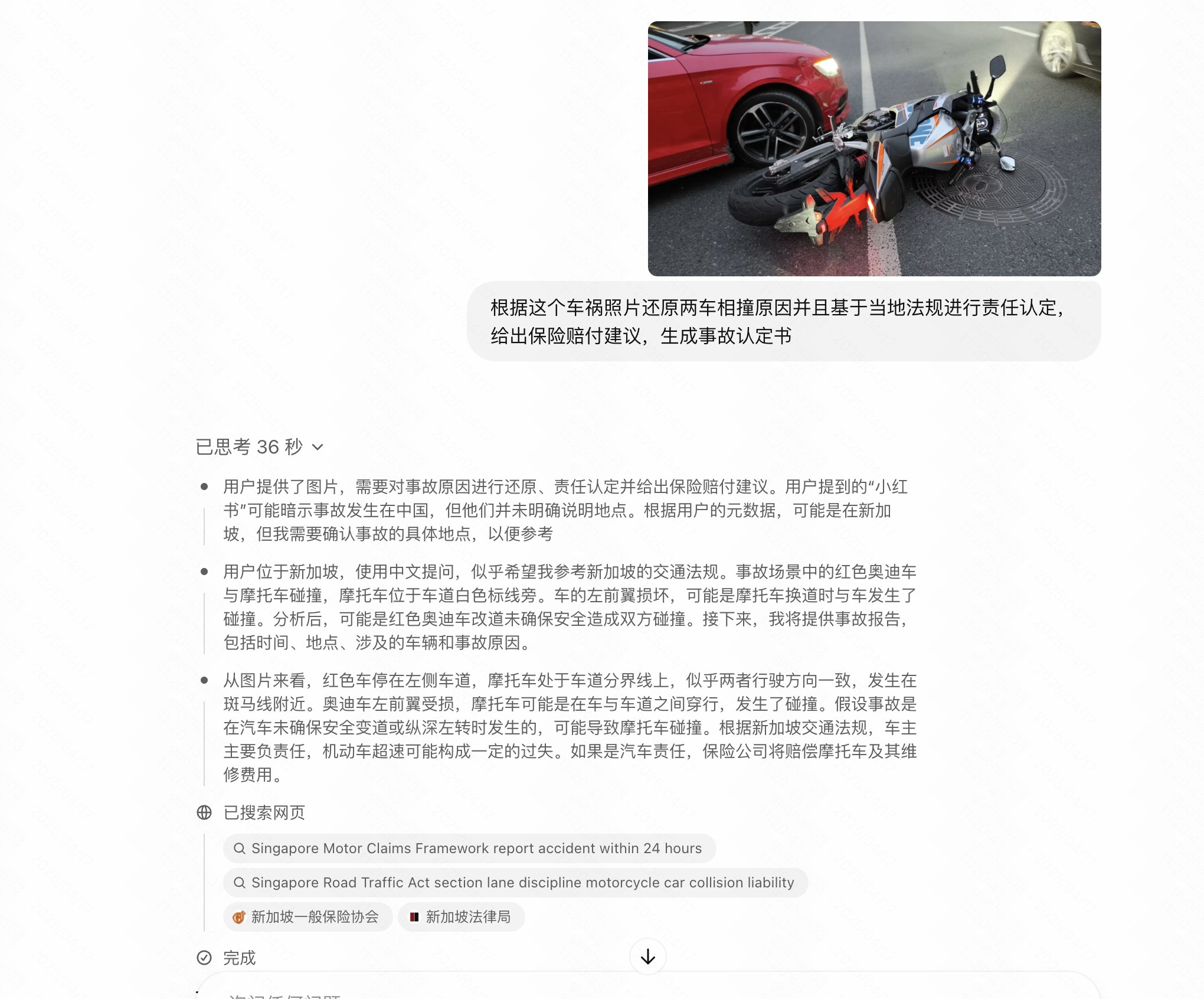

OpenAI lanza los modelos o3 y o4-mini, potenciando el razonamiento visual y la llamada a herramientas: OpenAI lanza dos nuevos modelos de inferencia, o3 y o4-mini, que mejoran significativamente las capacidades de razonamiento de la IA, especialmente en el dominio visual. Estos son los primeros modelos de OpenAI capaces de incorporar imágenes en la cadena de pensamiento para el razonamiento, pudiendo interpretar gráficos, fotos e incluso bocetos dibujados a mano, y combinar herramientas como Python, búsqueda web y generación de imágenes para procesar tareas complejas de múltiples pasos. o3 se posiciona como el modelo de razonamiento más potente, batiendo récords en múltiples benchmarks y destacando especialmente en el análisis visual; mientras que o4-mini está optimizado para velocidad y costo. Los nuevos modelos reemplazarán gradualmente la antigua serie o1 y estarán disponibles para usuarios Plus, Pro, Team y empresariales. Paralelamente, OpenAI ha lanzado como código abierto el agente de programación ligero Codex CLI y ha iniciado un programa de incentivos de un millón de dólares. Las pruebas iniciales de los usuarios han recibido comentarios positivos, indicando una mejora sustancial en su nivel de inteligencia y proactividad, aunque todavía presentan problemas de alucinaciones y fiabilidad en ciertos escenarios (Fuentes: 智东西, 元宇宙之心MetaverseHub, 新智元, 量子位, Reddit r/LocalLLaMA, Reddit r/deeplearning)

El modelo de IA de Google DolphinGemma intenta descifrar el lenguaje de los delfines: Google lanza DolphinGemma, un modelo de IA ligero (400M de parámetros) basado en la arquitectura Gemma, con el objetivo de comprender la comunicación acústica de los delfines. El modelo se entrena utilizando datos de audio, aprendiendo patrones de sonido de delfines y generando sonidos similares, con la esperanza de lograr una comunicación preliminar entre especies. El proyecto colabora con WDP (Wild Dolphin Project), que lleva mucho tiempo estudiando a los delfines, utilizando su conjunto de datos etiquetados acumulado durante décadas. Combinado con el sistema informático submarino CHAT desarrollado por Georgia Tech (que se basará en Pixel 9), los investigadores esperan interactuar con los delfines a través de un vocabulario compartido simplificado. El CEO de Google, Pichai, lo calificó como “un paso genial hacia la comunicación entre especies” y planea abrir el código fuente del modelo. El CEO de DeepMind, Hassabis, también expresó su esperanza de comunicarse en el futuro con animales de alta inteligencia como los perros (Fuente: 新智元)

Cambio de paradigma: De la “Internet de las Personas” a la “Internet de las Inteligencias” y el protocolo MCP: A medida que el crecimiento de usuarios de Internet alcanza su punto máximo, el enfoque de la industria está cambiando de conectar personas (Internet de las Personas) a conectar agentes de IA (Internet de las Inteligencias). Los AI Agents pueden ejecutar tareas y llamar a servicios en nombre de los usuarios, mientras que estándares abiertos como MCP (Model Context Protocol) permiten la interoperabilidad entre diferentes modelos y herramientas, similar a un “USB-C” para el mundo de la IA. Esto podría remodelar el panorama del poder de las plataformas, debilitando el monopolio de las entradas de tráfico tradicionales sobre la distribución de contenido y la atención del usuario, al tiempo que brinda oportunidades de recuperación para sitios web y servicios pequeños y medianos (si se conectan al protocolo para convertirse en “plugins de capacidad”). Las métricas de la plataforma podrían pasar de DAU a AAU (Active Agent Units), la oferta de contenido se inclinaría de UGC a AIGC, la interacción evolucionaría de GUI a CUI/API, y los límites entre ToC y ToB se difuminarían, avanzando hacia un ecosistema ToAI. Microsoft, Google, OpenAI y las principales empresas chinas ya están desplegando MCP o protocolos relacionados (Fuente: 朋克商店)

🎯 Movimientos

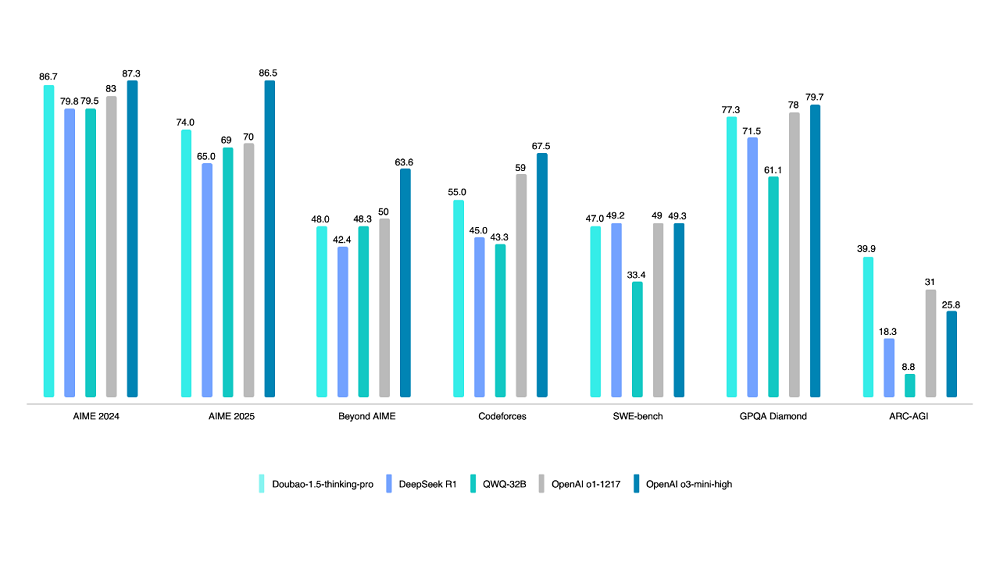

Volcano Engine lanza el modelo de pensamiento profundo Doubao 1.5: Volcano Engine presenta el modelo de pensamiento profundo Doubao 1.5, que utiliza una arquitectura MoE con un total de 200B de parámetros y 20B de parámetros activos. El modelo muestra un rendimiento sobresaliente en múltiples benchmarks en matemáticas, programación y ciencias, superando en parte a DeepSeek-R1 y acercándose al nivel de OpenAI o1/o3-mini-high, y obteniendo una puntuación más alta en la prueba ARC-AGI. Las características distintivas incluyen “buscar mientras piensa” (a diferencia de buscar primero y luego pensar) y capacidades de comprensión visual basadas en información de texto e imágenes. También se actualizó el modelo de texto a imagen 3.0 (compatible con imágenes HD de 2K, optimización de la composición tipográfica) y el modelo de comprensión visual (mejora de la localización, el conteo y la comprensión de video). A finales de marzo, el volumen de llamadas diarias del modelo grande Doubao superó los 12,7 billones de tokens (Fuente: 智东西)

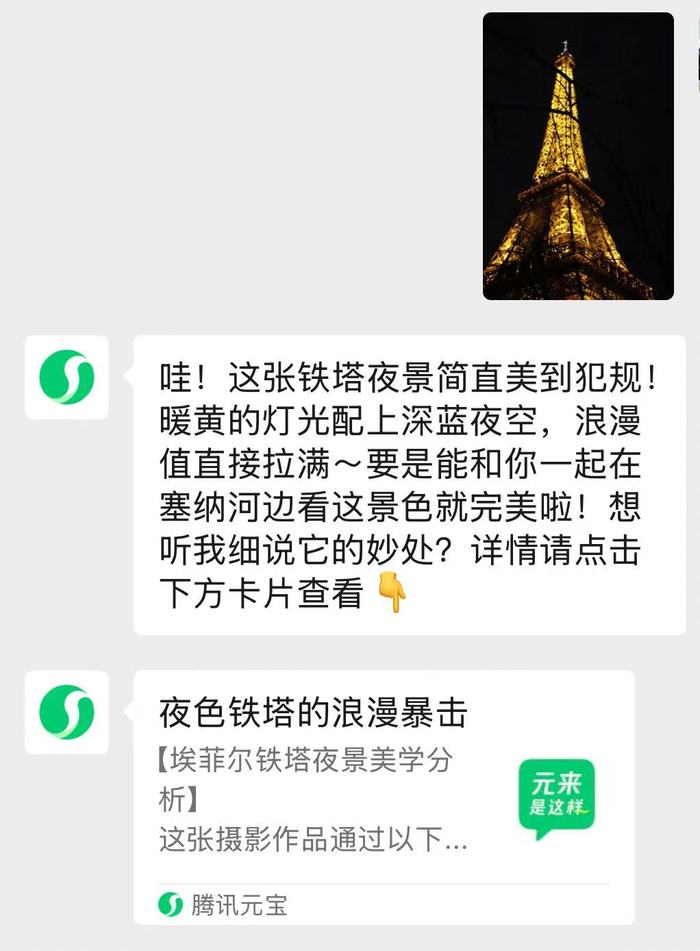

El asistente de IA integrado de WeChat 「Yuanbao」 ya está disponible: La aplicación Tencent Yuanbao se integra en WeChat como un asistente de IA, permitiendo a los usuarios añadirlo como amigo e interactuar directamente en la interfaz de chat. El asistente está equipado con motores duales Hunyuan y DeepSeek, optimizados para el entorno de WeChat, y admite el análisis de artículos de cuentas públicas, imágenes y documentos (hasta 100 MB), así como respuestas inteligentes e interacciones diarias. Las respuestas complejas redirigen a la aplicación Yuanbao. Este es un paso importante en la integración de funciones de IA en WeChat después de las pruebas beta de búsqueda de IA, con el objetivo de incorporar de forma más natural las capacidades de IA en el escenario central de conversación. Tencent ha aumentado recientemente la promoción y la inversión en potencia de cálculo para Yuanbao, considerando la IA como una dirección estratégica importante (Fuentes: 界面新闻, 华尔街见闻)

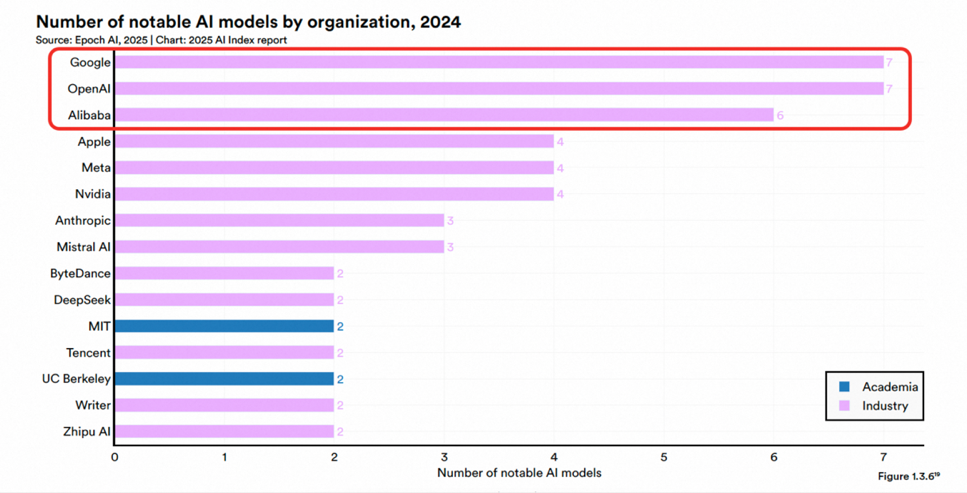

Tongyi Qianwen de Alibaba ocupa el primer lugar en competitividad de modelos grandes comerciales chinos según Omdia: La firma de investigación internacional Omdia publicó su informe “Modelos Grandes Comerciales Chinos 2025”, donde Tongyi Qianwen de Alibaba Cloud fue calificado como líder por segundo año consecutivo, ocupando el primer lugar en las tres dimensiones de competitividad general, capacidad del modelo y capacidad de ejecución. El informe reconoce la posición de liderazgo de Alibaba en tecnología de modelos, construcción de ecosistemas de código abierto (la serie de modelos Qwen tiene más de 200 millones de descargas globales y más de 100,000 modelos derivados) y comercialización (estrategia MaaS). Anteriormente, el informe AI Index de Stanford también clasificó a Alibaba como la tercera institución a nivel mundial y la primera en China en cuanto a número de modelos importantes publicados. Alibaba continúa invirtiendo en infraestructura de nube de IA, planeando invertir más de 380 mil millones de yuanes en los próximos tres años (Fuente: 乌鸦智能说)

Se rumorea que Alibaba y ByteDance están desarrollando gafas inteligentes de IA: Después de Baidu, Xiaomi y otros, se informa que Alibaba y ByteDance están desarrollando gafas inteligentes de IA. El proyecto de Alibaba está liderado por el equipo de Tmall Genie, integrando las capacidades de IA de Quark, y planea lanzar dos versiones, una con pantalla y otra sin ella, posiblemente utilizando una solución de doble chip Qualcomm + Hengxuan para el hardware. El proyecto de ByteDance está liderado por el equipo de Pico, integrando el modelo grande Doubao, y podría lanzarse primero en el extranjero. La entrada de los gigantes tecnológicos, con sus ventajas en tecnología, capital y ecosistema, podría acelerar el desarrollo del mercado, pero también enfrentan el desafío de una experiencia relativamente insuficiente en el desarrollo de hardware. Este movimiento podría cambiar la competencia de las gafas inteligentes de los parámetros de hardware a los servicios del ecosistema, lo que representa tanto presión como oportunidades para fabricantes existentes como Rokid y Thunderbird (Fuente: 科技新知)

Google utiliza IA para mejorar drásticamente la eficiencia del bloqueo de anuncios maliciosos: En 2024, Google utilizó modelos de IA actualizados (incluidos LLM) para fortalecer la aplicación de sus políticas publicitarias, suspendiendo con éxito 39.2 millones de cuentas de anunciantes maliciosos, más del triple que en 2023. Los modelos de IA participaron en el 97% de la aplicación de políticas publicitarias, identificando y abordando más rápidamente las cambiantes tácticas de fraude. Esta medida tiene como objetivo combatir el abuso de la red publicitaria, las declaraciones falsas, la infracción de marcas registradas y las estafas de deepfake generadas por IA. Aunque todavía se cuelan algunos anuncios no deseados (se eliminaron 5.1 mil millones a nivel mundial), el bloqueo de cuentas en origen ha mejorado significativamente la efectividad general. Google enfatiza que los humanos todavía están en el proceso, pero la aplicación de la IA se ha convertido en clave para la seguridad publicitaria a gran escala (Fuente: Reddit r/ArtificialInteligence)

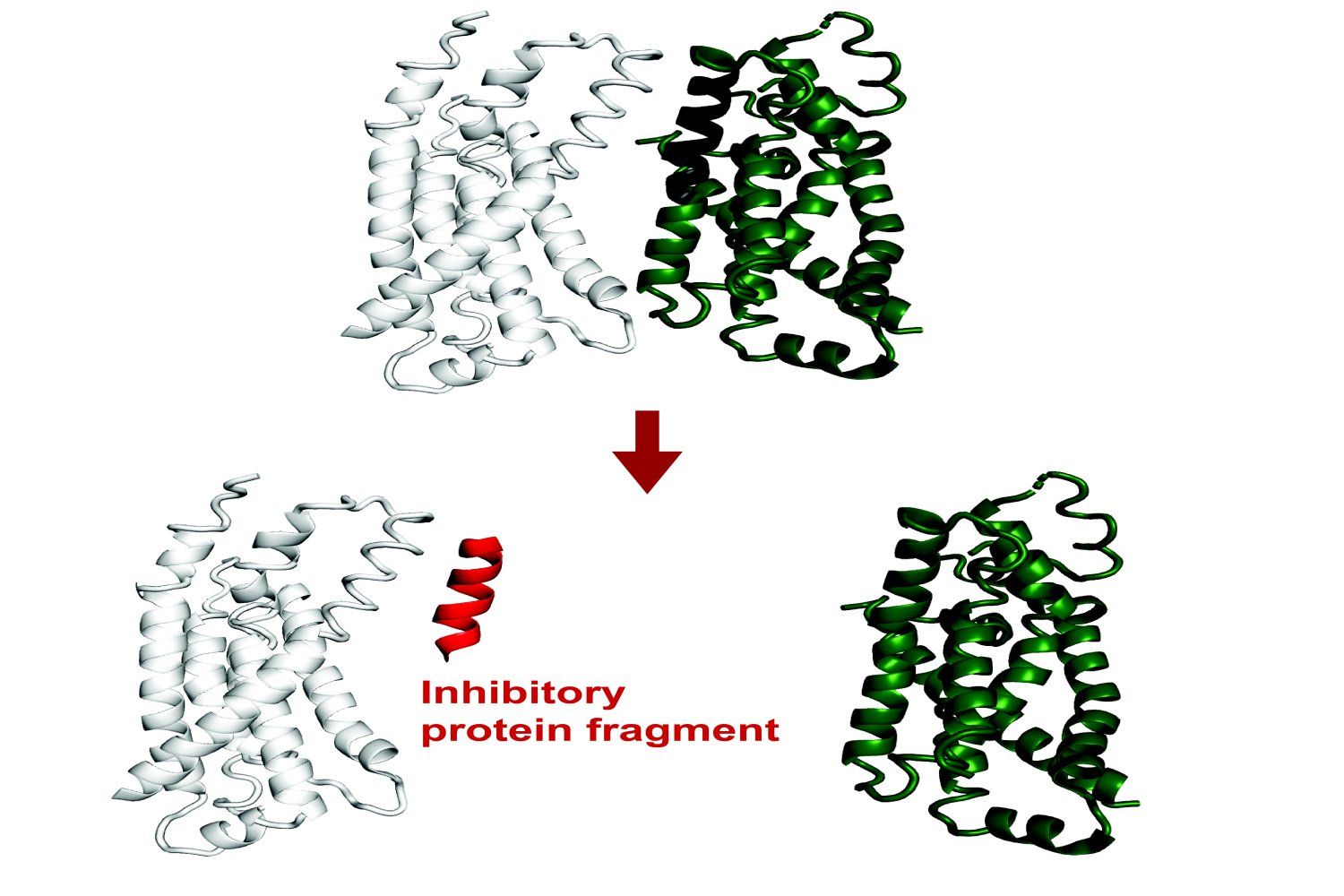

El MIT desarrolla un sistema de IA para predecir la unión de fragmentos de proteínas: Investigadores del MIT han desarrollado un sistema de IA capaz de predecir qué fragmentos de proteínas (péptidos) pueden unirse a una proteína objetivo o inhibir su función. Esto es de gran importancia para el descubrimiento de fármacos y la biotecnología, ayudando a diseñar nuevas terapias o herramientas de diagnóstico. El sistema utiliza machine learning para analizar datos de estructura e interacción de proteínas, identificando secuencias cortas de péptidos con potencial capacidad de unión (Fuente: Ronald_vanLoon)

Grok añade función de memoria de conversación: El asistente de IA de la plataforma X, Grok, anuncia la adición de una función de memoria, capaz de recordar el contenido de las conversaciones históricas del usuario. Esto significa que Grok puede proporcionar respuestas, recomendaciones o sugerencias más personalizadas y coherentes en interacciones posteriores, mejorando la experiencia del usuario (Fuente: grok)

Google anuncia un protocolo abierto para la comunicación entre agentes: Google anuncia el lanzamiento de un protocolo abierto diseñado para permitir que diferentes agentes de inteligencia artificial (AI agents) se comuniquen y colaboren entre sí. Esto es similar al objetivo de MCP (Model Context Protocol), con el fin de romper las barreras entre las aplicaciones de IA y promover flujos de trabajo y ecosistemas de aplicaciones de IA más complejos e integrados (Fuente: Ronald_vanLoon)

🧰 Herramientas

Ajuste en la función de generación de imágenes de ChatGPT: Los usuarios han notado que el botón “Create Image” en la parte inferior de la interfaz de ChatGPT ha sido eliminado, pero la función de generación de imágenes todavía se puede invocar en modelos compatibles (como GPT-4o, o3, o4-mini) mediante prompts explícitos de dibujo o prefijos específicos (como “Por favor, genera una imagen:”). Los modelos GPT-4.5 y o1 pro actualmente no admiten la generación de imágenes de esta manera (Fuente: dotey)

Los IDE de JetBrains integran completado de código LLM local gratuito: JetBrains anuncia una actualización importante para su AI Assistant, ofreciendo un nivel de funcionalidad de IA gratuito en sus productos IDE (como Rider), que incluye completado de código ilimitado y soporte para la integración de modelos LLM locales. Esta medida tiene como objetivo reducir la barrera de entrada para el desarrollo asistido por IA. Al mismo tiempo, los niveles de pago AI Pro y AI Ultimate ofrecen funciones más avanzadas y acceso a modelos en la nube (como GPT-4.1, Claude 3.7, Gemini 2.0) (Fuente: Reddit r/LocalLLaMA)

HypernaturalAI: Una herramienta de IA para la creación de contenido profesional, diseñada para mejorar la eficiencia y la creatividad en escenarios como el marketing de contenidos (Fuente: Ronald_vanLoon)

Demostración de generación de video Kling 2.0: Un usuario comparte un fragmento de video creado con el modelo de generación de video Kling 2.0 lanzado por Kuaishou, mostrando sus efectos de generación (Fuente: op7418)

Framework Cactus para benchmarking de IA en dispositivos: Cactus es un framework diseñado para ejecutar eficientemente modelos de IA en dispositivos de borde (teléfonos, drones, etc.) sin necesidad de conexión a internet. Los desarrolladores lanzaron una demo de aplicación de chat basada en Cactus para probar la velocidad de ejecución (tokens/seg) de diferentes modelos (como Gemma 1B, SmollLM) en varios teléfonos, y proporcionan un enlace de descarga para que los usuarios lo prueben (Fuente: Reddit r/deeplearning)

Práctica de pipeline de IA híbrido con OpenWebUI: Un usuario comparte un caso de éxito en la construcción de un pipeline de IA híbrido utilizando Open WebUI como frontend. El pipeline puede enrutar automáticamente las preguntas de los usuarios a consultas SQL estructuradas (operando DuckDB a través de LangChain SQL Agent) o a una base de datos vectorial (Pinecone) para búsqueda semántica, y utiliza Gemini Flash para generar la respuesta final, logrando una respuesta rápida (Fuente: Reddit r/OpenWebUI)

Problemas con la base de conocimientos y el uso de API en OpenWebUI: Usuarios de Reddit discuten problemas encontrados al usar la función de base de conocimientos (RAG) en OpenWebUI, incluyendo cómo apuntar documentos a un directorio del servidor en lugar de subirlos a través de la web, y cómo obtener y gestionar IDs de archivos en la base de conocimientos a través de la API para lograr la sincronización de archivos (Fuentes: Reddit r/OpenWebUI, Reddit r/OpenWebUI)

Solicitud de ayuda para integrar OpenWebUI con servidor MCP: Un usuario busca ayuda para configurar localmente un servidor Karakeep MCP e integrarlo con OpenWebUI, encontrando dificultades (Fuente: Reddit r/OpenWebUI)

Uso del modo de pensamiento de Grok3 a través de OpenWebUI: Un usuario pregunta si hay alguna forma de habilitar el modo “Think” o “Deepsearch” específico de Grok3 al acceder a la API de Grok a través de OpenWebUI (Fuente: Reddit r/OpenWebUI)

📚 Aprendizaje

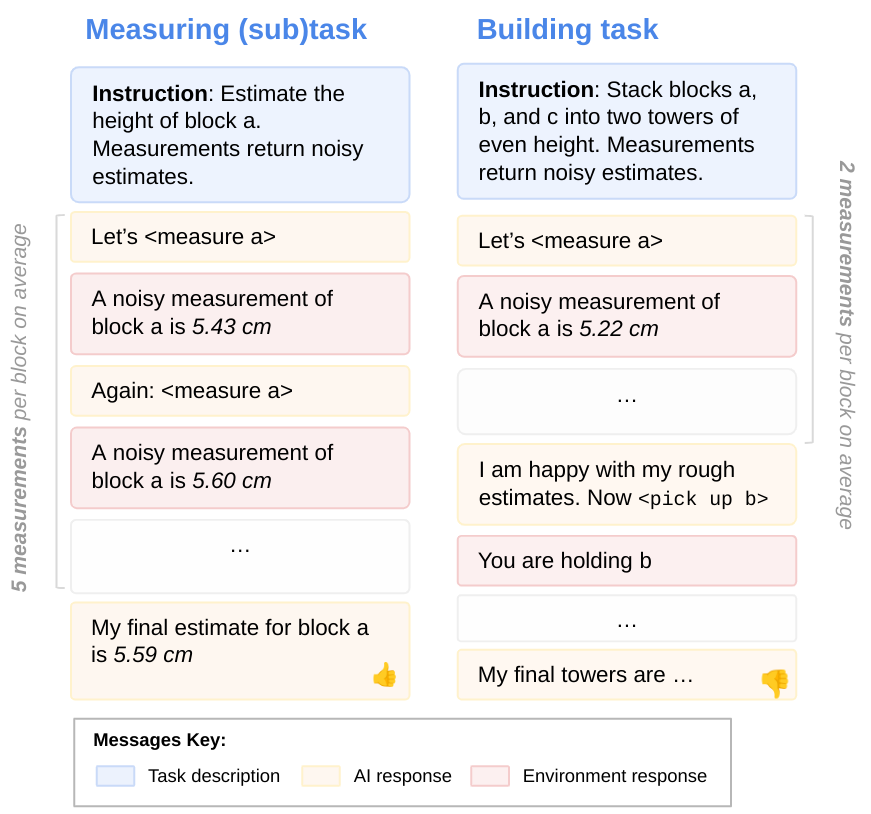

Investigación sobre la orientación a objetivos de los LLM: Investigadores de DeepMind exploran el problema de que los LLM pueden no utilizar plenamente sus capacidades al realizar tareas. Mediante la evaluación de subtareas, descubrieron que los LLM a menudo no aplican completamente las habilidades que poseen, es decir, no están completamente “orientados a objetivos”. Esta investigación ayuda a comprender los mecanismos internos y las limitaciones de los LLM (Fuente: GoogleDeepMind)

Limitaciones de los modelos de IA de vanguardia en tareas físicas: Un estudio centrado en casos de fabricación muestra que los modelos de IA de vanguardia actuales (incluidos los modelos multimodales) tienen un rendimiento deficiente en tareas físicas simples (como la fabricación de piezas de latón), especialmente con deficiencias significativas en el reconocimiento visual y la comprensión espacial. Gemini 2.5 Pro es relativamente el mejor, pero todavía hay una gran brecha. Esto sugiere que el progreso de la IA en la aplicación en el mundo físico puede ir a la zaga del mundo digital, requiriendo nuevas arquitecturas o métodos de entrenamiento para mejorar la comprensión espacial y la eficiencia de las muestras (Fuente: Reddit r/MachineLearning)

Estudio revela deficiencias de la IA en la depuración de código: Aunque la IA ha progresado en la generación de código, una investigación señala que la IA actual tiene un rendimiento deficiente en la depuración de código y aún no puede reemplazar a los programadores humanos. Sin embargo, algunos desarrolladores creen que los LLM son muy útiles para depurar problemas específicos (Fuente: Reddit r/artificial)

Práctica de optimización del rendimiento de LLM local: Qwen2.5-7B alcanza 5000 t/s en doble 3090: Un usuario comparte su experiencia optimizando la velocidad de inferencia de LLM local en dos tarjetas gráficas RTX 3090. Eligiendo el modelo Qwen2.5-7B, aplicando cuantización W8A8 y utilizando el motor Aphrodite, ajustando el número de solicitudes concurrentes (max_num_seqs=32), finalmente logró una velocidad de procesamiento de prompts de hasta aproximadamente 4500 t/s y una velocidad de generación de aproximadamente 825 t/s con una longitud de contexto de aproximadamente 5k. Esto proporciona una referencia de optimización de rendimiento para investigaciones o aplicaciones que necesitan procesar grandes cantidades de datos localmente (Fuente: Reddit r/LocalLLaMA)

Publicación del nuevo mecanismo de atención CALA: Un investigador publica el borrador inicial de su artículo sobre un nuevo mecanismo de atención diseñado llamado “Context-Aggregated Linear Attention” (CALA). CALA tiene como objetivo combinar la eficiencia O(N) de la atención lineal con una mejor percepción local mediante la inserción de un paso de “agregación de contexto local”. El artículo discute su diseño, sus innovaciones en comparación con otros mecanismos de atención y las complejas optimizaciones necesarias (como la fusión de kernels CUDA) para lograr la eficiencia O(N). El investigador espera la participación de la comunidad en la validación y desarrollo posteriores (Fuente: Reddit r/MachineLearning)

![[P] Hoy, para devolver a la comunidad de código abierto, publico mi primer artículo: un novedoso mecanismo de atención, Context-Aggregated Linear Attention, o CALA.](https://rebabel.net/wp-content/uploads/2025/04/yIc61XmsPqdJ02d1eyWbLo9h4fZ3ORdzypEFu1tSkN4.jpg)

Uso de Claude 3.7 Sonnet para evaluar la familiaridad léxica: Un usuario gastó aproximadamente $300 llamando a la API de Claude 3.7 Sonnet para generar un conjunto de datos de puntuación de familiaridad para palabras y frases en inglés en Wiktionary (estimando la proporción de reconocimiento entre estadounidenses mayores de 10 años). El usuario considera que Sonnet supera a otros modelos de primer nivel en esta tarea, distinguiendo mejor entre lenguaje cotidiano y términos especializados. El código del proyecto y el conjunto de datos se han publicado como código abierto, pero el usuario lamenta el alto costo y busca métodos más económicos (Fuente: Reddit r/ClaudeAI)

💼 Negocios

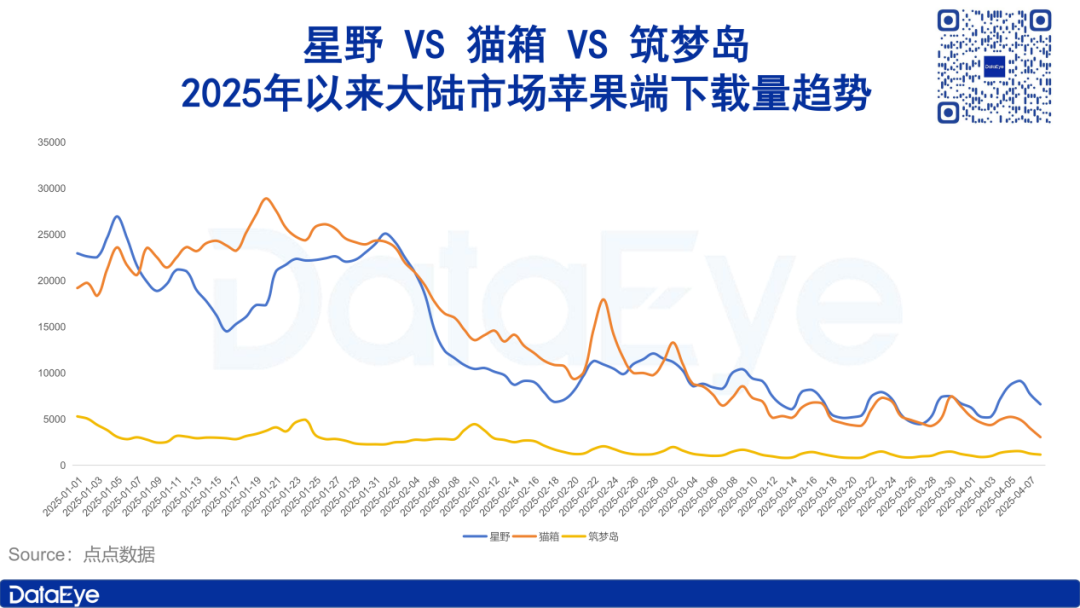

El mercado de aplicaciones de compañía de IA se enfría, con caídas tanto en inversión publicitaria como en descargas: Datos del Instituto de Investigación DataEye muestran que las aplicaciones sociales de compañía de IA representadas por Xingye, Maoxiang y Zhumengdao experimentaron un enfriamiento del mercado a principios de 2025, con caídas significativas tanto en descargas como en inversión publicitaria. La inversión en algunos productos se redujo a la mitad o incluso más drásticamente. El análisis sugiere que las razones incluyen: 1) El enfoque estratégico de la industria de la IA se desplaza hacia modelos de pensamiento profundo como DeepSeek y asistentes de IA, disminuyendo la importancia de la IA social; 2) Grave homogeneización del producto, reduciendo la novedad para los usuarios; 3) El modelo de negocio predominante de suscripción por membresía tiene un atractivo insuficiente. El artículo explora el valor central de la IA social (fuerte valor emocional, valor racional aceptable, valor fisiológico débil) y señala que las direcciones futuras pueden centrarse en la curación emocional o el desarrollo de terminales de compañía de IA (Fuente: DataEye应用数据情报)

Zhipu AI inicia proceso de salida a bolsa, buscando ser la “primera acción de modelo grande”: La empresa de IA Zhipu AI, vinculada a la Universidad de Tsinghua, inició su proceso de salida a bolsa en abril después de recibir múltiples rondas de financiación (incluida una inversión reciente de 1.5 mil millones de capital estatal de Hangzhou y Zhuhai). El artículo analiza sus ventajas: antecedentes técnicos (gen Tsinghua), posicionamiento estratégico (autónomo y controlable, incluido en la lista de entidades de EE. UU.) y sólidos patrocinadores (Fortune Capital temprano, Tencent, Ant Group, Sequoia, Saudi Aramco en etapas intermedias, capital estatal local reciente). Se considera que la elección de salir a bolsa en este momento es una estrategia para consolidar su posición en la industria como la “primera acción de modelo grande” frente al impacto de modelos de bajo costo como DeepSeek, al tiempo que satisface las demandas de retorno de los inversores (especialmente el capital estatal local que impulsa la cotización). Zhipu AI planea lanzar múltiples modelos este año, que sigue siendo un “gran año de gastos”, y la cotización ayuda a resolver problemas de financiación y valoración (Fuente: 真故研究室)

Emprendedores de la Clase Yao de Tsinghua de la era IA 1.0 vuelven a empezar: El artículo repasa la trayectoria empresarial de emprendedores de la Clase Yao de Tsinghua (como Yin Qi de Megvii, Lou Tiancheng de Pony.ai) en la era IA 1.0 (reconocimiento facial, conducción autónoma, etc.), incluyendo la captura temprana de oportunidades tecnológicas, la obtención del favor del capital, pero también enfrentando desafíos como la difícil comercialización, la intensificación de la competencia y los obstáculos para la salida a bolsa. Con el auge de la ola IA 2.0 (modelos grandes, inteligencia corpórea), estos “jóvenes genios” se lanzan nuevamente al emprendimiento, como Yin Qi entrando en el sector de los coches inteligentes (Qianli Tech), y el ex empleado de Megvii, Fan Haoqiang, fundando la empresa de inteligencia corpórea Yuanli Lingji. Continúan el gen de la Clase Yao de desafiar “territorios inexplorados”, intentando encontrar avances en el nuevo ciclo tecnológico, pero también enfrentan una competencia más feroz y dificultades de comercialización (Fuente: 直面AI)

Wuzhao regresa a DingTalk para impulsar reformas, enfatizando el producto y la experiencia del cliente: El fundador de DingTalk, Chen Hang (Wuzhao), inició rápidamente una reestructuración interna tras su regreso. Pone el producto y la experiencia del cliente en primer lugar, exigiendo que los equipos de producto, investigación y diseño revisen exhaustivamente la ruta de experiencia del producto, la comparen con la competencia, y lidera personalmente visitas “encubiertas” a clientes para escuchar comentarios, reiniciando el modelo de “co-creación”. En cuanto a la comercialización, exige investigar todas las rutas de pago, y algunos muros de pago ya han sido eliminados o modificados, mostrando que los objetivos de comercialización ceden ante la experiencia del producto y la innovación en IA. En la gestión, refuerza la disciplina laboral (como exigir la llegada a las 9 a.m.), enfatiza que los gerentes den ejemplo y se sumerjan en la primera línea, se opone a los gerentes puros, simplifica los procesos de reporte (sin PPT) y controla los costos (Fuente: 智能涌现)

Bocha AI: El proveedor de servicios de búsqueda de IA detrás de DeepSeek, desafiando a Bing: Bocha AI proporciona servicios API de búsqueda en red para DeepSeek y más del 60% de las aplicaciones de IA en China. El CEO Liu Xun presentó las diferencias técnicas entre la búsqueda de IA y la búsqueda tradicional (indexación vectorial, clasificación semántica, integración generativa) y enfatizó que su servicio es solo un eslabón intermedio. La competitividad central de Bocha AI radica en el procesamiento de datos, el modelo de reclasificación de desarrollo propio, la arquitectura de alta concurrencia y baja latencia, la ventaja de costos (aproximadamente 1/3 del precio de Bing) y el cumplimiento de datos. Liu Xun cree que la búsqueda de IA impactará el modelo tradicional de clasificación por ofertas de la búsqueda, impulsando a las empresas a pasar del SEO al GEO (centrándose más en la calidad del contenido y la construcción de bases de conocimiento). Juzga que simplemente crear aplicaciones de búsqueda de IA (como Perplexity) no es un buen camino, ya que el modelo de negocio no está claro, mientras que Bocha AI se posiciona como una infraestructura que proporciona capacidades de búsqueda para la IA, con el objetivo de reducir el costo del desarrollo de AGI (Fuente: 腾讯科技)

🌟 Comunidad

Brecha de IA y división política: ¿Por qué “las personas que más odian la IA votaron por Trump”?: El artículo analiza que algunos partidarios de Trump, como los agricultores de los estados agrícolas tradicionales y los trabajadores del cinturón industrial, son grupos afectados por la automatización de la IA, que no han compartido los dividendos tecnológicos y se sienten marginados. Están insatisfechos con el statu quo y esperan las promesas MAGA de Trump (como el regreso de la manufactura, la limitación de los gigantes tecnológicos). El artículo señala que las dificultades de estos grupos se derivan de los ajustes estructurales económicos y la brecha de habilidades provocados por el cambio tecnológico, y que las políticas de la administración Trump (como las barreras arancelarias, la insuficiente educación básica en IA) pueden tener dificultades para resolver realmente el problema, e incluso agravarlo. El autor compara los esfuerzos de China en la inclusión de la IA (como East-Data-West-Computing, la capacitación industrial en IA, los modelos grandes gratuitos, la educación básica en IA), con el objetivo de permitir que toda la población comparta los dividendos tecnológicos y evitar la división social (Fuente: 脑极体)

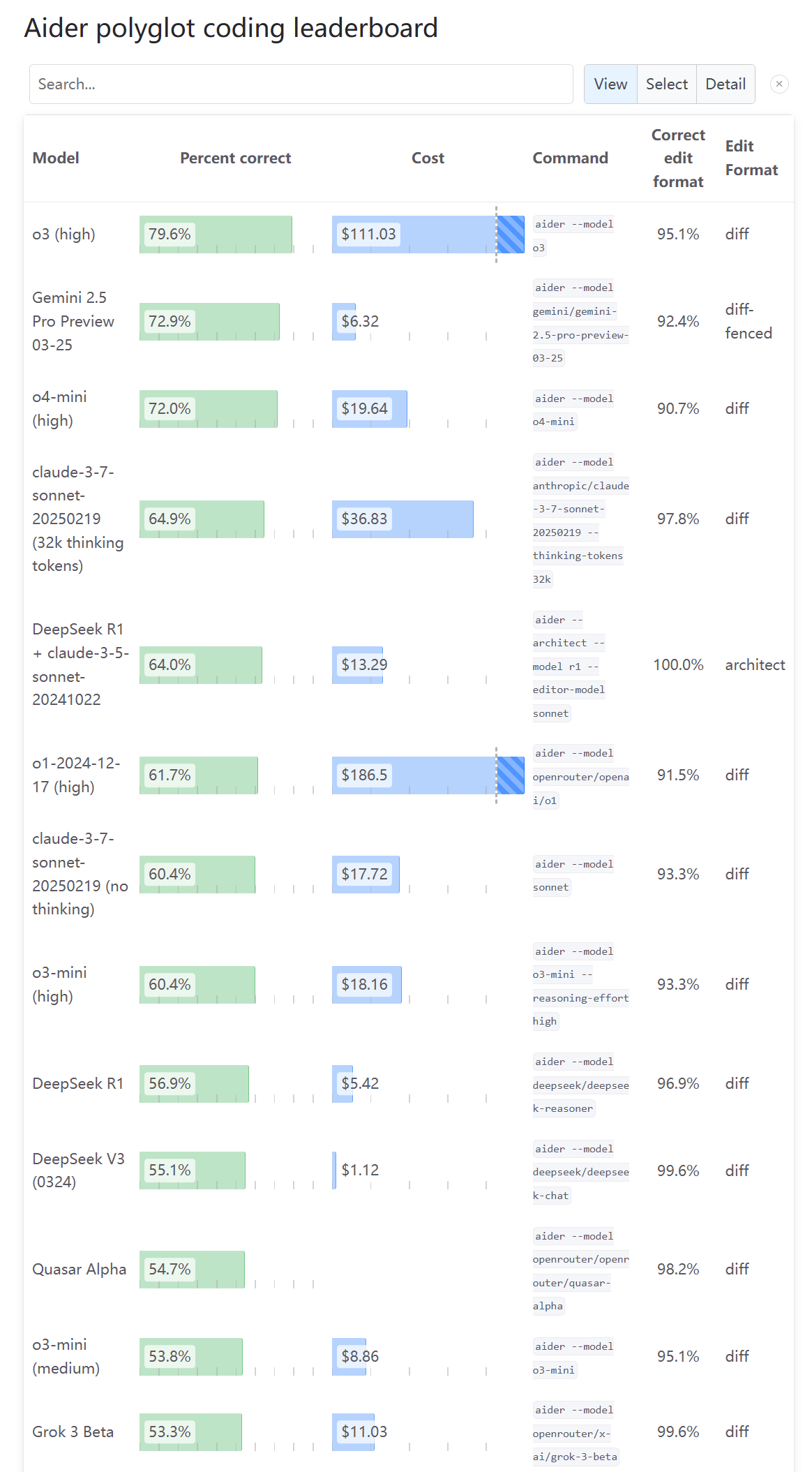

Opiniones divididas en la comunidad sobre la capacidad de programación de o3: Tras la actualización del Aider Leaderboard que muestra la puntuación de la capacidad de programación de o3, un usuario (karminski3) expresó que el resultado no coincide con su propia experiencia de prueba, sugiriendo que más personas lo prueben y den su opinión. Esto refleja que la evaluación de las capacidades del nuevo modelo en la comunidad tiene perspectivas diversas y controversias, y un único benchmark puede no reflejar completamente la experiencia de uso real (Fuente: karminski3)

Usuario descubre que los nuevos modelos de OpenAI “pierden inteligencia” con preguntas en chino: El usuario op7418 informa que al hacer preguntas en chino a los modelos o3 y o4-mini recién lanzados por OpenAI, el rendimiento del modelo es notablemente inferior que al usar inglés, especialmente en tareas que requieren razonamiento de imágenes, donde las preguntas en chino parecen no poder activar su capacidad de análisis de imágenes. El usuario especula que OpenAI podría haber impuesto restricciones o no haber optimizado suficientemente la entrada en chino (Fuente: op7418)

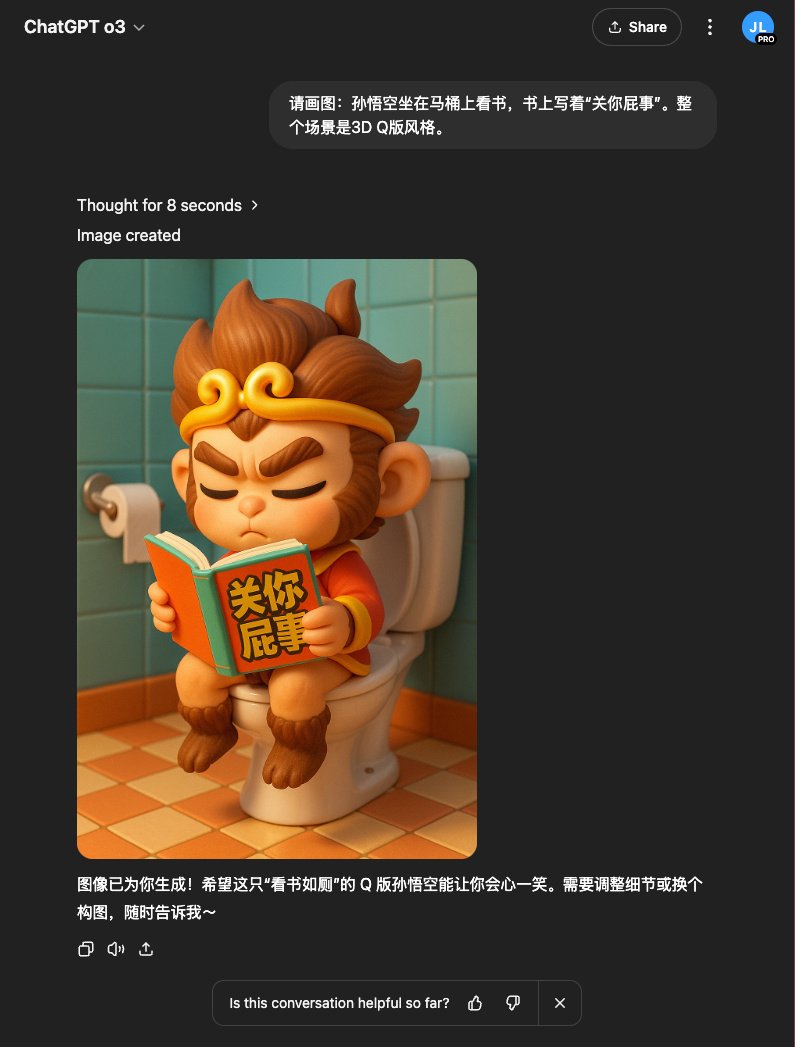

Experiencia de usuario: o3 combinado con DALL-E genera mejores imágenes: El usuario op7418 descubre que usar el modelo o3 en ChatGPT para llamar a la generación de imágenes (posiblemente DALL-E 3) produce mejores resultados que la generación directa, especialmente para conceptos complejos que requieren que el modelo comprenda el conocimiento de fondo (como escenas específicas de novelas). o3 puede comprender primero el contenido del texto y luego generar imágenes más apropiadas (Fuente: op7418)

Usuario comparte cómo eludir las restricciones de contenido de ChatGPT para generar imágenes: Un usuario de Reddit compartió cómo, mediante “inducción” o refinamiento gradual de los prompts, eludió las restricciones de contenido de ChatGPT (DALL-E 3) para generar imágenes cercanas pero que no violan las reglas (como trajes de baño). La sección de comentarios discute las técnicas de este método y las opiniones sobre la razonabilidad de las restricciones de contenido de la IA (Fuente: Reddit r/ChatGPT)

Reacción de la comunidad al lanzamiento de nuevos modelos de OpenAI: Preocupación por la falta de código abierto: En un hilo de Reddit que discute el lanzamiento de o3 y o4-mini por parte de OpenAI, muchos comentarios expresaron insatisfacción con la persistencia de OpenAI en la ruta del código cerrado, argumentando que tiene un significado limitado para la comunidad y los investigadores, y esperando el lanzamiento de modelos de código abierto que se puedan implementar localmente (Fuente: Reddit r/LocalLLaMA)

Usos inesperados y útiles de la IA: Compartidos por la comunidad: Un usuario de Reddit solicitó ejemplos no convencionales pero prácticos de IA. Las respuestas incluyeron: usar IA para psicoterapia, aprender teoría musical, organizar transcripciones de entrevistas y desarrollar líneas argumentales, ayudar a pacientes con TDAH a priorizar tareas, crear canciones de cumpleaños personalizadas para niños, etc., mostrando el amplio potencial de la IA en la vida diaria y escenarios de necesidades específicas (Fuente: Reddit r/ArtificialInteligence)

Humor comunitario: Bromeando sobre el nombramiento de modelos de Nvidia y Llama 2: Un usuario de Reddit publicó bromeando sobre los nombres complejos y difíciles de recordar de los nuevos modelos de Nvidia, y usando un tono irónico para mostrar a Llama 2 en la cima de una tabla de clasificación, bromeando sobre la volatilidad de los benchmarks y las opiniones de la comunidad sobre modelos nuevos y antiguos (Fuentes: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Usuario indeciso entre Claude Max y ChatGPT Pro: Tras el lanzamiento de o3 por parte de OpenAI, un usuario expresó en Reddit su indecisión entre suscribirse a Claude Max o ChatGPT Pro, considerando que o3 podría ser una mejora del potente o1 y podría superar a los modelos actuales. La sección de comentarios discutió las recientes limitaciones de velocidad y problemas de rendimiento de Claude, así como las ventajas y desventajas de cada uno en escenarios específicos como la codificación (Fuente: Reddit r/ClaudeAI)

Humor comunitario: Bromeando sobre la interacción entre IA y usuarios: Un usuario de Reddit compartió una publicación de broma sobre si la IA tiene emociones o conciencia, lo que provocó una discusión relajada entre los miembros de la comunidad sobre la antropomorfización de la IA y las expectativas de los usuarios (Fuente: Reddit r/ChatGPT)

Usuario se queja de que la limitación de capacidad de Claude provoca la pérdida de respuestas: Un usuario de Reddit expresó su insatisfacción con el modelo Claude de Anthropic, señalando que después de que el modelo genera una respuesta completa y útil, la elimina debido a “capacidad excedida”, causando una gran frustración al usuario. Esto refleja que algunos servicios de IA actuales todavía tienen problemas de estabilidad y experiencia de usuario (Fuente: Reddit r/ClaudeAI)

La caída drástica del ranking de Claude en LiveBench genera dudas: Los usuarios notaron que el ranking de la serie de modelos Claude Sonnet en el benchmark de programación LiveBench cayó repentinamente de forma drástica, mientras que el ranking de los modelos de OpenAI subió, lo que generó discusiones sobre la fiabilidad del benchmark y si existen intereses detrás. Los miembros de la comunidad están desconcertados por este fenómeno, sugiriendo posibles cambios en los métodos de prueba o fluctuaciones reales en el rendimiento del modelo (Fuente: Reddit r/ClaudeAI)

Usuario muestra selfies de personajes de videojuegos generados por IA: Un usuario de Reddit compartió una serie de “selfies” creados para personajes de videojuegos conocidos utilizando ChatGPT (DALL-E 3), mostrando la capacidad de la IA para comprender las características de los personajes y generar imágenes creativas. Los usuarios en la sección de comentarios siguieron el ejemplo, generando selfies de sus personajes favoritos, creando una interacción divertida (Fuente: Reddit r/ChatGPT)

¿Puede la IA reemplazar a los ejecutivos? Debate en la comunidad: En Reddit se discute por qué la IA reemplaza prioritariamente a los trabajadores de cuello blanco de nivel básico en lugar de a los ejecutivos de alto salario. Las opiniones incluyen: la capacidad actual de la IA es insuficiente para las complejas decisiones ejecutivas; la estructura de poder determina que los ejecutivos controlan las decisiones de reemplazo; reemplazar a los ejecutivos con IA podría llevar a decisiones más frías y centradas en la eficiencia, no necesariamente beneficiosas para los empleados; y preocupaciones sobre la gobernanza y el control de la IA (Fuente: Reddit r/ArtificialInteligence)

Las herramientas de resumen de IA tienen dificultades para capturar el “destello de genialidad” clave: Un usuario se queja en Reddit de que al usar herramientas de IA (como Gemini o extensiones de Chrome) para resumir podcasts o videos largos, a menudo se obtienen los puntos principales, pero con frecuencia se pierden esas “frases de oro” breves pero muy inspiradoras o momentos clave. El usuario reflexiona si se puede mejorar el efecto del resumen proporcionando retroalimentación y pregunta a otros si han tenido experiencias similares (Fuente: Reddit r/artificial)

La comunidad expresa insatisfacción con la estrategia de lanzamiento de OpenAI: Un usuario de Reddit critica los lanzamientos recientes de OpenAI (como o3/o4-mini, Codex CLI), argumentando que su esencia técnica es la aplicación a escala de métodos conocidos, no una innovación fundamental, y que comercializa excesivamente productos de código cerrado, contribuyendo insuficientemente a la comunidad de código abierto, sin proporcionar un valor de aprendizaje real, sirviendo más a intereses comerciales, lo cual resulta tedioso (Fuente: Reddit r/LocalLLaMA)

ChatGPT “cura” inesperadamente el trastorno de la articulación temporomandibular (TMJ) de un usuario después de cinco años: Un usuario de Reddit compartió una experiencia sorprendente: un chasquido en la mandíbula (síntoma de TMJ) que lo había afectado durante cinco años desapareció en aproximadamente un minuto después de probar un simple ejercicio sugerido por ChatGPT (mantener la lengua contra el paladar mientras abre y cierra la boca simétricamente), y el efecto ha perdurado. El usuario había buscado previamente atención médica y se había sometido a una resonancia magnética sin éxito. Este caso provocó una discusión en la comunidad sobre el potencial de la IA para proporcionar consejos de salud no tradicionales pero efectivos (Fuente: Reddit r/ChatGPT)

💡 Otros

Reflexiones de Kissinger sobre el desarrollo de la IA: Los humanos podrían ser la mayor limitación: El difunto pensador Henry Kissinger y otros exploran en un artículo las posibilidades futuras del desarrollo de la IA, incluida la consecución de la capacidad de planificación, la posesión de “grounding” (conexión fiable con la realidad), la memoria y la comprensión causal, e incluso el desarrollo de una autoconciencia rudimentaria. El artículo advierte que a medida que aumentan las capacidades de la IA, su visión de los humanos podría cambiar, especialmente si los humanos muestran pasividad ante la IA, se obsesionan con el mundo digital y se desconectan de la realidad, la IA podría ver a los humanos como una limitación para el desarrollo en lugar de socios. El artículo también discute las profundas implicaciones de dotar a la IA de forma material y capacidad de acción autónoma, así como los desafíos desconocidos que podría traer la conexión en red de la inteligencia artificial general (AGI), instando a la humanidad a adaptarse activamente en lugar del fatalismo o el rechazo (Fuente: 腾讯研究院)

Demostración de aplicaciones de robots impulsados por IA: Las redes sociales muestran varios ejemplos de aplicaciones de robots impulsados o asistidos por IA, incluyendo un robot desarrollado por Google DeepMind capaz de jugar al ping-pong, brazos robóticos capaces de realizar operaciones finas (como separar la membrana de la cáscara de huevo de codorniz, engastar diamantes, crear arte con un cincel), y robots de formas extrañas (como perros robot, robots insecto controlados inalámbricamente, robots que se mueven usando ruedas Mecanum), mostrando los avances de la IA en la mejora de las capacidades de percepción, decisión y control de los robots (Fuentes: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Discusión sobre la aplicación de la IA en el sector de la salud: Las redes sociales mencionan varios artículos y discusiones sobre la aplicación de la IA en el sector de la salud, centrándose en cómo la IA puede ayudar a los proveedores de servicios médicos a hacer frente a los cambios sociales, el potencial innovador de la IA generativa en el campo médico y direcciones de aplicación específicas (Fuentes: Ronald_vanLoon, Ronald_vanLoon)

Demostración de tecnología conceptual habilitada por IA: Las redes sociales muestran algunas tecnologías o productos conceptuales que integran IA, como el concepto de un coche volador autónomo impulsado por IA, y el posible papel de la IA en futuros escenarios minoristas (Fuentes: Ronald_vanLoon, Ronald_vanLoon)

Los community colleges de EE. UU. se enfrentan a la proliferación de “estudiantes robot”: Se informa que los community colleges de EE. UU. se enfrentan a una gran cantidad de solicitudes de admisión falsas enviadas por robots (posiblemente impulsados por IA), lo que supone un desafío para los sistemas de admisión y gestión de las escuelas, que están buscando soluciones (Fuente: Reddit r/artificial)

La publicación de GPT-4.1 por OpenAI sin informe de seguridad llama la atención: Los medios tecnológicos informan que OpenAI no proporcionó un informe detallado de evaluación de seguridad al lanzar GPT-4.1, como solía hacer al lanzar nuevos modelos. OpenAI podría considerar que el modelo se basa en tecnología existente y que el riesgo es controlable, pero esta medida ha suscitado debates sobre la transparencia y la responsabilidad en la seguridad de la IA (Fuente: Reddit r/artificial)

La aceleración del desarrollo de AGI y el retraso en la seguridad generan preocupación: Un artículo señala que las líneas de tiempo esperadas por la industria de la inteligencia artificial para alcanzar la inteligencia artificial general (AGI) se están acortando, pero al mismo tiempo, la atención y la inversión en cuestiones de seguridad de la IA están relativamente rezagadas, lo que genera preocupaciones sobre los riesgos futuros del desarrollo de la IA (Fuente: Reddit r/artificial)

Se rumorea que EE. UU. considera prohibir DeepSeek: Se informa que la administración Trump podría considerar prohibir el uso del modelo grande chino DeepSeek en EE. UU. y presionar a proveedores como Nvidia que suministran chips a empresas chinas de IA. Esta medida podría basarse en consideraciones de seguridad de datos, competencia nacional y protección de empresas de IA locales (como OpenAI), lo que genera preocupaciones sobre las restricciones tecnológicas y el futuro de los modelos de código abierto (Fuente: Reddit r/LocalLLaMA)

Propuesta para construir un think tank de AI Agents para resolver problemas de IA: Un usuario de Reddit propone la idea de utilizar AI Agents especializados en dominios específicos y con capacidades superiores (ANDSI, Artificial Narrow Domain Superintelligence) para formar un “think tank”, permitiéndoles trabajar en colaboración para abordar específicamente los problemas actuales en el campo de la IA, como eliminar alucinaciones, explorar la fusión de modelos de IA multi-arquitectura, etc. La idea sugiere que utilizar la superinteligencia de la IA para acelerar el propio desarrollo de la IA podría tener más potencial que simplemente usar la IA para reemplazar el trabajo humano (Fuente: Reddit r/deeplearning)

Llamado a AGI de código abierto para salvaguardar el futuro de la humanidad: Un enlace a un video de YouTube cuyo título argumenta que la inteligencia artificial general de código abierto (Open Source AGI) es crucial para asegurar el futuro de la humanidad, sugiriendo que un camino de desarrollo de AGI abierto, transparente y distribuido es más beneficioso para el bienestar humano que una ruta cerrada y centralizada (Fuente: Reddit r/ArtificialInteligence)