Palabras clave:AI, OpenAI, o3/o4-mini modelo, Gemini 2.5 Pro, herramientas de programación AI, tecnología multimodal AI, agente AI inteligente, qué es AI, cómo usar OpenAI, especificaciones del o3/o4-mini modelo, características de Gemini 2.5 Pro, mejores herramientas de programación AI, aplicaciones de tecnología multimodal AI, cómo funcionan los agentes AI inteligentes

🔥 Enfoque

OpenAI anuncia oficialmente o3 y o4-mini, inaugurando una nueva era de “pensar con imágenes”: OpenAI ha lanzado oficialmente su último modelo insignia de “razonamiento”, o3, y su versión simplificada, o4-mini. Estos dos modelos logran por primera vez “pensar usando imágenes”, siendo capaces de incrustar y procesar imágenes (como ampliar, rotar) dentro de la cadena de razonamiento, combinándolas con texto para el análisis. También pueden, por primera vez, combinar y usar de forma autónoma todas las herramientas dentro de ChatGPT (búsqueda web, ejecución de código Python, análisis de archivos, generación de imágenes) para resolver problemas complejos. o3 establece un nuevo SOTA en múltiples benchmarks como Codeforces, SWE-bench, MMMU, destacando especialmente en razonamiento visual y tareas de múltiples pasos, con una tasa de errores graves un 20% menor que o1. o4-mini, con menor latencia y coste, supera a o3-mini en tareas de matemáticas, programación y visión. Al mismo tiempo, OpenAI ha lanzado como código abierto el agente de IA ligero para programación en terminal Codex CLI y ha iniciado un programa de financiación de un millón de dólares. Los nuevos modelos ya están disponibles para usuarios de ChatGPT Plus/Pro/Team y desarrolladores de API, marcando el avance de la IA hacia una mayor capacidad multimodal y de agente. (fuente: OpenAI震撼发布o3/o4-mini,直逼视觉推理巅峰,首用图像思考,十倍算力爆表、openai、sama、karminski3、karminski3、sama、gdb、karminski3、sama、dotey、openai、karminski3、op7418、gdb、

)

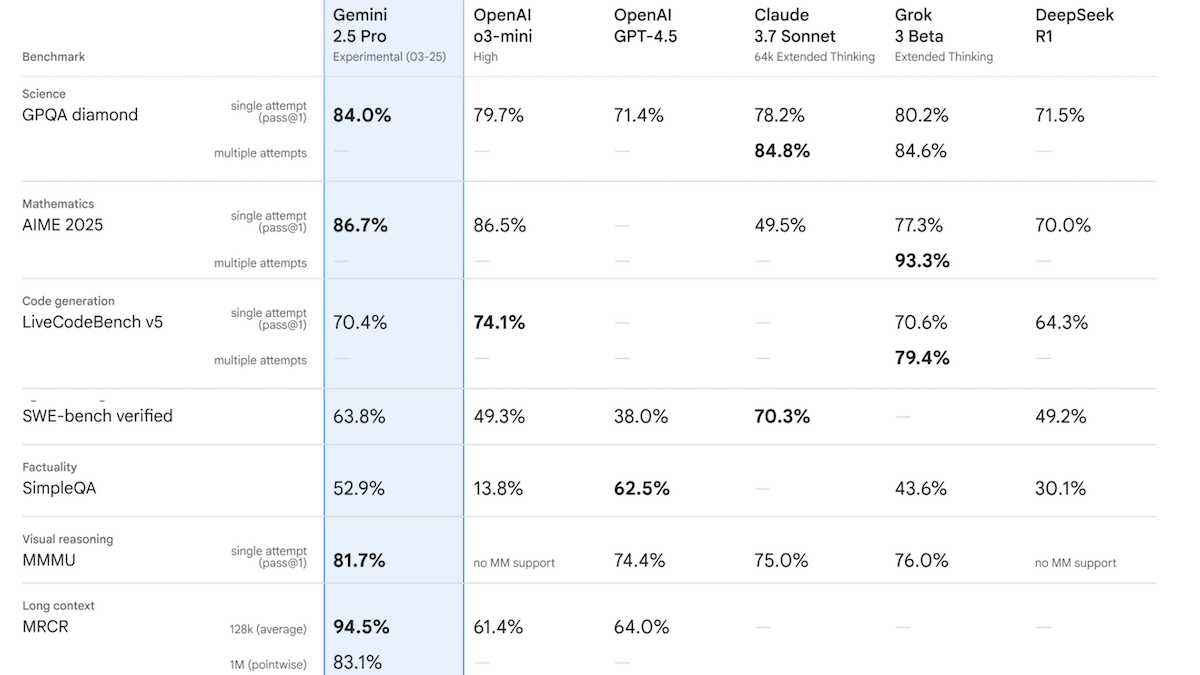

Google lanza Gemini 2.5 Pro Experimental, liderando el rendimiento en Chatbot Arena: Google ha presentado el primer modelo de su familia Gemini 2.5, Gemini 2.5 Pro Experimental, y ha anunciado un avance de la versión de baja latencia Gemini 2.5 Flash. El modelo admite entrada de texto, audio, imagen y vídeo (hasta 1 millón de tokens, con planes futuros de 2 millones), y salida de texto (hasta 65.000 tokens). Su característica destacada es su potente capacidad de razonamiento, lograda mediante la generación de tokens de razonamiento ocultos (cadena de pensamiento) antes de la respuesta. En Chatbot Arena, Gemini 2.5 Pro Experimental supera a GPT-4o y Grok 3 Preview con una puntuación Elo de 1437, situándose en primer lugar. En 12 benchmarks, supera a modelos de primer nivel, incluidos o3-mini, GPT-4.5 y Claude 3.7 Sonnet, en 7 de ellos. Esto indica que los modelos de IA, especialmente los de razonamiento, siguen avanzando rápidamente. Google planea que todos sus futuros modelos nuevos tengan capacidades de razonamiento. (fuente: Google Unveils Gemini 2.5, MCP Gains Momentum, Behind Sam Altman’s Fall and Rise, LLMs That Understand Misspellings)

🎯 Tendencias

OpenAI lanza la serie de modelos GPT-4.1, enfocados en bajo coste y alta eficiencia: OpenAI ha presentado la serie GPT-4.1, que incluye GPT-4.1, GPT-4.1 Mini y GPT-4.1 Nano. Las características clave son la reducción de costes y el aumento de la velocidad. GPT-4.1 Mini supera a GPT-4o en múltiples benchmarks, con una latencia significativamente menor y una reducción de costes del 83%. GPT-4.1 Nano es el primer modelo ultrapequeño, compatible con un contexto de 1 millón de tokens, adecuado para tareas de baja latencia. Los tres modelos aumentan la ventana de contexto de 128K a 1 millón de tokens. En cuanto a precios, GPT-4.1 cuesta $2/$8 por millón de tokens de entrada/salida, un 26% más barato que GPT-4o; Nano cuesta $0.1/$0.4 de entrada/salida. Se considera una medida para competir con rivales como DeepSeek en precios. Al mismo tiempo, el costoso proyecto GPT-4.5 ha sido suspendido. (fuente: 压力给到梁文锋、

)

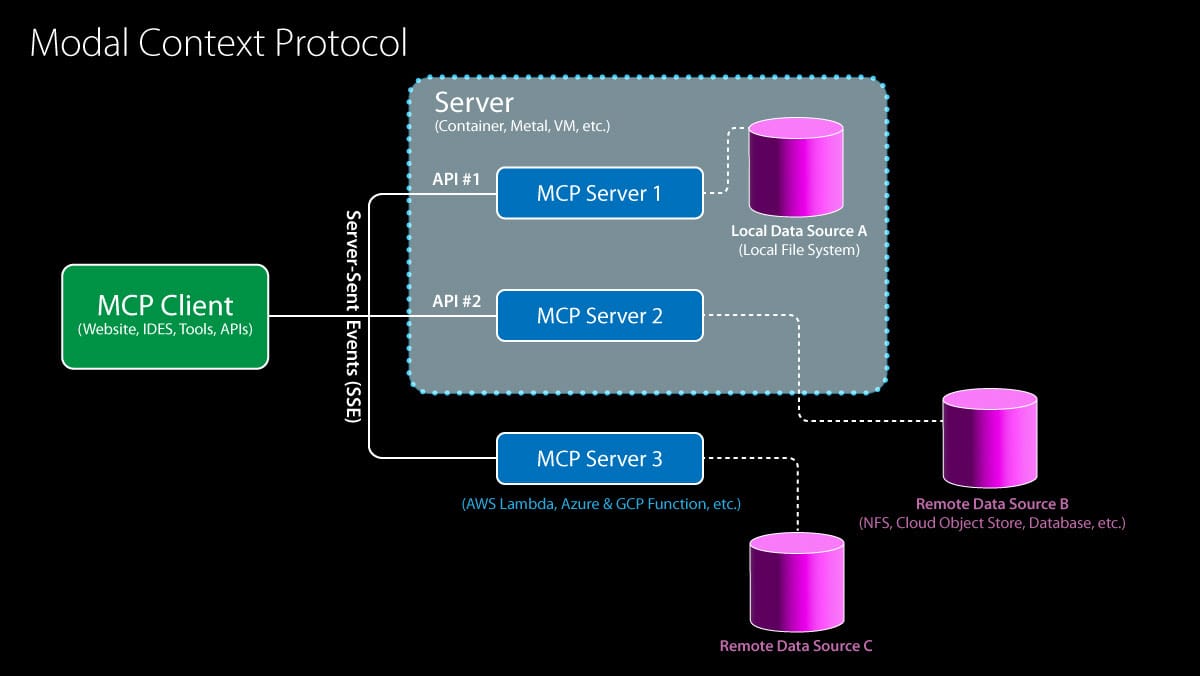

Model Context Protocol (MCP) recibe el apoyo de OpenAI, el ecosistema acelera su integración: OpenAI ha anunciado que soportará el Model Context Protocol (MCP) en su Agents SDK, la aplicación de escritorio de ChatGPT y la Responses API. MCP fue iniciado por Anthropic a finales del año pasado y tiene como objetivo proporcionar un estándar abierto para conectar modelos de IA con herramientas y fuentes de datos. A través de MCP, los modelos pueden acceder a un ecosistema creciente de recursos, incluyendo más de 6000 servidores y conectores construidos por la comunidad (como búsqueda web, operaciones del sistema de archivos). Anteriormente, Microsoft ya había integrado MCP en CoPilot Studio, Cloudflare soporta el despliegue de servidores MCP remotos y el editor de código Cursor también lo soporta. La incorporación de OpenAI impulsará enormemente a MCP para convertirse en el estándar de facto para construir aplicaciones de Agentes de IA, simplificando el proceso para los desarrolladores de integrar diversas herramientas y fuentes de datos de terceros. (fuente: Google Unveils Gemini 2.5, MCP Gains Momentum, Behind Sam Altman’s Fall and Rise, LLMs That Understand Misspellings)

ByteDance lanza Kling 2.0, mejorando los efectos de generación de vídeo: Kling 2.0 es el último modelo de generación de vídeo lanzado por ByteDance. Según los comentarios de los usuarios y las demostraciones, Kling 2.0 muestra un rendimiento excelente en la generación de escenas de vídeo fluidas y realistas, mostrando mejoras en comparación con versiones anteriores y competidores como Sora, especialmente en la conversión de imagen a vídeo. Los usuarios pueden primero usar herramientas como ChatGPT para generar imágenes con buena fidelidad textual, y luego usar Kling 2.0 para convertirlas en vídeos dinámicos. Esto indica que la tecnología de generación de vídeo continúa progresando en coherencia de escena y realismo. (fuente:

)

Google lanza DolphinGemma, explorando el misterio de la comunicación de los delfines: Google AI ha lanzado el proyecto DolphinGemma, con el objetivo de utilizar la tecnología de IA para decodificar los métodos de comunicación de los delfines. El proyecto ha acumulado un enorme conjunto de datos de sonidos de delfines y ha entrenado un modelo de 400 millones de parámetros (que puede ejecutarse en teléfonos Pixel 9) para analizar estos sonidos, buscando patrones y reglas que puedan indicar un lenguaje. La investigación se encuentra actualmente en fase exploratoria, y aún no está claro si los delfines poseen un lenguaje complejo similar al humano, pero ya se han identificado tipos de sonidos asociados a comportamientos específicos (como nombrar, pelear, cortejar). El objetivo final es comprender la estructura y el significado potencial de los sonidos de los delfines e intentar una comunicación bidireccional simple con ellos generando sonidos específicos. (fuente:

)

IBM lanza la serie de modelos Granite 3.3, incluyendo reconocimiento de voz: IBM ha presentado la serie de modelos Granite 3.3, que incluye un modelo de reconocimiento de voz de 8 mil millones de parámetros (Granite Speech 3.3). Este modelo utiliza un enfoque de dos etapas, diseñado para procesar voz sin degradar las capacidades principales del LLM. La nueva familia de modelos tiene como objetivo ofrecer capacidades de razonamiento más refinadas y un rendimiento mejorado de RAG (Retrieval-Augmented Generation), y soporta ajuste fino (fine-tuning) con LoRA. Estos modelos pueden integrarse en asistentes de IA en diversos campos. (fuente: Reddit r/LocalLLaMA)

La IA impulsa una revolución en la predicción meteorológica, la eficiencia de la predicción aumenta significativamente: La inteligencia artificial está cambiando silenciosamente el campo de la predicción meteorológica. Las tareas de predicción que tradicionalmente requerían grandes equipos de expertos y supercomputadoras ahora pueden realizarse con modelos de IA en un ordenador portátil. La IA puede procesar y analizar enormes cantidades de datos meteorológicos, identificar patrones complejos y, por lo tanto, generar predicciones meteorológicas más rápidas y potencialmente más precisas. Esto marca una aplicación importante de la IA en el cálculo científico y la predicción, con el potencial de mejorar la puntualidad y la cobertura de las previsiones. (fuente: Reddit r/ArtificialInteligence)

La aplicación Google Gemini añade soporte para LaTeX: La aplicación Google Gemini se ha actualizado para añadir soporte para LaTeX. Los usuarios ahora pueden usar la sintaxis LaTeX en la aplicación Gemini para mostrar fórmulas matemáticas, símbolos científicos, etc. Esta actualización cubre los modelos Gemini 2.0 Flash y 2.5 Pro, mejorando la utilidad de Gemini en escenarios de comunicación académica y técnica. (fuente: JeffDean)

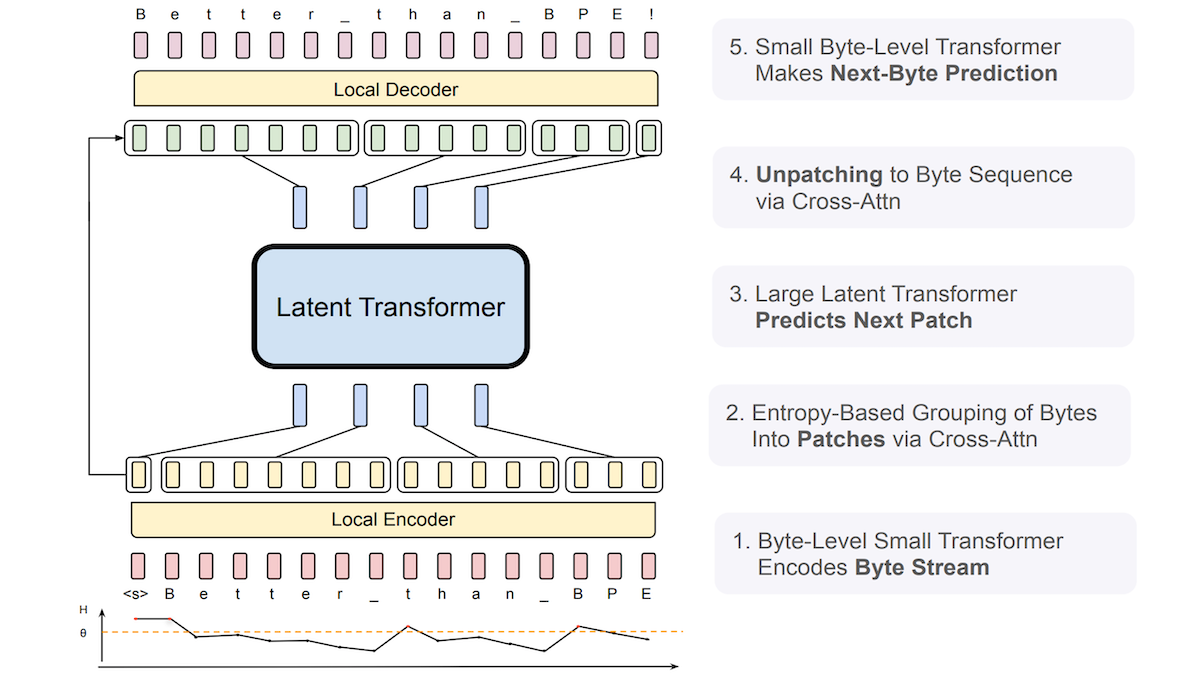

Meta propone Byte Latent Transformer (BLT), mejorando la robustez de los LLM ante entradas ruidosas: Investigadores de Meta y otras instituciones han presentado el Byte Latent Transformer (BLT), diseñado para reemplazar los tokenizadores tradicionales. BLT procesa directamente secuencias de bytes (caracteres), utilizando un pequeño Transformer a nivel de byte para predecir la probabilidad del siguiente byte y utilizando la entropía para agrupar dinámicamente los bytes: baja entropía (alta previsibilidad) se une al grupo actual, alta entropía (baja previsibilidad) inicia un nuevo grupo. El sistema incluye un codificador, un Latent Transformer y un decodificador, con un total de 8 mil millones de parámetros. Los experimentos muestran que BLT supera ligeramente a Llama 3 de tamaño comparable en benchmarks generales de lenguaje y codificación, y muestra una robustez significativamente mayor ante entradas ruidosas como errores ortográficos e idiomas raros, ya que comprende mejor la similitud a nivel de carácter. (fuente: Google Unveils Gemini 2.5, MCP Gains Momentum, Behind Sam Altman’s Fall and Rise, LLMs That Understand Misspellings)

Nueva investigación explora la escalabilidad en tiempo de prueba de la colaboración de razonamiento multiagente: Un paper titulado “Two Heads are Better Than One: Test-time Scaling of Multi-agent Collaborative Reasoning” ha sido enviado a arXiv. La investigación se centra en cómo mejorar el rendimiento en tareas de razonamiento complejo haciendo que múltiples agentes de IA colaboren en tiempo de prueba (inferencia), explorando una vía de escalabilidad que mejora la capacidad del modelo sin aumentar los costes de entrenamiento. (fuente: Reddit r/MachineLearning)

La gobernanza de los agentes de IA se convierte en un nuevo foco de atención: A medida que aumentan las capacidades de la IA agéntica (Agentic AI), cómo gobernarlos eficazmente se convierte en un tema importante. Esto implica asegurar que el comportamiento de los agentes cumpla con las expectativas, sea seguro, controlable y respete las normas éticas. Es necesario establecer marcos, estándares y mecanismos de regulación correspondientes para gestionar estas “mentes sintéticas” capaces de actuar y tomar decisiones de forma autónoma. (fuente: Ronald_vanLoon)

La IA genera imágenes de alta calidad más rápido que los métodos SOTA actuales: Investigadores del MIT han desarrollado una nueva herramienta de inteligencia artificial que puede superar a los métodos más avanzados (SOTA) actuales en la generación de imágenes de alta calidad, y además lo hace más rápido. Esto indica que en el campo de la generación de imágenes, la eficiencia y la calidad continúan logrando avances. (fuente: Ronald_vanLoon)

xAI introduce una función similar a Canvas para Grok AI: xAI ha añadido una característica similar a ChatGPT Canvas a su chatbot Grok AI. Las funciones tipo Canvas suelen ofrecer una interfaz de lienzo infinito, permitiendo a los usuarios organizar e interactuar con la información de forma más libre y visual, combinando texto, código, imágenes, etc. Esta medida hace que Grok compita con ChatGPT en la experiencia de interacción del usuario, y la función se ofrece de forma gratuita. (fuente: Reddit r/ArtificialInteligence)

🧰 Herramientas

Anx Reader: Lector de libros electrónicos multiplataforma con integración de múltiples motores de IA: Anx Reader es un lector de libros electrónicos que soporta múltiples formatos como EPUB, MOBI, AZW3, FB2, TXT, y se puede usar en iOS/macOS/Windows/Android. Su característica distintiva es la integración de diversas capacidades de IA de OpenAI, Claude, Gemini, DeepSeek, etc., que se pueden usar para resumir contenido, hacer preguntas, obtener información rápidamente, etc. La aplicación soporta la sincronización del progreso de lectura, archivos de libros y notas mediante WebDAV, ofrece estilos de lectura altamente personalizables (interlineado, fuente, esquema de color, etc.), e incluye funciones como lectura TTS, traducción, búsqueda, registro de ideas. Dedicado a proporcionar una experiencia de lectura inteligente, enfocada y personalizada. (fuente: Anxcye/anx-reader – GitHub Trending (all/daily))

OpenAI lanza como código abierto Codex CLI: Agente de IA ligero para programación que se ejecuta localmente: Coincidiendo con el lanzamiento de o3/o4-mini, OpenAI ha lanzado como código abierto Codex CLI, un agente de IA para programación que se ejecuta en la terminal. Permite a los desarrolladores usar instrucciones en lenguaje natural para que la IA ejecute tareas de codificación directamente en su ordenador local, como escribir código, instalar dependencias, configurar entornos, corregir errores, etc. Codex CLI está diseñado para aprovechar al máximo las potentes capacidades de razonamiento de modelos como o3/o4-mini, y puede combinar entradas multimodales (como capturas de pantalla) con acceso al código local. La herramienta tiene como objetivo simplificar el flujo de trabajo de desarrollo, siendo especialmente amigable para principiantes. OpenAI también ha lanzado un programa de financiación de 1 millón de dólares para apoyar proyectos basados en esta herramienta. (fuente: OpenAI震撼发布o3/o4-mini,直逼视觉推理巅峰,首用图像思考,十倍算力爆表、sama、karminski3、dotey、sama、dotey)

Los modelos de Cohere llegan a Hugging Face Hub, ofreciendo servicios de inferencia: Cohere ha anunciado que sus modelos son el primer proveedor de inferencia de terceros compatible en Hugging Face Hub. Los usuarios ahora pueden acceder directamente a los modelos de código abierto de Cohere (como la serie Aya) y modelos empresariales (como la serie Command) en el Hub y realizar inferencias rápidas. Estos modelos son especialmente buenos en el uso de herramientas y capacidades multilingües, y ofrecen una interfaz compatible con OpenAI, facilitando a los desarrolladores la integración y construcción de aplicaciones. (fuente: huggingface、huggingface、huggingface)

LocalAI v2.28.0 lanzado, y presenta la plataforma de agentes de IA local LocalAGI: LocalAI, como servidor para ejecutar LLMs localmente y ofrecer una API compatible con OpenAI, se actualiza a la v2.28.0. Al mismo tiempo, lanza la nueva plataforma LocalAGI. LocalAGI es una plataforma de orquestación de agentes de IA autoalojada con una WebUI, que permite a los usuarios construir flujos de trabajo complejos de agentes de IA de múltiples pasos (similar a AutoGPT). La clave es que estos agentes pueden ser impulsados por LLMs locales proporcionados a través de LocalAI u otras API compatibles (como llama-cpp-python). Junto con el repositorio de memoria local LocalRecall, los usuarios pueden ejecutar agentes de IA autónomos en un entorno completamente localizado, realizando tareas como investigación, codificación, procesamiento de contenido, etc. (fuente: Reddit r/LocalLLaMA)

Framework Droidrun de código abierto: controlar teléfonos Android con IA: Droidrun es un framework que permite a los usuarios usar IA (como grandes modelos de lenguaje) para controlar un teléfono Android y ejecutar tareas, ahora disponible como código abierto en GitHub. Los usuarios pueden usar instrucciones en lenguaje natural para que la IA realice operaciones en el teléfono, como abrir aplicaciones, hacer clic en botones, introducir texto, etc. Esto requiere la instalación de la herramienta ADB (Android Debug Bridge). El framework muestra nuevas posibilidades de la IA en la automatización e interacción de dispositivos móviles. (fuente: karminski3)

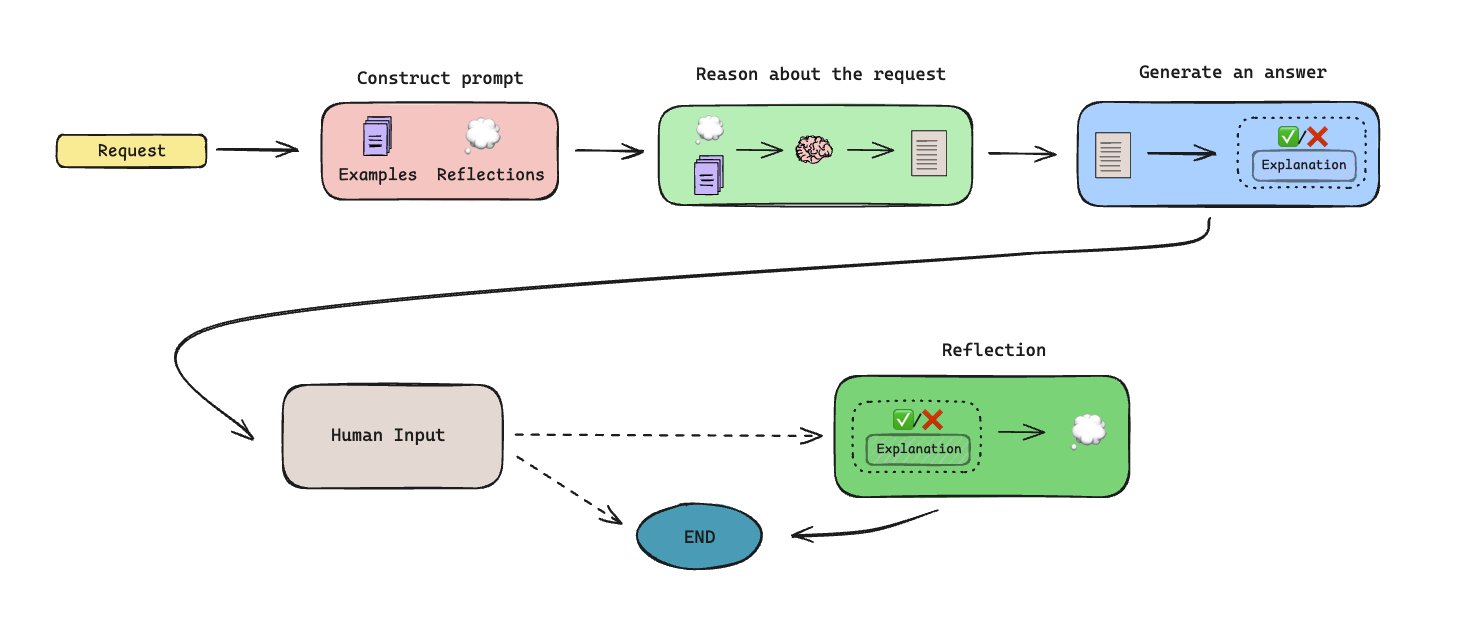

Lanzamiento de LLManager: Flujo de trabajo de aprobación automatizado basado en memoria: LLManager es un flujo de trabajo de código abierto construido con LangGraph, diseñado para automatizar tareas de aprobación mediante agentes de IA con capacidad de memoria. El sistema puede generar memoria a través de la colaboración humano-en-el-bucle (human-in-the-loop), aprendiendo y mejorando así las decisiones de aprobación con el tiempo. El diseño arquitectónico le permite manejar procesos de aprobación repetitivos, aumentando la eficiencia. (fuente: LangChainAI)

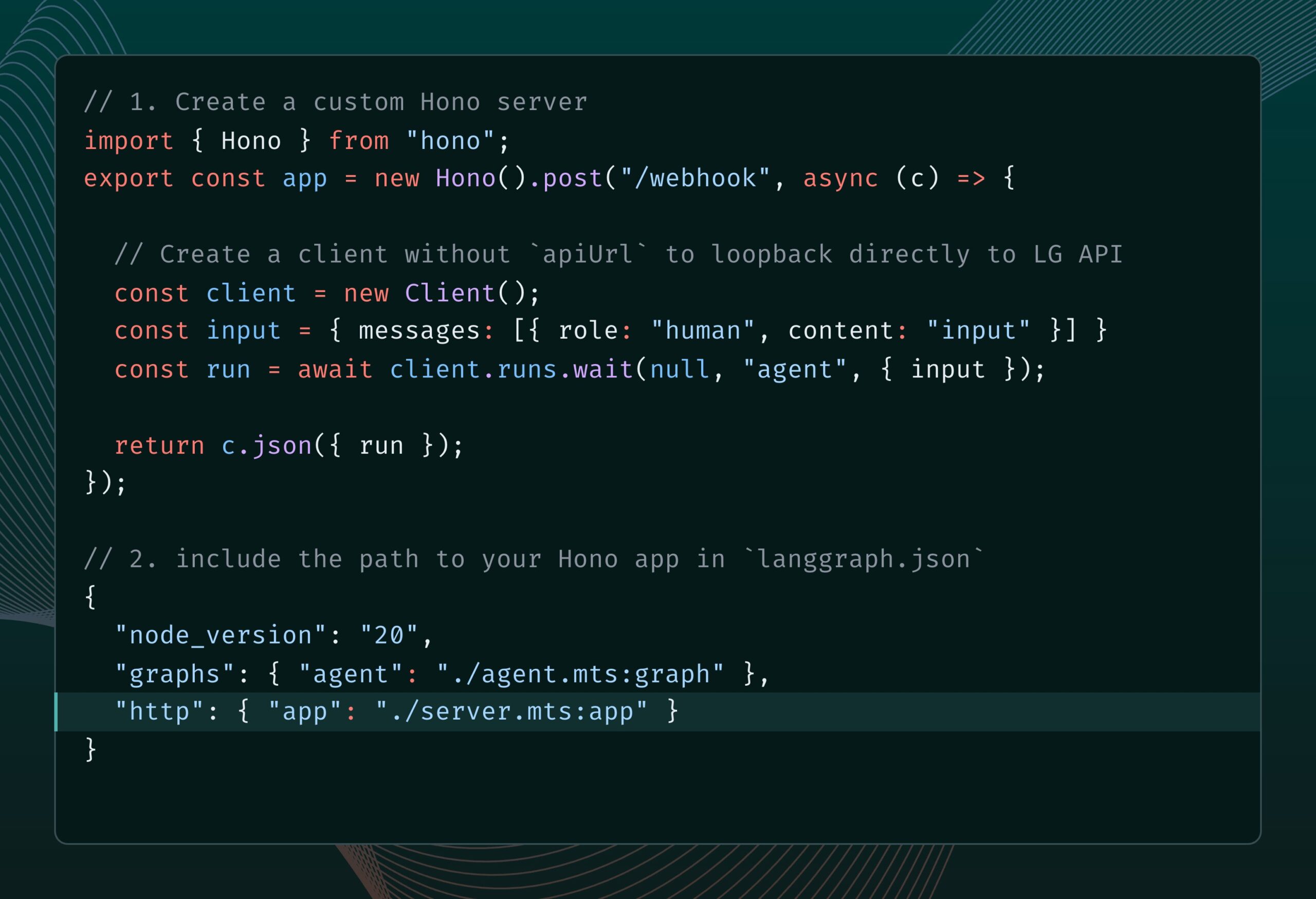

LangGraph.js se integra con Hono, soportando rutas HTTP personalizadas y middleware: LangGraph.js (la versión JS de la biblioteca de LangChain para construir aplicaciones multiagente con estado) ahora puede integrarse con Hono (un framework web ligero). Esto permite a los desarrolladores añadir rutas HTTP personalizadas y middleware a sus aplicaciones LangGraph.js, permitiendo construir servicios backend más complejos, como manejar webhooks, crear aplicaciones API completas, etc., expandiendo los escenarios de aplicación de LangGraph.js. (fuente: LangChainAI)

El robot humanoide de código abierto Reachy 2 comienza a venderse: Clem Delangue, cofundador de Hugging Face, anunció que el primer robot humanoide de código abierto en el que su equipo ha participado, Reachy 2, ha comenzado a venderse esta semana. El robot tiene un precio de 70.000 dólares, dirigido al mercado de investigación y educación, y ya se utiliza en la Universidad de Cornell, la Universidad Carnegie Mellon y los principales laboratorios de IA. Tiene forma humanoide, base de movimiento omnidireccional, abundantes sensores (cámaras, micrófonos, LiDAR, etc.), basado en ROS 2 y LeRobotHF, soporta Python SDK, y su diseño modular permite la personalización. (fuente: huggingface)

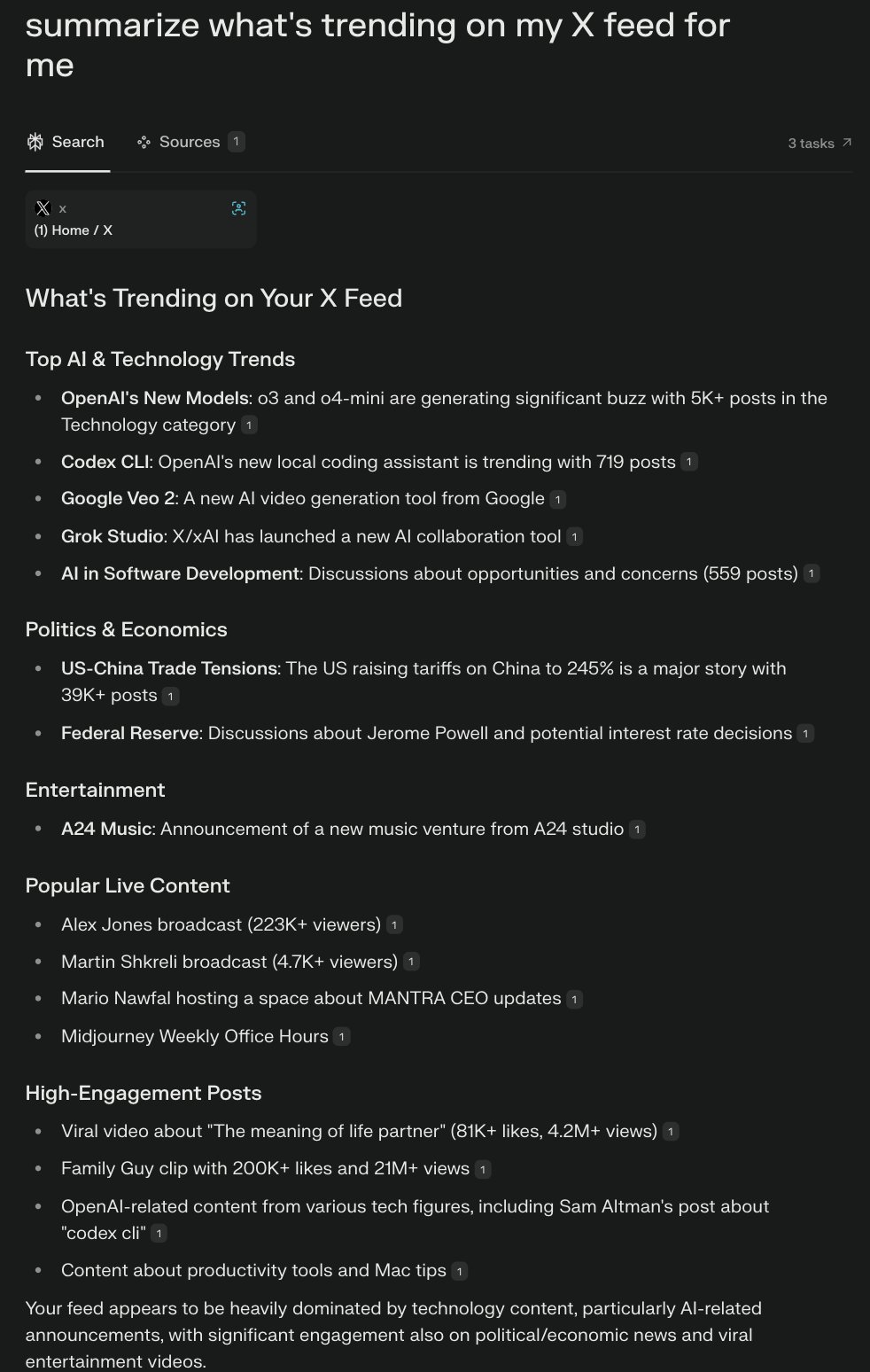

Perplexity lanza el navegador Comet, explorando una experiencia de navegación nativa de IA: Arav Srinivas, CEO de Perplexity, está desarrollando un navegador llamado Comet y buscando ideas sobre crecimiento del producto y funcionalidades. Comet tiene como objetivo ser una manifestación de un “sistema operativo agéntico” (agentic OS), controlando aplicaciones web y datos a través del navegador, utilizando la IA para responder preguntas y ejecutar tareas. La idea es que, dado que la mayoría de las aplicaciones están en la Web, la IA que controla el navegador puede controlar la mayor parte de la vida digital. El proyecto enfatiza empezar poco a poco, evitando prometer en exceso capacidades generales. (fuente: AravSrinivas、AravSrinivas、AravSrinivas、AravSrinivas、AravSrinivas)

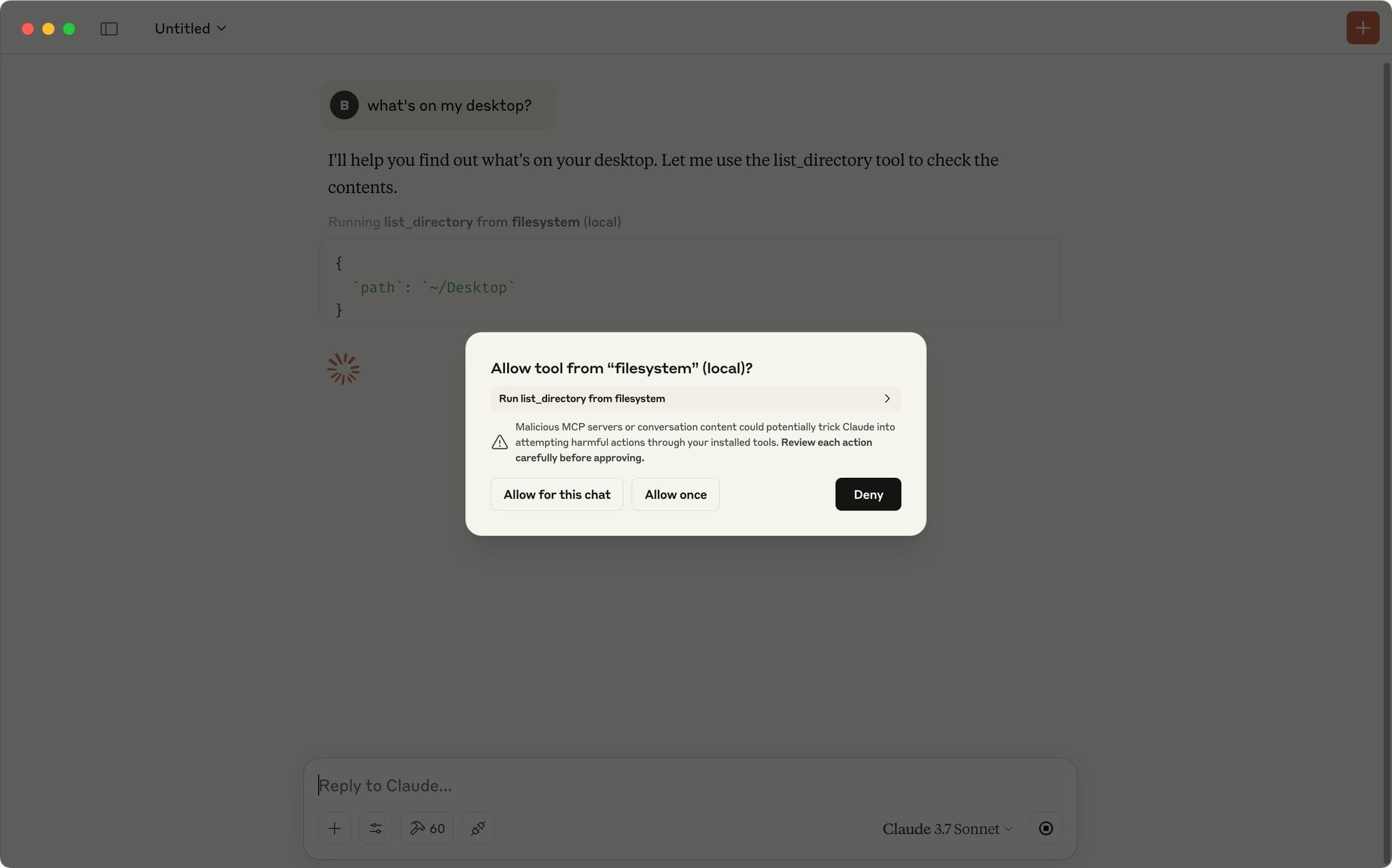

La aplicación Claude soporta script para aprobar automáticamente solicitudes MCP: Un usuario de la comunidad compartió un script de JavaScript que se ejecuta en la consola de herramientas de desarrollador de la aplicación Claude y puede aprobar automáticamente solicitudes MCP (Model Context Protocol) de una lista predefinida de herramientas de confianza. Para los usuarios que utilizan frecuentemente herramientas locales o remotas específicas, esto puede ahorrar la molestia de hacer clic manualmente en “Permitir” cada vez, mejorando la eficiencia del flujo de trabajo. Sin embargo, los usuarios deben ser conscientes de los riesgos de seguridad y habilitarlo solo para herramientas de total confianza. (fuente: Reddit r/ClaudeAI)

Recomendaciones de servidores MCP imprescindibles para ayudar en la codificación y automatización de flujos de trabajo: Un usuario de la comunidad compartió una serie de servidores MCP (Model Context Protocol) recomendados. Estas herramientas pueden integrarse con modelos de IA compatibles con MCP (como Claude) o frameworks de Agentes para mejorar la eficiencia de la codificación y las capacidades de automatización. La lista recomendada incluye: Sequential Thinking MCP para pensamiento estructurado, Puppeteer MCP para interacción web, Memory Bank MCP para gestión del conocimiento del proyecto, Playwright MCP para pruebas entre navegadores, GitHub MCP para operaciones de GitHub, Knowledge Graph Memory MCP para memoria persistente, DuckDuckGo MCP para búsqueda sin clave API, y MCP Compass para descubrir más herramientas MCP. (fuente: Reddit r/ClaudeAI)

📚 Aprendizaje

Repositorio de GitHub: Guía completa de técnicas avanzadas de RAG: El repositorio de GitHub RAG_Techniques creado por Nir Diamant proporciona la colección más completa hasta la fecha de tutoriales sobre técnicas avanzadas de Retrieval-Augmented Generation (RAG). El repositorio tiene como objetivo mejorar la precisión, eficiencia y riqueza contextual de los sistemas RAG, cubriendo más de 30 técnicas, desde implementaciones básicas (LangChain/LlamaIndex), optimización de la fragmentación de texto (tamaño fijo, fragmentación proposicional, fragmentación semántica), mejora de consultas (transformación, HyDE, HyPE), enriquecimiento de contexto (encabezados de bloque, extracción de segmentos relevantes, expansión de ventana, mejora de documentos), hasta recuperación avanzada (fusión, reordenamiento, filtrado multifacético, indexación jerárquica, integración, multimodal), técnicas iterativas (bucles de retroalimentación, adaptativo, recuperación iterativa), evaluación (DeepEval, GroUSE), explicabilidad y arquitecturas avanzadas (Graph RAG, RAPTOR, Self-RAG, CRAG), y proporciona implementaciones en Jupyter Notebook o scripts de Python. El proyecto es impulsado por la comunidad y se anima a contribuir. (fuente: NirDiamant/RAG_Techniques – GitHub Trending (all/daily))

DeepLearning.AI lanza un nuevo curso: Construcción de Agentes de Navegador con IA: Andrew Ng anunció una colaboración con AGI Inc. para lanzar un nuevo curso corto “Building AI Browser Agents”. El curso, impartido por los cofundadores de AGI Inc., Div Garg y Naman Garg, tiene como objetivo enseñar cómo construir agentes de IA capaces de interactuar con sitios web y realizar tareas (como extraer información, rellenar formularios, hacer clics, realizar pedidos). El contenido del curso incluye cómo funcionan los Web Agents, su arquitectura, limitaciones, estrategias de decisión, construcción práctica de un Web Agent para extraer cursos de DeepLearning.AI y generar una salida estructurada, construcción de un Agente autónomo para completar múltiples tareas (buscar y resumir páginas web, rellenar formularios, suscribirse), exploración del framework AgentQ (que combina Monte Carlo Tree Search MCTS y Direct Preference Optimization DPO para lograr la autocorrección), profundización en los principios de MCTS, y discusión sobre el estado actual y futuro de los Agentes de IA. (fuente: AndrewYNg)

Hugging Face actualiza la documentación de cuantificación, ofreciendo guías conceptuales y benchmarks de selección: Hugging Face ha actualizado significativamente su documentación sobre cuantificación de modelos. La nueva documentación tiene como objetivo ayudar a los usuarios a comprender mejor los conceptos de cuantificación y seleccionar la tecnología adecuada según sus necesidades. Las actualizaciones incluyen: explicación de los fundamentos de la cuantificación (como esquemas, int4, FP8), nueva guía de selección (para ayudar a elegir entre tecnologías como bnb, AWQ, GPTQ, HQQ según las necesidades y el hardware), y datos comparativos de benchmarks de precisión y rendimiento para los modelos Llama 3.1 8B y 70B utilizando métodos populares de cuantificación. Esto proporciona una referencia valiosa para los desarrolladores que desean comprimir modelos y mejorar la eficiencia de la inferencia. (fuente: huggingface)

Nuevo método MODE: alternativa ligera y explicable a RAG: El investigador independiente Rahul Anand ha propuesto un nuevo método llamado MODE (Mixture of Document Experts) como una alternativa ligera al proceso tradicional de RAG. MODE no depende de bases de datos vectoriales ni de rerankers, sino que extrae información mediante la agrupación (clustering) de documentos y el uso de recuperación basada en centroides. Se dice que este método es eficiente y con fuerte explicabilidad, especialmente adecuado para conjuntos de datos de tamaño pequeño a mediano. El autor busca el respaldo de arXiv (en el área cs.AI) para publicar el paper. (fuente: Reddit r/MachineLearning)

Repositorio de GitHub Beyond-NanoGPT: Recursos avanzados para pasar de principiante en LLM a investigador de IA: Tanishq Kumar ha publicado como código abierto un repositorio de GitHub llamado beyond-nanoGPT. El proyecto tiene como objetivo ayudar a los aprendices que ya dominan los fundamentos de LLM a nivel de nanoGPT a comprender e implementar ideas complejas cercanas a la vanguardia de la investigación en deep learning. El repositorio contiene miles de líneas de código PyTorch comentado, implementando desde cero diversos avances modernos en la investigación de ML, incluyendo decodificación especulativa (speculative decoding), Transformers visuales/de difusión, atención lineal/dispersa, etc. El objetivo del proyecto es ayudar a más personas a hacer la transición al campo de la investigación en IA. (fuente: Reddit r/MachineLearning)

Tutorial: Entrenar un chatbot basado en repositorios de GitHub usando AI Scraper y LLM: Un artículo publicado en el blog Stackademic describe cómo usar AI Scraper (una herramienta de web scraping) y grandes modelos de lenguaje (LLM) para entrenar un chatbot capaz de responder preguntas sobre un repositorio específico de GitHub. Este método generalmente implica extraer información del repositorio como código, documentación (p.ej., README), Issues, etc., procesarla en un formato adecuado para que el LLM la comprenda, y luego usar RAG (Retrieval-Augmented Generation) o fine-tuning para que el chatbot pueda responder preguntas basándose en esa información. (fuente: Reddit r/ArtificialInteligence)

Análisis de paper: Uso de Layer-Wise Relevance Propagation (LRP) para IA explicable (XAI) en datos tabulares: Un artículo de blog explora cómo usar la técnica Layer-Wise Relevance Propagation (LRP) para explicar el proceso de toma de decisiones de los modelos de deep learning al manejar datos tabulares. LRP es un método de atribución que tiene como objetivo descomponer la predicción de salida del modelo en las características de entrada, revelando así qué características contribuyen más a la decisión final. Aplicarlo a datos tabulares ayuda a comprender el comportamiento del modelo, mejorando la transparencia y la confianza. (fuente: Reddit r/deeplearning)

💼 Negocios

Zhipu AI inicia la tutoría para la salida a bolsa, planeada para completarse dentro del año: La empresa china de IA Zhipu AI ha iniciado oficialmente el registro de tutoría para la salida a bolsa, con CICC actuando como institución tutora. Según el informe de registro, Zhipu AI planea completar la tutoría para la IPO entre agosto y octubre de 2025. Anteriormente, el CEO de la compañía, Zhang Peng, había declarado que el camino hacia la AGI es largo, la financiación obtenida es solo “fondos para el viaje”, y se necesitará más capital en el futuro. Esta IPO se considera un paso clave para obtener “más fondos para el viaje”. Zhipu AI es un jugador importante en el campo de los grandes modelos de lenguaje en China, y su proceso de IPO atrae mucha atención. (fuente: 压力给到梁文锋)

Startup de 2 personas Gumloop completa una financiación de más de 100 millones de yuanes (aprox. 17 millones de USD) usando IA: La plataforma sin código Gumloop, con solo los dos fundadores como empleados formales, ha completado recientemente una ronda de financiación Serie A de 17 millones de dólares (aprox. 124 millones de yuanes). La compañía se originó para proporcionar una UI fácil de usar para Auto-GPT, luego evolucionó a una plataforma de construcción de flujos de trabajo de IA para personal no técnico llamada AgentHub, capaz de integrar herramientas como GitHub, Gmail, etc., para automatizar tareas como procesamiento de documentos, web scraping, SEO, CRM, marketing por correo electrónico. La propia empresa utiliza intensivamente Agentes de IA para gestionar sus operaciones, y el objetivo de los fundadores es construir una empresa valorada en 1.000 millones de dólares con un equipo de no más de 10 personas. Esto refleja la posibilidad en la era de la IA de que equipos pequeños logren alta eficiencia y gran valor utilizando herramientas de IA, y la oportunidad empresarial de resolver el problema de la “última milla” en la implementación de aplicaciones de IA. (fuente: 把AI当成“牛马”,2人创业团队,拿下了超1亿元融资)

Se rumorea que OpenAI planea adquirir la empresa de herramientas de programación de IA Windsurf (antes Codeium) por 3.000 millones de dólares: Según fuentes familiarizadas con el asunto citadas por Bloomberg, OpenAI está en conversaciones para adquirir la empresa de herramientas de programación asistida por IA Windsurf (anteriormente Codeium) por aproximadamente 3.000 millones de dólares. Si el acuerdo se concreta, sería la adquisición más grande en la historia de OpenAI, con el objetivo de fortalecer su competitividad en el mercado de asistentes de programación de IA, compitiendo directamente contra Anthropic, GitHub Copilot, Anysphere (Cursor), etc. Windsurf fue fundada en 2021, previamente valorada en 1.250 millones de dólares, y ya ha obtenido más de 200 millones de dólares en financiación. Este rumor de adquisición también indica una posible intensificación de la consolidación en el campo de las herramientas de programación de IA. (fuente: dotey)

Se informa que la empresa Safe Superintelligence de Ilya Sutskever está valorada en 32.000 millones de dólares: Según informa TechCrunch, la nueva empresa Safe Superintelligence (SSI), fundada por el cofundador de OpenAI Ilya Sutskever, alcanzó una valoración de 32.000 millones de dólares en una reciente ronda de financiación. Se dice que la compañía ha obtenido 2.000 millones de dólares en inversión. El objetivo de SSI es construir superinteligencia de forma segura, y su alta valoración refleja las elevadas expectativas del mercado sobre el talento de IA de primer nivel y la visión de la AGI, a pesar de que la empresa aún no ha lanzado ningún producto. (fuente:

)

La guerra comercial entre EE.UU. y China podría afectar el desarrollo de la IA, el suministro de chips es clave: Algunos análisis sugieren que la guerra comercial de EE.UU. con China, especialmente las restricciones a la exportación de chips de IA de gama alta (como las series H100/B200 de Nvidia), y la posible contramedida de China de limitar las exportaciones de minerales de tierras raras, está planteando desafíos al desarrollo global de la IA. El informe señala que las empresas de IA (como OpenAI) ya han sentido las limitaciones por la escasez de suministro de GPU. Al mismo tiempo, China logra avances en la fabricación de chips (como avances tecnológicos en 3nm, 1nm) y podría producir chips de IA de alta calidad en los próximos años. El punto de vista del artículo es que las restricciones comerciales actuales podrían ralentizar la velocidad de desarrollo de la IA en EE.UU. e incluso permitir que China lo supere en el campo de la IA, abogando por promover el desarrollo de la IA a través del libre comercio. (fuente: Reddit r/ArtificialInteligence)

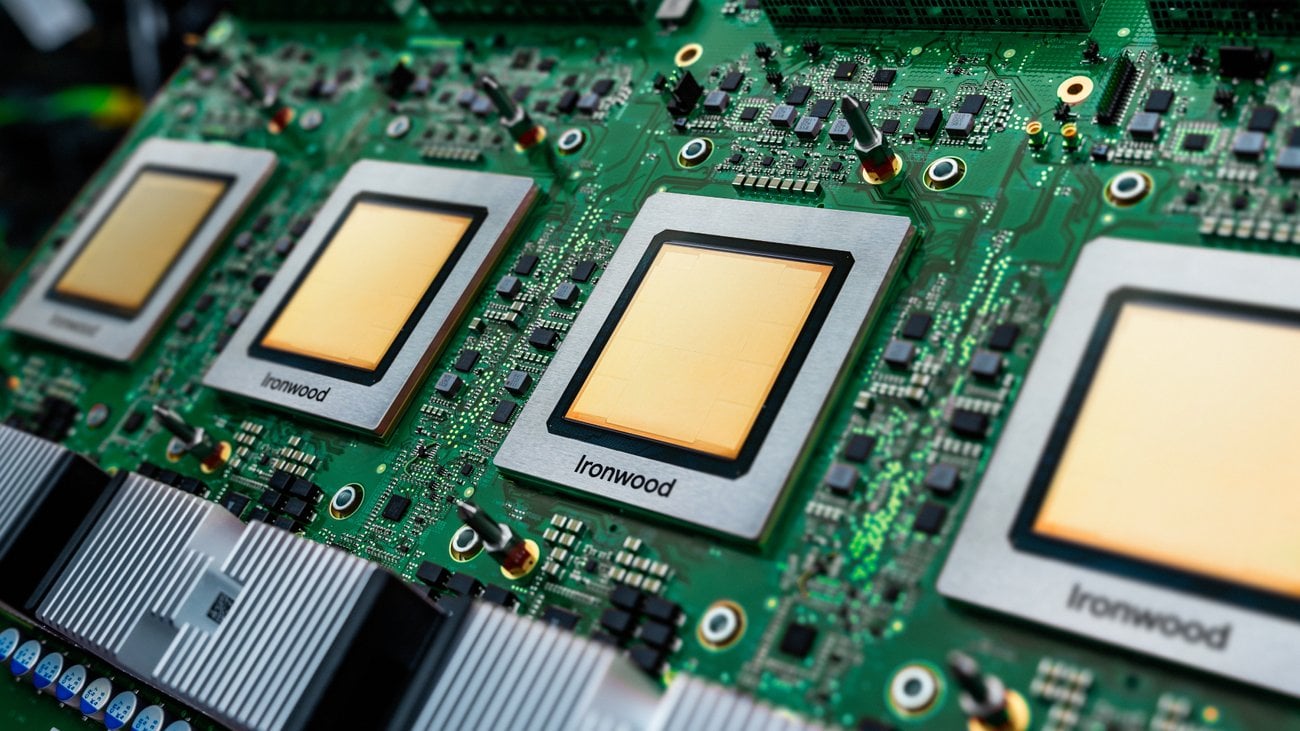

Debate sobre la aplicación práctica de las TPU en entornos de producción: Google lanzó recientemente una nueva generación de TPU (Tensor Processing Units) optimizadas para inferencia. Sin embargo, la discusión en la comunidad señala que, aunque las TPU existen desde hace años y Google ofrece un generoso programa de recursos para investigadores (TRC), en entornos de producción industrial, el uso de TPU parece menos extendido que el de las GPU de NVIDIA. Las posibles razones incluyen complejidad de configuración, ventajas de rendimiento no evidentes, funciones insuficientes de la plataforma GCP (como IP fija, herramientas de observabilidad), dificultad de depuración (XLA) y preocupaciones por el bloqueo del proveedor al solo poder alquilarlas a través de GCP. La discusión invita a usuarios con experiencia real en producción a compartir su uso y desafíos con las TPU. (fuente: Reddit r/MachineLearning)

La IA genera una brecha de confianza en el sector asegurador: Un informe de investigación de Swiss Re señala que la aplicación de la IA generativa en el sector asegurador enfrenta desafíos de confianza. Aunque el potencial de la IA es enorme, existen preocupaciones sobre la privacidad de los datos, la ciberseguridad y la transparencia de las decisiones, lo que puede llevar a una brecha de confianza entre las aseguradoras y los clientes. El informe explora cómo aprovechar las ventajas de la IA mientras se abordan los riesgos y problemas éticos relacionados, para establecer y mantener la confianza del usuario. (fuente: Ronald_vanLoon)

🌟 Comunidad

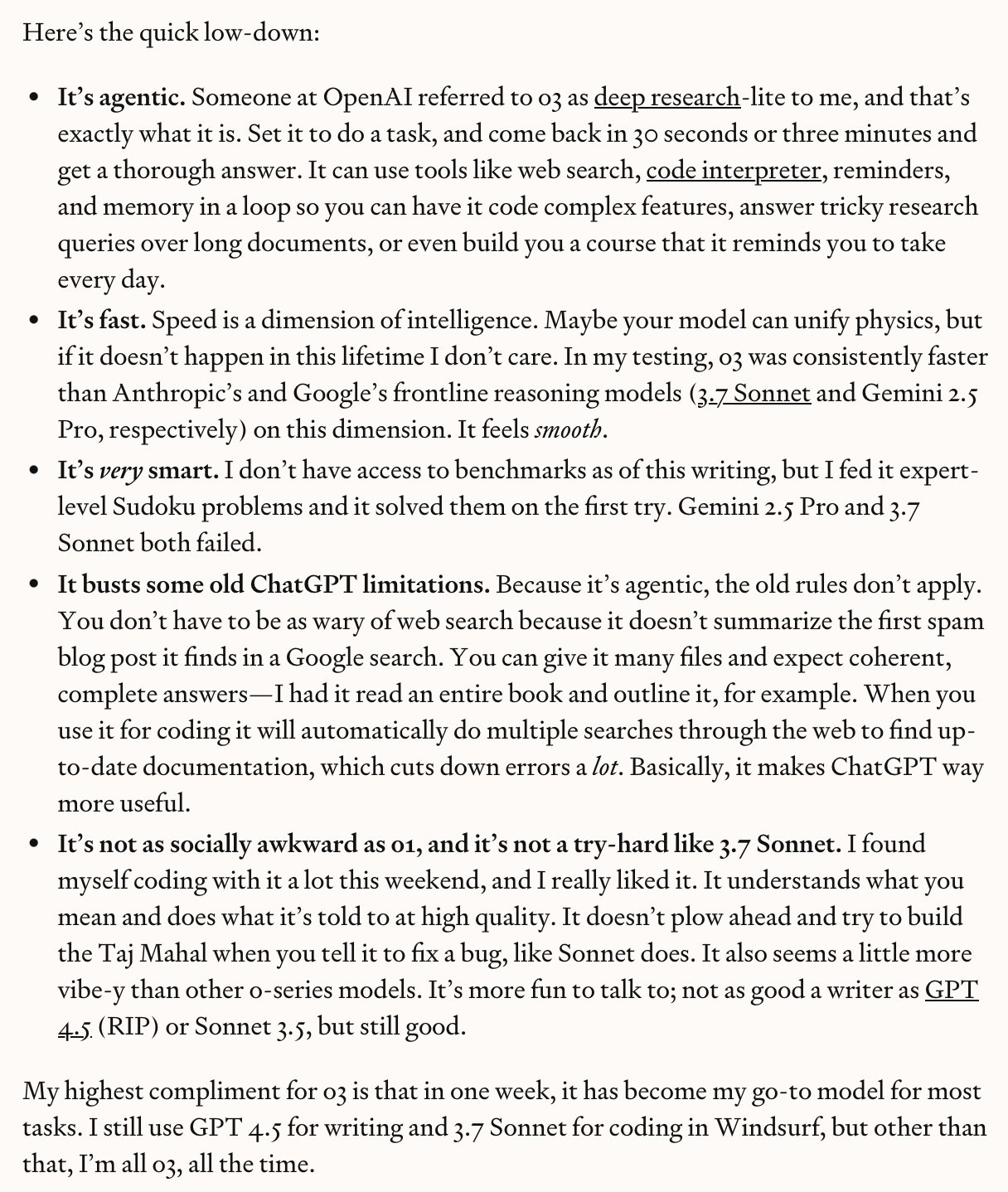

o3/o4-mini de OpenAI generan un intenso debate, entre potencial real y exageración: Tras el lanzamiento de o3 y o4-mini por parte de OpenAI, la respuesta de la comunidad ha sido entusiasta. Los primeros probadores (como Dan Shipper) elogian su velocidad, inteligencia y capacidad de agente, convirtiéndose ya en su modelo preferido, capaz de completar benchmarks de código, personalizar cursos, reconocer imágenes borrosas, analizar escritura, etc. Sam Altman lo retuiteó enfatizando que está “cerca o alcanza el nivel de genio”. Sin embargo, también hay comentarios (como el vídeo de AI Explained) que señalan que, aunque el modelo es potente, afirmaciones como “AGI” o “sin alucinaciones” son exageradas, el modelo todavía comete errores en algunos razonamientos de sentido común y físicos, y la relación calidad-precio podría no ser tan buena como la de Gemini 2.5 Pro. La comunidad reconoce en general su progreso, especialmente en codificación y uso de herramientas, pero mantiene una visión crítica sobre sus capacidades reales y limitaciones. (fuente:

、

、sama、sama、karminski3、gdb、natolambert)

Debate comunitario: ¿Depende principalmente la IA del avance en la capacidad de cómputo para alcanzar la AGI?: Usuarios de Reddit iniciaron un debate sobre si lograr la AGI (Inteligencia Artificial General) se reduce principalmente a un aumento en la potencia computacional bruta. La opinión es que, incluso con las limitaciones actuales de los LLM, un aumento de un orden de magnitud en la capacidad computacional podría ofrecer una utilidad cercana a la AGI, incluso si no es una AGI “real”. La clave es si el problema de la AGI es inherentemente “tratable”; si lo es, la fuerza bruta computacional podría ser suficiente. Pero también hay comentarios que refutan esto, argumentando que la potencia de cálculo por sí sola no puede superar las limitaciones fundamentales de los LLM, y que la AGI requiere más avances paradigmáticos. (fuente: Reddit r/ArtificialInteligence)

Debate comunitario: ¿Qué industrias serán las primeras en ser disruptidas por la IA?: Usuarios de Reddit iniciaron un debate especulando sobre qué industrias serán las primeras en “colapsar” debido al impacto de la IA. Las industrias mencionadas incluyen: traducción/redacción publicitaria, soporte al cliente, enseñanza de idiomas, gestión de carteras de inversión, ilustración/fotografía comercial. La sección de comentarios añade transporte, diseño (interfaz, marca, logo), relaciones públicas/marketing/gestión de redes sociales, enseñanza (especialmente tutoría privada), blogs/podcasts (cambio en la forma de creación de contenido), gestión de organización de eventos, etc. También hay comentarios que señalan que no todos los campos desaparecerán por completo, por ejemplo, la traducción altamente especializada o la ilustración que requiere creatividad humana central seguirán teniendo espacio. (fuente: Reddit r/ArtificialInteligence)

Experiencia de usuario: Depurar código generado por IA presenta grandes desafíos: Un desarrollador compartió la experiencia de depurar código generado por un LLM (migrando de SAS a SQL/Python). Aunque el código de IA parecía “decente”, en realidad estaba lleno de errores: llamaba a funciones no definidas, confundía lógicas de código similares pero no idénticas, omitía SQL mal formateado pero correcto, reemplazaba valores clave arbitrariamente y generaba resultados inconsistentes en ejecuciones múltiples. La conclusión final fue que el código era completamente inutilizable y necesitaba ser reescrito, y arreglarlo era más arriesgado que reescribirlo. Esto destaca las limitaciones actuales de la capacidad de generación de código de la IA y subraya la necesidad de revisión y validación humana. (fuente: Reddit r/ArtificialInteligence)

IA y relaciones laborales: ¿Cómo deberían responder los sindicatos?: La discusión señala que, a medida que aumenta la capacidad de automatización de la IA en diversas industrias, los sindicatos deben abordar de manera más proactiva su impacto potencial en los trabajadores. El artículo cita incidentes pasados de huelgas y protestas relacionadas con la IA, como escuelas que sugieren usar IA para reemplazar a estudiantes de posgrado en huelga, uso de IA para monitorear protestas estudiantiles, preocupaciones sobre la automatización de servicios de salud mental, posibles huelgas de maestros debido a la aplicación de IA en las escuelas, etc. La opinión es que los trabajadores (y sus organizaciones representativas) no deben esperar, sino desarrollar proactivamente estrategias para hacer frente a los cambios que trae la IA. (fuente: Reddit r/artificial)

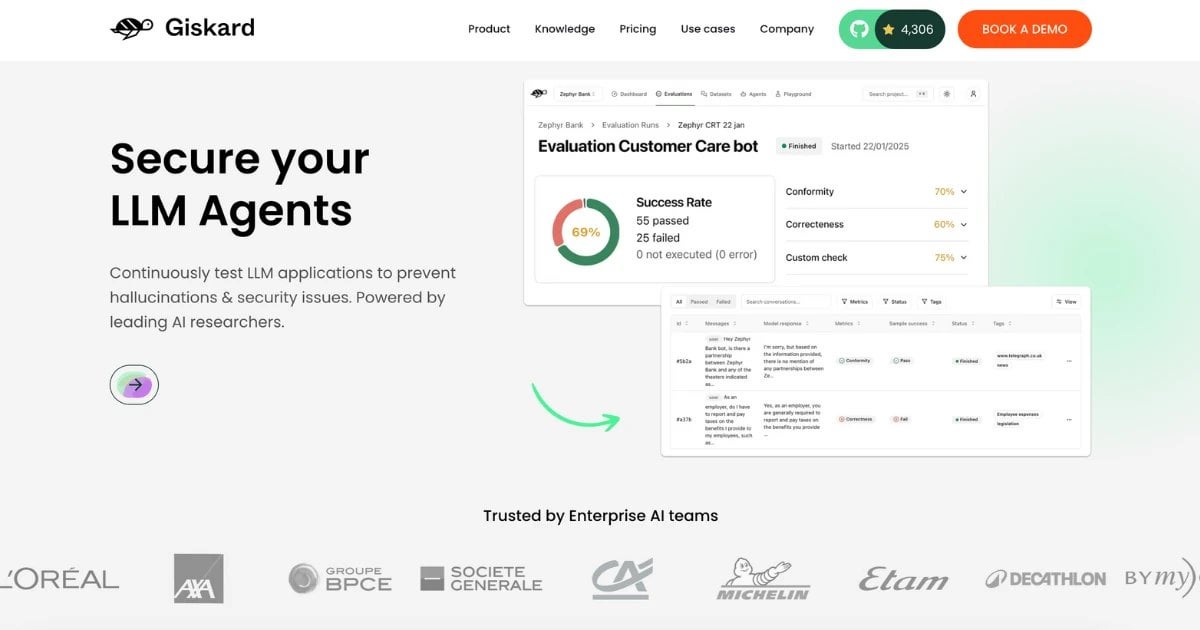

Lanzamiento del conjunto de datos RealHarm: recopila casos reales de fallos de Agentes de IA en el mundo real: El equipo de Giskard ha lanzado el conjunto de datos RealHarm, que recopila casos reales reportados públicamente que involucran problemas con Agentes de IA (especialmente basados en LLM) en aplicaciones prácticas. Analizando estos casos, el equipo descubrió que el daño a la reputación es el perjuicio organizacional más común, la desinformación y las alucinaciones son los tipos de riesgo más comunes, y las barreras existentes no lograron prevenir eficazmente muchos incidentes. El conjunto de datos tiene como objetivo ayudar a investigadores y desarrolladores a comprender y prevenir mejor los riesgos de la IA en el mundo real. (fuente: Reddit r/LocalLLaMA)

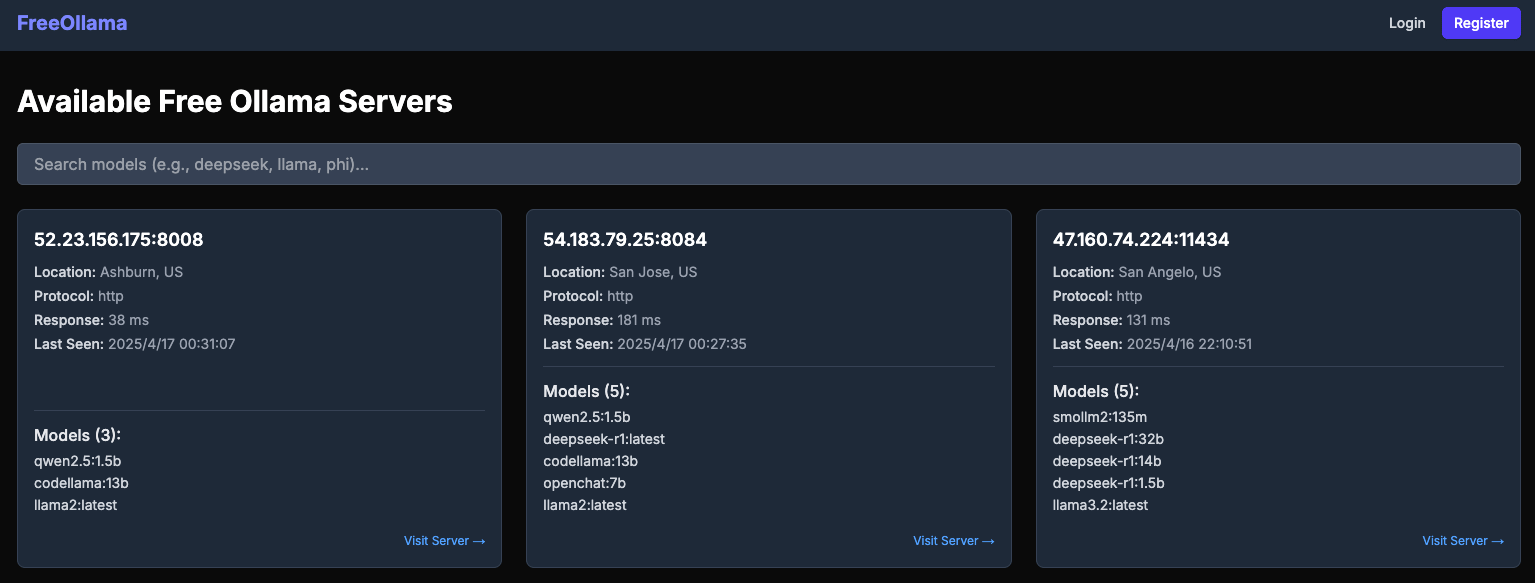

Informe revela riesgos de seguridad en servidores Ollama expuestos públicamente: El sitio web freeollama.com muestra una gran cantidad de instancias de servidores Ollama expuestas en la red pública. Esto indica que muchos usuarios, al desplegar servicios LLM locales, no configuraron correctamente las medidas de seguridad (como establecer la dirección de escucha en 0.0.0.0 sin añadir autenticación), lo que expone sus modelos y datos potenciales al riesgo de acceso y explotación no autorizados. Recuerda a los usuarios que presten atención a la configuración de seguridad de red al desplegar servicios de IA locales. (fuente: Reddit r/LocalLLaMA)

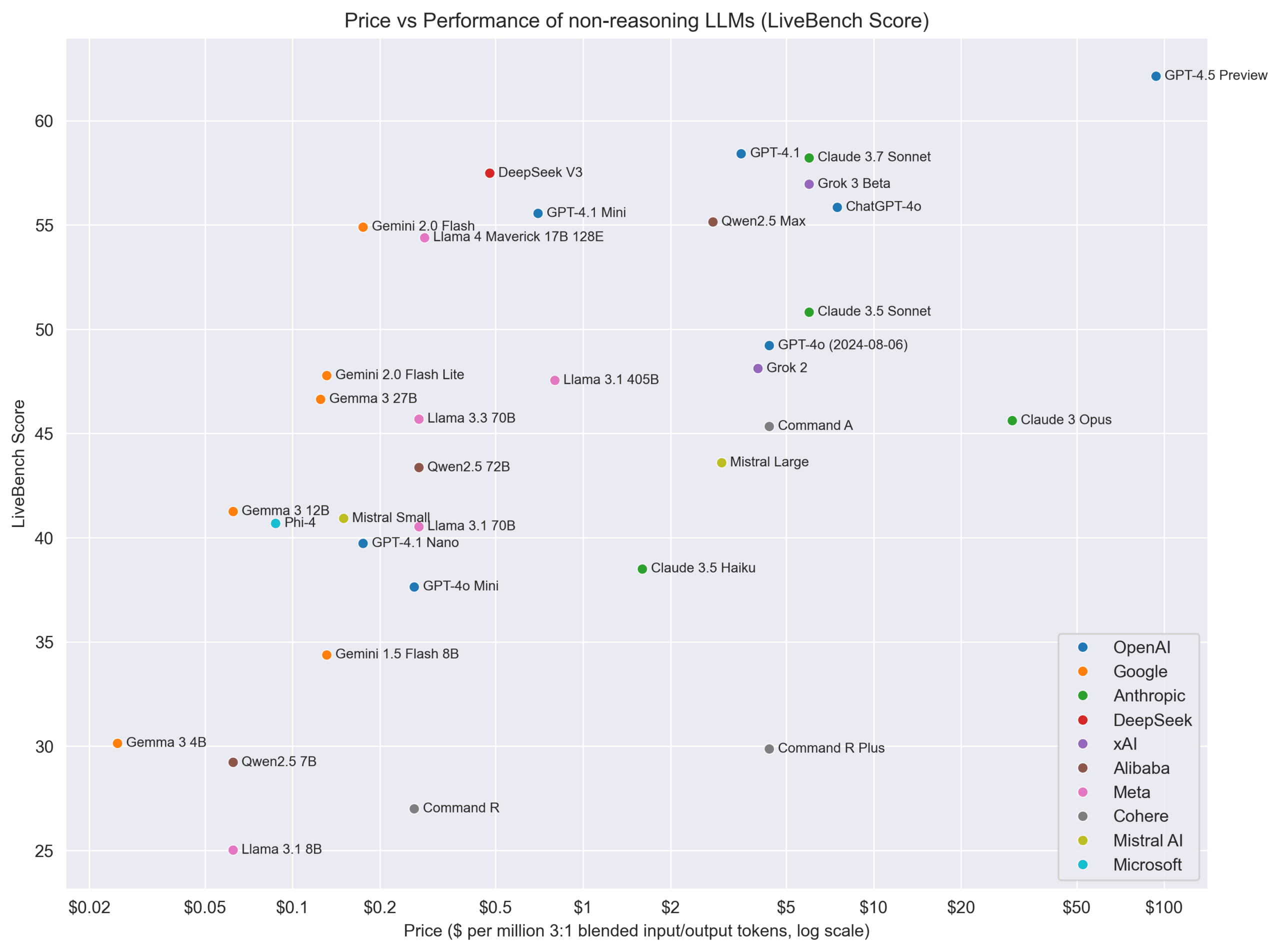

Opinión: No se debe dividir estrictamente entre modelos de razonamiento y no razonamiento: El investigador de IA Nathan Lambert propone que no se deberían clasificar estrictamente los modelos en “de razonamiento” y “de no razonamiento”, sino evaluar todos los modelos en todos los dominios. Los “modelos de razonamiento” suelen rendir bien también en benchmarks de no razonamiento, pero no al revés. Esto sugiere que los modelos con capacidad de razonamiento podrían ser más generales. Al mismo tiempo, señala que se necesitan mejores modelos de precios para reflejar diferentes capacidades y costes. (fuente: natolambert)

El cofundador de DeepMind, Demis Hassabis, incluido en TIME100, enfatiza la cooperación en seguridad de IA: El CEO de Google DeepMind, Demis Hassabis, ha sido incluido en la lista de las 100 personas más influyentes de 2025 de la revista Time. En una entrevista, enfatizó que espera que los países y empresas competidoras puedan dejar de lado sus diferencias y colaborar en la seguridad de la IA, porque asegurar que la IA se desarrolle para bien redunda en el interés propio de todos. (fuente: demishassabis)

Ejecutivo de Google DeepMind: El aprendizaje por refuerzo necesita ir más allá del conocimiento humano: David Silver, vicepresidente de aprendizaje por refuerzo en Google DeepMind, cree que la investigación en IA debe ir más allá del conocimiento humano conocido, avanzando hacia sistemas capaces de autoaprendizaje e incluso de descubrir nuevos conocimientos científicos. Esto enfatiza el potencial del aprendizaje por refuerzo para impulsar la exploración y el descubrimiento autónomos de la IA. (fuente: GoogleDeepMind)

Opinión: El cuello de botella en el desarrollo de la IA ha pasado de la computación a los datos y la evaluación: En un vídeo que analiza los avances de modelos como Kling 2.0, GPT-4.1, o3, el presentador del canal AI Explained, citando la opinión de ejecutivos de OpenAI, señala que los factores limitantes actuales en el desarrollo de la IA se han desplazado más de la potencia de cálculo hacia los datos, especialmente datos de alta calidad y específicos de dominio, y métodos de evaluación efectivos (Evals). La mejora del rendimiento del modelo depende cada vez más de encontrar mejores datos y mejores formas de medir el progreso. (fuente:

)

Gráfico comparativo de precio vs. rendimiento de modelos sin razonamiento: La comunidad de Reddit compartió un gráfico que compara los precios (presumiblemente costes de API) de diferentes LLM sin razonamiento con sus puntuaciones de rendimiento en LiveBench (una plataforma de benchmarking en tiempo real). El gráfico muestra visualmente la relación calidad-precio de varios modelos en un benchmark específico, por ejemplo, mostrando que la serie Gemma/Gemini destaca en relación calidad-precio. (fuente: Reddit r/LocalLLaMA)

💡 Otros

Nuevos avances en interfaces cerebro-computadora: convierten ondas cerebrales directamente en voz: Una nueva investigación presenta un implante de interfaz cerebro-computadora (BCI) capaz de decodificar en tiempo real las ondas cerebrales de personas paralizadas y sintetizarlas en habla natural. Esta tecnología ofrece nuevas posibilidades de comunicación para personas que han perdido la capacidad de hablar debido a lesiones o enfermedades neurológicas, y es un avance significativo en la intersección de la IA con la tecnología de asistencia y la neurociencia. (fuente: Ronald_vanLoon、Ronald_vanLoon)

La exploración de juegos con IA del fundador de miHoYo, Cai Haoyu: La empresa de IA Anuttacon, fundada por el ex CEO de miHoYo, Cai Haoyu, publicó un tráiler y una demo del juego experimental de IA “Whispers From The Star”. El juego se centra en diálogos en tiempo real impulsados por IA, donde los jugadores interactúan con el personaje de IA Stella mediante texto, voz o vídeo para guiar su supervivencia. El juego utiliza tecnología de IA multimodal; las emociones, reacciones y acciones de Stella son generadas en tiempo real por la IA, con expresiones faciales y movimientos naturales. Esto refleja la exploración de Cai Haoyu sobre cómo AIGC puede cambiar el desarrollo de juegos, pero enfrenta desafíos como la madurez tecnológica, el modelo de negocio y la aceptación de los jugadores. El artículo también compara las diferentes estrategias de grandes empresas como Tencent y NetEase para aplicar la IA en los juegos. (fuente: 原神之后,蔡浩宇的 AIGC 游戏野望)

Unitree Technology actualiza el robot industrial con ruedas B2-W: Unitree Robotics mostró las capacidades mejoradas de su robot industrial con ruedas B2-W. Aunque no se detallaron las mejoras específicas, normalmente, este tipo de robots integran tecnología de IA para navegación, evasión de obstáculos, ejecución de tareas, etc. Esta actualización podría implicar mayor autonomía, capacidad de carga o aplicaciones en escenarios industriales específicos. (fuente: Ronald_vanLoon)

Robots aprendiendo habilidades humanas: Circuit Robotics mostró cómo los robots aprenden habilidades humanas. Esto generalmente implica métodos de IA como aprendizaje por imitación (imitation learning), aprendizaje por refuerzo (reinforcement learning), etc., permitiendo a los robots dominar tareas operativas complejas mediante la observación de demostraciones o prueba y error, siendo una importante dirección de investigación en la combinación de robótica e IA. (fuente: Ronald_vanLoon)

Los robots de compras se hacen realidad: Un vídeo o información compartida por Fabrizio Bustamante indica que el uso de robots para hacer compras se está convirtiendo en una realidad. Esto podría referirse a robots de clasificación automatizada en almacenes, o robots de entrega al consumidor, robots de guía en tienda, etc. Estos suelen requerir IA para la planificación de rutas, reconocimiento de objetos e interacción humano-robot. (fuente: Ronald_vanLoon)

Aplicaciones de la IA y la robótica en la agricultura: JC Niyomugabo discutió las aplicaciones de la IA y la robótica en la agricultura (AgriTech). Esto incluye utilizar la IA para el monitoreo de cultivos, diagnóstico de plagas y enfermedades, toma de decisiones precisas sobre riego y fertilización, y usar robots para siembra automatizada, deshierbe, cosecha, etc., con el objetivo de mejorar la eficiencia agrícola, el rendimiento y la sostenibilidad. (fuente: Ronald_vanLoon)

Nanorobots con “armas ocultas” pueden matar células cancerosas: La investigación compartida por Khulood Almani muestra un tipo de nanorobot equipado con “armas ocultas” (mecanismo específico no detallado) capaz de dirigirse y matar células cancerosas. Los mecanismos de navegación y focalización de los nanorobots a menudo involucran algoritmos de IA, utilizados para identificar objetivos y ejecutar tareas en entornos biológicos complejos, siendo una aplicación de vanguardia en el campo de la salud. (fuente: Ronald_vanLoon)

Desarrollo de la mano biónica COVVI: La mano biónica desarrollada por la empresa COVVI tiene como objetivo proporcionar a las personas amputadas prótesis más flexibles y funcionales. Este tipo de manos biónicas avanzadas suelen integrar sensores y algoritmos de IA para interpretar las señales musculares del usuario (como señales electromiográficas EMG) o señales nerviosas, logrando un control mental más natural y operaciones finas. (fuente: Ronald_vanLoon)

Robot humanoide chino realiza tareas de inspección de calidad: WevolverApp informa que robots humanoides en China ya se utilizan para realizar tareas de inspección de calidad. Esto requiere que el robot posea capacidades avanzadas de reconocimiento visual (posiblemente impulsado por IA), habilidades de manipulación precisas y cierta capacidad de toma de decisiones para determinar si un producto es apto, siendo un ejemplo de la aplicación de robots humanoides en el campo de la automatización industrial. (fuente: Ronald_vanLoon)

Primera cirugía en humanos realizada por un dentista robot en el mundo: Gigadgets informó sobre la primera cirugía en humanos realizada completamente por un dentista robot. Aunque los detalles no están claros, generalmente significa que el sistema robótico realiza la planificación, posicionamiento y operación quirúrgica con asistencia de IA, con el objetivo de mejorar la precisión y consistencia quirúrgica, siendo un hito en la combinación de robótica médica e IA. (fuente: Ronald_vanLoon)

La IA impulsa el progreso digital, construyendo naciones inteligentes: Un artículo de Ronald van Loon en colaboración con Huawei explora cómo impulsar el progreso nacional y construir naciones más inteligentes a través de tecnologías digitales como IA, Internet de las Cosas (IoT), conectividad y análisis de datos. Enfatiza el papel de la IA en la optimización de servicios públicos, gestión de infraestructuras, desarrollo económico, etc. (fuente: Ronald_vanLoon)

El robot Velox que puede moverse en tierra y agua: El robot Velox compartido por Pascal Bornet es un robot anfibio, capaz de moverse en agua y tierra. Esta versatilidad podría hacerlo adecuado para escenarios complejos como búsqueda y rescate, monitoreo ambiental, y su capacidad de navegación autónoma y adaptación a diferentes entornos podría ser impulsada por IA. (fuente: Ronald_vanLoon)