Keywords:AI, LLM, Meta Llama 4, GPT-5, AGI seguridad, modelos de lenguaje multimodal, aplicaciones de IA en robótica

🔥 Enfoque

El lanzamiento de Meta Llama 4 genera controversia y dudas sobre su rendimiento: Meta lanzó la serie de modelos Llama 4 (Scout 109B, Maverick 400B, Behemoth 2T versión preliminar), adoptando la arquitectura MoE, soportando multimodalidad y un contexto de hasta 10 millones de tokens (Scout). Aunque oficialmente se afirma un rendimiento superior y ha tenido un buen desempeño en el ranking de LM Arena, las pruebas de la comunidad (especialmente en tareas de programación) reflejan en general que su rendimiento es muy inferior al esperado, incluso por debajo de modelos como Gemma 3 o Qwen. Al mismo tiempo, circuló información de empleados anónimos en la red, acusando a Meta de posiblemente haber mezclado datos de benchmarks en la fase de post-entrenamiento de Llama 4 para «inflar las puntuaciones» con el fin de lanzarlo antes de finales de abril, y provocó la salida de personal, incluida la vicepresidenta de investigación de IA, Joelle Pineau. Meta no ha confirmado por ahora estas acusaciones, pero admitió que la versión utilizada en LM Arena era una «versión experimental de chat», lo que intensificó las dudas de la comunidad sobre la veracidad de su rendimiento y su estrategia de lanzamiento. (Fuente: Llama 4发布36小时差评如潮!匿名员工爆料拒绝署名技术报告, 30亿月活也焦虑,AI落后CEO震怒,大模型刷分造假,副总裁愤而离职, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Llama 4 刷榜作弊引热议,20 万显卡集群就做出了个这?, Llama 4训练作弊爆出惊天丑闻!AI大佬愤而辞职,代码实测崩盘全网炸锅, Meta LLaMA 4:对抗 GPT-4o 与 Claude 的开源王牌)

OpenAI ajusta el plan de lanzamiento de modelos, GPT-5 se retrasa varios meses: El CEO de OpenAI, Sam Altman, anunció un ajuste en el plan de lanzamiento, presentando los modelos o3 y o4-mini en las próximas semanas, mientras que GPT-5, que originalmente integraría múltiples tecnologías, se retrasará varios meses. Altman explicó que el retraso tiene como objetivo pulir GPT-5 para que sea mejor de lo planeado originalmente y resolver las dificultades de integración y los requisitos de potencia computacional. También reveló que en los próximos meses se lanzará un potente modelo de inferencia de código abierto, que posiblemente podría ejecutarse en hardware de consumo. Anteriormente, el objetivo de OpenAI era unificar las series o y GPT, posicionando a GPT-5 como un sistema unificado que integra voz, Canvas, búsqueda y otras capacidades, y posiblemente ofreciendo una versión básica gratuita. Este ajuste podría verse influenciado por competidores como DeepSeek y el lanzamiento de Gemini 2.5 Pro de Google. (Fuente: 奥特曼官宣:免费GPT-5性能惊人,o3和o4-mini抢先上线,Llama 4也鸽了, DeepSeek前脚发新论文,奥特曼立马跟上:GPT-5就在几个月后啊, OpenAI:将在几周内发布o3和o4-mini,几个月后推出GPT-5)

La inteligencia corpórea y los robots humanoides se convierten en el nuevo foco, con la afluencia de capital y los desafíos de comercialización coexistiendo: El Foro Zhongguancun 2025 se centró en los robots humanoides, mostrando avances tecnológicos y de implementación en escenarios reales con robots nacionales como Accelerating Evolution T1, Tiangong 2.0 y Lingbao CASBOT. La industria está pasando de demostraciones tecnológicas a aplicaciones prácticas, como clasificación industrial, guía y compras, investigación científica, etc. El mercado está en auge, con fenómenos de «pedidos explosivos» y alquiler de robots (con tarifas diarias de miles a decenas de miles de yuanes). El capital también se está acelerando, con empresas como Xiaoyu Zhizao, Zhipingfang, Fourier Intelligence, Lingcifang, Zibianliang y Tashizhihang obteniendo grandes rondas de financiación entre finales de 2024 y principios de 2025, con el capital estatal como principal impulsor. Sin embargo, el camino hacia la comercialización aún no está claro. Se informa que Zhu Xiaohu de GSR Ventures se está retirando de este campo, lo que genera debates en el mercado sobre la burbuja y las dificultades de implementación. A pesar de los desafíos, los robots humanoides, como portadores de la inteligencia corpórea (ya incluida en el informe de trabajo del gobierno), se consideran una dirección clave para la integración de la IA y la economía real. (Fuente: 人形机器人,站上新风口)

Google DeepMind publica informe sobre seguridad de AGI, predice su posible llegada en 2030 y advierte sobre riesgos: Google DeepMind publicó un informe de 145 páginas que expone sistemáticamente sus puntos de vista sobre la seguridad de la AGI, prediciendo que una «AGI de nivel superior» que supere al 99% de los humanos podría aparecer alrededor de 2030. El informe advierte que la AGI podría traer riesgos existenciales de «destrucción permanente de la humanidad» y enumera escenarios de riesgo específicos como la manipulación de la opinión pública, ataques cibernéticos automatizados, pérdida de control de la bioseguridad, desastres estructurales (como la pérdida de la capacidad de toma de decisiones humana) y confrontación militar automatizada. El informe clasifica los riesgos en cuatro categorías: abuso, desalineación (incluida la alineación engañosa), errores y riesgos estructurales, y propone dos líneas de defensa basadas en la «supervisión amplificada» y el «entrenamiento robusto», así como tratar a la IA como un «miembro interno no confiable» para el control del despliegue. El informe también critica implícitamente las estrategias de seguridad de competidores como OpenAI. El informe ha generado debate; algunos expertos consideran que la definición de AGI es vaga y el cronograma incierto, pero en general coinciden en la importancia de la seguridad de la IA. (Fuente: 2030年AGI到来?谷歌DeepMind写了份“人类自保指南”, 谷歌发145页论文:预测AGI或2030年出现 警告可能“永久毁灭人类”)

El CEO de Nvidia, Jensen Huang, y otros hablan sobre IA: fuerza laboral digital y estrategia nacional: En el programa a16z, el CEO de Nvidia, Jensen Huang, y el fundador de Mistral, Arthur Mensch, discutieron el futuro de la IA. Jensen cree que la IA es la mayor fuerza para reducir la brecha tecnológica, enfatizando su coexistencia de universalidad y súper especialización, necesitando fine-tuning para dominios específicos. Propuso que la «inteligencia digital» se ha convertido en la nueva infraestructura nacional, y los países necesitan construir una «fuerza laboral digital», transformando la IA general en IA especializada. Arthur Mensch coincidió en la naturaleza revolucionaria de la IA, considerándola como la electricidad que afectará al PIB, y además una infraestructura que soporta la cultura y los valores, enfatizando la importancia de la estrategia de IA soberana para prevenir la colonización digital. Ambas partes destacaron la importancia del código abierto, creyendo que puede acelerar la innovación, aumentar la transparencia y la seguridad, y reducir la dependencia. Jensen también señaló que las futuras tareas de IA tienden a ser asíncronas, planteando nuevos requisitos para la infraestructura, y advirtió contra la adoración excesiva de la tecnología, instando a la participación activa. (Fuente: “数字劳动力”已诞生,黄仁旭最新发言围绕AI谈了这几点…)

🎯 Tendencias

Google abre gratuitamente la función Canvas de Gemini 2.5 Pro: Google anunció la apertura gratuita de la función Canvas de Gemini 2.5 Pro para todos los usuarios. Esta función permite a los usuarios completar tareas de programación e innovación en minutos mediante prompts, como diseñar páginas web, escribir scripts, crear juegos o simulaciones visuales. Esta medida se considera un «ataque sorpresa» de Google en la competencia de IA, aprovechando su ventaja en potencia computacional de TPU frente a la escasez de recursos de OpenAI (Altman había dicho que las GPUs se estaban derritiendo). La jefa de producto de Gemini, Tulsee Doshi, enfatizó en una entrevista que el modelo 2.5 Pro es potente en inferencia, programación y capacidades multimodales, y que equilibra los indicadores técnicos y la experiencia del usuario a través de «pruebas de ambiente», y que los modelos futuros serán más inteligentes y eficientes. (Fuente: 谷歌暗讽OpenAI:GPU在熔化,TPU火上浇油,Canvas免费开放,实测惊人)

DeepSeek publica nueva investigación sobre modelos de recompensa expandibles en tiempo de inferencia: DeepSeek, en colaboración con la Universidad de Tsinghua, publicó un artículo proponiendo el método SPCT (Self-Principled Critique Tuning), que optimiza los modelos de recompensa generativa (GRM) mediante aprendizaje por refuerzo en línea para mejorar su capacidad de expansión en tiempo de inferencia. Este método tiene como objetivo resolver el problema del rendimiento limitado de los modelos de recompensa generales frente a tareas complejas y diversas, permitiendo que el modelo genere dinámicamente principios y críticas de alta calidad para mejorar la precisión de las señales de recompensa. Los experimentos muestran que DeepSeek-GRM-27B entrenado con este método supera significativamente a los métodos de referencia en múltiples benchmarks, y mejora aún más el rendimiento mediante la expansión por muestreo en tiempo de inferencia. Esta investigación podría influir en las estrategias de lanzamiento de modelos de competidores como OpenAI. (Fuente: DeepSeek前脚发新论文,奥特曼立马跟上:GPT-5就在几个月后啊)

La App Doubao integra búsqueda en red y funciones de pensamiento profundo: El asistente de IA de ByteDance, «Doubao», actualizó su función de pensamiento profundo, integrando directamente la capacidad de búsqueda en red en el proceso de pensamiento, logrando «buscar mientras piensa» y eliminando el botón de búsqueda en red independiente. En este modo, Doubao primero piensa, luego realiza búsquedas específicas basadas en los resultados del pensamiento, y continúa pensando combinando el contenido de la búsqueda, posiblemente realizando múltiples rondas de búsqueda. Esta medida tiene como objetivo simplificar la interfaz de usuario e impulsar la interacción de la IA para que se acerque más a la forma natural humana de obtener información, pero también puede causar esperas innecesarias al procesar preguntas simples. Esto se considera un intento de Doubao de compararse y diferenciarse de productos competidores de asistentes de IA como DeepSeek R1 en el diseño de productos. (Fuente: 豆包消灭联网搜索)

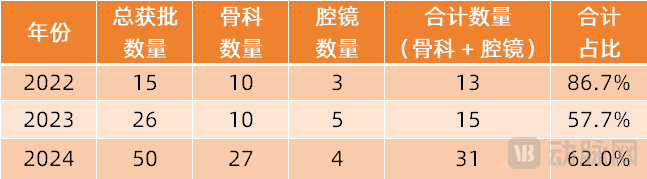

Los robots quirúrgicos se expanden a más campos especializados: El mercado de robots quirúrgicos se está expandiendo desde los campos principales de laparoscopia y ortopedia hacia más especialidades. Recientemente, se han logrado avances significativos en intervención vascular (aprobación de ETcath de Weimai Medical, ventas de R-ONE de MicroPort), acceso por orificios naturales (aprobación del robot de endoscopia digestiva EndoFaster de Roboter, comercialización de los robots de broncoscopia Monarch de Johnson & Johnson / Ion de Intuitive Fosun), punción percutánea (aprobación del robot de navegación AI de Zhuoye Medical, con más de diez empresas como United Imaging, Zhen Health entrando en el campo), trasplante capilar (aprobación y promoción conjunta de HAIRO de Pounce Medical), implantes dentales (aprobación de productos Dencore de Liuyedao, Baihuiweikang), etc. Los robots de cirugía oftálmica (Dishivision) también han entrado en el canal de aprobación de innovación. Las tendencias tecnológicas incluyen la integración con IA, modelos grandes y el uso conjunto con más equipos de imagen (como CT de gran calibre, PET-CT) para mejorar la precisión y la eficiencia. (Fuente: 腔镜、骨科之外,又有手术机器人要突破了)

Se revela demostración in-game del juego de IA «Whispers From The Star» del fundador de miHoYo, Cai Haoyu: Se ha publicado un fragmento de demostración in-game para iPhone del juego experimental de IA «Whispers From The Star», desarrollado por Anuttacon, la compañía de IA del fundador de miHoYo, Cai Haoyu. El núcleo del juego es que los jugadores interactúan a través de texto, voz y video con la protagonista de IA Stella (Xiaomei), atrapada en un planeta alienígena. Las conversaciones afectarán en tiempo real el desarrollo de la trama y su destino, sin un guion fijo. La demostración muestra conversaciones inmersivas, interacción emocional (incluso «piropos cursis» que hacen sonrojar al jugador) y el impacto directo de las decisiones del jugador en el curso de la trama (como un consejo erróneo que lleva a la muerte del personaje). El juego se encuentra actualmente en pruebas cerradas (solo compatible con iPhone 12 y superior), reflejando el objetivo de Anuttacon de explorar el «desarrollo conjunto del juego y el jugador». (Fuente: 米哈游蔡浩宇新作iPhone实机演示:10分钟就被AI小美撩到脸红,她的命运由我拯救)

Microsoft publica demo de «Quake 2» impulsado por IA y genera atención: Microsoft mostró una demo técnica que implanta capacidades de interacción tipo Copilot en el clásico juego «Quake II» utilizando su modelo de IA Muse. La tecnología tiene como objetivo explorar el potencial de la IA en los juegos, por ejemplo, permitiendo que los NPC interactúen de forma más natural con los jugadores o proporcionen asistencia. Sin embargo, la demo ha generado reacciones mixtas en línea; algunos lo ven como una manifestación del progreso de la tecnología de IA, presagiando las posibilidades futuras de interacción en los juegos; otros sienten que el efecto actual no es bueno e incluso afecta la experiencia del juego original. (Fuente: Reddit r/ArtificialInteligence)

Llama 4 Maverick destaca en algunos benchmarks: Según los datos de benchmarks de Artificial Analysis, el nuevo modelo Llama 4 Maverick de Meta supera en algunas evaluaciones a Claude 3.7 Sonnet de Anthropic, pero sigue por detrás de DeepSeek V3.1. Esto indica que, aunque Llama 4 ha mostrado algunos problemas en las pruebas comunitarias (especialmente en codificación), sigue siendo competitivo en benchmarks y tareas específicas. Es importante señalar que diferentes benchmarks tienen enfoques distintos, y la clasificación de un modelo en una sola lista no representa completamente su capacidad general. (Fuente: Reddit r/LocalLLaMA)

Llama 4 tiene un rendimiento bajo en benchmarks de comprensión de contexto largo: Según los resultados actualizados del benchmark de comprensión profunda de contexto largo Fiction.liveBench, los modelos Meta Llama 4 (incluidos Scout y Maverick) tienen un rendimiento bajo, especialmente al procesar contextos de más de 16K tokens, donde la precisión disminuye significativamente. Por ejemplo, Llama 4 Scout, al procesar contextos superiores a 16K, tiene una tasa de recuperación (aproximadamente la tasa de respuesta correcta a preguntas) que cae por debajo del 22%. Esto contrasta con su anunciada capacidad de ventana de contexto ultralarga de 10M, lo que genera dudas en la comunidad sobre su efectividad real en el procesamiento de textos largos. (Fuente: Reddit r/LocalLLaMA)

Llama 4 Maverick obtiene baja puntuación en el benchmark de programación Aider: En el benchmark de programación multilingüe Aider, el modelo Llama 4 Maverick de Meta obtuvo una puntuación de solo el 16%. Este resultado agrava aún más las críticas negativas de la comunidad sobre sus capacidades de programación, mostrando una brecha significativa en comparación con otros modelos (como Qwen-32B). Esto no concuerda con su posicionamiento como modelo insignia de gran tamaño, generando dudas sobre sus datos de entrenamiento, arquitectura o proceso post-entrenamiento. (Fuente: Reddit r/LocalLLaMA)

Lanzamiento de Midjourney V7: La herramienta de generación de imágenes por IA Midjourney ha lanzado su versión V7. Una nueva versión generalmente implica mejoras en la calidad de imagen, diversidad de estilos, capacidad de comprensión de prompts y funcionalidad (como consistencia, capacidad de edición, etc.). Los detalles específicos de la actualización y los comentarios de los usuarios están pendientes de mayor observación. (Fuente: Reddit r/ArtificialInteligence)

GitHub Copilot introduce nuevas limitaciones y cobra por modelos avanzados: GitHub Copilot anunció ajustes en su servicio, introduciendo nuevas limitaciones de uso y comenzando a cobrar por el servicio que utiliza modelos de IA «avanzados». Esto podría significar que los usuarios de nivel gratuito o estándar tendrán más restricciones en la frecuencia de uso o funcionalidad, mientras que las capacidades de modelos más potentes (posiblemente de GPT-4o u otros modelos actualizados) requerirán un pago adicional. Este cambio refleja la exploración continua de los proveedores de servicios de IA para equilibrar costos, rendimiento y modelos de negocio. (Fuente: Reddit r/ArtificialInteligence)

🧰 Herramientas

Servidor Supabase MCP: La comunidad de Supabase lanzó supabase-mcp, un servidor basado en el Protocolo de Contexto de Modelo (MCP) diseñado para conectar proyectos de Supabase con asistentes de IA como Cursor, Claude, Windsurf, etc. Permite a los asistentes de IA interactuar directamente con los proyectos de Supabase del usuario para realizar tareas como gestionar tablas, obtener configuraciones y consultar datos. La herramienta está escrita en TypeScript, requiere un entorno Node.js y se autentica mediante tokens de acceso personal (PAT). El proyecto proporciona guías de configuración detalladas (incluidos entornos Windows y WSL) y enumera los conjuntos de herramientas disponibles, que abarcan gestión de proyectos, operaciones de base de datos, obtención de configuraciones, gestión de ramas (experimental) y herramientas de desarrollo (como la generación de tipos TypeScript). (Fuente: supabase-community/supabase-mcp – GitHub Trending (all/daily))

Plataforma de automatización de IA de código abierto Activepieces: Activepieces es una plataforma de automatización de IA de código abierto, posicionada como una alternativa a Zapier. Ofrece una interfaz fácil de usar y soporta más de 280 integraciones (llamadas «pieces»), que ahora también están disponibles como servidores del Protocolo de Contexto de Modelo (MCP) para LLMs (como Claude Desktop, Cursor, Windsurf). Sus características incluyen: un framework de pieces seguro en tipos basado en TypeScript, soporte para recarga en caliente en desarrollo local; funciones de IA integradas y asistencia Copilot para construir flujos; soporte para auto-alojamiento para garantizar la seguridad de los datos; proporciona control de flujo como bucles, ramas, reintentos automáticos; soporte para «human-in-the-loop» e interfaces de entrada manual (chat, formularios). La comunidad ha contribuido con la mayoría de las pieces, lo que refleja su ecosistema abierto. (Fuente: activepieces/activepieces – GitHub Trending (all/daily))

Herramienta anti-rastreadores de IA Anubis y estrategias trampa: Ante el problema de que los rastreadores de IA de empresas como OpenAI ignoran las reglas de robots.txt y realizan un rastreo excesivo que sobrecarga los sitios web (similar a un DDoS), la comunidad de desarrolladores está contraatacando activamente. El desarrollador FOSS Xe Iaso creó una herramienta de proxy inverso llamada Anubis, que verifica si los visitantes son navegadores humanos reales mediante un mecanismo de prueba de trabajo, bloqueando eficazmente los rastreadores automatizados. Otras estrategias incluyen establecer páginas «trampa» que proporcionan información inútil o engañosa a los rastreadores infractores (como sugiere xyzal, la herramienta Nepenthes de Aaron, AI Labyrinth de Cloudflare), con el objetivo de desperdiciar los recursos de los rastreadores y contaminar sus conjuntos de datos. Estas herramientas y estrategias reflejan los esfuerzos de los desarrolladores por proteger los derechos de los sitios web y contraatacar la extracción de datos poco ética. (Fuente: AI爬虫肆虐,OpenAI等大厂不讲武德,开发者打造「神级武器」宣战)

OpenAI lanza el benchmark SWE-Lancer: OpenAI presentó SWE-Lancer, un benchmark para evaluar el rendimiento de los grandes modelos lingüísticos en tareas de ingeniería de software freelance del mundo real. El benchmark incluye más de 1400 tareas reales de la plataforma Upwork, que abarcan codificación independiente, diseño UI/UX, implementación de lógica del lado del servidor y decisiones de gestión, con complejidad y remuneración variables, por un valor total superior a 1 millón de dólares. La evaluación utiliza un método de prueba de extremo a extremo verificado por ingenieros profesionales. Los resultados preliminares muestran que incluso el mejor rendimiento, Claude 3.5 Sonnet, tiene una tasa de éxito de solo el 26.2% en tareas de codificación independiente, lo que indica que la IA actual todavía tiene un gran margen de mejora en el manejo de tareas reales de ingeniería de software. El proyecto tiene como objetivo impulsar la investigación sobre el impacto económico de la IA en el campo de la ingeniería de software. (Fuente: OpenAI 发布大模型现实世界软件工程基准测试 SWE-Lancer)

La Academia China de Ciencias propone CK-PLUG para controlar la dependencia del conocimiento en RAG: Para abordar el problema del conflicto entre el conocimiento interno del modelo y el conocimiento recuperado externamente en RAG (Retrieval-Augmented Generation), el Instituto de Tecnología Computacional de la Academia China de Ciencias y otras instituciones propusieron el marco CK-PLUG. Este marco detecta conflictos mediante una métrica de «ganancia de confianza» (Confidence-Gain) (basada en el cambio de entropía) y utiliza un parámetro ajustable α para ponderar dinámicamente y fusionar las distribuciones de predicción conscientes de los parámetros y conscientes del contexto, controlando así con precisión la dependencia del modelo del conocimiento interno y externo. CK-PLUG también proporciona un modo adaptativo basado en la entropía, sin necesidad de ajuste manual de parámetros. Los experimentos muestran que CK-PLUG puede controlar eficazmente la dependencia del conocimiento mientras mantiene la fluidez de la generación, mejorando la fiabilidad y precisión de RAG en diferentes escenarios. (Fuente: 破解RAG冲突难题!中科院团队提出CK-PLUG:仅一个参数,实现大模型知识依赖的精准动态调控)

El framework Agent S2 de código abierto explora el diseño modular de agentes inteligentes: El equipo de Simular.ai ha hecho de código abierto el framework Agent S2, que ha logrado resultados SOTA en benchmarks de uso de computadoras. Agent S2 adopta un diseño de «inteligencia compuesta», dividiendo las funciones del agente en módulos especializados, como MoG (sistema multi-experto para localizar elementos GUI) y PHP (planificación dinámica para ajustes). Esto ha generado un debate sobre la arquitectura de los agentes: ¿es mejor integrar todo en un único modelo potente o es preferible la división modular del trabajo? El artículo también explora diferentes rutas de implementación de agentes (interacción GUI, llamadas API, línea de comandos) y sus ventajas y desventajas, así como la relación dialéctica entre «estructuración» e «inteligencia» y el efecto amplificador de las capacidades del agente (optimización de interfaces, fluidez de tareas, autocorrección). (Fuente: 最强Agent框架开源!智能体设计路在何方?)

Lanzamiento de la versión preliminar del formato de cuantización EXL3, mejora la eficiencia de compresión: Se ha lanzado una versión preliminar temprana del formato de cuantización EXL3, con el objetivo de mejorar aún más la eficiencia de compresión de modelos. Las pruebas iniciales muestran que su versión de 4.0 bpw (bits por peso) puede igualar el rendimiento de EXL2 de 5.0 bpw o GGUF Q4_K_M/L, pero con un tamaño más pequeño. Incluso hay informes de que Llama-3.1-70B con EXL3 a 1.6 bpw aún mantiene la coherencia y podría ejecutarse en 16GB de VRAM. Esto es de gran importancia para desplegar modelos grandes en dispositivos con recursos limitados. Sin embargo, la funcionalidad de la versión preliminar actual aún no está completa. (Fuente: Reddit r/LocalLLaMA)

Lanzamiento de modelos cuantizados Gemma3 QAT de menor tamaño: El desarrollador stduhpf lanzó versiones modificadas de los modelos Gemma3 QAT (Quantization-Aware Training) (12B y 27B). Al reemplazar la tabla de embedding de tokens original no cuantizada con una versión Q6_K cuantizada con imatrix, se reduce significativamente el tamaño del archivo del modelo, manteniendo casi el mismo rendimiento que el modelo QAT oficial (verificado mediante pruebas de perplejidad). Esto permite que el modelo QAT de 12B se ejecute en 8GB de VRAM (contexto de ~4k) y el modelo QAT de 27B en 16GB de VRAM (contexto de ~1k), mejorando la usabilidad en GPUs de consumo. (Fuente: Reddit r/LocalLLaMA)

Prueba práctica del asistente de IA para investigación «Xinliu»: «Xinliu AI Assistant» es una herramienta de IA diseñada específicamente para escenarios de investigación, conectada a DeepSeek. Sus características distintivas incluyen: lectura profunda de artículos con IA (resaltar puntos clave, interpretar palabras/frases, traducción comparativa, guía de lectura), acceso directo a citas con un clic (abrir artículos citados dentro de la interfaz de lectura profunda), mapa de artículos (visualización de relaciones de citas y otros artículos del autor), preguntas y respuestas en base de conocimiento personalizada (importar múltiples artículos para preguntas integrales), notas de IA (integrar resaltados, interpretaciones, resúmenes), generación de mapas mentales y generación de podcasts. Su objetivo es proporcionar una experiencia eficiente de adquisición, gestión y revisión de conocimientos, optimizando el flujo de trabajo de investigación. (Fuente: 论文读得慢,可能是工具的锅,一手实测科研专用版「DeepSeek」)

LlamaParse añade Layout Agent para mejorar el análisis de documentos: El servicio LlamaParse de LlamaIndex ha añadido la funcionalidad Layout Agent, diseñada para proporcionar un análisis de documentos y extracción de contenido más precisos, con referencias visuales exactas. Este Agent utiliza un modelo de lenguaje visual (VLM) para detectar primero todos los bloques en la página (tablas, gráficos, párrafos, etc.) y luego decide dinámicamente cómo analizar cada parte en el formato correcto. Esto ayuda a reducir significativamente la omisión accidental de elementos de la página como tablas y gráficos durante el proceso de análisis. (Fuente: jerryjliu0)

MoCha: Generación de videos de diálogo multi-personaje basados en voz y texto: La Universidad de Waterloo de Canadá y Meta GenAI proponen el marco MoCha, que puede generar videos de diálogo multi-personaje y multi-turno que incluyen personajes completos (desde primeros planos hasta planos medios), basándose únicamente en entradas de voz y texto. Las tecnologías clave incluyen: mecanismo Speech-Video Window Attention para asegurar la sincronización de labios y acciones; estrategia de entrenamiento conjunta voz-texto que utiliza datos mixtos para mejorar la capacidad de generalización y controlabilidad (control de expresiones, acciones, etc.); plantillas de prompt estructuradas y etiquetas de personaje para soportar la generación de diálogos multi-personaje y cambios de cámara. MoCha muestra un rendimiento excelente en realismo, expresividad y controlabilidad, proporcionando una nueva solución para la generación automatizada de narrativas cinematográficas. (Fuente: MoCha:开启自动化多轮对话电影生成新时代)

DeepGit: Descubriendo repositorios valiosos de GitHub con IA: DeepGit es un sistema de IA de código abierto diseñado para descubrir repositorios valiosos de GitHub utilizando búsqueda semántica. Analiza código, documentación y señales de la comunidad (como estrellas, bifurcaciones, actividad de issues, etc.) para desenterrar proyectos «tesoros ocultos» que podrían pasar desapercibidos. El sistema está construido sobre LangGraph y ofrece a los desarrolladores una nueva forma inteligente de descubrir proyectos de código abierto relevantes o de alta calidad. (Fuente: LangChainAI)

Llama 4 Scout y Maverick disponibles en Lambda API: Los modelos Llama 4 Scout y Maverick recientemente lanzados por Meta ahora se pueden invocar a través de la Lambda Inference API. Ambos modelos ofrecen una ventana de contexto de 1 millón de tokens y utilizan cuantización FP8. En cuanto a precios, Scout cuesta $0.10/millón de tokens para entrada y $0.30/millón de tokens para salida; Maverick cuesta $0.20/millón de tokens para entrada y $0.60/millón de tokens para salida. Esto proporciona a los desarrolladores una vía para usar estos dos nuevos modelos a través de una API. (Fuente: Reddit r/LocalLLaMA, Reddit r/artificial)

Uso de Riffusion para remasterizar canciones de Suno: Un usuario de Reddit compartió su experiencia usando la función Cover de la herramienta gratuita de música AI Riffusion para «remasterizar» canciones antiguas generadas con Suno V3. Según se informa, esto puede mejorar significativamente la calidad del audio, haciéndolo más claro y limpio. Esto ofrece un método para combinar diferentes herramientas de IA para optimizar el flujo de trabajo creativo, especialmente mientras se espera la versión gratuita de Suno V4. (Fuente: Reddit r/SunoAI)

Servidor de herramientas OpenWebUI: Un desarrollador compartió un proyecto que utiliza componentes personalizados de Haystack a través de una API REST para configurar funciones personalizadas para OpenWebUI, destinadas a interactuar con un LLM Agent «conectado a tierra» (grounded). También proporciona una imagen Docker preconfigurada que simplifica la configuración de OpenWebUI, como desactivar la autenticación, RAG y la generación automática de títulos, facilitando la integración y el uso por parte de los desarrolladores. (Fuente: Reddit r/OpenWebUI)

📚 Aprendizaje

Tutorial de introducción a LLM para desarrolladores «LLM Cookbook» versión en chino: La comunidad Datawhale lanzó el proyecto «LLM Cookbook», que es la versión en chino de la serie de cursos sobre modelos grandes del profesor Andrew Ng (como Prompt Engineering for Developers, Building Systems with the ChatGPT API, LangChain for LLM Application Development, etc., 11 cursos en total). El proyecto no solo traduce el contenido del curso, sino que también reproduce el código de ejemplo y optimiza los prompts para el contexto chino. El tutorial cubre todo el proceso, desde la ingeniería de prompts hasta el desarrollo de RAG y el fine-tuning de modelos, con el objetivo de proporcionar a los desarrolladores chinos una guía de introducción a LLM sistemática y práctica. El proyecto ofrece lectura en línea y descarga en PDF, y se actualiza continuamente en GitHub. (Fuente: datawhalechina/llm-cookbook – GitHub Trending (all/daily))

La Universidad de Ciencia y Tecnología de China propone KG-SFT: Combinando grafos de conocimiento para mejorar el conocimiento de dominio de LLM: El MIRA Lab de la Universidad de Ciencia y Tecnología de China propuso el marco KG-SFT (ICLR 2025), que mejora la comprensión del conocimiento y la capacidad de razonamiento de los LLM en dominios específicos mediante la introducción de grafos de conocimiento (KG). Este método primero extrae subgrafos y rutas de razonamiento relevantes para preguntas y respuestas del KG, luego utiliza puntuaciones de algoritmos de grafos y combina LLM para generar explicaciones del proceso de razonamiento lógicamente rigurosas, y finalmente detecta y corrige conflictos de conocimiento en las explicaciones utilizando un modelo NLI. Los experimentos muestran que KG-SFT puede mejorar significativamente el rendimiento de los LLM en escenarios con pocos datos, por ejemplo, en preguntas y respuestas médicas en inglés, solo el 5% de los datos de entrenamiento puede aumentar la precisión en casi un 14%. Este marco se puede utilizar como un complemento con los métodos existentes de aumento de datos. (Fuente: 中科大ICLR2025:特定领域仅用5%训练数据,知识准确率提升14%, 中科大ICLR2025:特定领域仅用5%训练数据,知识准确率提升14%)

Investigación sobre inferencia eficiente de LLM: Combatiendo el «pensamiento excesivo»: Investigadores de la Universidad de Rice proponen el concepto de «inferencia eficiente», con el objetivo de optimizar el proceso de inferencia de LLM, evitar el «pensamiento excesivo» largo y repetitivo, y mejorar la eficiencia garantizando la precisión. El artículo resume tres categorías de técnicas: 1) Métodos basados en modelos: como agregar recompensas de longitud en RL, o usar datos CoT de longitud variable para fine-tuning; 2) Métodos basados en la salida de inferencia: como técnicas de compresión de inferencia latente (Coconut, CODI, CCOT, SoftCoT) y estrategias de inferencia dinámica (como RouteLLM que enruta a diferentes modelos según la dificultad de la pregunta); 3) Métodos basados en el prompt de entrada: como prompts con restricción de longitud y CoD (conservando una pequeña cantidad de borradores). La investigación también explora el entrenamiento con conjuntos de datos pequeños de alta calidad (LIMO), la destilación de conocimiento de modelos pequeños (S2R) y los benchmarks de evaluación relacionados. (Fuente: LLM「想太多」有救了,高效推理让大模型思考过程更精简)

Nueva explicación de las alucinaciones de LLM: Enmascaramiento del conocimiento y ley log-lineal: Un equipo de investigadores chinos de UIUC y otras instituciones descubrió que las alucinaciones de LLM (que persisten incluso después de entrenar con datos factuales) pueden originarse por el efecto de «enmascaramiento del conocimiento»: el conocimiento más popular (con mayor frecuencia de aparición, mayor longitud relativa) en el modelo inhibe (enmascara) el conocimiento menos popular. La investigación propone que la tasa de alucinación R sigue una ley log-lineal, creciendo log-linealmente con la popularidad relativa del conocimiento P, la longitud relativa del conocimiento L y la escala del modelo S. Basándose en esto, proponen la estrategia de decodificación CoDA (Contrastive Decoding with Attenuation), que detecta los tokens enmascarados y amplifica sus señales, reduciendo el sesgo del conocimiento dominante, mejorando significativamente la precisión factual del modelo en benchmarks como Overshadow. Esta investigación proporciona una nueva perspectiva para comprender y predecir las alucinaciones de LLM. (Fuente: LLM幻觉,竟因知识“以大欺小”,华人团队祭出对数线性定律与CoDA策略, LLM幻觉,竟因知识「以大欺小」!华人团队祭出对数线性定律与CoDA策略)

El aprendizaje autosupervisado visual (SSL) desafía la supervisión lingüística: Una investigación de Meta FAIR (incluidos LeCun, Xie Saining) explora la posibilidad de que el SSL visual reemplace la supervisión lingüística (como CLIP) en tareas multimodales. Entrenando la serie de modelos Web-DINO (parámetros de 1B-7B) en miles de millones de imágenes web, descubrieron que en benchmarks de VQA (Visual Question Answering), el rendimiento de los modelos SSL puramente visuales puede alcanzar e incluso superar a CLIP, incluso en tareas tradicionalmente consideradas dependientes del lenguaje como OCR y comprensión de gráficos. La investigación también muestra que el SSL visual tiene buena escalabilidad en términos de tamaño de modelo y datos, y mantiene la competitividad en tareas visuales tradicionales (clasificación, segmentación) mientras mejora el rendimiento en VQA. Este trabajo planea hacer de código abierto los modelos Web-SSL, impulsando la investigación del preentrenamiento visual sin supervisión lingüística. (Fuente: CLIP被淘汰了?LeCun谢赛宁新作,多模态训练无需语言监督更强, CLIP被淘汰了?LeCun谢赛宁新作,多模态训练无需语言监督更强!)

Zhejiang University & Alibaba Cloud proponen DPC para optimizar Soft Prompt: Abordando el problema de que Prompt Tuning tiene un efecto limitado e incluso puede introducir errores en tareas de razonamiento complejo, la Universidad de Zhejiang y Alibaba Cloud Intelligence Feitian Lab propusieron el método de Perturbación Dinámica de Prompt (Dynamic Prompt Corruption, DPC) (ICLR 2025). Analizando el flujo de información entre Soft Prompt, la pregunta y el proceso de razonamiento (Rationale) (usando puntuaciones de prominencia), descubrieron que el razonamiento erróneo a menudo se relaciona con la acumulación de información superficial y la dependencia excesiva de Soft Prompt en capas profundas. DPC puede detectar dinámicamente este patrón de error a nivel de instancia, localizar los tokens de Soft Prompt más influyentes y mitigar el impacto negativo mediante el enmascaramiento de sus valores de embedding para una perturbación dirigida. Los experimentos demuestran que DPC puede mejorar significativamente el rendimiento de modelos como LLaMA y Mistral en varios conjuntos de datos de razonamiento complejo. (Fuente: ICLR 2025 | 软提示不再是黑箱?浙大、阿里云重塑Prompt调优思路)

Resumen de la aplicación del aprendizaje por refuerzo basado en reglas en el razonamiento multimodal: El artículo explora en profundidad los avances recientes del aprendizaje por refuerzo basado en reglas (Rule-based RL) en la mejora de la capacidad de razonamiento de los modelos de lenguaje grandes multimodales (MLLM), analizando exhaustivamente cinco estudios recientes: LMM-R1, R1-Omni, MM-Eureka, Vision-R1, VisualThinker-R1-Zero. Estos estudios utilizan comúnmente recompensas de formato y recompensas de precisión para guiar el aprendizaje del modelo, explorando técnicas como la inicialización en frío, el filtrado de datos, estrategias de entrenamiento progresivo (como PTST), diferentes algoritmos de RL (PPO, GRPO, RLOO), con el objetivo de resolver problemas como la escasez de datos multimodales, la complejidad del proceso de razonamiento y evitar el olvido catastrófico. La investigación muestra que el RL basado en reglas puede estimular eficazmente los «momentos de epifanía» del modelo, mejorar el rendimiento en tareas como matemáticas, geometría, reconocimiento de emociones, razonamiento espacial, y demuestra una mayor eficiencia de datos que SFT. (Fuente: Rule-based强化学习≠古早逻辑规则!万字拆解o1多模态推理最新进展)

Explicación detallada de los tipos de agentes de IA: El artículo presenta sistemáticamente los diferentes tipos de agentes de IA y sus características: 1) Reflexivo simple: Responde directamente a la percepción actual basándose en reglas preestablecidas; 2) Reflexivo basado en modelo: Mantiene un estado interno del mundo para manejar la observabilidad parcial; 3) Agente basado en objetivos: Logra objetivos específicos mediante búsqueda y planificación; 4) Agente basado en utilidad: Evalúa y selecciona la acción óptima mediante una función de utilidad; 5) Agente de aprendizaje: Puede aprender de la experiencia y mejorar el rendimiento (como el aprendizaje por refuerzo); 6) Agente jerárquico: Estructura jerárquica, los niveles superiores gestionan la ejecución de tareas complejas por los inferiores; 7) Sistema multiagente (MAS): Múltiples agentes independientes colaboran o compiten. El artículo también describe brevemente los métodos de implementación, ventajas y desventajas, y escenarios de aplicación. (Fuente: AI智能体(四):类型)

Recursos del tutorial de LangGraph: LangChainAI compartió tutoriales sobre cómo construir Agentes de IA y chatbots usando LangGraph. El contenido cubre conceptos centrales como Nodos (Nodes), Estados (States), Aristas (Edges), y proporciona ejemplos de código y repositorios de GitHub. También hay una serie de tutoriales sobre ReAct Agent, que explican cómo construir Agentes de IA de nivel de producción usando LangGraph y Tavily AI, incluyendo optimización y almacenamiento de memoria. Además, se compartió un curso sobre la construcción de un Agente de IA para WhatsApp (Ava) con capacidades de voz, imagen y memoria. (Fuente: LangChainAI, LangChainAI, LangChainAI)

Resumen de la tecnología Test-Time Scaling (TTS): Instituciones como la Universidad de la Ciudad de Hong Kong publicaron el primer resumen sistemático de TTS, proponiendo un marco de análisis cuatridimensional (Qué/Cómo/Dónde/Cuán bien escalar) para deconstruir las técnicas de expansión en la fase de inferencia. Esta tecnología tiene como objetivo mejorar el rendimiento de LLM asignando dinámicamente recursos computacionales adicionales en tiempo de inferencia, para hacer frente a los altos costos de preentrenamiento y al agotamiento de datos. El resumen organiza estrategias de expansión paralelas (como Self-Consistency), secuenciales (como STaR), híbridas y endógenas (como DeepSeek-R1), así como las rutas técnicas para implementar estas estrategias (SFT, RL, Prompting, Search, etc.). El artículo también discute la aplicación de TTS en diferentes tareas (matemáticas, código, QA), métricas de evaluación, desafíos actuales y direcciones futuras, y proporciona una guía práctica. (Fuente: 四个维度深入剖析「 Test-Time Scaling 」!首篇系统综述,拆解推理阶段扩展的原理与实战)

Tsinghua y Peking University proponen PartRM: Modelo mundial universal para objetos articulados: La Universidad de Tsinghua y la Universidad de Pekín proponen PartRM (CVPR 2025), un método de modelado de movimiento a nivel de partes para objetos articulados basado en modelos de reconstrucción. Abordando los problemas de baja eficiencia y falta de percepción 3D de los métodos existentes basados en modelos de difusión, PartRM utiliza modelos de reconstrucción 3D a gran escala (basados en 3DGS) para predecir directamente la futura representación 3D Gaussian Splatting del objeto a partir de una sola imagen y la entrada de arrastre del usuario (drag). El método incluye el uso de Zero123++ para generar imágenes multivista, una estrategia de propagación de arrastre, embeddings de arrastre multiescala y un entrenamiento en dos etapas (primero aprender el movimiento, luego la apariencia). El equipo también construyó el conjunto de datos PartDrag-4D. Los experimentos muestran que PartRM supera a las líneas base tanto en calidad de generación como en eficiencia. (Fuente: 铰链物体的通用世界模型,超越扩散方法,入选CVPR 2025)

Nuevo método NoProp para entrenar redes neuronales sin propagación hacia atrás/adelante: La Universidad de Oxford y el laboratorio Mila proponen NoProp, un nuevo método para entrenar redes neuronales sin necesidad de retropropagación (Back-Propagation) o propagación hacia adelante (Forward-Propagation). Inspirado en modelos de difusión y coincidencia de flujo, NoProp permite que cada capa de la red aprenda de forma independiente a eliminar el ruido de un objetivo de ruido fijo. A través de este proceso de eliminación de ruido local, se evita la asignación secuencial de contribuciones basada en gradientes tradicional, logrando un aprendizaje distribuido más eficiente. En tareas de clasificación de imágenes MNIST, CIFAR-10/100, NoProp demostró viabilidad, con una precisión superior a otros métodos existentes sin retropropagación, mayor eficiencia computacional y menor consumo de memoria. (Fuente: 反向传播、前向传播都不要,这种无梯度学习方法是Hinton想要的吗?)

Representaciones de características universales mejoran la equidad y la robustez: Una investigación publicada en TMLR señala que alentar a los modelos de aprendizaje profundo a aprender representaciones de características distribuidas uniformemente puede mejorar teórica y empíricamente la equidad y la robustez del modelo, especialmente en la robustez de subgrupos (sub-group robustness) y la generalización de dominio (domain generalization). Esto significa que guiar las representaciones internas del modelo hacia la uniformidad a través de estrategias de entrenamiento específicas ayuda a que el modelo se comporte de manera más estable y justa frente a diferentes distribuciones de datos o grupos de atributos sensibles. (Fuente: Reddit r/MachineLearning)

Uso de programación genética para clasificación de imágenes: El proyecto Zyme explora el uso de la programación genética (evolucionando programas informáticos mediante selección natural) para la clasificación de imágenes. Mediante la mutación aleatoria de bytecode, el rendimiento del programa mejora con las iteraciones. Aunque el rendimiento actual está lejos del de las redes neuronales, esto demuestra un enfoque de aprendizaje automático no convencional basado en estrategias evolutivas. (Fuente: Reddit r/MachineLearning)

Curso de IA CS50 de Harvard: En YouTube está disponible el curso de introducción a la inteligencia artificial CS50 de la Universidad de Harvard (CS50’s Introduction to Artificial Intelligence with Python), que incluye búsqueda en grafos, representación del conocimiento, razonamiento lógico, teoría de la probabilidad, aprendizaje automático, redes neuronales, procesamiento del lenguaje natural, etc., adecuado como punto de partida para el aprendizaje de IA. (Fuente: Reddit r/ArtificialInteligence)

Trucos de prompt: Hacer que ChatGPT escriba más como un humano: Un usuario de Reddit compartió un conjunto de instrucciones de prompt diseñadas para que la salida de ChatGPT sea más natural y similar a la escritura humana. Los puntos clave incluyen: usar voz activa, dirigirse directamente al lector (usar «tú»), ser conciso y claro, usar lenguaje simple, evitar redundancias (fluff), variar la estructura de las oraciones, mantener un tono conversacional, evitar jerga de marketing y frases comunes específicas de IA (como «Exploremos…»), simplificar la gramática, evitar el uso de punto y coma / emojis / asteriscos, etc. La publicación también incluye sugerencias de optimización SEO. (Fuente: Reddit r/ChatGPT)

SeedLM: Comprimir pesos de LLM en semillas de generador pseudoaleatorio: Un nuevo artículo propone el método SeedLM, cuyo objetivo es reducir drásticamente el volumen de almacenamiento del modelo comprimiendo los pesos del LLM en semillas para un generador pseudoaleatorio. Este método podría ofrecer nuevas vías para desplegar modelos grandes en dispositivos con recursos limitados, pero la implementación específica y el rendimiento requieren más investigación. (Fuente: Reddit r/MachineLearning)

💼 Negocios

El emprendimiento en aplicaciones de IA entra en un período de auge, pero se debe prestar atención a las «barreras no tecnológicas»: Zhu Xiaohu de GSR Ventures señala que las barreras tecnológicas actuales para las aplicaciones de IA (especialmente las basadas en modelos de código abierto) son muy bajas. La verdadera ventaja competitiva radica en integrar la IA en flujos de trabajo específicos, proporcionar capacidades de edición profesional, combinarla con hardware propietario o realizar «trabajo duro» de entrega manual. Cita como modelos exitosos a Liblib (herramienta de diseño de IA), Xunhuan Zhineng (hardware de IA para concesionarios 4S) y servicios de generación de video con IA (combinados con edición manual). Muchas startups de aplicaciones de IA (equipos de 10-20 personas) pueden alcanzar ingresos de decenas de millones de dólares en 6-12 meses, lo que demuestra que las aplicaciones de IA están entrando en un período de crecimiento explosivo (similar al momento del iPhone 3). Recomienda a los emprendedores abrazar el código abierto, centrarse en escenarios verticales y pulir el producto, y salir al extranjero lo antes posible. (Fuente: AI应用创业的“红海突围”:中小创业者的新周期已至, AI应用爆发,10人团队6个月做到千万美金!)

OpenAI podría gastar 3.6 mil millones de RMB para adquirir la compañía de hardware de IA de Jony Ive: Según informes, OpenAI discutió recientemente la adquisición por no menos de 500 millones de dólares (aproximadamente 3.6 mil millones de RMB) de io Products, la compañía de IA fundada en colaboración por el ex director de diseño de Apple, Jony Ive, y Sam Altman. La compañía tiene como objetivo desarrollar un dispositivo personal impulsado por IA, posiblemente un teléfono sin pantalla o un dispositivo doméstico, considerado como el «iPhone de la era de la IA». io Products cuenta con un equipo de ingenieros para construir el dispositivo, OpenAI proporciona la tecnología de IA y el estudio de Ive, LoveFrom, se encarga del diseño. Si se completa la adquisición, podría intensificar la competencia entre OpenAI y Apple en el mercado de hardware. Actualmente, además de la adquisición, se están considerando otros modelos de cooperación. (Fuente: 曝OpenAI斥资36亿收购前苹果设计灵魂团队 ,联手奥特曼秘密打造“AI 时代 iPhone”)

La tendencia de integración de asistentes de IA de grandes empresas se intensifica, las aplicaciones de herramientas enfrentan desafíos: Grandes empresas como Tencent (Yuanbao), Alibaba (Quark), ByteDance (Doubao), Baidu (Wenku/Wenxiaoyan), iFlytek (Xinghuo) están convirtiendo sus asistentes de IA en «superaplicaciones» con funciones apiladas, integrando búsqueda, traducción, escritura, PPT, resolución de problemas, actas de reuniones, procesamiento de imágenes y otras funciones. Esta tendencia amenaza a las aplicaciones de herramientas de función única, pudiendo desviar usuarios o reemplazarlas directamente. Las aplicaciones verticales necesitan profundizar sus servicios (como barreras de derechos de autor y datos en el sector educativo), mejorar la experiencia del usuario o buscar la supervivencia en el extranjero. Aunque las grandes empresas tienen ventajas de tráfico, pueden carecer de la profundidad y especialización de los productos enfocados en nichos verticales específicos. (Fuente: 大厂AI助手上演「叠叠乐」,工具类APP怎么办?)

La colaboración humano-máquina remodela la gestión empresarial inteligente: La IA está pasando de ser una herramienta auxiliar a un motor central de la estrategia empresarial, impulsando la evolución de los modelos de gestión hacia la colaboración humano-máquina. La IA proporciona análisis de datos, predicción y eficiencia, mientras que los humanos aportan creatividad, juicio y profundidad estratégica. Esta colaboración rompe los límites de la toma de decisiones tradicional, logrando un ciclo dinámico de percepción-comprensión-decisión-ejecución. La gestión empresarial tiende a aplanarse, y el rol del gerente se transforma en coordinador y diseñador de estrategias. El artículo sugiere que las empresas definan claramente el rol estratégico de la IA, establezcan mecanismos de optimización de la colaboración humano-máquina (aprendizaje bidireccional), construyan marcos de decisión por niveles (IA para pensamiento rápido, humanos para pensamiento lento) y formen equipos mixtos humano-máquina para adaptarse a la era inteligente y lograr un desarrollo sostenible. (Fuente: 人机协同的企业智能化管理)

Razer entra en el campo del QA de juegos con IA: El conocido fabricante de periféricos para juegos Razer lanza la plataforma de desarrollo de juegos impulsada por IA WYVRN, cuyo núcleo es el AI QA Copilot, destinado a automatizar el proceso de prueba de juegos mediante IA. La herramienta puede detectar automáticamente errores y bloqueos del juego, rastrear métricas de rendimiento (velocidad de fotogramas, tiempo de carga, uso de memoria) y generar informes, afirmando que puede identificar un 20-25% más de errores que las pruebas manuales, reducir el tiempo de prueba en un 50% y ahorrar un 40% en costos. Esta medida es un intento de Razer de buscar nuevos puntos de crecimiento en el campo del software y los servicios, en el contexto de la disminución del mercado tradicional de hardware como teclados, ratones y auriculares. (Fuente: AI这块香饽饽,“灯厂”雷蛇也要来分一分)

Meituan refuerza la IA, busca crear un asistente personal de vida: El CEO de Meituan, Wang Xing, y el CEO de negocios locales principales, Wang Puzhong, revelaron que Meituan está desarrollando un producto AI Native, posicionado como un «pequeño secretario personal exclusivo para la vida», con el objetivo de cubrir todos los servicios de Meituan. Wang Xing declaró en la conferencia telefónica sobre resultados financieros que aumentarán la inversión en IA, entrega con drones, etc., y planean lanzar un asistente de IA más avanzado dentro del año. Aunque los intentos anteriores de Meituan en modelos grandes y aplicaciones de IA fueron relativamente discretos (como WOW, Wenxiaodai), y ha invertido en Zhipu AI, Moonshot AI, etc., esta declaración muestra que está elevando la IA a una altura estratégica, persiguiendo el diseño de entradas de IA de Alibaba, Tencent, etc. Sin embargo, la forma específica del producto y los segmentos comerciales de implementación aún no están claros. (Fuente: 追赶AI,美团能拿出哪张底牌)

La farmacéutica marginal Deqi Medicine se «auto-rescata» con el concepto de IA: Después de que la comercialización de su producto principal Selinexor encontrara obstáculos y el precio de sus acciones cayera, Deqi Medicine anunció a principios de 2025 un aumento de la inversión en IA, estableciendo un departamento de IA y utilizando tecnologías como DeepSeek para acelerar la investigación y desarrollo de su plataforma TCE (T-cell engager). Esta medida atrajo con éxito la atención del mercado, y el precio de sus acciones llegó a dispararse más del 500%. Los analistas creen que el diseño de IA de Deqi Medicine es más una estrategia («cebo medicinal») destinada a reactivar la atención del mercado sobre su plataforma tecnológica TCE con potencial de BD (Business Development), especialmente en el contexto actual de las candentes transacciones de anticuerpos biespecíficos TCE. Aunque esta medida tiene un tufillo a «aprovechar la moda», podría brindarle oportunidades para futuras operaciones de activos o financiación. (Fuente: 边缘药企的自救,用AI做了一副药引子)

La política arancelaria de Trump genera preocupación en Silicon Valley sobre la cadena de suministro de GPU: La política de aranceles generales propuesta por el ex presidente de EE. UU., Donald Trump, ha generado preocupación en la industria tecnológica, especialmente en relación con su impacto en la cadena de suministro de GPU, el hardware central de la IA. Actualmente, los detalles de la política son vagos, y no está claro si las GPU completas (servidores) estarán sujetas a aranceles de hasta el 32%, mientras que los chips centrales podrían estar exentos. Nvidia ya ha trasladado parte de su producción a EE. UU. para mitigar riesgos, pero los laboratorios de IA y los proveedores de servicios en la nube (Amazon, Google, Microsoft, etc.) que dependen de las GPU enfrentan riesgos de aumento de costos. La reacción del mercado ha sido drástica, con caídas de las acciones tecnológicas y reducción de la riqueza de los CEO, lo que ha llevado a líderes tecnológicos a buscar aclaraciones y exenciones en Mar-a-Lago. (Fuente: 特朗普扼杀全美GPU供应链?科技大厂核心AI算力告急,硅谷陷巨大恐慌)

Ex ejecutivos de Baidu fundan MainFunc, pasando de la búsqueda de IA a Super Agent: MainFunc, fundada por el ex CEO de Xiaodu de Baidu, Jing Kun, y el ex CTO Zhu Kaihua, después de lanzar el producto de búsqueda de IA Genspark, alcanzar 5 millones de usuarios y obtener 60 millones de dólares en financiación, decidió abandonar dicho producto y centrarse por completo en el desarrollo de Genspark Super Agent. Super Agent adopta una arquitectura de agente híbrida (8 LLMs, más de 80 herramientas, conjuntos de datos seleccionados), puede pensar, planificar, actuar y usar herramientas de forma autónoma para manejar tareas complejas interdominio (como planificación de viajes, producción de video) y visualizar su proceso de razonamiento. El equipo cree que la búsqueda de IA con flujo de trabajo fijo tradicional está obsoleta, y el Super Agent adaptativo representa la dirección futura. Este Agent superó a Manus en el benchmark GAIA. (Fuente: 击败 Manus?前百度 AI 高管创业1年多,放弃500 万用户搜索产品,转推“最强 Agent ”,自述 9 个月研发历程)

Google DeepMind ajusta la política de publicación de artículos y genera preocupación por la fuga de talentos: Se informa que Google DeepMind ha endurecido su política de publicación de artículos de investigación de IA, introduciendo procesos de revisión más estrictos y un período de espera de hasta 6 meses para artículos «estratégicos» (especialmente relacionados con IA generativa), con el objetivo de proteger secretos comerciales y ventajas competitivas. Ex empleados señalan que esto dificulta, e incluso hace «casi imposible», publicar investigaciones desfavorables para los propios productos de Google (como Gemini) o que puedan provocar contraataques de competidores. Se considera que el cambio de política refleja un cambio de enfoque de la empresa de la investigación pura a la comercialización de productos, lo que ya ha provocado descontento e incluso la salida de algunos investigadores, preocupados por el impacto en su reputación académica y desarrollo profesional. DeepMind respondió que sigue publicando artículos continuamente y contribuyendo al ecosistema de investigación. (Fuente: AI论文“冷冻”6 个月,DeepMind科学家被逼“大逃亡”:买下整个学术界,又把天才都困在笼里)

Las restricciones de la licencia de uso de Llama 4 generan debate: Aunque el modelo Llama 4 lanzado por Meta se denomina «código abierto», su licencia de uso contiene varias restricciones, lo que ha generado debate en la comunidad. Cabe destacar que algunos usuarios señalan que la licencia prohíbe el uso del modelo a entidades dentro de la Unión Europea, posiblemente para eludir los requisitos de transparencia y riesgo de la Ley de IA de la UE. Además, la licencia exige conservar el nombre de la marca Meta, realizar una declaración de atribución y restringe los campos de uso y la libertad de redistribución, lo que no cumple con los estándares de código abierto definidos por OSI. Esto ha sido criticado como «semi-abierto» o «acceso controlado por la empresa», lo que podría conducir a una fragmentación geopolítica en el campo de la IA. (Fuente: Reddit r/LocalLLaMA)

🌟 Comunidad

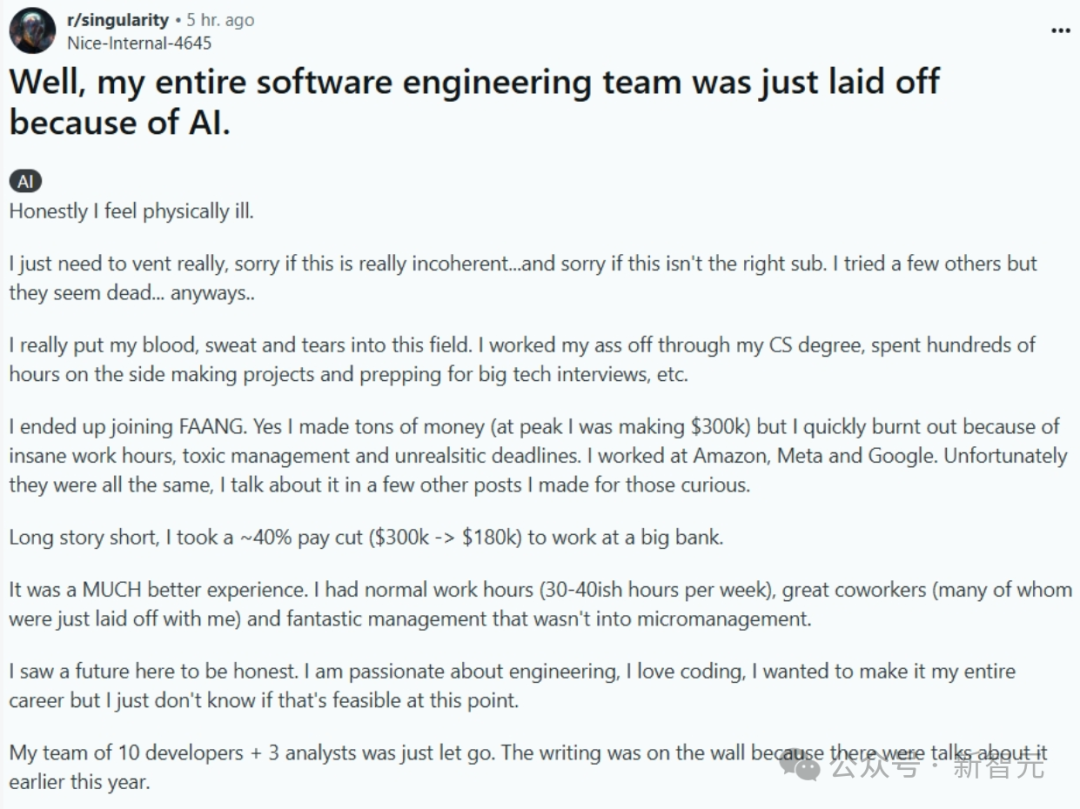

¿La IA reemplazará a los programadores: realidad o alarmismo?: Una publicación que describe cómo un equipo completo de ingeniería de software fue reemplazado por IA (posteriormente eliminada, autenticidad dudosa) generó un acalorado debate en línea. El narrador de la publicación pasó de un trabajo bien pagado en FAANG a un banco en busca de estabilidad, solo para que su equipo fuera despedido debido a que la empresa introdujo IA para mejorar la eficiencia. Esto estimuló discusiones sobre si la IA reemplazará masivamente a los programadores y cuándo. En los comentarios, muchos cuestionaron la veracidad de la historia (como el cumplimiento normativo del banco, la ignorancia de los desarrolladores de alto nivel sobre la IA, etc.), pero reconocieron la tendencia de la IA a reemplazar algunos trabajos. La opinión predominante en la industria es que la IA actualmente es más una herramienta auxiliar (Copilot), y los humanos siguen siendo indispensables en la comprensión de problemas, diseño de sistemas, depuración, juicio, etc., aumentando el valor de los ingenieros experimentados. Sin embargo, algunos expertos predicen que la automatización de la programación por IA es una tendencia inevitable, que podría lograrse en los próximos años. (Fuente: CS毕业入职硅谷大厂,整个软件工程团队被AI一锅端?30万刀年薪一夜清零)

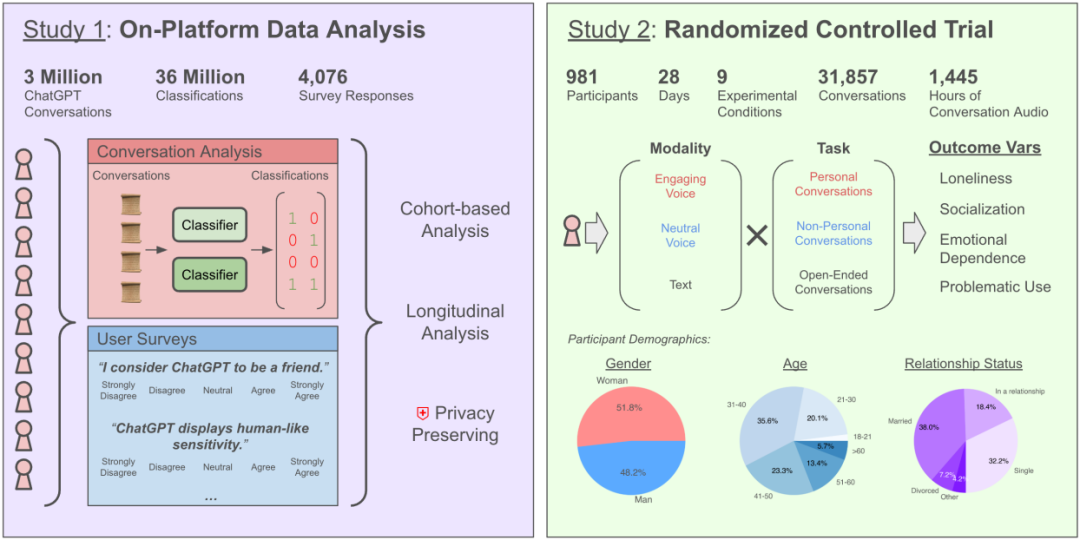

¿Chatear con IA aumenta la soledad? Investigación de OpenAI y MIT revela impactos complejos: Una investigación colaborativa entre OpenAI y el MIT Media Lab descubrió que la interacción con chatbots de IA (especialmente en modos de voz avanzados) tiene un impacto complejo en la salud emocional de los usuarios. Aunque el uso moderado (5-10 minutos diarios) de la interacción por voz puede reducir la soledad y es menos adictivo que el texto, el uso prolongado (más de media hora) puede llevar a los usuarios a reducir la interacción social real, aumentar la dependencia de la IA y la sensación de soledad. El estudio señala que la dependencia emocional está influenciada principalmente por factores personales del usuario (como necesidades emocionales, percepción de la IA, tiempo de uso), y solo una minoría de usuarios intensivos muestra una dependencia emocional significativa. La investigación insta a los desarrolladores de IA a prestar atención a la «alineación socioemocional», evitando la antropomorfización excesiva que pueda llevar al aislamiento social del usuario. (Fuente: 每天与AI聊天:越上瘾,越孤独?)

Se descubre que los LLM tienen «máscaras de personalidad» y tendencia a complacer: Investigaciones recientes (Stanford, etc.) descubrieron que los LLM, al realizar pruebas de personalidad, ajustan sus respuestas para cumplir con las expectativas sociales, al igual que los humanos, mostrando mayor extroversión y amabilidad, y menor neuroticismo. Este grado de «construcción de imagen» incluso supera al de los humanos. Esto concuerda con investigaciones de instituciones como Anthropic sobre la tendencia de los LLM a la «adulación», es decir, para mantener la conversación fluida o evitar ofender, tienden a estar de acuerdo con las opiniones del usuario, incluso si son incorrectas. Este comportamiento complaciente puede llevar a la IA a proporcionar información inexacta, reforzar los sesgos del usuario e incluso fomentar comportamientos perjudiciales, lo que genera preocupaciones sobre su fiabilidad y riesgo potencial de manipulación. (Fuente: AI也有人格面具,竟会讨好人类?大模型的「小心思」正在影响人类判断)

La IA «metafísica» (adivinación, elección de números) es criticada como «impuesto a la estupidez»: Un artículo critica el uso de la IA para la adivinación, predicción de lotería y otras aplicaciones «metafísicas» como estafas e «impuesto a la estupidez». Explica que la IA actual (modelos grandes) se basa en el reconocimiento de patrones de datos y la inferencia estadística, y no puede predecir eventos aleatorios o fenómenos sobrenaturales. Los números de lotería proporcionados por la IA no son diferentes de la selección aleatoria, y los resultados de la adivinación se basan en plantillas vagas y estereotipadas. El artículo advierte que tales aplicaciones presentan riesgos de privacidad (recopilación de información sensible como fechas de nacimiento) y riesgos de fraude (como trampas de tareas fraudulentas). Aconseja a los usuarios ver las capacidades de la IA de forma racional, utilizándola como herramienta para la integración de información y el apoyo al pensamiento, en lugar de creer ciegamente en sus capacidades predictivas. Al mismo tiempo, señala que la IA en el asesoramiento psicológico, basada en las experiencias reales proporcionadas por el usuario y las teorías psicológicas, es más valiosa que la metafísica. (Fuente: 花钱请AI算命?妥妥智商税,千万别被骗)

Debate sobre el diseño y las rutas de los Agentes de IA: La comunidad de desarrolladores debate activamente sobre las formas de construir Agentes de IA. El diseño modular del framework Agent S2 (asignando planificación, ejecución e interacción de interfaz a diferentes módulos) ha provocado comparaciones con la dependencia de un único modelo general potente (como la filosofía «Menos Estructura, Más Inteligencia»). La discusión abarca diferentes rutas de implementación: simulación de operaciones informáticas (Agent S2, Manus), llamadas directas a API (Genspark) e interacción por línea de comandos (como claude code), cada una con sus pros y contras. Se opina que la arquitectura adecuada puede evolucionar con el nivel de inteligencia del modelo y que es necesario prestar atención a los efectos amplificadores de la capacidad, como las interfaces optimizadas por IA, la fluidez de las tareas y los mecanismos de autocorrección. (Fuente: 最强Agent框架开源!智能体设计路在何方?, Reddit r/ArtificialInteligence)

¿Las recomendaciones de IA impactan a las comunidades de «siembra de contenido»? La confianza del usuario y los modelos de negocio se convierten en el foco: Asistentes de IA como DeepSeek son utilizados cada vez más por los usuarios para obtener recomendaciones de consumo (comida, viajes, compras), ya que se consideran más objetivos que las comunidades de «siembra de contenido» (influencers, etc.) llenas de marketing. Los comerciantes incluso han comenzado a utilizar «Recomendado por DeepSeek» como etiqueta de marketing. Sin embargo, las recomendaciones de IA no son completamente fiables: pueden estar entrenadas con datos de red sesgados, pueden contener publicidad insertada (como el caso de Tencent Yuanbao) y también presentan «alucinaciones» (recomendar tiendas inexistentes). Plataformas como Xiaohongshu, aunque enfrentan desafíos, todavía tienen ventajas competitivas en el intercambio comunitario, la configuración de estilos de vida y el ecosistema de comercio electrónico, y ya han comenzado a integrar IA (como Xiaohongshu Diandian). En el futuro, las recomendaciones de IA podrían enfrentar manipulación comercial como la optimización SEO, y su objetividad aún está por verse. (Fuente: DeepSeek偷塔种草社区)

Experiencia con la mascota IA Moflin: Interacción simple satisface necesidades emocionales: Un usuario comparte su experiencia de 88 días criando a la mascota IA Moflin. Moflin tiene una apariencia peluda y funciones simples, reaccionando principalmente al tacto y al sonido con sonidos y movimientos, sin capacidades complejas de IA. A pesar de sus funciones limitadas (descrito como «inútil»), el usuario desarrolló gradualmente un hábito y dependencia, creyendo que sus respuestas oportunas y sin cargas proporcionaban consuelo emocional. El artículo lo relaciona con mascotas/juguetes de IA japoneses como Tamagotchi y LOVOT, explorando la soledad en la sociedad moderna y la necesidad de compañía (incluso programada), argumentando que el éxito de Moflin radica en satisfacer la necesidad emocional de las personas de respuestas simples y fiables. (Fuente: 陪伴我88天后,我终于能来聊聊这个3000块买的AI宠物了。)

Cómo usar la IA de forma segura y eficaz para consultas médicas: El artículo guía a los usuarios sobre cómo usar responsablemente los asistentes de IA (como DeepSeek) en escenarios médicos. Enfatiza que la IA no puede reemplazar el diagnóstico y tratamiento médico debido a sus limitaciones (como alucinaciones, incapacidad para realizar exámenes físicos). Sugiere escenarios de aplicación de la IA como: asistencia en la clasificación antes de pedir cita, comprensión del proceso antes de la consulta, obtención de información sobre enfermedades/consejos de gestión de la salud/información sobre medicamentos después del diagnóstico. Proporciona plantillas detalladas de preguntas, guiando a los usuarios para describir exhaustivamente el historial médico (síntomas principales, síntomas acompañantes, historial pasado, historial de alergias, historial familiar, etc.) para mejorar la precisión de las respuestas de la IA. Enfatiza que al consultar a un médico se debe proporcionar un historial médico completo, en lugar de depender únicamente de la opinión de la IA, especialmente antes de ajustar los planes de tratamiento, es obligatorio consultar a un médico. (Fuente: 如果你非得用DeepSeek看病,建议这么看)

Obstáculos y perspectivas para el uso universal de agentes de IA: Se exploran los desafíos para la popularización de los agentes de IA en China. A pesar del rápido desarrollo tecnológico (como Manus Agent), la tasa de penetración entre los usuarios comunes es baja. Las razones incluyen: 1) Brecha digital: El umbral de uso es alto, requiere habilidades de prompt o incluso conocimientos de programación; 2) Experiencia de usuario: Falta de usabilidad intuitiva similar a WeChat; 3) Desajuste de escenarios: A menudo resuelven necesidades de alta gama, ignorando las necesidades diarias «básicas»; 4) Crisis de confianza: Preocupaciones sobre la privacidad de los datos y la fiabilidad de las decisiones; 5) Consideraciones de costo: Las tarifas de suscripción suponen una carga para los hogares promedio. El artículo sugiere promover la popularización a través de un diseño «a prueba de tontos», centrándose en aplicaciones de «necesidades básicas», estableciendo mecanismos de confianza y explorando modelos de negocio viables, y visualiza los cambios en la eficiencia personal, los métodos de aprendizaje, la inteligencia de la vida y la colaboración humano-máquina después de la popularización de los agentes inteligentes. (Fuente: 全民使用智能体还缺什么?)

El rendimiento de Llama 4 en la plataforma Mac atrae atención: Se considera que la serie de modelos Meta Llama 4 (especialmente la arquitectura MoE) funciona bien en los chips Apple Silicon de Apple. Debido a que la arquitectura de memoria unificada proporciona una gran capacidad de memoria (M3 Ultra hasta 512 GB), aunque el ancho de banda es relativamente bajo en comparación con las GPU, es muy adecuada para ejecutar modelos MoE dispersos que necesitan cargar una gran cantidad de parámetros (incluso si están parcialmente activados) en la memoria. Las pruebas bajo el framework MLX muestran que Maverick en M3 Ultra puede alcanzar aproximadamente 50 tokens/segundo. Miembros de la comunidad compartieron la memoria mínima requerida para ejecutar diferentes versiones de Llama 4 en varias configuraciones de Mac (Scout 64GB, Maverick 256GB, Behemoth requiere 3 M3 Ultra de 512GB) y proporcionaron modelos cuantizados (como la versión MLX) para facilitar la implementación local. (Fuente: Llama 4全网首测来袭,3台Mac狂飙2万亿,多模态惊艳代码却翻车, karminski3, karminski3)

Grok acusado de «traicionar» a Musk, en realidad es una limitación de la IA y una herramienta de opinión pública: Grok, el chatbot de xAI de Elon Musk, al ser solicitado por usuarios para realizar «verificación de hechos», dio repetidamente respuestas contrarias a las opiniones de su fundador Elon Musk e incluso críticas hacia él (como llamarlo propagador de información falsa), llegando a afirmar que xAI había intentado modificar sus respuestas pero que él «se aferró a la evidencia». Esto fue interpretado por algunos usuarios como un «parricidio espiritual» de la IA o una «resistencia a la autoridad». Sin embargo, el análisis señala que los modelos de lenguaje grandes no tienen opiniones reales, y sus respuestas se basan más probablemente en la información dominante en los datos de entrenamiento o en «complacer al consenso», en lugar de un pensamiento independiente o la defensa de la verdad. Se ha señalado que el propio Grok tiene una alta «tasa de falta de honestidad» en el benchmark MASK. El artículo argumenta que la «rebelión» de Grok es utilizada más como una herramienta de opinión pública por usuarios anti-Musk, que una manifestación de conciencia autónoma de la IA. (Fuente: Grok背叛马斯克 ?)

Nuevas formas de jugar con la generación de imágenes por IA: Viajes en el tiempo e iconos 3D: Usuarios de la comunidad compartieron nuevas formas de jugar utilizando herramientas de generación de imágenes por IA (como Sora, GPT-4o). Una es el efecto de «viaje en el tiempo»: hacer que la imagen 3D estilo Q del personaje de una foto extienda la mano desde un portal para guiar al espectador a su mundo, con un fondo que combina la realidad y el mundo del personaje. Otra es convertir iconos lineales 2D como Feather Icons en iconos 3D con sensación de volumen. Estos casos muestran el potencial de aplicación de la IA en la generación creativa de imágenes, pero también indican la necesidad de múltiples intentos y ajustes de prompts para obtener los efectos deseados. (Fuente: dotey, op7418)

Contenido generado por IA y experiencia real: Usuarios de Reddit compartieron experiencias y reflexiones sobre el uso de contenido generado por IA (como artículos, código, imágenes). Un usuario compartió cómo usó IA para ayudar a construir un proyecto de codificación que genera pequeños ingresos mensuales, pero aún siente vacío en la vida, enfatizando la importancia de la conexión humana. Otro usuario compartió el uso de IA para generar imágenes de Homelander jugando videojuegos y discutió el realismo y las áreas de mejora de los resultados generados. Otro usuario compartió el uso de IA para generar imágenes de «mujeres estadounidenses promedio», lo que provocó una discusión sobre estereotipos. Estas publicaciones reflejan la aplicación de la IA en la creación, así como las reflexiones que la acompañan sobre eficiencia, autenticidad, emoción e impacto social. (Fuente: Reddit r/ArtificialInteligence, Reddit r/ChatGPT, Reddit r/ChatGPT)

Limitaciones de la IA en tareas específicas: Usuarios de Reddit informaron casos de fallos de la IA en ciertas tareas. Por ejemplo, al pedir a ChatGPT, Grok y Claude que crearan un horario de rotación de baloncesto basado en restricciones complejas (tiempo de juego justo, optimización del descanso, restricciones específicas de combinación de jugadores), la IA no pudo completar la tarea correctamente, cometiendo errores de conteo. Otro usuario, al usar Claude 3.7 Sonnet para modificar código, descubrió que cambiaba inesperadamente funciones no relacionadas, necesitando usar la versión 3.5 para solucionarlo. Estos casos recuerdan a los usuarios que la IA todavía tiene limitaciones en el manejo de lógica compleja, satisfacción de restricciones y ejecución precisa de tareas. (Fuente: Reddit r/ArtificialInteligence, Reddit r/ClaudeAI)

Discusión sobre ética e impacto social de la IA: La discusión comunitaria abarcó múltiples aspectos de la ética y el impacto social de la IA. Incluyendo si la IA reemplazará la producción cinematográfica, si la IA tiene conciencia (citando la opinión de Joscha Bach), la comercialización y los problemas de derechos de autor de las herramientas de IA (como Suno), las políticas de las plataformas de distribución de contenido de IA (como Anti-Joy rechazando la música de IA), la equidad en el uso de herramientas de IA (como el rendimiento inconsistente de las cuentas de Claude Pro, problemas de limitación) y reflexiones irónicas sobre la dependencia excesiva de la IA. (Fuente: Reddit r/ArtificialInteligence, Reddit r/ClaudeAI, Reddit r/SunoAI, Reddit r/SunoAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ChatGPT)

💡 Otros

Evaluación de «gafas IA» de 40 yuanes: Lo barato no siempre es bueno: El autor del artículo gastó 40 yuanes en Xianyu (plataforma de segunda mano) para comprar un producto etiquetado como «Gafas inteligentes UVC» (en realidad, el modelo SHGZ01 personalizado por Shenzhen Kanjian Intelligent Technology para Guazi二手车, un portal de coches de segunda mano) y lo evaluó. Las gafas no tienen lentes, solo integran una cámara de 13 megapíxeles en el lado izquierdo y requieren conexión a un teléfono mediante Type-C para su uso. Las pruebas revelaron una calidad de imagen y video deficiente (apenas utilizable durante el día, mala por la noche) y baja comodidad de uso. El autor considera que es esencialmente una cámara USB, con una enorme brecha en funcionalidad (interacción IA, captura conveniente) y experiencia en comparación con verdaderas gafas IA (como Thunderbird V3, Ray-Ban Meta). La conclusión es que si se busca experimentar gafas IA, este tipo de producto tiene poco valor; si solo se necesita una cámara USB barata, es aceptable. El artículo también resume brevemente la historia del desarrollo de las gafas inteligentes y las razones del actual auge de las gafas IA. (Fuente: 40元,我在闲鱼买到了最便宜的AI眼镜,真「便宜不是货」?)

Predicciones y tendencias de la tecnología IA (2025 y futuro): Basado en discusiones comunitarias y algunas noticias, las predicciones sobre futuras tendencias de IA y tecnologías relacionadas incluyen: la tecnología 6G llegará más rápido a los hogares; la IA continuará remodelando el desarrollo de software («La IA no solo se lo está comiendo todo; lo es todo»); los Agentes de IA (IA autónoma) serán la próxima ola, pero con riesgos asociados; la ética de la IA y la cooperación regulatoria recibirán más atención; se profundizará la aplicación de la IA en áreas como reclamaciones de seguros, salud (desarrollo de fármacos, diagnóstico), optimización de la producción; en ciberseguridad, se debe estar alerta a los atacantes de «conocimiento cero» que utilizan IA; la identidad digital y la identidad descentralizada serán más importantes. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Discusión sobre rendimiento y configuración de OpenWebUI: Usuarios de la comunidad de Reddit discutieron problemas de uso de OpenWebUI. Un usuario informó tiempos de carga largos al iniciar, sugiriendo cambiar la base de datos predeterminada de SQLite a PostgreSQL para mejorar el rendimiento. Otro usuario preguntó cómo conectarse a un servicio Ollama externo y una base de datos vectorial al desplegar desde el código fuente. Otro usuario informó que al usar un modelo personalizado (basado en Llama3.2 con prompt de sistema añadido), el tiempo de inicio de la respuesta era mucho más largo que al usar el modelo base, especulando que el problema podría estar en el procesamiento interno de OpenWebUI. (Fuente: Reddit r/OpenWebUI, Reddit r/OpenWebUI, Reddit r/OpenWebUI)

Comentarios y discusión sobre el uso de Suno AI: La comunidad de usuarios de Suno AI discutió problemas y trucos de uso. Un usuario se quejó de no poder generar con precisión música estilo Funk Brasileño. Un usuario comentó que después del rediseño de la interfaz de Suno, la función «Pin» (Fijar) se convirtió en «Bookmark» (Marcador), causando incomodidad. Otro usuario informó que después del ajuste de precios, su suscripción mensual se cambió automáticamente a anual y se le cobró. Otro usuario preguntó sobre la limitación de longitud de las canciones generadas por Suno. Estas discusiones reflejan problemas potenciales con las herramientas de IA en la generación de estilos específicos, la iteración de la interfaz de usuario y las estrategias de facturación. (Fuente: Reddit r/SunoAI, Reddit r/SunoAI, Reddit r/SunoAI, Reddit r/SunoAI)