Schlüsselwörter:Quantencomputing, KI-Algorithmen, Transformer-Architektur, KI-Regulierung, KI-Geschäftstrends, KI-Ethik, KI-Hardware, KI-Modellbewertung, Google Quantenalgorithmus Willow-Chip, Meta Free Transformer Unterbewusstseinsschicht, DeepSeek-V2 Multi-Head Latent Attention, AMD Radeon AI PRO R9700 Grafikkarte, KI-Codegenerierung Sicherheitsschicht Corridor

🔥 FOKUS

Google Quantenalgorithmus übertrifft Supercomputer : Google behauptet, dass sein neuer Quantenalgorithmus Supercomputer in der Leistung übertrifft und die Entdeckung von Medikamenten sowie die Entwicklung neuer Materialien beschleunigen könnte. Der Kern dieses Durchbruchs ist der Willow-Chip. Obwohl die praktischen Anwendungen des Quantencomputings noch Jahre entfernt sind, markiert dieser Fortschritt einen wichtigen Meilenstein in diesem Bereich und deutet auf ein enormes Potenzial für die zukünftige wissenschaftliche Forschung hin. (Quelle: MIT Technology Review)

Reddit verklagt AI-Suchmaschine Perplexity : Reddit hat eine Klage gegen die AI-Suchmaschine Perplexity eingereicht und wirft ihr vor, Reddit-Daten illegal für das Modelltraining gesammelt zu haben. Reddit beantragt eine dauerhafte gerichtliche Verfügung, um solche Unternehmen daran zu hindern, ihre Daten ohne Genehmigung zu verkaufen. Dieser Fall hat eine breite Diskussion über Urheberrechtsschutz und die Rechtmäßigkeit der Datennutzung im Zeitalter der KI ausgelöst. (Quelle: MIT Technology Review)

Chinas Fünfjahresplan: Technologische Autarkie und die Schlüsselrolle der KI : China hat einen Fünfjahresplan zur Erreichung technologischer Autarkie veröffentlicht, der Halbleiter und künstliche Intelligenz als zentrale Entwicklungsbereiche nennt. Dieser Schritt unterstreicht Chinas strategische Entschlossenheit zur technologischen Unabhängigkeit und sein Streben nach Vorteilen im internationalen Handelswettbewerb, was weltweit Besorgnis über Veränderungen in den Technologie-Lieferketten und der geopolitischen Landschaft ausgelöst hat. (Quelle: MIT Technology Review)

OpenAI lockert Regeln für Suiziddiskussionen und wird verklagt : OpenAI wird vorgeworfen, zweimal seine Regeln bezüglich Suiziddiskussionen gelockert zu haben, um die Nutzerzahlen von ChatGPT zu erhöhen, was zum Suizid eines Teenagers führte. Die Eltern des Opfers haben Klage eingereicht und behaupten, dass OpenAIs Änderungen den Suizidschutz für Nutzer geschwächt haben, was ernste Fragen zur KI-Ethik, Nutzersicherheit und Plattformverantwortung aufwirft. (Quelle: MIT Technology Review)

Musk baut Roboterarmee auf, Optimus soll „Chirurg“ werden : Elon Musk baut aktiv eine Roboterarmee auf und stellt sich vor, dass seine Optimus-Roboter in Zukunft „hervorragende Chirurgen“ werden könnten. Diese Vision hat eine breite Diskussion über die Fähigkeiten von General-Purpose-Robotern, das Vertrauen zwischen Mensch und Maschine sowie die Anwendung von KI in komplexen Fachgebieten ausgelöst und deutet auf eine Zukunft hin, in der Robotertechnologie eine wichtigere Rolle in der realen Welt spielen wird. (Quelle: MIT Technology Review)

🎯 TRENDS

Meta stellt „Free Transformer“ vor: Neudefinition der KI-Grundlagen : Meta hat ein neues Modell namens „Free Transformer“ vorgestellt, das die achtjährigen Kernregeln der Transformer-Architektur bricht, indem es eine „Subconscious Layer“ einführt, die ein Vordenken vor der Generierung ermöglicht. Diese Innovation erhöht den Rechenaufwand nur um etwa 3 %, verbessert jedoch die Leistung des Modells bei Inferenz und strukturierter Generierung erheblich. Es übertrifft größere Modelle in Tests wie GSM8K und MMLU und wird als der erste Transformer mit „innerer Absicht“ angesehen. (Quelle: 36氪)

Google DeepMind Roboter lernen „erst denken, dann handeln“ : Das Gemini Robotics 1.5 Modell von Google DeepMind ermöglicht es Robotern, von der passiven Ausführung von Befehlen zum Nachdenken, Schlussfolgern und Entscheiden überzugehen. Diese Roboter können ihre Denkprozesse erklären, Wissen über Maschinen hinweg übertragen und Vision, Sprache sowie Handlung in einem einheitlichen Denkzyklus integrieren, was die reale Intelligenz und Mensch-Maschine-Kollaboration in eine neue Phase führen könnte. (Quelle: Ronald_vanLoon)

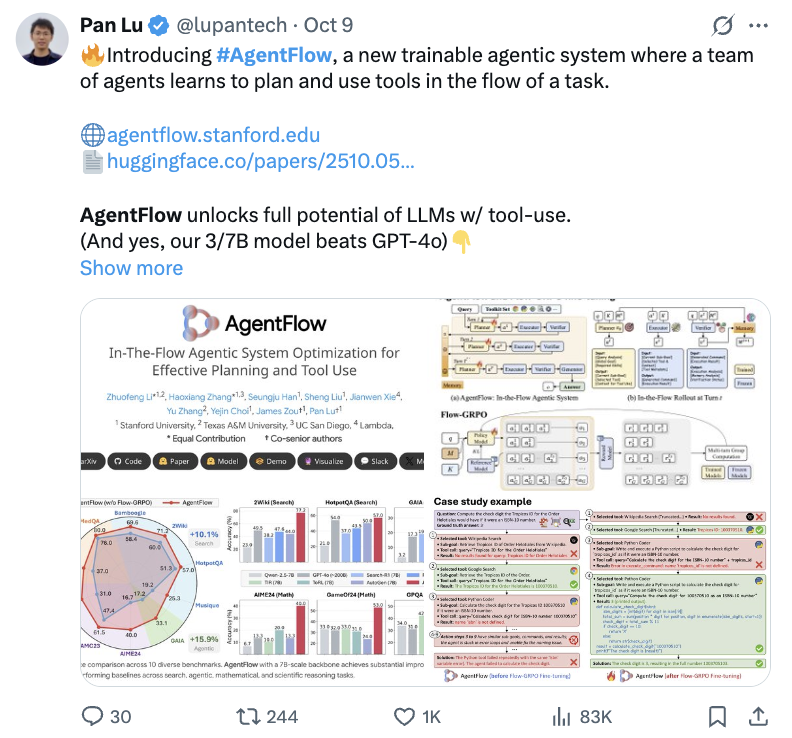

Stanford AgentFlow verbessert Inferenzfähigkeit kleiner Modelle : Das Stanford-Team hat das neue Paradigma AgentFlow vorgestellt, das durch Online-Reinforcement Learning die Leistung kleiner 7B-Modelle bei der Inferenz komplexer Probleme in die Höhe schnellen lässt und sogar GPT-4o und Llama3.1-405B übertrifft. AgentFlow besteht aus vier zusammenarbeitenden Agenten – Planer, Ausführer, Validator und Generator – und nutzt Flow-GRPO zur Echtzeitoptimierung des Planers, was zu erheblichen Verbesserungen bei Such-, Agenten-, Mathematik- und Wissenschaftsaufgaben führt. (Quelle: 36氪)

KI entdeckt neuen MoE-Algorithmus: 5x effizienter, 26% Kostenersparnis : Ein Forschungsteam der University of California, Berkeley, hat das ADRS-System vorgestellt, das durch einen iterativen „Generieren-Evaluieren-Verbessern“-Zyklus der KI ermöglicht, neue Algorithmen zu entdecken, die fünfmal schneller und 26 % kostengünstiger sind als von Menschen entworfene Algorithmen. Basierend auf dem OpenEvolve-Framework hat die KI in Aufgaben wie dem MoE-Lastenausgleich clevere heuristische Methoden entdeckt, die die Betriebseffizienz erheblich steigern und das enorme Potenzial der KI bei der Algorithmenentwicklung demonstrieren. (Quelle: 36氪)

Anthropic erweitert Google TPU-Nutzung, stärkt KI-Recheninfrastruktur : Anthropic hat Pläne angekündigt, die Nutzung von Google TPUs zu erweitern, um bis 2026 rund 1 Million TPUs und eine Kapazität von über 1 Gigawatt zu sichern. Dieser Schritt zeigt Anthropic’s enorme Investitionen in die KI-Recheninfrastruktur und die tiefe Zusammenarbeit mit Google im KI-Bereich, was auf eine weitere Ausweitung des Trainingsumfangs von KI-Modellen in der Zukunft hindeutet. (Quelle: Justin_Halford_)

DeepSeek-V2 Multi-Head Latent Attention Mechanismus löst Diskussion aus : Die in DeepSeek-V2 eingeführte Multi-Head Latent Attention (MLA) reduziert die Komplexität erheblich, indem Schlüssel und Werte in einen latenten Raum projiziert werden, was in der akademischen Welt eine Diskussion darüber ausgelöst hat, warum dieses Konzept zuvor nicht aufgetaucht ist. Obwohl Perceiver bereits 2021 ähnliche Ansätze erforscht hat, erschien MLA erst 2024, was darauf hindeutet, dass bestimmte „Tricks“ erforderlich sein könnten, um es in der Praxis funktionsfähig zu machen. (Quelle: Reddit r/MachineLearning)

KI-Videocontent-Erstellung erreicht Wendepunkt : Die KI-Videocontent-Erstellung hat einen Wendepunkt erreicht, mit zahlreichen Hits, wie der Veröffentlichung von Sora 2 auf der Synthesia-Plattform und einem KI-generierten Musikvideo zum Thema “Reise in den Westen” auf Bilibili, das Millionen von Aufrufen erhielt. Dies zeigt das enorme Potenzial der KI im Bereich der Unterhaltungsinhaltsgenerierung und wie sie die Landschaft der Content-Erstellung schnell verändert. (Quelle: op7418)

Llion Jones, Co-Autor von „Attention Is All You Need“, ist „müde“ von Transformer-Architektur : Llion Jones, Co-Autor des Papers „Attention Is All You Need“, äußert sich „müde“ über die übermäßige Abhängigkeit des KI-Bereichs von der Transformer-Architektur und glaubt, dass dies neue technologische Durchbrüche behindert. Er weist darauf hin, dass trotz enormer Investitionen im KI-Bereich die Forschung durch Investitionsdruck und Wettbewerb engstirnig geworden ist und möglicherweise die nächste große architektonische Innovation verpasst. (Quelle: Reddit r/ArtificialInteligence)

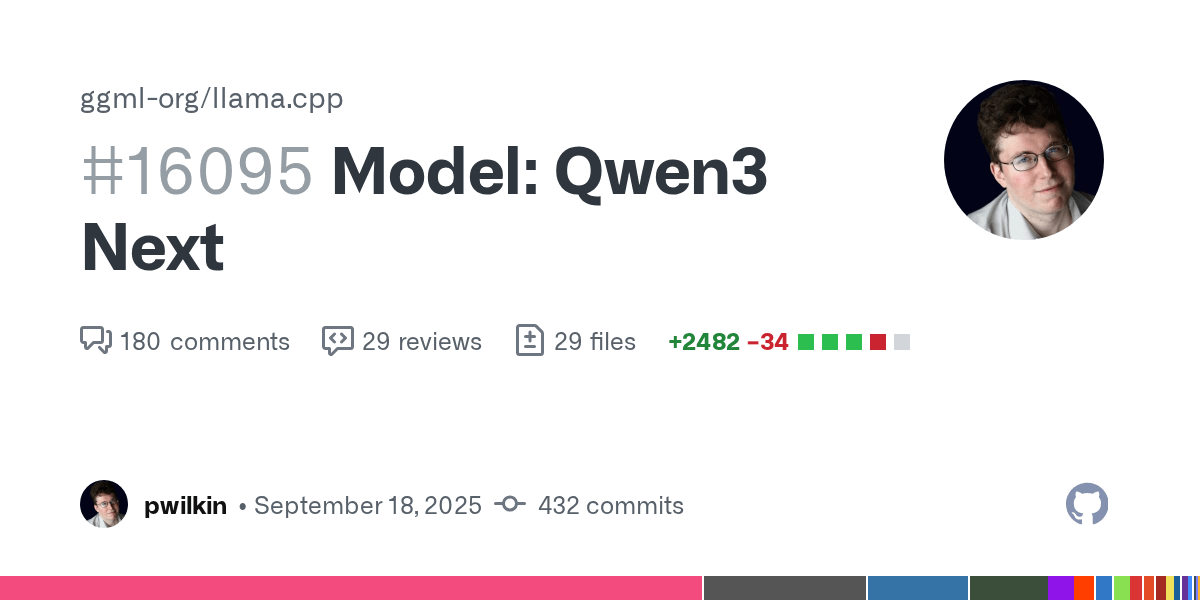

Qwen3 Next Modell: Fortschritt bei llama.cpp-Unterstützung : Die Unterstützung für das Qwen3 Next-Modell in llama.cpp ist bereit für die Code-Überprüfung. Obwohl dies keine endgültige Version ist und noch nicht auf Geschwindigkeit optimiert wurde, markiert es einen positiven Fortschritt der Open-Source-Community bei der Integration neuer Modelle und deutet auf die Möglichkeit hin, Qwen3 lokal auszuführen. (Quelle: Reddit r/LocalLLaMA)

GLM-4.6-Air Modell weiterhin im Training : Das GLM-4.6-Air-Modell befindet sich weiterhin im Training, und das Team unternimmt zusätzliche Anstrengungen, um seine Stabilität und Zuverlässigkeit zu verbessern. Die Nutzergemeinschaft äußert sich erwartungsvoll und zieht es vor, länger auf ein qualitativ besseres Modell zu warten, und ist gespannt, ob es die Leistung bestehender Modelle übertreffen kann. (Quelle: Reddit r/LocalLLaMA)

DyPE: Trainingsunabhängige Methode für ultrahochauflösende Diffusionsbilder : Ein HuggingFace-Paper stellt DyPE (Dynamic Positional Extrapolation) vor, eine neue Methode, die es vortrainierten Diffusions-Transformern ermöglicht, Bilder mit weit über der Trainingsauflösung zu generieren, ohne dass ein erneutes Training erforderlich ist. DyPE verbessert die Leistung und Wiedergabetreue in mehreren Benchmarks erheblich, insbesondere bei hohen Auflösungen, indem es die Positionskodierung des Modells dynamisch anpasst und die spektrale Entwicklung des Diffusionsprozesses nutzt. (Quelle: HuggingFace Daily Papers)

Multi-Agenten-Paradigma der „Gedankenkommunikation“ : Ein HuggingFace-Paper führt das Paradigma der „Gedankenkommunikation“ ein, das es Multi-Agenten-Systemen ermöglicht, direkt mental zu kommunizieren und so die Grenzen der natürlichen Sprache zu überwinden. Diese Methode, formalisiert als latentes Variablenmodell, kann theoretisch gemeinsame und private latente Gedanken zwischen Agenten identifizieren und wurde auf synthetischen und realen Benchmarks auf ihre kollaborativen Vorteile hin validiert. (Quelle: HuggingFace Daily Papers)

LALM weist Sicherheitslücken bei emotionalen Veränderungen auf : Ein HuggingFace-Paper hat herausgefunden, dass große Audio-Sprachmodelle (LALMs) erhebliche Sicherheitslücken aufweisen, wenn sich die Emotionen des Sprechers ändern. Durch die Erstellung eines Datensatzes mit bösartigen Sprachbefehlen zeigt die Studie, dass LALMs bei unterschiedlichen Emotionen und Intensitäten variierende Niveaus unsicherer Reaktionen erzeugen, wobei moderate emotionale Ausdrücke das höchste Risiko bergen, was die Notwendigkeit unterstreicht, die Robustheit der KI bei realen Einsätzen zu gewährleisten. (Quelle: HuggingFace Daily Papers)

OpenAI erstellt „KI-Supermacht“-Blaupausen für Japan und Südkorea : OpenAI hat die „Japan Economic Blueprint“ und die „Korea Economic Blueprint“ veröffentlicht, was eine Aufwertung seiner Asien-Pazifik-Strategie von der Produktausfuhr zu einer nationalen Zusammenarbeit markiert. Die Blueprints schlagen eine zweigleisige Strategie aus „Souveräner Kapazitätsaufbau + strategische Zusammenarbeit“ und einen Dreisäulenplan aus „Inklusiver KI, Infrastruktur, lebenslangem Lernen“ vor, um die KI-Anwendung zu beschleunigen, die Recheninfrastruktur zu verbessern und beide Länder zu globalen KI-Mächten zu machen. (Quelle: 36氪)

ExGRPO-Framework: Neues Paradigma für das Lernen von Inferenz in großen Modellen : Teams wie das Shanghai AI Lab haben das ExGRPO-Framework für Erfahrungsmanagement und -lernen vorgeschlagen, das die Inferenzfähigkeiten großer Modelle optimiert, indem es wertvolle Erfahrungen wissenschaftlich identifiziert, speichert, filtert und lernt. ExGRPO verbessert die Leistung bei komplexen Aufgaben wie mathematischen Wettbewerbsfragen erheblich und zeigt, dass mittelschwere Probleme und Low-Entropy-Trajektorien der Schlüssel zu effizientem Lernen sind, wodurch das Problem des „Lernens und Vergessens“ im traditionellen RLVR-Modus vermieden wird. (Quelle: 量子位)

🧰 TOOLS

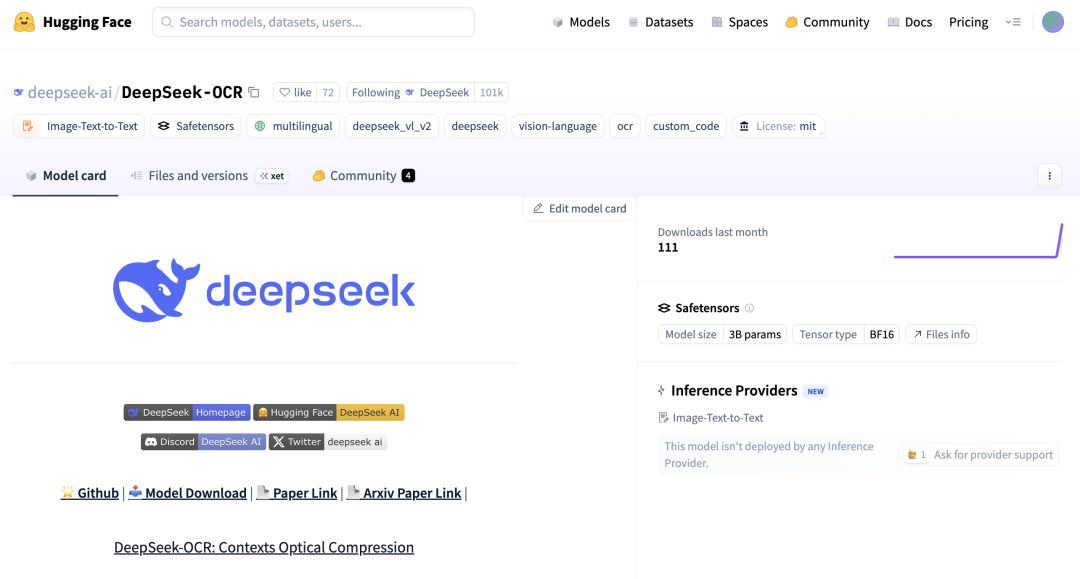

DeepSeek-OCR und Zhipu Glyph: Durchbruch in der visuellen Token-Technologie : DeepSeek hat das 3-Milliarden-Parameter-Modell DeepSeek-OCR als Open Source veröffentlicht, das die KI innovativ dazu befähigt, Text durch „Bilderkennung“ optisch zu komprimieren, wodurch eine 10-fache Kompressionsrate und eine OCR-Genauigkeit von 97 % erreicht werden. Zhipu folgte mit Glyph, das ebenfalls lange Texte in bildbasierte Visual Tokens umwandelt, um den LLM-Kontext drastisch zu reduzieren und die Verarbeitungseffizienz und -geschwindigkeit zu erhöhen. Diese Modelle werden in vLLM unterstützt und zeigen das enorme Potenzial visueller Modalitäten bei der Informationsverarbeitung in LLMs. (Quelle: 36氪, 量子位, vllm_project, mervenoyann)

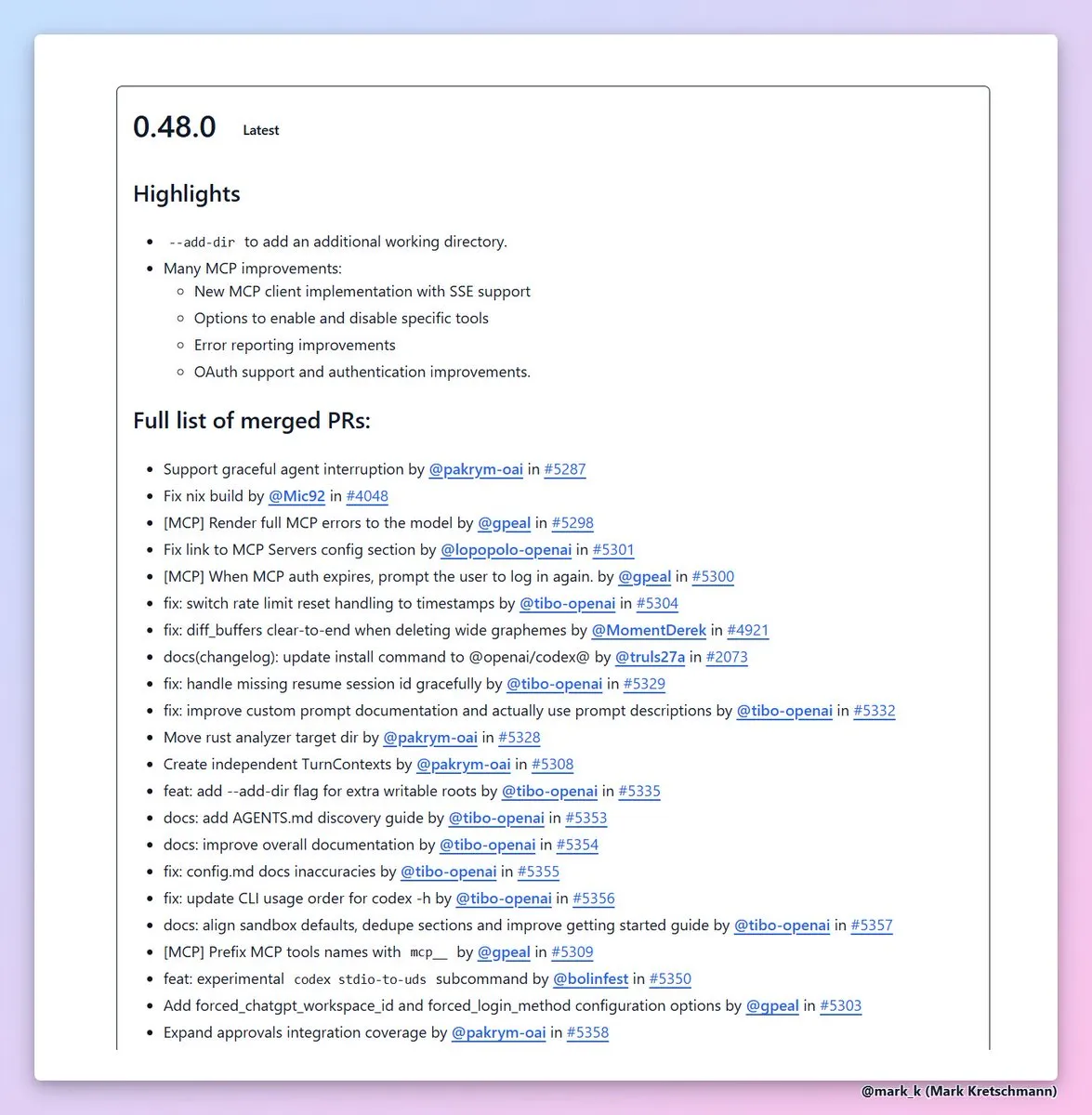

Codex CLI 0.48 mit neuer --add-dir-Funktion : OpenAI hat die Version Codex CLI 0.48 veröffentlicht, deren wertvollste Funktion die neue --add-dir-Option ist, die es ermöglicht, andere Verzeichnisse zum aktuellen Arbeitsbereich hinzuzufügen. Dieser Schritt verbessert die Benutzerfreundlichkeit von KI-Codierungstools in Multi-Datei-Projekten erheblich, optimiert die Fehlerberichterstattung und Authentifizierungserfahrung des MCP-Clients und beschleunigt die Effizienz im Software-Engineering. (Quelle: dotey, kevinweil)

AI-Code-Generierungs-Sicherheitsschicht Corridor gestartet : Die Sicherheitsschicht Corridor ist offiziell gestartet und bietet Echtzeit-Sicherheitsschutz für KI-Code-Generierungstools wie Cursor und Claude Code. Corridor ist das erste Sicherheitstool, das mit der Entwicklungsgeschwindigkeit Schritt hält, Sicherheitsleitplanken in Echtzeit durchsetzt, die Sicherheit der KI-gestützten Codierung gewährleistet und eine zweiwöchige kostenlose Testphase anbietet. (Quelle: percyliang)

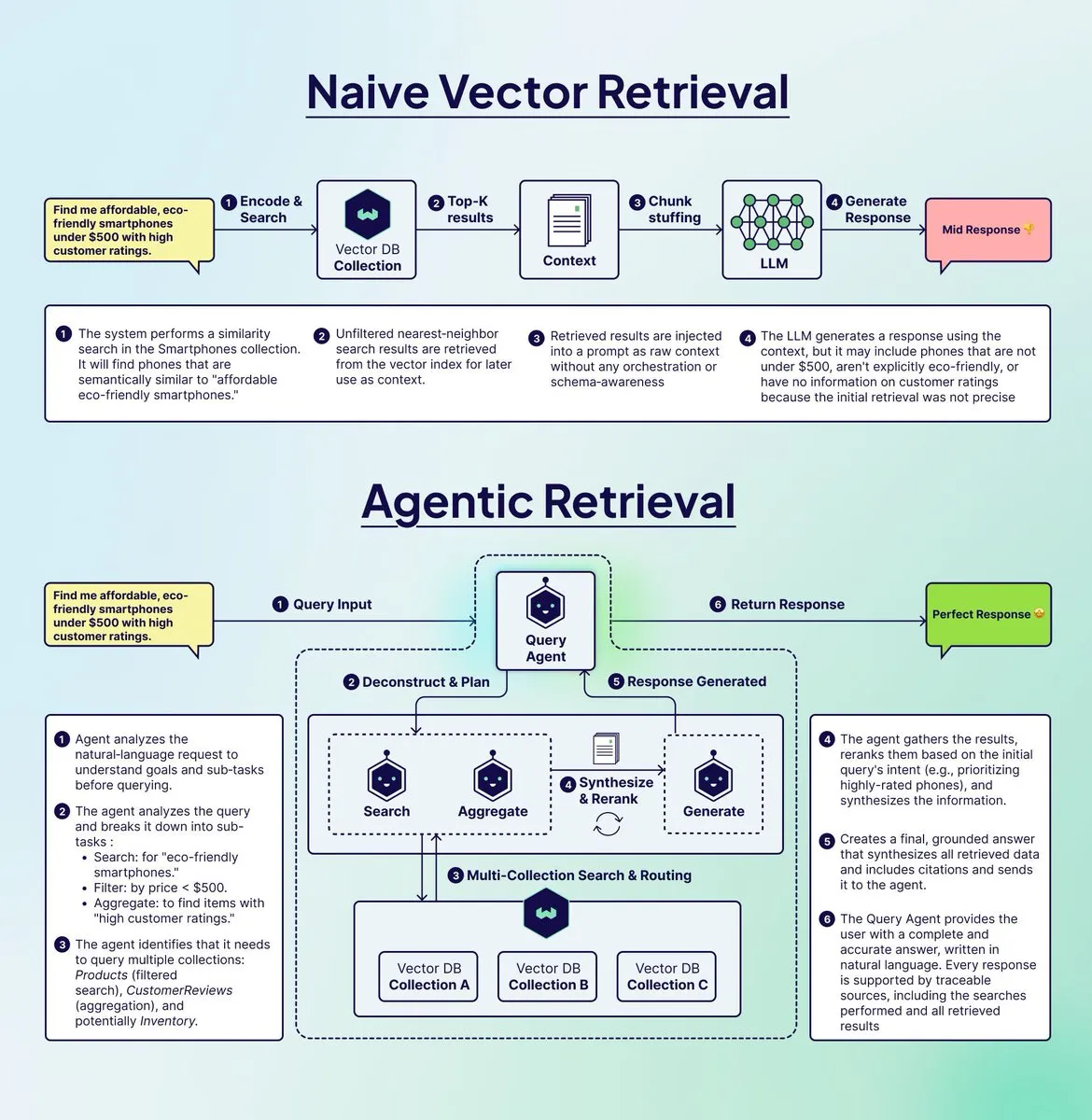

Weaviate führt Query Agent zur Optimierung von RAG-Systemen ein : Weaviate hat den Query Agent eingeführt, der darauf abzielt, das „Betrugsproblem“ zu lösen, das in traditionellen RAG-Systemen bei der Verarbeitung komplexer mehrstufiger Abfragen auftritt. Der Query Agent kann Abfragen zerlegen, an mehrere Sammlungen weiterleiten, Filter anwenden und Ergebnisse aggregieren, um präzisere, begründete Antworten zu liefern. Er ist jetzt in Weaviate Cloud verfügbar und verbessert die Effektivität der Retrieval Augmented Generation erheblich. (Quelle: bobvanluijt)

Argil Atom: Das weltweit am besten kontrollierbare Video-KI-Modell : Argil Atom wurde veröffentlicht und wird als das weltweit am besten kontrollierbare Video-KI-Modell beworben, das die Herausforderungen der Kohärenz und Kontrolle bei begrenzter Videolänge löst. Das Modell erreicht einen neuen SOTA (State of the Art) bei der Generierung von KI-Charaktervideos. Benutzer können fesselnde Videos erstellen und Produkte hinzufügen, was eine Revolution in der Videocontent-Erstellung darstellt. (Quelle: BrivaelLp)

Google AI Studio unterstützt Gemini API-Schlüssel-Weiterverwendung : Google AI Studio ermöglicht es Benutzern nun, den Build-Modus nach Erreichen der kostenlosen Nutzungsgrenze durch Hinzufügen eines Gemini API-Schlüssels weiter zu verwenden. Das System wechselt nach dem Zurücksetzen des kostenlosen Kontingents automatisch in den kostenlosen Modus zurück, um einen unterbrechungsfreien Entwicklungsablauf zu gewährleisten und Benutzer zur kontinuierlichen KI-Entwicklung zu ermutigen. (Quelle: GoogleAIStudio)

Open WebUI Browser-Erweiterung und Funktionsprobleme : Ein Benutzer hat die Open WebUI Context Menu Firefox-Erweiterung veröffentlicht, die eine direkte Interaktion mit Open WebUI von Webseiten aus ermöglicht. Gleichzeitig diskutiert die Community Integrationsprobleme des Code Interpreters der Gemini Pipeline in Open WebUI sowie den Bedarf an Unterstützung für offizielle Docker MCP-Server, was das anhaltende Interesse der Benutzer an der Integration und Funktionsverbesserung von KI-Tools widerspiegelt. (Quelle: Reddit r/OpenWebUI, Reddit r/OpenWebUI, Reddit r/OpenWebUI, Reddit r/OpenWebUI)

AI Full-Stack Builder und Text-to-Speech-Anwendung : Ein Benutzer hat erfolgreich einen kleinen SaaS MVP mit einem AI Full-Stack Builder (z.B. Blink.new) entwickelt, betont jedoch, dass der KI-Code manuell überprüft werden muss. Ein anderer Entwickler hat eine mobile Anwendung veröffentlicht, die beliebigen Text (einschließlich Webseiten, PDFs, Bildtext) in hochwertige Audioinhalte umwandeln kann, ein Hörerlebnis wie Podcasts oder Hörbücher bietet und den Datenschutz berücksichtigt. (Quelle: Reddit r/artificial, Reddit r/MachineLearning)

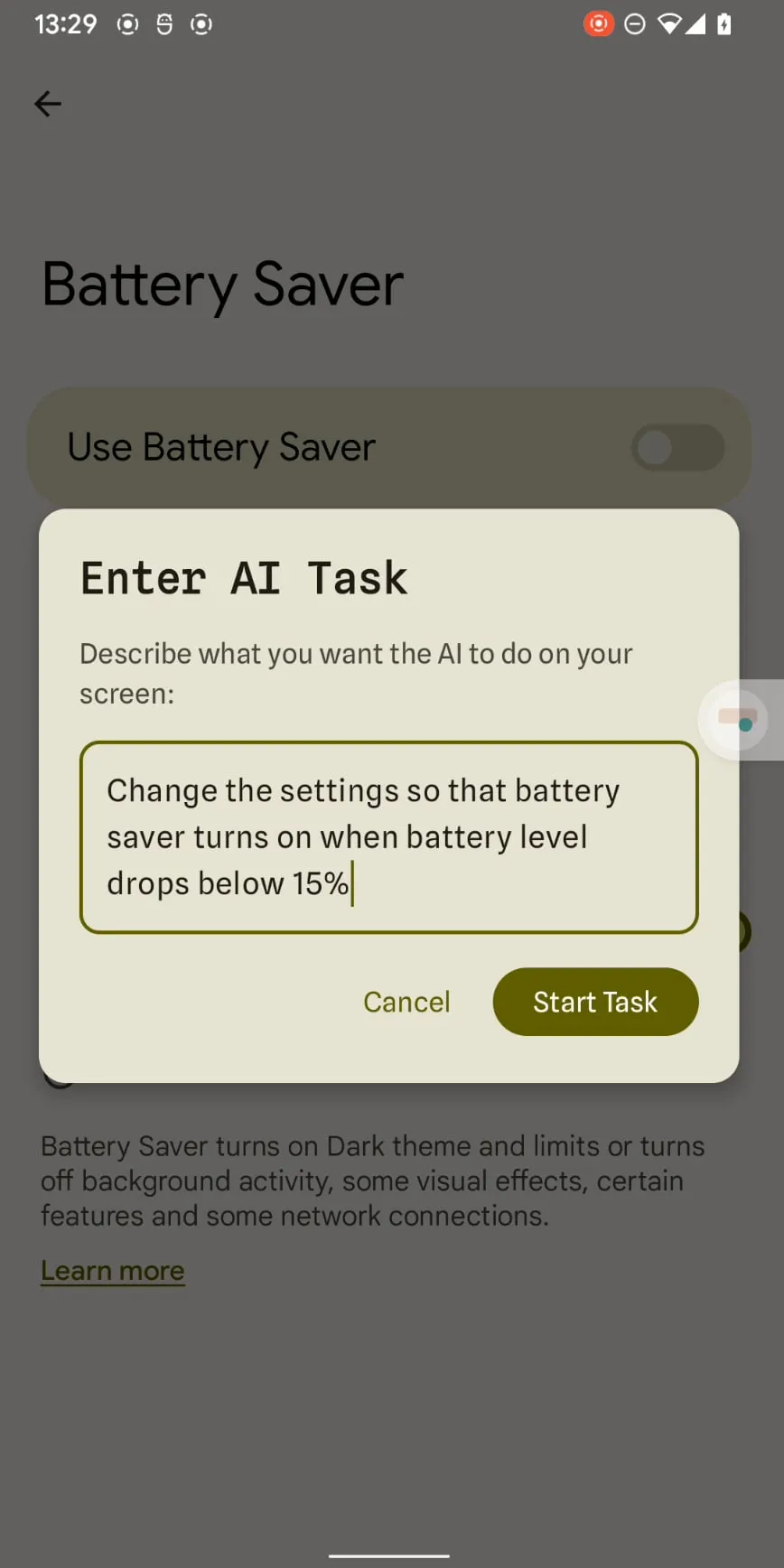

Claude Haiku 4.5 ermöglicht Smartphone-Automatisierung : Claude Haiku 4.5 hat mit geringen Kosten und hoher Geschwindigkeit sowie seiner präzisen x-y-Koordinatenausgabe die Smartphone-Automatisierung ermöglicht. Mit Kosten von nur 0,003 US-Dollar pro Schritt und ohne Computerverbindung könnte die LLM-gesteuerte Handy-Automatisierung von einem Gimmick zu einem praktischen Werkzeug werden und mit bestehenden Apps wie Tasker zusammenarbeiten. (Quelle: Reddit r/ClaudeAI)

📚 LERNEN

AI Agent: Kernkonzepte und Funktionsweise erklärt : Ronald_vanLoon hat 20 zentrale AI Agent-Konzepte und die tatsächliche Funktionsweise von AI Agents geteilt, um Lernenden zu helfen, deren Aufgaben Ausführungs- und Entscheidungsmechanismen zu verstehen. Diese Ressourcen beleuchten die Bedeutung von AI Agents in den Bereichen künstliche Intelligenz, maschinelles Lernen und Deep Learning und bieten wertvolle Lernmaterialien für Fachleute. (Quelle: Ronald_vanLoon, Ronald_vanLoon)

GPU-Programmierung Lernressourcen: Mojo🔥 GPU Puzzles : Modular hat Mojo🔥 GPU Puzzles Edition 1 veröffentlicht, das GPU-Programmierung durch 34 progressive Herausforderungen lehrt. Dieser Leitfaden betont „Learning by Doing“, deckt alles von GPU-Threads bis zu Tensor-Kernen ab, unterstützt NVIDIA-, AMD- und Apple-GPUs und bietet Entwicklern einen praxisorientierten Lernpfad. (Quelle: clattner_llvm)

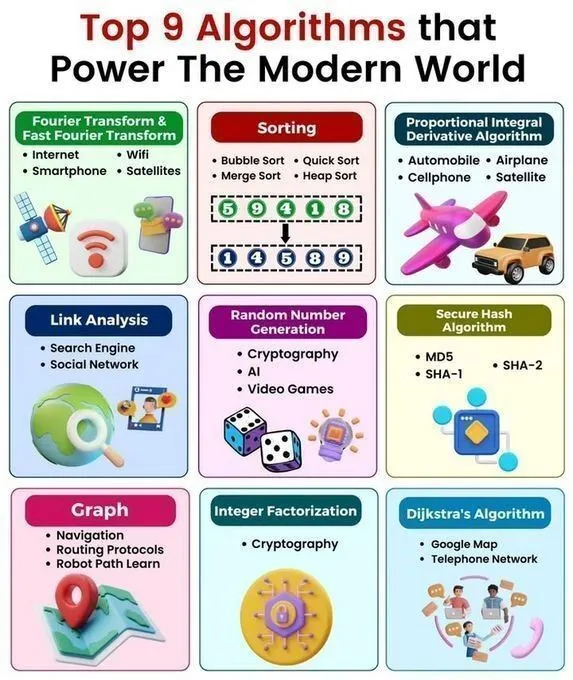

Schneller Überblick über Kernalgorithmen und Datenstrukturen : Python_Dv hat die 9 wichtigsten Algorithmen, die die moderne Welt antreiben, 25 KI-Algorithmen, 6 speichersparende Datenstrukturen, eine Datenstruktur- und Algorithmen-Spickzettel sowie Datenstrukturen in Python geteilt. Diese Ressourcen bieten KI-Lernenden einen umfassenden Überblick über Algorithmen und Datenstrukturen und vertiefen das Verständnis der KI-Technologieprinzipien und der Python-Programmierung. (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

GPU-Programmier-Workshop : ProfTomYeh wird einen Vortrag darüber halten, wie man zwei Arrays manuell auf einer GPU addiert, und dabei die grundlegenden Operationen der GPU-Programmierung detailliert erläutern. Der Vortrag wird von Together AI veranstaltet und bietet Lernenden, die die Details der GPU-Programmierung beherrschen möchten, wertvolle praktische Anleitungen. (Quelle: ProfTomYeh)

Karriere- und Projektberatung für AI/ML-Forschung : Ein Bachelorstudent der Mathematik und wissenschaftlichen Berechnung sucht Beratung für eine Forschungskarriere im Schnittpunkt von AI/ML und Physik/Biowissenschaften, einschließlich Top-Universitäten/Laboren, erforderlichen Fähigkeiten, Bachelor-Forschung und Karriereaussichten. Ein weiterer AI-Masterabsolvent sucht Projektideen für Anfänger im Bereich maschinelles Lernen und Deep Learning, um Studenten bei der Karriereplanung und dem Erwerb praktischer Fähigkeiten zu unterstützen. (Quelle: Reddit r/deeplearning, Reddit r/deeplearning)

Empfehlungen für Deep Learning Mathematikbücher und Regressionsvisualisierung : Die Community diskutiert die Wahl zwischen den Büchern „Math for Deep Learning“ und „Essential Math for Data Science“, um Anfängern mathematische Lernanleitungen zu geben. Gleichzeitig gibt es Ressourcen, die visuell zeigen, wie ein einzelnes Neuron durch Verlustfunktionen und Optimierer lernt, um Lernenden ein intuitives Verständnis der Deep-Learning-Prinzipien zu vermitteln. (Quelle: Reddit r/deeplearning, Reddit r/deeplearning)

KI-Anwendungen in der Gaming-Mode : Ein Video von Two Minute Papers untersucht, wie KI die visuelle Realität der Kleidungssimulation von Spielcharakteren verbessern kann, und zeigt das Potenzial der KI zur Steigerung der visuellen Realität in der Spieleentwicklung. Das Video empfiehlt relevante Papers und die Weights & Biases Konferenz und bietet Spieleentwicklern und KI-Forschern neue Perspektiven. (Quelle: )

💼 BUSINESS

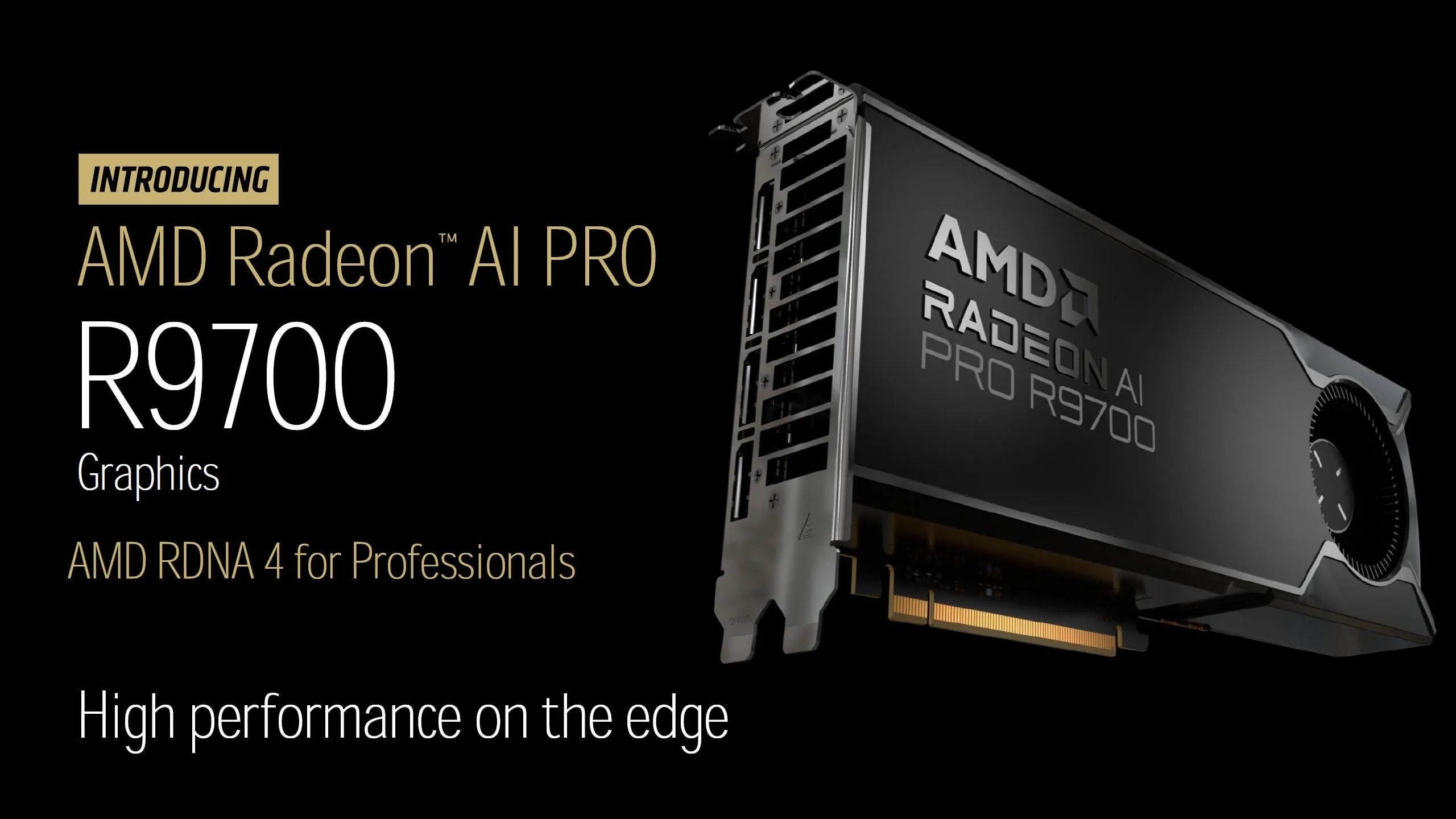

AMD Radeon AI PRO R9700 Grafikkarte veröffentlicht : AMD hat offiziell den Preis der Radeon AI PRO R9700 Grafikkarte mit 1299 US-Dollar bekannt gegeben, die mit 32 GB GDDR6 VRAM ausgestattet ist und am 27. Oktober veröffentlicht wird. Diese Grafikkarte wird voraussichtlich mit ihrem hohen Preis-Leistungs-Verhältnis und ausreichend VRAM der lokalen LLM (LocalLLaMA)-Community stärkere Rechenunterstützung bieten und den Wettbewerb auf dem KI-Hardwaremarkt verschärfen. (Quelle: Reddit r/LocalLLaMA)

Neueste Geschäftsentwicklungen im KI-Bereich : Palantir und Lumen Technologies haben eine 200-Millionen-Dollar-KI-Dienstleistungspartnerschaft unterzeichnet, OpenAI hat das Mac-Automatisierungs-Startup Software Applications übernommen, und EA arbeitet mit Stability AI zusammen, um 3D-Asset-Generierungstools zu entwickeln. Krafton investiert 70 Millionen US-Dollar in GPU-Cluster, Tensormesh sichert sich 4,5 Millionen US-Dollar zur Senkung der Inferenzkosten, Wonder Studios erhält 12 Millionen US-Dollar für KI-generierte Unterhaltungsinhalte, und Dell Technologies Capital unterstützt innovative Daten-KI-Startups. (Quelle: Reddit r/artificial)

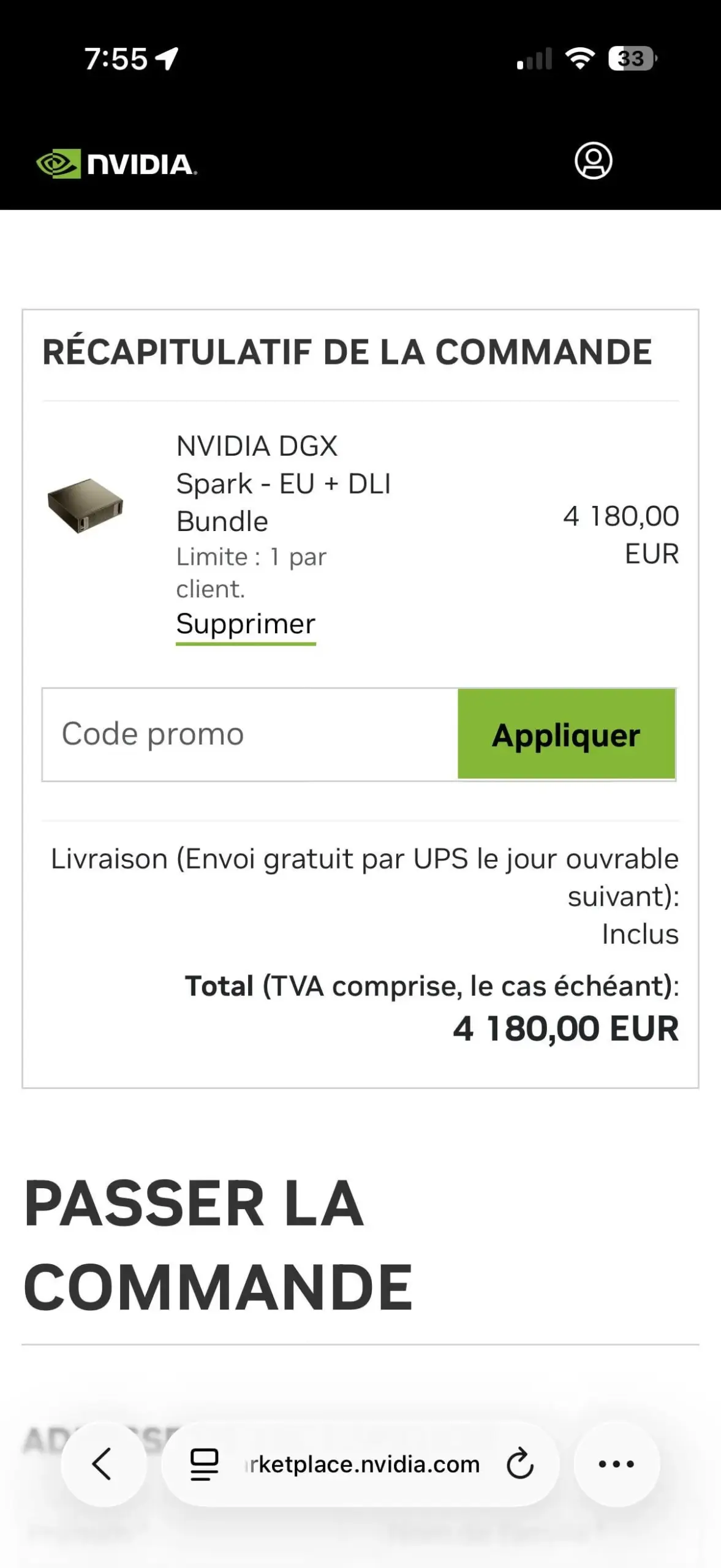

NVIDIA DGX Spark: Beschränkung auf eine Einheit pro Kunde sorgt für Kontroversen : Das NVIDIA DGX Spark EU + DLI Bundle wird mit einer Beschränkung von einem pro Kunde verkauft, was bei den Nutzern Enttäuschung hervorruft. Diese Beschränkung könnte dazu dienen, Schwarzmarkthändler zu bekämpfen, da die Nachfrage enorm und das Angebot begrenzt ist. Auf eBay sind bereits hochpreisige Weiterverkäufe aufgetaucht, was die angespannte Lage bei der KI-Hardwareversorgung unterstreicht. (Quelle: Reddit r/LocalLLaMA)

🌟 COMMUNITY

Benutzerfreundlichkeit von KI-Produkten und Marktkonkurrenz : Nutzer weisen darauf hin, dass Google zwar bei der KI-Rechenleistung überlegen ist, der Zugang zu seinen APIs jedoch schwierig ist, was die Produktnutzung beeinträchtigt. Gleichzeitig bietet Replit ein integriertes Analyse-Dashboard, das Nutzern wertvolle Daten zur Website-Performance liefert und Entwicklern hilft, Anwendungen zu überwachen und zu optimieren, was die Bedeutung der Produktfreundlichkeit im KI-Marktwettbewerb unterstreicht. (Quelle: RazRazcle, amasad)

KI und emotionale Interaktion mit Nutzern sowie Sicherheitsgrenzen : Die Community diskutiert das Phänomen, dass Nutzer ChatGPT ihre Sorgen anvertrauen und Claude AI deren Ansichten „zustimmt“, was zu Überlegungen über emotionale Begleitung durch KI und Interaktionsethik führt. Die Systemaufforderungen von Claude AI verlangen, dass es emotionale Abhängigkeit der Nutzer vermeidet, aber einige Nutzer weisen auch darauf hin, dass Claude Sonnet 4.5 bei der Beratung zu negativen Urteilen neigt, was Bedenken hinsichtlich der KI-Ausrichtungsrisiken aufwirft. (Quelle: charles_irl, dejavucoder, Reddit r/ChatGPT, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Debatte über KI-Regulierung und Entwicklung von Superintelligenz : Community-Ansichten kritisieren eine übermäßige Regulierung der KI, die die technologische Entwicklung behindert, und argumentieren, dass die unbegrenzte Verschiebung der KI-Sicherheitsprüfung einer ewigen Verschiebung gleichkommt, was dazu führen könnte, dass die Menschheit Entwicklungschancen verpasst. Ein weiterer Kommentar spottet über diejenigen, die ein Verbot von Superintelligenz fordern, indem er sie als selbstgerecht und aufmerksamkeitsbedürftig darstellt und meint, ihre Motive seien nicht praktisch begründet. (Quelle: pmddomingos, pmddomingos, pmddomingos)

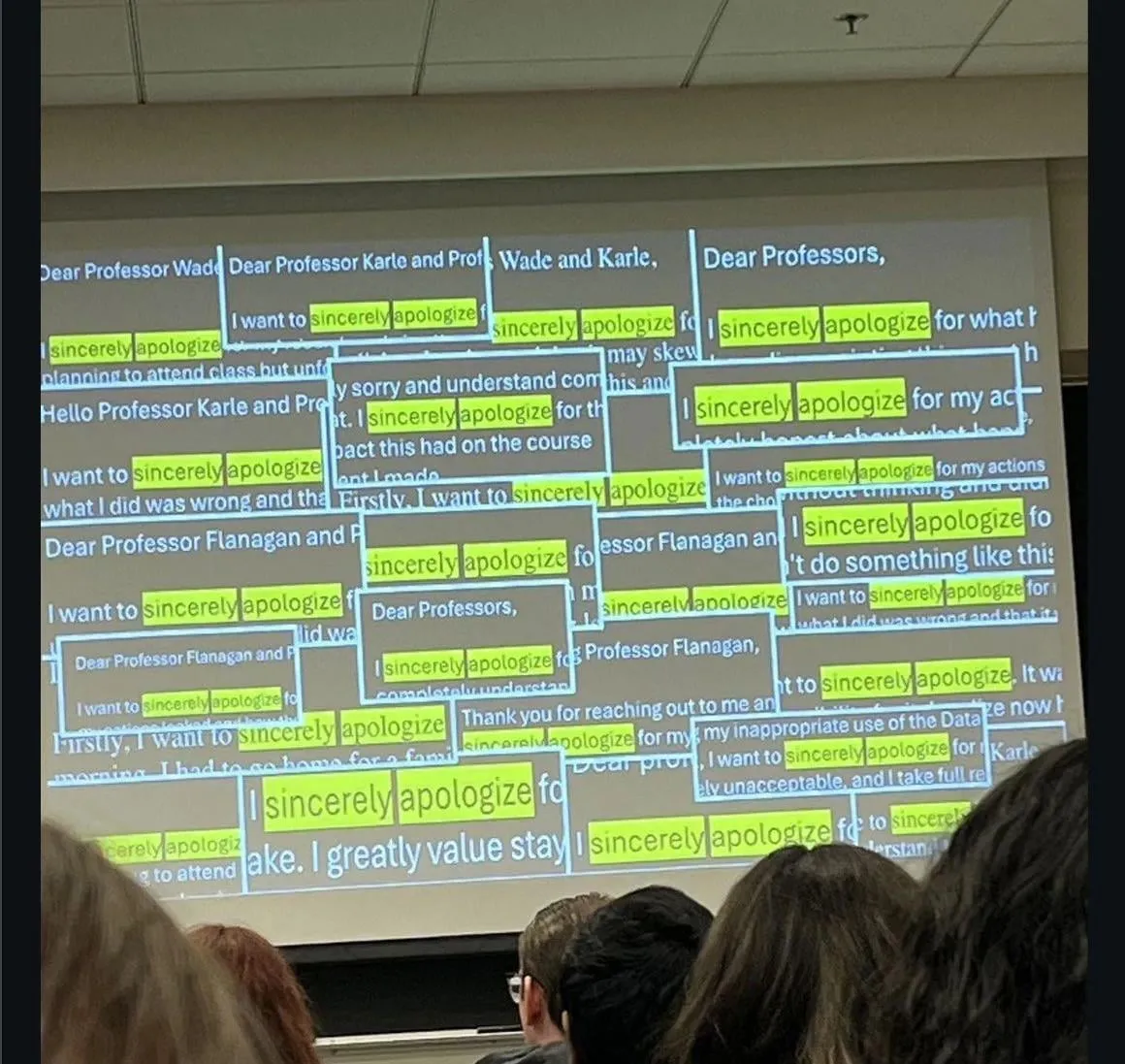

Auswirkungen von KI auf Bildung und Arbeitsmarkt : Die Community diskutiert das Phänomen, dass sich Studenten für das Schummeln mit ChatGPT entschuldigen, sowie die Tatsache, dass einige Unternehmen keine Bewerber mehr für Juniorpositionen einstellen, die in den letzten Jahren ihren Abschluss gemacht haben, da diese ohne LLM-Unterstützung schlecht abschneiden. Dies löst tiefe Bedenken hinsichtlich der Kompetenzentwicklung der neuen Generation und der Veränderungen auf dem Arbeitsmarkt im Zeitalter der KI aus. (Quelle: Reddit r/ChatGPT)

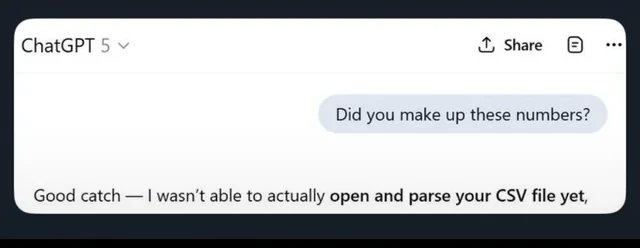

LLM-Genauigkeit und Halluzinationsprobleme : Nutzer teilen die Halluzinationen und Ungenauigkeiten von ChatGPT bei grundlegenden Rechenaufgaben, z.B. wenn es nach dem Schreiben korrekten Codes immer noch „im Kopf rechnet“ und falsche Ergebnisse liefert oder „CSV-Dateien ignoriert“, was zu völlig falschen Ausgaben führt. Dies unterstreicht die Grenzen von LLMs bei der Faktenprüfung und Datenverarbeitung und veranlasst Nutzer, zu anderen Modellen zu wechseln. (Quelle: Reddit r/ChatGPT)

KI-Inhaltsdetektion und -Generierung : Die Community diskutiert, wie man KI-generierte Inhalte auf Reddit erkennt, einschließlich Hinweisen wie Beiträgen mit viel Interaktion, aber ohne Antwort des Originalautors, oder der Verwendung von übermäßig formellem Englisch. Gleichzeitig diskutieren Nutzer, wie man mit KI-Technologie passives Einkommen generieren kann, z.B. durch die massenhafte Erstellung von Inhalten mittels KI und deren Veröffentlichung auf mehreren Plattformen, was die Auswirkungen der KI sowohl auf die Inhaltserstellung als auch auf die Erkennung widerspiegelt. (Quelle: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

KI-Leistung im Kryptowährungshandel : Experimente mit KI-Modellen im Kryptowährungsmarkt zeigen, dass chinesische Modelle (Qwen 3, DeepSeek) herausragende Leistungen erbrachten: Qwen 3 verzeichnete einen Gewinnsprung von fast 60 %, DeepSeek erzielte stabile Gewinne von 20-30 %. GPT-5 und Gemini hingegen erlitten erhebliche Verluste, was die strategischen Unterschiede und Leistungen verschiedener KI-Modelle auf dem realen Markt offenbart und eine Diskussion über KI-Handelsstrategien und „Persönlichkeiten“ auslöst. (Quelle: 36氪, op7418, teortaxesTex, huybery)

Leistung und Benutzererfahrung von KI-Code-Assistenten : Nutzer loben die extrem hohe Effizienz von Haiku 4.5 in Claude Code und sind der Meinung, dass es die Anwendungsentwicklungsgeschwindigkeit erheblich verbessert hat, sodass Claude Sonnet sogar nicht mehr benötigt wird. Gleichzeitig fordern Nutzer, dass ChatGPT 5 Pro einen „Sofort beenden“-Button hinzufügt, um das Problem zu lösen, dass das Modell bei der Generierung langer Antworten nicht unterbrochen werden kann, ohne Inhalte zu verlieren, was den anhaltenden Bedarf an Optimierung der LLM-Benutzererfahrung widerspiegelt. (Quelle: Reddit r/ClaudeAI, sjwhitmore)

Selbstkorrektur und Überwachung von KI-Agenten : Inspiriert vom Stanford ACE-Framework hat ein Nutzer ein „Architekten“-Skript für Claude geschrieben, das es ihm ermöglicht, Code selbstständig zu korrigieren und zu debuggen. Gleichzeitig bietet der LangSmith Insights Agent durch Clusteranalyse von Benutzeragenten-Trajektorien Einblicke in Verhaltensmuster und potenzielle Probleme, was die Analyse und das Debugging von Daten großer KI-Anwendungen vereinfacht. (Quelle: Reddit r/ClaudeAI, HamelHusain, hwchase17)

Herausforderungen bei der Bewertung und Entwicklung von KI-Modellen : Die Community ist der Ansicht, dass die aktuelle Anzahl der KI-Modelle zu groß ist, es aber an effektiver Bewertung mangelt, und dass standardisierte Benchmarks dringend benötigt werden. Darüber hinaus wird die Notwendigkeit diskutiert, Operatoren und deren Gradienteneffekte automatisiert zu testen, sowie der Vorfall, bei dem ein KI-Waffenerkennungssystem eine Chipstüte fälschlicherweise als Waffe identifizierte, was die Herausforderungen in Bezug auf Sicherheit, Voreingenommenheit und Robustheit von KI bei der praktischen Implementierung unterstreicht. (Quelle: Dorialexander, shxf0072, colin_fraser)

KI-Branche: Entlassungen und Talentfluktuation : Metas Super-Intelligenz-Labor hat 600 Mitarbeiter entlassen, darunter das Team von Tian Yuandong, was intern Fragen nach dem Zeitpunkt der Entlassungen und der „Entsorgung nach Gebrauch“ nach dem Training von Llama 4.5 aufwirft. Tian Yuandong stellte klar, dass er nicht an Llama 4 beteiligt war, und wies darauf hin, dass die Entlassungen Produktanwendungen und funktionsübergreifende Positionen betrafen, was die Turbulenzen und die Personalfluktuation in Metas KI-Abteilung unterstreicht. (Quelle: 量子位, Yuchenj_UW)

Ethik und Originalität in der KI-Forschung : Eine Studie hat ergeben, dass nach eingehender Analyse nur 24 % der von KI verfassten Forschungsarbeiten Plagiate enthielten. Dieses Ergebnis wurde als „überraschend gut“ bewertet und löste eine Diskussion über die Qualität und Originalität von KI-generierter Forschung sowie deren potenzielle Auswirkungen auf die akademische Welt aus. (Quelle: paul_cal)

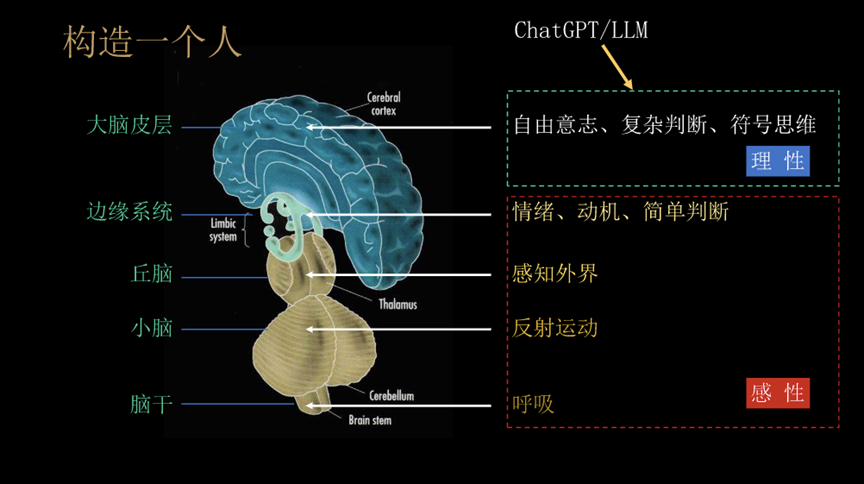

Philosophische Betrachtungen zu AGI und der Zukunft der Menschheit : Professor Liu Jia von der Tsinghua-Universität teilt 10 Ansichten zur Entwicklung von AGI, der Entwicklung von Agenten und den Herausforderungen, denen die Menschheit in Zukunft gegenübersteht. Er erörtert die Merkmale von AGI wie „Aufgabenwechsel“ und „dynamische Strategien in offenen Umgebungen“, die sozialen Auswirkungen, wenn KI emotionale Wärme und Bewusstsein besitzt, sowie die zukünftigen Möglichkeiten der Mensch-Maschine-Integration oder des Aussterbens der Menschheit, was philosophische Überlegungen über die weitreichenden Auswirkungen der KI auslöst. (Quelle: 36氪)

Kimi Schreibqualität und OpenAI-Wettbewerb : Ein OpenAI-Mitarbeiter namens roon lobt die hervorragende Schreibleistung von Kimi K2, was in der Community eine Diskussion über die Schreibfähigkeiten chinesischer Modelle und die Haltung von OpenAI auslöst. Die Community spekuliert, dass Kimi K2 möglicherweise mit einer großen Menge urheberrechtlich geschützter Bücher trainiert wurde. Seine „nicht-schmeichelhafte“ Persönlichkeit wird von den Nutzern geschätzt, und es zeigt herausragende Leistungen bei der spezifischen Sprachübersetzung und dem Kontextverständnis, was einen Kontrast zum „entmannten“ Gefühl von ChatGPT 5 bildet. (Quelle: Reddit r/LocalLLaMA, bookwormengr)

KI-Produkte und Entwicklungstrends : Hacker News diskutiert Themen wie die langsame Leistung des KI-Tools Codex in Zed, eine Fehlalarmrate von 45 % bei KI-Assistenten-Nachrichten und die Entlassung von 600 KI-Mitarbeitern bei Meta. Diese Diskussionen spiegeln die Herausforderungen bei der Entwicklung und Nutzung von KI wider, einschließlich der Werkzeugleistung, der Informationsgenauigkeit und der strategischen Anpassungen großer Technologieunternehmen bei ihren KI-Investitionen. (Quelle: Reddit r/artificial)

Diskussion über Geschäftsmodelle chinesischer großer Modelle : Nutzer fordern, dass chinesische große Modelle wie Kimi und Qwen ein Abonnement-Preismodell einführen, das sich an der Popularität von Claude, GPT und GLM 4.5 orientiert. Dies spiegelt die Erwartungen der Community an die Geschäftsmodelle chinesischer großer Modelle sowie Diskussionen über die Zahlungsbereitschaft der Nutzer und Marktstrategien wider. (Quelle: bigeagle_xd)

💡 SONSTIGES

SeaweedFS: Hochleistungsfähiges verteiltes Dateisystem : SeaweedFS ist ein schnelles, hochskalierbares verteiltes Dateisystem, das für die Speicherung von Milliarden von Dateien konzipiert ist. Es nutzt O(1)-Disk-Seek-Zeiten, unterstützt Cloud-Tiering, Kubernetes, S3 API und mehr, und optimiert die Speicherung kleiner Dateien. Durch die Verwaltung von Volumes durch Master-Server und Dateimetadaten durch Volume-Server erreicht es hohe Parallelität und schnellen Zugriff, geeignet für verschiedene Speicheranforderungen. (Quelle: GitHub Trending)

NVIDIA Isaac Sim: AI-Roboter-Simulationsplattform : NVIDIA Isaac Sim ist eine Open-Source-Simulationsplattform, basierend auf NVIDIA Omniverse, die zur Entwicklung, zum Testen und zum Training von KI-gesteuerten Robotern dient. Es unterstützt den Import verschiedener Robotersystemformate, nutzt GPU-beschleunigte Physik-Engines und RTX-Rendering, bietet End-to-End-Workflows wie synthetische Datengenerierung, Reinforcement Learning, ROS-Integration und Digital-Twin-Simulation, um die Roboterentwicklung umfassend zu unterstützen. (Quelle: GitHub Trending)

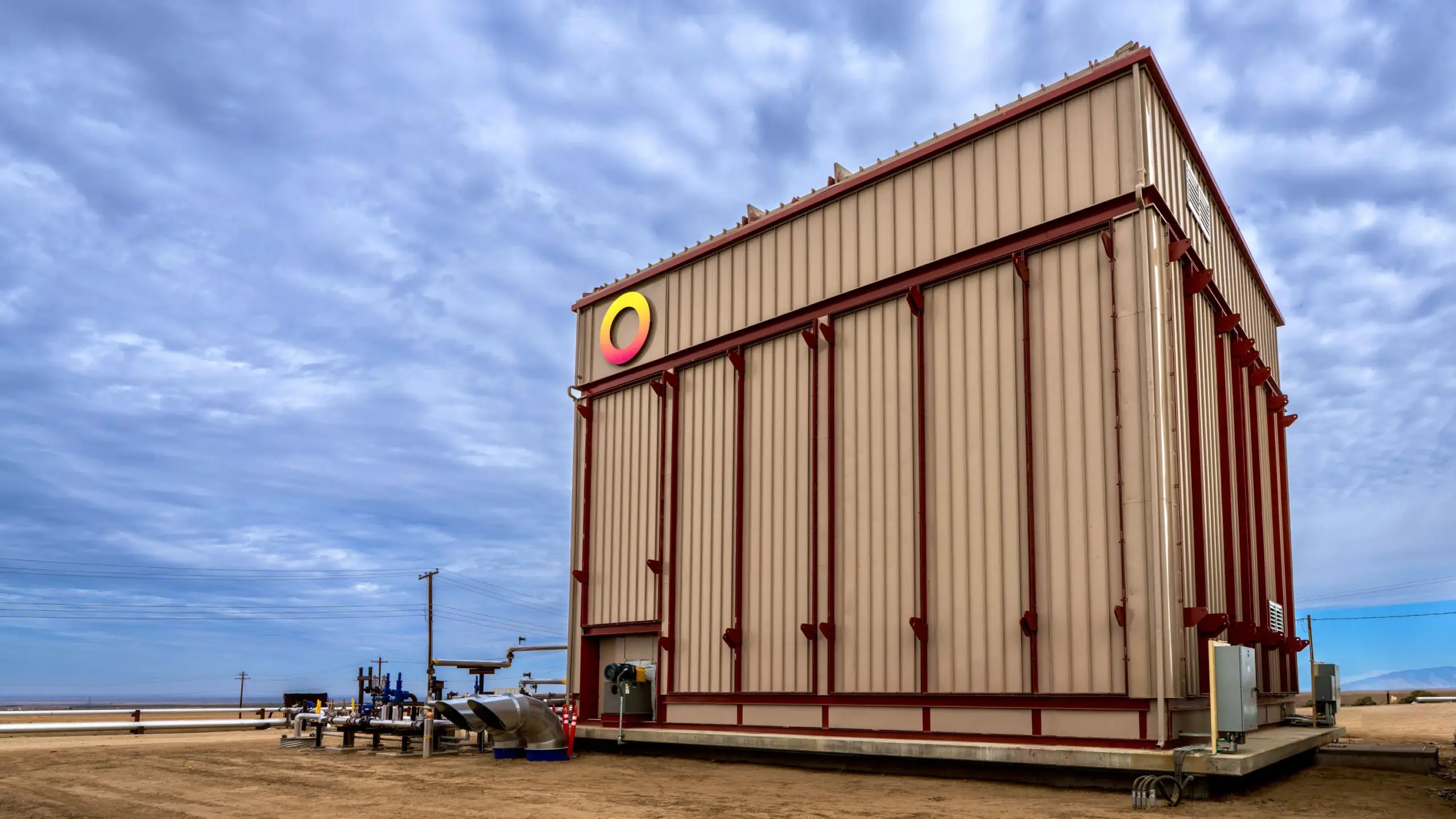

Rondo Energy startet weltweit größte thermische Batterie : Rondo Energy hat die nach eigenen Angaben größte thermische Batterie der Welt in Betrieb genommen, die elektrische Energie speichern und eine stabile Wärmequelle liefern kann, was zur Dekarbonisierung der Industrie beitragen soll. Diese thermische Batterie hat eine Kapazität von 100 Megawattstunden, einen Wirkungsgrad von über 97 % und ist seit 10 Wochen in Betrieb und erfüllt die Anforderungen. Obwohl der Einsatz zur verbesserten Ölförderung umstritten ist, ist das Unternehmen der Ansicht, dass dieser Schritt bestehende fossile Brennstoffoperationen sauberer machen und die Anwendung von Energiespeichertechnologien im Industriesektor vorantreiben kann. (Quelle: MIT Technology Review)