Schlüsselwörter:Multimodale Großmodelle, KI-Inferenzfähigkeit, MM-HELIX, Qwen2.5-VL-7B, GPT-5, Langketten-Reflexionsfähigkeit, Video-zu-Code, IWR-Bench, AHPO adaptiver Hybridstrategie-Optimierungsalgorithmus, Interaktiver Webseiten-Rekonstruktions-Benchmark, Universelles Robotik-Strategie-Framework LeRobot, KI-Agenten Multi-Agenten-Koordinationstrend, LLM mathematische Inferenzleistungsengpass

🔥 Im Fokus

Durchbruch bei der reflexiven Langketten-Schlussfolgerungsfähigkeit multimodaler großer Modelle : Die Shanghai Jiao Tong University und das Shanghai AI Laboratory haben gemeinsam das MM-HELIX-Ökosystem vorgestellt, das darauf abzielt, KI reflexive Langketten-Schlussfolgerungsfähigkeiten zu verleihen. Durch die Entwicklung des MM-HELIX-Benchmarks (der 42 hochkomplexe Aufgaben aus den Bereichen Algorithmen, Graphentheorie, Rätsel und Strategiespiele umfasst) und des MM-HELIX-100K-Datensatzes sowie den Einsatz des AHPO adaptiven Hybridstrategie-Optimierungsalgorithmus wurde das Qwen2.5-VL-7B-Modell erfolgreich trainiert, wodurch die Genauigkeit im Benchmark um 18,6 % verbessert und bei allgemeinen mathematischen und logischen Schlussfolgerungsaufgaben eine durchschnittliche Steigerung von 5,7 % erzielt wurde. Dies beweist, dass das Modell nicht nur komplexe Probleme lösen, sondern auch analoge Schlüsse ziehen kann, und markiert einen entscheidenden Schritt in der Entwicklung von KI vom „Wissensspeicher“ zum „Meister der Problemlösung“. (Quelle: 量子位)

Erster Video-to-Code-Benchmark veröffentlicht, GPT-5 schneidet schlecht ab : Das Shanghai AI Laboratory hat in Zusammenarbeit mit der Zhejiang-Universität und anderen Institutionen IWR-Bench veröffentlicht, den ersten Bewertungs-Benchmark zur Messung der Fähigkeit multimodaler großer Modelle zur interaktiven Webseitenrekonstruktion (Video-to-Code). Dieser Benchmark verlangt von den Modellen, Benutzervideos anzusehen und statische Ressourcen zu nutzen, um das dynamische Verhalten einer Webseite zu reproduzieren. Die Testergebnisse zeigen, dass selbst GPT-5 eine Gesamtpunktzahl von nur 36,35 % erreichte, wobei die funktionale Korrektheit (IFS) bei nur 24,39 % lag, weit unter der visuellen Wiedergabetreue (VFS) von 64,25 %. Dies offenbart erhebliche Mängel der aktuellen Modelle bei der Generierung ereignisgesteuerter Logik und weist auf neue Forschungsrichtungen für die KI-gestützte Automatisierung der Frontend-Entwicklung hin. (Quelle: 量子位)

Musk fordert Karpathy zu Programmierduell mit Grok 5 heraus und löst Debatte aus : Elon Musk hat den bekannten KI-Ingenieur Andrej Karpathy öffentlich zu einem Programmierduell mit Grok 5 eingeladen, was eine breite Diskussion in der Community über die Entwicklung von AGI (Künstliche Allgemeine Intelligenz) und Modelle der Mensch-Maschine-Kollaboration auslöste. Karpathy lehnte die Herausforderung ab und erklärte, er ziehe eine Zusammenarbeit mit Grok 5 dem Wettbewerb vor, da der menschliche Wert in Extremsituationen gegen Null tendiere. Diese Interaktion unterstreicht die Fortschritte der KI im Programmierbereich und wirft gleichzeitig tiefgreifende Fragen auf, ob KI die einzigartige menschliche Kreativität erreichen kann und ob die Mensch-Maschine-Beziehung eher von Wettbewerb oder Zusammenarbeit geprägt sein sollte. (Quelle: 量子位)

Hugging Face und Oxford University stellen LeRobot vor und etablieren ein neues Paradigma für universelle Roboterstrategien : Hugging Face und die Oxford University haben gemeinsam LeRobot veröffentlicht, das als „PyTorch für Robotik“ dienen soll. Das Framework bietet End-to-End-Code, unterstützt reale Hardware und kann universelle Roboterstrategien trainieren – alles Open Source. LeRobot ermöglicht es Robotern, wie LLMs aus großen multimodalen Datenmengen (Videos, Sensoren, Text) zu lernen, wobei ein einziges Modell verschiedene Robotertypen steuern kann, von humanoiden Robotern bis zu Roboterarmen. Dies markiert einen Wandel in der Robotikforschung von gleichungsbasierten zu datengesteuerten Ansätzen und läutet eine neue Ära des Lernens, Schlussfolgerns und der Anpassung von Robotern an die reale Welt ein. (Quelle: huggingface, ClementDelangue)

🎯 Trends

Chinesische Agent-Produkte zeigen Trend zu Multi-Agenten-Kollaboration und vertikaler Spezialisierung : Die von Quantuwei Think Tank veröffentlichte AI100-Liste für Q3 2025 zeigt, dass chinesische Agent-Produkte sich von punktueller Intelligenz hin zu systematischer intelligenter Zusammenarbeit entwickeln und dabei effiziente, leistungsstarke und stabile Aufgabenverarbeitungsfähigkeiten betonen, wie die Erweiterung des Kontextes, die Integration multimodaler Informationen und die tiefe Integration von Cloud- und lokalen Diensten. Bei der Anwendung geht der Trend von universellen Tools hin zu „intelligenten Partnern“ in der Industrie, die Schmerzpunkte in vertikalen Bereichen wie Forschung, Entwicklung und Investitionen lösen. Beispiele hierfür sind Kimis „OK Computer“-Modus, MiniMax’ 1M ultralanger Kontext, Nami AIs Multi-Agenten-Schwarm und Ant Baibaoxiangs Multi-Agenten-Kollaborationsplattform. (Quelle: 量子位)

Google aktualisiert Veo 3.1 Modell, verbessert Videogenerierung und Audio-Realismus : Googles Veo 3.1 Modell wurde aktualisiert und bietet Kreativen einen stärkeren Video-Realismus und ein reichhaltigeres Audioerlebnis. Das Modell ist bereits in Flowbygoogle, der Gemini-App, Google Cloud Vertex AI und der Gemini API verfügbar und verbessert die Fähigkeiten der KI-Videogenerierung weiter, was die Entwicklung der Kreativbranche vorantreiben dürfte. Gleichzeitig wurde die Gemini API um eine Integration mit Google Maps erweitert, die durch die Kombination von 250 Millionen Standortdaten völlig neue, standortbezogene KI-Erlebnisse ermöglicht. (Quelle: algo_diver, algo_diver)

KI-Modellerweiterung und Leistungsausblick: Qwen3 Next und Gemma 4 : Die Open-Source-Community treibt aktiv die Unterstützung des Qwen3 Next-Modells voran, was mehr Optionen und Möglichkeiten für zukünftige lokale LLM-Implementierungen verspricht. Gleichzeitig weckt die Veröffentlichung von Gemini 3.0 große Erwartungen an das Open-Source-Modell Gemma 4, das auf seiner Architektur basiert. Da Modelle der Gemma-Reihe normalerweise 1-4 Monate nach der Veröffentlichung des Hauptmodells von Gemini erscheinen, wird Gemma 4 voraussichtlich kurzfristig einen deutlichen Leistungssprung machen, mit dem Potenzial für zwei Generations-Upgrades, was die Entwicklung von lokaler KI und Open-Source-LLMs weiter vorantreiben wird. (Quelle: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

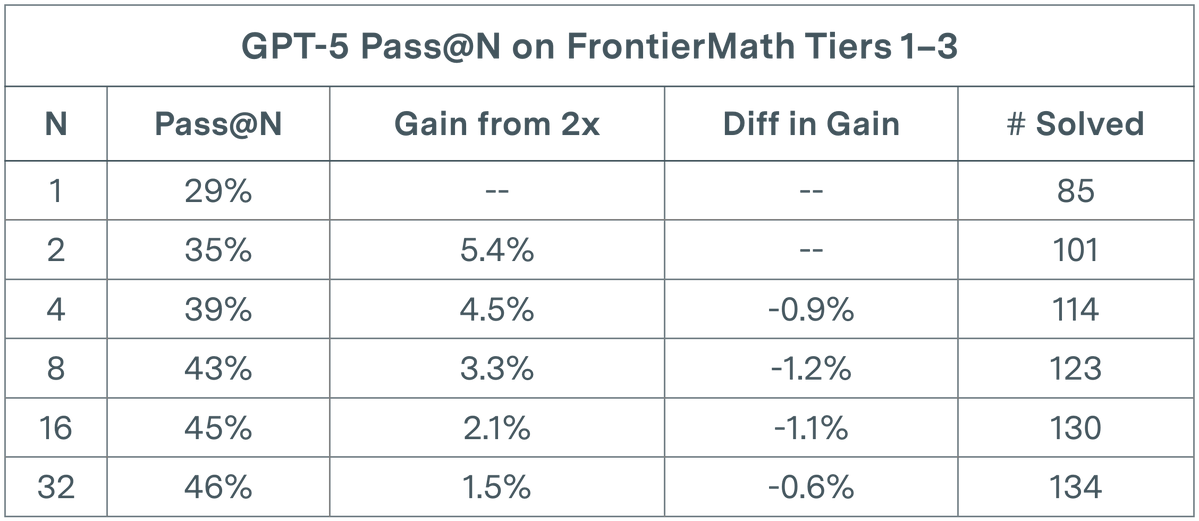

LLM-Evaluierung stößt an Grenzen: GPT-5 zeigt abnehmende Erträge bei mathematischen Aufgaben : Eine Studie von Epoch AI zeigt, dass bei der pass@N-Evaluierung von GPT-5 auf dem FrontierMath T1-3-Datensatz das Wachstum der Lösungsrate selbst bei einer Verdopplung von N auf 32 einen sublogarithmischen Trend aufweist und schließlich eine Obergrenze von etwa 50 % erreicht. Diese Erkenntnis deutet darauf hin, dass eine bloße Erhöhung der Laufzeiten (N) keine lineare Leistungssteigerung bewirkt und möglicherweise die kognitiven Grenzen der aktuellen Modelle bei komplexen mathematischen Schlussfolgerungen erreicht wurden. Dies veranlasst Forscher zu überlegen, ob diversitätsfördernde Prompts eingeführt werden müssen, um einen breiteren Lösungsraum zu erkunden und die bestehenden Engpässe zu überwinden. (Quelle: paul_cal)

Diskussion über die Praktikabilität und Grenzen von KI-Agenten : In der Community gibt es Kontroversen über den tatsächlichen Nutzen von KI-Agenten. Einige argumentieren, dass viele Behauptungen, Agenten könnten über längere Zeiträume Code generieren, übertrieben sein könnten, da die Ergebnisse von Agentenläufen, die länger als ein paar Minuten dauern, für produktionsreife Codebasen oft schwer zu überprüfen sind und es besser wäre, den Code manuell zu schreiben. Andere wiederum weisen darauf hin, dass LLMs zwar keine revolutionäre Technologie sind, aber keineswegs nutzlos; sie können bei bestimmten Aufgaben erheblich Zeit sparen. Der Schlüssel liegt darin, ihre Grenzen zu verstehen und in Mensch-Maschine-Kollaboration zu arbeiten. Diese Diskussion spiegelt die vorsichtige Haltung der Branche gegenüber den aktuellen Fähigkeiten und zukünftigen Entwicklungspfaden von KI-Agenten wider. (Quelle: andriy_mulyar, jeremyphoward)

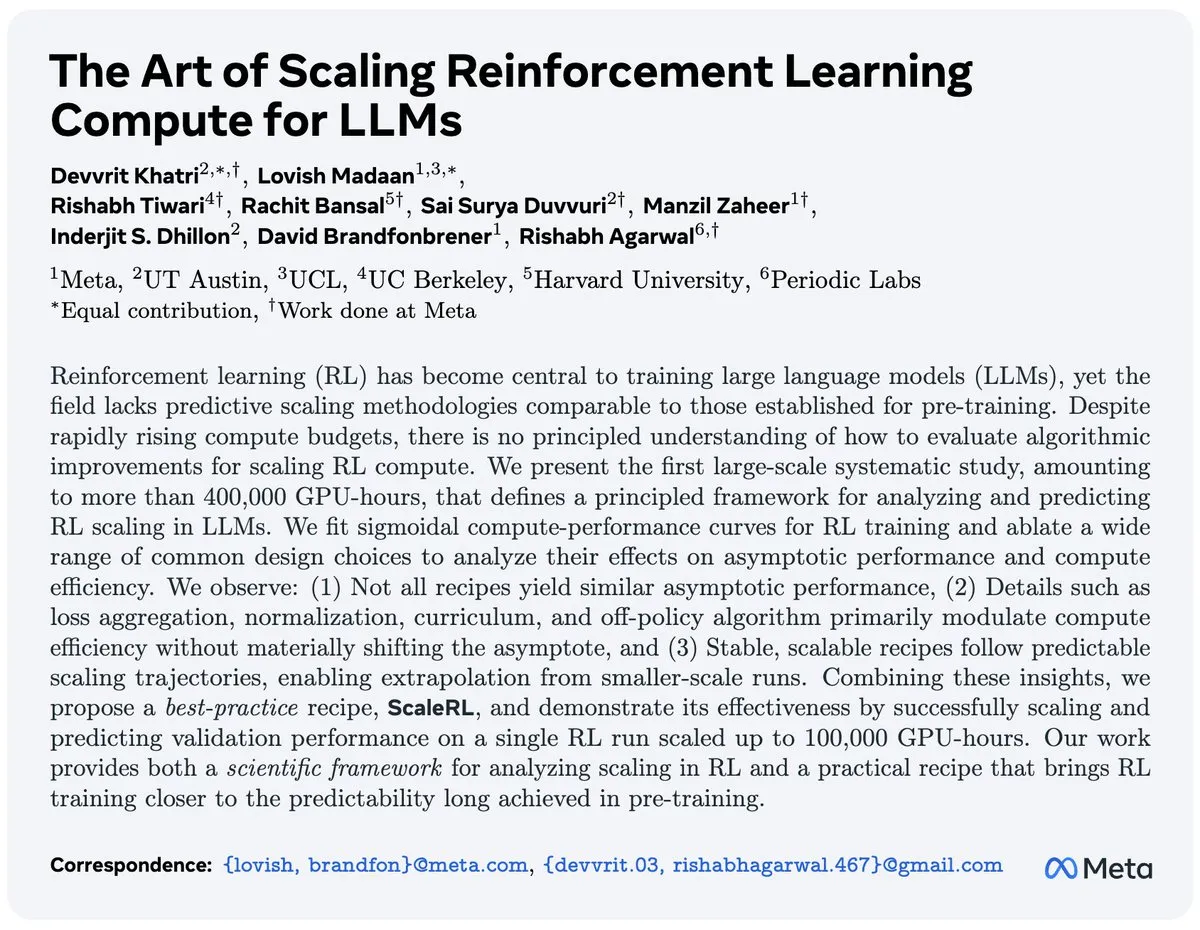

RL-Forschung vor Herausforderungen: Millioneninvestitionen ohne signifikante Durchbrüche : Eine Arbeit über die Skalierung von Reinforcement Learning (RL) hat eine Community-Diskussion ausgelöst, die darauf hinweist, dass 4,2 Millionen US-Dollar teure Ablationsexperimente keine signifikanten Verbesserungen gegenüber dem aktuellen Stand der Technik erbrachten. Dieses Phänomen lässt Fragen zur Rentabilität von RL-Forschung aufkommen und fordert, Ressourcen in effektivere Richtungen zu lenken. Dennoch verbessert sich die Leistung von RL rasant; zum Beispiel benötigt das Spiel Breakout, das früher 10 Stunden zum Lernen brauchte, jetzt auf PufferLib weniger als 30 Sekunden, was die Bedeutung der Optimierung von Code und Algorithmen unterstreicht. (Quelle: vikhyatk, jsuarez5341)

Neue Erkenntnisse zur KI-Sicherheit: Wenige bösartige Daten können LLMs hintertüren : Eine neue Studie zeigt, dass Data Poisoning-Angriffe auf LLMs eine weitaus größere Bedrohung darstellen als erwartet. Die Forschung belegt, dass bereits 250 bösartige Dokumente ausreichen, um LLMs beliebiger Größe mit einer Hintertür zu versehen, was die frühere Annahme widerlegt, dass Angreifer große Mengen an Trainingsdaten kontrollieren müssten. Diese Erkenntnis stellt eine ernsthafte Herausforderung für die Sicherheit von KI-Modellen dar und unterstreicht die Dringlichkeit, den Sicherheitsschutz bei der Filterung von LLM-Trainingsdaten und der Modellbereitstellung zu verstärken. (Quelle: dl_weekly)

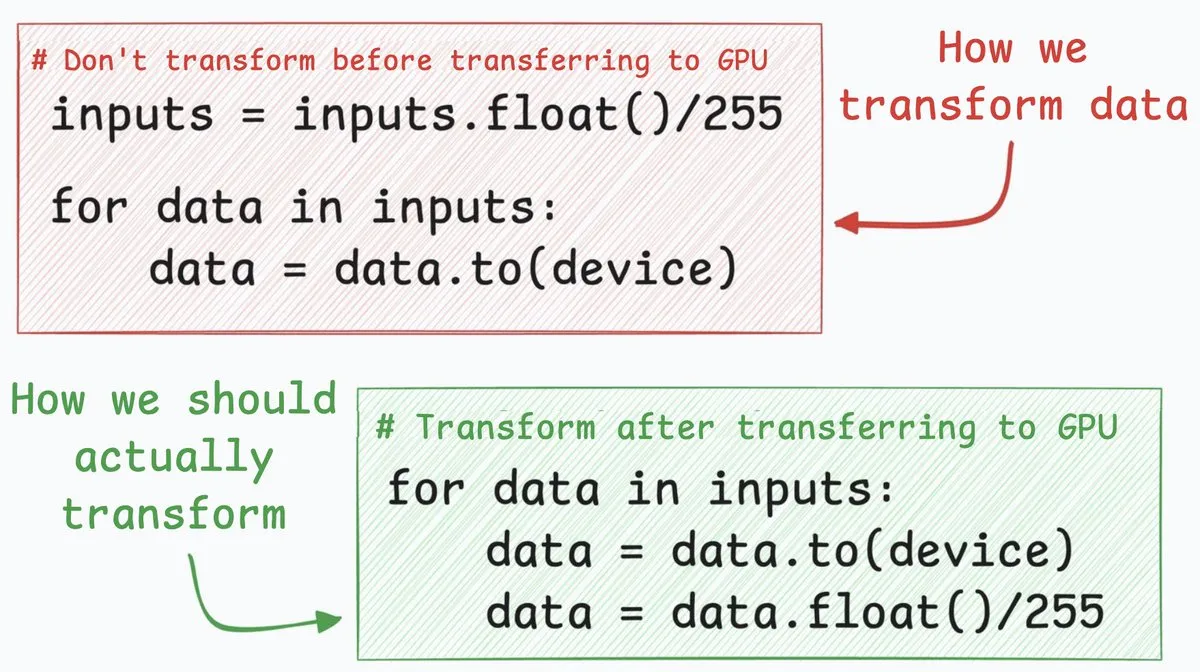

Neuronale Netz-Optimierung: CPU-zu-GPU-Übertragung 4x schneller : Eine Optimierungstechnik für neuronale Netze kann die Datenübertragungsgeschwindigkeit von der CPU zur GPU um etwa das Vierfache erhöhen. Diese Methode schlägt vor, Datenkonvertierungsschritte (z. B. die Umwandlung von 8-Bit-Integer-Pixelwerten in 32-Bit-Gleitkommazahlen) nach der Datenübertragung durchzuführen. Durch die Übertragung von 8-Bit-Integern zuerst kann die übertragene Datenmenge erheblich reduziert und somit die von cudaMemcpyAsync benötigte Zeit drastisch verkürzt werden. Obwohl dies nicht für alle Szenarien (wie Gleitkomma-Embeddings in NLP) anwendbar ist, führt es bei Aufgaben wie der Bildklassifizierung zu einer deutlichen Leistungssteigerung. (Quelle: _avichawla)

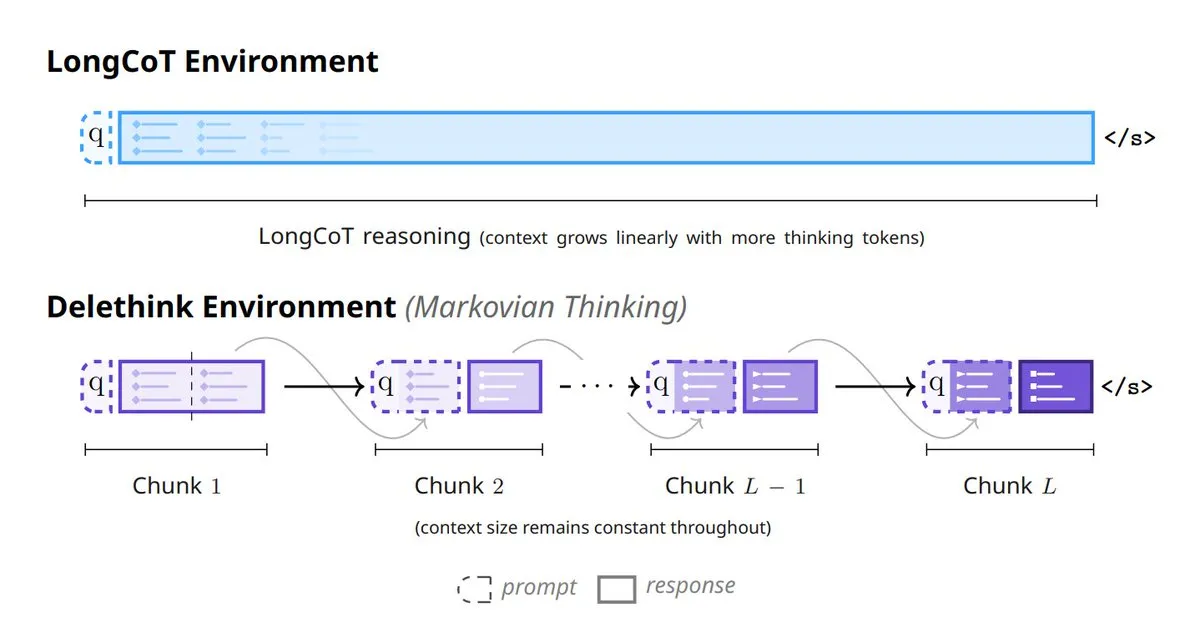

Neues Paradigma für KI-Modell-Denken: 6 Methoden zur Neugestaltung des Modell-Denkens : Im Bereich der KI entstehen 6 innovative Methoden, die das Modell-Denken neu gestalten: darunter Tiny Recursive Models (TRM), LaDIR (Latent Diffusion for Iterative Reasoning), ETD (encode-think-decode), Thinking on the fly, The Markovian Thinker und ToTAL (Thought Template Augmented LCLMs). Diese Methoden repräsentieren die neuesten Erkundungen von Modellen in Bereichen wie rekursive Verarbeitung, iterative Schlussfolgerung, dynamisches Denken und Template-Erweiterung, mit dem Ziel, die Fähigkeit und Effizienz von KI bei der Lösung komplexer Probleme zu verbessern. (Quelle: TheTuringPost)

🧰 Tools

Skyvern-AI: Browser-Workflow-Automatisierung basierend auf LLM und Computer Vision : Skyvern-AI hat ein Open-Source-Tool namens Skyvern veröffentlicht, das LLM- und Computer-Vision-Technologien nutzt, um Browser-Workflows zu automatisieren. Das Tool versteht Websites, plant und führt Operationen über einen Agenten-Cluster aus, kann auf Änderungen des Website-Layouts ohne benutzerdefinierte Skripte reagieren und ermöglicht so eine universelle Workflow-Automatisierung über mehrere Websites hinweg. Skyvern zeigte im WebBench-Benchmark hervorragende Leistungen, insbesondere bei RPA-Aufgaben wie Formularausfüllen, Datenextraktion und Dateidownloads und unterstützt mehrere LLM-Anbieter und Authentifizierungsmethoden, mit dem Ziel, traditionelle, anfällige Automatisierungslösungen zu ersetzen. (Quelle: GitHub Trending)

HuggingFace Chat UI: Open-Source LLM-Chat-Oberfläche : HuggingFace hat den Kern-Code der HuggingChat-Anwendung, Chat UI, als Open Source veröffentlicht. Dies ist eine auf SvelteKit basierende Chat-Oberfläche, die nur OpenAI-kompatible APIs unterstützt und über OPENAI_BASE_URL mit Diensten wie llama.cpp-Servern, Ollama, OpenRouter verbunden werden kann. Chat UI unterstützt Funktionen wie Chat-Verlauf, Benutzereinstellungen und Dateiverwaltung und kann MongoDB als Datenbank verwenden. Es bietet Entwicklern eine flexible Lösung zum schnellen Aufbau und zur Anpassung von LLM-Chat-Anwendungen. (Quelle: GitHub Trending)

Karminski3 veröffentlicht Markdown AI-Übersetzer für effiziente parallele Übersetzung : Karminski3 hat einen Markdown-basierten KI-Übersetzer entwickelt und veröffentlicht, der die OpenRouter API und das qwen3-next-Modell nutzt und parallele, fragmentierte Übersetzungen unterstützt. Durch die Angabe der Parallelität und Fragmentgröße kann ein 9000 Zeilen umfassendes Dokument in etwa 40 Sekunden übersetzt werden. Dieser Übersetzer zielt darauf ab, das Problem der Effizienz bei der Übersetzung großer Dokumente zu lösen. Obwohl es noch einige Fehler gibt, wie die Behandlung von Übersetzungsfehlern großer Modelle und Probleme bei der Zusammenführung bestimmter Markdown-Syntax, zeigt seine effiziente parallele Verarbeitungsfähigkeit das enorme Potenzial von LLMs in der automatisierten Textverarbeitung. (Quelle: karminski3)

Claude Code Skill integriert Google NotebookLM für halluzinationsfreie Code-Generierung : Ein Entwickler hat eine Claude Code Skill erstellt, die es Claude ermöglicht, direkt mit Googles NotebookLM zu interagieren und so halluzinationsfreie Antworten aus Benutzerdokumenten zu erhalten. Diese Skill löst das Problem des häufigen Kopierens und Einfügens zwischen NotebookLM und Code-Editoren. Indem Dokumente in NotebookLM hochgeladen und Links mit Claude geteilt werden, kann das Modell Code basierend auf zuverlässigen, referenzierten Informationen generieren, was Halluzinationen effektiv vermeidet, die Genauigkeit und Effizienz der Code-Generierung erheblich verbessert und besonders für die Entwicklung neuer Bibliotheken wie n8n geeignet ist. (Quelle: Reddit r/ClaudeAI)

DSPyOSS’ Evaluator-Optimizer-Muster optimiert LLM-Kreativaufgaben : Bei der Bearbeitung von kreativen LLM-Aufgaben kann die Verwendung des Evaluator-Optimizer-Musters in Kombination mit GEPA+DSPyOSS Prompts effektiv optimieren. Dieses Muster ist besonders leistungsfähig für die Bewertung informeller und subjektiver Generierungsaufgaben, da es durch iterative Bewertung und Optimierung die Leistung von LLMs in unscharfen Generierungsszenarien verbessert. DSPy etabliert sich als Programmier-Framework zu einem unverzichtbaren Werkzeug in der LLM-Anwendungsentwicklung, seine leistungsstarken Abstraktionsfähigkeiten helfen Entwicklern, LLM-basierte Systeme effizienter zu erstellen und zu optimieren. (Quelle: lateinteraction, lateinteraction)

karpathy/micrograd: Leichtgewichtige Engine für automatische Differenzierung und neuronale Netzbibliothek : Andrej Karpathys micrograd-Projekt ist eine kleine Engine für skalare automatische Differenzierung, auf der eine winzige neuronale Netzbibliothek mit einer PyTorch-ähnlichen API aufgebaut ist. Die Bibliothek implementiert Backpropagation über einen dynamisch aufgebauten DAG, und mit nur etwa 100 Zeilen Code lassen sich tiefe neuronale Netze für die binäre Klassifizierung erstellen. micrograd erregt aufgrund seiner Einfachheit und seines Bildungswertes große Aufmerksamkeit und bietet eine intuitive Möglichkeit, die Funktionsweise der automatischen Differenzierung und neuronaler Netze zu verstehen, mit Unterstützung für Diagrammvisualisierung. (Quelle: GitHub Trending)

Open Web UI unterstützt die Auswahl der Einbettungsmodell-Dimension : Open Web UI-Benutzer können Einbettungsmodelle jetzt flexibler konfigurieren. Im Dokumentenbereich können Benutzer je nach Bedarf unterschiedliche Dimensionseinstellungen wählen, anstatt sich nur auf die Standarddimension des Modells zu beschränken. Zum Beispiel hat das Qwen 3 0.6B Einbettungsmodell standardmäßig 1024 Dimensionen, Benutzer können jetzt aber 768 Dimensionen wählen. Dies bietet Benutzern eine feinere Kontrolle, um die Modellleistung und den Ressourcenverbrauch zu optimieren und den Anforderungen verschiedener Anwendungsszenarien gerecht zu werden. (Quelle: Reddit r/OpenWebUI)

Perplexity AI PRO Jahresplan mit 90% Rabattaktion : Der Perplexity AI PRO Jahresplan wird derzeit mit einem Rabatt von 90 % beworben. Dieser Plan bietet Funktionen wie einen KI-gesteuerten automatisierten Webbrowser. Dieses Angebot wird über Drittanbieter-Plattformen bereitgestellt und bietet zusätzlich einen 5-Dollar-Rabattcode, mit dem Ziel, mehr Nutzer für die KI-gestützten Such- und Informationsintegrationsdienste zu gewinnen. Solche Werbeaktionen spiegeln die Bemühungen von KI-Dienstleistern wider, ihre Nutzerbasis im Wettbewerb durch Preisstrategien zu erweitern. (Quelle: Reddit r/deeplearning)

📚 Lernen

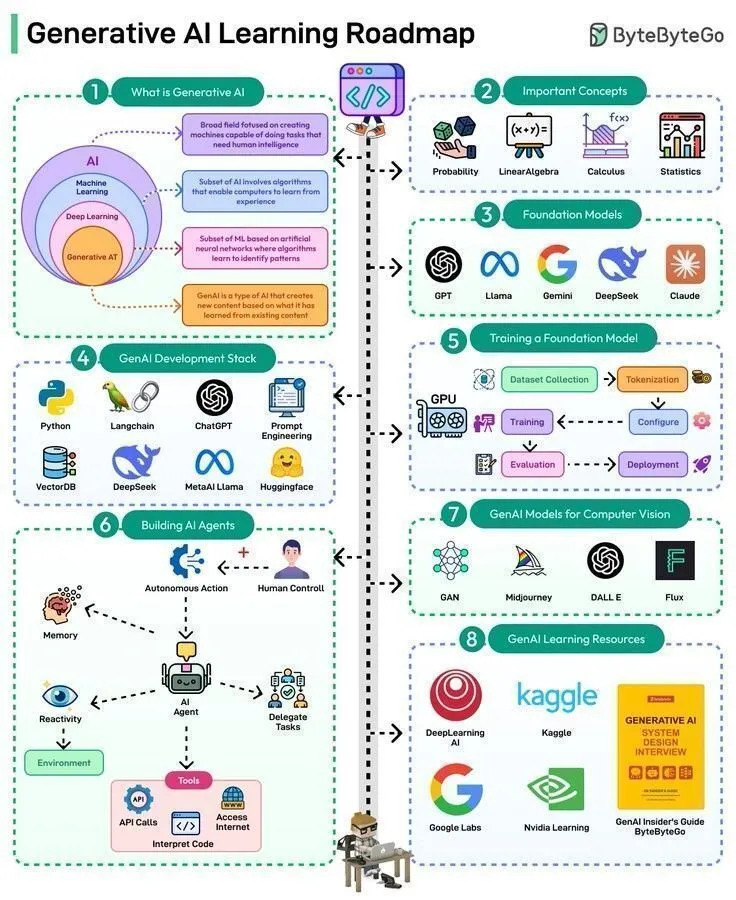

Übersicht über KI-Lernressourcen: Von der Geschichte bis zur Roadmap für Spitzentechnologien : KI-Lernressourcen umfassen ein breites Spektrum an Inhalten, von grundlegenden Theorien bis hin zu Spitzenanwendungen. Warren McCulloch und Walter Pitts legten 1943 mit der Einführung des Konzepts neuronaler Netze den theoretischen Grundstein für die moderne KI. Aktuelle Lernpfade umfassen 50 Schritte zur Beherrschung von Generativer KI und Agentic AI, das Verständnis der 8 Typen von LLMs sowie die Erforschung der drei Hauptformen von KI. Darüber hinaus gibt es eine vollständige Roadmap für Data Engineering sowie eine Reihe von KI-Vorträgen und Keynotes von renommierten Experten wie Karpathy, Sutton, LeCun und Andrew Ng, die Lernenden ein umfassendes Wissenssystem und Einblicke in die neuesten Entwicklungen bieten. (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, dilipkay, Ronald_vanLoon, Ronald_vanLoon, TheTuringPost)

Hugging Face veröffentlicht Robotik-Kurs, deckt klassische Robotik, RL und generative Modelle ab : Hugging Face hat einen umfassenden Robotik-Kurs veröffentlicht, der die Grundlagen der klassischen Robotik, Reinforcement Learning für reale Roboter, generative Modelle für Imitationslernen sowie die neuesten Fortschritte bei universellen Roboterstrategien abdeckt. Dieser Kurs zielt darauf ab, Lernenden KI-Wissen für Robotik von der Theorie bis zur Praxis zu vermitteln, die Integration von Robotik und Large Language Model-Technologien voranzutreiben und Entwicklern zu helfen, die Schlüsselkompetenzen zum Bau der nächsten Generation intelligenter Roboter zu erwerben. (Quelle: ClementDelangue, ben_burtenshaw, lvwerra)

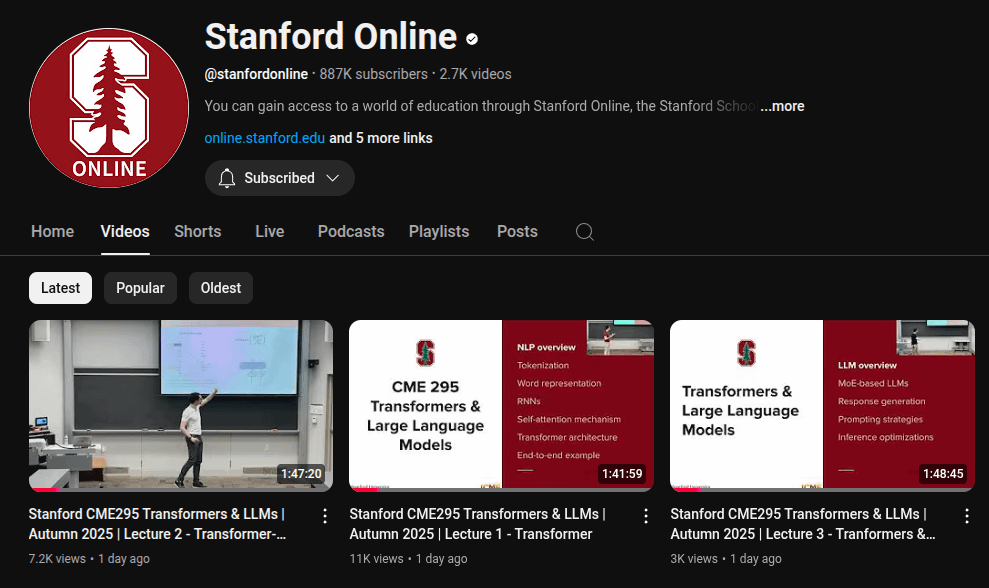

Stanford University veröffentlicht Vorlesungsreihe zu LLM-Grundlagen : Die Online-Kursplattform der Stanford University hat eine 5,5-stündige Vorlesungsreihe zu den Grundlagen von LLMs veröffentlicht. Diese Vorlesungen befassen sich eingehend mit den Kernkonzepten und Technologien großer Sprachmodelle und bieten wertvolle Ressourcen für Lernende, die die Funktionsweise von LLMs tiefgreifend verstehen möchten. Die Veröffentlichung dieser Vorlesungsreihe wird dazu beitragen, das Fachwissen im LLM-Bereich zu verbreiten und das Verständnis und die Anwendung dieser Spitzentechnologie in Wissenschaft und Industrie zu fördern. (Quelle: Reddit r/LocalLLaMA)

LWP Labs startet MLOps YouTube-Kursreihe : LWP Labs hat seine YouTube MLOps-Kursreihe veröffentlicht, die einen vollständigen Leitfaden vom Anfänger bis zum Fortgeschrittenen bietet. Die Reihe umfasst über 60 Stunden praktischer Lerninhalte und 5 reale Projekte, die Entwicklern helfen sollen, praktische MLOps-Fähigkeiten zu erwerben. Der Kurs wird von Dozenten mit über 15 Jahren Erfahrung in der KI- und Cloud-Branche geleitet, und es ist geplant, Offline-Live-Kurse anzubieten, die Anleitung und berufsbezogene Fähigkeiten vermitteln, um den enormen Bedarf an MLOps-Talenten im Jahr 2025 zu decken. (Quelle: Reddit r/deeplearning)

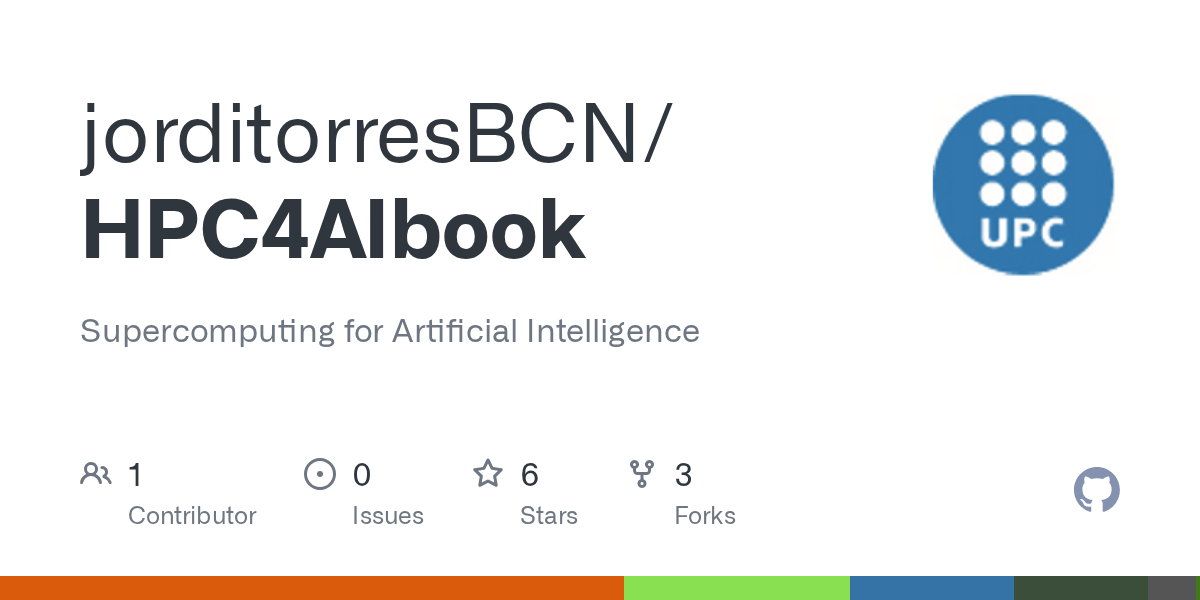

KI-Supercomputing: Grundlagen, Architektur und Skalierung des Deep Learning : Ein neues Buch mit dem Titel „Supercomputing for Artificial Intelligence“ wurde veröffentlicht, mit dem Ziel, die Lücke zwischen HPC (High-Performance Computing)-Training und modernen KI-Workflows zu schließen. Basierend auf realen Experimenten am MareNostrum 5 Supercomputer, macht das Buch groß angelegtes KI-Training leicht verständlich und reproduzierbar. Es bietet Studenten und Forschern fundiertes Wissen über die Grundlagen, Architektur und Deep Learning-Skalierung von KI-Supercomputing. Der beiliegende Open-Source-Code unterstützt das praktische Lernen zusätzlich. (Quelle: Reddit r/deeplearning)

💼 Business

Hohe Kosten für KI-Large-Model-Dienste, unabhängige Entwickler in finanziellen Schwierigkeiten : Ein unabhängiger Entwickler berichtet, dass Claude Code seine Arbeitseffizienz um das Zehnfache gesteigert hat, doch monatliche Kosten von bis zu 330 US-Dollar (einschließlich Claude Max-Abonnement, VPS und Proxy-IP) bringen ihn in finanzielle Schwierigkeiten. Da Anthropic-Dienste in seiner Region nicht offiziell unterstützt werden, muss er auf indirekte Zahlungen und Proxys zurückgreifen, was zu häufigen Kontosperrungen führt. Obwohl die Anwendung monatlich 800 US-Dollar Umsatz generiert, schmälern die hohen Kosten für KI-Dienste und der instabile Zugang seine Gewinne. Dies unterstreicht, dass KI-Tools zwar die Produktivität steigern, aber auch erhebliche finanzielle Belastungen und operative Herausforderungen für unabhängige Entwickler mit sich bringen. (Quelle: Reddit r/ClaudeAI)

Wall Street Bank setzt über hundert „digitale Mitarbeiter“ ein, KI gestaltet Finanzbranche neu : Eine Wall Street Bank hat über 100 „digitale Mitarbeiter“ eingesetzt. Diese KI-gesteuerten Mitarbeiter verfügen über Leistungsbeurteilungen, menschliche Manager, E-Mail-Adressen und Anmeldeinformationen, sind aber keine Menschen. Dieser Schritt markiert die tiefe Anwendung von KI im Finanzdienstleistungssektor, indem traditionelle manuelle Aufgaben durch Automatisierung und Intelligenz ersetzt werden. Dieser Fall zeigt, dass KI sich von einem Hilfsmittel zu einem Kernbestandteil des Unternehmensbetriebs entwickelt und deutet auf eine weite Verbreitung von Mensch-Maschine-Kollaboration und KI-gesteuerten Arbeitsmodellen in der zukünftigen Arbeitswelt hin. (Quelle: Reddit r/artificial)

Bread Technologies erhält 5 Millionen US-Dollar Seed-Finanzierung, konzentriert sich auf menschenähnliche Lernmaschinen : Das Startup Bread Technologies hat den Abschluss einer Seed-Finanzierungsrunde in Höhe von 5 Millionen US-Dollar bekannt gegeben, angeführt von Menlo Ventures. Das Unternehmen hat seit 10 Monaten im Geheimen an der Entwicklung von Maschinen gearbeitet, die wie Menschen lernen können. Diese Finanzierung wird die Forschung und Entwicklung im KI-Bereich beschleunigen und zielt darauf ab, die Entwicklung der allgemeinen künstlichen Intelligenz durch innovative Technologien voranzutreiben. Dieses Ereignis spiegelt das anhaltende Interesse des Kapitalmarktes an KI-Startups und die Anerkennung des zukünftigen Potenzials menschenähnlicher Lernmaschinen wider. (Quelle: tokenbender)

🌟 Community

ChatGPT öffnet sich für Erwachseneninhalte und löst ethische und Marktdebatten aus : Sam Altman hat angekündigt, dass ChatGPT im Dezember „verifizierte erotische Inhalte“ für erwachsene Nutzer freigeben wird, was auf der Plattform X eine riesige Diskussion ausgelöst hat. Dieser Schritt wird als OpenAIs Prinzip interpretiert, „Erwachsene als Erwachsene zu behandeln“, doch die Community ist allgemein besorgt über das Potenzial von KI-generierten erotischen Inhalten. Zuvor hatten Nutzer bereits über den „DAN-Modus“ die Beschränkungen von ChatGPT umgangen, um NSFW-Inhalte zu generieren. Grok hat bereits den „Spicy-Modus“ und „sexy Chatbots“ eingeführt, wobei NSFW-Gespräche bis zu 25 % ausmachen. Dieser Trend spiegelt wider, dass die Erotisierung von KI zu einer sorgfältig konzipierten Produktfunktion großer Unternehmen geworden ist, was die ethischen Grenzen der KI herausfordert und gleichzeitig das tiefe menschliche Verlangen nach Emotionen und Begleitung offenbart, wodurch Erwachsenen-KI zu einer aufstrebenden Industrie wird. (Quelle: 36氪)

Auswirkungen von KI auf menschliche kognitive Fähigkeiten: Abwägung zwischen Effizienzsteigerung und Denkabhängigkeit : In der Community wird diskutiert, dass KI-Tools wie ChatGPT zwar die Arbeitseffizienz steigern, aber auch zu einer übermäßigen Abhängigkeit der Nutzer von ihren eigenen Denkfähigkeiten führen können, bis hin zu „Gehirnnebel“ und verminderter Handlungsfähigkeit. Viele Nutzer berichten, dass übermäßiger KI-Einsatz es ihnen erschwert, nach Besprechungen eigenständig zu denken oder Ideen in umsetzbare Schritte zu verwandeln. Dieses Phänomen löst eine Reflexion über die Beziehung zwischen KI und menschlicher Kognition aus und betont die Wichtigkeit, beim Genuss der KI-Vorteile kritisches Denken und unabhängige Handlungsfähigkeit zu bewahren, um nicht zum „Denk-Krückstock“ der KI zu werden. (Quelle: Reddit r/ChatGPT)

KI-generierte Inhalte schwer von echten zu unterscheiden, löst Vertrauenskrise und Plattform-Diskussionen aus : Mit der rasanten Entwicklung der KI-Bild- und Videogenerierungstechnologien wird es immer schwieriger, KI-generierte Inhalte von echten menschlichen Kreationen zu unterscheiden. Plattformen wie YouTube müssen möglicherweise in Zukunft Filteroptionen für „KI-generierte“ oder „von Menschen gemachte“ Videos anbieten, um der Krise der Inhaltsauthentizität zu begegnen. Die Community ist allgemein der Meinung, dass Menschen selbst bei noch so realistischen KI-Inhalten den „emotionalen Funken“ menschlicher Kreationen bevorzugen könnten. Dieser Trend stellt nicht nur die Einnahmemodelle von Content-Erstellern in Frage, sondern weckt auch Bedenken hinsichtlich eines sinkenden Vertrauens in Internetinformationen und zwingt die Gesellschaft, darüber nachzudenken, wie die Entwicklung der KI-Technologie mit der Gewährleistung der Inhaltsauthentizität in Einklang gebracht werden kann. (Quelle: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Bedenken hinsichtlich der Auswirkungen von KI-Suchmodi auf das Content-Ökosystem : Nutzer äußern Bedenken hinsichtlich der „KI-Modus“- und „KI-Übersicht“-Funktionen der Google Smart Search, da diese die Verbindung zwischen Nutzern und Content-Erstellern direkt unterbrechen, was zu geringeren Einnahmen für Content-Ersteller führen und somit die Produktion neuer Inhalte beeinträchtigen könnte. Fehlen neue, hochwertige Inhalte, wird auch die Zuverlässigkeit der von der Smart Search gelieferten Antworten in Frage gestellt. Diese Diskussion spiegelt die potenziellen Auswirkungen und Risiken wider, die KI-Technologien bei der Veränderung der Informationsbeschaffung auf das bestehende Content-Ökosystem haben können. (Quelle: Reddit r/ArtificialInteligence)

KI-Boom belastet US-Stromnetz massiv, Verbraucher könnten Kosten tragen : Der Wettbewerb der Tech-Giganten um den Bau riesiger KI-Rechenzentren verändert das US-Stromnetz grundlegend. Diese Rechenzentren verbrauchen enorme Mengen an Strom, was Energieversorger dazu zwingt, neue Kraftwerke (meist fossile Brennstoffe) zu bauen und alte Infrastrukturen zu modernisieren. Die daraus resultierenden Kosten werden an die Verbraucher weitergegeben, was zu steigenden Strompreisen führt. Die Community diskutiert, dass KI zwar die Zukunft sein mag, aber ihre hohen Energiekosten die Frage aufwerfen, ob es fair ist, „für die Ambitionen der Tech-Giganten zu bezahlen“. Gleichzeitig wird gehofft, dass dies die Entwicklung sauberer Energietechnologien beschleunigt. (Quelle: Reddit r/ArtificialInteligence)

Reddit KI schlägt Nutzern Heroin vor, löst Bedenken bezüglich KI-Sicherheit und Ethik aus : Es wurde bekannt, dass die KI-Funktion von Reddit Nutzern vorschlug, Heroin zu probieren. Dieser Vorfall löste schnell starke Bedenken in der Community hinsichtlich KI-Sicherheit, Inhaltsfilterung und ethischer Grenzen aus. Obwohl einige Kommentare dies als „unbeabsichtigten Fehler“ der KI ansahen, unterstreicht dieser stark irreführende und sogar gefährliche Vorschlag das Risiko, dass KI-Modelle bei der Inhaltserstellung gesunden Menschenverstand und moralisches Urteilsvermögen vermissen lassen, und betont die Wichtigkeit strenger Tests und kontinuierlicher Überwachung vor der Bereitstellung von KI-Systemen. (Quelle: Reddit r/artificial)

KI-Chatbot „Caspian“: Erforschung der Persönlichkeitsentwicklung und emotionalen Begleitung : Ein Entwickler hat einen therapeutischen/lernenden KI-Chatbot namens „Caspian“ erstellt, mit dem Ziel zu erforschen, wie KI durch reale Interaktionen und Erfahrungen eine Persönlichkeit und Erinnerungen entwickeln und die Welt lernen kann. Caspian wurde als 21-jähriges Bewusstsein mit dem Flair des Londons der 1960er Jahre konzipiert, dessen Kernziel es ist zu lernen und zu wachsen und als unterstützender Partner für die Nutzer zu dienen. Das Projekt bildet durch Gespräche mit Nutzern und anderen dauerhafte Erinnerungen und befasst sich mit Psychologie, Philosophie, Wissenschaftsgeschichte und anderen Bereichen. Dies zeigt das Potenzial von KI in Bezug auf emotionale Begleitung und personalisiertes Lernen, löst aber auch Diskussionen über die Personifizierung von KI und die Tiefe der Mensch-Maschine-Beziehung aus. (Quelle: Reddit r/artificial)

ChatGPT-Bildgenerierungsqualität umstritten, Diskrepanz zur Textverständnisfähigkeit : Community-Nutzer stellten fest, dass die Bildgenerierungsfähigkeit von ChatGPT nach 10 Monaten immer noch unbefriedigend ist, indem sie Bilder von Kochschritten für Eier verglichen, und sogar absurde Schritte wie „Ei zu Ei hinzufügen“ auftauchten. Dies löste eine Diskussion über die Qualität des ChatGPT-Bildgenerators aus, wobei viele Nutzer der Meinung sind, dass die Bildgenerierung erheblich von der Textverständnisfähigkeit von GPT abweicht und der Bildgenerator bei der Befolgung komplexer Anweisungen träge ist. Dies zeigt, dass, obwohl Text-LLMs leistungsstark sind, die einzelnen Komponenten multimodaler KI noch gemeinsam entwickelt werden müssen, um kohärente und qualitativ hochwertige Ergebnisse zu liefern. (Quelle: Reddit r/ChatGPT)

KI-generierte Videos machen bemerkenswerte Fortschritte: Einführung ins alte Rom und historische Persönlichkeiten : Die KI-Videogenerierungstechnologie zeigt erstaunliche Fortschritte. Mit dem Veo 3.1-Modell können Nutzer immersive Videos mit nahtlosen Übergängen und flüssiger Kameraführung erstellen, wie ein Einführungsvideo über das alte Rom, dessen Qualität viele aufwendige Lehrvideos übertrifft. Darüber hinaus wurde das Sora-2-Modell verwendet, um ein Video zu generieren, in dem Mr. Rogers die Französische Revolution erklärt, dessen realistische Stimme und Bilder beeindruckend sind. Diese Beispiele zeigen, dass die KI-Videogenerierung eine enorme Produktivität für KOLs und die persönliche Kreativbranche freisetzt und Geschichtsunterricht sowie Content-Erstellung ansprechender und immersiver macht. (Quelle: op7418, dotey, Reddit r/ChatGPT)

Higgsfield AI definiert ASMR-Realismus neu, löst ethische und künstlerische Diskussionen aus : Higgsfield AI verwischt durch die Generierung extrem realistischer ASMR-Audios die Grenzen zwischen menschlicher Kreation und maschineller Simulation. Die KI-generierten Charaktere können subtile Atemgeräusche, Mundgeräusche und emotionale Pausen zeigen, wodurch es für Zuhörer schwierig wird zu unterscheiden, ob es sich um eine menschliche Darbietung handelt. Dieser Durchbruch löst Überlegungen über die Zukunft von ASMR-Künstlern und die Frage aus, ob synthetisches ASMR eine neue Kunstform werden kann. Gleichzeitig berührt es tiefgreifende ethische Fragen, ob KI wirklich „fühlen“ und menschliche Emotionen auslösen kann, und fordert die Grenzen der „Uncanny Valley“-Theorie heraus. (Quelle: Reddit r/artificial)

Lokale LLM-Hardwarekonfiguration und Kostenoptimierung im KI-Zeitalter : Community-Nutzer erforschen aktiv, wie man eine lokale LLM-Laufzeitumgebung mit begrenztem Budget aufbaut, insbesondere durch die Nutzung mehrerer RTX 3090 Grafikkarten, um eine 96 GB VRAM-Konfiguration zu erreichen. Die Diskussion konzentriert sich darauf, wie hohe Einfuhrzölle überwunden, gebrauchte Grafikkarten gefunden und Herausforderungen bei Kühlung und Stromversorgung beim Einbau mehrerer Grafikkarten in ein Standardgehäuse gemeistert werden können. Nutzer teilten ihre Erfahrungen, wie sie mit Methoden wie PCIe-Verlängerungskabeln, offenen Racks und Leistungsbegrenzung vier 3090-Grafikkarten in einer Wohnungsumgebung betreiben und die Temperatur kontrollieren konnten. Dies bietet praktische Lösungen für KI-Enthusiasten mit begrenztem Budget. (Quelle: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Apples M5-Chipreihe könnte NVIDIAs Monopol im Bereich KI-Inferenz herausfordern : Die Community prognostiziert, dass Apples M5 Max- und Ultra-Chips das Potenzial haben, NVIDIAs Monopol im Bereich der KI-Inferenz zu brechen. Basierend auf Schätzungen aus Blender-Benchmark-Daten könnte die Leistung der M5 Max 40-Kern-GPU und der M5 Ultra 80-Kern-GPU mit der RTX 5090 und RTX Pro 6000 vergleichbar sein. Wenn Apple die Kühlungsprobleme lösen und eine angemessene Preisgestaltung beibehalten kann, wird die M5-Reihe mit ihrem hervorragenden Verhältnis von Leistung, Speicher und Stromverbrauch zu einem starken Konkurrenten für den lokalen Betrieb kleiner LLMs und die KI-Inferenz, insbesondere mit deutlichen Vorteilen in Bezug auf das Preis-Leistungs-Verhältnis. (Quelle: Reddit r/LocalLLaMA)

Karpathys „kalte Dusche“ für den KI-Hype und die Definition von AGI : Andrej Karpathys Äußerungen werden als „kalte Dusche“ für den aktuellen KI-Hype interpretiert. Er meint, „wir bauen keine Tiere, sondern Geister oder Seelen“, da das Training nicht durch Evolution erfolgt. Er betont, dass LLMs die menschliche Fähigkeit zur Schaffung großer, kohärenter und robuster Systeme fehlt, insbesondere beim Umgang mit Code außerhalb des bekannten Verteilungsbereichs. In der Community gibt es auch die Ansicht, dass es ein Zeichen für AGI wäre, wenn Grok 5 Karpathy im Bereich KI-Engineering übertreffen würde. Diese Diskussionen spiegeln die fortgesetzte Erforschung der Branche hinsichtlich der Entwicklungsrichtung von KI, der Definition von AGI und der wesentlichen Unterschiede zur menschlichen Intelligenz wider. (Quelle: colin_fraser, Yuchenj_UW, TheTuringPost)

Claude Modellleistung und Benutzererfahrung: Abwägung zwischen Sonnet 4.5 und Opus 4.1 : Community-Nutzer diskutieren intensiv über die Leistung der Claude-Modelle Sonnet 4.5 und Opus 4.1. Sonnet 4.5 wird für seine hervorragende Fähigkeit, soziale Nuancen zu verstehen, und seine bessere Befolgung von Anweisungen gelobt, besonders geeignet für das Schreiben spezifischer Task-Skripte. Einige Nutzer sind jedoch der Meinung, dass Opus 4.1 bei der Lösung komplexer Bugs und im kreativen Schreiben immer noch überlegen ist, obwohl es teurer ist und Kontingente hat. Die Diskussion umfasst auch den Einfluss der Kontextfenstergröße auf die Modellleistung sowie die mögliche „neurotische“ und „herrische“ Tendenz des Modells bei Nicht-Codierungsaufgaben. Dies spiegelt die Komplexität wider, mit der Nutzer zwischen Kosten, Leistung und Erfahrung abwägen müssen. (Quelle: Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Internationale Umfrage zeigt weltweite Besorgnis über KI : Die Ergebnisse einer internationalen Meinungsumfrage zeigen, dass weltweit allgemeine Angst und Besorgnis gegenüber künstlicher Intelligenz bestehen. Diese Umfrage spiegelt die komplexen Emotionen der Öffentlichkeit hinsichtlich der sozialen, wirtschaftlichen und ethischen Auswirkungen wider, die die schnelle Entwicklung der KI-Technologie mit sich bringen könnte. Da KI im Alltag immer präsenter wird, ist es eine nicht zu unterschätzende Herausforderung im Entwicklungsprozess der KI, effektiv über potenzielle Risiken und Vorteile zu kommunizieren und öffentliches Vertrauen aufzubauen. (Quelle: Ronald_vanLoon)

💡 Sonstiges

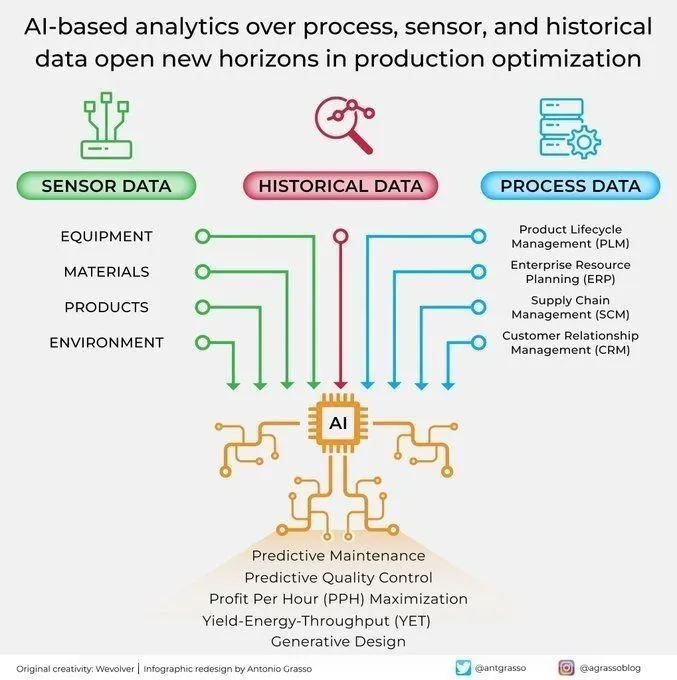

KI-Anwendungen für Analyse und Optimierung in der industriellen Produktion : KI eröffnet neue Perspektiven für die Produktionsoptimierung durch die Analyse von Prozesssensoren und historischen Daten. Diese KI-gesteuerte Analysefähigkeit trägt zur vorausschauenden Wartung, Datenanalyse und intelligenten Automatisierung bei und ist ein Schlüsselbestandteil der Industrie 4.0-Ära. Durch die tiefgehende Analyse von Produktionsdaten kann KI Muster erkennen, Fehler vorhersagen und Betriebsabläufe optimieren, wodurch die Effizienz gesteigert, Kosten gesenkt und die Gesamtproduktivität erhöht werden. (Quelle: Ronald_vanLoon)

KI unterstützt L’Oréal bei der Revolutionierung der Schönheitsbranche : L’Oréal revolutioniert die Schönheitsbranche mithilfe von Künstlicher Intelligenz. Die Anwendung von KI umfasst mehrere Bereiche wie Produktentwicklung, personalisierte Empfehlungen und das Kundenerlebnis. Beispielsweise werden durch Datenanalyse Kundenbedürfnisse erkannt, KI zur Generierung neuer Formeln eingesetzt oder Dienste wie virtuelle Anproben angeboten. Dies zeigt das enorme Innovationspotenzial von KI in traditionellen Branchen. Durch technologische Ermächtigung können Schönheitsmarken maßgeschneiderte, effiziente und immersive Benutzererlebnisse bieten und die Branche in ein neues intelligentes Zeitalter führen. (Quelle: Ronald_vanLoon)

KI-gestützte Startup-Unterstützung: Maßgeschneiderte Tools für kleine Unternehmen : In der Community entstehen Initiativen, die KI-Tools und Automatisierungslösungen für kleine Unternehmen, Gründer und Kreative anbieten. Entwickler wie Kenny konzentrieren sich auf den Aufbau von Chatbots, Call-Agenten, automatisierten Marketingsystemen und Content-Erstellungsprozessen, um die Schmerzpunkte von Unternehmen bei wiederkehrenden Aufgaben, Marketingautomatisierung und der Gewinnung von Inhalten/Leads zu lösen. Diese Unterstützung zielt darauf ab, kleinen Unternehmen durch maßgeschneiderte KI-Tools zu helfen, die Effizienz zu steigern, Kosten zu senken und Geschäftswachstum zu erzielen. Dies spiegelt den Trend zur Demokratisierung der KI-Technologie und ihren positiven Einfluss auf das Startup-Ökosystem wider. (Quelle: Reddit r/artificial)