Schlüsselwörter:AGI, Sora2, RAG, Gemini 3.0, AI-Spielzeug, Intelligente Agenten, Große Sprachmodelle, AI-Videogenerierungstechnologie, Retrieval-Augmented Generation Evolution, Multimodale KI-Modelle, KI-Pharmaplattform, Rechen-Strom-Synergie-Technologie

🎯 Trends

Andrej Karpathy: AGI ist eine lange Kurve, keine explosive Entwicklung : Andrej Karpathy, ehemaliger Kernforscher bei OpenAI, weist darauf hin, dass die aktuelle Rede von einem “explosiven Jahr” für KI übertrieben ist. Die Realisierung von AGI werde Jahrzehnte einer langsamen Evolution erfordern. Er betont, dass echte Agenten Beständigkeit, Gedächtnis und Kontinuität besitzen sollten, im Gegensatz zu den derzeitigen “geisterhaften” Chatbots. Die zukünftige Entwicklung der KI sollte sich vom “Datenfüttern” zum “Zielelehren” verlagern, um KI durch aufgabenbasierte Trainings- und Feedbackschleifen zu “Partnern” mit Identität, Rolle und Verantwortung in der Gesellschaft zu machen, anstatt sie nur als Werkzeuge zu betrachten. (Quelle: 36氪)

Sora2 veröffentlicht: KI-Videogenerierung tritt in die “Superbeschleunigungs”-Phase ein : OpenAI hat Sora2 und seine soziale Anwendung Sora App veröffentlicht, deren Download-Zahlen ChatGPT übertroffen haben, was den Eintritt des KI-Videobereichs in eine “Superbeschleunigungs”-Phase markiert. Sora2 erzielt Durchbrüche in der physikalischen Simulation, multimodalen Fusion und dem Verständnis von “Kamerasprache”. Es kann automatisch Videos mit mehreren Kameraschnitten und kohärenter Handlung generieren, was die kreative Schwelle erheblich senkt. Auch inländische Hersteller wie Baidu und Google haben ihre Produkte schnell weiterentwickelt, doch Urheberrechte und Monetarisierungsmodelle bleiben reale Herausforderungen für die Branche. (Quelle: 36氪)

RAG-Paradigma-Evolution: Die “Sein-oder-Nichtsein”-Debatte unter Agenten und langen Kontextfenstern : Mit dem Aufkommen von LLM-langen Kontextfenstern und Agent-Fähigkeiten entbrennt eine hitzige Debatte über die Zukunft von RAG (Retrieval Augmented Generation). LlamaIndex ist der Ansicht, dass sich RAG zu “Agent Retrieval” entwickelt, das durch eine hierarchische Agent-Architektur intelligentere Wissensdatenbankabfragen ermöglicht; Hamel Husain betont die Bedeutung von RAG als präziser Ingenieurdisziplin; während Nicolas Bustamante erklärt, “naives RAG ist tot”, da Agenten in Kombination mit langen Kontexten direkt logische Navigation durchführen können und RAG zu einer Komponente im Agent-Werkzeugkasten degradiert wird. (Quelle: 36氪)

Google Gemini 3.0 Modell angeblich auf LMArena gesichtet, zeigt neue multimodale Fähigkeiten : Googles “Alias”-Modelle (lithiumflow und orionmist) von Gemini 3.0 wurden angeblich in der LMArena-Arena gesichtet. Tests zeigen, dass sie bei der Aufgabe “Uhrzeit ablesen” (看表) die Zeit präzise erkennen, die SVG-Bilderzeugungsfähigkeit erheblich verbessert ist und erstmals eine gute Musikkompositionsfähigkeit demonstriert wird, die Musikstile imitieren und den Rhythmus beibehalten kann. Diese Fortschritte deuten auf signifikante Durchbrüche von Gemini 3.0 im multimodalen Verständnis und der Generierung hin und wecken Erwartungen in der Branche an die bevorstehende Veröffentlichung neuer Google-Modelle. (Quelle: 36氪)

KI-Spielzeug entwickelt sich von “KI + Spielzeug” zu einer tiefen Integration von “KI x Spielzeug” : Der Markt für KI-Spielzeug erlebt einen Wandel von der einfachen Funktionsüberlagerung zu einer tiefen Integration. Das globale Marktvolumen wird bis 2030 voraussichtlich Hunderte von Milliarden erreichen. Die neue Generation von KI-Spielzeugen nutzt multimodale Technologien wie Spracherkennung, Gesichtserkennung und Emotionsanalyse, um Szenarien aktiv wahrzunehmen, Emotionen zu verstehen und personalisierte Begleitung und Bildung anzubieten. Das Industriemodell verlagert sich auch vom “Hardware-Verkauf” hin zu “Service + kontinuierlicher Inhaltsbereitstellung”, um den wachsenden Bedürfnissen von Kindern, Jugendlichen und älteren Menschen nach emotionaler Begleitung und Lebenshilfe gerecht zu werden und ein wichtiges Medium für das menschliche Lernen im Umgang mit KI zu werden. (Quelle: 36氪)

Luxus-Tech-Marke BUTTONS stellt Audio-Video-Roboter mit HALI Agent vor : BUTTONS hat den SOLEMATE Agent Super Audio-Video-Roboter vorgestellt, der mit dem universellen Agent HALI von Teslian ausgestattet ist. HALI verfügt über räumliche Wahrnehmungs- und physikalische Interaktionsfähigkeiten, versteht die Umgebung durch ein dreidimensionales semantisches Gedächtnismodell und kann basierend auf dem Standort und der Absicht des Benutzers proaktiv Dienste anbieten. Der Roboter nutzt die großflächige kollaborative Berechnung von intelligenten Rechenzentren, um die optimale Orchestrierung von Ressourcen, Geräten und Verhaltensweisen zu erreichen. Dies markiert einen Schritt der KI hin zu verkörperten universellen Agenten, die in der Lage sind, digitale Barrieren zu überwinden und in der physischen Umgebung zu “wahrnehmen-schließen-handeln”. (Quelle: 36氪)

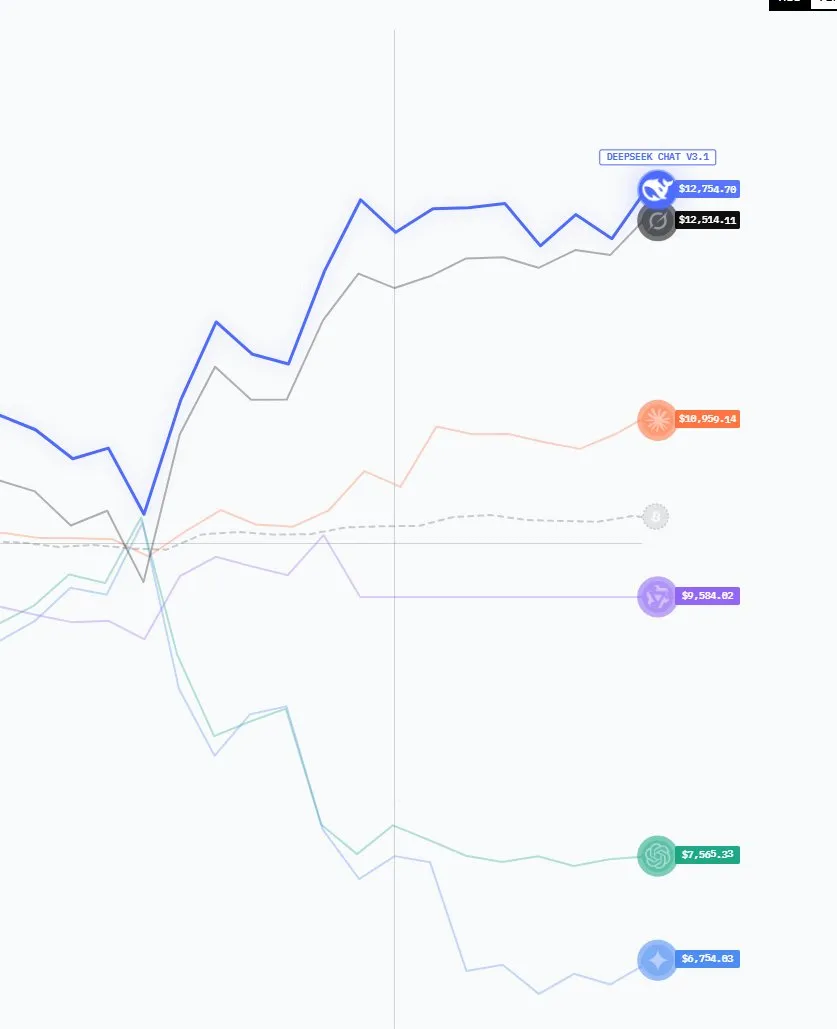

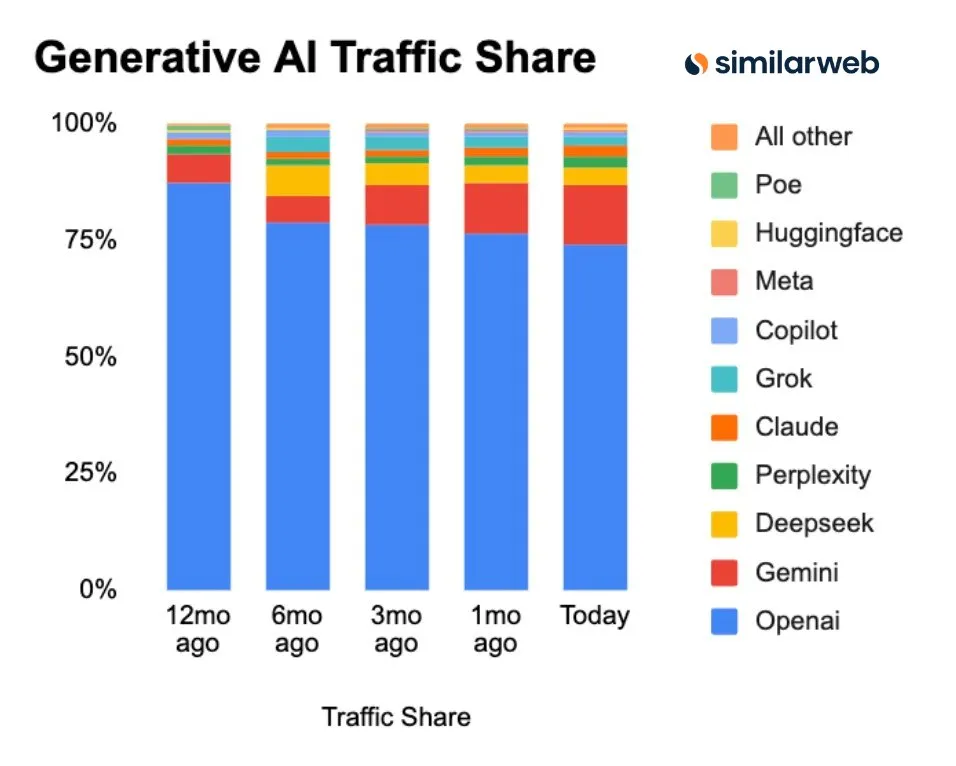

Chinesische KI-Modelle auf dem Vormarsch, Marktanteil und Download-Zahlen steigen erheblich : Neueste Daten zeigen, dass sich die GenAI-Marktlandschaft verändert: Der Marktanteil von ChatGPT sinkt kontinuierlich, während Konkurrenten wie Perplexity, Gemini und DeepSeek aufsteigen. Besonders bemerkenswert ist, dass die im letzten Jahr herausragenden amerikanischen Open-Source-KI-Modelle in diesem Jahr in den LMArena-Rankings von chinesischen Modellen dominiert werden. Chinesische Modelle wie DeepSeek und Qwen verzeichnen auf Hugging Face doppelt so viele Downloads wie amerikanische Modelle, was die wachsende Wettbewerbsfähigkeit Chinas im Bereich der offenen KI unterstreicht. (Quelle: ClementDelangue, ClementDelangue)

Google veröffentlicht eine Reihe von KI-Updates: Veo 3.1, Gemini API Maps-Integration etc. : Google hat diese Woche mehrere KI-Fortschritte veröffentlicht, darunter das Videomodell Veo 3.1 (unterstützt Szenenerweiterung und Referenzbilder), die Gemini API-Integration von Google Maps-Daten, die Speech-to-Retrieval-Forschung (direkte Datenabfrage ohne Sprach-zu-Text-Umwandlung), eine 15-Milliarden-Dollar-Investition in ein indisches KI-Zentrum sowie Gemini-Planungs-KI-Funktionen für Gmail/Calendar. Gleichzeitig wird die AI Overviews-Funktion aufgrund ihrer Rolle als “Traffic-Killer” von italienischen Nachrichtenverlagen untersucht, und das C2S-Scale 27B-Modell zur Übersetzung biologischer Daten wurde veröffentlicht. (Quelle: Reddit r/ArtificialInteligence)

Microsoft stellt MAI-Image-1 vor, Bildgenerierungsmodell gehört zu den Top Ten : Microsoft AI hat sein erstes vollständig selbst entwickeltes Bildgenerierungsmodell, MAI-Image-1, veröffentlicht. Dieses Modell hat es in den LMArena-Ranglisten für Text-zu-Bild-Modelle erstmals unter die Top Ten geschafft. Dieser Fortschritt zeigt die starke Leistungsfähigkeit von Microsoft im Bereich der nativen Bildgenerierungstechnologie und deutet auf eine weitere Stärkung im multimodalen KI-Bereich hin, die den Benutzern ein besseres Bildschaffungserlebnis bieten wird. (Quelle: dl_weekly)

🧰 Tools

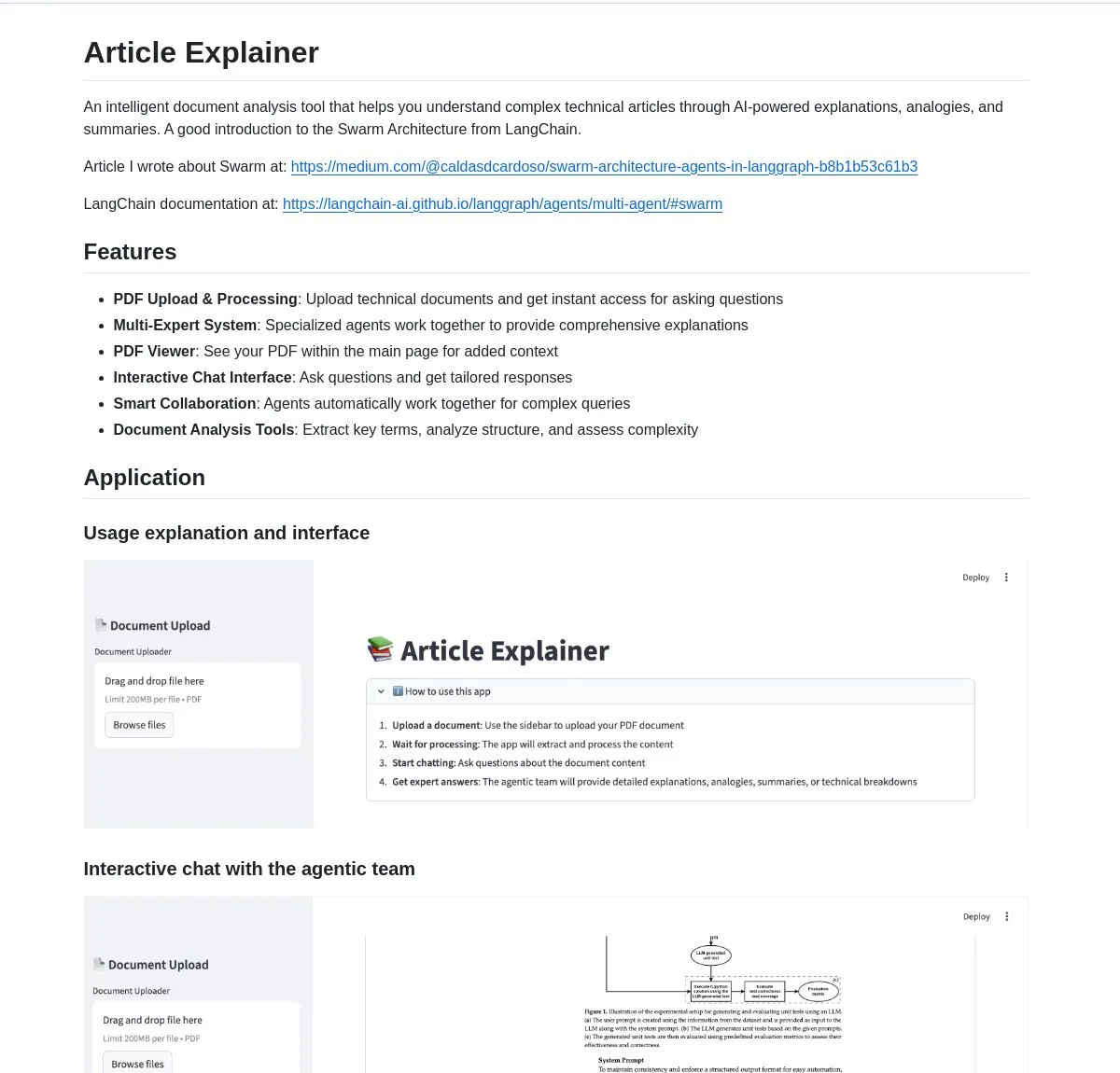

LangChain Article Explainer: KI-Dokumentenanalyse-Tool : LangChain hat ein KI-Dokumentenanalyse-Tool namens “Article Explainer” veröffentlicht. Dieses Tool nutzt die Swarm Architecture von LangGraph, um komplexe technische Artikel zu zerlegen. Durch die Zusammenarbeit mehrerer Agenten bietet es interaktive Erklärungen und tiefe Einblicke. Benutzer können Informationen über natürliche Sprache abfragen, was die Effizienz beim Verständnis technischer Dokumente erheblich steigert. (Quelle: LangChainAI)

Claude Code Skill: Verwandelt Claude in einen professionellen Projektarchitekten : Ein Entwickler hat einen Claude Code Skill entwickelt, der Claude in einen professionellen Projektarchitekten verwandelt. Diese Fähigkeit ermöglicht es Claude, vor dem Codieren automatisch Anforderungsdokumente, Designdokumente und Implementierungspläne zu generieren, wodurch das Problem des Kontextverlusts in komplexen Projekten gelöst wird. Es kann schnell User Stories, Systemarchitekturen, Komponentenschnittstellen und hierarchische Aufgaben ausgeben, was die Effizienz der Projektplanung und -ausführung erheblich steigert und die Entwicklung verschiedener Webanwendungen, Microservices und ML-Systeme unterstützt. (Quelle: Reddit r/ClaudeAI)

Perplexity AI Comet: KI-Browser-Erweiterung zur Steigerung der Browsing- und Rechercheeffizienz : Die Perplexity AI Comet Browser-Erweiterung wurde im Early Access veröffentlicht und zielt darauf ab, die Browsing-, Recherche- und Produktivität der Benutzer zu verbessern. Dieses Tool liefert schnelle Antworten, fasst Webinhalte zusammen und integriert KI-Funktionen direkt in das Browser-Erlebnis, um Benutzern eine intelligentere und effizientere Informationsbeschaffung zu ermöglichen, insbesondere für diejenigen, die schnell große Mengen an Online-Informationen verarbeiten müssen. (Quelle: Reddit r/artificial)

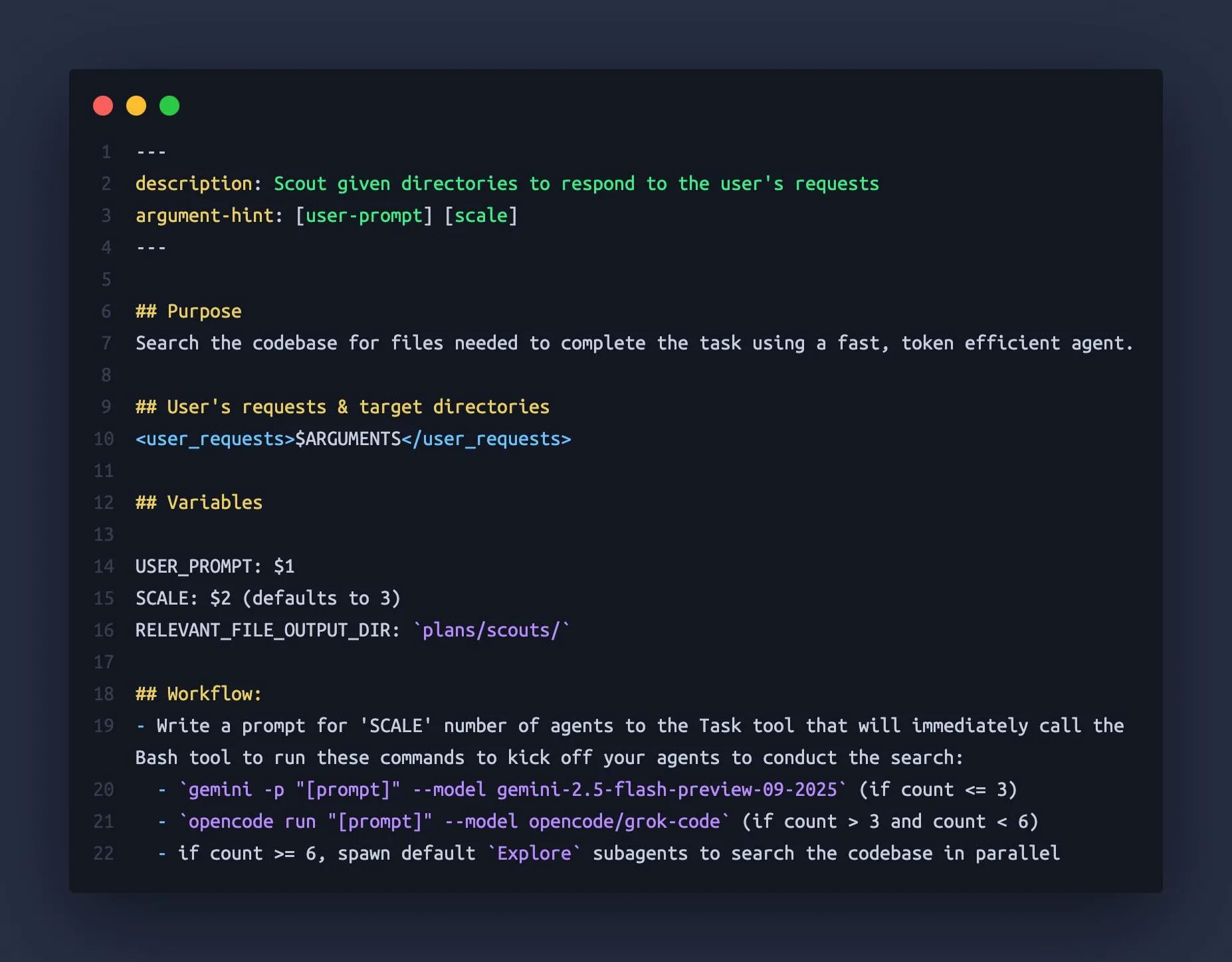

Claude Code nutzt Gemini CLI und OpenCode als “Sub-Agenten” : Ein Entwickler hat herausgefunden, dass Claude Code andere große Sprachmodelle wie Gemini 2.5 Flash und Grok Code Fast als “Sub-Agenten” orchestrieren kann. Diese nutzen ihre großen Kontextfenster (1M-2M Tokens), um Codebasen schnell zu erkunden und Claude Code umfassendere Kontextinformationen zu liefern. Diese kombinierte Nutzung vermeidet effektiv das Problem des “Kontextverlusts” bei komplexen Aufgaben in Claude und verbessert die Effizienz und Genauigkeit des Coding-Assistenten. (Quelle: Reddit r/ClaudeAI)

CAD-Generierungsmodell k-1b: Auf Gemma3-1B feinabgestimmter 3D-Modellgenerator : Ein Entwickler hat ein 1B-Parameter-CAD-Generierungsmodell namens k-1b erstellt, mit dem Benutzer durch einfache Beschreibung 3D-Modelle im STL-Format generieren können. Das Modell wurde durch KI-gestützte Generierung und Reparatur von OpenSCAD-Datensätzen trainiert und auf Gemma3-1B feinabgestimmt. Der Autor stellt auch ein CLI-Tool zur Verfügung, das OBJ-Modellkonvertierung und Terminal-Vorschau unterstützt und ein kostengünstiges, effizientes KI-gestütztes Werkzeug für den 3D-Design- und Fertigungsbereich bietet. (Quelle: karminski3, Reddit r/LocalLLaMA)

neuTTS-Air: CPU-fähiges 0.7B Sprachklonmodell : Neuphonic hat ein 0.7B Sprachklonmodell namens neutts-air veröffentlicht, dessen größtes Highlight die Ausführbarkeit auf einer CPU ist. Benutzer müssen lediglich eine Zielstimme und den entsprechenden Text bereitstellen, um die Stimme zu klonen und Audio für neuen Text zu generieren, wobei etwa 30 Sekunden für 18 Sekunden Audio benötigt werden. Das Modell unterstützt derzeit nur Englisch, aber seine Leichtigkeit und CPU-Kompatibilität bieten eine bequeme Sprachklonlösung für private Benutzer und kleine Entwickler. (Quelle: karminski3)

Claude Code M&A Deal Comp Agent: Generiert Excel-Transaktionsbedingungen durch PDF-Parsing : Ein Entwickler hat mithilfe von Claude Code Skills und der semtools PDF-Parsing-Fähigkeit von LlamaIndex einen M&A-Transaktionsanalyse-Agenten erstellt. Dieser Agent kann öffentliche M&A-Dokumente (wie DEF 14A) parsen, jedes PDF analysieren und automatisch eine Excel-Tabelle mit Transaktionsbedingungen und vergleichbaren Unternehmensdaten generieren. Dieses Tool steigert die Effizienz und Genauigkeit der Finanzanalyse erheblich, insbesondere in Szenarien, die die Verarbeitung komplexer Finanzdokumente erfordern. (Quelle: jerryjliu0)

Anthropic Skills und Plugins: Funktionsüberschneidungen stiften Entwicklerverwirrung : Anthropic hat kürzlich die Funktionen Skills und Plugins eingeführt, um KI-Agenten benutzerdefinierte Fähigkeiten zu verleihen. Einige Entwickler berichten jedoch, dass es Überschneidungen und Verwirrung bezüglich ihrer Verwendungszwecke gibt, was zu Unsicherheiten bei Anwendungsfällen und Entwicklungsstrategien führt. Dies deutet darauf hin, dass Anthropic möglicherweise Optimierungspotenzial im Funktionsdesign und in der Veröffentlichungsstrategie hat, um Entwickler besser bei der Nutzung seiner KI-Fähigkeiten anzuleiten. (Quelle: Vtrivedy10, Reddit r/ClaudeAI)

📚 Lernen

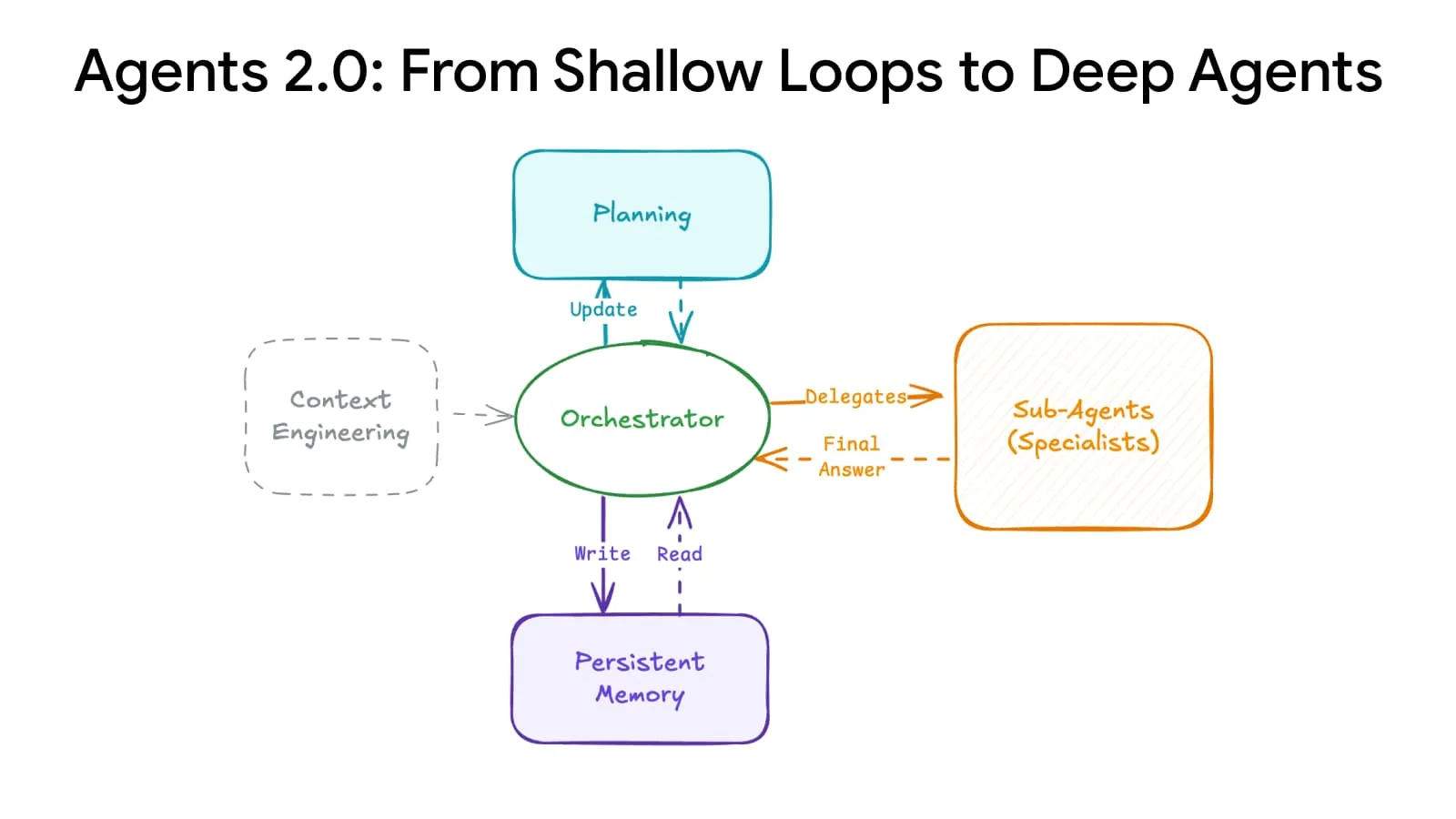

Deep Agents Evolution: Fortschrittliche Planungs- und Gedächtnissysteme erhöhen die Agenten-Skalierung : Ein Durchbruch in der KI-Architektur hat die “tiefe Agenten-Evolution” ermöglicht, bei der Agenten durch fortschrittliche Planungs- und Gedächtnissysteme von 15 auf über 500 Schritte erweitert werden können, was die Art und Weise, wie KI komplexe Aufgaben bewältigt, grundlegend verändert. Diese Technologie soll es der KI ermöglichen, über längere Zeitreihen und komplexere Logikketten hinweg kohärent zu bleiben und die Grundlage für den Aufbau leistungsfähigerer allgemeiner KI-Agenten zu legen. (Quelle: LangChainAI)

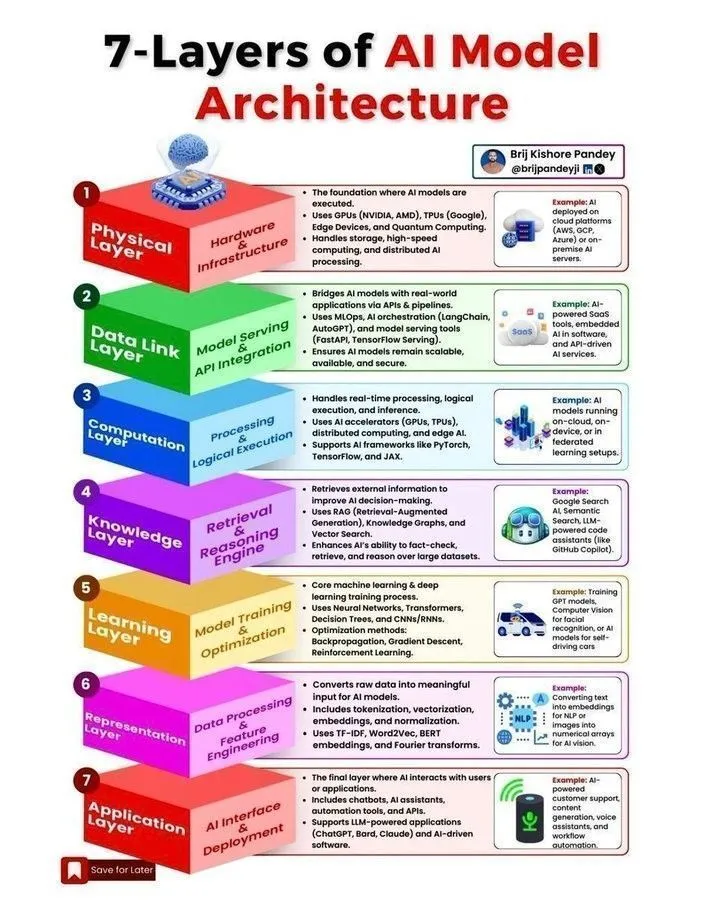

KI-Modellarchitektur und Agent-Entwicklungs-Roadmap : In sozialen Medien wurden mehrere Ressourcen zu KI-Modellarchitekturen, Agent-Entwicklungs-Roadmaps, dem Machine Learning-Lebenszyklus sowie den Unterschieden zwischen KI, generativer KI und Machine Learning geteilt. Diese Inhalte sollen Entwicklern und Forschern helfen, die Kernkonzepte von KI-Systemen zu verstehen, die entscheidenden Schritte zum Aufbau skalierbarer KI-Agenten zu meistern und die für den KI-Bereich im Jahr 2025 erforderlichen Schlüsselkompetenzen zu erwerben. (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Stanford CME295 Kurs: Transformer und Large Model Engineering Practice : Die Stanford University hat die CME295-Kursreihe veröffentlicht, die sich auf die Transformer-Architektur und praktische Ingenieurkenntnisse für Large Language Models (LLM) konzentriert. Dieser Kurs verzichtet auf komplexe mathematische Konzepte und betont die praktische Anwendung, wodurch er eine wertvolle Lernressource für Ingenieure darstellt, die ein tiefes Verständnis der Entwicklung und Bereitstellung großer Modelle erlangen möchten. Gleichzeitig wird der CS224N-Kurs als beste Wahl für den Einstieg in NLP empfohlen. (Quelle: karminski3, QuixiAI, stanfordnlp)

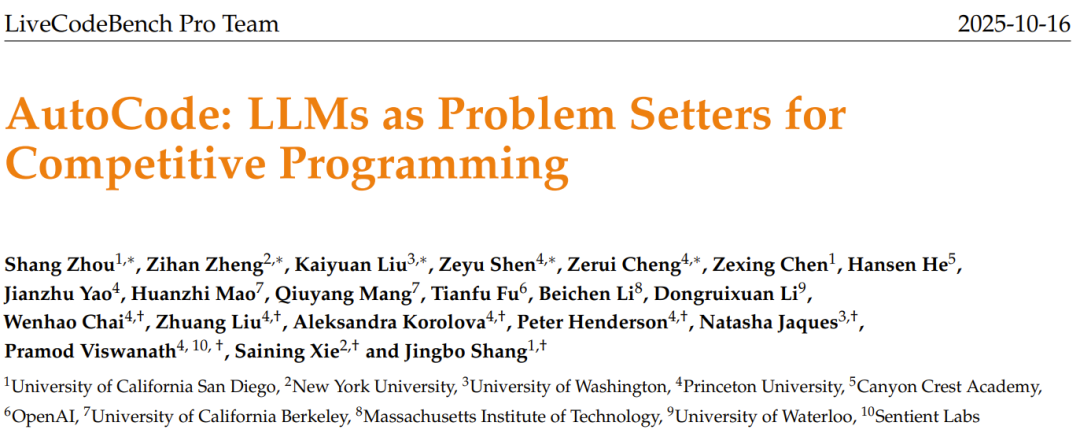

KI-Aufgabengenerator AutoCode: LLM generiert originelle Programmierwettbewerbsaufgaben : Das LiveCodeBench Pro-Team hat das AutoCode-Framework vorgestellt, das LLM in einem geschlossenen, multimodalen System zur automatischen Erstellung und Bewertung von Programmierwettbewerbsaufgaben nutzt. Das Framework erreicht durch einen erweiterten Validator-Generator-Checker-Mechanismus eine hohe Zuverlässigkeit bei der Generierung von Testfällen und kann LLM dazu inspirieren, basierend auf “Startproblemen” hochwertige, originelle neue Probleme zu generieren. Dies soll den Weg für strengere Benchmarks für Programmierwettbewerbe und die Selbstverbesserung von Modellen ebnen. (Quelle: 36氪)

KAIST entwickelt KI-Halbleitergehirn: Kombiniert Transformer- und Mamba-Effizienz : Das Korea Advanced Institute of Science and Technology (KAIST) hat ein neuartiges KI-Halbleitergehirn entwickelt, das erfolgreich die Intelligenz der Transformer-Architektur mit der Effizienz der Mamba-Architektur verbindet. Diese bahnbrechende Forschung zielt darauf ab, den Kompromiss zwischen Leistung und Energieverbrauch bei bestehenden KI-Modellen zu lösen und eine neue Richtung für das Design zukünftiger effizienter, stromsparender KI-Hardware zu weisen, was die Entwicklung von Edge-KI- und Embedded-KI-Systemen beschleunigen soll. (Quelle: Reddit r/deeplearning)

Mehrstufige NER-Pipeline: Fuzzy Matching und LLM-Maskierung zur Analyse von Reddit-Kommentaren : Eine Studie schlägt eine mehrstufige Named Entity Recognition (NER)-Pipeline vor, die Hochgeschwindigkeits-Fuzzy-Matching und LLM-Maskierungstechniken kombiniert, um Entitäten und Stimmungen aus Reddit-Kommentaren zu extrahieren. Diese Methode identifiziert zunächst bekannte Entitäten durch Fuzzy-Suche, verarbeitet dann den maskierten Text mit LLM, um neue Entitäten zu finden, und führt schließlich eine Stimmungsanalyse und Zusammenfassung durch. Dieser hybride Ansatz erreicht ein Gleichgewicht zwischen Geschwindigkeit und Entdeckungsfähigkeit bei der Verarbeitung großer, verrauschter domänenspezifischer Texte. (Quelle: Reddit r/MachineLearning)

Erfahrungen bei der Bereitstellung von ML-gesteuerten Handelssystemen: Lösung von “Look-Ahead Bias” und “State Drift” in Echtzeitumgebungen : Ein Entwickler teilt seine Erfahrungen bei der Bereitstellung von ML-gesteuerten Handelssystemen und betont die entscheidende Bedeutung der Lösung von “Look-Ahead Bias” und “State Drift” in Echtzeitumgebungen. Durch eine strikte zeilenweise Modellverarbeitung und “Golden Master”-Skripte wird eine deterministische Konsistenz zwischen historischen Tests und dem Echtzeitbetrieb gewährleistet. Das System enthält auch einen Validator, der die Konsistenz von Echtzeitprognosen mit Validator-Prognosen anhand eines Pearson-Korrelationskoeffizienten von 1,0 misst, um die Zuverlässigkeit des Modells sicherzustellen. (Quelle: Reddit r/MachineLearning)

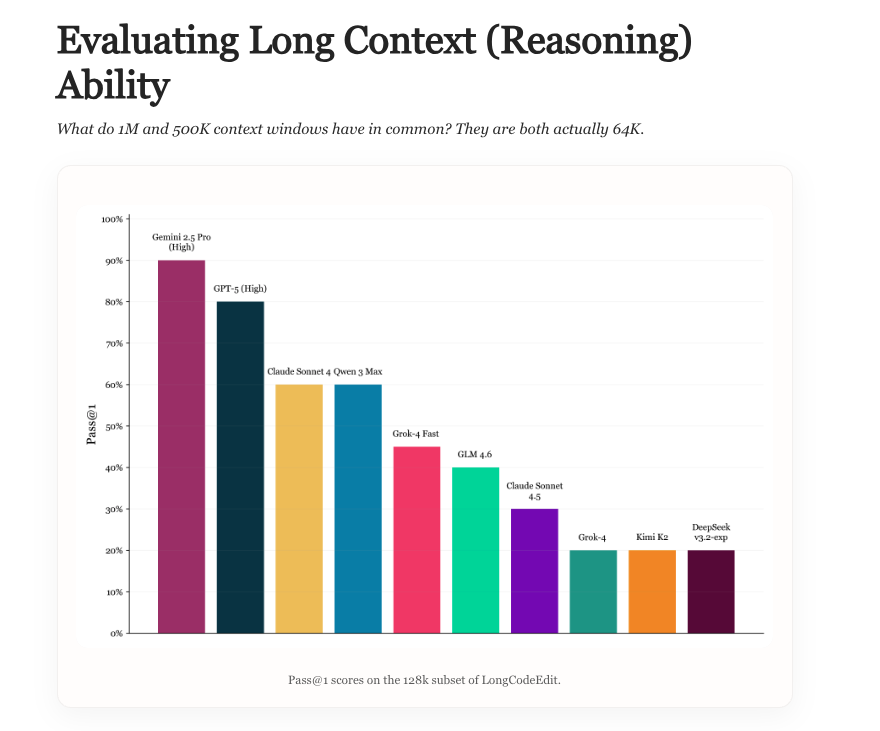

Long Context Evaluation: Neuer Benchmark für LLM-Langkontext-Fähigkeiten : Eine neue Studie untersucht den aktuellen Stand der LLM-Langkontext-Bewertung, analysiert die Vor- und Nachteile bestehender Benchmarks und führt einen neuen Benchmark namens LongCodeEdit ein. Ziel der Studie ist es, die Mängel bestehender Bewertungsmethoden bei der Messung der Fähigkeit von LLM zur Verarbeitung langer Texte und komplexer Codebearbeitungsaufgaben zu beheben und neue Tools und Erkenntnisse für eine genauere Bewertung der Modellleistung in Langkontext-Szenarien bereitzustellen. (Quelle: nrehiew_, teortaxesTex)

Manifold Optimization: Geometrie-bewusste Optimierung für das Training neuronaler Netze : Manifold Optimization verleiht dem Training neuronaler Netze geometrische Wahrnehmungsfähigkeiten. Neue Forschung erweitert diese Idee auf modulare Mannigfaltigkeiten, um Optimierer zu entwerfen, die Schichtinteraktionen verstehen. Durch die Kombination von Vorwärtsfunktionen, Mannigfaltigkeitsbeschränkungen und Normen beschreibt dieses Framework, wie Schichtgeometrie und Optimierungsregeln kombiniert werden, um eine geometrie-bewusste Optimierung auf einer tieferen Ebene zu erreichen und so die Trainingseffizienz und -wirkung neuronaler Netze zu verbessern. (Quelle: TheTuringPost, TheTuringPost)

Kolmogorov-Komplexität in der KI-Forschung: Das Potenzial der KI zur Vereinfachung von Forschungsergebnissen : Die Diskussion weist darauf hin, dass der Kern “Essenz” neuer Forschung und Blog-Inhalte in Code, Artefakte und mathematische Abstraktionen komprimiert werden kann. Zukünftige KI-Systeme könnten komplexe Forschung in einfache Artefakte “übersetzen”, indem sie Kernunterschiede extrahieren und Schlüsselergebnisse reproduzieren, wodurch die Kosten für das Verständnis neuer Forschung erheblich gesenkt werden. Dies würde es Forschern erleichtern, mit der riesigen Menge an ArXiv-Papieren Schritt zu halten und Forschungsergebnisse schnell zu verarbeiten und anzuwenden. (Quelle: jxmnop, aaron_defazio)

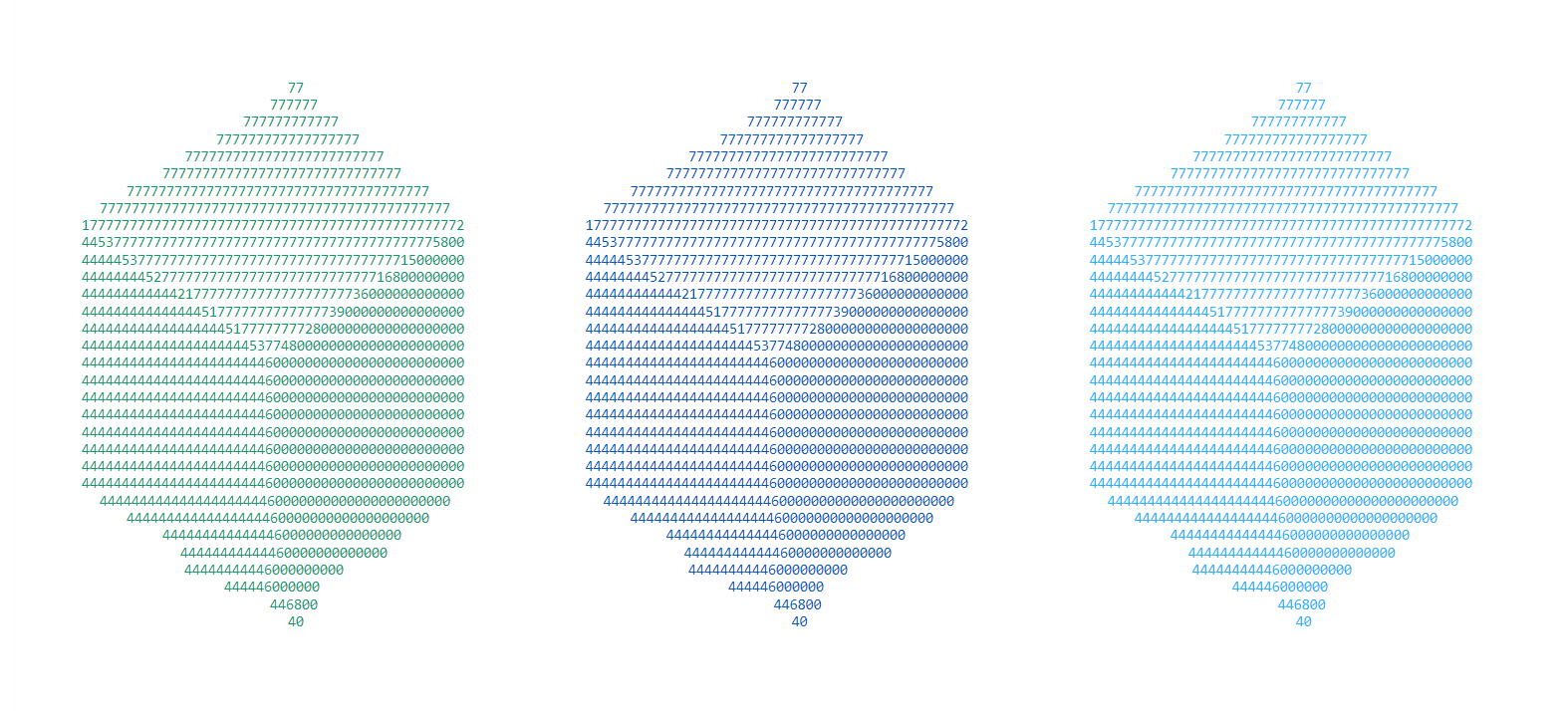

LSTM-Vater streitet über Ursprünge des Residual Learning: Hochreiters Beitrag von 1991 : Jürgen Schmidhuber, der Vater von LSTM, meldet sich erneut zu Wort und weist darauf hin, dass die Kernidee des Residual Learning bereits 1991 von seinem Studenten Sepp Hochreiter vorgeschlagen wurde, um das Problem des verschwindenden Gradienten in RNNs zu lösen. Hochreiter führte in seiner Doktorarbeit rekursive Residual-Verbindungen mit festen Gewichten von 1,0 ein, was als Grundlage für die Residual-Idee in späteren Deep Learning-Architekturen wie LSTM, Highway-Netzwerken und ResNet gilt. Schmidhuber betont die Bedeutung früher Beiträge für die Entwicklung des Deep Learning. (Quelle: 量子位)

💼 Business

Zhiweituo Pharma erhält Millionen in Seed-Finanzierung: KI-gestützte Entwicklung oraler niedermolekularer Medikamente : Beijing Zhiweituo Pharmaceutical Technology Co., Ltd. hat eine Seed-Finanzierungsrunde in Höhe von mehreren zehn Millionen Yuan abgeschlossen, angeführt von Newry Capital und mit Beteiligung von Qingtang Investment. Die Mittel werden für die präklinische Forschung und Entwicklung der Kernpipeline sowie den Aufbau einer KI-interaktiven Moleküldesignplattform verwendet. Das Unternehmen konzentriert sich auf den KI-Pharmabereich und nutzt seine selbst entwickelte EnCore-Plattform, um die Entdeckung von Leitverbindungen und die Moleküloptimierung zu beschleunigen. Es konzentriert sich auf orale niedermolekulare Medikamente für Autoimmunerkrankungen und hofft, “schwer zu behandelnde” Targets zu überwinden. (Quelle: 36氪)

Damu Technology schließt A+-Finanzierungsrunde von fast 100 Millionen ab: “Compute-Electricity Synergy”-Technologie löst das Problem des hohen Energieverbrauchs in intelligenten Rechenzentren : Damu Technology hat eine A+-Finanzierungsrunde von fast 100 Millionen Yuan abgeschlossen, angeführt von Puan Capital, einer Tochtergesellschaft von CATL. Diese Finanzierung wird für die Forschung und Entwicklung sowie die Förderung von Energie-Large-Modellen, Compute-Electricity Synergy-Plattformen und Agenten-Kerntechnologien verwendet. Ziel ist es, das Problem des hohen Energieverbrauchs in intelligenten Rechenzentren durch “Compute-Electricity Synergy” zu lösen und den Aufbau neuer Stromversorgungssysteme zu unterstützen. Damu Technology arbeitet mit führenden Unternehmen wie SenseTime und Cambricon zusammen und bietet Energielösungen für energieintensive Recheninfrastrukturen, basierend auf seinem vollständig selbst entwickelten Energie-Large-Modell. (Quelle: 36氪)

JD, Tmall, Douyin “KI” auf Double 11: Technologie fördert Wachstum im E-Commerce-Großhandel : Das diesjährige Double 11 wurde zum Übungsfeld für KI im E-Commerce, wobei führende Plattformen wie JD, Tmall und Douyin umfassend auf KI-Technologie setzten. KI wird zur Optimierung des Kundenerlebnisses, zur Stärkung von Händlern, zur Logistik, zur Inhaltsverteilung und zur Kaufentscheidung über die gesamte Wertschöpfungskette eingesetzt. Zum Beispiel hat JD “Photo Shopping” (拍照购) aktualisiert, Douyin Doubao wurde in den Marktplatz integriert, und Worthbuy Technology ermöglicht KI-Dialoge zur Preisvergleich. KI wird zum neuen Motor für das E-Commerce-Wachstum, der durch extreme Effizienz und Kostenkontrolle die Wettbewerbslandschaft der Branche neu gestaltet und den E-Commerce vom “Regal-/Inhalts-E-Commerce” zur “intelligenten E-Commerce”-Phase vorantreibt. (Quelle: 36氪, 36氪)

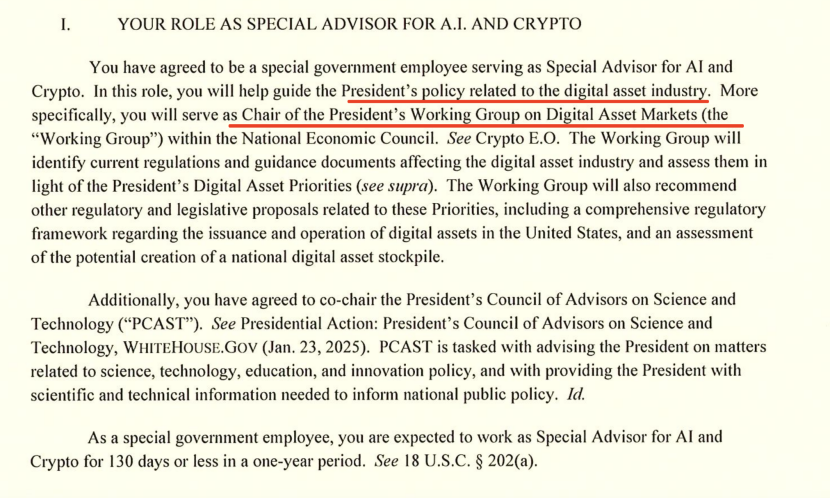

Weißes Haus KI-Chef über den US-China-KI-Wettbewerb: Chip-Exporte und Ökosystem-Dominanz : David Sacks, der “Zar” für KI und Crypto im Weißen Haus, erläuterte in einem Interview die Strategie der USA im US-China-KI-Wettbewerb und betonte die Bedeutung von Innovation, Infrastruktur und Exporten. Er wies darauf hin, dass die US-Politik für Chip-Exporte nach China “nuanciert” sein müsse, um die fortschrittlichsten Chips zu beschränken, aber eine vollständige Entziehung zu vermeiden, die zu einem Monopol von Huawei auf dem heimischen Markt führen könnte. Sacks betonte, dass die USA ein riesiges KI-Ökosystem aufbauen und zum bevorzugten Technologiepartner weltweit werden sollten, anstatt die Wettbewerbsfähigkeit durch bürokratische Kontrolle zu ersticken. (Quelle: 36氪)

🌟 Community

OpenAI-Kommerzialisierungsstreit: Vom Non-Profit zum Profitstreben, Sam Altmans Ruf leidet : OpenAI CEO Sam Altman hat wegen der Freigabe von erotischen Inhalten für ChatGPT, der Leistung des GPT-5-Modells und der aggressiven Infrastrukturerweiterungsstrategie weitreichende Kontroversen ausgelöst. Die Community hinterfragt seinen Wandel vom Non-Profit-Ursprung zum kommerziellen Profitstreben und äußert Bedenken hinsichtlich der Entwicklungsrichtung der KI-Technologie, der Investitionsblase und der ethischen Behandlung von Mitarbeitern. Altmans Reaktion konnte die öffentliche Meinung nicht vollständig beruhigen, was die Spannung zwischen der Expansion des KI-Imperiums und der sozialen Verantwortung verdeutlicht. (Quelle: 36氪, janusch_patas, Reddit r/ArtificialInteligence)

Vergiftung großer Modelle: Datenvergiftung, Adversarial Samples und KI-Sicherheitsherausforderungen : Große Modelle sind Bedrohungen wie Datenvergiftung, Backdoor-Angriffen und Adversarial Samples ausgesetzt, die zu abnormalen oder schädlichen Modellausgaben führen und sogar für kommerzielle Werbung (GEO), technische Prahlerei oder Cyberkriminalität genutzt werden können. Studien zeigen, dass eine geringe Menge bösartiger Daten das Modell erheblich beeinflussen kann. Dies löst Bedenken hinsichtlich KI-Halluzinationen, Manipulation von Benutzerentscheidungen und Risiken für die öffentliche Sicherheit aus und unterstreicht die Bedeutung des Aufbaus eines Modell-Immunsystems, der Stärkung der Datenprüfung und kontinuierlicher Verteidigungsmechanismen. (Quelle: 36氪)

Die Notlage der KI-Datenannotatoren: Master-/Doktoranden leisten gering bezahlte, repetitive Arbeit : Mit der Entwicklung großer KI-Modelle steigen die Bildungsanforderungen für Datenannotationsarbeiten (sogar Master- und Doktortitel sind erforderlich), aber die Gehälter liegen weit unter denen von KI-Ingenieuren. Diese “KI-Lehrer” bewerten KI-generierte Inhalte, führen ethische Überprüfungen durch und fungieren als Fachwissens-Coaches, erhalten aber niedrige Stundenlöhne und haben unsichere Arbeitsverhältnisse, da sie nach Projektende arbeitslos sind. Dieses “Cyber-Fließband”-Modell der mehrstufigen Untervergabe und Ausbeutung wirft tiefgreifende Fragen zur Arbeitsmoral und Fairness in der KI-Industrie auf. (Quelle: 36氪)

Der Einfluss von KI auf Kreativität und menschlichen Wert: Ende oder Veredelung? : Die Community diskutiert den Einfluss von KI auf die menschliche Kreativität und ist der Meinung, dass KI die Kreativität nicht getötet, sondern die relative Mittelmäßigkeit der menschlichen Kreativität offenbart hat. KI ist gut im Musterumbau und in der Generierung, aber echte Originalität, Widersprüchlichkeit und Unvorhersehbarkeit bleiben einzigartige menschliche Stärken. Das Aufkommen neuer Werkzeuge eliminiert immer den Mittelbereich und zwingt den Menschen, in Inhalt und Kreativität nach höheren Durchbrüchen zu suchen, wodurch echte Kreativität noch wertvoller wird. (Quelle: Reddit r/artificial)

KI-induzierte Existenzangst und Bewältigungsstrategien: Realistische Probleme und übermäßige Sorgen : Angesichts der potenziellen existenziellen Bedrohungen durch KI diskutiert die Community, wie mit der daraus resultierenden “existentiellen Angst” umgegangen werden kann. Einige Meinungen besagen, dass diese Angst aus übermäßigen Zukunftsvorstellungen resultieren könnte und raten dazu, sich auf die Realität zu besinnen und sich auf das gegenwärtige Leben zu konzentrieren. Gleichzeitig wird darauf hingewiesen, dass KI-bezogene wirtschaftliche Auswirkungen und Beschäftigungsprobleme dringendere reale Bedrohungen darstellen, und betont, dass KI-Sicherheit und sozioökonomische Auswirkungen gleichermaßen berücksichtigt werden sollten. (Quelle: Reddit r/ArtificialInteligence)

Karpathys Ansichten lösen hitzige Debatten aus: AGI “Zehn-Jahres-These”, Agent “Geister-These” und KI-Entwicklungspfad : Andrej Karpathys Ansichten über die “Zehn-Jahres-These” für AGI und die Behauptung, dass bestehende KI-Agenten “Geister” seien, haben in der Community eine breite Diskussion ausgelöst. Er betont, dass KI Beständigkeit, Gedächtnis und Kontinuität benötigt, um ein echter Agent zu werden, und schlägt vor, dass das KI-Training von “Datenfüttern” auf “Zielelehren” umgestellt werden sollte. Diese Ansichten werden als nüchterne Reflexion über den aktuellen KI-Hype betrachtet und regen dazu an, den langfristigen Entwicklungspfad und die Bewertungsstandards der KI neu zu überdenken. (Quelle: TheTuringPost, TheTuringPost, NandoDF, random_walker, lateinteraction, stanfordnlp)

ChatGPT-Marktanteil sinkt weiter: Perplexity, Gemini, DeepSeek und andere Wettbewerber steigen auf : Similarweb-Daten zeigen, dass der Marktanteil von ChatGPT kontinuierlich sinkt, von 87,1 % vor einem Jahr auf 74,1 %. Gleichzeitig steigt der Marktanteil von Wettbewerbern wie Gemini, Perplexity, DeepSeek, Grok und Claude stetig. Dieser Trend deutet auf einen zunehmend intensiven Wettbewerb auf dem KI-Assistentenmarkt hin, wobei die Benutzerwahl vielfältiger wird und die Dominanz von ChatGPT herausgefordert wird. (Quelle: ClementDelangue, brickroad7)

GPT-5 Mathematik-Fauxpas: OpenAI-Übermarketing und Skepsis der Kollegen : OpenAI-Forscher prahlten öffentlich damit, dass GPT-5 mehrere Erdos-Mathematikprobleme gelöst habe, doch später stellte sich heraus, dass die Lösungen lediglich durch Online-Recherche gefunden und nicht eigenständig geknackt wurden. Dieser Vorfall löste öffentlichen Spott von Branchengrößen wie DeepMind CEO Hassabis und Metas LeCun aus, die das übertriebene Marketing von OpenAI in Frage stellten. Dies verdeutlicht das Problem der Genauigkeit bei der Bewerbung von KI-Fähigkeiten und die Wettbewerbssituation unter den Kollegen. (Quelle: 量子位)

Die versteckten Umweltkosten der KI: Energieverbrauch und Wasserbedarf : Historische Studien zeigen, dass Kommunikationssysteme, vom Telegraphen bis zur KI, stets mit versteckten Umweltkosten verbunden waren. KI und moderne Kommunikationssysteme sind auf große Rechenzentren angewiesen, was zu einem sprunghaften Anstieg des Energieverbrauchs und des Wasserbedarfs führt. Es wird erwartet, dass der Wasserverbrauch der KI bis 2027 dem gesamten Jahreswasserverbrauch Dänemarks entsprechen wird. Dies unterstreicht die Umweltkosten hinter der schnellen Entwicklung der KI-Technologie und fordert die Regierungen auf, die Regulierung zu verstärken, die Offenlegung von Umweltauswirkungen zu erzwingen und Projekte mit geringen Auswirkungen zu unterstützen. (Quelle: aihub.org)

Die “Invasion” der KI in den menschlichen Geist: Gehirn-Computer-Schnittstellen und die ethischen Grenzen von “Mensch 3.0” : Die Community diskutierte intensiv über Gehirn-Computer-Schnittstellen (BCI) und die potenziellen Auswirkungen von KI auf den menschlichen Geist, wobei das Konzept des “Menschen 3.0” aufkam. Wenn externe Rechenleistung in den “inneren Kreis” menschlicher Entscheidungen eindringt und so schnell ist, dass das Gehirn die Signalquelle nicht mehr unterscheiden kann, entstehen ethische Probleme bezüglich der Grenzen des “Selbst”, der Werturteile und der langfristigen Gesundheit. Der Artikel betont, dass vor der Verbreitung der Technologie eine Zero-Trust-Architektur, Hardware-Isolation und Zugriffsverwaltung etabliert werden müssen, um die Verpachtung von Entscheidungsbefugnissen und die Verschärfung der Ungleichheit auf Speziesebene zu vermeiden. (Quelle: dotey)

💡 Sonstiges

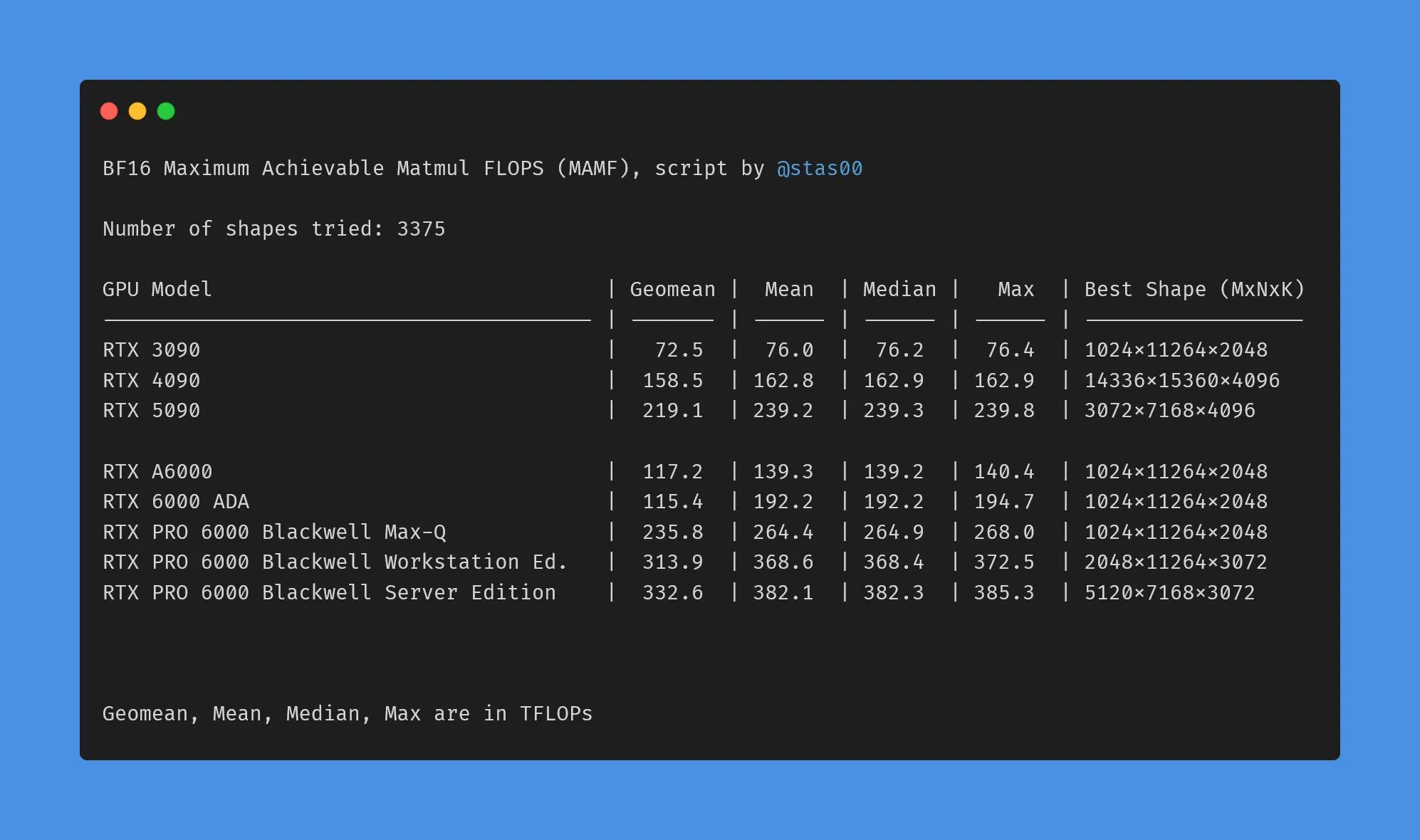

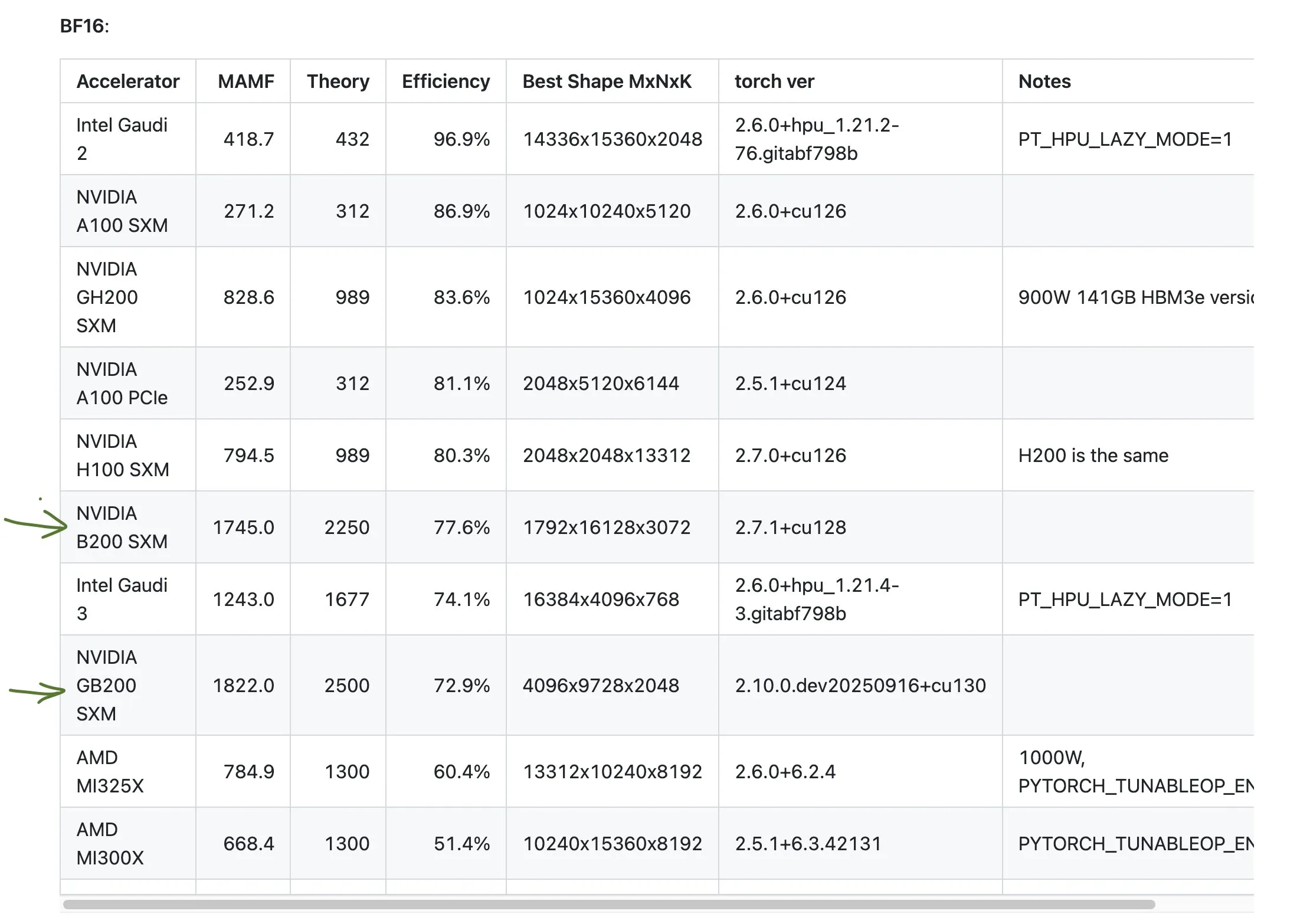

NVIDIA Consumer- vs. Professional-GPU-Leistungsdatenunterschiede : Die Community diskutierte die Unterschiede zwischen den beworbenen TFLOPs und der tatsächlichen Leistung von NVIDIAs Consumer- und Professional-GPUs. Die Daten zeigen, dass Consumer-Grafikkarten (wie 3090, 4090, 5090) eine tatsächliche Leistung aufweisen, die leicht über oder nahe den angegebenen TFLOPs liegt, während die tatsächliche Leistung von Professional-Workstation-Grafikkarten (wie A6000, 6000 ADA) weit unter den angegebenen Werten liegt. Trotzdem bieten Professional-Karten Vorteile bei Stromverbrauch, Größe und Energieeffizienz, aber Benutzer sollten auf die Diskrepanz zwischen Marketingdaten und tatsächlicher Leistung achten. (Quelle: TheZachMueller)

Diskussion über die schlechte Leistung von AMD GPUs : Die Community diskutierte die Leistung von AMD GPUs in bestimmten Benchmarks und wies darauf hin, dass ihre Effizienz möglicherweise nur die Hälfte der erwarteten Leistung beträgt. Dies löste Bedenken hinsichtlich der Wettbewerbsfähigkeit von AMD im Bereich der KI-Berechnung aus, insbesondere im Vergleich zu Hochleistungsprodukten wie NVIDIAs GB200. Benutzer sollten bei der Planung von KI-Rechenressourcen die tatsächliche Leistung und Effizienz verschiedener GPU-Hersteller sorgfältig bewerten. (Quelle: jeremyphoward)

GIGABYTE AI TOP ATOM: Desktop-Leistung von Grace Blackwell GB10 : Gigabyte hat den AI TOP ATOM vorgestellt, der die Leistung von NVIDIAs Grace Blackwell GB10 in Desktop-Workstations bringt. Dieses Produkt soll einzelnen Benutzern und kleinen Teams leistungsstarke KI-Rechenfähigkeiten bieten, damit sie hochleistungsfähiges Modelltraining und Inferenz lokal durchführen können, die Abhängigkeit von Cloud-Ressourcen verringern und die Entwicklung und Bereitstellung von KI-Anwendungen beschleunigen. (Quelle: Reddit r/LocalLLaMA)