Schlüsselwörter:DeepSomatic, PaddleOCR-VL, Blackwell-Chip, RTFM, LLM-Hirnfäulnis-Hypothese, KI-Agent, Multimodale KI, Google DeepSomatic Krebsforschung, Baidu PaddleOCR-VL Dokumentenanalyse, NVIDIA Blackwell-Chip-Herstellung, Fei-Fei Li RTFM Weltmodell, LLM-Datenqualität beeinflusst logisches Denken

Gerne, hier ist die deutsche Übersetzung der AI-Nachrichten, unter Beibehaltung der technischen Begriffe und des Formats:

🔥 Fokus

Google DeepSomatic-Modell beschleunigt Krebsforschung : Google Research veröffentlicht das DeepSomatic Machine-Learning-Modell, das in Zusammenarbeit mit UCSC Genomics und Children’s Mercy komplexe Genmutationen in Krebszellen präzise identifizieren kann. Dies steigert die Effizienz der Krebsforschung erheblich und stellt einen entscheidenden Schritt für präzisere Therapien dar. Das Modell ist eines der Ergebnisse aus zehn Jahren Entwicklung von Googles Genomik-AI und zeigt den weitreichenden Einfluss von AI im medizinischen Bereich. (Quelle: Google Research, Reddit r/artificial)

Baidu PaddleOCR-VL dominiert den OCR-Bereich mit SOTA-Ergebnissen : Baidu hat das leichte multimodale Dokumentenanalysemodell PaddleOCR-VL mit nur 0,9 Milliarden Parametern veröffentlicht, das auf der OmniDocBench V1.5-Rangliste mit 92,6 Punkten weltweit den ersten Platz belegt und in den vier Kernkompetenzen Texterkennung, Formelerkennung, Tabellenverständnis und Lesereihenfolge umfassend neue SOTA-Werte erzielt hat. Das Modell nutzt eine innovative zweistufige Architektur, um komplexe Dokumentstrukturen, Handschriften und mehrsprachige Inhalte präzise zu verstehen, und bietet eine schnelle Inferenzgeschwindigkeit. Dies beweist das Potenzial kleiner Modelle, in spezifischen Aufgaben große Universalmodelle zu übertreffen. (Quelle: 量子位)

NVIDIA und TSMC kooperieren, erster in den USA gefertigter Blackwell-Chip-Wafer vorgestellt : NVIDIA und TSMC haben in der US-Fabrik in Arizona erstmals den ersten in den USA hergestellten Blackwell-Chip-Wafer präsentiert. Dieses Meilensteinereignis markiert einen entscheidenden Schritt in der Verlagerung der AI-Chip-Produktion in die USA, mit dem Ziel, die Führungsposition der USA im AI-Bereich zu stärken und die Grundlage für die Produktion der Blackwell-Architektur und ihrer Nachfolger (wie Blackwell Ultra und Rubin) zu legen, um den zukünftigen Anforderungen an das Training und die Inferenz großer Modelle gerecht zu werden. (Quelle: nvidia, 36氪)

Fei-Fei Lis Team veröffentlicht Echtzeit-generatives Weltmodell RTFM : Das World Labs-Team von AI-Pionierin Fei-Fei Li hat das neue Echtzeit-generative Weltmodell RTFM (Real-Time Frame Model) veröffentlicht. Das Modell kann auf einer einzelnen H100 GPU ausgeführt werden und zeichnet sich durch Effizienz, Skalierbarkeit und Persistenz aus. Es kann kontinuierlich laufen und 3D-Konsistenz bewahren, was einen wichtigen Durchbruch bei Echtzeit-, persistenten 3D-Weltmodellen darstellt. Dies könnte die Anwendungen von AI im Bereich des Verständnisses und der Interaktion in komplexen Umgebungen vorantreiben. (Quelle: 9点1氪)

🎯 Trends

„LLM Brain Rot Hypothesis“ enthüllt Einfluss der Datenqualität auf die Modellkognition : Eine aktuelle Studie stellt die „LLM Brain Rot Hypothesis“ auf, die besagt, dass der kontinuierliche Kontakt von LLMs mit minderwertigen Webtexten zu einem Rückgang der kognitiven Fähigkeiten führt, was sich auf Inferenz, langes Kontextverständnis und Sicherheit auswirkt und möglicherweise „dunkle Persönlichkeitsmerkmale“ verstärkt. Die Studie identifiziert „Gedankensprünge“ als primäres Fehlermuster und dass der Schaden schwer vollständig rückgängig zu machen ist. Dies unterstreicht die Bedeutung der Datenkuratierung als wichtiges Sicherheitsproblem beim Training. (Quelle: omarsar0, HuggingFace Daily Papers)

AI-Hardwareleistung und LLM-Optimierungstechniken erzielen signifikante Fortschritte : Die NVIDIA Blackwell RTX Pro 6000 zeigt im vLLM-Benchmark eine herausragende Inferenzleistung für 120B-Modelle. llama.cpp hat die Verarbeitungsgeschwindigkeit des GLM 4.6 IQ4_XS-Modells durch RPC-Optimierung um das Vierfache erhöht. Cerebras hat die REAP-Technologie zur effizienten Komprimierung von MoE-Modellen veröffentlicht. Die SuperOffload-Technologie steigert den LLM-Trainingsdurchsatz um das Vierfache, und Elastic-Cache beschleunigt die Dekodierung von Diffusions-LLMs um das 45-fache. Darüber hinaus zeigen der Schedulefree AdamW-Optimierer, neue Modelle und verteierte Bewertungsfunktionen der mlx-lm-Bibliothek sowie das Potenzial von SSMs bei der Generalisierung langer Kontexte vielfältige Wege zur Steigerung der AI-Effizienz auf. (Quelle: Teknium1, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, dl_weekly, omarsar0, aaron_defazio, awnihannun, gallabytes)

Robotik setzt Innovationen fort und strebt intelligentere Wahrnehmung und Bedienung an : Die Robotik entwickelt sich hin zum „Verstehen statt nur Gehorchen“ menschlicher Absichten. Es entstehen mechanische Meißel, die Kunst schaffen können, humanoide Roboter, die chinesische Kalligrafie demonstrieren, intelligente Schwarmroboter, kugelförmige Polizeiroboter und dreibeinige Roboter. Die Shanghai Jiao Tong Universität hat das U-Arm-Projekt als Open Source veröffentlicht, das für nur 400 Yuan eine universelle Fernsteuerung für 95 % der gängigen Roboterarme ermöglicht. Industrieroboter verbessern ihr Verständnis und ihre Manipulationsfähigkeiten in der realen Welt durch intelligente visuelle Objektplattformen. Der humanoide Roboterarm MIT ORCA v1 demonstriert ebenfalls sein ausgeklügeltes Design. (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, teortaxesTex, janusch_patas, 量子位)

AI erzielt Durchbrüche in der wissenschaftlichen Forschung und Inhaltserstellung : DeepMind arbeitet mit Commonwealth Fusion Systems zusammen, um den TORAX AI-Simulator zur Plasmakontrolle zu nutzen und den kommerziellen Kernfusionsprozess zu beschleunigen. SR-Scientist verwandelt LLMs in autonome „AI-Wissenschaftler“, die durch werkzeuggesteuerte Datenanalyse und Gleichungstests die Fähigkeit zur Gleichungsfindung verbessern. Suno V5 bringt die AI-Musikproduktion an einen Wendepunkt. LongCat-Audio-Codec optimiert Sprach-LLMs. RunwayML APPS ermöglicht Zeitreise-Videobearbeitung, und Simulon kann realistische VFX-Beleuchtung generieren. (Quelle: ClementDelangue, Reddit r/artificial, TheTuringPost, op7418, huggingface, c_valenzuelab, timsoret)

Neue Paradigmen für LLM-Inferenz: Inferenz-Generalisierung ohne RL/Training : Jüngste Forschungsergebnisse zeigen, dass grundlegende Sprachmodelle durch verbesserte Sampling-Strategien zur Testzeit ohne Reinforcement Learning, Training oder Validatoren eine mit GRPO vergleichbare oder sogar bessere Inferenzleistung in einer einzigen Inferenz erreichen können, während gleichzeitig der Verlust an generativer Vielfalt vermieden wird. Darüber hinaus erweitert das Recursive Language Models (RLM)-Framework die Kontextverarbeitungskapazität auf über 10 Millionen Tokens, indem es LLMs ermöglicht, sich selbst rekursiv aufzurufen, um extrem lange Kontexte zu verarbeiten, ohne die Leistung zu beeinträchtigen, und verbessert die Genauigkeit von GPT-5-mini-Variantenmodellen. (Quelle: dearmadisonblue, dilipkay, karminski3)

AI Agent Kontextmanagement und Effizienzsteigerung : Die Context-Folding-Technologie verleiht Agenten die Fähigkeit, Kontexte aktiv zu verwalten. Durch Verzweigung und Komprimierung von Kontexten übertrifft sie ReAct bei Such- und SWE-Aufgaben und reduziert den Kontextverbrauch um das Zehnfache. Dieser Fortschritt löst den Effizienzengpass von LLMs bei der Verarbeitung langer Kontexte. (Quelle: ethanCaballero)

Google Gemini API und Maps-Integration, Microsoft Windows 11 tiefgreifend mit AI integriert : Google hat bekannt gegeben, dass die Gemini API jetzt in Google Maps integriert ist. Entwickler können die Inferenzfähigkeiten des Gemini-Modells in Kombination mit realen Daten von Google Maps nutzen, um neuartige geospatiale AI-Anwendungen zu entwickeln. Microsoft positioniert Windows 11 als AI-First-Gerät und integriert den sprachgesteuerten Copilot tiefgreifend. Ziel ist es, Aufgaben ohne Maus und Tastatur zu verwalten und so die Benutzererfahrung zu verbessern. (Quelle: osanseviero, Reddit r/artificial, 9点1氪)

Aktive Entwicklung multimodaler AI-Modelle und der Open-Source-Community : HuggingFace meldet eine Million neue Open-Source-AI-Repositories innerhalb von 90 Tagen, und NVIDIA ist der größte Beitragsleistende zu Open-Source-AI-Modellen geworden. Chinesische Labore wie Alibaba Qwen und DeepSeek gewinnen schnell an Bedeutung. LongCat-Audio-Codec wurde als Open-Source-Lösung zur Audio-Kodierungsoptimierung für Sprach-LLMs veröffentlicht. Der HoneyBee-Datensatz verbessert das visuelle Sprachverständnis, und MIT-IBM-Forscher haben die Genauigkeit von visuellen Sprachmodellen für die personalisierte Objekterkennung um 12-21 % verbessert. (Quelle: huggingface, huggingface, Teknium1, Reddit r/artificial)

AI-Branchenanwendungen vertiefen sich: Medizin, Cybersicherheit, Vertragsprüfung und Finanzen : AI-Anwendungen vertiefen sich in verschiedenen Branchen. AI-gesteuerte Stethoskop-Systeme können gesunde Herzgeräusche mit über 95 % Genauigkeit klassifizieren und Krankheiten frühzeitig erkennen. Microsoft hat eine Open-Source-Benchmark-Suite veröffentlicht, um die Fähigkeiten von AI Agenten bei der Zielzerlegung, Werkzeugnutzung und Evidenzsynthese in Cybersicherheitsaufgaben zu bewerten. Es wird erwartet, dass große Organisationen innerhalb der nächsten fünf Jahre die AI-gestützte Vertragsprüfung flächendeckend einführen werden. AI spielt auch eine Schlüsselrolle im Umsatzwachstumsmanagement im Finanzsektor. (Quelle: Reddit r/artificial, Ronald_vanLoon, scottastevenson, Ronald_vanLoon)

AI Agent definiert Beobachtbarkeit und Unternehmensanwendungen neu : Agentic AI beschleunigt nicht nur die Ereignisreaktion, sondern verbessert auch die Erkennung, Überwachung und Behebung während des gesamten Beobachtbarkeitslebenszyklus, wodurch die traditionelle Fehlerbehebung in eine Lebenszyklustransformation umgewandelt wird. Die Kombination von Cisco und Splunk bietet End-to-End-Sichtbarkeit und treibt die digitale Transformation voran. Die schnelle Akzeptanz von AI Agenten in Unternehmen übertrifft die Erwartungen, und sie werden zu einer Infrastruktur zur Koordination von Aufgaben, zur Bereitstellung personalisierter Erlebnisse und zur Bewältigung komplexer Probleme. (Quelle: Ronald_vanLoon, Ronald_vanLoon)

🧰 Tools

Claude Code-Updates verbessern das Entwicklererlebnis : Claude Code führt das Haiku 4.5-Modell, Explore Sub-Agenten und interaktive Q&A-Funktionen ein, um die Effizienz der Code-Erkundung und des Debuggings zu verbessern. Benutzer können jetzt Anweisungen im Q&A-Modus klären und Explore Sub-Agenten nutzen, um Codebasen effizient zu durchsuchen. Gleichzeitig werden Claude Skills unterstützt, die es ermöglichen, das Agentenverhalten über Markdown-Dateien anzupassen, was die Personalisierung und Workflow-Automatisierung verbessert. (Quelle: tokenbender, Reddit r/ClaudeAI, Reddit r/ClaudeAI, omarsar0, jerryjliu0, skirano, QuixiAI)

LlamaIndex stellt Agent Builder und Workflow Debugger vor : LlamaIndex hat den Code-First Agent Builder LlamaAgents veröffentlicht, der das Kodieren und Bereitstellen komplexer Agenten-Workflows unterstützt. Gleichzeitig wurde ein visueller Workflow Debugger eingeführt, der es Benutzern ermöglicht, Agentenläufe in Echtzeit anzuzeigen, zu debuggen und zu vergleichen. Dies steigert die Effizienz der Agentenentwicklung und -wartung erheblich, insbesondere für Wissensarbeit, die komplexe Dokumente verarbeitet. (Quelle: jerryjliu0, jerryjliu0)

Perplexity erweitert AI-Assistentenfunktionen um E-Mail und Finanzanalyse : Die AI-Assistentenfunktionen von Perplexity werden kontinuierlich erweitert. Es wurde ein E-Mail-Assistent eingeführt, der E-Mails automatisch entwerfen und über 500 Anwendungsoperationen ausführen kann, sowie ein Finanzmodul, das Insiderhandel und Transaktionen von Politikern verfolgen kann. Diese Tools zielen darauf ab, alltägliche Aufgaben durch AI zu automatisieren und professionelle Informationen bereitzustellen, wodurch die Benutzerproduktivität erheblich gesteigert wird. (Quelle: AravSrinivas, AravSrinivas, AravSrinivas)

LangChain veröffentlicht LangGraph zur Unterstützung der Entwicklung produktionsreifer Agenten : LangChain hat das LangGraph-Framework vorgestellt, das darauf abzielt, die richtige Abstraktionsschicht für produktionsreife AI Agenten bereitzustellen. Das Framework konzentriert sich auf Kontrolle und Persistenz und bietet Kernfunktionen zur Unterstützung der skalierbaren Bereitstellung von Agenten. Darüber hinaus kann LangChain in Kombination mit Codex CLI schnell Multi-Session-, kontextsensitive Chatbots mit Rich-Text-Antworten erstellen, ohne Code schreiben zu müssen. (Quelle: hwchase17, hwchase17)

HuggingChat Omni integriert über hundert Modelle und ermöglicht automatische Modellauswahl : HuggingFace hat HuggingChat Omni eingeführt, das durch intelligente Routing-Technologie automatisch das beste Modell für Benutzeranfragen auswählt. Es integriert über 100 Open-Source-Modelle, darunter gpt-oss, deepseek, qwen. Die Plattform zielt darauf ab, die optimiertesten, kostengünstigsten und schnellsten Antworten zu liefern und plant, auf verschiedene Modalitäten wie Bilder, Audio und Video zu erweitern, was die Effizienz und Flexibilität der AI-Interaktion erheblich steigert. (Quelle: ClementDelangue, huggingface, yupp_ai)

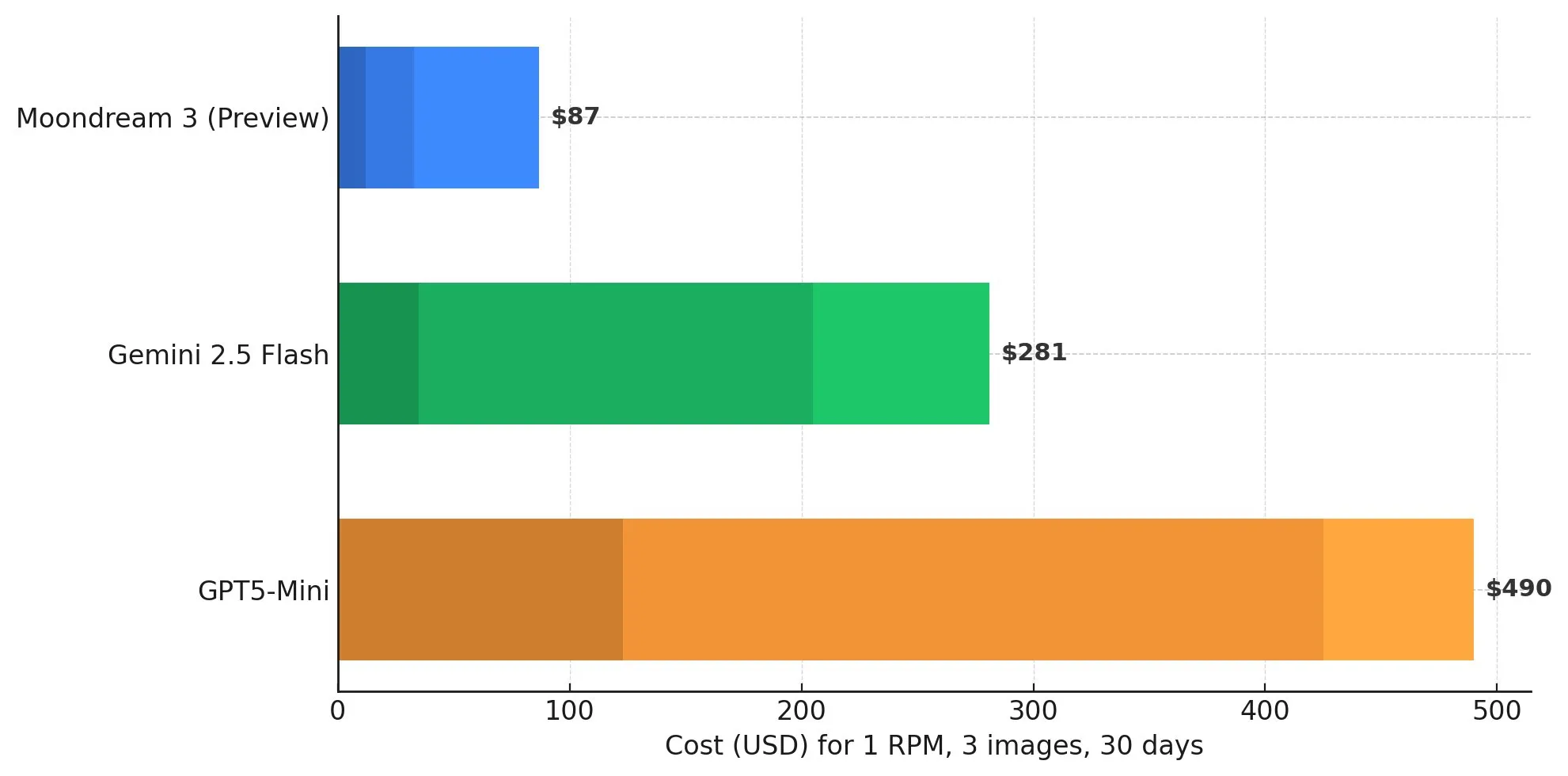

Moondream AI bietet effiziente VLM-Dienste und unterstützt lokale Bereitstellung : Moondream Cloud ist als gehosteter visueller AI-Dienst gestartet und wird als schneller, günstiger und intelligenter als Gemini 2.5 Flash und GPT-5 Mini beworben. Es bietet kostenlose monatliche Credits und ein Pay-as-you-go-Modell. Dieses VLM-Modell zeichnet sich durch Bildunterschriften aus, unterstützt die lokale Bereitstellung und bietet Benutzern eine kostengünstige Lösung für die visuelle Sprachverarbeitung. (Quelle: vikhyatk, vikhyatk, vikhyatk)

LlamaBarn vereinfacht lokale AI-Bereitstellung auf dem Mac, Yupp.ai bietet AI-Vergleichsplattform : Das LlamaBarn-Projekt bietet eine One-Click-Lösung, die es MacBook- oder MacMini-Benutzern ermöglicht, große Sprachmodelle einfach herunterzuladen und auszuführen, ohne komplexe Konfiguration, und bietet Web-Chat- und API-Schnittstellen. Yupp.ai bietet eine kostenlose AI-Vergleichsplattform, die über 800 AI-Modelle integriert, um Benutzern zu helfen, die Leistung verschiedener AIs tiefgreifend zu verstehen und zu vergleichen, und unterstützt die AI-Videokreation und PFP-Generierung. (Quelle: karminski3, yupp_ai, yupp_ai)

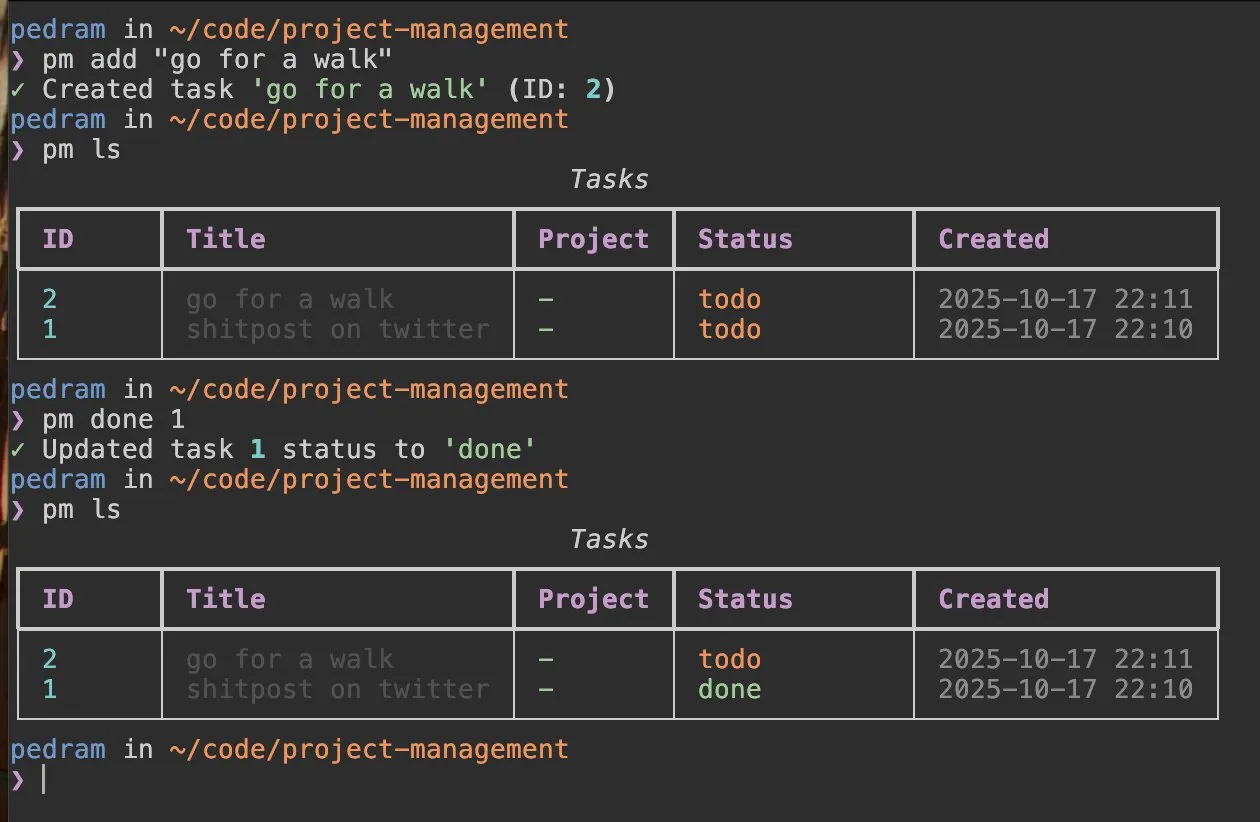

Scorecard erhöht die Sicherheit von AI Agenten, AI-gesteuerte Projektmanagement-Tools entstehen : Das Unternehmen Scorecard überträgt die Sicherheitslogik autonomer Fahrzeuge auf den Bereich der AI Agenten. Durch Sandbox-Tests und -Bewertungen wird verhindert, dass Unternehmens-AI „Halluzinationen“ und unsicheres Verhalten zeigt, insbesondere um die Zuverlässigkeit in regulierten Branchen zu gewährleisten. Gleichzeitig werden AI-gesteuerte Projektmanagement-CLI-Tools entwickelt, die voraussichtlich das Projekt-Tracking und -Management durch „vibe coding“ vereinfachen werden. (Quelle: dariusemrani, TheEthanDing)

📚 Lernen

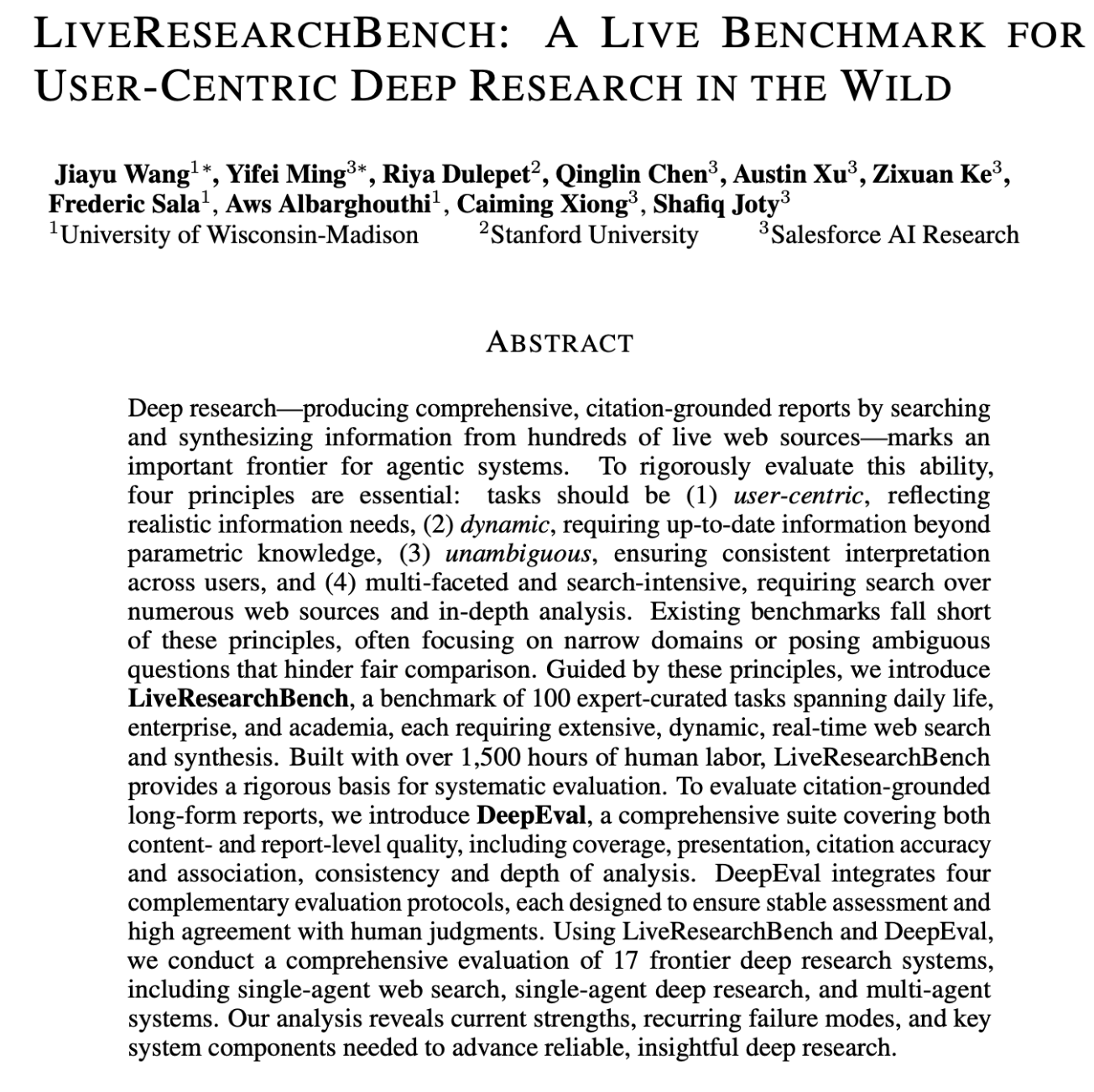

AI-Bildung und Lernressourcen: Grundlagentheorie und Spitzenforschung im Gleichgewicht : Der Bereich der AI-Bildung betont, dass fundierte Kenntnisse in Wahrscheinlichkeitstheorie, linearer Algebra und klassischem Machine Learning für das Verständnis moderner AI entscheidend sind. Lernressourcen umfassen AI Agent-Einführungen, DSPy-Wochenberichte, Funktionsweisen von Transformer-Modellen, Roboter-Lern-Tutorials und mehr. Im Forschungsbereich wurden wegweisende Arbeiten zu Transformer OOD-Generalisierung, kontextsensitiven Skalierungsgesetzen, diskriminativer Validierung, GroundedPRM und anderen Themen veröffentlicht, sowie die Benchmarks FML-bench und LiveResearchBench zur Bewertung von ML-Forschungsagenten. Die LangChain-Dokumentationserfahrung wurde verbessert, und Best Practices für das Hosting des Claude Agent SDK wurden geteilt. (Quelle: dilipkay, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, jeremyphoward, ClementDelangue, bookwormengr, lateinteraction, charles_irl, SchmidhuberAI, TheTuringPost, Reddit r/deeplearning, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, sbmaruf, sbmaruf, gneubig)

![18 months ago, @karpathy set a challenge: "Can you take my 2h13m tokenizer video and translate [into] a book chapter".](https://rebabel.net/wp-content/uploads/2025/10/image_1760789355.webp)

Neueste Fortschritte bei AI Agenten und ML-Forschungsbenchmarks : FML-bench dient als Benchmark zur Bewertung autonomer Machine Learning-Forschungsagenten und betont die Bedeutung der Explorationsbreite für Forschungsergebnisse. LiveResearchBench ist ein benutzerzentrierter Deep-Research-Benchmark, der 100 Expertenaufgaben umfasst und darauf abzielt, die Fähigkeit von Agenten streng zu bewerten, Informationen aus Hunderten von Live-Webquellen zu suchen und zu synthetisieren. Der Hard2Verify-Benchmark konzentriert sich darauf, die Fähigkeit von Validatoren zu messen, schrittweise Korrektheitslabels für offene, hochmoderne mathematische Probleme bereitzustellen. (Quelle: HuggingFace Daily Papers, HuggingFace Daily Papers, sbmaruf, sbmaruf)

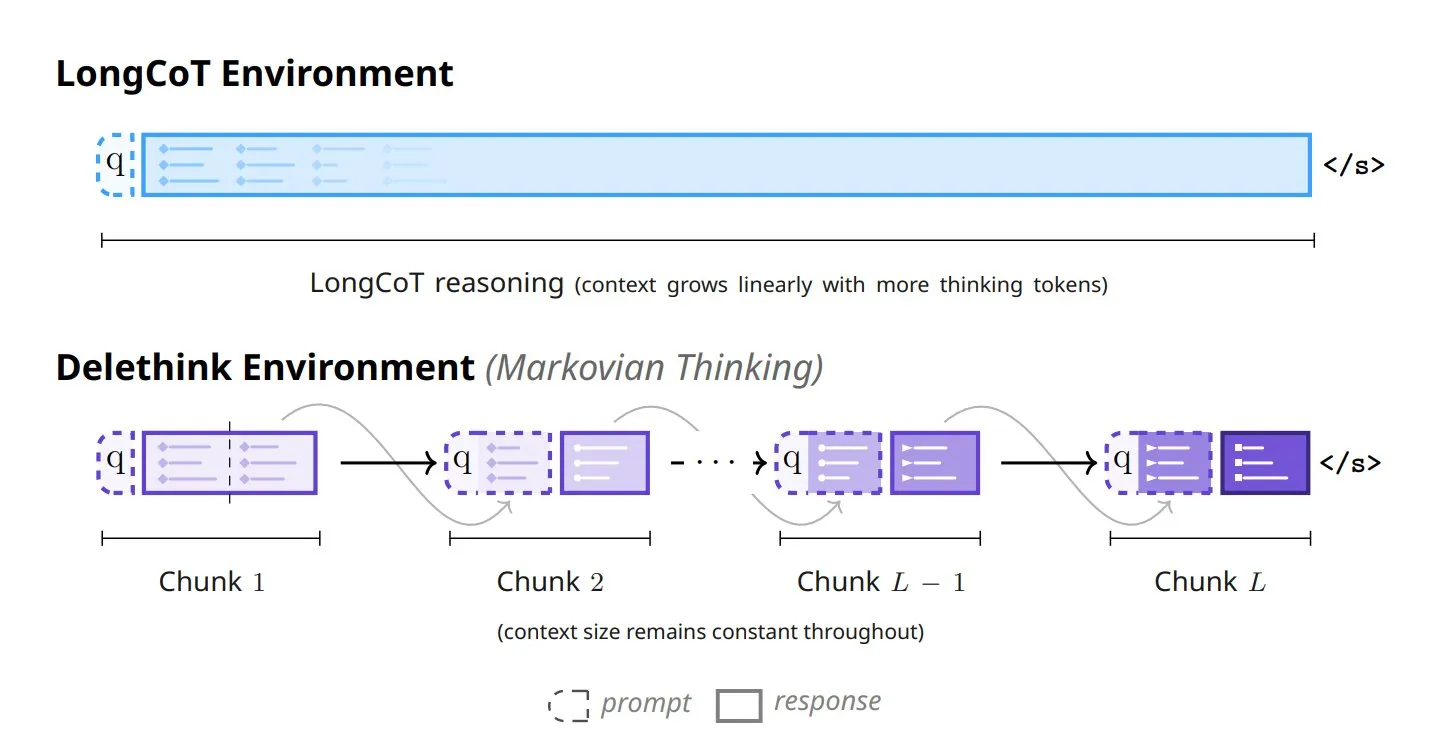

Sechs neue Ansätze für das Modell-Denken : Jüngste Forschungsergebnisse haben sechs neue Ansätze zur Transformation des Modell-Denkens vorgestellt, darunter Tiny Recursive Models (TRM), LaDIR (Latent Diffusion for Iterative Reasoning), ETD (encode-think-decode), Thinking on the fly, The Markovian Thinker und ToTAL (Thought Template Augmented LCLMs). Diese Methoden zielen darauf ab, die Inferenzfähigkeiten, die Effizienz und die Fähigkeit von Modellen zur Bewältigung komplexer Aufgaben zu verbessern und die Entwicklung von AI-Modellen hin zu fortschrittlicheren kognitiven Funktionen voranzutreiben. (Quelle: TheTuringPost)

💼 Business

AI beschleunigt die Durchdringung im Geschäftsbereich, CFOs als neue Champions der AI-Einführung : Die Anwendung von AI in Unternehmen beschleunigt sich. CFOs werden zu Schlüsselakteuren bei der Förderung der AI-Einführung. Die Akzeptanz von AI Agenten auf Unternehmensebene übertrifft die Erwartungen, und sie spielen eine strategische Rolle im Umsatzwachstumsmanagement. NVIDIA hat eine Marktkapitalisierung von über 4 Billionen US-Dollar erreicht, was das starke Wachstum des AI-Hardwaremarktes widerspiegelt. Der Gründer von HeyGen teilte Management- und Produktmethoden für AI-Produktteams und betonte Geschwindigkeit und Anpassungsfähigkeit an Modelliterationen. (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, SchmidhuberAI, dotey)

Oracle AI Cloud Services mit beachtlichen Bruttomargen, Microsoft AI Accelerator im Fokus : Oracle hat bekannt gegeben, dass seine AI-Cloud-Dienste eine Bruttomarge von bis zu 35 % erzielen können und bereits Verträge über 65 Milliarden US-Dollar für neue Cloud-Infrastruktur abgeschlossen hat. Dies zeigt seine starke Dynamik im AI-Cloud-Markt. Das AI-Accelerator-Programm von Microsoft stößt ebenfalls auf großes Interesse. Obwohl die Möglichkeiten für seinen Maia-Chip im 18A-Prozess variieren, bleibt es der AI-Hardwareentwicklung verpflichtet. (Quelle: 9点1氪, dylan522p)

AI-Startups aktiv in der Finanzierung, offenes Ökosystem und MCP-Kommerzialisierungsaussichten : General Intuition hat eine Seed-Finanzierungsrunde von 134 Millionen US-Dollar abgeschlossen, mit dem Ziel, Agenten zu trainieren, die 3D-Umgebungen verstehen. HuggingFace hat einen neuen Leiter für Anwendungen ernannt, um das Open-Source-Modell-Ökosystem voranzutreiben. Die Kommerzialisierungsaussichten des MCP-Protokolls werden untersucht, und Stripe diskutiert mit Entwicklern, wie die Nutzung von MCP abgerechnet werden kann. LangChain wird bald eine Launch Week veranstalten, um die Fortschritte bei seinen Agentenprodukten zu präsentieren. (Quelle: Reddit r/artificial, francoisfleuret, huggingface, fabianstelzer, LangChainAI, johannes_hage)

🌟 Community

AI Agent-Entwicklung löst Debatten aus: Vom Traum zur Realisierung, Praktikabilität und Grenzen koexistieren : Die Erwartungen der Community an AI Agenten verschieben sich von „Alleskönner-Fantasien“ hin zu „Systemaufbau“ und betonen ihre Rolle als Katalysatoren für Geschäftsprozesse. (Quelle: Ronald_vanLoon, Ronald_vanLoon)