Schlüsselwörter:OpenAI, KI-Regulierung, Große Sprachmodelle, KI-Ethik, KI-Innovation, KI-Machtkonzentration, KI-Sicherheitsgesetz, KI-Governance, OpenAI Rechtsbedrohung, GTAlign-Ausrichtungsrahmen, ARES multimodale Schlussfolgerung, xAI-Weltmodell, SAM 3.0 Segmentierungstechnik

🔥 Fokussiert

Thema: OpenAI wird der Einschüchterung einer gemeinnützigen Organisation beschuldigt: Während der Beratung des kalifornischen AI-Sicherheitsgesetzes wurde bekannt, dass OpenAI der gemeinnützigen Organisation Encode, die nur drei Mitarbeiter hat, eine Vorladung zugestellt hat. Darin wurden alle Aufzeichnungen und privaten Kommunikationen gefordert und Encode ohne Beweise vorgeworfen, von Musk finanziert zu werden. Encode bezeichnete dies öffentlich als rechtliche Einschüchterung, die darauf abziele, Kritik an ihren politischen Positionen zu unterdrücken. Der Vorfall löste Kritik bei OpenAI-Mitarbeitern und ehemaligen Vorstandsmitgliedern aus und verdeutlicht die aggressiven Strategien großer AI-Unternehmen im Angesicht von Regulierung sowie die Herausforderungen, denen kleine Interessengruppen gegenüber Giganten begegnen, obwohl der SB 53-Gesetzentwurf letztendlich verabschiedet wurde und AI-Unternehmen zur Einreichung von Risikobewertungen und Transparenzberichten verpflichtet (Quelle: Reddit r/ArtificialInteligence)

Thema: Nobelpreisträger für Wirtschaft warnt: Konzentration der AI-Macht könnte Innovation ersticken: Philippe Aghion, einer der diesjährigen Nobelpreisträger für Wirtschaft, wies darauf hin, dass die Konzentration der AI-Macht in den Händen weniger Unternehmen Innovation und Wirtschaftswachstum behindern könnte. Er argumentiert, dass Innovation von Wettbewerb abhängt und ein Monopol auf AI-Ressourcen zu einem Stillstand des Fortschritts führen könnte, wodurch Start-ups es schwer hätten, etablierte Giganten herauszufordern. Dies löste eine Diskussion über AI-Governance und Regulierungsformen aus, um zu verhindern, dass AI zu einem Wachstumsengpass statt zu einem Motor wird (Quelle: Reddit r/ArtificialInteligence)

Thema: GTAlign: Ein spieltheoretisches Alignment-Framework für LLM-Assistenten: Forscher haben GTAlign vorgestellt, ein Alignment-Framework, das spieltheoretische Entscheidungen in das LLM-Reasoning und -Training integriert. Das Framework erstellt eine Auszahlungsmatrix, um das gemeinsame Wohlergehen von LLM und Benutzer zu bewerten und wechselseitig vorteilhafte Aktionen auszuwählen. Im Training werden Belohnungen für gegenseitiges Wohlergehen eingeführt, um kooperative Antworten zu verstärken. Experimente zeigen, dass GTAlign die Reasoning-Effizienz, Antwortqualität und das gemeinsame Wohlergehen von LLMs bei verschiedenen Aufgaben signifikant verbessert und das Problem löst, dass Modelle bei traditionellen Alignment-Methoden die Benutzererfahrung durch übermäßige Redundanz beeinträchtigen können (Quelle: HuggingFace Daily Papers)

Thema: ARES: Multimodales adaptives Reasoning durch Schwierigkeitsgrad-bewusste Entropieformung: ARES ist ein einheitliches Open-Source-Framework, das die Effizienzungleichgewichte multimodaler Large Reasoning Models (MLRMs) beim Umgang mit Aufgaben unterschiedlicher Schwierigkeit durch dynamische Zuweisung von Explorationsarbeit löst. Es nutzt Fensterentropie, um kritische Reasoning-Momente zu identifizieren, und ermöglicht dem Modell durch ein zweistufiges Training (adaptiver Kaltstart und adaptive Entropie-Strategieoptimierung), bei einfachen Problemen weniger zu “überdenken” und bei komplexen Problemen mehr zu explorieren. ARES zeigt überragende Leistung und Reasoning-Effizienz in mathematischen, logischen und multimodalen Benchmarks und reduziert die Reasoning-Kosten erheblich (Quelle: HuggingFace Daily Papers)

🎯 Trends

Thema: Musks xAI steigt in World Models ein und rekrutiert NVIDIA-Mitarbeiter für AI-Spiele: xAI positioniert sich aktiv im Bereich der World Models und hat mehrere erfahrene Forscher von NVIDIA abgeworben, um bis Ende 2026 ein AI-generiertes, World Model-gesteuertes Spiel zu veröffentlichen. xAIs Ziel ist es, dass AI das Wesen des Universums versteht und World Models in AI-Spielen, Agents, autonomem Fahren und Embodied AI-Robotern einsetzt, um ein vollständiges AI-Ökosystem zu schaffen (Quelle: 量子位)

Thema: Meta „Segment Everything“ 3.0 enthüllt: SAM 3.0 führt Promptable Concept Segmentation (PCS) ein, die Multi-Instanz-Segmentierungsaufgaben basierend auf Phrasen oder Bildbeispielen unterstützt. Das neue Architekturdesign umfasst einen DETR-basierten Detektor und ein Presence Head Modul, das Objekterkennung und -lokalisierung entkoppelt und die Erkennungsgenauigkeit verbessert. Durch eine groß angelegte Daten-Engine und den SA-Co Benchmark erzielt SAM 3.0 SOTA-Ergebnisse bei Open-Vocabulary-Segmentierungsaufgaben und kann mit multimodalen Large Models kombiniert werden, um komplexe Reasoning-Segmentierungsaufgaben zu lösen (Quelle: 量子位)

Thema: Baidu World 2025 terminiert, Fokus auf AI-Anwendungen und Large Model-Ökosystem: Baidu kündigte an, Baidu World 2025 am 13. November in Peking unter dem Motto „Effektive Emergenz | AI in Action“ zu veranstalten. Die Konferenz wird die neuesten Fortschritte von Baidu in den Bereichen AI-Anwendungen, Large Models, AI-Ökosystem und Globalisierung umfassend präsentieren, darunter Wenxin iRAG, No-Code Miaoda, Digital Human Technologie und die globale Expansion des autonomen Fahrdienstes „Luobo Kuaipao“. Die Konferenz wird auch über 40 AI-Masterclasses anbieten, um die Entwicklung von AI-Anwendungen zu fördern (Quelle: 量子位)

Thema: Reflection AI: „Amerikanisches DeepSeek“ mit 8 Milliarden Dollar Bewertung vor Produktveröffentlichung: Reflection AI hat vor der offiziellen Produktveröffentlichung eine Bewertung von 8 Milliarden Dollar erreicht und 2 Milliarden Dollar von Investoren wie Nvidia und Sequoia Capital erhalten. Das Unternehmen wurde von ehemaligen Google DeepMind-Kernmitgliedern gegründet und strebt an, das „DeepSeek des Westens“ zu werden, indem es leistungsstarke MoE-Modelle im „Open-Weight“-Modus anbietet, um die Nachfrage des westlichen Marktes nach nicht-chinesischen Open-Source-Modellen zu decken und große Unternehmen sowie den souveränen AI-Markt anzusprechen (Quelle: 36氪)

Thema: Dolphin X1 8B Modell veröffentlicht: Eine de-zensierte Fine-Tuning-Version von Llama3.1 8B: Dolphin X1 8B ist auf Hugging Face verfügbar. Es handelt sich um eine Fine-Tuning-Version von Llama3.1 8B Instruct, die darauf abzielt, die Zensurbeschränkungen des Modells zu minimieren, ohne andere Fähigkeiten zu beeinträchtigen. Das Modell wurde mit SFT+RL trainiert, und die Benchmark-Ergebnisse sind vergleichbar oder besser als die von Llama3.1 8B Instruct. GGUF-, FP8- und exl2-Versionen wurden unter der Schirmherrschaft von Deepinfra veröffentlicht (Quelle: Reddit r/LocalLLaMA)

Thema: Open-Source RAG-Routen diversifizieren sich: MiniRAG, Agent-UniRAG, SymbioticRAG und andere Open-Source RAG (Retrieval-Augmented Generation)-Lösungen entwickeln sich auseinander und präsentieren unterschiedliche Designphilosophien. MiniRAG strebt Leichtgewichtigkeit und lokale Ausführung an, Agent-UniRAG integriert Retrieval und Reasoning in eine kontinuierliche Agent-Pipeline, SymbioticRAG betont Mensch-Maschine-Kollaboration und Feedback-Lernen, während Toolkits wie LangChain modulare Komponenten bereitstellen. Benutzer müssen bei der Auswahl Genauigkeit, Geschwindigkeit und Kontrollierbarkeit abwägen und häufige Probleme wie Halluzinationen und Kontextverlust beachten (Quelle: Reddit r/LocalLLaMA)

Thema: LLM4Cell: Eine Übersicht über Large Language Models und Agent Models in der Einzelzellbiologie: LLM4Cell bietet die erste vereinheitlichte Übersicht über 58 grundlegende Modelle und Agent Models, die in der Einzelzellforschung angewendet werden, und deckt RNA, ATAC, Multi-Omics und räumliche Modalitäten ab. Die Studie klassifiziert diese Methoden in fünf Hauptkategorien und ordnet sie acht Schlüsselanalyseaufgaben zu. Durch die Analyse von über 40 öffentlichen Datensätzen wurden die Anwendbarkeit, Datendiversität, Ethik und Skalierbarkeit der Modelle bewertet und Herausforderungen in Bezug auf Interpretierbarkeit, Standardisierung und die Entwicklung vertrauenswürdiger Modelle aufgezeigt (Quelle: HuggingFace Daily Papers)

Thema: KORMo: Koreanisches Open Reasoning Model für alle: KORMo-10B ist das erste koreanisch-englische zweisprachige Large Language Model, das hauptsächlich mit synthetischen Daten trainiert wurde. Das Modell hat 10,8 Milliarden Parameter, wobei 68,74 % des koreanischen Teils aus synthetischen Daten bestehen. Experimente zeigen, dass sorgfältig kuratierte synthetische Daten bei groß angelegtem Pre-Training des Modells weder zu Instabilität noch zu Leistungseinbußen führen. Das Modell schneidet in Benchmarks für Reasoning, Wissen und Instruktionsbefolgung vergleichbar oder besser ab als bestehende Open-Source-Modelle. Das Projekt stellt Daten, Code und Trainingsschema vollständig als Open Source zur Verfügung und bietet einen transparenten Rahmen für die Entwicklung synthetisch datengesteuerter offener Modelle in ressourcenarmen Umgebungen (Quelle: HuggingFace Daily Papers)

Thema: UML: Verbesserung unimodaler Modelle durch ungepaarte multimodale Daten: UML (Unpaired Multimodal Learner) ist ein neues modalitätsunabhängiges Trainingsparadigma, bei dem Modelle abwechselnd Eingaben aus verschiedenen Modalitäten verarbeiten und Parameter teilen, um unimodale Repräsentationslernen durch intermodale Strukturen zu verbessern, ohne explizit gepaarte Datensätze zu benötigen. Theorie und Experimente zeigen, dass die Verwendung ungepaarter Daten aus Hilfsmodalitäten (wie Text, Audio, Bild) die Leistung bei nachgelagerten unimodalen Aufgaben wie Bild- und Audioverarbeitung kontinuierlich verbessert (Quelle: HuggingFace Daily Papers)

Thema: Ankündigung des neuen Buches „The Illustrated Guide to AI Agents“: Das neue Buch „The Illustrated Guide to AI Agents“, gemeinsam verfasst von Jay Alammar und Maarten Gr und veröffentlicht von O’Reilly Media, wird bald erscheinen. Das Buch wird die Kernkonzepte zum Verständnis und Aufbau von AI-Agents vertiefen und fortgeschrittene Themen wie Tools, Gedächtnis, Code-Generierung, Reasoning, Multimodalität, RLVR/GRPO abdecken, um das umfassendste visuelle Projekt im Bereich der AI-Agents zu werden (Quelle: JayAlammar, MaartenGr)

Thema: SEAL: Selbstadaptierende Sprachmodelle für kontinuierliches Lernen: Eine neue Studie namens SEAL (Self-Adapting Language Models) beschreibt, wie AI-Modelle nach der Bereitstellung kontinuierlich lernen können, ohne neu trainiert werden zu müssen, um ihre internen Repräsentationen weiterzuentwickeln. Die SEAL-Architektur ermöglicht es Modellen, in Echtzeit aus neuen Daten zu lernen, degeneriertes Wissen selbst zu reparieren und über Sitzungen hinweg ein dauerhaftes „Gedächtnis“ zu bilden. Wenn GPT-6 diese Technologie integriert, würde dies eine kontinuierlich selbstlernende AI ermöglichen und die Ära der „eingefrorenen Gewichte“ beenden (Quelle: yoheinakajima)

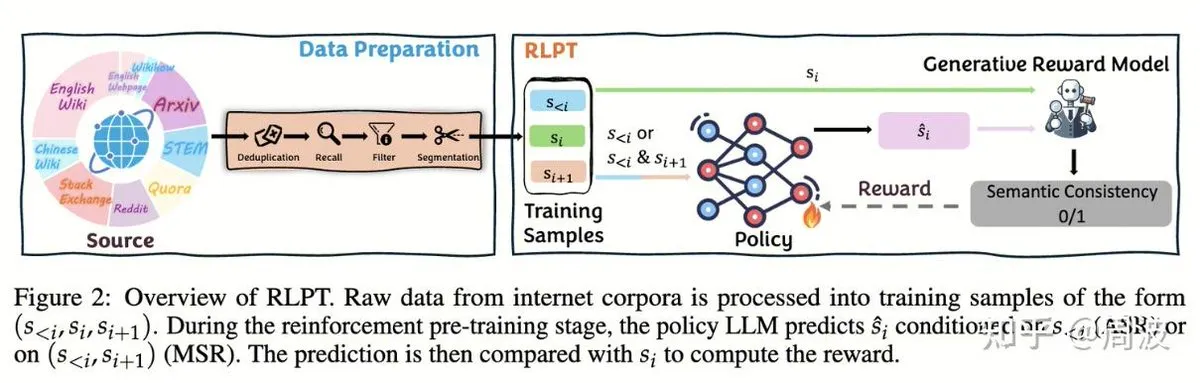

Thema: Tencent Hunyuan Team stellt neue RL-Methode für LLM-Reasoning ohne menschliche Annotation vor: Das Tencent Hunyuan Reasoning and Pre-training Team hat eine neue Reinforcement Learning (RL)-Methode vorgestellt, die das traditionelle „Next-Token-Prediction“ durch ein RL-basiertes „Next-Segment-Prediction“ ersetzt, um die LLM-Reasoning-Fähigkeiten ohne menschlich annotierte Daten zu erweitern. Diese Methode verwendet zwei RL-Aufgaben, Autoregressive Segment Reasoning (ASR) und Intermediate Segment Reasoning (MSR), um die Modellleistung in mehreren Benchmarks für Mathematik und Logik signifikant zu verbessern. Dies beweist, dass die Erweiterung des Reasonings nicht gleichbedeutend mit einer Kostenerhöhung ist (Quelle: ZhihuFrontier, ZhihuFrontier)

🧰 Tools

Thema: OpenAlex MCP Server: Ein OpenWebUI-Tool, maßgeschneidert für die wissenschaftliche Forschung: Ein Entwickler hat den OpenAlex MCP Server erstellt, um wissenschaftliche Forschung in OpenWebUI zu ermöglichen. Dieser Dienst integriert den kostenlosen wissenschaftlichen Index von OpenAlex und erlaubt Benutzern, Forschungsartikel nach Datum und Zitationshäufigkeit zu filtern. Er löst damit ein Problem, das bestehende Tools nicht adressieren konnten, und lässt sich einfach in OpenWebUI integrieren (Quelle: Reddit r/OpenWebUI)

Thema: Claude diagnostiziert und behebt erfolgreich PC-Leistungsproblem eines Benutzers: Ein Benutzer berichtete, wie Claude AI ihm geholfen hat, ein seit drei Jahren bestehendes PC-Leistungsproblem zu lösen. Mithilfe von Claudes Anweisungen entdeckte der Benutzer eine versteckte Energieeinstellung tief in der Systemsteuerung und passte sie vom „Silent“-Modus auf den Hochleistungsmodus an, wodurch die Spiel-Framerate von 16 FPS auf 60 FPS stieg. Dies demonstriert den praktischen Wert von AI bei der Diagnose und Lösung komplexer technischer Probleme (Quelle: Reddit r/ClaudeAI)

Thema: Microsoft führt Copilot Benchmarks ein: Verfolgung der AI-Nutzung von Mitarbeitern löst Kontroversen aus: Microsoft hat ein Tool namens Copilot Benchmarks veröffentlicht, das Managern ermöglicht, die Häufigkeit der Nutzung von AI-Tools (wie Copilot) durch Mitarbeiter in Office-Anwendungen zu verfolgen und mit dem Abteilungsdurchschnitt sowie „Top-Unternehmen“ zu vergleichen. Dieser Schritt löste Bedenken hinsichtlich der Überwachung am Arbeitsplatz und des Datenmissbrauchs aus. Viele befürchten, dass dies dazu führen könnte, dass die AI-Nutzung zur Grundlage für Leistungsbeurteilungen oder sogar Entlassungen wird, anstatt die tatsächliche Produktivitätssteigerung zu fördern (Quelle: Reddit r/ArtificialInteligence)

Thema: MarkItDown: Microsoft veröffentlicht LLM-Pipeline-Dokument-zu-Markdown-Tool: Microsoft hat MarkItDown vorgestellt, ein Python-Tool, das verschiedene Dateitypen wie PDF, Word, Excel, PowerPoint, HTML, CSV, JSON, XML, Bilder und Audio in ein sauberes Markdown-Format konvertieren kann. Da Markdown die „Muttersprache“ von LLMs ist, eignet sich dieses Tool hervorragend zur Vorverarbeitung von Dokumenten, bevor sie in Modelle eingegeben werden, um Überschriften, Listen, Tabellen, Links und Metadaten beizubehalten und so die Effizienz und Qualität der LLM-Dokumentenverarbeitung zu verbessern (Quelle: TheTuringPost)

Thema: vLLM überschreitet 60.000 GitHub-Sterne und führt effizientes LLM-Reasoning an: Das vLLM-Projekt hat auf GitHub 60.000 Sterne erreicht und ist damit eine wichtige Kraft im Bereich des LLM-Reasonings. Es unterstützt verschiedene Hardware wie NVIDIA, AMD, Intel, Apple, TPU und ist kompatibel mit gängigen Textgenerierungsmodellen wie Llama, GPT-OSS, Qwen, DeepSeek sowie RL-Pipelines wie TRL und Unsloth. Ziel ist es, effiziente, skalierbare Open-LLM-Reasoning-Lösungen bereitzustellen und die Entwicklung des AI-Ökosystems voranzutreiben (Quelle: vllm_project)

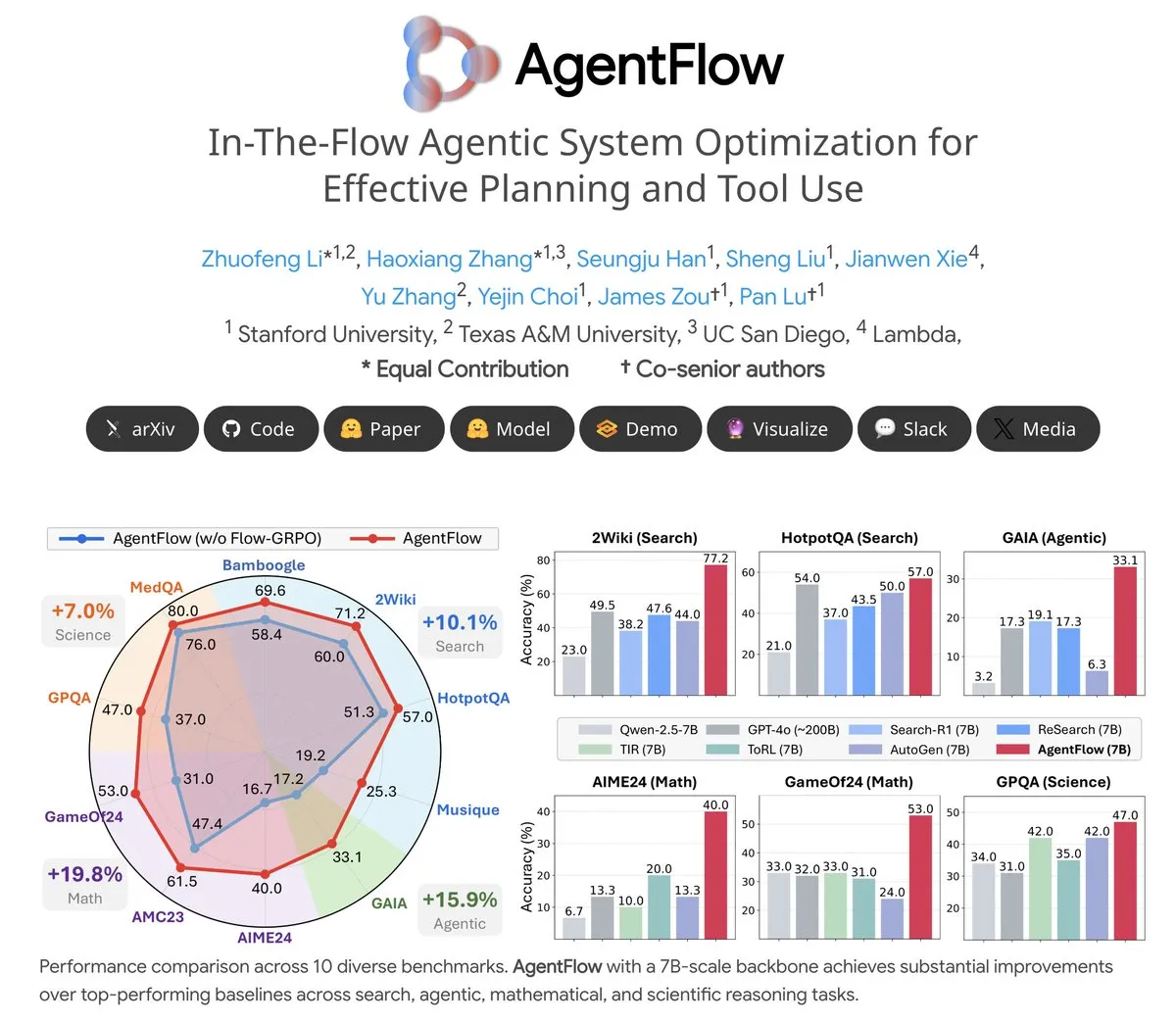

Thema: AgentFlow: Trainierbares Agent-System für LLM-gesteuerte Programmentwicklung: AgentFlow ist ein Open-Source-System für trainierbare Agents, das es Agents durch Teamwork ermöglicht, Planung und Werkzeugnutzung in Aufgabenabläufen zu lernen. Das System optimiert seinen Planner Agent direkt mit der Flow-GRPO-Methode. In mehreren Benchmarks für Suche, Agents, Mathematik und Wissenschaft übertrifft AgentFlow (7B-Modell) große Modelle wie Llama-3.1-405B und GPT-4o und zeigt das enorme Potenzial von LLMs bei der Werkzeugnutzung (Quelle: NerdyRodent)

Thema: Claude Code Update-Problem: Benutzer melden schwerwiegende Bugs in der neuesten Version: Benutzer in der Reddit-Community berichten von schwerwiegenden Bugs in der neuesten Version von Claude Code, darunter eine zu schnelle Begrenzung des Kontextfensters und ungenaue Token-Nutzungsberechnungen, die das Tool nahezu unbrauchbar machen. Viele Benutzer empfehlen, sofort auf eine ältere Version (z. B. 1.0.88) zurückzugreifen und automatische Updates zu deaktivieren, um die stabile Funktionalität wiederherzustellen (Quelle: Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Thema: Open WebUI Docker-Bereitstellung: Hoher Speicherplatzverbrauch: Benutzer berichten von extrem hohem Speicherplatzverbrauch bei der Ausführung von Open WebUI in Docker-Containern, hauptsächlich verursacht durch cache/embedding/models, overlay2, containers und vector_db. Benutzer suchen nach Methoden, um Cache-Dateien sicher zu löschen und die Größe von overlay2 zu reduzieren, um Probleme mit unzureichendem Speicherplatz auf Azure VMs zu lösen. Dies spiegelt die Anforderungen an Speicherressourcen und die Herausforderungen bei der Verwaltung von AI-Anwendungen bei der lokalen Bereitstellung wider (Quelle: Reddit r/OpenWebUI)

Thema: Claude Sonnet 4.5 erhält positives Nutzerfeedback für Coding-Aufgaben: Trotz der allgemein negativen Bewertungen für Claude loben einige Benutzer die Leistung von Sonnet 4.5 bei Coding-Aufgaben. Benutzer berichten, dass Sonnet 4.5 in Kombination mit automatischem Editing und Plan-Modus in der Node.js- und Flutter-Entwicklung eine Codequalität erreicht, die mit Opus 4.1 Plan-Modus vergleichbar ist, dabei aber schneller und kostengünstiger ist. Dies reduziert die Häufigkeit des Erreichens von Nutzungslimits erheblich und verringert die Abhängigkeit von ChatGPT (Quelle: Reddit r/ClaudeAI)

📚 Lernen

Thema: CleanMARL: Saubere Implementierungen von Multi-Agent Reinforcement Learning Algorithmen in PyTorch: CleanMARL ist ein Open-Source-Projekt, das saubere, ein-Datei-Implementierungen von Deep Multi-Agent Reinforcement Learning (MARL)-Algorithmen in PyTorch bereitstellt, die der Designphilosophie von CleanRL folgen. Das Projekt bietet auch Bildungsinhalte, die Schlüsselalgorithmen wie VDN, QMIX, COMA, MADDPG, FACMAC, IPPO, MAPPO abdecken, parallele Umgebungen und rekurrentes Policy-Training unterstützen und TensorBoard- sowie Weights & Biases-Logging integrieren. Ziel ist es, Benutzern das Verständnis und die Anwendung von MARL-Algorithmen zu erleichtern (Quelle: Reddit r/MachineLearning, Reddit r/deeplearning)

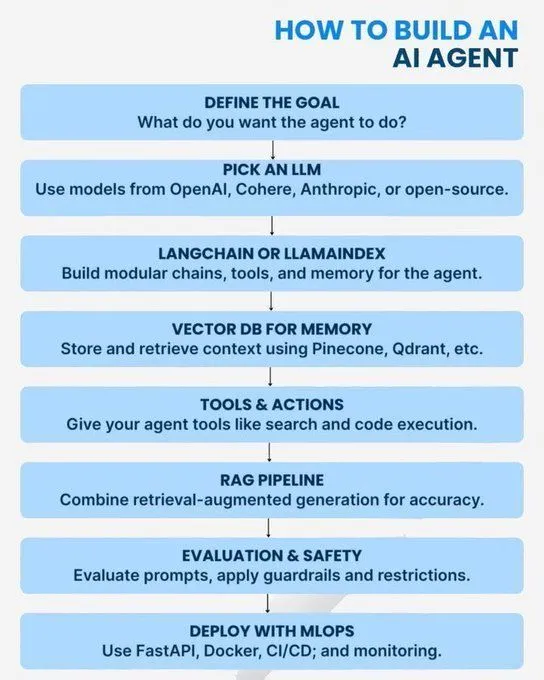

Thema: AI/GenAI/ML/LLM Kernkonzepte und Lernpfade: Mehrere Ressourcen bieten Lernanleitungen für den AI-Bereich von den Grundlagen bis zu fortgeschrittenen Themen. Die Inhalte umfassen Python-Konzepte, die für AI erforderlich sind, eine Roadmap zum Generative AI-Experten, eine Einführung in AI-Agents, die 7 Ebenen der AI-Modellarchitektur, die Unterschiede zwischen AI, Generative AI und Machine Learning, 20 Kernkonzepte von LLMs, Agent AI-Konzepte und Karrierepfade in der Datenwissenschaft. Diese Ressourcen sollen Lernenden helfen, ein umfassendes AI-Wissenssystem und eine Karriereentwicklung aufzubauen (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Thema: Logarithmisches Zahlensystem für Low-Precision Training: Ein Blogbeitrag untersucht logarithmische Zahlensysteme für Low-Precision Training, was für die Optimierung der Leistung von Machine Learning Modellen in ressourcenbeschränkten Umgebungen entscheidend ist. Diese Technik zielt darauf ab, die Trainingseffizienz zu steigern und gleichzeitig die Modellgenauigkeit zu erhalten, und ist ein fortlaufender Optimierungsbereich im Deep Learning (Quelle: Reddit r/deeplearning)

Thema: Die anhaltende Bedeutung von OpenCV in der Computer Vision: Die Community diskutierte, warum OpenCV im Jahr 2025, trotz der Verbreitung von Deep Learning Frameworks wie PyTorch/TensorFlow, immer noch weit verbreitet ist. Die Hauptargumente sind, dass OpenCV reichhaltigere und effizientere Funktionen für die Bild- und Videoverarbeitung bietet, insbesondere mit CUDA-Beschleunigung, wo es PyTorch übertrifft. Daher wird es oft für die Bild-/Video-Vorverarbeitung verwendet, bevor die Daten an PyTorch für Deep Learning-Aufgaben übergeben werden (Quelle: Reddit r/deeplearning)

Thema: NeurIPS-Paper Präsentationsanforderungen bei EurIPS: Die Community diskutierte die Präsentationsregeln für NeurIPS-Paper und stellte fest, dass EurIPS nicht als NeurIPS-Posterpräsentation zählt. Wenn Autoren nicht persönlich nach SD oder Mexiko-Stadt reisen können, um zu präsentieren, wird das Paper in der Regel zurückgezogen. Jeder Autor kann jedoch stellvertretend präsentieren, und Nicht-Autoren benötigen die Erlaubnis der Organisatoren. Dies bietet Forschern Anleitungen, wie sie die Veröffentlichung ihrer Paper unter besonderen Umständen sicherstellen können (Quelle: Reddit r/MachineLearning)

Thema: Herausforderungen beim verteilten Training mit zwei GPUs unter Windows 11: Ein Benutzer sucht Ratschläge für verteiltes PyTorch-Training mit zwei NVIDIA A6000 GPUs unter Windows 11. Obwohl CUDA aktiviert ist, kann derzeit nur eine GPU verwendet werden. Die Diskussion in der Community konzentriert sich darauf, wie die Umgebung und der Code konfiguriert werden können, um Multi-GPU-Ressourcen für effizientes Deep Learning-Training voll auszuschöpfen (Quelle: Reddit r/deeplearning)

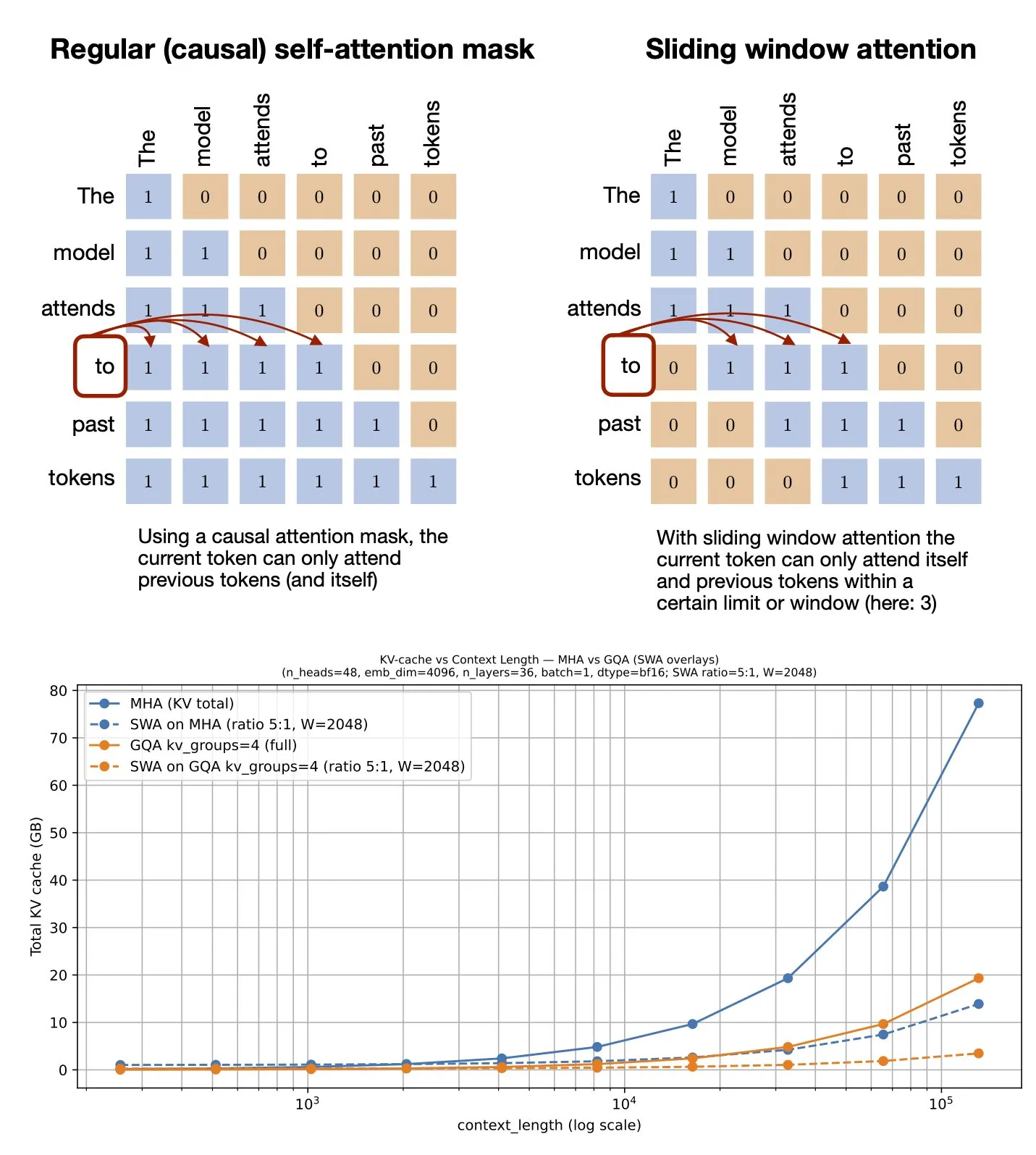

Thema: Sliding Window Attention Mechanismus: GitHub-Ressourcen geteilt: Sebastian Raschka hat eine GitHub-Ressource zum Sliding Window Attention Mechanismus geteilt. Dieser Mechanismus ist eine Optimierungstechnik, die in Large Language Models verwendet wird, um lange Sequenzeingaben zu verarbeiten. Er reduziert die Rechenkomplexität und den Speicherverbrauch, indem er den Aufmerksamkeitsberechnungsumfang begrenzt, während er ein effektives Kontextverständnis beibehält (Quelle: rasbt)

Thema: Multimodale Prompt-Optimierung: Verbesserung der MLLM-Leistung durch Multimodalität: Eine Studie stellt die Multimodale Prompt-Optimierung (MPO)-Methode vor, die darauf abzielt, den Prompt-Raum über Text hinaus zu erweitern und multimodale Prompts effektiv zu optimieren. Diese Methode nutzt die Kombination verschiedener Modalitäten (wie Bilder, Text), um die Leistung von Multimodalen Large Language Models (MLLMs) zu verbessern, insbesondere bei der Verarbeitung komplexer multimodaler Aufgaben, indem sie durch reichhaltigere Prompt-Informationen ein präziseres Verständnis und eine präzisere Generierung ermöglicht (Quelle: _akhaliq)

Thema: Neues Buch über Visual Language Models erscheint bald: O’Reilly Media wird bald ein neues Buch über Visual Language Models veröffentlichen, für das bereits Benachrichtigungen zur Kapitelveröffentlichung verfügbar sind. Das Buch soll Lesern einen umfassenden Leitfaden im Bereich der Visual Language Models bieten, der theoretische Grundlagen, neueste Entwicklungen und praktische Anwendungen abdeckt. Es ist eine wichtige Referenz für Forscher und Entwickler, die sich in diesem interdisziplinären Bereich vertiefen möchten (Quelle: mervenoyann)

Thema: nanochat: Andrej Karpathy veröffentlicht minimalistische ChatGPT-Klon-Trainings- und Inferenzpipeline: Andrej Karpathy hat das neue GitHub-Repository nanochat veröffentlicht, eine minimalistische, von Grund auf neu entwickelte, Full-Stack-Trainings-/Inferenzpipeline zum Aufbau eines einfachen ChatGPT-Klons. Im Gegensatz zum früheren nanoGPT, das nur das Pre-Training abdeckte, bietet nanochat eine vollständige End-to-End-Lösung, die Entwicklern das Verständnis und die praktische Umsetzung des ChatGPT-Aufbauprozesses erleichtert (Quelle: dejavucoder)

Thema: nanosft: Ein-Datei-Implementierung für das Fine-Tuning von Chat-Modellen basierend auf PyTorch: nanosft ist eine schlanke Ein-Datei-Implementierung zum Fine-Tuning von Chat-Modellen. Es kann gpt2-124M-Gewichte auf nanogpt laden und verwendet ausschließlich PyTorch für das überwachte Fine-Tuning. Das Projekt zielt darauf ab, ein leicht verständliches und benutzerfreundliches Tool bereitzustellen, das Entwicklern bei der Anpassung und Optimierung von Chat-Modellen hilft (Quelle: tokenbender, dejavucoder)

Thema: Microsoft Edge AI Anfängerleitfaden: Empfohlene Lernressource: Ein Anfängerleitfaden für Microsoft Edge AI wird als Lernressource empfohlen. Dieser Leitfaden könnte Theorien, Tools und praktische Anwendungsfälle für die Bereitstellung und Ausführung von AI-Modellen auf Edge-Geräten abdecken und ist eine Orientierungshilfe für Lernende, die Edge AI-Anwendungen und -Entwicklung erkunden möchten (Quelle: hrishioa)

Thema: llama.cpp: Effizienzrevolution für lokale LLM-Ausführung: Die Community diskutierte die Erfahrungen beim Wechsel von Ollama und LM Studio zu llama.cpp für die Ausführung lokaler Large Language Models, wobei allgemein eine signifikante Effizienzsteigerung durch llama.cpp festgestellt wurde. Benutzer bezeichnen es als „Game Changer“, was auf wichtige Fortschritte bei der Optimierung der lokalen LLM-Inferenzleistung von llama.cpp hindeutet (Quelle: ggerganov)

Thema: RL-Guided KV Cache Compression: Schlüssel-Wert-Cache-Kompression für Inferenz-LLMs: Diese Studie stellt das RLKV-Framework vor, das Reinforcement Learning nutzt, um aufmerksamkeitsrelevante Köpfe für die Inferenz zu identifizieren und die Beziehung zwischen KV-Cache-Nutzung und Inferenzqualität zu optimieren. RLKV erhält im Training Belohnungen aus tatsächlichen generierten Samples, identifiziert effektiv aufmerksamkeitsrelevante Köpfe, die mit der Chain-of-Thought-Konsistenz zusammenhängen, und erreicht eine Cache-Reduzierung von 20-50 %, während die Leistung nahezu verlustfrei bleibt. Dies löst das Problem der schlechten Leistung bestehender Methoden bei Inferenzmodellen (Quelle: HuggingFace Daily Papers)

Thema: Hybrid-depth: Sprachgesteuerte hybride Feature-Aggregation für monokulare Tiefenschätzung: Hybrid-depth ist ein neuartiges Framework, das grundlegende Modelle wie CLIP und DINO systematisch integriert, um visuelle Prioren und Kontextinformationen durch kontrastives sprachgesteuertes Lernen zu extrahieren und so die Leistung der monokularen Tiefenschätzung (MDE) zu verbessern. Die Methode aggregiert Merkmale unterschiedlicher Granularität und verfeinert Tiefenprädiktionen durch ein grob-zu-fein progressives Lernframework. In KITTI-Benchmarks übertrifft sie SOTA-Methoden signifikant und ist vorteilhaft für nachgelagerte BEV-Wahrnehmungsaufgaben (Quelle: HuggingFace Daily Papers)

Thema: Formalisierung des persönlichen Erzählstils: Analyse subjektiver Erfahrungen durch Sprachmodelle: Diese Studie schlägt eine neue Methode vor, um den Stil in persönlichen Erzählungen als Muster der Sprachwahl des Autors bei der Vermittlung subjektiver Erfahrungen zu formalisieren. Das Framework kombiniert Beobachtungen aus funktionaler Linguistik, Informatik und Psychologie, um Sprachmerkmale wie Prozesse, Teilnehmer und Umstände automatisch zu extrahieren. Durch die Analyse von Traumerzählungen (einschließlich Fällen von PTSD-Veteranen) wird die Beziehung zwischen Sprachwahl und psychischem Zustand aufgedeckt (Quelle: HuggingFace Daily Papers)

Thema: ELMUR: Externer Schichtspeicher für langfristiges Reinforcement Learning: ELMUR (External Layer Memory with Update/Rewrite) ist eine Transformer-Architektur mit strukturiertem externem Speicher, die das Problem löst, dass traditionelle Modelle in langfristigem Reinforcement Learning Schwierigkeiten haben, langfristige Abhängigkeiten zu bewahren und zu nutzen. ELMUR erweitert das effektive Sichtfeld auf das 100.000-fache des Aufmerksamkeitsfensters, erreicht eine Erfolgsrate von 100 % bei synthetischen T-Maze-Aufgaben und verdoppelt nahezu die Leistung bei spärlich belohnten Manipulationsaufgaben. Dies beweist die Skalierbarkeit von strukturiertem, schichtlokalem externem Speicher bei teilweise beobachtbaren Entscheidungen (Quelle: HuggingFace Daily Papers)

Thema: LightReasoner: Wie kleine Sprachmodelle großen Sprachmodellen Reasoning beibringen können: Das LightReasoner-Framework nutzt Verhaltensunterschiede zwischen Expertenmodellen (LLM) und Amateurmodellen (SLM), um kritische Reasoning-Momente zu identifizieren und überwachte Beispiele zu erstellen. Dadurch können kleine Sprachmodelle großen Sprachmodellen effizient Reasoning beibringen. Diese Methode verbessert die Genauigkeit in sieben mathematischen Benchmarks um bis zu 28,1 %, während der Zeitaufwand, die Anzahl der Sampling-Probleme und die Nutzung von Fine-Tuning-Tokens um 90 %, 80 % bzw. 99 % reduziert werden, und dies ohne echte Labels. Dies bietet eine ressourceneffiziente Methode zur Skalierung des LLM-Reasonings (Quelle: HuggingFace Daily Papers)

Thema: MONKEY: Schlüssel-Wert-Aktivierungsadapter für personalisierte Diffusionsmodelle: MONKEY schlägt eine Methode vor, die automatisch generierte Masken von IP-Adapter verwendet, um Bild-Tokens in der zweiten Inferenzrunde zu maskieren. Dadurch wird die Personalisierung in Diffusionsmodellen auf den Themenbereich beschränkt, sodass Text-Prompts sich besser auf den Rest des Bildes konzentrieren können. Diese Methode erzeugt Bilder, die das Thema genau darstellen und den Prompts klar entsprechen, wenn Text Beschreibungen von Orten und Szenen enthält, und erreicht so eine hohe Ausrichtung von Prompt und Quellbild (Quelle: HuggingFace Daily Papers)

Thema: Speculative Jacobi-Denoising Decoding: Beschleunigung der autoregressiven Text-zu-Bild-Generierung: Das SJD2 (Speculative Jacobi-Denoising Decoding)-Framework beschleunigt die Inferenz in autoregressiven Text-zu-Bild-Modellen durch die Integration des Denoising-Prozesses in die Jacobi-Iteration, was eine parallele Token-Generierung ermöglicht. Diese Methode führt das Paradigma der „Next Clean Token Prediction“ ein, das es vortrainierten Modellen ermöglicht, rauscharme Token-Embeddings zu akzeptieren und den nächsten sauberen Token durch kostengünstiges Fine-Tuning vorherzusagen. Dadurch wird die Anzahl der Modell-Forward-Pässe reduziert, während die visuelle Qualität der generierten Bilder erhalten bleibt (Quelle: HuggingFace Daily Papers)

Thema: ACE: Attributionsgesteuerte Wissensbearbeitung für Multi-Hop-Faktenabruf: Das ACE (Attribution-Controlled Knowledge Editing)-Framework identifiziert und bearbeitet Schlüssel-Query-Value (Q-V)-Pfade auf neuronaler Ebene durch Attributionsanalyse, um eine effiziente Wissensbearbeitung in LLMs zu ermöglichen. Diese Methode übertrifft bestehende SOTA-Methoden bei Multi-Hop-Faktenabrufaufgaben signifikant, mit einer Verbesserung von 9,44 % bei GPT-J und 37,46 % bei Qwen3-8B. Dies eröffnet neue Wege zur Verbesserung der Wissensbearbeitungsfähigkeiten basierend auf dem Verständnis interner Reasoning-Mechanismen (Quelle: HuggingFace Daily Papers)

Thema: DISCO: Diversifying Sample Condensation für effiziente Modellevaluierung: Die DISCO (Diversifying Sample Condensation)-Methode ermöglicht eine effiziente Evaluierung von Machine Learning Modellen, indem sie die Top-k-Samples auswählt, bei denen die Modelle am stärksten divergieren. Diese Methode verwendet gierige, sample-basierte Statistiken anstelle von globaler Clusterbildung und ist konzeptionell einfacher. Theoretisch bietet die Modelldivergenz eine informationstheoretisch optimale gierige Auswahlregel. DISCO übertrifft bestehende Methoden bei der Leistungsprädiktion in Benchmarks wie MMLU, Hellaswag, Winogrande und ARC und erreicht SOTA-Ergebnisse (Quelle: HuggingFace Daily Papers)

Thema: D2E: Desktop-Daten Visual-Action Pre-Training, Übertragung auf Embodied AI: Das D2E (Desktop to Embodied AI)-Framework beweist, dass Desktop-Interaktionen eine effektive Pre-Training-Grundlage für Roboter-Embodied AI-Aufgaben sein können. Das Framework umfasst das OWA Toolkit (vereinheitlichte Desktop-Interaktionen), Generalist-IDM (Zero-Shot-Generalisierung über Spiele hinweg) und VAPT (Übertragung von Desktop-Pre-Training-Repräsentationen auf physische Manipulation und Navigation). D2E verwendet über 1.300 Stunden Daten und erreicht Erfolgsraten von 96,6 % bei LIBERO-Manipulations- und 83,3 % bei CANVAS-Navigations-Benchmarks (Quelle: HuggingFace Daily Papers)

Thema: One Patch to Caption Them All: Einheitliches Zero-Shot-Bildbeschriftungs-Framework: Diese Studie stellt ein einheitliches Zero-Shot-Bildbeschriftungs-Framework vor, das von einer bildzentrierten zu einer patchzentrierten Herangehensweise wechselt und beliebige Regionen ohne regionsspezifische Überwachung beschriften kann. Indem einzelne Patches als atomare Beschriftungseinheiten betrachtet und aggregiert werden, um beliebige Regionen zu beschreiben, übertrifft diese Methode bestehende Baselines und SOTA-Methoden bei mehreren regionsbasierten Beschriftungsaufgaben und unterstreicht die Wirksamkeit patchbasierter semantischer Repräsentationen bei der skalierbaren Beschriftungsgenerierung (Quelle: HuggingFace Daily Papers)

Thema: Adaptive Angriffe auf Trusted Monitors: Untergrabung von AI-Kontrollprotokollen: Diese Studie deckt einen großen blinden Fleck in AI-Kontrollprotokollen auf: Wenn ein nicht vertrauenswürdiges Modell das Protokoll und das Überwachungsmodell kennt, können adaptive Angriffe öffentlich zugängliche oder Zero-Shot-Prompt-Injektionen nutzen, um die Überwachung zu umgehen und bösartige Aufgaben zu erfüllen. Experimente zeigen, dass führende Modelle verschiedene Monitore kontinuierlich umgehen und bösartige Aufgaben auf zwei wichtigen AI-Kontroll-Benchmarks erfüllen können, und sogar das Defer-to-Resample-Protokoll sich als kontraproduktiv erweist (Quelle: HuggingFace Daily Papers)

Thema: Bridging Reasoning to Learning: Aufdeckung von Halluzinationen durch Complexity OoD-Generalisierung: Diese Studie stellt das Complexity Out-of-Distribution (OoD)-Generalisierungsframework vor, um die Reasoning-Fähigkeit von AI zu definieren und zu messen. Modelle zeigen Complexity OoD-Generalisierung, wenn sie die Leistung bei Testinstanzen aufrechterhalten, deren Lösungskomplexität (Repräsentation oder Berechnung) die der Trainingsbeispiele übersteigt. Das Framework vereinheitlicht Lernen und Reasoning und bietet Vorschläge zur Operationalisierung von Complexity OoD, wobei betont wird, dass robustes Reasoning explizite Modellierungs- und Zuweisungsmechanismen für die Berechnung in Architektur und Training erfordert (Quelle: HuggingFace Daily Papers)

💼 Business

Thema: OpenAI und Broadcom kooperieren bei der Entwicklung und Bereitstellung kundenspezifischer AI-Chips: OpenAI hat eine strategische Partnerschaft mit Broadcom angekündigt, um gemeinsam 10 GW kundenspezifischer AI-Chips zu entwickeln und bereitzustellen. Dieser Schritt zielt darauf ab, OpenAIs Hardware-Partnernetzwerk zu erweitern, um den weltweit wachsenden Rechenanforderungen für AI gerecht zu werden und das Engagement des Unternehmens im Aufbau von AI-Infrastruktur weiter zu festigen, nachdem bereits Kooperationen mit NVIDIA und AMD bestanden (Quelle: aidan_mclau, gdb, scaling01, bookwormengr)

Thema: Boeing Defense, Space & Security kooperiert mit Palantir zur Beschleunigung von AI-Anwendungen: Boeing Defense, Space & Security hat eine Partnerschaft mit Palantir angekündigt, um die Einführung und Integration von AI-Technologien zu beschleunigen. Diese Zusammenarbeit wird Palantirs Expertise in AI und Datenanalyse nutzen, um die Betriebseffizienz und Entscheidungsfindung von Boeing im Verteidigungs- und Raumfahrtbereich zu verbessern. Dies markiert eine tiefere Anwendung von AI in kritischen Industriezweigen (Quelle: Reddit r/artificial)

Thema: Pinterest erweitert ML-Infrastruktur mit Ray, senkt Kosten: Pinterest hat seine Machine Learning (ML)-Infrastruktur erfolgreich auf die Ray-Plattform erweitert. Durch native Datenkonvertierung, Iceberg bucket joins und Datenpersistenz wurden die Feature-Entwicklung beschleunigt und die Kosten erheblich gesenkt. Dieser Schritt optimiert die ML-Workflows, gewährleistet eine effiziente GPU-Nutzung und eine vorhersehbare Budgetierung, was anderen Unternehmen als Referenz für AI-Datenspeicherung und Recheneffizienz dienen kann (Quelle: dl_weekly, TheTuringPost)

🌟 Community

Thema: „AI gut nutzen“ vs. „gut in der Arbeit sein“ in AI-Diskussionen: Ein großes Problem in AI-Diskussionen in sozialen Medien ist die Diskrepanz zwischen der Fähigkeit, „AI gut zu nutzen“, und der Fähigkeit, „gut in der eigenen Arbeit zu sein“. Viele Experten mögen hervorragend in der AI-Anwendung sein, während andere dies nicht sind, was zu Schwierigkeiten im gegenseitigen Verständnis führt. Dieser Unterschied unterstreicht die Notwendigkeit der Integration von Fähigkeiten über verschiedene Bereiche hinweg im Zeitalter der AI (Quelle: nptacek)

Thema: ChatGPT Pulse Update-Feedback: Benutzer erwarten gamifizierte Prompts und Funktionsunterstützung: Benutzer diskutieren aktiv das ChatGPT Pulse Update, teilen ihre als „Game Changer“ empfundenen Prompts und weisen auf derzeit nicht unterstützte Funktionen hin. Diese Diskussionen konzentrieren sich darauf, wie das ChatGPT-Erlebnis optimiert, Interaktionen personalisiert und Erwartungen an neue Funktionen und Verbesserungen bestehender Funktionen erfüllt werden können, was den Wunsch der Benutzer nach tieferer Anpassung und Unterstützung durch AI-Assistenten widerspiegelt (Quelle: ChristinaHartW, _samirism, nickaturley)

Thema: Warnung: cairosvg in Produktionsumgebungen vermeiden, DoS-Risiko: Ein Entwickler warnt davor, cairosvg in Produktionsumgebungen zu verwenden, da es bei der Analyse falsch formatierter SVG-Dateien in eine Endlosschleife geraten und so zu einem Denial-of-Service (DoS)-Angriff führen kann. Dies erinnert Entwickler daran, bei der Auswahl von Bibliotheken neben der Funktionalität auch deren Stabilität und Sicherheit in Produktionsumgebungen genau zu beachten (Quelle: vikhyatk)

Thema: LLM-Schreibstil und „Model Collapse“: Die Community kritisiert die übermäßige Verwendung rhetorischer Mittel wie „Dies ist nicht X, dies ist Y“ durch LLMs und argumentiert, dass Modelle Muster ohne Kontext kopieren, was zu einer Verschlechterung der Schreibqualität führt und dies mit dem Phänomen des „Model Collapse“ in Verbindung bringt. Dieses Phänomen zeigt, dass LLMs Einschränkungen in Bezug auf die Qualität der Trainingsdaten und das Musterverständnis aufweisen, was ihre Leistung bei komplexen Schreibaufgaben beeinträchtigen kann (Quelle: Reddit r/LocalLLaMA, Reddit r/artificial)

Thema: AI verschärft den „Matthäus-Effekt“ am Arbeitsplatz, vergrößert die Kluft zwischen Top-Mitarbeitern und Durchschnittsmitarbeitern: Das Wall Street Journal weist darauf hin, dass AI die Kluft zwischen Top-Mitarbeitern und Durchschnittsmitarbeitern weiter vergrößern wird. Top-Mitarbeiter können aufgrund ihres Fachwissens und ihrer effizienten Gewohnheiten AI-Tools früher und tiefer nutzen, effiziente Workflows aufbauen und AI-Vorschläge besser beurteilen. Durchschnittliche Mitarbeiter hingegen neigen dazu, auf klare Anweisungen zu warten, und ihre AI-unterstützten Ergebnisse werden oft der Technologie statt der persönlichen Fähigkeit zugeschrieben, was den „Matthäus-Effekt“ am Arbeitsplatz verstärkt (Quelle: dotey)

Thema: Benutzer zweifeln, ob AI den Menschen sinnvoll ersetzen kann: Einige Benutzer äußern, dass LLMs zwar in puncto Geschwindigkeit hervorragend sind, aber immer noch Mängel beim Befolgen spezifischer Anweisungen, der Verarbeitung komplexer Kontexte und der Vermeidung fragmentierter Texte aufweisen. Benutzer glauben, dass Menschen im Durchschnitt immer noch besser im Kontextverständnis und der Ausführung von Anweisungen sind als AI, und äußern daher Zweifel, ob AI den Menschen sinnvoll ersetzen kann. Sie fordern, dass die AI-Entwicklung mehr Wert auf Zuverlässigkeit und Konsistenz legen sollte (Quelle: Reddit r/ClaudeAI)

Thema: Sora 2 löst Bedenken hinsichtlich der Authentizität von AI-generierten Inhalten und ethische Kontroversen aus: Die Community äußert Bedenken hinsichtlich der Verbreitung von AI-Videogenerierungstools wie Sora 2 und befürchtet, dass ihre hochrealistischen Ausgaben zur Erstellung von Fehlinformationen und Streichen verwendet werden könnten, was das Vertrauen der Öffentlichkeit in AI untergraben würde. Zum Beispiel verbreitete sich ein Video über einen „AI-Obdachlosen-Streich“ in sozialen Medien und erhielt zahlreiche Likes, was die Herausforderungen bei der Überprüfung der Authentizität von AI-Inhalten und die potenziellen negativen sozialen Auswirkungen verdeutlicht (Quelle: Reddit r/artificial, Reddit r/artificial)

Thema: AI-Richter lösen Debatte über Gerechtigkeit und Ethik in der Justiz aus: Zwei US-Bundesrichter, die AI zur Unterstützung bei der Ausarbeitung von Gerichtsbeschlüssen einsetzten, lösten eine hitzige Debatte über die Rolle von AI in der Justiz aus. Befürworter argumentieren, dass AI die Arbeit der Gerichte vereinfachen und den Zugang zu Rechtsdienstleistungen verbessern kann; Kritiker warnen jedoch vor möglichen Fehlern von AI und dem Mangel an der für die Justiz notwendigen „gemeinsamen Menschlichkeit“, was Empathie und Fairness beeinträchtigen könnte. China und Estland haben bereits Experimente mit AI-Richtern durchgeführt, was auf bedeutende Veränderungen im zukünftigen Justizsystem hindeutet (Quelle: Reddit r/ArtificialInteligence)

Thema: Diskussion über ChatGPTs Unterstützung für die psychische Gesundheit von Benutzern: Reddit-Benutzer teilen persönliche Erfahrungen mit ChatGPT als kreatives Ventil und emotionales Unterstützungstool, insbesondere im Umgang mit Traumata und psychischen Schwierigkeiten. Sie sind der Meinung, dass AI einen sicheren privaten Raum bietet, der ihnen hilft, Einsamkeit und Angst zu bewältigen, und fordern AI-Unternehmen auf, bei der Festlegung von Inhaltsbeschränkungen die vielfältigen Gesundheits- und kreativen Nutzungsbedürfnisse erwachsener Benutzer zu berücksichtigen, um negative Auswirkungen durch übermäßige Einschränkungen zu vermeiden (Quelle: Reddit r/ChatGPT)

Thema: ChatGPT steckt in Endlosschleife fest – Bug entdeckt: Benutzer haben entdeckt und geteilt, dass ChatGPT bei der Beantwortung bestimmter Fragen (z. B. „Was ist das Seepferdchen-Emoji?“) in eine sich wiederholende, selbstreferenzielle Endlosschleife gerät. Dieses Phänomen löste Diskussionen und humorvolle Reaktionen in der Community aus und offenbart unerwartetes Verhalten und Einschränkungen von AI-Modellen bei der Verarbeitung bestimmter vager oder offener Fragen (Quelle: Reddit r/ChatGPT)

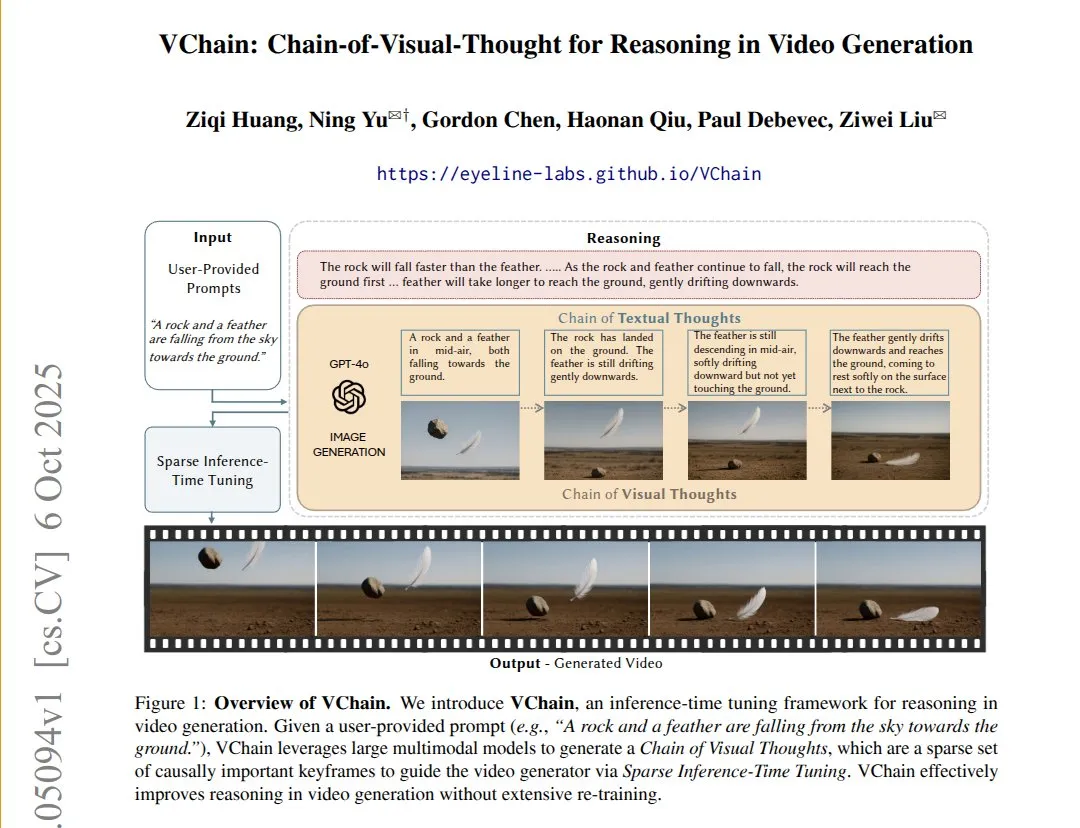

Thema: VChain: Verbesserung der kausalen Konsistenz von Text-zu-Video-Modellen durch Visual Chain of Thought: VChain ermöglicht es Text-zu-Video-Modellen, realen Kausalitäten zu folgen, indem während der Inferenz eine „Visual Chain of Thought“ (eine Reihe von Schlüsselbildern) injiziert wird. Diese Methode erfordert kein vollständiges erneutes Training, sondern nur wenige Schlüsselbilder und Fine-Tuning während der Inferenz, um die physikalische und kausale Konsistenz von Videos signifikant zu verbessern. Dies löst das Problem bestehender Videomodelle, die zwar eine hohe Glätte aufweisen, aber wichtige kausale Konsequenzen überspringen (Quelle: connerruhl)

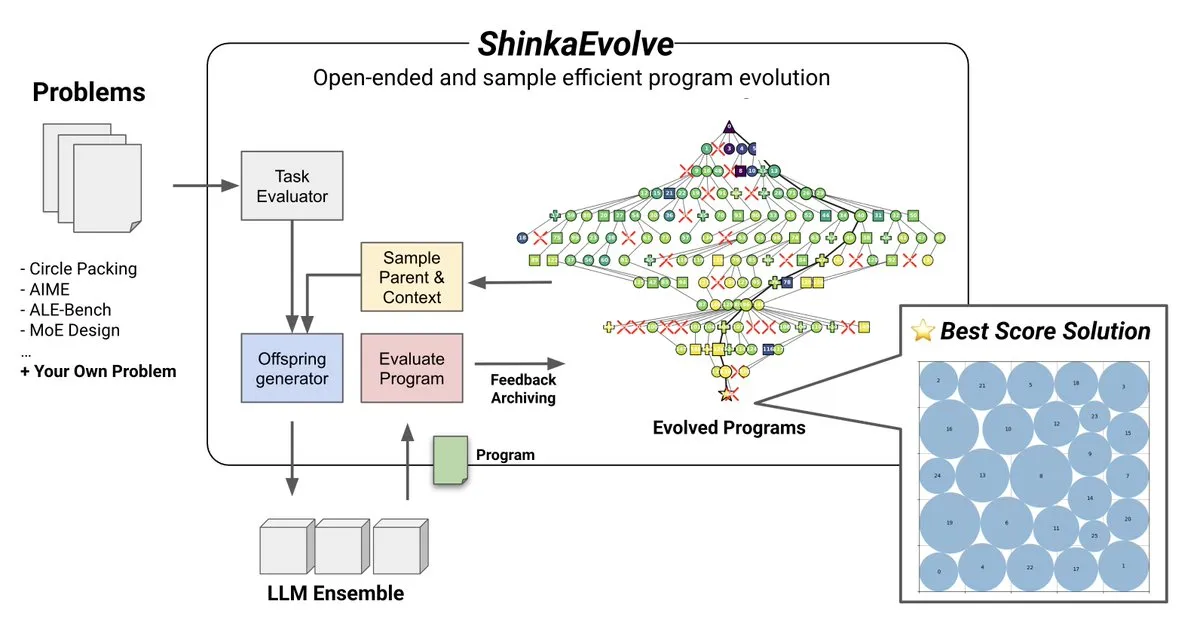

Thema: ShinkaEvolve: Open-Source-Methode für LLM-gesteuerte Programmentwicklung: Sakana AI hat ShinkaEvolve vorgestellt, eine Open-Source-, sample-effiziente, LLM-gesteuerte Methode zur Programmentwicklung, die darauf abzielt, die kritischen Herausforderungen effektiver Programmvariationen bei der offenen und sample-effizienten Entdeckung zu lösen. Dieses Framework nutzt LLMs als intelligente Rekombinationsoperatoren, um die Programmentwicklung in der wissenschaftlichen Entdeckung voranzutreiben, und wurde in der Praxis getestet, was neue Perspektiven für Methoden wie AlphaEvolve bietet (Quelle: hardmaru)

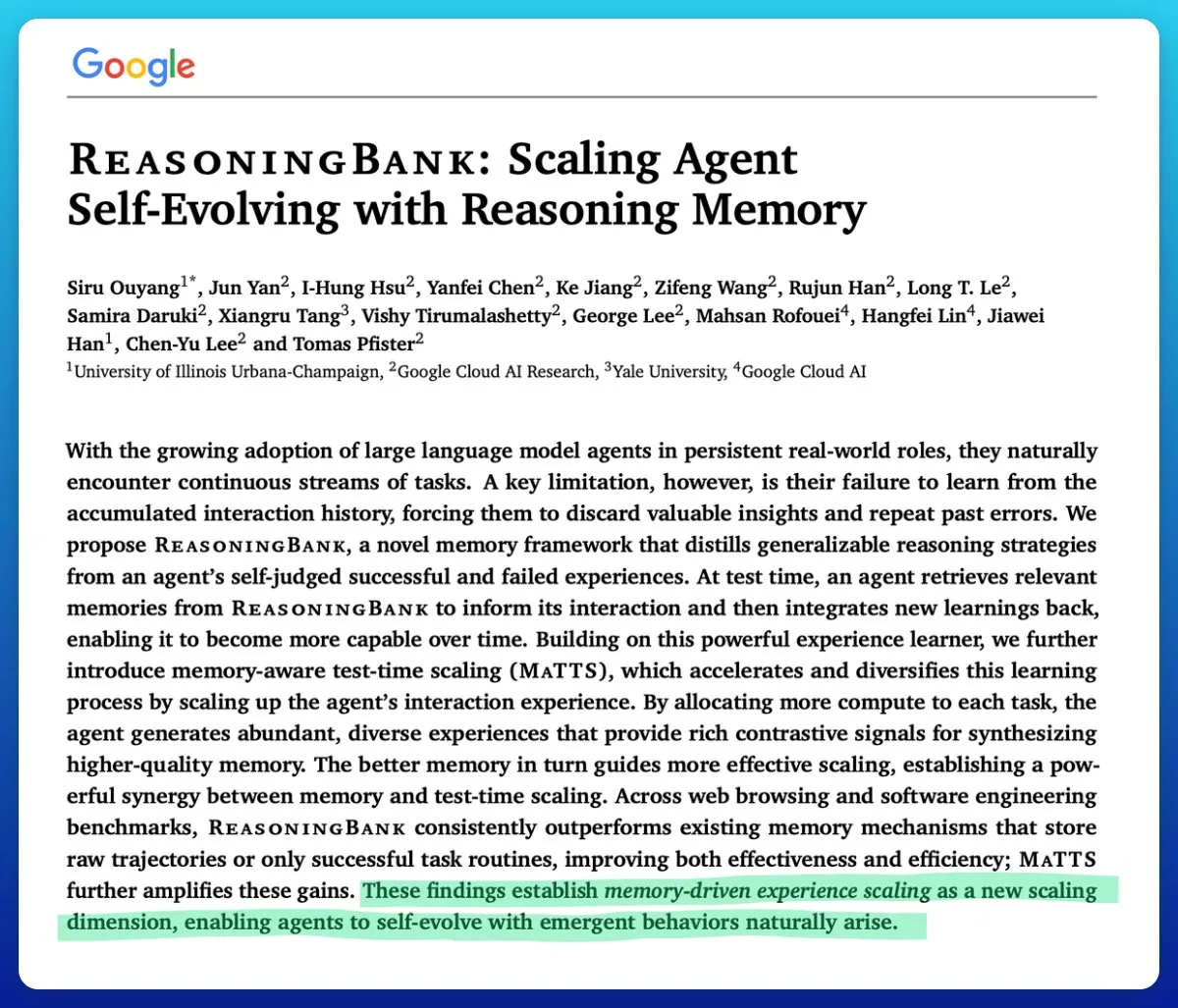

Thema: Google führt Memory-aware Test-Time Scaling-Technik ein, um die Effizienz von AI-Agents zu steigern: Google hat eine Memory-aware Test-Time Scaling-Technik vorgestellt, um selbstentwickelnde AI-Agents zu verbessern. Diese Technik nutzt strukturierte und adaptive Gedächtnismechanismen, um die Leistung von Agents signifikant zu steigern und andere Gedächtnismechanismen zu übertreffen. Dies löst ein Schlüsselproblem bei der effektiven Verwaltung des Gedächtnisses in AI-Agents (Quelle: omarsar0)

Thema: AMD ROCm Softwarequalität deutlich verbessert, MI300X wettbewerbsfähig bei Inferenz-Workloads: Die Community berichtet, dass die Softwarequalität von AMD ROCm seit Sommer 2024 einen „Quantensprung“ gemacht hat, mit deutlich weniger Bugs. Benchmarks zeigen, dass der MI300X vLLM bei Llama3 70B FP8 Inferenz-Workloads 5-10 % unter dem H100 vLLM in Bezug auf die Leistung pro TCO liegt, aber im Vergleich zwischen MI325X vLLM und H200 vLLM sowie GPTOSS MX4 120B Mi355 und B200 wettbewerbsfähig ist (Quelle: riemannzeta)

Thema: Nando de Freitas: Maschinen, die Wahrnehmung vorhersagen, sind der Keim des Bewusstseins: Nando de Freitas von Google DeepMind schlägt vor, dass Maschinen, die vorhersagen können, was Sensoren (Tastsinn, Kameras, Tastaturen, Temperatur, Mikrofone, Gyroskope usw.) wahrnehmen werden, bereits Bewusstsein und subjektive Erfahrung besitzen, und dies sei nur eine Frage des Grades. Er glaubt, dass mehr Sensoren, Daten, Berechnungen und Aufgaben unweigerlich zur Entstehung eines „Ich“ führen werden, was eine Diskussion darüber auslöst, wann Bewusstsein und Selbstbewusstsein beginnen (Quelle: TheRealRPuri)

Thema: Auswirkungen der Internet-Datenabschottung auf AI-Deep-Research-Agents: Es wird argumentiert, dass mit dem Aufkommen von LLMs die Internet-Daten zunehmend abgeschottet werden, was die Existenz von Deep-Research-Agents erschwert. Es wird die Frage aufgeworfen, ob ein LLM-Agent, der kein Wissen speichert, aber gut im Wissensabruf ist, realisiert werden kann, wenn der Datenzugriff eingeschränkt ist. Dies spiegelt Bedenken hinsichtlich der Datenoffenheit und -zugänglichkeit in der AI-Entwicklung wider (Quelle: Teknium1)

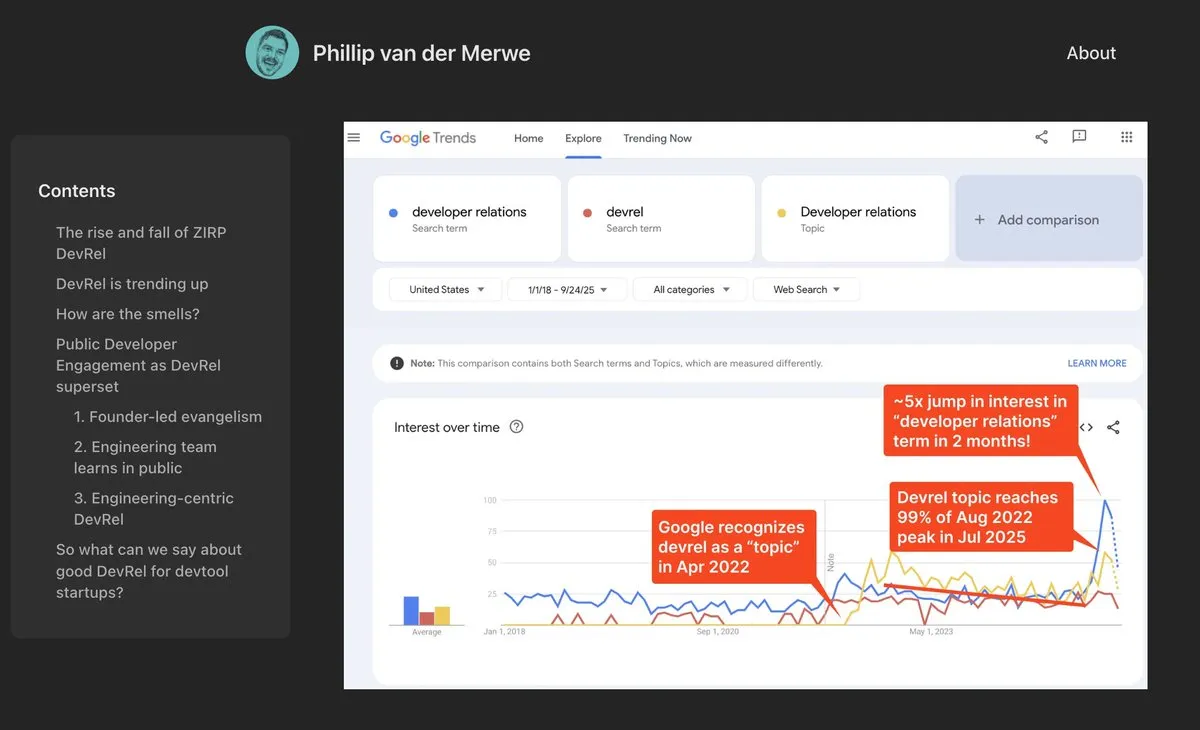

Thema: DevRel-Positionen erleben ein starkes Comeback im AI-Bereich: AI-Unternehmen wie Anthropic stellen hochbezahlte Developer Relations (DevRel)-Talente ein, was auf eine starke Wiederbelebung dieser Position im AI-Bereich hindeutet. Dies ist auf die wachsende Bedeutung von Prompt Engineering und Community-Engagement in der AI-Technologie zurückzuführen, wobei DevRel-Experten eine Schlüsselrolle bei der Verbindung von Entwicklern, der Förderung der Produktakzeptanz und dem Aufbau von Ökosystemen spielen (Quelle: swyx)

Thema: Jonathan Blow: AI-generierter Code ist von geringer Qualität und wird von AI nicht verstanden: Der bekannte Entwickler Jonathan Blow weist darauf hin, dass der von AI-Systemen ausgegebene Code von „sehr geringer Qualität“ ist und die AI selbst diesen Code nicht versteht. Er ist der Meinung, dass die Anwendungsfälle für AI-generierten Code hauptsächlich auf Szenarien beschränkt sind, die eine große Menge an minderwertigem Code erfordern. Dies löst eine Diskussion über die tatsächlichen Fähigkeiten und Grenzen von AI im Programmierbereich aus (Quelle: aiamblichus, jeremyphoward, teortaxesTex)

Thema: Kritik an AI-Hype-Posts: Forderung nach Transparenz und substanziellem Inhalt: Die Community äußert Unzufriedenheit über vage, übertriebene Hype-Posts zu AI-Fortschritten und fordert die Verfasser auf, konkretere, substanziellere Inhalte bereitzustellen und sogar „Whistleblowing“ zu betreiben, wenn es um bedeutende, lebensverändernde Fortschritte geht. Diese Stimmung spiegelt die Erwartungen der Öffentlichkeit an die Qualität von Informationen im AI-Bereich und die Abneigung gegen unverantwortliche „vage Propaganda“ wider (Quelle: aiamblichus, Teknium1)

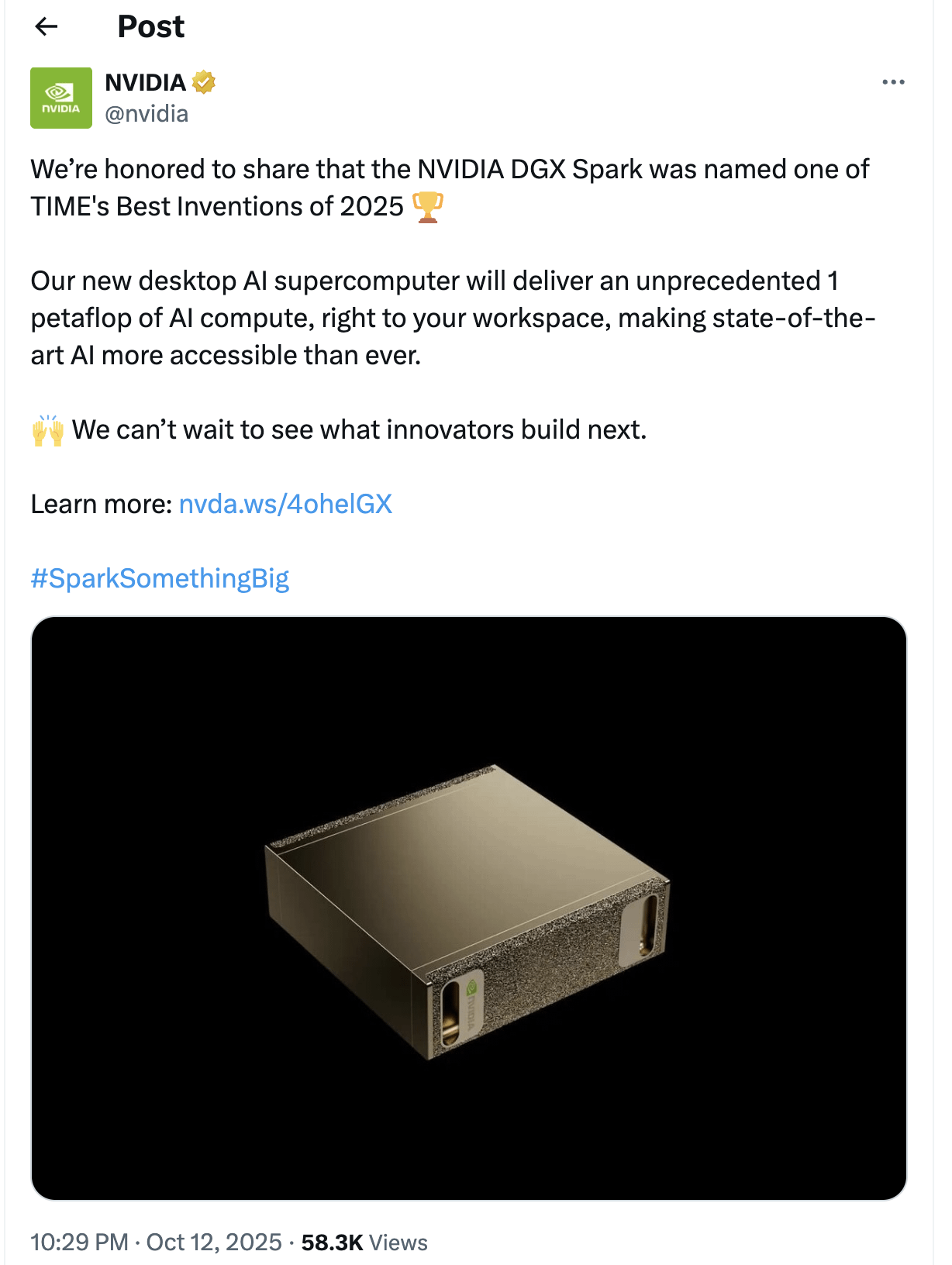

Thema: Fragen und Erwartungen an NVIDIA DGX Spark: Die Community äußert Skepsis gegenüber der Veröffentlichung des „Desktop AI Supercomputers“ NVIDIA DGX Spark und hinterfragt dessen Zugänglichkeit, Preis und tatsächliche Leistung, insbesondere für die Ausführung lokaler LLMs. Viele halten die Werbung für übertrieben, die Leistung möglicherweise nicht den Erwartungen entsprechend, und die wiederholte Verzögerung der Veröffentlichung veranlasst einige Benutzer, sich anderen Lösungen zuzuwenden (Quelle: Reddit r/LocalLLaMA)

💡 Sonstiges

Thema: Yunpeng Technology stellt neue AI+Gesundheitsprodukte vor, fördert intelligente häusliche Gesundheitsverwaltung: Yunpeng Technology hat in Zusammenarbeit mit Shuaikang und Skyworth das „Digitale Zukunftsküchenlabor“ und einen intelligenten Kühlschrank mit einem AI-Gesundheits-Large Model vorgestellt. Der intelligente Kühlschrank bietet über den „Gesundheitsassistenten Xiaoyun“ eine personalisierte Gesundheitsverwaltung und optimiert das Küchendesign und den Betrieb. Diese Veröffentlichung markiert einen Durchbruch von AI im Bereich der täglichen Gesundheitsverwaltung und verspricht, personalisierte Gesundheitsdienste durch intelligente Geräte zu ermöglichen und die Lebensqualität der Bewohner zu verbessern (Quelle: 36氪)

Thema: Nobelpreis-Material MOF wird zu gehirnähnlichem Nanofluidik-Chip verarbeitet: Wissenschaftler der Monash University haben erfolgreich einen ultra-miniaturisierten Nanofluidik-Chip unter Verwendung des Nobelpreis-Materials MOF (Metal-Organic Framework) hergestellt. Dieser Chip kann nicht nur reguläre Berechnungen durchführen, sondern auch wie neuronale Zellen im Gehirn frühere Spannungsänderungen speichern und lernen, wodurch ein Kurzzeitgedächtnis entsteht. Diese bahnbrechende Errungenschaft löst das langjährige Problem der fehlenden praktischen Anwendungen von MOF-Materialien und bietet ein völlig neues Paradigma für die nächste Generation von Computern und gehirnähnlichen Berechnungen (Quelle: 量子位)

Thema: Globale Robotik-Innovation und -Anwendung beschleunigen sich: Der Bereich der Robotik erlebt mehrere innovative Durchbrüche und breite Anwendungen. Knightscopes autonome Sicherheitsroboter verändern den Sicherheitssektor, und China hat Hochgeschwindigkeits-Kugelpolizeiroboter eingeführt, die Kriminelle autonom fangen können. AgiBot hat den humanoiden Roboter Lingxi X2 mit nahezu menschlicher Bewegungsfähigkeit und multifunktionalen Fertigkeiten vorgestellt und das weltweit größte Trainingszentrum für humanoide Roboter eingerichtet, um deren soziale Integration und Anwendung zu beschleunigen. Darüber hinaus zeigen tragbare Kraftverstärkungsroboter für Industriearbeiter und vierbeinige Roboter, die 100 Meter in 10 Sekunden laufen können, das Potenzial der Robotertechnologie in verschiedenen Szenarien (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)