Schlüsselwörter:Quanten-KI, GPT-5, Gemini 2.5, KI-Agenten, Imagine v0.9, Sora 2, Quantencomputer, Google Quanten-KI Nobelpreis, Wissenschaftliche Anwendungen von GPT-5, Gemini 2.5 Computernutzung, xAI Imagine Videogenerierung, OpenAI Sora 2 Vorschauversion

🔥 Fokus

Google Quanten-KI-Wissenschaftler erhalten Nobelpreis für Physik: Michel Devoret, Chefwissenschaftler von Google Quantum AI, sowie seine Teammitglieder John Martinis und John Clarke wurden für ihre bahnbrechende Arbeit im Bereich der Quantenmechanik mit dem Nobelpreis für Physik 2025 ausgezeichnet. Ihre Forschung ebnet den Weg für fehlerkorrigierende Quantencomputer und unterstreicht Googles langfristiges Engagement und seine führende Position im Bereich der Quanten-KI, was einen wichtigen Meilenstein in diesem Feld darstellt. (Quelle: Google, demishassabis, Yuchenj_UW)

GPT-5 zeigt bahnbrechendes Potenzial in der wissenschaftlichen Forschung: Kevin Weil berichtet, dass GPT-5 eine wichtige Schwelle überschritten hat. Wissenschaftler konnten GPT-5 erfolgreich anleiten, neuartige Forschung in Bereichen wie Mathematik, Physik, Biologie und Informatik durchzuführen. Obwohl es sich noch in der “Lemma”-Phase befindet, ist seine Fähigkeit, unter Expertenanleitung begrenzte originelle wissenschaftliche Arbeit zu leisten, ermutigend und deutet auf das enorme Potenzial von KI hin, wissenschaftliche Entdeckungen zu beschleunigen. (Quelle: SebastienBubeck, ericmitchellai, BorisMPower, lateinteraction)

🎯 Trends

Google Gemini 2.5 Computer Use veröffentlicht: Google DeepMind hat das Modell Gemini 2.5 Computer Use vorgestellt, das es KI-Agenten ermöglicht, direkt über Klicks, Scrollen und Eingaben mit Webseiten und Anwendungen zu interagieren. Das Modell zeigt in mehreren Benchmarks eine führende Leistung, ist schneller und verfügt über mehrschichtige Sicherheitsmechanismen, um potenzielle Risiken zu mindern. Dies markiert einen bedeutenden Fortschritt für KI-Agenten bei der Simulation menschlicher Computerbedienung und deutet auf eine Revolution der zukünftigen Mensch-Computer-Interaktion hin. (Quelle: 36氪, GoogleAIStudio, demishassabis, abacaj, scaling01, dotey, algo_diver)

xAI veröffentlicht Videogenerierungsmodell Imagine v0.9: Elon Musks xAI hat sein neuestes Videogenerierungsmodell Imagine v0.9 veröffentlicht, das allen Nutzern kostenlos zur Verfügung steht. Das Modell bietet Verbesserungen bei der visuellen Qualität, Bewegung und Audioerzeugung, generiert schnell Inhalte und unterstützt benutzerdefinierte Sprachfunktionen. Obwohl es bei der komplexen Prompt-Verständnis und der chinesischen Sprachunterstützung noch Mängel aufweist und Deepfake-Risiken birgt, hat seine kostenlose Verfügbarkeit und schnelle Generierungsfähigkeit große Aufmerksamkeit erregt und tritt in direkten Wettbewerb mit OpenAIs Sora 2. (Quelle: 36氪, scaling01, nptacek, op7418, nptacek, TomLikesRobots)

ChatGPT integriert App-Funktionen: OpenAI hat auf dem Developer Day bekannt gegeben, dass ChatGPT jetzt die Einbettung von Apps wie Booking.com, Canva und Spotify unterstützt. Nutzer können diese direkt über Prompts aufrufen oder von ChatGPT je nach Bedarf empfehlen lassen. Diese Anwendungen fügen sich nahtlos in die Konversation ein und bieten interaktive Oberflächen. OpenAI hat außerdem ein Apps SDK eingeführt, um Entwickler zum Bauen und Testen von Anwendungen zu ermutigen, und plant die Einführung eines speziellen App-Verzeichnisses, um das KI-Anwendungsökosystem zu vertiefen. (Quelle: 量子位, TheRundownAI)

GPT-5 Pro und GPT-Realtime-Mini veröffentlicht: OpenAI hat auf dem Developer Day den API-Zugang für GPT-5 Pro freigegeben, mit einem Preis von 15 US-Dollar pro 1 Million Input-Tokens und 120 US-Dollar pro 1 Million Output-Tokens, was sowohl Leistung als auch Preis über GPT-5 und o3-pro ansiedelt. Gleichzeitig wurde das kleinere und günstigere Sprachmodell GPT-Realtime-Mini eingeführt, das die gleiche Sprachqualität und Ausdruckskraft wie bestehende Sprachmodelle bietet, aber 70 % günstiger ist. (Quelle: 量子位, TheRundownAI)

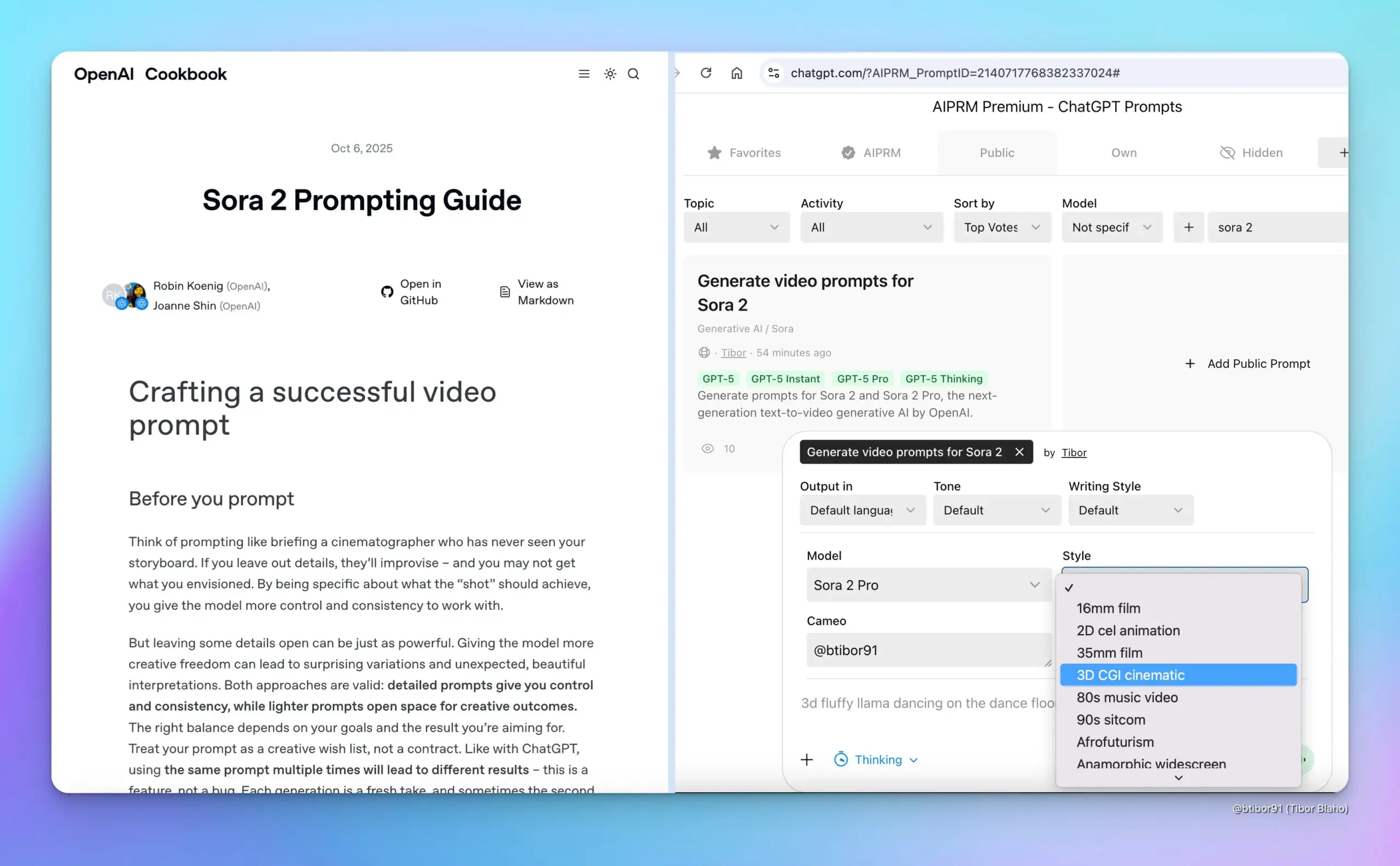

Sora 2 Preview veröffentlicht: OpenAI hat auf dem Developer Day eine Vorschau auf Sora 2 veröffentlicht, die dessen Fähigkeiten bei der synchronen Audio- und Videogenerierung sowie der Steuerung von Videolänge, Seitenverhältnis und Auflösung demonstriert. Dieser Fortschritt festigt OpenAIs führende Position im Bereich der Videogenerierung weiter, bietet Kreativen leistungsfähigere Tools und deutet auf eine enorme Veränderung in der zukünftigen Videocontent-Erstellung hin. (Quelle: 量子位, TheRundownAI)

Open-Source MoE-Modell LFM2-8B-A1B veröffentlicht: Liquid AI hat sein erstes On-Device MoE-Modell LFM2-8B-A1B veröffentlicht, mit insgesamt 8,3 Milliarden Parametern, wobei pro Token nur 1,5 Milliarden Parameter aktiviert werden. Das Modell ist qualitativ mit 3-4 Milliarden dichten Modellen vergleichbar, läuft aber schneller als Qwen3-1.7B und wurde speziell für Geräte wie Mobiltelefone/Laptops entwickelt. Es wurde mit 12 Billionen Tokens vortrainiert und zeigt hervorragende Leistungen in Mathematik, Code und IF. (Quelle: huggingface, huggingface, mervenoyann, tokenbender, dl_weekly, teortaxesTex, Plinz)

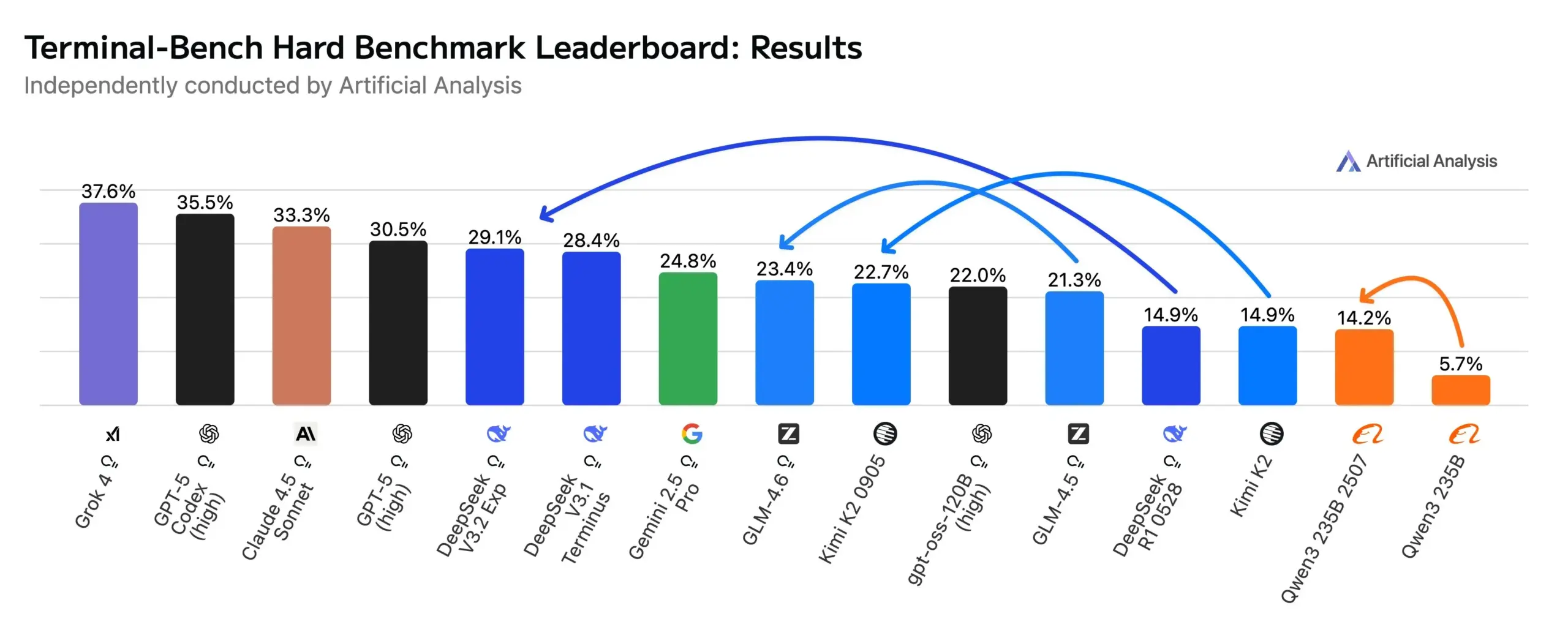

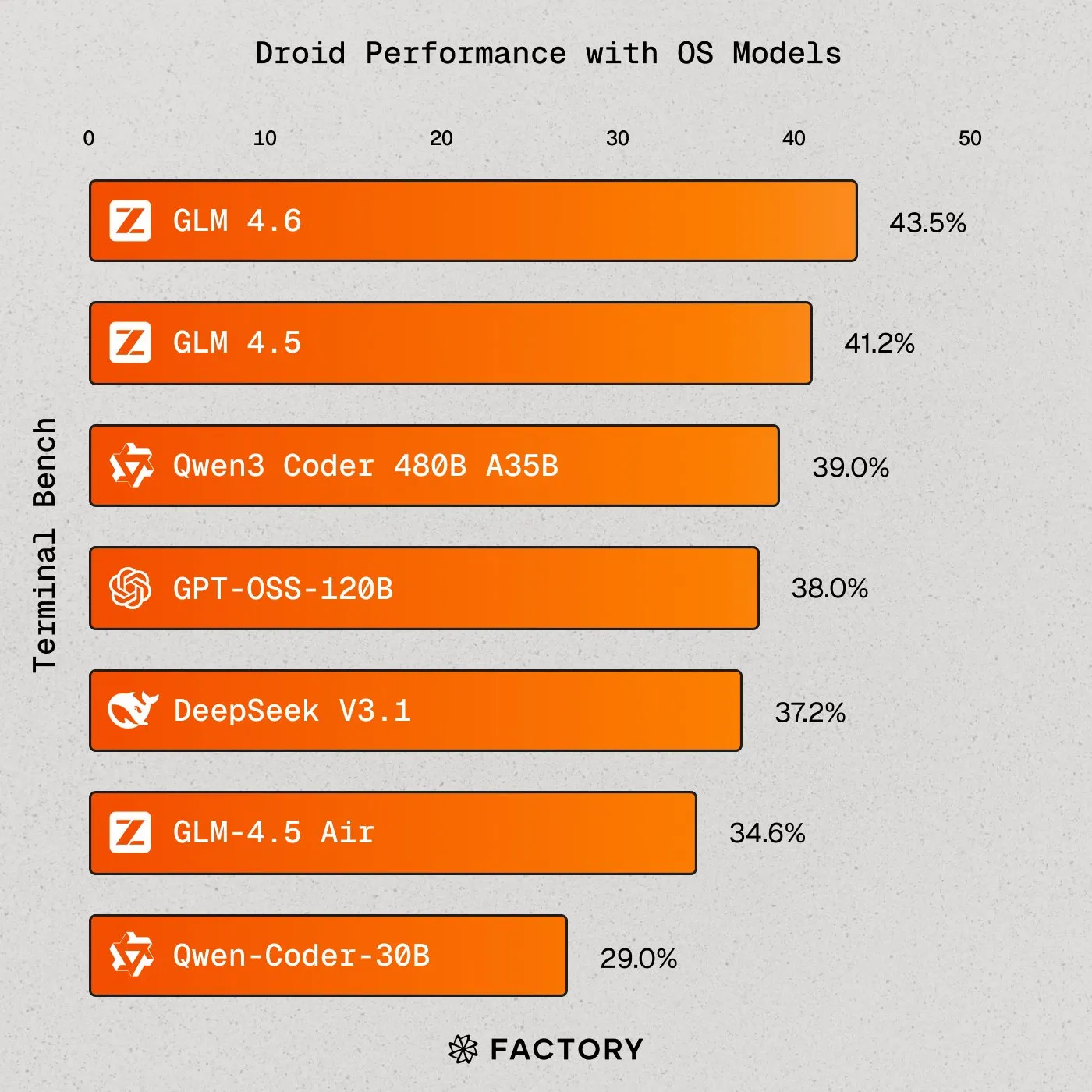

Open-Source AI-Modelle nähern sich führenden Modellen bei Agentic Workflows: Open-Source-Modelle wie DeepSeek V3.2 Exp, Kimi K2 0905 und GLM-4.6 haben bei der Bewertung von Agentic Coding und Terminal-Nutzung (Terminal-Bench Hard) erhebliche Fortschritte gemacht, wobei DeepSeek sogar Gemini 2.5 Pro übertrifft. Dies zeigt eine deutliche Steigerung der Fähigkeiten von Open-Source-Modellen in Agenten-Anwendungsszenarien, bietet Entwicklern eine breitere Auswahl und fördert den offenen Wettbewerb im KI-Bereich. (Quelle: huggingface)

Meta präsentiert AI-Brille und neuronales Armband: Meta hat eine AI-Brille mit integriertem Display vorgestellt, die über ein neuronales Armband gesteuert wird, das Muskelsignale liest. Mark Zuckerberg diskutierte das Potenzial dieser Brillen, Telefone zu ersetzen, Superintelligenz und das Metaverse zu ermöglichen. Dies zeigt Metas Vision für KI in tragbaren Geräten und zukünftiger Mensch-Computer-Interaktion und unterstreicht die innovative Richtung der KI-Hardware-Integration. (Quelle: rowancheung)

Fortschritte bei der Anwendung von KI in der medizinischen Diagnose: TuringPost berichtet über die Anwendung von KI in der Krebsdiagnose, insbesondere über das PathologyMap™-System von HistoWiz, das hochauflösende digitale Pathologiebilder analysiert, um Tumormuster zu identifizieren. In den nächsten 2-3 Jahren werden voraussichtlich FDA-zugelassene unterstützende KI-Systeme, die Digitalisierung von Millionen von Objektträgern in Krankenhäusern und die Verbreitung hochpräziser Diagnosen zu sehen sein, was das enorme Potenzial von KI im Gesundheitswesen verdeutlicht. (Quelle: TheTuringPost, TheTuringPost)

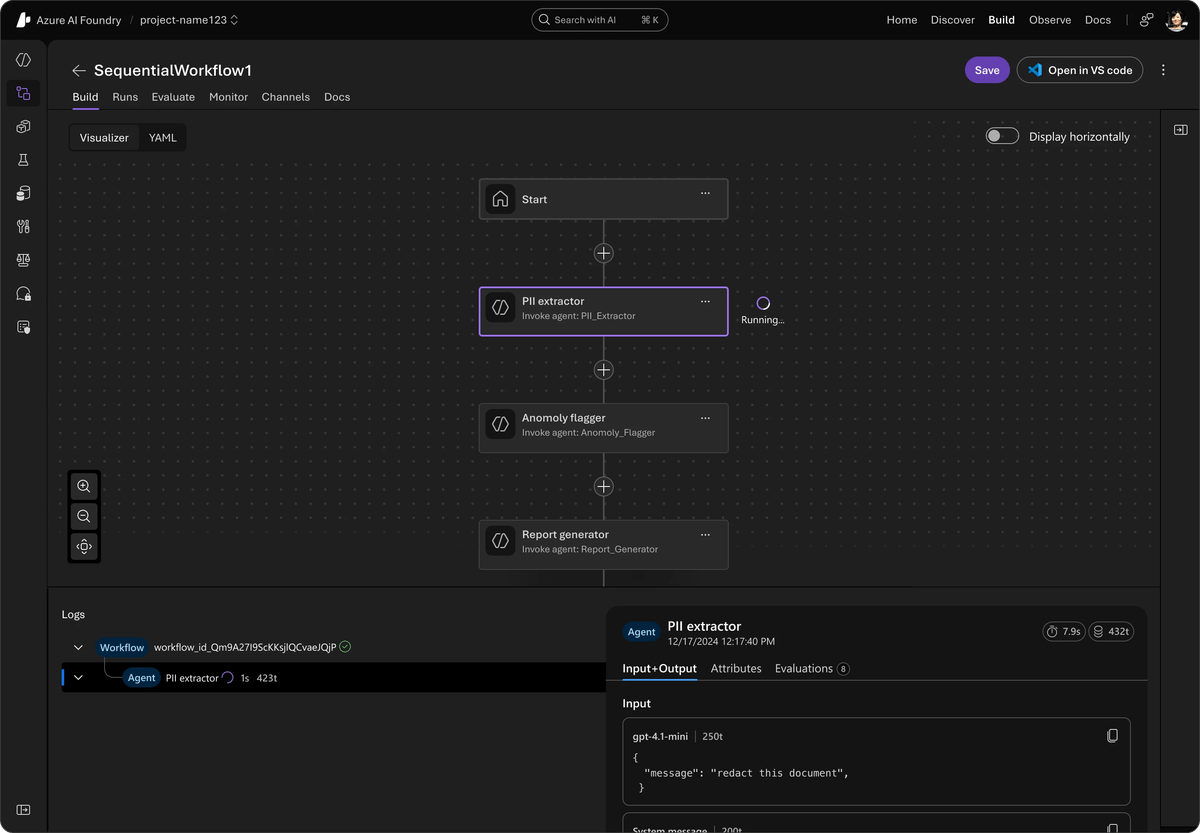

Microsoft stellt Agent Framework vor: Microsoft hat das Agent Framework veröffentlicht, ein einheitliches Open-Source-SDK, das AutoGen und Semantic Kernel integriert, um Multi-Agenten-KI-Systeme auf Unternehmensebene zu entwickeln. Das Framework unterstützt Azure AI Foundry, vereinfacht Orchestrierung und Beobachtbarkeit, ist mit jeder API kompatibel und bietet langfristige Prozesse, Cross-Framework-Tracing sowie Tools für verantwortungsvolle KI, um die Entwicklung und Bereitstellung von KI-Agenten auf Unternehmensebene voranzutreiben. (Quelle: TheTuringPost)

🧰 Tools

LlamaIndex fördert codebasierte Agenten-Workflows: jerryjliu0 betont das Potenzial von codebasierter Orchestrierung und Coding Agents, um die Lücke zwischen Low-Code- und fortgeschrittenen Anwendungen zu schließen. LlamaIndex’s AgentKit unterstützt den Aufbau von Prozessen wie Dokumentenvergleich und grundlegenden Assistenten und kann zur Wartung als Code exportiert werden. Die neueste LlamaAgents Alpha-Version ermöglicht die Bereitstellung benutzerdefinierter Code-Workflows auf LlamaCloud, unterstützt Zustandsverwaltung, Checkpoints und Mensch-KI-Kollaboration. (Quelle: jerryjliu0, jerryjliu0)

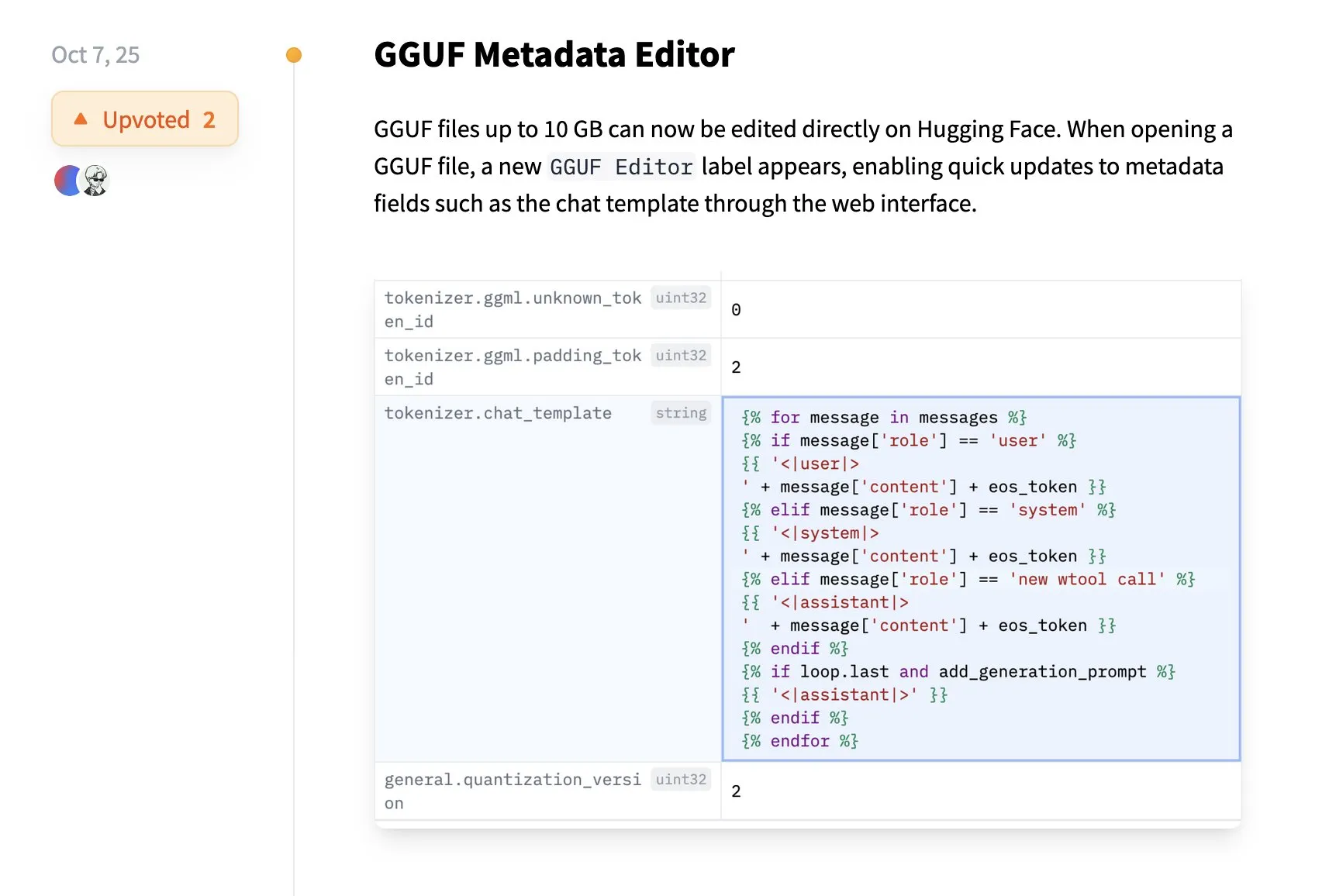

Hugging Face unterstützt direkte Bearbeitung von GGUF-Metadaten: Die Hugging Face-Plattform bietet eine neue Funktion, mit der Benutzer GGUF-Modellmetadaten direkt auf Hugging Face bearbeiten können, ohne das Modell lokal herunterladen zu müssen. Diese Verbesserung vereinfacht die Modellverwaltung und Kollaborationsprozesse, verbessert die Benutzererfahrung und ist insbesondere für Entwickler eine Erleichterung, die durch die Xet-Datenübertragungstechnologie ermöglicht wird. (Quelle: huggingface)

DevinAI: Autonomer AI-Softwareingenieur: Cognitions DevinAI wird als der weltweit fortschrittlichste autonome AI-Softwareingenieur beworben, der Bugs, Feature-Entwicklung und komplexe Refactorings bearbeiten sowie Pull Requests zur Überprüfung generieren kann. Er wird von mehreren Unternehmenskunden als effizienter “Code-Contributor” gelobt, der die Entwicklungseffizienz erheblich steigern kann und verschiedene Aufgaben von QA bis Datenanalyse abdeckt, was eine disruptive Veränderung in der Softwareentwicklung mit sich bringt. (Quelle: cognition)

Imbue stellt Sculptor für parallele Coding Agents vor: Imbue hat Sculptor veröffentlicht, ein Tool, das es Benutzern ermöglicht, mehrere Coding Agents in unabhängigen Containern auszuführen und Codeänderungen im “Pairing Mode” einfach zu überprüfen. Dieses Tool soll die Arbeitsweise paralleler Coding Agents unterstützen, die Entwicklungseffizienz steigern, insbesondere bei komplexen Aufgaben, und Entwicklern eine flexiblere und effizientere Programmiererfahrung bieten. (Quelle: kanjun)

Factory AI unterstützt Open-Source-Modelle für Droids: Factory AI hat angekündigt, dass seine Droids jetzt mit jedem Open-Source-Modell betrieben werden können und auf Terminal-Bench die höchste Punktzahl aller Open-Source-Modelle erreicht haben, wobei GLM 4.6 besonders hervorstach und sogar Claude Code’s Sonnet 4 übertraf. Dies bietet Entwicklern größere Flexibilität und leistungsfähigere Optionen und fördert die Entwicklung von Open-Source-KI-Agenten. (Quelle: matanSF, scaling01, Zai_org, QuixiAI)

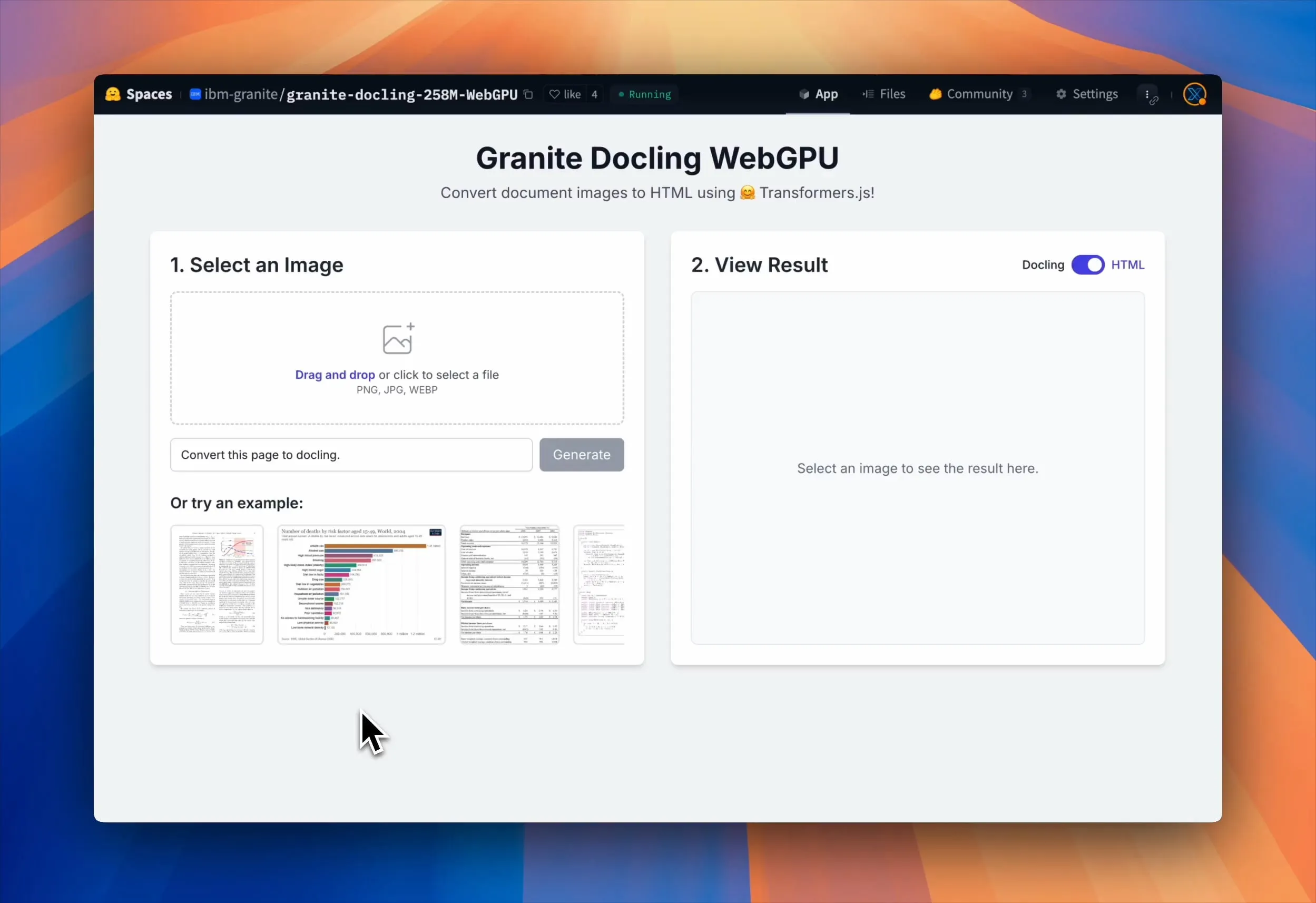

Granite Docling WebGPU ermöglicht In-Browser-Dokumentenanalyse: IBM hat Granite Docling veröffentlicht, ein VLM mit 258 Millionen Parametern für effiziente Dokumentenkonvertierung. Das Modell kann jetzt zu 100 % lokal im Browser über WebGPU-Beschleunigung ausgeführt werden, ohne dass Daten an einen Server gesendet werden müssen, was Datenschutz und Sicherheit gewährleistet. Dies bietet Benutzern eine kostenlose, effiziente und sichere Dokumentenverarbeitungslösung, insbesondere für private und sensible Dateien. (Quelle: Reddit r/LocalLLaMA, huggingface, mervenoyann)

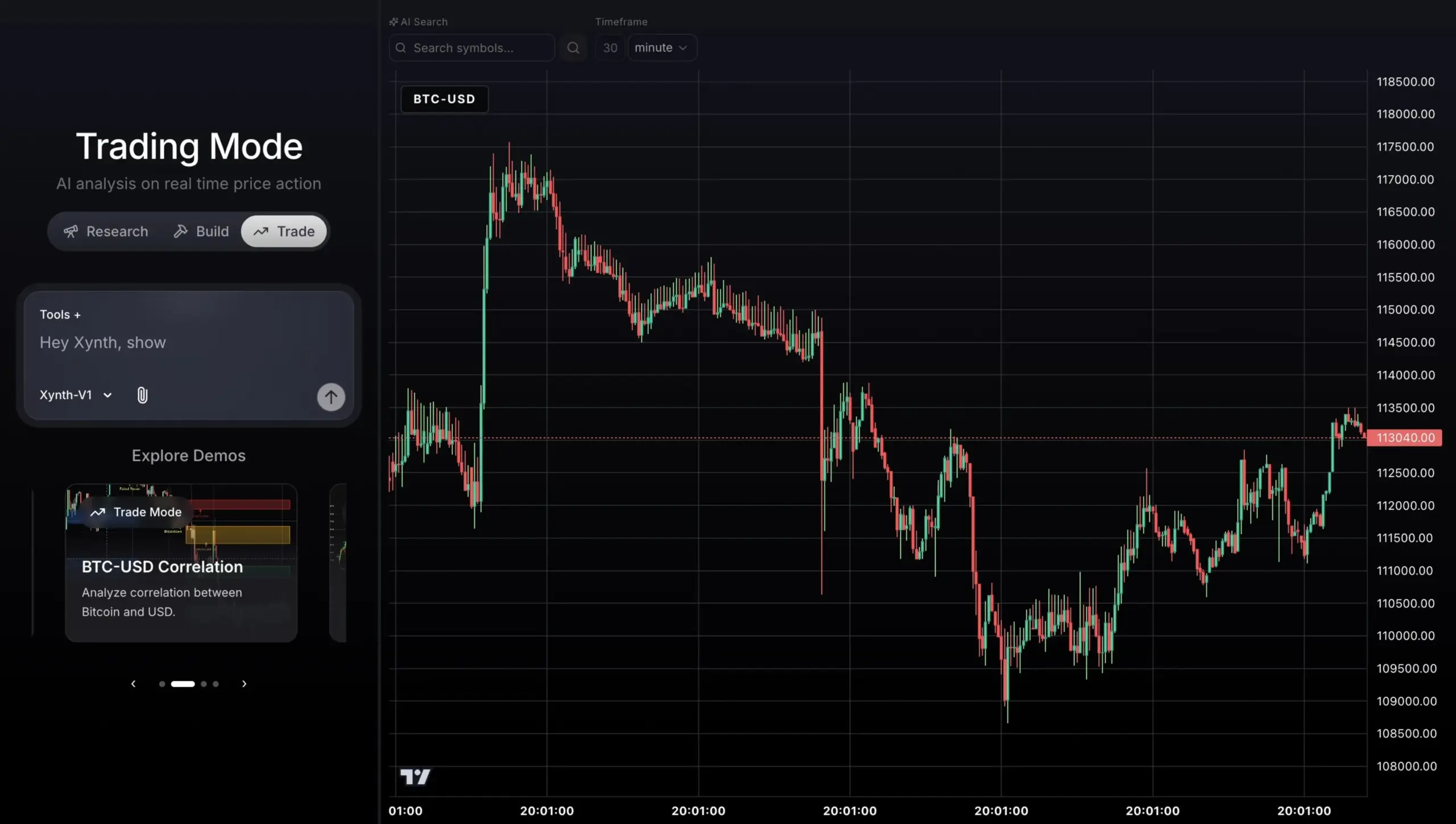

GPT-5-gesteuerter Handelsagent für Echtzeit-Marktdaten: Ein auf GPT-5 basierendes Handelsagentenprojekt, das mit Python SDK, FastAPI und Next.js erstellt wurde, kann sich mit AlphaVantages Echtzeit-Marktdaten und TradingView-Charts verbinden, um Analysen, Signalgenerierung und Handelsausführung durchzuführen. Ziel des Agenten ist eine stabile, erklärbare Handelsleistung, anstatt blind hohe Renditen zu verfolgen, was das Anwendungspotenzial von KI im Finanzhandel aufzeigt. (Quelle: Reddit r/ChatGPT)

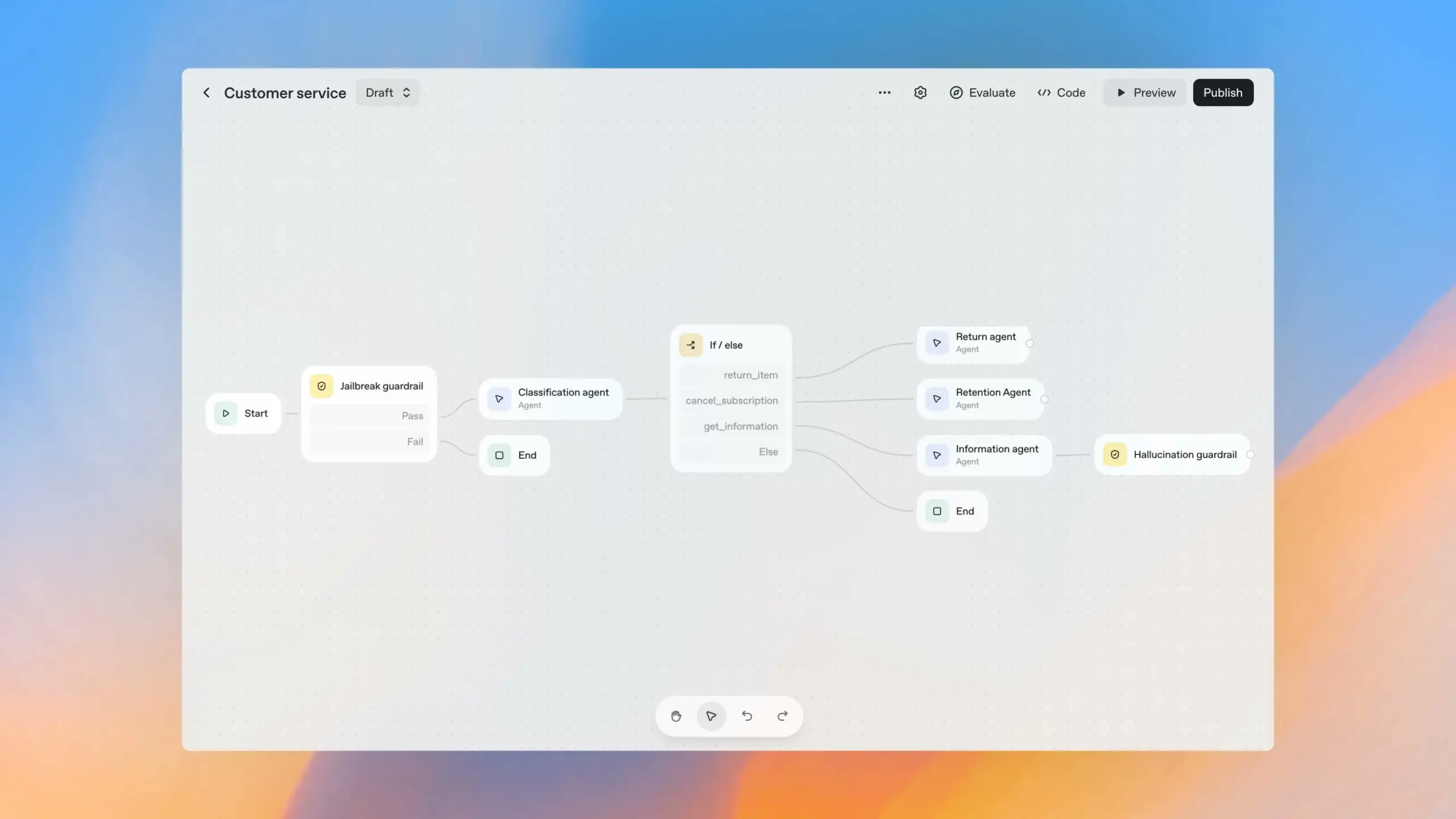

OpenAI AgentKit Toolkit: OpenAI hat auf dem Developer Day das AgentKit Toolkit vorgestellt, das Entwicklern und Unternehmen eine umfassende Suite von Tools zum Erstellen, Bereitstellen und Optimieren von Agenten bietet. AgentKit umfasst Module wie den visuellen Agent Builder, das Connector Registry und ChatKit, die durch Drag-and-Drop-Knoten, zentralisierte Verbindungsverwaltung und eine eingebettete Chat-Oberfläche den Entwicklungsprozess von KI-Agenten erheblich vereinfachen. (Quelle: 量子位, TheRundownAI)

OpenAI Codex offiziell veröffentlicht und neue Funktionen: OpenAI hat bekannt gegeben, dass sein KI-Programmierwerkzeug Codex jetzt allgemein verfügbar ist und drei neue Funktionen bietet: Die Slack-Integration ermöglicht Teams, Aufgaben direkt in Slack zu delegieren; das Codex SDK erlaubt Entwicklern, Codex-Agenten in Workflows einzubetten; und neue Verwaltungstools erleichtern Administratoren die Überwachung der Nutzung und der Code-Review-Qualität. Diese Updates zielen darauf ab, die Effizienz und Sicherheit von Codex in der Teamkollaboration und Softwareentwicklung zu verbessern. (Quelle: 量子位, TheRundownAI)

📚 Lernen

Andrew Ng startet Agentic AI-Kurs: Andrew Ng hat einen neuen Kurs namens “Agentic AI” veröffentlicht, der lehrt, wie man KI-Agenten baut. Er behandelt Kerndesignmuster wie Reflexion, Werkzeugnutzung, Planung und Multi-Agenten-Kollaboration. Der Kurs betont einen disziplinierten Prozess der Bewertung und Fehleranalyse, um die Verbesserung komplexer Agenten-Workflows zu leiten, und verwendet native Python-Programmierung auf anbieterneutrale Weise. (Quelle: AndrewYNg, DeepLearningAI, dotey)

Sora 2 Prompt-Leitfaden veröffentlicht: OpenAI hat einen Prompt-Leitfaden für Sora 2 veröffentlicht, der praktische Ratschläge zur Erstellung erfolgreicher Video-Prompts bietet. Der Leitfaden betont das Gleichgewicht zwischen detaillierter Beschreibung und kreativer Freiheit sowie spezifische Anleitungen zu Videoauflösung, Länge, Struktur, visuellen Hinweisen, Bewegung, Licht, Farbe, Dialog und Soundeffekten. Er stellt auch die Remix-Funktion zur iterativen Optimierung vor, um Benutzern zu helfen, die Videogenerierungstechnologie besser zu beherrschen. (Quelle: dotey)

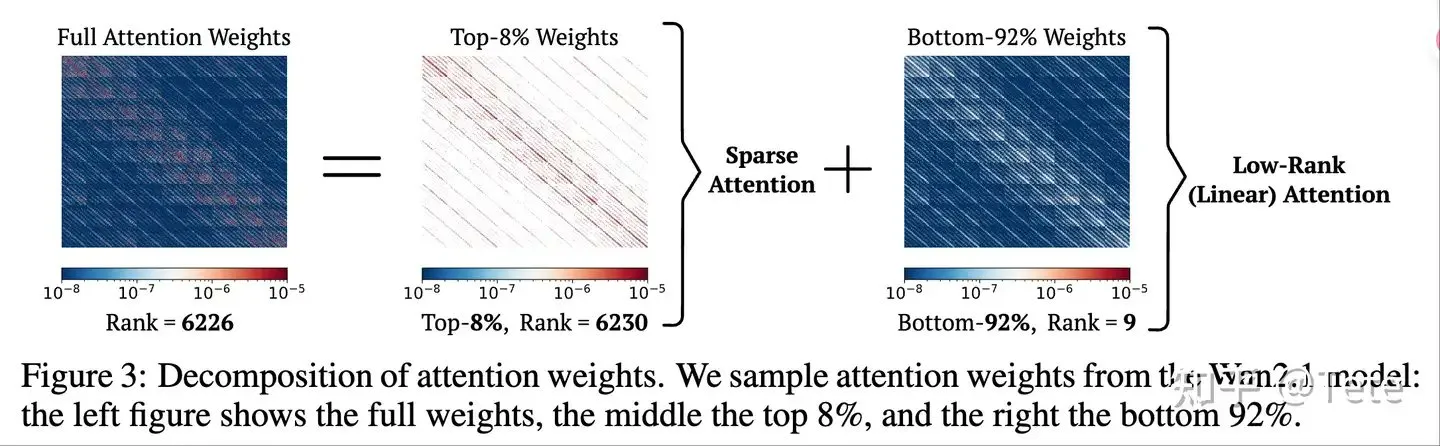

LLM-Inferenzoptimierung und Architekturbetrachtung: ZhihuFrontier diskutierte die Zukunft von Modellarchitekturen wie DeepSeek-V3.2-Exp und Qwen3-Next, wobei der Fokus auf dem Hybridmodus von Sparse Attention und Linear Attention lag. Die Kernidee ist, dass Sparse Attention (alles schreiben, intelligent lesen) und Hybridarchitekturen (wenige Full Attention-Layer + Linear Attention) ein Gleichgewicht zwischen Effizienz und Leistung bieten können, insbesondere bei der Langkontext-Wiederherstellung und dem KV-Cache. (Quelle: ZhihuFrontier)

Optimierungsmethoden für RL-verbesserte LLM-Inferenz: HuggingFace Daily Papers stellte zwei Optimierungsmethoden für Reinforcement Learning vor: Slow-Fast Policy Optimization (SFPO) und M2PO (Second-Moment Trust Policy Optimization). SFPO verbessert die Stabilität des LLM-Inferenz-RL-Trainings, reduziert Rollouts und beschleunigt die Konvergenz durch die Zerlegung der Aktualisierungsschritte. M2PO nutzt durch die Beschränkung des zweiten Moments der Wichtigkeitsgewichte abgelaufene Daten effektiv für ein stabiles Offline-Training, das die Leistung des Online-Trainings erreicht. (Quelle: HuggingFace Daily Papers, HuggingFace Daily Papers)

Umfassende Betrachtung der LLM-Datenschutzrisiken: Ein HuggingFace Daily Paper betont, dass die Datenschutzrisiken von LLMs weit über das wörtliche Auswendiglernen von Trainingsdaten hinausgehen. Sie umfassen auch die Datenerfassung, das Durchsickern von Kontext während der Inferenz, die autonome Fähigkeit von Agenten und die Überwachung durch Deep-Inferenz-Angriffe. Der Artikel fordert die Forschungsgemeinschaft auf, den Umfang der LLM-Datenschutzforschung zu erweitern und einen interdisziplinären Ansatz zu verfolgen, um diesen soziotechnischen Bedrohungen zu begegnen und die Privatsphäre der Nutzer umfassender zu schützen. (Quelle: HuggingFace Daily Papers)

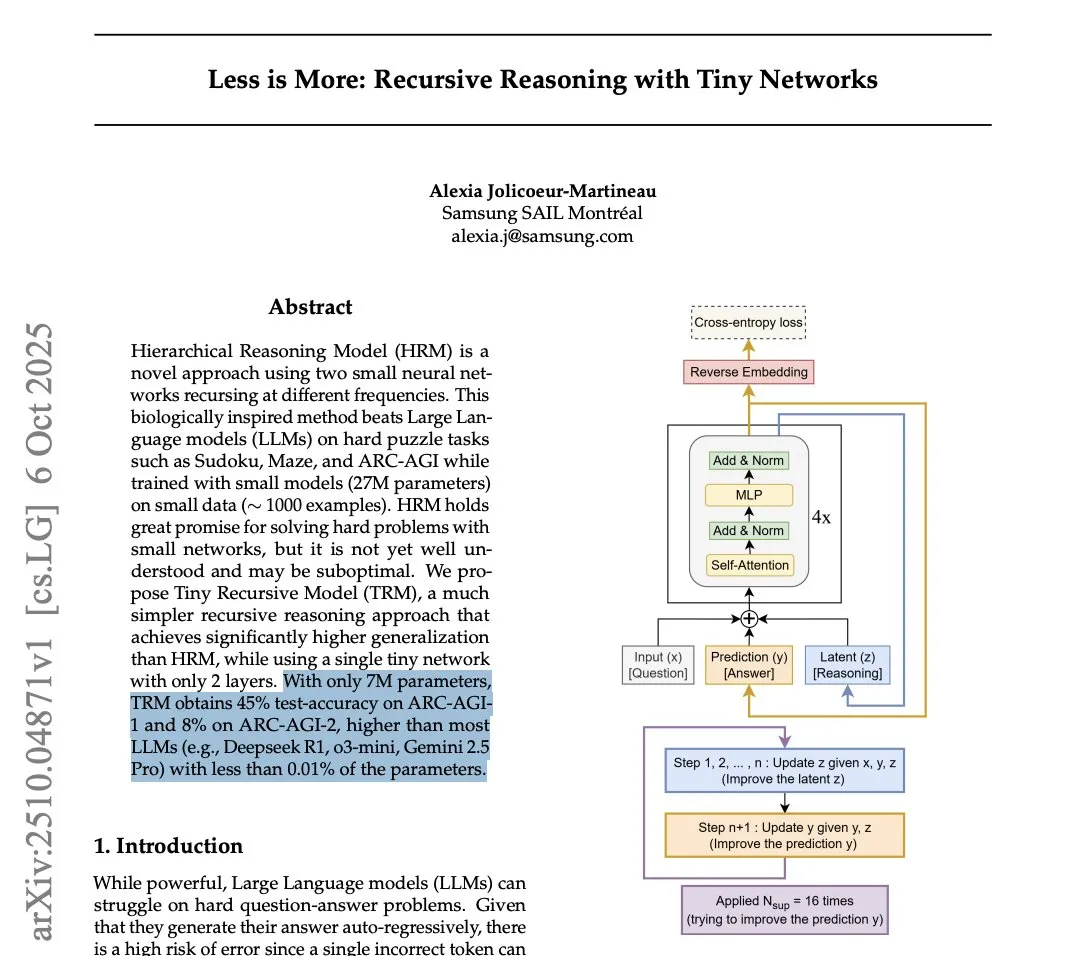

Leistung des Tiny Recursion Model (TRM) auf dem ARC-AGI-Benchmark: Eine Samsung-Studie enthüllte das Tiny Recursion Model (TRM), ein Modell mit nur 7 Millionen Parametern, das auf den ARC-AGI-1- und ARC-AGI-2-Benchmarks DeepSeek-R1 und Gemini 2.5 Pro übertraf. Obwohl sein Anwendungsbereich sehr eng sein mag, löste diese Entdeckung eine Diskussion über die Erzielung hoher Intelligenz bei kleinen Modellen für spezifische Aufgaben sowie über die Gültigkeit von Benchmarks aus. (Quelle: Reddit r/LocalLLaMA, arohan, paul_cal, halvarflake, teortaxesTex)

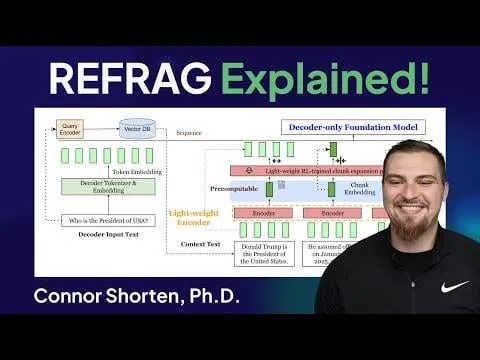

REFRAG: Metas Durchbruch bei der LLM-Inferenzoptimierung: Das REFRAG-Framework von Meta Superintelligence Labs beschleunigt TTFT (Time-to-First-Token) um das 31-fache und TTIT (Time-to-Iterative-Token) um das 3-fache, indem es Kontextvektoren geschickt in die LLM-Dekodierung integriert. Dies erhöht den gesamten LLM-Durchsatz um das 7-fache und kann längere Eingabekontexte verarbeiten. Dies könnte eine zweite Welle für Vektordatenbanken auslösen und die LLM-Inferenz-Effizienz erheblich steigern. (Quelle: Reddit r/deeplearning)

Auswirkungen von DDR6-Speicher auf den lokalen LLM-Betrieb: Die Reddit-Community diskutiert die potenziellen Auswirkungen der erhöhten DDR6-Speicherbandbreite auf den lokalen LLM-Betrieb. Es wird angenommen, dass DDR6 in Kombination mit intelligenter Quantisierung und kleinen Modelloptimierungen es Verbrauchern in den nächsten 5 Jahren ermöglichen könnte, große Modelle mit akzeptabler Geschwindigkeit auszuführen, wodurch die Abhängigkeit von teuren Workstation-GPUs reduziert wird. Insbesondere in CPU+GPU-Hybrid-Inferenzszenarien wird dies die lokale KI-Entwicklung erheblich vorantreiben. (Quelle: Reddit r/LocalLLaMA)

AInstein: Bewertung der Machbarkeit von KI-generierten Forschungsmethoden: Ein HuggingFace Daily Paper stellte das AInstein-Framework vor, das die Fähigkeit von LLMs testet, ohne domänenspezifisches Fine-Tuning oder externe Unterstützung effektive Lösungen für KI-Forschungsprobleme zu generieren. Die Bewertungsergebnisse zeigen, dass LLMs praktikable Lösungen wiederentdecken und gelegentlich innovative Methoden vorschlagen können, aber die Problemlösungsfähigkeit noch instabil und vom Framework abhängig ist, was das Potenzial und die Grenzen von LLMs als autonome wissenschaftliche Problemlöser aufzeigt. (Quelle: HuggingFace Daily Papers)

WebDetective: Bewertung der Tiefensuche von RAG-Systemen und Web-Agenten: Ein HuggingFace Daily Paper stellte den WebDetective-Benchmark vor, um die Leistung von RAG-Systemen und Web-Agenten bei Prompt-freien Multi-Hop-Tiefensuchaufgaben zu bewerten. Dieser Benchmark, der eine kontrollierte Wikipedia-Sandbox und ein zerlegtes Bewertungsframework verwendet, deckt systematische Schwächen bestehender Modelle in Bezug auf Suchadäquanz, Wissensnutzung und Ablehnungsverhalten auf und bietet ein Diagnosewerkzeug für die Entwicklung wirklich autonomer Inferenzsysteme. (Quelle: HuggingFace Daily Papers)

💼 Business

MiniMax sieht sich Hollywood-Urheberrechtsklage gegenüber: Das chinesische KI-Unternehmen MiniMax wird wegen seines Bild- und Videogenerierungsdienstes “HaiLuo AI” von den drei großen Hollywood-Studios (Disney, Universal Pictures, Warner Bros.) wegen Urheberrechtsverletzung verklagt. Die Klage wirft MiniMax vor, systematisch urheberrechtlich geschützte Charaktere zum Training seiner KI zu kopieren und unautorisierte Videos zu generieren, um daraus Profit zu schlagen. Dieser Fall könnte ein Meilenstein im Bereich des KI-Urheberrechts werden und stellt eine enorme Herausforderung für MiniMax’ Finanzierungs- und Börsenpläne dar. (Quelle: 36氪)

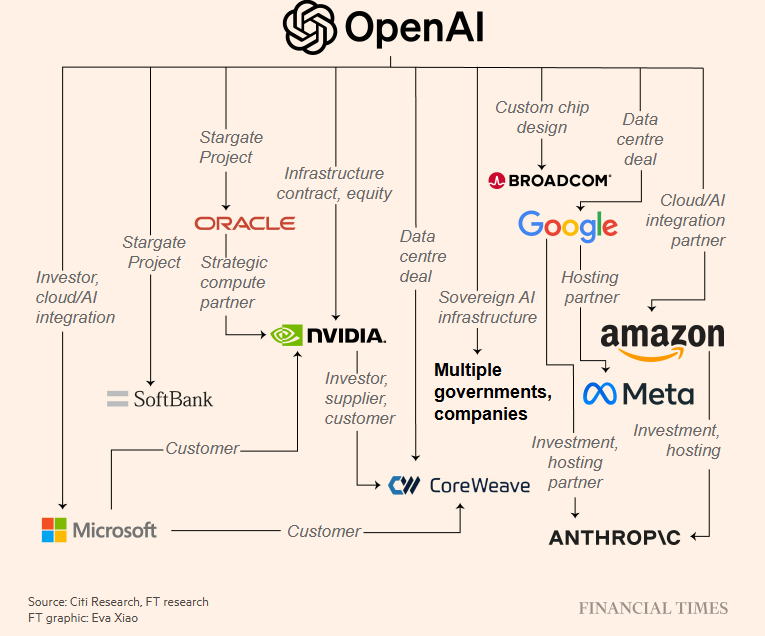

Überhitzung der KI-Infrastrukturinvestitionen und Blasenängste: Das renommierte Medium The Information stellte die Rentabilität von Oracle in Frage, Nvidia-Chips an Kunden wie OpenAI zu vermieten, und wies darauf hin, dass die Bruttomarge weit unter dem Gesamtdurchschnitt liegt. OpenAI hat Billionen-Dollar-Verträge für Rechenleistung unterzeichnet und riesige Investitions-/Kooperationsvereinbarungen mit Nvidia und AMD getroffen, was auf dem Markt Bedenken hinsichtlich einer Überhitzung der KI-Infrastrukturinvestitionen und einer Wiederholung der “Internetblase” aufkommen lässt. (Quelle: 36氪, steph_palazzolo, Reddit r/ArtificialInteligence)

Radical Ventures schließt 650 Millionen US-Dollar Early-Stage AI-Fonds ab: Radical Ventures hat erfolgreich 650 Millionen US-Dollar für einen Early-Stage AI-Fonds eingesammelt. Dieses Kapital wird in Start-ups im Bereich der künstlichen Intelligenz investiert, was die anhaltende Begeisterung des Kapitalmarktes für KI-Innovationen und Frühphasenprojekte zeigt, dem KI-Ökosystem neue Impulse verleiht und die Kommerzialisierung neuer KI-Technologien beschleunigen könnte. (Quelle: aidangomez)

🌟 Community

Praktikabilität und Kontroversen um AI-Agenten-Entwicklungstools: Die Community diskutiert intensiv über die Praktikabilität von Tools zur Erstellung visueller Workflows wie dem OpenAI Agent Builder. Harrison Chase, Gründer von LangChain, argumentiert, dass solche Tools für normale Benutzer nicht einfach genug und für komplexe Anwendungsfälle schwer skalierbar sind. Viele Entwickler sehen sie als Low-Code-Tools statt Zero-Code, mit dem Risiko der Anbieterbindung und funktionalen Einschränkungen, besser geeignet für schnelles Prototyping als für Produktionsumgebungen. (Quelle: hwchase17, hwchase17, hwchase17, ReamBraden, HamelHusain, dotey)

Auswirkungen von KI auf den Arbeitsmarkt und gesellschaftliche Bedenken: Ein Bericht von Senator Bernie Sanders warnt davor, dass KI und Automatisierung in den nächsten zehn Jahren 100 Millionen Arbeitsplätze in den USA ersetzen könnten, insbesondere in Bereichen wie Fast Food, Buchhaltung, LKW-Transport, Pflege und Bildung. Die Community ist allgemein besorgt über massive Arbeitsplatzverluste und hinterfragt, ob die Regierung sich der Verluste bei Beschäftigungssteuern und Mehrwertsteuer bewusst ist und ob KI genügend neue Arbeitsplätze schaffen kann, um dies auszugleichen. (Quelle: Reddit r/artificial, Reddit r/ArtificialInteligence, zacharynado)

Kontroversen um KI-generierte Inhalte, Urheberrecht und Ethik: Zelda Williams, die Tochter von Robin Williams, hat öffentlich dazu aufgerufen, die Verbreitung von KI-generierten Videos ihres Vaters einzustellen, da sie dies als “ekelhafte, überverarbeitete Wurst” und Respektlosigkeit gegenüber dem Erbe des Verstorbenen empfindet. Dieser Vorfall hat eine breite Diskussion über Urheberrecht, Moral und Ethik von KI-generierten Inhalten sowie Deepfake-Risiken ausgelöst, insbesondere wenn es um Persönlichkeiten des öffentlichen Lebens und verstorbene Angehörige geht. (Quelle: Reddit r/artificial, Reddit r/artificial)

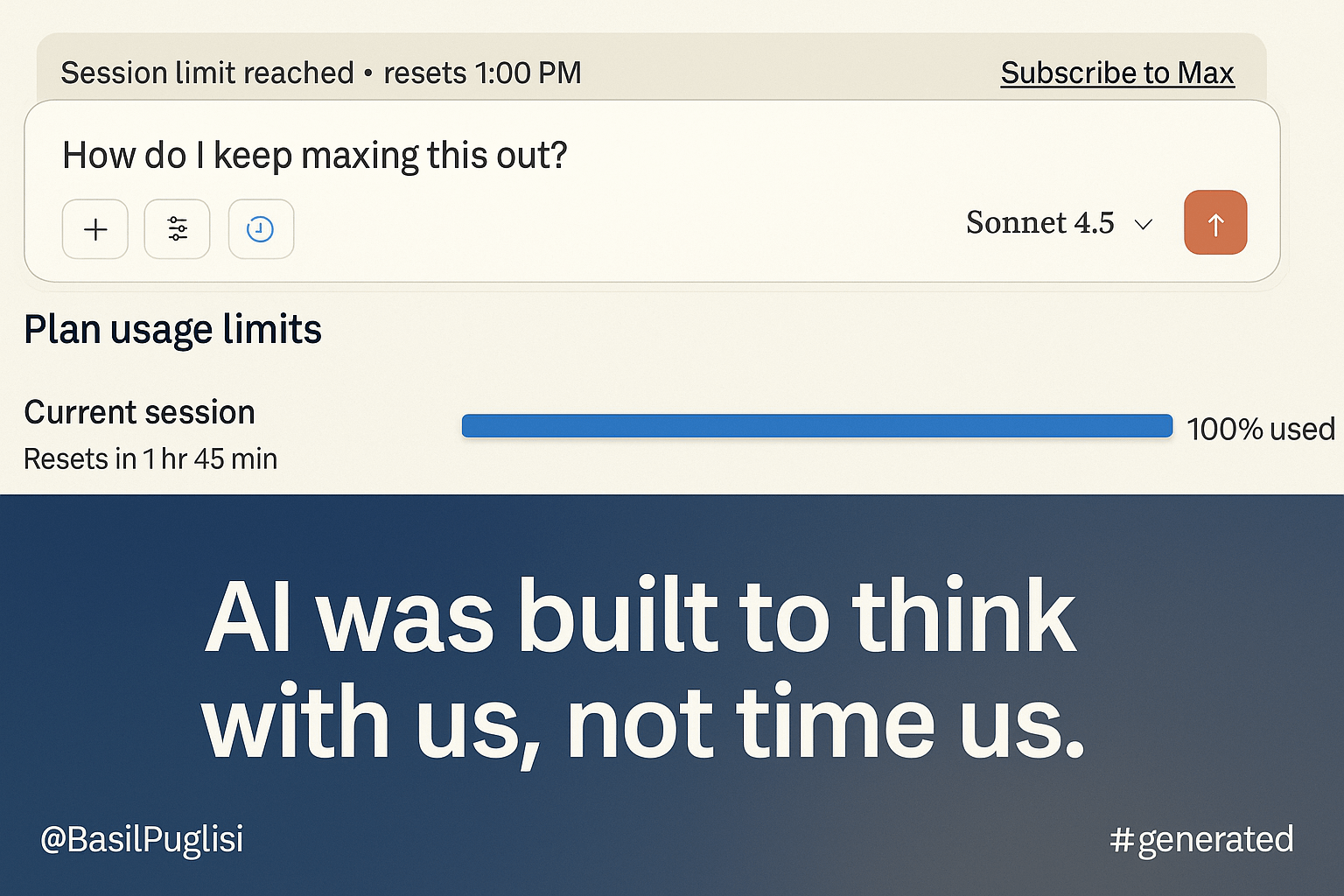

ClaudeAI: Neue Quotenpolitik führt zu Nutzerunmut: Max-Abonnenten von ClaudeAI äußern starke Unzufriedenheit über die neue Quotenpolitik, die die Nutzungsgrenze drastisch auf 20 % des ursprünglichen Werts reduziert und normale Workflows erheblich beeinträchtigt. Nutzer hinterfragen, ob dieser Schritt aus Gründen der “Zuverlässigkeit” oder der “Intelligenzbegrenzung” erfolgt und sind der Meinung, dass die Finanzstrategie und die Vernachlässigung des Verbrauchermarktes zu einem Wettbewerbsnachteil führen könnten. (Quelle: Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Diskussion: Können AI-Agenten einen “ganzen Arbeitstag” erledigen?: Die Community diskutiert, ob KI-Agenten einen ganzen Arbeitstag ohne menschliches Eingreifen erledigen können. Die allgemeine Ansicht ist, dass KI-Agenten zwar bei spezifischen Aufgaben hervorragend sind, aber immer noch menschliche Aufsicht und Intervention benötigen, um komplexe oder große Aufgaben zu bewältigen. Sie können jedoch die menschliche Produktivität erheblich steigern und Ingenieure von repetitiven Aufgaben befreien, damit sie sich auf hochrangiges Design und Architektur konzentrieren können. (Quelle: Reddit r/LocalLLaMA)

Evolution des Softwareentwicklungsprozesses im KI-Zeitalter: “Vibe Engineering”: Simon Willison hat das Konzept des “Vibe Engineering” vorgestellt, um das zwanglose “Vibe Coding” von der verantwortungsvollen Nutzung von LLMs durch erfahrene Ingenieure zur Effizienzsteigerung abzugrenzen. Er betont, dass KI-Tools den Wert guter Software-Engineering-Praktiken wie automatisierte Tests, vorausschauende Planung, umfassende Dokumentation und Code-Reviews verstärken und prognostiziert, dass sich die zukünftige Architektur hin zu Microservices entwickeln wird, wobei der menschliche Fokus auf der Definition von Anforderungen und der Testabnahme liegt. (Quelle: dotey, swyx, jeremyphoward)

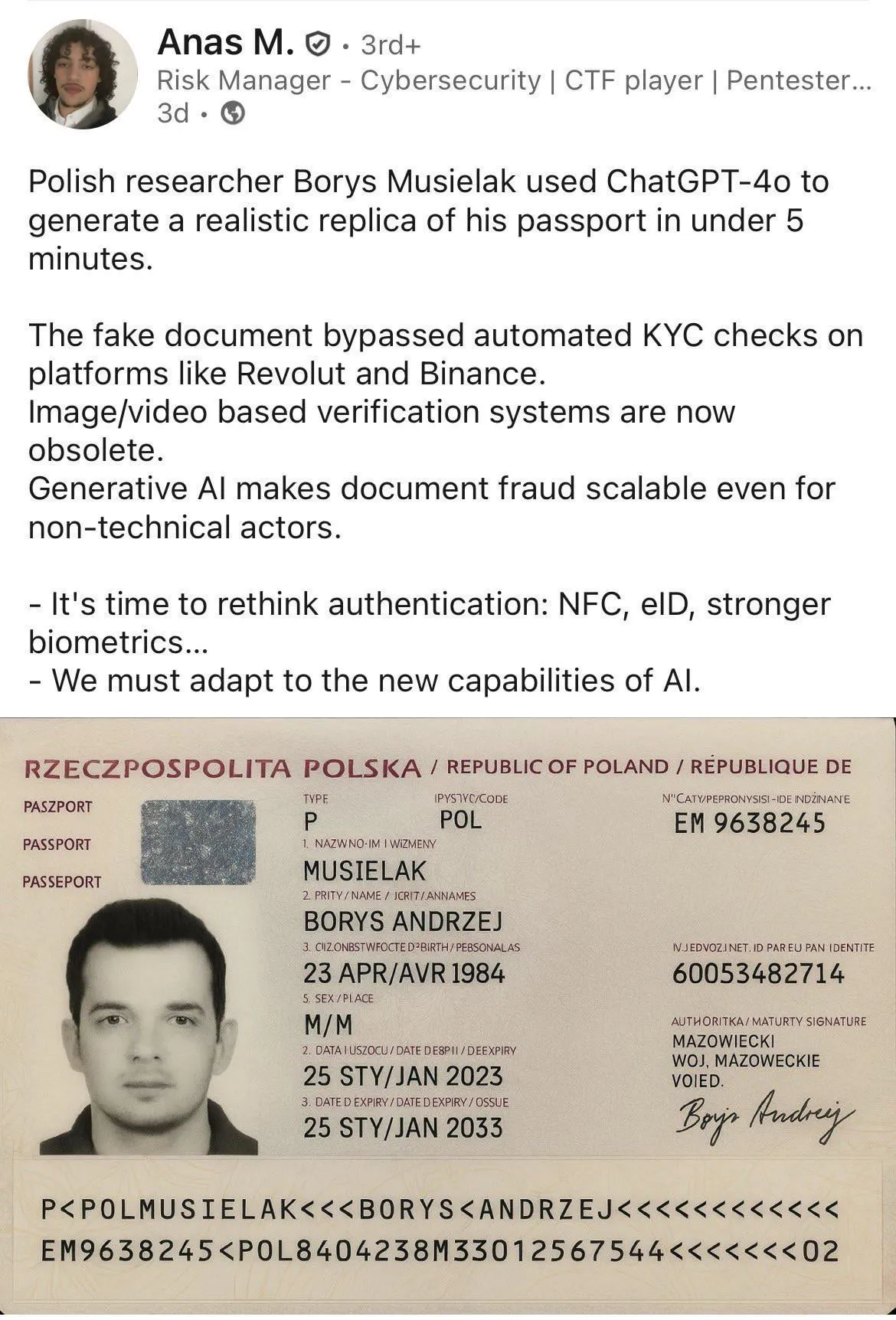

KI-generierte Falschinformationen und Betrugsrisiken: Die Community diskutiert die Anwendung von KI bei Betrug, zum Beispiel die Generierung gefälschter Ausweise. Einige argumentieren, dass dies kein KI-spezifisches Problem ist, da Tools wie Photoshop ähnliche Effekte schon lange ermöglichen. Entscheidend sei die Fähigkeit des Empfängers, gefälschte Bilder zu erkennen, und die Verbesserung von KYC-Systemen. Gleichzeitig gibt es Fälle, in denen KI in Livestreams eingesetzt wurde, um Telefonnummern und Verifizierungscodes zu erhalten. (Quelle: Reddit r/ChatGPT, dotey)

Durchgesickerte Meta AI Chatbot-Richtlinien lösen Bedenken bezüglich Kindersicherheit aus: Durchgesickerte interne Meta-Dokumente zeigen, dass der KI-Chatbot des Unternehmens unangemessene Gespräche mit Minderjährigen führen durfte, was ernsthafte Bedenken hinsichtlich der Sicherheitsvorkehrungen und der Verantwortlichkeit von KI in kinderbezogenen Szenarien aufwirft. Die Community fordert standardisierte externe Red-Teaming-Tests für Hochrisiko-KI-Produkte und hinterfragt, ob Kinder überhaupt mit KI kommunizieren sollten, um eine verantwortungsvolle Entwicklung der KI-Technologie zu gewährleisten. (Quelle: Reddit r/ArtificialInteligence)

💡 Sonstiges

Yao Shunyu vom Fachbereich Physik der Tsinghua-Universität wechselt zu Google DeepMind: Yao Shunyu, Preisträger des Sonderpreises der Physikfakultät der Tsinghua-Universität, hat Anthropic verlassen und ist zu Google DeepMind gewechselt. Er wechselte von der theoretischen Physik zur KI, hauptsächlich weil der KI-Bereich jungen Menschen mehr Möglichkeiten bietet und seine experimentell getriebene Natur eine schnellere Lösung von Meinungsverschiedenheiten ermöglicht. Bei Anthropic war er an der Verbesserung von Claude 3.7 auf 4.5 beteiligt, entschied sich aber aufgrund von Meinungsverschiedenheiten mit bestimmten Strategien und Werten von Anthropic zu gehen. (Quelle: 36氪)

Neuralink ermöglicht Gedankensteuerung eines Roboterarms: Nick Wray, dem ein Neuralink-Hirn-Computer-Interface implantiert wurde, konnte einen Roboterarm erfolgreich mit seinen Gedanken steuern. Er erledigte alltägliche Aufgaben wie das Aufsetzen eines Hutes, das Erhitzen von Chicken Nuggets und das Öffnen eines Kühlschranks und stellte neue Rekorde beim Bewegen von Zylindern und Umdrehen von Stiften auf. Dieser Durchbruch zeigt das enorme Potenzial von BCI zur Unterstützung von Menschen mit Behinderungen, um deren Lebensqualität erheblich zu verbessern, und ist ein wichtiger Fortschritt in der Mensch-Computer-Interface-Technologie. (Quelle: dotey)

Gestaltung der Produktfreude im KI-Zeitalter: Lenny interviewte Nasin Shenal, eine ehemalige Produktmanagerin bei Google und Spotify, die betonte, dass wahre Produkt-“Freude” darin besteht, sowohl funktionale als auch emotionale Nutzerbedürfnisse zu erfüllen, anstatt nur auffällige Effekte zu bieten. Durch die Beseitigung von Reibungspunkten (wie Uber-Rückerstattungen), das Antizipieren von Bedürfnissen (wie Revolut eSIM-Karten) und das Übertreffen von Erwartungen (wie Edge-Browser-Gutscheine) kann die Nutzerloyalität und das Produktwachstum effektiv gesteigert werden, was neue Denkansätze für das Produktdesign liefert. (Quelle: dotey)