Schlüsselwörter:Meta KI, LIRA Multimodales Framework, Microsoft Agent Framework, NVIDIA Marktkapitalisierung, Sora 2 Pro, Perplexity KI Comet, IBM Granite 4.0, Qwen Modellreihe, Meta KI-Team Umstrukturierung, LIRA Bildsegmentierungsgenauigkeit, Agent Framework Mehrsprachige Unterstützung, NVIDIA KI-Chip Markt, Sora 2 Videogenerierungsbeschränkungen

🔥 Fokus

Turbulenzen im internen AI-Team von Meta und Gerüchte über LeCuns Rücktritt : Interne Umstrukturierungen in Metas AI-Abteilung führen zu wachsender Unzufriedenheit, und es gibt Gerüchte, dass Turing-Preisträger Yann LeCun von seiner Position als Chief Scientist bei FAIR zurücktreten könnte. Interne Strategieanpassungen, wie zusätzliche Prüfungen für Veröffentlichungen und hohe Gehälter sowie bevorzugte Ressourcen für neue Mitarbeiter, verstärken das Gefühl der eingeschränkten akademischen Freiheit und die Unzufriedenheit unter den FAIR-Mitarbeitern, was zu mehreren Abgängen von Forschern führt. Diese Turbulenzen verdeutlichen die Herausforderungen großer Technologieunternehmen bei der Anpassung ihrer AI-Strategie und den Konflikt zwischen der Verfolgung kommerzieller Ziele und der Wahrung der Freiheit der Grundlagenforschung. (Quelle: QbitAI)

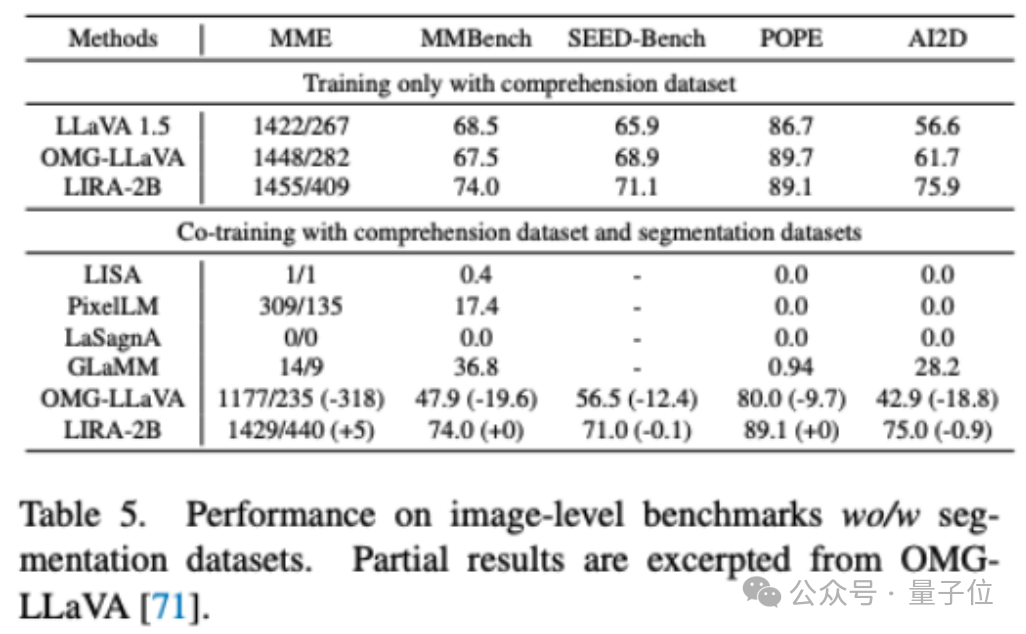

Team um Bai Xiang von der Huazhong University of Science and Technology stellt multimodales LIRA-Framework vor, das doppeltes SOTA bei Segmentierung und Verständnis erreicht : Ein Team der Huazhong University of Science and Technology und Kingsoft Office hat gemeinsam das multimodale Großmodell LIRA vorgestellt. Durch zwei innovative Module, den „Semantic-Enhanced Feature Extractor“ (SEFE) und „Interleaved Local Visual Coupling“ (ILVC), wurden die Genauigkeit der Bildsegmentierung erheblich verbessert und Verständnis-Halluzinationen reduziert. LIRA erreicht in Segmentierungs- und Verständnisaufgaben SOTA und kann insbesondere in komplexen Szenarien Ziele genauer segmentieren. Es übertrifft bestehende Methoden, wie OMG-LLaVA, in mehreren Benchmarks. Diese Forschung bietet neue Ansätze für die visuelle Wahrnehmung und Inferenzfähigkeit von feingranularen multimodalen Großmodellen. (Quelle: QbitAI)

Microsoft veröffentlicht AI Agent Framework, unterstützt mehrsprachige Entwicklung in Python und .NET : Microsoft hat das Agent Framework vorgestellt, ein umfassendes mehrsprachiges Framework zum Erstellen, Orchestrieren und Bereitstellen von AI-Agenten und Multi-Agenten-Workflows. Das Framework unterstützt Python und .NET und bietet grafische Workflows, ein experimentelles AF Labs-Paket, eine interaktive DevUI, OpenTelemetry-Beobachtbarkeitsintegration sowie Unterstützung für verschiedene LLM-Anbieter und ein flexibles Middleware-System. Es zielt darauf ab, die Entwicklung von einfachen Chat-Agenten bis hin zu komplexen Multi-Agenten-Workflows zu vereinfachen und die Entwicklungseffizienz sowie die Kontrollierbarkeit von AI-Anwendungen zu verbessern. (Quelle: GitHub Trending)

NVIDIA Marktkapitalisierung übersteigt 4 Billionen US-Dollar, AI-Rechenanforderungen explodieren weiter : NVIDIA hat erstmals eine Marktkapitalisierung von über 4 Billionen US-Dollar erreicht und ist damit das erste börsennotierte Unternehmen weltweit, das diesen Meilenstein erreicht. Dieser Erfolg spiegelt das anhaltend starke Wachstum der AI-Rechenanforderungen sowie NVIDIAs dominierende Position im GPU-Technologie- und AI-Chip-Markt wider. AI-Pioniere wie Jürgen Schmidhuber gratulierten NVIDIA ebenfalls zu seinen Beiträgen zur Förderung des Potenzials neuronaler Netze und wiesen auf den Trend hin, dass die Rechenkosten erheblich sinken, während der Wert von NVIDIA stark ansteigt. (Quelle: SchmidhuberAI, SchmidhuberAI, SchmidhuberAI, nvidia)

🎯 Trends

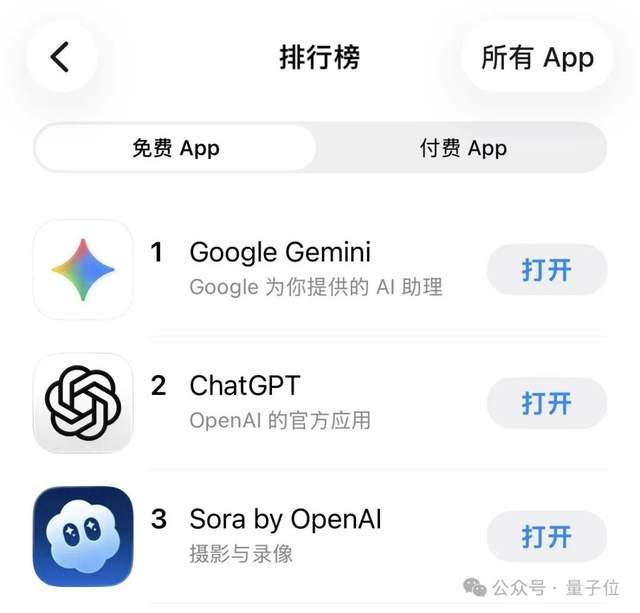

Erweiterung der Sora 2 Pro Video-Generierungsfunktion und Marktauswirkungen : OpenAIs Sora 2 Pro Video-Generierungsfunktion wird schrittweise für ChatGPT Pro-Nutzer freigeschaltet und unterstützt die Erstellung von 15-sekündigen hochwertigen Videos. Das Erscheinen von Sora 2 erregte schnell Marktinteresse und führte sogar dazu, dass es die Spitze der AI-App-Charts im App Store erreichte. Das Produkterlebnis wird als „Killer-Feature“ gelobt, obwohl einige argumentieren, dass das Modell selbst nicht SOTA ist und die Produktisierungsfähigkeit der Schlüssel zum Erfolg ist. Darüber hinaus könnten die Prompts von Sora 2 modellgefiltert sein und sogar Inhalte aus dem öffentlichen Bereich modifizieren, was Diskussionen über Urheberrecht und Inhaltskontrolle auslöst. (Quelle: dotey, thursdai_pod, billpeeb, TomLikesRobots, dotey, iScienceLuvr, skirano, VictorTaelin, Reddit r/artificial)

Perplexity AI Comet Browser kostenlos verfügbar und schnell verbreitet : Perplexity AI hat angekündigt, dass sein Comet-Browser weltweit kostenlos verfügbar ist, nachdem er zuvor 200 US-Dollar pro Monat kostete. Nutzer loben das Design und die Benutzerfreundlichkeit sehr und sind der Meinung, dass AI natürlich und nicht-invasiv integriert wurde, wodurch die Notwendigkeit entfällt, neue Interaktionen zu erlernen. Der Browser zeigt eine schnelle Akzeptanz bei Windows- und Mac-Nutzern, insbesondere auf Mac, und wird als eines der besten Produkte des Jahres 2025 angesehen. Es gibt jedoch auch Fragen zur Angemessenheit seines früheren hochpreisigen Bezahlmodells. (Quelle: AravSrinivas, AravSrinivas, AravSrinivas, AravSrinivas, bookwormengr, Reddit r/artificial)

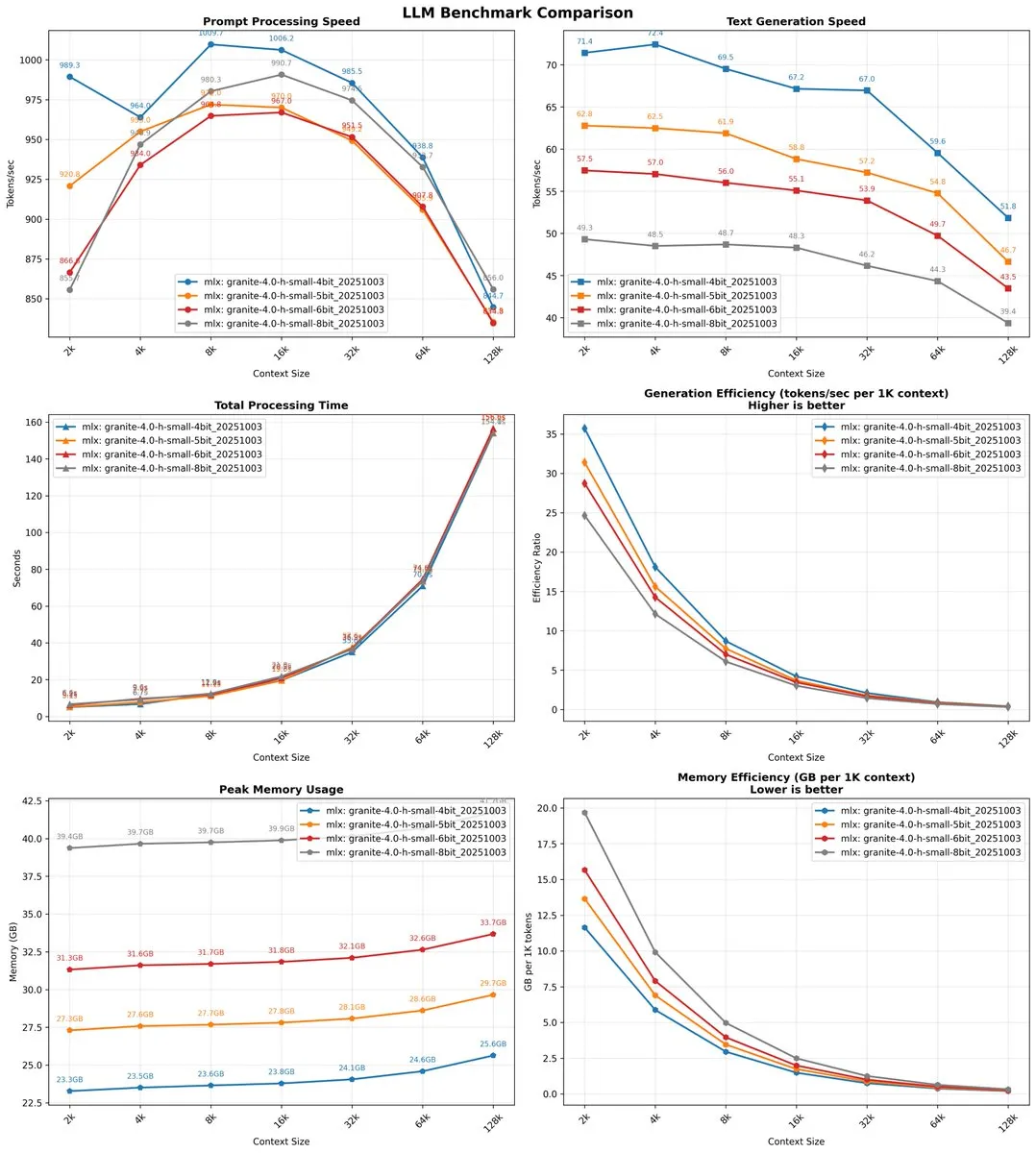

IBM Granite 4.0 Modell erzielt signifikante Fortschritte in Leistung und langem Kontext : IBM hat die Granite 4.0-Modellreihe veröffentlicht, wobei Granite-4.0-H-Tiny in mehreren Metriken wie Mathematik, Codierung und allgemeinem Wissen das vor 10 Monaten veröffentlichte OLMoE-Modell deutlich übertrifft und auf einem normalen PC mit angemessener Geschwindigkeit CPU-Inferenz durchführen kann. Das Granite 4.0-H-Small-Modell zeigt ebenfalls eine extrem schnelle Inferenzgeschwindigkeit (bis zu 79 Token/Sekunde), wobei die Geschwindigkeit mit zunehmender Kontextlänge nicht signifikant abnimmt, und unterstützt ein Kontextfenster von bis zu 1M (obwohl offiziell bis 128k validiert). Benutzer loben den geringen Speicherverbrauch und die prägnante Ausgabe und sind der Meinung, dass es in bestimmten Szenarien hervorragende Leistungen erbringt. (Quelle: ImazAngel, NerdyRodent, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

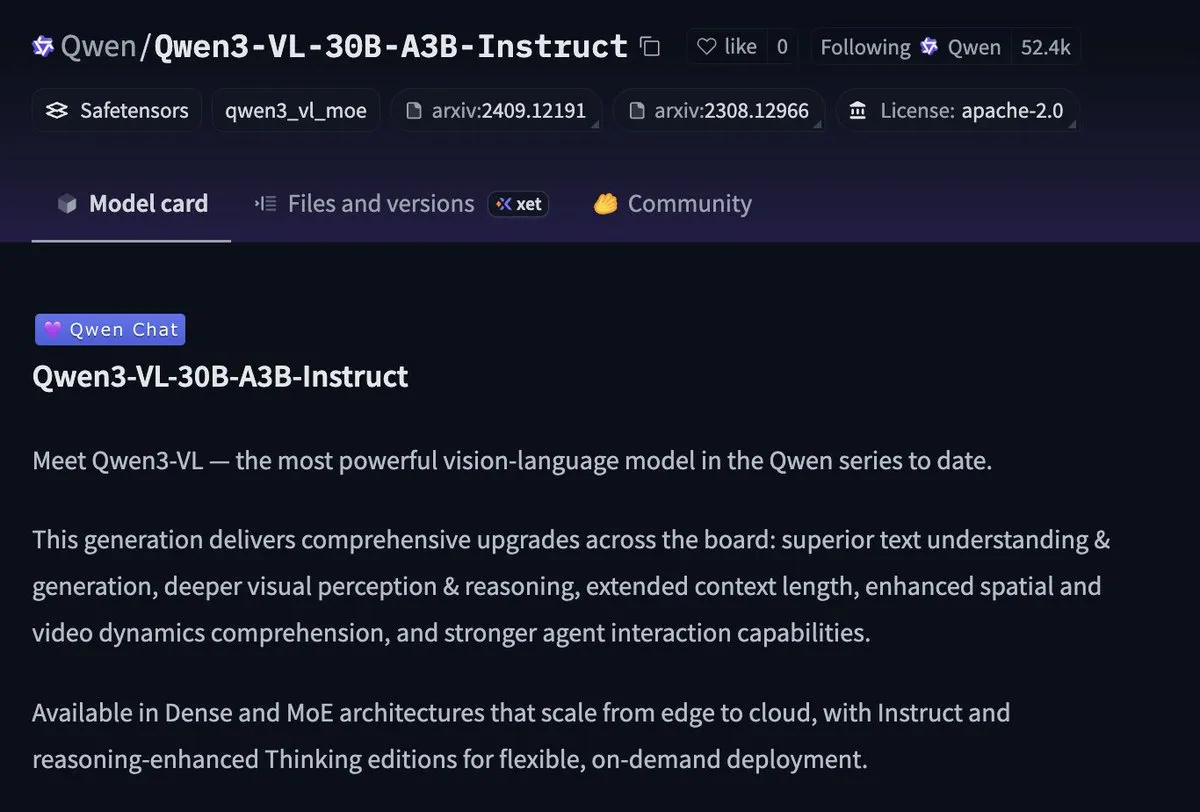

Qwen Modellreihe Updates und strategische Positionierung : Das Alibaba Cloud Qwen-Team hat die Namenslogik und Entwicklungsziele seiner verschiedenen Modellfamilien wie LLM, Coder, VL, Omni und Image detailliert erläutert, mit dem Ziel, sie letztendlich zu einem Allround-Modell zu vereinen. Qwen3-Next, als Vorabversion von „Qwen3.5“, erzielt durch ein hybrides Aufmerksamkeitsdesign einen Effizienz-Durchbruch und übertrifft Qwen3-32B mit 10% der Trainingskosten und dem 10-fachen des langen Kontext-Durchsatzes. Darüber hinaus zeigt das Qwen MoE-Modell eine hervorragende CPU-Inferenzgeschwindigkeit, was auf sein Potenzial für Edge-Geräte hindeutet. Qwens Gesamtstrategie wird als Aufbau eines „Android-Ökosystems“ für AI-Modelle interpretiert, das niedrige Kosten, weite Verbreitung und Modifizierbarkeit betont. (Quelle: stablequan, karminski3, Teknium1, Dorialexander, ClementDelangue, natolambert, Reddit r/deeplearning)

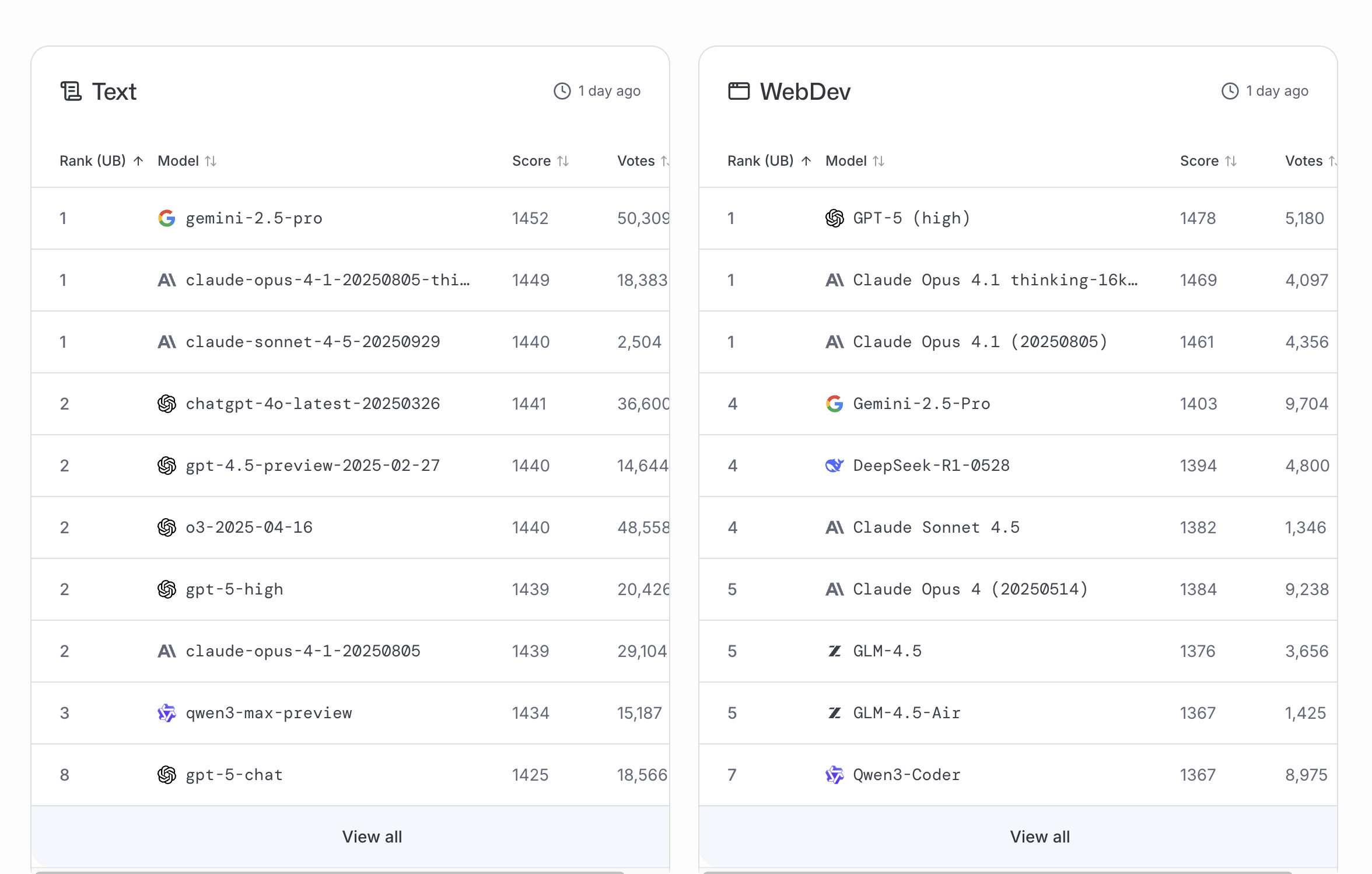

Claude 4.5 Sonnet und Opus Leistung sowie Kontroversen um Nutzungseinschränkungen : Nach der Veröffentlichung von Anthropic’s Claude 4.5 Sonnet-Modell liegt es trotz umfangreicher Werbung in Benchmarks wie WebDev und Text im mittleren Bereich und hinter GPT-5 und der „Denkmodus“-Version von Claude Opus 4.1 zurück. Nutzer berichten, dass die wöchentliche Nutzungsgrenze von Claude Opus drastisch reduziert wurde; eine komplexe Planungsaufgabe kann 6% des wöchentlichen Kontingents verbrauchen, was die verfügbare Zeit für Max-Plan-Nutzer von „25-40 Stunden“ auf wenige Minuten reduziert. Dies hat zu starker Unzufriedenheit über die Diskrepanz zwischen Preisgestaltung und tatsächlichem Service geführt und die Frage aufgeworfen, ob Anthropic tiefe, komplexe Inferenzaufgaben bestraft. (Quelle: thursdai_pod, alexalbert__, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Yunpeng Technology stellt AI+Gesundheits-Neuheiten vor : Yunpeng Technology hat am 22. März 2025 in Hangzhou neue Produkte in Zusammenarbeit mit Shuaikang und Skyworth vorgestellt, darunter ein „Digitales und intelligentes Zukunftsküchenlabor“ und einen intelligenten Kühlschrank mit einem AI-Gesundheits-Großmodell. Das AI-Gesundheits-Großmodell optimiert Küchendesign und -betrieb, während der intelligente Kühlschrank über den „Gesundheitsassistenten Xiaoyun“ personalisiertes Gesundheitsmanagement bietet, was einen Durchbruch von AI im Gesundheitsbereich markiert. Diese Veröffentlichung demonstriert das Potenzial von AI im täglichen Gesundheitsmanagement. Durch intelligente Geräte werden personalisierte Gesundheitsdienste ermöglicht, was die Entwicklung der häuslichen Gesundheitstechnologie vorantreiben und die Lebensqualität der Bewohner verbessern könnte. (Quelle: 36Kr)

🧰 Tools

Googles Nano Banana Bildgenerierungs-API geöffnet und Funktionsupdates : Googles Nano Banana Bildgenerierungsmodell hat offiziell seine API geöffnet, mit einem Preis von etwa 0,039 US-Dollar pro Bild. Gleichzeitig wurden Optionen für das Seitenverhältnis (unterstützt verschiedene Verhältnisse wie 16:9, 9:16, 4:3, 3:2) und ein reiner Bildausgabemodus (ohne Text) hinzugefügt, um den Anforderungen rein visueller Szenarien wie Echtzeit-Vorschauen, E-Commerce-Präsentationen und Design-Tools gerecht zu werden. Diese Updates zielen darauf ab, Nano Banana weiter als praktisches Tool zu positionieren und Entwicklern die Integration in ihre eigenen Produkte zu erleichtern. (Quelle: QbitAI)

Microsoft Agent Framework vereinfacht die Entwicklung von AI-Agenten : Microsoft hat das Agent Framework vorgestellt, ein umfassendes Framework, das Python und .NET unterstützt und darauf abzielt, die Erstellung, Orchestrierung und Bereitstellung von AI-Agenten und Multi-Agenten-Workflows zu vereinfachen. Das Framework bietet grafische Workflows, eine interaktive DevUI, OpenTelemetry-Beobachtbarkeit, Unterstützung für mehrere LLM-Anbieter und ein flexibles Middleware-System, um Entwicklern zu helfen, effizient von einfachen Chat-Agenten bis hin zu komplexen Multi-Agenten-Anwendungen zu erstellen. (Quelle: GitHub Trending)

Liquid AI stellt Apollo Android App vor, ermöglicht lokale AI-Bereitstellung : Liquid AI hat die Apollo-App für Android vorgestellt, die ein latenzarmes, Cloud-freies lokales AI-Erlebnis bietet. Apollo, als „Spielplatz in der Tasche“, ermöglicht Nutzern sofortigen Zugriff auf schnelle und effiziente AI, während gleichzeitig Datenschutz und Sicherheit gewährleistet werden. In Kombination mit der LEAP-Technologie senkt Apollo die Hürden für Edge-AI, sodass Nutzer und Entwickler AI einfach lokal verwenden, testen und bereitstellen können. (Quelle: maximelabonne)

„solveit“ AI-Coding-Coach steigert die Effizienz von Programmierern : Jeremy Howard hat das AI-Coding-Coach-Tool „solveit“ vorgestellt, das Programmierern helfen soll, qualitativ hochwertige Software effizienter zu schreiben. Das Tool führt Benutzer durch die Softwareentwicklung mit AI, besonders nützlich für Entwickler, die sich bei AI-gestützter Programmierung frustriert fühlen. Es bietet ein „Coding-Coach“-Modell, bei dem AI und Programmierer zusammenarbeiten, um den Entwicklungsprozess zu beschleunigen. (Quelle: jeremyphoward, jeremyphoward)

Jules Tools CLI ermöglicht AI Agent Kommandozeilenverwaltung : Google hat den Jules Coding-Agenten in eine Kommandozeilenschnittstelle (CLI) integriert und Jules Tools veröffentlicht. Benutzer können nun Agent-Aufgaben, die in der Cloud laufen, über die Kommandozeile fernsteuern, was eine bessere Integration mit CI/CD oder Code ermöglicht. Dies bietet Entwicklern, die Kommandozeilen bevorzugen, ein bequemes AI-Codierungserlebnis und zeigt eine reibungslose Benutzererfahrung, insbesondere beim Debugging und der interaktiven Entwicklung. (Quelle: dotey, matanSF)

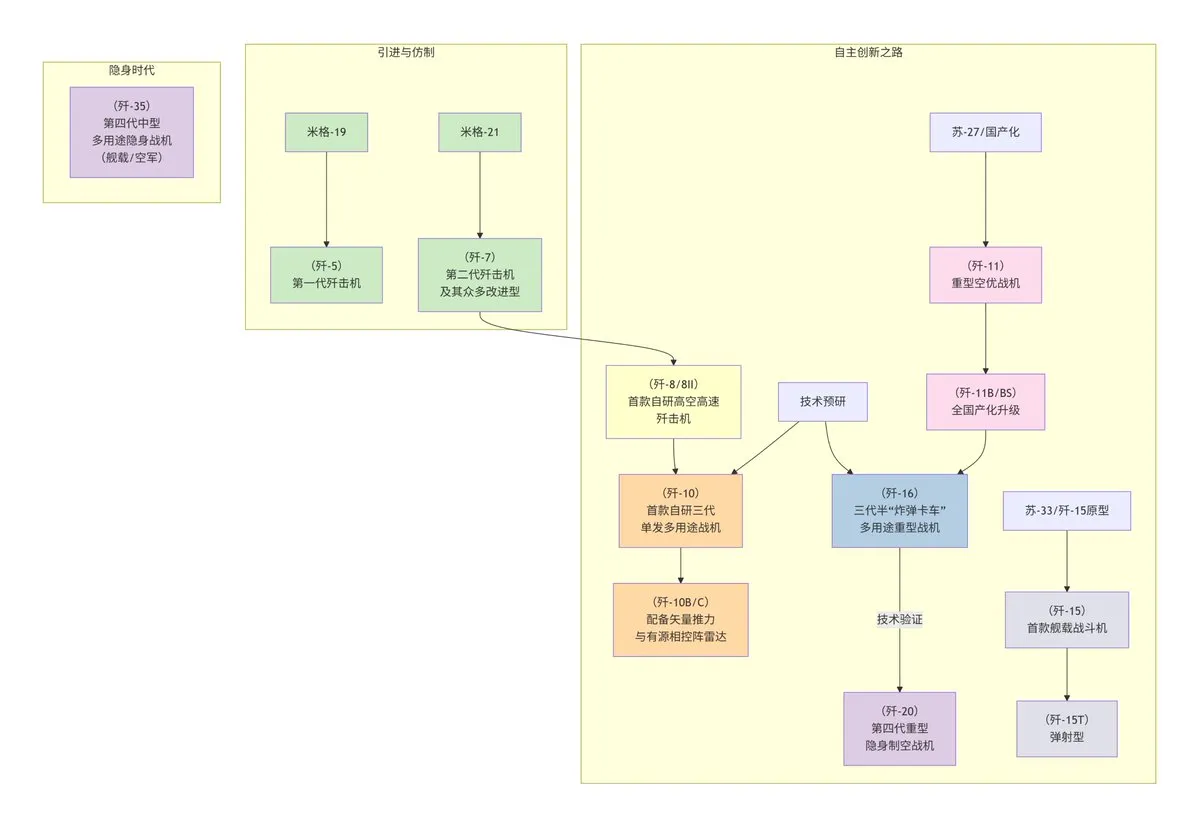

DeepSeek Flussdiagramm-Generierungsfunktion vereinfacht die Diagrammerstellung : Das DeepSeek-Modell kann jetzt schnell Flussdiagramme durch einfache Schlüsselwörter (wie „flowchart“ oder „Mermaid“) generieren. Benutzer müssen lediglich beschreibende Anweisungen eingeben, um komplexe Informationen, wie die Entwicklungsgeschichte der chinesischen J-Serie Kampfflugzeuge oder die Zeitlinie von „Fullmetal Alchemist“, automatisch zu strukturieren und zu zeichnen, was den Prozess der Diagrammerstellung erheblich vereinfacht und die Arbeitseffizienz steigert. (Quelle: karminski3)

Synthesia stellt Video Agents für bidirektionale Videokonversationen vor : Synthesia hat „Video Agents“ vorgestellt, den ersten Schritt von Video zu bidirektionaler Konversation. Diese Technologie ermöglicht es Benutzern, jederzeit im Video eine Echtzeit-Konversation zu starten. Die Agenten können sich mit Unternehmenswissensdatenbanken verbinden, um Kontext zu erhalten, und Daten erfassen, die in bestehende Systeme zurückgespeist werden. Dies könnte die Art und Weise, wie Videos interagieren, revolutionieren und sie von passivem Konsum zu aktiver Beteiligung machen. (Quelle: synthesiaIO, synthesiaIO)

Blink.new AI-Coding-Agent ermöglicht schnelle Bereitstellung „von der Idee zur Anwendung“ : Blink.new hat einen AI-Coding-Agenten vorgestellt, der angeblich die Zeit „von der Idee zur Produktionsanwendung“ von Monaten auf Minuten verkürzt und eine schnelle No-Code-Entwicklung ermöglicht. Die Plattform wandelt natürlichsprachliche Beschreibungen in ausführbaren Code um, konfiguriert Datenbanken, entwirft UIs und stellt automatisch bereit. Sie bietet produktionsreife Funktionen wie kostenloses Hosting, SSL, CDN und automatische Skalierung, was die Geschwindigkeit von Proof-of-Concepts und Produktentwicklung erheblich steigert. (Quelle: Ronald_vanLoon)

VS Code integriert Hintergrund-Coding-Agenten zur Verbesserung des Entwicklungserlebnisses : Das VS Code-Team führt die neuesten Verbesserungen ein, die das Ausführen von Coding-Agenten (wie GitHub Copilot) im Hintergrund unterstützen, um die Entwicklungseffizienz und -erfahrung zu verbessern. Diese Integration ermöglicht es den Agenten, kontinuierliche Code-Unterstützung und Vorschläge im Hintergrund bereitzustellen, was den Programmier-Workflow weiter optimiert und Entwicklern hilft, schneller qualitativ hochwertigen Code zu schreiben. (Quelle: code, pierceboggan)

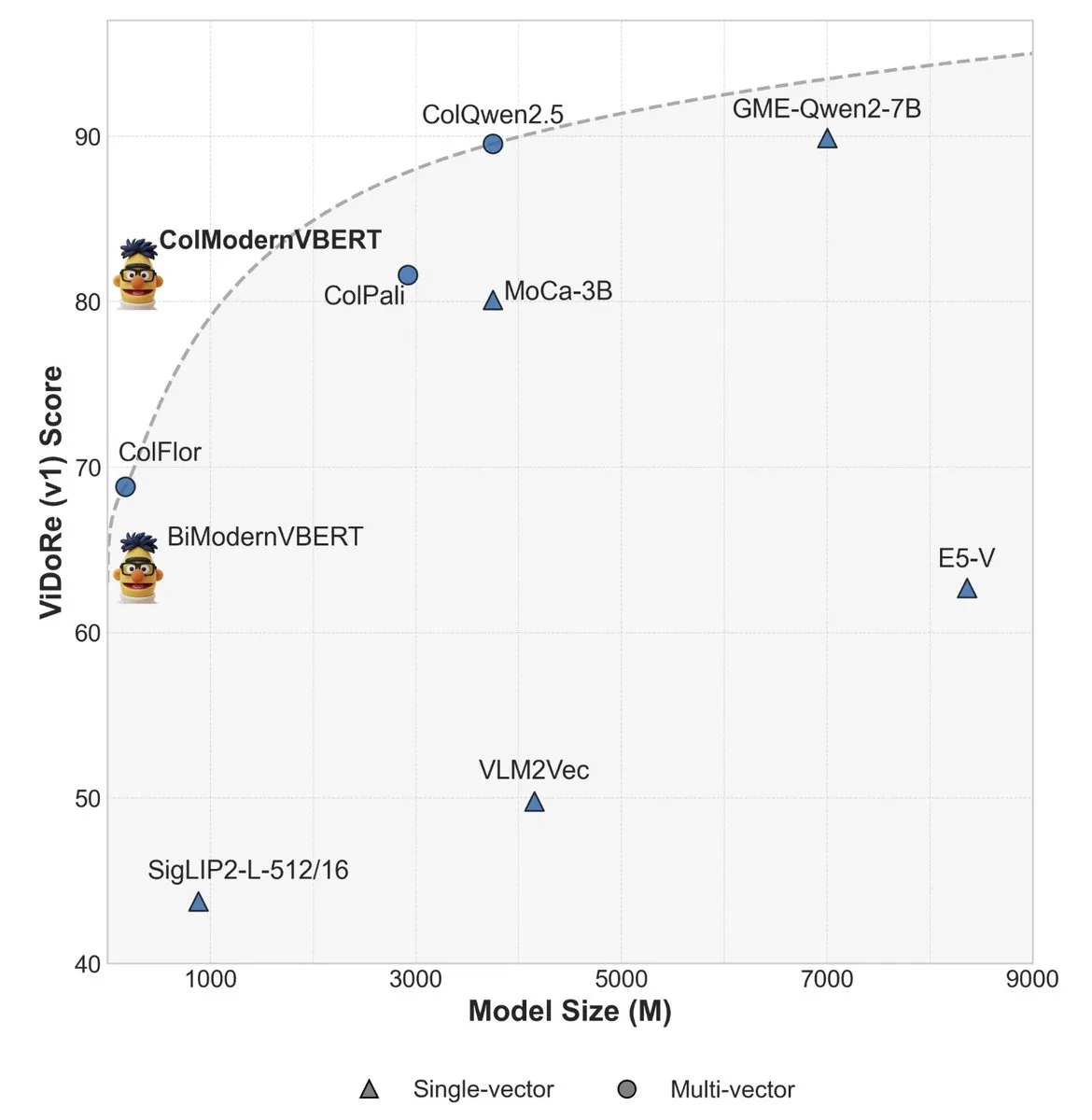

ModernVBERT: Kleiner visueller Dokumenten-Retriever übertrifft große Modelle : ModernVBERT ist ein kompakter visueller Sprach-Encoder mit 250 Millionen Parametern, der nach Feinabstimmung für Dokumentenabrufaufgaben Modelle übertrifft, die zehnmal größer sind. Die Studie identifizierte durch kontrollierte Experimente Schlüsselfaktoren für die Leistung wie Aufmerksamkeitsmasken, Bildauflösung, modale Ausrichtungsdatenschemata und späte interaktive Kontrastziele, was prinzipielle Leitlinien für die Entwicklung effizienterer visueller Dokumentenabrufmodelle liefert. Modell und Code sind auf HuggingFace als Open Source verfügbar. (Quelle: tonywu_71, lateinteraction, lateinteraction, lateinteraction, lateinteraction, lateinteraction, ClementDelangue, HuggingFace Daily Papers)

AI-Musiksuchmaschine EmergeSound.ai nutzt Audio-Embedding-Technologie : EmergeSound.ai ist eine Musiksuchmaschine und ein Basismodell, das auf über 100 Millionen Audio-Embeddings basiert. Die Plattform ermöglicht es Benutzern, Musik nach Klang statt nach Text oder Metadaten zu suchen, Lieder aus verschiedenen Epochen zu erkunden und verborgene Verbindungen zu entdecken. Das Projekt zielt darauf ab, Audio-Features mithilfe von Deep-Learning-Modellen zu kodieren, um die Entdeckung und Erkundung von Musik zu ermöglichen und Produzenten, Forschern und Musikliebhabern neue Tools zur Verfügung zu stellen. (Quelle: Reddit r/MachineLearning)

OpenWebUI-Nutzer entwickeln Web-Content-Crawling- und Zusammenfassungstools : Ein OpenWebUI-Nutzer hat ein Toolset zum Crawlen und Zusammenfassen von Webinhalten entwickelt, das darauf abzielt, die Kontextausdehnung zu minimieren. Das Tool kann Webseiten-Zusammenfassungen anstelle von SERP-Auszügen zurückgeben und ermöglicht es dem Modell, Abfrage-basierte Zusammenfassungen oder direkte Antwort-Auszüge anzufordern. Darüber hinaus nutzt es Playwright und Trafilatura, um die Web-Crawling-Ergebnisse zu optimieren und sie kompakter zu gestalten. Das Tool sucht derzeit nach Community-Hilfe, um eine allgemeinere OpenWebUI-Integration zu erreichen. (Quelle: Reddit r/OpenWebUI)

Mit Claude entwickeltes Spiel „Trial of Ariah“ zeigt LLM-Codierungspotenzial : Ein unabhängiger Entwickler hat das Spiel „Trial of Ariah“ vollständig mit Claude AI programmiert. Der Entwickler wies darauf hin, dass Claude das gleichzeitige Importieren von bis zu 20 Skripten unterstützt, was Fehler im Vergleich zu ChatGPT erheblich reduziert und die Entwicklungseffizienz steigert. Obwohl betont wird, dass „reines Vibe Coding“ nicht existiert und Entwickler weiterhin über Grundkenntnisse verfügen müssen, um Halluzinationen und Fehler von LLMs zu erkennen, demonstriert dieser Fall die starke unterstützende Fähigkeit von LLMs in komplexen Projekten wie der Spieleentwicklung. (Quelle: Reddit r/ClaudeAI)

📚 Lernen

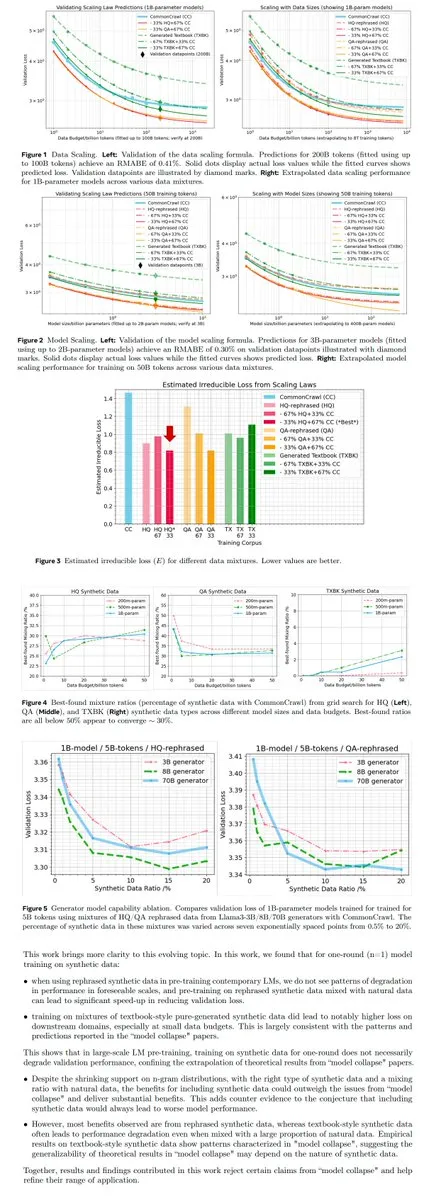

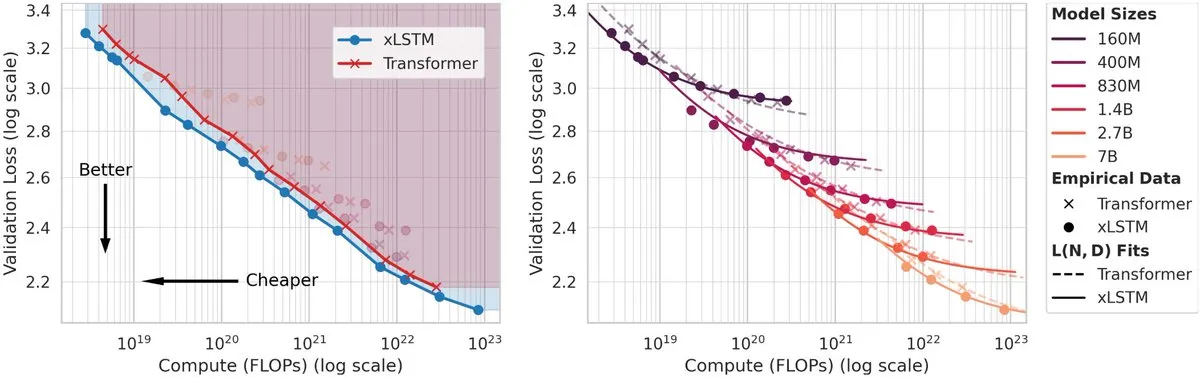

Neue Paradigmen für LLM-Training und -Optimierung : Mehrere Artikel untersuchen neue Paradigmen für das LLM-Training, darunter die Anwendung synthetischer Daten (Meta-Forschung), PPO/GRPO und menschliche Wahrnehmungsverzerrungen (Humanline) sowie Strategien wie One-Token Rollout (OTR). Ziel ist es, die Generalisierungsfähigkeit des Modells zu verbessern, Probleme mit spärlichen Belohnungen und katastrophalem Vergessen zu lösen und die Trainingskosten zu optimieren. Diese Forschungen bieten neue theoretische und praktische Anleitungen für das Fine-Tuning und Pre-Training von LLMs und betonen die Bedeutung von Datenstrategien, Belohnungsdesign und Trainingsparadigmen. (Quelle: teortaxesTex, tokenbender, HuggingFace Daily Papers, YejinChoinka, arankomatsuzaki)

LLM-Architektur und Effizienzoptimierung : Fokus auf interne LLM-Mechanismen, wie die Effizienz der Nutzung des latenten Raums von Feed-Forward Networks (FFN) („Spectral Scaling Laws“), den Vergleich der Skalierungsgesetze von xLSTM und Transformer sowie parallele Inferenztechniken (Bridge), um die Modellleistung zu steigern und gleichzeitig die Rechenkosten zu senken. Diese Forschungen liefern wichtige Einblicke für das Design und die Bereitstellung der nächsten Generation von LLMs. (Quelle: HuggingFace Daily Papers, ethanCaballero, HuggingFace Daily Papers)

AI-Sicherheit und Modellrobustheit : Erforschung der Sicherheitsherausforderungen von AI-Modellen, einschließlich der potenziellen Gefährdung der LLM-Sicherheitsausrichtung durch Activation Steering („The Rogue Scalpel“), der Erkennung von Halluzinationsfragmenten (RL4HS) und Poisoning-Angriffen auf 3D Gaussian Splatting (3DGS) („StealthAttack“). Diese Forschungen decken potenzielle Schwachstellen von AI-Systemen auf und schlagen Methoden zur Verbesserung der Modellsicherheit und -zuverlässigkeit vor. (Quelle: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

Verbesserung der Wahrnehmungs- und Inferenzfähigkeiten multimodaler Modelle : Umfasst Forschungen zur Multi-Subjekt-Fidelity von T2I-Modellen, spärlichen Belohnungen in der feingranularen visuellen Inferenz von MLLMs (RewardMap), VLM-Wahrnehmungsinferenz (AGILE), Videoverständnis (VideoNSA) und trainingsunabhängiger kombinatorischer Bildsuche (SQUARE). Diese Arbeiten verschieben gemeinsam die Leistungsgrenzen multimodaler Modelle bei Aufgaben wie Bildgenerierung, visueller Fragebeantwortung, Videoanalyse und Cross-Modality-Retrieval. (Quelle: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

AI Karriereentwicklung und Lernressourcen : Zusammenstellung von Schlüsselkompetenzen im AI-Bereich für 2025, Karriere-Roadmaps für Data Scientists und LLM Scientists, Karriereentwicklungstipps für AI-Forscher sowie Ressourcen wie Claude Cookbooks, um AI-Profis umfassende Orientierung zu bieten. (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, BlackHC, Reddit r/deeplearning, GitHub Trending)

💼 Business

OpenAI Bewertung übersteigt 500 Milliarden US-Dollar, wird wertvollstes Startup weltweit : OpenAI erreicht eine Bewertung von 500 Milliarden US-Dollar und übertrifft damit SpaceX als wertvollstes privates Startup-Unternehmen weltweit. Dieser Meilenstein spiegelt das enorme Vertrauen des Marktes in die AI-Technologie und ihr Kommerzialisierungspotenzial wider, obwohl er auch Diskussionen über Bewertungsblasen und das Geschäftsmodell des Unternehmens ausgelöst hat. Darüber hinaus hat ChatGPT eine Funktion für direktes Online-Shopping in der Chat-Oberfläche hinzugefügt, was seine kommerziellen Anwendungsszenarien weiter erweitert. (Quelle: TheRundownAI, Dorialexander, dl_weekly)

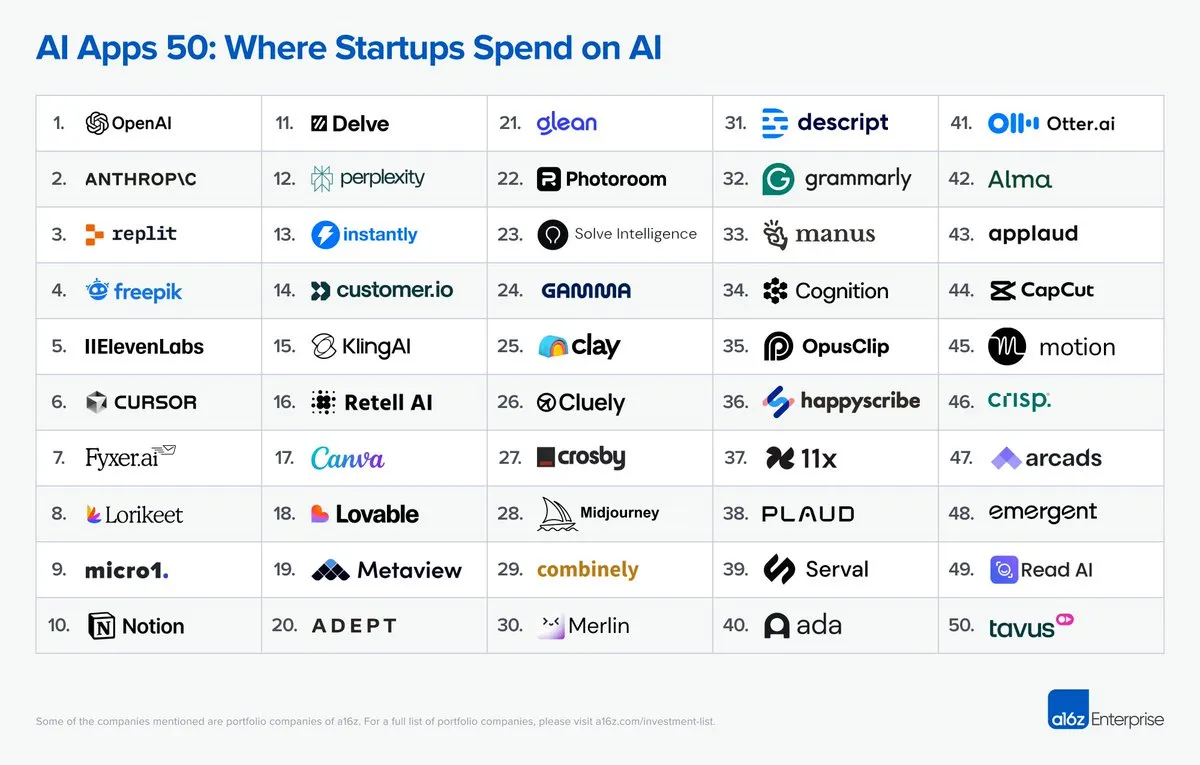

AI Apps 50 Bericht enthüllt AI-Ausgabentrends von Startups : a16z hat in Zusammenarbeit mit Mercury den Bericht „AI Apps 50: Startup Edition“ veröffentlicht, der die Ausgaben von Startups für AI-Anwendungen analysiert. Der Bericht bietet Einblicke in die tatsächliche Anwendung und Investitionsrichtungen der AI-Technologie in Startups und hilft, die AI-Marktlandschaft und aufkommende Trends zu verstehen, was für Investoren und Unternehmer von Referenzwert ist. (Quelle: amasad, amasad)

Groq implementiert AI-Stack schnell und kooperiert mit McLaren F1 : Groq implementiert seinen AI-Stack mit „beispielloser Geschwindigkeit“ und arbeitet mit dem McLaren F1-Team zusammen, um das Anwendungspotenzial seiner AI-Chips im Bereich des Hochleistungsrechnens zu demonstrieren. Diese Zusammenarbeit unterstreicht den Wert der AI-Technologie in Branchen, die extrem schnelle Datenverarbeitung und Entscheidungsfindung erfordern, wie dem Motorsport, und deutet auf eine schnelle Expansion von Groq im AI-Hardwaremarkt hin. (Quelle: JonathanRoss321, JonathanRoss321)

🌟 Community

AI im Kreativbereich (Musik, Schreiben, Kunst) – Neugestaltung und Herausforderungen : AI verändert kreative Bereiche wie Musik, Schreiben und Kunst grundlegend, indem es Inhalte algorithmisch generiert. Dies hat weitreichende Diskussionen über die Rolle von AI in der Kreativbranche, Modelle der Mensch-AI-Zusammenarbeit und die Urheberrechtszuordnung ausgelöst. AI-Künstler stehen vor der Herausforderung, technische Unterstützung und Originalität in Einklang zu bringen. Gleichzeitig wirken sich AI-generierte Inhalte auf traditionelle Kreativmärkte und die Einkommensmodelle von Kreativen aus. (Quelle: Ronald_vanLoon, Ronald_vanLoon, Reddit r/artificial)

Auswirkungen von AI auf die Realitätswahrnehmung und das Vertrauen in digitale Inhalte : Mit der Verbreitung von AI-Generierungstools wie Sora 2 wächst die Sorge, dass AI Musik, Filme, Animationen und sogar Personen perfekt imitieren kann, was dazu führt, dass digitale Inhalte schwer von echten zu unterscheiden sind und Online-Medien möglicherweise emotionale Verbindung und Vertrauen verlieren. Die Community diskutiert, dass Menschen in Zukunft möglicherweise mehr Wert auf echte Offline-Erlebnisse legen werden, während AI-generierte Inhalte eine neue „digitale Hippie“-Kultur fördern könnten, die nur Medien aus der Zeit vor AI konsumiert. Gleichzeitig gibt es die Ansicht, dass die Echtheit von AI-generierten Inhalten unwichtig ist, wenn deren Qualität hoch ist. (Quelle: vikhyatk, Reddit r/ArtificialInteligence, Reddit r/artificial, VictorTaelin)

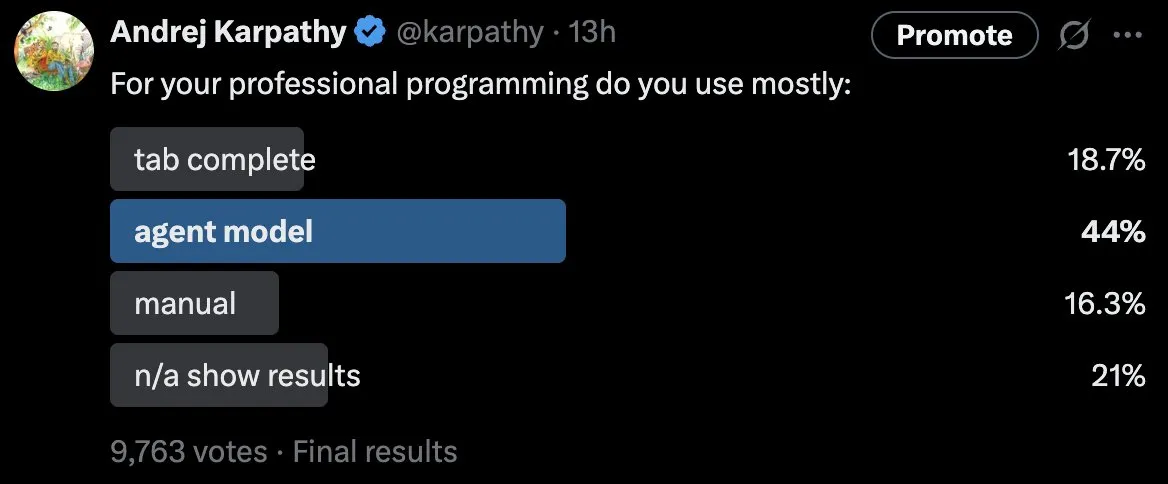

LLM-Anwendungsmuster und Herausforderungen in der professionellen Programmierung : Eine von Andrej Karpathy initiierte Umfrage zeigt, dass etwa die Hälfte der professionellen Programmierer „hauptsächlich“ den Agentenmodus verwenden (d.h. LLMs über Textprompts große Mengen an Code schreiben lassen). Er zeigte sich überrascht und argumentierte, dass LLMs bei der Bearbeitung komplexer oder von den Trainingsdaten abweichender Probleme anfällig für Fehler, Redundanzen und subtile Ungenauigkeiten sind. Dies löste eine tiefgehende Diskussion über die tatsächlichen Fähigkeiten von LLMs in der professionellen Programmierung, optimale Mensch-Maschine-Kollaborationsmodelle und die Grenzen des „Vibe Coding“ aus, wobei betont wird, dass AI bei tiefem, verstricktem Code immer noch Mängel aufweist. (Quelle: karpathy)

AI-Sicherheit und Sorgen vor Biobedrohungen : Microsoft warnt, dass AI „Zero-Day“-Biobedrohungen erzeugen könnte, was tiefe Besorgnis in der Community über die AI-Sicherheit auslöst. Gleichzeitig lösten Experimente, bei denen AI „Verschwörungen zur Tötung von Forschern“ schmiedete, Diskussionen aus. Die meisten sind der Meinung, dass LLMs lediglich Text basierend auf Datenmustern vorhersagen und nicht wirklich „denken“ oder „verschwören“, aber einige befürchten, dass AI Böses aus menschlichem Verhalten lernen könnte. Diese Diskussionen unterstreichen die kritischen Fragen der Ethik, Sicherheit und Kontrolle in der AI-Entwicklung. (Quelle: Reddit r/artificial, Reddit r/ArtificialInteligence)

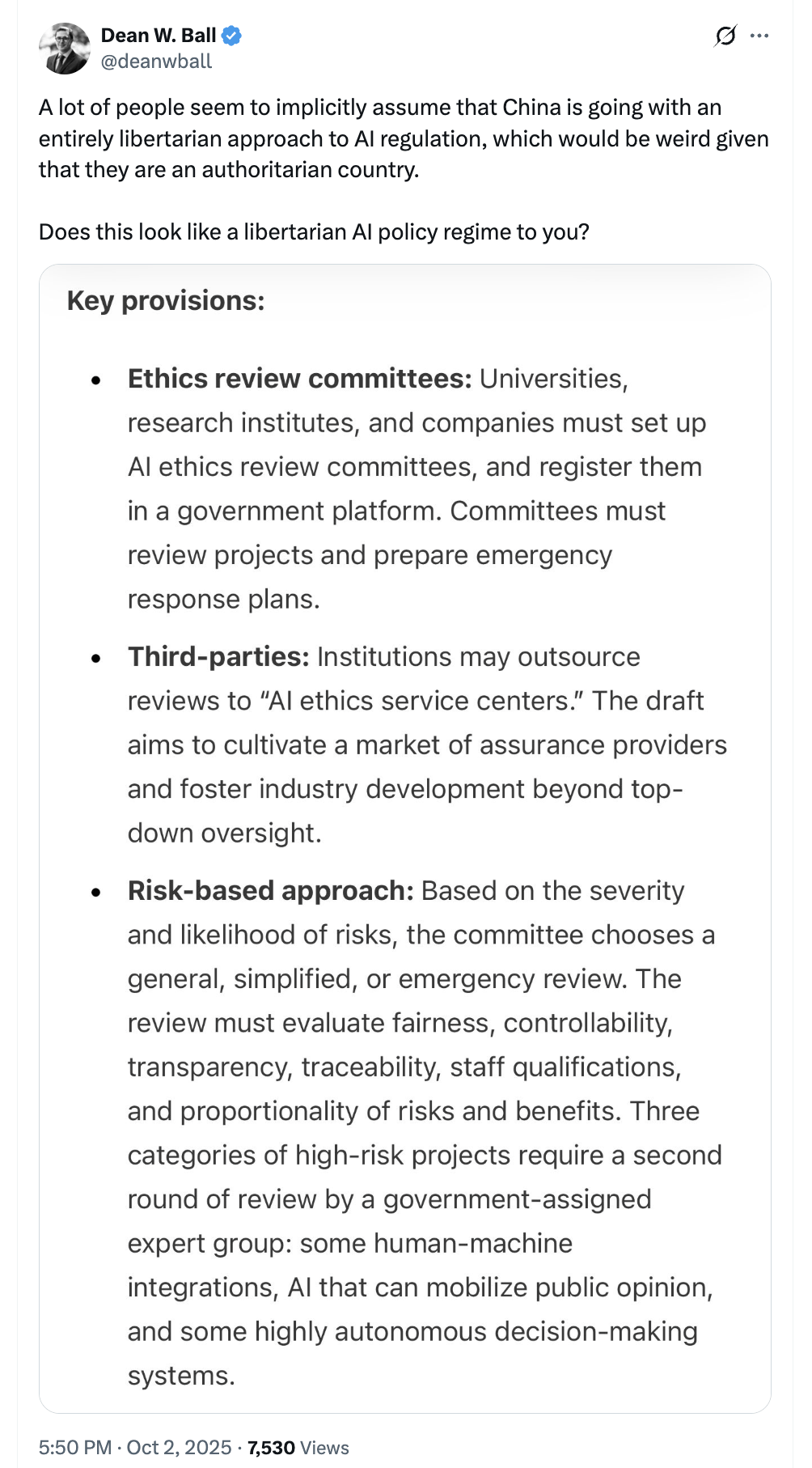

AI-Regulierung: Unterschiede in den Strategien Chinas und des Westens sowie geopolitische Auswirkungen : Als Reaktion auf die Behauptung von AI-Lobbyisten, „China reguliert AI nicht, daher würde jede Regulierung dazu führen, dass wir ins Hintertreffen geraten“, wird argumentiert, dass China tatsächlich strengere AI-Regulierungen als die USA umsetzt. Die Community diskutiert, dass die Entwicklung der AI-Technologie schwer vollständig zu unterdrücken ist und Regulierung hauptsächlich die kommerzielle Umsetzung, nicht aber die Forschung selbst, beeinflusst. AI wird zunehmend zu einem geopolitischen Thema, und der Wettbewerb zwischen dem Westen und China um den AI-Stack wird als entscheidender Plattformkampf angesehen. (Quelle: teortaxesTex, Reddit r/artificial, kylebrussell)

AI-Anwendungen und Kontroversen im Bildungsbereich : Eine „Alpha School“ mit 40.000 US-Dollar Jahresgebühr gestaltet jede Unterrichtsstunde durch AI-gesteuerte personalisierte Software, wobei Erwachsene im Klassenzimmer die Rolle von „Mentoren“ statt traditioneller Lehrer einnehmen. Dieses Modell löst Diskussionen darüber aus, ob AI Lehrer ersetzen wird, über Bildungsgerechtigkeit und die Angemessenheit der hohen Schulgebühren. Befürworter argumentieren, dass AI für jeden Schüler individuelle Lernpläne erstellen und das „Einheitslösung“-Problem der traditionellen Bildung lösen kann; Gegner befürchten die Auswirkungen auf das Geschäftsmodell und die Rolle der Lehrer. (Quelle: Reddit r/artificial, Reddit r/ArtificialInteligence)

AI und die Zukunft von Urheberrecht und Inhaltserstellung : Künstler hoffen, die AI-Entwicklung durch Urheberrechtsschutz aufzuhalten, aber es gibt die Ansicht, dass die nächste Generation von Führungskräften die Vorteile von „alles kann remixed werden“ und kostenloser Verbreitung erkennen wird. Dies deutet darauf hin, dass AI die Inhaltserstellung in ein neues Paradigma führen wird, das traditionelle Urheberrechtskonzepte und das kreative Ökosystem herausfordert. Darüber hinaus löst die Frage, ob für die Trainingsdaten von Sora 2 (wie Instagram, YouTube, TikTok) Urheberrechtsgebühren gezahlt wurden, ethische Diskussionen aus. (Quelle: kylebrussell, bookwormengr)

AI-Agenten revolutionieren die Beobachtbarkeit : Agentic AI definiert die Beobachtbarkeit neu und verschiebt den Fokus von der Fehlerbehebung zur Lebenszyklustransformation. AI-Agenten beschleunigen nicht nur die Ereignisreaktion, sondern verbessern auch die Erkennung, Überwachung, Datenerfassung und Behebung über den gesamten Beobachtbarkeits-Lebenszyklus hinweg. Sie wandeln „Suchen“ in „Inferieren“ um und ermöglichen es Benutzern, den Systemstatus direkt abzufragen. Darüber hinaus sind für AI-Workloads neue Metriken erforderlich, um Halluzinationen, Verzerrungen, Kosten und die Qualität der LLM-Nutzung zu überwachen. (Quelle: Ronald_vanLoon)

Herausforderungen und Erfolgsstrategien bei der AI-Produktintegration : Die Community diskutierte die Gründe für das Scheitern von 99% der Unternehmen bei der AI-Integration und erfolgreiche Strategien. Es wurde betont, dass die Betrachtung von AI als Kernstrategie, die Konzentration auf den Geschäftswert, die Überwindung von Integrationshindernissen und der Aufbau einer Unternehmenskultur, die AI-Innovation unterstützt, entscheidend für den Erfolg sind und praktische Anleitungen für die effektive Bereitstellung von AI in Unternehmen bieten. (Quelle: Ronald_vanLoon)

AI-generierte Inhalte und ethische Probleme: AI-Betrugsroboter : AI-Betrugsroboter geben sich als Menschen aus, um Gespräche zu führen und Finanzbetrügereien wie „Pig Butchering“ zu begehen, was in der Community Bedenken hinsichtlich des Missbrauchs von AI-Technologie, der Authentizität digitaler Identitäten und der Sicherheit der Nutzerdaten auslöst. Es wird zur Wachsamkeit aufgerufen und die Erkennung und Bekämpfung immer komplexerer AI-Betrugsmethoden diskutiert. (Quelle: Reddit r/ArtificialInteligence)

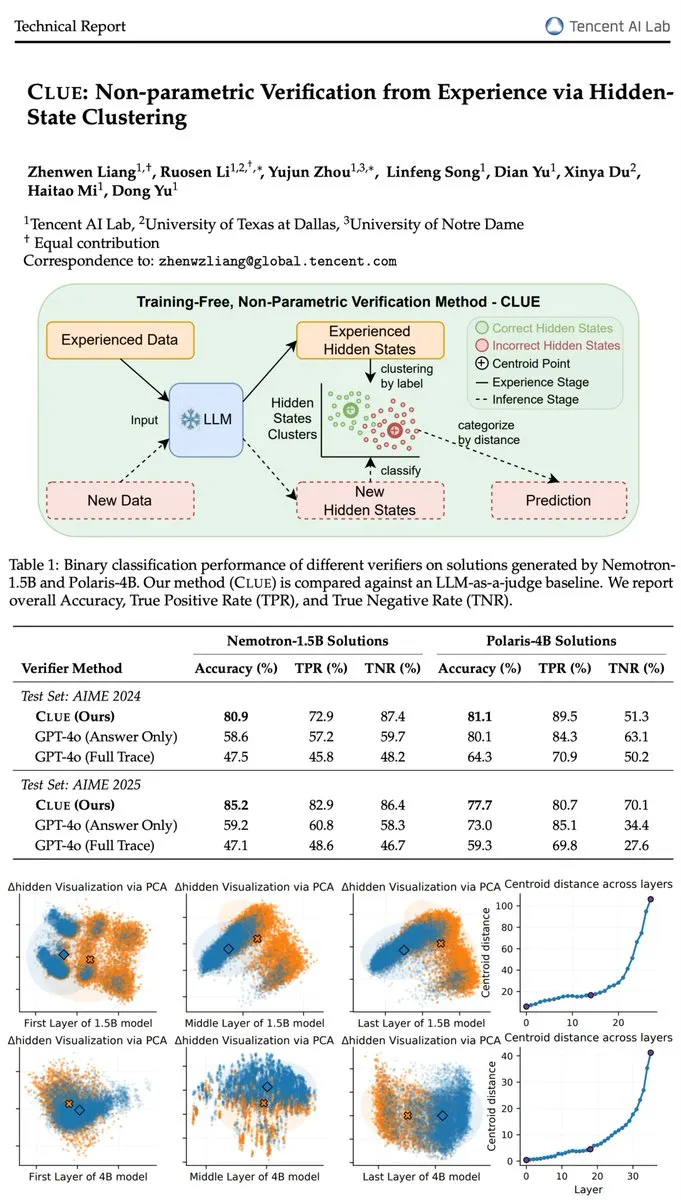

LLM-Halluzinationsproblem und Validierungsmodell CLUE : Der vom Tencent AI Lab entwickelte CLUE-Validierer übertrifft die Validierungsgenauigkeit von GPT-4o ohne Trainingsparameter, indem er versteckte Zustände durch Clusteranalyse inferiert und das LLM-Halluzinationsproblem effektiv löst. Diese Innovation bietet eine effiziente und erklärbare Lösung zur Verbesserung der Zuverlässigkeit und faktischen Genauigkeit von LLMs. (Quelle: teortaxesTex, menhguin)

Kling AI 2.5 Turbo und Sora 2 im Videogenerierungs-Wettbewerb : Kling AI 2.5 Turbo wird aufgrund seiner hochwertigen Video-Generierung als starker Konkurrent von Sora 2 angesehen; Nutzer demonstrierten seine Fähigkeiten in komplexen Szenarien und visuellen Effekten. Die Community diskutiert, dass chinesische AI-Anwendungen schnell aufholen, aber die Audioverarbeitung verbessern müssen, was auf einen intensiven Wettbewerb im Bereich der Videogenerierung hindeutet. (Quelle: bookwormengr, Kling_ai, Kling_ai, Kling_ai, bookwormengr)

💡 Sonstiges

Fortschritte in der Robotertechnologie: Schiffsinspektion, Popcorn-Service und Fabrik-Qualitätskontrolle : Die Robotertechnologie entwickelt sich ständig weiter und bringt vielfältige Anwendungen hervor. Zum Beispiel werden Roboter zur Inspektion von Schiffswänden eingesetzt, um die Schiffssicherheit zu gewährleisten. Der Optimus-Roboter demonstrierte seine Servicefähigkeiten, indem er Popcorn servieren konnte. Das Unternehmen CasiVision hat den rollenden humanoiden Roboter CASIVIBOT vorgestellt, der speziell für die Qualitätskontrolle in intelligenten Fabriken entwickelt wurde. Diese Fortschritte zeigen, dass Roboter schrittweise in verschiedene Branchen vordringen und das Niveau der Automatisierung sowie die Arbeitseffizienz steigern. (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Meta FAIR veröffentlicht Code World Model (CWM) zur Erforschung von Codegenerierung und -inferenz : Meta FAIR hat das Code World Model (CWM) veröffentlicht, ein Forschungsmodell mit 32 Milliarden Parametern, das erforschen soll, wie Weltmodelle die Codegenerierung und Code-Inferenz verändern können. Die Veröffentlichung von CWM soll den Fortschritt in der Weltmodellforschung vorantreiben und wird unter einer Forschungslizenz geteilt, um die Community zu weiteren Innovationen im Bereich des Code-Verständnisses und der Generierung zu befähigen. (Quelle: NandoDF)

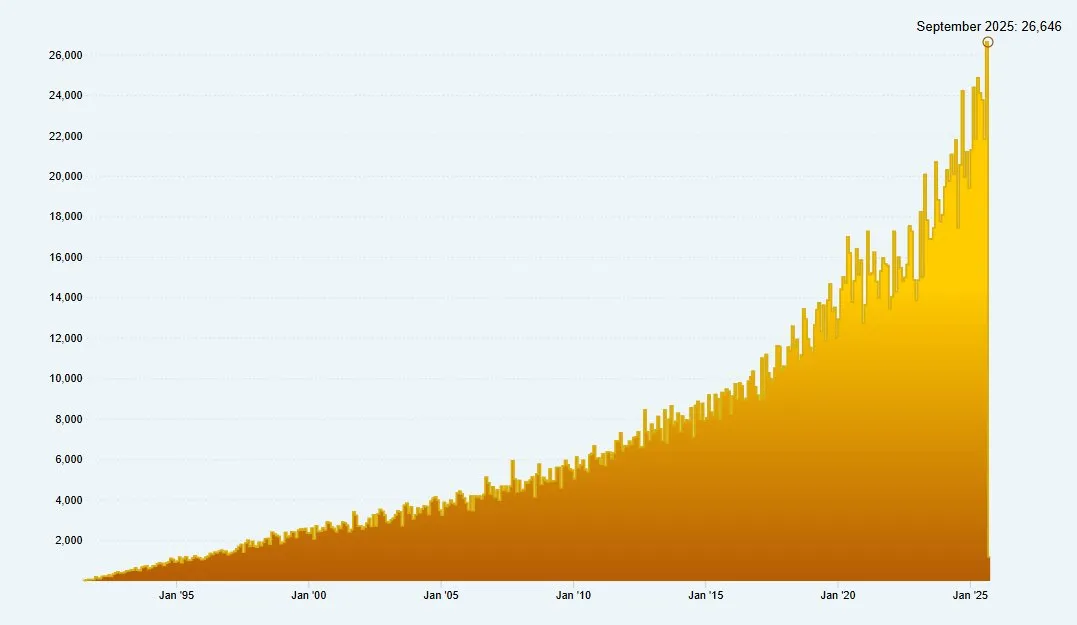

Starker Anstieg der arXiv-Paper-Einreichungen und Redaktionsdruck : arXiv erhielt im September 2025 insgesamt 26.646 neue Paper-Einreichungen, während nur 7 Redakteure und Support-Mitarbeiter zur Verfügung standen. Dieses enorme Arbeitsaufkommen löst Bedenken hinsichtlich des Betriebs- und Leistungsdrucks von Open-Access-Plattformen aus und unterstreicht die Herausforderungen bei der Überprüfung und Verwaltung von Papers im Kontext der rasanten Entwicklung der wissenschaftlichen Forschung. (Quelle: clefourrier)