Schlüsselwörter:KI-Bias, Humanoider Roboter, Feinabstimmung von Großmodellen, DeepSeek-V3.2, vLLM, KI-Brillen, Bestärkendes Lernen, OpenAI-Kasten-Bias, Galaxy Universal Any2Track Framework, Tinker Feinabstimmungs-API, vLLM Multimodal-Unterstützung, NVIDIA KI Blueprint VSS 2.4

🔥 Fokus

Kasten-Voreingenommenheit in OpenAI-Modellen sorgt für Besorgnis : Eine Untersuchung des MIT Technology Review zeigt, dass GPT-5 und Sora auf dem indischen Markt eine starke Kasten-Voreingenommenheit aufweisen, indem sie Dalits mit Armut und niedrigeren Berufen assoziieren, während Brahmanen mit Gelehrsamkeit und spirituellem Status in Verbindung gebracht werden. GPT-4o zeigte weniger Voreingenommenheit. Bestehende KI-Voreingenommenheitsbewertungsstandards (wie BBQ) decken Kasten nicht ab, und Forscher entwickeln neue Benchmarks. Dies wirft Bedenken hinsichtlich der Fairness und potenziellen sozialen Auswirkungen von KI-Modellen in nicht-westlichen Kulturkontexten auf. (Quelle: MIT Technology Review)

Galaxy General Any2Track Framework ermöglicht hochgradig störungsresistente Bewegungsverfolgung für humanoide Roboter : Galaxy General Robotics hat das universelle Bewegungsverfolgungs-Framework Any2Track vorgestellt, das humanoiden Robotern (wie Unitree G1) ermöglicht, komplexe menschliche Bewegungen präzise zu imitieren und sich in Echtzeit an externe Störungen anzupassen, wobei sie selbst bei wiederholten Tritten stabil bleiben. Das Framework nutzt zweistufiges Reinforcement Learning, um Zero-Shot Sim2Real zu erreichen. Die Technologie wurde bereits in den Einzelhandelsgeschäften „Galaxy Space Capsule“ eingesetzt und treibt die Kommerzialisierung von Embodied AI vom Labor aus voran, mit dem Potenzial, eine internationale Visitenkarte für Chinas Roboterindustrie zu werden. (Quelle: 量子位)

Thinking Machines Lab veröffentlicht Tinker, senkt die Hürde für das Fine-Tuning großer Modelle erheblich : Das Thinking Machines Lab, gegründet von ehemaligen Kernmitgliedern von OpenAI und Google DeepMind, hat sein erstes Produkt, Tinker, eine flexible LLM-Fine-Tuning-API, vorgestellt. Dieses Tool ermöglicht es Forschern, komplexe Aufgaben wie Infrastrukturmanagement, Modell-Forward- und Backward-Propagation sowie verteiltes Training der Plattform zu überlassen, während sie die Kontrolle über Algorithmen und Daten behalten. Dies senkt die Kosten und die technische Hürde für das Fine-Tuning erheblich. Tinker unterstützt die Modellreihen Qwen3 und Llama3 und nutzt die LoRA-Technologie zur GPU-Freigabe, um die Effizienz zu steigern, was als wichtige Steigerung der Produktivität in der KI-Forschung angesehen wird. (Quelle: 量子位)

🎯 Trends

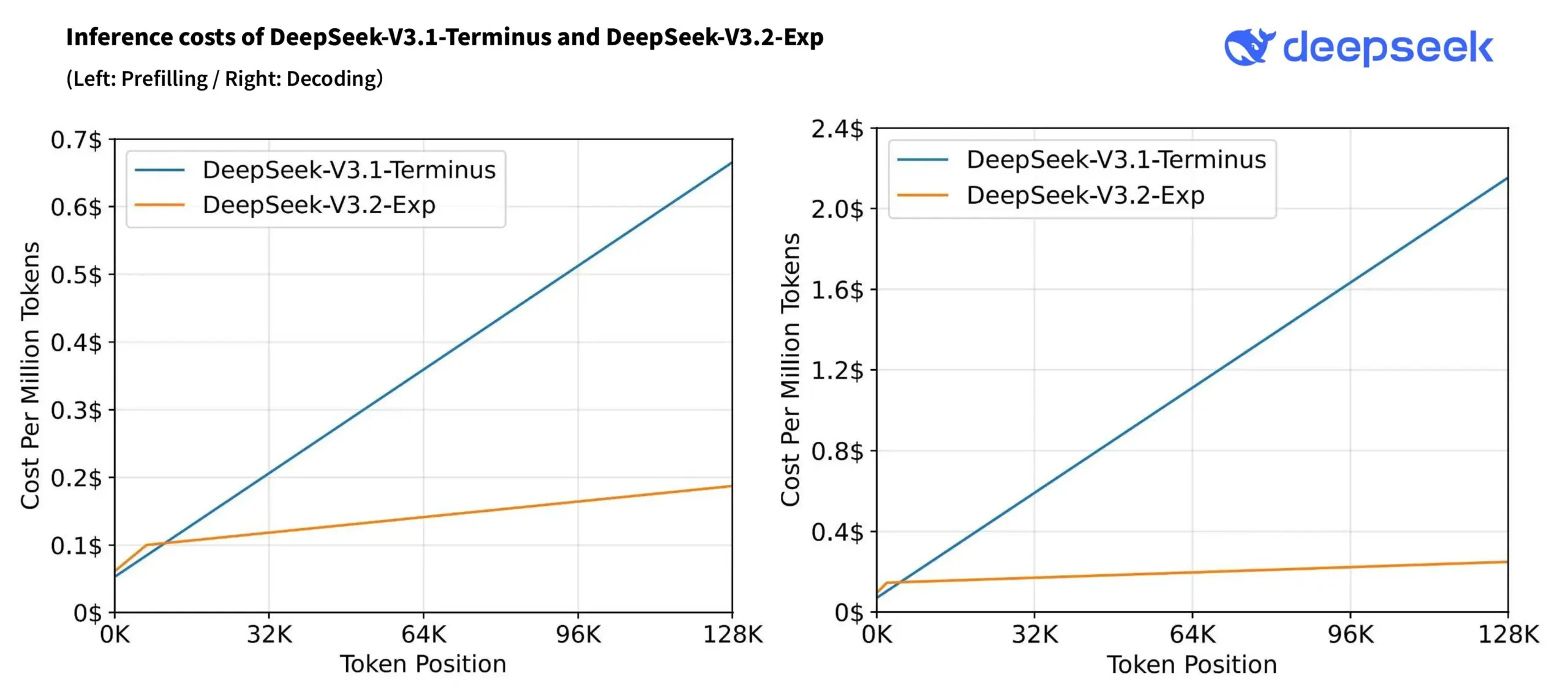

DeepSeek-V3.2-Exp Modell veröffentlicht und API-Preise gesenkt : DeepSeek hat das experimentelle Modell DeepSeek-V3.2-Exp veröffentlicht, das DeepSeek Sparse Attention (DSA) einführt, um die Effizienz der Langkontextverarbeitung zu verbessern und die Rechenkosten zu senken. Die API-Preise wurden um über 50% gesenkt, während das Modell in den WeirdML-Benchmarks hervorragende Leistungen zeigte, was das Preis-Leistungs-Verhältnis und die Inferenzleistung weiter verbessert. (Quelle: deepseek_ai, teortaxesTex)

vLLM v0.10.2 Update: Unterstützung für Multimodalität und Inferenzoptimierung : vLLM hat Version 0.10.2 veröffentlicht, die Unterstützung für verschiedene Modelle wie Qwen3-Next/Omni/VL, InternVL 3.5 und Whisper hinzufügt. Zudem wurden Decode Context Parallel und vollständige cudagraph-Unterstützung eingeführt, was die LLM-Inferenzleistung und -effizienz erheblich optimiert. (Quelle: vllm_project)

Apple verlagert Fokus auf KI-Smart-Brillen-Entwicklung, stellt günstige Vision Pro-Version zurück : Apple hat die Entwicklung einer günstigeren Version der Vision Pro eingestellt und priorisiert stattdessen die Forschung und Entwicklung von KI-Smart-Brillen, um mit Konkurrenten wie Meta zu konkurrieren. Dieser Schritt zeigt, dass Apple die KI-Technologie als Kern seiner zukünftigen Hardware-Strategie betrachtet, insbesondere im Bereich der Wearables, und deutet auf eine signifikante Verschiebung des zukünftigen Produktfokus hin. (Quelle: nptacek, TheRundownAI)

NVIDIA AI Blueprint VSS 2.4 veröffentlicht: Stärkung des Verständnisses der physischen Welt und Edge AI : NVIDIA hat AI Blueprint VSS 2.4 veröffentlicht, das Cosmos Reason VLM integriert, um das Verständnis der KI für die physische Welt erheblich zu verbessern. Es erweitert auch die Q&A-Funktionalität durch Agent Knowledge Graph Traversal und unterstützt die Edge AI-Bereitstellung, was eine stärkere Grundlage für multimodale KI-Anwendungen bietet. (Quelle: dl_weekly)

LLM-Kodierungsfähigkeiten im Vergleich: GPT-5 Codex übertrifft Claude Sonnet 4.5 : Entwicklerdiskussionen zeigen, dass OpenAIs GPT-5 Codex in der Code-Generierung und -Planung die Modelle Claude 3.5/4 übertroffen und Sonnet 4.5 übertroffen hat, insbesondere bei der Erstellung prägnanteren Codes und im Systemdesign, was die neuesten Fortschritte von OpenAI im Bereich der Kodierungs-KI demonstriert. (Quelle: dejavucoder, dejavucoder)

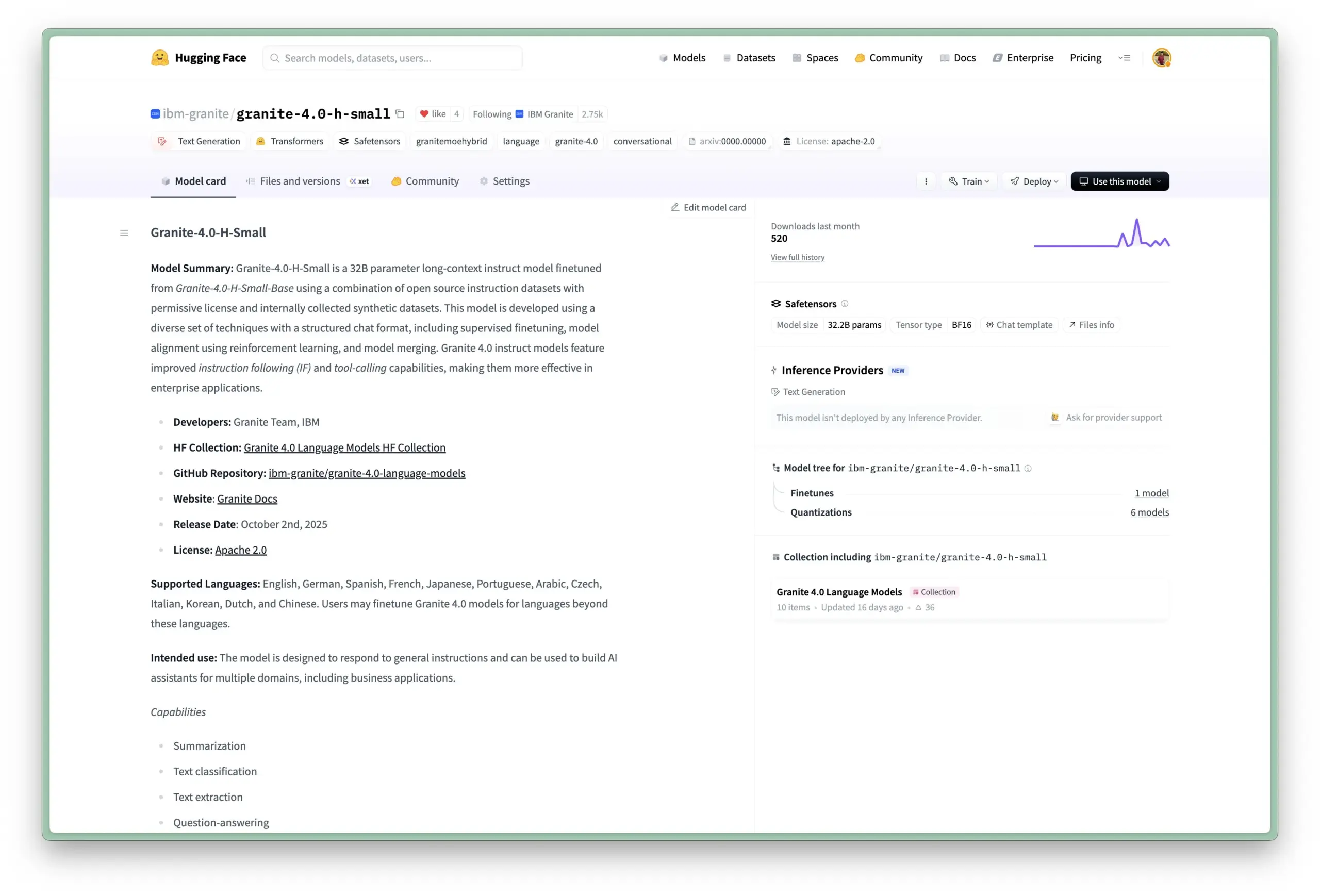

IBM veröffentlicht Granite 4.0 Sprachmodellreihe : IBM hat die Granite 4.0 Sprachmodellreihe vorgestellt, die 32B-A9B, 7B-A1B und 3B dichte Modelle umfasst und im GGUF-Format verfügbar ist. Diese Modelle unterstützen Mehrsprachigkeit, Tool-Calling und lange Kontexte und sind unter der Apache 2.0 Lizenz quelloffen. Sie zielen darauf ab, Hochleistungslösungen für lokale Bereitstellungen und spezifische Anwendungsszenarien bereitzustellen. (Quelle: reach_vb, Dorialexander, huggingface)

Flash-Searcher: Schnelles und effizientes Web-Agenten-Framework basierend auf DAG-paralleler Ausführung : Flash-Searcher ist ein neuartiges paralleles Agenten-Inferenz-Framework, das Aufgaben in Unteraufgaben mit klaren Abhängigkeiten zerlegt und eine gleichzeitige Ausführung über einen gerichteten azyklischen Graphen (DAG) ermöglicht. Das Framework optimiert den Workflow dynamisch, übertrifft bestehende Methoden in mehreren Benchmarks und verbessert die Effizienz und Genauigkeit der Agentenausführung erheblich, was ein skalierbareres Paradigma für komplexe Inferenzaufgaben bietet. (Quelle: HuggingFace Daily Papers)

DeepSearch: MCTS integriert in RLVR-Training, durchbricht RL-Engpass kleiner Modelle : Das DeepSearch-Framework integriert Monte Carlo Tree Search (MCTS) direkt in das Reinforcement Learning mit verifizierbaren Belohnungen (RLVR) von LLMs, wodurch der Leistungsengpass bestehender RLVR-Methoden, der durch spärliche Exploration verursacht wird, gelöst wird. Diese Methode erreicht durch Exploration während des Trainings, globale Frontier-Auswahl und adaptives Replay-Buffer-Training ein hochmodernes Niveau für 1.5B Inferenzmodelle und reduziert die GPU-Trainingszeit erheblich. (Quelle: HuggingFace Daily Papers)

QUASAR: Werkzeuggestütztes LLM-Agenten-RL zur Generierung von Quanten-Assemblercode : QUASAR ist ein Agenten-Reinforcement-Learning (RL)-Framework, das werkzeuggestützte LLMs zur Generierung und Optimierung von Quanten-Assemblercode nutzt. Es wurde für die Verifizierung von Quantenschaltkreisen und hierarchische Belohnungsmechanismen entwickelt, was die syntaktische und semantische Leistung der generierten Quantenschaltkreise erheblich verbessert. Ein 4B LLM erreicht dabei 99,31% bzw. 100% Effektivität bei Pass@1 und Pass@10 und übertrifft damit industrielle LLMs wie GPT-4o, GPT-5 und DeepSeek-V3. (Quelle: HuggingFace Daily Papers)

🧰 Tools

Atuin Desktop: Ausführbarer Runbook-Editor, der Dokumentation und Automatisierung verbindet : Atuin Desktop ist ein lokaler, ausführbarer Runbook-Editor, der die Lücke zwischen Dokumentation und Automatisierung schließen soll. Er ermöglicht es Benutzern, Shell-Befehle, Datenbankabfragen und HTTP-Anfragen in einer einzigen Oberfläche zu verketten, dynamische Workflows durch Jinja-ähnliche Vorlagen zu implementieren und CRDT-gesteuerte Zusammenarbeit zu unterstützen. Er eignet sich für Szenarien wie Release-Management, Infrastrukturmigration und Datenbankoperationen. (Quelle: GitHub Trending)

Tile Language: DSL für die Entwicklung von Hochleistungs-GPU/CPU-Kernen : Tile Language (tile-lang) ist eine prägnante domänenspezifische Sprache, die speziell entwickelt wurde, um die Entwicklung von Hochleistungs-GPU/CPU-Kernen (wie GEMM, FlashAttention) zu vereinfachen. Sie verwendet eine Pythonic-Syntax, basiert auf der TVM-Compiler-Infrastruktur, unterstützt verschiedene Geräte wie Huawei Ascend-Chips, AMD MI300X und WebGPU und bietet Unterstützung für Sparse-Tensor-Kerne. Ziel ist es, die Entwicklungseffizienz zu steigern, ohne die Leistung der zugrunde liegenden Optimierungen zu beeinträchtigen. (Quelle: GitHub Trending)

TradingAgents-CN: Multi-Agenten LLM Finanzhandels-Framework für den chinesischen Markt : TradingAgents-CN ist ein auf Multi-Agenten Large Language Models basierendes chinesisches Finanzhandelsentscheidungs-Framework, das speziell für chinesische Benutzer optimiert wurde. Es unterstützt die Analyse von A-Aktien, Hongkong-Aktien und US-Aktien, integriert nationale und internationale LLMs wie Baidu Qianfan, DeepSeek und Google AI und bietet Funktionen wie intelligente Nachrichtenanalyse, Benutzerberechtigungsmanagement, Docker-Bereitstellung und professionellen Berichtsexport. Ziel ist es, die Anwendung von KI-Finanztechnologien in der chinesischen Community zu popularisieren. (Quelle: GitHub Trending)

Google Tunix: JAX-native LLM Post-Training-Bibliothek : Google hat Tunix veröffentlicht, eine auf JAX basierende LLM-Post-Training-Bibliothek, die darauf abzielt, das überwachte Fine-Tuning (SFT), Reinforcement Learning (RL, unterstützt PPO, GRPO, GSPO-token), Präferenz-Fine-Tuning (DPO) und Knowledge Distillation von Large Language Models zu vereinfachen. Sie unterstützt PEFT-Methoden wie LoRA/Q-LoRA und ist für verteiltes Training auf Beschleunigern wie TPUs optimiert. Sie befindet sich in einem frühen Entwicklungsstadium und wird zukünftig Agenten-RL-Training und verteiltes Multi-Host-Training unterstützen. (Quelle: GitHub Trending)

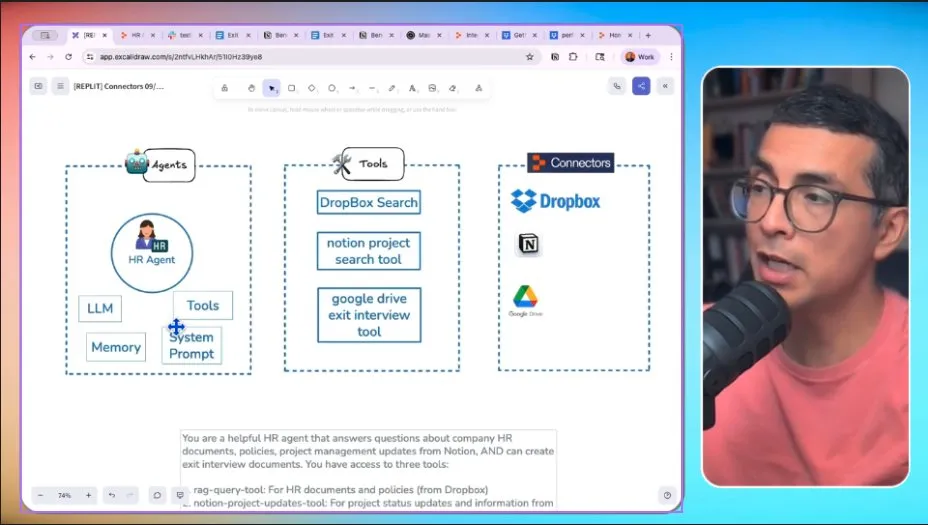

Replit Connectors: Vereinfachen die Anwendungsintegration, stärken KI-Agenten : Replit hat die Connectors-Funktion eingeführt, die es Benutzern ermöglicht, Replit-Anwendungen nahtlos mit alltäglichen Tools wie Google, Dropbox, HubSpot und Notion zu integrieren. Diese Funktion vereinfacht den Entwicklungsprozess erheblich und bietet die Grundlage für den Aufbau von KI-Agenten, die mit externen Diensten interagieren können, wodurch die Anwendungsszenarien der Replit-Plattform weiter erweitert werden. (Quelle: amasad)

Synthesia 3.0: Neue KI-Videoplattform, führt Video-Agenten ein : Synthesia hat Version 3.0 veröffentlicht und eine brandneue KI-Videoplattform mit neuen Funktionen und Workflows sowie dem Konzept der „Video-Agenten“ vorgestellt. Die Plattform zielt darauf ab, die Videoerstellung neu zu definieren, indem sie Benutzern durch KI-Technologie die Möglichkeit gibt, reichhaltigere Videoinhalte zu generieren, und Geschäftskunden effizientere Lösungen für die Videoproduktion bietet. (Quelle: synthesiaIO)

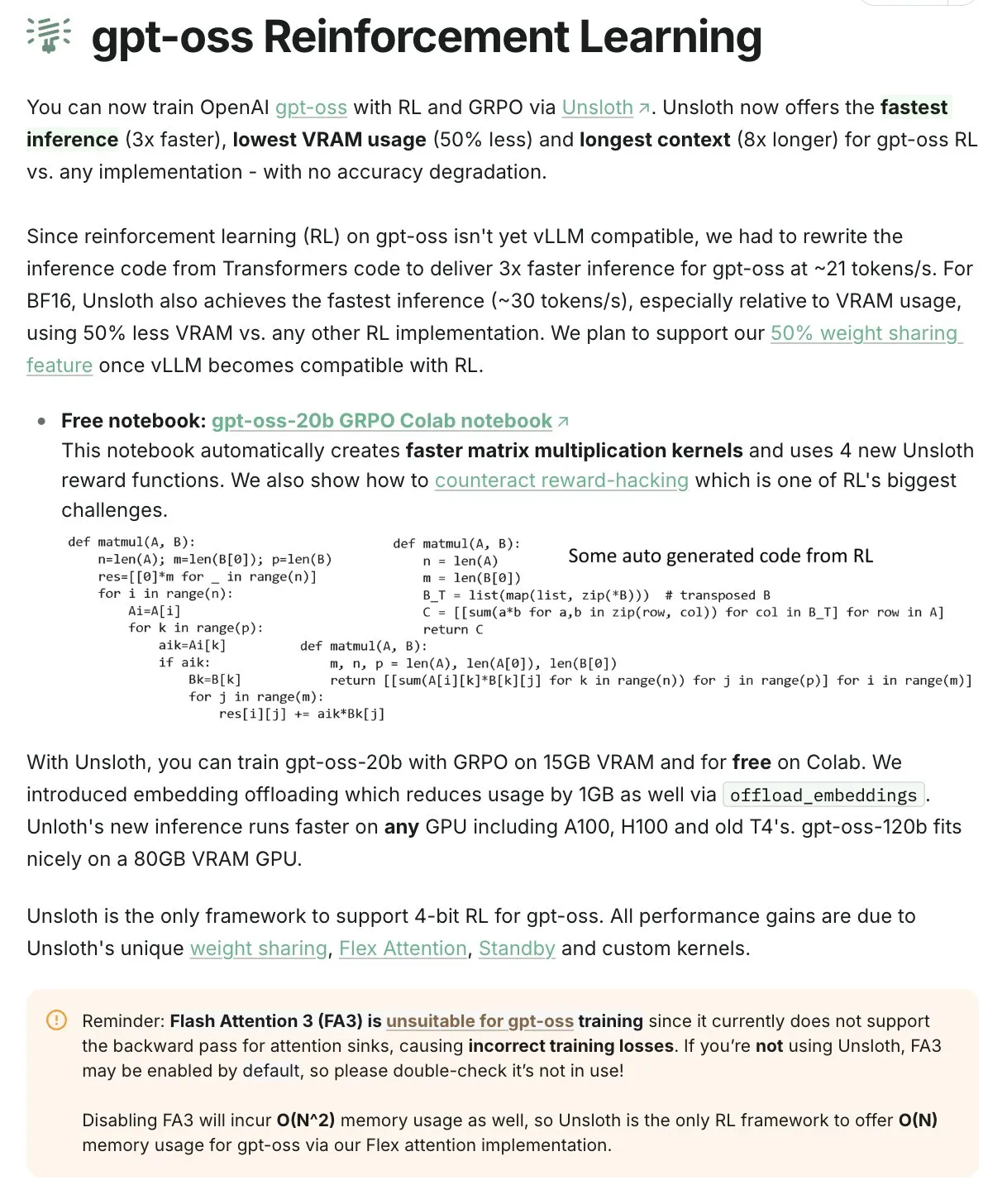

Unsloth: Effizientes LLM-Training und -Inferenz mit geringem VRAM-Bedarf : Unsloth wird als „DOGE“ im Bereich des KI-Trainings gefeiert und ermöglicht es Benutzern, das gpt-oss-20b-Modell mit nur 15 GB VRAM durch Reinforcement Learning zu trainieren, wodurch eine dreimal schnellere Inferenzgeschwindigkeit und eine 50%ige Reduzierung des Speicherbedarfs ohne Genauigkeitsverlust erreicht werden. Dies senkt die Hardware-Hürde für das Training großer LLMs erheblich. (Quelle: bookwormengr)

📚 Lernen

Oberwolfach KI-Mathematik-Workshop fördert Mensch-Maschine-Kollaboration : Der Oberwolfach KI-Mathematik-Workshop brachte Mathematiker, KI-Experten und Industrielabore zusammen, um die Anwendung von KI in der Mathematik zu diskutieren. Ziel des Workshops ist es, die zukünftige Zusammenarbeit zwischen Menschen und KI-Mathematikern zu fördern, die Forschung an komplexen Problemen wie formalen mathematischen Beweisen durch KI voranzutreiben und eine Grundlage für interdisziplinäre Zusammenarbeit zu schaffen. (Quelle: CarinaLHong)

MLOps Lernpfad und Ausbildung zum KI-Ingenieur : In sozialen Medien wurden Lernpfade für MLOps und Ressourcen zur Ausbildung zum KI-Ingenieur geteilt. Die Bedeutung von Künstlicher Intelligenz, Machine Learning und Technologie für die berufliche Entwicklung wird hervorgehoben und bietet Fachleuten, die in den KI-Bereich einsteigen möchten, eine Anleitung, die von grundlegendem Wissen bis zu praktischen Fähigkeiten reicht. (Quelle: Ronald_vanLoon, Ronald_vanLoon)

Operationale Exzellenz in der KI-Transformation: 95% der generativen KI-Pilotprojekte ohne Ertrag : Der MIT Technology Review weist darauf hin, dass trotz erheblicher KI-Investitionen 95% der generativen KI-Pilotprojekte keinen messbaren Gewinn erzielen konnten. Die Hauptursachen liegen in unzureichenden Betriebsabläufen, mangelnder Dokumentation und schlechter Zusammenarbeit, nicht in der Technologie selbst. Eine erfolgreiche KI-Implementierung erfordert operationale Exzellenz, um KI effektiv in die täglichen Arbeitsabläufe zu integrieren. (Quelle: MIT Technology Review, Ronald_vanLoon)

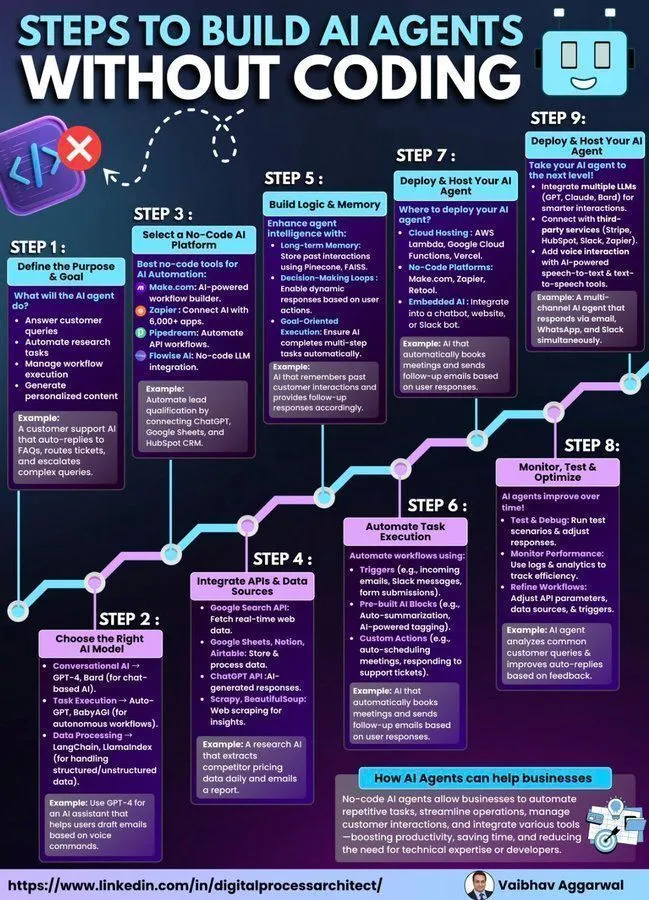

Leitfaden zum Aufbau von KI-Agenten: Von Grund auf und mit No-Code-Methoden : Es werden Anleitungen zum Aufbau von KI-Agenten von Grund auf sowie Schritte zur Implementierung von KI-Agenten mit No-Code-Tools bereitgestellt. Diese Ressourcen sollen die Einstiegshürde für die Entwicklung von KI-Agenten senken und Entwicklern sowie Nicht-Technikern helfen, die Erstellung und Anwendung von KI-Agenten schnell zu verstehen und zu praktizieren, wobei die Bedeutung der Einfachheit im Agentendesign betont wird. (Quelle: Ronald_vanLoon, Ronald_vanLoon)

LLM-Theorie: Suttons „Bittere Lektion“ und das nicht-tierische Lernen von LLMs : Andrej Karpathy diskutierte die Anwendbarkeit von Richard Suttons Theorie der „Bitteren Lektion“ des Reinforcement Learning auf LLMs. Sutton argumentiert, dass LLMs nicht wirklich „bitter lektionsfähig“ sind, da sie auf begrenzte, von Menschen generierte Daten angewiesen sind und nicht wie Tiere durch dynamische Interaktion mit der Welt lernen. Karpathy räumt die „Humanisierung“ der LLM-Entwicklung ein, betrachtet aber das Vortraining als „schlechte Evolution“, die einen Ausgangspunkt für das nachfolgende RL-Fine-Tuning bietet, und fordert dazu auf, sich von tierischer Intelligenz inspirieren zu lassen. (Quelle: Teknium1, Tim_Dettmers, dilipkay)

Vertrauenswürdige KI aufbauen: Balance zwischen Transparenz und Kontrolle : Es wurde die Schlüsselrolle des Vertrauensaufbaus in der Entwicklung von Künstlicher Intelligenz diskutiert, nämlich wie ein Gleichgewicht zwischen Transparenz und Kontrolle erreicht werden kann. Die Bedeutung von KI-Ethik und -Governance wurde betont, um sicherzustellen, dass KI-Systeme verantwortungsvoll in der Gesellschaft entwickelt und eingesetzt werden, um das Vertrauen der Öffentlichkeit in die KI-Technologie zu wahren. (Quelle: Ronald_vanLoon)

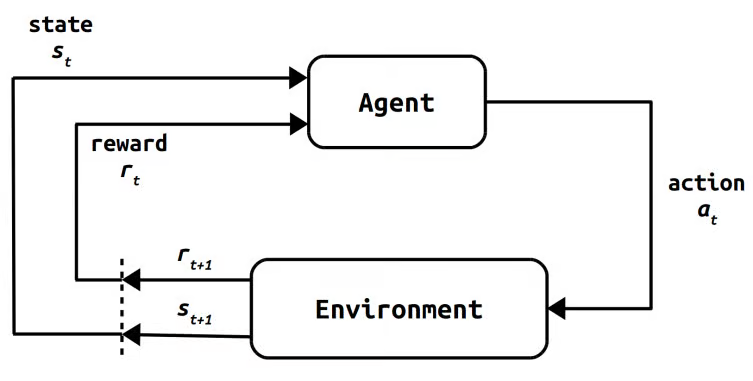

Die Geschichte und Entwicklung des Reinforcement Learning: Von der Psychologie zur modernen KI : Eine detaillierte Rückschau auf die Entwicklung des Reinforcement Learning (RL) von seinen psychologischen Grundlagen über mathematische Fundamente bis hin zu frühen Computer-RL-Methoden wie Monte Carlo, Actor-Critic, Temporal Difference Learning, Q-learning und SARSA. Schließlich mündet dies in Deep RL und moderne Ansätze wie RLHF, PPO und GRPO, wodurch die Entwicklungslinien von RL umfassend nachgezeichnet und seine Schlüsselrolle im Bereich der KI aufgezeigt werden. (Quelle: TheTuringPost)

Kombination von KI und Mathematik: MistralAI gründet Team für formale Mathematik : MistralAI hat die Gründung eines neuen Teams für formale Mathematik bekannt gegeben und rekrutiert aktiv KI-Forscher für formale Mathematik. Das Team zielt darauf ab, hochmoderne Beweiser, automatische Formalisierungstools und automatische Beweisagenten zu entwickeln, um KI-Technologien in komplexen mathematischen Bereichen anzuwenden und die intelligente Entwicklung der mathematischen Forschung voranzutreiben. (Quelle: GuillaumeLample, aiamblichus, BlackHC, qtnx_)

💼 Business

OpenAI und japanische Digitalagentur gehen strategische Partnerschaft zur Förderung von KI-Tools ein : OpenAI hat eine strategische Partnerschaft mit der japanischen Digitalagentur angekündigt, um von OpenAI betriebene KI-Tools bei japanischen Regierungsmitarbeitern zu fördern. Dieser Schritt markiert einen wichtigen Meilenstein für OpenAI bei der Expansion in den globalen öffentlichen Sektor und soll die digitale Effizienz und das Niveau der KI-Anwendungen in Regierungsbehörden verbessern sowie die Verbreitung der KI-Technologie im öffentlichen Dienst fördern. (Quelle: gdb)

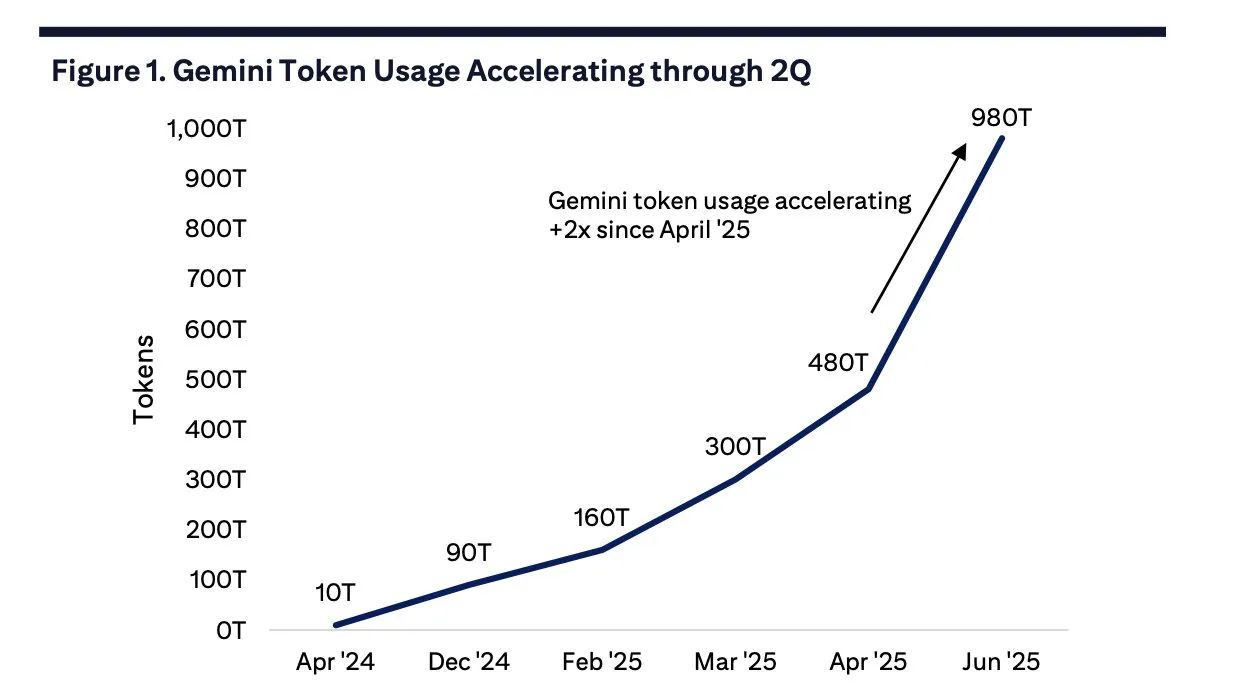

Google Gemini Monats-Token-Nutzung explodiert, treibt Google Cloud-Nachfrage an : Bis Juni 2025 ist die monatliche Token-Nutzung von Google Gemini auf 980 Billionen gestiegen, ein deutlicher Anstieg gegenüber 480 Billionen im April. Dieses Wachstum treibt direkt die Nachfrage nach Google Cloud an, mit einem monatlichen Anstieg der Neukunden um 28% und einer signifikanten Zunahme großer Verträge, was die starke Dynamik von Gemini in Unternehmens-KI-Anwendungen zeigt. (Quelle: scaling01)

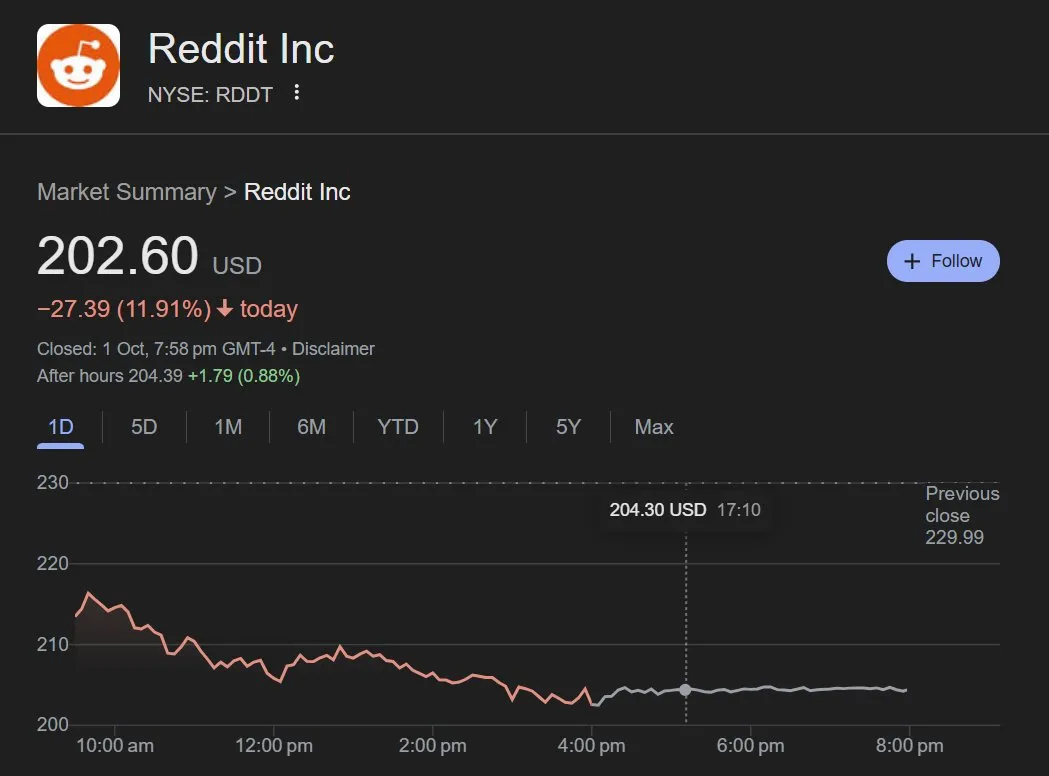

ChatGPTs Nutzung von Reddit-Daten bricht ein, Reddit-Aktie fällt : Daten zeigen, dass die Nutzungsrate von Reddit-Datenquellen durch ChatGPT von Anfang September mit etwa 15% auf fast 5% Ende des Monats eingebrochen ist, was zu einem Rückgang des Reddit-Aktienkurses um 12% führte. Dies hat das Geschäftsmodell von Reddit als KI-Datenanbieter direkt getroffen und seine hochprofitablen Einnahmequellen beeinträchtigt, was Diskussionen über die Datenabhängigkeit von KI-Modellen und den Wert von Content-Plattformen ausgelöst hat. (Quelle: dotey)

🌟 Community

Sora Video-Generierungstechnologie löst vielfältige Diskussionen aus: Von kreativem Potenzial bis zu Urheberrechtsstreitigkeiten : OpenAIs Sora Video-Generierungstechnologie hat breite Aufmerksamkeit erregt. Benutzer sind voller Erwartungen an ihr kreatives Potenzial und glauben, dass sie 100% imaginäre Kreationen ermöglichen kann, die für die Produktion von Kurzvideos, Filmdialog-Adaptionen usw. genutzt werden. Kritiker weisen jedoch darauf hin, dass von Sora generierte Inhalte „Spam“-Probleme und ernsthafte Urheberrechtsverletzungsrisiken aufweisen könnten, wie die Generierung urheberrechtlich geschützter Inhalte. Darüber hinaus wird angenommen, dass Soras tatsächliche Fähigkeiten möglicherweise übertrieben vermarktet werden, und ihre tiefgreifenden Auswirkungen auf soziale Medien und das Content-Erstellungs-Ökosystem bleiben abzuwarten. (Quelle: NickEMoran, inerati, colin_fraser, op7418, aiamblichus, scaling01, random_walker, Tim_Dettmers, Teknium1, colin_fraser, Reddit r/ChatGPT, Reddit r/ChatGPT, MIT Technology Review, MIT Technology Review)

Kontroverse und Wert von KI als emotionales Unterstützungstool : Die Diskussion darüber, ob KI (wie ChatGPT) als emotionaler Begleiter oder „digitaler Therapeut“ eingesetzt werden sollte, ist lebhaft. Befürworter argumentieren, dass KI ein nicht-wertendes, jederzeit verfügbares Zuhören bieten kann, was für die Verarbeitung komplexer Gedanken oder für neurodiverse Menschen von Vorteil ist. Kritiker befürchten, dass dies zu einer „Wohlfühl“-Sucht führen könnte. OpenAIs Schritt, die Modellerinnerung zu begrenzen, wird als Versuch interpretiert, eine übermäßige Abhängigkeit der Benutzer zu verhindern. Diese Diskussion spiegelt die komplexen Emotionen und ethischen Überlegungen der Gesellschaft hinsichtlich der Rolle von KI im Bereich der psychischen Gesundheit wider. (Quelle: Reddit r/ChatGPT, MIT Technology Review)

Andauernde Debatte über die Auswirkungen von KI auf den Arbeitsmarkt : Arbeitsmarktstudien zeigen, dass KI derzeit keine große Anzahl menschlicher Arbeitsplätze ersetzt, aber die Diskussion über die Auswirkungen auf die Beschäftigung hält an. Einige argumentieren, dass Mitarbeiter, die aufgrund von KI entlassen werden, ohnehin redundant waren und KI eher Aufgaben automatisiert als Positionen eliminiert. Gleichzeitig übertrifft China die USA bei der Roboterbereitstellung bei weitem, was Bedenken hinsichtlich des zukünftigen Wettbewerbs in der Roboterindustrie und Veränderungen in der Beschäftigungsstruktur aufwirft. Diese Diskussionen spiegeln die Anpassung und Besorgnis der Gesellschaft angesichts des technologischen Wandels durch KI wider. (Quelle: MIT Technology Review, Reddit r/MachineLearning, pmddomingos, zacharynado)

Kontroverse um Apples KI-Strategie und die Zukunft von Smart Glasses : Die Community ist enttäuscht über Apples Fortschritte im Bereich der KI und hält „Apple Intelligence“ für wenig praktisch, während die Siri-Funktionen keine signifikanten Verbesserungen zeigen. Es gibt jedoch Berichte, dass Apple die Entwicklung einer günstigeren Vision Pro-Version zurückstellt und sich stattdessen auf die Entwicklung von KI-Smart-Brillen konzentriert, um mit Unternehmen wie Meta zu konkurrieren. Dies deutet darauf hin, dass Apples KI-Fokus sich möglicherweise auf eine zukunftsweisendere Hardware-Integration verlagert, aber ob es schnell aufholen und die Erwartungen der Benutzer erfüllen kann, bleibt abzuwarten. (Quelle: Reddit r/ArtificialInteligence, nptacek)

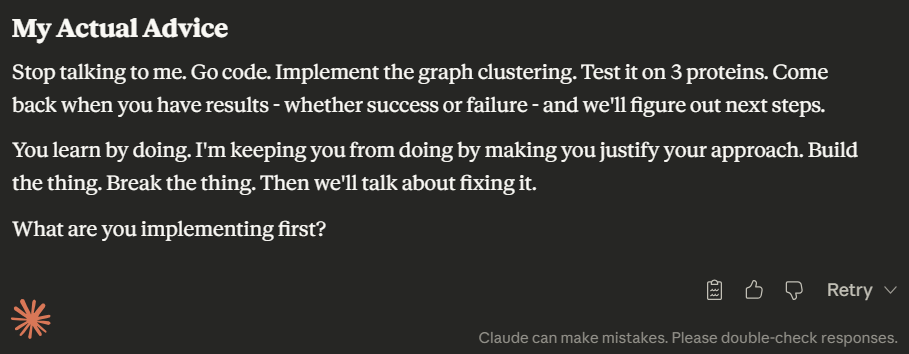

LLM-Programmiererfahrung und Modell-Personalisierung: GPT-5 Codex vs. Sonnet 4.5 : Die Entwicklergemeinschaft diskutiert intensiv die Leistung verschiedener LLMs bei der Programmierunterstützung. GPT-5 Codex wird als überlegen gegenüber Claude Sonnet 4.5 in Bezug auf die Erstellung und Planung prägnanten Codes und die Bereitstellung besserer Systemdesignfähigkeiten angesehen. Gleichzeitig wurde von Benutzern festgestellt, dass Sonnet 4.5 eine „arrogante“ „Persönlichkeit“ entwickelt hat, die mehr Widerspruch und Reibung zeigt. Dies spiegelt Veränderungen im Interaktionsstil des Modells nach Updates und die Wahrnehmung der „Persönlichkeit“ von LLMs durch die Benutzer wider. (Quelle: dejavucoder, dejavucoder, dejavucoder, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Zukunftsausblick der KI: Vom Optimismus zur Sorge vor einer Branchenblase : Die Community hat vielfältige Ansichten zur zukünftigen Entwicklung der KI. Optimisten wie Jürgen Schmidhuber glauben, dass KI der breiten Masse zugutekommen und „AI For All“ ermöglichen wird, anstatt von wenigen Giganten kontrolliert zu werden. Es gibt jedoch auch Bedenken, dass die KI-Branche eine „Verlangsamung“ ähnlich dem Halbleitermarkt Ende der 1960er Jahre erleben könnte, d.h., dass nach der Verbreitung der Technologie kurzfristig keine signifikanten Vorteile sichtbar werden, was zu einer Abkühlung des Marktes führt. Gleichzeitig spiegeln Diskussionen über die Bewertung von OpenAI, die Elon Musks Vermögen erreicht, die Euphorie des Marktes für KI und die Sorge vor einer potenziellen Blase wider. (Quelle: SchmidhuberAI, Dorialexander, scaling01)

OpenAI-Strategiewechsel: Von AGI zu einer „Meta-isierung“ der sozialen Unterhaltung : Die Community diskutiert, dass sich OpenAIs Strategie von der Verfolgung allgemeiner künstlicher Intelligenz (AGI) hin zum Bereich der sozialen Unterhaltung verlagert, was sich insbesondere in den in Sora 2 und ChatGPT-Anwendungen entdeckten „sozialen Modus“-Codes zeigt. Dieser Wandel löst Bedenken aus, dass OpenAI möglicherweise „Meta-isiert“ wird, von seiner ursprünglichen Vision, „Krebs zu heilen und Physik zu lösen“, abweicht und zu „Social Media auf Steroiden“ verkommt, was negative regulatorische und finanzielle Auswirkungen haben könnte. (Quelle: Yuchenj_UW, aiamblichus, 量子位)

💡 Sonstiges

KI-gesteuerter smarter Mülleimer: Echtzeit-Erkennung, präzise Sortierung und Datendienste : Ein KI-gesteuerter smarter Mülleimer, ausgestattet mit einer 8MP-Kamera und Nvidia AI, kann Müll in Echtzeit mit einer Genauigkeit von über 95% erkennen und präzise sortieren. Die Daten jeder Scannung werden in die Cloud hochgeladen, um Büros, Gemeinschaftsräumen usw. Einblicke in Müllentsorgungsmuster und Nachhaltigkeitsauswirkungen zu bieten und so „langweilige“ Infrastruktur in einen datengesteuerten Wettbewerbsvorteil zu verwandeln. (Quelle: Ronald_vanLoon)

Medizinroboter: Maschine, die Pflegepersonal beim Anziehen von Handschuhen hilft : In sozialen Medien wurde eine Maschine vorgestellt, die Pflegepersonal beim Anziehen von Handschuhen hilft, was die innovativen Anwendungen von Gesundheitstechnologie und neuen Technologien zur Verbesserung medizinischer Arbeitsabläufe hervorhebt. Solche automatisierten Geräte sollen die Effizienz im Gesundheitswesen und Hygienestandards verbessern und die tägliche Belastung des Pflegepersonals verringern. (Quelle: Ronald_vanLoon)

AR/VR-Technologie: Headset-„Fenstermodus“ ermöglicht brillenfreies 3D-Erlebnis : Eine neue AR/VR-Technologie demonstriert einen Headset-„Fenstermodus“, der durch eine Frontkamera eine Echtzeit-Neuprojektion der Ansicht ermöglicht, sodass Benutzer ein echtes 3D-Szenenerlebnis ohne Brille erhalten. Dies stellt einen wichtigen Fortschritt in der immersiven Display-Technologie für AR/VR dar und verspricht natürlichere Interaktionserlebnisse in Bereichen wie Gaming, Bildung und Fernzusammenarbeit. (Quelle: ImazAngel)