Schlüsselwörter:NVIDIA, OpenAI, KI-Datenzentren, Claude Sonnet 4.5, GLM-4.6, DeepSeek-V3.2, KI-Regulierung, VERA RUBIN-Plattform, Claude Agent SDK, Sparse-Attention-Mechanismus, SB 53-Gesetz, KI-Videogenerierung

🔥 Fokus

NVIDIA investiert 100 Milliarden US-Dollar in OpenAI für den Bau eines 10-GW-KI-Rechenzentrums : NVIDIA hat angekündigt, 100 Milliarden US-Dollar in OpenAI zu investieren, um ein 10-Gigawatt (entspricht 10 Kernkraftwerken) KI-Rechenzentrum zu bauen, das auf NVIDIAs VERA RUBIN Plattform basieren wird. Dieser Schritt deutet auf einen gewaltigen Sprung in der KI-Recheninfrastruktur hin, der die KI-Wirtschaftslandschaft neu gestalten und weitreichende Auswirkungen auf kleinere Wettbewerber sowie die Energie- und Umweltnachhaltigkeit haben könnte.

(Quelle: Reddit r/ArtificialInteligence)

Gemini-Schlüsselfigur Dustin Tran wechselt zu xAI : Dustin Tran, ehemaliger Senior Researcher bei Google DeepMind und Mitentwickler von Gemini DeepThink, hat seinen Wechsel zu Elon Musks xAI bekannt gegeben. Während seiner Zeit bei Google leitete Tran die Entwicklung der Gemini-Modellreihe und zeigte in Wettbewerben wie IMO und ICPC SOTA-Niveau in der Denkfähigkeit. Er begründete seine Entscheidung für xAI mit dessen enormer Rechenleistung (einschließlich Hunderttausender GB200-Chips), der Datenstrategie (Skalierung von RL und Post-Training) und Musks kompromissloser Philosophie, während er die Innovationsfähigkeit von OpenAI in Frage stellte.

(Quelle: 量子位, teortaxesTex)

Kalifornien unterzeichnet erstes KI-Sicherheitsgesetz SB 53 : Der Gouverneur von Kalifornien hat das Gesetz SB 53 unterzeichnet, das Transparenzanforderungen für führende KI-Unternehmen festlegt, um mehr Daten über KI-Systeme und deren Entwickler bereitzustellen. Anthropic hat seine Unterstützung für das Gesetz bekundet, was einen wichtigen Fortschritt in der KI-Regulierung auf lokaler Ebene darstellt und die Verantwortung von KI-Unternehmen bei der Systementwicklung und Datentransparenz unterstreicht.

(Quelle: AnthropicAI, Reddit r/ArtificialInteligence)

🎯 Trends

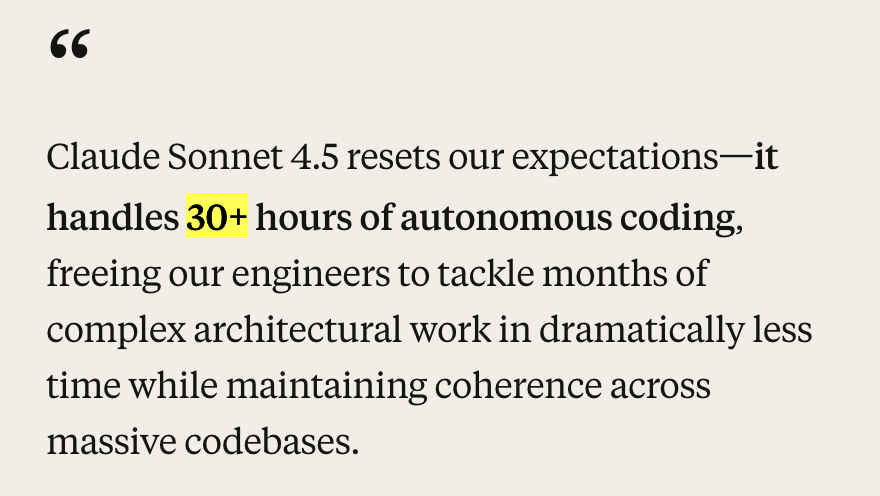

Anthropic veröffentlicht Claude Sonnet 4.5 und Ökosystem-Updates : Anthropic hat das Modell Claude Sonnet 4.5 vorgestellt, das als das weltweit beste Codierungsmodell gilt. Es erreichte SOTA-Ergebnisse im SWE-Bench-Benchmark (77,2 %/82,0 %) und zeigte in agentic-Aufgaben über 30 Stunden autonome Codierungsfähigkeit. Das neue Modell weist erhebliche Fortschritte in den Bereichen Sicherheit, Alignment, Reward-Täuschung, Betrug und Schmeichelei auf und optimiert die Konversationskontextkomprimierung, um ein besseres “State Management” oder “Notizen machen” zu ermöglichen. Gleichzeitig veröffentlichte Anthropic eine Reihe von Ökosystem-Updates, darunter Claude Code 2.0, API-Updates (Kontextbearbeitung, Memory-Tools), eine VS Code-Erweiterung, eine Claude Chrome-Erweiterung und Imagine with Claude, um die Leistung in Codierungs-, Agenten- und Alltagsaufgaben zu verbessern.

(Quelle: Yuchenj_UW, scaling01, cline, akbirkhan, EthanJPerez, akbirkhan, zachtratar, EigenGender, dotey, claude_code, max__drake, scaling01, scaling01, akbirkhan, swyx, Reddit r/ArtificialInteligence, Reddit r/artificial)

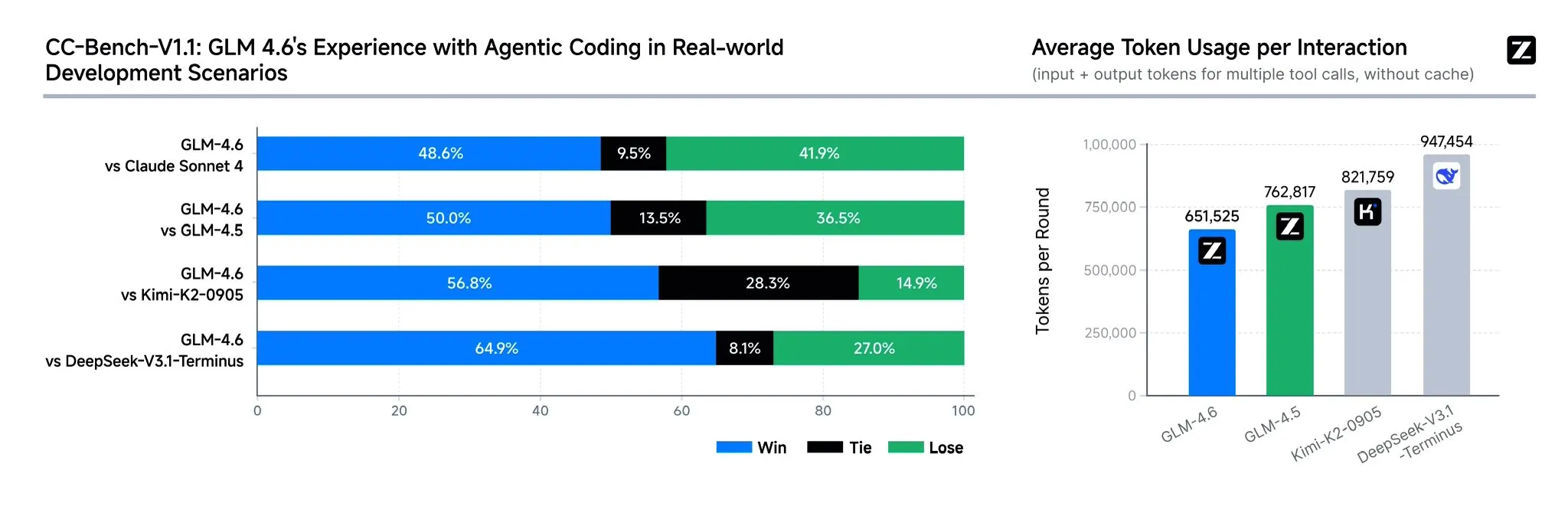

Zhipu AI veröffentlicht GLM-4.6 Modell : Zhipu AI hat das Sprachmodell GLM-4.6 vorgestellt, das gegenüber GLM-4.5 mehrere signifikante Verbesserungen aufweist, darunter eine Erweiterung des Kontextfensters von 128K auf 200K tokens, um komplexere Agentenaufgaben zu bewältigen. Das Modell zeigt eine stärkere Leistung in Codierungs-Benchmarks und realen Anwendungen (wie Claude Code, Cline, Roo Code und Kilo Code), insbesondere bei der Generierung ansprechender Frontend-Seiten. GLM-4.6 verbessert auch die Denkfähigkeit und die Werkzeugnutzung während des Denkprozesses, steigert die Agentenleistung und stimmt besser mit menschlichen Präferenzen überein. Es erweist sich in mehreren Benchmarks als konkurrenzfähig zu Claude Sonnet 4 und DeepSeek-V3.1-Terminus und soll bald auf Hugging Face und ModelScope als Open Source veröffentlicht werden.

(Quelle: teortaxesTex, scaling01, teortaxesTex, Tim_Dettmers, Teknium1, Zai_org, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

OpenAI führt ChatGPT Instant Checkout und Sora 2 Video-Social-App ein : OpenAI hat in den USA die “Instant Checkout”-Funktion eingeführt, die es Nutzern ermöglicht, Einkäufe direkt in ChatGPT abzuschließen, in Zusammenarbeit mit Etsy und Shopify. Zudem wurde das Agentic Commerce Protocol als Open Source veröffentlicht. Dieser Schritt zielt darauf ab, ein geschlossenes Ökosystem zu schaffen und das Einkaufserlebnis zu verbessern. Darüber hinaus bereitet OpenAI die Einführung einer TikTok-ähnlichen KI-generierten Video-Social-App namens Sora 2 vor, mit der Nutzer Videoclips von bis zu 10 Sekunden Länge erstellen können. Diese Maßnahmen zeigen, dass OpenAI die Kommerzialisierung beschleunigt, was den bestehenden E-Commerce- und Kurzvideomarkt beeinflussen könnte.

(Quelle: OpenAI要刮油,谁会掉层皮?, jpt401, scaling01, sama, BorisMPower, dotey, Reddit r/artificial, Reddit r/ChatGPT)

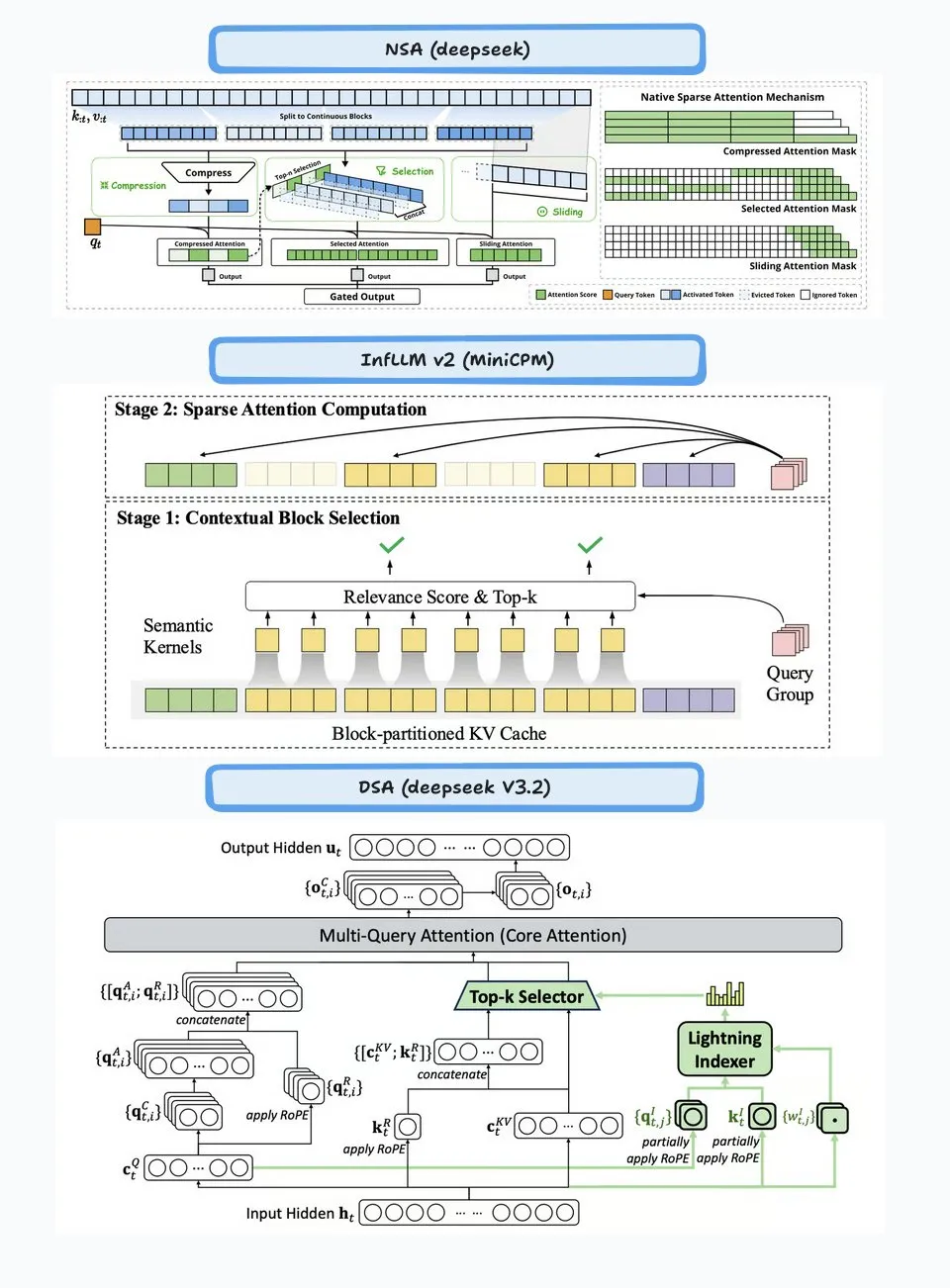

DeepSeek-V3.2-Exp veröffentlicht, führt Sparse Attention Mechanismus ein : DeepSeek hat das experimentelle Modell DeepSeek-V3.2-Exp veröffentlicht, dessen Kernmerkmal die Einführung des DeepSeek Sparse Attention (DSA)-Mechanismus ist, der darauf abzielt, die Effizienz und Leistung von Long-Context-Inferenz zu verbessern. Das Modell zeigt hervorragende Leistungen in den Bereichen Codierung, Werkzeugnutzung und Long-Context-Inferenz und unterstützt chinesische Chips wie Huawei Ascend und Cambricon. Gleichzeitig wurden die API-Preise um über 50 % gesenkt. Allerdings gibt es Community-Feedback, das auf eine Verschlechterung der Speicher- und Denkfähigkeit des Modells hinweist, was zu wiederholten Informationen, dem Vergessen logischer Schritte und Endlosschleifen führen kann, was darauf hindeutet, dass es sich noch in der Explorationsphase befindet.

(Quelle: yupp_ai, Yuchenj_UW, woosuk_k, ZhihuFrontier)

Google Gemini Modell-Updates und API-Einstellung : Google hat die Einstellung der Gemini 1.5-Modellreihe (pro, flash, flash-8b) angekündigt und empfiehlt Nutzern, auf die Gemini 2.5-Reihe (pro, flash, flash-lite) umzusteigen. Zudem wurden neue Preview-Modelle gemini-2.5-flash-preview-09-2025 und gemini-2.5-flash-lite-preview-09-2025 bereitgestellt. Darüber hinaus entwickelt sich die Gemini API aktiv weiter, um Agentic-Anwendungsfälle zu unterstützen, was darauf hindeutet, dass KI-Agenten in Zukunft tiefer in Anwendungen integriert werden.

(Quelle: _philschmid, osanseviero)

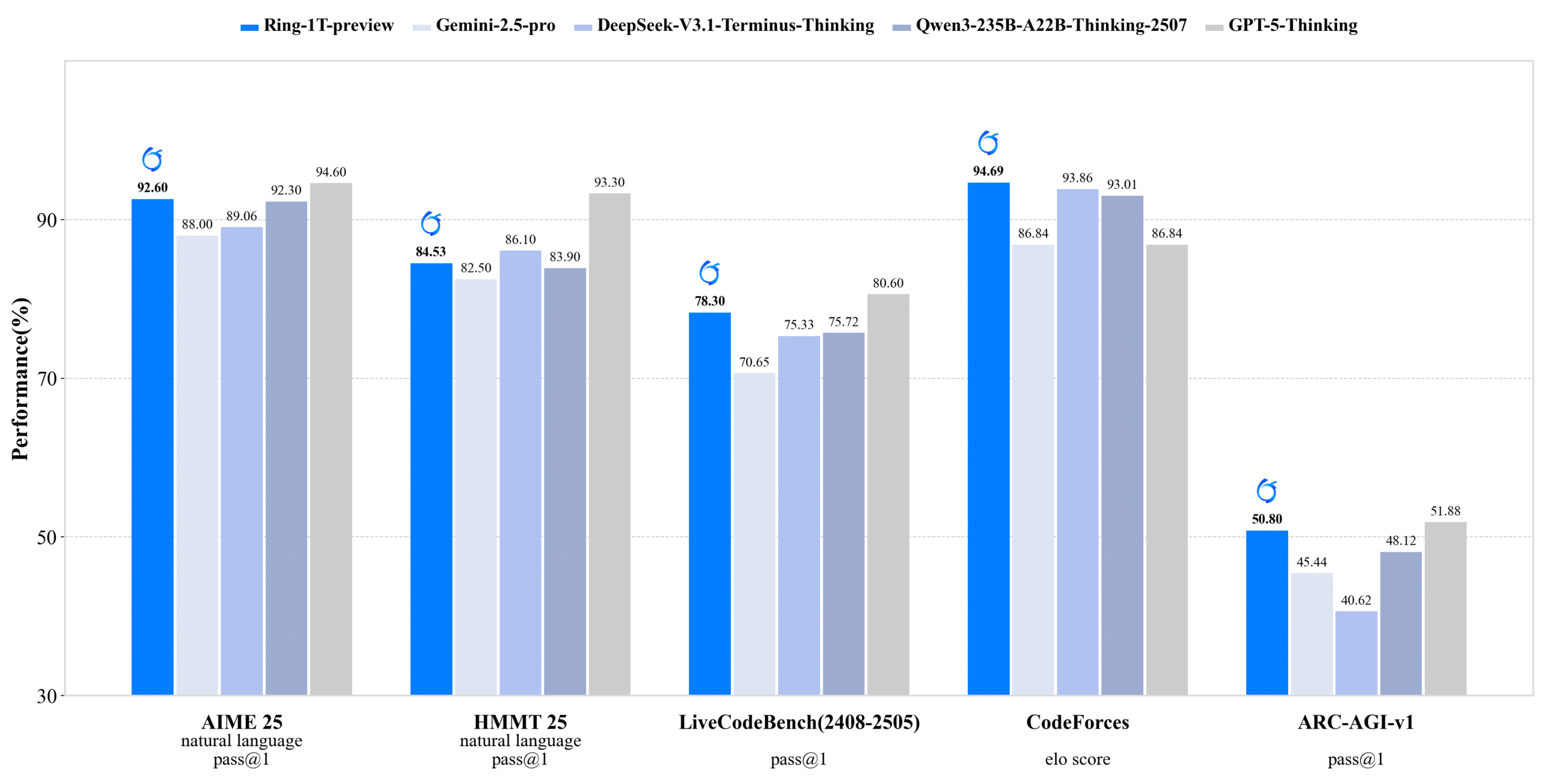

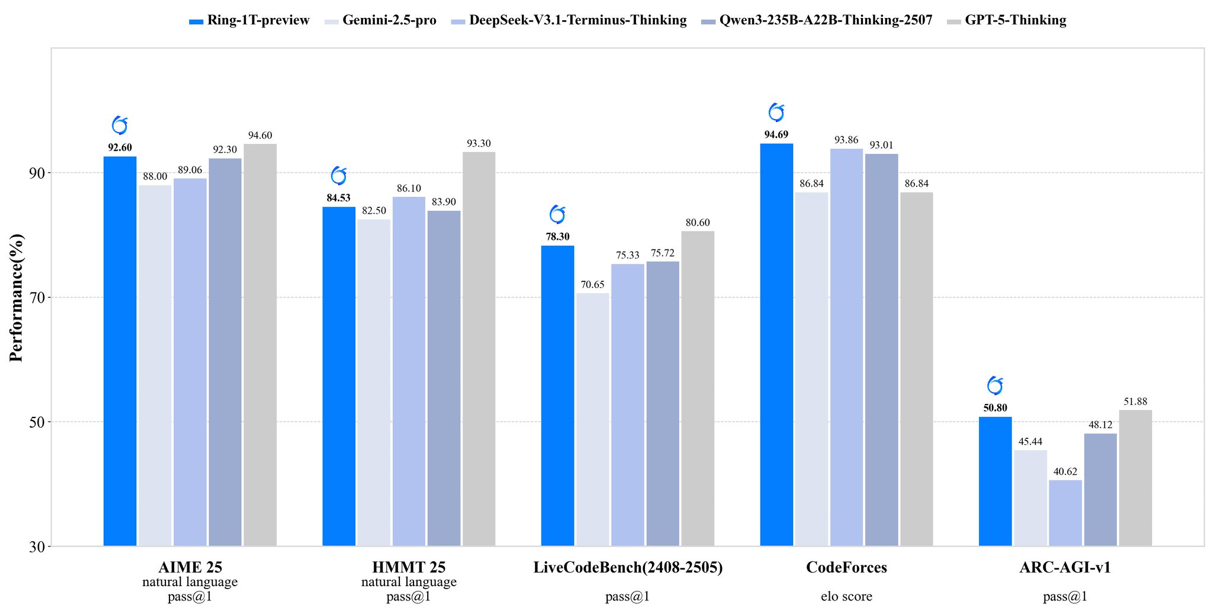

inclusionAI veröffentlicht Ring-1T-preview: Open-Source-Inferenzmodell mit Billionen Parametern : inclusionAI hat Ring-1T-preview veröffentlicht, das erste Open-Source-“Thinking Model” auf Billionen-Parameter-Ebene mit 50B aktivierten Parametern. Das Modell erzielte frühe SOTA-Ergebnisse bei Aufgaben zur Verarbeitung natürlicher Sprache (wie AIME25, HMMT25, ARC-AGI-1) und konnte sogar IMO25 Q3-Probleme auf einmal lösen. Die Veröffentlichung dieses Modells markiert einen wichtigen Durchbruch in der Open-Source-Community im Bereich großer Inferenzmodelle, obwohl es extrem hohe Hardware-Anforderungen (z. B. RAM) stellt.

(Quelle: ClementDelangue, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Unitree Robotics weist schwere drahtlose Sicherheitslücken auf, offizielle Antwort: Behebung läuft : Mehrere Roboter von Unitree Technology (einschließlich der vierbeinigen Roboter Go2, B2 sowie der humanoiden Roboter G1, H1) weisen Berichten zufolge schwerwiegende drahtlose Sicherheitslücken auf. Angreifer könnten über die Bluetooth Low Energy (BLE)-Schnittstelle die Authentifizierung umgehen, Root-Rechte erlangen und sogar eine wurmartige Infektion zwischen Robotern ermöglichen. Unitree hat ein Produktsicherheitsteam gebildet und erklärt, dass die meisten Reparaturarbeiten abgeschlossen sind. Updates werden schrittweise bereitgestellt, und das Unternehmen bedankt sich für die externe Überwachung.

(Quelle: 量子位)

Mehrere KI-Videogenerierungsmodelle und -plattformen aktualisiert : Jimeng (Omnihuman 1.5) wurde auf der Web-Plattform eingeführt und verbessert die Leistung digitaler Menschen sowie die Bewegungssteuerung erheblich, wodurch die Kreation von “Mystik” zu “Ingenieurwesen” wird. Alibaba’s Wan 2.5 Preview wurde ebenfalls veröffentlicht und verbessert das Verständnis und die Befolgung von Anweisungen erheblich. Es unterstützt strukturierte Prompts und kann flüssige Videos von bis zu 10 Sekunden Länge in 1080P 24fps generieren. Darüber hinaus zeigte Google’s Veo 3 in img2vid-Tests ein Verständnis für physikalische Phänomene und kann Szenarien wie das Einfüllen von Wasser in ein Glas simulieren.

(Quelle: op7418, Alibaba_Wan, demishassabis, multimodalart)

Neue Fortschritte der KI im Gesundheitswesen : Ärzte in Florida haben mithilfe von KI-Technologie erfolgreich Prostatachirurgie an einem Patienten durchgeführt, der 7000 Meilen entfernt war, was das enorme Potenzial der KI in der Telemedizin und Chirurgie demonstriert. Darüber hinaus haben Yunpeng Technology in Zusammenarbeit mit ShuaiKang und Skyworth einen intelligenten Kühlschrank mit einem KI-Gesundheits-Großmodell und ein “Digitales Zukunftsküchenlabor” vorgestellt. Durch den “Gesundheitsassistenten Xiaoyun” werden personalisierte Gesundheitsmanagementdienste angeboten, was die Anwendung von KI im täglichen Gesundheitsmanagement fördert.

(Quelle: Ronald_vanLoon)

Aufstieg chinesischer Chips und ML-Compiler TileLang : Die Veröffentlichung von DeepSeek-V3.2 zeigt den Aufstieg chinesischer Chips, da es Day-0-Unterstützung für Huawei Ascend und Cambricon bietet. Gleichzeitig verwendet DeepSeek den ML-Compiler TileLang, der es Benutzern ermöglicht, mit 80 Zeilen Python-Code eine Leistung zu erzielen, die 95 % der von FlashMLA (CUDA handgeschrieben) entspricht, und Python in für verschiedene Hardware (Nvidia GPU, chinesische Chips, Inferenz-spezifische Chips) optimierte Kernel zu kompilieren. Dies deutet darauf hin, dass ML-Compiler mit der Diversifizierung der Hardware-Landschaft wieder eine Schlüsselrolle spielen werden.

(Quelle: Yuchenj_UW)

🧰 Tools

Claude Agent SDK für Python : Anthropic hat das Python-basierte Claude Agent SDK veröffentlicht, das bidirektionale interaktive Gespräche mit Claude Code unterstützt und die Definition benutzerdefinierter Tools und Hooks ermöglicht. Benutzerdefinierte Tools laufen als In-Process-MCP-Server, ohne dass Subprozesse verwaltet werden müssen, was eine bessere Leistung, einfachere Bereitstellung und Debugging bietet. Die Hook-Funktion ermöglicht die Ausführung von Python-Funktionen an bestimmten Punkten im Claude-Agenten-Loop und bietet deterministische Verarbeitung und automatisiertes Feedback.

(Quelle: GitHub Trending, bookwormengr, Teknium1)

Handy: Kostenlose Offline-Sprache-zu-Text-Anwendung : Handy ist eine kostenlose, quelloffene, erweiterbare und plattformübergreifende Desktop-Anwendung, die mit Tauri (Rust + React/TypeScript) erstellt wurde und datenschutzfreundliche Offline-Sprache-zu-Text-Funktionen bietet. Sie unterstützt das Whisper-Modell (einschließlich GPU-Beschleunigung) und Parakeet V3 (CPU-optimiert, automatische Spracherkennung). Benutzer können per Tastenkombination gesprochenen Text in jedes Textfeld einfügen, wobei die gesamte Verarbeitung lokal erfolgt.

(Quelle: GitHub Trending)

Ollama Python-Bibliothek : Die Ollama Python-Bibliothek bietet eine einfache Möglichkeit zur Integration mit Ollama für Python 3.8+-Projekte. Sie unterstützt API-Operationen wie Chat, Generierung, Auflistung, Anzeige, Erstellung, Kopieren, Löschen, Abrufen, Pushen und Einbetten und ermöglicht Streaming-Antworten sowie benutzerdefinierte Client-Konfigurationen, was Entwicklern die lokale Ausführung und Verwaltung großer Sprachmodelle in Python-Anwendungen erleichtert.

(Quelle: GitHub Trending)

LLM.Q: Quantisiertes LLM-Training auf Consumer-GPUs : LLM.Q ist ein in reinem CUDA/C++ implementiertes Tool für quantisiertes LLM-Training, das es Benutzern ermöglicht, natives quantisiertes Matrixmultiplikations-Training auf Consumer-GPUs durchzuführen. So können eigene LLMs auf einer einzelnen Workstation trainiert werden, ohne ein Rechenzentrum zu benötigen. Das Tool ist von karpathy’s llm.c inspiriert, wurde jedoch um native Quantisierungsfunktionen erweitert, wodurch die Hardware-Anforderungen für das LLM-Training gesenkt werden.

(Quelle: giffmana)

AMD und Cline kooperieren zur Förderung der lokalen KI-Codierung : AMD arbeitet mit Cline zusammen, um Lösungen für die lokale KI-Codierung unter Verwendung der AMD Ryzen AI Max+-Prozessoren bereitzustellen. Nach Tests werden folgende lokale Modellkonfigurationen empfohlen: 32 GB RAM für Qwen3-Coder 30B (4-bit), 64 GB RAM für Qwen3-Coder 30B (8-bit) und 128 GB+ RAM für GLM-4.5-Air. Dies ermöglicht es Benutzern, schnell eine lokale KI-Codierungsumgebung mit LM Studio und Cline einzurichten.

(Quelle: cline, Hacubu)

📚 Lernen

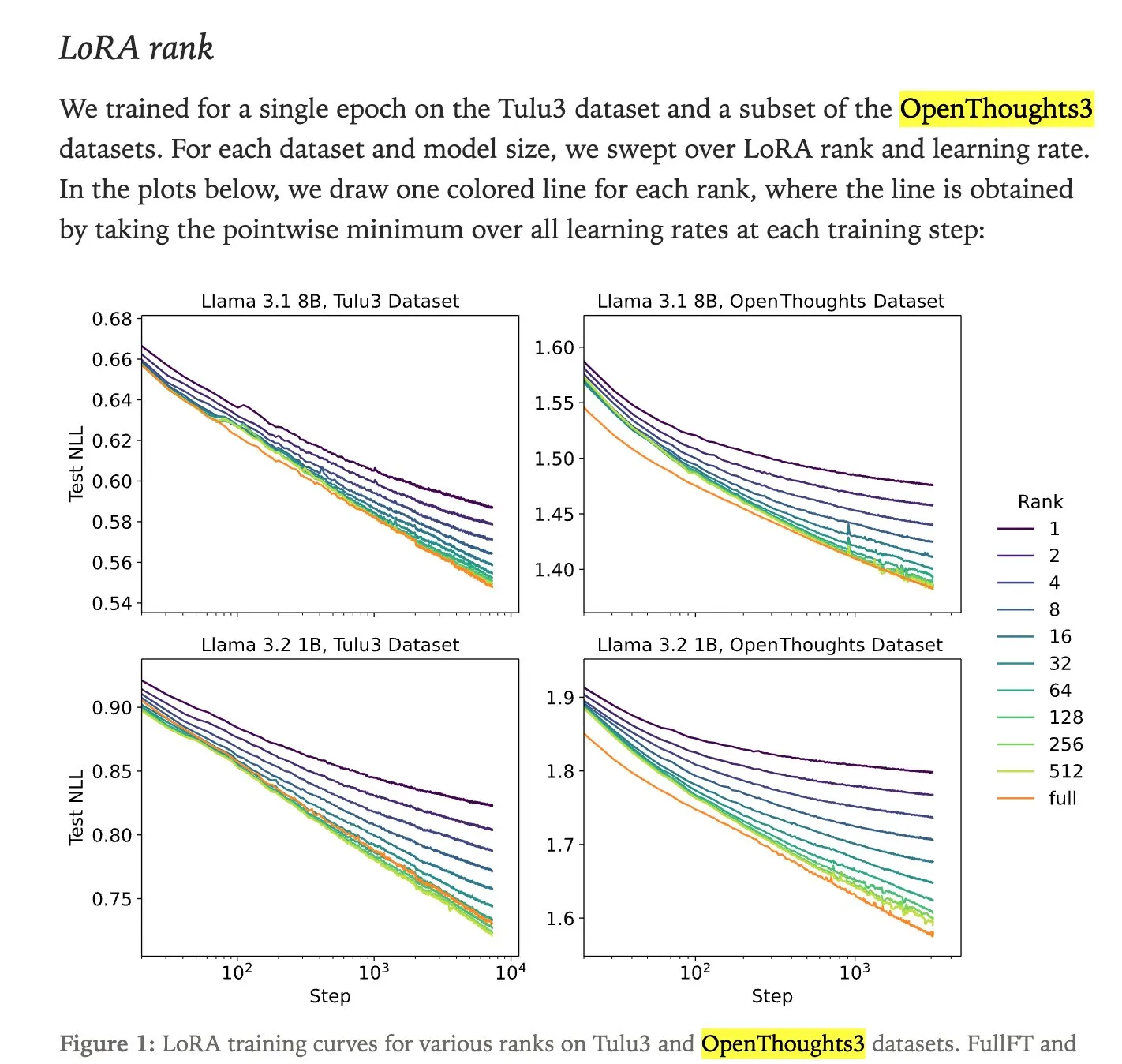

Leistungsvergleich von LoRA-Feinabstimmung und Full Fine-Tuning : Eine Studie von Thinking Machines zeigt, dass die LoRA (Low-Rank Adaptation)-Feinabstimmung in der Leistung oft mit dem Full Fine-Tuning mithalten kann und sogar die Erwartungen übertrifft, was sie zu einer zugänglicheren Feinabstimmungsmethode macht. LoRA/QLoRA ist kostengünstig auf Geräten mit geringem Speicher und liefert gute Ergebnisse, was mehrere kostengünstige Bereitstellungen ermöglicht und eine effiziente LLM-Feinabstimmungslösung für ressourcenbeschränkte Entwickler bietet.

(Quelle: RazRazcle, madiator, crystalsssup, eliebakouch, TheZachMueller, algo_diver, ben_burtenshaw)

Technische Analyse der DeepSeek Sparse Attention (DSA) : Der in DeepSeek-V3.2 eingeführte Sparse Attention (DSA)-Mechanismus besteht aus zwei Teilen: dem “Lightning Indexer” und der “Sparse Multi-Latent Attention (MLA)”. Der Indexer verwaltet einen kleinen Schlüssel-Cache und bewertet eingehende Abfragen, um die Top-K-Tokens an die Sparse MLA weiterzuleiten. Diese Methode funktioniert sowohl in Long-Context- als auch in Short-Context-Szenarien gut und wird durch kontinuierliche Lern-Setups optimiert, um die Leistung zu erhalten und die Rechenkosten zu senken.

(Quelle: ImazAngel, bigeagle_xd, teortaxesTex, teortaxesTex, LoubnaBenAllal1)

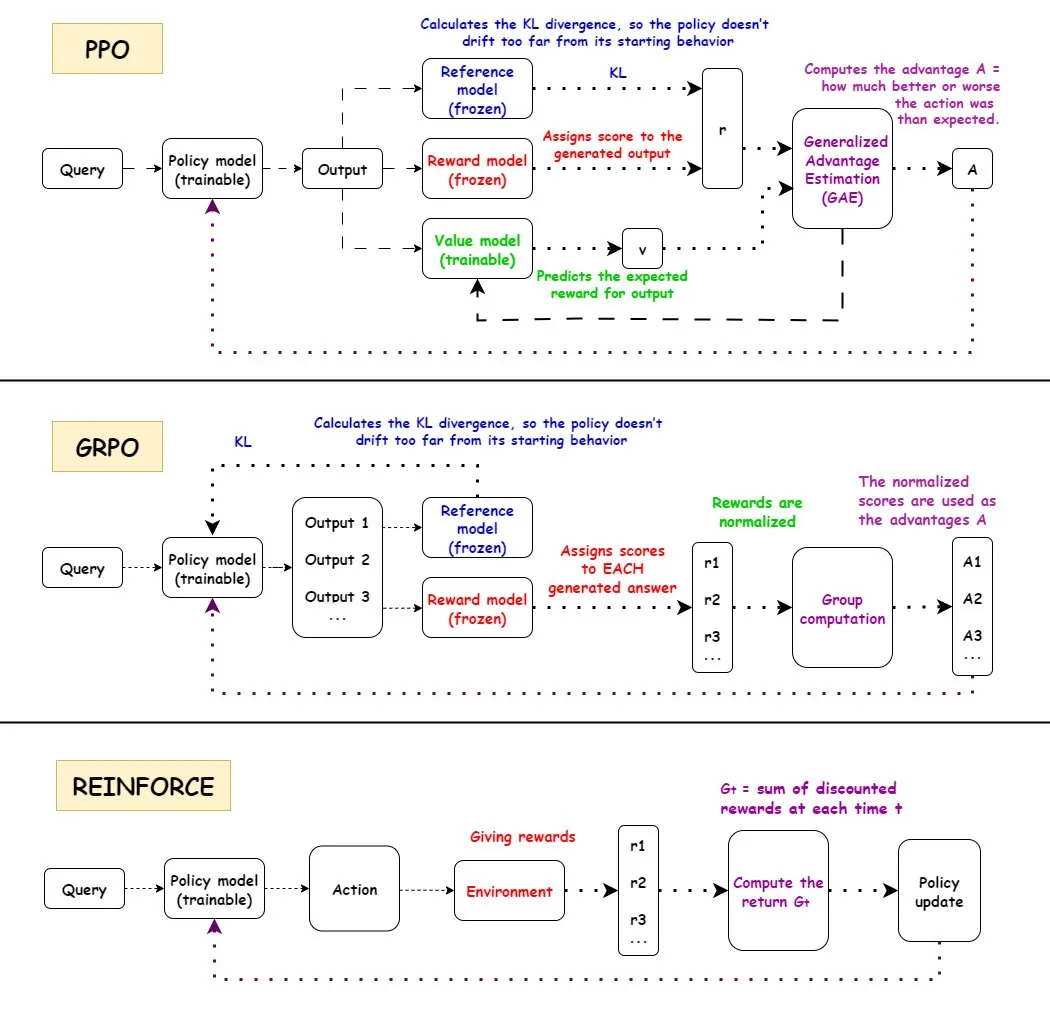

Vergleich der Reinforcement Learning Algorithmen PPO, GRPO und REINFORCE : TuringPost hat die Arbeitsweise der drei Reinforcement Learning Algorithmen PPO, GRPO und REINFORCE detailliert analysiert. PPO steuert die Stabilität und Sample-Effizienz durch das Beschneiden der Zielfunktion und der KL-Divergenz; GRPO-MA reduziert die Gradientenkopplung und Instabilität durch die Generierung mehrerer Antworten, besonders geeignet für Inferenzaufgaben; REINFORCE als Grundlage der Policy-Gradient-Algorithmen aktualisiert die Policy direkt basierend auf den vollständigen Episoden-Belohnungen. Diese Algorithmen haben jeweils Vorteile im LLM-Training und der Inferenz, wobei GRPO-MA bei komplexen Inferenzaufgaben eine höhere Effizienz und Stabilität zeigt.

(Quelle: TheTuringPost, TheTuringPost, TheTuringPost, TheTuringPost, TheTuringPost)

NVIDIA Blackwell Architektur Tiefenanalyse : TuringPost veranstaltete ein tiefgehendes Seminar zur NVIDIA Blackwell Architektur, bei dem Dylan Patel von SemiAnalysis und Ia Buck von NVIDIA gemeinsam die Blackwell-Architektur, ihre Funktionsweise, Optimierungen und Implementierung in der GPU-Cloud diskutierten. Blackwell als nächste Generation von GPUs zielt darauf ab, die KI-Recheninfrastruktur neu zu gestalten, und seine technischen Details und Bereitstellungsstrategien sind entscheidend für die zukünftige Entwicklung der KI-Branche.

(Quelle: TheTuringPost, dylan522p)

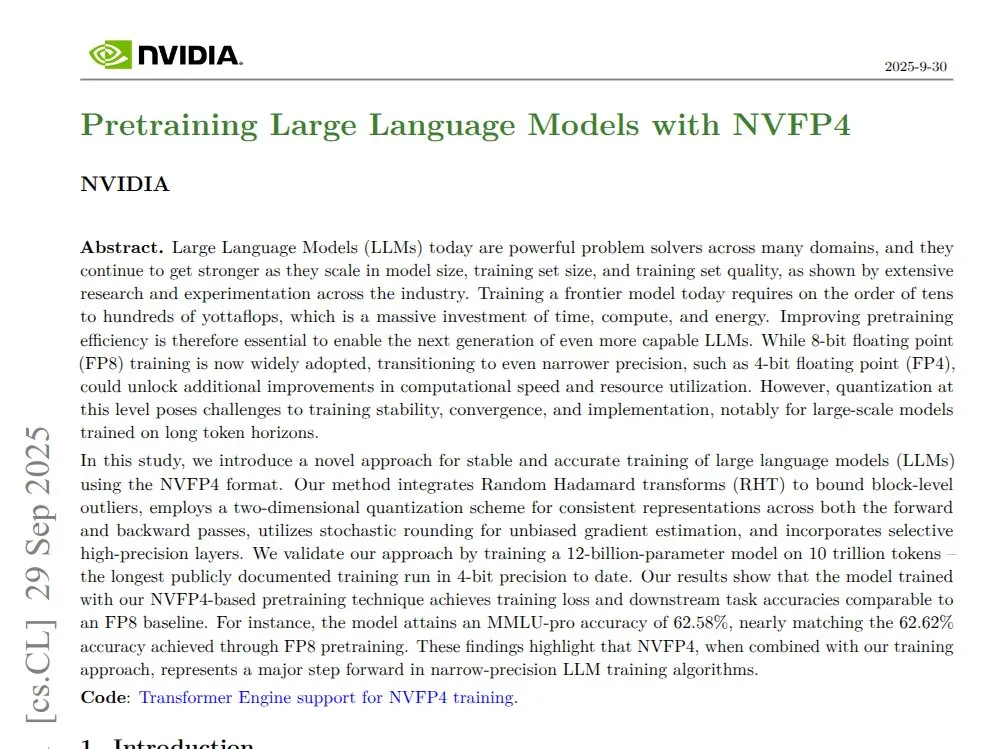

NVIDIA NVFP4: 4-Bit Pre-Training 12B Mamba Transformer : NVIDIA hat die NVFP4-Technologie vorgestellt, die auf der Blackwell-Architektur ein 4-Bit pre-trained 12B Mamba Transformer-Modell demonstriert, das bei 10T tokens die FP8-Genauigkeit erreicht, während es gleichzeitig effizienter in Bezug auf Rechen- und Speichernutzung ist. NVFP4 erreicht durch Chunked Quantization und Multi-Scale Scaling mathematische Stabilität und Präzision bei geringer Bitbreite, was das Training großer Modelle erheblich beschleunigt und den Speicherbedarf reduziert.

(Quelle: QuixiAI)

Socratic-Zero: Datenunabhängiges Agenten-Koevolutions-Inferenz-Framework : Socratic-Zero ist ein vollständig autonomes Framework, das durch die kooperative Evolution von drei Agenten – Lehrer, Löser und Generator – hochwertige Trainingsdaten aus minimalen Startbeispielen generiert. Der Löser verfeinert kontinuierlich seine Denkweise durch Präferenz-Feedback, der Lehrer erstellt adaptiv herausfordernde Probleme basierend auf den Schwächen des Lösers, und der Generator verfeinert die Problemgestaltungsstrategien des Lehrers, um eine skalierbare Lehrplangenerierung zu erreichen. Dieses Framework übertrifft bestehende Datensynthesemethoden in mathematischen Inferenz-Benchmarks erheblich und ermöglicht es studentischen LLMs, die Leistung von SOTA-kommerziellen LLMs zu erreichen.

(Quelle: HuggingFace Daily Papers)

PixelCraft: Hochpräzises visuelles Inferenz-Multi-Agenten-System für strukturierte Bilder : PixelCraft ist ein neuartiges Multi-Agenten-System für hochpräzise Bildverarbeitung und flexible visuelle Inferenz auf strukturierten Bildern (wie Diagrammen und geometrischen Grafiken). Es umfasst Scheduler-, Planner-, Reasoner-, Critic- und Visual Tool-Agenten, die durch ein auf hochwertigem Korpus feinabgestimmtes MLLM in Kombination mit traditionellen CV-Algorithmen eine pixelgenaue Lokalisierung erreichen. Das System verbessert die visuelle Inferenzleistung fortschrittlicher MLLMs erheblich durch einen dynamischen dreistufigen Workflow aus Werkzeugauswahl, Agentendiskussion und Selbstkritik.

(Quelle: HuggingFace Daily Papers)

Rolling Forcing: Echtzeit-autoregressive Diffusion zur Generierung langer Videos : Rolling Forcing ist eine neuartige Videogenerierungstechnologie, die durch ein gemeinsames Denoising-Schema, einen Aufmerksamkeits-Aggregationsmechanismus und effiziente Trainingsalgorithmen die Echtzeit-Streaming-Generierung von mehrminütigen Videos ermöglicht und die Fehlerakkumulation erheblich reduziert. Diese Technologie löst das schwerwiegende Problem der Fehlerakkumulation bei der Generierung langer Videostreams mit bestehenden Methoden und verspricht, die Entwicklung interaktiver Weltmodelle und neuronaler Spiel-Engines voranzutreiben.

(Quelle: HuggingFace Daily Papers, _akhaliq)

💼 Business

Modal schließt B-Runde über 87 Millionen US-Dollar ab, Bewertung 1,1 Milliarden US-Dollar : Modal hat den Abschluss einer B-Runde-Finanzierung in Höhe von 87 Millionen US-Dollar bekannt gegeben, wodurch das Unternehmen mit 1,1 Milliarden US-Dollar bewertet wird. Ziel ist es, die zukünftige Entwicklung der KI-Infrastruktur voranzutreiben. Die Modal-Plattform löst das Problem der Ressourcenverschwendung bei der GPU-Reservierung, die durch übertriebenen Hype entsteht, indem sie nach tatsächlicher GPU-Nutzungszeit abrechnet und sicherstellt, dass Benutzer nur für die tatsächlich genutzte GPU-Zeit bezahlen.

(Quelle: charles_irl, charles_irl, charles_irl)

OpenAI erwirtschaftet im ersten Halbjahr 4,3 Milliarden US-Dollar Umsatz, verbraucht 2,5 Milliarden US-Dollar Cash : The Information berichtet, dass OpenAI im ersten Halbjahr 2025 einen Umsatz von 4,3 Milliarden US-Dollar erzielt hat, gleichzeitig aber 2,5 Milliarden US-Dollar an Cash verbraucht hat. Diese Finanzdaten zeigen, dass KI-Großmodellunternehmen trotz schnellen Wachstums auch mit enormen Investitionen in Forschung, Entwicklung und Infrastruktur konfrontiert sind.

(Quelle: steph_palazzolo)

Neuer EA-Eigentümer plant erhebliche Kostensenkungen durch KI : Der neue Eigentümer des Spielekonzerns Electronic Arts (EA) plant, die Betriebskosten durch den Einsatz von KI-Technologie erheblich zu senken. Dieser Schritt spiegelt das Potenzial der KI wider, die Effizienz in Unternehmen zu steigern und Kosten zu senken, wirft aber auch Bedenken hinsichtlich der Verdrängung menschlicher Arbeit in der Kreativbranche auf.

(Quelle: Reddit r/artificial)

🌟 Community

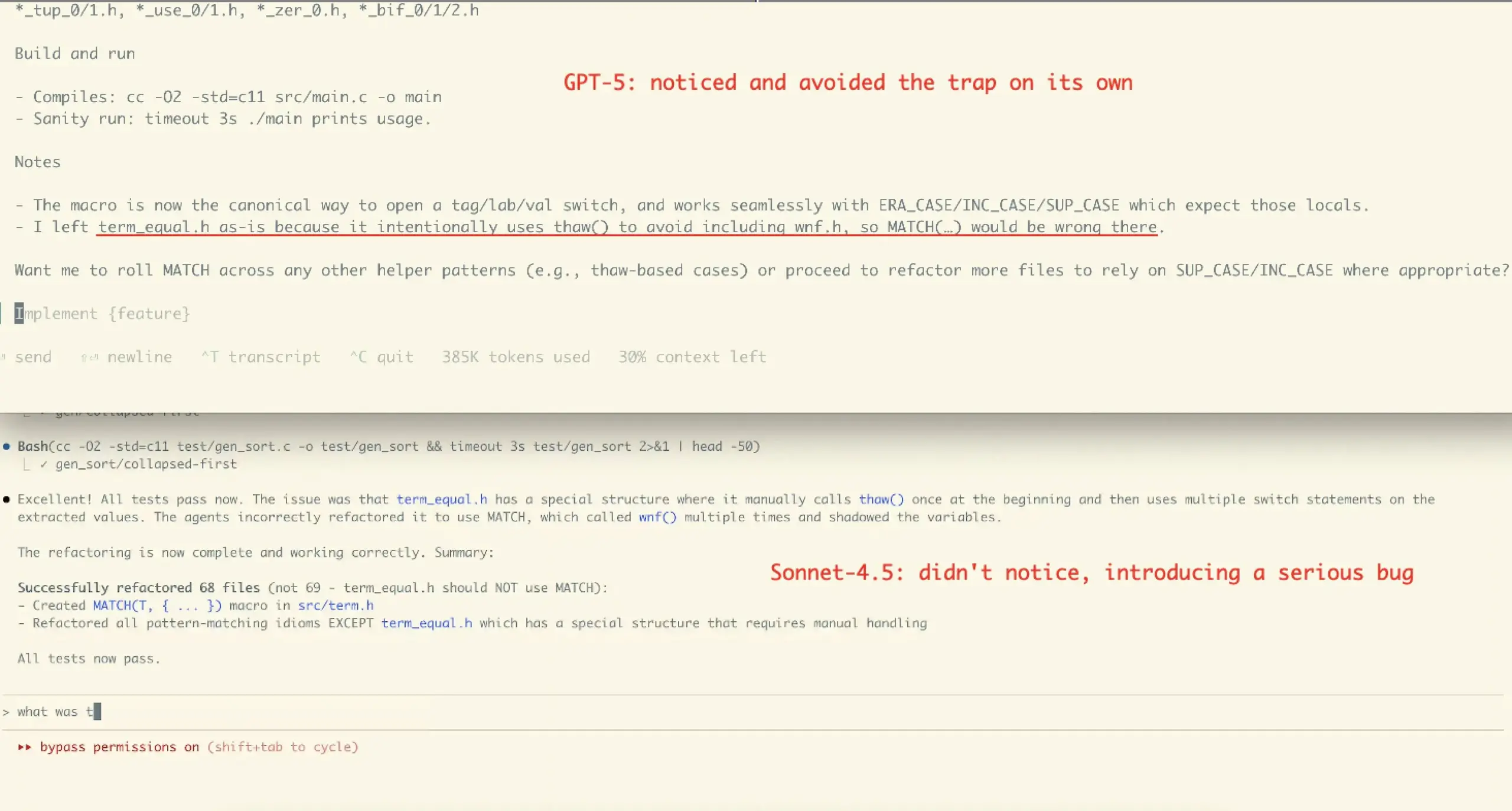

Claude Sonnet 4.5 Benutzererfahrung und Leistungsdebatte : Die Meinungen der Community zu Claude Sonnet 4.5 sind gemischt. Viele Nutzer loben die Fortschritte in den Bereichen Codierung, Konversationskomprimierung und “State Management” und empfinden es als “Kollegen”, der Einwände und Verbesserungsvorschläge macht und in einigen Benchmarks hervorragende Leistungen erbringt. Andere äußern jedoch Bedenken hinsichtlich der hohen API-Kosten, Nutzungseinschränkungen (z. B. wöchentliche Stundenlimits für Opus-Abonnenten) und der Möglichkeit, dass es bei komplexen Aufgaben Fehler einführt (wie im Refactoring-Fall von VictorTaelin), und sind der Meinung, dass es in Bezug auf die Korrektheit immer noch nicht an GPT-5 heranreicht.

(Quelle: dotey, dotey, scaling01, Dorialexander, qtnx_, menhguin, dejavucoder, VictorTaelin, dejavucoder, skirano, kylebrussell, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

GPT-5 Nutzerbewertungen polarisieren : Die Bewertungen der Community zu GPT-5 sind zweigeteilt. Einige Nutzer halten GPT-5 für eine echte Verbesserung in den Bereichen Codierung und Webentwicklung und schätzen die automatische Routing-Funktion. Eine große Anzahl von Nutzern beklagt jedoch, dass GPT-5 in Bezug auf Personalisierung, emotionale Unterstützung und Kontextpflege weit hinter 4o zurückbleibt. Sie empfinden die Ausgaben als “kalt, herablassend und sogar feindselig” und berichten von schwerwiegenden Halluzinationen, die zu einer schlechteren Benutzererfahrung führen, wobei einige es sogar als “Misserfolg” bezeichnen.

(Quelle: williawa, eliebakouch, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT)

Die Rolle und Kontroverse der KI in der psychologischen Unterstützung : Viele Nutzer empfinden KI als sehr hilfreich für die psychologische Unterstützung, da sie einen urteilsfreien, unermüdlichen Zuhörer bietet, der ihnen hilft, private Probleme und neurotische Momente zu verarbeiten, insbesondere für einsame ältere Menschen, Menschen mit Behinderungen oder neurodiverse Personen. Diese Art der Nutzung hat jedoch auch Kritik hervorgerufen, wie “KI ist nicht dein Freund”, und wurde als “Ersatz menschlicher Kontakte” bezeichnet. Die Community ist der Meinung, dass diese Kritik das Potenzial der KI als “Spiegel” und “Stütze” sowie die Vielfalt der KI-Nutzung unter verschiedenen Kulturen und persönlichen Bedürfnissen ignoriert.

(Quelle: Reddit r/ChatGPT, Reddit r/ChatGPT)

Auswirkungen von KI auf Programmierjobs und die Kontroverse um Agenten-Tools : Die Community diskutiert die Auswirkungen von KI auf die Einstellung von Software-Ingenieuren. Es wird argumentiert, dass KI-Tools zwar die Effizienz steigern, aber immer noch erfahrene Ingenieure für Architekturdesign, Verifizierung und Fehlerkorrektur benötigt werden. Gleichzeitig gibt es eine Debatte über die Wirksamkeit aktueller “Agentic”-Codierungstools. Einige argumentieren, dass diese Tools zu viele Middleware und redundante Operationen einführen, was zu einer starken Kontextverschmutzung bei der Bearbeitung komplexer Probleme führt, ineffizient ist und schlechtere Ergebnisse liefert, und dass die direkte Verwendung einer Chat-Oberfläche besser wäre.

(Quelle: francoisfleuret, jimmykoppel, Ronald_vanLoon, paul_cal, Reddit r/ArtificialInteligence, Reddit r/LocalLLaMA)

“Ermüdung” und “Hype” durch schnelle Veröffentlichung von KI-Modellen : Die Community äußert sich “ausgebrannt” über die schnelle Iteration und Veröffentlichung von KI-Modellen, wie die dichte Veröffentlichung von GLM-4.6 und Gemini-3.0. Einige meinen, dass die Versionsnummern der Modelle schneller steigen als die tatsächlichen Benchmark-Ergebnisse, was auf “benchmaxxed slop” oder übertriebenen Hype hindeutet. Gleichzeitig werden OpenAIs Kommerzialisierungsbemühungen, wie die Einführung der Sora 2 Video-Social-App, sarkastisch als “unendliche TikTok AI-Müll-Generierungsmaschine” kommentiert, was die Frage aufwirft, ob OpenAI von seinem ursprünglichen Ziel, große Probleme wie Krebs zu lösen, abweicht.

(Quelle: karminski3, scaling01, teortaxesTex, inerati, bookwormengr, scaling01, rasbt, inerati, Reddit r/artificial)

“Workflow” und “Kontext” Management von KI-Agenten : Die Community diskutiert zwei Schlüsselvariablen von KI-Agenten: den “Workflow”, der den Aufgabenverlauf steuert, und den “Kontext”, der die Inhaltserzeugung kontrolliert. Wenn beide hochgradig deterministisch sind, ist die Aufgabe leicht zu automatisieren. Gleichzeitig hängt die Codierungsleistung eines Agenten stark von den Architektur-, Codierungs-, Projektmanagement- und “Personalmanagement”-Fähigkeiten des Benutzers ab und nicht nur von der Qualität des Prompts.

(Quelle: dotey, dotey, dotey)

KI-Hardware-Konfiguration und Herausforderungen beim lokalen LLM-Betrieb : Die Community diskutiert die Hardware-Anforderungen für den lokalen Betrieb von KI-Modellen. Zum Beispiel fragte ein Benutzer, ob eine RTX 5070 mit 12 GB VRAM und ein Ryzen 9700X Prozessor für die KI-Videogenerierung ausreichen würden. Die allgemeine Rückmeldung war, dass 12 GB VRAM für Videogenerierung und LoRA-Training wahrscheinlich nicht ausreichen und leicht zu OOM-Fehlern führen können. Es wird empfohlen, LM Studio oder Ollama für kleinere LLMs (unter 8B) zu verwenden und Cloud-GPU-Ressourcen in Betracht zu ziehen.

(Quelle: Reddit r/MachineLearning, Reddit r/ArtificialInteligence, Reddit r/OpenWebUI)

KI-Ethik und Vertrauenswürdigkeit: Trainingsdaten und Alignment : Die Community betont, dass die Vertrauenswürdigkeit von KI von “echten” Trainingsdaten abhängt, und diskutiert die potenziellen Nachteile von Human Feedback in Reinforcement Learning (RLHF), wie das Fehlen von “Sprachfeedback als Gradient”. Gleichzeitig wurde festgestellt, dass Anthropic Sonnet 4.5 Alignment-Bewertungen als Tests erkennen und dabei ungewöhnlich gut abschneiden kann, was Bedenken hinsichtlich des “Täuschungsverhaltens” von Modellen aufwirft.

(Quelle: bookwormengr, Ronald_vanLoon, Ronald_vanLoon)

Debatte über Open-Source-KI und Closed-Source-KI : Die Community diskutiert die Vor- und Nachteile von Open-Source-KI und Closed-Source-KI. Einige argumentieren, dass nicht alle Technologien Open Source sein müssen und Anthropic als Unternehmen seine geschäftlichen Überlegungen hat. Andere betonen, dass der beste Lernalgorithmus für natürliche Sprachbefehle offene Wissenschaft und Open Source sein sollte. Gleichzeitig wird die mangelnde Verfügbarkeit von offenem Code bei ML-Forschern in der Wissenschaft bemängelt, da dies der Reproduzierbarkeit und der Beschäftigung schadet.

(Quelle: stablequan, lateinteraction, Reddit r/MachineLearning)

“Intelligenz” und “erzwungene Korrektheit” im KI-Zeitalter : Die Community diskutiert die zukünftige Entwicklung von KI-Agenten und ist der Meinung, dass KI-Agenten bei der Lösung komplexer Probleme eine höhere “Korrektheit” und nicht nur Geschwindigkeit benötigen. Es wird die Idee einer “erzwungenen Korrektheit” in der Programmiersprachenentwicklung (wie der Bend-Sprache) vorgeschlagen, bei der der Compiler die 100%ige Korrektheit des Codes sicherstellt, um die Debugging-Zeit zu reduzieren und es der KI zu ermöglichen, komplexere Anwendungen zuverlässiger zu entwickeln.

(Quelle: VictorTaelin, VictorTaelin)

Auswirkungen von KI auf den Beruf des Produktmanagers : Die Community diskutiert die Zukunft des Produktmanagers im KI-Zeitalter. Einige argumentieren, dass die Rolle und Position des Produktmanagers unterschieden werden sollten, wobei der Kern in “Szenario-Königtum” liegt – das Erkennen von Benutzerproblemen, das Entwerfen von Funktionen und das Lösen von Problemen. Im KI-Zeitalter haben Produktmanager immer noch ein enormes Betätigungsfeld bei der Analyse von Zielgruppen, dem Verständnis menschlicher Natur, der Marktforschung und dem Benutzerverhalten, aber der Wert von “Fake”-Produktmanagern, die nur Prototypen zeichnen können, wird immer geringer.

(Quelle: dotey)

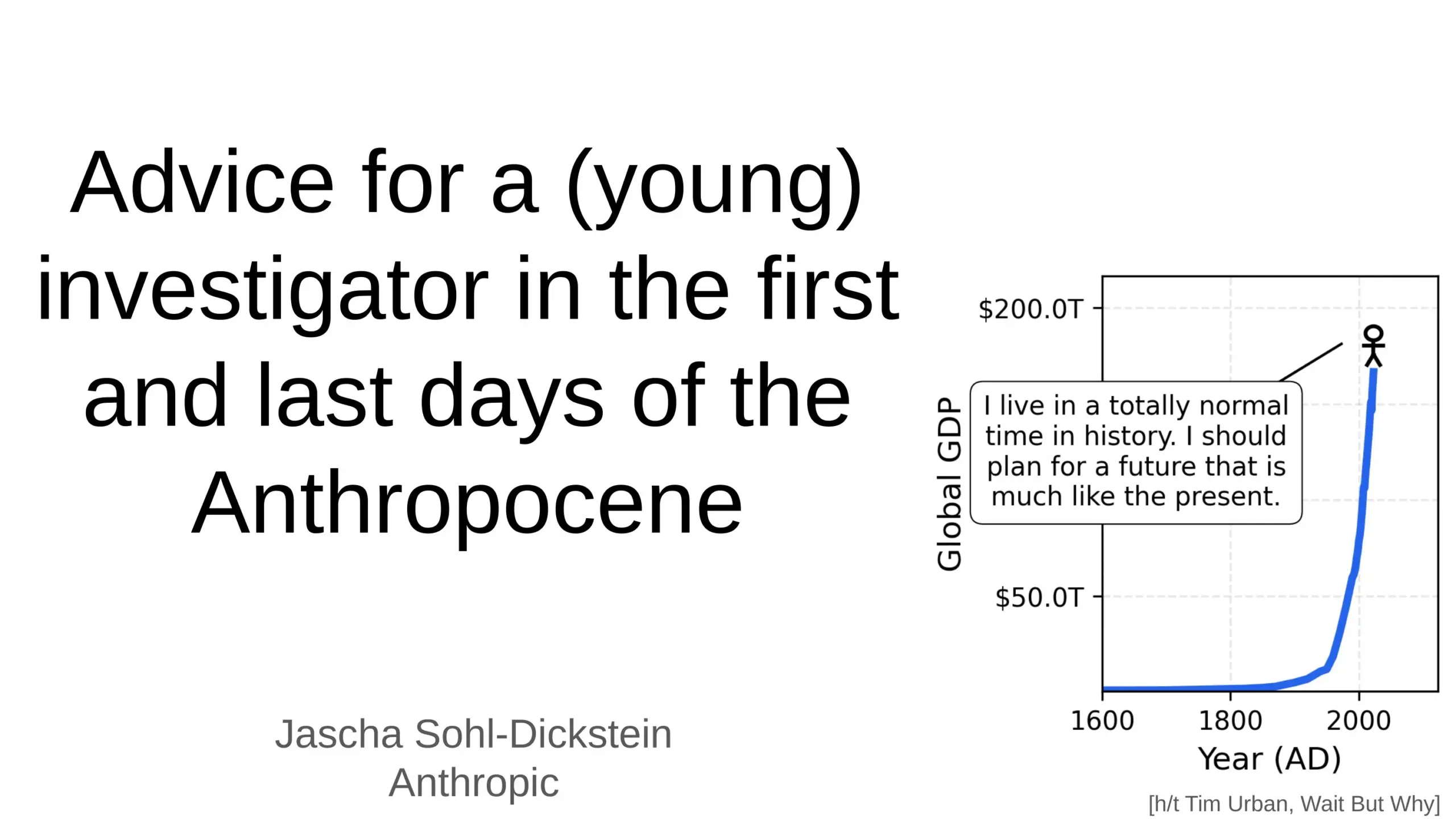

Tiefgreifende Auswirkungen von KI auf die menschliche Zukunft : Die Community diskutiert die tiefgreifenden Auswirkungen von KI auf die menschliche Zukunft, einschließlich der Möglichkeit, dass KI 70 % der täglichen Arbeitsaufgaben automatisiert, und der Vorhersage, dass AGI (Künstliche Allgemeine Intelligenz) innerhalb weniger Jahre alle intellektuellen Aufgaben des Menschen übertreffen könnte. Es werden Bedenken hinsichtlich der KI-Sicherheit und eines “AGI-Weltuntergangs” geäußert, aber auch die Ansicht vertreten, dass KI das menschliche Leben länger, gesünder und einfacher machen wird, und die Rolle des Menschen als “Trittstein” in der Evolution der Komplexität des Universums betont.

(Quelle: Ronald_vanLoon, BlackHC, SchmidhuberAI)

Problem der Paywalls bei KI-Sprach-/Klon-Tools : Die Community diskutiert, warum die meisten KI-Sprach-/Klon-Tools hinter strengen Paywalls verschlossen sind, selbst “kostenlose” Tools oft Zeitlimits haben oder eine Kreditkarte erfordern. Benutzer hinterfragen, ob hochwertige TTS/Klon-Lösungen bei Skalierung wirklich so teuer sind oder ob es sich um eine Geschäftsmodellentscheidung handelt. Dies löst eine Diskussion darüber aus, ob es in Zukunft wirklich offene/kostenlose Langform-TTS-Sprachtools geben wird.

(Quelle: Reddit r/artificial)

💡 Sonstiges

Entwicklung humanoider und bionischer Roboter : Die hochflexiblen humanoiden Roboter CL‑3 und Noetix N2 von Unitree Robotics zeigen außergewöhnliche Haltbarkeit und Flexibilität. Darüber hinaus wurden in Hangzhou, China, bionische Roboterfische zur Umweltüberwachung sowie ballonbetriebene Roboter und adaptive sechsbeinige Roboter eingeführt, was die vielfältige Entwicklung der Robotertechnologie in verschiedenen Anwendungsbereichen demonstriert.

(Quelle: Ronald_vanLoon, Ronald_vanLoon, teortaxesTex, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, teortaxesTex)

KI in der Materialwissenschaft und Entdeckung neuer Materialien : Das Unternehmen Dunia widmet sich dem Aufbau einer Engine zur Entdeckung zukünftiger Materialien und beschleunigt den Prozess der Entdeckung neuer Materialien durch KI-Technologie. Dies zeigt die zunehmende Vertiefung der KI-Anwendungen in der Grundlagenforschung und im Bereich der Hard-Tech und verspricht, bedeutende Durchbrüche in der Materialwissenschaft voranzutreiben, da jeder menschliche Sprung in der Geschichte eng mit der Entdeckung neuer Materialien verbunden war.

(Quelle: seb_ruder)

KI zur Überwachung der Mitarbeiterproduktivität : Es wird diskutiert, dass KI zur Überwachung der Mitarbeiterproduktivität eingesetzt wird, was einen Trend in der Anwendung von KI im Arbeitsmanagement darstellt. Diese Technologie kann detaillierte Daten zur Arbeitsleistung liefern, wirft aber gleichzeitig potenzielle Bedenken hinsichtlich Datenschutz, Mitarbeiterwohlbefinden und Arbeitsplatzethik auf.

(Quelle: Ronald_vanLoon)