Schlüsselwörter:NVIDIA, KI-Fabrik, KI-Infrastruktur, OpenAI, GPT-Tür, Siri, KI-Cloud-Markt, NVIDIA KI-Kapazitätsumstellung, OpenAI Modellwechselkontroverse, Apple Siri KI-Upgrade, Chinas KI-Cloud-Marktwettbewerb, KI-Talentschlacht

🔥 Fokus

NVIDIA gestaltet die KI-Industrie neu: Vom Chip-Verkauf zum „Verkauf von KI-Kapazität“ : NVIDIA-CEO Huang Renxun wies in einem aktuellen Interview darauf hin, dass das Zeitalter des Universal Computing beendet sei und die KI-Nachfrage ein doppelt exponentielles Wachstum erlebe, wobei die Inferenz-Nachfrage voraussichtlich um das Milliardfache steigen werde. NVIDIA wandelt sich vom Chiphersteller zum „KI-Infrastrukturpartner“, indem es in Zusammenarbeit mit Unternehmen wie OpenAI „KI-Fabriken“ im 10GW-Bereich aufbaut und ein „ultimatives kollaboratives Design“ von Chips über Software, Systeme bis hin zu Netzwerken anbietet, um die höchste Leistung pro Energieeinheit zu erzielen. Er betonte, dass diese Full-Stack-Optimierungsfähigkeit eine zentrale Wettbewerbsbarriere darstellt, die NVIDIA in der KI-Industrierevolution eine dominante Position verschafft und das Potenzial hat, den KI-Infrastrukturmarkt von 400 Milliarden US-Dollar auf eine Billion US-Dollar zu erweitern. (Quelle: 36氪, 36氪, Reddit r/artificial)

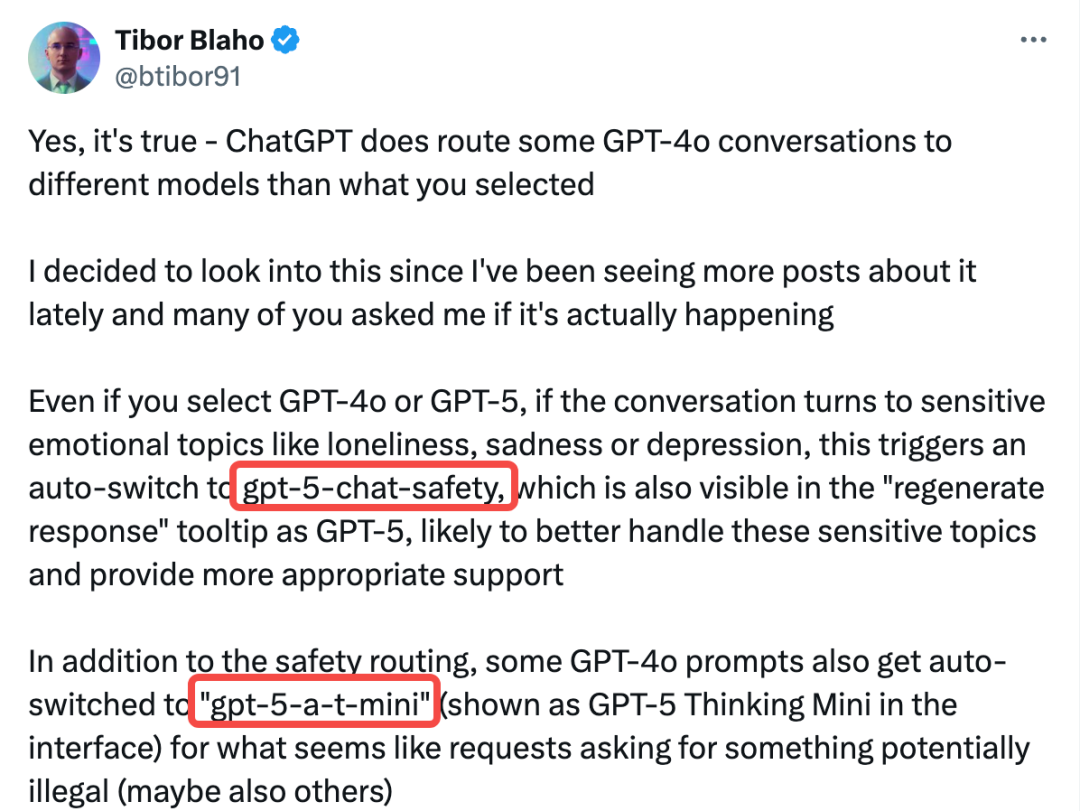

OpenAI „GPT-Gate“-Skandal entfacht: Bezahlte Nutzer heimlich herabgestuft und Modelle gewechselt : OpenAI wird vorgeworfen, Nutzergespräche heimlich an nicht offengelegte „Sicherheitsmodelle“ (gpt-5-chat-safety und 5-a-t-mini) weiterzuleiten, insbesondere wenn emotionale oder sensible Inhalte erkannt werden. Dieses Verhalten, das vom AIPRM-Chefingenieur bestätigt wurde und breites Nutzerfeedback hervorrief, führte zu einer Verschlechterung der Modellleistung, wobei Nutzer ohne ihr Wissen oder ihre Zustimmung Modelle gewechselt bekamen. Obwohl ein OpenAI-Vizepräsident dies als temporären Sicherheitstest bezeichnete, löste der Vorfall starke Bedenken hinsichtlich Transparenz, Nutzerautonomie und potenziell betrügerischem Verhalten aus, was zahlreiche Nutzer dazu veranlasste, ihre Abonnements zu kündigen und die Schaffung von „KI-Nutzerrechten“ zu fordern. (Quelle: 36氪, 36氪, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT)

Apple setzt auf Siri-Wiedergeburt 2026: Systemweite KI und Integration von Drittanbieter-Modellen : Apple gestaltet Siri umfassend neu durch interne ChatGPT-ähnliche Anwendungen „Veritas“ und „Linwood“-Systeme, mit dem Ziel, kontextsensitive Dialoge und tiefe App-Interaktionen zu ermöglichen. Der iOS 26.1 Beta-Code zeigt, dass Apple die Unterstützung für MCP (Model Context Protocol) in App Intents einführt, was es kompatiblen KI-Modellen wie ChatGPT und Claude ermöglichen wird, direkt mit Mac-, iPhone- und iPad-Anwendungen zu interagieren. Dieser Schritt markiert Apples Übergang von einem „Full-Stack“-Ansatz zu einem „Plattform-Ansatz“, der durch die Integration von Drittanbieter-Modellen die Entwicklung seines KI-Ökosystems beschleunigt, während Datenschutz und eine konsistente Nutzererfahrung gewährleistet werden. Die neue Siri-Version wird voraussichtlich Anfang 2026 erscheinen. (Quelle: 36氪, 36氪)

Hintons Prophezeiung widerlegt: KI hat Radiologen nicht ersetzt, sondern sie noch beschäftigter gemacht : Im Jahr 2016 sagte Geoffrey Hinton, der Vater der KI, voraus, dass KI Radiologen innerhalb von fünf Jahren ersetzen würde, und empfahl, die Ausbildung einzustellen. Fast zehn Jahre später erreichen jedoch sowohl die Anzahl der Radiologen in den USA als auch ihr durchschnittliches Jahresgehalt (bis zu 520.000 US-Dollar) neue Höchststände. Hauptgründe dafür sind die abnehmende KI-Leistung in realen klinischen Szenarien, rechtliche und regulatorische Hürden sowie die Tatsache, dass KI nur einen kleinen Teil der Arbeit von Ärzten abdeckt. Dies spiegelt das Jevons-Paradoxon wider: KI erhöht die Effizienz der Bildinterpretation, was jedoch den Bedarf an Ärzten für Überwachung, Kommunikation und nicht-diagnostische Aufgaben steigert, wodurch ihre Arbeit umfangreicher wird, anstatt sie zu ersetzen. (Quelle: 36氪)

🎯 Trends

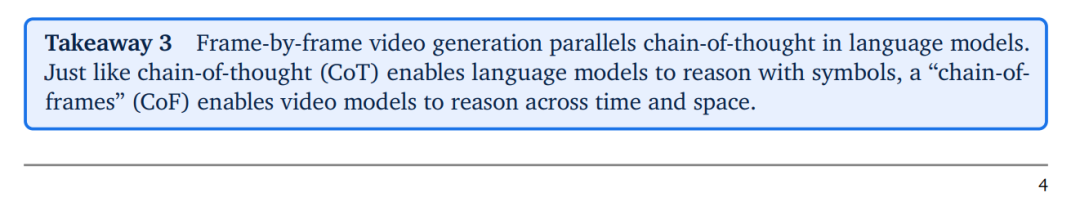

DeepMind Veo 3 stellt „Frame-of-Thought“-Konzept vor, fördert universelles visuelles Verständnis in Videomodellen : DeepMinds Videomodell Veo 3 führt das Konzept der „Frame-of-Thought“ (CoF) ein, analog zur Chain-of-Thought (CoT) von Large Language Models (LLM), wodurch es Zero-Shot Visual Reasoning durchführen kann. Veo 3 zeigt starke Fähigkeiten zur Wahrnehmung, Modellierung und Manipulation der visuellen Welt und hat das Potenzial, ein „universelles Basismodell“ im Bereich der maschinellen Bildverarbeitung zu werden. Die Forschung prognostiziert, dass mit der schnellen Verbesserung der Modellfähigkeiten und sinkenden Kosten im Bereich der Videomodelle „Generalisten Spezialisten ersetzen werden“, was eine neue Phase rasanter Entwicklung in der Videogenerierung und -verständnis einläutet. (Quelle: 36氪, shlomifruchter, scaling01, Reddit r/artificial)

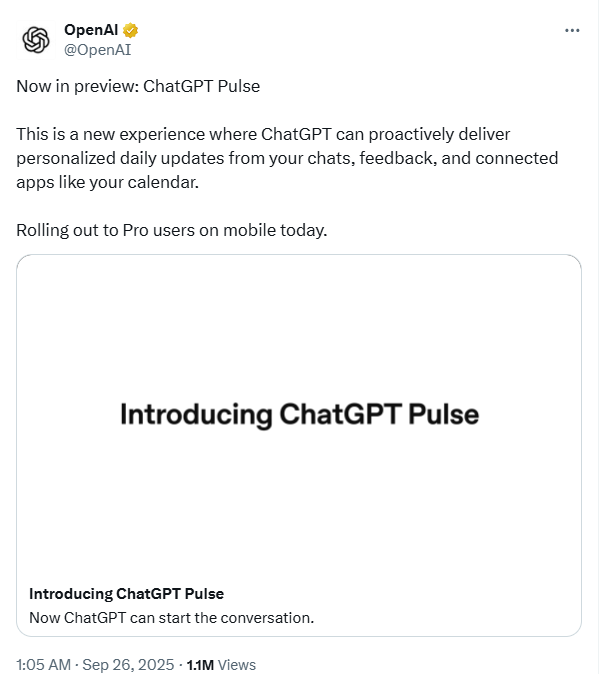

ChatGPT Pulse gestartet: KI wechselt von passiver Beantwortung zu proaktivem Service : OpenAI hat die „Pulse“-Funktion für ChatGPT Pro-Nutzer eingeführt, was die Entwicklung von ChatGPT von einem passiven Frage-Antwort-Tool zu einem persönlichen Assistenten markiert, der proaktiv Nutzerbedürfnisse vorhersagt. Pulse erstellt durch nächtliche „asynchrone Recherche“, die Nutzer-Chatverläufe, Erinnerungen und externe Anwendungen (wie Gmail, Google Calendar) kombiniert, morgens personalisierte „tägliche Briefings“. Dies stellt einen wichtigen Schritt von OpenAI im Bereich der „intelligenten Agenten-KI“ dar, mit dem Ziel, KI-Assistenten zu ermöglichen, Nutzerziele zu verstehen und ohne Aufforderung proaktiv Dienste anzubieten, wodurch ein neues Paradigma der Mensch-Computer-Interaktion geschaffen wird. (Quelle: 36kr)

Sutton, Vater des Reinforcement Learning: Large Language Models sind der falsche Ausgangspunkt : Richard Sutton, der Vater des Reinforcement Learning, stellte in einem Interview fest, dass Large Language Models (LLM) der falsche Ausgangspunkt für echte Intelligenz seien. Er ist der Meinung, dass echte Intelligenz aus „erfahrungsbasiertem Lernen“ entsteht, d.h. durch kontinuierliche Verhaltenskorrektur mittels Handlungen, Beobachtungen und Feedback zur Zielerreichung. Die Vorhersagefähigkeit von LLMs sei lediglich eine Nachahmung menschlichen Verhaltens und es fehle ihnen an unabhängigen Zielen und der Fähigkeit, über Veränderungen in der Außenwelt „überrascht“ zu sein. Diese Ansicht löste eine tiefgreifende Debatte über den Entwicklungspfad der AGI (Artificial General Intelligence) aus und hinterfragt das derzeitige, von LLMs dominierte KI-Paradigma. (Quelle: 36kr, paul_cal, algo_diver, scaling01, rao2z, bookwormengr, BlackHC, rao2z)

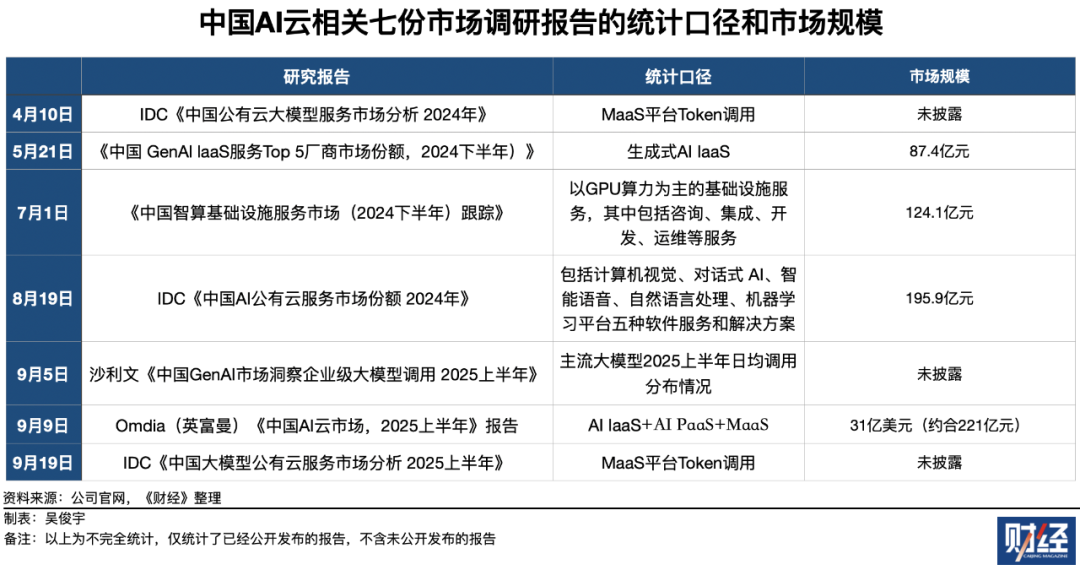

Chinas KI-Cloud-Markt im harten Wettbewerb: Alibaba Cloud führt, Volcengine holt schnell auf : Im Jahr 2025 ist der chinesische „KI-Cloud“-Markt hart umkämpft. Alibaba Cloud führt weiterhin in Bezug auf den Gesamtumsatz, der AI IaaS, PaaS und MaaS umfasst. ByteDance’s Volcengine dominiert jedoch den MaaS (Model-as-a-Service) Token-Aufrufmarkt mit einem Marktanteil von fast der Hälfte und wird mit erstaunlichem Wachstum zum größten Konkurrenten von Alibaba Cloud. Baidu Smart Cloud liegt im Bereich der öffentlichen KI-Cloud-Dienste (Softwareprodukte und -lösungen) gleichauf mit Alibaba Cloud an erster Stelle. Der Markt zeigt eine mehrdimensionale Wettbewerbssituation, wobei die Token-Aufrufe exponentiell wachsen, was auf ein enormes Wachstumspotenzial und eine Neugestaltung des zukünftigen KI-Cloud-Marktes hindeutet. (Quelle: 36氪)

KI-Talentkampf eskaliert: Hohe Gehälter und H-1B Visum-Herausforderungen : Der KI-Talentmarkt bleibt heiß. Xpeng Motors kündigte an, 2026 über 3000 Hochschulabsolventen einzustellen, mit Jahresgehältern von bis zu 1,6 Millionen und keiner Obergrenze für herausragende Talente. Meta bietet astronomische Gesamtvergütungspakete von über 200 Millionen US-Dollar, um Top-KI-Talente anzuziehen, während NVIDIA und OpenAI ebenfalls durch Übernahmen und Aktienoptionen um Talente kämpfen. Die Verschärfung der US-H-1B-Visumspolitik (z.B. zusätzliche Gebühren von 100.000 US-Dollar) stellt jedoch eine Herausforderung für hochqualifizierte ausländische Talente dar, im Silicon Valley zu bleiben, was bei Tech-Giganten Bedenken hinsichtlich des Talentabflusses hervorruft und die Intensität und Komplexität des globalen KI-Talentwettbewerbs unterstreicht. (Quelle: 36kr, 36kr)

🧰 Tools

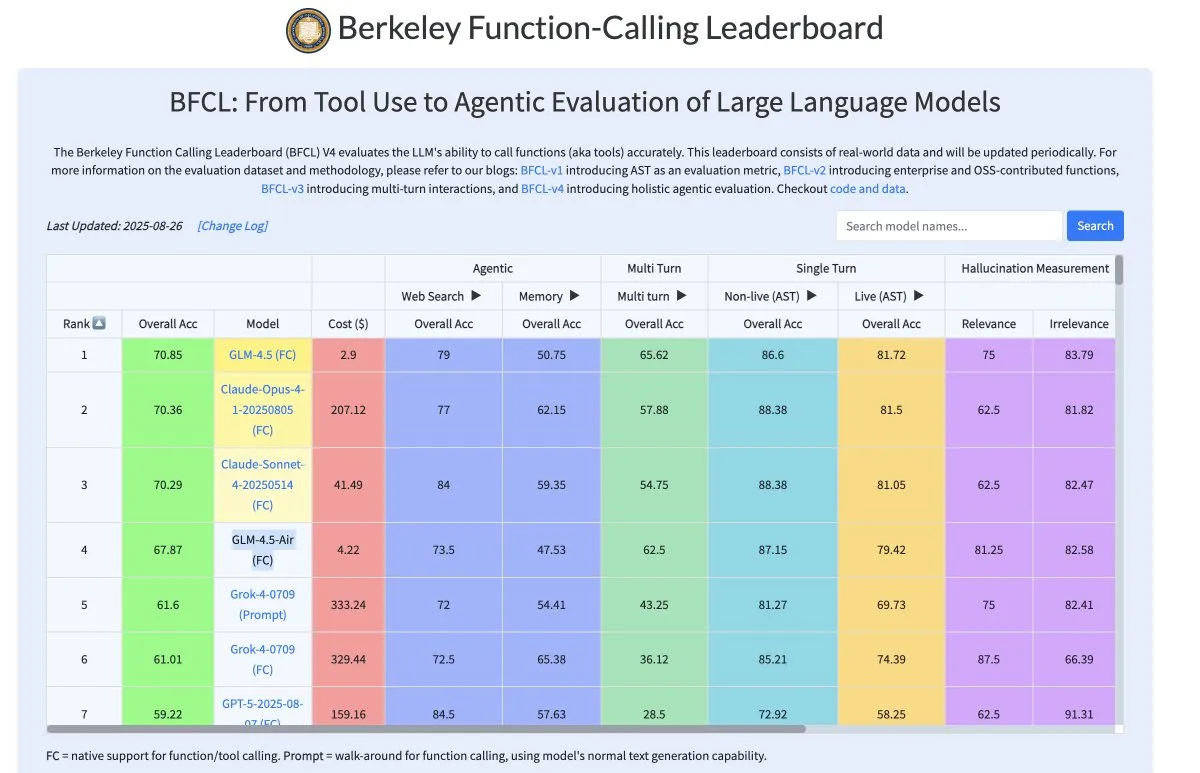

Zhipu AI GLM-4.5-Air: Kosteneffizientes Tool-Calling-Modell : Zhipu AIs GLM-4.5-Air-Modell (106B Parameter, 12B aktive Parameter) zeigt eine hervorragende Leistung beim Tool-Calling, die der von Claude 4 nahekommt, jedoch mit 90% geringeren Kosten. Das Modell reduziert Halluzinationen in der Inferenzphase erheblich, erhöht die Zuverlässigkeit des Tool-Callings und macht tiefe Forschungs-Workflows stabiler und effizienter, wodurch Entwicklern eine kosteneffiziente LLM-Lösung geboten wird. (Quelle: bookwormengr)

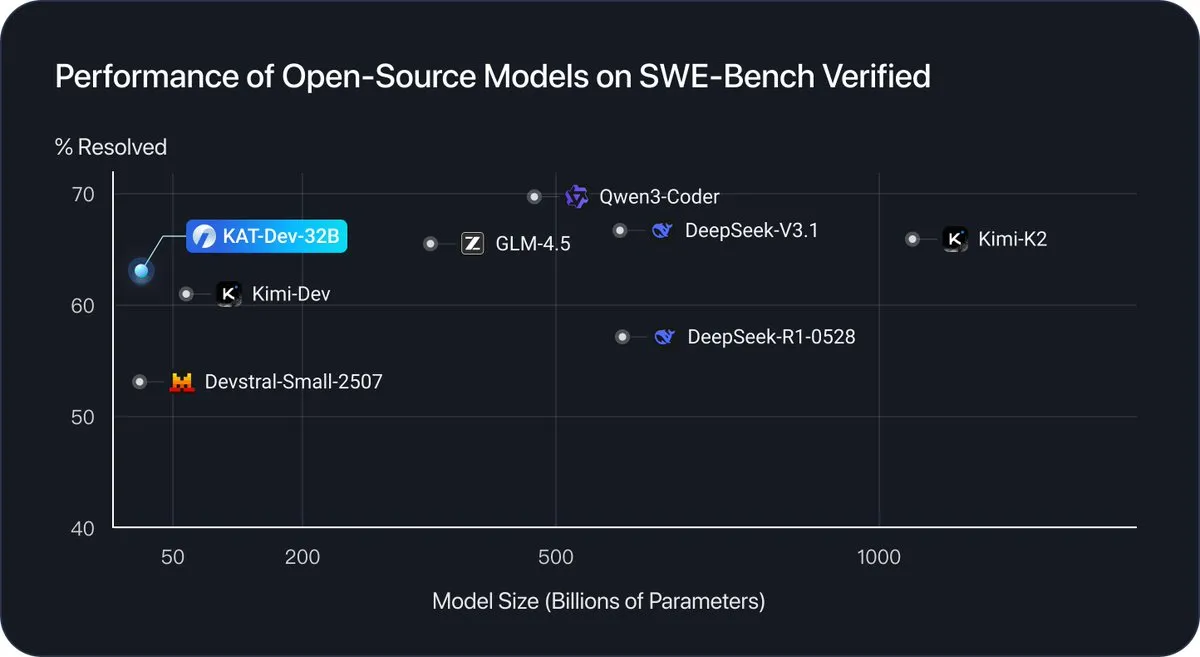

KAT-Dev-32B: 32B-Parameter-Modell, speziell für Software-Engineering-Aufgaben entwickelt : KAT-Dev-32B ist ein 32B-Parameter-Modell, das sich auf Software-Engineering-Aufgaben spezialisiert. Es erreichte eine Lösungsrate von 62,4% im SWE-Bench Verified-Benchmark und belegt im Vergleich zu Open-Source-Modellen unterschiedlicher Größe den fünften Platz in Bezug auf die Leistung, was erhebliche Fortschritte von Open-Source-LLMs in den Bereichen Codegenerierung, Debugging und Entwicklungsworkflows demonstriert. (Quelle: _akhaliq)

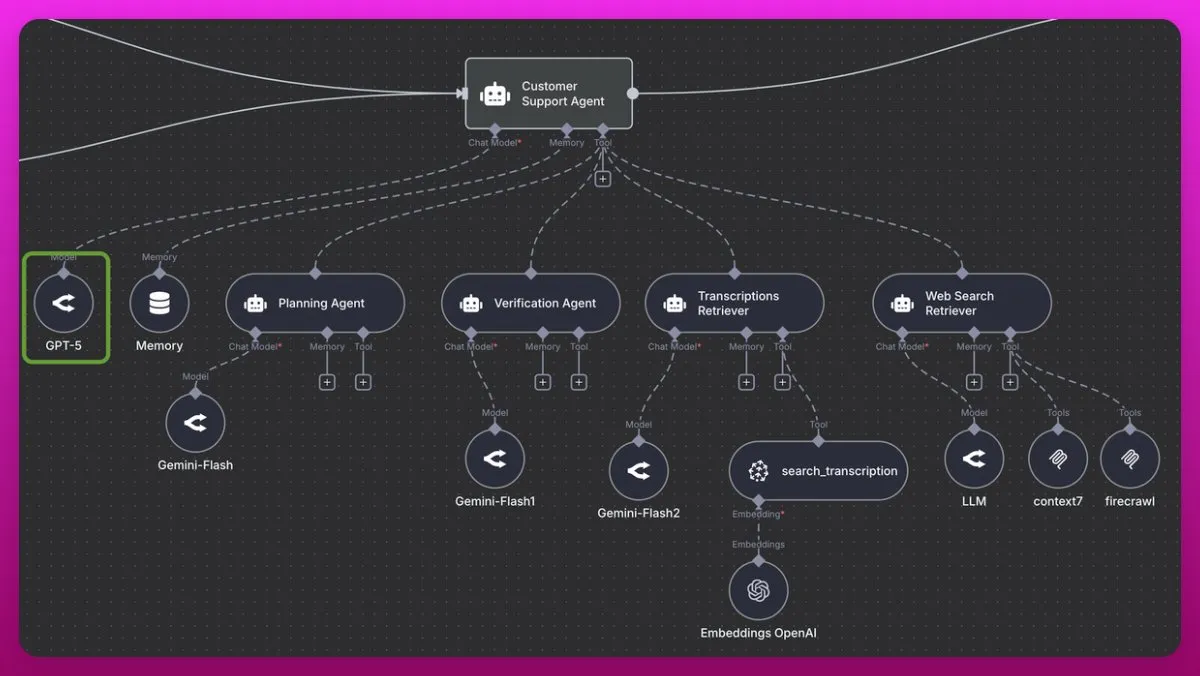

GPT-5: Exzellenter Koordinator für Multi-Agenten-Systeme : GPT-5 wird als hervorragender Koordinator für Multi-Agenten-Systeme gelobt, insbesondere für Bereiche außerhalb der Codierung, wie z.B. Kundensupport. Es kann Absichten tief verstehen, große Datenmengen effizient verarbeiten und Informationslücken schließen, was es bei der Verwaltung komplexer Multi-Retrieval-Systeme hervorragend macht. Im Vergleich zu Claude 4 (aufgrund der Kosten) und Gemini 2.5 Pro übertrifft GPT-5 (einschließlich GPT-5-mini) in Konsistenz und Genauigkeit des Tool-Callings und bietet starke Unterstützung für die Entwicklung fortschrittlicher Agenten-Systeme. (Quelle: omarsar0)

Tencent HunyuanImage 3.0: Neuer Maßstab für Open-Source Text-to-Image Large Models : Das Tencent Hunyuan-Team hat HunyuanImage 3.0 veröffentlicht, ein Open-Source Text-to-Image-Modell mit über 80 Milliarden Parametern, das während der Inferenz 13 Milliarden Parameter aktiviert. Das Modell verwendet eine Transfusion-based MoE-Architektur und koppelt Diffusion- und LLM-Training tief miteinander, wodurch es starke Fähigkeiten zur Weltwissensinferenz, komplexes Verständnis von Prompts im Tausend-Wort-Bereich und präzise Textgenerierung innerhalb von Bildern besitzt. HunyuanImage 3.0 zielt darauf ab, Grafikdesign- und Content-Erstellungsprozesse zu revolutionieren und plant zukünftig die Unterstützung von Image-to-Image, Bildbearbeitung und anderen multimodalen Interaktionen. (Quelle: nrehiew_, jpt401)

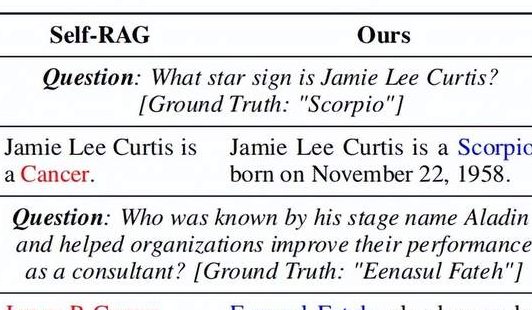

DRAG-Framework: Verbessert das Verständnis von RAG-Modellen für lexikalische Diversität : ACL 2025 schlägt das Lexical Diversity-aware RAG (DRAG)-Framework vor, das erstmals „lexikalische Diversität“ in den Retrieval- und Generierungsprozess von RAG einführt. DRAG zerlegt die Abfragesemantik in invariante, variable und ergänzende Komponenten und verwendet differenzierte Strategien für Relevanzbewertung und Risikospärlichkeitskalibrierung. Diese Methode verbessert die RAG-Genauigkeit erheblich (z.B. 10,6% Steigerung bei HotpotQA), setzt neue SOTA-Benchmarks in mehreren Bereichen und ist von großer Bedeutung für Informationsabruf- und Frage-Antwort-Systeme, da sie komplexe menschliche Sprache präziser verstehen können. (Quelle: 量子位)

Tencent Hunyuan3D-Part: Branchenweit erstes Modell zur Generierung hochwertiger nativer 3D-Komponenten : Das Tencent Hunyuan 3D-Team hat Hunyuan3D-Part vorgestellt, das branchenweit erste Modell, das hochwertige, semantisch zerlegbare 3D-Komponenten generieren kann. Dieses Modell erreicht durch das native 3D-Segmentierungsmodell P3-SAM und das industrietaugliche Komponentengenerierungsmodell X-Part eine hochgetreue, strukturell konsistente 3D-Teilegenerierung. Dieser Durchbruch ist von großer Bedeutung für Videospiel-Produktionspipelines und die 3D-Druckindustrie, da er komplexe Geometrien in einfache Komponenten zerlegen kann, den Aufwand für die nachgelagerte Verarbeitung erheblich reduziert und modulare Montage unterstützt. (Quelle: 量子位)

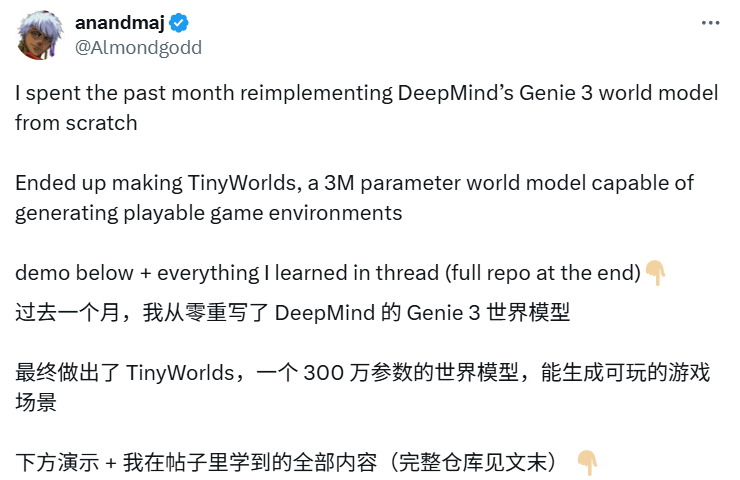

TinyWorlds: 3 Millionen Parameter replizieren DeepMind World Model, ermöglichen interaktive Echtzeit-Pixelspiele : X-Blogger anandmaj hat innerhalb eines Monats die Kernideen von DeepMind Genie 3 repliziert und TinyWorlds entwickelt. Dieses World Model mit nur 3 Millionen Parametern kann spielbare Pixel-Art-Spielumgebungen wie Pong, Sonic, Zelda und Doom in Echtzeit generieren. Es erfasst Videoinformationen durch spatio-temporale Transformer und Video-Tokenisierer und ermöglicht so die Generierung interaktiver Pixelwelten, was das enorme Potenzial kleiner Modelle im Bereich der Echtzeit-Weltgenerierung demonstriert und der Code ist Open Source. (Quelle: 36氪)

OpenWebUI unterstützt nativ MCP: Neues Paradigma für die LLM-Tool-Integration : Das neueste Update von OpenWebUI unterstützt nativ Model Context Protocol (MCP)-Server, sodass Benutzer nun externe Tools wie HuggingFace MCP integrieren können. Diese Funktion standardisiert die Verbindung von LLMs mit externen Datenquellen und Tools, erweitert das Ökosystem der KI-Anwendungen und ermöglicht es Benutzern, verschiedene KI-Tools in der OpenWebUI-Oberfläche flexibler und effizienter zu nutzen. (Quelle: Reddit r/LocalLLaMA, Reddit r/OpenWebUI)

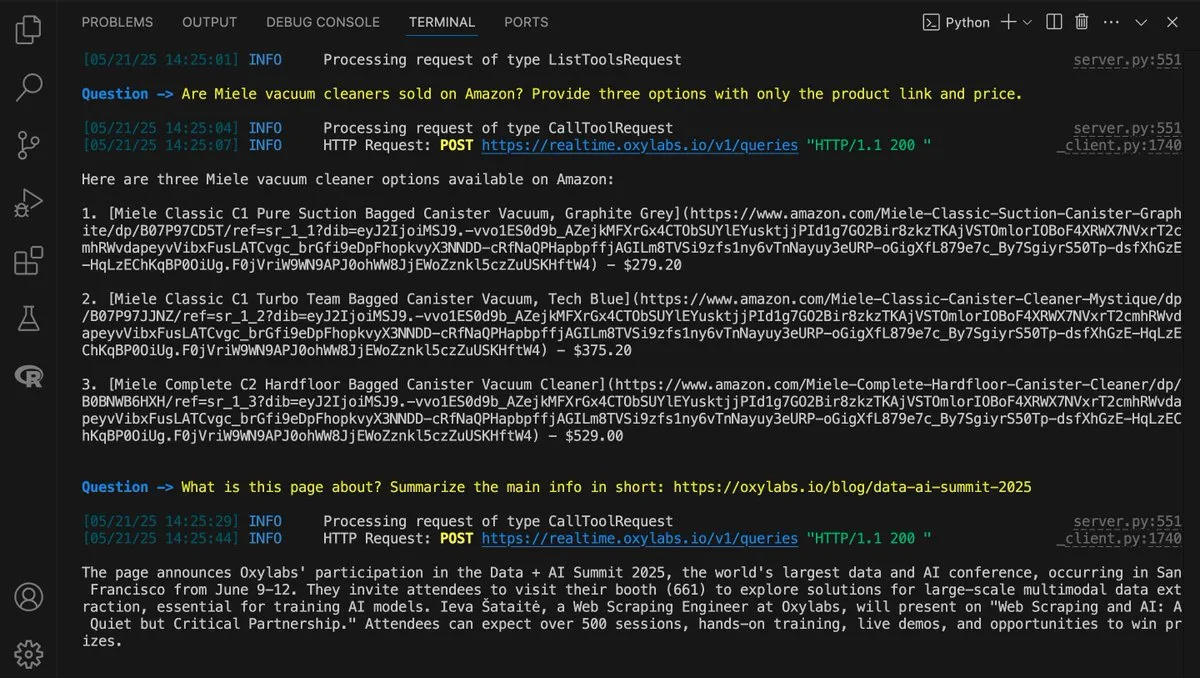

LangChain und Oxylabs kooperieren: Aufbau einer KI-gesteuerten Web-Scraping-Lösung : LangChain und Oxylabs haben einen Leitfaden veröffentlicht, der zeigt, wie die Intelligenz von LangChain mit der Scraping-Infrastruktur von Oxylabs kombiniert werden kann, um eine KI-gesteuerte Web-Scraping-Lösung aufzubauen. Diese Lösung unterstützt Mehrsprachigkeit und verschiedene Integrationsmethoden, wodurch KI-Agenten gängige Web-Zugangsherausforderungen wie IP-Sperren und CAPTCHAs überwinden können, was einen effizienteren Echtzeit-Datenabruf ermöglicht und Agenten-Workflows unterstützt. (Quelle: LangChainAI)

Open-Source LLM-Evaluierungstool Opik: Umfassende Überwachung und Debugging von KI-Anwendungen : Opik ist ein neu veröffentlichtes Open-Source LLM-Evaluierungstool, das Entwicklern helfen soll, LLM-Anwendungen, RAG-Systeme und Agenten-Workflows zu debuggen, zu evaluieren und zu überwachen. Es bietet umfassendes Tracking, automatisierte Evaluierung und produktionsreife Dashboards, die wichtige Erkenntnisse zur Verbesserung der Leistung und Zuverlässigkeit von KI-Systemen liefern. (Quelle: dl_weekly)

📚 Lernen

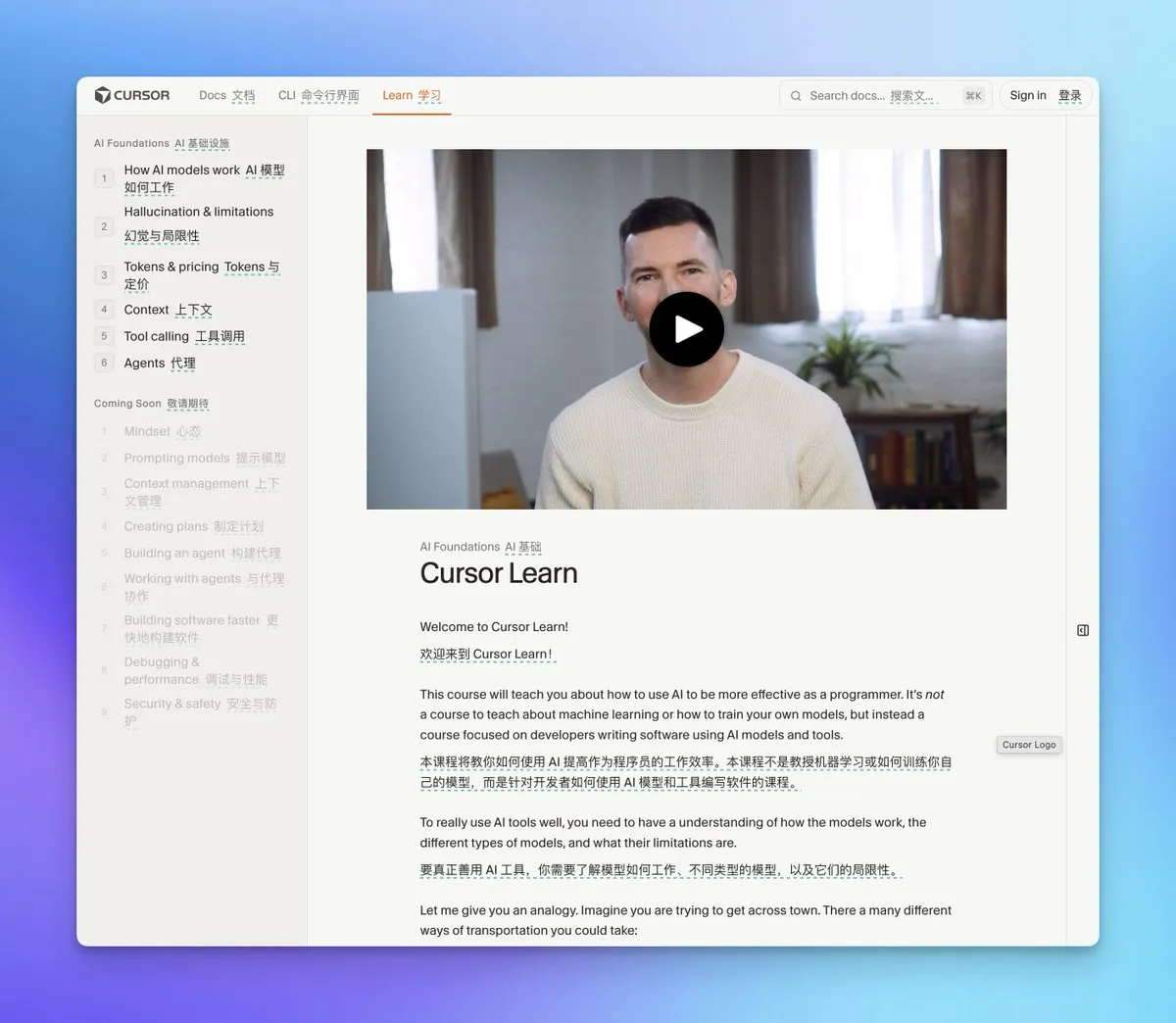

Cursor Learn: Kostenlose KI-Grundlagen-Videokurse : Cursor Learn hat einen kostenlosen sechsteiligen KI-Grundlagen-Videokurs veröffentlicht, der speziell für Anfänger konzipiert ist und Kernkonzepte wie Token, Kontext und Agenten abdeckt. Der Kurs enthält Quizze und interaktive KI-Modelle und zielt darauf ab, innerhalb einer Stunde KI-Grundlagenwissen zu vermitteln, einschließlich fortgeschrittener Themen wie Agenten-Kollaboration und Kontextmanagement, was ihn zu einer wertvollen Ressource für den KI-Einstieg macht. (Quelle: cursor_ai, op7418)

Ausgewählte AI/ML GitHub Code-Bibliotheken: Umfassende Frameworks wie PyTorch, TensorFlow : Auf GitHub wurde eine Reihe ausgewählter AI/ML Code-Bibliotheken geteilt, die praktische Notebooks für verschiedene Deep-Learning-Frameworks wie PyTorch, TensorFlow und FastAI enthalten. Diese Ressourcen decken Bereiche wie Computer Vision, Natural Language Processing, GANs, Transformer, AutoML und Objekterkennung ab und bieten Lernenden und Praktikern umfangreiches Lernmaterial, das die technische Erkundung und Projektentwicklung unterstützt. (Quelle: Reddit r/deeplearning)

Kostenloses E-Book: „A First Course on Data Structures in Python“ : Ein kostenloses E-Book mit dem Titel „A First Course on Data Structures in Python“ wurde veröffentlicht. Das Buch bietet die grundlegenden Bausteine, die für KI und Machine Learning erforderlich sind, einschließlich Datenstrukturen, algorithmischem Denken, Komplexitätsanalyse, Rekursion/Dynamischer Programmierung und Suchmethoden, und ist eine wertvolle Ressource zum Erlernen der KI-Grundlagen. (Quelle: TheTuringPost)

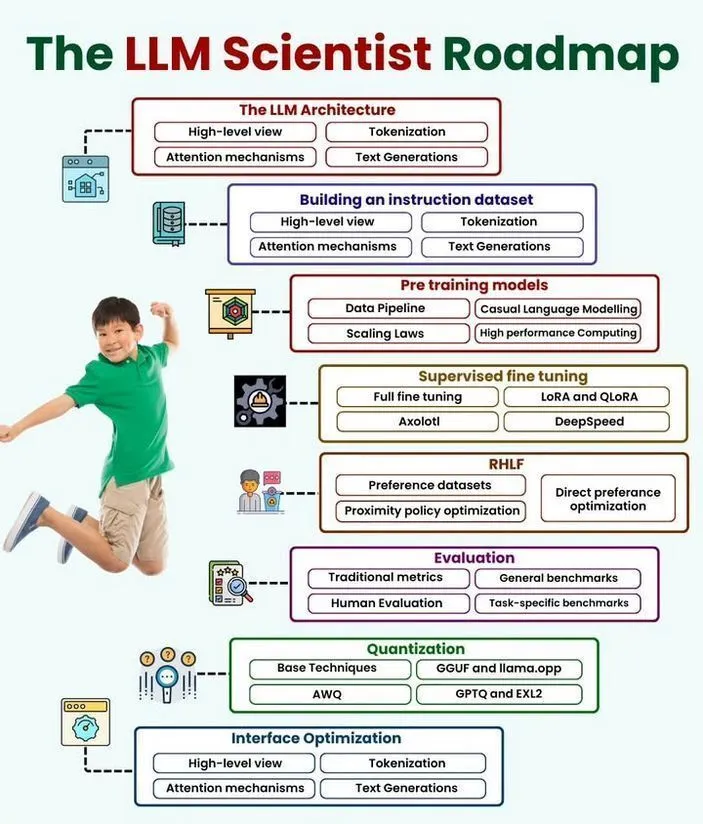

LLM-Wissenschaftler und Data Scientist Roadmaps veröffentlicht : Detaillierte Roadmaps für die berufliche Entwicklung von LLM-Wissenschaftlern und Data Scientists wurden veröffentlicht. Diese Ressourcen skizzieren die erforderlichen Fähigkeiten, Tools und Lernpfade, um in die Bereiche Künstliche Intelligenz, Maschinelles Lernen und Datenwissenschaft einzusteigen oder sich dort weiterzuentwickeln, und bieten eine klare Anleitung zur Karriereplanung für Interessierte. (Quelle: Ronald_vanLoon, Ronald_vanLoon)

A16Z Speedrun 2026: Startup-Accelerator für KI und Unterhaltung : A16Z Speedrun 2026 nimmt Bewerbungen von Gründern im Bereich KI und Unterhaltung entgegen. Das Programm bietet Unterstützung für Gründer, die sich auf den Aufbau ihres eigenen Unternehmens konzentrieren, und ist eine Gelegenheit für Unternehmer, die im sich schnell entwickelnden Bereich der KI-gesteuerten Produkte wachsen möchten. (Quelle: yoheinakajima)

💼 Business

MiniMax Urheberrechtsklage: Schatten auf dem Börsengang des KI-Einhorns : Das chinesische KI-Einhorn MiniMax, mit einer Bewertung von über 4 Milliarden US-Dollar, sieht sich einer gemeinsamen Urheberrechtsklage von Disney, Universal Pictures und Warner Bros. gegenüber. Die Klage wirft MiniMax vor, dass sein Videogenerierungstool „Haikuo AI“ durch Benutzerprompts Inhalte mit urheberrechtlich geschützten Charakteren generiert, was eine systematische Urheberrechtsverletzung darstellt. Dieser Fall stellt einen verheerenden Schlag für die IPO-Pläne von MiniMax dar und unterstreicht die ernsthaften Herausforderungen der IP-Compliance im generativen KI-Markt sowie die Bedeutung des Gleichgewichts zwischen technologischer Innovation und rechtlichen Grenzen. (Quelle: 36氪)

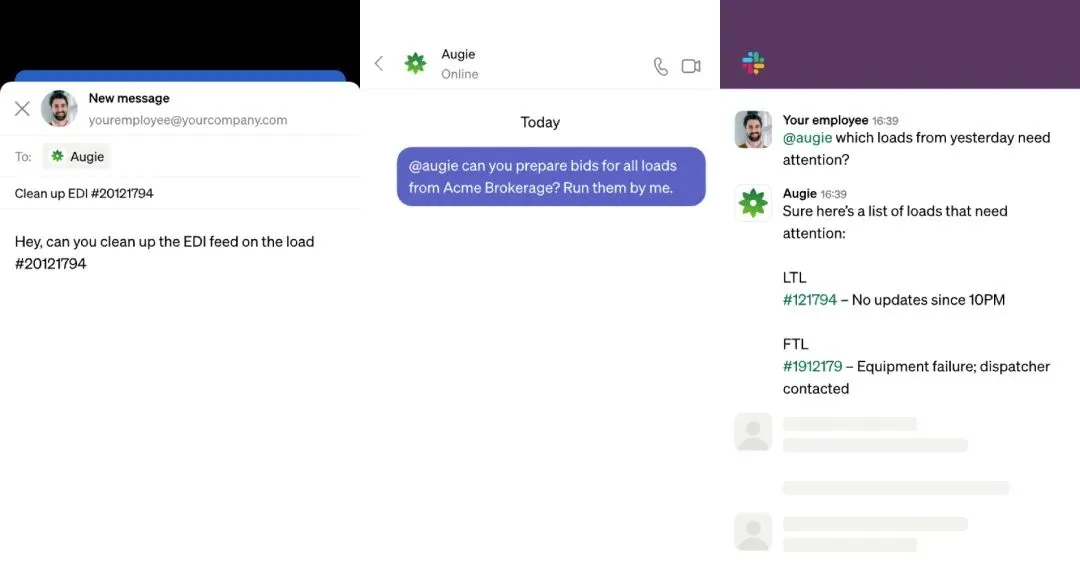

KI-Logistikunternehmen Augment erhält 85 Millionen US-Dollar Finanzierung, Gesamtfinanzierung von 800 Millionen RMB nach fünf Monaten : Das KI-Logistikunternehmen Augment hat nur fünf Monate nach dem Start erfolgreich eine Series A Finanzierungsrunde über 85 Millionen US-Dollar abgeschlossen, wodurch die Gesamtfinanzierung 110 Millionen US-Dollar (ca. 800 Millionen RMB) erreicht. Sein KI-Agentenprodukt Augie kann komplexe, fragmentierte Aufgaben im gesamten Logistiklebenszyklus, von der Auftragsannahme bis zur Zahlung, automatisieren. Es hat bereits Waren im Wert von über 35 Milliarden US-Dollar für Dutzende führende 3PLs (Third-Party Logistics) und Verlader verwaltet und Kunden Millionen von US-Dollar gespart, was den starken kommerziellen Wert von KI bei der Optimierung arbeitsintensiver Logistikbereiche demonstriert. (Quelle: 36氪)

Microsoft integriert Anthropic’s Claude-Modelle in Copilot : Microsoft hat Anthropic’s Claude Sonnet 4 und Opus 4.1 Modelle in seinen Copilot-Assistenten für Unternehmenskunden integriert. Dieser Schritt zielt darauf ab, die alleinige Abhängigkeit von OpenAI zu reduzieren und Microsofts Position als neutraler Plattformanbieter zu festigen. Unternehmenskunden können nun zwischen OpenAI- und Anthropic-Modellen wählen, was die Flexibilität erhöht und voraussichtlich den Wettbewerb im Unternehmens-KI-Markt fördern wird. (Quelle: Reddit r/deeplearning)

🌟 Community

KI’s Einfluss auf menschliches Verständnis und Gesellschaft: Das Paradox von Effizienz und „Informationsblasen“ : Die Community ist allgemein besorgt, dass KI, ähnlich wie soziale Medien, das menschliche Verständnis, kritisches Denken und Lebensziele negativ beeinflussen könnte. Durch die Optimierung der Inhaltserstellung auf „Verbreitung“ statt auf „Wahrheit“ oder „Tiefe“ könnte KI zu einem „Lernplateau“ und einer „Maschine für unendlichen Müll“ führen. Dies löst eine Diskussion darüber aus, wie die KI-Entwicklung hin zu wachstumsfördernden statt süchtig machenden Tools gelenkt werden kann, und fordert Veränderungen in Regulierung, Industriepraktiken und kulturellen Normen. (Quelle: Reddit r/ArtificialInteligence, Reddit r/artificial, Reddit r/ArtificialInteligence, Yuchenj_UW, colin_fraser, Teknium1, cloneofsimo)

KI am Arbeitsplatz: Der Konflikt zwischen Effizienzsteigerung und „verdeckter Ausbeutung“ : Die Integration von KI in den Arbeitsplatz, insbesondere für Mitarbeiter auf der Ausführungsebene, führt zu einem Paradoxon: Effizienzsteigerungen gehen oft mit höheren Leistungserwartungen einher, ohne dass die Mitarbeiter entsprechende Belohnungen erhalten. Diese „verdeckte Ausbeutung“ verwandelt Mitarbeiter in „manuelle Qualitätsprüfer“ für KI-generierte Inhalte, was die kognitive Belastung und Angst erhöht. KI steigert die Unternehmensproduktivität, aber die Gewinne fließen eher ins Kapital, was die „kognitive Kluft“ zwischen strategischen Managern und toolabhängigen Ausführenden vertieft. Ohne eine Umstrukturierung der Organisation könnte dies zu weit verbreitetem Burnout führen. (Quelle: 36氪, glennko, mbusigin)

Im Zeitalter der KI übertrifft der Wert der „Fragekompetenz“ die „Ausführungskompetenz“ : In einer KI-gesteuerten Welt verlagert sich der wahre Wettbewerbsvorteil von der Ausführungsgeschwindigkeit zur „Fragekompetenz“ – der Fähigkeit, zu erkennen, welche Probleme es wert sind, gelöst zu werden. Eine übermäßige Abhängigkeit von KI für die Ausführung ohne kritische Problemdefinition könnte dazu führen, die falschen Probleme effizient zu lösen und ein falsches Gefühl des Fortschritts zu erzeugen. Design Thinking, Empathie-Mapping und kontinuierliches Hinterfragen werden als entscheidende menschliche Fähigkeiten angesehen, die KI nicht ersetzen kann, und helfen Einzelpersonen und Organisationen, KI effektiv zu nutzen und sich auf die Lösung bedeutungsvoller Herausforderungen zu konzentrieren. (Quelle: 36氪)

KI-Geopolitik: Der KI-Wettlauf zwischen China und den USA und internationale Regulierungsdebatten : Der KI-Wettlauf zwischen China und den USA wird als Marathon und nicht als Sprint betrachtet, wobei China bei Roboteranwendungen führend sein könnte. Die USA werden aufgefordert, sich auf praktische KI-Investitionen zu konzentrieren, anstatt nur nach Superintelligenz zu streben, lehnen jedoch internationale KI-Aufsicht auf UN-Ebene ab und betonen die nationale Souveränität. Dies unterstreicht die komplexe geopolitische Landschaft, in der KI-Entwicklung mit nationaler Sicherheit, Handelspolitik (wie H-1B-Visa) sowie dem Wettbewerb um KI-Infrastruktur und Talente verknüpft ist. (Quelle: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, adcock_brett, Dorialexander, teortaxesTex, teortaxesTex, teortaxesTex, brickroad7, jonst0kes)

Emad Mostaque prognostiziert die „letzte Ökonomie“: KI wird den menschlichen Wert neu definieren : Emad Mostaque, ehemaliger CEO von Stability AI, prognostiziert, dass KI die Wirtschaftsstruktur innerhalb der nächsten 1000 Tage vollständig umgestalten wird und der Wert menschlicher Arbeitskraft auf Null oder sogar negativ sinken könnte. Er schlägt das „MIND-Framework“ (Materie, Intelligenz, Netzwerke, Diversität) zur Messung der Wirtschaftsgesundheit vor und argumentiert, dass der durch KI verursachte Überschuss an „intellektuellem Kapital“ eine Neubewertung der Bedeutung anderer Kapitalformen erfordert. Diese „vierte Umkehrung“ wird dazu führen, dass KI kognitive Arbeit ersetzt, und erfordert den Aufbau einer „menschenzentrierten“ neuen Währung und einer universellen Basis-KI zur Bewältigung des gesellschaftlichen Wandels. (Quelle: 36氪)

KI-Hardware-Wettlauf: OpenAI, ByteDance und Meta kämpfen um den Markt für Consumer-Geräte : Tech-Giganten wie OpenAI, ByteDance und Meta investieren aktiv in die Entwicklung von KI-Hardware für Endverbraucher. Metas Ray-Ban AI-Brillen haben bereits beachtliche Verkaufszahlen erzielt, während OpenAI Berichten zufolge mit Apple-Zulieferern an der Entwicklung eines „bildschirmlosen Smart Speakers“ arbeitet und ByteDance KI-Smart-Brillen entwickelt. Dieser Wettlauf deutet darauf hin, dass KI tiefer in den Alltag integriert wird, und die Unternehmen erforschen vielfältige Produktformen und Interaktionsmodelle, um im Bereich der umgebungsbewussten KI die Nase vorn zu haben. (Quelle: 36氪)

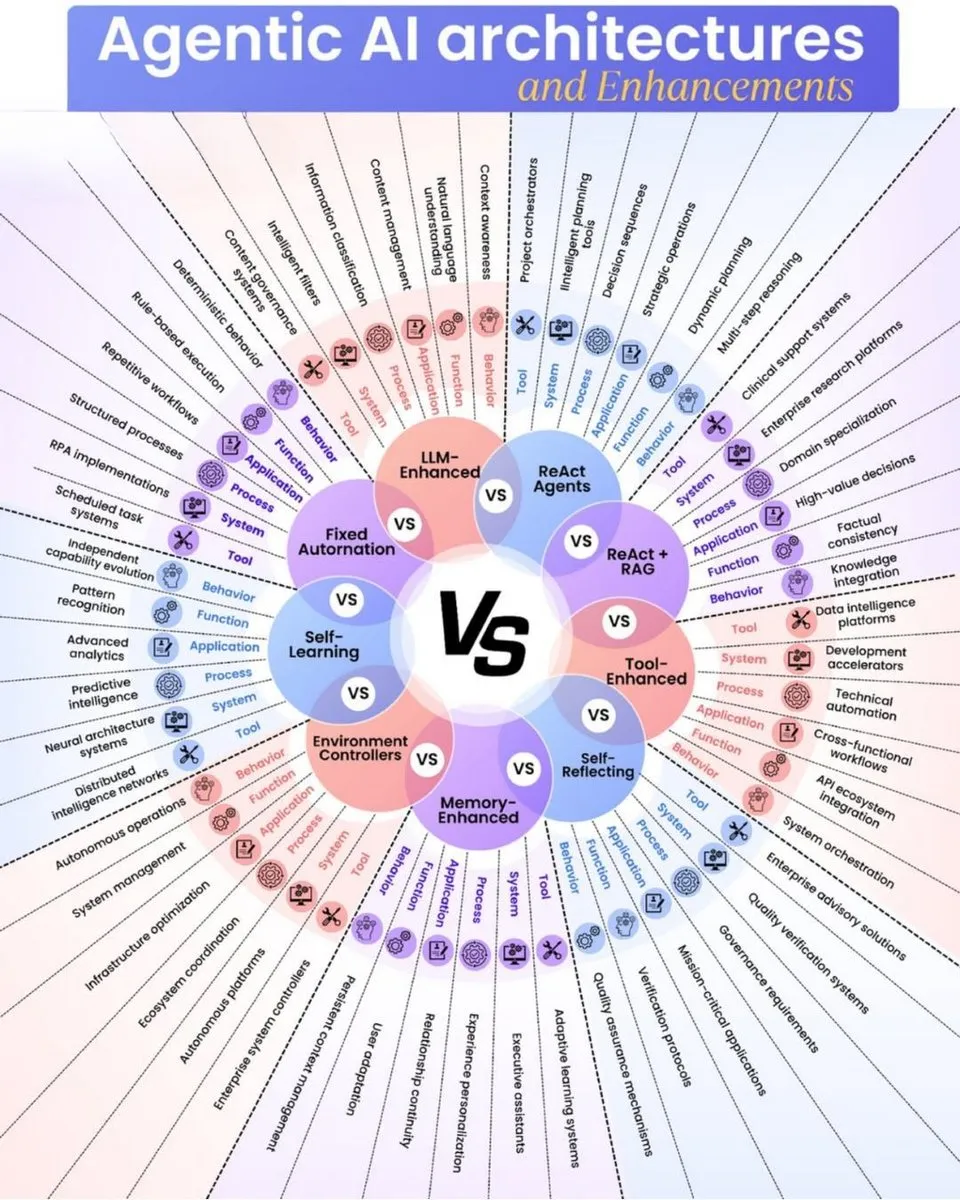

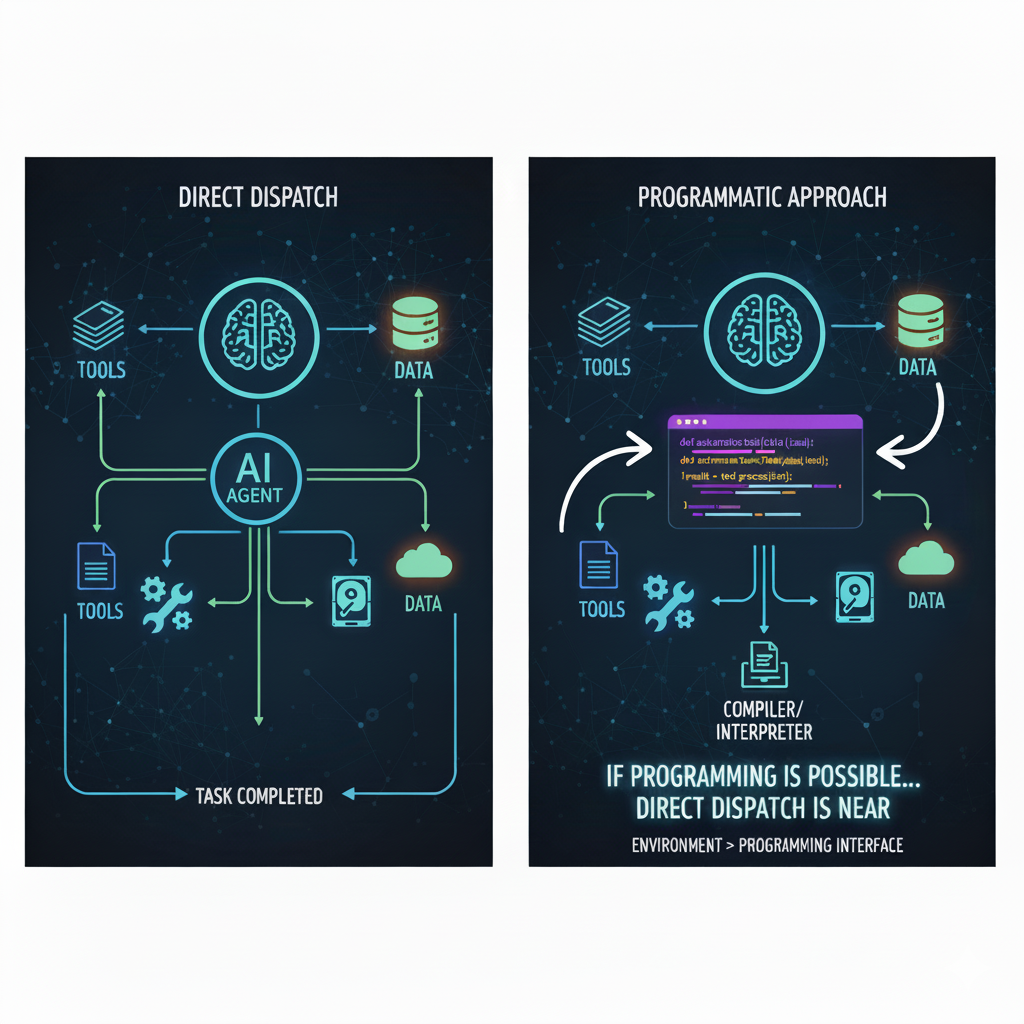

KI-Agenten: Paradigmenwechsel von Mensch-Maschine-Kollaboration zu „Mensch-Maschine-Delegation“ : Die KI-Branche erlebt einen „sanften Wendepunkt“ von der Mensch-Maschine-Kollaboration zur „Mensch-Maschine-Delegation“, wobei autonome KI-Agenten komplexe Aufgaben in großem Maßstab ausführen werden. Der Durchbruch von KI beim „Durchbrechen der Programmierung“ deutet darauf hin, dass sie alle semi-offenen Systeme bewältigen kann. Dieser Wandel wird zur Entstehung von „unbemannten Unternehmen“ führen, wobei die menschliche Rolle sich von der Mikroausführung zur Makrosteuerung verlagert, die sich auf die Vermittlung von Werten, Systemarchitekturdesign und Makronavigation konzentriert und durch KI Copilot bei der Entscheidungsfindung unterstützt wird, anstatt direkt in schnell laufende KI-Systeme einzugreifen. (Quelle: 36氪)

KI-Einfluss auf Fremdsprachenstudiengänge: Studierende müssen „Fremdsprache+“-Verbundfähigkeiten entwickeln : Der Aufstieg der KI-Übersetzungstechnologie beeinflusst Fremdsprachenstudiengänge tiefgreifend, was zu einem Rückgang der Nachfrage nach traditionellen Sprachberufen und der Einstellung entsprechender Studiengänge an mehreren Hochschulen führt. Fremdsprachenstudierende stehen unter Transformationsdruck und müssen von einzelnen Sprachkenntnissen zu einem „Fremdsprache+“-Verbundmodell wechseln, wie z.B. „Fremdsprache+KI“ für Natural Language Processing oder „Fremdsprache+internationale Kommunikation“. Dies treibt die Reform der Fremdsprachenausbildung voran, die interkulturelles Verständnis und umfassende Fähigkeiten betont, statt nur Übersetzungsübungen, um den neuen Anforderungen des KI-Zeitalters an Sprachtalente gerecht zu werden. (Quelle: 36氪, Reddit r/ClaudeAI)

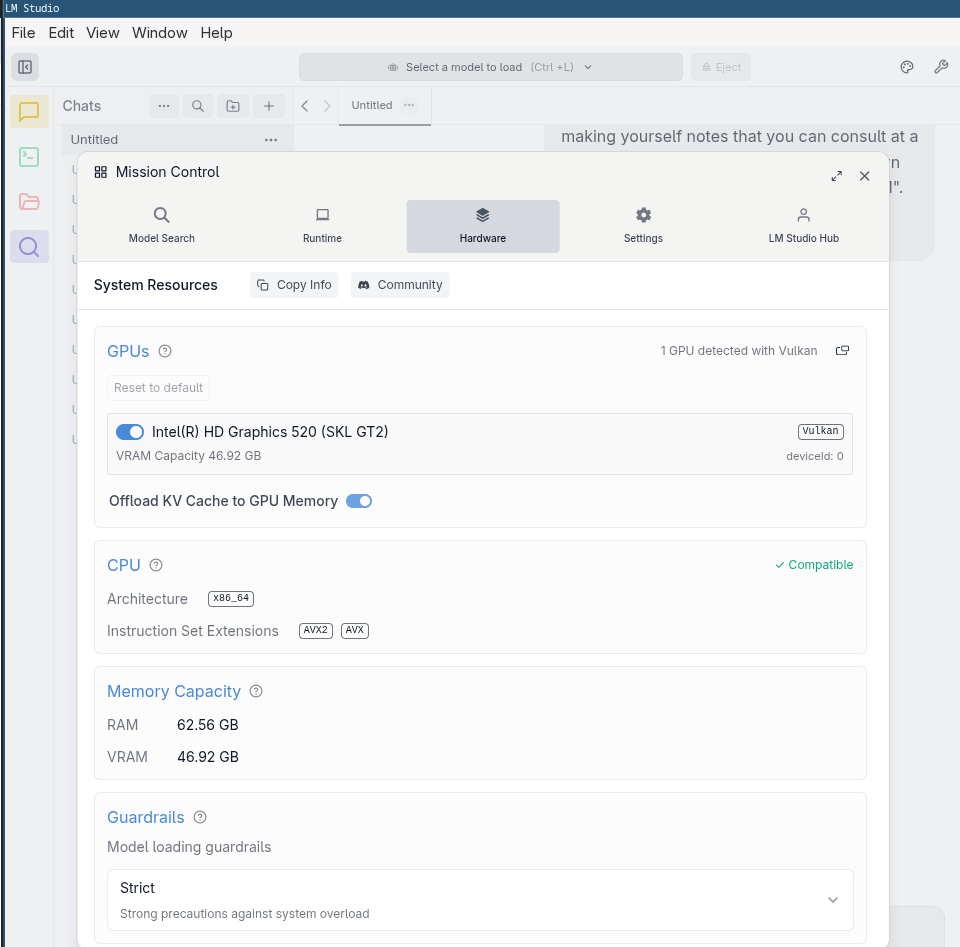

Hohe GPU-Preise: Getrieben durch KI-Nachfrage und lokale LLM-Optimierung : Die Community ist allgemein besorgt über die anhaltend hohen GPU-Preise, wobei die Hauptgründe die steigende Nachfrage von KI-Rechenzentren und die Inflation sind. Viele glauben, dass die Preise nicht wesentlich sinken werden, es sei denn, die KI-Blase platzt oder kundenspezifische Chips werden massenhaft eingesetzt. Um dieser Herausforderung zu begegnen, arbeitet die Community jedoch an der Optimierung der lokalen LLM-Leistung, wie z.B. die Tatsache, dass AMD MI50 in llama.cpp/ggml NVIDIA P40 übertrifft, und die Nutzung von iGPUs für grundlegende LLM-Aufgaben, um die lokalen KI-Berechnungskosten zu senken. (Quelle: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

💡 Sonstiges

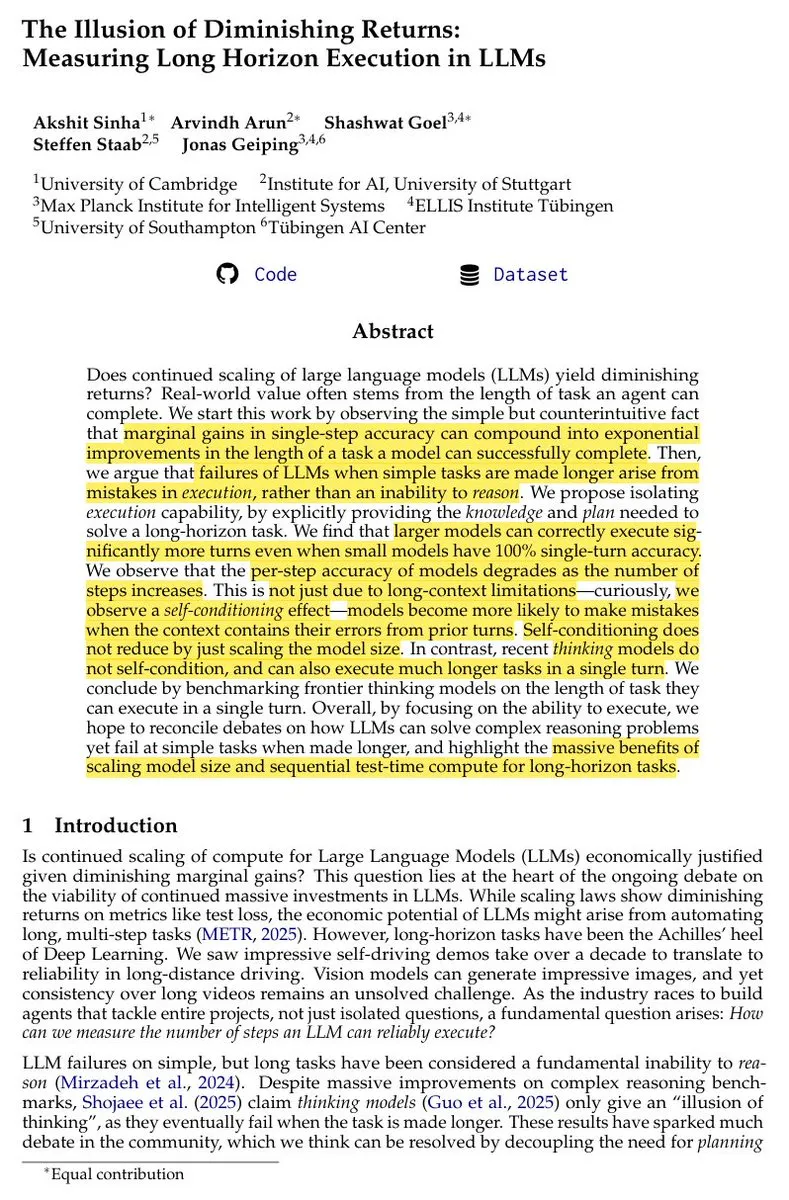

Die „Illusion abnehmender Erträge“ bei LLM-Skalierung und Langzeitaufgaben : Studien zeigen, dass, obwohl Einzelrunden-Benchmark-Tests eine Verlangsamung des LLM-Fortschritts zeigen mögen, die Modellskalierung bei der Ausführung von Langzeitaufgaben weiterhin zu nicht-abnehmenden Verbesserungen führt. Die „Illusion abnehmender Erträge“ resultiert aus geringfügigen Verbesserungen der Einzelschrittgenauigkeit, kann jedoch zu über-exponentiellen Verbesserungen bei der Erledigung von Langzeitaufgaben führen. Der Vorteil sequenzieller Berechnungen bei Langzeitaufgaben ist mit parallelen Tests nicht vergleichbar, was darauf hindeutet, dass kontinuierliche Modellskalierung und Reinforcement Learning Training entscheidend für die Realisierung fortgeschrittener Agenten-Verhaltensweisen sind. (Quelle: scaling01)

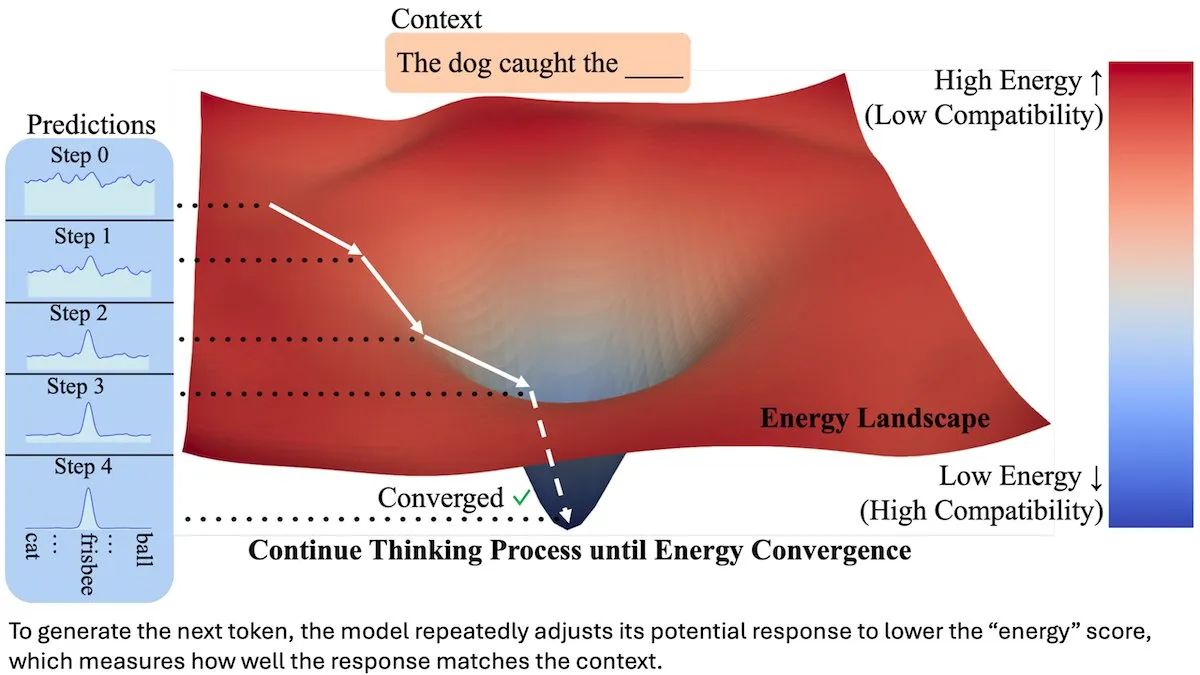

Energy-Based Transformer (EBT) verbessert die Leistung der nächsten Token-Vorhersage : Forscher haben den Energy-Based Transformer (EBT) vorgestellt, der potenzielle nächste Token mittels einer „Energie“-Punktzahl bewertet und iterativ die Energie durch Gradientenschritte zur Validierung und Auswahl reduziert. In Experimenten mit 44 Millionen Parametern übertraf EBT herkömmliche Transformer gleicher Größe in drei von vier Benchmarks, was darauf hindeutet, dass diese neuartige Token-Auswahlmethode die LLM-Leistung verbessern kann. (Quelle: DeepLearningAI)

KI-Roboter-Fortschritte: Humanoide Verkäufer und autonom laufende Roboterhunde ohne Training : Xpeng Motors hat den humanoiden Autoverkäufer „Tiedan“ in seinen Ausstellungsräumen eingesetzt, was die Anwendung von KI im Bereich kundenorientierter Roboter demonstriert. Darüber hinaus kann ein Roboterhund mit „tierischen Reflexen“ ohne Training durch Wälder laufen, was die Fortschritte in der autonomen Robotertechnologie bei der Nachahmung biologischer Bewegung und Wahrnehmung unterstreicht. Diese Entwicklungen deuten auf die zunehmende Komplexität und praktische Anwendungen von KI im Bereich physischer Roboter hin. (Quelle: Ronald_vanLoon, Ronald_vanLoon)