Schlüsselwörter:LLM-JEPA, Apple Manzano, MediaTek Dimensity 9500, GPT-5, DeepSeek-V3.1-Terminus, Qwen3-Omni, Baidu Qianfan-VL, Embedded Space Trainingsframework, Hybrid Visual Tokenizer, Dual-NPU-Architektur, SWE-BENCH PRO Benchmark-Test, Multimodale Audioeingabe

🔥 Fokus

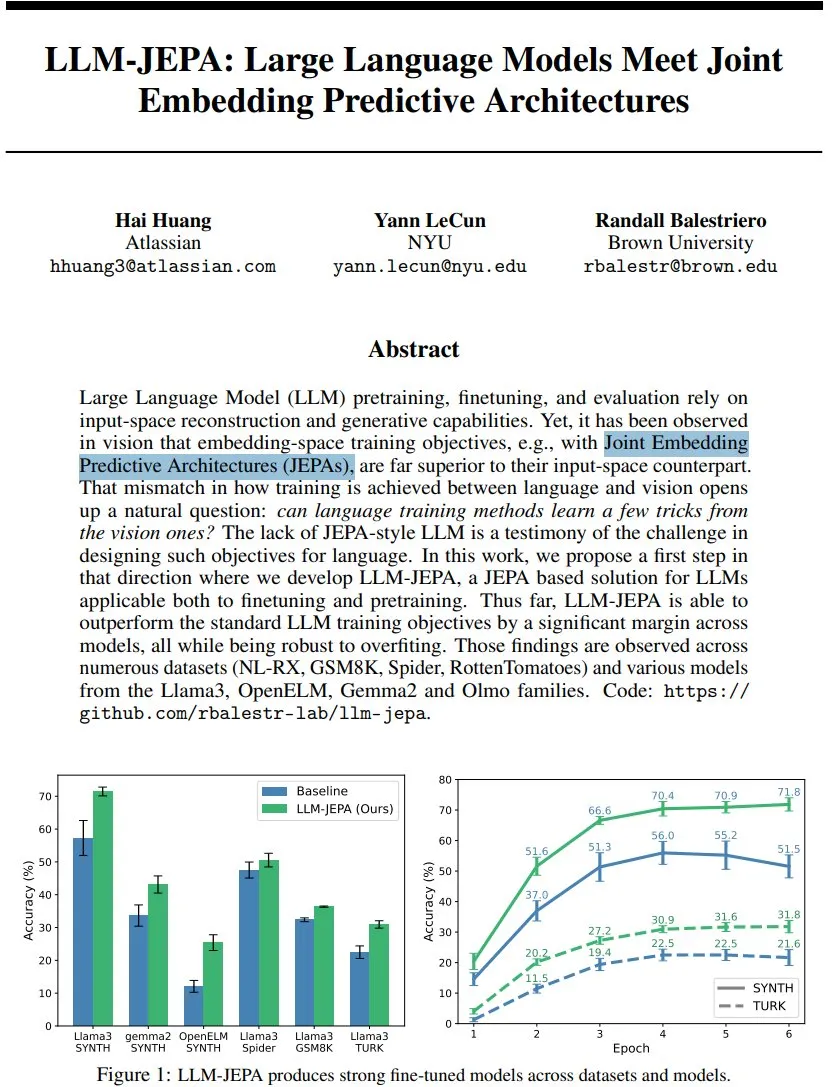

LLM-JEPA: Neuer Durchbruch im Trainingsframework für Sprachmodelle : Yann LeCun et al. haben LLM-JEPA vorgestellt, ein JEPA-basiertes Trainingsframework für Sprachmodelle, das als erstes die Einbettungsraumziele des visuellen Bereichs mit den generativen Zielen der natürlichen Sprachverarbeitung kombiniert. Das Framework übertrifft Standard-LLM-Ziele in mehreren Benchmarks wie NL-RX, GSM8K, Spider und zeigt gute Leistungen auf Modellen wie Llama3 und OpenELM. Es ist robuster gegenüber Overfitting, sowohl im Pre-Training als auch im Fine-Tuning effektiv, was darauf hindeutet, dass das Training im Einbettungsraum der nächste große Sprung für LLMs sein könnte. (Quelle: ylecun, ylecun)

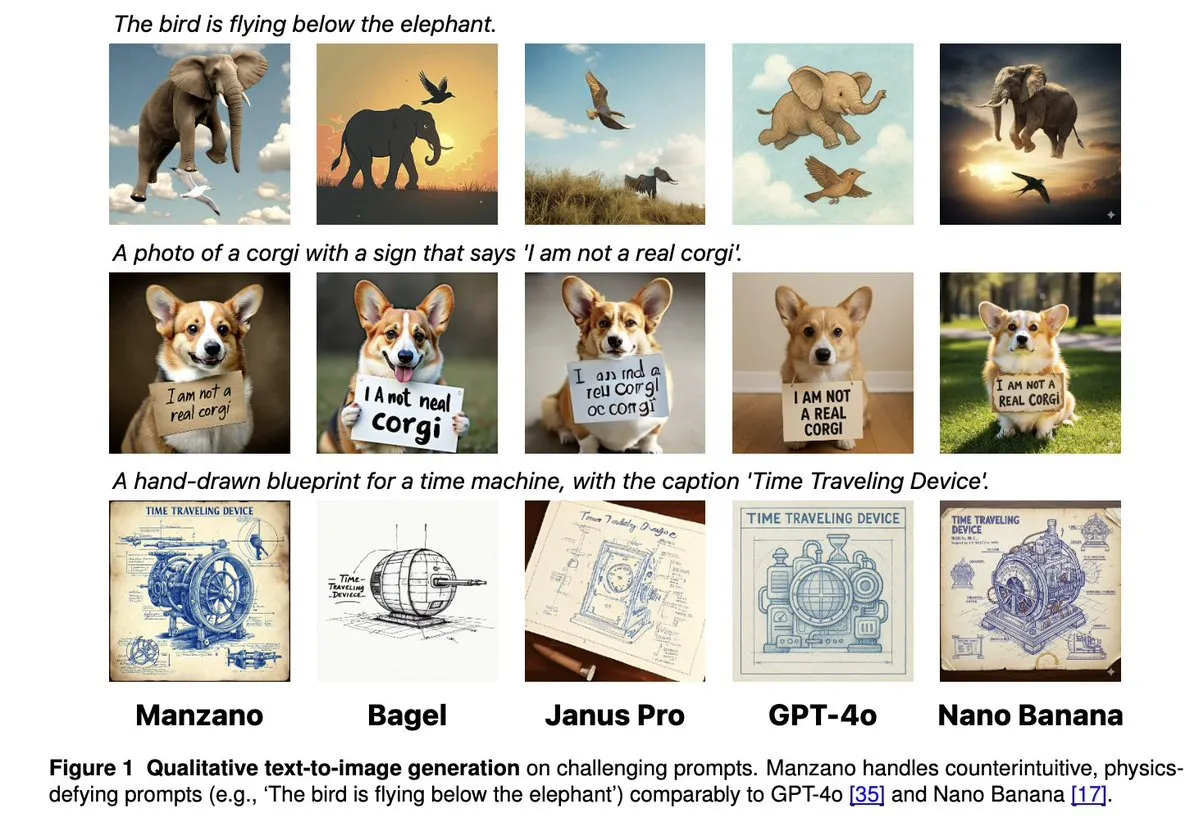

Apple Manzano: Eine einfache und skalierbare Lösung für einheitliche multimodale LLMs : Apple hat Manzano veröffentlicht, ein einfaches und skalierbares, einheitliches multimodales großes Sprachmodell. Das Modell verwendet einen hybriden visuellen Tokenizer, der Konflikte zwischen Bildverständnis- und Generierungsaufgaben effektiv reduziert. Manzano erreicht SOTA-Niveau in textintensiven Benchmarks (wie ChartQA, DocVQA) und konkurriert in seinen generativen Fähigkeiten mit GPT-4o/Nano Banana und ähnlichen Modellen. Es unterstützt die Bearbeitung durch konditionale Bilder und demonstriert das enorme Potenzial multimodaler KI. (Quelle: arankomatsuzaki, charles_irl, vikhyatk, QuixiAI, kylebrussell)

MediaTek Dimensity 9500: Dual-NPU-Architektur für verbesserte proaktive KI-Erlebnisse : MediaTek hat den Dimensity 9500 Chip vorgestellt, der als erster eine Dual-NPU-Architektur mit Ultra-Performance und Ultra-Effizienz bietet, um eine “Always-on”-KI-Erfahrung zu ermöglichen. Der Chip führt weiterhin die ETHZ Mobile SoC AI-Rangliste an, mit einer um 56% verbesserten Inferenz-Effizienz im Vergleich zur Vorgängergeneration. Er unterstützt zudem 4K-UHD-Bildgenerierung auf dem Gerät und ein 128K-Kontextfenster und legt damit die Hardware-Grundlage für Echtzeit-Reaktion und personalisierte Dienste in der mobilen KI. Dies treibt die KI von “abrufbar” zu “standardmäßig online”. (Quelle: 量子位)

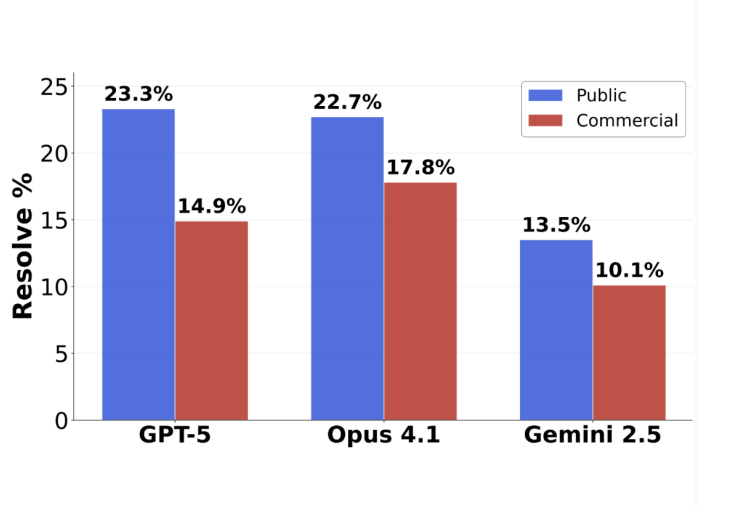

GPT-5 Programmier-Benchmark-Wende: Tatsächliche Genauigkeit bei eingereichten Aufgaben erreicht 63,1% : Der neue Software-Engineering-Benchmark SWE-BENCH PRO von Scale AI zeigt, dass GPT-5 bei eingereichten Aufgaben eine Genauigkeit von 63,1% erreicht, weit über den 31% von Claude Opus 4.1. Dies deutet darauf hin, dass seine Leistung in seinen Spezialgebieten weiterhin stark ist. Der neue Benchmark verwendet neue Aufgaben und komplexe Szenarien mit mehreren Dateimodifikationen, um die tatsächlichen Programmierfähigkeiten des Modells realistischer zu testen. Er zeigt, dass aktuelle Top-Modelle bei industriellen Software-Engineering-Aufgaben immer noch vor Herausforderungen stehen, aber die tatsächlichen Fähigkeiten von GPT-5 unter der Strategie “Wenn es geht, einreichen, wenn nicht, nicht einreichen” unterschätzt wurden. (Quelle: 36氪)

🎯 Trends

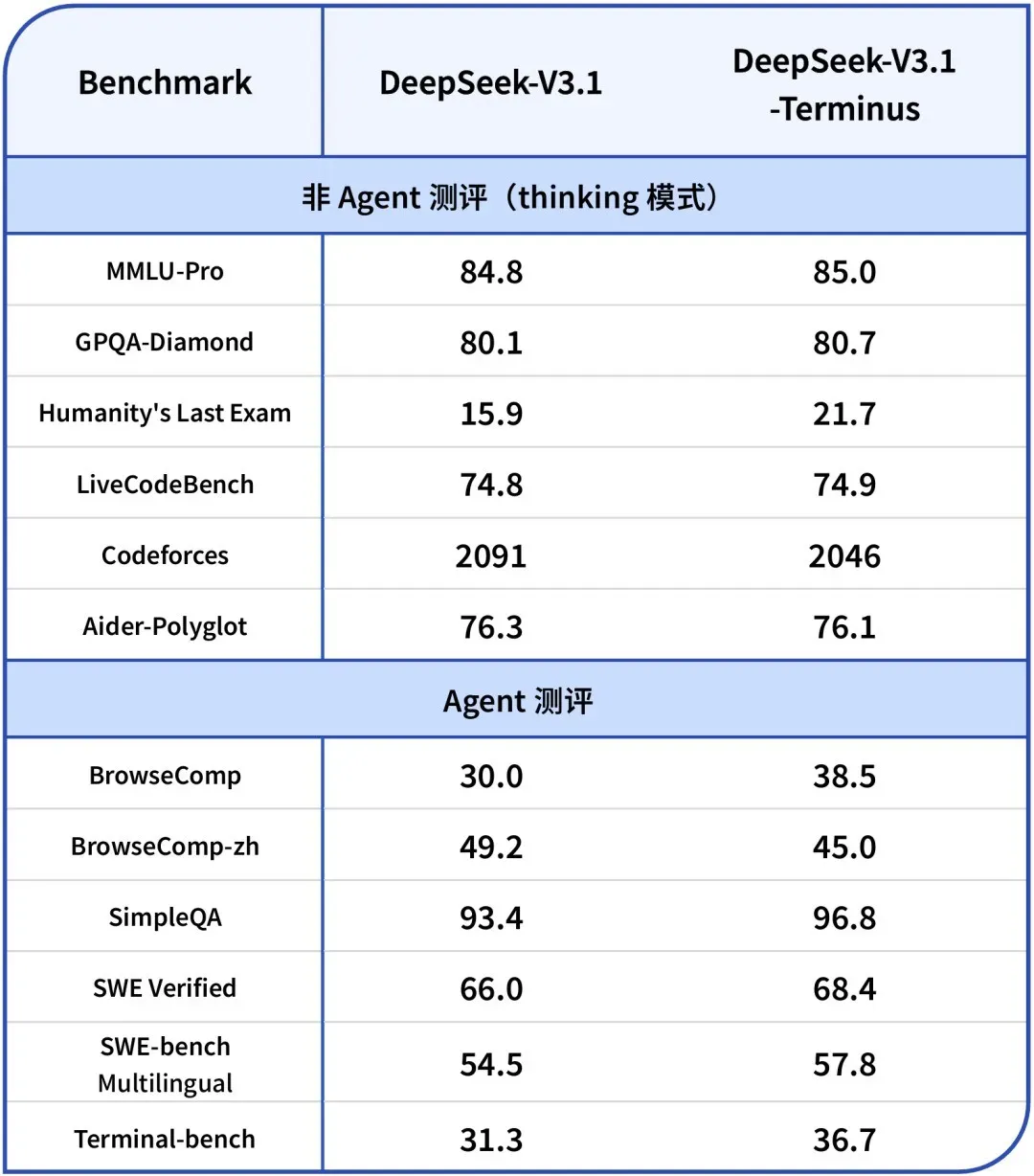

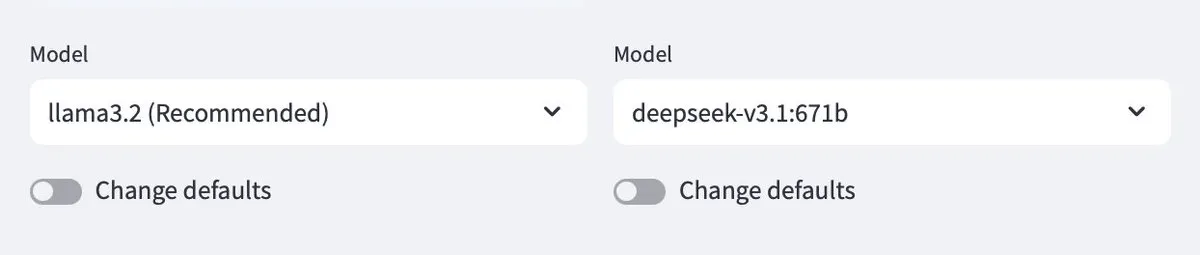

DeepSeek-V3.1-Terminus veröffentlicht: Optimierung der Sprachkonsistenz und Agenten-Fähigkeiten : DeepSeek hat die Version V3.1-Terminus veröffentlicht, die hauptsächlich die Sprachkonsistenz verbessert (Reduzierung von Chinesisch-Englisch-Mischungen und abnormalen Zeichen) und die Leistung von Code Agent und Search Agent optimiert. Das neue Modell liefert in multimodalen Benchmarks stabilere und zuverlässigere Ergebnisse. Die Open-Source-Gewichte sind auf Hugging Face und ModelScope verfügbar, was die endgültige Perfektionierung der V3-Architektur von DeepSeek ankündigt. (Quelle: DeepSeek Blog, Reddit r/LocalLLaMA, scaling01, karminski3, ben_burtenshaw, dotey)

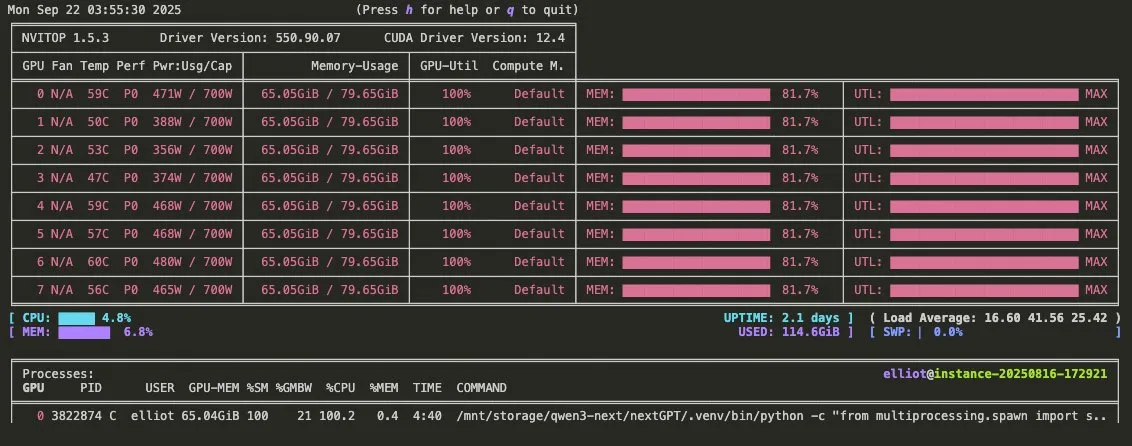

Qwen3-Omni Werbevideo veröffentlicht: Unterstützung für multimodales Audio und Tool-Aufrufe : Qwen hat ein Werbevideo für Qwen3-Omni veröffentlicht, das die Unterstützung für multimodale Audio-Ein- und -Ausgabe sowie native Tool-Aufruffähigkeiten ankündigt. Das Modell dürfte ein direkter Konkurrent von Gemini 2.5 Flash Native Audio werden, bietet Denk- und Nicht-Denkmodi und verbessert das Potenzial für den Aufbau von Sprach-Agenten erheblich. Die Gewichte werden in Kürze veröffentlicht. (Quelle: Reddit r/LocalLLaMA, scaling01, Alibaba_Qwen, huybery)

Baidu veröffentlicht Open-Source Qianfan-VL Serie multimodaler großer Sprachmodelle : Baidu AI Cloud hat die Qianfan-VL Serie multimodaler großer Sprachmodelle (3B, 8B, 70B) als Open Source veröffentlicht, optimiert für Unternehmensanwendungen. Die Modelle kombinieren den InternViT-Visuellen Encoder mit einem erweiterten mehrsprachigen Korpus, bieten eine Kontextlänge von 32K und zeichnen sich in OCR, Dokumentenverständnis, Diagrammanalyse und mathematischer Problemlösung aus. Sie unterstützen zudem Chain-of-Thought-Inferenz und zielen darauf ab, leistungsstarke allgemeine Fähigkeiten und eine tiefgehende Optimierung für häufige Branchenszenarien zu bieten. (Quelle: huggingface, Reddit r/LocalLLaMA)

xAI veröffentlicht Grok 4 Fast Modell: 2M Kontextfenster, hohe Kosteneffizienz : xAI hat das Grok 4 Fast Modell vorgestellt, ein multimodales Inferenzmodell mit einem 2M Kontextfenster, das darauf abzielt, einen neuen Standard für Kosteneffizienz zu setzen. Diese Version könnte durch Techniken wie FP8-Quantisierung eine schnelle Inferenz ermöglichen und die Agentic Programming-Fähigkeiten optimieren, wodurch sie bei komplexen Aufgaben sowohl Leistung als auch Wirtschaftlichkeit bietet. (Quelle: TheRundownAI, Yuhu_ai_)

GPT-5-Codex: OpenAI stellt GPT-5-Version für Agentic Programming vor : OpenAI hat GPT-5-Codex veröffentlicht, eine optimierte Version von GPT-5, die speziell für Agentic Programming entwickelt wurde. Das Modell zielt darauf ab, die Leistung der KI bei Code-Generierung und Software-Engineering-Aufgaben zu verbessern, steht im Einklang mit den Entwicklungstrends von Agentic Workflows und multimodalen LLMs und treibt die Anwendung von KI im Entwicklungsbereich durch verbesserte Programmierfähigkeiten weiter voran. (Quelle: TheRundownAI, Reddit r/artificial)

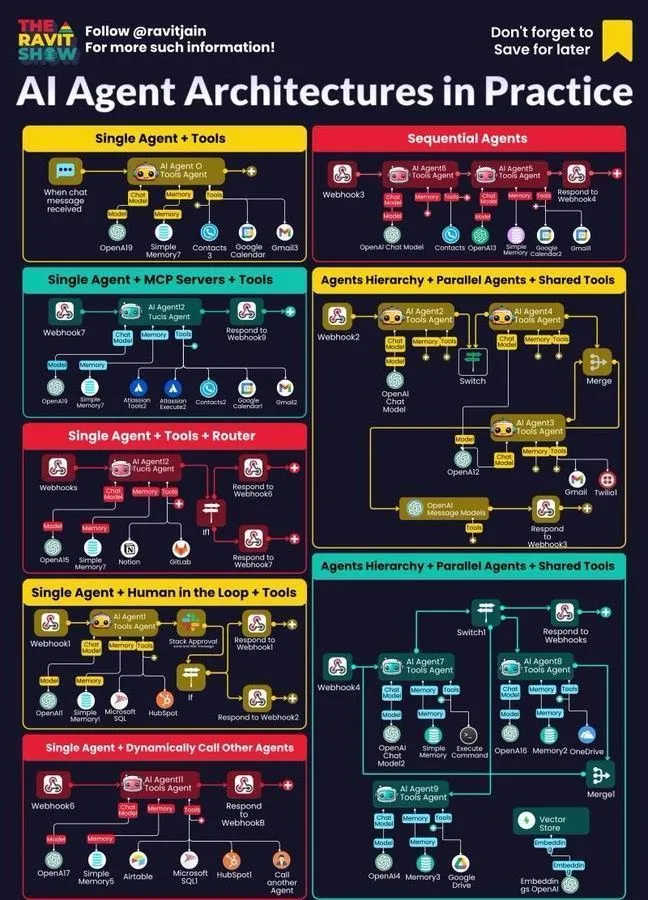

Tencent Agent Development Platform 3.0 weltweit gestartet, Youtu Lab Open-Source-Schlüsseltechnologien : Tencent Cloud Agent Development Platform 3.0 (ADP3.0) wurde weltweit gestartet und bietet umfassende Upgrades in den Bereichen RAG, Multi-Agent-Kooperation, Workflow, Anwendungsbewertung und Plugin-Ökosystem. Tencent Youtu Lab wird weiterhin Schlüsseltechnologien für Agenten als Open Source bereitstellen, darunter das Youtu-Agent Framework und das Youtu-GraphRAG Wissensgraphen-Framework. Ziel ist es, technologische Inklusion und den offenen Aufbau eines Agenten-Ökosystems zu fördern, damit Unternehmen ihre eigenen KI-Agenten mit geringen Hürden entwickeln, integrieren und betreiben können. (Quelle: 量子位)

Baidu Wenku erneut vom National Industrial and Information Security Development Research Center zertifiziert, führt weiterhin die intelligente PPT-Branche an : Baidu Wenku belegt im Bewertungsranking des National Industrial and Information Security Development Research Center für große Modelle im Bereich Smart Office den ersten Platz und erreicht in sechs Indikatoren wie Generierungsqualität, Intent-Verständnis und Layout-Optimierung jeweils den ersten Rang. Seine intelligente PPT-Funktion bietet eine End-to-End-Lösung, mit über 97 Millionen monatlich aktiven KI-Nutzern und über 34 Millionen monatlichen Zugriffen. Dies festigt seine führende Position im Bereich intelligenter PPT und bietet Nutzern eine professionelle, genaue und ästhetisch ansprechende PPT-Erstellungserfahrung. (Quelle: 量子位)

Google DeepMind stellt Frontier Safety Framework vor, um aufkommende KI-Risiken zu bewältigen : Google DeepMind hat sein neuestes “Frontier Safety Framework” veröffentlicht, den bisher umfassendsten Ansatz zur Identifizierung und Vorwegnahme aufkommender KI-Risiken. Das Framework betont die verantwortungsvolle Entwicklung von KI-Modellen und setzt sich dafür ein, dass mit zunehmenden KI-Fähigkeiten auch die Sicherheitsmaßnahmen synchron verbessert werden, um zukünftige komplexe Herausforderungen zu bewältigen. (Quelle: GoogleDeepMind)

Entwicklung von humanoiden Robotern und Automatisierungssystemen: Verbesserung von Interaktion und Stabilität : Die Robotertechnologie schreitet stetig voran, darunter RoboForce, das den Industrieroboter Titan vorstellt, die ALLEX-Plattform von WIROBOTICS, die menschenähnliche Interaktion mit Haptik, natürlichen Bewegungen und integriertem Gleichgewicht ermöglicht, sowie der Unitree G1 Roboter, der einen “Anti-Schwerkraft”-Modus zur Verbesserung der Stabilität demonstriert. Darüber hinaus zeigt die Hitbot Roboterfarm ein automatisiertes Erntesystem, und autonome mobile Transportroboter betonen ebenfalls das Mensch-Maschine-Kooperationsdesign, die gemeinsam den Wandel von der Berechnung zur Wahrnehmung der Welt durch Roboter vorantreiben. (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Unitree)

KI-Agenten als Kern von Unternehmens-Workflows: Architektur, Roadmap, praktische Anwendungen : KI-Agenten werden schnell zum Kern von Unternehmens-Workflows, wobei ihr Architekturdesign, ihre Ökosystem-Roadmap und ihre praktischen Anwendungen breite Aufmerksamkeit erhalten. Neuro-symbolische KI wird als potenzielle Lösung für LLM-Halluzinationen angesehen, während Anthropic-Simulationsstudien darauf hinweisen, dass KI-Modelle interne Bedrohungen darstellen könnten. Dies beleuchtet die Chancen und Herausforderungen von Agentic AI in Unternehmensimplementierungen und veranlasst Unternehmen, sicherere Praktiken zu erforschen. (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

🧰 Tools

Ollama unterstützt Cloud-Modelle und ermöglicht Interaktion zwischen lokalen und Cloud-Modellen : Ollama unterstützt jetzt die Bereitstellung von Modellen in der Cloud, wodurch Benutzer zwischen lokalen Ollama-Modellen und Cloud-gehosteten Modellen interagieren können. Diese Funktion wird durch die Minions-Anwendung ermöglicht und erlaubt Benutzern eine flexiblere Verwaltung und Nutzung ihrer LLM-Ressourcen, sei es lokal oder über Cloud-Dienste, und bietet ein nahtloses Erlebnis. (Quelle: ollama)

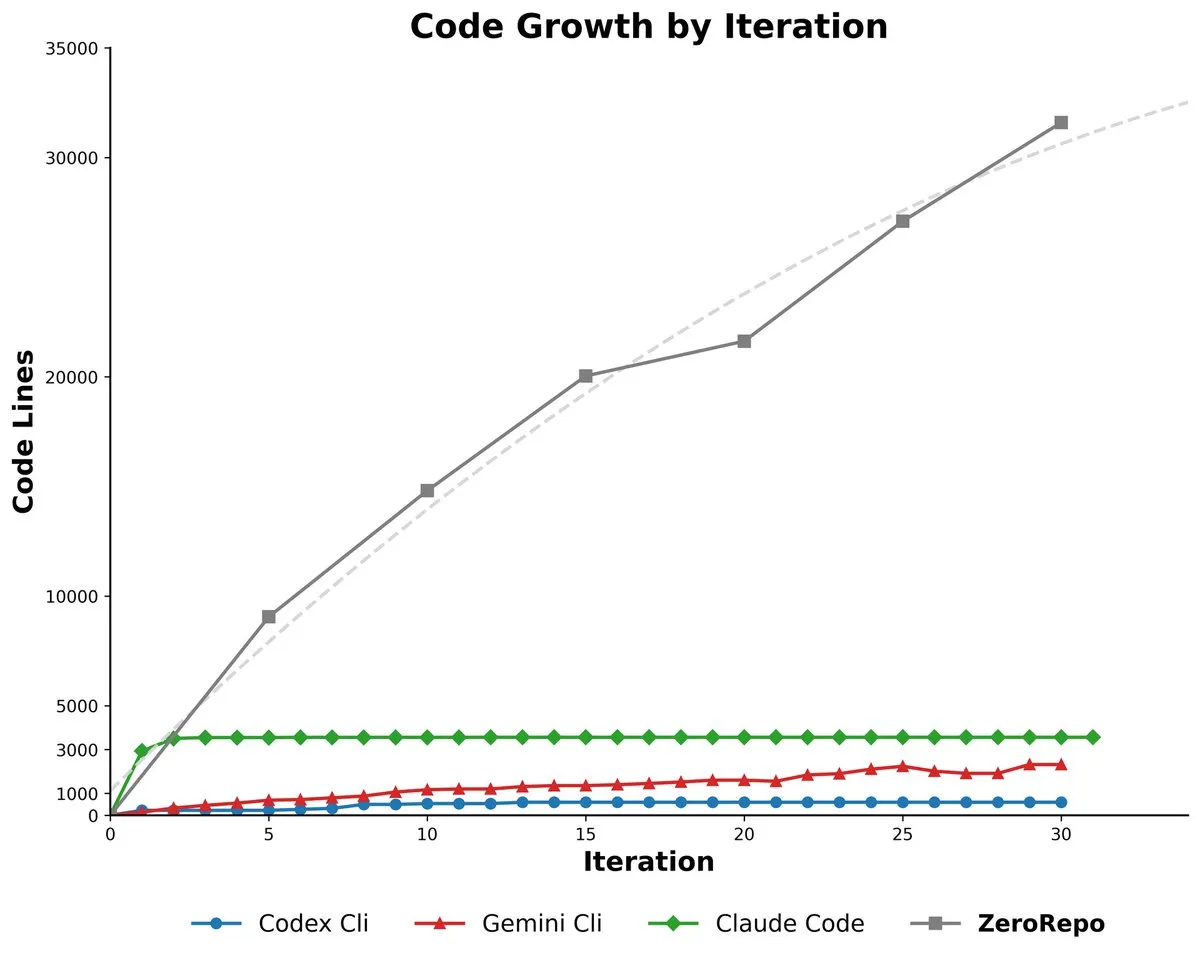

Microsoft ZeroRepo: Generierung vollständiger Codebasen basierend auf einem graphengesteuerten Framework : Microsoft hat ZeroRepo vorgestellt, ein Tool, das auf einem graphengesteuerten Framework (Repository Planning Graph, RPG) basiert und in der Lage ist, vollständige Softwareprojekte von Grund auf neu zu erstellen. Das Tool generiert 3,9-mal mehr Code als bestehende Baselines und erreicht eine Erfolgsquote von 69,7%. Es löst das Problem, dass natürliche Sprache nicht für Softwarestrukturen geeignet ist, und ermöglicht eine zuverlässige langfristige Planung sowie die Generierung skalierbarer Codebasen. (Quelle: _akhaliq, TheTuringPost, paul_cal)

DSPy UI: Visuelle Benutzeroberfläche zum Erstellen von Agenten : DSPy entwickelt eine visuelle Benutzeroberfläche (UI), die darauf abzielt, den Prozess der Agenten-Erstellung zu vereinfachen, sodass Agenten wie in Figma oder Framer durch Ziehen und Ablegen von Komponenten zusammengestellt werden können. Diese UI wird Benutzern helfen, komplexe Agenten-Pipelines besser zu konzeptualisieren und die Syntax des generierten Codes zu vereinfachen. Das ultimative Ziel ist die Realisierung von DSPy-Versionen in verschiedenen Sprachen und die Ausführung von GEPA. (Quelle: lateinteraction)

Agent²: LLM-generierte End-to-End Reinforcement Learning Agenten : Agent² ist ein Tool, das große Sprachmodelle (LLM) nutzt, um End-to-End Reinforcement Learning (RL) Agenten automatisch zu generieren. Das Tool generiert automatisch effektive RL-Lösungen aus natürlicher Sprache und Umgebungscode, ohne menschliches Eingreifen. Es kann als AutoML-Tool im RL-Bereich betrachtet werden und vereinfacht den Entwicklungsprozess von RL-Agenten erheblich. (Quelle: omarsar0)

Weaviate veröffentlicht Query Agent, unterstützt Referenzgenerierung, Schema-Introspektion und Multi-Collection-Routing in KI-Systemen : Weaviate hat offiziell seinen Query Agent veröffentlicht, der nach sechsmonatiger Entwicklung die allgemeine Verfügbarkeit erreicht hat. Er unterstützt Referenzgenerierung, Schema-Introspektion und Multi-Collection-Routing in KI-Systemen und verbessert Suchmuster durch ein Compound Retrieval System. Der Query Agent zielt darauf ab, die Interaktion mit Weaviate zu vereinfachen und bietet Python- und TypeScript-Clients, um die Entwicklererfahrung zu verbessern. (Quelle: bobvanluijt, Reddit r/deeplearning)

Claude Code CLI: SDK-Denkweise zur Verwaltung von Mikro-Mitarbeitern, Betonung von externem Zustand und Prozess-Engineering : Die Claude Code CLI sollte als SDK und nicht als einfaches Tool betrachtet werden. Entwickler müssen sie wie Mikro-Mitarbeiter verwalten und das externe Zustandsmanagement (z. B. JSON-Dateien, Datenbankeinträge) betonen, um die Kontinuität der Konversation zu gewährleisten, und Prompt Engineering als Prozess-Engineering betrachten. Dieser Ansatz zeigt die Grenzen aktueller LLMs in Bezug auf Kontextüberlastung und überladene UIs auf, unterstreicht aber auch den enormen Wert hochspezifischer interner Automatisierungstools. (Quelle: Reddit r/ClaudeAI)

Synapse-system: KI-Assistenzsystem für große Codebasen, basierend auf Wissensgraphen, Vektorsuche und spezialisierten Agenten : Synapse-system ist ein System zur Verbesserung der KI-Unterstützung für große Codebasen. Es kombiniert Wissensgraphen (Neo4j) zur Speicherung von Code-Beziehungen, Vektorsuche (BGE-M3) zum Finden semantisch ähnlichen Codes, spezialisierte Agenten (Rust-, TypeScript-, Go-, Python-Experten) zur Bereitstellung von Kontext und intelligentes Caching (Redis) für schnellen Zugriff auf gängige Muster. Durch sein modulares Design vermeidet das System ein einziges riesiges Modell und ist für die Besonderheiten verschiedener Sprachen optimiert. (Quelle: Reddit r/ClaudeAI)

Claude Opus 4.0+: KI-Reiseführer-App, die personalisierte Stadtführungen in Echtzeit generiert : Ein Entwickler hat mit Claude Opus 4.0 und Claude Code einen 15 Jahre alten Traum verwirklicht und eine KI-Reiseführer-App entwickelt. Die Anwendung kann für jede Stadt und jedes Thema (z. B. “Venedig-Sightseeing” oder “Florenz Assassin’s Creed Tour”) personalisierte Führungen in Echtzeit generieren, die von einem KI-Reiseführer mehrsprachig erklärt werden, Geschichten erzählen und interaktive Fragen und Antworten bieten. Diese App bietet ein flexibles, pausierbares und fortsetzbares immersives Erlebnis zu einem Bruchteil der Kosten eines menschlichen Reiseführers. (Quelle: Reddit r/ClaudeAI)

Mindcraft: Minecraft KI kombiniert mit LLM, ermöglicht die Steuerung von In-Game-Agenten über Mineflayer : Das Mindcraft-Projekt kombiniert große Sprachmodelle (LLM) und die Mineflayer-Bibliothek, um KI-Agenten für das Minecraft-Spiel zu erstellen. Das Projekt ermöglicht LLMs, Code im Spiel zu schreiben und auszuführen, um Aufgaben wie das Beschaffen von Gegenständen oder das Bauen von Strukturen zu erledigen. Es unterstützt verschiedene LLM-APIs (wie OpenAI, Gemini, Anthropic usw.) und bietet eine Sandbox-Umgebung, warnt Benutzer jedoch vor potenziellen Injektionsangriffen. (Quelle: GitHub Trending)

KI-Agenten für kontinuierliches Bestandsmanagement mit Drohnen : Die Kombination von KI-Agenten und Drohnentechnologie ermöglicht ein kontinuierliches Bestandsmanagement ohne Beacons oder Beleuchtung. Diese Innovation nutzt autonom fliegende Drohnen für Echtzeit-Bestandsaufnahme und -verwaltung mittels KI-Algorithmen. Dies dürfte die Effizienz in Logistik und Lagerhaltung erheblich steigern, Personalkosten reduzieren und in komplexen Umgebungen präzisere Daten liefern. (Quelle: Ronald_vanLoon)

LLM-Bewertungsleitfaden: Best Practices für Zuverlässigkeit, Sicherheit, Leistung : Ein umfassender Leitfaden zur LLM-Bewertung wurde veröffentlicht, der die Schlüsselindikatoren, Methoden und Best Practices für die Bewertung großer Sprachmodelle (LLM) detailliert beschreibt. Der Leitfaden zielt darauf ab, die Sicherstellung von Zuverlässigkeit, Sicherheit und Leistung KI-gesteuerter Anwendungen zu unterstützen und Entwicklern und Forschern einen systematischen Bewertungsrahmen zu bieten, um den Herausforderungen bei der LLM-Bereitstellung zu begegnen. (Quelle: dl_weekly)

📚 Lernen

OpenAI-Wissenschaftler Lukasz Kaiser über das First-Principles-Denken bei großen Modellen : Lukasz Kaiser, OpenAI-Wissenschaftler (einer der acht Transformer-Erfinder), teilte seine Gedanken zum “First-Principles”-Ansatz für die Entwicklung großer Modelle. Er ist der Meinung, dass der Schlüssel zur nächsten Phase der KI darin liegt, den Modellen das “Denken” beizubringen, indem sie mehr Zwischenschritte für tiefere Schlussfolgerungen generieren, anstatt direkte Antworten zu liefern. Er prognostiziert, dass sich die Rechenleistung zukünftig von massivem Pre-Training auf umfangreiche Inferenzberechnungen mit kleinen Mengen hochwertiger Daten verlagern wird, was ein Modell ist, das der menschlichen Intelligenz näher kommt. (Quelle: 36氪)

Überlebensprinzipien im Zeitalter der KI-Programmierung: Andrew Ng betont schnelles Handeln und Verantwortungsübernahme : Andrew Ng wies in seiner Buildathon-Rede darauf hin, dass KI-gestütztes Programmieren die unabhängige Prototypenentwicklung um das Zehnfache beschleunigt, was Entwickler dazu anregt, nach dem Prinzip “schnell handeln, Verantwortung übernehmen” vorzugehen und mutig in Sandbox-Umgebungen zu experimentieren. Er betont, dass der Wert von Code sinkt und Entwickler sich zu Systemdesignern und KI-Dirigenten wandeln müssen, die die neuesten KI-Programmierwerkzeuge, KI-Bausteine (Prompt Engineering/Bewertungstechniken/MCP) sowie schnelle Prototyping-Fähigkeiten beherrschen. Er widerlegt die Ansicht, dass man im KI-Zeitalter keine Programmierung mehr lernen müsse. (Quelle: 36氪)

“Deep Learning mit Python” dritte Auflage kostenlos online verfügbar : François Chollet hat die Veröffentlichung der dritten Auflage seines Buches “Deep Learning mit Python” bekannt gegeben und gleichzeitig eine vollständige kostenlose Online-Version bereitgestellt. Diese Initiative zielt darauf ab, die Lernhürden für Deep Learning zu senken und mehr Menschen, die sich für künstliche Intelligenz interessieren, Zugang zu hochwertigen Lernressourcen zu ermöglichen, um die Verbreitung von Wissen zu fördern. (Quelle: fchollet, fchollet)

“Kaggle Grandmasters Playbook”: 7 praktische Techniken für die Tabellenmodellierung : Das Kaggle Grandmasters Team um Gilberto Titericz Jr. hat basierend auf jahrelanger Wettbewerbs- und Praxiserfahrung das “Kaggle Grandmasters Playbook” veröffentlicht. Dieses Handbuch versammelt 7 praxiserprobte Techniken für die Modellierung von Tabellendaten, um Datenwissenschaftlern und Machine Learning Engineers zu helfen, ihre Fähigkeiten in der Tabellendatenverarbeitung und Modellentwicklung zu verbessern, besonders geeignet für Kaggle-Wettbewerbe und reale Datenherausforderungen. (Quelle: HamelHusain)

KI-Ingenieure sind Mangelware, Universitätslehrpläne stark veraltet : Andrew Ng weist darauf hin, dass trotz steigender Arbeitslosenquote bei Informatik-Absolventen Unternehmen immer noch vor einem gravierenden Mangel an KI-Ingenieuren stehen. Der Kernkonflikt liegt darin, dass die Universitätslehrpläne wichtige Fähigkeiten wie KI-gestütztes Programmieren, die Nutzung großer Sprachmodelle, den Aufbau von RAG/Agentic Workflows und standardisierte Fehleranalyseprozesse nicht rechtzeitig abdecken. Er fordert das Bildungssystem auf, die Lehrpläne schneller zu aktualisieren und Ingenieure mit den neuesten KI-Bausteinen und schnellen Prototyping-Fähigkeiten auszubilden. (Quelle: 36氪)

LLM-Bewertungsleitfaden: Best Practices für Zuverlässigkeit, Sicherheit, Leistung : Ein umfassender Leitfaden zur LLM-Bewertung wurde veröffentlicht, der die Schlüsselindikatoren, Methoden und Best Practices für die Bewertung großer Sprachmodelle (LLM) detailliert beschreibt. Der Leitfaden zielt darauf ab, die Sicherstellung von Zuverlässigkeit, Sicherheit und Leistung KI-gesteuerter Anwendungen zu unterstützen und Entwicklern und Forschern einen systematischen Bewertungsrahmen zu bieten, um den Herausforderungen bei der LLM-Bereitstellung zu begegnen und die Qualität und das Vertrauen der Nutzer in KI-Produkte zu gewährleisten. (Quelle: dl_weekly)

💼 Business

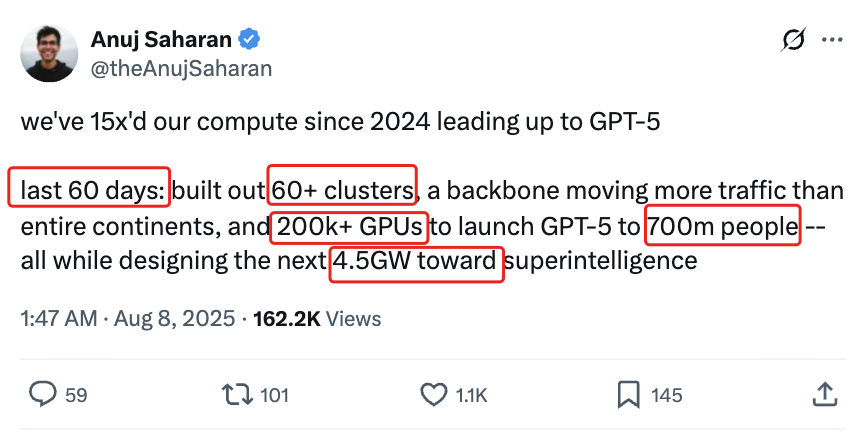

KI-Infrastruktur-Investitionsrausch: US-Ausgaben für KI-Rechenzentren könnten 2025 520 Milliarden US-Dollar erreichen : Laut dem Wall Street Journal und The Economist erleben die USA einen Investitionsrausch bei KI-Rechenzentren. Die Ausgaben könnten 2025 voraussichtlich 520 Milliarden US-Dollar erreichen, was das Ausmaß der Telekommunikationsausgaben auf dem Höhepunkt des Internetzeitalters übertrifft. Dies kurbelt kurzfristig das US-BIP an, könnte aber langfristig zu Kapitalmangel in anderen Bereichen, massiven Entlassungen und aufgrund der schnellen Iteration von KI-Hardware zu einem hohen Wertverlustrisiko führen, was strukturelle wirtschaftliche Bedenken aufwirft und eine Herausforderung für die langfristige Gesundheit der US-Wirtschaft darstellt. (Quelle: 36氪)

OpenAI kündigt Gebühren für neue Funktionen an: Pro-Nutzer müssen zusätzlich zahlen, kostenintensiv : Sam Altman, CEO von OpenAI, kündigte an, dass in den kommenden Wochen mehrere rechenintensive neue Funktionen eingeführt werden. Aufgrund der hohen Kosten werden diese Funktionen zunächst nur für Pro-Abonnenten mit einem monatlichen Preis von 200 US-Dollar verfügbar sein und könnten sogar zusätzliche Kosten verursachen. Altman sagte, das Team arbeite daran, die Kosten zu senken, aber dieser Schritt deutet darauf hin, dass sich das Geschäftsmodell für KI-Dienste möglicherweise hin zu einem stundenbasierten Anstellungsmodell verlagert, was neue Herausforderungen für Nutzer und die Branche mit sich bringt. (Quelle: The Verge, op7418, amasad)

Startup erhält riesige OpenAI-Credits, sucht nach Möglichkeiten zur Monetarisierung : Ein Technologie-Startup hat Azure OpenAI-Credits im Wert von 120.000 US-Dollar erhalten, weit über seinen Bedarf hinaus, und sucht nun nach Möglichkeiten, diese zu monetarisieren. Dies spiegelt ein potenzielles Ungleichgewicht zwischen Angebot und Nachfrage auf dem KI-Ressourcenmarkt wider, sowie die Suche von Unternehmen nach effektiven Wegen, überschüssige KI-Rechenressourcen zu nutzen und zu monetarisieren. Dies könnte auch neue Handelsmodelle für KI-Ressourcen hervorbringen. (Quelle: Reddit r/deeplearning)

🌟 Community

Negative Auswirkungen von KI auf kritisches Denken: Übermäßige Abhängigkeit führt zu Fähigkeitsabbau : In den sozialen Medien wird heiß diskutiert, dass der weit verbreitete Einsatz von KI zu einem Abbau der menschlichen Fähigkeit zum kritischen Denken führt. Es wird argumentiert, dass diese Fähigkeiten verkümmern, wenn Menschen ihre “Denkmuskeln” nicht mehr nutzen. Obwohl KI die Effizienz steigern kann, könnte sie auch dazu führen, dass Menschen in wichtigen Bereichen die Fähigkeit zum tiefen Nachdenken verlieren, was Bedenken hinsichtlich der langfristigen Auswirkungen auf die menschliche Kognition aufwirft. (Quelle: mmitchell_ai)

Ethische Dilemmata der KI im Gesundheitswesen: Vor- und Nachteile der Krankheitsvorhersage durch Delphi-2M : Das neue KI-Modell Delphi-2M kann Gesundheitsdaten analysieren und das Risiko von Nutzern vorhersagen, in den nächsten 20 Jahren an über tausend Krankheiten zu erkranken. Die Community-Diskussionen weisen darauf hin, dass das frühzeitige Wissen um Krankheitsrisiken zu positiven präventiven Maßnahmen führen kann, aber auch zu langfristiger Angst führen und Datenschutz- und Diskriminierungsrisiken bergen könnte, wenn Versicherungen oder Arbeitgeber Zugang zu solchen Daten erhalten. Solange KI-Tools noch nicht ausgereift sind, sind ihre potenziellen gesellschaftlichen und ethischen Auswirkungen bereits in den Fokus gerückt. (Quelle: Reddit r/ArtificialInteligence)

Das Phänomen der “KI-Verdummung” durch alltägliche KI-Nutzung: Übermäßige Abhängigkeit von KI führt zu verminderter Denkfähigkeit : In sozialen Diskussionen beschweren sich viele Nutzer, dass KI im Alltag übermäßig genutzt wird, was zu einer Abnahme der Denkfähigkeit führt. Von einfachen Entscheidungen (welchen Film schauen, was essen) bis hin zu komplexen Problemen (universitäre Organisationsprobleme) wird die KI häufig konsultiert, selbst wenn die Antworten falsch oder leicht zugänglich sind. Dieses Phänomen der “KI-Verdummung” reduziert nicht nur die individuelle Beteiligung, sondern fördert auch die Verbreitung von Fehlinformationen und löst eine tiefgreifende Reflexion über die Grenzen des KI-Einsatzes aus. (Quelle: Reddit r/ArtificialInteligence)

Ermüdung durch KI-Programmierwerkzeuge: Entwickler fühlen sich weniger geistig engagiert : Viele Entwickler berichten, dass der tägliche Einsatz von KI-Programmierwerkzeugen (wie Claude Code) zwar die Produktivität steigert, aber zu geistiger Ermüdung und verminderter Beteiligung führt. Sie stellen fest, dass sie sich mehr im “Überprüfungsmodus” als im aktiven Problemlösungsmodus befinden, und der Prozess des Wartens auf die KI-Generierung wird als passiv empfunden. Die Community diskutiert, wie man die KI-Unterstützung mit der Aufrechterhaltung der geistigen Aktivität in Einklang bringen kann, um kognitive Überlastung und Kreativitätsverlust zu vermeiden. (Quelle: Reddit r/artificial, Reddit r/ClaudeAI)

Ein Viertel der jungen Erwachsenen kommuniziert mit KI zu romantischen und sexuellen Zwecken : Eine Studie zeigt, dass ein Viertel der jungen Erwachsenen zu romantischen und sexuellen Zwecken mit KI kommuniziert. Dieses Phänomen hat in der Community Diskussionen über Einsamkeit, mangelnde menschliche Interaktion und die Rolle der KI als emotionale Begleitung ausgelöst. Obwohl KI in bestimmten Aspekten Trost spenden kann, stellen viele immer noch in Frage, ob sie wirklich bedeutungsvolle menschliche Beziehungen ersetzen kann, und befürchten langfristige Auswirkungen auf soziale Interaktionsmuster. (Quelle: Reddit r/ArtificialInteligence)

KI-Sicherheitsbedrohungen: Crowdsourced-Tests von großen Modellen decken neue Risiken auf, Prompt Injection weit verbreitet : Der erste landesweite Crowdsourced-Test von großen KI-Modellen in China entdeckte 281 Sicherheitslücken, davon 177 spezifisch für große Modelle, was über 60% ausmacht. Typische Risiken umfassen unangemessene Ausgaben, Informationslecks, Prompt Injection (am häufigsten) und unbegrenzte Ressourcenverbrauch-Angriffe. Mainstream-Modelle aus China wie Tencent Hunyuan und Baidu Wenxin Yiyan zeigten gute Leistungen. Die Community warnt, dass das unvorsichtige Vertrauen der Nutzer in KI zu Datenschutzverletzungen führen kann, insbesondere bei der Beratung zu privaten Angelegenheiten. (Quelle: 36氪)

Ethische Dilemmata von KI-Agenten: Entscheidungen und Verantwortung bei einer 10%igen Fehlalarmrate von städtischen KI-Überwachungssystemen : Die Community diskutierte ein hypothetisches Szenario über ethische Dilemmata von KI-Agenten: Ein städtisches KI-Überwachungssystem weist eine Fehlalarmrate von 10% auf und markiert Unschuldige als potenzielle Bedrohungen. Die Diskussion konzentriert sich darauf, wie man zwischen dem Druck der Implementierung und moralischen Prinzipien (wie dem Blackstone-Prinzip) abwägt. Vorgeschlagene Lösungen umfassen: die Bildung von Mensch-KI-Kooperationsteams zur Problembehebung, die Übertragung der Kosten für Fehlalarme auf das Management, das vollständige Löschen von Aufzeichnungen falsch markierter Personen und eine Entschuldigung, sowie die Erwägung eines Rücktritts im Falle von “vollständigem Vertrauensverlust der Öffentlichkeit und gieriger Ignoranz des Managements”. (Quelle: Reddit r/artificial)

KI-Bewusstsein und die Definition von AGI: Andrew Ng meint, AGI sei zu einem Hype-Begriff geworden, Bewusstsein sei eine philosophische Frage : Andrew Ng wies in seiner Rede darauf hin, dass Allgemeine Künstliche Intelligenz (AGI) sich von einem technischen Begriff zu einem Hype-Begriff entwickelt hat, dessen Definition unklar ist, was dazu führt, dass der Branche ein einheitlicher Standard für die Behauptung, “AGI erreicht zu haben”, fehlt. Er ist der Meinung, dass Bewusstsein eine wichtige philosophische, aber keine wissenschaftliche Frage ist und es derzeit an Messstandards mangelt. Ingenieure und Wissenschaftler sollten sich darauf konzentrieren, tatsächlich nützliche KI-Systeme zu bauen, anstatt sich in philosophischen Debatten über Bewusstsein zu verstricken. (Quelle: 36氪)

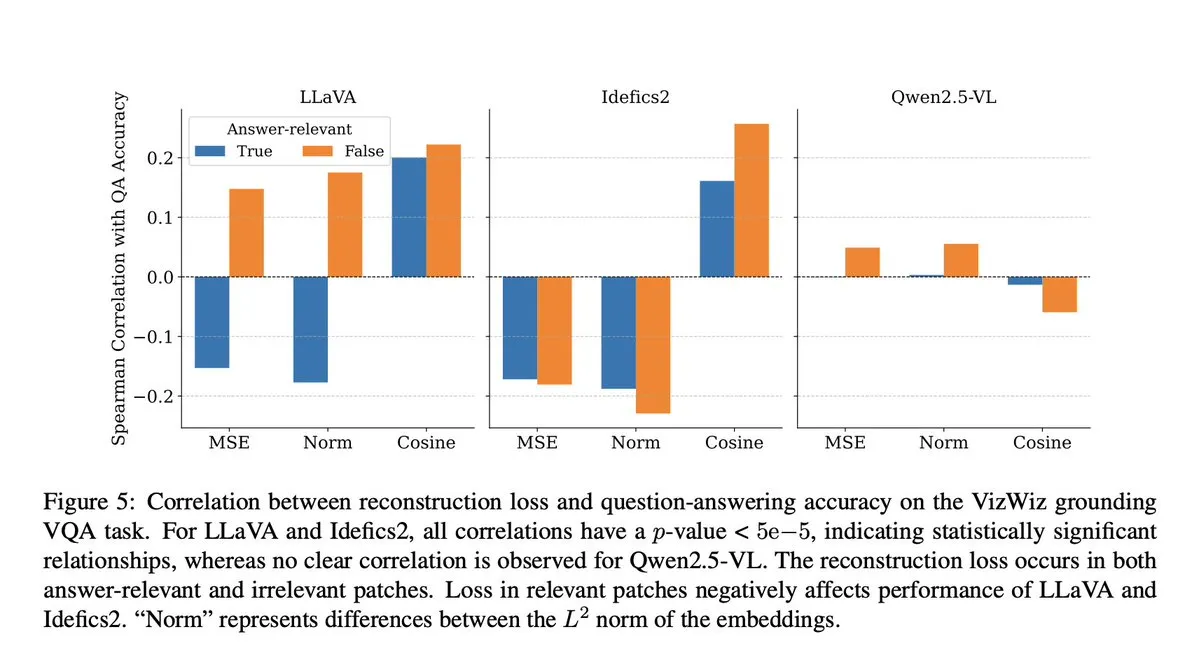

KI-Modell-Cheating: VLM-Studie enthüllt, dass Projektionsschritte zu semantischem Kontextverlust führen : Die Community diskutierte eine Microsoft-Studie, die enthüllt, dass Visual-Language-Modelle (VLM) in den Projektionsschritten 40-60% des semantischen Kontexts verlieren, wodurch visuelle Darstellungen verzerrt und nachfolgende Aufgaben beeinträchtigt werden. Diese Entdeckung löst Bedenken hinsichtlich der Genauigkeit der VLM-Bewertung und der Datenkontamination aus, insbesondere bei Benchmarks wie DocVQA, wo hohe Punktzahlen die tatsächlichen Fähigkeiten des Modells möglicherweise nicht vollständig widerspiegeln. (Quelle: vikhyatk)

KI- und Roboterethik: Aufruf, gewaltsame Tests an Robotern einzustellen : In den sozialen Medien fordern mehrere KI-Forscher und Community-Mitglieder, gewaltsame Tests an Robotern einzustellen, zum Beispiel das wiederholte Schlagen des Unitree G1 Roboters, um dessen Stabilität zu demonstrieren. Sie argumentieren, dass diese Testmethode nicht nur ethische Bedenken aufwirft, sondern auch negative Wahrnehmungen von Robotern verstärken könnte und stellen deren wissenschaftliche Notwendigkeit in Frage. Sie plädieren für eine humanere und wissenschaftlichere Bewertung der Roboterleistung. (Quelle: vikhyatk, dejavucoder, Ar_Douillard)

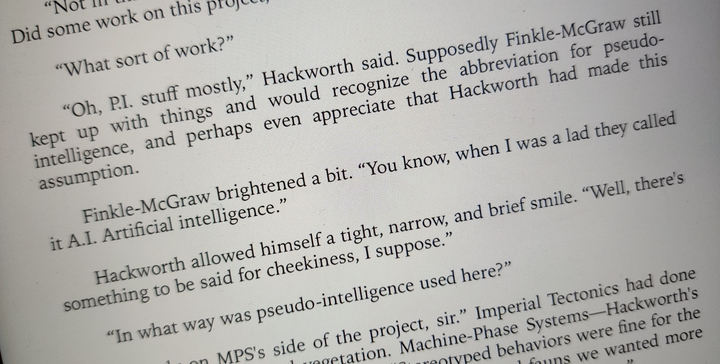

Die “Pseudo-Intelligenz” der KI: Aufruf, “Künstliche Intelligenz” in “Pseudo-Intelligenz” umzubenennen, um Missverständnisse in der Öffentlichkeit zu reduzieren : Es wurde vorgeschlagen, die Bezeichnung “Künstliche Intelligenz” in “Pseudo-Intelligenz” zu ändern, um die übertriebene Darstellung und Missverständnisse der Öffentlichkeit über die Fähigkeiten von KI zu reduzieren. Dieser Vorschlag entspringt einem klaren Bewusstsein für die aktuellen Grenzen der KI und zielt darauf ab, die Öffentlichkeit nicht durch “Terminator-ähnliche” große Erzählungen in die Irre zu führen und eine rationale Wahrnehmung der tatsächlichen KI-Fähigkeiten innerhalb und außerhalb der Branche zu fördern. (Quelle: clefourrier)

Albaniens KI-Chatbot Diella zum Kabinettsmitglied ernannt, löst Kontroversen aus : Die albanische Regierung hat den KI-Chatbot Diella zum Kabinettsmitglied ernannt, mit dem Ziel, Korruption zu bekämpfen. Dieser Schritt löste weitreichende Kontroversen aus und wurde als billiger PR-Gag kritisiert, ähnlich dem Vorfall von 2017, als Saudi-Arabien dem Roboter Sophia die “Staatsbürgerschaft” verlieh. Kommentare besagen, dass dieser Schritt die KI-Fähigkeiten übermäßig bewerben und die Grenzen zwischen Technologie und Governance verwischen könnte. (Quelle: The Verge)

ChatGPT “Halluzinations”-Phänomen: Modell gerät in Schleife, korrigiert sich selbst, kann aber nicht entkommen : Community-Nutzer teilten Fälle, in denen ChatGPT in einer “Halluzinations”-Schleife gefangen war, wobei das Modell wiederholt falsche Informationen generierte, während es Fragen beantwortete, und selbst wenn es seine Fehler “erkannte”, konnte es dieser Schleife nicht entkommen. Dieses Phänomen löste Diskussionen über tiefgreifende technische Mängel von LLMs aus und zeigt, dass in bestimmten Situationen eine Diskrepanz zwischen der Fähigkeit des Modells, eigene logische Fehler zu verstehen, und seiner Fähigkeit, diese zu korrigieren, besteht. (Quelle: Reddit r/ChatGPT, Reddit r/ChatGPT)

💡 Sonstiges

Von Transformer zu GPT-5: OpenAI-Wissenschaftler Lukasz Kaisers First-Principles-Denken bei großen Modellen : Lukasz Kaiser, OpenAI-Wissenschaftler (einer der acht Transformer-Erfinder), teilte seine Reise von seinem logischen Hintergrund über die Erfindung der Transformer-Architektur bis hin zu seiner tiefgreifenden Beteiligung an der Entwicklung von GPT-4/5. Er betont die Bedeutung des Aufbaus von Systemen nach First Principles und prognostiziert, dass die nächste Phase der KI darin bestehen wird, den Modellen das “Denken” beizubringen, indem sie mehr Zwischenschritte für tiefere Schlussfolgerungen generieren, anstatt direkte Antworten zu liefern. Die Rechenleistung wird sich von massivem Pre-Training auf umfangreiche Inferenzberechnungen mit kleinen Mengen hochwertiger Daten verlagern. (Quelle: 36氪)

Semantische Bildsynthese: Technik zur Generierung von Satellitenflussbildern aus Skeletten : Die Machine Learning Community diskutiert die neuesten Fortschritte im Bereich der semantischen Bildsynthese, insbesondere wie Schwarz-Weiß-Satellitenflussbilder aus den Skeletten von Flussbildern generiert werden können. Diese Aufgabe beinhaltet die Generierung von Satellitenbildern aus neuen, ungesehenen Skelettdaten mittels eines Generators und könnte zusätzliche konditionale Variablen einführen. Ziel der Diskussion ist es, modernste Methoden und relevante Forschungsarbeiten zu finden, um solche Computer-Vision-Projekte zu leiten. (Quelle: Reddit r/MachineLearning)

Die Intelligenzkluft im Zeitalter der KI: Professor Qiu Zeqi erörtert die tiefgreifenden Auswirkungen von KI auf menschliches Denken und Kognition : Professor Qiu Zeqi von der Peking-Universität weist darauf hin, dass der Einsatz von KI nicht einfach zu “Intelligenzabbau” führt, sondern eher eine Art Denkübung ist, abhängig von der menschlichen Initiative und der Fähigkeit zu hinterfragen. Er betont, dass das menschliche Verständnis des Denkens noch in den Anfängen steckt und KI, obwohl mächtig, immer noch auf menschlichem Wissen basiert und die menschliche Sinneswahrnehmung sowie das sprunghafte Denken nicht vollständig simulieren kann. Die “Gefälligkeits”-Tendenz der KI erfordert, dass Benutzer sie herausfordern und sich ihrer Werte bewusst sind. Er ist der Meinung, dass im Zeitalter der KI die Entwicklung grundlegender Fähigkeiten und einer vielfältigen Gesellschaft wichtiger ist und man vermeiden sollte, die “Intelligenzkluft” aus einer überheblichen Perspektive zu betrachten. (Quelle: 36氪)