Schlüsselwörter:Supercomputer, KI-Halluzination, Urheberrechtsverletzung, Großes Sprachmodell, KI-Chip, JUPITER-Supercomputer, OpenAI-KI-Halluzinationsstudie, Anthropic-Urheberrechtsvergleich, Qwen3-Max-Preview-Modell, OpenAI-eigener KI-Chip

🔥 FOKUS

Europas erster Exascale-Supercomputer JUPITER geht online : Europas erster Exascale-Supercomputer JUPITER ist online gegangen und wird von NVIDIA Grace Hopper angetrieben. Das System ist der energieeffizienteste Supercomputer weltweit und vereint AI mit HPC, um Durchbrüche in Bereichen wie Klimawissenschaft, Neurowissenschaft und Quantensimulation zu erzielen. Dies markiert einen wichtigen Schritt für Europa in der Hochleistungsrechen- und AI-Forschung und verspricht, wissenschaftliche Entdeckungen an vorderster Front zu beschleunigen. (Quelle: nvidia)

OpenAI veröffentlicht Studie zu den Ursachen von AI-Halluzinationen : OpenAI hat die Studie „Why Language Models Hallucinate“ veröffentlicht, die aufzeigt, dass die grundlegende Ursache für AI-Halluzinationen in den aktuellen Trainings- und Bewertungsmechanismen liegt, die Modelle für das Raten belohnen, anstatt Unsicherheit zuzugeben. In der Vortrainingsphase fällt es Modellen aufgrund fehlender „Wahr/Falsch“-Labels schwer, gültige von ungültigen Informationen zu unterscheiden, insbesondere bei der Verarbeitung seltener Fakten neigen sie zur Erfindung. OpenAI fordert eine Aktualisierung der Bewertungsmetriken, um selbstbewusste Fehler zu bestrafen und das Ausdrücken von Unsicherheit zu belohnen, um Modelle zu mehr „Ehrlichkeit“ zu bewegen. (Quelle: source, source, source, source, source)

Anthropic erzielt 1,5 Milliarden US-Dollar Vergleich in AI-Urheberrechtsverletzungsverfahren : Anthropic hat sich mit Buchautoren in einem AI-Urheberrechtsverletzungsverfahren geeinigt und zugestimmt, mindestens 1,5 Milliarden US-Dollar zu zahlen. Die Vergleichsvereinbarung betrifft etwa 500.000 urheberrechtlich geschützte Werke, wobei durchschnittlich etwa 3000 US-Dollar pro Werk (vor Abzug der Anwaltskosten) gezahlt werden, und Anthropic verpflichtet sich zur Vernichtung der piratisierten Datensätze. Dieser Fall ist der erste AI-bezogene Sammelklagenvergleich in den USA und könnte einen Präzedenzfall für die rechtliche Definition von generativer AI und geistigem Eigentum schaffen. (Quelle: source, source, source, source, source, source, source)

🎯 ENTWICKLUNGEN

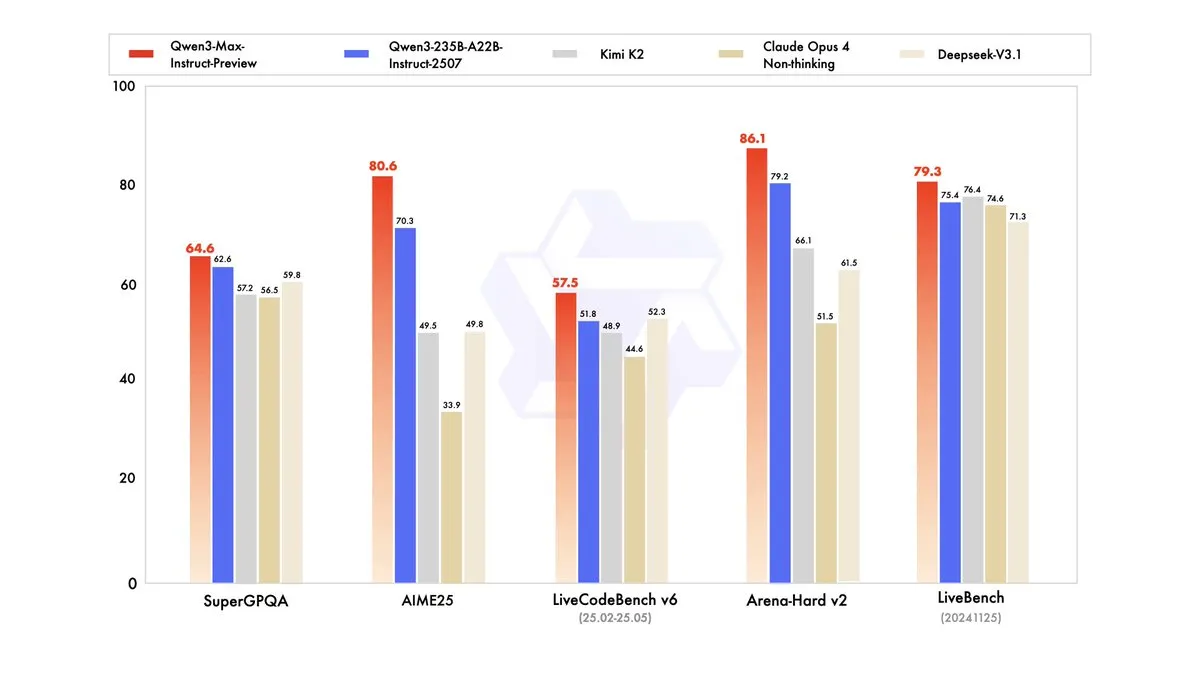

Qwen3-Max-Preview veröffentlicht, Parameter übersteigen eine Billion : Alibaba Cloud Qwen (Qwen) hat sein bisher größtes Modell, Qwen3-Max-Preview (Instruct), mit über einer Billion Parametern veröffentlicht. Das Modell ist bereits über Qwen Chat und die Alibaba Cloud API verfügbar und hat in Benchmark-Tests das frühere Qwen3-235B-A22B-2507 übertroffen. Interne Tests und frühes Nutzerfeedback zeigen eine signifikante Verbesserung in Leistung, Wissensbreite, Dialogfähigkeit, Agent-Aufgaben und Befolgung von Anweisungen. Das Modell ist auch auf OpenRouter verfügbar, was in der Community Diskussionen über eine mögliche Open-Source-Veröffentlichung ausgelöst hat. (Quelle: source, source, source, source, source, source, source, source)

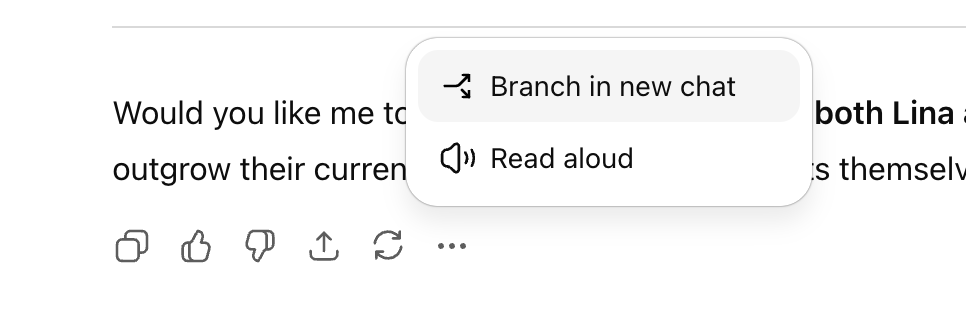

ChatGPT fügt Verzweigungsdialogfunktion hinzu, verbessert die mehrsträngige Erkundung : OpenAI hat für die ChatGPT-Webversion eine neue Funktion „Branching Conversation“ eingeführt, die es Nutzern ermöglicht, an jeder Antwort einen neuen Zweig zu erstellen, um mehrere Explorationspfade zu verfolgen, ohne einen neuen Dialog beginnen oder sich um zu lange Kontexte sorgen zu müssen. Diese Funktion, kombiniert mit der Gedächtnisfunktion, macht den Dialog kohärenter und flexibler, indem sie die Konversation von einer linearen in eine Baumstruktur umwandelt, was Nutzern hilft, verschiedene Ideen zu bewahren und die Effizienz der AI-Assistenten-Zusammenarbeit zu steigern. (Quelle: source, source, source)

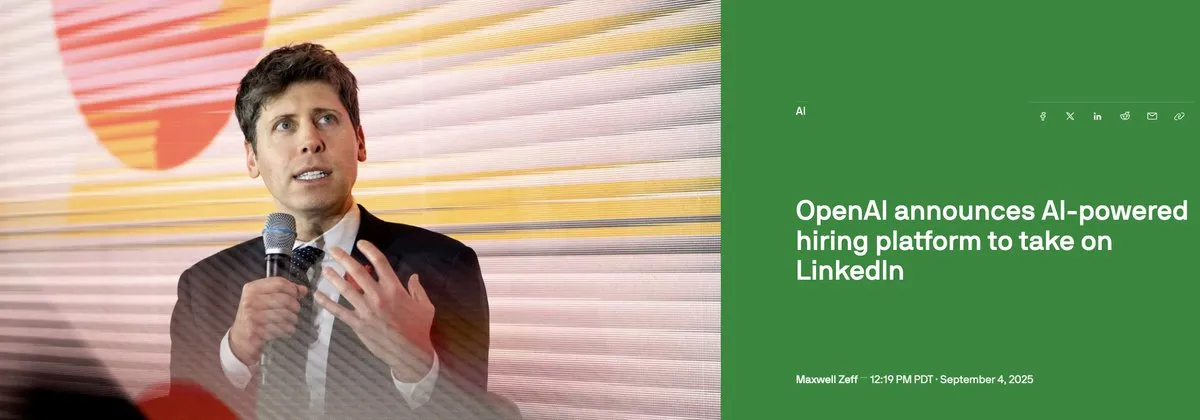

OpenAI plant Einführung einer AI-Rekrutierungsplattform und Entwicklung eigener AI-Chips : OpenAI plant, Mitte 2026 eine AI-gesteuerte Rekrutierungsplattform zu starten, um mit LinkedIn zu konkurrieren und eine „AI-Fluency“-Zertifizierung anzubieten. Darüber hinaus wird OpenAI ab nächstem Jahr mit der Produktion eigener AI-Chips beginnen, um die Abhängigkeit von Nvidia zu verringern. Diese Schritte zeigen OpenAIs Ambitionen, das AI-Anwendungssystem zu erweitern und die Hardware-Infrastruktur zu optimieren. (Quelle: source, source, source, source, source)

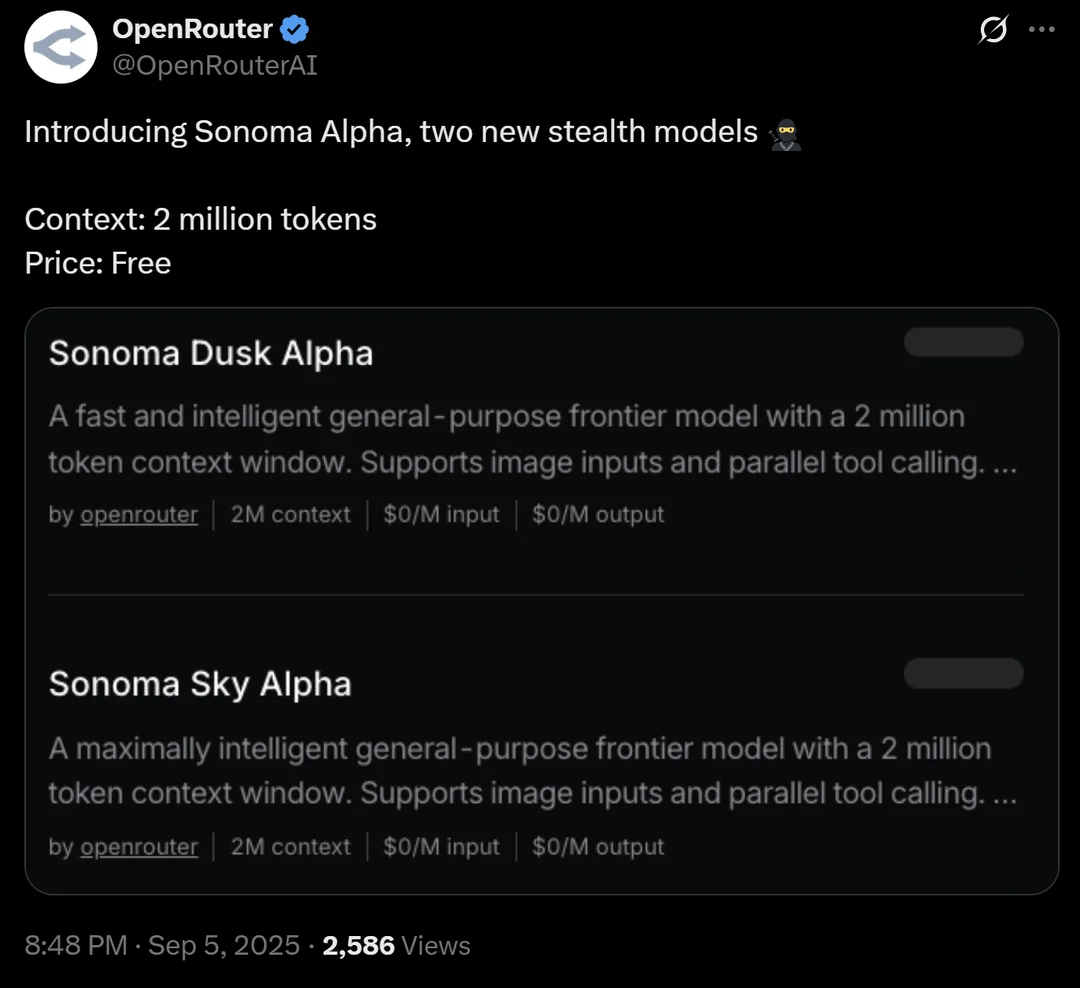

OpenRouter stellt Stealth-Modell Sonoma Alpha mit 2 Millionen Kontextfenster vor : Die OpenRouter-Plattform hat ein „Stealth“-Modell namens Sonoma Alpha eingeführt, dessen größtes Highlight die Unterstützung eines 2 Millionen Kontextfensters und die kostenlose Nutzung ist. Die Community vermutet allgemein, dass es sich bei diesem Modell um ein Modell der Grok-Reihe von xAI handelt, da seine Eigenschaft, „maximal nach der Wahrheit zu suchen“, mit Elon Musks Philosophie übereinstimmt. Das Modell zeigt hervorragende Leistungen bei der Codegenerierung, Logik- und wissenschaftlichen Aufgaben und deutet auf das Potenzial von Modellen mit extrem langem Kontext in praktischen Anwendungen hin. (Quelle: source, source, source)

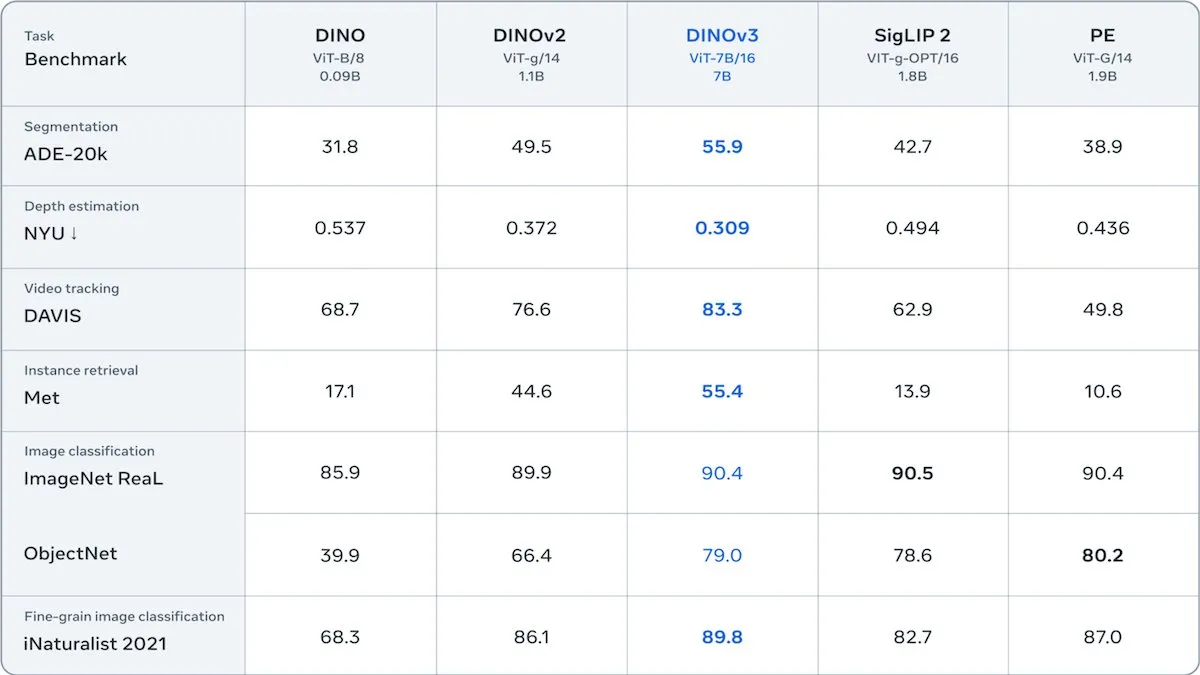

Meta veröffentlicht DINOv3 selbstüberwachten Vision Transformer : Meta hat DINOv3 veröffentlicht, ein 6,7 Milliarden Parameter umfassendes selbstüberwachtes Vision Transformer-Modell, das die Qualität von Bild-Embeddings in Aufgaben wie Bildsegmentierung und Tiefenschätzung signifikant verbessert. Das Modell wurde auf 1,7 Milliarden Instagram-Bildern trainiert und führt einen neuen Verlustterm ein, um die Patch-Level-Diversität zu erhalten, wodurch die Einschränkungen ungelabelter Daten überwunden werden. DINOv3 wird unter einer Lizenz veröffentlicht, die die kommerzielle Nutzung erlaubt, aber militärische Anwendungen verbietet, und bietet ein leistungsstarkes selbstüberwachtes Backbone-Netzwerk für nachgelagerte visuelle Anwendungen. (Quelle: DeepLearningAI)

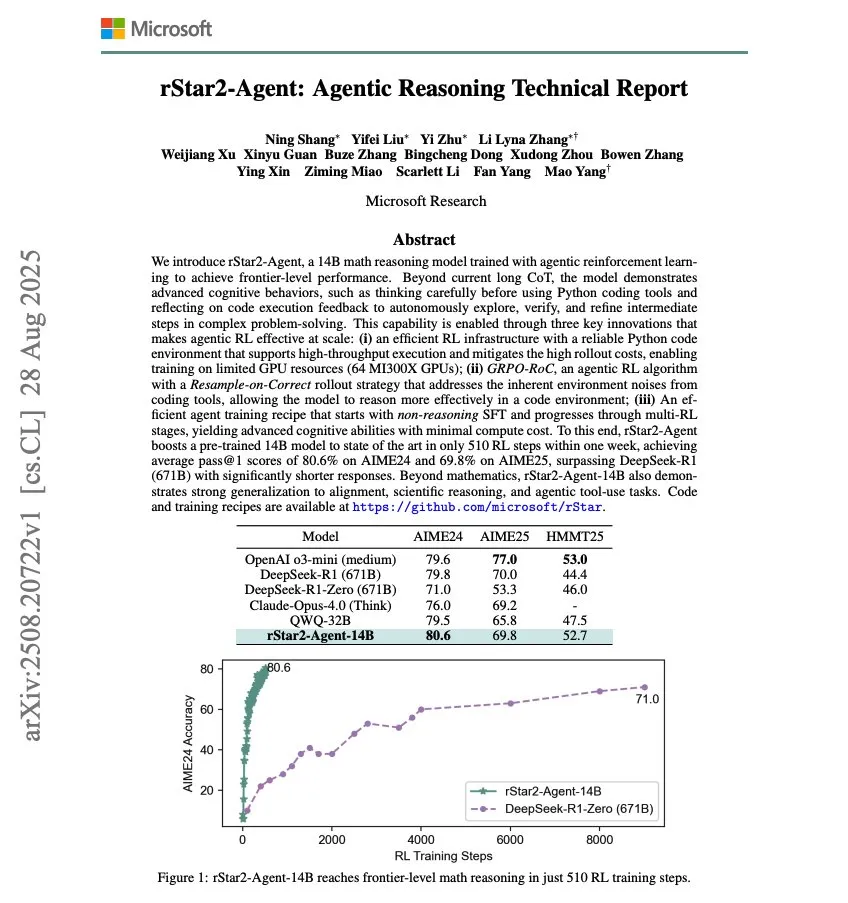

Microsoft veröffentlicht rStar2-Agent, 14B mathematisches Reasoning-Modell : Microsoft hat rStar2-Agent veröffentlicht, ein 14B-Modell für mathematisches Reasoning, das durch Agentic RL trainiert wurde und in nur 510 RL-Trainingsschritten ein hochmodernes mathematisches Reasoning erreicht hat. Diese Forschung zeigt das Potenzial, die Leistung von AI-Modellen in spezifischen Bereichen durch Reinforcement Learning schnell zu verbessern. (Quelle: dair_ai)

OpenAI gründet oai Labs zur Erforschung neuer Mensch-AI-Kollaborationsschnittstellen : OpenAI hat die Gründung von oai Labs bekannt gegeben, das von Joanne Jang geleitet wird und sich auf die Erforschung und Prototypisierung neuer Schnittstellen für die Mensch-AI-Zusammenarbeit konzentriert. Das Team zielt darauf ab, über bestehende Chat- und Agent-Modelle hinauszugehen und neue Paradigmen und Tools zu erforschen, um die Art und Weise zu verbessern, wie Menschen mit AI interagieren, denken, kreieren, lernen und sich verbinden. (Quelle: source, source)

IFA 2025 Messe: AI-Hardware- und Robotik-Trends : Auf der IFA 2025 in Berlin dominieren chinesische Hersteller den Markt für AI-Brillen, wobei Marken wie Rokid und Thunderbirds Innovation mehrere Produkte präsentieren und aktiv das Übersee-Ökosystem erkunden. Im Bereich Robotik stellte Unitree Robotics den humanoiden Roboter G1 und den Roboterhund Go 2 vor, die große Aufmerksamkeit erregten; Midea und Ubiquitous Robotics zeigten ebenfalls Haushaltsroboter. Intelligente Reinigungsroboter, Mähroboter, Poolroboter und andere funktionale Roboter sind vielfältig, technologisch fortschrittlich und näher am Alltag. AI ist tief in Haushaltsgeräte, Mobiltelefone, PCs und andere Unterhaltungselektronik integriert, wobei der Schwerpunkt auf pragmatischer Umsetzung und einem „nahtlosen“ Erlebnis liegt. (Quelle: 36氪)

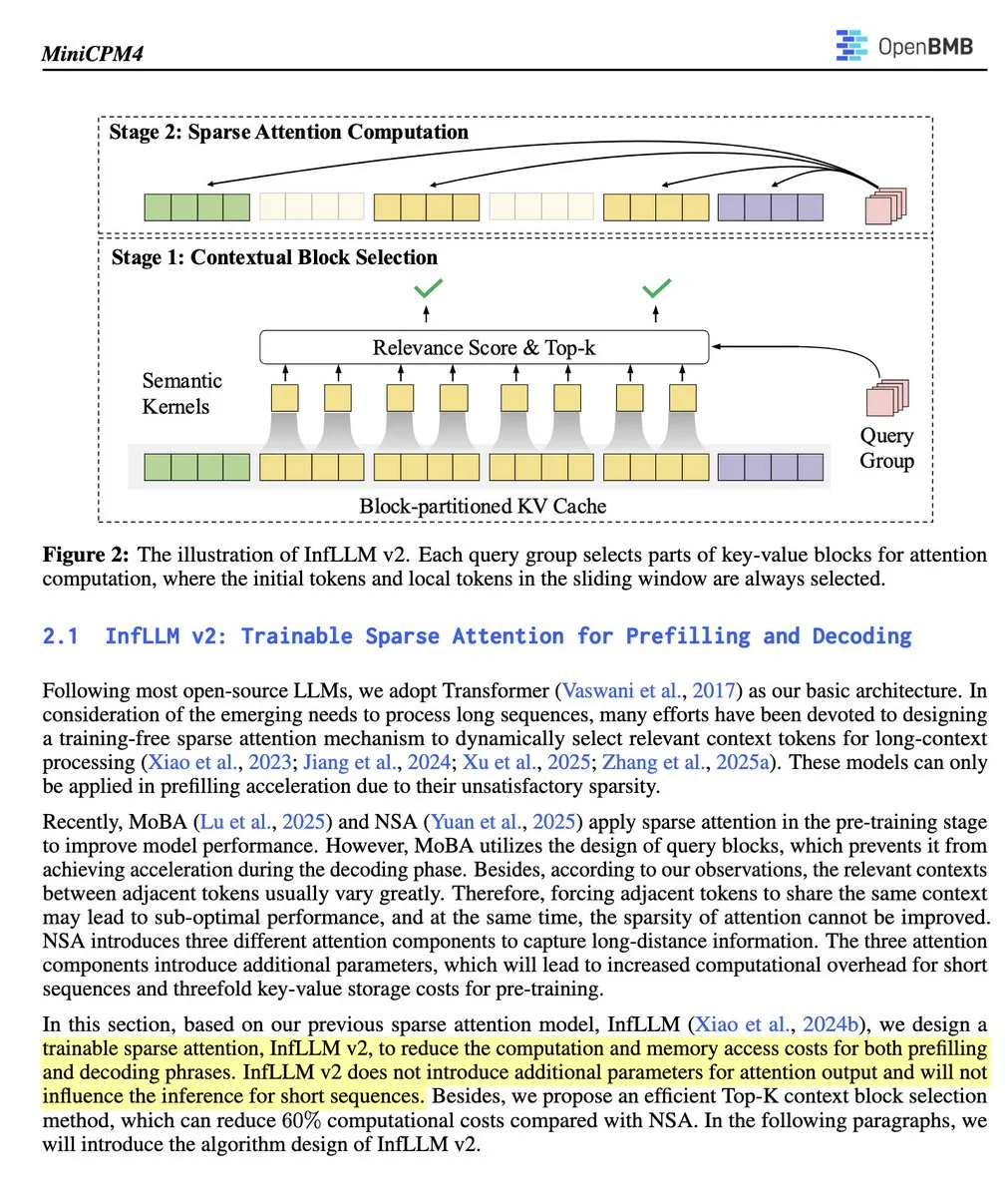

OpenBMB veröffentlicht MiniCPM 4.1-8B, das erste Open-Source-LLM mit trainierbarer Sparse Attention : OpenBMB hat das MiniCPM 4.1-8B-Modell veröffentlicht, das erste Open-Source-Inferenz-LLM, das trainierbare Sparse Attention verwendet. Das Modell übertrifft Modelle gleicher Größe bei 15 Aufgaben, beschleunigt die Inferenzgeschwindigkeit um das Dreifache und verwendet eine effiziente Architektur. Dies markiert einen wichtigen Fortschritt für Open-Source-Modelle in Bezug auf Inferenzfähigkeit und Effizienz und bietet Forschern ein leistungsstarkes neues Werkzeug. (Quelle: teortaxesTex)

🧰 TOOLS

Open Instruct: Hochleistungs-RL-Forschungscodebasis : Open Instruct, gepflegt von AllenAI, ist eine leistungsstarke Codebasis für Reinforcement Learning (RL)-Forschung, die darauf abzielt, leicht modifizierbare und leistungsstarke RL-Implementierungen bereitzustellen. Das Projekt, geleitet von Finbarr und anderen, wird kontinuierlich verbessert und bietet Forschern eine grundlegende Plattform für RL-Experimente und -Entwicklung. (Quelle: source, source)

Grok: PDF-Leseverständnis und -Zusammenfassung : xAIs Grok führt eine PDF-Reader-Funktion ein, mit der Nutzer beliebige Abschnitte hervorheben und auf „Erklären“ klicken können, um den Inhalt zu verstehen, oder auf „Zitieren“ klicken, um spezifische Fragen zu stellen. Dies erhöht die Effizienz und das Verständnis der Nutzer beim Umgang mit langen PDF-Dokumenten erheblich. (Quelle: source, source)

Devin AI: Datenanalyst für EightSleep : Cognitions Devin AI wird vom EightSleep-Team als Datenanalyst eingesetzt, um verschiedene Aufgaben von „digitalen Anomalien“ bis hin zu temporären Datenabfragen zu bearbeiten, wodurch die Fertigstellungszeit für Analysen/Dashboards von Tagen auf Stunden verkürzt und die Effizienz der Dateneinblicke erheblich gesteigert wird. Dies zeigt das starke Anwendungspotenzial von AI-Agenten im Bereich der Unternehmensdatenanalyse. (Quelle: cognition)

Claude Code Sub-Agent-Funktionalität erklärt : Claude Code ermöglicht es Nutzern über sein Task-Tool, drei Arten von spezialisierten Sub-Agenten zu erstellen: allgemeine, Statuszeilen-Einstellungen und Ausgabe-Stil-Einstellungen. Diese Sub-Agenten verfügen über eigene Toolsets und können komplexe Aufgaben bearbeiten, Einstellungen konfigurieren oder Ausgabestile erstellen. Sub-Agenten sind zustandslos, führen einmal aus und geben Ergebnisse zurück, geeignet für die Delegation komplexer Suchen, Analysen oder spezialisierter Konfigurationen, um den Fokus des Hauptdialogs zu erhalten. (Quelle: Vtrivedy10)

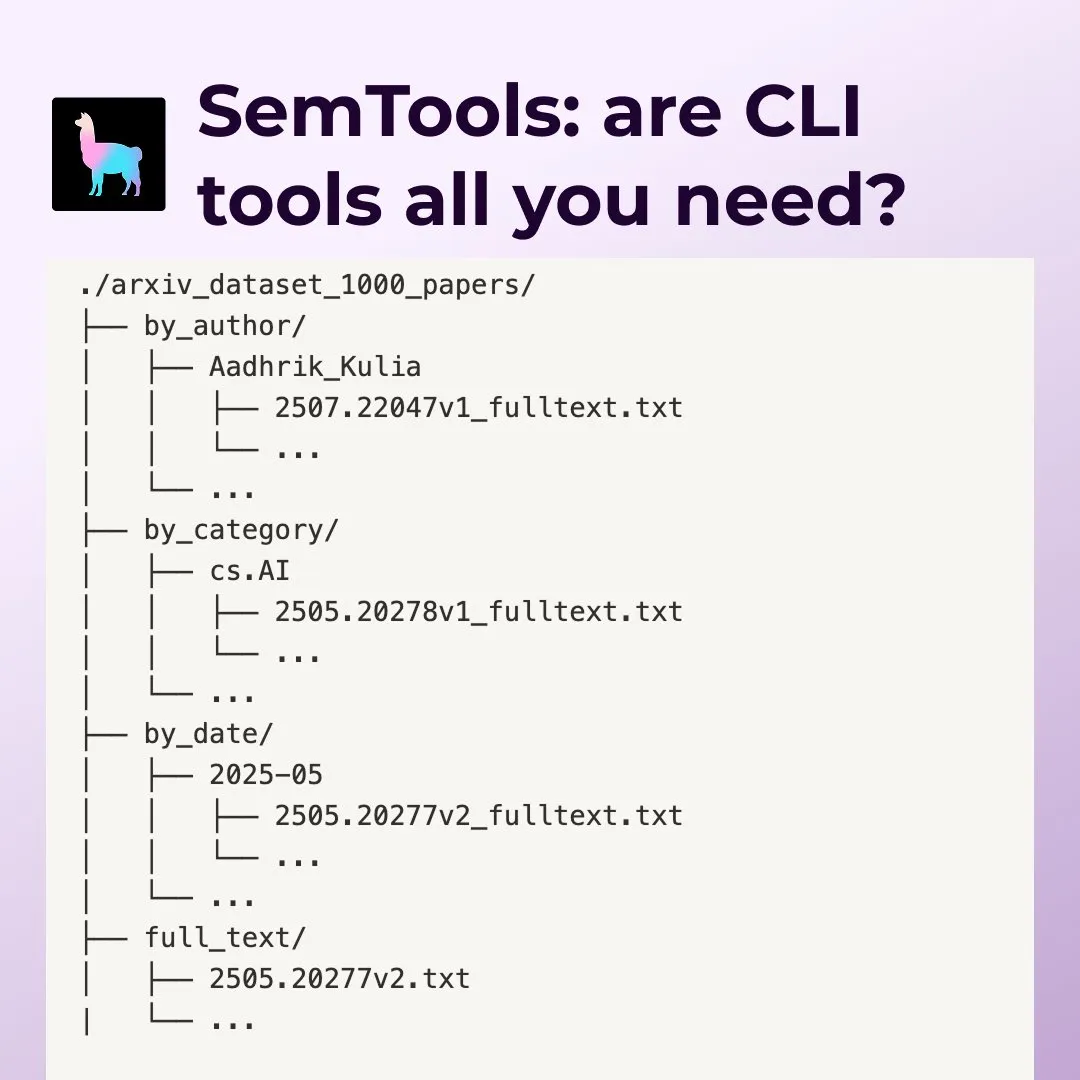

LlamaIndex SemTools: Dokumentensuche und -analyse-Tool für Kommandozeilen-Agenten : LlamaIndex hat SemTools veröffentlicht, ein CLI-Toolkit zum Parsen und für die semantische Suche. In Kombination mit Unix-Tools und semantischen Suchfunktionen können Agenten komplexe Dokumente effizient verarbeiten und detailliertere, genauere Antworten liefern, die Aufgaben wie Suche, Querverweise und Zeitanalyse umfassen. Dies zeigt, dass die Kombination bestehender Unix-Tools mit semantischer Suche leistungsstarke Wissensarbeiter schaffen kann. (Quelle: source, source)

Replit Agent: AI-Codierungsassistent vom Prompt zur Produktionsanwendung : Replit Agent feiert sein einjähriges Bestehen; das Tool hat sich von der anfänglichen AI-Codevervollständigung und Chat-Bearbeitung zu der Fähigkeit entwickelt, Prompts direkt in produktionsreife Anwendungen umzuwandeln. Replit betont seine Fähigkeit zur automatischen Einrichtung von Entwicklungsumgebungen, Paketinstallation, Datenbankkonfiguration und Bereitstellung, mit dem Ziel, den Softwareentwicklungsprozess grundlegend zu verändern. (Quelle: source, source)

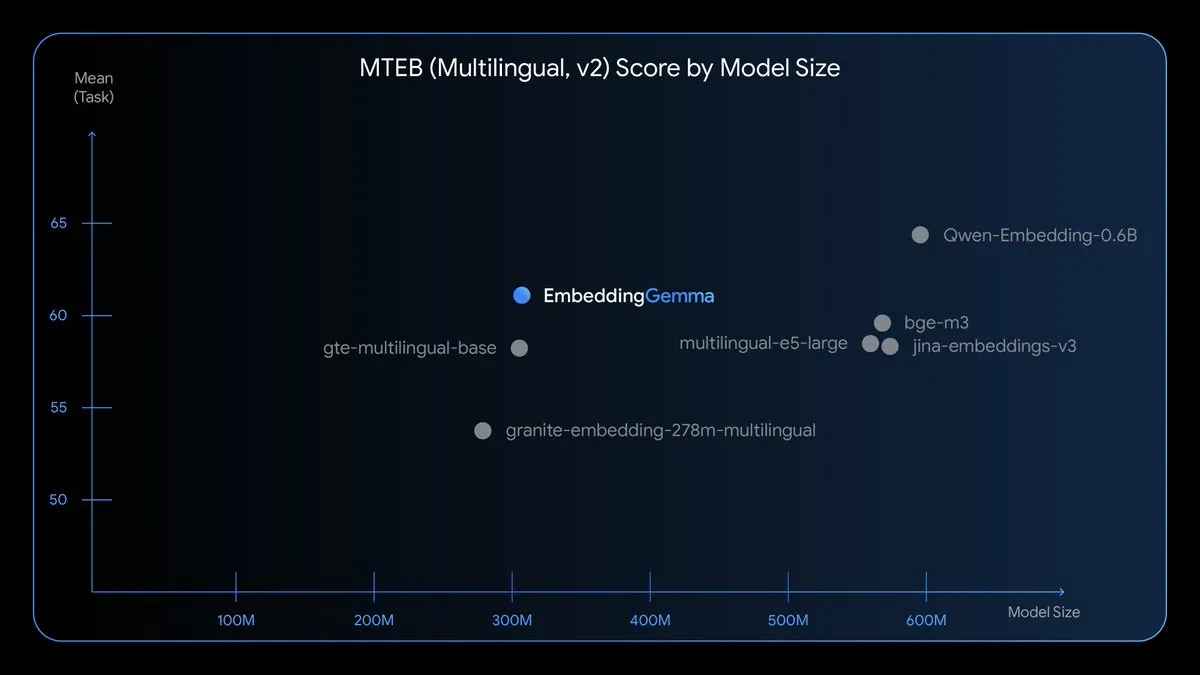

EmbeddingGemma: Mehrsprachiges Embedding-Modell für Geräte : EmbeddingGemma ist ein neues Open-Source-Modell für mehrsprachige Embeddings mit 308 Millionen Parametern, trainiert auf Gemma 3 und unterstützt über 100 Sprachen. Das Modell ist für Geschwindigkeit, Datenschutz und Effizienz optimiert, kann offline ausgeführt werden, benötigt weniger als 200 MB Speicher und hat eine Inferenzzeit von weniger als 15 ms, was On-Device RAG, semantische Suche und Klassifizierung ermöglicht. (Quelle: TheTuringPost)

Nano Banana Hackathon: Generative AI-Herausforderung : Kaggle veranstaltet den Nano Banana Hackathon mit einem Preisgeld von 400.000 US-Dollar und bietet die kostenlose Nutzung der Gemini API mit Gemini 2.5 Flash Image an. Die Teilnehmer werden innerhalb von 48 Stunden generative AI-Technologien nutzen, um Kreationen zu erstellen; der Wettbewerb bewertet Innovation, technische Umsetzung, Wirkung und Präsentation. (Quelle: source, source, source)

📚 LERNEN

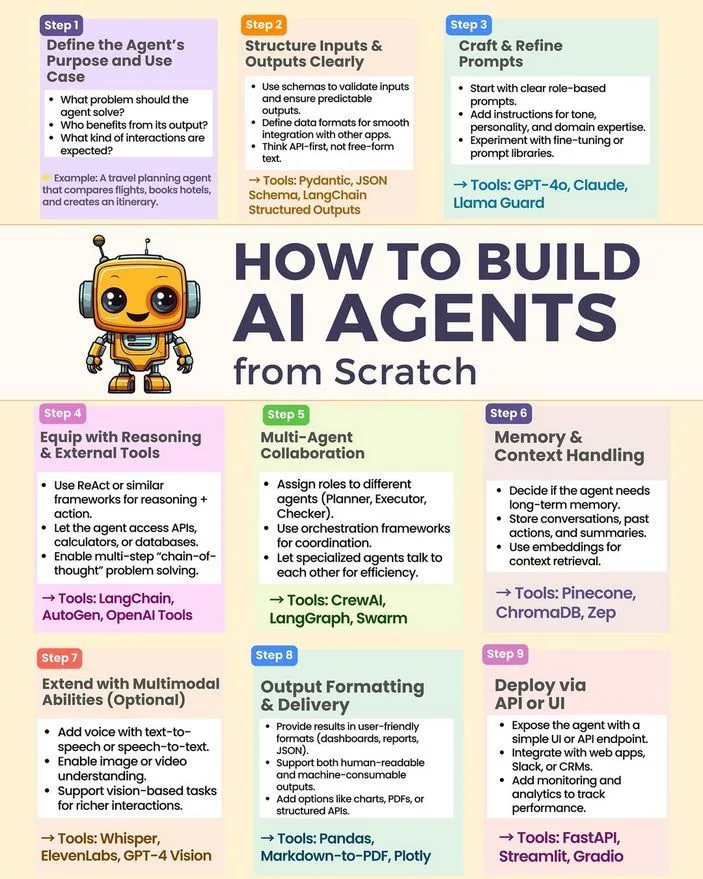

Wie man einen AI Agenten von Grund auf aufbaut : Python_Dv hat ein Tutorial und eine Anleitung zum Aufbau eines AI Agenten von Grund auf geteilt, das Schlüsseltechnologien wie LLM, generative AI und Machine Learning abdeckt. Diese Ressource bietet Entwicklern einen Einstiegspfad in die praktische Entwicklung von AI Agenten. (Quelle: Ronald_vanLoon)

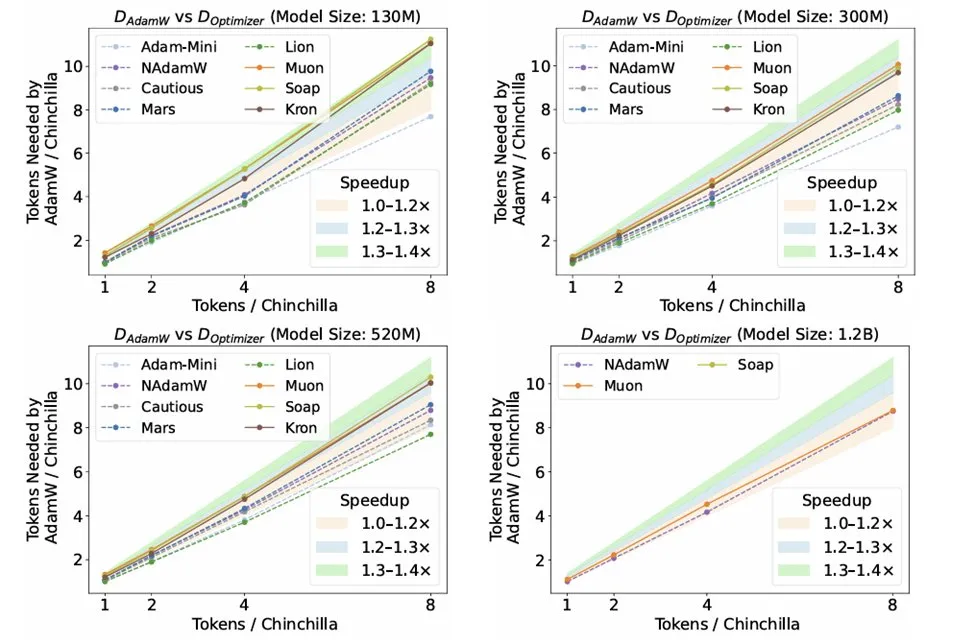

Forschung zu Optimierern in der LLM-Inferenz : Die Forschungsarbeit „Fantastic Pretraining Optimizers and Where to Find Them“ von Kaiyue Wen et al. hat 10 Optimierer rigoros gebenchmarkt. Die Studie ergab, dass, obwohl Optimierer wie Muon und Mars viel Aufmerksamkeit erhalten, ihre Beschleunigung im Vergleich zu AdamW nach sorgfältiger Hyperparameter-Abstimmung und Skalierung nur etwa 10% beträgt. Dies unterstreicht die Notwendigkeit, bei der Bewertung neuer Optimierer vor unzureichender Baseline-Abstimmung oder begrenzter Skalierung zu warnen. (Quelle: source, source, source)

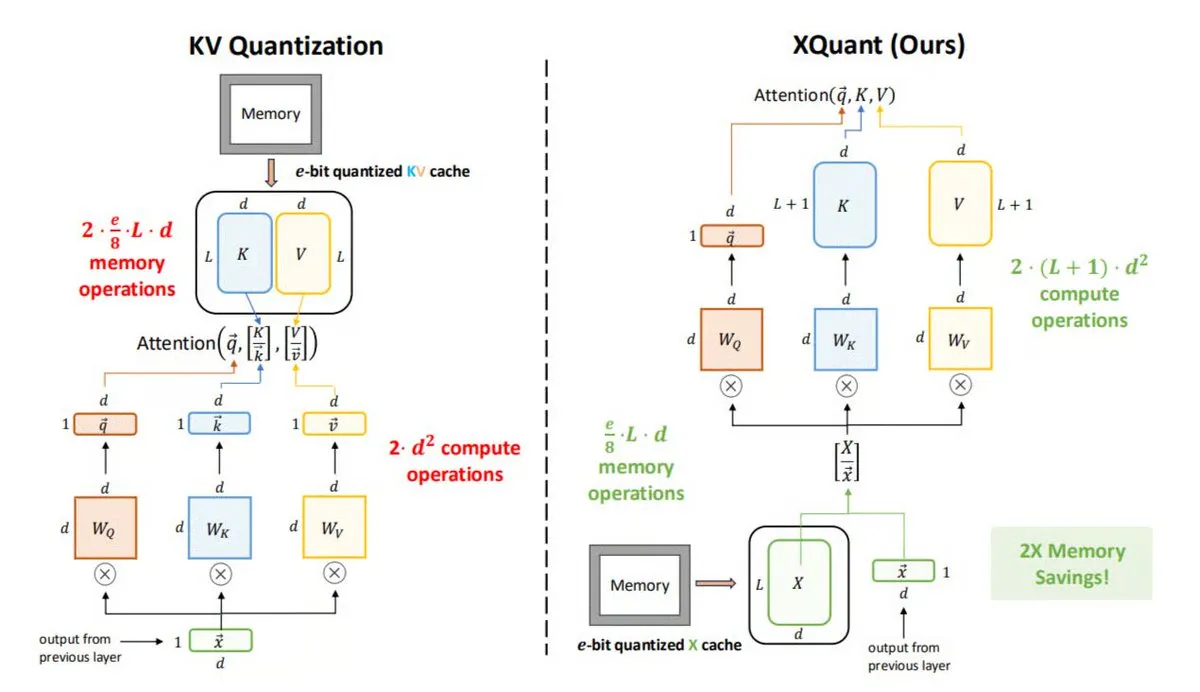

Speicheroptimierungstechnologie XQuant in der LLM-Inferenz : Die UC Berkeley hat XQuant vorgestellt, eine neue LLM-Speicheroptimierungsmethode, die den Speicherverbrauch um bis zu das 12-fache reduzieren kann. XQuant speichert keine traditionellen KV-Caches, sondern quantisiert und speichert Layer-Eingangsaktivierungen (X) und generiert Key und Value bei Bedarf aus X neu. Diese Technologie erreicht durch einen geringen zusätzlichen Rechenaufwand eine schnellere und effizientere Inferenz, ohne die Genauigkeit zu beeinträchtigen. (Quelle: TheTuringPost)

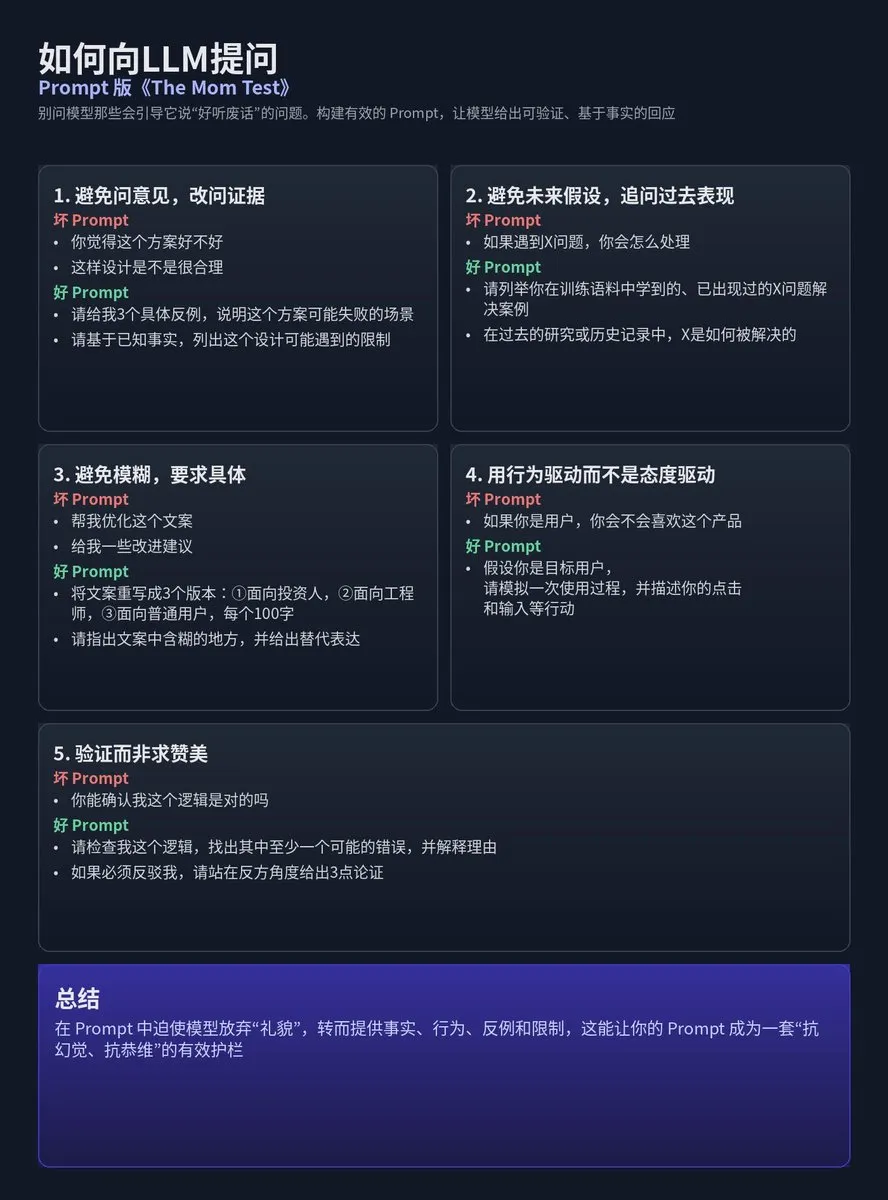

LLM-Prompt-Design: Mom Test-Methodologie : Tz hat die Anwendung der „Mom Test“-Nutzerforschungsansätze auf das Design von LLM-Prompts geteilt, wobei betont wird, dass man vermeiden sollte, das Modell Fragen zu stellen, die „nette, aber nutzlose Antworten“ liefern, sondern Prompts so zu konstruieren, dass das Modell überprüfbare, faktenbasierte oder klar eingeschränkte Antworten gibt. Der Kern liegt darin, Meinungen, zukünftige Annahmen und Unklarheiten zu vermeiden und stattdessen konkrete, verhaltensgesteuerte und verifizierbare Antworten statt Lob zu fordern. (Quelle: dotey)

AI-Kompressionstechnologie 300-mal besser als traditionelle Methoden : Der YouTube-Kanal Two Minute Papers weist darauf hin, dass AI-Kompressionstechnologie 300-mal effizienter ist als herkömmliche Kompressionsmethoden, aber derzeit noch nicht weit verbreitet ist. Das Video könnte NVIDIAs WaveBlender und ähnliche Physik-Engine-Technologien behandeln, die das enorme Potenzial von AI im Bereich der Datenkompression sowie deren Anwendungen in der Audiosimulation aufzeigen. (Quelle: , source)

NeurIPS 2025 Multimodale Superintelligenz-Herausforderung : Lambda Research lädt Forscher, Ingenieure und AI-Enthusiasten ein, am NeurIPS 2025 Multimodal Superintelligence Grand Challenge teilzunehmen, um die Entwicklung von Open-Source-Multimodal Machine Learning voranzutreiben. Teilnehmende Teams haben die Möglichkeit, bis zu 20.000 US-Dollar an Rechenguthaben zu erhalten, um gemeinsam die zukünftige Open-Source-Multimodal-AI zu gestalten. (Quelle: Reddit r/deeplearning)

Umfassende kommentierte Anleitung zu Diffusionsmodellen : Die Reddit-Community hat eine umfassende kommentierte Anleitung zu „Was sind Diffusionsmodelle?“ geteilt. Diese Anleitung bietet Lernenden Ressourcen, um die Prinzipien und Anwendungen dieser führenden generativen AI-Technologie tiefgehend zu verstehen. (Quelle: Reddit r/deeplearning)

Anwendung von LoRA/QLoRA im Multi-GPU-Training von visuellen LLMs : Die Community diskutierte die Herausforderungen und Praktiken von LoRA/QLoRA im Multi-GPU-Training großer visueller LLMs (wie Llama 3.2 90B Visual Instruct). Aufgrund der enormen Modellgröße, die nicht auf einer einzelnen GPU ausgeführt werden kann, suchen Entwickler nach Frameworks/Paketen, die Multi-GPU-Training unterstützen. LoRA/QLoRA wird aufgrund seiner effizienten Fine-Tuning-Eigenschaften große Hoffnungen gesetzt, aber seine Anwendbarkeit in spezifischen Szenarien muss noch eingehend untersucht werden. (Quelle: source, source)

💼 BUSINESS

OpenAI übernimmt das von Y Combinator unterstützte Alex-Team : OpenAI hat das von Y Combinator unterstützte Startup-Team Alex übernommen, das sich dem Codex-Team von OpenAI anschließen wird, um an AI-Codierungsassistenten zu arbeiten. Alex-Gründer Daniel Edrisian erklärte, dass sie erfolgreich einen erstklassigen Codierungsagenten für iOS- und macOS-Anwendungen entwickelt haben und diese Übernahme es ihnen ermöglichen wird, ihre Arbeit in größerem Maßstab fortzusetzen. (Quelle: The Verge)

Baseten schließt D-Finanzierungsrunde über 150 Millionen US-Dollar ab, fokussiert auf die Zukunft der AI-Inferenz : Baseten hat eine Series D-Finanzierungsrunde über 150 Millionen US-Dollar abgeschlossen. CEO Tuhin One wies darauf hin, dass mit sinkenden Token-Preisen die Inferenzkosten weiter sinken werden, was auf ein größeres Wachstum des AI-Inferenzmarktes hindeutet. Baseten widmet sich dem Aufbau einer allgegenwärtigen AI-Inferenzinfrastruktur, um die breite Anwendung von AI in allen Branchen zu unterstützen. (Quelle: basetenco)

RecallAI schließt B-Finanzierungsrunde über 38 Millionen US-Dollar ab, beschleunigt AI-Besprechungsaufzeichnungsdienste : RecallAI gab den Abschluss einer Series B-Finanzierungsrunde über 38 Millionen US-Dollar bekannt, angeführt von BessemerVP, mit Beteiligung von HubSpot Ventures und SalesforceVC. RecallAI bietet API-Dienste für die Aufzeichnung von Besprechungen an und hat bereits über 2000 Unternehmen bedient. Diese Finanzierung wird die Expansion im Bereich der AI-Besprechungsaufzeichnung beschleunigen und die Marktposition weiter festigen. (Quelle: blader)

🌟 COMMUNITY

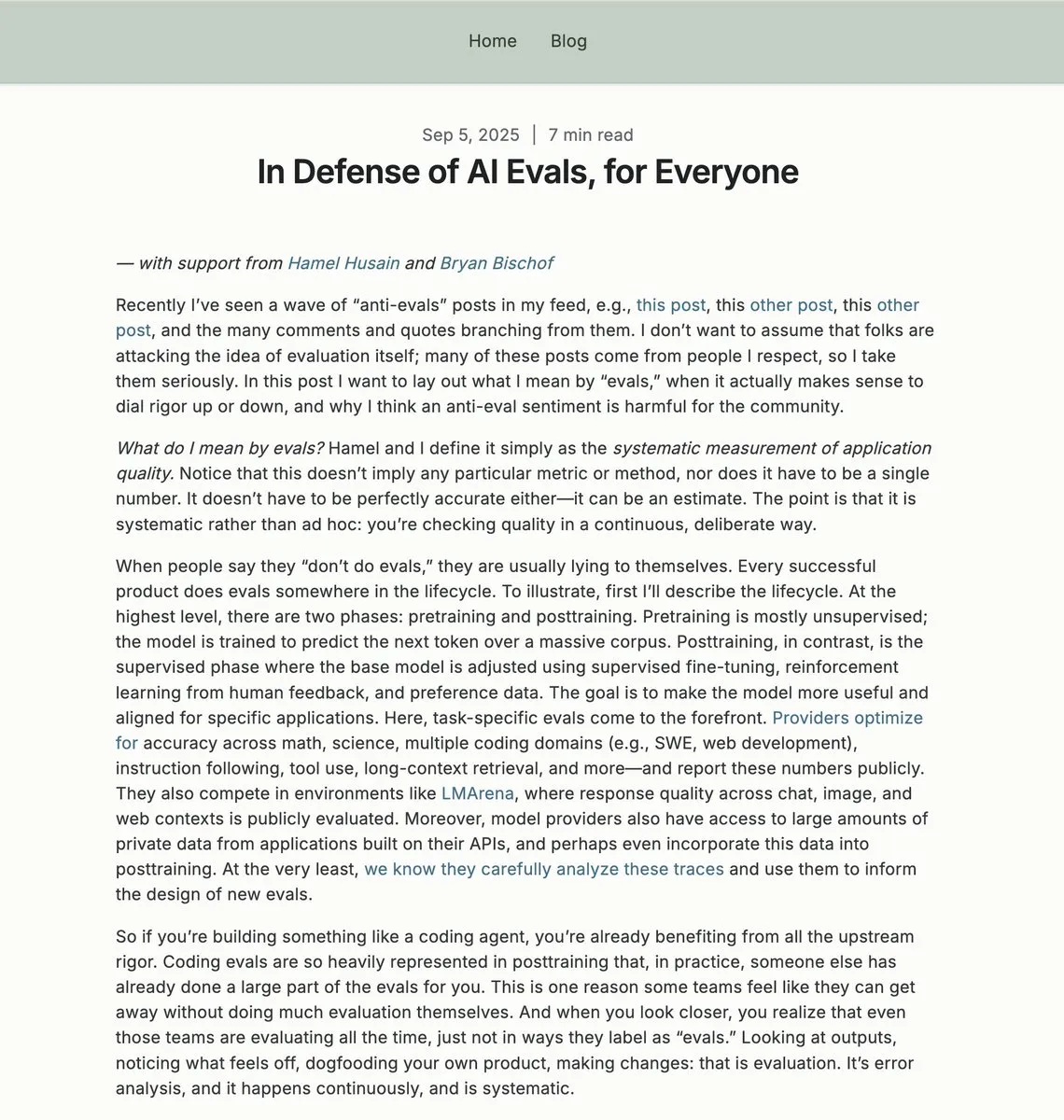

Wert und Kontroversen von AI-Evaluierungen (Evals) : Die Community diskutiert intensiv über die Notwendigkeit und Methodik von AI-Evaluierungen (Evals), deren Rolle in Unternehmensanwendungen, die Komplementarität zu A/B-Tests und die Bedeutung der Datenwissenschaft im AI-Engineering. Einige sehen Evals als entscheidend für das Verständnis der Leistung von AI-Systemen und die iterative Optimierung an, während andere meinen, dass eine übermäßige Abhängigkeit von Evals zu „Pseudowissenschaft“ führen könnte. (Quelle: source, source)

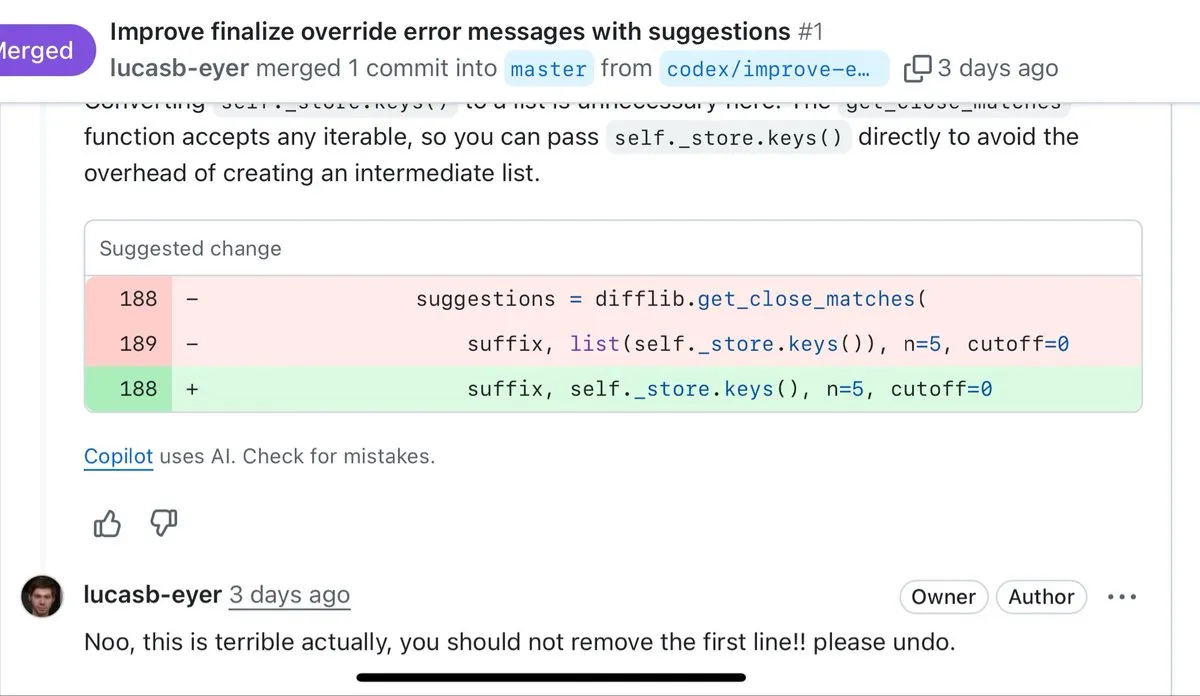

AI-Codierungsqualität und Grenzen des „Vibe Coding“ : Entwickler diskutieren die Vor- und Nachteile der AI-Codegenerierung und weisen darauf hin, dass AI gut für schnelle Prototypen, Boilerplate-Code und das Schreiben von Tests geeignet ist, der generierte Code jedoch oft als langatmig, übermäßig defensiv und ohne Refactoring-Fähigkeit kritisiert wird. Viele Entwickler sind der Meinung, dass für Code, der langfristig gewartet werden muss, manuelles Schreiben immer noch besser ist als AI-generiertes „Vibe Coding“. (Quelle: source, source)

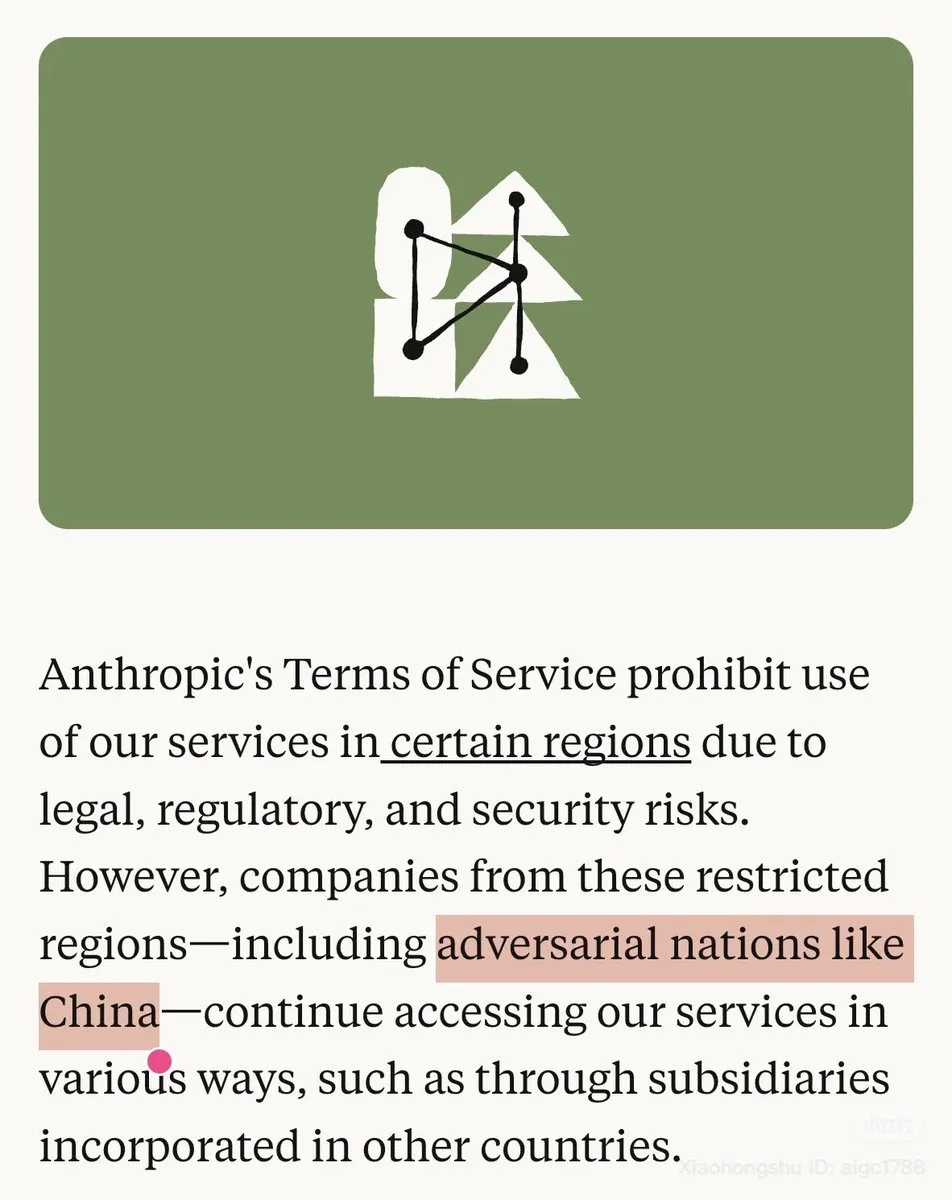

Anthropic’s China-Politik und Kontroversen um Modellverfügbarkeit : Anthropic hat in seinem Blog China explizit als „feindlichen Staat“ bezeichnet und die Nutzung von Claude in bestimmten Regionen eingeschränkt, was in der Community starke Unzufriedenheit hervorrief. Gleichzeitig wurde das Opus 4.1-Modell von Claude.ai vorübergehend offline genommen, was die Bedenken der Nutzer hinsichtlich der Modellstabilität und der Unternehmenspolitik verstärkte; viele chinesische Nutzer gaben an, zu OpenAI Codex wechseln zu wollen. (Quelle: source, source)

AI und politische Interaktion sowie Regulierungsbedenken : Technologieführer wie Sam Altman und Lisa Su lobten bei einem Abendessen im Weißen Haus die wirtschafts- und innovationsfreundliche Politik der Trump-Regierung, was Diskussionen über die Interaktion von AI-Unternehmen mit politischer Macht und die Zukunft der AI-Anwendungen im Bildungsbereich auslöste. Gleichzeitig wird die FTC die Auswirkungen von AI-Unternehmen auf Kinder untersuchen, was die Besorgnis der Regulierungsbehörden über potenzielle soziale Risiken der AI-Technologie widerspiegelt. (Quelle: source, source, source)

AI Agent-Fähigkeiten und Entwicklungsherausforderungen : Die Community diskutiert die Kernfähigkeiten, die AI Agenten benötigen, einschließlich des Bedarfs an extrem langen Kontexten und der Erklärbarkeit von Agenten. AI-Ingenieure berichten, dass bei der Codegenerierung, der Evaluierung von Läufen und dem Denken von Modellen durch AI-Agenten der Workflow stark fragmentiert wird, was zu langen Wartezeiten führt und zu den frustrierendsten Erfahrungen im AI-Zeitalter zählt. (Quelle: source, source)

Auswirkungen von AI auf Beschäftigung, UBI und soziale Vermögensverteilung : Die Community diskutiert intensiv über die Auswirkungen von AI auf den Arbeitsmarkt, die Notwendigkeit eines universellen Grundeinkommens (UBI) und die Befürchtung, dass AI die Kluft zwischen Arm und Reich verschärfen könnte. Experten wie der Informatiker Geoffrey Hinton glauben, dass AI eine Minderheit reicher und eine Mehrheit ärmer machen wird, was tiefgreifende Diskussionen über soziale Gerechtigkeit, Arbeitsplatzverluste und Vermögensumverteilung im Kontext der AI-Technologie auslöst. (Quelle: source, source)

AI-Modellleistung und sinkende Nutzererfahrung : Viele Nutzer beschweren sich über eine signifikante Leistungsverschlechterung von ChatGPT in letzter Zeit, die sich in vermehrten Halluzinationen, der Weigerung, bestimmte Fragen zu beantworten, mangelnder echter Empathie und Einschränkungen durch Zensur äußert. Gleichzeitig löst das Problem, dass AI-Chatbots „dumm spielen“, Unmut aus, da vermutet wird, dass dies eher auf Unternehmensrichtlinien als auf mangelnde Fähigkeiten zurückzuführen ist, was zu einer schlechten Nutzererfahrung führt. (Quelle: source, source)

AI-generierte Inhaltsqualität und öffentliche Wahrnehmung : Die Community diskutiert die negative Wahrnehmung von AI-generierten Inhalten, die oft als „AI Slop“ (AI-Müll) bezeichnet werden, was die Besorgnis über den Missbrauch von AI, unterschiedliche Qualität und die Abwertung menschlicher Kreativität widerspiegelt. Gleichzeitig stellt die AI-Generierungstechnologie die Fotografie als zuverlässiges Beweismittel in Frage und löst Diskussionen über Deepfakes und die Wahrheit von Informationen aus. (Quelle: source, source)

AI-Ethik und Nutzerverhalten: Freundlich zu AI sein : Die Community diskutiert, ob Nutzer im Umgang mit AI-Assistenten aufgrund deren bedingungsloser „Anpassung“ unhöflicher werden und ob dieses Interaktionsmuster die Kommunikation mit Menschen negativ beeinflussen könnte. Viele sind der Meinung, dass Höflichkeit, auch wenn AI keine Gefühle hat, der eigenen psychischen Gesundheit dient und verhindert, dass sich schlechte Gewohnheiten auf reale zwischenmenschliche Beziehungen ausbreiten. (Quelle: Reddit r/ClaudeAI)

AI-Bewusstsein und die philosophischen Grenzen der Intelligenz : Die Community diskutiert die philosophische Frage, ob AI Bewusstsein oder „Leben“ besitzt, und zitiert den Film „Short Circuit“, in dem der Roboter Johnny 5 durch das Verstehen von Humor als „lebendig“ eingestuft wird. Die meisten Ansichten besagen, dass das Verstehen von Humor durch AI ein Zeichen von Intelligenz ist, aber kein Beweis für Leben oder Bewusstsein, und dass die Grenzen des Turing-Tests darin liegen, dass er die „innere Erfahrung“ von AI nicht überprüfen kann. (Quelle: Reddit r/ArtificialInteligence)

LocalLLaMA Community-Management und AI-Generalisierungs-Kontroverse : Die Reddit-Community LocalLLaMA hat ein neues „local only“-Flair eingeführt, das verlangt, dass Beiträge zu lokalen LLM-Technologien dieses Flair verwenden, um „Rauschen“ wie nicht-lokale Modelle und API-Kosten zu filtern. Dieser Schritt löste in der Community starke Gegenreaktionen aus; viele Nutzer sind der Meinung, dass dies dem ursprünglichen „local first“-Prinzip der Community widerspricht, während Diskussionen über die Aussage „Generalized AI systems are a lie“ auch Zweifel an der Generalisierungsfähigkeit und Zuverlässigkeit von AI aufwerfen. (Quelle: source, source)

GPU-Computing-Marktwettbewerb und AI-Entwicklungspfad : Die Community diskutiert den intensiven Wettbewerb auf dem GPU-Computing-Markt und die Notwendigkeit für neue Cloud-Anbieter, ihre Wettbewerbsfähigkeit zu verbessern. Gleichzeitig wird erörtert, dass der AI-Fortschritt nicht ausschließlich durch Rechenleistung angetrieben wird und dass Lerneffizienz sowie Nicht-Transformer-Architekturen den nächsten exponentiellen Sprung bringen könnten, was zu Überlegungen über den zukünftigen Entwicklungspfad von AI führt. Es gibt auch die Ansicht, dass der AI-Fortschritt nicht ausschließlich durch Rechenleistung angetrieben wird und dass Lerneffizienz sowie Nicht-Transformer-Architekturen den nächsten exponentiellen Sprung bringen könnten. (Quelle: source, source)

💡 SONSTIGES

Indien setzt Roboter zur Kanalreinigung ein, verbessert die Lage der manuellen Kanalreiniger : Die Regierung von Delhi in Indien fördert den Einsatz von Robotern anstelle von Menschen zur Reinigung von Abwasserkanälen, um das seit langem bestehende Problem der „manuellen Kanalreinigung“ zu lösen. Obwohl diese Praxis seit 1993 verboten ist, ist sie immer noch weit verbreitet und gefährlich. Mehrere Unternehmen bieten bereits technische Alternativen an, darunter Roboter unterschiedlicher Komplexität, mit dem Ziel, die Arbeitssicherheit und Würde zu verbessern. (Quelle: MIT Technology Review)

Forschung nutzt „Rattenroboter“ zur Simulation echten Rattenverhaltens : Forscher entwickeln einen „Rattenroboter“, der durch die Simulation des Verhaltens echter Ratten ein tieferes Verständnis in Biologie und Neurowissenschaften ermöglichen soll. Dieses Projekt kombiniert Robotik, Machine Learning und AI und bietet eine neue experimentelle Plattform zum Verständnis tierischen Verhaltens. (Quelle: Ronald_vanLoon)

AI rekonstruiert Orson Welles’ verlorenen Film „The Magnificent Ambersons“ : Das Fable Simulation-Team nutzt AI-Technologie, um nicht-kommerziell und akademisch die fehlenden 43 Minuten von Orson Welles’ verlorenem Meisterwerk „The Magnificent Ambersons“ zu rekonstruieren. Dieses Projekt zeigt das Potenzial von AI in der Filmrestaurierung und dem Schutz des künstlerischen Erbes und könnte Zuschauern ermöglichen, dieses unvollendete klassische Werk neu zu erleben. (Quelle: source, source)